高光谱图像(hyperspectral image, HSI)是一种高维图像, 它比普通图像具有更丰富的光谱信息, 可反映地物的空间信息和光谱信息, 有庞大的数据量, 目前已广泛应用于军事、农业、地质、海洋、城市规划等各个领域, 有着广阔的前景. 为了充分分析原始高光谱图像, 高光谱图像分类起着至关重要的作用, 是走向许多遥感应用的先决条件.

早期的高光谱图像分类中, 学者们将SVM[1], 随机森林[2], KNN[3]等传统分类算法应用到高光谱图像分类上, 但由于HSI的高维特性, 传统的分类方法无法充分挖掘其深层特征, 导致分类效果较差. Chen等[4]首次将深度学习的概念引入到HSI分类中, 通过提取空间-光谱联合特征得到了更优分类结果, 由此揭示了深度学习在HSI分类中的巨大潜力. ResNet[5]和DenseNet[6]的提出, 有效解决了深度神经网络的退化问题和梯度消失问题, 因此, 研究者们开始基于这两种神经网络研究HSI的分类方法. Wang等[7]结合DenseNet的思想, 提出一种端到端的快速密集光谱空间卷积神经网络(FDSSC). Zhong等[8]结合ResNet提出一种光谱空间残差网络(SSRN), 其中的残差块可以高效学习和判别丰富的空间特征和光谱特征.

虽然上述模型较传统方法而言具有更优的分类性能, 但它们忽视了卷积核提取的不同特征的重要性对分类结果的影响, 而随着SENet[9]、CBAM[10]、BAM[11]、TAM[12]等各种注意力机制被提出和应用, 并在图像描述[13]、目标检测[14]、图像分类[15]等不同的任务中取得了优异的效果, 基于双分支结构结合不同的注意力机制的HSI分类方法成为研究热点. Ma等[16]提出了一种基于卷积块注意力(CBAM)机制的双分支多注意神经网络(DBMA), Li等[17]提出了一种端到端的双分支双注意力机制网络(DBDA), 王欣等[18]提出了一种基于改进DenseNet和空谱注意力机制的高光谱图像分类, 杨国亮等[19]提出了一种基于快速双分支密集连接网络和双注意力机制的高光谱图像分类.

上述基于双分支结构的方法通过在不同分支中对光谱和空间领域分别应用不同的注意力机制, 有效选择出与任务关联性较高的光谱特征和空间特征, 最终取得了令人满意的分类效果. 然而, 这些方法中的光谱分支和空间分支通常是两个单独的支路, 两者之间没有实质性的联系, 最终也只是简单地将提取的光谱特征和空间特征进行相加, 并不能使光谱和空间信息的互补性得到很好的利用. 本文提出了一种基于全局注意力信息交互的高光谱图像分类方法, 该方法首先利用DenseNet结合3D-CNN有效地提取图像的光谱特征和空间特征, 然后引入了全局注意力机制(GAM)[20]来重点关注特征图中全局维的交互信息, 最终通过一种显式的信息交互方法来得到光谱特征和空间特征的混合信息并利用该信息特征实现分类.

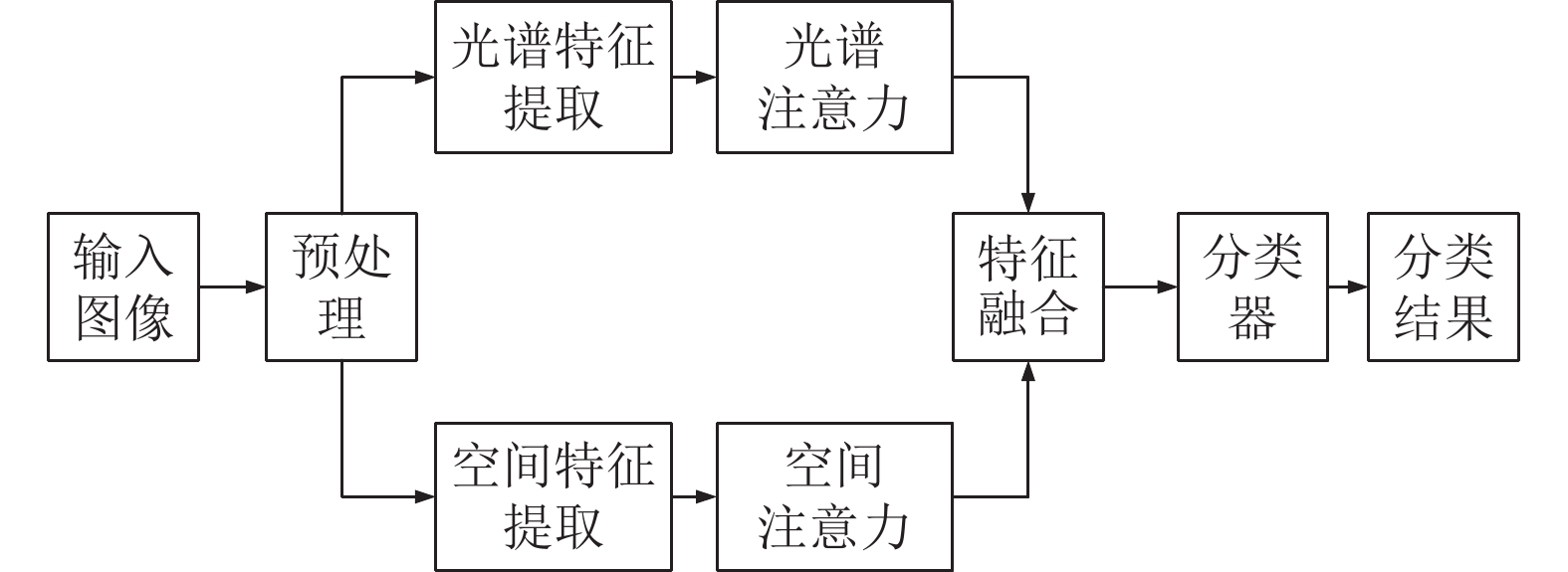

2 网络框架本文方法概况如下: 首先通过一个特征提取网络分别对图像的光谱领域和空间领域的特征进行细化, 之后结合GAM得到各自领域的全局注意力特征, 最后利用一个显式的信息交互模块进行光谱信息和空间信息的交互并通过一个全连接层得到最终分类的分类结果.

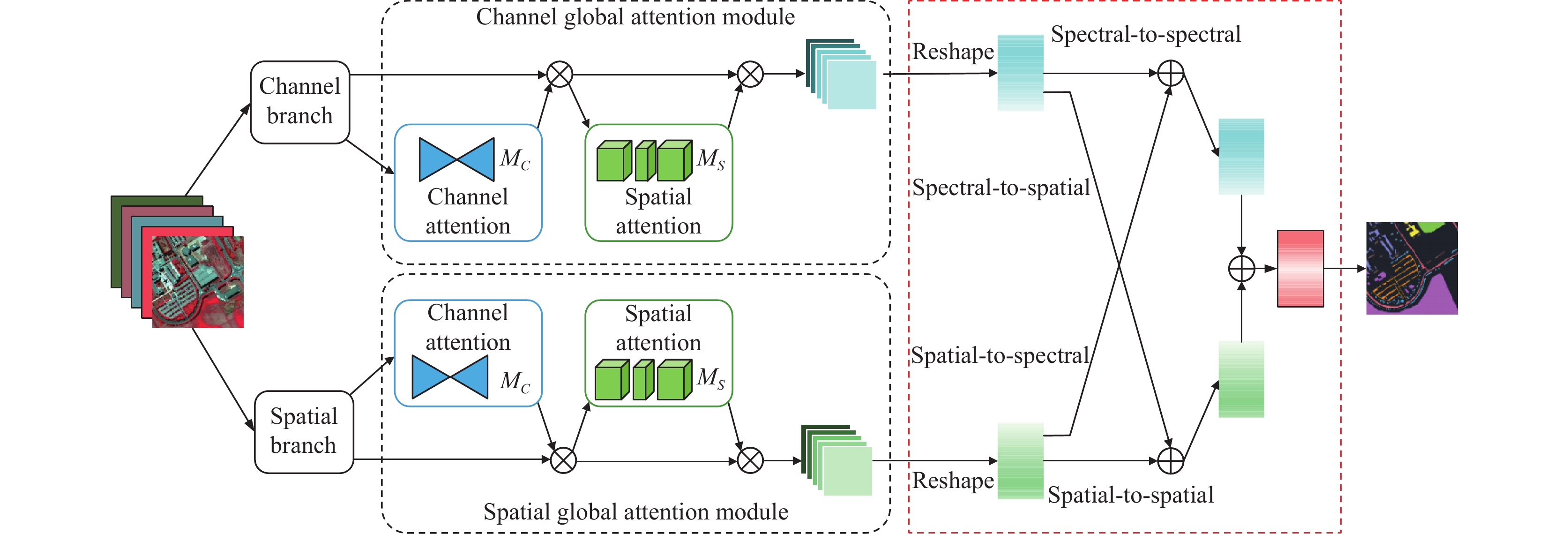

2.1 总体架构本文方法的总体架构如图1所示, 主要包括特征提取模块、通道全局注意力和空间全局注意力模块、信息交互模块3个主要部分. 该方法首先分为光谱分支和空间分支两个分支, 基于DenseNet框架结合卷积核大小不一致的3D-CNN分别对高光谱图像的光谱特征和空间特征进行细化, 然后在两个分支中引入全局注意力GAM对提取的特征进行权重分配, 再将两个分支中得到的注意力特征输入到一个显式的光谱-空间信息交互模块中, 最终通过显式交互后得到高光谱图像的分类结果.

2.2 光谱特征和空间特征的提取在本方法的特征提取部分, 我们采用了3D-DenseNet, 即DenseNet结构结合3D卷积作为特征提取网络. 相较于探索单一特征信息的2D卷积, 3D卷积可以从具有高维特性的高光谱图像中同时学习空间信息和光谱信息, 挖掘出更丰富的特征知识. 而DenseNet采用的密集连接机制, 互相连接所有的层, 每个层将前面所有层的输出在channel上进行concat操作后作为当前层的输入, 进而实现特征重用, 不仅缓解了梯度消失的现象, 也使得它在参数和计算量更少的情况下能实现比ResNet更优的性能. 因此, 在特征提取部分, 3D-DenseNet会随着参数数量不断增加而持续提高精度, 防止网络性能下降和过拟合现象发生.

在特征提取模块, 我们首先使用一个光谱分支和一个空间分支分别对输入的高光谱图像的光谱特征和空间特征进行提取, 得到其对应的光谱特征图和空间特征图. 光谱分支和空间分支的具体操作如下: 输入的初始高光谱图像块大小分配为p×p×B, 其中

|

图 1 基于全局注意力信息交互的高光谱图像分类结构图 |

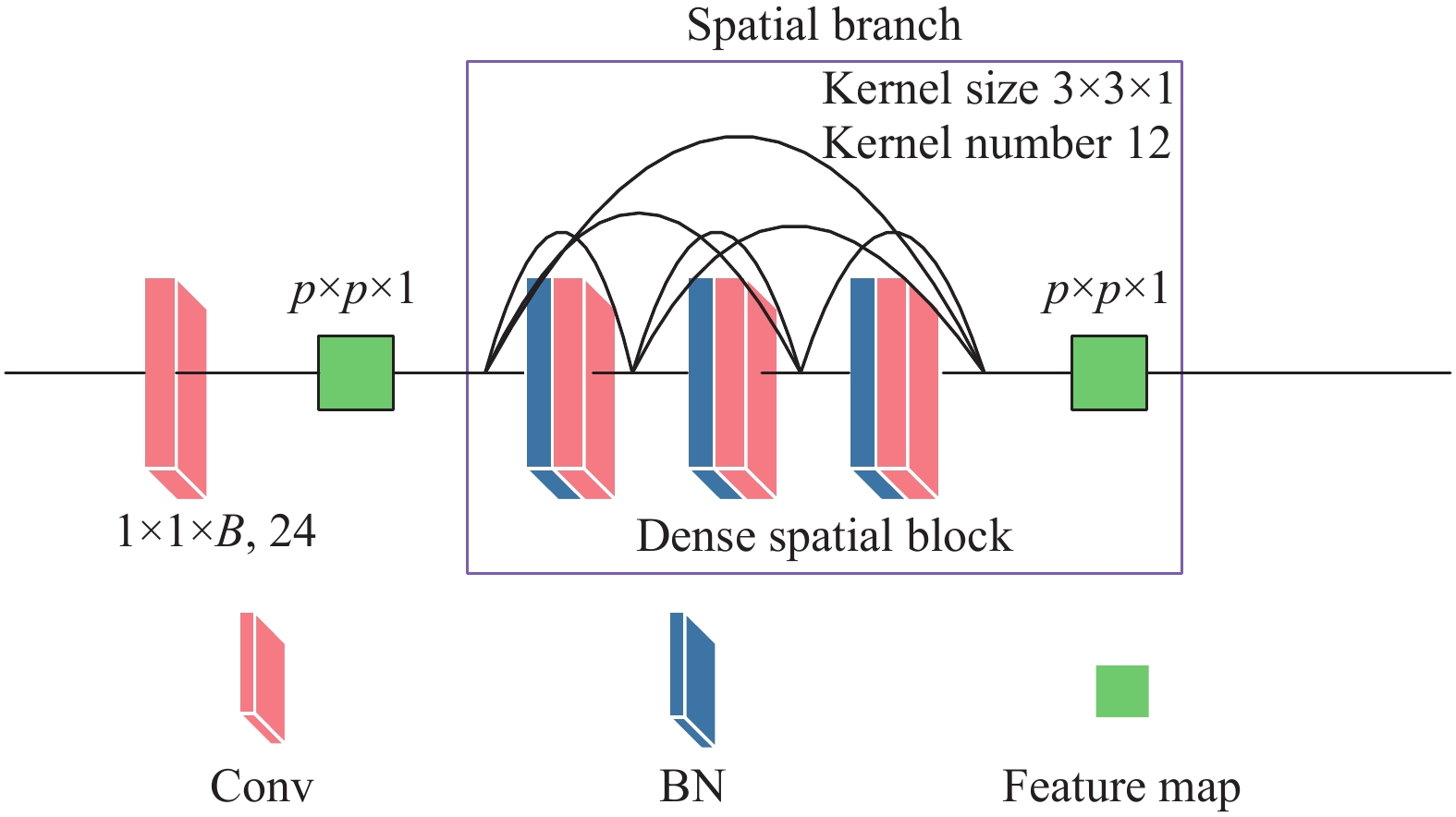

如图2所示, 通道分支中, 首先, 使用由24个核大小为

| f3=F3([f0,f1,f2]) | (1) |

其中,

如图3所示, 在空间分支中, 输入的高光谱数据为

|

图 2 通道分支结构图 |

2.3 光谱全局注意力和空间全局注意力

经过3D-DenseNet细化后得到的光谱特征图和空间特征图中, 依然存在另一个维度的特征信息, 因此, 考虑到跨维度的信息相关性, 本方法引入了GAM来提取空间特征图和光谱特征图中的全局维度交互特征. 将3D-DenseNet细化后得到的光谱特征和空间特征输入到GAM注意力模块中, 我们分别得到光谱全局注意力特征和空间全局注意力特征.

| 表 1 通道分支实现细节 |

|

图 3 空间分支结构图 |

| 表 2 空间分支实现细节 |

GAM可在减少信息弥散的同时放大跨维度特征的交互作用, 其整体结构与CBAM相似, 包含了通道注意力模块和空间注意力模块两个子模块, 这两个模块分别沿通道和空间两个独立的维度依次进行注意力操作, 最终得到跨维度交互信息的全局特征图.

GAM的总体结构如图4所示, 给定输入的特征映射

| I2 = MC(I1)⊗I1 | (2) |

| I3=MS(I2)⊗I2 | (3) |

其中,

|

图 4 GAM总体结构图 |

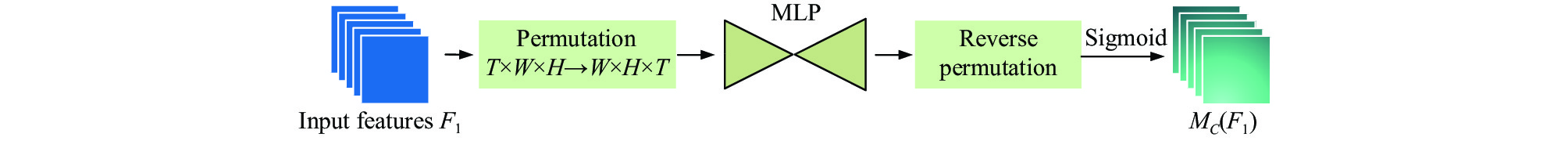

通道注意力子模块中如图5所示, 其中的T、W、H分别为图像块的通道数、空间宽度及长度. 为了尽量保留图像通道信息, 该子模块移除了CBAM通道注意力子模块中的池化操作, 首先进行了维度转换, 再将经过维度转换的特征图输入到MLP来放大跨维通道信息, 然后再转换为原来的维度, 最后用Sigmoid处理得到通道注意特征图.

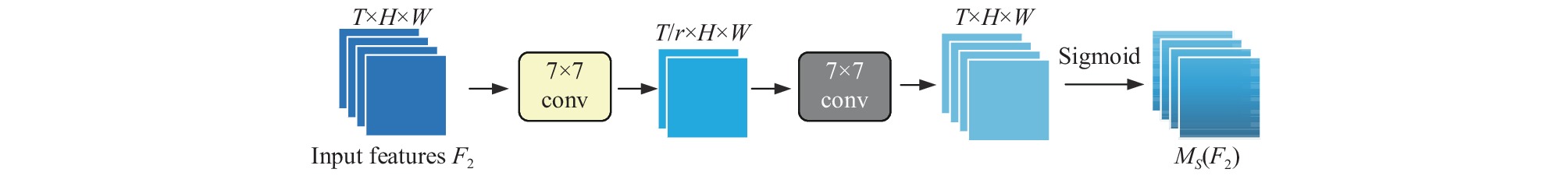

空间注意子模块如图6所示, 其中T、W、H分别为图像块的通道数、空间宽度及长度, r为缩减比, 我们在该模块中采取了与BAM机制相同的缩减比取值, 即r取值为4. 主要使用了卷积处理进行空间信息融合, 首先通过卷积核为7的卷积缩减通道数量, 缩小计算量, 在经过一个卷积核为7的卷积操作, 增加通道数量, 保持通道数量的一致, 最后用Sigmoid处理得到空间注意特征图.

|

图 5 GAM的通道注意力子模块 |

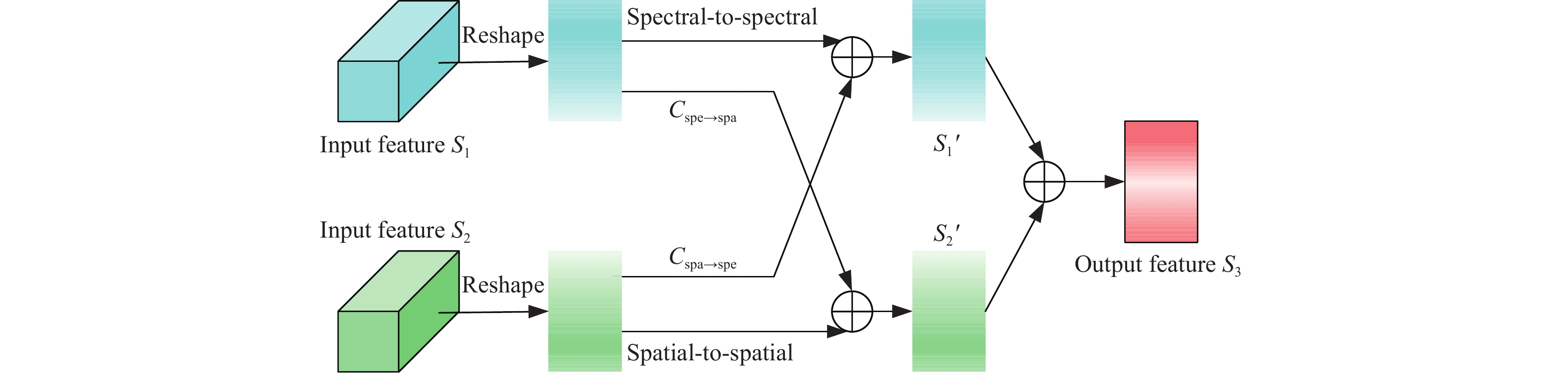

2.4 光谱-空间信息显式交互模块

本方法中引入了一种挖掘光谱特征和空间特征之间信息的显式交互方法. 该方法受八度卷积模型的启发, 分别在光谱通道融入空间信息以及在空间通道融入光谱信息, 在此卷积层的输出中, 可以得到光谱特征和空间特征的混合信息, 在一定程度上正确地融合光谱特征和空间特征, 从而更有效地进行最终的分类, 其结构如图7所示.

图7中输入的S1和S2分别是经过通道全局注意力和空间全局注意力处理后得到的特征图, S1'和S2'为经过信息交互后得到的特征图, 最终两特征图级联后得到输出特征图S3.

|

图 6 GAM的空间注意力子模块 |

|

图 7 光谱与空间信息交互模块 |

针对传统卷积模型中存在的空间冗余问题, 将一个图像分解为空间特征和光谱特征, 分别表示全局结构和局部细节. 通过在空间特征和光谱特征之间建立有效的通信, 增大接收域的大小, 使重要的信息流能在光谱和空间特征之间传输, 以便它们的贡献可以更好地融合, 从而获得更多的全局信息. 对于建立光谱与空间特征之间的信息流来说, 最关键的任务是构造一个可学习且可以融合光谱和空间特征的信息交互矩阵, 首先, 将光谱分支输出的光谱特征记作:

| Cspe→spa=[Softmax(AspaW⊗AspeT)]⊗AspeW | (4) |

| Cspa→spe=[Softmax(AspeW⊗AspaT)]⊗AspaW | (5) |

其中,

| Tspe=Cspa→spe+AspeW | (6) |

| Tspa=Cspe→spa+AspaW | (7) |

其中,

本次实验在Pavia University (PU)、Salinas Valley(SV)两个公开的高光谱数据集上进行以验证所提出算法的性能. PU数据集由610×340像素组成, 有115个光谱反射波段, 光谱分辨率为4 nm, 去除12个受水蒸气吸收影响的噪声通道, 在实验中使用了最后的103个波段, 包含9类不同生长阶段的不同作物. SV数据集是由512×217像素组成, 在400–2500 nm之间有224个光谱反射波段, 去除20个波段后, 实验中保留了最后204个波段, 可用的土地覆盖类别涵盖了16类. 在数据处理阶段, 将数据集划分为训练集、验证集和测试集3部分, 训练集及其真实标签的作用是更新网络参数, 验证集及其真实标签用于验证在训练阶段生成的临时模型的性能, 测试集用于评估最优模型. 由于PU和SV数据集样本数量较多, 我们使用0.5%的数据作为训练集, 0.5%的数据作为验证集, 剩下99%的数据集作为测试集, PU和SV数据集数据划分详情分别如表3和表4所示.

| 表 3 PU数据集数据划分详情 |

| 表 4 SV数据集数据划分详情 |

3.2 实验配置与评价指标

本文的实验都是使用Python 3.6版本搭载PyTorch学习框架实现的, 实验设备是一台基于Linux系统并搭载NVIDIA GeForce RTX-2070 GPU的计算机. 在实验中, 我们采用了交叉熵损失作为损失函数, 通过分析比较总体分类精度

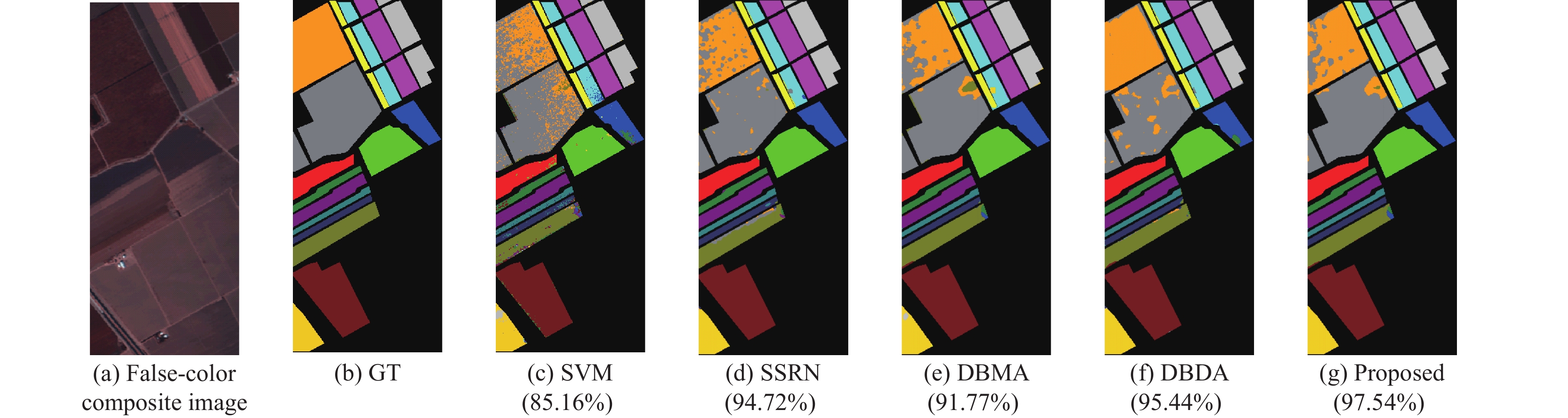

为了验证所提算法的性能, 本文把提出的方法与SVM[1]、SSRN[8]、DBMA[16]、DBDA[17]四种方法在PU和SV数据集上进行实验并比较分析. 其中, SVM是基于机器学习的传统分类算法, 其他3种方法是基于深度学习的双分支结构的HSI分类算法, 经典的双分支结构如图8所示.

|

图 8 双分支结构图 |

对于PU数据集和SV数据集使用不同方法的分类结果分别如表5和表6所示, 其中后3行分别表示各方法的OA值, AA值以及Kappa系数. 不同方法的分类图和地面真实值的分类图分别如图9和图10所示, 子图题括号内数值表示该分类结果图对应的OA值. 可以看出, 本文提出的方法在PU数据集和SV数据集上的实验结果优于其他4种方法.

| 表 5 PU数据集上的分类结果(%) |

从实验结果可以看出, 本文提出的方法及其他基于双分支的方法SSRN、DBMA、DBDA各项评价指标都要高出SVM许多, 从而证明了基于深度学习的分类算法较传统分类方法更适用于高光谱图像分类. 在PU数据集的实验结果中, 本文提出的方法得到的AA指标值稍低于DBDA, 分析原因如下: 由于特征信息的交互导致了光谱混合效应, 也就是同种类物体出现了不同的光谱或者是不同种类物体出现了相同的光谱[21], 而个别地物类型在光谱混合效应中表现出的问题更为突出, 因此造成了部分类别的平均分类精度较其他方法的低. 本文提出的方法在两个数据集上得到的OA指标值和Kappa系数都较其他4种方法高, 证明了本文方法的有效性, 也展现了在基于双分支结构的高光谱图像分类算法中, 光谱-空间特征信息的交互对高光谱图像分类的重要影响.

| 表 6 SV数据集上的分类结果 (%) |

|

图 9 PU数据集的分类图 |

|

图 10 SV数据集的分类图 |

4 结论与展望

本文提出了一种以3D-DenseNet为特征提取网络, 基于全局注意力信息交互的高光谱图像分类算法. 采用密集连接的3D卷积来分别细化图像的光谱特征和空间特征, 更充分实现了特征提取, 并减少了参数量; 同时引入GAM机制来放大所提取特征中的全局维的交互信息, 有效减少了特征信息的丢失; 最终通过利用光谱特征和空间特征的信息流传输, 实现了光谱-空间信息的交互, 更充分地利用了光谱信息和空间信息, 提高了模型的鲁棒性和泛化性. 在两个公共高光谱数据集上对不同的算法进行实验, 结果表明了所提出的算法在HSI分类上能获得更为准确的精度. 本文所提出的方法虽然在精度上取得了不错的结果, 但是依然存在不足, 且复杂网络对训练样本也提出了更高的要求, 因此我们下一步将尝试引入轻量化的特征提取网络来减少模型的复杂度. 而针对实验中出现的问题, 我们将研究如何利用半监督的方法实现对未标记样本的利用, 从而实现样本量的扩增, 减小因样本量少及光谱混合效应对分类效果的负面影响.

| [1] |

Melgani F, Bruzzone L. Classification of hyperspectral remote sensing images with support vector machines. IEEE Transactions on Geoscience and Remote Sensing, 2004, 42(8): 1778-1790. DOI:10.1109/TGRS.2004.831865 |

| [2] |

Wang AL, Wang Y, Chen YS. Hyperspectral image classification based on convolutional neural network and random forest. Remote Sensing Letters, 2019, 10(11): 1086-1094. DOI:10.1080/2150704X.2019.1649736 |

| [3] |

Bo CJ, Lu HC, Wang D. Spectral-spatial K-nearest neighbor approach for hyperspectral image classification. Multimedia Tools and Applications, 2018, 77(9): 10419-10436. DOI:10.1007/s11042-017-4403-9 |

| [4] |

Chen YS, Zhao X, Jia XP. Spectral-spatial classification of hyperspectral data based on deep belief network. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(6): 2381-2392. DOI:10.1109/JSTARS.2015.2388577 |

| [5] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 770–778.

|

| [6] |

Huang G, Liu Z, Van Der Maaten L, et al. Densely connected convolutional networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 2261–2269.

|

| [7] |

Wang WJ, Dou SG, Jiang ZM, et al. A fast dense spectral-spatial convolution network framework for hyperspectral images classification. Remote Sensing, 2018, 10(7): 1068. DOI:10.3390/rs10071068 |

| [8] |

Zhong ZL, Li J, Luo ZM, et al. Spectral-spatial residual network for hyperspectral image classification: A 3-D deep learning framework. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(2): 847-858. DOI:10.1109/TGRS.2017.2755542 |

| [9] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [10] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 3–19.

|

| [11] |

Park J, Woo S, Lee JY, et al. BAM: Bottleneck attention module. Proceedings of the 2018 British Machine Vision Conference. Newcastle: BMVC, 2018. 147.

|

| [12] |

Misra D, Nalamada T, Arasanipalai AU, et al. Rotate to attend: Convolutional triplet attention module. Proceedings of the 2021 IEEE Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2021. 3138–3147.

|

| [13] |

Anderson P, He XD, Buehler C, et al. Bottom-up and top-down attention for image captioning and visual question answering. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6077–6086.

|

| [14] |

Lipton AJ, Fujiyoshi H, Patil RS. Moving target classification and tracking from real-time video. Proceedings of the 4th IEEE Workshop on Applications of Computer Vision. Princeton: IEEE, 1998. 8–14.

|

| [15] |

Zoran D, Chrzanowski M, Huang PS, et al. Towards robust image classification using sequential attention models. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 9480–9489.

|

| [16] |

Ma WP, Yang QF, Wu Y, et al. Double-branch multi-attention mechanism network for hyperspectral image classification. Remote Sensing, 2019, 11(11): 1307. DOI:10.3390/rs11111307 |

| [17] |

Li R, Zheng SY, Duan CX, et al. Classification of hyperspectral image based on double-branch dual-attention mechanism network. Remote Sensing, 2020, 12(3): 582. DOI:10.3390/rs12030582 |

| [18] |

王欣, 樊彦国. 基于改进DenseNet和空谱注意力机制的高光谱图像分类. 激光与光电子学进展, 2022, 59(2): 0210014. |

| [19] |

杨国亮, 龚家仁, 习浩, 等. 基于快速双分支密集连接网络和双注意力机制的高光谱图像分类. 激光与光电子学进展, 2022, 59(8): 0810002. |

| [20] |

Liu YC, Shao ZR, Hoffmann N. Global attention mechanism: Retain information to enhance channel-spatial interactions. arXiv:2112.05561, 2021.

|

| [21] |

Ahmad M, Shabbir S, Roy SK, et al. Hyperspectral image classification-traditional to deep models: A survey for future prospects. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 968-999. DOI:10.1109/JSTARS.2021.3133021 |

2023, Vol. 32

2023, Vol. 32