伴随着互联网的飞速发展以及电子拍摄设备在人群中的高范围普及, 视频数量呈现爆炸式增长. 如何将繁琐的视频内容转为有效的文本信息供人们参考便成为一项研究热点[1, 2]. 视频描述任务便是通过计算机将一段视频的内容信息转化为文本信息. 视频描述来自于图像描述, 其本质是实现计算机视觉以及自然语言处理两个模态融合, 将一段视频分解为一帧一帧的图像, 通过对每一张图像地逐帧理解处理, 生成一段能够简单描述该视频的语言文本[3]. 视频描述在视频检索、人机交互、辅助网检人员筛选视频、帮助视力缺陷人群导航等多方面有着宏远的应用市场.

传统的视频描述技术为基于模板的方法[4, 5]和基于检索的方法[6]. 模板方法通过检测视频中物体、状态以及物体之间的关系等, 将检测到的视觉目标与语义信息按照事先设定好的语言模板进行映射, 如主语-动词-宾语等. 通常这类方法生成的文本能够满足句子的基本语法规则, 但过度依赖于设定好的语言模板, 生成的文本描述受到模板的限制而过于单一, 句式缺少了灵活性. 检索方法通过检索大量人工标注的视频样本与给定视频进行映射, 根据相似的文本描述映射得到给定视频的文本描述. 这类方法通常能够得到更加符合人类语言表达的语句, 但过度依赖于样本集的大小以及给定视频与样本集内视频的相似度. 样本集过小或给定视频与样本集内视频不相似都会导致生成的描述语句与原视频内容不符.

如今主流视频描述技术大部分是基于深度学习的编解码框架[7]. 早期工作中Venugopalan等[8]提出S2VT模型, 通过端到端训练模型来映射帧序列到单词序列, 该模型未考虑动态相关性. Yao等[9]针对视频动态相关性, 提出了一种结合时空3D-CNN的短时间动态表示, 引入注意力机制结合递归编码器, 利用局部和全局时间结构生成视频描述. Pei等[10]提出MARN模型, 在解码器中嵌入记忆体块增强描述质量. Gan等[11]利用视觉特征与人工视频标注, 训练一种语义检测网络来得到语义信息增强描述. Chen等[12]利用语义检测网络与计划采样辅助模型生成描述. 近年来随着多模态概念的提出, Chen等[13]利用双Transformer形成框架生成视频描述. 丁恩杰等[14]提出MMI模型从视频的多维度和多模态提取信息进行特征融合, 从视频的静态、动态、地点等多方面维度提取特征传入模型中, 为描述提供更加丰富的视觉特征. 李铭兴等[15]提出MABVC将视频的音频和视觉特征传入到Transformer框架中实现多模态信息融合的方式描述视频. Zhang等[16]引入外部语言模型来解决描述的长尾问题. 以上方法多关注于如何增多编码解码框架的输入来辅助模型, 却忽略物体相似时, 提取的视觉特征之间存在差异, 导致生成的部分单词不够精确, 使文本质量不高. 并且每个视频的标注语句有限, 想要获得视频中更加新颖的信息就需要从数据集外的知识进行补充. 针对以上两个问题, 本文通过添加特征强化模块使模型提高对视频中静态物体细粒度特征的提取能力, 解决相似物体之间识别的差异问题. 添加知识补充模块在预测单词时通过提高某些新颖单词的概率, 为模型提供更多线索辅助描述生成. 本文的主要工作有: (1) 融入特征强化模块于静态特征网络中, 提高模型对相似物体间的分辨能力; (2) 将知识语库引入编解码器中, 利用训练集中部分没有包含的外部知识来补充模型知识储备, 以此生成更有含义与新颖的语句; (3) 在公共数据集 MSR-VTT与MSVD与上进行模型验证, 并使用评估指标对生成的描述语句进行评分.

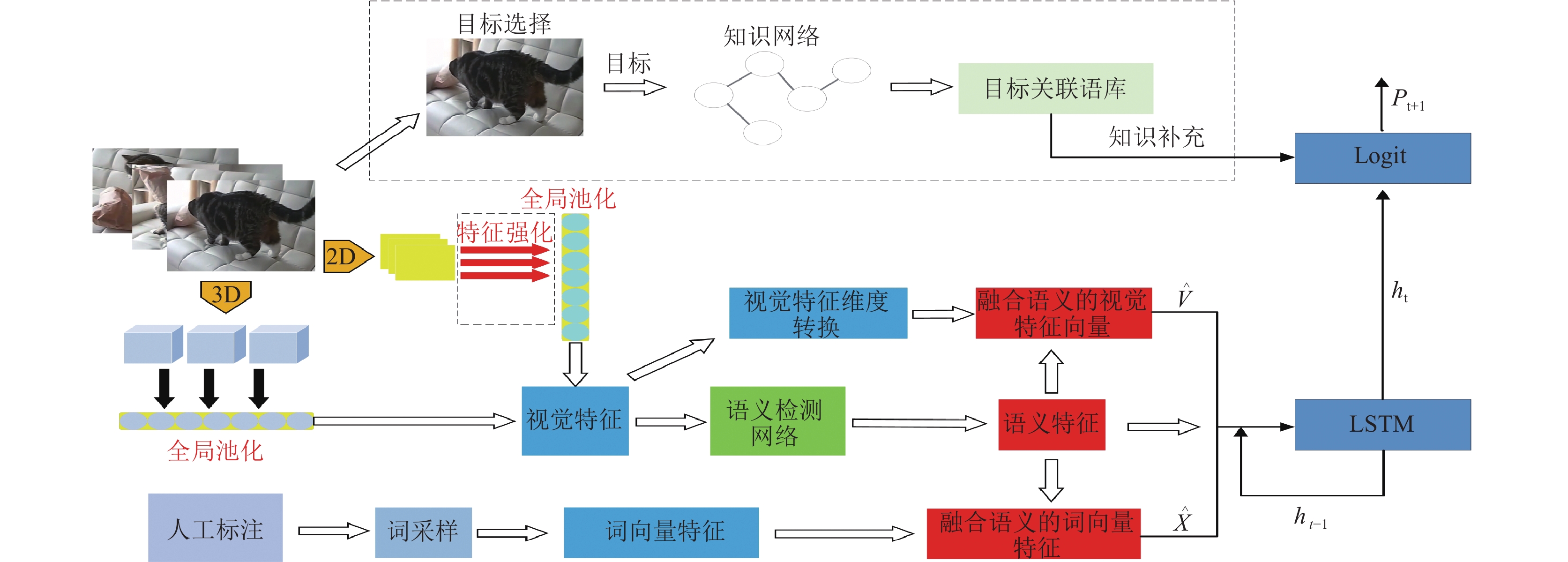

1 相关工作 1.1 网络整体框架本文整体流程如图1所示. 将需要生成文本的视频进行处理转化为视频帧序列, 将特征强化模块融入2D-CNN中提取视频的静态特征, 再利用3D-CNN提取视频的动态特征. 将提取的静态与动态特征通过拼接的方式传入到语义检测网络中得到视觉语义信息. 把视频中的真实标注转换为词向量, 将视频特征和词向量融合语义信息共同传入到LSTM进行预测. 同时利用Faster-R-CNN检测视频部分帧的视觉目标, 将视觉目标传入到知识补充模块中得到相关联的知识语库, 当预测的单词与检测出的视觉目标一致时, 检索语库中的关联知识并增加其概率, 最终得到的单词由当前预测的单词概率与检索语库中的检索概率共同得到. 通过给每个可能相关联的单词增添概率, 模型就能挖掘一些隐含的信息, 以此得到更加新颖和有含义的描述. 最终输出的所有单词构成整个文本描述.

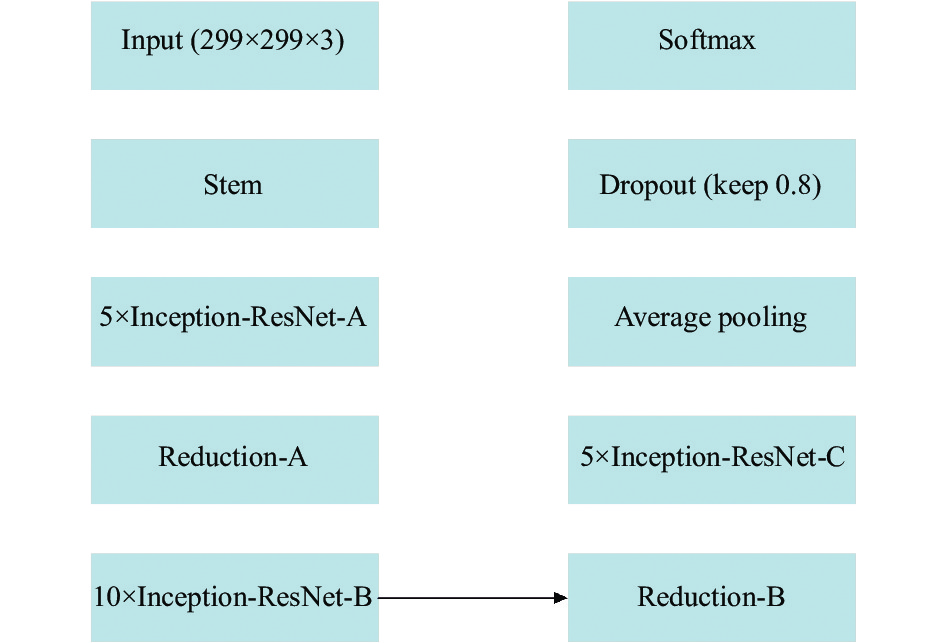

1.2 视频特征提取 1.2.1 静态特征提取本文采用Inception-ResNet-V2模型提取视频中的静态特征. Inception-ResNet-V2[17]网络框架主要由Stem、5个Inception-ResNet-A、10个Inception-ResNet-B、5个Inception-ResNet-C、Reduction-A和Reduction-B几种模块堆叠而成, 如图2所示, 其中keep 0.8 表示神经元保留比例为0.8. Inception-ResNet-V2对上一层的输入进行不同尺寸卷积核的卷积操作, 扩增了网络的宽度与深度, 同时使模型对不同尺度大小的图像有更强的适应能力.

1.2.2 特征强化模块对于视频中物体相似可能存在语义不同的情况, 导致模型根据特征生成的单词可能与真实标注单词并不相同, 生成的描述准确性降低. 如“boy”与“girl”之间外观相似, 视觉特征如果提取不够精确就会导致生成文本发生混乱, 并且频繁的维度切换可能会导致网络丢失掉某些较为重要的细粒度信息, 使得描述出现偏差.

|

图 1 总体流程结构 |

|

图 2 Inception-ResNet-V2网络框架 |

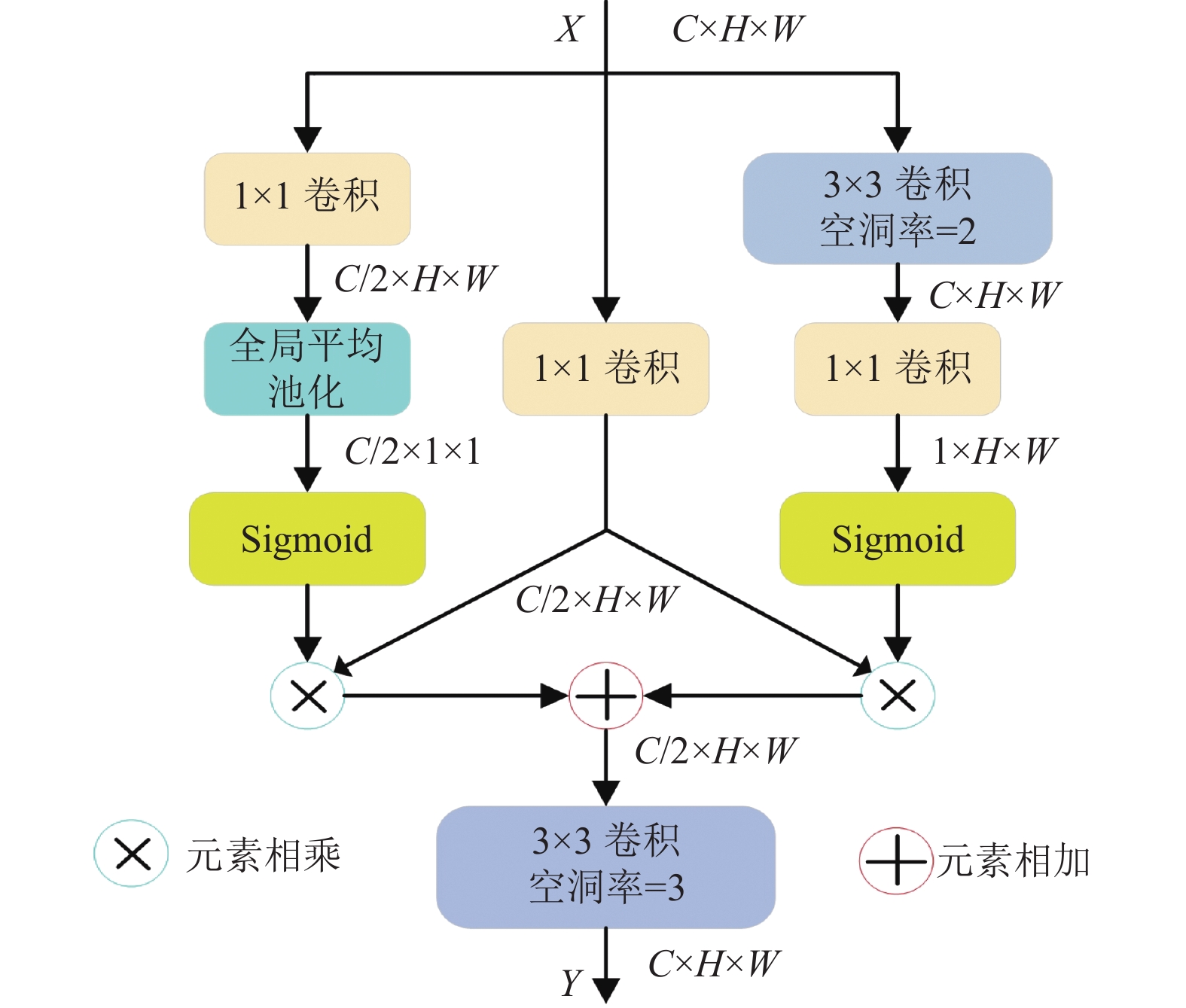

针对上述情况, 本文设计一种特征强化模块(feature enhancement module, FEM). FEM具体如图3所示, 其中包括3条支路: (1)通道支路(左侧), 针对特征中的局部信息进行处理. (2)压缩支路(中间), 通过压缩通道来降低FEM的计算成本. (3)空间支路(右侧), 针对特征的全局信息进行处理, 利用空洞卷积对原有特征的感受野进行扩张. 其次将压缩支路的特征与其他两条支路进行融合并相加, 得到的特征经过尾部的空洞卷积进行第2次的感受野扩张, 获得经过局部和全局特征强化的融合特征. 强化后的特征Y计算公式如式(1)所示:

| Y=C3,3[C1⊗δ(C1(C3,2(X)))⊕δ(P(C1(X)))] | (1) |

其中, X为上一层的输出特征,

|

图 3 特征强化FEM模块 |

1.2.3 改进静态特征提取网络

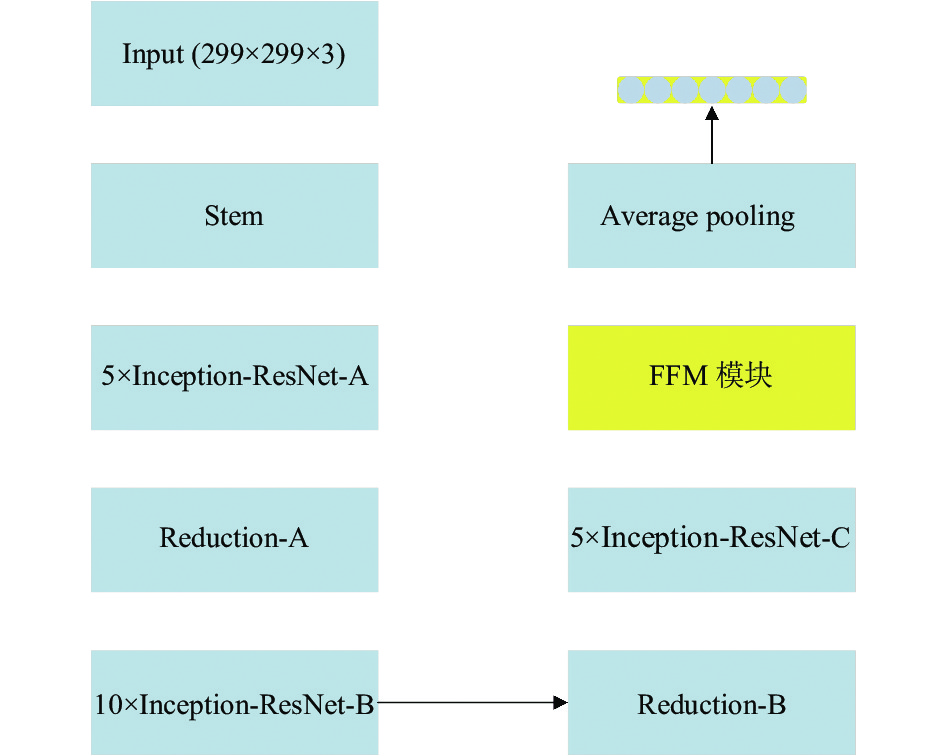

将FEM添加于图2中5个Inception-ResNet-C堆叠之后, 如图4所示. 通过添加FEM模块, 将原网络提取的特征利用空洞卷积使感受野扩张获取全局强化型特征, 并通过1×1卷积实现局部通道间的信息交互获取局部强化型特征. 融合全局与局部强化后的特征并再次利用空洞卷积使感受野扩展得到整体强化特征. 强化后的特征相较于原有特征在细粒度方面更加精确, 使模型提高相似物体特征之间的分辨能力, 引导模型生成更加准确的视频静态特征.

|

图 4 增添FEM的Inception-ResNet-V2网络框架 |

为了提取视频的静态特征, 首先对视频经过预处理, 每个视频提取32帧得到视频序列帧

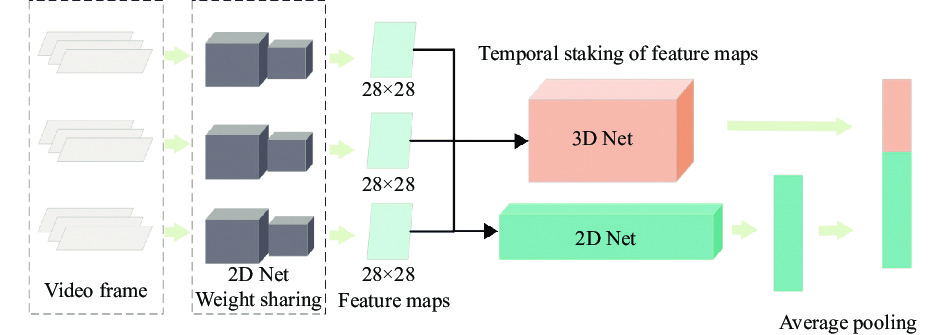

针对视频中时间尺度上的动态特征, 选择高效卷积神经网络ECO (full)[19]提取动态特征. 如图5所示. 该网络采用随机取样的方式整合各个时间段的特征信息, 利用2D卷积提取视频采样帧的特征并在时间维度上拼接, 拼接后的特征传入3D卷积处理在时间尺度上的信息, 增添2D卷积进一步利用2D部分的信息. ECO网络通过2D加3D的组合方式更充分地进行特征提取, 在视频分类上达到较好精度的同时, 速度也更快.

|

图 5 高效卷积神经网络ECO (full) 网络框架 |

在编码阶段, 将视频按照每32帧为一组的方式得到视频帧序列, 将帧序列作为输入传到ECO网络中进行特征提取, 载入在Kinetics-400数据集[20]上的预训练模型, 去除全连接层, 在平均池化层之后的1 536维张量作为动态特征

本文采用基准模型[12]中的方法, 人工地从数据集的训练集与验证集中选择出现次数较高的

| L(Si,˜Si)=1N∑N−1i=0∑K−1j=0(˜Si,jlogSi,j+(1−˜Si,j)log(1−Si,j)) | (2) |

从训练集中选取出现频率较高的300个单词, 以此300个词作为标签分类通过语义检测将每个视频得到所对应的真实语义标签, 再将整体特诊输入到语义检测网络中获取每个视频所对应的语义特征向量

采用GloVe的预训练模型将视频的人工标注语句转化为单词库, 选取出现概率前

本文使用基准模型[12]中的S-LSTM作为本文的解码模型, 其能借助语义信息来辅助生成更加准确的文本. 因为视觉特征要和词向量特征同一纬度, 所以通过转换矩阵得到输入视觉特征

| {Vj′=((V×Wj,a)⊙(S⊗Wj,b))×Wj,c, j∈{i,c,f,o}X′j,t=((Xt×Pj,a)⊙(S⊗Pj,b))×Pj,c, j∈{i,c,f,o}h′j,t−1=((ht−1×Uj,a)⊙(S⊗Uj,b))×Uj,c, j∈{i,c,f,o} | (3) |

其中,

| {it=σ(X′i,t+h′i,t−1+V′t+zi)ft=σ(X′f,t+h′f,t−1+V′f+zf)ot=σ(X′o,t+h′o,t−1+V′o+zo)c′t=tanh(X′c,t+h′c,t+V′c+zc)ct=ft⊙ct−1+it⊙c′tht=ot⊙tanh(ct) | (4) |

其中,

| pt+1=wTt+1Mght | (5) |

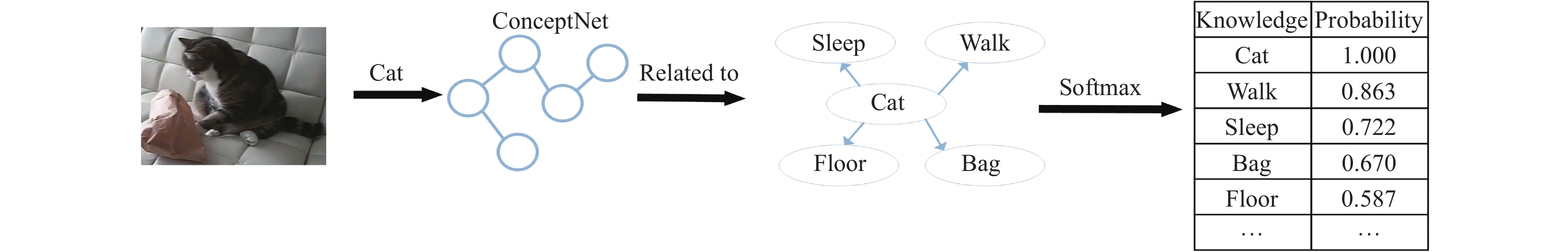

在视频描述的任务中, 描述语句的丰富性也是十分重要. 描述语句的主要来自于目前已有数据集中每个视频所对应的真实标签语句, 这些真实标签是人类为机器自动生成文本描述所提供的知识, 可以称作为内部知识. 但是随着视频越来越多, 其中内容难免有在一些数据集中不存在的知识, 这导致视频描述出的语句不够新颖. 因此, 本文考虑从外部资源中补充知识来辅助视频描述生成, 以此来增强模型的泛化性. 本文采用ConceptNet[21]来辅助模型进一步地理解视频图像中的隐藏含义. ConcepNet是一个包含多信息语义知识的开放式网络, 容纳了许多与人类日常生活紧密相关的常识性知识.

图片中每一个视觉目标均可以表现为此目标与另一目标在现实世界之间的关系. 为了得到视频中可能隐含的知识关系, 从预处理的视频中等间隔提取5帧的图片传入Faster-R-CNN[22]中检测相关的视觉目标, 将得到的视觉目标传入到ConceptNet中得到在语义上有关联的知识. 因为检测出的目标受限于标签类别, 本文选择检测到的频率为前3的目标作为视觉目标, 数量不够3时以0填充. 图6表示外部知识补充过程. 如图6所示, 检索的每个知识后会得到一些相关语义知识的关联概率值, 这些概率值将成为模型利用知识的重要依据. 考虑到目标与不同常识性知识间有权重, 本文选择前4个且weight≥1.0的知识作为语库, 不够4时以0补充. 当检测到“cat”后, 将目标传入知识网络中得到“walk”“sleep”等关联知识, 每条关联知识都有相应的权重, 选择与目标相关的知识作为一个小型知识语库

如果直接将知识语库作为输入传入到LSTM中进行训练可能会产生不必要的噪声, 从而使得模型的性能降低. 因此, 本文并不将这些知识信息作为输入传入到LSTM中, 而是在模型预测单词时, 增加知识语库的词汇表中某些单词的概率, 使模型能够发现一些隐含信息, 为此将第1.4节中生成单词的式(5)的生成机制修改为式(6):

| pt+1={wTt+1Mght+λpl(wt+1),wt+1∈WLwTt+1Mght, 其他 | (6) |

其中,

|

图 6 外部知识补充过程 |

2 实验设置 2.1 数据集和参数设置

模型在MSVD[23]和MSR-VTT[24]这两个公开数据集上进行实验验证. MSVD数据集有1 970个短视频, 每个视频平均时长在9 s, 且有40个人工标注的英文语句. MSR-VTT数据集由多个视频剪辑而成, 共有10 000个短视频, 每个视频剪辑在10–20 s, 且有20个人工标注的英文语句. 构建词典来自于两个数据集人工标注语句组成的语库, 删除语库中的生僻词和标点符号, 无法识别的词转为<UNK>. MSVD和MSR-VTT构建的字典库分别为12 954和13 794. 将数据集按照标准拆分为如表1.

| 表 1 数据集拆分 |

本文实验环境如表2所示. 其中训练隐藏层状态维度设置为512, 训练batch_size大小设置为64, 初始学习率为0.000 1, 模型生成最大长度为20, 最小为1, 损失函数采用稀疏交叉熵损失函数. 采用TensorFlow框架中的Adam优化器优化参数, 训练epoch设置为50.

| 表 2 实验环境配置 |

2.2 训练策略

本文采用计划采样(scheduled sampling)[12]的训练策略, 即以采样率

| p=p+epoch×ratio | (7) |

其中, epoch为训练周期,ratio为采样增长率, 设置为0.008, 刚开始设置

模型性能评估选择标准指标BLEU[25]、METEOR[26]、Rouge_L[27]和CIDEr[28]. BLEU用来判别模型生成的句子与实际标签句子之间的差异, 取值范围在0.0到1.0之间, 数值越大表示两个句子越相似. BLEU指标是基于n-gram (相邻单词片段)的, n的取值从1到4, 对应BLEU-1到BLEU-4, 每个n-gram的计算为式(8):

| Pn=∑Ei∑Kkmin(hk(Ci),minj∈Mhk(si,j))∑Ei∑Kkmin(hk(Ci)) | (8) |

其中,

| BLEU-N=BP×exp(N∑n=1Wnlog(Pn)) | (9) |

METEOR是一种基于召回率和精确指标结合一起的评估方法, 与BLEU最大的不同在于METEOR能够利用单词字母组合与同义词之间的映射关系, 参考同义词来扩展词库, 计算结果对应模型生成文本与实际标签句子之间的准确率和召回率的调和平均值, 取值范围在0.0到1.0之间, 计算公式为式(10):

| METEOR=(1−Penalty)F | (10) |

其中,Penalty为惩罚因子, F为参考文本和模型生成文本之间的准确率和召回率的调和平均值.

Rouge_L是一种计算生成文本与参考文本之间最长公共子序列的评估方法, 计算结果对应最长子序列所占比例, 见式(11):

| Rouge_L=(1+β2)RlPlRl+β2Pl | (11) |

其中,

CIDEr是一种结合BLEU与向量空间的评估指标, 通过计算生成文本与参考文本之间的余弦相似度的平均值来评判模型性能, 见式(12):

| CIDEr=1m∑jgn(c)Tgn(s)||gn(c)||⋅||gn(s)|| | (12) |

其中,

本文方法主要在MSVD与MSR-VTT数据集上进行验证评估, 分数单位为%, 分数越高代表模型生成语句与标注语句越接近, 模型越好. 基准模型为文献[12]. 由于

| 表 3 基于MSR-VTT数据集上模型的消融实验(%) |

| 表 4 基于MSVD数据集上模型的消融实验(%) |

表3为在MSR-VTT数据集上不同λ值的消融试验, 模型引入特征强化模块之后, 4种评估指标相较于基准模型平均提升了1.3%. 在引入知识补充模块λ=0.1时, BLEU-4取得最大值, λ=0.2时, METEOR和Rouge_L取得最大值, 此时4种评估指标相较于基准模型平均提升了1.8%. 表4为在MSVD数据集上不同

表5为基础模型引入特征强化模块与知识补充超参数设为0.2的理想模型与近年来其他方法在MSVD与MSR-VTT两个数据集上的对比结果. 表中各种方法的评估结果以文献中数据为准, 部分评估没有数据的以“—”代替.

其中MARN[10]在编解码框架中加入了记忆体快提高描述质量, SCN[11]提出一个语义检测网络检测视频的语义信息, SBAT[13]利用双视觉Transformer形成编解码框架生成视频描述, MMI[14]通过利用视频中的场景, 静态动态特征, 图像描述形成的多模态辅助模型生产描述, MABVC[15]通过融合视觉与音频传入到Transformer形成的多模态框架生成描述, ORG-TRL[16]提出一种新的训练方式来解决人工标注中长尾分布的问题, ECO[19]通过高效卷积神经网络捕获视频的动态特征生成描述, 本文在基准模型SAM-SS[12]上通过静态视觉的特征强化以及外部知识补充, 使模型对物体的细粒度特征提取更加全面, 并且在得到外部知识补充后, 既能辅助模型生成与视觉目标相关的文本, 也在一定程度上帮助模型发现视频中的隐含信息. 由表5实验结果可知, 本文方法在两个数据集上的表现相较于基础模型有了提升, 在4种评价指标上均取得了良好的效果, 并优于其他方法, 证明了模型的有效性.

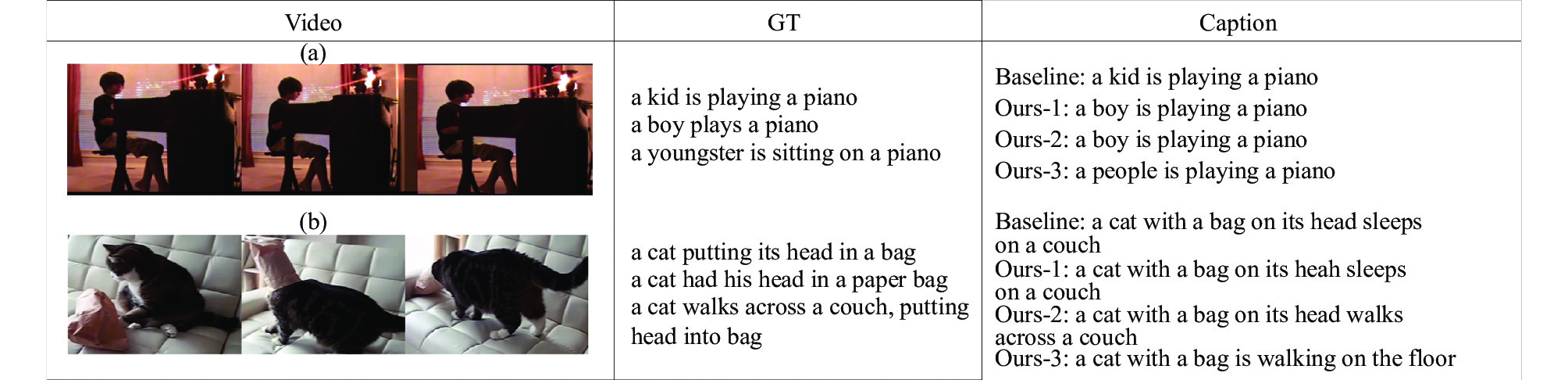

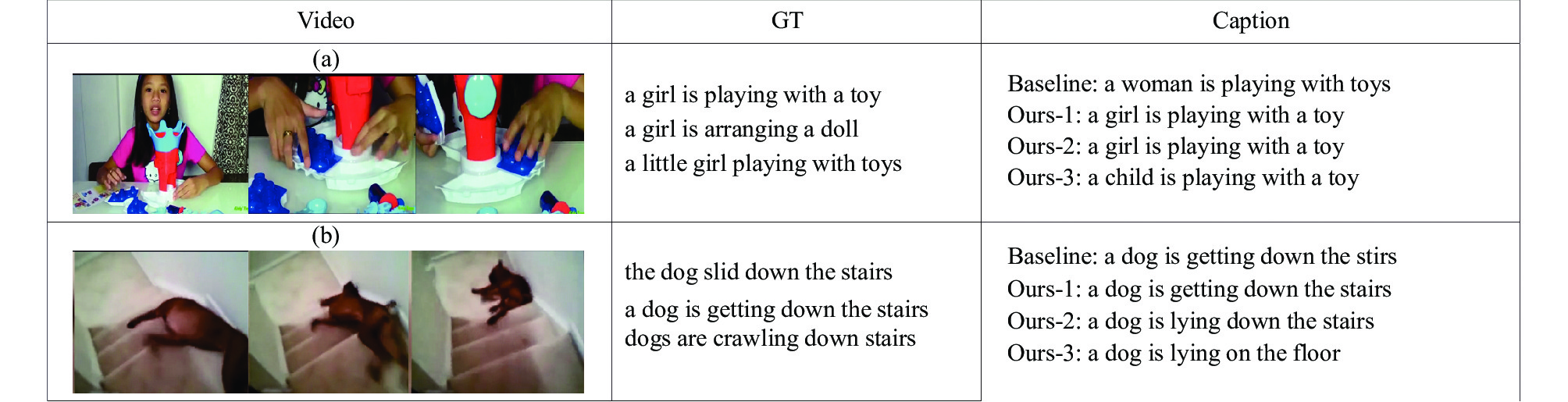

图7和图8为本文加入特征强化(FEM)与知识补充(λ)的模型生成语句与人工标注的语句在MSVD与MSR-VTT数据集上的对比. 其中GT为人工标注的3个语句, Caption为模型生成语句, Baseline为基准模型, Ours-1为加入特征强化后的模型, Ours-2为加入特征强化与知识补充(λ=0.2)的理想模型, Ours-3为加入特征强化与知识补充(λ=0.6)的模型. 图7(a)与图8(a)可见, Ours-1相较于基准模型对“boy”与“girl”特征的有更高的辨识度, 并最终生成于文本中. Ours-3在图7与图(8)中由于分别检测出“people”“cat”“toy”与“dog”, 过大补充了部分的常识性知识概率, 使生成文本过于偏离标注文本, 因此知识补充的程度是有限的. 图7(b)与图8(b)可见, Ours-2为本文理想模型, 当检测到视觉目标“cat”或“dog”后, 通过知识补充, 分别增添了“walk”与“lying”常识性动作知识的概率, 并最终生成与文本中. 其中Ours-2在图8(b)中相较于基础模型, 发现了“lying”隐含信息, 使得描述更加符合视频中“dog”的行为. 由此可见在模型经过特征强化与定量知识补充后, 模型生成的描述语句能够区分更加细粒度的相似物体, 也可能得到一些隐含信息, 使描述更加符合人的感知, 真实地体现出方法的优势性.

| 表 5 本文模型与其他模型在MSVD和MSR-VTT数据集上对比(%) |

|

图 7 MSVD数据集上模型描述对比 |

|

图 8 MSR-VTT数据集上模型描述对比 |

4 结论与展望

本文探索了如何提升对静态视觉特征的提取能力和如何集成更多的知识信息来辅助模型生产更加新颖和符合人类感知的描述语句, 提出了一种基于特征强化与知识补充的视频描述方法. 在MSVD数据集与MSR-VTT数据集上的实验证明, 本文模型无论在评估指标还是直观的描述上都取得了较好的结果, 在提升评估指标的同时一定程度上能挖掘视频中的部分新颖内容. 未来考虑融入注意力机制与多模态输入使模型能获得更多有效信息来指导模型生成更加准确和更有质量的语句.

| [1] |

Kojima A, Izumi M, Tamura T, et al. Generating natural language description of human behavior from video images. Proceedings of the 15th International Conference on Pattern Recognition. Barcelona: IEEE, 2000. 728–731.

|

| [2] |

Zhao B, Li XL, Lu XQ. CAM-RNN: Co-attention model based RNN for video captioning. IEEE Transactions on Image Processing, 2019, 28(11): 5552-5565. DOI:10.1109/TIP.2019.2916757 |

| [3] |

Liu CJ, Wechsler H. Gabor feature based classification using the enhanced fisher linear discriminant model for face recognition. IEEE Transactions on Image Processing, 2002, 11(4): 467-476. DOI:10.1109/TIP.2002.999679 |

| [4] |

Song JK, Yang Y, Yang Y, et al. Inter-media hashing for large-scale retrieval from heterogeneous data sources. Proceedings of the 2013 ACM SIGMOD International Conference on Management of Data. New York: ACM, 2013. 785–796.

|

| [5] |

Krishnamoorthy N, Malkarnenkar G, Mooney R, et al. Generating natural-language video descriptions using text-mined knowledge. Proceedings of the 27th AAAI Conference on Artificial Intelligence. Bellevue: AAAI Press, 2013. 541–547.

|

| [6] |

Odonez V, Kulkarni G, Berg TL. Im2Text: Describing images using 1 million captioned photographs. Proceedings of the 24th International Conference on Neural Information Processing Systems. Granada: Curran Associates Inc., 2011. 1143–1151.

|

| [7] |

Donahue J, Hendricks LA, Rohrbach M, et al. Long-term recurrent convolutional networks for visual recognition and description. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 677-691. DOI:10.1109/TPAMI.2016.2599174 |

| [8] |

Venugopalan S, Rohrbach M, Donahue J, et al. Sequence to sequence-video to text. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 4534–4542.

|

| [9] |

Yao L, Torabi A, Cho K, et al. Describing videos by exploiting temporal structure. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 4507–4515.

|

| [10] |

Pei WJ, Zhang JY, Wang XR, et al. Memory-attended recurrent network for video captioning. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 8347–8356.

|

| [11] |

Gan Z, Gan C, He XD, et al. Semantic compositional networks for visual captioning. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1141–1150.

|

| [12] |

Chen HR, Lin K, Maye A, et al. A semantics-assisted video captioning model trained with scheduled sampling. Frontiers in Robotics and AI, 2020, 7: 475767. DOI:10.3389/frobt.2020.475767 |

| [13] |

Chen M, Li YM, Zhang ZF, et al. TVT: Two-view transformer network for video captioning. Proceedings of the 10th Asian Conference on Machine Learning. Beijing: PMLR, 2018. 847–862.

|

| [14] |

丁恩杰, 刘忠育, 刘亚峰, 等. 基于多维度和多模态信息的视频描述方法. 通信学报, 2020, 41(2): 36-43. DOI:10.11959/j.issn.1000-436x.2020037 |

| [15] |

李铭兴, 徐成, 李学伟, 等. 基于多模态融合的城市道路场景视频描述模型研究. 计算机应用研究, 2022.

|

| [16] |

Zhang ZQ, Shi YY, Yuan CF, et al. Object relational graph with teacher-recommended learning for video captioning. Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 13275–13285.

|

| [17] |

Szegedy C, Ioffe S, Vanhoucke V, et al. Inception-v4, Inception-ResNet and the impact of residual connections on learning. Proceedings of the 31st AAAI Conference on Artificial Intelligence. San Francisco: AAAI Press, 2017. 4278–4284.

|

| [18] |

Deng J, Dong W, Socher R, et al. ImageNet: A large-scale hierarchical image database. Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 248–255.

|

| [19] |

Zolfaghari M, Singh K, Brox T. ECO: Efficient convolutional network for online video understanding. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 713–730.

|

| [20] |

Carreira J, Zisserman A. Quo vadis, action recognition? A new model and the Kinetics dataset. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 4724–4733.

|

| [21] |

Speer R, Chin J, Havasi C. ConceptNet 5.5: An open multilingual graph of general knowledge. Proceedings of the 31st AAAI Conference on Artificial Intelligence. San Francisco: AAAI Press, 2017. 4444–4451.

|

| [22] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [23] |

Chen DL, Dolan W B. Collecting highly parallel data for paraphrase evaluation. Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Portland: ACL, 2011. 190–200.

|

| [24] |

Xu J, Mei T, Yao T, et al. MSR-VTT: A large video description dataset for bridging video and language. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 5288–5296.

|

| [25] |

Papineni K, Roukos S, Ward T, et al. BLEU: A method for automatic evaluation of machine translation. Proceedings of the 40th Annual Meeting on Association for Computational Linguistics. Philadelphia: ACL, 2002. 311–318.

|

| [26] |

Banerjee S, Lavie A. METEOR: An automatic metric for MT evaluation with improved correlation with human judgments. Proceedings of the 2005 ACL Workshop on Intrinsic and Extrinsic Evaluation Measures for Machine Translation and/or Summarization. Ann Arbor: ACL, 2005. 65–72.

|

| [27] |

Lin CY. ROUGE: A package for automatic evaluation of summaries. Proceedings of the 2004 Text Summarization Branches Out. Barcelona: ACL, 2004. 74–81.

|

| [28] |

Vedantam R, Zitnick CL, Parikh D. CIDEr: Consensus-based image description evaluation. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 4566–4575.

|

2023, Vol. 32

2023, Vol. 32