中国城市交通中非机动车扮演着重要角色, 我国依据国家道路交通发展的需求, 对非机动车有自己详细的分类. 将自行车, 电动三轮车, 电动自行车, 残疾人和老年人使用的助力车, 以及畜力车统一划分为非机动车. 随着科技的发展以及时代的进步, 部分车型以逐步淘汰, 但以共享单车为主的自行车得到了迅速普及, 除此之外适宜短途出行的电动自行车也仍是人们喜爱的交通工具. 非机动车辆数量的不断扩增, 以及其车辆驾驶员淡薄的道路交通安全意识, 随之带来许多因非机动车造成的严重交通事故. 非机动车驾驶员相较于汽车卡车等驾驶员处于交通弱势地位, 一旦发生交通事故, 往往会引起较为严重的伤亡. 为避免交通事故所带来的不必要人员伤亡, 近年来我国各地方纷纷制定了较为严格的非机动车安全条例, 加强非机动车辆的管理力度, 但相应的需要交通管理部门出动大量的人力物力进行交通监管. 现有交通路段均设有大量视频监控, 但与日俱增的交通监控视频信息未得到充分的利用. 人工智能技术的不断发展, 带来的智能化的监控方式很大程度上减少了不必要的人力资源, 基于路面监控的非机动车在线智能检测对城市交通道路安全有着重要的意义. 传统的目标检测算法往往通过人工手动提取图像特征信息, 其过程具有较强的可解释性, 但其识别度低, 计算量大, 运行速度慢. 常见的经典传统目标检测算法如HOG+SVM[1]、DPM[2]、SIFT[3]. 传统的方法都是将所提出的目标特征放入标准分类器中进行分组识别, 但是因为在实际场景中非机动车体积较小, 而且容易被屏蔽等原因导致无法获得较好的目标特性, 使得传统方法难以适应现实场景需要. 随着机器学习领域分支的延伸, 对深度学习探索不断深入的同时将目标检测技术推入新的台阶. 目前深度学习的目标检测算法主要包括两大类:基于区域建议概念的two-stage检测算法和基于回归思想的one-stage检测算法[4]两阶段的目标检测算法先生成候选区域(region proposals), 再对生成的候选框进行分类检测, 典型代表算法: R-CNN[5], SPPNet[6], Fast R-CNN[7], Faster R-CNN[8]. 其识别精度高, 误检漏检率较低, 但检测速率缓慢, 无法满足实际场景中的实时检测任务. 单阶段检测算法无需提前生成候选框, 能直接对目标物体进行分类回归, 典型代表算法: SSD[9]、YOLO[10-13]. 文献[14]提出基于组件的传统检测算法DPM, 并通过已知的几何上下文信息提升检测效率. 文献[15]利用EdgeBoxes[16]提取感兴趣区域并与Fast R-CNN相结合提升非机动车的检测效率. 文献[17]通过重新设计YOLOv3的特征融合方式降低非机动车的漏检率. 上述文献均都未能对视频图像中的非机动车小目标, 遮挡目标特征进行有效处理, 检测效率不高, 同时参数较大, 不利于移动部署. 本文根据易部署移植, 实时性等因素选用了YOLO家族中YOLOv5目标检测算法, 在其基础上进行改进优化. 该算法较之前提的一些其他算法, 其精度和复杂场景下的检测能力有待提升. 本文针对上述不足对YOLOv5算法进行改进优化, 使其检测精度和复杂场景的适应能力有很大提升, 同时仍具备良好的实时性.

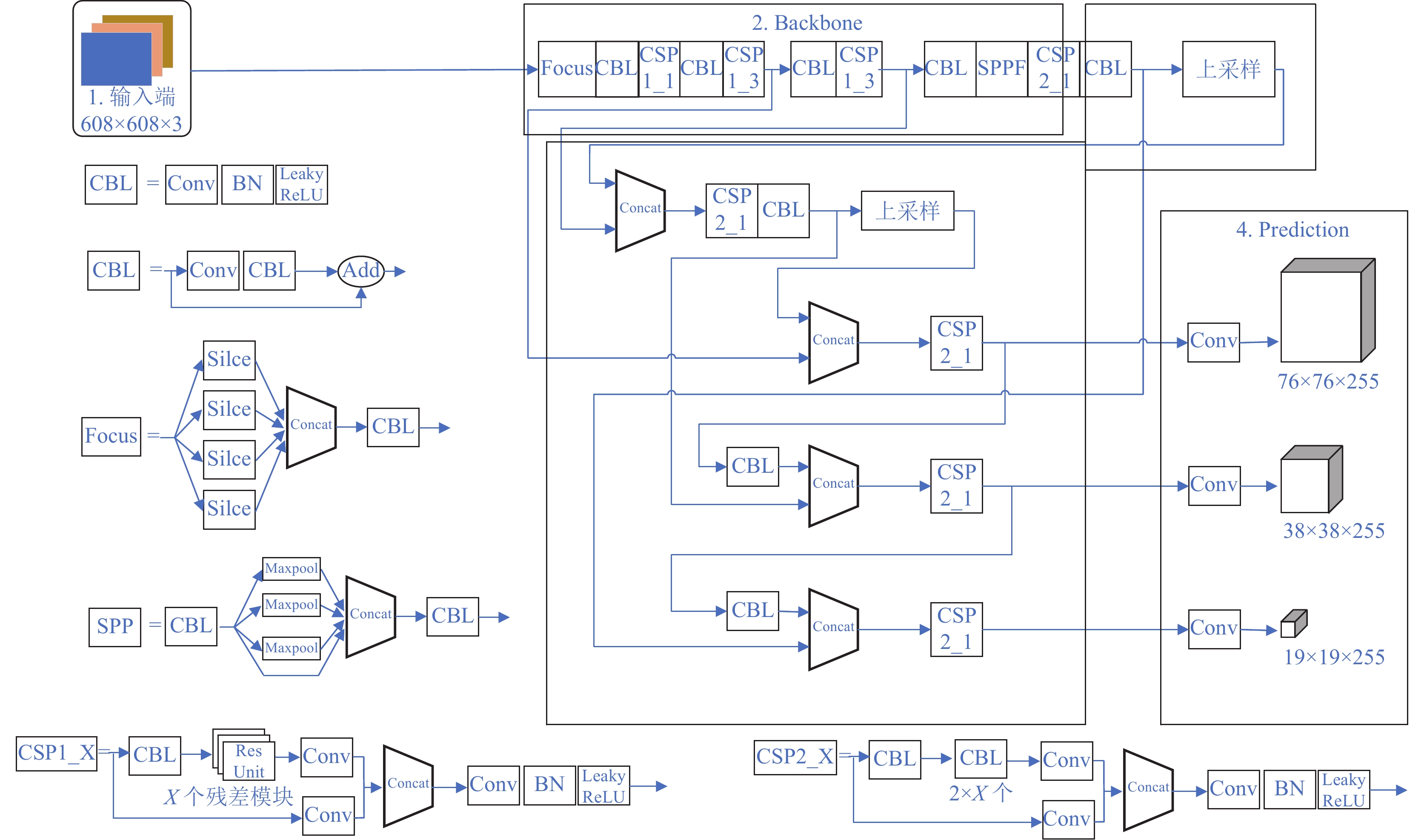

1 本文算法 1.1 YOLOv5模型YOLOv5算法共分为4部分, 分别为输入端、主干网络(Backbone)、多尺度特征融合网络(Neck)以及头部分类预测网络(Prediction).

网络输入端主要用来进行数据的预处理, 使用了Mosaic数据增强对待检测图像进行随机缩放、裁剪、排布的处理; 采用自适应锚框计算, 对不同数据集计算产生合适的锚框尺寸; 运用自适应图片缩放对不同尺寸原始图像进行黑边填充, 再缩放到符合输入网络的图像大小. 主干网络主要用来提取图像特征信息, 提出了一种切片操作Focus, 对特征图进行类似邻近下采样操作, 将一张特征图分成4份扩充到通道空间中, 与普通卷积相比充分保留特征信息. 同时还设计出两种跨阶段部分网络(cross stage partial network, CSPNet), 一种用于主干网络如图1中的CSP1_X, 另一种用在Neck网络如图1中的CSP2_X所示. Neck网络主要使用CSP2_X和PANet用来进行加强网络的特征融合能力. 头部网络即输出端主要采用nms非极大值抑制, 以及使用CIoU_loss作为bounding box的损失分类回归.

1.2 主干网络的改进 1.2.1 DenseNet与VovNet网络DenseNet网络是由Huang等人[18]提出了一种新型的网络结构. 分析参照了ResNet以及Inception网络的思想, 其网络从检测物体的特征入手, 通过合理的特征重用方式提升网络提取信息的能力同时减小了参数数量并很好地缓解卷积网络造成的梯度问题, 相比ResNet网络有一定的提升. 一般卷积网络中有

|

图 1 YOLOv5网络结构 |

|

图 2 DenseNet与VovNet网络主要结构图 |

1.2.2 跨区域局部VovNet

非机动车辆与汽车相比, 在交通监控下的像素点相对较少, 除密集车流量的情况下车辆之间也存在相互遮掩现象外, 驾驶者自身会带来严重的遮挡. 含目标物体的图片输入深度网络经过多层卷积后其有效信息可能进一步减少. 上述情况均带来一定的特征缺失从而引起造成漏检, 错检. 为缓解此类问题, 本文使用更为高效的主干网络VovNet, 并结合CPSNet特点对其进行改进. VovNet网络继承了DenseNet网络特征复用的优点, 充分保留了小目标浅层特征信息同时避免了网络各层新输出比重逐渐降低的问题, 每个卷积层仅为包含双向连接, 即一个连接下一层获取更大感受野和深层语义信息, 一个在最终输出中聚合映射. 图3为改进前的VovNet和改进后的VovNet.

|

图 3 改进前后的主体结构 |

当输入图像进入改进后的模块后会分为2个部分, 第1部分将输入图像通过1×1的卷积对浅层特征进行简单的压缩提取, 第2部分通过不断3×3卷积操作提取更深层次的特征信息, 在保证输入与输出图像大小保持不变的情况下, 最终得到所有层的输出, 将所有输出进行通道拼接再进行1×1的卷积减少输出通道数得到最终的输出. 将改进后的VovNet网络运用到YOLOv5的主干网络后, 其网络结构为图4所示.

上述网络在原有CSPDarknet网络的基础上将具有ResNet模块的CSP1_x模块进行了替换, 该结构的设计对网络不同的深度采用了不同的配置, 本文根据VovNet-57对改进后4个阶段的CSP-VovNet进行配置, 其比例为1:1:4:3. 根据VovNet网络的特点删除了原网络中的步长为2的3×3卷积改为步长为1的3×3最大池化进行下采样, 即图4中P3, P4, P5. 通过对原有残差结构的改进让网络进一步加强了特征提取的能力, 保留了相对比例的浅层信息, 如纹理, 颜色, 边缘, 棱角等. 同时通过不同阶段增加输出通道来增加高层语义信息的比重, 避免了DenseNet网络只有少量新输出的特点. 本文CSPVovNet提升主干提取特征的能力, 同时降低很大程度的计算量, 提高了检测的精准度.

|

图 4 改进后的YOLOv5主干网络 |

1.3 可变形卷积的引入

交通道路数据中非机动车属于像素点较小的目标之一且交通摄像头拍摄的高度和角度大相径庭, 因此存在不同程度的模糊和形变, 为解决这类问题将可变形卷积运用于提取目标特征的基础网络中.

1.3.1 可变形卷积结构(DCN)相对于普通卷积来说, 可变形卷积的卷积核的形状不是固定的几何形状, 可以根据图像中目标的内容进行自适应的改变. 相对于传统卷积, 其映射方式是十分规整统一的, 可理解为刚性映射, 大多数的目标检测任务中目标物体往往都具备非刚性结构, 但传统的卷积仅能用规整的方形结构来覆盖被测物体. 图5为可变形卷积不同表现形式.

|

图 5 可变形卷积不同表现形式 |

而本文用到的可变形卷积, 能有效地映射目标区域, 其卷积核会根据目标物体内容进行不同形式的变化, 卷积区域可以尽可能地覆盖到被测非机动车辆的外观形状, 有利于获取更多有用的特征信息, 进一步实现更好的特征提取效果. 如图6所示.

|

图 6 普通卷积和可变形卷积效果 |

普通的Conv2通常分为两部分, 一是使用图5中普通卷积在输入特征映射

| R={(−1,−1),(−1,0),⋯,(0,1),(1,1)} | (1) |

对输出映射特征图上的每个像素点

| F(P0)=∑Pn∈Rw(Pn)∗X(P0 + Pn) | (2) |

在可变形卷积中, 卷积核

| F(P0)=∑Pn∈Rw(Pn)∗X(P0 + Pn + ΔPn) | (3) |

其中,

本文将可变形卷积(DCN)运用到目标检测模型YOLOv5中去, 以此来提升对检测目标的几何变换的建模能力, 对原有的模型进行进一步的优化从而提高对此次非机动车检测的任务的检测效果.

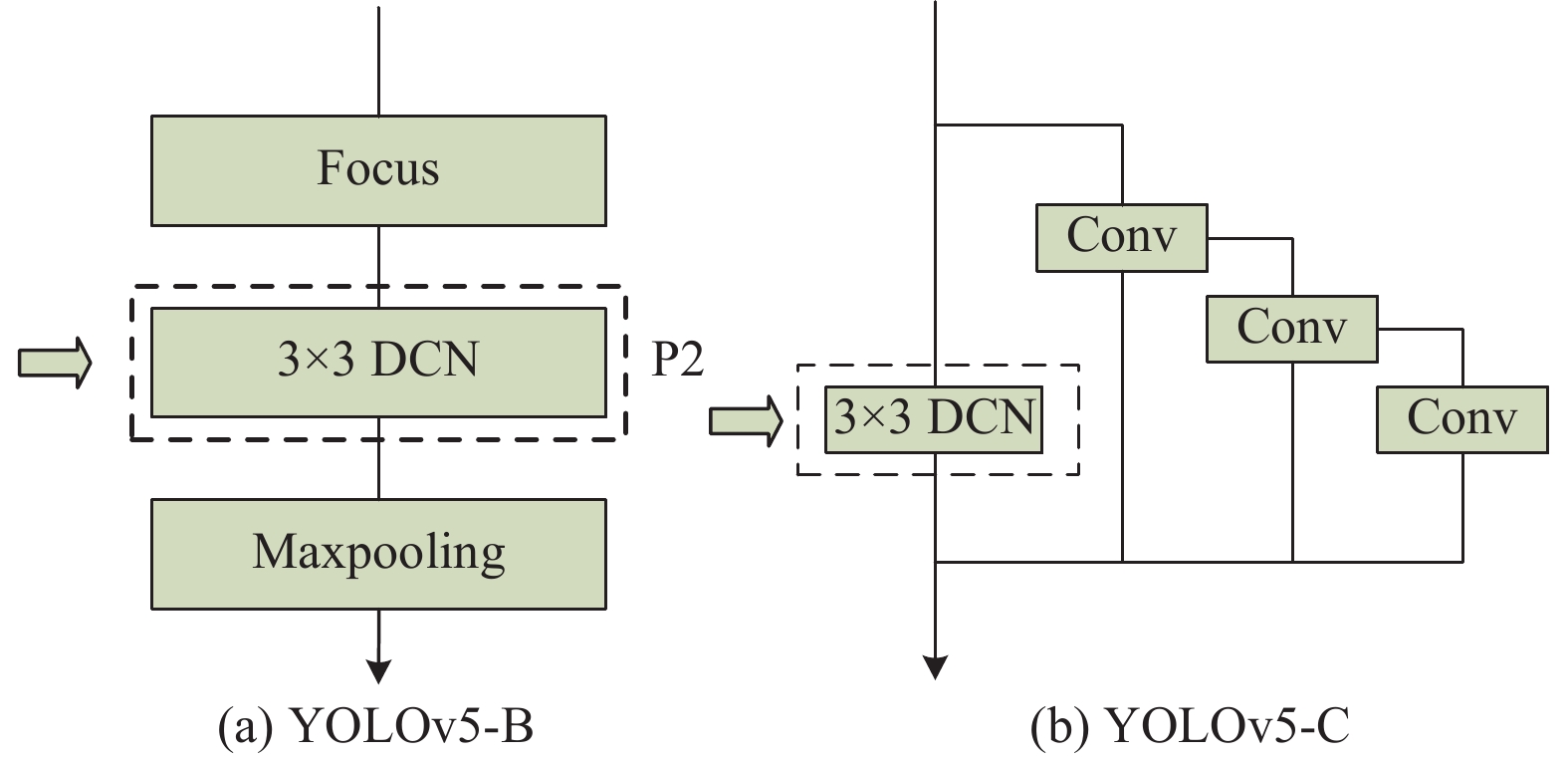

1.3.2 3种添加方式本文根据主干网络结构设计出3种不同的卷积添加方式, 3种方法对应3种模型分别记为: YOLOv5-A, YOLOv5-B, YOLOv5-C. YOLOv5-A: 在上述主干网络的P2层, 不同CSPVovNet结构中分别用3×3可变形卷积替换常规3×3的卷积及CSP结构中的1×1卷积. YOLOv5-B: 仅在网络的P2层加入可变形卷积, 如图7(a). YOLOv5-C: 仅在网络的前两个CSPVovNet层加入可变形卷积, 如图7(b). 两种添加模型如图7.

|

图 7 DCN在网络中的添加方式 |

1.4 EIoU-YOLOv5s

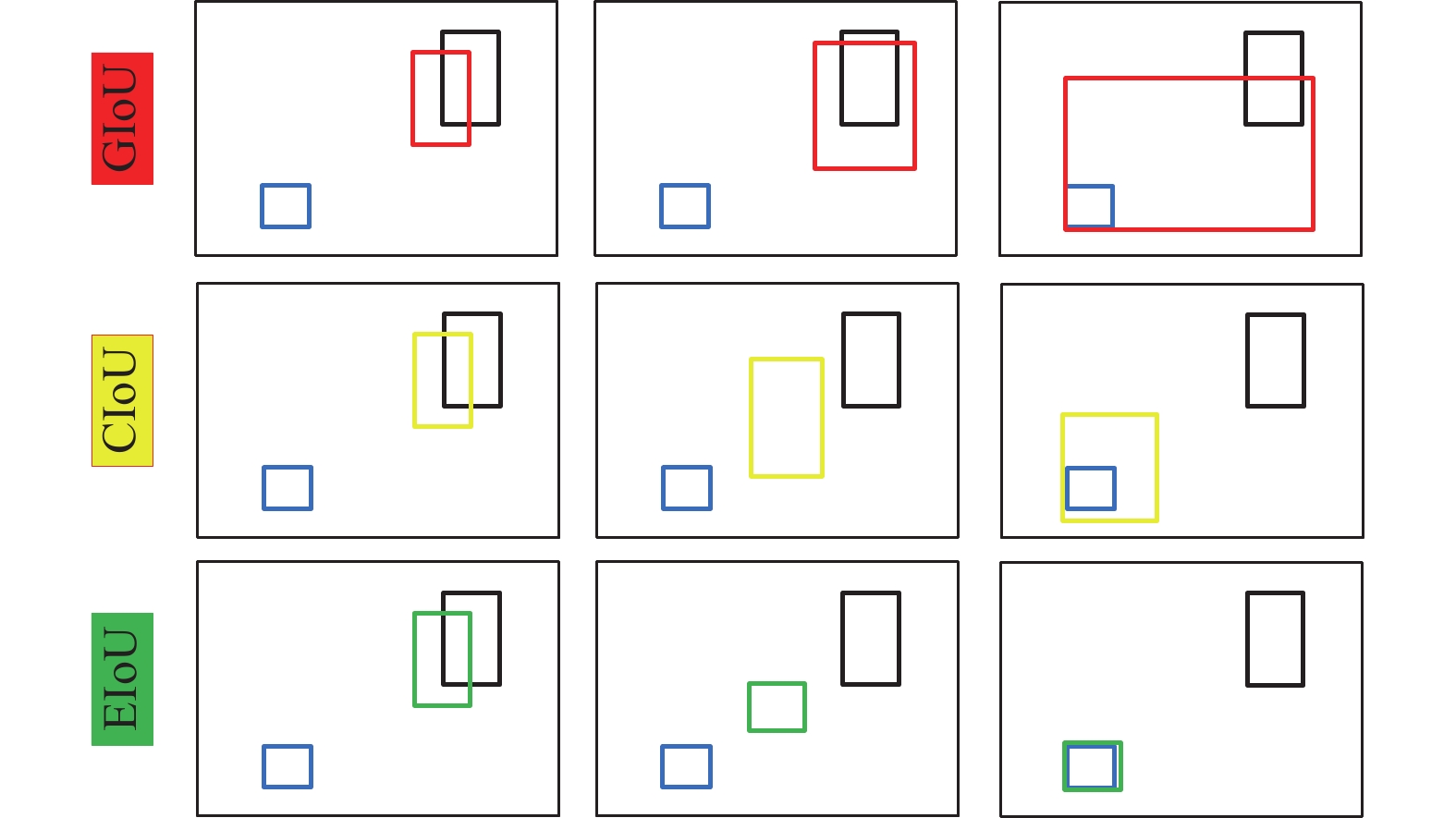

YOLOv5共采用3种损失函数分别为分类损失(cls_loss), 定位损失(box_loss)和置信度损失(obj_loss). 其中分类损失和置信度损失均使用了二元交叉熵损失函数(BCEWithLogitsLoss)进行该部分损失计算, 使用CIoU_loss作为bounding box回归定位损失. GIoU的问题是使用闭包的面积减去并集的面积作为惩罚项, 这就导致了GIoU存在先扩大并集面积再优化IoU的走弯路的问题. CIoU的问题是宽和高不能同时增大或者减小. 例如在图8中的第2行, anchor是一个锚框, 它的宽和高均大于待检测物体, 但是在优化过程中它仍然会放大预测框的宽. 对比上面两个损失函数, EIoU则拥有更快的收敛速度.

基于这个现象, EIoU提出了直接对

| LEIoU=LIoU+Ldis+Lasp=1−IoU+ρ2(b,bgt)c2+ρ2(w,wgt)C2w+ρ2(h,hgt)C2h | (4) |

其中,

|

图 8 不同loss的多次迭代过程 |

2 实验对比 2.1 实验准备

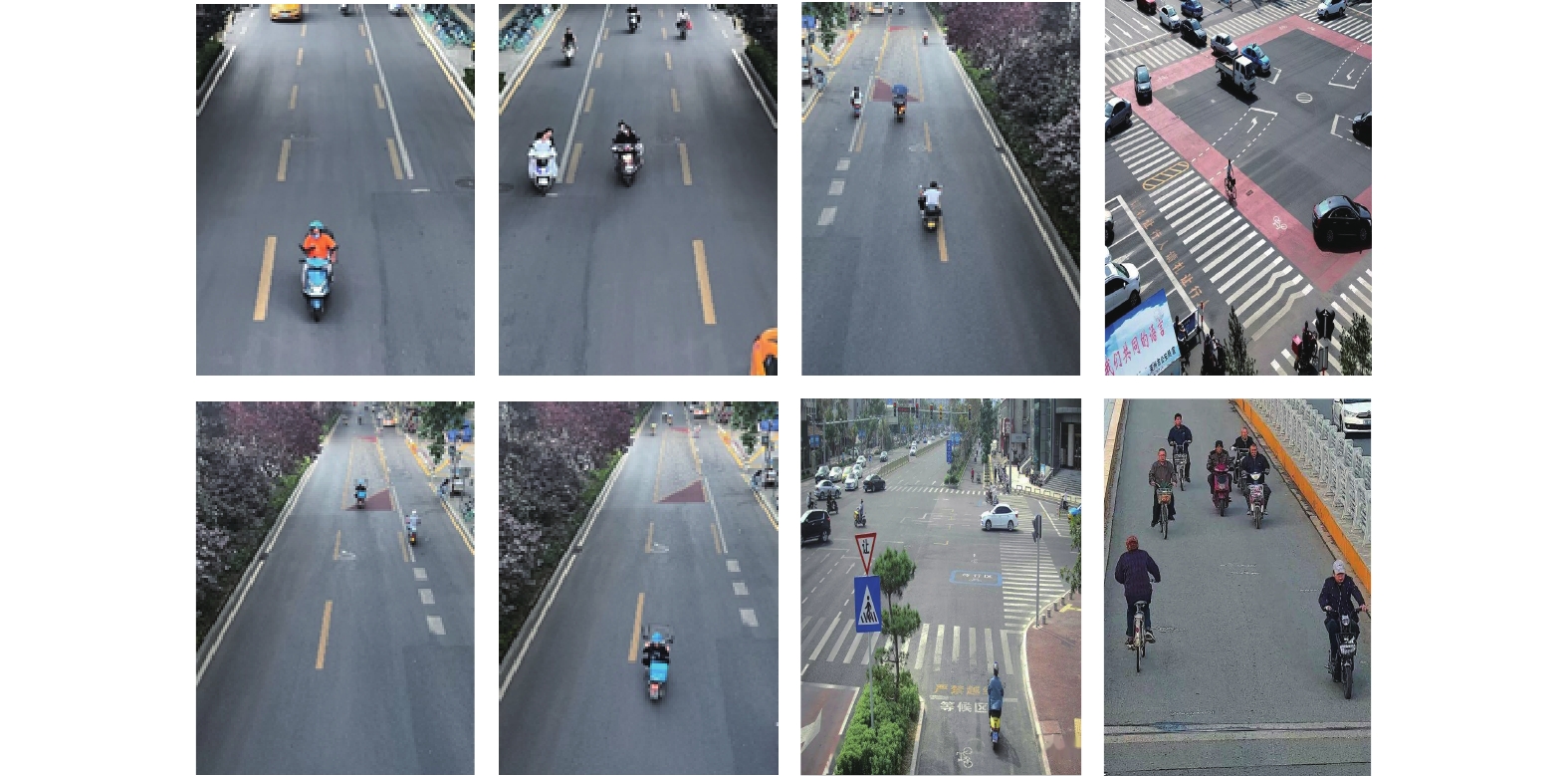

为证明优化后模型的性能, 提取使用Pascal VOC2007开源数据集中的motorbike和bicycle这两类进行训练测试. 同时由于我国的交通环境的复杂, 现有的开源公共数据集不能满足本次实验全部需求, 故通过网络爬虫, 实地拍摄等方式获取大量有关非机动车的图片数据建立新的数据集, 该自制数据集中包含大量各类电动车, 自行车图片. 通过使用labeling工具人工方式进行标注, 统一标注为nm-vehicle, 共使用12 000张图片作为本次检测识别任务的训练集和测试集, 其中用于训练图片9 600张, 用于验证测试图片2 400张, 比例设置为8:2. 图9为自制非机动车数据集中部分图片.

|

图 9 自制非机动车数据集 |

本次模型验证主要在Ubuntu系统上对YOLOv5基础源码上实验分析, 针对非机动车检测识别的问题对原有算法进行不同的优化和调试. 具体实验环境如表1所示.

本文实验使用到的评价指标如下: mAP(平均精度)、precision (精准率)、recall (召回率)、mAP@0.5(IoU=0.5时的平均精度)、mAP@0.5:0.95 (在不同IoU阈值(IoU在0.5–0.95之间, 步长为0.5的平均精度), FPS(图片每秒传输帧率). 各指标计算方式如下:

| precision=TPTP+FP | (5) |

| recall=TPTP+FN | (6) |

| AP=∫recall0(precision)drecall | (7) |

| mAP=1NN∑i=1AP | (8) |

| FPS=FrameNumElapsedTime | (9) |

其中, TP表示实际为正样本标签而且被预测为正样本的数量, FP表示实际是正样本但被预测为负样本的数量,

| 表 1 实验环境 |

2.2 主干更换实验

为了验证改进后模型的可行性和有效性, 本文在自制的非机动车数据集中分别进行Faster R-CNN算法, SSD算法, YOLOv3算法, YOLOv4算法, YOLOv5s算法和YOLOv5s-MobileNetV3算法验证, 将本文算法与上述流行的目标检测算法进行对照. 图片输入根据基础算法要求均调整为640×640, 批次处理大小batch_size设置为16, 初始学习率为0.01, 衰减系数设置为0.000 5, 优化器为SGD, 训练次数设为200轮. 训练后其各项性能指标如表2所示 .

可见, 经过改进主干后的YOLOv5s网络在IoU=0.5的设定下达到几乎和YOLOv4相持平的

| 表 2 不同算法各性能指标 |

|

图 10 平均精度对比 |

在上述对比图中仅对3种不同主干网进行对比, 以此推断改进后的性能. 从图10不难看出使用MoblieNet-V3改进后的特征提取模块效果最差, 在200个epoch后精度仍然偏低, 其原CSPDarknet网络和改进后的CSPVOvNet网络在精度上不容易看出太大差别, 但其收敛速度改进后的网络明显优于原网络, 且在mAP@0.5:0.95这张图中原YOLOv5s网络精度随着epoch的增加后期开始出现下降趋势, 存在过拟合的现象.

2.3 DCN嵌入对比实验本部分的实验在公开数据集Pascal VOC2007和自制数据集上分别进行验证, 在VOC2007数据集中直接使用motorbike和bicycle两类进行训练测试, 在自制数据集仅划分nm-vehicle这一类进行训练测试. 实验均不使用预训练模型, 4种测试算法训练过程均使用相同的参数配置, 输入图片大小为640×640, epoch设置为200轮, batch_size设置为16, 优化器为SGD, 权重初始学习率设为0.01, 衰减系数设置为0.000 5, IoU设定为0.5, 随机划分训练和测试集比例为8:2. 测试结果如表3所示. 通过表3可以看出DCN添加不同位置和不同数据集上的效果, YOLOv5-A将P2层普通3×3卷积和前两个CSP-VovNet中的1×1卷积替换为3×3可变形卷积, 其性能与原YOLOv5s算法同比在VOC2007和自制非机动车量数据上均有明显下降, YOLOv5-C在VOC2007上的精准率precision比原始算法提升了4%,

| 表 3 4种不同DCN添加方式测试结果 |

2.4 消融实验

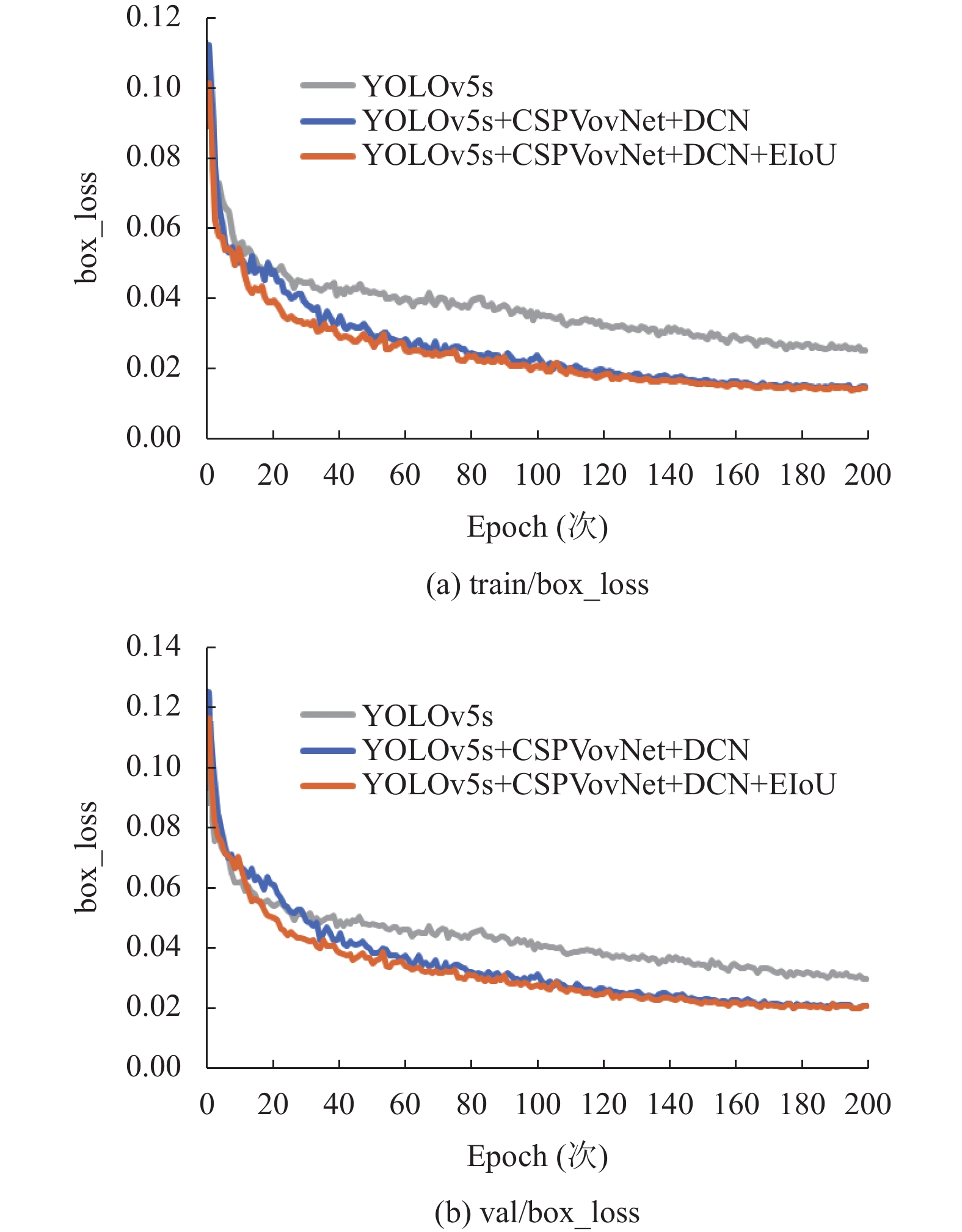

在原YOLOv5s算法的基础上在非机动车辆数据集进行消融实验, 验证各模块改进后的性能表现, 图片输入大小仍为640×640, 批次处理大小batch_size设置为16, 初始学习率为0.01, 衰减系数设置为0.000 5, 优化器为SGD, 训练次数设为200次. 实验数据如表4所示. 通过表4中的实验a (YOLOv5s), 实验b (YOLOv5+CSPVovNet+DCN)和实验c (YOLOv5+CSPVovNet+DCN+EIoU)可以验证其损失函数更换为EIoU_loss效果, 图11为3种实验在训练集和验证集上回归损失的收敛结果.

| 表 4 消融实验 |

从图11中我们可以看到实验b和c对比原始的YOLOv5s算法其最终损失值更低, 效果更佳优越. 实验c的不同在于将实验a和b中的回归损失CIoU换成EIoU, 可以清楚看出无论在训练集还是验证集上选取EIOU作为回归损失其收敛速度都更快, 性能更好. 由表4实验a, b对照看出CSPVovNet结构取代CSPDarknet作特征提取其平均精度

|

图 11 不同损失函数在train和val中训练结果 |

|

图 12 可视化结果 |

3 结束语

本文提出了一种基于YOLOv5网络改进的非机动车检测识别算法, 将YOLOv5中特征提取网络CSPDarknet53更换为CSPVovNet网络, 根据VovNet网络核心思想改进的CSPVovNet能够充分有效地加强特征传递, 改善因多层卷积造成的特征缺失, 提高输入目标特征图浅层特征复用的同时, 能够缓解因深层网络带来的梯度消失的问题. 针对交通监控场景下非机动车呈现的多角度多尺度问题, 引入可变形卷积, 通过实验对比选取最佳的添加位置, 提升了网络定位目标的能力. EIoU用于目标的回归损失的计算, 直接将宽高差值作为惩罚项, 加快收敛速度的情况下, 同时解决了CIoU只能同时增减的缺点. 实验表明, 本文提出的改进算法相较于YOLOv5s原始的算法在mAP指标上提升了4.14%, 能够一定程度上减少漏检, 误检的现象, 其算法的时空复杂度均能够满足实际交通场景下的移动部署和实时检测要求. 后续, 增加非机动车种类, 扩充数据集, 引入跟踪算法进一步解决遮挡问题, 改进用于交通场景下的非机动车各类违规行为识别判定.

| [1] |

Tian DX, Zhang C, Duan XT, et al. The cooperative vehicle infrastructure system based on machine vision. Proceedings of the 6th ACM Symposium on Development and Analysis of Intelligent Vehicular Networks and Applications. Miami: ACM, 2017. 85–89.

|

| [2] |

Drożdż M, Kryjak T. FPGA implementation of multi-scale face detection using HOG features and SVM classifier. Image Processing & Communications, 2017, 21(3): 27-44. |

| [3] |

Dalal N, Triggs B. Histograms of oriented gradients for human detection. Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego: IEEE, 2005. 886–893.

|

| [4] |

Felzenszwalb PF, Girshick RB, McAllester D, et al. Object detection with discriminatively trained part-based models. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645. DOI:10.1109/TPAMI.2009.167 |

| [5] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [6] |

He KM, Zhang XY, Ren SQ, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 |

| [7] |

Girshick R. Fast R-CNN. Proceeding of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 1440–1448.

|

| [8] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [9] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37.

|

| [10] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 779–788.

|

| [11] |

Redmon J, Farhadi A. YOLO9000: Better, faster, stronger. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 779–788.

|

| [12] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [13] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [14] |

Dahiya K, Singh D, Mohan CK. Automatic detection of bike-riders without helmet using surveillance videos in real-time. Proceedings of the 2016 International Joint Conference on Neural Networks (IJCNN). Vancouver: IEEE, 2016. 3046–3051.

|

| [15] |

路雪, 刘坤, 程永翔. 一种深度学习的非机动车辆目标检测算法. 计算机工程与应用, 2019, 55(8): 182-188, 214. DOI:10.3778/j.issn.1002-8331.1801-0199 |

| [16] |

Zitnick CL, Dollár P. Edge boxes: Locating object proposals from edges. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 391–405.

|

| [17] |

叶佳林, 苏子毅, 马浩炎, 等. 改进YOLOv3的非机动车检测与识别方法. 计算机工程与应用, 2021, 57(1): 194-199. DOI:10.3778/j.issn.1002-8331.2005-0343 |

| [18] |

Huang G, Liu Z, van der Maaten L, et al. Densely connected convolutional networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2261–2269.

|

| [19] |

Lee Y, Hwang JW, Lee S, et al. An energy and GPU-computation efficient backbone network for real-time object detection. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Long Beach: IEEE, 2019. 756–760.

|

| [20] |

Zheng Z, Wang P, Liu W, et al. Distance-IoU loss: Faster and better learning for bounding box regression. Proceedings of the 2020 AAAI Conference on Artificial Intelligence. 2020, 34(7): 12993–13000.

|

| [21] |

Howard A, Sandler M, Chen B, et al. Searching for MobileNetV3. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 1314–1324.

|

2023, Vol. 32

2023, Vol. 32