2. 海南医学院, 海口 571199

2. Hainan Medical University, Haikou 571199, China

全球蚊虫种类3600多种, 其中伊蚊、按蚊、库蚊是最危险的蚊种, 伊蚊能传播登革热、黄热病等, 按蚊能传播疟疾, 库蚊能传播流行性乙型脑炎等. 随着全球气候的变暖, 城市化进程的加快, 旅游和贸易的快速发展, 生态环境的不断恶化, 全球蚊媒传染病发病呈上升趋势, 原有疾病的流行区域不断扩展, 疾病的流行频度不断增强[1]. 蚊媒疾病广泛流行于全球多个国家和地区, 给人类健康和社会经济发展造成重大危害[2]. 世界卫生组织(WHO)表示, 昆虫学设备的研究是应对全球虫媒病毒爆发的关键方法, 虫媒病毒目前影响世界至少80%的人口, 估计每年感染率达3.9亿人[3]. 针对蚊媒疾病在世界广泛性的流传, 各种蚊媒疾病的疫苗处于试验时期, 采取蚊虫的监测与预防蚊媒疾病的工作是有必要的. 蚊虫的鉴定工作中, 需要专业人员操作专业的仪器, 这种方法费时费力, 且参与蚊虫监测工作中的人员并非都具备很高的蚊虫鉴定水平和经验, 这些方面都会增加蚊虫监测活动的成本. 为此, 提出一种蚊虫自动化分类的方法, 有助于提高蚊虫鉴定的效率, 减少工作人员的劳动力, 降低成本, 并为蚊媒疾病的预防提供帮助.

近年来, 人工智能和机器学习呈现爆发式发展势头, 在诸多领域取得重要研究成果, 在医学和公共卫生领域的应用也逐渐增多[4]. 研究人员利用机器学习和深度学习的方法对病媒蚊虫进行了自动化分类研究, 以此解决人工蚊虫鉴定的负担. 蚊虫自动化分类分为音频特征和视觉特征两种. 在音频特征方面, Fernandes等[5]提出使用卷积神经网络的音频分类检测埃及伊蚊, 通过智能设备记录的蚊虫翼拍音频对成年埃及伊蚊进行分类, 利用卷积神经网络训练了二分类器、多分类器和集成二分类器, 其中, 二分类器取得了97.65%的高准确率. 但该方法是在噪声较小的实验室环境中获取蚊虫翼拍音频, 因此分类器在有噪声的真实环境中效率可能会降低. 另外, 获取蚊虫翼拍音频成本较高, 不适合推广.

在视觉特征方面, Fuad等[6]和Sanchez-Ortiz等[7]提出使用深度卷积神经网络训练埃及伊蚊幼虫图像数据集, 分别微调了ImageNet[8]预训练模型Inception-V3[9]和AlexNet[10], 两者取得了较高的准确率, 能区分埃及伊蚊幼虫和非埃及伊蚊幼虫, 但两者实验的数据集是在实验室环境下获取, 应用到实际环境当中比较困难. Park等[11]微调了VGG-16[12]、ResNet50[13]、SqueezeNet[14] 这3种ImageNet预训练模型, 在对包括8个类别成年蚊虫的图像数据集进行数据增强的情况下, 模型最高准确率达到97%, 但实验的一部分数据集是在实验室环境下采集, 数据集通用性不够强, 在真实环境可能会出现偏差.

Motta等[15]利用3 种卷积神经网络LeNet[16]、AlexNet、GoogLeNet[17]对埃及伊蚊、白纹伊蚊和库蚊图像进行从头训练, 通过设置不同的损失函数和学习率进行对比, 在验证阶段, LeNet的蚊子分类准确率为57.5%, AlexNet为74.7%, GoogLeNet为83.9%. 在测试阶段, 使用GoogLeNet获得了最佳结果为76.2%; 使用LeNet和AlexNet分别获得52.4%和51.2%的结果, 其实验蚊虫样本均在野外采集, 但从头训练整个网络的收敛效果并不好, 总体的准确率不高. 洪铭鸿[18]提出基于边缘计算和深度学习开展病媒蚊虫的分类鉴定研究, 该方法对伊蚊和库蚊的验证准确率高达98%, 测试准确率达到90.5%, 但其方法需要去除蚊虫图像的背景, 避免图像噪声干扰, 在真实环境中应用会有所偏差.

蚊子警报(Mosquito Alert)公民科学平台[19], 是西班牙的一个小型学术机构开发的一款完全开源的用于鉴别携带疾病蚊虫的智能手机应用, 该平台利用公民用户拍摄上传蚊虫图像并由专家进行鉴定, 其蚊虫图像保留了真实背景, 符合真实环境, 图像通用性较强. 针对西班牙的环境, Pataki等[20]和Adhane等[21]微调了ImageNet预训练模型ResNet50、VGG16仅对蚊子警报平台的白纹伊蚊进行了自动化分类, 前者通过比较ROC、AUC曲线以及对应的准确率曲线, 表明了随着数据集数量增大, 模型的分类准确率也将提高; 后者通过5折交叉验证方法, 模型平均测试准确率达到了94%, 但平台的库蚊和埃及伊蚊并没有用模型进行分类, 无法应用到更多的蚊虫分类环境当中.

得益于蚊子警报平台蚊虫图像的通用性, 本文将利用该平台由专家鉴定的白纹伊蚊、埃及伊蚊以及库蚊3个类别的蚊虫图像构建数据集, 受限于平台的埃及伊蚊数据太少, 本文将基于迁移学习, 在少量数据集下采用K折交叉验证的方法为ResNet18[13]、DenseNet121[22]、MobileNetV2[23]这3种模型选择合适的超参数, 初步检验模型在少量数据集下的性能, 然后利用选择好的超参数在数据集上重新训练模型, 最后通过训练好的模型进行预测评估模型的实际表现.

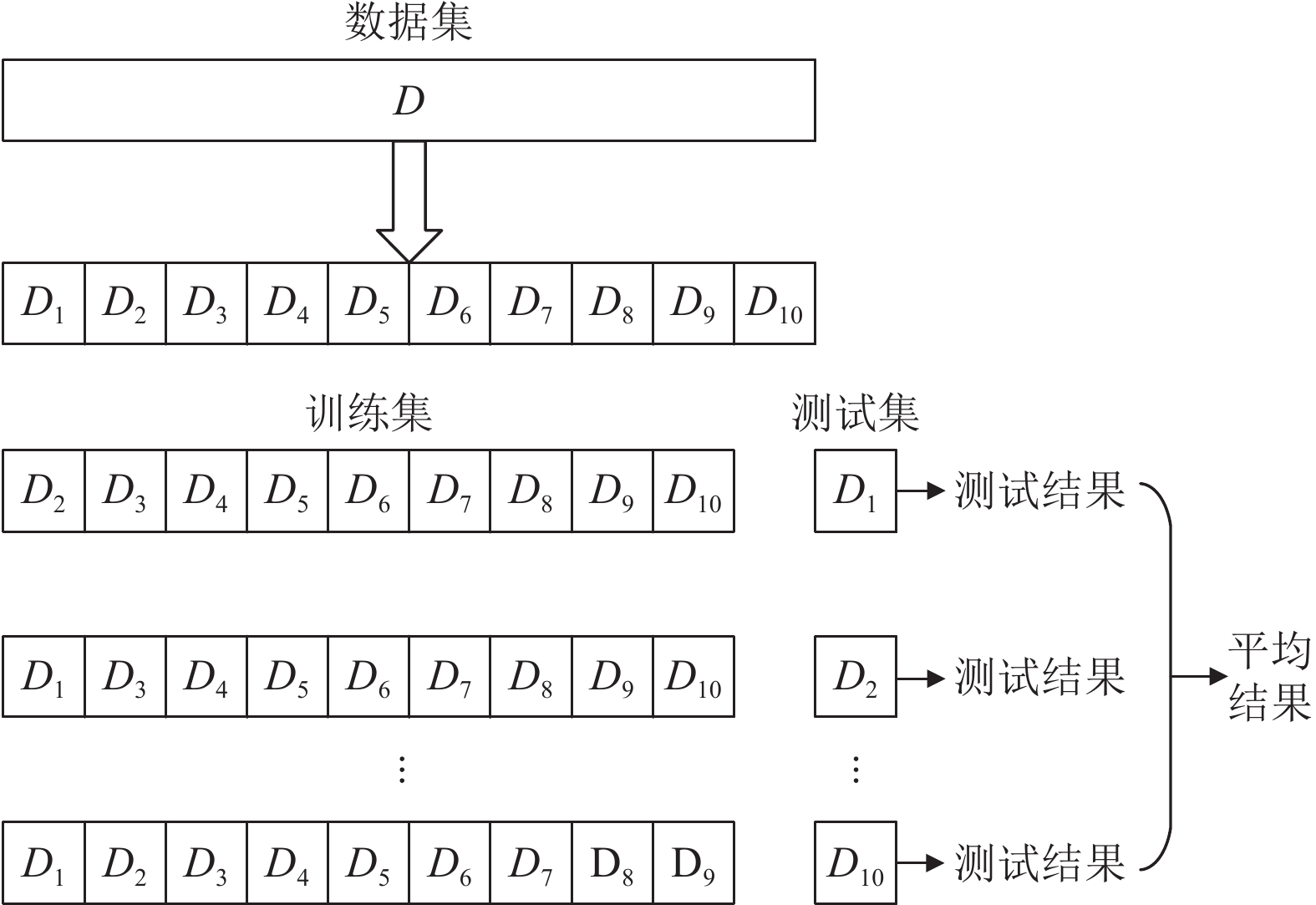

1 基本原理 1.1 K折交叉验证K折交叉验证(K-fold cross-validation)[24-26]适合用于数据集较少情况, 将数据集随机划分为样本数量近乎相等的k个子集, 每次不重复的抽取1个子集作为测试集, 其余的k–1个子集作为训练集, 共进行k次实验, 计算每次实验的准确率、损失等评价指标, 最终取k次实验评价指标的平均值来评估模型的性能. 相关研究表明,k值越大, 评估准确性越高, k为5或10时在评估准确性和计算复杂性下综合性能最优[26]. 本文实验采用10折交叉验证方法, 示意图如图1所示.

|

图 1 10折交叉验证示意图 |

1.2 迁移学习

迁移学习 (transfer learning)[27]中通常需要微调(fine-tuning)[28, 29] 预训练模型, 使得模型适配自己的数据集. 模型微调示意图如图2所示, 模型微调流程如下.

|

图 2 模型微调示意图 |

1) 在源数据集(如ImageNet)上预训练一个神经网络模型, 为源模型.

2) 创建一个与预训练模型相同的神经网络模型, 导入预训练参数.

3) 修改目标模型的分类层为目标数据集的类别个数, 并随机初始化分类层的模型参数.

4) 在目标数据集上训练目标模型, 从头训练目标模型的分类层, 前层根据预训练模型参数进行微调.

2 蚊虫特征介绍及模型选择 2.1 蚊虫特征介绍蚊虫的身体分为头、胸、腹3部分, 其胸部的图案是最明显的特征之一, 是专家对其进行分类的标准之一, 而腿部通常也是关注点, 本文分类的3种蚊虫的胸部和腿部特征如图3所示(图片来源: http://www.mosquitoalert.com/en/info-mosquitoes/disease-transmitting-mosquitoes/).

|

图 3 蚊虫胸部、腿部特征图 |

图3(a)白纹伊蚊是一种小的颜色为黑色的蚊子, 可以通过①胸部的一条白线来识别, ②腿部为黑色且带有白色斑点; 图3(b)埃及伊蚊是一种颜色为深褐色的蚊子, 可以通过①胸部的像琴形状的4条白线来识别, ②腿部有白色条纹; 图3(c)库蚊是一种浅棕色或者稻草黄色的蚊子, ①胸部不像伊蚊那样具有明显的特征, ②腿部是黑色且均匀的. 图3中可见白纹伊蚊和埃及伊蚊相似度很高.

2.2 模型选择深度学习中, 随着神经网络的卷积层和池化层的叠加, 网络并没有出现学习效果越来越好的情况, 预测效果反而越来越差, 出现了网络退化以及梯度爆炸和梯度消失的问题, 文献[13]提出通过数据的预处理以及在网络中使用BN (batch normalization)层来解决梯度爆炸和梯度消失问题, 在网络中添加残差模块人为地让神经网络隔层相连, 弱化每层之间的强联系, 不仅提升了网络的预测效果, 而且解决了网络退化的问题. 残差结构如图4所示.

DenseNet建立的是前层与后层的密集连接, 通过特征在通道(channel)上的连接来实现特征重用, 这种密集连接为密集块, 让DenseNet在参数和计算成本更少的情形下实现比ResNet更优的性能. 密集模块如图5所示.

|

图 4 残差模块 |

|

图 5 密集模块 |

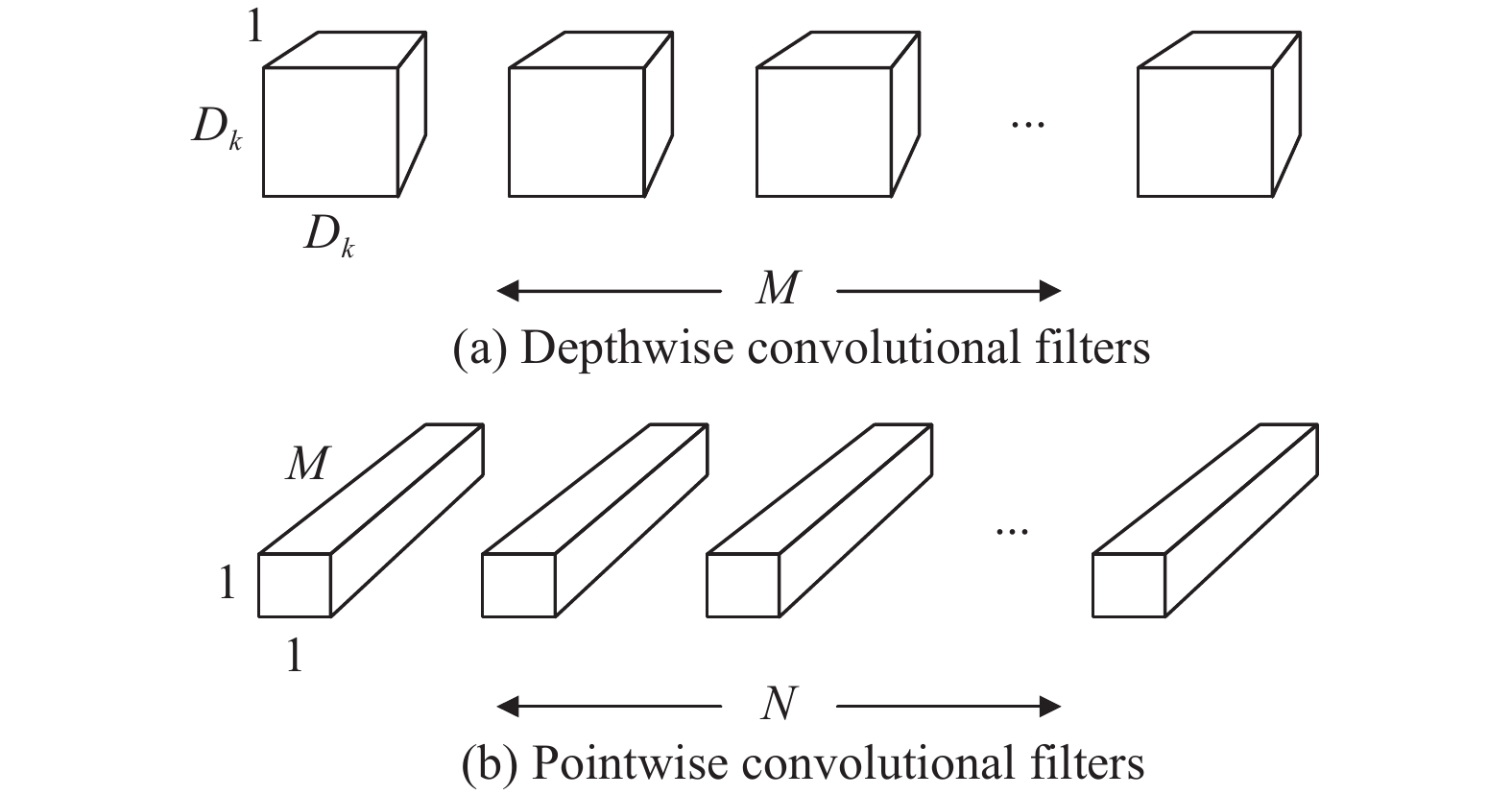

MobileNet基于流线型架构, 是将标准的卷积分解为深度卷积和称为点卷积的1×1卷积, 其为深度可分离卷积, 以此来构建轻量级深度神经网络, 用于移动和嵌入式视觉应用. 该网络引入了两个简单的全局超参数: 宽度乘数和分辨率乘数, 可以有效地在延迟和准确性之间进行权衡. 深度可分离卷积如图6所示.

|

图 6 深度可分离卷积 |

随着深度学习的不断发展, ResNet、DenseNet、MobileNet已经成为主流的神经网络, 被用于计算机视觉的各种任务当中, 因此本文将使用这3种不同结构的网络进行病媒蚊虫的分类.

3 实验与分析 3.1 实验准备本文实验数据集为蚊子警报公民科学平台的1 244张蚊虫图像, 随机抽取900张蚊虫图像进行10折交叉验证实验, 其中埃及伊蚊图像、白纹伊蚊图像和库蚊图像各300张, 由于埃及伊蚊图像数量过少, 故添加了从网络中搜集的部分图像, 并使用图像增强仅对埃及伊蚊图像进行水平、垂直翻转、旋转操作, 不改变埃及伊蚊固有的特征. 余下的344张蚊虫图像用于模型的最终预测, 其中152张白纹伊蚊图像、92张埃及伊蚊图像、100张库蚊图像. 图像数据集均为平台用户上传, 尺寸大小不一, 在进行数据预处理时, 先按比例把图像最小的一个边长缩放到256, 然后从图像中心处剪裁为统一的224×224大小, 最终使用z-score将图像特征进行归一化处理, 使得图像特征的平均值和标准偏差分别为0和1, 计算如下:

| $ {\textit{z}} = \frac{{{{x}} - \mu }}{\sigma }\;\;\;\; $ | (1) |

其中, μ和

|

图 7 保留真实背景的白纹伊蚊(第1行)、埃及伊蚊(第2行)、库蚊(第3行)图像 |

考虑到较大模型参数量的网络在少量数据集下可能会降低模型的通用性, 故选用较小模型参数量的ResNet18、DenseNet121、MobileNetV2进行实验. 本文实验微调的3种预训练模型均使用随机梯度下降(stochastic gradient descent, SGD)作为优化器, 损失函数采用交叉熵损失(cross entropy loss), 动量设置为0.7, 防止损失函数在训练的过程中陷入局部最小值, 权重衰减系数设置为0.001, 减少模型过拟合的问题. 实验计划在训练25个epochs后停止, batch size设置为16, 初始学习率设置为0.001, 使用固定步长(StepLR)使得学习率在每7个epochs后衰减为初始学习率的0.1倍, 模型分类层的类别个数修改为3分类, 与前人实验不同的是, Adhane等[21]微调模型时, 对于模型的所有层都使用一个较小的学习率进行训练, 这可能使得训练出来的分类器的效果并不好, 本实验将修改后的分类层学习率设置为初始学习率的10倍, 其他层使用较小的初始学习率.

实验GPU为AutoDL的RTX A5000, 显存为24 GB, CUDA版本11.3, PyTorch版本1.11.0, Python版本3.8.

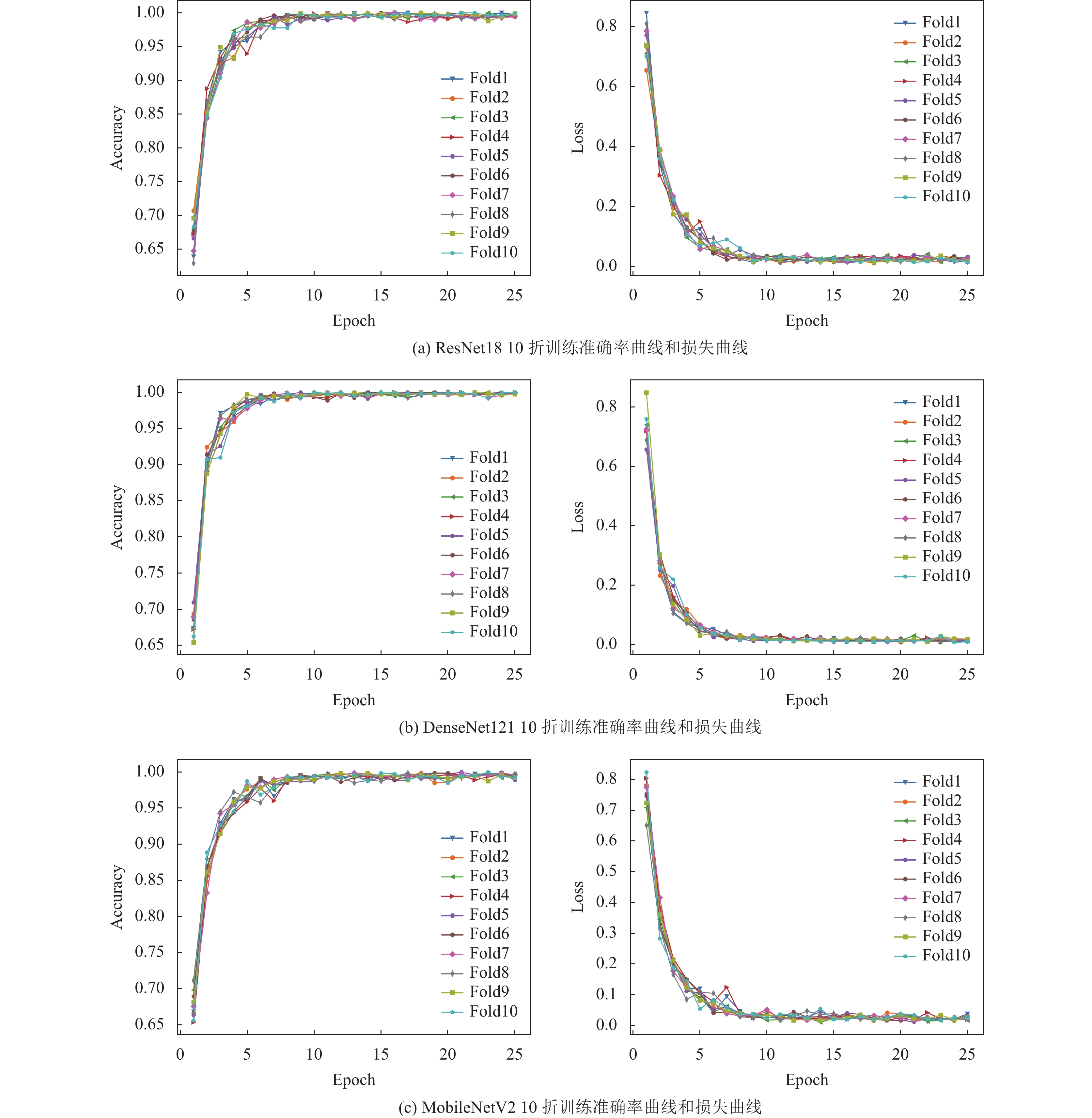

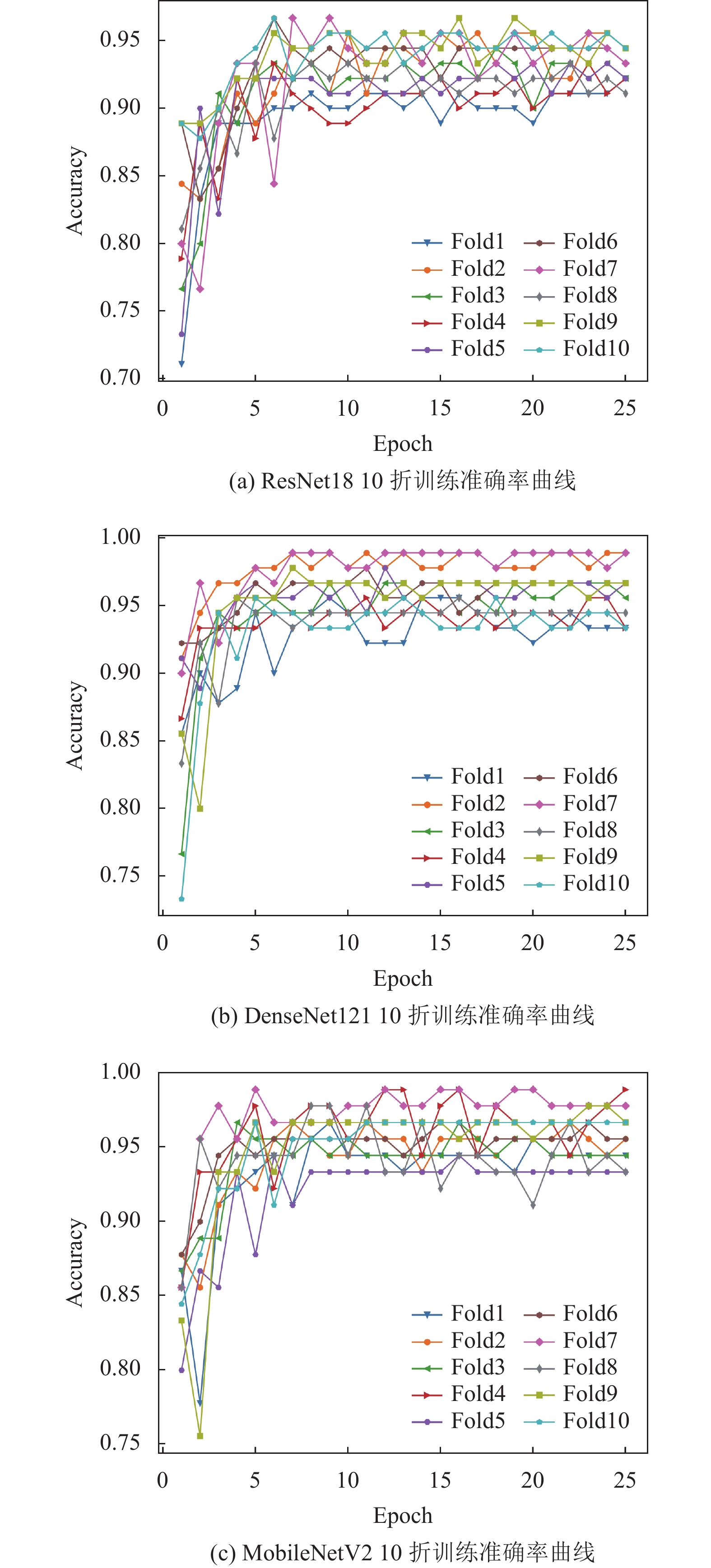

3.2 对比实验 3.2.1 10折交叉验证实验首先通过10折交叉验证评估ResNet18、DenseNet121、MobileNetV2三种模型在900张少量蚊虫图像数据集上的表现, 取95%的置信度, 计算模型在训练集和测试集上的平均峰值准确率置信区间和平均损失, 对比结果如表1所示, 另外, 记录3种模型每一折的训练准确率曲线和训练损失曲线如图8所示, 测试准确率曲线如图9所示.

| 表 1 模型在训练集和测试集上的平均准确率和平均损失 |

|

图 8 3种模型在10折交叉验证下的训练准确率曲线和训练损失曲线 |

|

图 9 3种模型在10折交叉验证下的测试准确率曲线 |

结合表1和图8分析, 3种训练模型在10个epochs之后逐渐收敛, 可见, 利用迁移学习进行模型微调, 于少量数据样本下能使模型快速的收敛, 在95%置信度下, 平均训练准确率保持在98%–99%之间, 3种模型在训练集表现相当, 训练损失在0.01–0.04之间小范围波动, 模型每一折的准确率曲线和损失曲线几乎重合, 说明为模型选择的超参数可以使得模型在少量数据集下能保持稳定的收敛, 曲线没有较大的上下振荡, 验证了为模型选择的超参数的可行性. 从测试准确率看, 3种模型平均准确率能达到95%及以上, 初步检验了3种模型在少量数据集下能取得很好的分类性能. 另外, 在95%置信度下, 模型的平均训练准确率误差和平均测试准确率误差分别在0.04–0.08之间和0.2–0.3之间, 误差区间较小, 整体而言, 3种模型能在少量数据集下保持对蚊虫较高的分类准确率. 在平均训练准确率几乎相同的情况下, 对比3种模型的平均测试准确率, DenseNet121和MobileNetV2比ResNet18高2%, 初步说明, 10折交叉验证下, DenseNet121和MobileNet-V2在少量数据集中的模型分类能力要明显高于ResNet18.

图9展示了3种模型在10折交叉验证实验下的每一折的测试准确率曲线, 结合表1可以直观看出, 3种模型虽然能取得较高的平均测试准确率, 但仍然有部分测试准确率曲线波动较大的现象, 少量数据集会给不同的模型带来不同程度的模型泛化能力的影响, 总体上, 3种模型测试准确率曲线逐渐达到一个最大值, 最后在最大值附近上下波动. 从每一折曲线最后达到的准确率看, DenseNet121、MobileNetV2准确率能达到95%以上, 而ResNet18准确率在95%附近及以下, 10折交叉验证每一折划分的数据集对模型的分类性能影响较大, 结合训练准确率分析, ResNet18训练准确率与测试准确率有较明显的偏差, 受到少量数据集的影响较大, 直观地说明在此实验中DenseNet121、MobileNetV2表现优于ResNet18.

同样使用交叉验证方法, 在训练相同的25个epochs之内, 本文交叉验证实验的平均测试准确率与Adhane等[21]交叉验证实验的平均测试准确率进行对比, 如表2所示.

| 表 2 本文与Adhane等[21]微调的VGG16和ResNet50平均测试准确率对比(%) |

表2中, 可以看出, 本文分别设置网络前层和分类层以不同的学习率, 其中分类层学习率为前层的10倍, 与Adhane等[21]设置前层与分类层相同的学习率相比, 在训练相同epochs之内, 本文微调ResNet18、DenseNet121、MobileNetV2三种模型的平均测试准确率均高于前者微调VGG16和ResNet50的平均测试准确率, 可见, 分类层设置比前层较大的学习率, 在一定程度上能提高网络的预测效果. 在交叉验证期间, 前者对白纹伊蚊的平均测试准确率仅在94%左右, 本文对3种蚊虫的总体最高平均准确率在97%, 最低也在95%左右, 从而间接地提高了对每一种蚊虫的平均测试准确率, 通过对比, 说明实验设置网络前层和分类层以不同的学习率是可行的, 有效地提高了对蚊虫的预测效果.

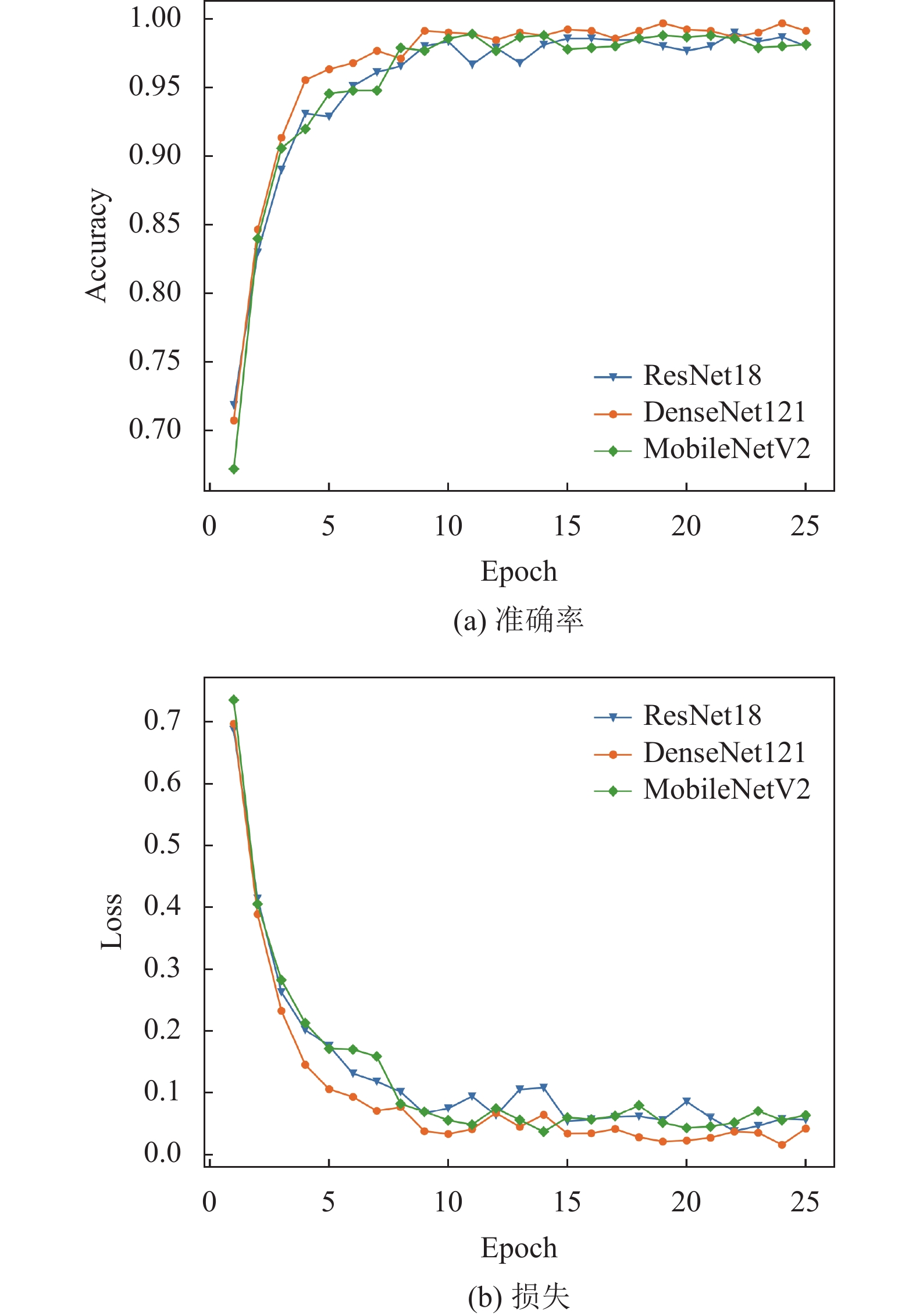

3.2.2 模型预测10折交叉验证已经验证了为模型选取的超参数的可行性, 且3种模型都表现良好, 故实验最后取10折交叉验证的模型超参数, 在整个900张蚊虫数据集上进行训练, 保存训练模型, 最后在344张蚊虫图像中进行预测, 用于评价模型的实际表现, 记录3种模型的训练准确率曲线和损失曲线如图10所示.

|

图 10 ResNet18、DenseNet121、MobileNetV2在900张蚊虫图像数据集上的训练准确率曲线和损失曲线 |

模型预测评价标准: 深度学习分类当中, 训练后的网络在测试集上进行测试, 通常可以通过以下指标进行定量评估: 精准率(precision,P)、召回率(recall, R)、F1 score (F1), 计算公式如下:

| $ {{P}} = \frac{{{{TP}}}}{{{{TP}} + {{FP}}}}\;\;\;\; $ | (2) |

| $ {{R}} = \frac{{{{TP}}}}{{{{TP}} + {{FN}}}}\;\;\;\; $ | (3) |

| $ {{F}}1 = 2 \times \frac{{{{P}} \times {{R}}}}{{{{P}} + {{R}}}}\;\;\;\; $ | (4) |

其中, TP、FP、FN分别表示真阳性、假阳性和假阴性. 本文实验为3分类, 分别计算每一类的精准率和召回率, 取3类精准率和召回率的平均值作为最终的精准率和召回率, 最后计算F1, 另外给出3种模型的参数量进行对比, 如表3所示.

| 表 3 模型参数量、精准率、召回率、F1对比 |

结合图10和表3分析, 图10中, 3种模型在整个900张蚊虫数据集上最终训练准确率都在95%以上, 10个epochs之后逐渐收敛, 而表3中, 对比3种模型预测的精准率、召回率和F1, ResNet18的实际预测表现未能达到训练时的预期值, DenseNet121和Mobile-NetV2的3个指标明显高于ResNet18, 再结合3个模型的参数量的大小可以得出, 少量数据集对ResNet18的模型泛化能力影响较大, 在少量数据集下应当选择更小参数量的模型进行训练, 避免少量数据集影响模型的泛化能力. 另外, 在精准率相同的情况下, 对比DenseNet121和MobileNetV2的召回率和F1可以看出, MobileNetV2表现优于DenseNet121, 且3种指标达到了0.95, 说明少量数据集对MobileNetV2的模型泛化能力影响较小.

3.3 预测结果分析为进一步分析3种模型预测的最终精准率和召回率的影响因素, 找出模型对3类蚊虫分类出现的偏差, 对比3种模型预测的每一类蚊虫的精准率和召回率, 其中ResNet18预测的3类蚊虫精准率和召回率用P0和R0表示; DenseNet121预测的3类蚊虫精准率和召回率用P1和R1表示; MobileNetV2预测的3类蚊虫精准率和召回率用P2和R2表示, 如表4所示.

| 表 4 具体的精准率和召回率结果 |

表4中, 观察3种模型预测的召回率结果, 对埃及伊蚊预测的召回率结果分别达到了0.95、0.97、0.98, 3种模型在埃及伊蚊的样本当中对埃及伊蚊的分类效果较好; 对库蚊的预测的召回率结果分别为0.93、0.90、0.91, 3种模型在库蚊的样本当中对库蚊的分类效果一般; ResNet18在白纹伊蚊的样本当中预测的召回率结果仅为0.89, 说明该模型把白纹伊蚊预测成另外两种蚊虫的样本数量较多, 导致整体预测偏差较大, 结合ResNet18对3种蚊虫预测的精准率看, 这种较大的偏差降低了模型对3种蚊虫预测的精准率, 说明白纹伊蚊对ResNet18的预测结果影响相对较大. DenseNet121和MobileNetV2对白纹伊蚊预测的召回率结果分别为0.96、0.95, 两种模型在白纹伊蚊样本当中对白纹伊蚊的分类效果较好, 结合两种模型对埃及伊蚊、白纹伊蚊预测的精准率和召回率的结果看, 两种模型对埃及伊蚊和白纹伊蚊的预测效果较好. 反观DenseNet121和MobileNetV2对库蚊的预测精准率分别达到了0.95、0.96的较高水平, 而召回率只有0.90、0.91, 说明两种模型的预测结果受库蚊影响相对较大.

利用3种模型预测结果的混淆矩阵可以直观地得出模型分类的情况, 用于评判模型的优劣, 混淆矩阵如表5–表7所示.

| 表 5 ResNet18预测结果混淆矩阵 |

从3种模型预测结果的混淆矩阵看, 模型能预测正确大部分的蚊虫样本, 其中3种模型在未知蚊虫样本上对于白纹伊蚊的预测准确率和Adhane等[21]实验进行对比, 如表8所示.

| 表 6 DenseNet121预测结果混淆矩阵 |

| 表 7 MobileNetV2预测结果混淆矩阵 |

| 表 8 本文模型对白纹伊蚊预测效果与Adhane等[21]对比结果(%) |

表8中, 本文改变以往的模型微调方式, 设置模型分类层学习率为前层学习利率的10倍, 与Adhane等[21]对比, DenseNet121和MobileNetV2对于白纹伊蚊的预测准确率在95%以上, 比Adhane等[21] VGG16的预测准确率提高了5%–6%, 说明本文实验模型微调的方式即使在少量数据集下也能使模型的收敛效果比前人的更佳, 提高了模型预测的准确率.

通过混淆矩阵, 计算ResNet18、DenseNet121、MobileNetV2对3种蚊虫的总体预测准确率分别为91.57%、94.48%、94.77%, DenseNet121和MobileNetV2预测效果相当, 由于测试样本数据不平衡, 其最终的预测准确率会受到样本数量多的蚊虫类别的影响, 但结合表3中最终的预测精准率、召回率、F1综合评价, MobileNetV2的3个指标都在0.95, 高于ResNet18和DenseNet121, 相较之下, MobileNetV2在少量数据集下表现更稳定, 而MobileNetV2的特点是更轻量化, 速度快, 也适合在移动端使用, 使得蚊虫的分类更加便捷. 综上, 本文实验的3种模型中, MobileNetV2在保持较高精准度的情况下, 在少量数据集下表现更好.

4 结论与展望针对传统的病媒蚊虫鉴定工作的繁琐, 且成本较高, 本文提出了深度学习下的病媒蚊虫分类的方法. 首先在900张蚊虫图像数据集上, 利用迁移学习对ResNet18、DenseNet121、MobileNetV2三种模型使用10折交叉验证方法, 检验了3种模型在少量数据集下可以取得很好的性能表现, 最后利用3种模型在整个900张蚊虫图像数据集上重新训练, 并用344张蚊虫图像检验3种模型的真实预测能力, 结合最终的预测精准率、召回率以及F1, MobileNetV2表现最佳, 能对白纹伊蚊、埃及伊蚊、库蚊3种蚊虫进行较高精准度的分类.

本文实验具有两大特点.

1)基于迁移学习, 使用10折交叉验证方法, 验证了模型在少量数据集下也能取得较好的预测效果, 能解决模型在少量数据集下不收敛的问题.

2)改变了以往的模型微调方式, 设置模型前层和分类层以不同的学习率, 与Adhane等[21]设置模型所有层为相同的学习率相比, 对白纹伊蚊的分类准确率提高了5%–6%, 进一步提高了蚊虫的分类效果.

本文实验所用蚊虫图像保留了真实的环境背景, 通用性较强, 在前人的基础上进一步扩展了蚊虫分类的类别数量, 使得实验训练的模型适用于更多的蚊虫分类环境, 从而可以在病媒蚊虫的鉴定工作当中配合工作人员使用, 降低成本和提高工作效率, 并为蚊媒疾病的预防提供帮助, 具有一定的社会意义. 由于本文实验的蚊虫类别只有3类, 受现有数据样本的限制, 其他能传播病毒的蚊虫并没有加入, 蚊虫因其种类的复杂, 体积小, 不同的蚊虫之间也有高度相似的特征, 在识别上有一定的难度, 下一步将搜集更多的蚊虫种类样本, 以细粒度病媒蚊虫的分类为重点, 进一步扩展蚊虫分类的适用环境.

| [1] |

余向华. 蚊媒传染病流行特征及气象影响因素研究[硕士学位论文]. 杭州: 浙江大学, 2007.

|

| [2] |

王朝阳, 陈小芳, 程功. 媒介蚊虫唾液蛋白调控蚊媒病毒传播的研究进展. 中国媒介生物学及控制杂志, 2021, 32(6): 653-659. DOI:10.11853/j.issn.1003.8280.2021.06.001 |

| [3] |

WHO. Global vector control response 2017–2030. https://apps.who.int/iris/bitstream/handle/10665/259205/9789241512978-eng.pdf

|

| [4] |

孙燕群, 张守刚, 赵姗姗, 等. 机器学习在蚊虫及蚊媒传染病研究中的应用进展. 中国媒介生物学及控制杂志, 2021, 32(4): 503-508. DOI:10.11853/j.issn.1003.8280.2021.04.024 |

| [5] |

Fernandes MS, Cordeiro W, Recamonde-Mendoza M. Detecting Aedes aegypti mosquitoes through audio classification with convolutional neural networks

. Computers in Biology and Medicine, 2021, 129: 104152. DOI:10.1016/j.compbiomed.2020.104152 |

| [6] |

Fuad MAM, Ab Ghani MR, Ghazali R, et al. Training of convolutional neural network using transfer learning for Aedes aegypti larvae

. Telkomnika, 2018, 16(4): 1894-1900. DOI:10.12928/telkomnika.v16i4.8744 |

| [7] |

Sanchez-Ortiz A, Fierro-Radilla A, Arista-Jalife A, et al. Mosquito larva classification method based on convolutional neural networks. Proceedings of the 2017 International Conference on Electronics, Communications and Computers (CONIELECOMP). Cholula: IEEE, 2017. 1–6.

|

| [8] |

Russakovsky O, Deng J, Su H, et al. ImageNet large scale visual recognition challenge. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y |

| [9] |

Szegedy C, Vanhoucke V, Ioffe S, et al. Rethinking the inception architecture for computer vision. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2818–2826.

|

| [10] |

Krizhevsky A, Sutskever I, Hinton GE. ImageNet classification with deep convolutional neural networks. Communications of the ACM, 2017, 60(6): 84-90. DOI:10.1145/3065386 |

| [11] |

Park J, Kim DI, Choi B, et al. Classification and morphological analysis of vector mosquitoes using deep convolutional neural networks. Scientific Reports, 2020, 10(1): 1012. DOI:10.1038/s41598-020-57875-1 |

| [12] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv:1409.1556, 2014.

|

| [13] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [14] |

Iandola FN, Han S, Moskewicz MW, et al. SqueezeNet: AlexNet-level accuracy with 50× fewer parameters and < 0.5 MB model size. arXiv:1602.07360, 2016.

|

| [15] |

Motta D, Santos AÁB, Winkler I, et al. Application of convolutional neural networks for classification of adult mosquitoes in the field. PLoS One, 2019, 14(1): e0210829. DOI:10.1371/journal.pone.0210829 |

| [16] |

LeCun Y, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 |

| [17] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 1–9.

|

| [18] |

洪铭鸿. 基于边缘计算和深度学习之病媒蚊分类系统[硕士学位论文]. 台北: 台湾师范大学, 2019.

|

| [19] |

Mosquito Alert: A citizen platform for studying and which transmit global diseases controlling mosquitos. http://www.mosquitoalert.com/en/. [2022-09-10].

|

| [20] |

Pataki BA, Garriga J, Eritja R, et al. Deep learning identification for citizen science surveillance of tiger mosquitoes. Scientific Reports, 2021, 11(1): 4718. DOI:10.1038/s41598-021-83657-4 |

| [21] |

Adhane G, Dehshibi MM, Masip D. A deep convolutional neural network for classification of Aedes albopictus mosquitoes

. IEEE Access, 2021, 9: 72681-72690. DOI:10.1109/ACCESS.2021.3079700 |

| [22] |

Huang G, Liu Z, van der Maaten L, et al. Densely connected convolutional networks. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 4700–4708.

|

| [23] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520.

|

| [24] |

Yadav S, Shukla S. Analysis of k-fold cross-validation over hold-out validation on colossal datasets for quality classification. Proceedings of the 6th IEEE International Conference on Advanced Computing (IACC). Bhimavaram: IEEE, 2016. 78–83.

|

| [25] |

Wong TT, Yeh PY. Reliable accuracy estimates from k-fold cross validation

. IEEE Transactions on Knowledge and Data Engineering, 2020, 32(8): 1586-1594. DOI:10.1109/TKDE.2019.2912815 |

| [26] |

Rodriguez JD, Perez A, Lozano JA. Sensitivity analysis of k-fold cross validation in prediction error estimation

. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(3): 569-575. DOI:10.1109/TPAMI.2009.187 |

| [27] |

庄福振, 罗平, 何清, 等. 迁移学习研究进展. 软件学报, 2015, 26(1): 26-39. DOI:10.13328/j.cnki.jos.004631 |

| [28] |

赵凯琳, 靳小龙, 王元卓. 小样本学习研究综述. 软件学报, 2021, 32(2): 349-369. DOI:10.13328/j.cnki.jos.006138 |

| [29] |

Cetinic E, Lipic T, Grgic S. Fine-tuning convolutional neural networks for fine art classification. Expert Systems with Applications, 2018, 114: 107-118. DOI:10.1016/j.eswa.2018.07.026 |

2023, Vol. 32

2023, Vol. 32