2. 东莞理工学院 计算机科学与技术学院, 东莞 523808

2. School of Computer Science, Dongguan University of Technology, Dongguan 523808, China

半导体晶圆生产需要经历拉单晶、切片、磨片、抛光、增层、光刻、掺杂、热处理、针测以及划片等生产工序, 不可避免在这些生产过程中出现表面缺陷. 因此, 半导体晶圆表面缺陷检测就变得非常重要. Wu等人[1]用真实的晶圆图像构建了一个公开晶圆数据集WM-811K, 他们提出了基于拉冬变换特征和支持向量机的方法实现对晶圆的缺陷进行分类. 在WM-811K上测试集的准确率为94.63%. Yu等人[2]提出了一种结合局部和非局部线性判别分析的方法来进行晶圆图缺陷检测与识别. Piao等人[3]提出了一种基于拉东变换特征和决策树的晶圆缺陷识别方法, 在WM-811K上的识别准确率为78.43%. Nakazawa等人[4]提出了一种使用卷积神经网络的方法进行晶圆缺陷的分类, 它在合成晶圆图像上的准确率为98.2%, 但在对191个真实的晶圆图像测试过程时各类正确率在66.7%和100%之间. Kim等人[5]提出了一种基于神经网络的bin着色方法, 称为Bin2Vec, 这种方法可以对晶圆图像进行更加方便的识别和确认缺陷. Saqlain等人[6]提出了一种具有多种机器学习方法的投票集成分类器, 包括逻辑回归、随机森林、梯度提升机和人工神经网络, 它在WM-811K真实数据集的准确率为95.86%. Ishida 等人[7]提出了一种基于VGG的分类网络, 在所提出的方法中, 提出了一种基于降噪的数据增强技术, 该技术很好地改善了数据集标签不平衡的问题. Nakazawa等人[8]使用了一个降低权重的全卷积网络, 该网络基于编码器解码器架构, 可以检测和分割晶圆图上的缺陷图案. Kyeong等人[9]提出了一种卷积神经网络模型, 用于对晶圆图像的单一缺陷或混合缺陷进行分类. 他们还开发了多个模型, 每个模型都分类一个特定的缺陷类别, 这种方法将花费大量的运算时间. Cheon等人[10]提出了一种卷积神经网络模型, 可以从真实晶圆图像中提取特征, 并将输入数据准确分类为5个不同的晶圆缺陷类别. 该模型在将卷积神经网络模型与K最近邻算法相结合后, 还可以对未知缺陷的类别进行分类. Yu等人[11]提出了一种基于增量学习的晶圆表面缺陷检测方法并在实验过程中采用ResNet作为骨干网络. Gómez-Sirvent等人[12]提出了一种基于特征向量的方法, 它首先采用计算机视觉的技术将缺陷从背景中分离出来, 然后通过缺陷的形状、大小、纹理等信息来创建一个用于描述缺陷的特征向量, 最后通过支持向量机分类器来对特征向量进行评估. Chauhan等人[13]提出了一种基于卷积神经网络的分类器, 对晶圆图像中两种不同的缺陷进行分类, 使用较小的训练数据取得了较高的检测精度. Wei等人[14]针对混合型晶圆缺陷识别提出了一种新的多尺度信息融合和Transformer相结合的模型, 通过多尺度信息融合网络来关注晶圆的详细特征, 通过Transformer网络中的多头注意力机制对晶圆图像的全局上下文特征进行编码, 从而对晶圆图像和缺陷类型之间的关系进行建模, 最终实现对混合型晶圆缺陷的识别. Wei等人[15]提出了一种基于多面动态卷积的混合型缺陷检测模型, 主要是采用了一个一维的自编码器来处理输入的信息并将其扩展到三维, 再通过通道合并机制来合并跨通道信息. 为了更好地解决这一复杂的实际问题, 本文提出了一种基于深度可分离卷积和注意力机制的端到端的轻量级缺陷检测模型, 它以更小的参数量和运算量达到较高的识别准确度.

1 数据集 1.1 WM-811K数据集介绍WM-811K数据集是一个半导体晶圆数据集, 来源于真实环境, 它是目前世界上最大的可公开访问的晶圆图像数据集, 包括811 457张真实世界的晶圆图像. 这些图像是从46 293个批次中收集的, 每个批次包括25幅晶圆图像, 因此总共应该为1 157 325幅晶圆图像. 但是由于传感器故障和一些未知的原因, 造成某些批次的晶圆图像空缺, 因此最终只获得了811 457张晶圆图像. 该数据集除了包括晶圆图像的信息和缺陷类别的信息外, 还包括批次名称、晶圆尺寸、训练标签、测试标签等额外信息. 该数据集有共有632种不同尺寸的晶圆图像, 范围从(6×21)到(300×202). WM-811K的数据集虽然有811 457张晶圆图像, 但是有标签的图像只有172 950张. 带有标签的晶圆图像类别共有9种, 具体分布如表1所示. Center缺陷类别的晶圆图像有4 294张, 占有标签图像的2.5%; Donut缺陷类别的晶圆图像有555张, 占有标签图像的0.3%; Edge-Loc缺陷类别的晶圆图像有5 189张, 占有标签图像的3.0%; Edge-Ring缺陷类别的晶圆图像有9 680张, 占有标签图像的5.6%; Loc缺陷类别的晶圆图像有3 593张, 占有标签图像的2.1%; Random缺陷类别的晶圆图像有866张, 占有标签图像的0.5%; Scrath缺陷类别的晶圆图像有1 193张, 占有标签图像的0.7%; Near-full缺陷类别的晶圆图像有149张, 占有标签图像的0.1%; None缺陷类别的晶圆图像有147 431张, 占有标签图像的85.2%. 晶圆图像具体的缺陷类型如图1所示.

1.2 WM-811K数据集预处理由于在训练模型时, 必须把输入图像的尺寸调整为相同的大小以供模型使用. 但是WM-811K数据集的图像尺寸大小是不相等的, 因此需要先将图像调整为(128×128), 以供模型使用. 原始的晶圆图像是单通道的, 每一个像素值都是一个状态变量, 共有0、1、2这3种状态: 0表示未知状态, 1表示正常状态, 2表示缺陷状态. 然后对每个像素值采用独热的方式进行编码, 将单通道的图像扩展为三通道的图像. 由于缺陷类别标签是不平衡的, 因此对于独热编码后的图像数据进行数据增强. 本文实验中, 对于数据增强后的图像每个标签各取10 000张图像, 用做本次的实验数据. 然后对每类标签数据各取80%用于训练集, 10%用于验证集, 10%用于测试集.

| 表 1 WM-811K数据集晶圆图像不同缺陷类别的数量分布 |

|

图 1 晶圆图像不同类型的缺陷 |

1.3 WM-811K数据集数据增强

从表1可知, WM-811K带有标签的图像的数量是非常不平衡的, 这将严重影响模型的训练结果, 使模型的准确率大幅度降低. 为了解决类别标签不平衡的问题, 我们对图像采用了随机旋转, 调整分辨率、对比度、饱和度, 增加随机噪声, 改变透明度等方法进行数据增强, 使数据各个类别的标签达到平衡, 提高模型分类的准确率.

2 模型介绍当用神经网络解决图像分类任务时几乎都采用简单的卷积堆叠的方式进行模型设计, 这样的方式往往不能获得很高的准确率, 达不到实际生产和生活中的要求. 本文为了解决晶圆表面缺陷检测这一实际问题, 将深度可分离卷积[16]和注意力机制[17]相结合, 并在模型中运用了残差网络, 同时使用了ReLU6作为激活函数. 这些改进使模型在晶圆缺陷数据集上达到了很好的分类效果.

2.1 深度可分离卷积深度可分离卷积是将普通的卷积操作分成了两个过程, 分别是逐通道卷积和逐点卷积.

逐通道卷积, 就是先对每个通道进行单独的卷积, 相当于在一个二维平面上进行卷积, 每个卷积核的通道数为1, 此时卷积核的数量与上一层的通道数相同. 由于逐通道卷积的特性, 当卷积结束以后得到的输出数据与输入数据只是在宽高维度上发生了, 通道数仍然相等. 因为逐通道卷积只是在宽高的维度上面进行卷积, 每个通道都是独立运算的, 并没有利用通道间的信息, 因此需要逐点卷积对通道间的空间信息进行处理.

逐点卷积, 就是运用1×1×C的卷积核对所有通道间的信息进行整合处理,C为上一层输出的通道数, 因此这里就是将逐通道得到的输出在通道的维度上面进行加权求和.

当进行完逐点卷积和逐通道卷积后, 输入数据的通道位置信息和空间位置信息都得到了有效的利用, 且模型实现了普通卷积核的功能. 但深度可分离卷积与普通卷积相比, 大大降低了参数量和运算量, 因此使用深度可分离卷积可以极大地减少模型运行的内存占用量, 并提高神经网络模型的推理速度.

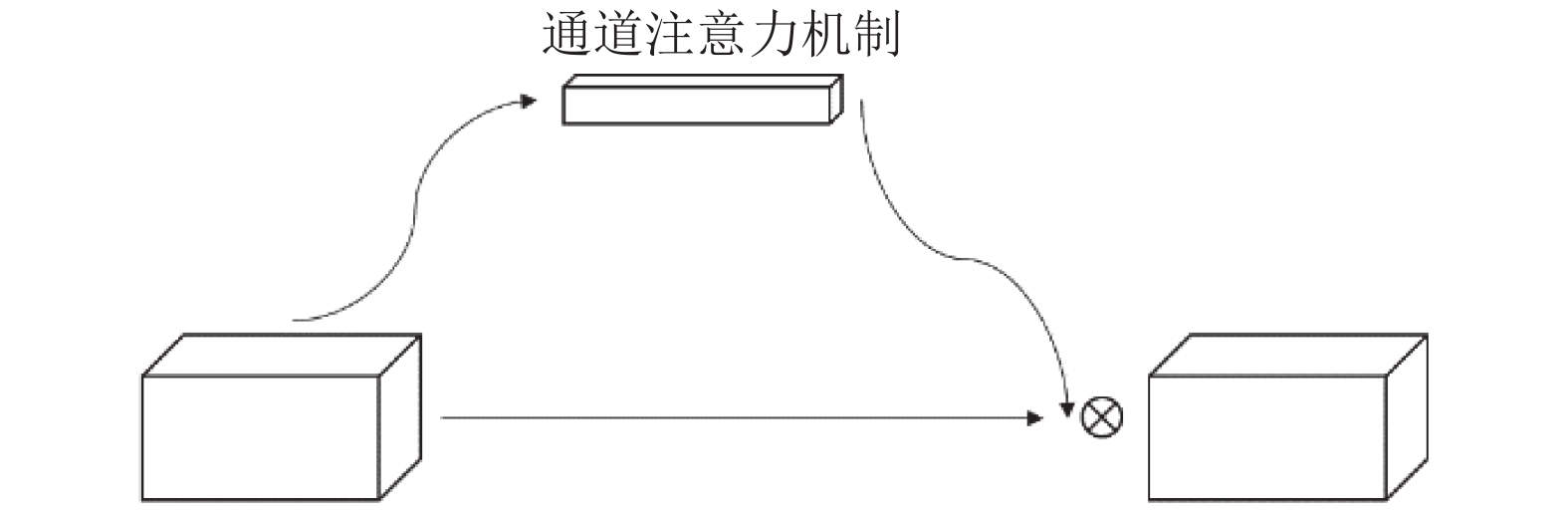

2.2 通道注意力机制通道注意力机制是一种采取权值的方式使其对特征层的通道信息更加关注的网络结构. 该模块的每一个通道都会在训练后得到一个对应的权值. 具体结构如图2所示.

通道注意力机制首先对输入的单个特征层进行全局平均池化, 得到1×1×C1的通道信息,C1为特征层的通道数. 然后对得到的通道信息做一个神经元较少的全连接, 再做一次和输入特征层通道数相等的全连接, 从而获得每个通道对应的权值. 通过对通道注意力机制的训练, 产生的权值就代表模型对不同通道的关注程度. 然后把训练得到的权值与输入特征层按照通道对应一一相乘, 从而获得更好的对于图像分类的有用信息, 从而提高模型的分类性能.

|

图 2 通道注意力机制示意图 |

2.3 ReLU6激活函数

经过ReLU激活函数后的数值范围是0到正无穷, 这样就有可能造成权值之间相差过大, 从而降低模型的精度. ReLU6激活函数是在ReLU函数的基础上进行了改进, 把经过激活函数的数值固定到0到6这个范围中. 该操作可以缓解ReLU造成权值范围相差过大的现象, 有效地防止了数值爆炸. 其表达式可表示为:

| f(x)={0,x⩽0x,0<x<66,x⩾6 | (1) |

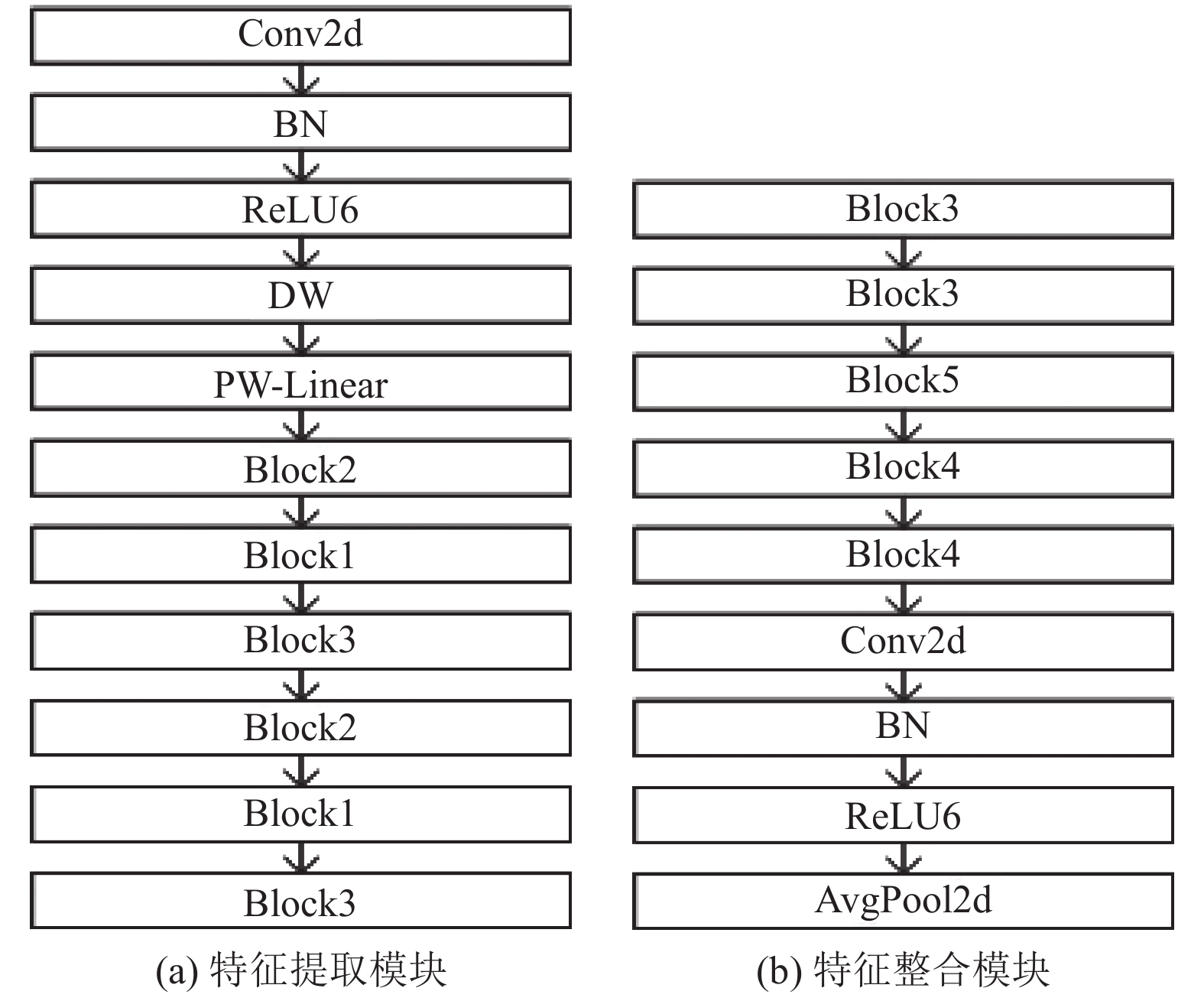

本文的数据集是一个具有9种缺陷类别的标记数据集, 每种类别根据缺陷的不同特征进行区分. 为了解决这个缺陷分类问题, 本文提出了一种端到端的半导体晶圆缺陷检测模型. 该模型主要运用了深度可分离卷积和通道注意力机制, 并配合残差网络的思想, 对部分网络层进行残差连接, 模型结构如图3所示. 首先, 模型对输入的图像进行特征提取, 然后把提取到的特征输入到通道注意力机制模块, 使模型更加关注图像中有缺陷的区域, 再把从通道注意力机制输出的信息输入特征整合模块和全连接层, 最后输入图像的缺陷类别. 特征提取和特征整合模块如图4(a)和图4(b)所示.

|

图 3 模型整体结构图 |

|

图 4 模型核心模块结构图 |

图4中各主要模块如表2所示. Block1和Block2都采用双分支结构, 一个分支进行深度可分离卷积, 另外一个分支进行普通的卷积, 然后对两个分支的卷积结果进行特征融合. 这里需要注意的是, 为了保证两个分支卷积后的输出特征能够进行特征融合, 两个分支都必须要进行相同的下采样. Block3借鉴了ResNet的残差结构以加快模型的优化速度, 其中跳跃连接有效防止模型增加深度带来梯度消失问题的发生. Block4和Block5只采用了深度可分离卷积并进行了不同程度的下采样, 使用这种结构可以大大降低模型的参数量, 加快模型的训练速度和推理速度.

模型整体结构和参数如表3所示. 首先对输入图像进行卷积, 增加数据的通道数, 并进行下采样. 然后通过深度可分离卷积的Block1、Block2和Block3分别对得到的数据进行特征提取, 使用通道注意力机制获取对模型训练更有利的特征. 接下来使用Block3、Block4、Block5对数据进行处理, 最后使用全局平均池化和全连接层输出各个类别的预测分数. 模型全部采用了ReLU6激活函数.

| 表 2 模型的主要模块 |

| 表 3 提议的深度模型参数 |

3 实验及结果 3.1 实验过程

本次实验所用的数据集共有9个类别, 每个类别10 000张晶圆图像, 共计90 000张. 然后把数据集按照8:1:1的比例划分成训练集、验证集和测试集, 分别在VGG16[18]、MobileNetv2[19]、ANN、SVM[20]和本文提出的模型上面进行训练、验证和测试. 在模型训练阶段, 图像的输入大小为3×128×128, 学习率为1E−4, 批量大小为32.

本文对每个模型训练20个epoch, 前10个epoch使用Adam梯度优化器, 后10个epoch的训练使用SGD梯度优化器. 这是由于Adam优化器的特性可以使模型快速收敛, SGD优化器可以对模型的参数进行微调, 提高模型的准确率. 如表4所示, 在实验中证明, 先使用Adam梯度优化器, 再使用SGD梯度优化器这种优化方案是正确的, 它既可以节省模型的训练时间, 也可以提高模型的准确率. 在使用Adam优化器进行训练时, 每一个epoch结束后得到的模型都使用验证集进行验证, 选择在验证集上准确率最高的模型进行后SGD优化器的训练. 同样在使用SGD优化器的训练中, 每一个epoch结束后也使用验证集验证. 最终选取在验证集上准确率最高的模型作为训练的结果. 在得到最优模型后, 使用测试集对模型的性能进行测试, 以获得准确率、精准率、召回率和F1分数等图像分类的指标, 以分析模型的性能.

| 表 4 使用不同梯度优化器在验证集上精度的变化(%) |

本文采用交叉熵损失作为损失函数, 其表达式为:

| losscross=−1C×N∑Ci∑Nj(yi,j×log(pi,j)) | (2) |

其中,

实验使用的深度学习框架为PyTorch 1.11, 解释器为Python 3.9. 该实验是在个人笔记本电脑上进行的, 操作系统为Windows 10, CPU为Intel(R) Core(TM) i5-7300HQ, 内存8 GB, GPU为NVIDIA GTX1050Ti, 显存为4 GB.

3.2 模型评价指标在图像分类任务中, 常见的评价指标为准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数(F1-score), 其表达式分别为:

| Accuracy=TN+TPFP+TN+TP+FN | (3) |

| Precision=TPTP+FP | (4) |

| Recall=TPTP+FN | (5) |

| F1-score=2×Precision×RecallPrecision+Recall | (6) |

其中,

将本文方法与VGG16、MobileNetv2、SVM、ANN等方法进行对比, 发现本文的方法在参数量、运行速度、准确率上都具有一定的优势. 从表5中可以看出, 除了SVM方法不能量化参数外, 在其余的4个模型中, 本文方法的参数量最低的, 但是却获得了最高的准确率, 与经典的轻量级网络MobileNetv2相比, 参数量只是它的73.5%, 但是准确率却比它高了0.7%. 在参数量方面, 本文方法的参数量也是最少的, 它只是VGG16计算量的0.48%, 是ANN计算量的0.62%, 是轻量级网络MobileNetv2计算量的28.6%. 本文的方法在计算量和参数量都处于最少的情况下, 却表现出最高的准确率, 这意味着本文的方法在同等的硬件条件下更有优势.

| 表 5 各个模型参数量、计算量、准确率对比 |

表6展示了所有模型的性能对比, 结果表明, 本文的方法除了测试集的正确率比VGG16和MobileNetv2低0.1%外, 在验证集、测试集、查准率、查全率、F1分数这几个性能上均获得了最高值, 分别为96.5%, 96.5%, 96.4%, 96.5%和96.5%. 对于实际应用来说, 模型在测试集上的正确率才是最具有价值的性能指标, 因为测试集是模型训练时没有用到的数据, 与模型的训练过程完全无关. 在测试集这一性能中, 仍然是本文提出的方法达到了更高的准确率. 虽然MobileNetv2在验证集上的正确率也高达95.8%, 只比本文提出的方法低了0.7%, 但是本文方法的参数量和计算量更低, 所以综合来看本文提出的方法更具有优势.

| 表 6 不同模型的准确率、查准率、查全率、F1分数对比(%) |

表7展示了不同模型对晶圆缺陷分类的精度对比, 从表7中可以清晰看出, 本文的模型在对于Center、Donut、Random、Scratch和Near-full类进行分类时, 准确率分别为97.9%, 100.0%, 96.7%, 100.0%, 99.1%和96.7%, 都高达96.0%以上. 虽然本文的方法对Edge-Loc、Local、None类别的正确率只有91.5%, 92.6%和94.0%, 但却是这几类模型中对该类缺陷类别分类正确率最高的. 但是对于Edge-Ring类别缺陷来说, VGG16的分辨率却获得了最高的正确率, 高达97.9%, 说明对于某一类缺陷来说, 某一模型可能会有更好的适应性. 从表7中还可以看出VGG16对于Local类别缺陷的正确分辨率只有74.9%, 与MobileNetv2和本文的模型相比分别低了14.8%和17.7%. SVM分类器在Edge-Loc、Scratch、Near-full、None类别上的正确分辨率只有54.3%、64.7%和45.1%. 在ANN模型中, Edge-Loc、Local、None的正确分辨率也不是很高, 分别只有77.2%、66.4%和79.2%. 本文的模型与MobileNetv2相比, 本文的方法虽然只有Edge-Loc和Near-full这两类的准确率高于MobileNetv2模型1.0%和2.1%, 但是仍然可以说明本文的方法具有比MobileNetv2模型更高的准确率.

为了能够更直观地看到本文的方法在测试集上各个类别的分类情况, 本文绘制了混淆矩阵, 如表8所示. 其中, 横轴代表预测标签, 纵轴代表真实标签. 每一行表示某类真实标签的晶圆图像被正确预测的类别数量和错误预测的类别数量, 以及被错误预测成某类类别的数量. 每一列表示哪些类别被预测成为该类缺陷类别, 哪些被错误的预测, 以及错误预测的数量. 并且从主对角线可以直观地看出每一个类被成功预测的数量. 从混淆矩阵中可以看出, 模型对Donut和Random类的正确分辨数量达到了100.0%, 对Scratch类的正确分辨数量达到99.1%, 都具有较高的正确率, 说明模型对这3类有很强的分辨能力. 但是在Edge-Loc类上的正确的分辨数量只有91.5%, Local和None类的正确分辨数量分别也只有92.6%和94.0%. 在Edge-Loc类中, 被错误分类成Local和None类的数量竟然高达2.3%和2.6%. 由于缺陷类别形状的原因, 给模型对这些类别的分辨造成了一定的困难, 又有一些晶圆图像上面有多种缺陷, 增加了模型识别的难度, 将一些类别与其他类别进行分类, 从而造成分类错误. 在Center、Edge-Ring和Near-full的正确分辨数量分别为97.9%, 96.7%和96.7%.

| 表 7 不同模型在各个缺陷类别上的正确率(%) |

| 表 8 本文模型的混淆矩阵(%) |

3.3.2 消融实验

在表9中, no_se_model表示在本文的方法上去掉注意力机制的模型, no_dpw_model表示在本文的方法上不使用深度可分离卷积的模型. 从表9中可以看出, 当不使用深度可分离卷积时, 虽然也能达到和使用深度可分离卷积的模型几乎相等的准确率, 但是参数量确实使用深度可分离卷积的12.3倍, 运算量是深度可分离卷积的14.9倍. 虽然使用注意力机制使模型的参数量增加了2.1%, 但是在运算量等同的条件下, 模型的准确率却提高了2.3%. 在实际生产过程中, 这种提升是非常有必要的.

| 表 9 是否使用深度可分离卷积和注意力机制对比 |

3.3.3 模型的收敛性分析

图5给出了所提模型在训练集和验证集上的准确率变化曲线. 可以看出, 模型在训练集和验证集上的准确率都呈现先上升后平稳的状态. 在训练集中, 模型的准确率在第14个epoch中达到最大值99.8%. 在验证集中, 模型的准确率在第16个epoch中达到最大值96.5%. 因此可以看出, 模型具有较强的收敛性, 可以通过较少的epoch迅速达到较高的准确率, 并保持相对稳定.

|

图 5 模型在训练集和验证集上准确率变化曲线图 |

4 结语

结合深度可分离卷积和注意力机制, 本文提出了一种端到端的轻量化半导体晶圆缺陷检测模型. 其中深度可分离卷积模块大大降低模型的参数量和运算量, 提高了模型的运算速度. 而注意力机制模块则提高了模型对缺陷分类的精度. 该方法在本次实验所运行的数据集上获得了不错的效果, 与其他模型相比大大降低了参数量和运算量, 但仍然保持较高的分类准确度.

| [1] |

Wu MJ, Jang JSR, Chen JL. Wafer map failure pattern recognition and similarity ranking for large-scale data sets. IEEE Transactions on Semiconductor Manufacturing, 2015, 28(1): 1-12. DOI:10.1109/TSM.2014.2364237 |

| [2] |

Yu JB, Lu XL. Wafer map defect detection and recognition using joint local and nonlocal linear discriminant analysis. IEEE Transactions on Semiconductor Manufacturing, 2016, 29(1): 33-43. DOI:10.1109/TSM.2015.2497264 |

| [3] |

Piao MH, Jin CH, Lee JY, et al. Decision tree ensemble-based wafer map failure pattern recognition based on Radon transform-based features. IEEE Transactions on Semiconductor Manufacturing, 2018, 31(2): 250-257. DOI:10.1109/TSM.2018.2806931 |

| [4] |

Nakazawa T, Kulkarni DV. Wafer map defect pattern classification and image retrieval using convolutional neural network. IEEE Transactions on Semiconductor Manufacturing, 2018, 31(2): 309-314. DOI:10.1109/TSM.2018.2795466 |

| [5] |

Kim J, Kim H, Park J, et al. Bin2Vec: A better wafer bin map coloring scheme for comprehensible visualization and effective bad wafer classification. Applied Sciences, 2019, 9(3): 597. DOI:10.3390/app9030597 |

| [6] |

Saqlain M, Jargalsaikhan B, Lee JY. A voting ensemble classifier for wafer map defect patterns identification in semiconductor manufacturing. IEEE Transactions on Semiconductor Manufacturing, 2019, 32(2): 171-182. DOI:10.1109/TSM.2019.2904306 |

| [7] |

Ishida T, Nitta I, Fukuda D, et al. Deep learning-based wafer-map failure pattern recognition framework. Proceedings of the 20th International Symposium on Quality Electronic Design (ISQED). Santa Clara: IEEE, 2019. 291–297.

|

| [8] |

Nakazawa T, Kulkarni DV. Anomaly detection and segmentation for wafer defect patterns using deep convolutional encoder-decoder neural network architectures in semiconductor manufacturing. IEEE Transactions on Semiconductor Manufacturing, 2019, 32(2): 250-256. DOI:10.1109/TSM.2019.2897690 |

| [9] |

Kyeong K, Kim H. Classification of mixed-type defect patterns in wafer bin maps using convolutional neural networks. IEEE Transactions on Semiconductor Manufacturing, 2018, 31(3): 395-402. DOI:10.1109/TSM.2018.2841416 |

| [10] |

Cheon S, Lee H, Kim CO, et al. Convolutional neural network for wafer surface defect classification and the detection of unknown defect class. IEEE Transactions on Semiconductor Manufacturing, 2019, 32(2): 163-170. DOI:10.1109/TSM.2019.2902657 |

| [11] |

Yu NG, Li X, Xu Q, et al. Research on wafer surface defect pattern detection method based on incremental learning. Journal of Physics: Conference Series, 2021, 2078: 012046. DOI:10.1088/1742-6596/2078/1/012046 |

| [12] |

Gómez-Sirvent JL, de la Rosa FL, Sánchez-Reolid R, et al. Optimal feature selection for defect classification in semiconductor wafers. IEEE Transactions on Semiconductor Manufacturing, 2022, 35(2): 324-331. DOI:10.1109/TSM.2022.3146849 |

| [13] |

Chauhan KK, Joshi G, Kaur M, et al. Semiconductor wafer defect classification using convolution neural network: A binary case. IOP Conference Series: Materials Science and Engineering, 2022, 1225: 012060. DOI:10.1088/1757-899X/1225/1/012060 |

| [14] |

Wei YX, Wang H. Mixed-type wafer defect recognition with multi-scale information fusion transformer. IEEE Transactions on Semiconductor Manufacturing, 2022, 35(2): 341-352. DOI:10.1109/TSM.2022.3156583 |

| [15] |

Wei YX, Wang H. Mixed-type wafer defect pattern recognition framework based on multifaceted dynamic convolution. IEEE Transactions on Instrumentation and Measurement, 2022, 71: 2511211. |

| [16] |

Sifre L, Mallat S. Rigid-motion scattering for texture classification. arXiv:1403.1687, 2014.

|

| [17] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [18] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv:1409.1556, 2014.

|

| [19] |

Sandler M, Howard A, Zhu ML, et al. MobileNetv2: Inverted residuals and linear bottlenecks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520.

|

| [20] |

Cortes C, Vapnik V. Support-vector networks. Machine Learning, 1995, 20(3): 273-297. |

2023, Vol. 32

2023, Vol. 32