图像翻译旨在将图像从一个域转换到另一个域. 随着生成对抗网络(generative adversarial network, GAN)[1]的兴起, 越来越多的研究将其应用于两个域之间的图像翻译, 并取得了较好的效果. 它们可以在差异较小的域(如马和斑马)之间进行有效翻译, 却很难在差异较大的域(如人脸和动画)之间高质量地翻译图像. 例如, 用于多域图像翻译的StarGAN v2[2]只需要映射纹理和颜色样式就可以轻松翻译面部风格(如面部表情、肤色和性别). 然而, StarGAN v2在两个差距较大域之间的图像翻译任务上表现一般. 一个合理的解释是这些翻译任务中存在复杂的外观变化: 即除纹理变换之外, 网络还需要夸大图像的局部结构, 将局部形状转化为目标域的相应样式.

注意力机制促使图像翻译网络在翻译过程中更加关注影响判断的区域, 因此一些研究[3-5]将注意力机制集成到模型中. ContrastGAN[3]通过调整对象实例的掩码实现对完整图像的注意力语义操作. UGATIT[5]将 CAM[6]作为辅助分类器来获取注意力图, 引导模型专注于类别判断区域. 然而, 这种注意力方法忽略了像素之间的关联, 从而导致生成的图像出现明显的特征失真, 如图1所示.

|

图 1 UGATIT生成的人脸扭曲图像 |

针对上述问题, 本文提出了一种用于图像翻译任务的多角度注意力(multi-angle attention, MA), 从多个角度考虑了注意力机制的聚焦能力. 与 UGATIT基于通道维度提取图像特征的方法不同, 本文否定了特征通道之间不相关的假设, 并强调隐藏激活神经元的权重与目标对象的空间相关性. 通过比较同一空间位置神经元的激活情况发现, 激活程度越高, 对最具判别力的区域分配的权重越大, 即网络对敏感区域的关注度越高. 本文还探索出相同的结构接受不同程度的空间激活, 性能存在明显差异. 对于生成器来说, 主要任务是捕获两个域之间最具判别性的区域, 必须更高程度地激活最大视差区域的特征, 以便获得足够的关注. 但是判别器需要从整体上判断生成图像的真实性, 而不是只关注对象的局部区域, 因此需要对判别对象的所有特征信息使用相同程度的激活. 为了使模型翻译出来的图像更多地具有目标域图像风格, 同时保留原始图像的内容, 本文采用VGG19作为特征提取网络, 以提取输入图像和生成图像的深度感知特征, 同时引入风格损失函数和内容重建损失函数, 并在风格损失函数中, 计算所提取特征的Gram矩阵[7]来衡量特征间的关系. 最终通过定性和定量分析证明了本文设计的模型能够在多个数据集上有效地翻译图像.

1 相关工作 1.1 生成对抗网络生成对抗网络(GAN) 凭借其巧妙的网络结构和损失函数, 在各种图像处理任务中取得了卓越的成绩, 包括图像生成[8-11], 图像翻译[12-15], 多模态图像合成[16, 17]等. GAN由生成器和判别器两个部分组成, 二者对抗训练, 将生成图像的分布逼近到与其对应的真实图像的分布. 为了改善生成图像的质量, 出现了一系列GAN的变体. 一方面, StyleGAN[9]能够控制所生成图像的高层次属性. 其升级版StyleGAN v2修复了StyleGAN生成图像中的特征伪影, 从而提高了生成图像的质量. 另一方面, StarGAN[18]超越了一对一翻译的限制, 以统一框架实现了一对多的转换.

1.2 图像翻译图像翻译任务使用的数据集包括配对数据集和非配对数据集. 对于配对数据集, pix2pix[19]通过对抗损失学习两个域之间的映射. 之后Wang等人[20]提出它的改进版, 用来完成高分辨率图像的翻译. 由于数据样本的配对是一项非常繁琐的工作, 因此使用非配对数据集训练网络的方式愈加受欢迎. CycleGAN[21]提出循环一致性损失, 首次实现以无监督的方式训练图像翻译网络. 为了实现多模态图像翻译, MUNIT[17]采用AdaIN[22]来合并内容和样式的编码.

1.3 注意力注意力可以促进网络感知影响性能的重要特征信息. SAGAN[23]将自注意力机制引入到图像生成网络, 提高了生成图像的质量. UGATIT使用CAM作为辅助分类器, 帮助图像翻译网络区分不同域图像的判别性区域. CAM通过全局平均池化操作, 使网络在分类训练过程中无需任何边界框标注即可完成目标定位. 为了更好地理解定位信息, CAM将输入图像的预测类别分数可视化, 突出显示网络捕获到的目标. 虽然该方法对完整物体的识别有积极的效果, 但它是基于每个通道提取特征, 并假设通道之间不相关. 此外, Zagoruyko等人[24]对决定网络判断的输入空间区域进行了编码, 该方法将网络的注意力集中在某一层次的特征上, 但未能成功定位完整的对象.

2 网络结构本文提出了结合生成对抗网络及多角度注意力的图像翻译模型(MAGAN), 其目标是训练生成器来学习具有未配对数据的两个域之间的相互映射. 具体来说, 设X和Y是两个不同的域, 给定

|

图 2 完整的网络架构 |

2.1 生成器

如图2(b)所示, 生成器由编码器E、解码器D和多角度注意力MA组成. 编码器提取输入图像的特征信息; 解码器从样式代码构造图像; 多角度注意力预测图像的类别概率并获得注意力特征图.

编码器E由3个卷积层和4个残差层组成. 它的输入是源图像x, 输出x的特征图

不仅同一通道的特征具有特定的关系, 而且不同通道之间的特征也存在密切的相关性. 忽略特征的空间相关性是翻译图像中存在特征扭曲的关键原因. 为了解决上述问题, 本文设计了一个多角度注意力

| ΓG(x)=Concat(ξα,ξβ,ξγ)=σ(∑nωn∑i,jθni,j) | (1) |

激活神经元的权重即为特征图的注意力权重. 一方面, 利用CAM分类器的权重信息对特征图

| aG(x)=Conv(aα,aβ) | (2) |

在图像翻译过程中, 解码器翻译前景对象的同时保留全局结构. 首先, 将多角度注意力输出的注意力特征图

|

图 3 多角度注意力(MA)的详细处理流程 |

2.2 判别器

如图2(c)所示, 判别器由编码器E、多角度注意力模块(MA)

对图像

| Φ(z)=Φ(aD(z))=σ(Conv(aD(z))) | (3) |

为了促进网络生成更高质量的图像并使整个网络训练更加稳定, 总的损失函数包括跨域对抗损失、风格损失、内容重建损失和类别损失. 其中, 风格损失使生成的图像具有目标域图像的纹理, 内容重建损失使生成的图像保留源图像的内容. 为了减少图像中噪声的干扰, 风格损失和内容重建损失是使用图像的特征图而不是图像本身来计算的. 使用预训练的VGG19作为感知网络来提取图像的高级语义特征.

2.3.1 跨域对抗损失给定图像

| Ladv(X,Y)=Ey∈Y[log(DY(Y))]+Ex∈X[log(1−DY(GY(x)))] | (4) |

本文引入风格损失函数

| Lstyle(X)=Ex∈X,y∈Y[||Mφi(x)−Mφi(GX(y))||1] | (5) |

其中,

在图像翻译任务中, 翻译后的图像通常会改变输入图像的内容语义信息. 为了避免这个问题, 使用内容重建损失函数

| Lrec(X)=Ex∈X[||φj(GX(GY(x)))−φj(x)||1] | (6) |

类别损失

| {LGYcate=Ex∈X,y∈Y[||ΓGY(x)−ΓGY(y)||1]LDYcate=Ex∈X,y∈Y[||ΓDY(y)−ΓDY(GY(x))||2] | (7) |

综上, MAGAN完整的训练损失函数为:

| {LG,ΓG=Ladv+Lstyle+Lrec+LGcateLD,ΓD=−Ladv−LDcate | (8) |

本文选取CycleGAN[21]、DRIT[25]、UNIT[26]、MUNIT[17]和UGATIT[5]作为基线模型. CycleGAN首次利用未配对数据通过循环一致性损失来限制两个域之间的映射标准. DRIT将特征信息解耦为内容空间和风格空间. UNIT提出共享潜在空间的假设, 并结合可变分自编码来完成图像转换. 与DRIT类似, MUNIT将图像信息分解为内容编码和样式编码.

3.2 数据集本文在selfie2anime、cat2dog、horse2zebra以及vangogh2photo这4个数据集上进行性能评估, 每个数据集的详细信息如表1所示, 所有图像大小均为256×256. 特别地, selfie2anime数据集只包含女性的照片, 人脸和动漫脸是差距较大的两个域. 两域间的图像翻译不仅需要颜色和纹理的变化, 更重要的是面部特征形状的转换, 具有更大的挑战性. 然而horse2zebra数据集的两个域仅在纹理上有所不同, 在形状上没有变化.

| 表 1 实验数据集详细信息 |

3.3 实现细节

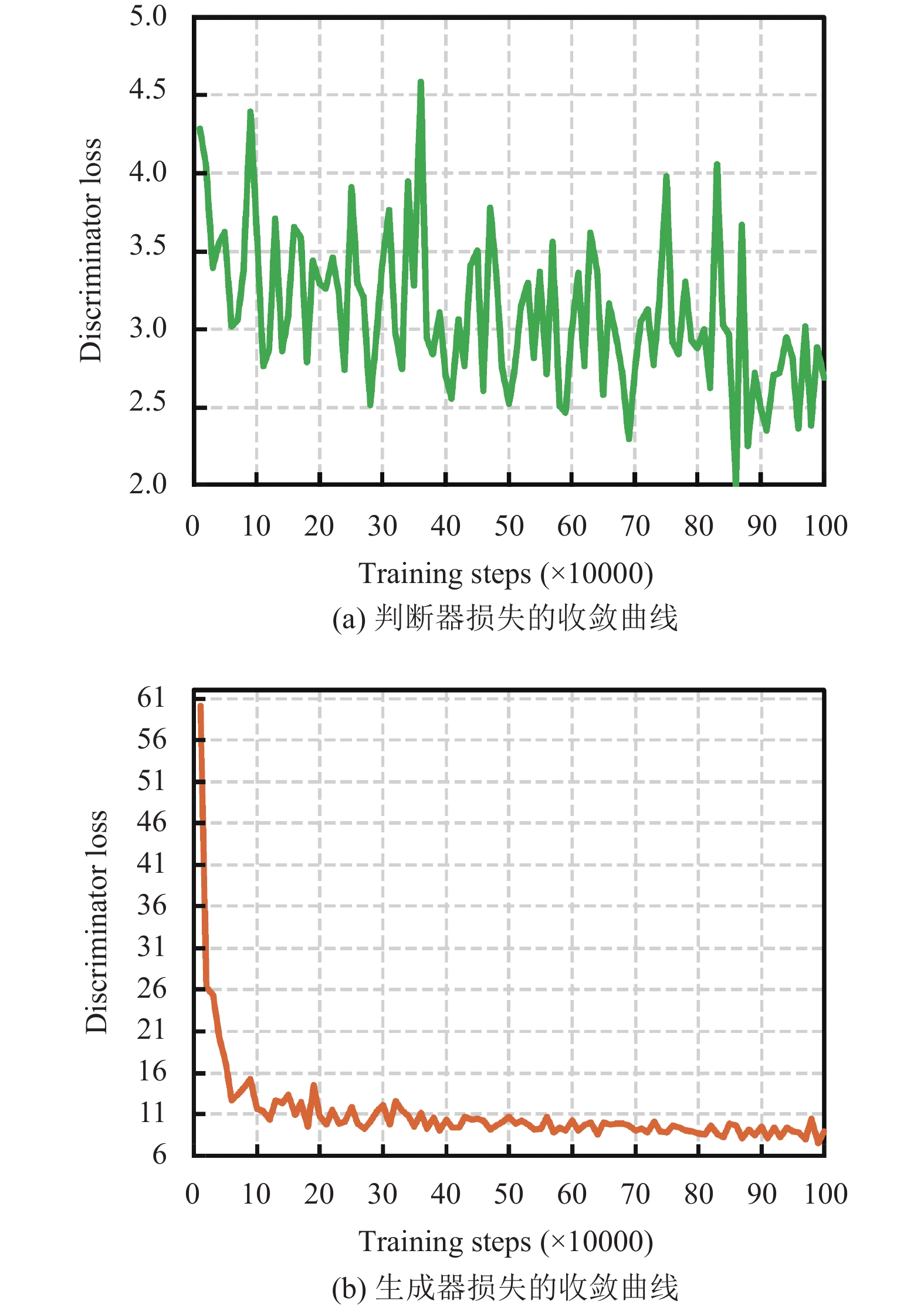

第2.1节中介绍的网络结构作为MAGAN的基准骨干网络. 为了增强训练数据, 将图像以0.5的概率水平翻转. 对于训练参数, 批处理大小设置为1, 模型训练总步长为1000 k. 使用Adam作为优化器, 其中

|

图 4 判别器损失和生成器损失的收敛曲线 |

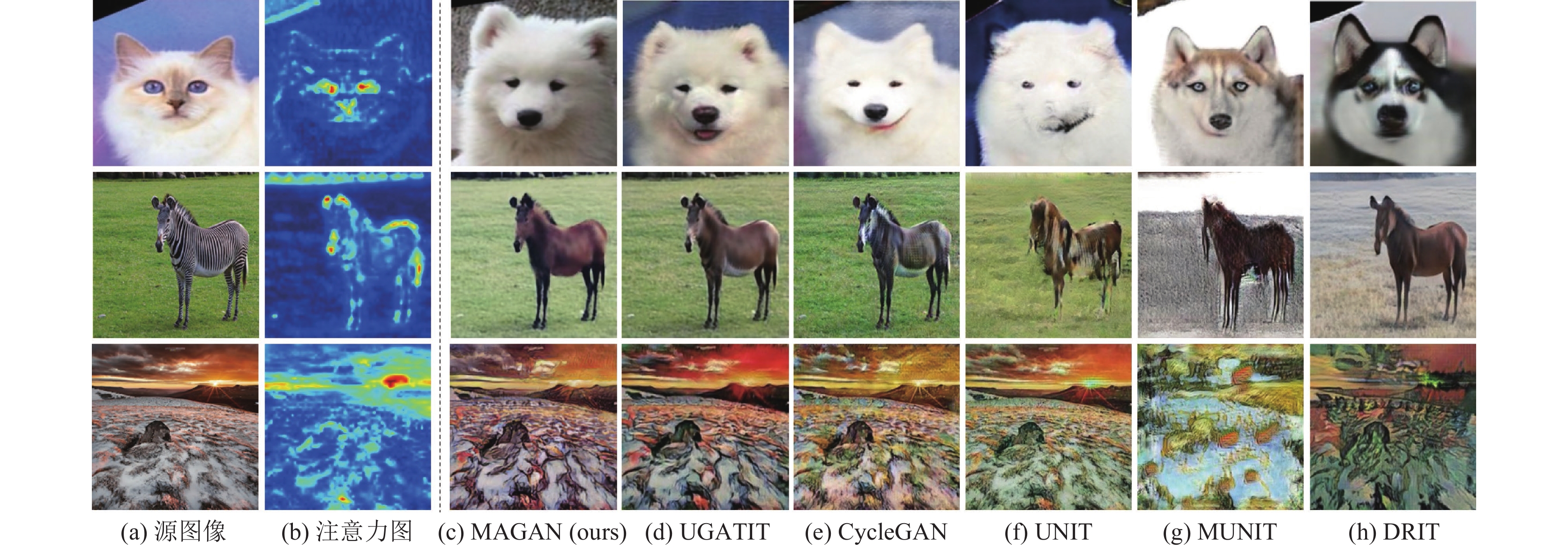

3.4 定性比较

为了验证本文模型MAGAN的有效性, 在所有翻译任务上进行了对比评估. 图5显示了selfie2anime数据集上对翻译结果的定性比较. 实验结果表明, CycleGAN生成的动漫人在图5(e)中有明显失真. DRIT、UNIT和MUNIT生成的图像与输入图像明显不一致. 它们没有充分保留源图像的全局信息. 如图5(d)所示, UGATIT翻译的动漫脸面部轮廓不平滑, 并引入了冗余特征, 如第3行生成了两个鼻子. 本文的方法(图5(c))优于上述模型, 生成了高质量的动漫面孔. 本文对多角度注意力的精心设计使得网络能够精确地关注两个域最具有判别性的区域并有效地翻译局部结构, 从而去除翻译图像中的特征扭曲. 图6展示了其他数据集的定性比较结果.

3.5 定量比较 3.5.1 内核初始距离内核初始距离 (kernal inception distance, KID)[27]通过计算最大平均差的平方来衡量两组样本之间的差异. KID值越小表明生成图像的分布更接近真实图像的分布. 在KID的计算中测试集被划分为10个大小为10的子集, 并将KID的度设置为9. 在表2中, 使用KID来评估本文提出的模型和基线模型在所有数据集上的性能. 从表2可以看出, MAGAN得到了最优的KID值. 这意味着本文提出的模型生成的图像具有最接近真实图像的分布, 因此它们在视觉上看起来很相似并且适用于多种图像翻译任务. 其他对比模型的KID分数来自UGATIT[5].

|

图 5 所有对比模型在selfie2anime任务上的翻译结果 |

3.5.2 用户研究

为了使实验结果的评价更符合人类的感知, 本文还通过用户研究对生成的图像效果进行定量比较. 感知研究实验涉及20名受试者. 对于每个参与者, 一次展示1张源域图像和5张由翻译模型生成的目标域图像, 参与者在不知情的情况下挑选出具有最佳视觉效果的图像. 本文一共收到了来自20名受试者的1000份结果. 表3中的结果表明我们的方法获得了更多的投票, 意味着用户更喜欢我们的方法翻译的图像.

|

图 6 所有对比模型在其他数据集上的翻译结果 |

| 表 2 所有数据集上关于内核初始距离的定量比较 (KID×100±std×100) |

| 表 3 用户研究评估结果 (%) |

3.6 消融实验

本文设计了消融实验来验证结合生成对抗网络及多角度注意力的图像翻译模型的性能. 所有的消融实验都在selfie2anime 数据集上完成.

3.6.1 多角度注意力的实验分析在图7(b)中, 多角度注意力图促使网络关注两个域最具辨别性的图像区域. 设计了3个基线: “w/ CAM”(图7(f))、“w/ SAM”(图7(g))和“w/o attention”(图7(h)). 其中, “w/o attention”没有使用注意力机制, 翻译效果不尽人意. “w/ CAM”通过类激活映射技术计算注意力图. 由于CAM忽略了不同通道之间的特征关联, 导致翻译的图像中存在严重的特征扭曲. “w/ SAM”只能捕获局部特征信息, 边缘定位效果较差. 相比之下, 多角度注意力不仅可以定位到完整的目标, 还可以充分利用目标的空间相关性来生成高质量的动漫图像.

由表4可知, “w/o attention”在selfie2anime数据集上的KID分数最高. 验证了注意力机制在提高网络性能方面发挥了重要作用. 本文提出的模型在人脸和动漫脸相互转换的任务上的KID值最低, 分别为9.48和9.35, 表明本文提出的模型生成的图像更加真实.

3.6.2 特征激活程度的实验分析本文研究了特征激活度对网络性能的影响, 并可视化了不同激活度下的注意力图. p的取值有1 (“w/low”)、2 (“w/ middle”)或3 (“w/ high”). 同时, 为了验证相同激活度在不同网络架构的效果差异, MAGAN分别为生成器网络和判别器网络设置了每个激活度的特征激活. 如图8所示, 每列表示生成器中使用相同的激活程度, 每行表示判别器中使用相同的激活程度. 其中, 第1–3行是注意力特征图的可视化, 第4–6行是生成器输出相应的图像. 当p=1时, 网络倾向于关注全局信息, 而对重要敏感区域(例如眼睛和嘴巴)的信息关注度不够; 随着p值的增加, 更多的注意力被放在最具辨别性的局部区域; 当p=3时, 网络失去了捕捉边界定位细节的能力(例如, 面部轮廓扭曲). 生成器网络需要对辨别性最大的区域赋予更多的权重, 因此将p设置为2效果最好. 与生成器网络不同, 判别器网络必须从整体上判断图像的真实性, 因此将p设置为1最合适. 在表5中, 生成器“w/ middle”和判别器“w/ low”的模型在selfie2anime数据集上的KID得分最低.

|

图 7 对多角度注意力消融研究的定性比较 |

| 表 4 selfie2anime数据集上对多角度注意力消融研究的定量比较 (KID×100±std×100) |

|

图 8 对特征激活程度消融研究的定性比较 |

| 表 5 在selfie2anime数据集上对特征激活程度消融研究的定量比较 (KID×100±std×100) |

4 结论与展望

本文提出了一种结合生成对抗网络及多角度注意力的无监督图像翻译模型. 本文所提出的注意力模型能够有效地引导生成器和判别器关注判别性区域. 其不但可以保留源图像的全局信息, 而且能够将局部风格转换为目标域的风格. 实验结果表明, 与其他模型相比, 本文提出的MAGAN生成了高质量的图像. 此外, 多角度注意力可以增强模型的抗干扰能力, 适用于多种类型的图像翻译任务. 然而, 由于我们的注意力模块不能实现内容和风格的完全解耦, 所以生成的图像中包含预期外的内容. 因此, 在未来的工作中, 将研究一种新的模型以完全解耦图像的内容和风格, 从而实现更精准的图像翻译.

| [1] |

Goodfellow IJ, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2014. 2672–2680.

|

| [2] |

Choi Y, Uh Y, Yoo J, et al. StarGAN v2: Diverse image synthesis for multiple domains. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 8185–8194.

|

| [3] |

Liang XD, Zhang H, Lin L, et al. Generative semantic manipulation with mask-contrasting GAN. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 574–590.

|

| [4] |

Liu MY, Huang X, Mallya A, et al. Few-shot unsupervised image-to-image translation. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 10550–10559.

|

| [5] |

Kim J, Kim M, Kang H, et al. U-GAT-IT: Unsupervised generative attentional networks with adaptive layer-instance normalization for image-to-image translation. Proceedings of the 8th International Conference on Learning Representations (ICLR). Addis Ababa: OpenReview.net, 2020. 1–19.

|

| [6] |

Zhou BL, Khosla A, Lapedriza A, et al. Learning deep features for discriminative localization. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2921–2929.

|

| [7] |

Li YJ, Fang C, Yang JM, et al. Diversified texture synthesis with feed-forward networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 266–274.

|

| [8] |

Chen SSC, Cui H, Du MH, et al. Cantonese porcelain classification and image synthesis by ensemble learning and generative adversarial network. Frontiers of Information Technology & Electronic Engineering, 2019, 20(12): 1632-1643. |

| [9] |

Karras T, Laine S, Aila T. A style-based generator architecture for generative adversarial networks. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4396–4405.

|

| [10] |

吴福祥, 程俊. 基于自编码器生成对抗网络的可配置文本图像编辑. 软件学报, 2022, 33(9): 3139-3151. DOI:10.13328/j.cnki.jos.006622 |

| [11] |

秦魁, 侯新国, 周锋, 等. fire-GAN: 基于生成对抗网络的火焰图像生成算法. 激光与光电子学进展, 2022, 1–13. https://kns.cnki.net/KCMS/detail/detail.aspx?dbcode=CAPJ&dbname=CAPJLAST&filename=JGDJ202207130F9. (2022-07-17).

|

| [12] |

Chen L, Wu L, Hu ZZ, et al. Quality-aware unpaired image-to-image translation. IEEE Transactions on Multimedia, 2019, 21(10): 2664-2674. DOI:10.1109/TMM.2019.2907052 |

| [13] |

Liu Y, Chen W, Liu L, et al. SwapGAN: A multistage generative approach for person-to-person fashion style transfer. IEEE Transactions on Multimedia, 2019, 21(9): 2209-2222. DOI:10.1109/TMM.2019.2897897 |

| [14] |

Song YH, Yang C, Lin Z, et al. Contextual-based image inpainting: Infer, match, and translate. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 3–18.

|

| [15] |

王清和, 曹兵, 朱鹏飞, 等. 基于自判别循环生成对抗网络的人脸图像翻译. 中国科学: 信息科学, 2022, 52(8): 1447-1462. |

| [16] |

Yang C, Kim T, Wang RZ, et al. Show, attend, and translate: Unsupervised image translation with self-regularization and attention. IEEE Transactions on Image Processing, 2019, 28(10): 4845-4856. DOI:10.1109/TIP.2019.2914583 |

| [17] |

Huang X, Liu MY, Belongie S, et al. Multimodal unsupervised image-to-image translation. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 179–196.

|

| [18] |

Choi Y, Choi M, Kim M, et al. StarGAN: Unified generative adversarial networks for multi-domain image-to-image translation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8789–8797.

|

| [19] |

Isola P, Zhu JY, Zhou TH, et al. Image-to-image translation with conditional adversarial networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5967–5976.

|

| [20] |

Wang TC, Liu MY, Zhu JY, et al. High-resolution image synthesis and semantic manipulation with conditional GANs. Proceedings of the 2018 IEEE CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8798–8807.

|

| [21] |

Zhu JY, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2242–2251.

|

| [22] |

Huang X, Belongie S. Arbitrary style transfer in real-time with adaptive instance normalization. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 1510–1519.

|

| [23] |

Zhang H, Goodfellow I, Metaxas DN, et al. Self-attention generative adversarial networks. Proceedings of the 36th International Conference on Machine Learning. Long Beach: PMLR, 2019. 7354–7363.

|

| [24] |

Zagoruyko S, Komodakis N. Paying more attention to attention: Improving the performance of convolutional neural networks via attention transfer. Proceedings of the 5th International Conference on Learning Representations (ICLR). Toulon: OpenReview.net, 2017. 1–13.

|

| [25] |

Lee HY, Tseng HY, Huang JB, et al. Diverse image-to-image translation via disentangled representations. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 36–52.

|

| [26] |

Liu MY, Breuel T, Kautz J. Unsupervised image-to-image translation networks. Proceedings of the 31st International Conference on Neural Information Processing System. Long Beach: ACM, 2017. 700–708.

|

| [27] |

Bińkowski M, Sutherland DJ, Arbel M, et al. Demystifying MMD GANs. Proceedings of the 6th International Conference on Learning Representations (ICLR). Vancouver: OpenReview.net, 2018. 1–36.

|

2023, Vol. 32

2023, Vol. 32