2. 电子科技大学 信息与通信工程学院, 成都 611731

2. School of Information and Communication Engineering, University of Electronic Science and Technology of China, Chengdu 611731, China

布匹瑕疵检测是纺织业在布匹质量管理的重要一环, 布匹表面的瑕疵严重影响着其美观和质量, 导致布匹产品滞销和经济损失[1]. 目前, 大多数纺织业仍采用人工检测的方法, 该方法存在成本高、效率低、会导致误检和漏检等问题[2]. 部分纺织业使用传统机器视觉方法等自动化方法实现瑕疵检测, 但传统机器视觉方法存在检测瑕疵类型单一、计算成本高、复杂花色背景检测效果差等缺陷, 不能满足检测要求. 压缩生产成本、提高生产效率是当前纺织业日益迫切的需求. 研究实现智能化、轻量化的花色布匹瑕疵检测方法具有重要的实际意义.

传统机器视觉方法根据布匹图像纹理特征分为基于统计学方法、基于频谱方法、基于模型方法. 统计学方法量化分析布匹图像数据, 提取纹理信息进行统计处理, 常用方法有: 直方图统计法[3]、灰度共生矩阵法[4]和数学形态学[5]等. 该类方法适用于无复杂背景图案、分辨率较小的布匹图像, 存在检测布匹类型单一、瑕疵定位不准确等缺陷. 频谱法针对布匹图像频谱特性进行分析, 实现瑕疵分类, 方法有傅里叶变换[6]、小波变换[7]和Gabor滤波[8]等. 频谱法对规律性纹理的布匹图像检测效果较好, 但难以在空间上对瑕疵位置进行定位. 模型法将正常布匹图像作为分布模型, 将检测图像输入模型进行匹配判别瑕疵位置, 方法有自回归模型[9]和马尔科夫随机场模型[10]. 该类方法对表面纹理单一的图像检测效果较好, 对于纹理复杂、不清晰图像的检测存在局限性. 综上所述, 传统方法对花色布匹瑕疵检测有一定借鉴作用, 但存在计算复杂度高、收敛速度慢、参数调节困难及检测精度低等缺点. 同时, 传统方法通常依赖人工经验调参实现, 生产过程中难以实现实时检测, 不能满足纺织业日益增长的工业化生产需求.

随着深度学习技术的发展, 布匹瑕疵检测朝着自动化、智能化的方向发展. 深度学习算法对复杂花色背景下的布匹瑕疵有优异的检测性能, 可实现传统方法难以达到的检测效果. 基于深度学习的目标检测算法按候选区域的处理方式不同分为两大类: 第1类是基于region-convolutional neural networks (R-CNN)系列算法[11-13]的两阶段目标检测网络. 如基于Faster R-CNN[14]的布匹瑕疵检测系统针对布匹数据集中类别数量不均衡、瑕疵目标小的特点, 对region proposal network (RPN)网络进行改进, 能准确标识瑕疵点的位置. 两阶段检测网络能够有效对高分辨率、小瑕疵的布匹图像进行检测, 但在检测速度上不理想. 第2类是基于you only look once (YOLO)系列算法[15-18]的单阶段端到端目标检测网络. 如Jing等[19]提出一种基于改进YOLOv3的实时性能高的织物瑕疵检测方法, 将低层特征与高层信息相结合应用于不同特征层进行布匹瑕疵检测, 该方法主要适用于色调单一的坯布与有规律性背景的格子布. Zheng等[20]提出了一种基于squeeze-and-excitation (SE)模块的SE-YOLOv5高效布匹瑕疵检测算法, 可以满足布匹瑕疵检测的需要, 但该算法难以在嵌入式设备上实现检测.

尽管基于深度学习的方法在布匹瑕疵检测中取得了较好的检测效果, 但此类方法计算复杂度高、计算量大, 使其难以在嵌入式设备上实现高精度、高实时性等检测要求. 近年来, 随着移动及嵌入式设备对深度学习算法的需求增大, 基于轻量级网络结构的目标检测方法的研究增多, 各种轻量级检测网络被提出, 如MobileNet[21, 22]、ShuffleNet[23, 24]及GhostNet网络[25]等. 此类轻量级检测网络可在嵌入式设备上实现智能化花色布匹瑕疵检测, 以此为基础, 本文提出了一种基于改进ShuffleNetV2的轻量级花色布匹瑕疵检测方法, 旨在有效降低纺织业检测成本, 在嵌入式设备上实现准确、快速的花色布匹瑕疵检测.

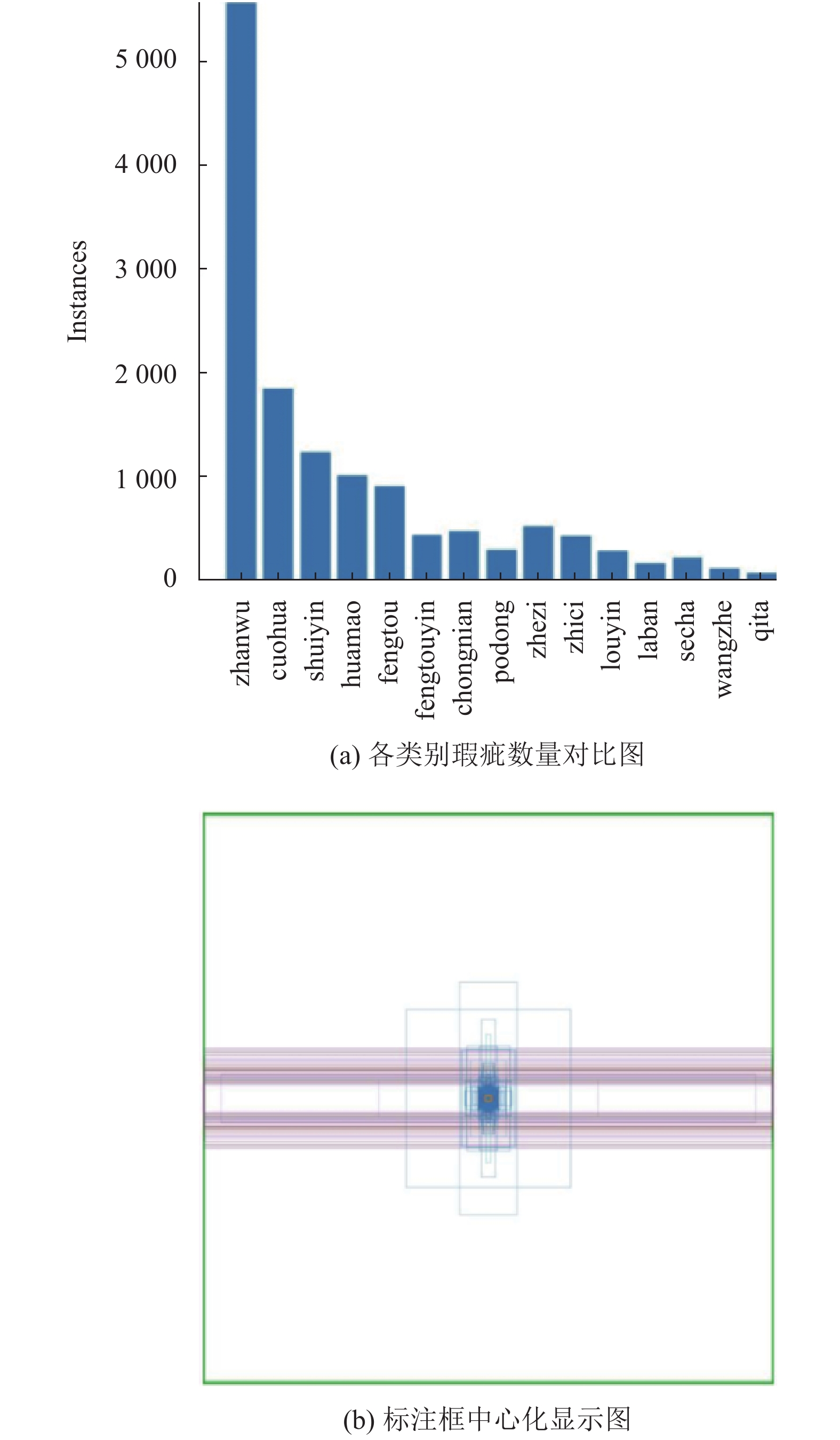

1 花色布匹瑕疵数据集构建与数据增强处理花色布匹瑕疵数据集来源于天池工业智造创新大赛[26], 包含4354张瑕疵图像, 16457个瑕疵标注, 标注为每个瑕疵的类别及边界框. 瑕疵类别为实际生产中常见的15类瑕疵, 如缝头、错花和沾污等. 布匹图像的像素大小为4096×1800. 本文随机抽取90%作为训练集, 10%为测试集, 其中训练集中20%为验证集. 各类别瑕疵数量对比图与标注框中心化显示图如图1.

|

图 1 各类别瑕疵数量对比图与标注框中心化显示图 |

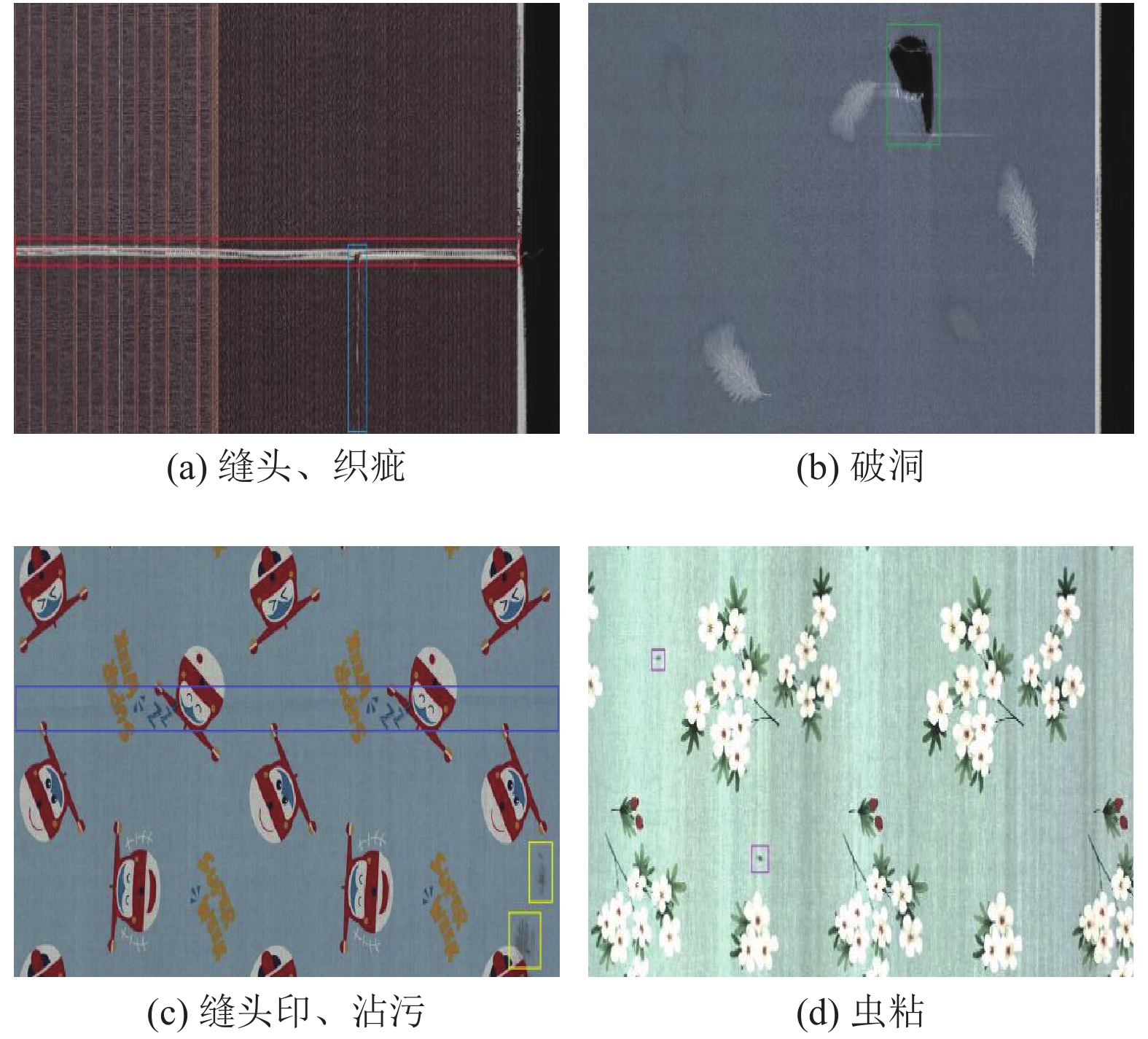

从图1中可得出以下信息: (1)不同类别瑕疵之间数量差异大; (2)瑕疵尺寸差异大, 小瑕疵占比高; (3)长宽比大. 这些都是目标检测领域中的重点、难点所在. 为降低不同类别瑕疵之间数量差异大对检测效果的影响, 本文在训练过程中, 采取随机翻转、变形缩放等方式对数据集进行增强处理. 实验中为减少模型计算量及加快收敛速度, 将图像统一缩小为416×416像素. 花色布匹瑕疵数据集中部分瑕疵样本如图2.

|

图 2 花色布匹瑕疵数据集部分瑕疵样本 |

2 花色布匹瑕疵检测网络结构设计 2.1 深度可分离卷积

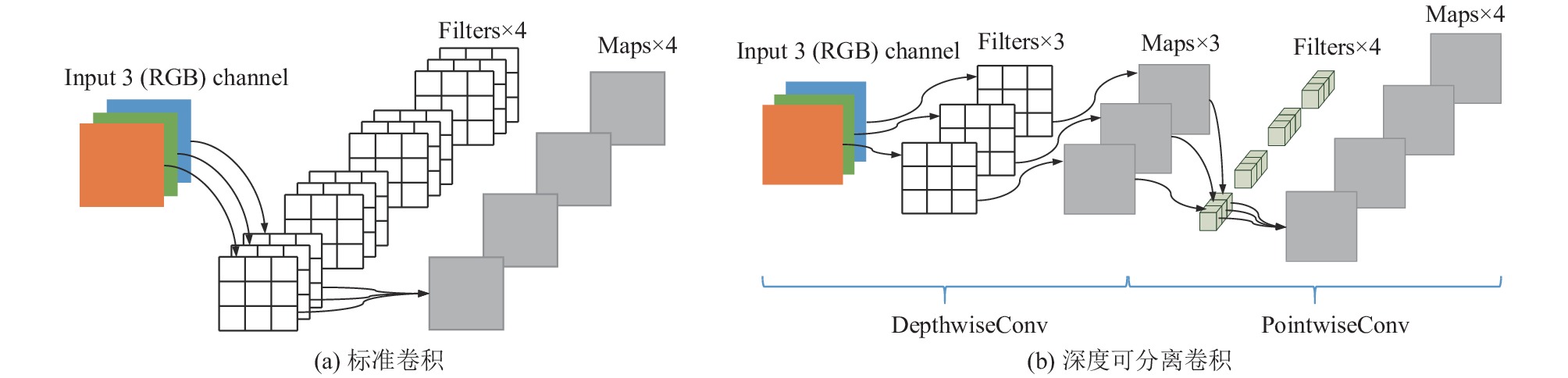

传统卷积神经网络内存占用大、运算量大导致在嵌入式设备上运行困难. 深度可分离卷积(depthwise separable convolution, DepthSepConv)可大大减少卷积运算复杂度与参数量. 该卷积由深度卷积(3×3 DepthwiseConv)和点卷积(1×1 PointwiseConv)组成, 其首次在MobileNetV1[21]中被提出, 并逐渐成为在边缘设备上运行轻量化网络的可靠组件. 标准卷积(standard convolution)与深度可分离卷积如图3所示.

|

图 3 标准卷积与深度可分离卷积 |

从图3(a)可以看出, 对于宽、高和通道数分别为W、H和C的输入图像, 得到大小为w×h×c的特征图(feature map), 标准卷积参数量(parameters, P)为:

| Pstd=Dk×Dk×C×c | (1) |

其中,

| Fstd=Dk×Dk×C×c×W×H | (2) |

深度可分离卷积中每个输入特征图通道只与一个卷积核进行运算, 得到中间特征图后与点卷积进行加权混合生成新的特征图. 深度可分离卷积的参数量为:

| Pds=Dk×Dk×C+C×c | (3) |

深度可分离卷积的计算量为:

| Fds=Dk×Dk×C×W×H+C×c×W×H | (4) |

可得深度可分离卷积与标准卷积的参数量和计算量之比为:

| FdsFstd=PdsPstd=1c+1Dk2 | (5) |

从深度可分离卷积与标准卷积的参数量和计算量之比可以看出, 在获得与标准卷积计算相同效果时, 无论是参数量还是计算量上比标准卷积少许多倍, 极大减少了模型参数量与计算量. ShuffleNetV2中特征提取基本组件basic block使用深度可分离卷积. 在Raspberry Pi 4B等嵌入式开发板上实现花色布匹瑕疵检测算法的难点之一是模型结构的优化, 而深度可分离卷积则更加适合在嵌入式设备上部署运行.

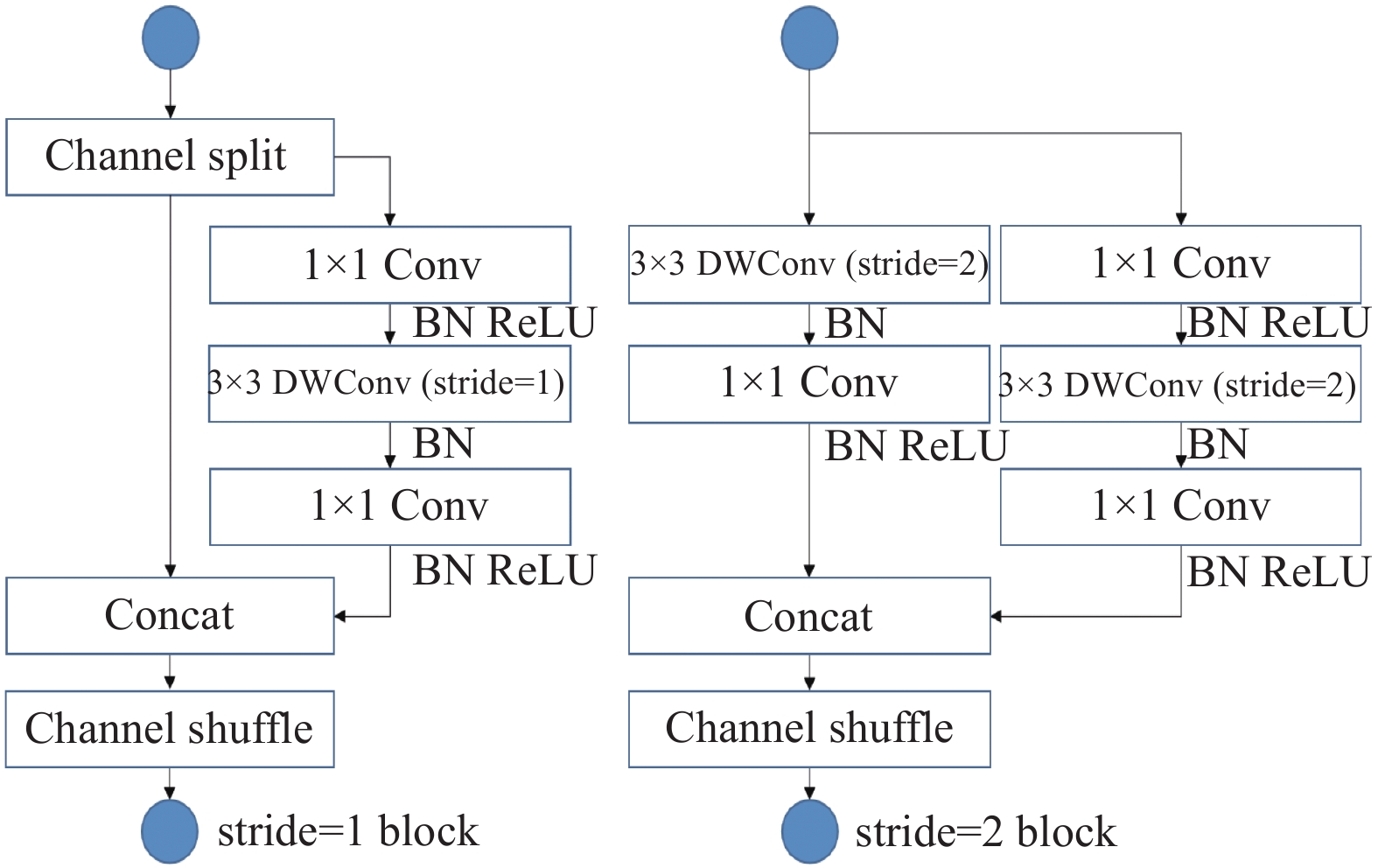

2.2 ShuffleNetV2网络模型为降低网络模型计算量, 提高推理速度和检测精度, ShuffleNetV2以ShuffleNetV1为基础, 其保留了ShuffleNetV1中通道混洗和深度可分离卷积等优秀组件, 减少了模型参数量与计算量. 同时ShuffleNetV2进一步分析了影响模型推理速度的原因, 充分考虑内存访问成本(memory access cost, MAC)与网络并行度(degree of parallelism, DP)这两个重要指标, 提出了更为高效的基本单元(basic block), 如图4所示.

|

图 4 基本单元 |

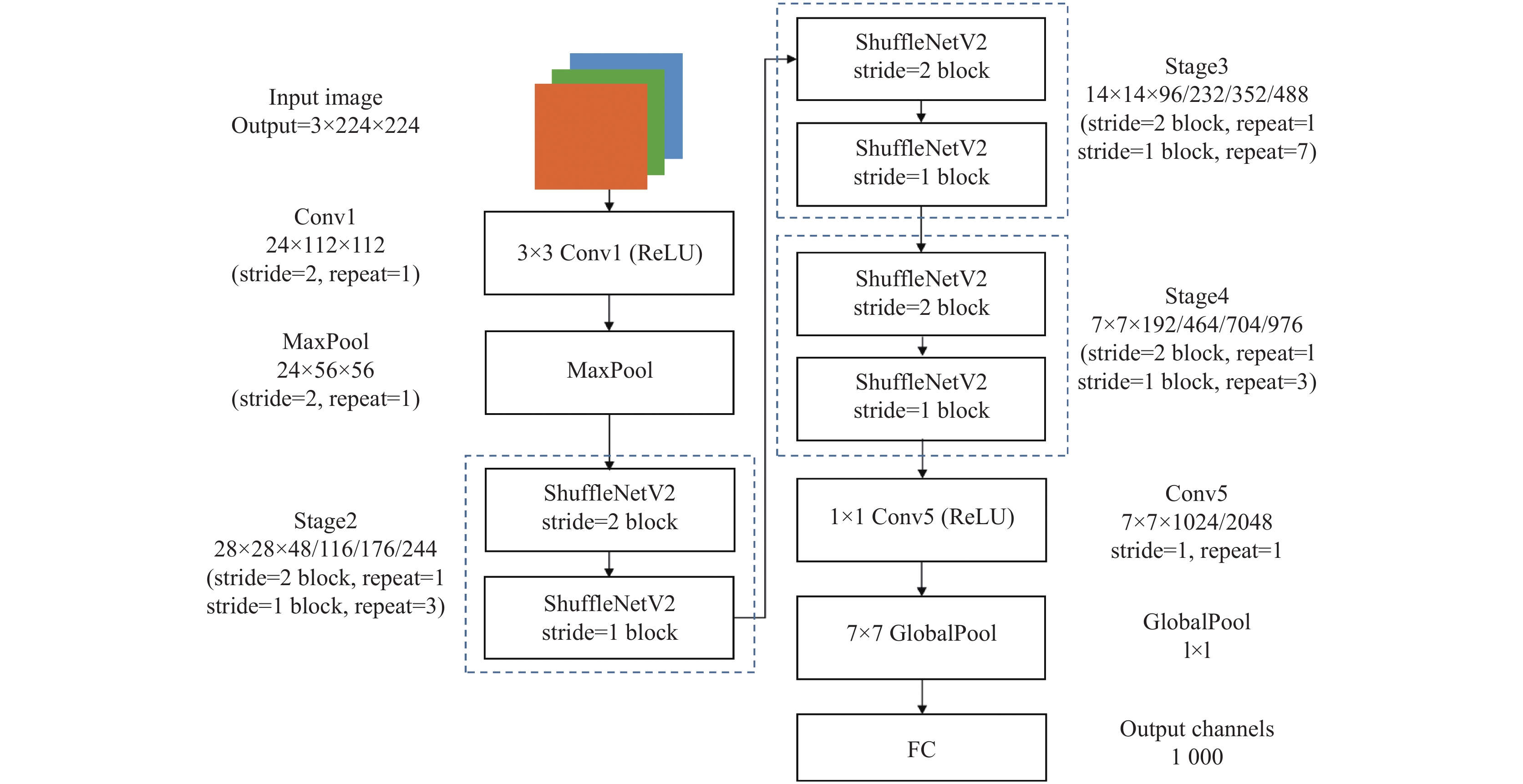

ShuffleNetV2网络结构如图5所示.

|

图 5 ShuffleNetV2网络结构图 |

从图5中可以看出, ShuffleNetV2网络结构中Stage2、Stage3、Stage4和Conv5的输出通道数(output channels)依次增大, 分为4个版本, 分别是0.5×、1×、1.5×和2×. 随着版本增大, 基本单元不变, 组件Stage结构的输出通道数依次增加. 网络深度的增加使得模型的特征提取能力逐渐增强, 检测精度提高, 但随之而来的是模型的浮点运算量(FLOPs)和模型大小的增大. 由于Raspberry Pi 4B嵌入式设备算力条件有限, 为保证花色布匹瑕疵检测有更好的检测速度, 本文选择计算量及参数量较低的0.5×版本作为本文算法的主干网络(Backbone).

2.3 基于改进ShuffleNetV2的花色布匹瑕疵检测网络ShuffleNetV2 0.5×的网络结构如图5所示. 输入图像分辨率大小为3×224×224, 先经过24个大小为3×3、步数(stride)为2的标准卷积进行特征提取, 得到24×112×112的特征图(feature map). 然后使用MaxPool做最大池化处理达到下采样的目的, 得到24×56×56的特征图后连接3个由ShuffleNetV2网络基本组件stride=1 block和stride=2 block构成的Stage结构, 提取目标图像不同层级的语义信息. Stage2、Stage3和Stage4结构输出特征图的通道数大小分别为48、96和192, 它们中的block2和block1的重复次数分别为1:3、1:7和1:3, 之后由1024个1×1的卷积扩充特征提取通道, 进一步提升模型对目标的特征提取. 最后由全局池化层充分融合空间信息, 防止模型过拟合, 使用全连接层(fully connected layers, FC)进行目标分类.

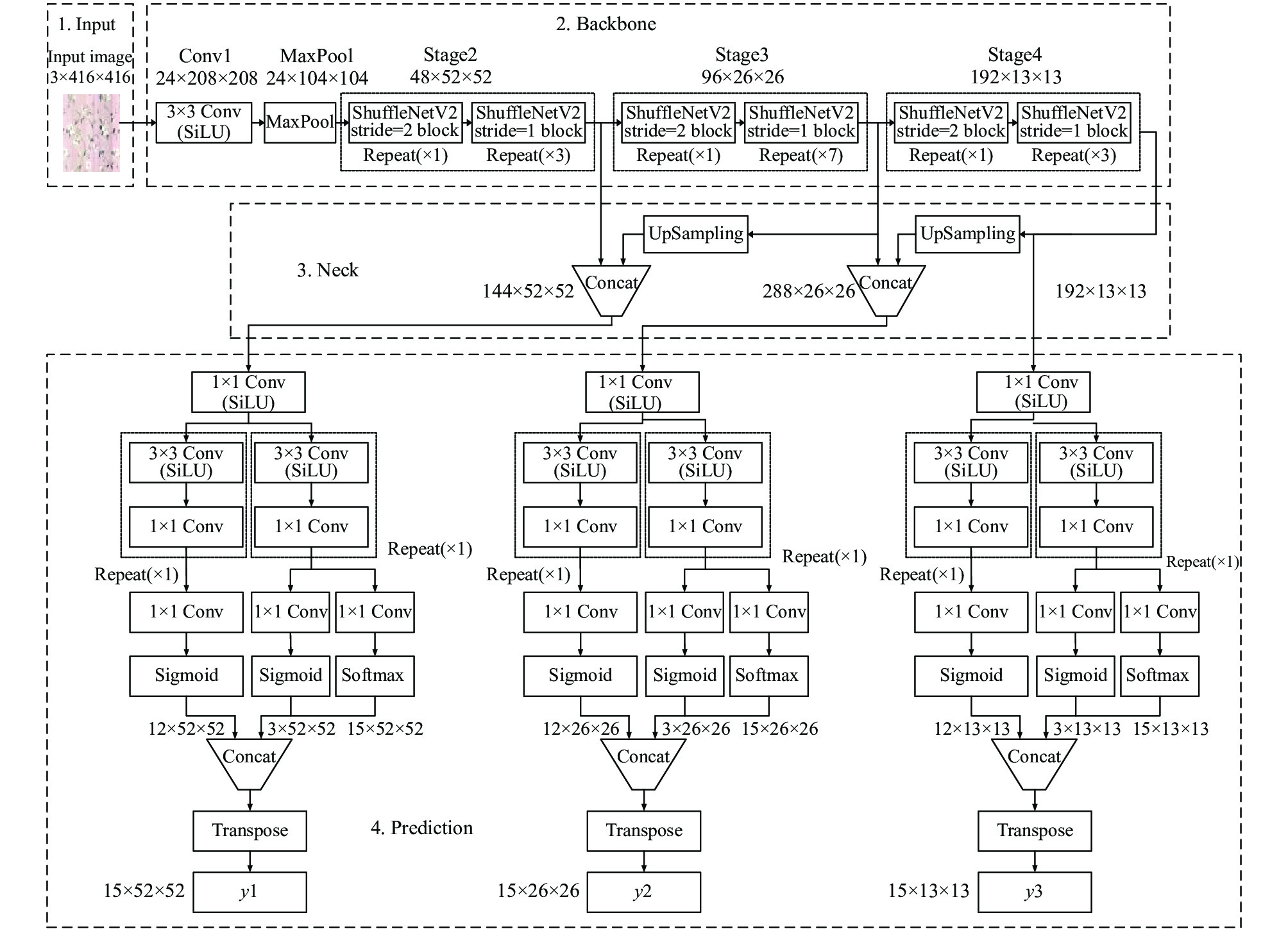

本文在以ShuffleNetV2 0.5×作为花色布匹瑕疵特征提取网络的基础上, 有效融合浅层与深层特征信息, 达到可在嵌入式设备上实现的花色布匹瑕疵检测模型, 所提出的基于改进ShuffleNetV2的花色布匹瑕疵检测算法整体网络结构如图6所示.

|

图 6 本文检测算法整体网络结构图 |

本文检测算法整体网络结构为端到端一阶网络YOLO架构, 分为输入端(input)、主干网络(backbone)、颈部网络(neck)和检测输出(prediction). 输入端为416×416像素大小、3通道(RGB)的花色布匹图像. 主干网络又称为特征提取网络, 本文由ShuffleNetV2网络的前大部分结构构成, 得益于其优异的功能组件, 使在嵌入式设备上实现花色布匹瑕疵检测成为可能. 颈部网络又称为特征融合网络, 本文将深层Stage4后的特征图用于小布匹瑕疵的检测. 将深层Stage4后的特征图经上采样后与Stage3拼接, 将中层特征与深层特征融合用于中等大小布匹瑕疵的检测. 同样也将Stage3结构提取的特征信息与Stage2的特征信息进行融合, 这样可以更好融合浅层的表征位置信息与深层语义信息从而提升模型的检测能力.

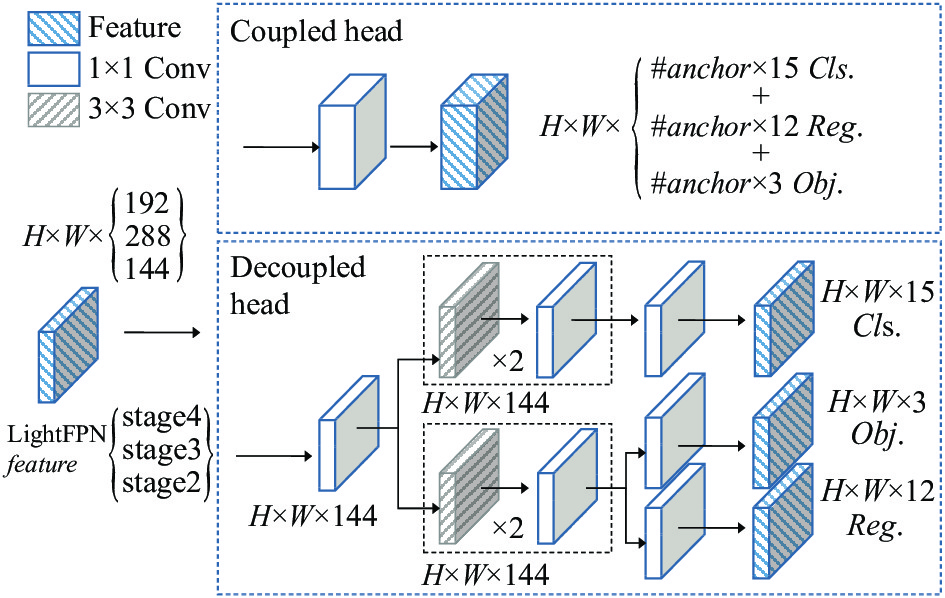

对于检测输出prediction, 也称为YOLO检测头(YOLO Head), 用于将获得的3种尺寸大小的布匹瑕疵特征进行处理, 输出预测. 在目标检测的分类和定位任务中, 会存在spatial misalignment的问题[27], 分类与定位任务的聚焦点不一样. 分类任务关注所提取的特征与所有检测类别的哪一类更为相近, 而定位任务更加关注与目标真实框(ground truth box)的位置坐标信息, 进而修正边界框参数. 本文将目标检测算法YOLOv3–v4[17, 18]使用同一个特征图进行分类和定位的coupled head方法改进为解耦头(decoupled head)[28]的结构设计, coupled head与decoupled head结构如图7所示.

|

图 7 Coupled head与decoupled head结构图 |

使用解耦头结构将特征图解耦成分别针对分类和定位任务后将获得3个预测结果, 分别是瑕疵框的前景背景信息判断(Out_Obj), 大小为(3×w×h), 输出通道数3为针对每个特征点产生的3个预测框是否有布匹瑕疵的概率信息; 瑕疵框的位置坐标(Out_Reg), 大小为(12×w×h), 输出通道数12为3个预测框的中心点对该特征点的坐标偏移情况及宽高对于该特征点的对数指数的参数信息; 瑕疵框的类别(Out_Cls), 大小为(15×w×h), 输出通道数15表示每一个特征点对应15类布匹瑕疵的概率信息.

2.4 损失函数本文的分类概率损失LossCls和置信度损失LossObj所用的损失函数分别为交叉熵损失函数(crossentropy loss)、二元交叉熵损失函数(BCE with logits loss). IoU (intersection over union)是一种在目标检测中检测相应目标准确度的一个标准, 计算预测框与真实框的交集和并集的比值. IoU和损失函数的计算公式为:

| IoU=|A∩B||A∪B| | (6) |

| LossIoU=1−IoU | (7) |

其中, A代表预测框, B代表真实框. 在IoU的基础上, 瑕疵框的位置回归损失LossReg采用CIoU (complete IoU loss)[29]损失函数计算边框损失. CIoU的计算公式为:

| LCIoU=1−IoU+ρ2(p,pgt)c2+αV | (8) |

| α={0,ifIoU<0.5V(1−IoU)+V,ifIoU>0.5 | (9) |

| V=4π2(arctanwgthgt−arctanwh)2 | (10) |

其中,

本文的实验平台是Ubuntu 18.04 LTS 64位操作系统, CPU为Intel i9-10850K, 16 GB内存, 显卡为NVIDIA GeForce RTX 3070, 显卡显存为8 GB, 包管理环境为Anaconda. 使用Python 3.8、PyTorch 1.9.0、CUDA 11.1搭建网络模型.

嵌入式平台Raspberry Pi 4B搭载1.5 GHz的64位四核处理器(Broadcom BCM2711, Cortex-A72 (ARM v8) 64-bit), 8 GB LPDDR4内存, 配置系统为Raspbian 64位操作系统.

在模型训练过程中, 先将图像尺寸经过缩小调整为416×416大小, 再将图像做归一化处理后输入网络进行训练. 网络参数训练优化采用随机梯度下降(stochastic gradient descent, SGD)优化器进行参数调整, 其中动量参数(momentum)设为0.95, 权重衰减(weight_decay)为0.0005. 训练迭代300次(epoch), 初始学习率为0.001, 训练批次(batch_size)大小为100.

3.2 评价指标本文的模型性能评价指标为在Raspberry Pi 4B上用对测试集的检测速度、检测精度、模型大小来衡量模型性能. 检测速度为在Raspberry Pi 4B上每秒检测的布匹图像帧数(FPS). 检测精度包括精确率(precision, P)、召回率(recall, R)、平均精度(average precision, AP)和平均精度均值(mean average precision, mAP)等. 计算公式为:

| P=TP/TP(TP+FP)(TP+FP) | (11) |

| R=TP/TP(TP+FN)(TP+FN) | (12) |

| AP=∫10P(R)dR | (13) |

| mAP=1M∑Mm=1AP(m) | (14) |

其中, TP为判别正确的正样本数量, FP为判别错误的正样本数量, FN为判别错误的负样本数量. 其中精确率表示被认为是正样本中实际是正样本的目标个数占被认为是正样本的比例. 召回率是指被认为是正样本中实际是正样本的目标个数占测试集中是正样本的比例. AP表示在单个瑕疵类别下的平均精度, mAP表示所有瑕疵类别的AP均值, 本文以mAP为最终评判标准.

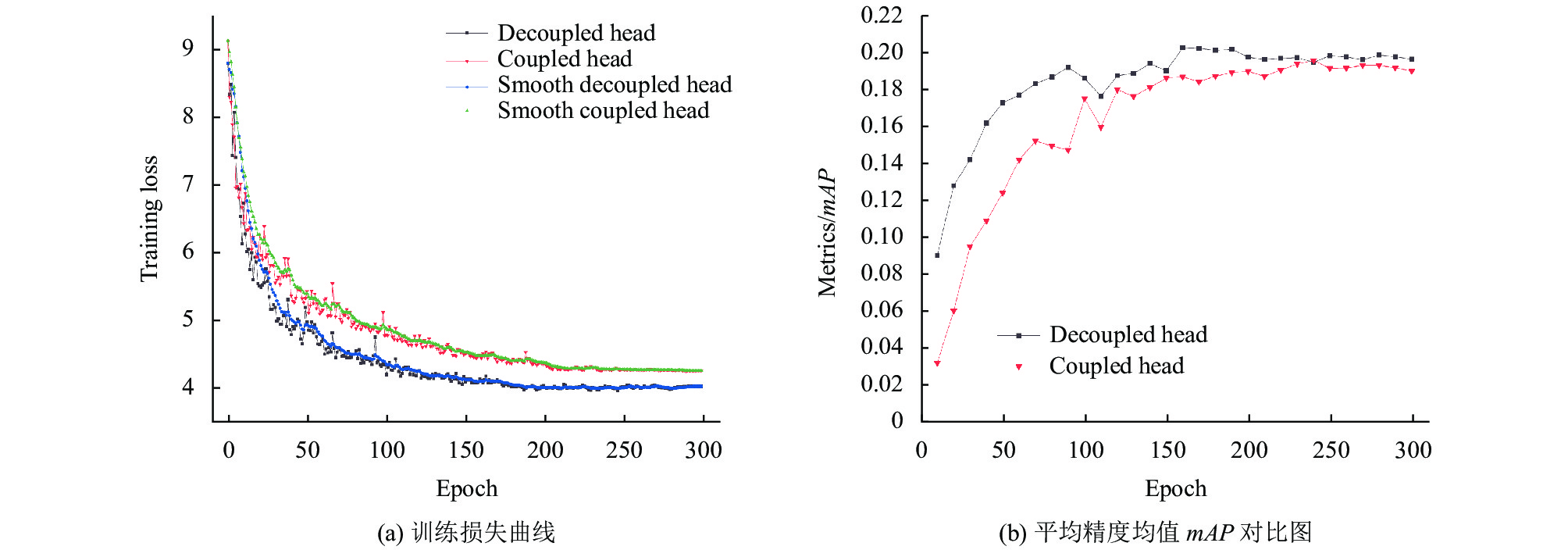

3.3 结果与分析为直观评估本文将检测头解耦合的影响, 验证改进模块对网络整体性能的效果. 本文将coupled head与decoupled head结构分别进行实验, 在本文数据集上进行训练损失与检测效果的可视化, 结果如图8所示. 从图8(a)训练损失曲线可以看出, decoupled head结构的平滑收敛速度明显优于coupled head结构. 图8(b)为每10个epoch评估一次本文验证集上的mAP. 显然, 从图中可以看出本文算法使用decoupled head结构的收敛速度比coupled head快得多, 并最终获得了更好的检测结果.

|

图 8 Coupled head与decoupled head结构训练损失曲线与mAP对比图 |

为验证本文算法在Raspberry Pi 4B上检测精度与检测速度的有效性和先进性, 采用当前目标检测算法中适合在嵌入式设备上部署的YOLOv5-lite-s[31]与NanoDet-m-416[32]等轻量级算法进行实验对比. 使用本文花色布匹数据集的测试集对各算法进行对比测试, 本文算法与另两种检测算法的检测结果如表1所示.

| 表 1 不同算法的花色布匹瑕疵检测结果 |

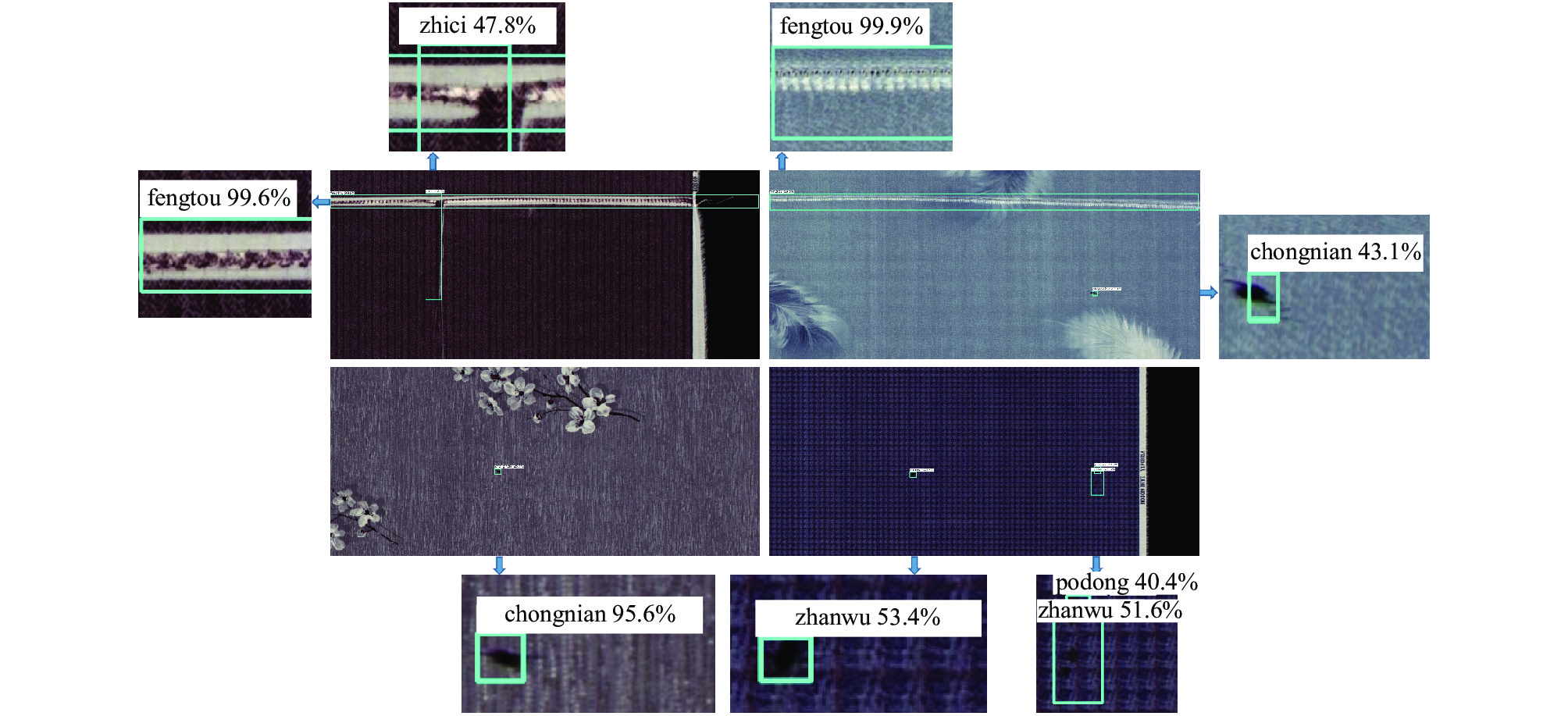

从表1可以看出, 在花色布匹瑕疵检测中, 与算法YOLOv5-lite-s和NanoDet-m-416算法相比, 本文算法在参数量(Params)和浮点运算量上(FLOPs)上有明显优势, 本文方法的参数量仅为0.27 MB, 远小于另两种检测算法的1.49 MB和0.89 MB, FLOPs的大小也仅为0.3 G. 同YOLOv5-lite-s检测算法相比, 在平均精度均值mAP低1.8%的情况下, 本文算法在Raspberry Pi 4B上的检测速度达到8.6 FPS, 在检测速度上约为另两种算法的2.5倍. 此外在模型大小上仅为另外两种算法的1/3. 通过对比数据可知, 本文算法在保证一定精确度时大大提升了花色布匹瑕疵的检测速度, 更加适合于嵌入式设备上的检测部署. 本文算法检测结果如图9所示.

|

图 9 花色布匹瑕疵检测结果图 |

从检测结果图可以看出, 本文算法不仅能对有较大长宽比的“缝头”类型瑕疵进行精准检测, 其类别置信度可达99%以上, 对于像素占比少的“虫粘”“沾污”和“破洞”等小瑕疵类型也有较好的检出效果, 在嵌入式设备上实现了准确、快速的检测.

4 结论针对目前纺织业花色布匹瑕疵检测成本高、效率低和漏检率高等问题, 提出了一种基于改进ShuffleNetV2的轻量级花色布匹瑕疵检测方法并实现在嵌入式设备Raspberry Pi 4B上的部署检测. 本文方法在改进ShuffleNetV2网络基础上充分融合浅层位置信息与深层高级语义信息; 在检测输出部分将检测头进行解耦计算, 加快模型训练和收敛速度; 为提升瑕疵预测框的定位精度与加快收敛, 预测框采用CIoU损失函数计算边框损失. 实验结果表明, 本文方法在检测速度与模型参数量上有显著优势, 在极大减少企业花色布匹瑕疵检测成本的同时能满足瑕疵检测的要求.

| [1] |

Ngan HYT, Pang GKH, Yung NHC. Automated fabric defect detection—A review. Image and Vision Computing, 2011, 29(7): 442-458. DOI:10.1016/j.imavis.2011.02.002 |

| [2] |

孟志青, 邱健数. 基于级联卷积神经网络的复杂花色布匹瑕疵检测算法. 模式识别与人工智能, 2020, 33(12): 1135-1144. DOI:10.16451/j.cnki.issn1003-6059.202012008 |

| [3] |

李春雷, 高广帅, 刘洲峰, 等. 应用方向梯度直方图和低秩分解的织物疵点检测算法. 纺织学报, 2017, 38(3): 149-154. DOI:10.13475/j.fzxb.20160304106 |

| [4] |

孙国栋, 林松, 艾成汉, 等. 基于灰度共生矩阵与反向投影的织物疵点检测. 计算机测量与控制, 2016, 24(7): 65-67. DOI:10.16526/j.cnki.11-4762/tp.2016.07.018 |

| [5] |

Mak KL, Peng P, Yiu KFC. Fabric defect detection using morphological filters. Image and Vision Computing, 2009, 27(10): 1585-1592. DOI:10.1016/j.imavis.2009.03.007 |

| [6] |

陈剑威, 冯晓霞, 柳成林. 基于频率域滤波器的织物疵点检测. 闽南师范大学学报(自然科学版), 2020, 33(1): 18-23. DOI:10.16007/j.cnki.issn2095-7122.2020.01.004 |

| [7] |

Hu GH, Wang QH, Zhang GH. Unsupervised defect detection in textiles based on Fourier analysis and wavelet shrinkage. Applied Optics, 2015, 54(10): 2963-2980. DOI:10.1364/AO.54.002963 |

| [8] |

赵宏威, 王亦红. 基于改进Gabor优化选择的布匹瑕疵检测方法. 计算机工程与应用, 2019, 55(24): 202-207. DOI:10.3778/j.issn.1002-8331.1901-0403 |

| [9] |

Bu HG, Huang XB, Wang J, et al. Detection of fabric defects by auto-regressive spectral analysis and support vector data description. Textile Research Journal, 2010, 80(7): 579-589. DOI:10.1177/0040517509340599 |

| [10] |

Zhang Y, Jiang GM, Yao JZ, et al. Intelligent segmentation of jacquard warp-knitted fabric using a multiresolution Markov random field with adaptive weighting in the wavelet domain. Textile Research Journal, 2014, 84(1): 28-39. DOI:10.1177/0040517513485629 |

| [11] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [12] |

Girshick R. Fast R-CNN. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [13] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [14] |

蔡兆信, 李瑞新, 戴逸丹, 等. 基于Faster RCNN的布匹瑕疵识别系统. 计算机系统应用, 2021, 30(2): 83-88. DOI:10.15888/j.cnki.csa.007818 |

| [15] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [16] |

Redmon J, Farhadi A. YOLO9000: Better, faster, stronger. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6517–6525.

|

| [17] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [18] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [19] |

Jing JF, Zhuo D, Zhang HH, et al. Fabric defect detection using the improved YOLOv3 model. Journal of Engineered Fibers and Fabrics, 2020, 15: 1558925020908268.

|

| [20] |

Zheng LM, Wang XJ, Wang Q, et al. A fabric defect detection method based on improved YOLOv5. Proceedings of the 2021 7th International Conference on Computer and Communications (ICCC). Chengdu: IEEE, 2021. 620–624.

|

| [21] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017.

|

| [22] |

Howard A, Sandler M, Chu B, et al. Searching for MobileNetV3. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 1314–1324.

|

| [23] |

Zhang XY, Zhou XY, Lin MX, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6848–6856.

|

| [24] |

Ma NN, Zhang XY, Zheng HT, et al. ShuffleNet V2: Practical guidelines for efficient CNN architecture design. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 122–138.

|

| [25] |

Han K, Wang YH, Tian Q, et al. GhostNet: More features from cheap operations. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 1577–1586.

|

| [26] |

Tianchi. Smart diagnosis of cloth flaw dataset. https://tianchi.aliyun.com/dataset/dataDetail?dataId=79336. (2020-10-21).

|

| [27] |

Song GL, Liu Y, Wang XG. Revisiting the sibling head in object detector. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 11560–11569.

|

| [28] |

Ge Z, Liu ST, Wang F, et al. YOLOX: Exceeding YOLO series in 2021. arXiv:2107.08430, 2021.

|

| [29] |

Zheng ZH, Wang P, Ren DW, et al. Enhancing geometric factors in model learning and inference for object detection and instance segmentation. IEEE Transactions on Cybernetics, 2022, 52(8): 8574-8586. DOI:10.1109/TCYB.2021.3095305 |

| [30] |

王宸, 唐禹, 张秀峰, 等. 基于改进EfficientNet的锻件磁粉探伤智能检测方法研究. 仪器仪表学报, 2021, 42(9): 89-96. DOI:10.19650/j.cnki.cjsi.J2107796 |

| [31] |

Chen X, Gong Z. YOLOv5-lite: Lighter, faster and easier to deploy. https://pythonawesome.com/yolov5-lite-lighter-faster-and-easier-to-deploy/. (2021-09-05).

|

| [32] |

RangiLyu. NanoDet-Plus: Super fast and high accuracy lightweight anchor-free object detection model. https://github.com/RangiLyu/nanodet.

|

2023, Vol. 32

2023, Vol. 32