情绪是生物针对内部及外部事物的刺激而做出的一系列反应, 且情绪的存在对于生物而言至关重要. 近些年, 各个行业对情绪识别的需求不断增长, 在医疗方面, 情绪识别可以辅助心理疾病及精神疾病的研究和治疗[1], 此外, 通过情绪识别可以对病患的情感状态进行适当评估, 为医生制定合适的治疗方案提供极有利帮助. 同时, 情绪识别在VR游戏用户体验、实时监测驾驶员情绪状态[2]及特定犯人的审问等各个领域均发挥了重大作用. 目前, 情绪识别主要通过人的面部表情或者肢体动作等非生理信号进行研究, 相较而言, 基于脑电(electroencephalogram, EEG)、肌电(electromyography, EMG)以及心电(electrocardiogram, ECG)等生理信号的情绪识别研究还不够成熟. 然而, 由于生理信号能够更好地避开伪装等假性情绪, 可以更加准确地识别人的真实情感, 故基于生理信号的情绪识别正逐渐成为研究的热点[3].

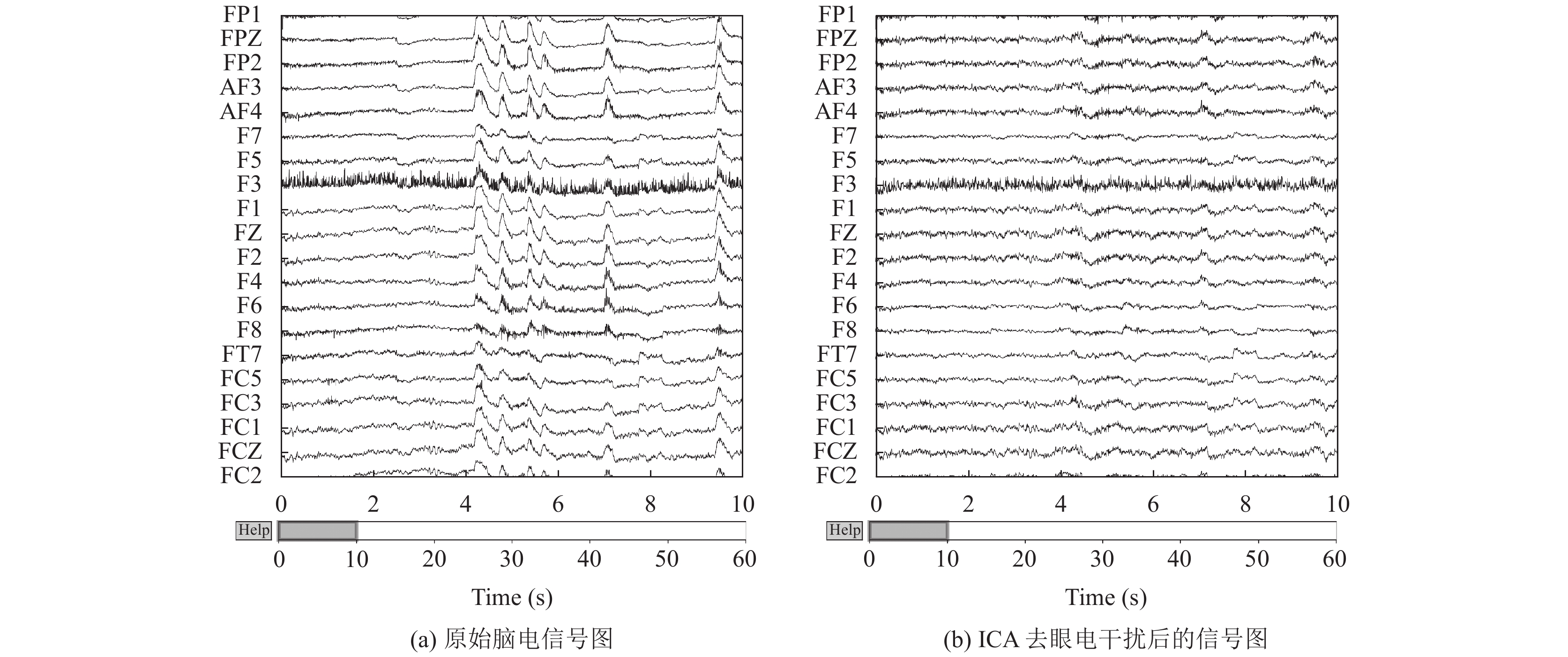

其中, 基于脑电的情绪识别过程一般包括脑电信号的采集、脑电信号的预处理、特征提取和情绪识别4部分. 目前, 不同型号的脑电信号采集系统之间的最大区别在于电极材料及放置方法不同. 电极主要包括湿电极和干电极两大类[4], 而本文用于模型验证的SEED数据集是通过使用湿电极帽的NeuroScan ESI-128系统[5]采集的. 脑电信号预处理先通过滤波器去除信号中工频噪声干扰, 再去除眼电、肌电及心电等伪迹干扰, 去除伪迹的主要方法有傅里叶变换(fast Fourier transform, FFT)、小波变换(wavelet transform, WT)及独立成分分析(independent component analysis, ICA)等[6]. 本文主要通过ICA去除眼电伪迹干扰. 准确实时的特征提取对于脑电情绪识别结果具有一定的影响, 用于情绪识别的脑电特征主要包括时域特征、频域特征、时频域特征及空间域特征, 本文提取频域特征作为分类模型的输入信号.

基于脑电信号的情绪识别算法主要包括机器学习算法和深度学习算法. 传统的机器学习算法, 如支持向量机(support vector machine, SVM)、K-近邻(K-nearest neighbor, KNN)和决策树(decision tree, DT)等, 理论发展成熟, 在情绪识别方面已经取得了一定的研究成果. 例如, 骆金晨等[7]采用希尔伯特黄变换、一对多共空间模式、近似熵、模糊熵和样本熵等多种特征融合算法, 通过主成分分析降维, 使用粒子群优化SVM对国际标准数据集 BCI2005 Data set IIIa中的k3b受试者数据进行分类处理得到93.30%的准确率, 之后采用此方法对4名实验者的脑电数据进行分类, 得到72.96%的平均识别率. Bhardwaj等[8]采用SVM及Fisher判别式的线性判别分析(linear discriminant analysis, LDA)对7种情感对应的脑电信号特征进行判别分析, 获得的平均分类准确率分别为74.13%和66.50%.

深度学习算法主要包括卷积神经网络(convolutional neural network, CNN)和循环神经网络(recurrent neural network, RNN)两类, 在脑电信号识别中亦得到了广泛应用, 并且相较于机器学习, 其识别率普遍更高. 如官金安等[9]采用3DCNN对IR-BCI的靶刺激和非靶刺激进行分类, 得到了85.2%的平均准确率. Qiao等[10]采用CNN的方法对DEAP数据集进行情绪识别, 得到了87.27%的平均识别率. Zheng等[11]采用深度信念网络(deep belief network, DBN)代替传统的分类器对脑电情感进行分类, 识别率达到86.08%.

然而, 若局限于使用单一的神经网络算法进行情绪分类识别, 会导致脑电信号的时间空间域信息不完整. 为解决这一问题, 一些研究人员首先提出CNN与长短时期记忆神经网络(long short term memory, LSTM)结合, 并取得良好的应用效果. 蔡冬丽等[12]提出一种3DCNN结合双向LSTM的混合神经网络(3DCNN-BLSTM), 并在SEED数据集上验证, 得到98%的准确率. 为解决LSTM的参数较多导致训练时间过长的问题, 提出以门控循环单元(gated recurrent unit, GRU)代替LSTM进行时序特征提取. 目前, 采用CNN与GRU结合的混合神经网络主要应用在非生理信号方面的情感识别. 如Swain等[13]采用级联CNN和GRU结合的混合模型 (CGRU) 对采用语音信号的韵律和频谱特征进行语音情感识别, 并在Odia语言数据集上面验证, 发现使用CGRU算法比单独使用CNN与GRU提高了5.36%与6.52%的准确率. Cheng等[14]提出采用多通道卷积与双向GRU多头注意力胶囊混合模型提取文本序列的多层次特征, 在情感分类通用语料库中的3个英文数据集和一个中文数据集进行实验, 取得比其他基线模型更好的结果. 而在生理信号的脑电情绪识别中应用较少, 用于基于脑电的情绪分类研究中更少. 黄永庆等[15]构建了CNN-GRU模型对原始脑电信号进行情绪识别, 虽然在公开数据集中验证获得89.20%的准确率, 然而在自采数据集上仅获得83.76%的辨识率, 结果表明预处理和特征提取过程对分类结果具有一定的影响.

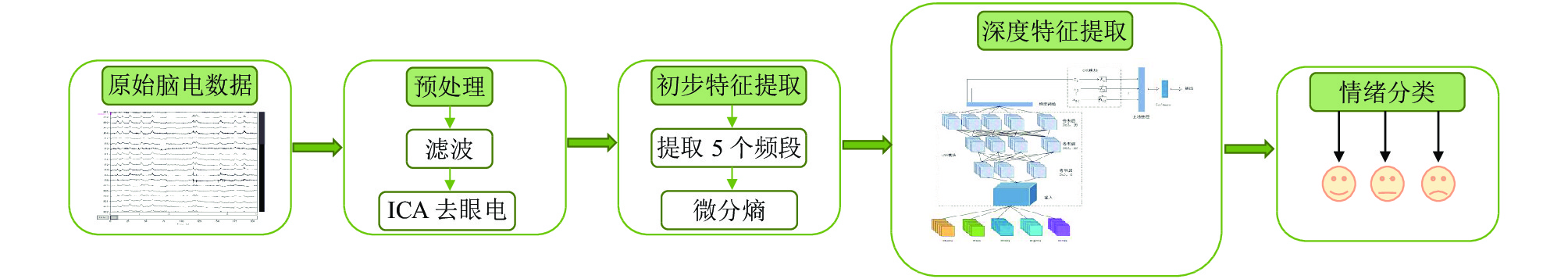

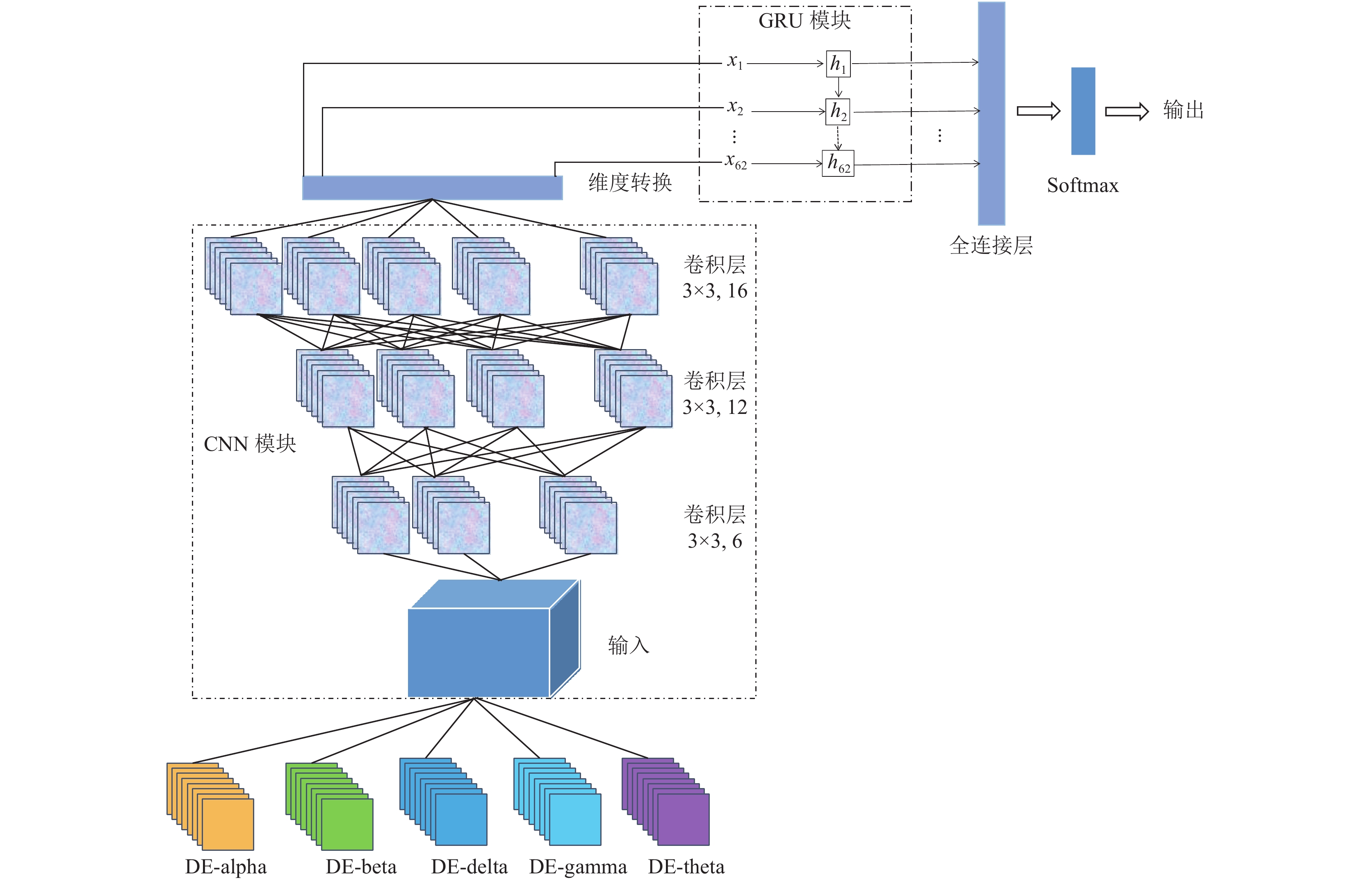

故本文在此基础上进行改进, 增加初步特征提取过程, 将初步特征提取过程与CNN和GRU结合, 提出一种混合特征提取分类模型DE-CNN-GRU. 首先对原始数据集的微分熵(differential entropy, DE)进行初步特征提取, 删减部分无用信息, 保留有效特征. 随后将其输入到CNN-GRU网络模型, 进一步提取时间与空间域特征信息, 以解决特征信息提取不完整问题, 最终结合Softmax进行情绪分类. 在SEED数据集上验证该模型的有效性, 获得分类准确率最高为98.9%. 整体实验框架如图1所示.

本文主要工作如下: 第1节简单介绍相关算法原理; 第2节介绍整体的实验过程; 第3节对实验结果进行分析与对比; 第4节为总结.

|

图 1 DE-CNN-GRU基本框架 |

1 算法原理 1.1 微分熵

DE主要是用于描述连续变量的复杂性, 其计算公式如下:

| $ DE = - \int_X {f(x)\log (f(x))dx} $ | (1) |

其中,

| $ \begin{split} DE = & - \int_{ - \infty }^{ + \infty } {\frac{1}{{\sqrt {2\pi {\sigma ^2}} }}{{\rm{e}}^{\frac{{{{(x - \mu )}^2}}}{{2{\sigma ^2}}}}}\log \left(\frac{1}{{\sqrt {2\pi {\sigma ^2}} }}{{\rm{e}}^{\frac{{{{(x - \mu )}^2}}}{{2{\sigma ^2}}}}}\right)dx} \\ = & \frac{1}{2}\log (2\pi {\rm{e}}{\sigma ^2}) \end{split} $ | (2) |

本文将经过预处理的脑电数据集分为alpha、beta、delta、gamma及theta这5个频段, 再分别提取DE特征, 对于某一频带DE特征可表示为如下公式[17]:

| $ DE = \frac{1}{2}\log ({P_i}) + \frac{1}{2}\log \left(\frac{{2\pi {\rm{e}}}}{N}\right) $ | (3) |

其中,

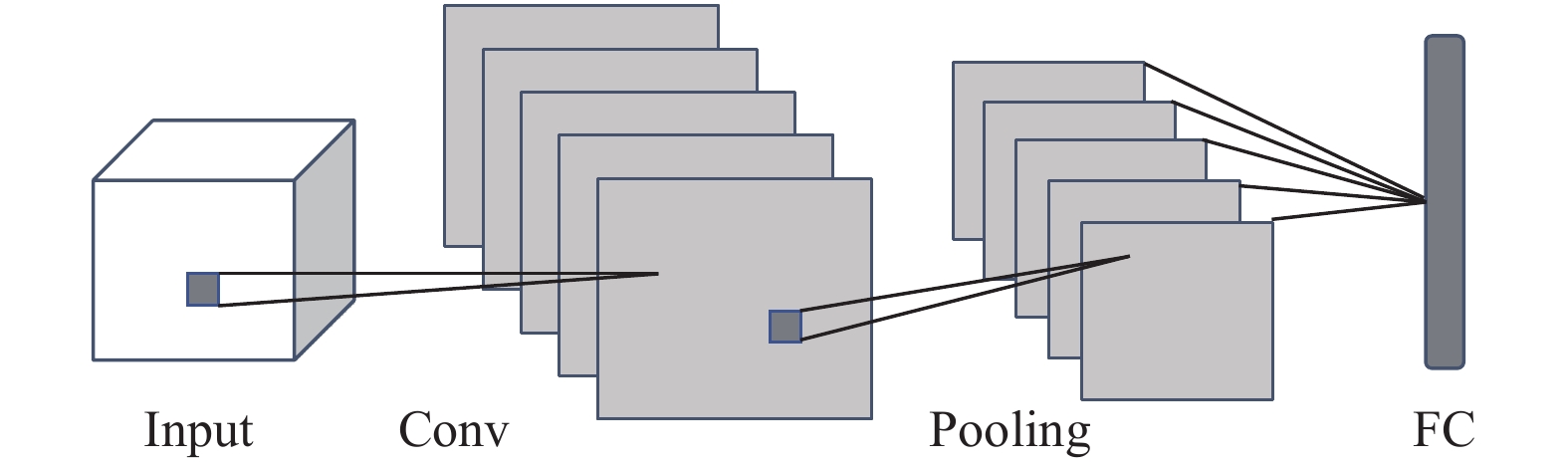

CNN是由卷积层(Conv)、池化层(pooling)和全连接层(FC)构成, 如图2所示. 卷积处理有两个特性, 即权值共享和局部连接. 权值共享是指其通过每个卷积核进行卷积计算, 输出不同的特征, 可见想要获得所需要的特征信息, 必须要选择合适的卷积核. 局部连接是指输入中的每个神经元与前一层的局部感受野连接在一起, 对局部进行感知, 综合局部信息作为全局信息. 每个卷积层都包含一个激活函数对提取的特征进行非线性变换, 本文选择线性整流函数(ReLU)作为卷积层中的激活函数. 池化层也称为下采样层, 可以有效减少神经网络中的参数, 以防止过拟合[18]. 在CNN的末端需要连接一个全连接层, 全连接层的每个神经元都与前一层的神经元相连接, 将前层计算得到的多维特征向量映射为一维的向量, 以减少由于特征位置排布对于分类结果的影响, 提高了整个网络的鲁棒性.

|

图 2 CNN的结构图 |

1.3 门控循环单元

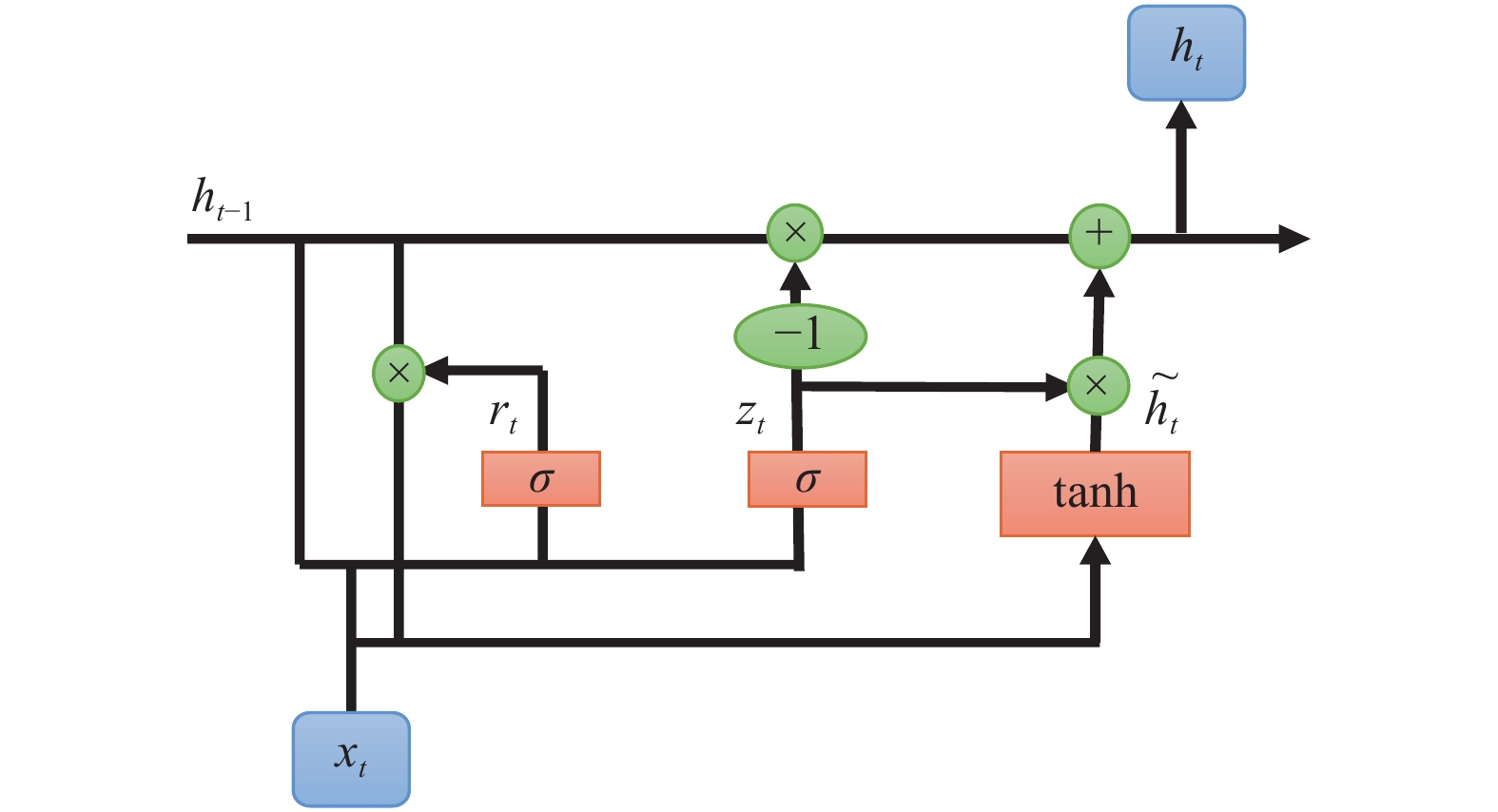

GRU是由Cho等人提出的LSTM的一种改进的神经网络[19], 与LSTM一样, 可以解决RNN中出现的梯度消失问题. GRU的原理与LSTM非常相似, 且在很多情况下表现出的实际效果相差无几. 两者不同之处在于, GRU只有两个门: 一个是将LSTM中的输入门与遗忘门合二为一的更新门, 控制前面记忆信息能够继续保留到当前时刻的数据量; 另一个是重置门, 主要控制要遗忘多少过去的信息. LSTM需要多个门控控制“遗忘”和“记忆”, 而GRU只需要一个门控, 所以GRU的参数量比LSTM少, 能够很大程度上提高训练效率. 图3展示了GRU的基本内部结构, 其表达式如下所示:

| $ {{\textit{z}}_t} = \sigma ({W_z} \times [{h_{t - 1}}, {x_t}]) $ | (4) |

| $ {r_t} = \sigma ({W_r} \times [{h_{t - 1}}, {x_t}]) $ | (5) |

| $ {\tilde h_t} = \tanh ({W_{\tilde h}} \times [{r_t} \times {h_{t - 1}}, {x_t}]) $ | (6) |

| $ {h_t} = (1 - {{\textit{z}}_t}) \times {h_{t - 1}} + {{\textit{z}}_t} \times {\tilde h_t} $ | (7) |

其中,

|

图 3 GRU的内部结构图 |

2 实验过程 2.1 实验平台

本实验全过程均在Intel(R) Core(TM) i5-12400F 4.4 GHz处理器、GPU为NVIDIA RTX3060的环境下, 使用Python 3.7编程语言以及TensorFlow深度学习框架进行的.

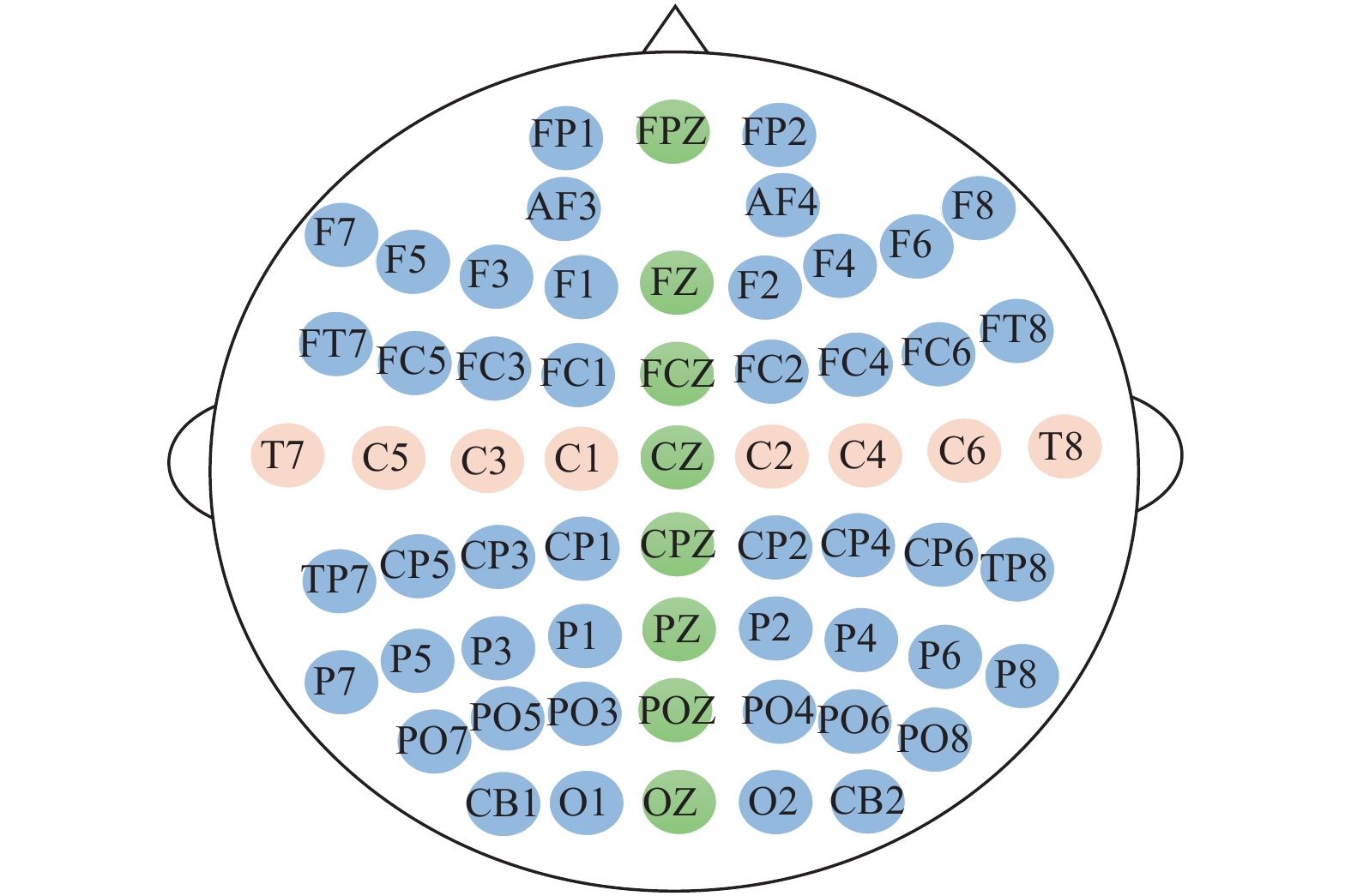

2.2 数据集实验采用上海交通大学的公开数据集SEED数据集[20]作为原始数据集, 进行积极、消极以及中性的三分类情绪识别研究. 受试者一共15名(7名男性, 8名女性, 平均年龄23.27), 每位受试者需要进行3次实验, 并且每两次实验间隔一周及以上. 每次实验需要观看15个电影片段, 故每次实验共有15个实验trials. 这些电影片段是从6部电影中截取的, 代表了3种不同情绪, 其中每种情绪包括5个片段, 每个片段大约4 min, 且同一种情绪的片段不会连续播放. 表1是数据集采集所需要的刺激视频的详细信息. 每个受试者的脑电信号均有62个通道, 根据国际10-20标准系统的62通道的电极分布如图4所示. 之后对采集的脑电信号进行下采样处理, 将信号频率从1000 Hz降到200 Hz, 并用0–75 Hz的带通滤波器进行滤波处理, 得到预处理后的数据集. 本文将预处理后的数据集进一步通过ICA去除眼电信号的干扰, 如图5所示. 图5(a)是原始脑电信号图, 尖峰突出, 有明显的眨眼伪迹, 图5(b)是经过ICA去眼电干扰后的信号图, 尖峰消失, 明显比左侧图信号平稳, 有效去除眼电伪迹.

| 表 1 实验中所需影片的详细信息 |

|

图 4 62通道电极分布图 |

2.3 特征提取

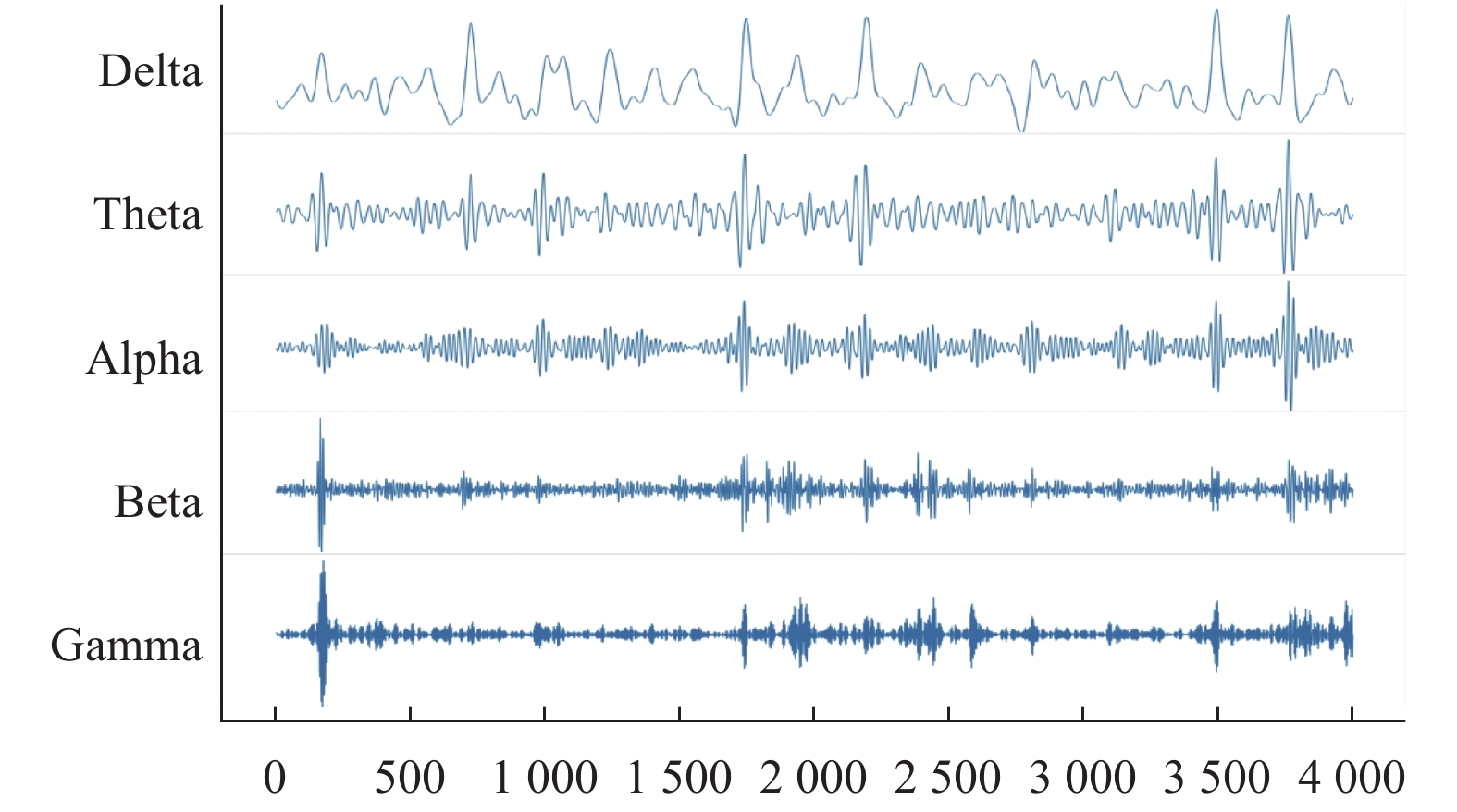

尽管CNN与GRU均可以直接对原始脑电信号进行特征提取及分类, 但为保证特征信息的完整性, 在将数据输入至CNN-GRU模型之前, 提取DE特征作为初始特征. 首先将经过滤波以及ICA去眼电后的脑电信号分为delta (0.5–3.5 Hz)、theta (4–7 Hz)、alpha (8–13 Hz)、beta (14–30 Hz)及gamma (31–50 Hz)这5个频段信号, 图6为第1位受试者的FP1通道的5个频段图. 之后对5个频段分别提取DE特征[21], 每个频段每个通道每隔1 s取一次. 由于SEED数据集中15个情绪片段的截取时长不同, 所以每个trial的采样点数不同. 其中, 代表中性情绪的第5个trial的采样点数最小, 为185. 故本文为统一起见, 以185为标准, 将每位受试者的DE特征构建为62×185×5的三维特征矩阵. 将其输入到CNN-GRU结合网络模型中进行深度时间空间域特征提取.

|

图 5 ICA去眼电前后脑电信号对比图 |

|

图 6 第1位受试者的FP1通道的5个频段波形图像 |

2.4 DE-CNN-GRU混合网络模型

DE-CNN-GRU混合模型结构框架如图7所示. 首先将DE特征输入到CNN模块的卷积层中提取脑电信号的空间信息, 并在卷积层之后增加一个池化层, 减少一定的参数, 以便提取更加有用的脑电信息. 之后将通过CNN模块提取到的空间信息进行维度变换, 由三维矩阵转变为适合输入到GRU模块的二维矩阵, 通过GRU模块提取时间域信息. 最后通过Softmax函数进行情绪识别分类.

整个DE-CNN-GRU网络模型包含3个卷积层, 3个最大池化层, 2个全连接层及1个GRU层. 3个卷积层均以ReLU作为激活函数, 卷积核为3×3, 填充方式为“same”, 代表填充输入以使输出具有与原始输入相同的长度[22]. 最大池化层的池大小为2×2, 步长为2×2. GRU层的激活函数为tanh, 输出维度设置为128, GRU后面的全连接层的输出维度为128, 之后使用Softmax函数进行三分类, 如表2所示.

本文所提模型的参数设置如下: 迭代次数为1000次, 优化器选择Adam优化器用于学习, 其学习率为1E–4, 损失函数为交叉熵损失函数, 评估标准是准确率. 训练集及测试集是按照7:3的比例进行划分, 输入到DE-CNN-GRU中进行训练.

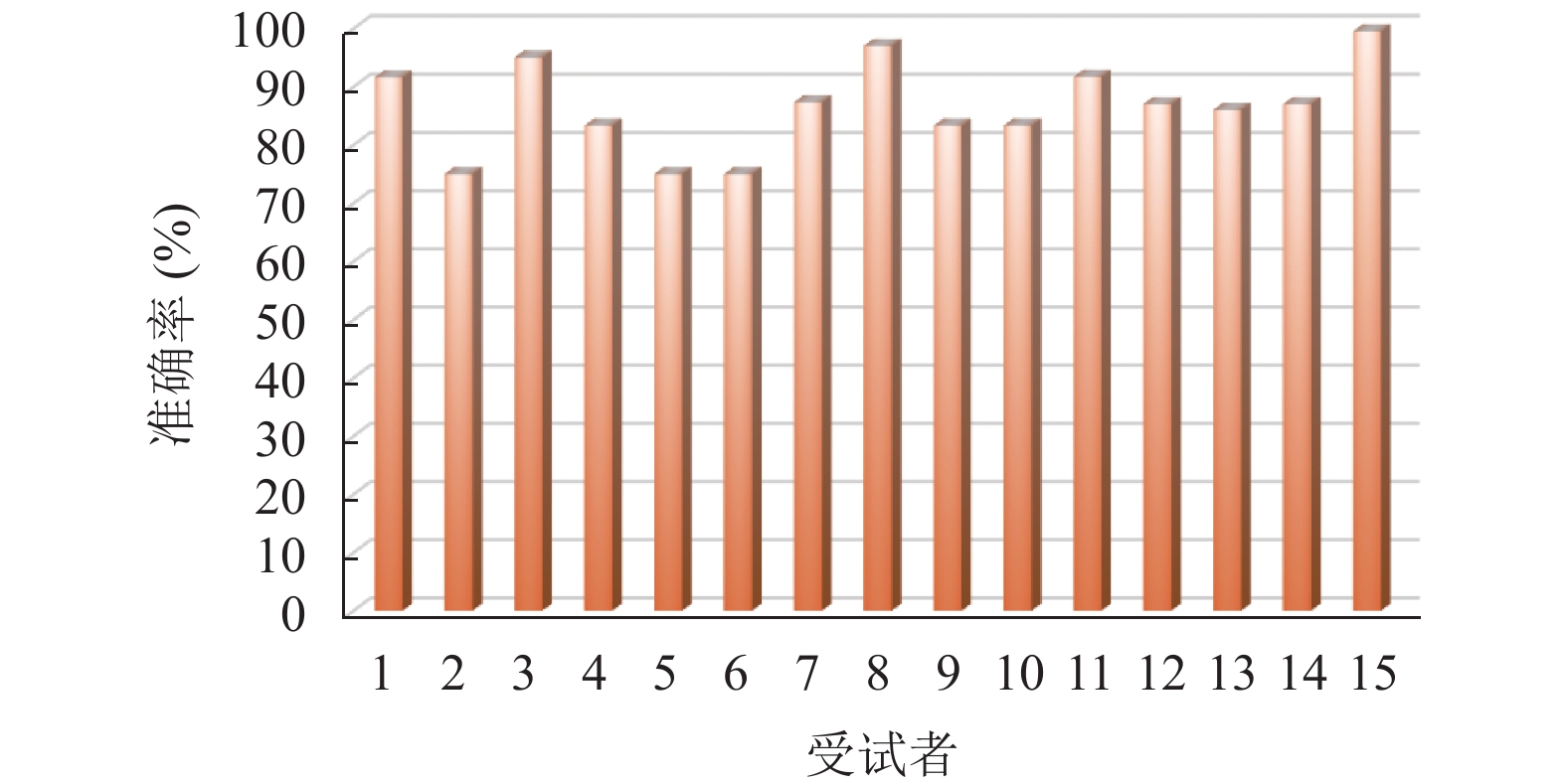

3 实验结果与分析 3.1 实验结果将15名受试者的DE特征输入CNN-GRU混合模型, 在混合模型中进行训练. 通过该模型进一步提取空间时间信息, 输入到Softmax函数中进行情绪三分类(积极、中性和消极). 图8为经过1000次迭代后每位受试者的分类准确率的柱形图. 由图8可知, 第15位受试者的分类准确率最高, 可达98.9%, 由此可验证该模型在基于脑电的情绪识别研究中的有效性. 此外, 该实验结果表明, 有些受试者的分类准确率较低, 而有些受试者的分类准确率很高, 究其原因, 可能是由于每个人对于刺激的反应强度不同导致数据差异性大小不同, 分类效果亦不同.

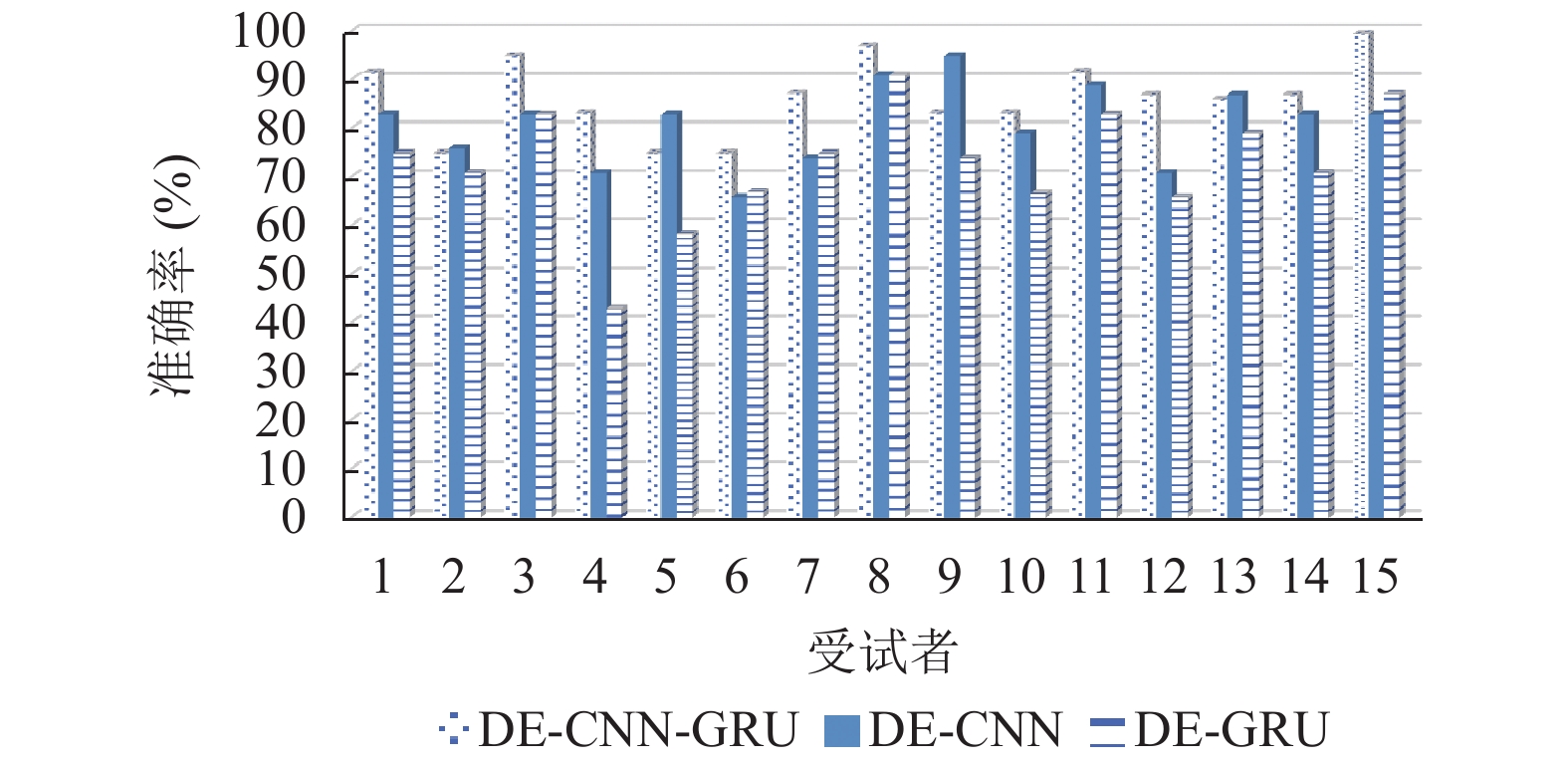

3.2 混合模型与单一模型的比较CNN-GRU模型是CNN与GRU两个单一模型结合成的混合模型, 为证明该混合模型的分类效果优于单一模型, 本文设计DE-CNN、DE-GRU两个单一模型的实验进行对比分析, 为保证单一变量, 两个单一模型只有最后的分类算法与混合模型不同, 前面的预处理阶段以及DE特征提取阶段都与之相同. 3种不同模型的分类准确率如图9所示, 图9结果表明DE-CNN-GRU混合模型对15位受试者的分类准确率普遍高于DE-CNN、DE-GRU两个单一模型. 这3种模型的平均分类准确率如表3所示, 可知, DE-CNN-GRU混合模型的分类能力优于DE-CNN与DE-GRU单一模型, 由此可见, 通过更好地提取时间与空间信息特征, DE-CNN-GRU混合模型对于脑电情绪识别具有更优的效果.

|

图 7 DE-CNN-GRU混合模型结构框架 |

| 表 2 混合网络结构的具体细节 |

3.3 与其他算法的比较

为了进一步验证本文DE-CNN-GRU模型的有效性与优越性, 将其与已有文献中提到的情绪识别算法结构进行对比分析, 结果如表4所示. Badicu等[23]对原始脑电数据集使用LSTM进行分类, 得到80.00%的识别准确率. Li等[24]采用CNN和LSTM的混合循环神经网络(CLRNN)对DEAP数据集进行分类, 得到的准确率为75.21%. Ren等[25]采用K-means算法与WT进行特征提取, SVM作为分类器, 得到78.20%的准确率. Brown等[26]将左右电极alpha频段的功率比作为特征, 采用KNN算法进行分类处理得到82.00%的准确率. Gonzalez等[27]采用CNN作为分类器在DEAP数据集上进行分类任务, 得到唤醒度为72.42%, 效价度为70.26%, 表4只列出了该算法得到的唤醒度结果. 与之相比, 本文的混合模型比单一模型更加完整地提取脑电特征信息, 提高了分类准确率. 为进一步验证本文所提混合算法DE-CNN-GRU的有效性与优越性, 将其与Li等[28]所提出的和本文思路类似的混合模型WT-CNN-RNN进行比较. Li等利用稀疏WT将原始脑电信号变换成二维频谱图输入CNN-RNN混合网络, 在效价和唤醒度两个维度上的准确率分别为72.06%和74.12%, 同样, 表4只列出唤醒度结果. 由表4可知, 本文所提出的混合模型对基于脑电信号的情绪识别研究得到的平均准确率为86.50%, 明显优于大多数算法模型的分类结果.

|

图 8 15位受试者的三分类准确率 |

|

图 9 不同模型的分类准确率对比分析 |

| 表 3 3种模型的平均分类准确率 |

| 表 4 与其他研究算法的比较 |

4 总结

本文以脑电信号为研究对象进行情绪识别研究, 采用DE-CNN-GRU混合模型进行特征提取与分类. 通过两次特征提取, 即初步提取DE特征后进一步深度提取时间空间信息, 以保证时空域特征信息的完整性, 最后通过Softmax函数进行分类. 在国际公开数据集SEED上验证该混合模型的效果, 取得了86.50%的平均分类准确率. 通过与DE-CNN或DE-GRU两个单一模型进行对比, 可证明混合模型的平均准确率优于单一模型, 分别高出5.57%与13.82%. 同时, 与其他算法进行比较, 发现本文提出的混合模型对情绪分类的效果是优于大多已有算法的, 证明了该混合模型的适应性和有效性. 此外, 该混合模型的参数及结构仍然具备一定的提升空间, 这将在今后的研究工作中进一步讨论.

| [1] |

王晴. 基于脑电信号的情绪分类[硕士学位论文]. 北京: 北京邮电大学, 2019.

|

| [2] |

王浩伦, 朱业安, 彭理群, 等. 汽车驾驶人的情绪诱发与识别研究综述. 交通信息与安全, 2018, 36(4): 1-6, 50. DOI:10.3963/j.issn.1674-4861.2018.04.001 |

| [3] |

Jenke R, Peer A, Buss M. Feature extraction and selection for emotion recognition from EEG. IEEE Transactions on Affective Computing, 2014, 5(3): 327-339. DOI:10.1109/TAFFC.2014.2339834 |

| [4] |

赵倩, 谭浩然, 王西岳, 等. 脑电采集电极研究进展. 科学技术与工程, 2021, 21(15): 6097-6104. DOI:10.3969/j.issn.1671-1815.2021.15.002 |

| [5] |

滕凯迪, 赵倩, 谭浩然, 等. 基于SVM-KNN算法的情绪脑电识别. 计算机系统应用, 2022, 31(2): 298-304. DOI:10.15888/j.cnki.csa.008332 |

| [6] |

杜晓燕, 李颖洁, 朱贻盛, 等. 脑电信号伪迹去除的研究进展. 生物医学工程学杂志, 2008, 25(2): 464-467, 471. DOI:10.3321/j.issn:1001-5515.2008.02.048 |

| [7] |

骆金晨, 姜月, 胡秀枋, 等. 基于多特征融合的多分类运动想象脑电信号识别研究. 生物信息学, 2020, 18(3): 176-185. DOI:10.12113/201912006 |

| [8] |

Bhardwaj A, Gupta A, Jain P, et al. Classification of human emotions from EEG signals using SVM and LDA classifiers. Proceedings of the 2015 2nd International Conference on Signal Processing and Integrated Networks (SPIN). Noida: IEEE, 2015. 180–185.

|

| [9] |

官金安, 汪鹭汐, 赵瑞娟, 等. 基于3D卷积神经网络的IR-BCI脑电视频解码研究. 中南民族大学学报(自然科学版), 2019, 38(4): 538-546. DOI:10.12130/znmdzk.20190411 |

| [10] |

Qiao R, Qing CM, Zhang T, et al. A novel deep-learning based frame-work for multi-subject emotion recognition. Proceedings of the 2017 4th International Conference on Information, Cybernetics and Computational Social Systems. Dalian: IEEE, 2017. 181–185.

|

| [11] |

Zheng WL, Guo HT, Lu BL. Revealing critical channels and frequency bands for emotion recognition from EEG with deep belief network. Proceedings of the 2015 7th International IEEE/EMBS Conference on Neural Engineering (NER). Montpellier: IEEE, 2015. 154–157.

|

| [12] |

蔡冬丽, 钟清华, 朱永升, 等. 基于混合神经网络的脑电情感识别. 华南师范大学学报(自然科学版), 2021, 53(1): 109-118. DOI:10.6054/j.jscnun.2021017 |

| [13] |

Swain M, Maji B, Das U. Convolutional gated recurrent units (CGRU) for emotion recognition in Odia Language. Proceedings of the IEEE EUROCON 2021 19th International Conference on Smart Technologies. Lviv: IEEE, 2021. 269–273.

|

| [14] |

Cheng Y, Sun H, Chen HM, et al. Sentiment analysis using multi-head attention capsules with multi-channel CNN and bidirectional GRU. IEEE Access, 2021, 9: 60383-60395. DOI:10.1109/ACCESS.2021.3073988 |

| [15] |

黄永庆, 周强. 基于CNN-GRU融合网络的情绪脑电信号辨别研究. 传感技术学报, 2021, 34(8): 1109-1116. DOI:10.3969/j.issn.1004-1699.2021.08.016 |

| [16] |

陈万, 蔡艳平, 李爱华, 等. 基于脑电微分熵的警觉度估计方法. 计算机应用研究, 2022, 39(8): 2347-2351. DOI:10.19734/j.issn.1001-3695.2022.01.0021 |

| [17] |

戴紫玉, 马玉良, 高云园, 等. 基于多尺度卷积核CNN的脑电情绪识别. 传感技术学报, 2021, 34(4): 496-503. DOI:10.3969/j.issn.1004-1699.2021.04.011 |

| [18] |

Liu FG, Zhang ZW, Zhou RL. Automatic modulation recognition based on CNN and GRU. Tsinghua Science and Technology, 2022, 27(2): 422-431. DOI:10.26599/TST.2020.9010057 |

| [19] |

Cho K, Van Merriënboer B, Bahdanau D, et al. On the properties of neural machine translation: Encoder-decoder approaches. Proceedings of the 8th Workshop on Syntax, Semantics and Structure in Statistical Translation. Doha: Association for Computational Linguistics, 2014. 103–111.

|

| [20] |

Zheng WL, Lu BL. Investigating critical frequency bands and channels for EEG-based emotion recognition with deep neural networks. IEEE Transactions on Autonomous Mental Development, 2015, 7(3): 162-175. DOI:10.1109/TAMD.2015.2431497 |

| [21] |

Duan RN, Zhu JY, Lu BL. Differential entropy feature for EEG-based emotion classification. Proceedings of the 2013 6th International IEEE/EMBS Conference on Neural Engineering. San Diego: IEEE, 2013. 81–84.

|

| [22] |

张学军, 陈都, 孙知信. 基于卷积神经网络的脑电信号情绪分类方法. 电子测量技术, 2022, 45(1): 1-7. DOI:10.19651/j.cnki.emt.2108357 |

| [23] |

Badicu B, Udrea A. Cross-subjects emotions classification from EEG signals using a hierarchical LSTM based classifier. Proceedings of the 2019 E-Health and Bioengineering Conference. Iasi: IEEE, 2019. 1–4.

|

| [24] |

Li YJ, Huang JJ, Zhou HY, et al. Human emotion recognition with electroencephalographic multidimensional features by hybrid deep neural networks. Applied Sciences, 2017, 7(10): 1060. DOI:10.3390/app7101060 |

| [25] |

Ren FJ, Dong YD, Wang W. Emotion recognition based on physiological signals using brain asymmetry index and echo state network. Neural Computing and Applications, 2019, 31(9): 4491-4501. DOI:10.1007/s00521-018-3664-1 |

| [26] |

Brown L, Grundlehner B, Penders J. Towards wireless emotional valence detection from EEG. Proceedings of the 2011 Annual International Conference of the IEEE Engineering in Medicine and Biology Society. Boston: IEEE, 2011. 2188–2191.

|

| [27] |

Gonzalez HA, Yoo J, Elfadel IM. EEG-based emotion detection using unsupervised transfer learning. Proceedings of the 2019 41st Annual International Conference of the IEEE Engineering in Medicine and Biology Society. Berlin: IEEE, 2019. 694–697.

|

| [28] |

Li X, Song DW, Zhang P, et al. Deep fusion of multi-channel neurophysiological signal for emotion recognition and monitoring. International Journal of Data Mining and Bioinformatics, 2017, 18(1): 1-27. DOI:10.1504/IJDMB.2017.086097 |

2023, Vol. 32

2023, Vol. 32