行人重识别(person re-identification, Re-ID)指跨摄像头, 跨场景在特定视频或者图像集中检索同一行人或者区别不同行人[1]. 随着智能视频监控日益凸显的应用需求, Re-ID的研究已成为计算机视觉领域的热点问题[2-4]. 在监控场景中, 行人个体的相互遮挡、行人受背景的遮挡是普遍存在的现象, 增加了Re-ID的难度. 关键问题在于, 遮挡会在行人表征过程中引入过多的噪声, 降低特征的表示能力. 近年来, 尽管深度学习在Re-ID应用研究中的不断深入, 但同样面临该问题的挑战. 相较于一般Re-ID, 遮挡Re-ID需要处理图像中由遮挡物造成的噪声信息. 因此直接对整张图像进行特征提取, 往往难以学习到鲁棒的识别特征.

目前针对遮挡Re-ID的多数研究方法都关注于遮挡区域的抑制. Sun等人[5]提出了一种可见部件感知模型(visibility-aware part model, VPM), 先将人体划分为3个部分, 然后通过自监督学习方式确定人体部件可见或不可见, 网络只需关注不同遮挡图像中共同可见的部件特征. 但VPM的区域划分较为粗粒度, 不够细致. 而文献[6-9]通过局部区域定位的方式引导网络关注行人非遮挡区域, 起到了过滤遮挡噪声的作用, 从而降低遮挡对Re-ID的干扰. Zhao等人[6]使用多阶段特征融合的方式提取不同部位的特征, 再按像素层比较特征值, 保留最大值的特征, 达到去除遮挡噪声的目的. Su等人[7]根据人体姿态估计模型输出的14个关键点把行人分成6区域, 通过赋予行人每个特征区域一个不同的权重, 起到抑制遮挡噪声作用. Miao等人[9]提出了(pose-guided feature alignment, PGFA) 方法, 通过预先定义关节点置信度的阈值, 来确定未遮挡的人体区域, 然后结合人体区域的全局特征和水平切块的局部特征, 增强网络处理遮挡问题的能力. Gao等人[8]提出的(pose-guided visible part matching, PVPM) 网络则是通过生成伪标签的形式单独训练一个人体部件可见度网络, 引导网络关注未遮挡区域. 但这些方法存在过分依赖姿态估计模型的问题. 它们将行人特征的提取以及后续构建其他行人身份匹配的规则都完全建立在姿态估计模型输出的准确性上. 当姿态估计网络不准确时, 会导致Re-ID的性能出现严重下降, 增添了网络的不稳定性.

上述遮挡Re-ID方法都试图先定位遮挡物位置, 然后提取非遮挡部分的行人特征, 最后将可见行人部分特征与完整行人图像特征进行对齐与身份匹配. 于是, 针对Re-ID中的遮挡问题, 本文提出了一种姿态驱动的特征重构网络(pose-driven feature alignment network, PDFA), 该网络包括姿态编码器(pose encoder, PE)、行人部件对齐模块(human parts alignment module, HPAM)两个部分组成. 其中, 姿态修正编码器PE对人体姿态估计模型 (human pose estimation network, HPEN)输出的关键点的置信度进行动态调整, 抑制区域遮挡导致的关键点错误; 最后, 在全身(holistic)数据集、半身(partial)数据集和遮挡(occluded)数据集进行了仿真实验. 实验结果表明所提方法行人重识别效果优于其他对比算法.

1 姿态驱动的行人重识别方法本网络主要包含姿态编码器和姿态对齐两个模块, 如图1. 姿态编码模块的作用是判别行人是否存在遮挡情况, 并通过骨骼关键点置信度, 引导特征提取网络关注可见部分的行人特征; 姿态对齐模块首先根据姿态修正模块的置信图, 对行人各个部位的特征进行精确定位, 然后提取不同区域的局部特征.

|

图 1 网络框架 |

1.1 姿态编码器

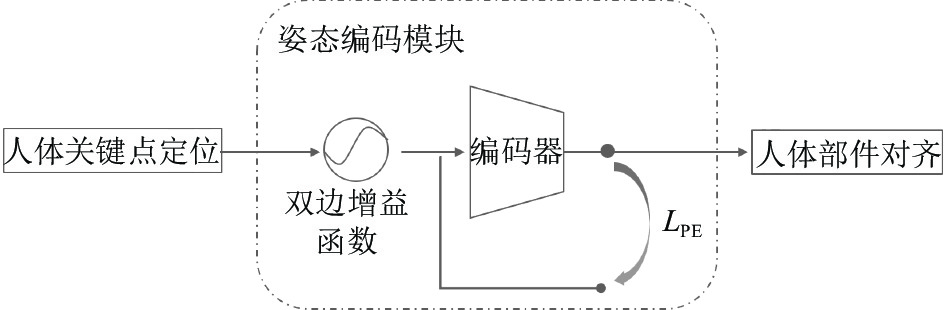

解决遮挡问题的关键在于提取行人特征, 减少遮挡区域特征的干扰. 通过观察经典的HPEN (如OpenPose[10]等)在遮挡与半身Re-ID数据集上的表现, 说明HPEN无法很好地解决遮挡状况下人体关键点的定位问题. 若在上述问题没有得到很好处置的情况下, Re-ID网络完全依赖于HPEN的输出, 则必然会出现不理想的Re-ID结果. 为了使网络在遇到遮挡情况时引导特征提取网络关注行人特征, 本文提出了姿态编码模块, 包括编码器(encoder)与双边增益函数(bilateral optimization function, BOF), 如图2所示.

|

图 2 姿态编码器 |

由于HPEN不参加训练, 其网络参数是恒定的, 当遮挡造成关键点热力图错误时, Re-ID结果也会出现偏差. 但Re-ID网络无法通过改变HPEN的参数来抑制噪声. 于是本文提出了编码器. 当样本存在遮挡区域时, 编码器可以通过梯度的反向传播精准的微调(fine-tune)编码器, 减少被遮挡人体部位的置信度, 使得Re-ID网络降低对遮挡区域特征的响应程度, 从而达到抑制非行人特征, 关注行人特征的目的.

具体说, 本文在HPEN后连接了一个CNN结构, 对HPEN输出的关键点热力图进行自适应调整. 首先, 输入样本通过HPEN输出关键点热力图

| y={1,y⩾1ex2−1,others | (1) |

| δiHPEN=max(yiHPEN) | (2) |

| LPE=MSE(Y′HPEN,YPE)=1nn∑i=1δiHPEN(y′iHPEN−yiPE)2 | (3) |

其中,

遮挡Re-ID的本质是遮挡后的行人图像与原始行人图像之间的匹配问题. 由于遮挡导致行人特征不完整, 在进行特征比较时, 易出现特征错位, 进而增大了Re-ID的难度. 为此, 本文在PE后设计了姿态部件对齐模块, 获得更多细致的行人特征信息.

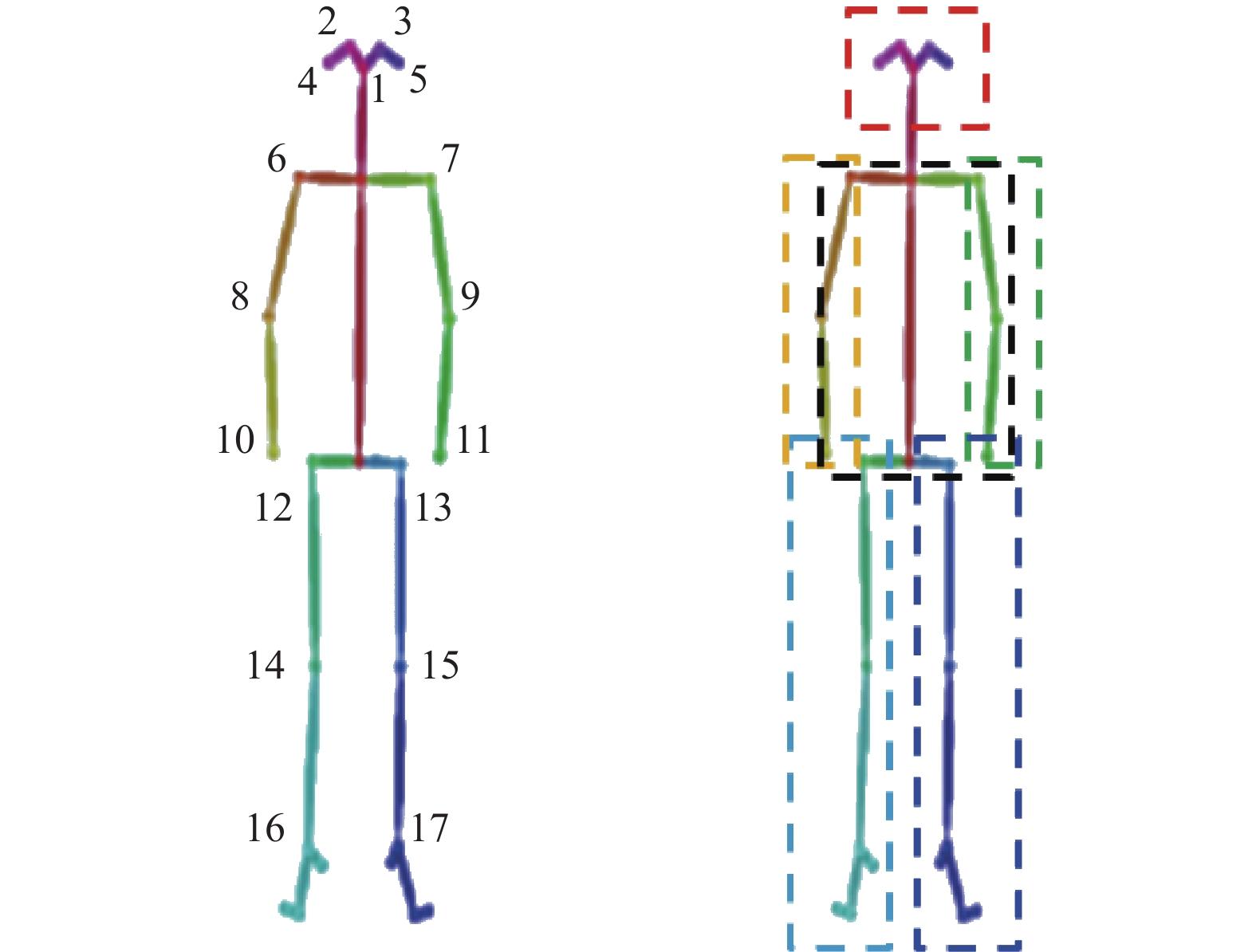

此模块对图像中的人体部位进行定位, 抑制遮挡噪声, 以获得有效的行人特征. 首先, 此模块根据HPEN输出的17个骨骼关键点热力图划分为6局部区域热力图H1–H6, 如图3所示. 接着, 将局部区域热力图和人体全局特征图 进行外积操作, 然后将外积后获得的不同人体部位的局部特征图通过全连接层FC映射成2 048维向量

| {fi=(yBackbone)⊗(yiPE⋅δiHPEN)Lcross=−n∑i=0p(xi)log(q(xi)) | (4) |

其中,

|

图 3 人体部件划分示意图 |

1.3 损失函数

为了使新提出的Re-ID模型拥有出色的行人特征提取能力, 采用多任务学习的策略. 同时训练多个网络分支, 包括2个主要部分: 特征提取模块与姿态编码器模块. 于是总的损失函数为式(5):

| L=Lcross+LPE | (5) |

其中,

硬件环境: CPU Intel Xeon(R) E5-2640, 内存8 GB, 显卡Nvidia GTX2070 Super; 软件环境: 操作系统为64位Ubuntu 16.04.7, 基于Python 3.7.9的深度学习框架PyTorch 1.8.1完成程序编程.

2.2 实验数据与评估指标为了验证本文所提方法的有效性, 分别使用7种公开的数据集进行实验, 包括3种全身数据集(Market-1501[3]、DukeMTMC-ReID[11]), 两种半身数据集(Partial-ReID[12]、Partial-iLIDS[13])和两种遮挡数据集(Occluded-Duke[9]、Occluded-ReID[14]). 本文使用了平均精确均值(mean average precision, mAP)和首位准确率(Rank-1)作为评估指标. Rank-1代表第1张图像与目标图像是同一行人ID的准确度. mAP如式(6),

| {APi=1mn∑i=1(p(i)⋅g(i))mAP=n∑i=1APiC | (6) |

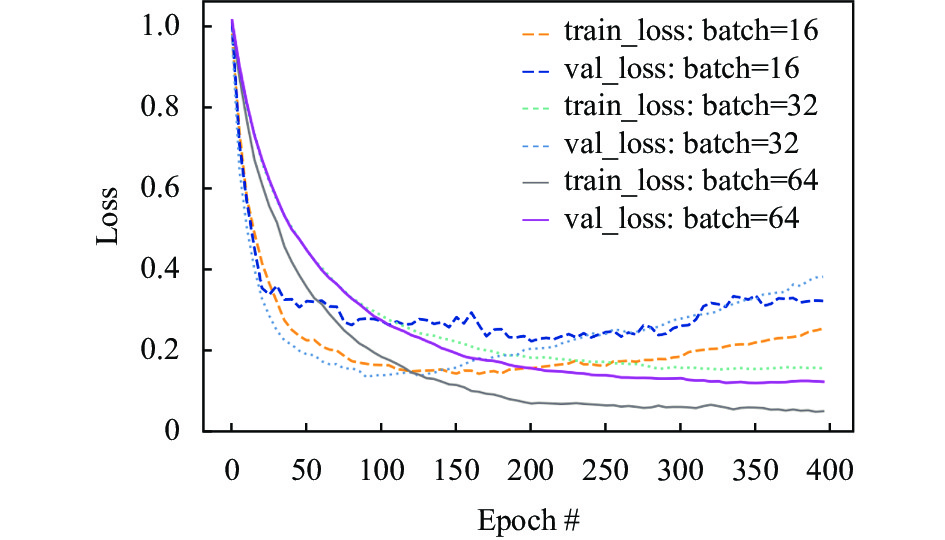

本文主干网络采用ResNet50[15]作为特征提取网络, 并移除其global average pooling层与classifier层. 使用BYOL[16]算法分别在Market1501和DukeMTMC-ReID对特征提取网络进行无监督预训练. 本实验中的姿态估计模型是HR-Net[17], 它在COCO数据集[18]上被预训练. 训练过程中, 输入网络的行人样本尺寸为256×128 (h×w), 模型训练迭代400个周期. 通过对比不同训练集批次的实验效果, 如图4, 本文将batch设为64. 初始化学习率被设置为3.5×10−5, 然后迭代到50, 150和350周期时分别衰减0.1倍, 选择Adam作为模型参数优化器.

|

图 4 不同batch参数下train_loss和val_loss的实验结果 |

2.4 PE的有效性

PE主要有两个组件: 编码器与双边增益函数. 首先, 进行消融试验确认每个组件都发挥了作用, 结果如表1. 实验表明只添加BOF时, 在单域条件下mAP和Rank-1最大分别增加了1.7%与1.6%; M→D的Rank-1提升了3.9%, D→M的mAP却下降了2.6%, 说明BOF具有修正姿态的作用, 但存在矫正盲区. 此时完全依赖姿态信息会让模型变得脆弱, 网络完全有机会学习到非行人的“虚假”特征, 使模型缺乏泛化性, 阻碍算法提高Re-ID的能力; 当添加编码器时, M→M与D→D的mAP与Rank-1分别得到7%和10%左右的大幅提升; 当编码器与BOF联合训练时, 模型无论是单域(训练与测试样本同源)还是跨域(训练与测试样本非同源)的性能都有极大提升, 且大于分别加入编码器与BOF的总和. 这说明PE有效增强了模型获取真正行人分类特征的能力, 验证了PE设计的意义性.

最后, 引入两个数据集: 半身(partial)数据集和遮挡(occluded)数据集. 为了更加全面地展现PE设计的合理性, 使用3组网络进行对比: 组别1 (†), 同样使用骨骼关键点作为辅助的网络; 组别2 (‡), 使用了切片对齐的网络; 组别3 (※), 针对遮挡和部分行人设计的网络. 最终, 本文提出的方法在Partial-ReID、Partial-iLIDS、Occluded-Duke和Occluded-ReID数据集上分别取得了Rank-1 77.2%、72.4%、56.7%与71.4%的良好表现, 见表2. 需要特别指出的是依据表2中组别1和2的结果证明: 在行人信息部分可见的错综场景下, 本模型取得良好Re-ID效果的主要原因不是使用了姿态估计或部件对齐方法. 更有力佐证了姿态修正方法的有效性.

| 表 1 PDFA主要组件消融实验效果(%) |

| 表 2 半身与遮挡数据集准确率对比结果(%) |

3 结论

本文的目的是让网络提取更具鲁棒性的判别特征. 于是, 提出姿态驱动的局部特征对齐的行人重识别模型. 首先, 通过重构姿态估计模型输出的热力图来获得高阶的人体姿态信息起到定位行人可见区域的作用, 减弱噪声的干扰, 避免非行人特征给模型带来的低鲁棒性. 其次, 参照其他优秀算法在模型中使用局部特征对齐的方法, 进一步提升网络在遮挡情况下对行人特征的匹配能力. 最终, 在众多的数据集上进行的大量实验证明了本文提出的方法的有效性.

| [1] |

Karanam S, Gou MR, Wu ZY, et al. A systematic evaluation and benchmark for person re-identification: Features, metrics, and datasets. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(3): 523-536. DOI:10.1109/TPAMI.2018.2807450 |

| [2] |

Ye M, Shen JB, Lin GJ, et al. Deep learning for person re-identification: A survey and outlook. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(6): 2872-2893. DOI:10.1109/TPAMI.2021.3054775 |

| [3] |

Zheng L, Shen LY, Tian L, et al. Scalable person re-identification: A benchmark. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1116–1124.

|

| [4] |

Zheng ZD, Zheng L, Yang Y. Pedestrian alignment network for large-scale person re-identification. IEEE Transactions on Circuits and Systems for Video Technology, 2019, 29(10): 3037-3045. DOI:10.1109/TCSVT.2018.2873599 |

| [5] |

Sun YF, Xu Q, Li YL, et al. Perceive where to focus: Learning visibility-aware part-level features for partial person re-identification. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 393–402.

|

| [6] |

Zhao HY, Tian MQ, Sun SY, et al. SpindleNet: Person re-identification with human body region guided feature decomposition and fusion. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 907–915.

|

| [7] |

Su C, Li JN, Zhang SL, et al. Pose-driven deep convolutional model for person re-identification. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 3980–3989.

|

| [8] |

Gao S, Wang JY, Lu HC, et al. Pose-guided visible part matching for occluded person ReID. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 11741–11749.

|

| [9] |

Miao JX, Wu Y, Liu P, et al. Pose-guided feature alignment for occluded person re-identification. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 542–551.

|

| [10] |

Cao Z, Hidalgo G, Simon T, et al. OpenPose: Realtime multi-person 2D pose estimation using part affinity fields. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(1): 172-186. DOI:10.1109/TPAMI.2019.2929257 |

| [11] |

Zheng ZD, Zheng L, Yang Y. Unlabeled samples generated by GAN improve the person re-identification baseline in vitro. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 3774–3782.

|

| [12] |

Zheng WS, Li X, Xiang T, et al. Partial person re-identification. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 4678–4686.

|

| [13] |

He LX, Liang J, Li HQ, et al. Deep spatial feature reconstruction for partial person re-identification: Alignment-free approach. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7073–7082.

|

| [14] |

Zhuo JX, Chen ZY, Lai JH, et al. Occluded person re-identification. Proceedings of the 2018 IEEE International Conference on Multimedia and Expo (ICME). San Diego: IEEE, 2018. 1–6.

|

| [15] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [16] |

Grill JB, Strub F, Altché F, et al. Bootstrap your own latent a new approach to self-supervised learning. Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver: Curran Associates Inc., 2020. 21271–21284.

|

| [17] |

Sun K, Xiao B, Liu D, et al. Deep high-resolution representation learning for human pose estimation. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 5686–5696.

|

| [18] |

Lin TY, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 740–755.

|

| [19] |

Zheng ZD, Yang XD, Yu ZD, et al. Joint discriminative and generative learning for person re-identification. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 2133–2142.

|

| [20] |

Sun YF, Zheng L, Deng WJ, et al. SVDNet for pedestrian retrieval. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 3820–3828.

|

| [21] |

Zhang X, Luo H, Fan X, et al. AlignedReID: Surpassing human-level performance in person re-identification. arXiv:1711.08184, 2017.

|

| [22] |

Sun YF, Zheng L, Yang Y, et al. Beyond part models: Person retrieval with refined part pooling (and a strong convolutional baseline). Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 501–518.

|

| [23] |

Luo H, Fan X, Zhang C, et al. STNReID: Deep convolutional networks with pairwise spatial transformer networks for partial person re-identification. IEEE Transactions on Multimedia, 2020, 22(11): 2905-2913. DOI:10.1109/TMM.2020.2965491 |

2023, Vol. 32

2023, Vol. 32