2. 中北大学 大数据学院, 太原 030051

2. School of Data Science and Technology, North University of China, Taiyuan 030051, China

火灾是最危险的灾害类型之一, 威胁着人类的生命财产、生态环境和基础设施. 减少火灾造成的损失具有重要的理论和现实意义[1-5]. 尤其是当有用到火药的地方, 如果火药在被小火星碰到时, 就会迅速燃烧, 甚至过多的火药可能会引起爆炸. 当火药在刚要燃烧的瞬间迅速检测出来, 并将其直接扑灭, 以防止燃烧和爆炸发生, 这一点则极为重要.

火的特征可分为静态特征和动态特征. 静态特征包括目标信息和空间结构信息, 动态特征包括整体运动特征和随机运动特征[6]. 早期的火灾探测方法通常根据这些特征中的一个或多个来识别火灾. 吴茜茵等人[7]根据火焰形状的纵横比和质心高度系数来判别火焰; Ouyang等人[8]通过分析火焰的边缘信息, 改进了Sobel算子, 通过提取火焰颜色的边缘梯度特征来识别火焰. 然而, 早期这种手工提取的特征是高度冗余的, 尽可能多的深度静态特征的智能提取是不可能的[9, 10]. 并且这种传统的手工提取特征的方法检测速度很慢, 达不到实时性, 其次识别精度也不高, 不能满足实际应用要求.

随着视频监控设备的日益普及和计算机视觉技术的发展, 卷积神经网络得到了一个迅猛的发展, 并且在各种视觉领域都取得了非常大的成果. 2012年, AlexNet[11]在ImageNet数据集上达到15.3%的top5错误率, 与传统手工特征提取方法相比, 在精度方面有了一个质的提升. 随之出现了更深和更宽的卷积神经网络VGG[12]以及GoogLeNet[13]用于提升网络精度. 而随后出现的带有残差结构的ResNet[14]网络很好地缓解了网络过深而导致的梯度消失以及过拟合等问题. 在火焰识别方面, 卷积神经网络被用来识别当前环境中是否有火焰产生, 从而起到预防作用. 并且深度学习火焰识别方法最大的优点便是不再需要手动提取火焰特征[15-17]. 但是这些大型网络参数量和计算量庞大, 不易部署到边缘设备上运行. 而当前用于实际火焰识别项目的硬件设备为边缘设备或者移动端设备, 因此要求网络需要足够轻量化并且能够保持一定的识别准确率.

为了促使网络轻量化, 可部署到移动端和边缘设备上运行, 2016年提出了SqueezeNet[18], 是最早的轻量级卷积神经网络, 主要包括两部分: squeeze和expand. Squeeze中通过1×1卷积核对上一层特征图进行卷积, 从而降低特征图维数; expand则是经过一组连续的1×1卷积和3×3卷积之后拼接构成. SqueezeNet的精度与AlexNet相比虽然没有降低, 模型参数量也只有AlexNet的1/50, 但是他加深了网络的深度, 并丧失了网络的并行能力, 不能够很好地去满足实时性. 因此, Qiang等人[19]为了加快检测和识别速度, 以SqueezeNet为基础, 大幅压缩参数, 并引入残差结构来集成高级和低级特征, 从而提高精度降低计算成本; Zhang等人[20]为了能够可靠的实时探测森林火灾, 将SqueezeNet中的普通卷积替换为深度卷积, 并在其Fire模块中使用通道混洗操作以作为特征通信器.

2017年, 谷歌提出了采用多个深度可分离卷积去代替常规卷积进行堆叠形成的轻量级神经网络MobileNet[21]. 深度可分离卷积使用深度卷积去代替常规卷积进行特征提取, 之后利用点卷积进行各通道之间的信息交流, 有效减少模型参数. 后来为了进一步优化MobileNet的网络结构, 提出了带有反向残差结构的MobileNetV2[22], 但其小目标检测能力并不出众. 为了针对早期火焰多为小目标的问题, He等人[23]通过移植轻量级算法MobileNet SSD, 并结合多特征融合技术, 提高了算法的小目标检测能力; 文献[24]以MobileNetV2网络为主干网络, 并引入通道注意力机制, 实现特征增强, 在保证算法轻量化的同时有效提升网络的检测性能; Bouguezzi等人[25]提出了一个增强版的MobileNet, 通过对MobileNet中的深度可分离卷积单元进行修改, 使模型精度获得了显著的提高.

ShuffleNet[26]中利用shuffle操作去替换常规组卷积之后的点卷积操作, 对组卷积之后的特征图在通道维度上随机均匀打乱, 再进行组卷积操作, 从而实现不同分组之间的信息交流. 这样做可以很大程度的减少网络参数量和计算量, 但是ShuffleNet中组卷积使用过多, 且元素级操作过多, 导致运行速度较慢. Yang等人[27]通过奇异值分解对卷积进行分解优化, 并用h-swish激活函数代替ReLU激活函数来改进ShuffleNet, 以达到减少参数量和计算量的目的; Chen等人[28]对 ShuffleNet引入注意力机制以及采用新的激活函数来改善分类准确率低实时性差的问题.

深度可分离卷积是先学习空间之间的相关性, 再学习通道之间的相关性, 而Xception[29]的Xception模块则完全相反, 他是先学习通道之间的相关性, 再学习空间之间的相关性, 并且在学习过程中未使用激活函数, 却能有效提升网络性能. Shi等人[30]通过调整网络分支和网络层对Xception 网络改进, 从而实现了高精度的分类.

这些轻量化网络模型的出现, 使模型速度更快, 体积更小, 同时能保持精度, 能够在边缘设备中更好的运行. 在本文中则以ShuffleNetV2[31]为基础, 自主构建火焰图像数据集作为训练样本, 从以下几个方面设计快速准确的火焰图像识别方法并用于实际项目中: 1)设计了一种通道加空间的双重注意力模块SCDAM (space and channel dual attention module), 赋予重要特征一个更大的权重, 同时抑制无用特征, 在保证网络轻量化的基础上进一步去提升网络精度; 2)设计多尺度特征融合模块, 从而提升网络对不同尺度的一个适应性; 3)将上述所提出的注意力模块和多尺度模块合理的嵌入到ShuffleNetV2中去, 从而提高网络的检测能力; 4)利用迁移学习对网络进行训练, 更好地去提升网络性能.

1 算法设计 1.1 整体结构设计ShuffleNetV2是在2018年所提出的一种轻量化神经网络, 其主要创新点是提出了4条轻量化原则, 并通过这4条原则对ShuffleNetV1中的结构进行了改进.

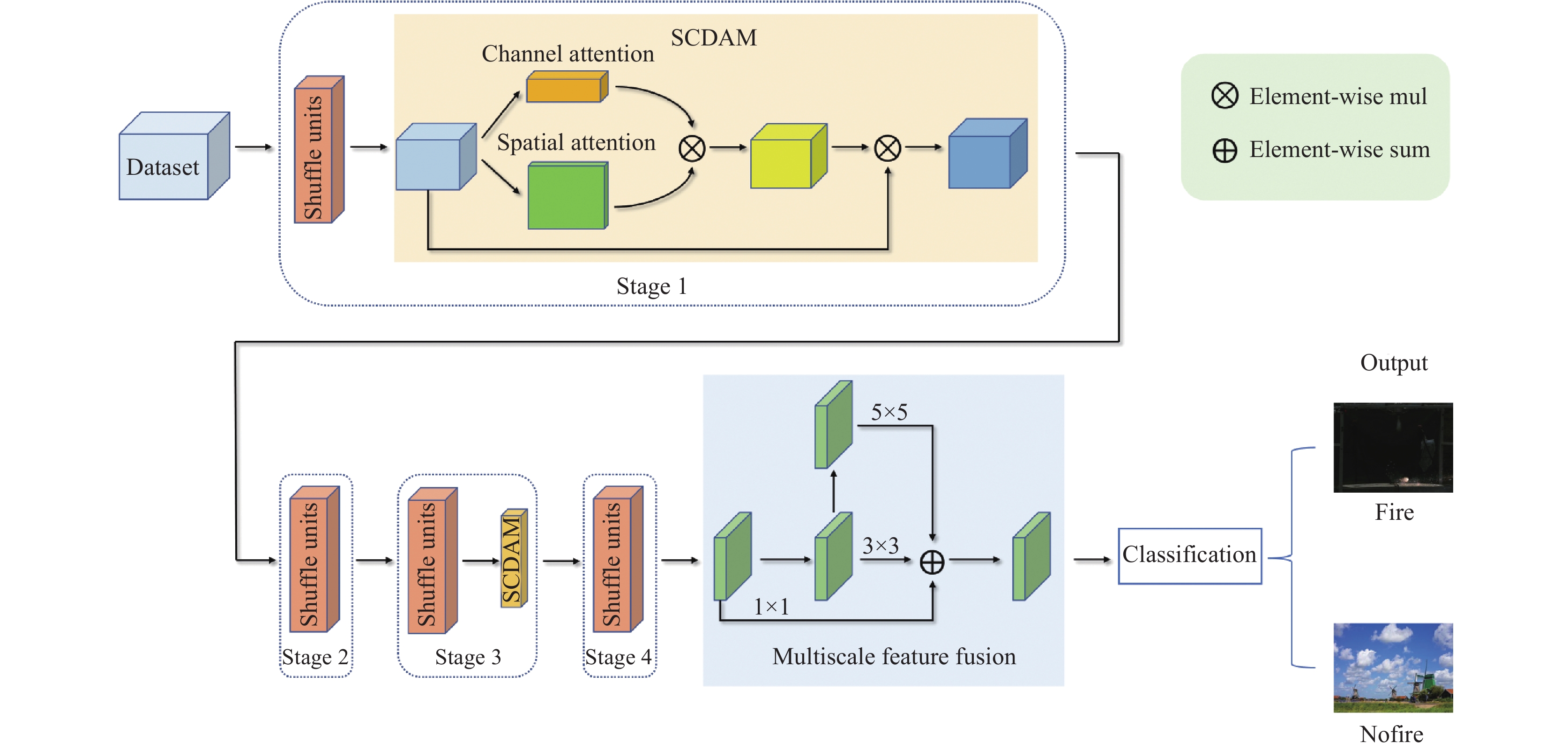

本算法选取ShuffleNetV2为主干网络, 在保证其轻量化的基础上加入自主设计的双重注意力机制模块(SCDAM)以及改进之后的多尺度特征融合模块, 利用迁移学习来提升网络的分类准确率, 改进之后的网络结构图如图1所示. 图1中在ShuffleNetV2第1阶段以及第3阶段之后分别嵌入SCDAM注意力模块, 在第4阶段之后嵌入多尺度模块, 最终输出分类置信度, 判断是否存在火焰.

|

图 1 改进ShuffleNetV2整体框架图 |

1.2 SCDAM模块设计

注意力机制最早是在自然语言处理中出现, 而在视觉领域, 注意力机制通过对特征图附加权重, 从而去加强重要特征的提取, 抑制不重要特征. 目前, 已有大量针对注意力机制的研究. 最早出现的SENet[32]借鉴注意力机制思想, 设计了一种通道注意力模块, 引入squeeze和excitation两个过程, 首先通过全局平均池化层将特征图在空间维度上压缩为

本文提出了一种新的空间加通道的双重注意力模块SCDAM, 其整体构成图如图2所示. 当输入的特征图为

| XW=σ(fe(WC)⊗fe(WS)) | (1) |

| XV=XW⊗XU | (2) |

其中,

|

图 2 SCDAM注意力机制整体模块图 |

通道注意力机制的具体实现过程为, 首先输入特征图的全局信息在空间维度上经过全局平均池化层进行压缩, 压缩之后的通道特征图尺寸为

| WC=F1d(FGAP(XU)) | (3) |

其中,

空间注意力是为了突出或抑制特定位置点的特征, 在这里我们首先对输入特征图采用1×1卷积进行降维处理, 然后使用两个深度可分离的3×3空洞卷积, 空洞率分别为2和4. 因为大的感受野可以更好的捕捉语义信息, 采用深度可分离的空洞卷积可以扩大感受野, 同时保持较低的复杂度, 采用空洞率为2和4是为了避免提取的特征过于分散, 同时也为了避免特征语义在空间上不连续. 最后再用一个1×1卷积对输入特征做进一步降维处理, 将其压缩为

| WS=F(f4(f2(F(XU)))) | (4) |

其中,

为了提取到的特征在空间尺度上更加丰富, 利于后续的火焰识别, 采用多尺度特征融合方式. GoogLeNet提出的InceptionV1模块利用1×1, 3×3, 5×5这3个不同大小的卷积核和3×3的池化操作对输入的特征进行提取, 不止加宽了网络, 同时增加了网络对不同尺度的适应性, 提升了网络的性能.

在本文中对InceptionV1中模块进行改进, 改进后的多尺度特征融合模块如图3所示. 首先对输入特征使用1×1卷积进行降维处理, 同时将处理后的结果作为1×1尺度特征提取的分支. 然后进行两次3×3深度可分离卷积操作, 将第1次3×3深度可分离卷积之后的结果作为3×3尺度特征提取的分支. 在VGG中提出两个3×3卷积提供的感受野相当于一个5×5卷积提供的感受野, 因此在这里将第2次3×3深度可分离卷积之后的结果作为5×5尺度特征提取的分支. 将3条分支的结果进行相加进行特征融合, 采用相加而非拼接是为了减少模型的参数量, 融合之后使用1×1卷积做升维处理, 恢复到输入特征时的维度大小.

|

图 3 多尺度特征融合模块 |

1.4 迁移学习

为了使模型获得更好的初始化权重参数, 利用模型在相似任务中的学习权重, 在此基础上采用迁移学习方式, 避免模型从零开始学习.

本研究利用ShuffleNetV2在ImageNet数据集中的预训练权重作为初始化权重, 由于对模型进行改进导致部分结构发生变化, 因此在导入权重时需要跳过不匹配的操作层.

2 实验与结果 2.1 实验环境与数据集介绍本实验使用Windows 10系统, 深度学习框架采用PyTorch框架, CPU为Intel Core i7-10870, GPU为NVIDIA GeForce RTX2060 (显存6 GB).

所采用数据集来源为3部分, 第1部分来源于为网络收集, 第2部分为现场采集, 第3部分为公共数据集(fire image data set for Dunnings 2018 study). 实验所用数据集共19182张图片, 图片尺寸全设为320×240, 分为两个类别fire和nofire, 其中fire包含9887张图片, nofire包含正常非火图片以及类火干扰性较大的图片(如夕阳朝阳图片, 灯泡灯光, 不锈钢反射光等), 共计9295张图片, 具体样本数量如表1所示. 代表性图片如图4所示.

在实验过程中将数据集按8:2划分为训练集和测试集, 同时为加强模型泛化能力, 对数据进行随即裁剪, 翻转, 亮度变化等数据增强方式进行扩充. 在模型训练过程中, 优化算法采用Adam优化器; 训练批次为160, 批大小为8; 损失函数使用交叉熵损失函数; 学习率为0.0001.

| 表 1 数据集样本分布 |

|

图 4 代表性图片 |

2.2 注意力模块性能对比实验

为验证所设计注意力模块SCDAM的性能, 以MobileNetV3为基础网络, 将不同的注意力机制模块嵌入MobileNetV3进行对比, 在这里选用MobileNetV3为基础网络是因为MobileNetV3本身加入了注意力模块SENet, 并且已经选好了加入注意力模块的位置, 我们只需要将其他注意力模块替换掉MobileNetV3本身自带的SENet进行对比即可. 实验选取了CBAM, BAM, ECA, SGE以及MobileNetV3本身携带的SENet在准确率, 模型大小, 参数量, 计算量这4个方面进行对比来验证本文所提注意力模块SCDAM的有效性. 与不同注意力模块的对比如表2所示.

| 表 2 各注意力模块效果对比 |

由表2可知, 本文所提出的注意力模块在精度方面与其他5个注意力模块相比有一个较为明显的提升, 且本文所提出的注意力模块的参数量比SENet, CBAM, BAM少, 与ECA和SGE相比也没有增加太多. 整体在准确率与参数量上达到一个比较适中的状态.

在160次迭代中, 嵌入不同注意力模块的MobileNetV3准确率变化如图5所示. 绿色实线代表嵌入本文所提出的SCDAM模块的MobileNetV3在迭代过程中的准确率变化, 并且在105轮之后的迭代过程中绿色实线整体优于其他颜色实线.

|

图 5 各模块迭代过程 |

综上分析, 有效证明了SCDAM的有效性, 尤其是在准确率上有较大提升. 主要包括两个方面: 一是在通道注意力方面选取一维卷积实现各通道之间的交流, 避免使用全连接层降维再升维的操作, 不止参数量和计算量有大幅度的减少, 且避免了降维过程中的信息丢失, 使最后的权重分配更加合理; 二是在空间注意力方面, 选取深度可分离的空洞卷积代替普通卷积, 有效的增加了感受野, 更好地去捕捉语义信息, 并且连续采用了两个不同空洞率的空洞卷积, 避免特征语义在空间上的不连续, 使提取到的显著特征图更加合理. 通道注意力和空间注意力两方面的优化效果叠加, 使得SCDAM的效果提升明显.

为了进一步验证本文所提出注意力模块的性能与其泛化性, 在公共数据集CIFAR-100上, 将该模块分别嵌入不同的网络进行测试. 实验选取了6种典型的网络, 分别以代表加深网络深度从而提升效果的VGG16, 开创残差网络的ResNet18, 稠密连接网络的DenseNet, 实现多尺度的GoogLeNet, 轻量化网络的MobileNetV2和ShuffleNetV2加以对比. 实验效果如表3所示.

由表3可知, 在不同的神经网络中加入本文所提出的注意力模块SCDAM, 与原网络相比均有一定程度的效果提升, 准确率上平均提升幅度为0.83%, 且在VGG16和ShuffleNetV2中提升幅度较大, 分别为1.1%和1%.

| 表 3 不同神经网络效果对比 |

2.3 消融实验

本文以ShuffleNetV2为主干网络, 将SCDAM模块和改进之后的多尺度特征融合模块分别嵌入ShuffleNetV2中以改进ShuffleNetV2网络的性能. 通过消融实验证明本文提出的SCDAM模块, 多尺度特征融合模块以及迁移学习都对模型性能提升有所贡献, 消融实验结果如表4所示.

| 表 4 消融实验结果 |

由表4可知, 利用迁移学习训练网络相比直接训练网络在精度方面会有一个巨大的提升, 模型的准确率可以提高1.9%; 在利用迁移学习训练网络的基础下加入注意力模块SCDAM, 可以看出在参数量微涨的情况下, 模型准确率可以提高0.8%, 达到93.6%的准确率; 而将注意力模块换成多尺度特征融合模块后, 进一步加强网络对尺度的适应性, 可以发现, 在参数量略微增加的情况下, 准确率也可提升0.5%; 最终本文在迁移学习的基础下初始化模型权重参数, 通过引入注意力模块SCDAM和多尺度特征融合模块去改进ShuffleNetV2, 改进之后的ShuffleNetV2模型与原模型相比在准确率方面可以提升3.2%, 达到94.1%的准确率, 且参数量与原模型相比只增加了0.034M, 实现了在轻量化的基础上精度的进一步提升.

2.4 算法对比与分析(1)效果对比: 本文通过改进ShuffleNetV2 实现了优良的效果, 在图6中我们通过一些可视化的样例展示了我们方法的优越性. 图中红色区域代表模型最后输出时所关注的区域, 颜色越深代表关注程度越高. 其中左侧图片是普通火焰的样例, 可以看出本文方法对火焰区域的关注程度都重于ShuffleNetV2. 右侧图片是火药点燃时所产生火焰的样例, 由于火药点燃产生的火星微小, 不易被检测出, 而本文通过对ShuffleNetV2添加注意力模块以及多尺度模块, 使模型进一步加深对不明显火焰区域特征的提取, 从而将微小火星检测出来.

|

图 6 模型最终输出时所关注区域的比较 |

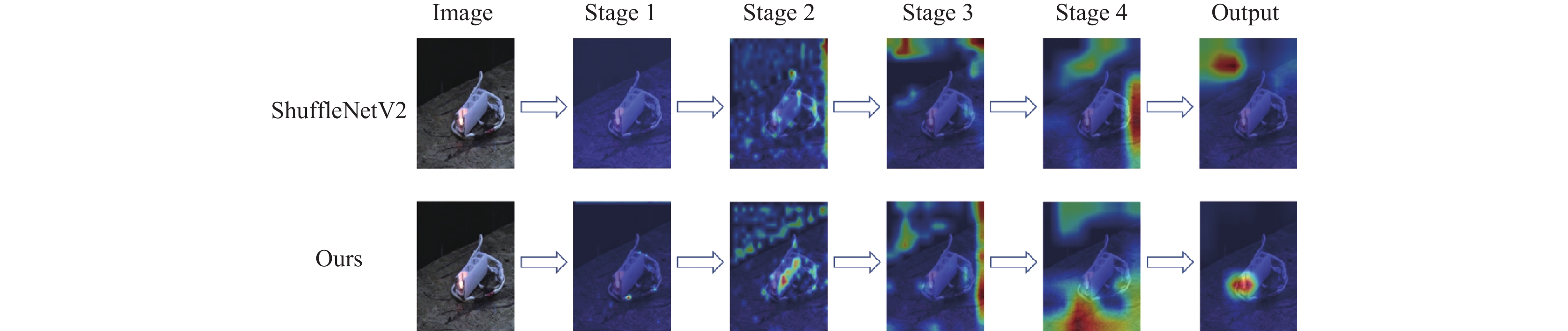

图7中展示了在部分样例中, 本文方法与ShuffleNetV2在各个阶段对火焰目标关注程度的对比. 在第2阶段前以及第4阶段前加入注意力模块使模型在不同区域赋予不同的权重比重, 在输出前加入的多尺度模块使模型进一步关注火焰本身区域, 便于后续的火焰识别.

|

图 7 模型在各阶段关注程度的样例 |

为了进一步验证本文方法在识别微小火焰方面的优越性, 在本文所自制数据集上, 将本文模型与VGG, ResNet等经典网络模型以及具有代表性的MobileNet系列和ShuffleNet系列的轻量化网络模型进行对比, 对比结果如表5所示.

由表5可知, 在本文自建数据集中VGG16与MobileNetV2的准确率最低, 只有91.1%. 本文算法准确率最高, 可以达到94.1%, 且参数量与计算量相对都比较少.

(2)推理速度对比: 为了验证本文在实时性方面也能满足要求, 在自建数据集中随机选取100张图片进行模型推理速度测试, 结果表明: 本文在ShuffleNetV2基础上采用迁移学习方式, 加入SCDAM注意力模块以及多尺度模块, 在精度提升3.2%的幅度下, 平均推理速度也能达到8.7 ms, 完全能够满足本项目在实时性上的要求.

3 结论与展望本文针对火药在燃烧时产生的小火苗进行及时检测, 并将其扑灭避免火灾发生. 为了满足模型实时性要求且能够在边缘设备中快速运行, 选取轻量化网络ShuffleNetV2为基础网络, 将所设计的空间加通道的双重注意力模块以及多尺度模块嵌入到ShuffleNetV2中, 显著提高了模型的特征提取能力, 以较小的开销代价提升了模型的准确率, 且本文所提出的模型平均推理每张图片的速度仅为8.7 ms, 完全能够达到本项目在实时性上的要求. 未来研究方向主要为如何在保持网络轻量化的前提下去进一步提升模型的抗干扰能力, 且能够更准确地去分辨出各种类火干扰图片.

| 表 5 各模型在本文自建数据集中训练结果对比 |

| [1] |

Muhammad K, Ahmad J, Mehmood I, et al. Convolutional neural networks based fire detection in surveillance videos. IEEE Access, 2018, 6: 18174-18183. DOI:10.1109/ACCESS.2018.2812835 |

| [2] |

Luo YM, Zhao L, Liu PZ, et al. Fire smoke detection algorithm based on motion characteristic and convolutional neural networks. Multimedia Tools and Applications, 2018, 77(12): 15075-15092. DOI:10.1007/s11042-017-5090-2 |

| [3] |

Sudhakar S, Vijayakumar V, Kumar CS, et al. Unmanned aerial vehicle (UAV) based forest fire detection and monitoring for reducing false alarms in forest-fires. Computer Communications, 2020, 149: 1-16. DOI:10.1016/j.comcom.2019.10.007 |

| [4] |

Sharma A, Singh PK, Kumar Y. An integrated fire detection system using IoT and image processing technique for smart cities. Sustainable Cities and Society, 2020, 61: 102332. DOI:10.1016/j.scs.2020.102332 |

| [5] |

王林, 赵红. 改进YOLOv3的火灾检测. 计算机系统应用, 2022, 31(4): 143-153. DOI:10.15888/j.cnki.csa.008404 |

| [6] |

Foggia P, Saggese A, Vento M. Real-time fire detection for video-surveillance applications using a combination of experts based on color, shape, and motion. IEEE Transactions on Circuits and Systems for Video Technology, 2015, 25(9): 1545-1556. DOI:10.1109/TCSVT.2015.2392531 |

| [7] |

吴茜茵, 严云洋, 杜静, 等. 多特征融合的火焰检测算法. 智能系统学报, 2015, 10(2): 240-247. |

| [8] |

Ouyang JN, Bu LP, Yang ZK, et al. An early flame identification method based on edge gradient feature. Proceedings of the 2nd IEEE Advanced Information Management, Communicates, Electronic and Automation Control Conference. Xi’an: IEEE Press, 2018. 642–646.

|

| [9] |

Xie YK, Zhu J, Cao YG, et al. Efficient video fire detection exploiting motion-flicker-based dynamic features and deep static features. IEEE Access, 2020, 8: 81904-81917. DOI:10.1109/ACCESS.2020.2991338 |

| [10] |

罗梦研, 刘雁飞. 基于轻量化卷积神经网络的服装分类方法. 计算机系统应用, 2019, 28(3): 223-228. DOI:10.15888/j.cnki.csa.006821 |

| [11] |

Krizhevsky A, Sutskever I, Hinton GE. ImageNet classification with deep convolutional neural networks. Communications of the ACM, 2017, 60(6): 84-90. DOI:10.1145/3065386 |

| [12] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv:1409.1556, 2015.

|

| [13] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015, 1-9. DOI:10.1109/cvpr.2015.7298594 |

| [14] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE Press, 2016. 770–778.

|

| [15] |

Muhammad K, Ahmad J, Lv ZH, et al. Efficient deep CNN-based fire detection and localization in video surveillance applications. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2019, 49(7): 1419-1434. DOI:10.1109/TSMC.2018.2830099 |

| [16] |

Huang HY, Kuang P, Fan L, et al. An improved multi-scale fire detection method based on convolutional neural network. Proceedings of the 17th International Computer Conference on Wavelet Active Media Technology and Information Processing. Chengdu: IEEE, 2020. 109–112.

|

| [17] |

徐小平, 余香佳, 刘广钧, 等. 利用改进AlexNet卷积神经网络识别石墨. 计算机系统应用, 2022, 31(2): 376-383. DOI:10.15888/j.cnki.csa.008311 |

| [18] |

Iandola FN, Han S, Moskewicz MW, et al. SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5 MB model size. arXiv:1602.07360, 2016.

|

| [19] |

Qiang BH, Zhai YJ, Zhou ML, et al. SqueezeNet and fusion network-based accurate fast fully convolutional network for hand detection and gesture recognition. IEEE Access, 2021, 9: 77661-77674. DOI:10.1109/ACCESS.2021.3079337 |

| [20] |

Zhang JM, Zhu HQ, Wang PY, et al. ATT Squeeze U-Net: A lightweight network for forest fire detection and recognition. IEEE Access, 2021, 9: 10858-10870. DOI:10.1109/ACCESS.2021.3050628 |

| [21] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017.

|

| [22] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520.

|

| [23] |

He HF, Huang PJ, Xiong AM, et al. Design of embedded real-time video fire AI recognition system. Proceedings of 2021 International Conference on Computer Communication and Artificial Intelligence. Guangzhou: IEEE, 2021. 52–55.

|

| [24] |

任坤, 黄泷, 范春奇, 等. 基于多尺度像素特征融合的实时小交通标志检测算法. 信号处理, 2020, 36(9): 1457-1463. DOI:10.16798/j.issn.1003-0530.2020.09.010 |

| [25] |

Bouguezzi S, Faiedh H, Souani C. Slim MobileNet: An enhanced deep convolutional neural network. Proceedings of the 18th International Multi-Conference on Systems, Signals & Devices. Monastir: IEEE, 2021. 12–16.

|

| [26] |

Zhang XY, Zhou XY, Lin MX, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6848–6856.

|

| [27] |

Yang DD, Peng HY, Wan TZ. Attachment fault diagnosis for tidal stream turbine based on improved ShuffleNetV2. Proceedings of 2021 China Automation Congress. Beijing: IEEE, 2021. 6844–6849.

|

| [28] |

Chen ZC, Yang J, Chen LF, et al. Garbage classification system based on improved ShuffleNetV2. Resources, Conservation and Recycling, 2022, 178: 106090. DOI:10.1016/j.resconrec.2021.106090 |

| [29] |

Chollet F. Xception: Deep learning with depthwise separable convolutions. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1800–1807.

|

| [30] |

Shi CP, Xia RY, Wang LG. A novel multi-branch channel expansion network for garbage image classification. IEEE Access, 2020, 8: 154436-154452. DOI:10.1109/ACCESS.2020.3016116 |

| [31] |

Ma NN, Zhang XY, Zheng HT, et al. ShuffleNetV2: Practical guidelines for efficient CNN architecture design. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 122–138.

|

| [32] |

Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. DOI:10.1109/TPAMI.2019.2913372 |

| [33] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 3–19.

|

| [34] |

Wang QL, Wu BG, Zhu PF, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks. Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 11531–11539.

|

| [35] |

Howard A, Sandler M, Chen B, et al. Searching for MobileNetV3. Proceedings of 2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul: IEEE, 2019. 1314–1324.

|

2023, Vol. 32

2023, Vol. 32