2. 石嘴山银行股份有限公司 金融大数据实验室, 银川 750011;

3. 宁夏大学 前沿交叉学院, 中卫 755099

2. Laboratory of Financial Big Data, Bank of Shizuishan, Yinchuan 750011, China;

3. School of Advanced Interdisciplinary Studies, Ningxia University, Zhongwei 755099, China

线上个人信用贷款业务是商业银行直接面向个人客户的金融服务, 客户可以通过该项服务申请贷款, 但有些客户在完成贷款申请通过授信后, 并没有即时用信, 也就是没有发生用款行为, 有些客户在通过授信后马上就进行用信. 利用机器学习模型可以充分结合和利用银行金融大数据信息, 高效、批量地对客户是否用信进行预测, 但高性能机器学习模型由于其复杂的内部结构会引发不可解释的问题, 导致模型的输入和输出难以展现因果关系, 模型预测结果也难以被解释. 对于金融领域, 如果仅凭模型预测结果就轻易做出商业决策, 是具有很高的风险性的. 而模型可解释性方法可以结合实际业务理解对机器学习模型预测结果进行解释性分析, 使预测结果符合业务认知, 更加有理有据. 机器学习模型可解释性方法可以满足商业银行对金融业务场景下的模型可解释性要求, 推动高性能机器学习模型在金融领域的应用. 本文研究的主题就是根据客户相关信用信息, 预测客户在通过授信后是否用信, 并重点研究结合可解释性方法分析影响客户用信的关键因素.

目前, 国内外相关研究领域对客户用信预测的研究较少, 金融用信方面模型可解释性的研究不足. 在客户用信预测的相关研究工作中: 倪政[1]提出基于随机森林的农户用信行为预测模型, 并使用LIME可解释性框架分析影响农户是否用信的关键因素, 为银行对信贷农户采用不同营销策略提供依据, 预测结果的相关性能指标优于神经网络模型及支持向量机模型, 但在结合算法模型时没有做过多的优化策略. 在模型可解释性的相关研究工作中: 雷欣南等[2]结合SHAP解释方法提出小微企业违约识别的机器学习模型, 将SHAP方法应用于实际业务中, 分析比较了导致小微企业发生违约的关键特征. 蔡青松等[3]提出基于可解释集成学习的信贷违约预测, 通过模型融合方法, 引入LIME解释融合模型的预测结果, 提高了信贷违约预测的精确性和可解释性. 孔令莹[4]提出基于LightGBM结合SHAP方法建立客户消费信贷违约风险评估模型, 分析了对信贷违约有关键影响的不同因素以及特征变化对违约风险预测的影响. Chen等[5]提出了一种两层加性信用风险可解释模型, 该方法提供了3种类型的解释, 具有全局一致性, 有助于特征重要性分析及解释.

上述已有的相关研究工作中, 很少有在客户用信预测方面的研究, 且在模型可解释性方面的研究中, 虽然采用了各种集成学习算法提高了模型预测的准确性, 但所建立的模型难以平衡精度和可解释性, 并且缺乏足够的可解释性, 而商业银行以及其他金融机构对金融业务场景下的模型可解释性的要求很严格. 为了解决以上研究中存在的问题, 在平衡模型预测精度和可解释性的基础上, 本文提出使用CatBoost模型进行客户用信行为的预测, 并引入TreeSHAP方法研究模型的可解释性. 本文主要贡献在于: 通过TreeSHAP方法在一定程度上克服了CatBoost模型的黑箱特性, 对影响客户是否用信的关键因素结合金融业务场景进行可解释性分析, 不仅可以实现在总体层面上解释某些因素如何影响客户用信, 也可以实现在单个样本层面上解释哪些因素的变化会导致客户用信. 进行客户用信预测可解释性研究, 为商业银行精准化营销提供依据, 具有很大的应用价值.

1 相关理论概述 1.1 CatBoost模型CatBoost[6]是一种以对称决策树为基学习器的GDBT算法框架下的一种改进实现算法, 主要优势是能够对类别特征进行高效处理、解决了预测偏移以及梯度偏差的问题, 从而减少过拟合, 进而提高模型的泛化能力和准确性. CatBoost处理离散特征的主要方法是Greedy TS, 其思想是在决策树中, 将标签平均值作为节点分裂的标准, 公式如下:

| xi,j=n∑k=1[xk,j=xi,j]⋅Yk+α⋅Pn∑k=1[xk,j=xi,j]+α | (1) |

其中, xi, j表示第j个特征的第i类值, Yk表示所对应的标签值, 分子表示第j个特征的第i类值所对应的标签值的总和, 分母表示第j个特征的第i类值的数量.P表示添加的先验项, α是大于0的权重系数. 添加先验分布项, 可以减少数据噪音, 克服低频类别数据对于模型的影响.

1.2 TreeSHAP解释性方法集成学习模型自有的特征重要性评估方法只能表示出哪个特征重要, 并不能解释该特征如何影响模型的预测结果, 而SHAP事后可解释方法不但能反映出每一个样本中的特征对预测结果的影响作用, 并且还能表现出这种作用的正负性. SHAP (Shapley additive explanation)是由Lundberg等[7]提出的一种对模型进行解释的方法. SHAP基于Shapley值, 将该值解释为一种加性特征归因方法(addititve feature attribution method), 将模型的预测值解释为二元变量的线性函数, 函数公式如下:

| g(z)=ϕ0+M∑k=1ϕk | (2) |

其中, g表示解释模型, M表示输入特征的数量,

| ϕk=∑N⊆{M∖xk}(|M|−|N|−1)!|N|!|M|!{f(xN∪{k})−f(xN)} | (3) |

其中, M表示特征集合, N表示{M\xk}的子集合, 分式表示不同特征组合对应的概率, f(xN∪{k})与f(xN)分别表示不同特征组合下xk入模与不入模时模型的预测结果.

针对树集成模型, Lundberg等[8]提出了SHAP的改进方法TreeSHAP, 该方法运算速度快、不需要抽样、通过树模型中的节点来计算Shapley值, 尤其适用于基于决策树的集成学习模型. TreeSHAP的基本计算原理如下: 给定一棵树, 针对某个样本s和特征子集T, 若子集T含有全部特征, 则叶子结点的预测值就是该特征下的模型的输出值; 若子集T为空, 则将全部叶子结点的预测值的加权平均作为输出值; 若子集T包含部分特征, 则删除由于去掉部分特征后无法通达的叶子结点, 在剩下的结点中取加权平均作为输出值. 通过TreeSHAP方法, 可以优化计算Shapley值的算法从而显著缩短计算时间、可以将局部解释直接扩展到抓取模型内部的交互效应、可以计算出全部样本集中对应某个特征的Shapley值, 将它们的均值作为该特征的重要性值, 从而基于众多的局部解释得到模型的全局解释. 接下来的实验部分, 将使用TreeSHAP方法来解释CatBoost模型.

2 特征工程 2.1 数据预处理本文所采用的数据集, 来自S银行2021年4月至2022年4月期间线上个贷业务经MD5加密后的客户用信、授信和基本信息数据, 对某些数据特征名进行模糊处理, 然后进行数据集成并去重, 删除一些无关特征后, 得到整合信用数据集, 共有158个特征、91448条样本. 进行缺失值处理, 删除数据集行缺失率大于0.5的2579个样本, 没有列缺失率大于0.9的特征, 无需删除特征. 对有缺失值的样本根据S银行提供的特征缺失值填充规则进行填充. 进行异常值处理, 利用四分位距原理(IQR)[9]对异常值进行检测, IQR表示上四分位与下四分位的差值, 超过IQR规定上下界以外的点为异常值. 在本文数据集中, 存在异常值的样本量相对总体样本量较少, 直接删除存在异常值的样本, 不会对整体样本量产生较大的影响.

2.2 特征选择选择合适的特征及特征数可有效防止过拟合问题, 第1步进行基于IV值[10]的初步选择, IV值表征输入特征对目标特征的预测能力, 公式如下:

| IV=m∑i(Pyi−Pni)ln(PyiPni) | (4) |

其中, i表示组数, m表示在该特征上样本划分的总组数, Pyi、Pni分别表示在第i组中用信占总用信和不用信占总不用信的样本比例. 删除IV值小于0.02的无预测能力的特征, 选择了86个特征. 第2步进行基于Pearson相关系数[11]的特征选择, 去除特征冗余, 公式如下:

| ρxy=Cov(x,y)σxσy=∑[(x−ˉx)(y−ˉy)]√∑(x−ˉx)2∑(y−ˉy)2 | (5) |

其中, Cov(x, y)表示特征x、y的协方差, σx和σy表示两个特征的标准差. 当两个特征相关系数的绝对值大于0.7时, 表示这两个特征强相关, 则删除其中IV值较小的特征, 进一步选择了34个特征.

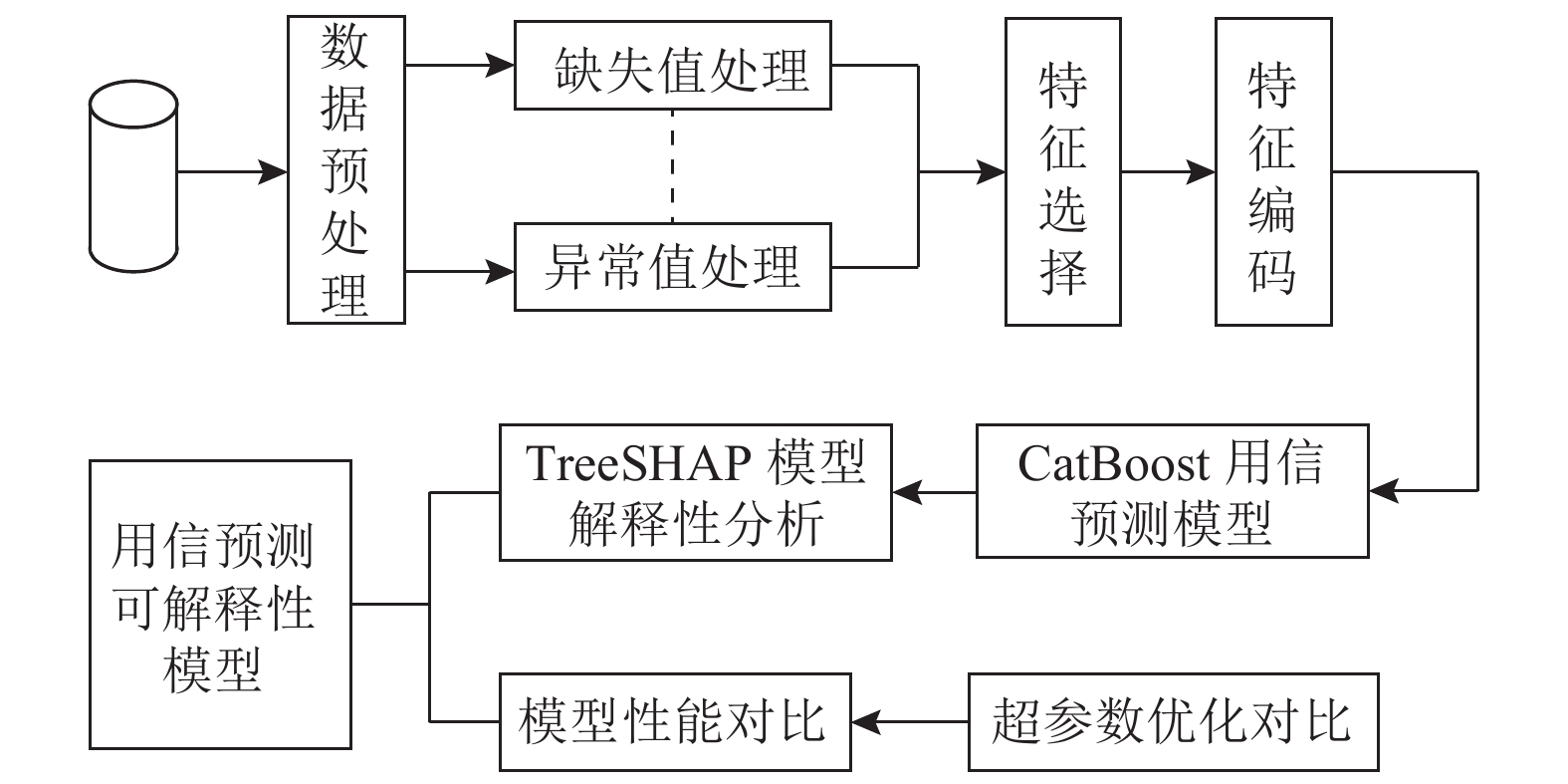

3 实验设计与分析整个实验流程如图1所示, 主要包括特征工程、基于CatBoost构建用信预测模型、3种超参数优化算法对比分析、4项模型性能指标对比分析、TreeSHAP模型可解释性分析.

3.1 模型评估指标实验采用精确率(Precision)、召回率(Recall)、准确率(Accuracy)、AUC值这4项分类评估指标对模型性能进行对比评估. AUC值是接收者工作特征(ROC)曲线的量化表示, AUC值越接近于1, 模型预测性能越优. 前3个指标的公式如下所示, 混淆矩阵如表1所示.

| Precision=TPTP+FP | (6) |

| Recall=TPTP+FN | (7) |

| Accuracy=TP+TNFN+FP+TP+TN | (8) |

|

图 1 实验流程 |

| 表 1 混淆矩阵 |

3.2 模型超参数优化对比分析

实验分别利用网格搜索(GridSearch)、随机搜索(RandomSearch)和TPE算法[12]对CatBoost模型的4种核心参数进行超参数优化, 以AUC值作为调参优化指标. 超参数调优结果对比如表2所示, 调优算法性能指标对比结果如表3所示. 由表3可知, 经过TPE算法优化后的模型AUC值最高.

| 表 2 超参数调优结果对比 |

| 表 3 调优算法性能指标对比 |

3.3 模型性能对比分析

实验将优化后的T-CatBoost模型与未优化的CatBoost模型以及其他5种主流机器学习模型的预测结果性能指标进行对比分析, 结果如表4所示, ROC曲线对比如图2所示.

| 表 4 模型性能指标对比 |

|

图 2 ROC曲线对比 |

由表4及图2的实验结果可知, 经TPE算法超参数调优后的CatBoost模型在精确率、准确率和AUC值上的性能表现均优于其他模型. CatBoost模型的优势在于对离散型特征采用目标统计的编码方式, 可以有效降低数据噪音, 并且由于解决了梯度偏差和预测偏移的缺陷, 从而有效减少了模型训练过拟合问题, 提高了模型预测的性能.

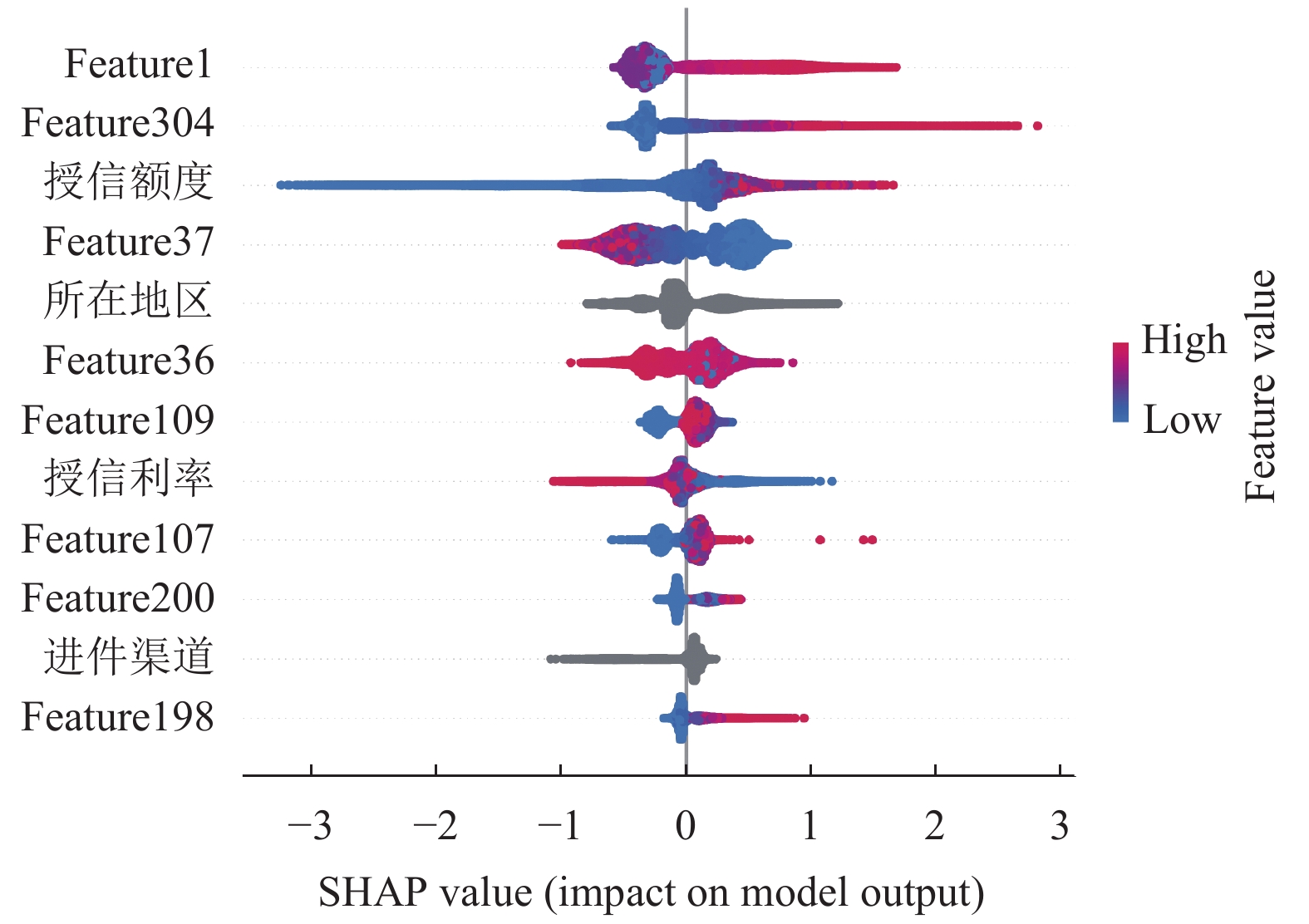

4 TreeSHAP模型解释性分析 4.1 全局可解释性分析从全局层面对用信预测模型进行解释与分析, 图3对影响客户是否用信的特征按重要性进行排序, 显示了对客户是否用信影响作用最大的12个特征. 特征feature1表示“贷记卡额度使用率”, 该特征是影响客户是否用信的最重要因素, 贷记卡额度使用率越高, 则客户用信的概率越大. 而对于授信额度特征, 其SHAP值大量聚集于平均值以下, 属于左偏分布, 说明其授信额度越低, 客户用信概率越小.

|

图 3 SHAP特征概要 |

4.2 局部可解释性分析

从局部层面对单个客户是否用信的影响因素进行解释性分析, 图4(a)为某一预测结果为用信客户的特征贡献, 图4(b)为某一预测结果为不用信客户的特征贡献, 其中红色部分表示对预测为用信有正向影响的特征, 会增大模型将该客户判断为用信客户的概率, 蓝色部分表示对预测为用信有负向影响的特征, 会增大模型将该客户判断为不用信客户的概率. 白色箭头表示特征之间的分割线, 相邻分割线之间的距离, 则表示所对应特征及其特征值对预测结果的影响程度, 距离越长, 则影响程度越大.

|

图 4 SHAP特征贡献 |

图4(a)中, 该客户样本的预测概率值f(x)为1.38, 远大于整个数据集的基准值(base value), 表示通过TreeSHAP方法解释的CatBoost用信预测模型预测该客户很有可能会用信, 被预测为用信客户的最大影响因素是feature304, 其值为15, 其他主要影响因素为授信额度较高为60000元、授信利率较低为年化6.12%等因素, 特征feature304表示“近12个月贷款审批查询次数”.

图4(b)中, 该客户样本的预测概率值f(x)为−3.78, 远小于整个数据集的基准值(base value), 表示通过TreeSHAP方法解释的CatBoost用信预测模型预测该客户很有可能会不用信, 被预测为不用信客户的最大影响因素是授信额度较低只有1000元, 其他主要影响因素是授信利率较高为年化12.0%、feature1为0.34等因素, 这就导致了客户最终可能会选择不用信.

4.3 特征依赖性分析分析单个特征如何影响用信预测模型的预测结果, 选择feature26和授信额度这两个特征分别绘制SHAP特征部分依赖图. 如图5(a)所示, 依赖图的横轴表示所选特征的值, 纵轴表示所选特征的SHAP值, 右边第3轴表示与所选特征交互作用最强的特征的值, 该特征是算法自动选择的, 散点颜色越红, 表示该特征的值越大. 随着feature26的增大, SHAP值呈现先降低再升高的变化趋势, 表明feature26增大到某一阈值之前对客户用信存在反向作用, 增大到某一阈值之后对客户用信存在正向作用, feature26表示“信用记录月份数”. 图5(b)中, 随着授信额度的增大, SHAP值在增加并趋于稳定, 表明授信额度提高对客户用信存在正向作用, 但授信额度提高到25000元之后, 红色散点整体高于蓝色散点, 且所有样本的SHAP值显现出水平分布的情况, 此时授信额度已不再是影响客户用信的主要因素, 其对客户用信的影响就不再发生显著变化. 在相同的授信额度条件下, 特征feature37的值越大, 预测为用信客户的概率越高.

|

图 5 SHAP特征依赖 |

4.4 特征重要性分析

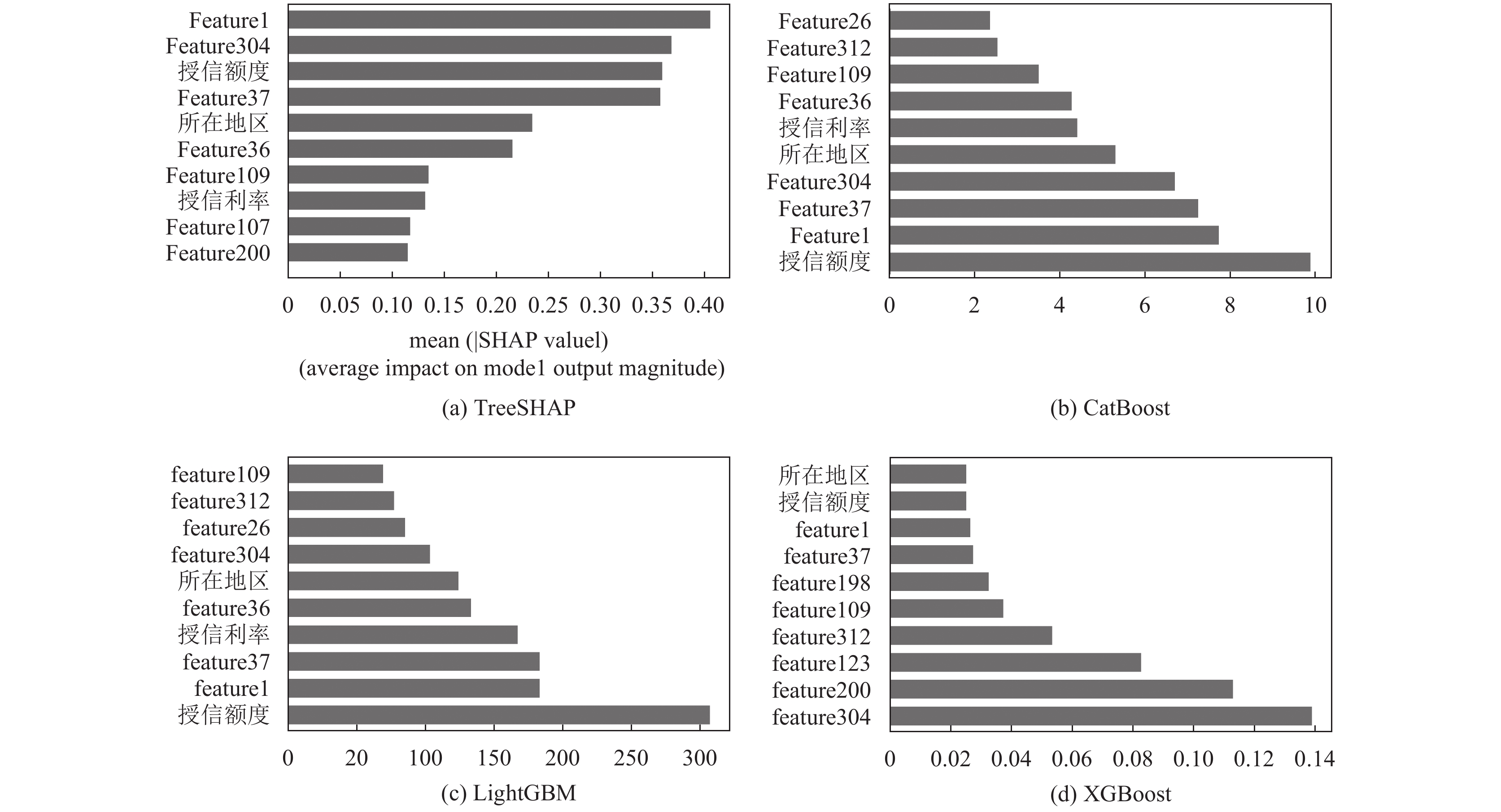

对比分析不同模型和TreeSHAP方法的特征重要性排序, 可综合评估出影响客户是否用信的关键因素. 由图6可知, TreeSHAP方法、CatBoost模型、LightGBM模型、XGBoost模型给出的特征重要性排序并不完全相同, 综合分析4种排序结果, 可知对客户是否选择用信具有显著性影响的因素: feature1、feature304、授信额度、feature37、所在地区、授信利率和feature36等. 在实际业务中, 需要重点关注这一组特征及其数据分布情况.

5 结论与展望客户用信率的提高对商业银行进行精细化运营和精准化营销具有重要作用, 准确预测客户是否用信且分析客户用信的关键影响因素则能有效提高客户服务质量和效率. 本文提出一种基于CatBoost的客户用信预测模型, 并结合TreeSHAP方法对用信预测模型进行解释性分析. 同时, 通过3种超参数优化方法对比调参进一步提升了模型的性能, 与逻辑回归、AdaBoost、随机森林、LightGBM和XGBoost这5种主流机器学习模型进行对比实验, 证明了本文所提模型的优越性. 最后, 通过TreeSHAP方法结合实际金融业务对模型进行全局和局部解释性分析以及特征依赖性分析, 并通过对比不同模型的重要性排序, 综合分析出了影响客户是否用信的关键因素.

|

图 6 特征重要性 (其中, 横坐标表示模型自有特征重要性评估方法的分数值, 纵坐标表示特征名) |

由于本文数据集来自商业银行真实信贷业务数据, 目前缺少公开的客户用信数据集作为对照, 下一步工作主要是在公开数据集上进行模型的迁移实验, 以及考虑更加有效的模型优化方法和模型解释方法, 进一步提高模型的精度、可解释性及其实际应用价值.

| [1] |

倪政. 基于随机森林的兴农卡农户用信预测模型及应用研究[硕士学位论文]. 武汉: 中南林业科技大学, 2019.

|

| [2] |

雷欣南, 林乐凡, 肖斌卿, 等. 小微企业违约特征再探索: 基于SHAP解释方法的机器学习模型. 中国管理科学, 2022, 1-13. DOI:10.16381/j.cnki.issn1003-207x.2021.0027 |

| [3] |

蔡青松, 吴金迪, 白宸宇. 基于可解释集成学习的信贷违约预测. 计算机系统应用, 2021, 30(12): 194-201. DOI:10.15888/j.cnki.csa.008220 |

| [4] |

孔令莹. 基于TPE-LightGBM算法和SHAP值的信贷违约预测[硕士学位论文]. 湘潭: 湘潭大学, 2021.

|

| [5] |

Chen CF, Lin KC, Rudin C, et al. An interpretable model with globally consistent explanations for credit risk. arXiv:1811.12615, 2018.

|

| [6] |

Prokhorenkova LO, Gusev G, Vorobev A, et al. CatBoost: Unbiased boosting with categorical features. Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal: Curran Associates Inc., 2018. 6639–6649.

|

| [7] |

Lundberg SM, Lee SI. A unified approach to interpreting model predictions. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 4768–4777.

|

| [8] |

Lundberg SM, Lee SI. Consistent feature attribution for tree ensembles. arXiv:1706.06060, 2017.

|

| [9] |

Vinutha HP, Poornima B, Sagar BM. Detection of outliers using interquartile range technique from intrusion dataset. Information and Decision Sciences: Proceedings of the 6th International Conference on FICTA. Singapore: Springer, 2018. 511–518.

|

| [10] |

Freedman S, Jin GZ. The information value of online social networks: Lessons from peer-to-peer lending. International Journal of Industrial Organization, 2017, 51: 185-222. DOI:10.1016/j.ijindorg.2016.09.002 |

| [11] |

Ly A, Marsman M, Wagenmakers EJ. Analytic posteriors for Pearson’s correlation coefficient. Statistica Neerlandica, 2018, 72(1): 4-13. DOI:10.1111/stan.12111 |

| [12] |

Erwianda MSF, Kusumawardani SS, Santosa PI, et al. Improving confusion-state classifier model using XGBoost and tree-structured parzen estimator. 2019 International Seminar on Research of Information Technology and Intelligent Systems (ISRITI). Yogyakarta: IEEE, 2019. 309–313.

|

2023, Vol. 32

2023, Vol. 32