2. 辽宁省化工过程工业智能化技术重点实验室, 沈阳 110142

2. Liaoning Key Laboratary of Intelligent Technology for Chemical Process Industry, Shenyang 110142, China

随着社会经济的发展和旅游业的兴旺, 由于一小部分人的环境保护意识薄弱, 导致景区内水体质量每况愈下, 水面垃圾的清理成为景区水体保护的新课题. 目前景区内保护水面环境主要通过人工驾驶小船的方式清除水面垃圾. 若安排人员定时清除, 垃圾不多时浪费人力物力, 人口高峰时垃圾增加过快, 清除时已造成严重的水体污染. 因此景区内水面垃圾的清除时间安排成为难题. 随着计算机技术的不断发展, 机器视觉成为水体监测的一个主要发展方向, 使用机器视觉技术可对水面垃圾量进行有效的监测. 因此, 基于机器视觉的水面垃圾监测能有效反映水面的环境质量, 能够在保持水面环境的前提下尽量减少清理次数从而节省相应的人力物力. 同时, 水面垃圾目标检测算法也是实现水面垃圾清除机器人智能化的关键核心技术.

目前, 对于水面目标检测主要分为传统水面垃圾目标检测算法[1]和基于深度学习的水面垃圾检测算法[2]. 传统的水面垃圾检测算法主要是通过统计目标物体图像的颜色、纹理和边缘等信息建立模板, 通过统计的模板使用相应的分类器进行类别识别. 王斌[3]先使用局部峰值奇异性进行图像预处理, 再采用基于亮度区域划分的目标检测机制识别水面物体, 但受到水面环境复杂多变和水面目标众多的干扰, 导致算法识别率低下. 方晶等人[4]在视觉注意模型的基础上, 通过小波变换, 高斯金字塔和归一化算子等方法融合各类特征, 提升了算法的抗干扰能力, 但水面气候复杂、目标众多会影响识别精度. 魏建荣[5]结合图像的背景纹理和噪声优化算法, 有效的提升水面目标的检测效率, 但该方法易受水面建筑物和岸体轮廓的干扰, 影响水面垃圾识别. 汤伟等人[6]通过结合Meanshift算法和基于色差灰度模型改进的最大类间方差法, 有效抑制水面波纹, 光照不均和水面倒影问题, 在精度有所提升, 但实时性不高, 不利于移动硬件部署. 总体而言, 传统水面垃圾检测算法普遍存在检测速度不快和精度不高以及鲁棒性差等问题.

随着计算能力的提高, 图形处理单元处理器的发展以及大数据技术的成熟, 深度学习技术在目标检测任务中取得了相当大的性能提升. 目前, 基于深度学习的目标检测算法有两个解决方向: 第1种是基于特征生成特征候选区域再执行分类和回归任务的目标检测算法[7-13]; 第2种是基于回归方法在图像上直接划分候选区的目标检测算法[13-18]. 基于特征生成候选区的主流算法有区域卷积神经网络(R-CNN)[7], 快速区域卷积神经网络(Fast R-CNN)[8]和基于Region的全卷积神经网络(R-FCN)[9]等. 基于回归的算法主要的代表有YOLO系列[10], SSD[11], RetinaNet[12]等. 很多算法都是基于主流算法的改进. 如李佳琪等人[13]基于注意力机制, 生成对抗网络与Mask R-CNN[14]结合, 解决遥感影响检测中的问题. 王志鹏等人[15]提出一种结合帧差法思想的Faster R-CNN算法[16]实现对施工的智能化监管. 王林等人[17]通过在YOLOv3主干网络后添加空间金字塔池化, 提升了对火焰和烟雾的检测精度. 孙备等人[18]基于多尺度卷积融合和空间注意力改进SSD检测算法, 对水面微小目标的检测精度有很大提升. 总体而言, 深度学习的算法比起传统算法有很大的进步, 然而针对水面垃圾数据集目标与背景差异颜色小, 形状尺度多变以及小目标检测精度不高的问题深度学习的方法还存在很大挑战.

本文针对水面垃圾数据集面临的挑战, 基于YOLOv3算法, 提出一种结合注意力机制的多尺度池化模块和融合多层特征图丰富边缘信息的多向特征金字塔网络分别解决水面垃圾检测中的目标与背景颜色差异小, 形状差异大和小目标检测问题. 同时改进K-means聚类算法, 使聚类得到的先验框更匹配数据集, 加快算法损失收敛速度, 提高算法检测精度. 最后为缓解YOLOv3中正负样本失衡问题, 使用focal loss替换计算负样本置信度的交叉熵. 实验表明, 本文基于YOLOv3的改进能够大大改善水面垃圾检测的精度.

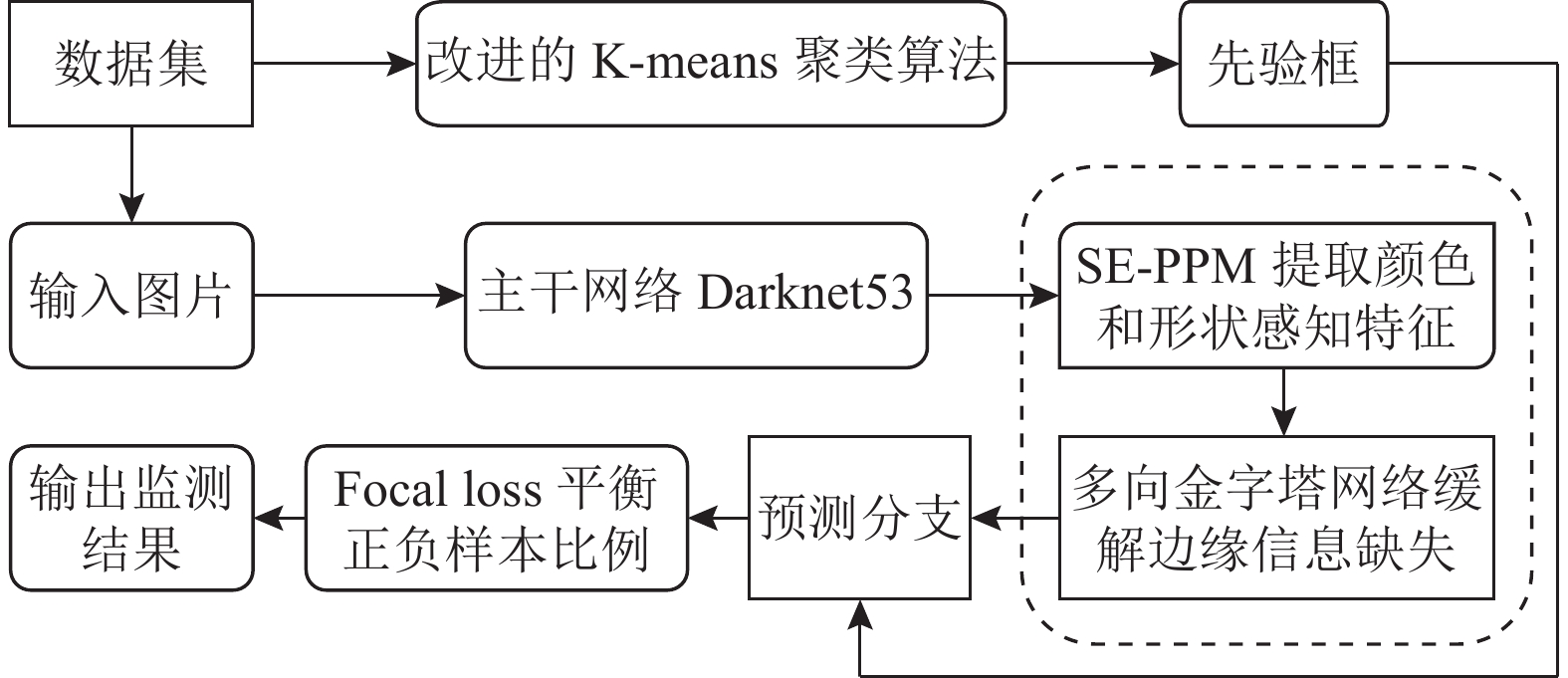

1 改进的YOLOv3算法本文基于YOLOv3的目标检测框架, 添加了注意力多尺度池化模块和多向金字塔网络, 来解决水面垃圾目标中的目标与背景差异小, 形状尺度多变和小目标问题, 在提升水面垃圾检测准确度的同时, 不损失太多YOLOv3的检测速度. 检测框架如图1所示.

|

图 1 基于YOLOv3的水面垃圾检测框架整体流程 |

该框架的具体流程如下.

1) 通过数据集使用改进的K-means算法聚类得到先验框.

2) 输入待检测的图像.

3) 使用主干网络Darknet53提取卷积的特征, 即主干特征.

4) 把主干特征输入SE-PPM模块加强目标颜色和形状特征.

5) 使用多向金字塔网络缓解加强后的特征图在上采样过程中边缘信息缺失.

6) 在预测分支中通过聚类得到的先验框对目标进行预测.

7) 使用focal loss替换交叉熵计算负样本的置信度, 并进行梯度更新.

8) 输出当前图像目标检测结果, 即该图像中所有目标的分类准确度和定位框坐标信息.

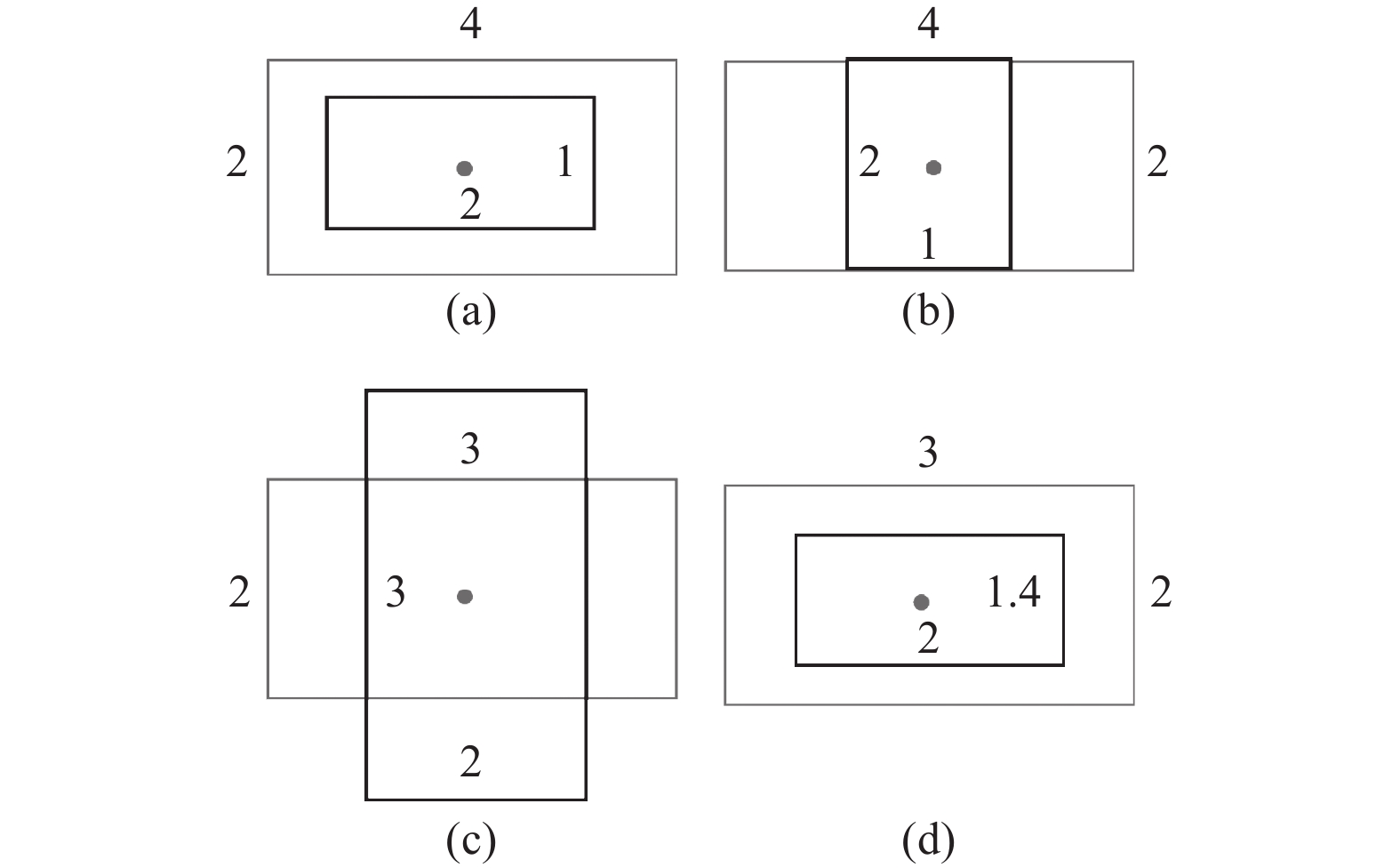

1.1 改进的K-means聚类方法因为本文中水面垃圾数据集与CoCo等公开数据集有很大差异, 需要使用聚类算法重新聚类先验框. YOLOv3算法使用K-means[19]聚类生成先验框, 其聚类的衡量指标为d=1–IoU, 使用d作为衡量指标会造成无法正确判断聚类中心点的情况, 如图2所示.

|

图 2 先验框生成示意图 |

图2(a)的IoU=0.5, 图2(b)的IoU=0.5, 使得da=db, 无法判断该目标框属于哪一个聚类中心. 同理, 图2(c)的IoU=0.5, 图2(d)的IoU=0.47, da<db, 该目标框被划分给了图2(c)聚类中心, 而事实上该目标框划分给图2(d)聚类中心更加适合. 因此提出一种新的衡量指标WIoU, 将K-means聚类中的距离衡量公式替换为d1:

| $ {d_1} = 1 - WIo{U_{(A, B)}} $ | (1) |

| $ WIo{U_{(A, B)}} = Io{U_{(A, B)}} - \frac{{\left| {C\backslash (A \cup B)} \right|}}{{\left| C \right|}} - \alpha v $ | (2) |

| $ v = \frac{4}{{{\pi ^2}}}{\left(\arctan \frac{{{w^{gt}}}}{{{h^{gt}}}} - \arctan \frac{{{w_{{i}}}}}{{{h_{{i}}}}}\right)^2} $ | (3) |

其中, C为包含A与B的最小边界框;

使用WIoU作为衡量指标时, 图2(a)的WIoU=0.5, 图2(b)的WIoU=0.33, da=0.5<db=0.67, 目标被划分给更合适的聚类中心图2(a); 图2(c)的WIoU=0.33, 图2(d)的WIoU=0.469, da=0.67>db=0.531, 目标框划分给更匹配的聚类中心图2(d). 由此可知, 使用WIoU计算出来的先验框与真实标注框的贴合程度最高.

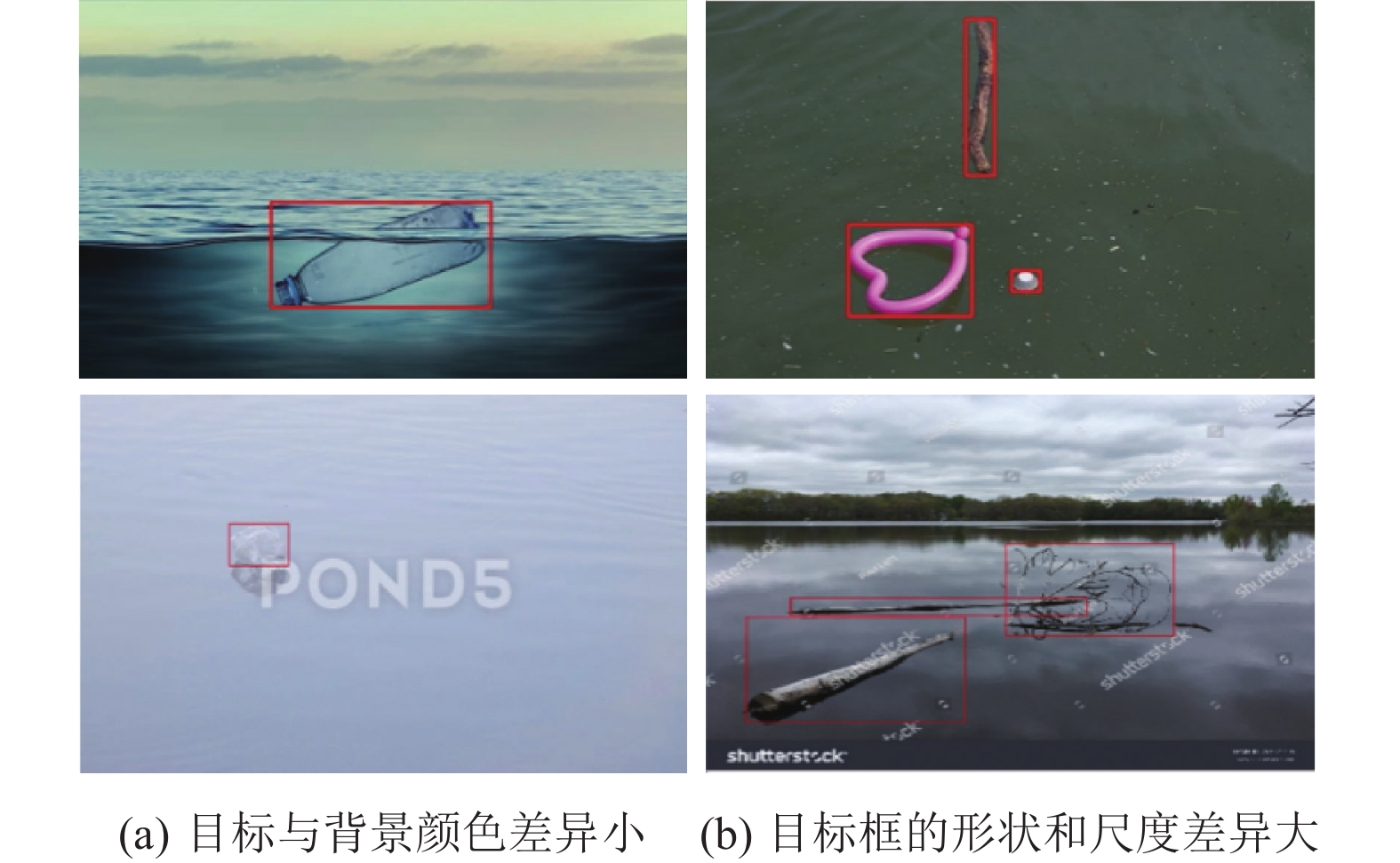

1.2 SE-PPM模块在水面垃圾数据集, 发现两个很大的挑战: 1)不同的分类的目标框形状尺度差别很大; 2)塑料垃圾和瓶子垃圾与背景颜色差异很小. 如图3所示.

|

图 3 数据集的尺度形状以及背景差异 |

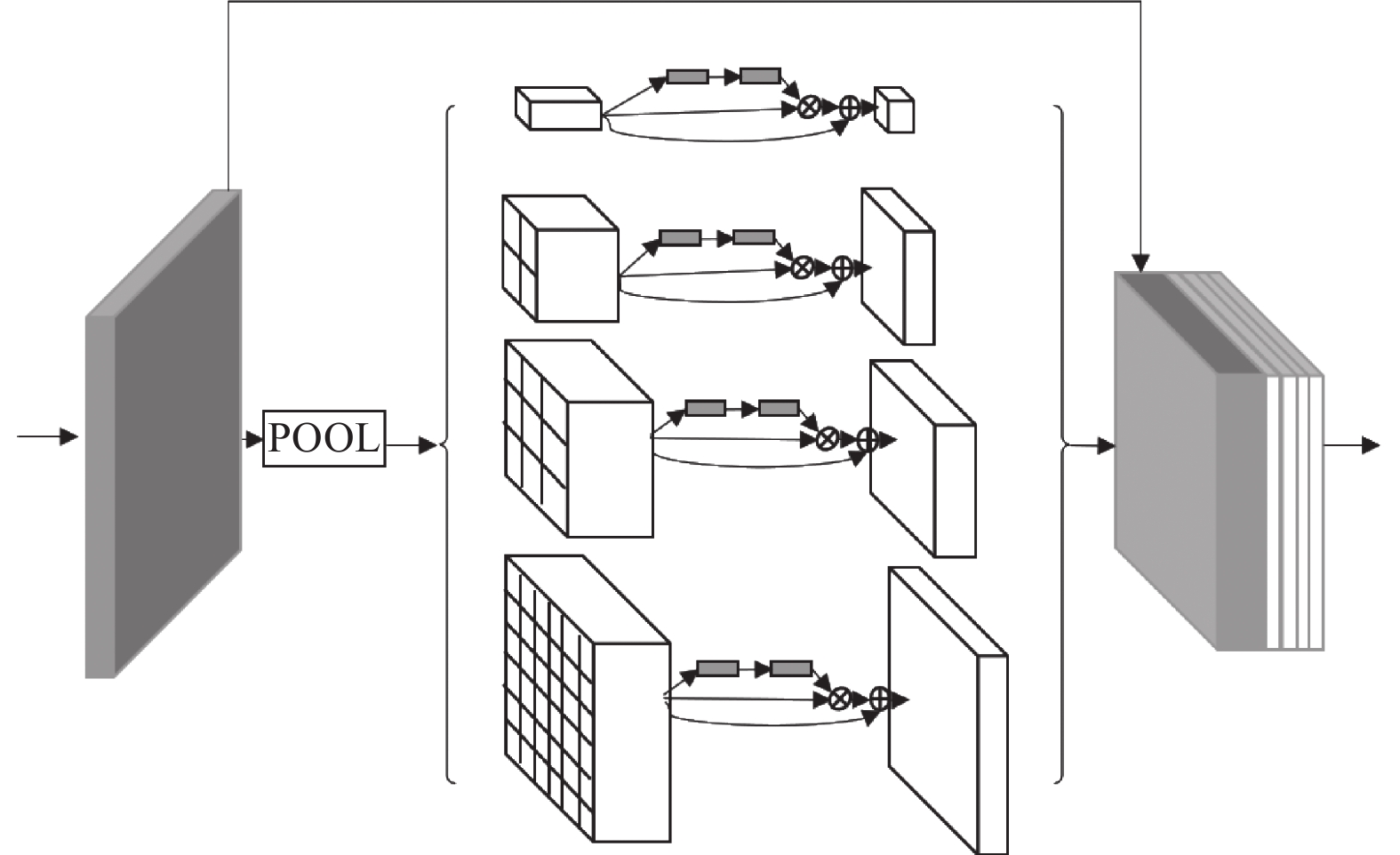

针对这两个挑战, 本文提出一种新的解决方法, 即带注意力机制的多尺度池化模块(SE-PPM), 如图4所示.

|

图 4 SE-PPM网络结构 |

通过图4可以看出, 首先把主干网络提取的特征池化成4个不同尺度的特征图, 分别为1×1×C, 2×2×C, 3×3×C和6×6×C. 不同尺度的池化模块PPM[20]的使用, 首先能将不同尺度的特征图转化为固定尺寸的特征图, 提高了图像目标的尺寸不变性, 缓解了图像中目标形状大小差异问题; 其次, 大尺寸的池化能够提升感受野, 感知目标的整体信息, 小尺度的池化能关注目标的细节信息, 然而过大尺度的池化必然会导致细节信息丢失, 因此通过主干网络特征和经过不同尺度池化后特征图进行通道融合. 特征融合后的特征图使用一个卷积核为1×1的卷积层对通道进行调整, 最终与输入的特征图通道保持一致.

在经过池化后的特征图, 添加进带残差结构的通道注意力机制(SEnet)[21]结构中, 经过squeeze和excitation后得到各个通道相应的权值再与原特征图对应通道的所有元素相乘, 这样的好处是能够加强图像中目标的特征, 降低检测与背景颜色差异小的目标的难度. 但注意力机制往往是聚焦于重要信息, 忽略相对不重要的信息, 造成了细节信息的丢失, 使小目标的检测变得更加困难, 为了保留细节信息不被丢弃, 借用残差网络的思想, 把输入的特征图与经过通道注意力机制提取的特征图相加.

实验证明, 本文设计的带注意力机制的多尺度池化模块(SE-PPM)不仅能增强对多尺度目标信息变化的关注, 而且一定程度上缓解了待检测目标和背景颜色差异小而漏检的问题.

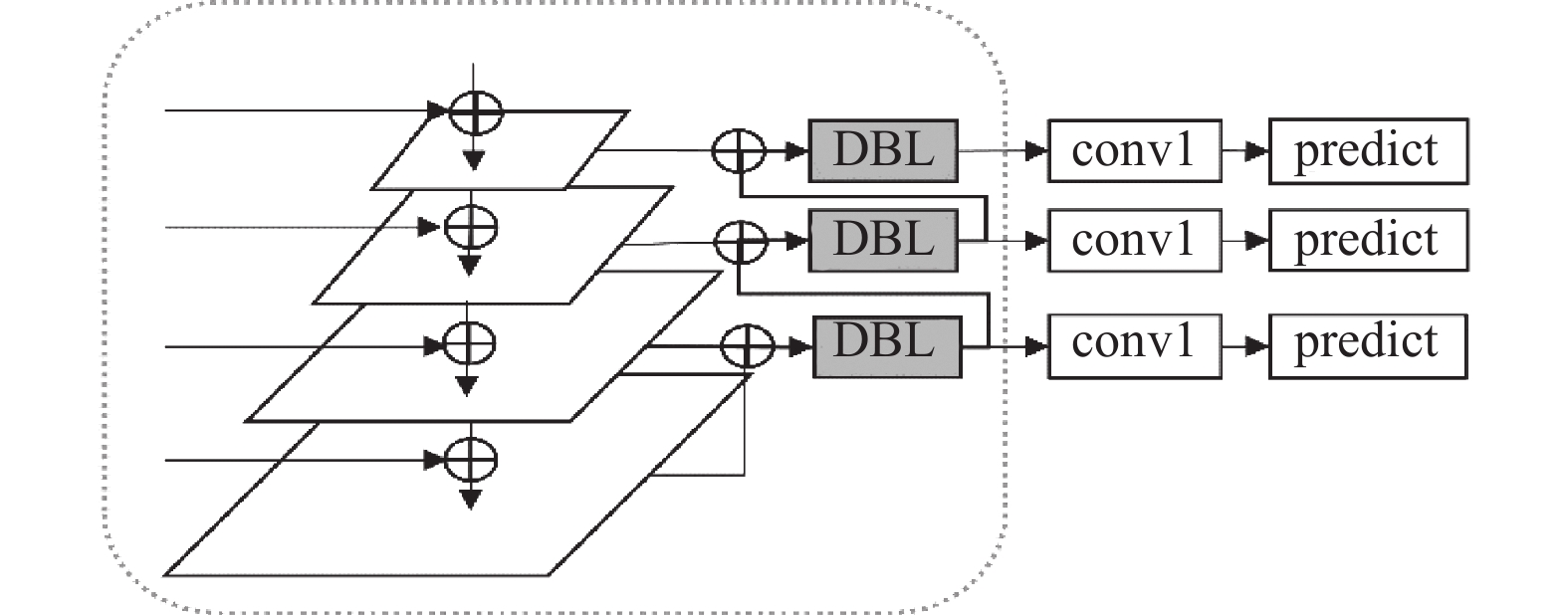

1.3 多向金字塔目标检测任务中, 随着卷积网络深度增加能获得更好的语义信息的特征图, 但深度增加的同时, 特征图的尺寸也在指数倍减小, 很多小目标的位置信息在此过程中被当成边缘信息被忽略掉, 导致小目标在检测任务中经常出现漏检和误检的情况. YOLOv3算法虽然通过最邻近元插值法上采样使3个不同尺度的特征图进行融合, 在一定程度上缓解了小目标位置信息的缺失, 但是对浅层的目标信息利用不够充分, 降低了对小目标的检测精度. 针对上述的挑战, 本文提出了一种新的基于特征融合的改进方法, 其网络结构如图5所示.

多向金字塔网络(multidirection FPN)的具体流程为: 首先通过自底向上的方式把携带丰富特征语义信息的深层上采样与携带准确位置信息的浅层特征融合, 在原有的基础上上采样融合特征到尺度为112×112的特征图. 融合后的特征图经过5个基础卷积模块后进入检测头部, 特征图在检测头部中先使用一个基础卷积块(图5中的DBL)调整通道, 再使用自顶向下的方式把融合后携带丰富上下文信息的特征图通过下采样与深层进行融合, 进一步增强检测小尺度的检测头中的上下文信息, 最后通过一个卷积核为1×1的卷积层(图5中的conv1)调整通道数后进行预测. 实验表明, 多向金字塔网络获得了携带更丰富上下文信息的特征图, 提高了检测精度.

|

图 5 多向金字塔网络结构 |

1.4 改进的损失函数

YOLOv3算法是基于网格进行预测的, 针对每个网格都会使用3个先验框去试探, 从而选出置信度最高的先验框帮助模型进行预测得到预测框, 再根据预测框的得分和位置等信息计算模型的总损失. 检测目标的总损失是由检测框损失, 置信度损失和类别损失加权求和得到. 其计算公式如下:

| $ \begin{split} lbox = &{\lambda _{{\rm{coord}}}}\sum\limits_{i = 0}^{{S^2}} {\sum\limits_{m = 0}^B {I_{{{im}}}^{{\rm{obj}}}(2 - {w_i} \times {h_i})[{{({x_i} - {{x}'_i})}^2} + ({y_i} - {{y}'_i}} } {)^2} \\ & + {({w_i} - {{w}'_i})^2} + {({h_i} - {{h}'_i})^2}] \end{split} $ | (4) |

| $ \begin{split} lcls = &{\lambda _{{\rm{class}}}}\sum\limits_{i = 0}^{{S^2}} {I_{{{im}}}^{{\rm{obj}}}\sum\limits_{c \in {\textit{classes}}} {[(} } {{\hat p}_i}(c)\log ({p_i}(c)) \\ & + (1 - {{\hat p}_i}(c))\log (1 - {p_i}(c))] \end{split} $ | (5) |

| $ lobj = \sum\limits_{i = 0}^{{S^2}} {\sum\limits_{m = 0}^B {I_{{{im}}}^{{\rm{obj}}}({c_i} - {{c}'_i}} } {)^2} + {\lambda _{{\rm{noobj}}}}\sum\limits_{i = 0}^{{S^2}} {\sum\limits_{m = 0}^B {I_{ij}^{{\rm{noobj}}}({c_i} - {{c}'_i}} } {)^2} $ | (6) |

| $ loss = lbox + lcls + lobj $ | (7) |

事实上在目标检测任务中, 包含目标的网格在待检测的特征图中占比是很小的, 又因为YOLOv3使用的是多尺度的预测方法, 每一次检测时会输入14×14, 28×28, 56×56这3个待检测的特征图像, 这意味每次会输出12102个检测框, 导致正负样本的比例不均衡的问题更突出了. Focal loss[12]从样本难易分类的角度出发解决了样本不均衡的问题, 提升了检测精度. 原因有二: 1)根据统计学可知样本越少的类别分类的难度越大; 2)模型在训练过程中会更倾向于难分类的目标图像, 更有助于小目标准确度的提升. 本文在通过focal loss替换置信度损失公式中负样本的交叉熵公式, 使模型在训练过程中让正样本占据更大权重, 使模型的梯度向正样本方向倾斜, 有效信息得到多次学习, 检测的精度因此也得到提升.

在YOLOv3模型中使用交叉熵公式来计算负样本置信度损失, 交叉熵如式(8)所示:

| $ \begin{split} {L_{{\text{ce}}}} &= - y\log {{\hat p}} - (1 - y)\log (1 - \hat p) \\ & = \left\{ {\begin{array}{*{20}{l}} { - \log \hat p, } \\ { - \log (1 - \hat p), } \end{array}} \right.\begin{array}{*{20}{c}} {} \\ {} \end{array}\begin{array}{*{20}{c}} {} \\ {} \end{array}\begin{array}{*{20}{c}} {y = 1} \\ {y = 0} \end{array} \end{split} $ | (8) |

其中, y表示真值, 1为正样本, 0为负样本;

Focal loss[16]是基于交叉熵公式上, 通过调整置信度损失中正负样本比例, 使正负样本达到平衡. Focal loss公式如下:

| $ \begin{split} {L_{{\rm{fl}}}}& = - \alpha y{(1 - \hat p)^\gamma }\log \hat p - (1 - \alpha )(1 - y){{\hat p}^\gamma }\log (1 - \hat p) \\ & {\text{ = }}\left\{ {\begin{array}{*{20}{l}} { - \alpha y{{(1 - \hat p)}^\gamma }\log \hat p, } \\ { - (1 - \alpha ){{\hat p}^\gamma }\log (1 - \hat p), } \end{array}} \right.\begin{array}{*{20}{l}} {} \\ {} \end{array}\begin{array}{*{20}{c}} {} \\ {} \end{array}\begin{array}{*{20}{c}} {y = 1} \\ {y = 0} \end{array} \end{split} $ | (9) |

如式(9)所示, focal loss在交叉熵公式基础上添加了一个权重因子γ. 当γ=0时, focal loss就为交叉熵公式. 当γ>0时, 损失函数会减少易分类样本的计算, 增加对难分类样本的计算. 此外, 加入了平衡因子

为了验证改进的YOLOv3水面垃圾检测算法的优越性, 使用自制的水面垃圾检测数据集进行了以下实验: (1) 使用改进前后的K-means聚类算法的实验对比; (2) 本文SPMYOLOv3算法与其他目标检测算法的对比; (3) 多尺度对比实验分析; (4) 不同改进策略的消融实验对比.

2.1 实验环境算法的训练和测试环境如表1所示.

| 表 1 网络模型训练与测试环境 |

2.2 实验数据集

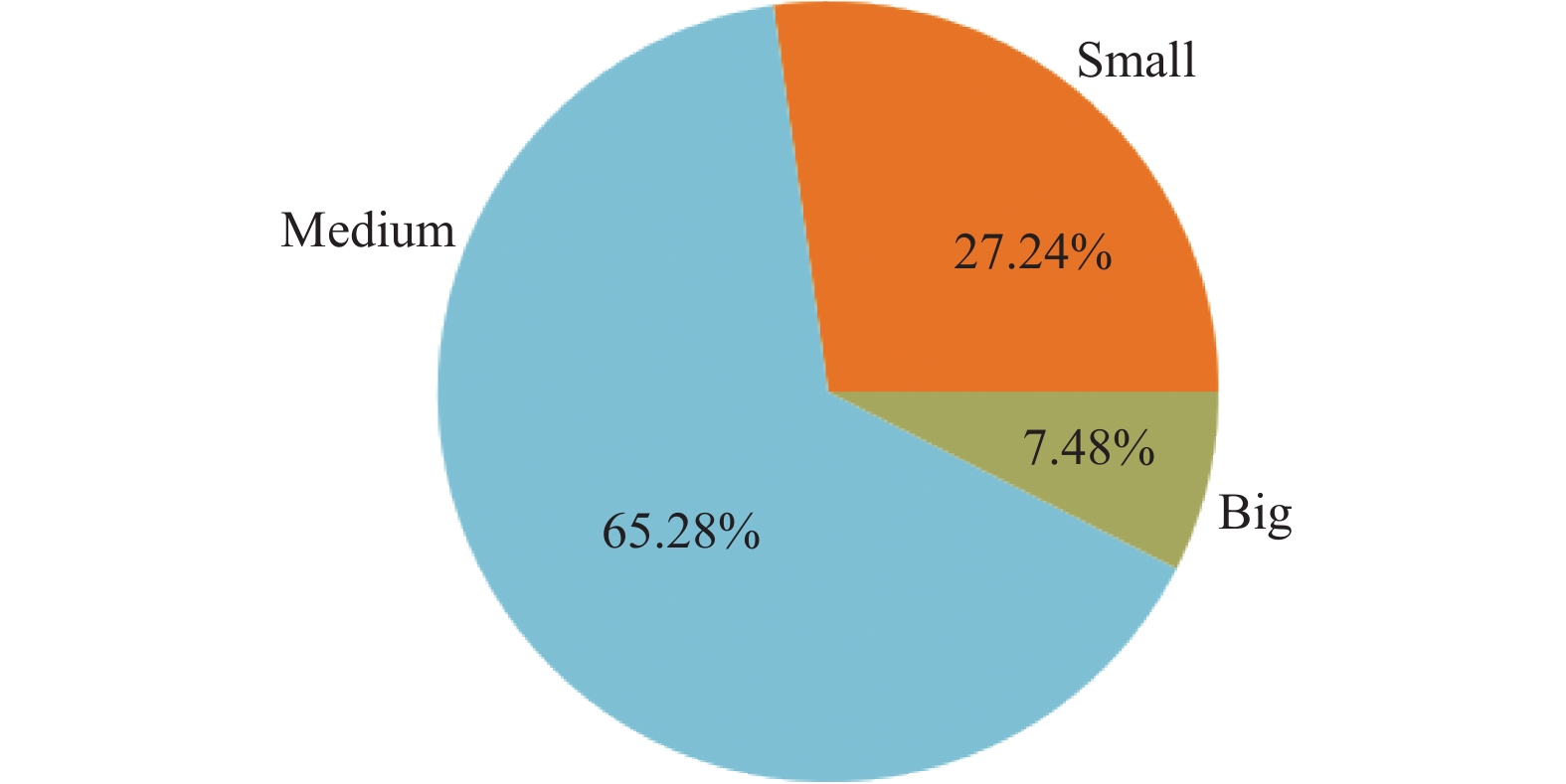

为验证改进SPMYOLOv3算法的优越性, 必须具备现实中复杂环境下的水面垃圾数据集. 数据集的来源有两种: 第1部分来源于政府部门; 第2部分来源于网络搜集水面垃圾图像. 数据集使用Labeling标注工具按照voc数据集格式标注了共2928张水面垃圾检测图片, 共包含5814个目标, 定义32×32尺寸以下为小目标, 96×96尺寸以下为中目标, 其余尺寸为大目标, 其尺度分布如图6所示.

|

图 6 水面垃圾数据集尺度分布 |

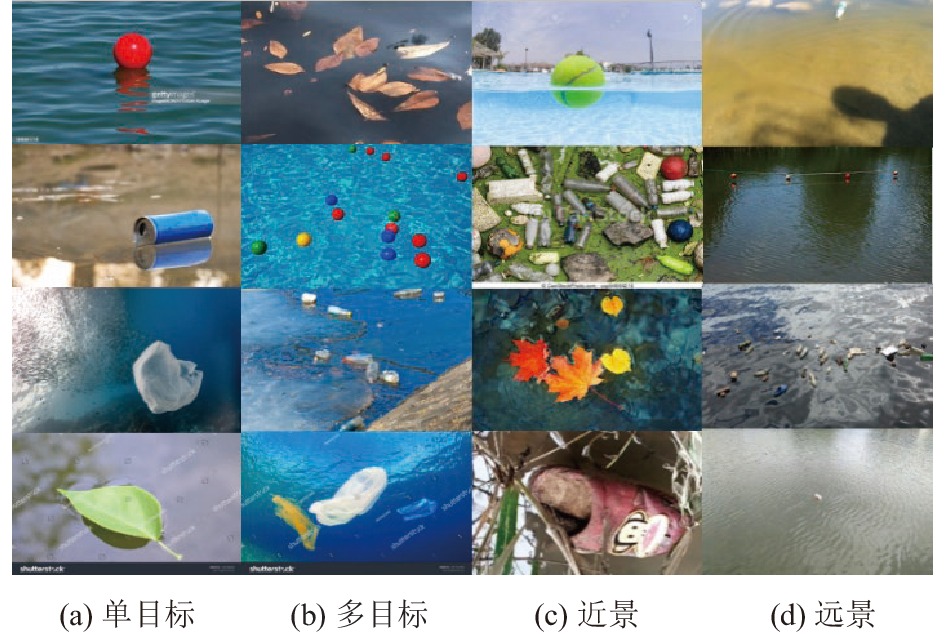

从图6可知, 水面垃圾数据集内中小目标共占92.52%. 数据集总共包含了bottle, grass, branch, milk-box, plastic-bag, plastic-gar-bage, ball和leaf这8个类别, 同时数据集中包含丰富的现实场景, 有远景, 近景, 单目标, 多目标等, 符合实际情况, 如图7所示.

2.3 改进前后的K-means聚类算法实验分析在YOLOv3算法中有3个检测头, 每个检测头中包含3个先验框, 因此使用K-means算法聚类时设定k=9. 当k=9时, 比较K-means聚类算法改进前后聚类得到M_IoU (%)和mAP (%)的具体数据如表2所示.

改进后的先验框与数据集的检测框的M_IoU提升了约13.20%, 聚类后的锚选框加入到YOLOv3原始模型中进行训练, 实验结果发现mAP提升了0.43%. 由此可知由改进的M_IoU指标聚类获得的9个先验框与水面垃圾数据集匹配程度更好.

|

图 7 水面垃圾数据集 |

2.4 检测算法对比实验分析

本文为验证改进后的模型的性能, 对改进YOLOv3检测算法与几大主流目标检测算法进行两个方面比较: 一是通过比较实验检测的效果图; 二是比较实验检测的结果.

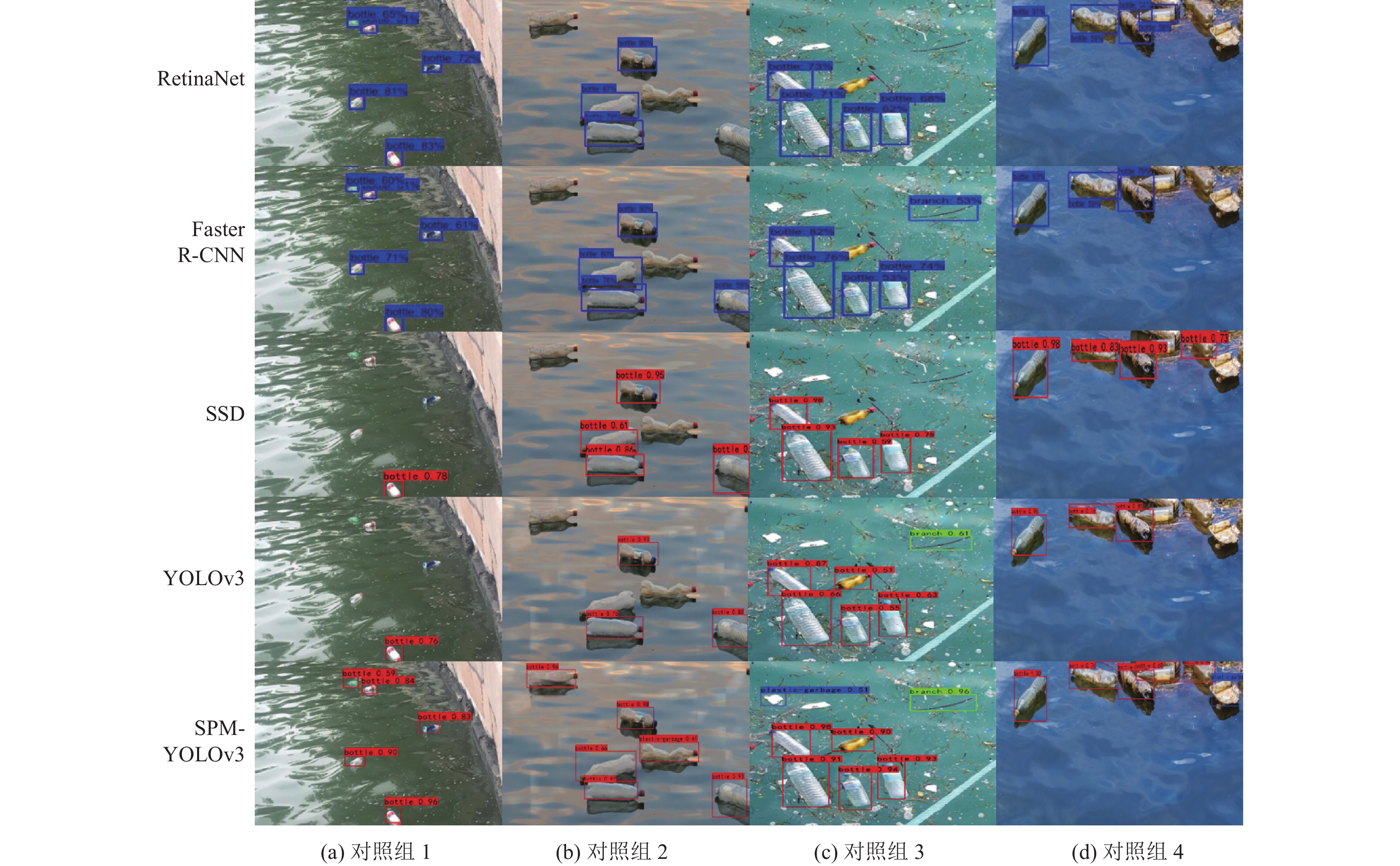

为了测试各模型对水面垃圾检测效果, 选取了测试集中几张有代表性的图像进行对比, 如图8所示.

| 表 2 K-means聚类算法改进前后尺寸和精度对比 |

|

图 8 5种算法的检测结果图 |

从图8的检测结果可以看出, 改进的YOLOv3算法在检测效果图上表现最好, 从图8(a)–图8(d)这4组对照实验, 其他算法均出现漏检和误检的情况, 而改进后的算法不仅没有出现误检和漏检, 同时检测精度均高于其他算法.

实验检测结果采用目标检测领域常用的评价指标平均精度均值(mAP)和每秒检测帧数(FPS)作为改进的YOLOv3检测算法和其他目标检测算法的衡量标准.

其中, mAP的计算公式为:

| $ {{m}}AP = \frac{{\displaystyle\sum\limits_{i = 1}^N {A{P_{(i)}}} }}{N} $ | (10) |

其中, N代表类别数; AP(i)代表每一类的准确度的均值, 其计算公式如下:

| $ A{P_{(i)}} = \int_0^1 {{P_{(i)}}({R_{(i)}}){{d}}{R_{(i)}}} $ | (11) |

使用相同的训练集和测试集通过随机梯度下降(SGD)训练150个epochs. 其实验结果如表3所示.

| 表 3 不同算法检测结果对比 |

从表3的检测结果对比中可知, 改进的YOLOv3算法在所有模型中的检测精度最高, 比二阶段的Faster R-CNN和一阶段的SSD300以及RetinaNet分别提高了5.22%, 11.38%, 6.93%. 从单个类别的检测精度上比较, 本文改进的算法在大多数类别中准确度最高. 同时检测速度相比于最好的YOLOv3也没有太多的下降. 改进后的算法既能满足对水面垃圾目标的检测精度要求, 也能满足对水面垃圾目标检测的实时性要求.

2.5 多尺度对比实验分析在本节中, 为了深入探索本文算法对不同尺度的目标检测精度的影响, 分别对不同尺度的目标进行了实验, 实验结果如表4所示.

| 表 4 各尺度目标检测精度mAP对比 (%) |

从表4可知, 本文在大尺度目标的检测精度上只提升了1.70%, 效果比较一般. 但本文算法改进对于中小目标的检测精度提升较大, 分别为3.51%和5.59%, 极大地改善了对于水面垃圾小目标检测精度不高的问题, 这也验证了本文算法针对中小目标检测精度不高的改进是有效的.

2.6 消融实验及分析在本节中, 为了深入研究每个模块的改进对原始YOLOv3网络的影响, 本文在进行消融实验时逐个加入各个改进的模块, 并记录其效果. 表5中√表示选择使用该模块, 最终得到的结果如表5所示. 其中, 方案1代表原始YOLOv3模型的精度; 方案2为使用K-means算法后, YOLOv3模型的精度; 方案3是在K-means算法后, 使用SE-PPM模块改进YOLOv3的模型精度; 方案4在方案3的基础上, 加入MdFPN模块后的模型精度; 方案5在方案4的基础上使用Focal loss损失函数替换原有的损失函数得到模型的精度.

| 表 5 Darknet53下不同改进方案消融实验的mAP对比 |

从表5可以看出, K-means算法的改进在精度的提升了0.43%, 且先验框和真实框的M_IoU提升了13.20%, 使得检测框和先验框得到更大的交并比, 帮助模型更好的预测检测结果.

添加SE-PPM模块对YOLOv3网络的影响效果明显, 精度提升了1.6%, 因为该模块通过多尺度池化缓解水面垃圾目标形状多变的难题, 且保留全局信息, 再通过其中带残差的注意力机制使得重要特征更容易被检测到, 提升了检测精度; 加入SE-PPM和MdFPN两个模块, 精度提升了2.55%, 原因有二: 1)多向特征融合解决了上下文信息利用不充分的问题, 提升了模型的检测精度; 2) SE-PPM突出重要的局部信息, 保留了全局信息, 对于多向特征融合网络有更好的搭配作用, 让特征信息得到更充分的利用.

使用focal loss替换原模型中二元交叉熵函数也起到较为明显的效果, 虽然在添加focal loss后精度只提升了0.98%, 但focal loss的使用解决了YOLOv3模型中负样本失衡的问题, 同时让模型向正样本方向进行梯度更新, 加快了模型的收敛速度, 是很好的一个改进策略.

3 总结水面垃圾检测在水体保护领域有重大意义, 本文针对目前水面垃圾目标与背景差异颜色小, 形状尺度多变以及小目标检测精度不高的问题提出一种SPMYOLOv3水面垃圾目标检测方法. 通过先验框的优化, 带注意力的多尺度池化网络, 特征融合网络改进和交叉熵损失函数替换等措施提升了改进算法在水面垃圾数据集上的检测效果. 后续工作将考虑使用轻量化网络替换基础网络, 在确保精度不损失情况下, 实现算法在下游移动端设备上的应用.

| [1] |

Viola P, Jones MJ. Robust real-time face detection. International Journal of Computer Vision, 2004, 57(2): 137-154. DOI:10.1023/B:VISI.0000013087.49260.fb |

| [2] |

Szegedy C, Toshev A, Erhan D. Deep neural networks for object detection. Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe: Curran Associates Inc., 2013. 2553–2561.

|

| [3] |

王斌. 海面目标红外检测方法研究[博士学位论文]. 大连: 大连海事大学, 2018.

|

| [4] |

方晶, 冯顺山, 冯源. 水面航行体对舰船目标的图像检测方法. 北京理工大学学报, 2017, 37(12): 1235-1240. |

| [5] |

魏建荣. 背景纹理模型在海面舰船目标检测中的应用研究. 舰船科学技术, 2017, 39(10A): 159-161. |

| [6] |

汤伟, 刘思洋, 陈景霞, 等. 基于计算机视觉的水面目标分割与识别方法. 2018中国自动化大会(CAC2018)论文集. 西安: 中国自动化学会, 2018. 532–537.

|

| [7] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [8] |

Girshick R. Fast R-CNN. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [9] |

Dai JF, Li Y, He KM, et al. R-FCN: Object detection via region-based fully convolutional networks. Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona: Curran Associates Inc., 2016. 379–387.

|

| [10] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [11] |

Fu CY, Liu W, Ranga A, et al. DSSD: Deconvolutional single shot detector. arXiv:1701.06659, 2017.

|

| [12] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2999–3007.

|

| [13] |

李佳琪, 吴湘宁, 邓中港, 等. 基于注意力及生成对抗网络的遥感影像目标检测方法. 中国, CN113989612A. 2022-01-28.

|

| [14] |

He KM, Gkioxari G, Dollár P, et al. Mask R-CNN. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988.

|

| [15] |

王志鹏, 王涛. 基于Faster RCNN的穿越围栏违规行为检测. 计算机系统应用, 2022, 31(4): 346-351. DOI:10.15888/j.cnki.csa.008423 |

| [16] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2015. 91–99.

|

| [17] |

王林, 赵红. 改进YOLOv3的火灾检测. 计算机系统应用, 2022, 31(4): 143-153. DOI:10.15888/j.cnki.csa.008404 |

| [18] |

孙备, 左震, 吴鹏, 等. 面向无人艇环境感知的改进型SSD目标检测方法. 仪器仪表学报, 2021, 42(9): 52-61. DOI:10.19650/j.cnki.cjsi.J2108000 |

| [19] |

Hartigan JA, Wong MA. Algorithm AS 136: A K-means clustering algorithm. Journal of the Royal Statistical Society. Series C (Applied Statistics), 1979, 28(1): 100-108. |

| [20] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [21] |

Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6230–6239.

|

2023, Vol. 32

2023, Vol. 32