场景理解就是对场景进行可视化分析, 是一个将图像或点云转化为认知的研究方向. 场景理解可以实现对三维场景的检测、定位、识别和理解4个层次的功能, 除了检测角落、边缘和移动区域等视觉特征外, 还可以提取与物理世界相关的信息, 具有一定的研究价值和应用前景[1]. 三维场景密集字幕作为视觉场景理解和自然语言处理联合领域的一个新兴任务, 备受关注, 目标是对三维场景中的任一对象进行定位和描述. 该任务不仅要求模型能够理解场景的点云内容信息, 还要求用自然语言描述对象特征和对象之间的关系. 到目前为止, 视觉和自然语言的联合领域已经有了很多工作, 比如图像字幕、密集字幕、视频字幕、视觉问答等, 但是其中绝大多数工作都只局限在二维视觉数据上. 在物理世界中, 所有的元素理所当然的交织在一起, 因此真正理解物理世界需要整合多层次的信息以及学习场景元素之间关系, 即使是二维的照片和视频, 其所描绘的场景和对象本身也应是三维的. 为了更加真切的解释我们周围的世界, 视觉场景理解模型必须具备理解三维场景的能力. 与二维图像相比, 点云等三维数据能够为场景提供更详细的几何、结构和空间信息, 所以在由点云表示的真实世界环境中定位对象和产生描述性语句对于许多任务更为重要, 比如: 室内导盲机器人、机器人抓取、自动驾驶等. 中国有超过1750万人视障, 他们的日常生活和出行十分不便, 无法定位和自主拿取物品, 道路突发事件难以及时规避, 该技术可以在实际中进行应用, 使得视障人士能够实时感知外部环境, 为日常生活提供便利和安全.

该任务实验所需数据集要求包含整个场景的点云及点云特征信息, 以及标注好的每个三维对象的三维边界框和相应描述. 但是制作数据集需要采集海量的场景样本并进行人工标注, 将耗费大量的人力物力. 由于实验缺少充足的训练数据, 三维密集字幕任务一直没有被跟进. 随着ScanRefer数据集[2]的提出, 字幕任务才首次被Chen等人[3]正式引入到三维视觉任务中, 即三维场景密集字幕任务, 也是近年来三维视觉领域发展的一个新的方向, 该任务在三维场景中密集地定位和描述三维对象, 比二维图像字幕更具有挑战性.

除了目标检测深度网络模型是关键的技术重点外, 为场景中检测出的物体生成相应的外观和相对位置自然语言描述, 也是需要突破的关键技术与发展方向. 基于此, 本文考虑到当前存在的目标检测模型未充分考虑场景点云之间的上下文信息. 如图1所示, 模型在定位对象时将微波炉下面的橱柜识别为“床”, 进而导致为对象“微波炉”生成的描述为“微波炉在床上”, 事实上, 在许多场景中, 微波炉是不可能放在床上的. 为了有效避免类似情况, 本文提出多层级上下文投票网络.

在投票过程中使用自注意力机制捕获点云的上下文信息, 同时还在投票过程中引入原始点云特征, 并以多层传导、层级叠加的方式更大化利用点云特征、降低特征损失, 进而提高检测三维对象的准确率. 考虑到隐藏状态信息量单一, 且前一时刻生成的单词对当前时刻单词生成也具有一定的指导作用, 本文提出了隐藏状态-注意力时序融合模块, 该模块在字幕生成过程中分别对两层门控循环单元(gated recurrent unit, GRU)的隐藏状态施加上下文注意力, 并将注意力结果传入下一时刻与“融合GRU”的隐藏状态融合, 以提升隐藏状态的有效信息量, 进而更加丰富并准确地生成单词. 除此之外, 本文采用“两阶段”训练方法代替基线的“端到端”训练方法, 第1阶段使用基于多层级上下文投票网络的目标检测方法定位和识别场景中的三维对象, 生成三维对象提案; 第2阶段根据生成的对象提案和相应的实体名称标记来指导生成字幕. 该训练方法有效解决了前后阶段训练参数不匹配的问题, 过滤掉第1阶段生成的低质量对象提案, 从而降低了第2阶段训练的时间复杂度并增强描述效果.

|

图 1 场景举例 |

本文的创新点可以总结归纳为如下4点.

(1)提出了多层级上下文投票网络, 该网络通过利用三维元素之间的上下文关系来对场景中三维对象进行定位, 同时, 通过多层级引入原始点云特征, 达到减少投票过程中特征丢失的目的.

(2)设计隐藏状态-注意力时序融合模块, 该模块通过融合隐藏状态与上一时刻注意力结果, 丰富当前时刻隐藏状态的有效信息量, 更加准确地指导生成单词.

(3)采用“两阶段”训练方法, 不仅解决了前后阶段训练参数不匹配问题, 而且过滤掉了低质量对象提案, 在增强描述效果的同时, 降低了字幕生成阶段的时间复杂度.

(4)通过基于ScanNet和ScanRefer数据集上的大量实验, 对本文提出的模型进行了分析与验证, 结果表明了该方法的有效性.

2 相关工作 2.1 三维视觉和语言近年来, 视觉和语言的联合领域获得了极大的关注, Chen等人[4]提出了数据集Text2Shape, 包含对三维形状数据集ShapeNet[5]的描述, 提出了基于自然语言检索、生成彩色三维形状的任务. Achlioptas等人[6]和Chen等人[2]提出了两个数据集ReferIt3D和ScanRefer, 包含对ScanNet数据集[7]场景中三维对象的描述. 不同的是, ReferIt3D用来根据自然语言描述区分场景中的细粒度对象. ScanRefer用于根据自然语言描述在场景中检测和定位对象. Yuan等人[8]和Zhao等人[9]的工作, 也是利用自然语言描述在三维场景中检测和定位对象. 之后, Chen等人[3]提出一个反向任务, 根据场景上下文密集的定位和描述三维对象, 是三维视觉领域的目标检测任务和二维图像领域的字幕生成任务的联合, 该任务首次将字幕生成任务引入到三维领域中. 尽管该方法可以有效地为三维对象生成字幕, 但是生成的字幕单一且可辨别性不足. Chen等人[10]提出了一个更有效的半监督方法, 使用PointGroup网络[11]作为检测主干, 并添加“说话者-听众”模块, 以自我批评的方式生成字幕. 该方法取得了更有竞争力的结果. 但是模型结构较为复杂, 机器需要较高的配置, 耗费大量的时间. 我们将Chen等人[3]的工作作为基线. 通过引入多层级上下文投票网络和隐藏状态-注意力时序融合模块, 提高三维对象定位的准确性和生成字幕的可靠性.

2.2 三维目标检测三维目标检测是计算机视觉领域中一个活跃的研究课题, 也是三维场景密集字幕的重要阶段. Qi等人提出了PointNet[12]和PointNet++[13]网络, 开辟了在神经网络中直接处理三维点云数据的新途径. 接着, Shi等人[14]提出了一个两阶段三维目标检测网络, 先生成三维边界框提案, 再对这些提案进行细化获得最终检测结果, 很好地解决了遮挡问题以及检测过程中对二维检测结果的依赖. 但是该方法检测精度依然不高, 无法聚合对象中心周围的上下文信息. 受二维目标检测的霍夫投票策略[15]的启发, Qi等人[16]提出了一个端到端的三维目标检测网络, 将本应存在于物体表面的点云用类似霍夫投票的方式投射到更加接近对象中心的位置, 进而预测对象的三维边界框. 虽然VoteNet网络在三维目标检测方面是有效的, 但是它的有效性很大程度上依赖于从骨架网络学习的点云特征. 因此, 提取高质量的点云特征是该三维目标检测方法成功的关键因素. 在该网络的基础上, Chen等人[17]采用基于图卷积的分层图神经网络用于三维目标检测; Yang等人[18]提出一种基于特征距离的新型采样策略; Zhang等人[19]通过引入一组混合的几何图元来改进由投票预测的初始边界框; Xie等人[20]在检测过程中捕获点、对象和场景级别的上下文信息. Zhao等人[9]提出了基于Transformer的架构, 在定位期间处理多模态上下文. 虽然这些方法有效地整合了多层次上下文信息、提高了检测精度, 但仍未有效解决投票过程中特征丢失过多的问题, 针对此问题, 本文提出多层级上下文投票网络, 致力于改进投票过程中的特征丢失问题, 进一步丰富生成投票点的位置.

2.3 图像字幕和密集字幕图像字幕是计算机技术的研究热点, 也是计算机视觉和自然语言处理的一个快速发展的研究领域. 与早期基于模板和基于检索的图像字幕方法相比, Zhu等人[21]和Ji等人[22]的工作基于编码器-解码器结构的图像字幕方法取得了巨大进步. 受机器翻译的启发, Anderson等人[23]和Wang等人[24]提出了基于注意机制的图像字幕模型, 以提高描述性能. Mi等人[25]和Li等人[26]利用场景图来捕捉对象之间的关系信息, 以提高图像字幕的性能. 但是这些方法只生成单个的枯燥、信息量少的字幕. Johnson等人[27]提出了一个完全卷积的定位网络, 将目标检测和图像字幕统一在一个框架中, 以预测对象区域上的一组描述, 用更多的句子描述图像以覆盖更多图像中的细节, 即图像密集描述. Krishna等人[28]将密集字幕移植到视频中, 旨在预测连续的事件提案并为每个剪辑生成描述. 在这些工作中, 密集的字幕比传统的单句传达了更多视觉内容的细节. 与图像密集字幕相似, 在三维场景中进行密集字幕生成任务需要首先为视觉概念标记边界框, 然后为每一个边界框标注字幕. 然而, 这些算法很少考虑到对象之间的空间关系信息, 这可能导致字幕任务在三维场景中生成不准确的对象之间关系的描述. 除此之外还有隐藏状态信息单一等问题, 导致生成的句子形式简单. 我们的工作是通过对两层GRU的特征向量和隐藏状态施加上下文注意力, 并将隐藏状态与前一时刻注意力的结果融合, 增加隐藏状态的有效信息量, 从而提高字幕模型的描述性能.

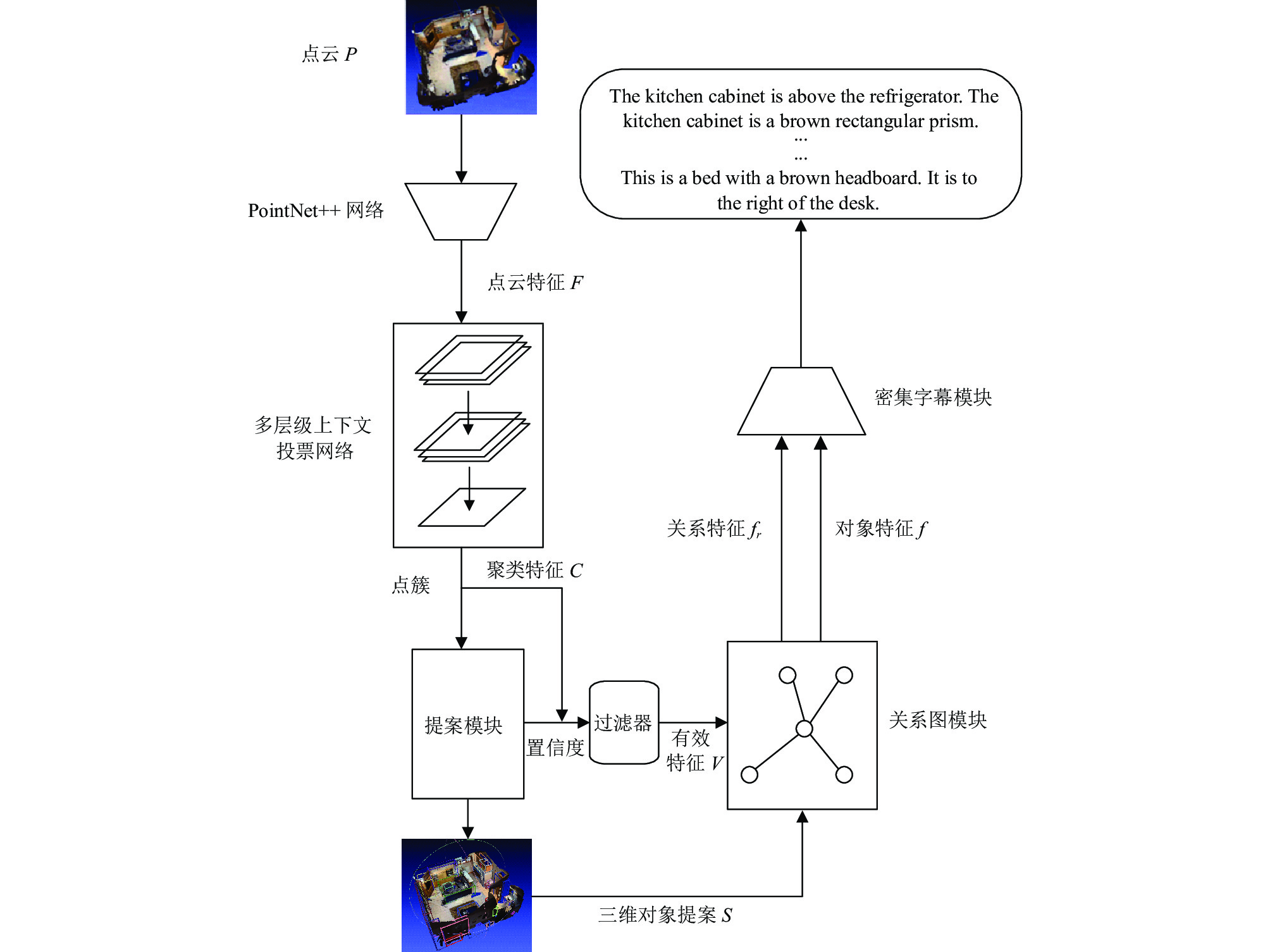

3 本文方法 3.1 整体框架本文的整体模型框架如图2所示. 采用三维场景的点云作为网络的输入, 使用点云特征提取网络PointNet++提取点云特征

|

图 2 整体模型框架图 |

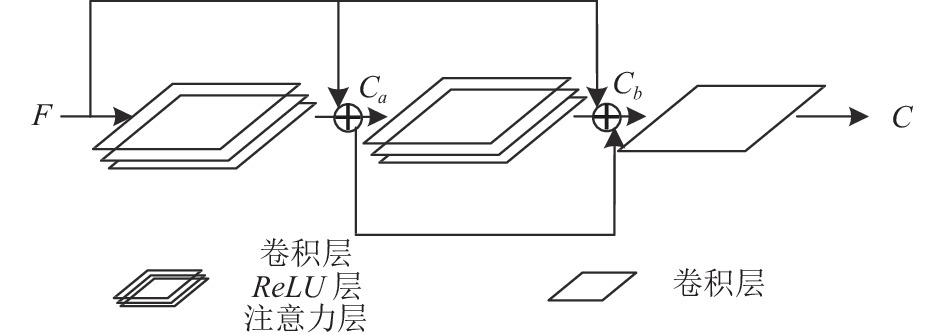

3.2 多层级上下文投票网络

本文提出了一个多层级上下文投票网络, 我们将原始VoteNet网络投票过程的“卷积层+ReLU激活函数”称作一个投票单元. 在原始投票网络的基础上为两个投票单元各施加一层自注意力以学习投票过程中点云之间的上下文信息, 并将新投票单元的过程特征与原始点云特征融合. 该网络具体结构如图3所示.

此网络中, 将PointNet++网络提取的点云特征

| Ca=SA(ReLU(Conv(F))) | (1) |

| Cb=SA(ReLU(Conv(δ1Ca+γ1F))) | (2) |

| C=Conv(δ2F+γ2Ca+λCb) | (3) |

其中,

|

图 3 多层级上下文投票网络框架图 |

3.3 带有隐藏状态-注意力时序融合的密集字幕模块

本文将关系图模块输出的对象特征

|

图 4 带有隐藏状态-注意力时序融合的密集字幕模块 |

首先, 本文通过式(4)表示

| ht=GRU(ut,ht−1,vt) | (4) |

其中,

在每个时间步长

| u1t=[h2t−1,fk,xt−1] | (5) |

其中,

得到融合GRU的隐藏状态

| H1t=W1h1t+W2[α1t−1,α2t−1] | (6) |

| α1t=Softmax((WvVr+WhH1t)Wa) | (7) |

其中,

将注意力结果与融合GRU的隐藏状态连接作为语言GRU的输入向量, 对应公式为:

| u2t=[h1t,α1t] | (8) |

我们与Qi等人[16]使用相同的目标检测损失:

| φdet=φvote-reg+0.5φobjn-cls+φbox+0.1φsem-cls | (9) |

其中,

| φbox=φcenter-reg+0.1φsize-cls+φsize-reg | (10) |

其中,

为了稳定关系图模块的学习过程, 在消息传递网络上应用相对方向损失

最后用线性方式组合上述3个损失项, 作为最终的损失函数:

| φ = m1φdet+m2φad+m3φdes | (11) |

其中,

本文在官方数据集ScanNet和ScanRefer上评估和验证基于多层级上下文投票的三维密集字幕模型. ScanRefer数据集包含800个场景、11046个对象以及51583个对应的描述, 这些描述包含对象的外观信息(例如: 这是一个白色的微波炉)以及相对空间位置(例如: 它在桌子上的角落里). 数据样本分为训练集36665个和验证集9508个, 确保每个分割的场景不相交, 结果和分析同样是在验证集上进行的. 在实验过程中, 使用预测边界之间的交并比(intersection over union, IoU)分数来评估生成的三维边界框, IoU 阈值的平均精度 (mean average precision, mAP) 作为目标检测评价指标. 使用标准图像字幕评估策略, 包括CIDEr[31]、BLEU[32]、METEOR[33]、ROUGE[34], 来评估本文所提出的模型, 并与基线模型进行比较. CIDEr评估方法将生成的字幕表示成向量, 计算真实标签与模型生成字幕的余弦相似度. BLEU评估生成字幕与真实标签的差异, 取值范围为0–1, 如果两者完美匹配, 那么BLEU是1, 反之则为0. METEOR评估单字精度召回率. ROUGE将生成字幕与真实标签的n元组贡献统计量作为评估指标.

4.2 实验细节本文所做实验均是基于PyTorch框架, 并在装有RTX 2080Ti GPU的计算机上进行实验, 代替基线的端到端训练方法, 本文采用“两阶段”训练模式, 第1阶段训练三维目标检测模块, 使用Adam优化器, 批次大小为8, 学习率为0.01, 训练轮次为200, 学习率衰减步长为{80, 120, 160}, 衰减率为{0.1, 0.1, 0.1}, 训练完成后从IoU阈值设置为0.5的模型中选出最优模型; 第2阶段将训练好的三维目标检测模型作为预训练模型, 训练密集字幕模块, 学习率设置为1E–5, 批次大小设置为12, 训练轮次为50, 迭代次数114600.

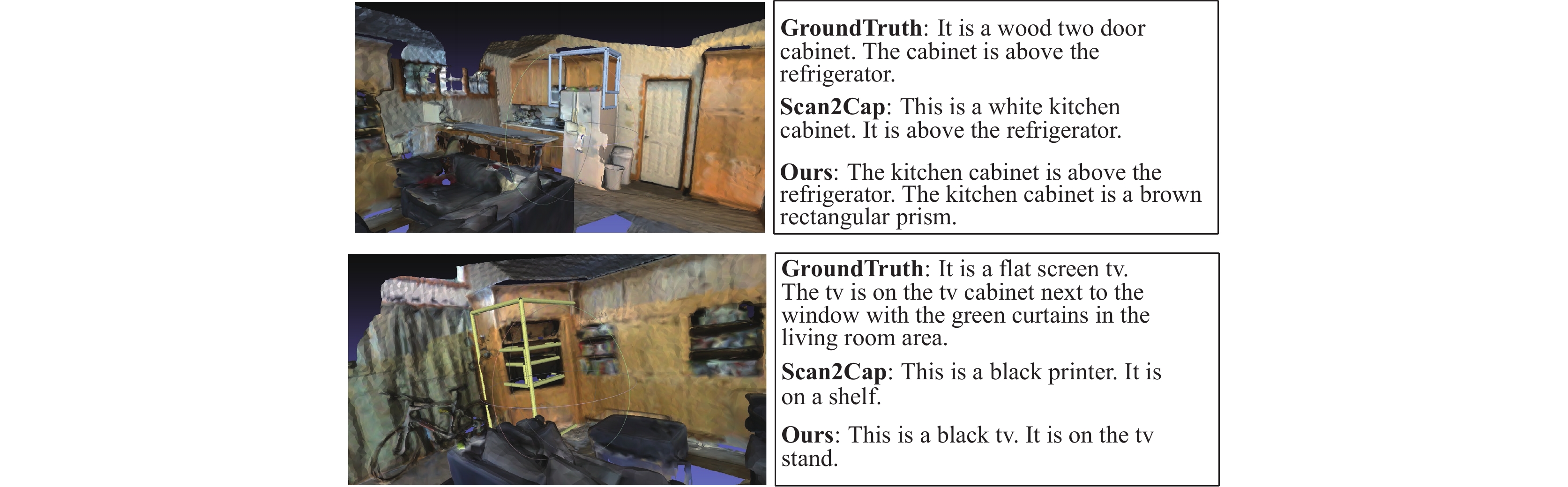

4.3 实验结果如图5所示, 是本文提出的方法训练的模型与基线模型在ScanRefer数据集上的结果比较, 可以看出, 对于同一场景, 本文的模型定位对象更准确, 生成的密集字幕与三维场景的契合度更高, 语言的表达更加准确、流利.

|

图 5 实验结果图 |

如表1所示, 本文在ScanNet和ScanRefer官方数据集上对所提方法进行了测试.

| 表 1 IoU阈值为0.25和0.5模型字幕评级指标得分 |

从表1的测试结果中可以看到, 与基线模型相比, 本文训练的模型生成的字幕评估指标都有所提高, 尤其是模型IoU阈值为0.25的CIDEr得分提高了2.86%, 模型IoU阈值为0.5的CIDEr得分提高了2.33%. 表1测试结果验证了本文提出的模型和训练方法的有效性.

4.4 实验分析为了评估本文提出的多层级上下文投票网络和隐藏状态-注意力时序融合模块的有效性, 本文对两个部分单独进行实验验证, 表2中的A表示在基线方法Scan2Cap模型的基础上, 将原始投票网络更换为本文提出的多层级上下文投票网络, B表示在Scan2Cap模型的字幕生成阶段添加隐藏状态-注意力时序融合模块. 结果如表2所示.

从表2的实验结果中可以看到, 在基线模型的基础上单独应用A时, IoU阈值设置为0.25和0.5的模型CIDEr得分分别提升了0.78%和1.58%, 在基线模型的基础上单独应用B时, CIDEr得分分别提升了1.89%和1.24%. 不出所料, 当同时应用A和B时, 我们的模型性能提升到最高. 表2测试结果验证了单独应用本文提出的多层级上下文投票网络和隐藏状态-注意力时序融合模块, 模型改进效果依然有效.

| 表 2 消融实验 |

为了验证本文“两阶段”训练方法的有效性, 本文设计了对比实验, 结果如表3、表4所示. Our (e2e)表示本文模型采用“端到端”训练方式.

| 表 3 “端到端”方法与“两阶段”方法模型得分比较 |

| 表 4 “端到端”方法与“两阶段”方法训练时间比较 (h) |

从表3的实验结果中可以看到, 本文采用的“两阶段”训练方法比基线的“端到端”训练方法生成的字幕评估分数更高, 从表4的实验结果中可以看到, 采用“两阶段”训练方法时模型总训练时间从120 h缩减为96 h. 表3、表4测试结果验证了本文“两阶段”训练方法的有效性.

为了研究选取第1阶段不同IoU阈值的目标检测模型作为第2阶段的预训练模型, 对本文最终模型性能的影响, 我们进行了对比实验, 如表5所示. Ours (0.25)表示本文模型选取第1阶段IoU阈值为0.25的目标检测模型作为第2阶段的预训练模型.

| 表 5 选取不同IoU阈值模型作为预训练模型的结果比较 |

从表5的实验结果中可以看到, 选取第1阶段IoU阈值为0.25的目标检测模型作为第2阶段的预训练模型, CIDEr得分相较基线分别提升了3.26%和0.53%, 但IoU阈值为0.5的模型METEOR分数降低了0.16%. 表5测试结果表明选取第1阶段IoU阈值为0.5中模型的最优目标检测模型作为第2阶段的预训练模型比0.25的整体模型效果更好. 且IoU阈值为0.5的模型说服力比0.25更高.

5 结论与展望本文提出了一种基于多层级上下文投票和隐藏状态-注意力时序融合的模型用于三维密集字幕生成, 该模型能够捕获投票过程中点云的上下文信息, 提高检测目标的准确性, 还能够将原始点云特征信息和投票过程中的信息加以多层级利用, 减少投票过程中的特征丢失. 同时, 本文设计的隐藏状态-注意力时序融合模块将当前时刻融合GRU的隐藏状态与前一时刻两层注意力进行融合, 提升隐藏状态的有效信息量. 本文还采用“两阶段”训练方法, 有效地过滤掉目标检测阶段生成的低质量对象提案, 降低字幕生成阶段的时间复杂度并增强描述效果. 通过广泛的实验验证了基于多层级上下文投票网络的三维密集字幕方法的有效性. 在未来的工作中, 将进一步探索模型框架和注意力机制的改进方式.

| [1] |

Romaszko L, Williams CKI, Winn J. Learning direct optimization for scene understanding. Pattern Recognition, 2020, 105(2): 107369. |

| [2] |

Chen DZ, Chang AX, Nießner M. ScanRefer: 3D object localization in RGB-D scans using natural language. Proceedings of the 16th European Conference on Computer Vision (ECCV). Glasgow: Springer, 2020. 202–221.

|

| [3] |

Chen DZ, Gholami A, Nießner M, et al. Scan2Cap: Context-aware dense captioning in RGB-D scans. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 3192–3202.

|

| [4] |

Chen K, Choy CB, Savva M, et al. Text2Shape: Generating shapes from natural language by learning joint embeddings. Proceedings of the 14th Asian Conference on Computer Vision. Perth: Springer, 2018. 100–116.

|

| [5] |

Chang AX, Funkhouser T, Guibas L, et al. ShapeNet: An information-rich 3D model repository. arXiv:1512.03012, 2015.

|

| [6] |

Achlioptas P, Abdelreheem A, Xia F, et al. ReferIt3D: Neural listeners for fine-grained 3D object identification in real-world scenes. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 422–440.

|

| [7] |

Dai A, Chang AX, Savva M, et al. ScanNet: Richly-annotated 3D reconstructions of indoor scenes. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 2432–2443.

|

| [8] |

Yuan ZH, Yan X, Liao YH, et al. InstanceRefer: Cooperative holistic understanding for visual grounding on point clouds through instance multi-level contextual referring. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 1791–1800.

|

| [9] |

Zhao LC, Cai DG, Sheng L, et al. 3DVG-transformer: Relation modeling for visual grounding on point clouds. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 2908–2917.

|

| [10] |

Chen DZ, Wu QR, Nießner M, et al. D3Net: A speaker-listener architecture for semi-supervised dense captioning and visual grounding in RGB-D scans. arXiv:2112.01551, 2021.

|

| [11] |

Jiang L, Zhao HS, Shi SS, et al. PointGroup: Dual-set point grouping for 3D instance segmentation. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 4867–4876.

|

| [12] |

Qi CR, Su H, Kaichun M, et al. PointNet: Deep learning on point sets for 3D classification and segmentation. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 77–85.

|

| [13] |

Qi CR, Yi L, Su H, et al. PointNet++: Deep hierarchical feature learning on point sets in a metric space. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 5105–5114.

|

| [14] |

Shi SS, Wang XG, Li HS. PointRCNN: 3D object proposal generation and detection from point cloud. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach: IEEE, 2019. 770–779.

|

| [15] |

Leibe B, Leonardis A, Schiele B. Robust object detection with interleaved categorization and segmentation. International Journal of Computer Vision, 2008, 77(1–3): 259–289.

|

| [16] |

Qi CR, Litany O, He KM, et al. Deep Hough voting for 3D object detection in point clouds. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul: IEEE, 2019. 9276–9285.

|

| [17] |

Chen JT, Lei BW, Song QY, et al. A hierarchical graph network for 3D object detection on point clouds. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 389–398.

|

| [18] |

Yang ZT, Sun YN, Liu S, et al. 3DSSD: Point-based 3D single stage object detector. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 11037–11045.

|

| [19] |

Zhang ZW, Sun B, Yang HT, et al. H3DNet: 3D object detection using hybrid geometric primitives. Proceedings of the 16th European Conference on Computer Vision (ECCV). Glasgow: Springer, 2020. 311–329.

|

| [20] |

Xie Q, Lai YK, Wu J, et al. MLCVNet: Multi-level context VoteNet for 3D object detection. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 10444–10453.

|

| [21] |

Zhu Z, Wang T, Qu H. Macroscopic control of text generation for image captioning. arXiv:2101.08000, 2021.

|

| [22] |

Ji JZ, Xu C, Zhang XD, et al. Spatio-temporal memory attention for image captioning. IEEE Transactions on Image Processing, 2020, 29: 7615-7628. DOI:10.1109/TIP.2020.3004729 |

| [23] |

Anderson P, He XD, Buehler C, et al. Bottom-up and top-down attention for image captioning and visual question answering. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6077–6086.

|

| [24] |

Wang WX, Chen ZH, Hu HF. Hierarchical attention network for image captioning. Proceedings of the 33rd AAAI Conference on Artificial Intelligence and 31st Innovative Applications of Artificial Intelligence Conference and 9th AAAI Symposium on Educational Advances in Artificial Intelligence. Honolulu: AAAI, 2019. 1099.

|

| [25] |

Mi JP, Lyu J, Tang S, et al. Interactive natural language grounding via referring expression comprehension and scene graph parsing. Frontiers in Neurorobotics, 2020, 14: 43. DOI:10.3389/fnbot.2020.00043 |

| [26] |

Li XY, Jiang SQ. Know more say less: Image captioning based on scene graphs. IEEE Transactions on Multimedia, 2019, 21(8): 2117-2130. DOI:10.1109/TMM.2019.2896516 |

| [27] |

Johnson J, Karpathy A, Li FF. DenseCap: Fully convolutional localization networks for dense captioning. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 4565–4574.

|

| [28] |

Krishna R, Hata K, Ren F, et al. Dense-captioning events in videos. Proceedings of the 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017. 706–715.

|

| [29] |

Zhao HS, Jiang L, Jia JY, et al. Point transformer. arXiv:2012.09164, 2020.

|

| [30] |

Fan HQ, Su H, Guibas L. A point set generation network for 3D object reconstruction from a single image. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 605–613.

|

| [31] |

Vedantam R, Zitnick CL, Parikh D. CIDEr: Consensus-based image description evaluation. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 4566–4575.

|

| [32] |

Papineni K, Roukos S, Ward T, et al. BLEU: A method for automatic evaluation of machine translation. Proceedings of the 40th Annual Meeting on Association for Computational Linguistics. Philadelphia: Association for Computational Linguistics, 2002. 311–318.

|

| [33] |

Banerjee S, Lavie A. METEOR: An automatic metric for MT evaluation with improved correlation with human judgments. Proceedings of the ACL Workshop on Intrinsic and Extrinsic Evaluation Measures for Machine Translation and/or Summarization. Ann Arbor: Association for Computational Linguistics, 2005. 65–72.

|

| [34] |

Lin CY. ROUGE: A package for automatic evaluation of summaries. Proceedings of the Workshop on Text Summarization Branches Out. Barcelona: Association for Computational Linguistics, 2004. 74–81.

|

2023, Vol. 32

2023, Vol. 32