2. 中国科学院 沈阳计算技术研究所, 沈阳 110168;

3. 沈阳理工大学, 沈阳 110159

2. Shenyang Institute of Computing Technology, Chinese Academy of Sciences, Shenyang 110168, China;

3. Shenyang Ligong University, Shenyang 110159, China

知识图谱(knowledge graph, KG)将非结构化知识转化为清晰简洁的<头实体、关系、尾实体>三元组, 其中实体指的是现实世界中的唯一对象, 而关系则是描述连接这些对象的关系. 使用实体作为节点, KG中的三元组本质上是相互关联的, 从而组成了一个大的知识图谱, 以实现知识的快速响应. 目前KG已在多个领域构建和应用, 除了个性化推荐[1]、问答[2]和信息提取[3]外, 在不同行业也有广泛应用, 例如医疗、金融和信息等行业. 现有的大多数知识图谱都是由不同的机构根据不同的数据源和需求进行构建的, 因此, KG存在异构性, 即使是在同一领域, 同一实体也可能以不同的形式存在于不同的知识库中. 为了处理KG的异构性问题并融合不同知识库中的知识, 必须进行知识图谱对齐, 即在不同知识图谱中找到相同的现实世界对象的实体, 这称为实体对齐. 实体对齐提供了一种有效的方法, 通过链接等效实体, 将这些知识库中的知识融合到一个统一的KG中, 从而更高效地使用KG进行应用.

实体对齐的早期方法通常需要人工参与的特征构建过程[4]或依赖于他人构建的外部信息来克服KG之间的异质性, 例如机器翻译和外部词典[5]. 最近的研究提出了一些新的实体对齐方法来减少人工参与, 可以将不同KG的实体嵌入到统一的向量空间中实现实体对齐.

1 相关工作 1.1 KG嵌入知识图谱嵌入模型是实现知识图谱融合的重要方法之一, 是指将KG中的实体和关系嵌入到统一向量空间, 同时保留KG中的结构信息. 当前的KG嵌入模型主要分为翻译模型、语义匹配模型和神经模型. TransE[6]是一种典型的翻译模型, 其基本思想是如果三元组

神经模型利用深度学习技术进行KG嵌入, 图神经网络GNN最近已被用于各种自然语言处理任务, 例如分类任务、关系提取和机器翻译等. GNN在图结构上聚合信息, 主要通过递归聚合相邻节点的表示来学习目标节点的表示. GNN有许多变体, 包括图卷积网络(GCN)、图注意力网络(GAT)和关系图卷积网络(R-GCN). GCN能够提供强大的图结构建模能力, 而GAT对GCN采用了注意力机制, 其中每个节点根据其相邻节点获得一个注意力分数, 实现对相邻节点信息的聚合. R-GCN可以建模带有多种关系类型的图数据. 以上模型都关注关系结构, 可以对KG的结构信息进行编码.

1.2 实体对齐方法基于嵌入的实体对齐方法一般分为嵌入学习阶段和实体对齐阶段. 嵌入学习阶段使用知识表示学习方法来学习KG的实体嵌入, 实体对齐阶段通过计算实体嵌入的相似度实现实体对齐. IPTransE[8]和BootEA[9]使用半监督学习来克服实体对齐的“种子对齐”的稀疏性, 将迭代过程中新的实体对齐添加到训练数据集中以优化后续进程. MtransE[10]使用TransE模型来学习两个KG中实体的嵌入, 为每个实体向量表示计算出映射到其他嵌入空间中的变换.

基于图的模型是当前实体对齐的一种主流方法. GCN-Align[11]是一种基于图卷积网络的模型, 它利用图卷积网络GCN根据实体的相邻节点信息对其进行建模. RDGCN[12]结合门控机制和GCN网络将关系信息与相邻结构信息进行整合, 通过计算注意力权重来获取KG的复杂关系信息. MuGNN[13]利用基于注意力的GNN模型为相邻节点分配不同的权重, 通过多个通道对KG进行编码实现对齐. KECG[14]结合了图注意力网络和TransE模型来捕获图内结构和图间对齐信息, 通过生成联合训练模型来解决KG的结构异质性问题. AliNet[15]采用了注意力机制突出有用的远邻节点并减少噪音, 用门控机制与远距离邻域信息直接聚合, 以端到端的方式缓解邻域结构的异构问题. Dual-AMN[16]使用双重注意力匹配网络来捕获图内和跨图的双重关系信息, 同时引入归一化硬样本挖掘损失, 优化了基于嵌入方法的性能.

许多相关工作将KG中的其他信息与结构信息结合起来, 以提高实体对齐的性能. JAPE[17]将两个知识图的结构信息共同嵌入到一个统一的向量空间中, 利用属性相关性来进一步完善. KDCoE[18]使用协同训练方法, 利用实体描述作为补充来细化实体嵌入, 在KG结构信息和实体描述上迭代训练两个嵌入模型. AttrE[19]将属性三元组

在本文中, 知识图谱(KG)被表示为六元组有向图

本文采用基于属性嵌入与图注意力的实体对齐方法, 充分利用KG的结构信息和属性信息, 将实体嵌入到统一的向量空间中, 主要分为3个阶段, 分别是结构信息嵌入、属性信息嵌入和实体对齐预测. 首先, 模型利用引入注意力机制的GAT模型作为编码器来进行结构嵌入, 它能够通过忽略重要程度较低的相邻节点来减轻实体对齐过程中异构性产生的负面影响, 得到实体结构的全局特征; 同时, 设计一种属性信息编码器嵌入实体的属性信息, 从初始特征开始选择性地向目标实体聚合属性和属性值的特征; 最后, 在对齐阶段将结构嵌入和属性嵌入结合, 通过测量统一嵌入空间中实体之间的距离来进行对齐预测. 模型的整体框架如图1所示.

|

图 1 模型整体框架图 |

3.1 知识嵌入模块 3.1.1 结构嵌入

KG的结构信息为实体对齐提供了有力的帮助, 这表示具有相似相邻结构的实体对齐效果会更好. 给定两个知识图谱

| H(l+1)=ReLU(D(l)H(l)W(l)) | (1) |

其中,

| d(l)ij=Softmax(c(l)ij)=exp(c(l)ij)∑k∈Niexp(c(l)ik) | (2) |

其中,

| c(l)ij=σ(rT[W(l)h(l)i⊕W(l)h(l)j]) | (3) |

其中,

KG的结构信息为表示实体提供了有用的信息. 然而, 仅使用结构嵌入很难区分相似度高的实体, 尤其是仅具有细微差异的实体. 为了提高实体对齐的效果, 消除相似实体的歧义, 本文引入属性嵌入来改进基于结构嵌入的实体表示.

属性嵌入的目标是将实体属性信息嵌入到一个统一的向量空间中. 在传统方法中, 需要手动匹配属性, 然后比较相应属性的值以获得实体之间的相似性. 由于KG的数据特性, 目标对齐实体的属性之间可能存在较大差异, 从而误导GAT训练. 为了解决以上问题, 同时, 为了提高嵌入精度, 使属性嵌入更适合GAT训练, 本文设计了一种属性信息编码器, 可以从初始特征开始选择性地向目标实体聚合属性和属性值的特征.

首先使用前文提到的预训练词嵌入来进行属性信息嵌入, 得到实体e的属性特征序列

| s(l)e=ϕ(∑msk=1αkW1[ak;vk]) | (4) |

| θk=Softmax(qk)=exp(qk)∑msi=1exp(qi) | (5) |

| qk=σ(uT[s0e;ak]) | (6) |

其中,

实体对齐通过减少等效实体之间的距离, 将每个输入图的等效实体汇聚到一个统一的向量空间中. 给定两个知识图谱

| F(e1,e2)=τf(h(L)(e1),h(L)(e2))mh+(1−τ)f(s(L)(e1),s(L)(e2))ms | (7) |

| f(a,b)=∥a−b∥L1 | (8) |

其中,

在对齐阶段, 目标是将实体嵌入到相同的低维向量空间中, 其中等效实体彼此靠近. 为了使GAT能够在向量空间中尽可能近地嵌入等效实体, 使用负样本来训练模型, 正负样本中实体对之间的距离尽可能大, 通过最小化以下基于边际的排名损失函数来执行模型训练:

| L=∑(ei,ej)∈L∑(e′i,e′j)∈L′max{0,F(ei,ej)+γ−F(e′i,e′j)} | (9) |

其中,

参考最近研究[23, 24]与经典算法, 本文使用DBP15K数据集作为实验数据来评估模型. DBP15K数据集由文献[17]构建, 从包含不同语言版本之间丰富的语言间链接(ILL)的大型多语言知识库DBpedia生成, 包括3个子集DBP15KZH-EN、DBP15KJA-EN和DBP15KFR-EN. 每个子集包含15000个对齐的实体对, 采用两种语言版本的知识库. DBP15K数据集的信息如表1所示, 详细介绍了每个子集所包含的实体、关系及关系三元组、属性及属性三元组的数量.

| 表 1 DBP15K数据集 |

4.2 评价指标与参数设置

模型使用Hits@k和MRR (平均倒数排名)作为评估指标来评估模型和基准方法的性能, 这些指标在其他 KG对齐工作中被广泛使用. Hits@k衡量在前k个候选中排名正确的实体的比例, MRR是结果的倒数排名的平均值. 在本文中使用Hits@1、Hits@10、MRR作为评价指标, 更高的Hits@k和MRR意味着更好的性能.

对于参数设置, 两个GAT层都包含128个隐藏单元, 结构嵌入和属性嵌入的维度同样设置为128, 使用BERT模型对数据进行预训练词嵌入, 并进行最大池化操作得到一个固定长度的向量作为初始化的特征向量嵌入. 学习率设置为0.005, 损失函数中的阈值

本文将模型与最近提出的6种实体对齐基线模型进行比较, 并将其分为两类: 1)仅使用实体结构信息, MTransE、IPTransE以TransE为基础嵌入结构信息, RDGCN以GCN为基础引入注意力机制增强信息学习能力; 2)使用实体结构和属性信息, JAPE结合TransE和属性信息联合学习, GCN-Align用GCN作为基础模型结合属性信息, 结合属性结构的图卷积模型[25](以下简称Dual-GCN)使用加强的双重GCN联合属性嵌入. 对于所有比较的方法, 随机拆分30%的数据作为训练数据集, 剩余的作为测试数据. 实体对齐的结果如表2所示.

| 表 2 实体对齐结果对比 |

实验结果表明, 本文模型性能在3个数据集上的所有指标都明显优于基准方法. 与同使用实体结构和属性信息的JAPE、GCN-Align和Dual-GCN相比, 本文模型性能取得了明显的提高, 说明选用GAT模型优于KG嵌入模型和GCN模型. 基于嵌入的模型对实体的约束相对不足, 所以对齐结果较差. 基于GCN模型的方法, 对结构差异很敏感, 很难缩小对齐的差异. 因此本文模型使用GAT作为基础模型, 改善了基于图的方法的缺点, 有效减轻了异构KG的负面影响, 成功地提高了实体对齐的效果. 在仅使用结构信息的方法MTransE、IPTransE和RDGCN中, RDGCN的各项指标是最高的, 与RDGCN相比, 本文模型在指标Hits@1、Hits@10、MRR分别提升了6%、5%、10%, 说明引入属性信息对实体对齐同样重要.

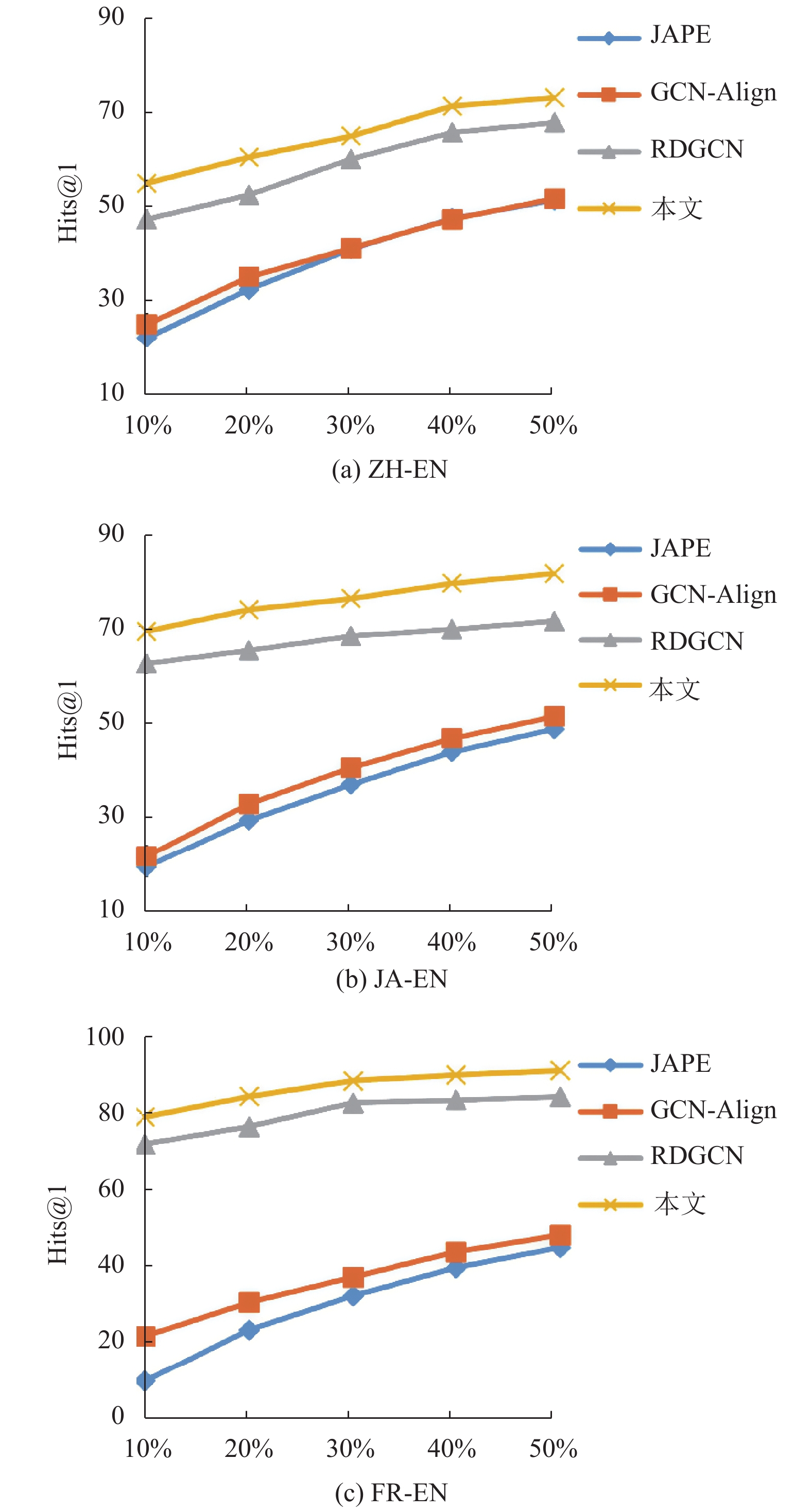

4.3.2 对齐种子敏感度实验在本文中, 将模型与JAPE、GCN-Align、RDGCN进行比较, 将预对齐实体对的比例从10%开始, 以10%的步长增加到50%, 并将其余的对齐种子作为测试集.

实验结果如图2所示, 随着对齐种子比例的增加, 所有模型的性能在所有数据集上持续增加. 从图2可以看出, 本文所使用的模型始终以显著的优势优于基准方法, 说明了模型的稳健性.

|

图 2 不同比例种子集对齐敏感度对比结果 (横坐标为对齐种子的比例) |

5 结论

本文提出了一种基于图注意力网络和属性嵌入的方法. 模型使用图注意力网络GAT对知识图谱进行编码, 引入注意力机制从实体应用到属性, 通过忽略一些重要程度较低的邻近节点来减轻对齐过程中异质性的负面影响, 同时设计一种属性信息编码器利用实体的属性信息, 在对齐阶段将结构嵌入和属性嵌入进行结合, 实现了实体对齐效果的提升. 模型在3个真实的数据集上进行评估, 结果显示所提出的方法优于其他6个基准方法. 本文工作只使用了属性信息, 还有一些额外信息如实体名称、关系路径等信息没有被充分利用. 在未来的工作中将研究如何通过这些辅助信息来进一步提高实体对齐的准确性.

| [1] |

Wang X, Wang DX, Xu CR, et al. Explainable reasoning over knowledge graphs for recommendation. Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33(1): 5329–5336.

|

| [2] |

Wang GY, Zhang W, Wang RX, et al. Label-free distant supervision for relation extraction via knowledge graph embedding. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: Association for Computational Linguistics, 2018. 2246–2255.

|

| [3] |

Zhang YY, Dai HJ, Kozareva Z, et al. Variational reasoning for question answering with knowledge graph. Proceedings of the 32nd AAAI Conference on Artificial Intelligence and 30th Innovative Applications of Artificial Intelligence Conference and 8th AAAI Symposium on Educational Advances in Artificial Intelligence. New Orleans: AAAI Press, 2018. 745.

|

| [4] |

Mahdisoltani F, Biega J, Suchanek FM. YAGO3: A knowledge base from multilingual Wikipedias. Proceedings of the 7th Biennial Conference on Innovative Data Systems Research. Asilomar: CIDR Conference, 2015. 1–11.

|

| [5] |

Wang ZC, Li JZ, Tang J. Boosting cross-lingual knowledge linking via concept annotation. Proceedings of the 23rd International Joint Conference on Artificial Intelligence. Beijing: AAAI Press, 2013. 2733–2739.

|

| [6] |

Bordes A, Usunier N, Garcia-Durán A, et al. Translating embeddings for modeling multi-relational data. Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe: Curran Associates Inc., 2013. 2787–2795.

|

| [7] |

Nickel M, Rosasco L, Poggio T. Holographic embeddings of knowledge graphs. Proceedings of the AAAI Conference on Artificial Intelligence, 2016, 30(1): 1955-1961. |

| [8] |

Zhu H, Xie RB, Liu ZY, et al. Iterative entity alignment via joint knowledge embeddings. Proceedings of the 26th International Joint Conference on Artificial Intelligence (IJCAI). Melbourne: AAAI Press, 2017. 4258–4264.

|

| [9] |

Sun ZQ, Hu W, Zhang QH, et al. Bootstrapping entity alignment with knowledge graph embedding. Proceedings of the 27th International Joint Conference on Artificial Intelligence. Stockholm: AAAI Press, 2018. 4396–4402.

|

| [10] |

Chen MH, Tian YT, Yang MH, et al. Multilingual knowledge graph embeddings for cross-lingual knowledge alignment. Proceedings of the 26th International Joint Conference on Artificial Intelligence. Melbourne: AAAI Press, 2017. 1511–1517.

|

| [11] |

Wang ZC, Lv QS, Lan XH, et al. Cross-lingual knowledge graph alignment via graph convolutional networks. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: Association for Computational Linguistics, 2018. 349–357.

|

| [12] |

Wu YT, Liu X, Feng YS, et al. Relation-aware entity alignment for heterogeneous knowledge graphs. Proceedings of the 28th International Joint Conference on Artificial Intelligence. Macao: IJCAI, 2019. 5278–5284.

|

| [13] |

Cao YX, Liu ZY, Li CJ, et al. Multi-channel graph neural network for entity alignment. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 1452–1461.

|

| [14] |

Li CJ, Cao YX, Hou L, et al. Semi-supervised entity alignment via joint knowledge embedding model and cross-graph model. Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Hong Kong: Association for Computational Linguistics, 2019. 2723–2732.

|

| [15] |

Sun ZQ, Wang CM, Hu W, et al. Knowledge graph alignment network with gated multi-hop neighborhood aggregation. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(1): 222-229. DOI:10.1609/aaai.v34i01.5354 |

| [16] |

Mao X, Wang WT, Wu YB, et al. Boosting the speed of entity alignment 10×: Dual attention matching network with normalized hard sample mining. Proceedings of the Web Conference 2021. Ljubljana: Association for Computing Machinery, 2021. 821–832.

|

| [17] |

Sun ZQ, Hu W, Li CK. Cross-lingual entity alignment via joint attribute-preserving embedding. Proceedings of the 16th International Semantic Web Conference. Vienna: Springer, 2017. 628–644.

|

| [18] |

Chen MH, Tian YT, Chang KW, et al. Co-training embeddings of knowledge graphs and entity descriptions for cross-lingual entity alignment. Proceedings of the 27th International Joint Conference on Artificial Intelligence. Stockholm: AAAI Press, 2018. 3998–4004.

|

| [19] |

Trisedya BD, Qi JZ, Zhang R. Entity alignment between knowledge graphs using attribute embeddings. Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33(1): 297-304. |

| [20] |

Zhang QH, Sun ZQ, Hu W, et al. Multi-view knowledge graph embedding for entity alignment. Proceedings of the 28th International Joint Conference on Artificial Intelligence. Macao: IJCAI, 2019. 5429–5435.

|

| [21] |

车超, 刘迪. 基于双向对齐与属性信息的跨语言实体对齐. 计算机工程, 2022, 48(3): 74-80. DOI:10.19678/j.issn.1000-3428.0060540 |

| [22] |

Wu YT, Liu X, Feng YS, et al. Neighborhood matching network for entity alignment. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Association for Computational Linguistics, 2020. 6477–6487.

|

| [23] |

赵丹, 张俊. 基于双重注意力和关系语义建模的实体对齐方法. 计算机应用研究, 2022, 39(1): 64-69, 79. DOI:10.19734/j.issn.1001-3695.2021.04.0169 |

| [24] |

Yu DH, Yang YM, Zhang RH, et al. Knowledge embedding based graph convolutional network. Proceedings of the 2021 Web Conference. Ljubljana: Association for Computing Machinery, 2021. 1619–1628.

|

| [25] |

田江伟, 李俊锋, 柳青. 结合属性结构的图卷积实体对齐算法. 计算机应用研究, 2021, 38(7): 1979-1982, 1992. DOI:10.19734/j.issn.1001-3695.2020.10.0366 |

2023, Vol. 32

2023, Vol. 32