随着卫星技术的发展, 卫星视频中的目标跟踪成为新的研究领域. 而与普通视频相比, 卫星视频中的目标相对于背景只占少量像素, 这会使卫星视频中的目标跟踪更容易产生漂移现象.

目标跟踪分为基于相关滤波和基于深度学习的方法. 基于相关滤波的方法依赖手工特征通过相关计算进行目标的位置预测, 常见的相关滤波算法有MOSSE[1]、CSK[2]、KCF[3]、CN[4]等. 基于深度学习的孪生网络跟踪方法通过提取深度特征在精度和速度之间达到了平衡, 这种方法简单高效, 受到广泛学者的关注. Bertinetto等[5]提出SiamFC算法, 该算法使用相同的网络结构提取模板和搜索区域的特征, 然后利用相关计算得到目标位置. Li等[6]在SiamFC的基础上加入区域候选网络, 提出了SiamRPN算法, 有效解决了目标尺度变化问题. Li等[7]在SiamRPN的基础上引入残差网络和通道互相关策略, 提出了SiamRPN++算法. Guo等[8]在SiamRPN++的基础上将分类和回归并行计算, 提出了SiamCAR算法, 实现无先验框跟踪, 避免了很多先验框超参数的设置. Shi等[9]在SiamFC的基础上增添一个新分支提出了TripFC算法.

这些方法主要针对传统视频的目标跟踪进行的改进, 但在卫星视频跟踪中还需要根据目标特征不明显的特点进行优化. Shao等[10]在孪生网络中加入目标的像素级运动特征保证目标更精确的定位. Zhang等[11]利用全卷积网络预测像素位置提高跟踪精度. Wu等[12]引入慢特征和运动特征提高目标跟踪性能. Ruan等[13]通过拟合目标运动轨迹缓解模型漂移问题. Song等[14]在孪生网络中加入通道、空间和交叉注意力机制, 实现更精确的目标定位.

与上述算法不同, 本文以无锚框SiamCAR算法为基本框架, 将通道注意力模块和运动激励模块结合, 更多的关注得分较高的通道和运动位置, 并且添加相邻帧分支和卡尔曼预测分支形成四重网络, 提高算法在卫星视频中的目标跟踪能力. 我们的算法仅需额外训练注意力机制模块, 增添的相邻帧和卡尔曼预测模块不需要训练, 可以直接使用.

1 相关理论SiamCAR将跟踪问题分解成分类和回归两个子问题, 以像素的方式进行求解. 该框架主要包括: 一个用于特征提取的骨干网络和一个用于边界框预测的分类回归子网.

1.1 特征提取特征提取子网采用改进的ResNet-50网络[15], 如图1, ResNet-50网络包含49个卷积层、1个全连接层, 第1部分结构主要对输入进行卷积、正则化、激活函数和最大池化计算, 第2–5部分结构中都增添了残差块, 解决了原CNN网络过深时准确率下降的问题.

改进的ResNet-50将后3层的特征进行拼接分别得到template patch的特征图

| R=φ(Z)⋆φ(X) | (1) |

其中,

|

图 1 ResNet-50网络结构 |

1.2 边界框预测

将特征提取阶段得到的

| ˜l=x−x0 | (2) |

| ˜t=y−y0 | (3) |

| ˜r=x1−x | (4) |

| ˜b=y1−y | (5) |

| C(i,j)=I(˜ti,j)∗√min(˜l,˜r)max(˜l,˜r)×min(˜t,˜b)max(˜t,˜b) | (6) |

对于每个位置都会生成对应的6维向量

| q=argmaxi,j{(1−λd)clsij×pij+λdHij} | (7) |

其中, H是余弦窗,

将SiamCAR算法作为基本框架, 首先在特征提取模块中加入运动激励模块(ME)和改进的高效通道注意力(ECA)模块; 然后加入相邻帧模板和卡尔曼预测模板补充对象模板以形成四重网络结构.

2.1 特征提取模块特征提取模块以改进的ResNet-50为基础, 在骨干网络的残差单元加入了运动激励模块和改进的高效通道注意力模块, 改进的残差单元结构如图2所示.

|

图 2 改进的残差单元结构 |

2.1.1 运动激励模块

运动激励模块[16]将短距离运动建模与整个时空特征学习方法相结合, 激发特征的运动敏感通道, 以解决卫星视频中前景背景对比性低的问题. 首先输入形状为[N, T, C, H, W]的时空特征X, 其中N是批量大小, T和C分别表示时间维度和特征通道, H和W表示形状. 将输入特征X经过1×1的2D卷积得到信道压缩特征

| M(t)=convtrans∗Xr(t+1)−Xr(t),1⩽t⩽T−1 | (8) |

其中, convtrans是一个3×3的 2D通道卷积层.

接着, 连接所有运动特征得到最终运动矩阵M, 使用全局平均池层来总结空间信息得到

| A=2Sigmoid(convexp∗Ms)−1,A∈RN×T×C×1×1 | (9) |

最后, 将输入特征X与注意力权重A进行通道乘法, 得到了激励运动敏感通道和抑制静态背景信息的特征, 计算公式如下:

| Xo=X+X⊗A,Xo∈RN×T×C×H×W | (10) |

其中,

高效通道注意力模块[17]是在SE-Net通道注意力基础上采用无降维的局部跨通道交互策略的一种注意力机制, 该模块涉及少量参数, 通过增强有用信息的通道, 抑制信息较少的通道, 带来明显的性能增益. 卫星视频中目标相对于背景只占少量像素, 原ECA模块利用通道的全局平均值计算, 会带来很多与目标无关的背景信息, 因此本文加入全局最大值计算, 将全局平均值和全局最大值得到两个空间信息进行叠加优化成更好的通道注意力模块, 如图3所示.

首先将大小为

| k=|log2Cγ+bγ|odd | (11) |

其中, C为通道数,

最后, 使用Sigmoid函数将得到的结果转换成0–1之间的数值, 作为权值与输入的特征对应相乘, 得到带有通道注意力的特征图.

|

图 3 改进的ECA模块 |

2.2 四重网络模型构建

SiamCAR使用初始帧作为对象模板, 在跟踪过程中, 通常会面临着遮挡、光照等影响, 此时初始帧模板中包含的信息不足以支持后续帧的跟踪. 为了提高跟踪器的性能, 我们加入了相邻帧模板和卡尔曼预测模板, 用来补充对象模板以形成四重网络, 如图4所示.

|

图 4 改进算法的网络框架 |

2.2.1 加入相邻帧模板

SiamCAR算法仅利用首帧模板进行目标跟踪, 当目标在后续跟踪中受到干扰时会导致模板信息不准确, 于是在SiamCAR的基础上添加一个相邻帧模板, 将初始帧和相邻帧的信息结合以增强模板特征的表达能力. 分别将初始帧模板和相邻帧模板与搜索区域进行深度互相关计算, 计算公式如下:

| R1=φ(Z1)⋆φ(X) | (12) |

| R2=φ(Z2)⋆φ(X) | (13) |

其中,

| Acls=φcls(R1)+φcls(R2) | (14) |

| Acen=φcen(R1)+φcen(R2) | (15) |

| Areg=φreg(R1) | (16) |

| Pscore1=Acls×Acen | (17) |

由于卫星视频中目标相对于背景较小, 特征信息不明显, 于是在SiamCAR的基础上增添一个卡尔曼[18]预测的模板分支, 对目标的运动轨迹进行预测, 将预测的目标位置与跟踪算法得到的目标位置进行最优值计算, 减少目标漂移问题, 提高目标的跟踪性能. 卡尔曼滤波器系统的状态方程和观测方程分别为:

| xt=At−1xt−1+wt−1 | (18) |

| zt=Htxt+vt | (19) |

其中,

然后利用上一时刻运动状态预测此时刻的状态变量值, 如式(20)所示:

| ˆx−t=Atˆxt−1 | (20) |

利用上一时刻误差协方差值预测此时刻的误差协方差值, 如式(21)所示:

| P−t=At−1Pt−1ATt−1+Qt−1 | (21) |

使用卡尔曼增益系数作为权重, 如式(22)所示:

| Kt=P−tHT(HP−tHT+Rt)−1 | (22) |

然后取状态变量预测值与观测值的加权和作为最终状态变量, 如式(23)所示:

| ˆxt=ˆx−t+Kt(zt−Hkˆx−t) | (23) |

误差协方差值更新, 如式(24)所示:

| Pt=P−t−KtHtP−t | (24) |

利用卡尔曼滤波预测的模板与搜索区域进行深度互相关计算, 计算公式如下:

| R3=φ(Z3)⋆φ(X) | (25) |

| A∗cls=φcls(R3) | (26) |

| A∗cen=φcen(R3) | (27) |

| Pscore2=A∗cls×A∗cen | (28) |

根据前两个阶段分别得到的响应图

| Pscore=max(Pscore1,Pscore2) | (29) |

| q=argmax(Pscore) | (30) |

本文实验所使用的环境配置为Windows 11、CUDA 11.6. 硬件配置为Intel-CPU-i5-11260H处理器, 显卡为Nvidia GeForce RTX 3050Ti. 本文选取SatSOT卫星视频数据集[19]里的10组数据作为本文实验的测试序列, SatSOT是第1个密集注释的卫星视频目标跟踪数据集, 覆盖了卫星视频中特定的移动目标类别, 包括汽车、火车、飞机和船舶. 为了验证本文算法的鲁棒性和有效性, 采取成功率和准确率作为跟踪评价标准, 将SiamCAR算法与本文算法进行对比.

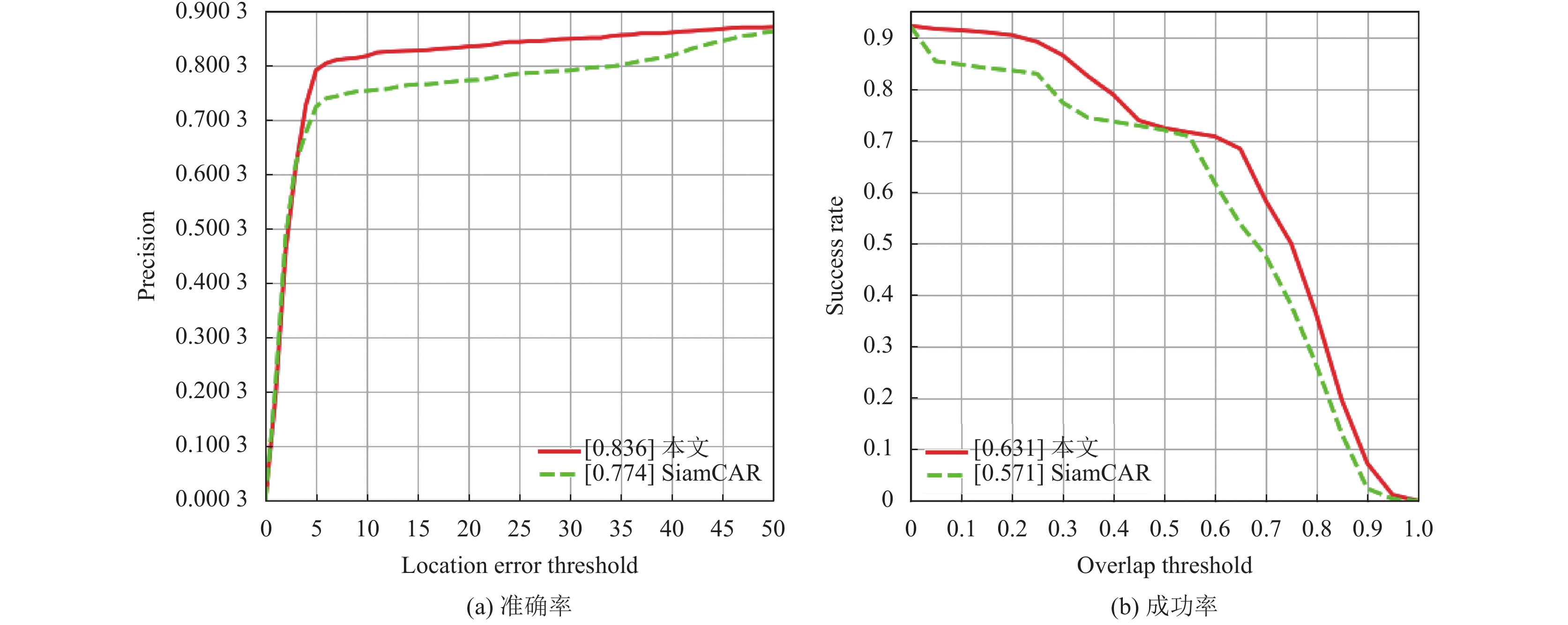

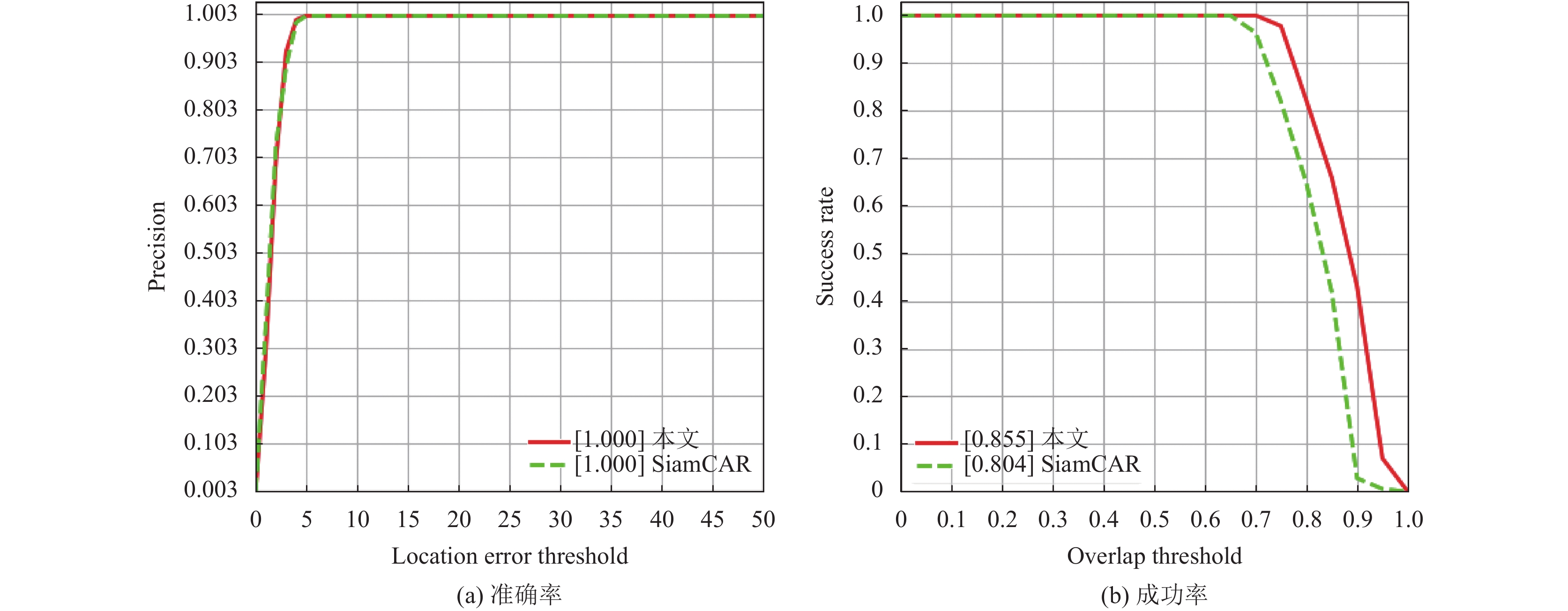

3.2 算法结果比较分析 3.2.1 定量分析为了验证算法的跟踪性能, 在选取的10组数据集上测试了SiamCAR算法和本文算法. 表1为实验所得数据. 本文算法在10组数据集的准确率和成功率相比SiamCAR算法分别提高了6%和6.2%; 本文算法在plane_02序列中的准确率和成功率相比SiamCAR算法分别提高了0和45.1%; 本文算法在ship_01序列中的准确率和成功率相比SiamCAR算法分别提高了57.2%和5.1%; 本文算法在train_03序列中的准确率和成功率相比SiamCAR算法分别提高了3.3%和7.5%. 分别如图5–图8所示.

| 表 1 在SatSOT数据集上两种算法对比 |

3.2.2 定性分析

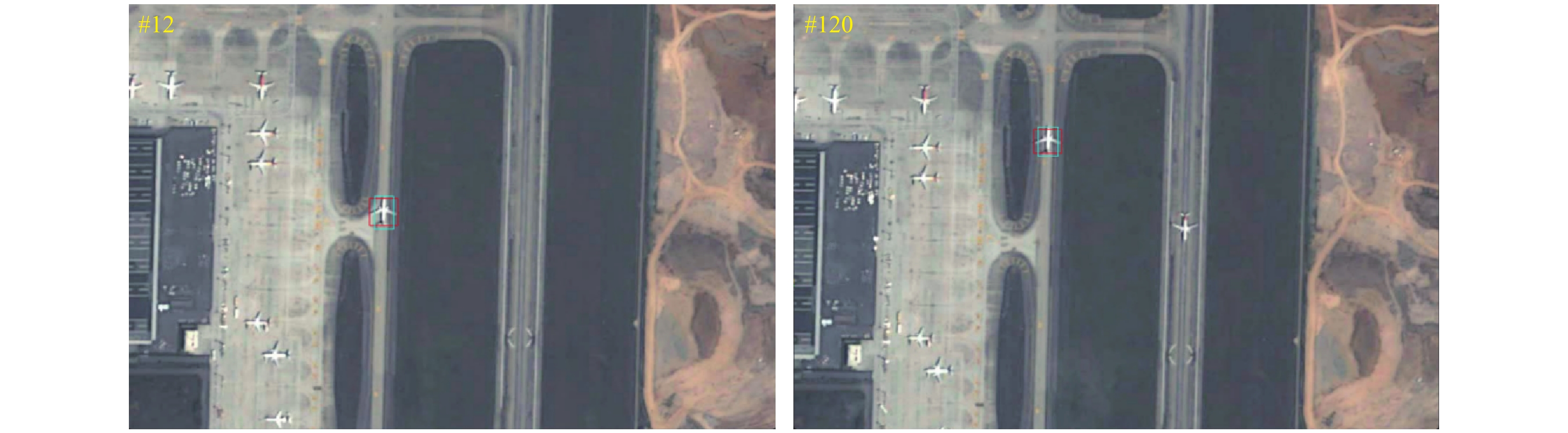

为了更直观评估算法的跟踪性能, 将本文算法与SiamCAR算法分别在plane_04、ship_01和train_03视频序列上进行了对比实验, 如图9–图11所示. 其中红色框代表本文算法跟踪结果、蓝色框代表SiamCAR算法跟踪结果. 图9–图11表明, 在卫星视频目标跟踪中, 本文算法相比于SiamCAR算法可以更贴合目标的尺寸, 更好的跟踪目标.

|

图 5 SatSOT中10组数据集算法准确率和成功率对比图 |

|

图 6 plane_02序列中算法准确率和成功率对比图 |

|

图 7 ship_01序列中算法准确率和成功率对比图 |

|

图 8 train_03序列中算法准确率和成功率对比图 |

|

图 9 两种算法在plane_04序列中的跟踪结果 |

|

图 10 两种算法在ship_01序列中的跟踪结果 |

|

图 11 两种算法在train_03序列中的跟踪结果 |

4 结论

本文主要介绍了改进后的卫星视频目标跟踪算法网络, 针对卫星视频中存在的目标特征信息不明显、目标与背景对比性低等问题, 将运动激励模块和改进的高效通道注意力模块加入到骨干网络的残差单元, 激励目标的运动敏感通道和有用信息通道, 增强目标的特征提取信息; 并增加了相邻帧模板和卡尔曼预测帧模板与首帧模板和搜索区域形成四重网络结构, 补充目标的运动信息和外观信息. 实验表明, 改进后的算法网络有效地提高了目标跟踪的准确率和成功率.

| [1] |

Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters. Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco: IEEE, 2010. 2544–2550.

|

| [2] |

Henriques JF, Caseiro R, Martins P, et al. Exploiting the circulant structure of tracking-by-detection with kernels. Proceedings of the 12th European Conference on Computer Vision. Florence: Springer, 2012. 702–715.

|

| [3] |

Henriques JF, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 |

| [4] |

Danelljan M, Khan FS, Felsberg M, et al. Adaptive color attributes for real-time visual tracking. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 1090–1097.

|

| [5] |

Bertinetto L, Valmadre J, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking. Proceedings of the European Conference on Computer Vision. Amsterdam: Springer, 2016. 850–865.

|

| [6] |

Li B, Yan JJ, Wu W, et al. High performance visual tracking with Siamese region proposal network. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8971–8980.

|

| [7] |

Li B, Wu W, Wang Q, et al. SiamRPN++: Evolution of Siamese visual tracking with very deep networks. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 16–20.

|

| [8] |

Guo DY, Wang J, Cui Y, et al. SiamCAR: Siamese fully convolutional classification and regression for visual tracking. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6269–6277.

|

| [9] |

Shi T, Wang DH, Ren HG. Triplet network template for Siamese trackers. IEEE Access, 2021, 9: 44426-44435. DOI:10.1109/ACCESS.2021.3066294 |

| [10] |

Shao J, Du B, Wu C, et al. HRSiam: High-resolution Siamese network, towards space-borne satellite video tracking. IEEE Transactions on Image Processing, 2021, 30: 3056-3068. DOI:10.1109/TIP.2020.3045634 |

| [11] |

Zhang WH, Jiao LC, Liu F, et al. MBLT: Learning motion and background for vehicle tracking in satellite videos. IEEE Transactions on Geoscience and Remote Sensing, 2021, 60: 4703315. DOI:10.1109/TGRS.2021.3109028 |

| [12] |

Wu JL, Su X, Yuan QQ, et al. Multivehicle object tracking in satellite video enhanced by slow features and motion features. IEEE Transactions on Geoscience and Remote Sensing, 2021, 60: 5616426. DOI:10.1109/TGRS.2021.3139121 |

| [13] |

Ruan L, Guo YJ, Yang DQ, et al. Deep Siamese network with motion fitting for object tracking in satellite videos. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 6508005. DOI:10.1109/LGRS.2022.3158652 |

| [14] |

Song W, Jiao LC, Liu F, et al. A joint Siamese attention-aware network for vehicle object tracking in satellite videos. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5625617. DOI:10.1109/TGRS.2022.3184755 |

| [15] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [16] |

Li Y, Ji B, Shi XT, et al. TEA: Temporal excitation and aggregation for action recognition. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 909–918.

|

| [17] |

Wang QL, Wu BG, Zhu PF, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 11531–11539.

|

| [18] |

Kalman RE. A new approach to linear filtering and prediction problems. Journal of Fluids Engineering, 1960, 82(1): 35-45. |

| [19] |

Zhao MQ, Li SY, Xuan SY, et al. SatSOT: A benchmark dataset for satellite video single object tracking. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5617611. DOI:10.1109/TGRS.2022.3140809 |

2023, Vol. 32

2023, Vol. 32