虹膜是位于黑色瞳孔和白色巩膜之间的圆环状部分, 这个圆环部分里面包含了许多相互交错的细节特征, 而在生物特征中, 虹膜的这些细节特征并不会随着年龄的增长而发生任何改变, 因此虹膜可以作为识别生物身份的一种方法. 虹膜特征也因其独特性、稳定性以及不可更改性在国防和安全方面均发挥着十分重要的作用[1, 2]. 虹膜识别因此也被认为是21世纪最有前途的生物识别技术[3], 被广泛应用于各种生物特征识别应用, 包括智能解锁[4]、边境控制[5]、取证等. 一个完整的虹膜识别系统流程通常包括以下4个步骤: 虹膜图像采集、虹膜预处理、特征提取和匹配[6]. 作为虹膜预处理的一部分, 虹膜分割定义了用于特征提取和匹配的图像区域, 因此直接影响虹膜整体识别性能[7]. 由此可见虹膜分割在虹膜识别中占有重要意义, 分割算法的鲁棒性和准确性直接决定了后续虹膜特征提取、验证和识别[8].

近年来, 基于深度学习的图像处理研究越来越深入, 取得的成就也非常可观. 相较于传统的虹膜分割方法, 基于深度学习的虹膜分割方法更加具有鲁棒性和识别性. 2015年, Long等人提出全卷积神经网络(fully convolutional network, FCN)[9] 开创了语义级别的图像分割先河, 随后各种语义分割网络如雨后春笋, 纷纷涌现. 如UNet[10]、SegNet[11]、PsPNet[12]以及DeepLab系列. 其中DeepLab系列作为语义分割的经典模型, 取得了非常不错的分割成果. DeepLabv1[13]针对池化降低分辨率问题, 提出了空洞卷积来扩展视野, 以便获取更多的上下文信息. DeepLabv2[14]主要贡献在于提出了空洞空间金字塔池化(atrous spatial pyramid pooling, ASPP), 其使用不同采样率的空洞卷积并行采样生成多尺度特征图, 用于处理尺度可变性问题. DeepLabv3[15] 基于图像层次将全局背景进行编码得到图像级特征, 增强了ASPP, 进一步提升了分割精度. 2017年Transformer横空出世, 随着Transformer在自然语言领域的应用和普及, 其也逐渐被应用到计算机视觉领域中. Valanarasu等人[16]提出的MedT基于Transformer的编码器架构来分割医学图像, 取得了很好的性能. 最早将深度学习方法应用到虹膜分割领域是Jalilian等人[17]提出的全卷积编码解码网络(FCEDNs), 实验表明FCEDMNs的分割结果优于传统的算法. Lian等人[18]提出了ATT-UNet, 将UNet与注意力结合, 取得了不错的分割效果. Wang等人[19]基于转移学习提出一种新的训练方法, 该方法是以ResNet34为骨干的经典UNet架构, 采用两个基于UNet的独立模型来执行虹膜的分割和定位任务, 提高了模型的泛化能力. 最终获得了NIR-ISL 2021虹膜比赛的冠军. 由于语义分割只根据不同语义像素进行分割, 不能区分不同实体, 因此出现了实例分割, 即在检测到目标以后再对其进行分割. He等人[20]提出的Mask R-CNN在Faster R-CNN[21]的基础上增加了一个分支用于语义分割, 即对检测到的目标框进行目标分割. 从而实现实例分割并且通过大量实验证明该网络模型达到了较高的分割精度. 上述基于深度学习的分割算法网络被广泛应用于图像分割领域, 在虹膜分割任务中也取得了不错的成果. 但是对于存在各种噪声因素的困难样本分割效果不是很好, 存在分割边缘不够圆滑、漏分、错分等情况.

针对这一问题, 本文提出了基于Mask R-CNN神经网络的Mask-INet模型. 该模型以Mask R-CNN为基本框架, 结合了特征金字塔和混合注意力机制. Mask R-CNN网络在语义分割的基础上对同类的物体能够进行更加精细的分割, 能进一步减少虹膜错分的情况. 我们利用特征金字塔高层特征进行上采样与底层特征自下而上的连接结构来提取虹膜图像特征. 特征金字塔这种连接结构融合了低分辨率语义信息较强的特征图和高分辨率语义信息较弱但空间信息丰富的特征图, 加深了对虹膜特征信息的挖掘. 特征金字塔在提取虹膜特征信息过程中虽然容易获取高层语义信息但是对于底层的定位信息却难以获取, 会导致检测精度不高. 为了提升虹膜最终的分割精度, 给特征金字塔添加了一条自下而上的路径, 这条路径不仅充分利用高层语义信息同时也充分利用了底层定位信息来挖掘虹膜特征, 极大提高了检测精度. 为了进一步挖掘虹膜特征, 我们在掩模预测分支引入两个上采样层将虹膜特征图的空间分辨率放大4倍. 再将注意力机制引入改进的掩模预测分支中, 注意机制能加强虹膜特征区域的权重信息, 抑制无关信息对模型的打扰, 能有效提升模型的分割精度和灵敏度.

2 准备工作 2.1 残差网络卷积神经网络是目前计算机视觉领域中主要的特征提取技术[22]. 传统的卷积神经网络在信息传递过程中总是存在着信息丢失、梯度消失或梯度爆炸的问题, 因此不能训练很深的网络. 理论上, 越深的网络输入表示能力越强的特征, 但随着网络的加深, 参数量和计算力也会增加, 从而影响网络的训练效果造成网络退化. He等人[22]提出的残差网络很好地解决了这个问题. 残差网络由一个个残差单元模块叠加组成, 一个残差单元的输入与输出可以用式(1)表示:

| $ \left\{\begin{array}{l}{y}_{l}{=}h{(}{x}_{l}{)+}F{(}{x}_{l}, {W}_{l}{)}\\ {x}_{l+1}=f{(}{y}_{l}{)}\end{array} \right.$ | (1) |

其中, xl和xl+1分别代表当前这个残差单元的信号输入和输出, l代表层, h(xl)代表当前残差单元的恒等映射即identity mapping, F(·)是残差部分, 一般由2个或者3个卷积操作构成, Wl表示为该部分卷积的权重, f(·)为ReLU激活函数.

残差单元的残差式跳跃结构打破了传统n−1层的输出只能传给n层的惯例, 使得随意某层的输出可以跳跃多层作为后层的输入, 这样做的好处在于虽然增加了网络结构的深度但网络并未退化且训练效果非常好, 为以后在模型叠加上提供了新的方向.

2.2 特征金字塔识别不同尺寸的目标是计算机视觉的一个基本挑战[23]. 在目标检测任务中, 许多网络如YOLO1[24], 利用卷积层提取特征, 经过多个池化层输出小尺度的特征图, 利用这个单个特征图进行后续的分类和边界框的回归, 但是对于目标大小不同的物体来说存在一定的缺陷. 因此文献[23]提出了特征金字塔网络.

传统的特征提取使用人工, 在图像金字塔上构建特征金字塔(简称特征化图像金字塔)[25], 其任务是提取不同尺度图片的特征. 但是这样做增加计算量的同时还会消耗大量内存. 随后人们使用深度卷积网络(ConvNets)提取特征, 其做法是直接取高层语义特征进行预测, 但是由于感受野的问题, 对于小特征的物体可能存在检测不到的情况. 为了改善上述问题, SSD[26]提出输出不同尺度的特征图预测. 但底层特征图的语义信息薄弱导致出现虽然框选出小物体但很容易将小物体错分类的情况. 针对上述3种问题, FPN提出基于自底向上提取各层语义特征, 进行自顶向下的连接中融合自底向上的特征图, 再输出各个尺度特征图的预测.

FPN的结构图如图1所示, 自底向上的过程中利用ResNet每级最后一个残差块的输出作为预测特征的输入, 其分别对应输入图片的下采样倍数为{4, 8, 16, 32}. 自顶向下的过程中通过上采样的方式将顶层的小特征图放大到同上一个stage的特征图尺度相同, 再同经过1×1卷积的残差块最后一层的特征图作逐元素相加操作.

|

图 1 特征金字塔结构 |

2.3 CBAM

近年来, 为了提升网络的性能, 研究人员不仅将研究重心放在了如何利用网络的宽度、深度和基数这几个因素来提升网络的性能. 同时对注意力的研究也不断加深. Google mind团队在文献[27]中将注意力机制引入RNN模型中进行图像分类, 注意力才正式进入计算机视觉领域.

在掩模预测分支进行特征提取时, 一些分布在特征图某些通道中的无效信息会被保留下来影响虹膜的分割精度. 因此, 我们引入CBAM强调所需分割的目标. 相较于SE-Net[28]只关注通道的注意力机制而言, CBAM结合了空间注意力机制和通道注意力机制[29], 不仅考虑到不同通道像素的重要性, 还考虑到同一通道的不同位置的像素重要性. CBAM是基于注意力机制的轻量级通用模型, 能融入到各种常规的卷积层中.

对上采样后的特征图, CBAM从通道和空间两个维度计算该特征图的注意力图, 增强对目标物体的识别. 结构如图2所示, CBAM由通道注意力机制和空间注意力机制串行组成, 通道子模块在共享网络中分别使用最大池化和平均池化聚合特征图的空间信息, 生成两个不同上下文的描述符, 对得到的两个特征做相加和Sigmoid处理得到通道注意力图Mc. 空间子模块利用沿通道轴汇聚的相似的两个输出, 并将它们转发到卷积层, 再做Sigmoid处理得到空间注意力图Ms. CBAM将得到的Mc同输入的feature按元组进行乘法操作再经过空间注意力机制得到Ms与通道注意力机制得到的特征同样按元素进行乘法操作. 可用如下公式表示:

| $ {F}'={M}_{c}(F)\otimes F $ | (2) |

| $ {F}''={M}_{s}({F'})\otimes {F'} $ | (3) |

其中, F表示输入特征, Mc(F)表示经过通道注意力机制所获取的特征.

|

图 2 CBAM网络结构 |

3 Mask-INet算法

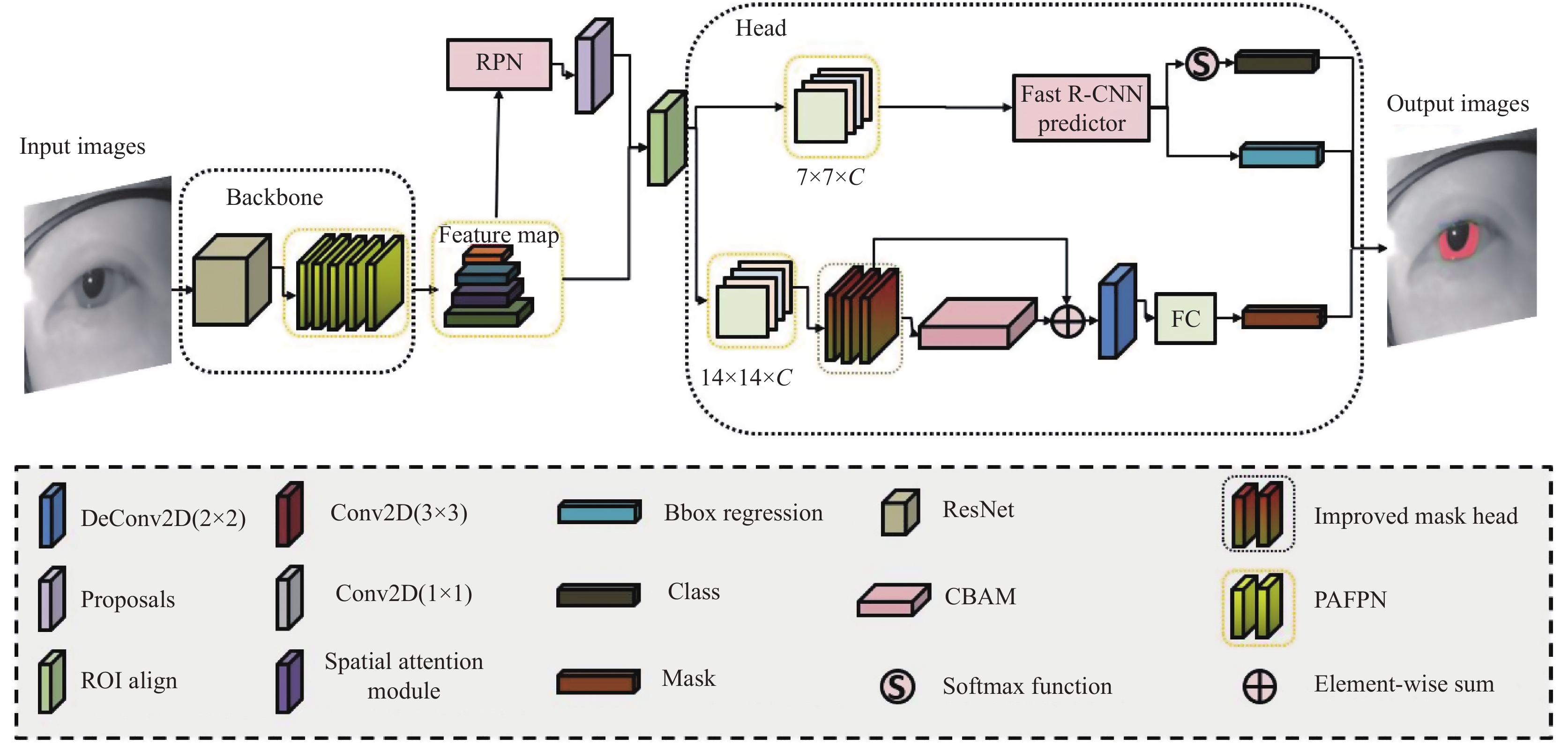

本文使用ImageNet[30]预训练的残差网络作为主干网络, 结合改进后的特征金字塔, 在掩模预测阶段利用上采样层来增大特征图的空间分辨率, 进一步挖掘虹膜特征的空间信息. 随后引入第2.3节介绍的CBAM机制激励重要特征信息, 抑制无用信息. 再同未经过CBAM网络的特征图进行逐元素相加, 从而提升虹膜的分割精度. Mask-INet是一种端到端的网络, 以处理成coco格式的虹膜图像为输入, 经多次训练后输出虹膜的掩码和定位. 该网络总体结构如图3所示.

Mask-INet模型使用残差结构有效避免了因网络加深而造成的模型退化问题. 同FPN[[23]相比, 改进后的FPN不仅保留了FPN模块融合后浅层高分辨率的特征如高层的语义信息和底层的边缘信息同时也充分利用了底层的边缘信息来获取定位信息, 使得每层特征既具有高层语义信息又具有底层的定位信息. 由于本文数据属于红外图像, 而在红外图像中, 背景和目标的对比度较低, 不同实例的辨别主要依靠轮廓特征信息, 因此在掩模预测分支中添加注意力机制来提升对有效特征提取的能力.

3.1 PA-FPN在Mask R-CNN中引入特征金字塔网络结构能较好地检测不同尺度的物体, 但是在实验过程中仍存在检测精度较差的情况, 容易造成虹膜漏分. 这是由于FPN是自顶向下的模式, 只将相邻的特征进行直接融合, 而底层特征却无法影响高层特征, 也就是说高层特征难以获取底层特征的定位信息, 因此导致难以对目标进行精确定位[31].

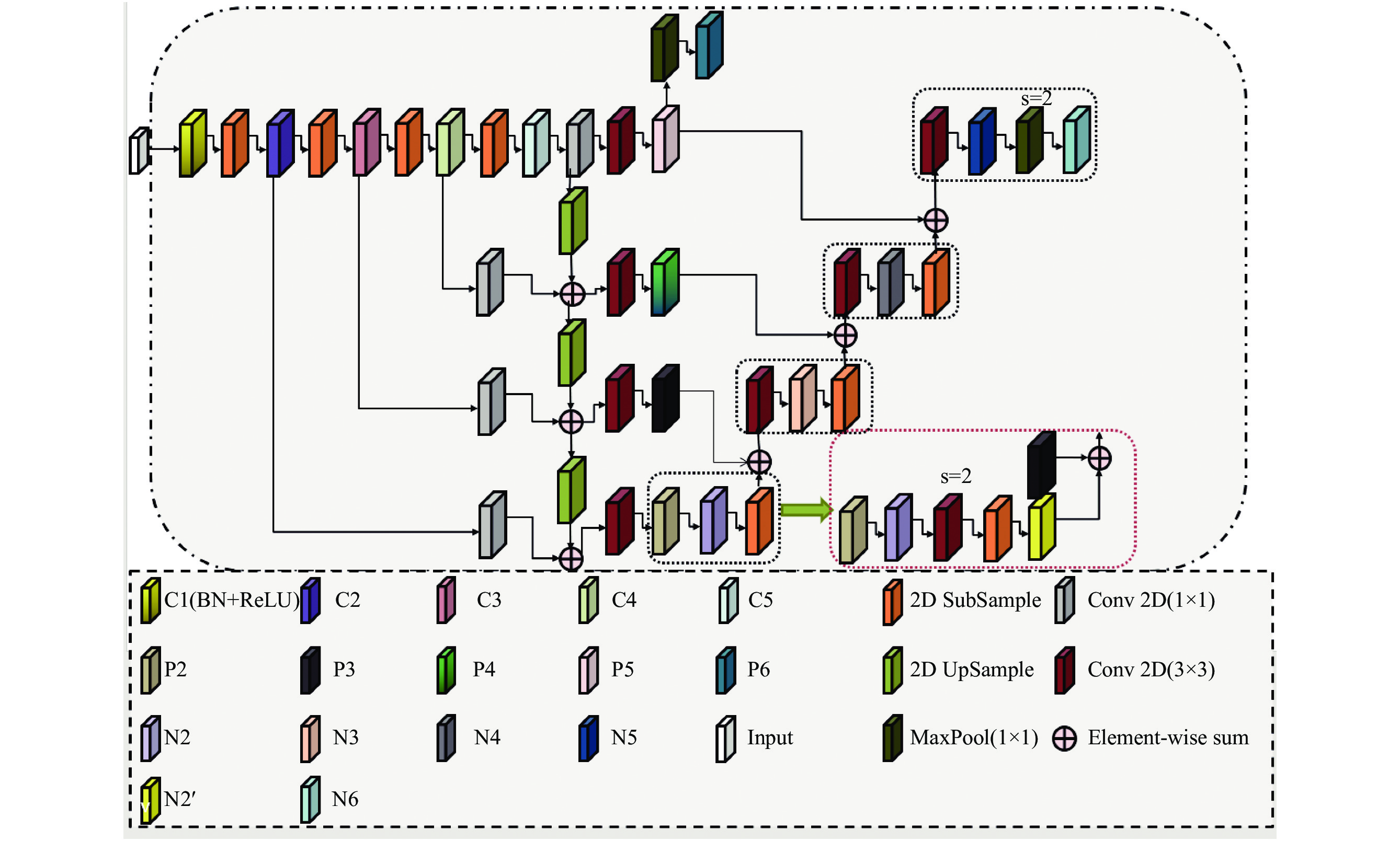

为了充分利用底层定位信息, 提高对目标的检测精度, 为FPN添加了一条自底向上的路径, 如图4, 该结构使得低层信息更容易传递到高层顶部, 有效利用底层的定位信息, 提高了检测精度. 之前底层特征只能通过特征金字塔, 现在能直接通过该结构传播到顶层, 进一步提高了传播效率. 为了方便后续使用, 将其简称为PA-FPN.

|

图 3 Mask-INet模型的网络架构概述 |

|

图 4 PA-FPN结构图 |

图中输入为残差网络模块输出的权重向量. 具体如表1所示, 输入图片大小为512×512×3, C2到C5通道数列表为{64, 128, 256, 512}分别对应表1中P2到P5的输入尺寸. 为了使每个特征图在融合时保持一致, 需要对每个特征层得到的特征图进行一个1×1卷积操作, 再将高层特征图进行一次2倍上采样与同尺度特征图进行融合, 最后经过一个3×3的卷积得到P2到P5, 通道数均为256. 得到的特征金字塔特征图列表为{P2, P3, P4, P5, P6}, 如图3红色虚线框部分, 令P2=N2, 对N2进行stride=2, kernel=3×3的卷积操作, 然后再进行下采样, 得到为原来的一半的特征图记为N2′, 将N2′与P3进行逐元素融合, 为了消除上采样带来的混叠效果, 再通过一个3×3的卷积层, 最后生成特征图N3, 在这过程中通道数均为256. 重复此操作, 最后输出特征图记为{N2, N3, N4, N5, N6}, 其中N6是N5通过一个大小为1×1, 步距为2的最大池化层实现下采样得到的. {N2, N3, N4, N5}的空间分辨率与横向连接传递的{P2, P3, P4, P5}互相对应. 我们将最终得到的金字塔特征图{N2, N3, N4, N5, N6}用于后续RPN网络的输入.

3.2 Improved-MaskHead (I-MH)Mask R-CNN中有3个分支, 一个用于预测分类、一个用于预测边界框回归、一个用于预测分割掩码, 这3个分支并行处理, 为每一个检测类别独立预测出掩码从而消除跨类别的竞争. 尽管Mask R-CNN相较其他算法有一定的优越性, 但是在掩模分支处理虹膜特征图的过程中发现空间分辨率较低, 导致信息损失较多, 所以本文在原始的掩码分支中加入了上采样层, 将原始特征图的分辨率增大了4倍. 预测虹膜图像掩模的本质问题是语义分割, 而语义分割对特征图的空间分辨率更为敏感, 分辨率更高的特征图, 更接近原的分辨率, 信息损失更少, 更有助于分割语义信息. 本文使用带有参数的反卷积层来进行上采样操作, 因为带有参数的反卷积层比不带参数的反卷积层更能适应不同的任务, 更具泛化能力.

Mask分支模块的结构图如图5所示, 输入为经过RoI Align得到的特征, 通道大小为256, 最终输出特征图大小为56×56×2. 具体参数如表2所示, 其中numcls代表类别数这里为2.

| 表 1 PA-FPN结构 |

|

图 5 Mask分支结构图 |

改进后的mask分支是由4个3×3的卷积层, 两个2×2的反卷积层和一个全连接层组成. 表2中RoI Align输入尺寸为h×w×256的特征图, 其中h×w是指输入任意的空间分辨率. 在这过程中通道数始终保持为256. RoI Align输入的特征图利用表中mask_fcn1、mask_fcn2、mask_fcn3、mask_fcn4等4个卷积层对特征进行空间信息挖掘, 同时利用mask_deconv1、mask_deconv2两个反卷积层将特征图的分辨率增大, 增强特征的空间信息, 便于生成质量更好的虹膜图像掩码. 最后通过一个1×1的卷积, 卷积核个数为分类个数, 得到预测后的每个类别的mask且大小均为56×56.

| 表 2 添加了上采样层的掩模预测分支结构 |

3.3 损失函数

在训练模型的过程中, 需要通过损失函数来定义该模型预测的好坏及优化的目标. 损失函数越小表明模型的鲁棒性越好.

总的损失函数为式(4), L是3个损失函数的总和.

| $ L= {L}_{{\rm{cls}}}+{L}_{{\rm{box}}}+{L}_{{\rm{mask}}} $ | (4) |

其中, Lcls为分类损失函数, 表示如式(6):

| $ {S}_{i}= \frac{{e}^{{a}_{i}}}{{{\displaystyle \sum }}_{k=1}^{T}{e}^{{a}_{k}}} $ | (5) |

| $ {L_{{\rm{cls}}}} = - \mathop \sum \limits_{i = 1}^T {y_i}\log {S_i} $ | (6) |

本文基于Softmax函数来计算RPN网络的交叉熵损失. 式(5)中符号ai表示类别i经过网络前向传播后所得分, T为分类的类别个数, Si表示类别i经Softmax函数计算得到的概率. 式(6)中yi表示真实标签, Si表示所得概率.

式(4)中Lbox为回归损失函数, 表示如式(7):

| $ {L}_{{\rm{box}}}=\left\{\begin{array}{l}0.5\times {x}^{2},\; {\rm{if}} \; \left|x\right| < 1\\ \left|x\right|-0.5, \; {\rm{otherwise}}\end{array} \right.$ | (7) |

其中,

式(4)中Lmask为分割损失函数, 表示如式(8):

| $ {L_{{\rm{mask}}}} = - \mathop \sum \limits_{k = 1}^n \widehat {{y_k}}\log {y_k} + \left(1-\widehat{{y}_{k}}\right)\mathrm{log}\left(1-\widehat{{y}_{k}}\right) $ | (8) |

输入掩模预测分支的图像会经过一系列的卷积层、反卷积层之后输出总的类别的特征图, 这一分支的损失函数定义为平均二值交叉熵损失函数. 式(8)中n代表n种类别,

本文借助2021年举办的NIR-ISL 2021比赛—一项与IJCB 2021联合举办的基准测试挑战比赛中所提供的数据集, 包括CASIA-Iris-Asia、CASIA-Iris-M1和CASIA-Iris-Africa[19].

CASIA-Iris-Asia包含了亚洲人在非合作环境的各种近红外虹膜图像[19]. 该数据集是由CASIA-Iris-Distance和CASIA-Iris-Complex所组成. 这些数据集使用不同的移动设备从不同场景和环境下获得. 该比赛提供的CASIA-Iris-Complex数据集共1000张, 其中包括遮挡虹膜图像500张和虹膜角度偏离图像500张. CASIA-Iris-Distance数据集400张. 本文从这3部分数据集随机平等的抽取共900张虹膜图像作为训练数据, 剩余的图像作为测试数据.

CASIA-Iris-M1是一个大型的近红外移动虹膜数据集, 包括3个子集: CASIA-Iris-M1-S1、CASIA-Iris-M1-S2和CASIA-Iris-M1-S3. 从3个子集中随机且平等的选择共1800张图像作为训练数据, 以同样的方式选择不相交的600张图像作为测试数据.

CASIA -Iris-Africa是非洲第一个大规模的黑人虹膜数据集. 从中随机平等的选取400张不同噪声类型的虹膜图像作为训练数据, 以同样的方式选择不相交的250张图像作为测试数据.

我们从3个数据集中抽取不同类型的虹膜图像, 组成我们的数据集. 比赛方提供的数据集为一般的分割数据集, 本文将该数据集处理成coco数据集格式以便使用. 所给原始数据如图6(a)所示, 虹膜的位置为标记区域, 如图6(b)所示.

|

图 6 眼睛数据 |

一般而言, 成功的神经网络需要大量的参数, 而能使模型正常工作的大量参数是需要训练海量数据才能得到. 在实际情况中, 数据的获取非常困难, 不仅消耗大量人力财力还浪费时间. 所以对于数据量较小的数据集, 一般会采用数据增强. 本文虹膜数据集中的训练集图片数量较少, 很容易导致训练过程出现过拟合的情况, 因此使用数据增强来提高模型的泛化能力和鲁棒性. 常用的数据增强方法包括图像旋转、翻转、裁剪、缩放、移动等, 本文所用到的数据增强方法包括水平翻转、垂直翻转、裁剪和缩放. 最后将虹膜图像统一裁剪成512×512的固定大小.

5 实验结果与分析 5.1 实验环境及细节本实验是在一台小型深度学习服务器上开展的, 该服务器的具体配置参数如下: 操作系统是Ubuntu 18.04LTS, CPU型号为I7-7700K内存大小为128 GB, 显存为11 GB的Nvidia GTX 2080Ti显卡. Python版本为3.6, PyTorch版本为1.6.

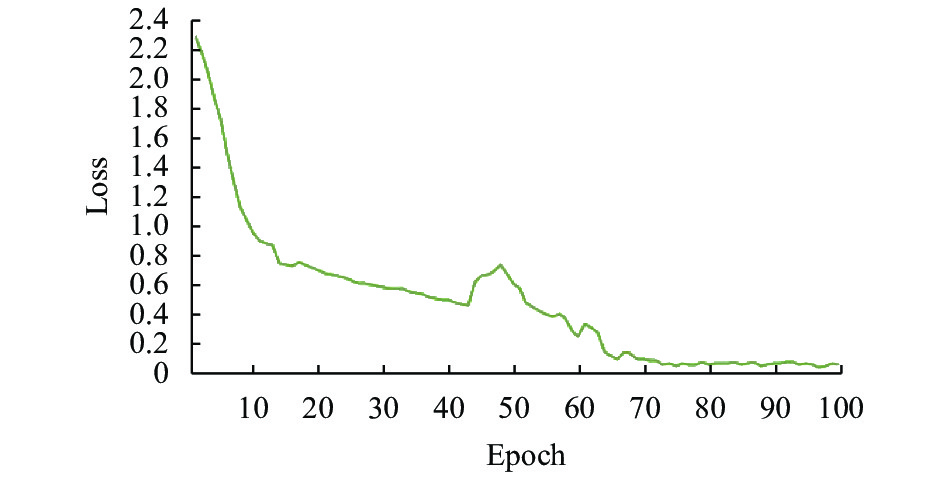

该实验采用Adamw优化算法加快收敛速度, 设置weight-decay为0.05, 训练epoch总数为100, 每个epoch迭代次数为1000, Batch Size设置为8, 初始的学习率为0.0002, 每20个epoch学习率衰减为原来的0.1. 绘制的训练集损失值变化如图7所示, 横坐标表示训练epoch次数, 纵坐标表示损失值. 当训练到70个epoch后模型损失值趋于收敛.

|

图 7 损失值变化 |

5.2 评价指标

为了验证所提出网络结构的有效性, 本文与不同方法作了对比实验. 实验结果评价指标包括常用的分割指标召回率(Recall)、Dice相似系数(Dice)、平均交并比(mIoU).

Recall是衡量被标注为正的样本占总样本比例的重要指标. 如式(9)所示, 其中TP表示被预测为正样本, 真实值也为正样本; FN表示被预测为负样本, 但真实值为正样本.

| $ {{{Re}}} call = \frac{{TP}}{{TP + FN}} $ | (9) |

Dice是用于衡量真实掩码与分割结果相交集合相似性的度量指标, 如式(10)所示, 其中

| $ Dice= \frac{2|X \cap Y|}{\left|X\right|+\left|Y\right|} $ | (10) |

mIoU是衡量所有类别交集与并集之比的平均值的指标. 如式(11)所示, 其中k代表类别数, FP表示被预测为正样本, 真实值为负样本.

| $ mIoU=\frac{1}{k}\displaystyle \sum _{i=1}^{k}\frac{TP}{FN+FP+TP} $ | (11) |

本文分别将ResNet18、ResNet50和ResNet101作为Mask R-CNN的Backbone, 通过表3结果显示, 在不同场景下的虹膜分割任务中, ResNet50作为backbone时, Dice、mIoU和召回率均为最优. 因此本文采用ResNet50作为本文的backbone.

| 表 3 Mask R-CNN在3种不同backbone下的评估对比结果(%) |

5.4 FPN实验

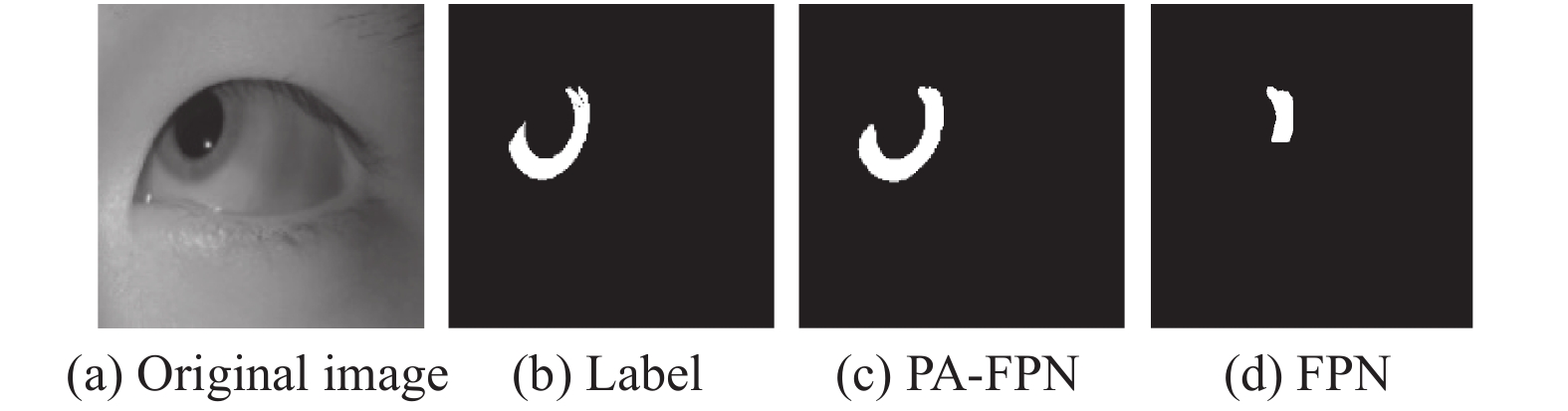

随着网络层数的加深, 检测所需的位置信息越差, 为了进一步增强特征图的语义信息以及目标物体的检测精度, 在FPN中引入一条自底而上的路径(称为PA-FPN).

由表4可以知道, 使用PA-FPN进行训练得到模型的Dice值达到了92.43%, 相较原始的FPN模型Dice提升了2.65%, mIoU提升了3.15%, 这说明PAFPN能有效提升图像的分割精度.

如图8所示是PA-FPN与原始FPN对比结果, 可以看出原始FPN对斜视图像的分割效果较差, 存在漏分的情况, 且虹膜边界分割比较粗糙. 相比之下PA-FPN分割出的虹膜内外边界更加平滑, 分割的最终效果更接近真实标签.

| 表 4 PA-FPN同原模型性能评估对比结果(%) |

|

图 8 FPN与PA-FPN的模型预测结果对比 |

5.5 掩码预测分支改进实验

虹膜分割在虹膜识别中具有十分重要的作用, 本质上是对虹膜进行语义分割. 而在语义分割中, 空间分辨率的大小会影响对特征空间信息的挖掘. 本文利用上采样进一步提取空间信息, 如表5所示, 添加了上采样的Mask R-CNN在Dice、mIoU指标上分别提升了2.75%、2.91%.

| 表 5 I-MH方法同原模型的对比结果(%) |

5.6 不同注意力机制模块的横向对比实验

为了进一步挖掘虹膜的特征信息, 我们在第3.2节的I-MH中引入注意力机制, 并同未加注意力以前的特征图作逐元素相加操作, 进一步融合特征信息. 注意力机制能够让模型更加关注实例区域, 减少不相关的信息对目标检测性能的影响. CBAM能同时兼顾空间和通道的特征信息, 能获取更好的效果. 本文同SENet、ECA-Net[32]等不同的注意力机制作了对比. 从表6可以看出, 添加注意力机制能有效提升虹膜的分割精度. 相比其他注意力机制而言, CBAM的各项指标明显更好. 同未加注意力机制的模型对比, Dice值、mIoU分别提升了2.02%、3.11%.

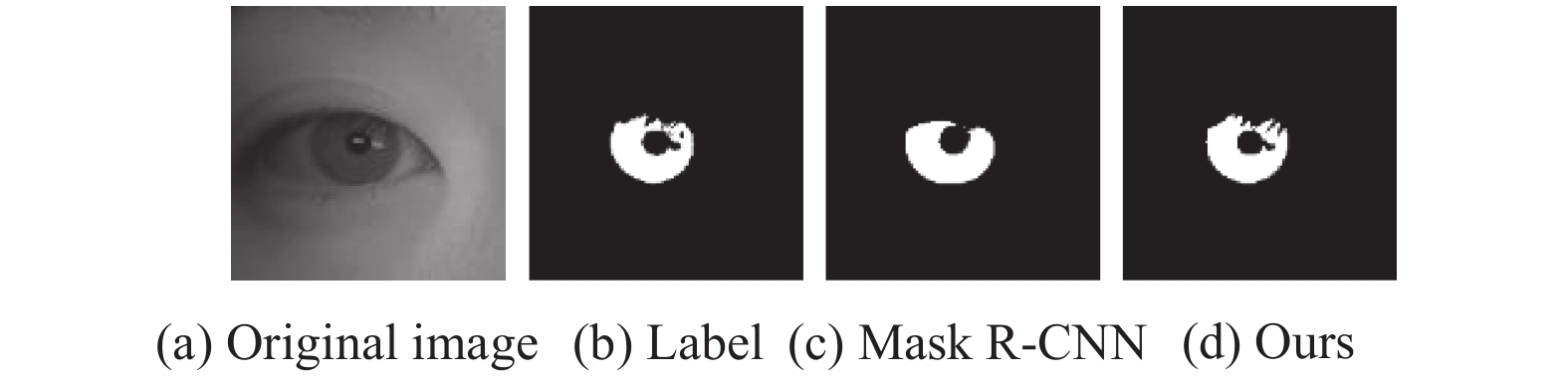

5.7 不同方法性能对比为了说明Mask-INet模型的有效性和准确性, 我们在相同的数据集上, 使用具有相同实验条件的各种模型进行了对比实验, 实验结果采用相同的评价标准. 不同算法的分割结果如图9所示, 其中第1列为虹膜图像、第2列为虹膜的真实标签、第3列为UNet[10]的分割掩码、第4列为SegNet[11]的分割掩码、第5列为PSPNet[12]的分割掩码、第6列为DeepLabv3[15]的分割掩码、第7列为T-UNet[19]方法的分割掩码, 第列为文献MedT[16]的分割掩码结果, 最后一列是本文方法的分割掩码. 实验结果表明, UNet、SegNet、PSPNet、DeepLabv3、T-UNet、MedT等方法对于包含斜视、模糊、眼镜遮挡、睫毛遮挡、瞳孔收缩等困难样本的分割效果较差, 存在错分、漏分的情况, 且虹膜边缘部分分割不够圆滑, 而本文提出的方法虹膜分割结果依然精确, 且边缘更加光滑, 分割结果更接近真实标签, 有效提升了分割精度.

| 表 6 不同注意力机制对本文测试数据集的评估对比结果(%) |

|

图 9 不同方法的对比结果 |

表7展示了不同虹膜分割方法的定量指标结果, 可以看出本文方法在Dice相似系数、平均交并比和召回率3项评价指标上均优于其他几种方法. 在测试集上, Dice相似系数上达到了95.62%, 平均交并比达到了92.78%, 召回率达到了96.36%.

5.8 消融实验为了验证各个模块对整体模型的有效性, 基于Mask R-CNN网络、以ResNet50为骨干网络, 加入PA-FPN结构、在掩码预测分支引入上采样和CBAM模块构成不同网络模型进行消融实验. 如表8所示, 相较其他方法, 本文方法在Dice相似系数、平均交并比和召回率的值上均取得了最高值. 分割精度在原模型的基础上Dice相似系数提升8.53%, 平均交并比提升了11.97%, 召回率提升了8.88%, 充分证明了本文提出方法的有效性

| 表 7 不同方法性能评估对比结果(%) |

| 表 8 模型性能对比结果(%) |

由图10可以看出, 本文改进的Mask R-CNN能够有效准确的分割出模糊样本中完整的虹膜, 分割结果接近真实标签.

|

图 10 改进后模型对比结果 |

6 结论与展望

受残差网络、特征金字塔、注意力机制等多种网络的启发, 本文提出了基于Mask R-CNN网络的Mask-INet模型, 该模型对存在遮挡物、斜视、模糊等虹膜困难样本进行了有效、准确的分割. 本文的关键在于为特征金字塔添加了一条自底向上的路径, 缩短了信息路径, 增强了浅层的定位信息, 有效提升对虹膜特征的提取效果. 实验表明: 本文方法有效提高了虹膜图像的分割精度, 且有效改善了包含不同噪声因素的虹膜图像的分割. 相比于传统的Mask R-CNN网络, Mask-INet网络的Dice值达到了95.62%、mIoU达到了92.78%、Recall达到了96.36%、分别提升了8.53%、11.97%、8.88%. 在下一步的工作中, 会探究如何捕获检测分支中不同大小的感受野, 提升生成Mask预测的质量, 从而进一步提高模型对虹膜困难样本分割的精确度.

| [1] |

田会娟, 翟佳豪, 柳建新, 等. 基于SRN-UNet的低质量虹膜分割算法. 光子学报, 2022, 51(2): 0210006. DOI:10.3788/gzxb20225102.0210006 |

| [2] |

苑玮琦, 冯琪, 白晓光. 基于2D-Gabor滤波器的虹膜噪音检测方法. 光子学报, 2010, 39(2): 369-374. DOI:10.3788/gzxb20103902.0369 |

| [3] |

Zhou WB, Ma XT, Zhang Y. Research on image preprocessing algorithm and deep learning of iris recognition. Journal of Physics: Conference Series, 2020, 1621: 012008. DOI:10.1088/1742-6596/1621/1/012008 |

| [4] |

Cambier JL, Siedlarz JE. Portable authentication device and method using iris patterns: US, US6532298B1. 2003-03-11.

|

| [5] |

Sequeira AF, Chen LL, Ferryman J, et al. PROTECT Multimodal DB: Fusion evaluation on a novel multimodal biometrics dataset envisaging border control. Proceedings of the 2018 International Conference of the Biometrics Special Interest Group (BIOSIG). Darmstadt: IEEE, 2018. 1–5.

|

| [6] |

Wang CY, Muhammad J, Wang YL, et al. Towards complete and accurate iris segmentation using deep multi-task attention network for non-cooperative iris recognition. IEEE Transactions on Information Forensics and Security, 2020, 15: 2944–2959.

|

| [7] |

He ZF, Tan TN, Sun ZN, et al. Toward accurate and fast iris segmentation for iris biometrics. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(9): 1670-1684. DOI:10.1109/TPAMI.2008.183 |

| [8] |

Chen Y, Wang WY, Zeng Z, et al. An adaptive CNNs technology for robust iris segmentation. IEEE Access, 2019, 7: 64517-64532. DOI:10.1109/ACCESS.2019.2917153 |

| [9] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 3431–3440.

|

| [10] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [11] |

Badrinarayanan V, Kendall A, Cipolla R. SegNet: A deep convolutional encoder-decoder architecture for image segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495. DOI:10.1109/TPAMI.2016.2644615 |

| [12] |

Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6230–6239.

|

| [13] |

Chen LC, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs. Computer Science, 2014(4): 357-361. |

| [14] |

Chen LC, Papandreou G, Kokkinos I, et al. DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 |

| [15] |

Chen LC, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation. arXiv:1706.05587, 2017.

|

| [16] |

Valanarasu JMJ, Oza P, Hacihaliloglu I, et al. Medical transformer: Gated axial-attention for medical image segmentation. Proceedings of the 24th International Conference on Medical Image Computing and Computer-assisted Intervention. Strasbourg: Springer, 2021. 36–46.

|

| [17] |

Jalilian E, Uhl A. Iris segmentation using fully convolutional encoder-decoder networks. Deep Learning for Biometrics. Cham: Springer, 2017. 133–155.

|

| [18] |

Lian S, Luo ZM, Zhong Z, et al. Attention guided U-Net for accurate iris segmentation. Journal of Visual Communication and Image Representation, 2018, 56: 296-304. DOI:10.1016/j.jvcir.2018.10.001 |

| [19] |

Wang CY, Wang YL, Zhang KB, et al. NIR iris challenge evaluation in non-cooperative environments: Segmentation and localization. 2021 IEEE International Joint Conference on Biometrics (IJCB). Shenzhen: IEEE, 2021. 1–10.

|

| [20] |

He KM, Gkioxari G, Dollár P, et al. Mask R-CNN. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988.

|

| [21] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2015. 91–99.

|

| [22] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [23] |

Lin TY, Dollár P, Girshick R, et al. Feature pyramid networks for object detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 936–944.

|

| [24] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [25] |

王广学, 黄晓涛, 周智敏. SAR图像尺度不变特征提取方法研究. 中国图象图形学报, 2011, 16(12): 2199-2205. DOI:10.11834/jig.20111215 |

| [26] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37.

|

| [27] |

Mnih V, Heess N, Graves A, et al. Recurrent models of visual attention. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2014. 2204–2212.

|

| [28] |

Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. DOI:10.1109/TPAMI.2019.2913372 |

| [29] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 3–19.

|

| [30] |

Deng J, Dong W, Socher R, et al. ImageNet: A large-scale hierarchical image database. 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 248–255.

|

| [31] |

Liu S, Qi L, Qin HF, et al. Path aggregation network for instance segmentation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8759–8768.

|

| [32] |

Wang QL, Wu BG, Zhu PF, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 11531–11539.

|

2023, Vol. 32

2023, Vol. 32