2. 北京师范大学 数学科学学院, 北京 100875;

3. 上海交通大学, 上海 200240;

4. 中国国家博物馆, 北京 100006

2. School of Mathematical Sciences, Beijing Normal University, Beijing 100875, China;

3. Shanghai Jiao Tong University, Shanghai 200240, China;

4. National Museum of China, Beijing 100006, China

当今, 随着全媒体时代的发展, 一些音视频网站与应用正在逐渐盛行, 例如腾讯视频、爱奇艺、TikTok、快手等, 人们正生活在一个多种媒体相互作用、互为补充的社会里. 这些应用的特点是: 一方面, 它们提供了大量的物品数据, 其中包括文本、图像、音频、视频等不同媒体类型的物品信息; 另一方面, 这些应用的用户粘性很大程度上取决于推荐系统的好坏. 因此, 能够融合多类媒体和多种信息进行更加精准、更为个性化的推荐具有非常重要的意义.

传统的推荐算法多使用用户历史行为信息(例如: 点赞、评分、点击量等)对用户和物品的交互通过偏好程度的相似度进行建模, 这种方法也被称作协同过滤算法. 但随着实际的应用, 这个算法一方面被认为不能够很好地解决稀疏性和冷启动的问题[1]; 另一方面, 如果加入辅助信息, 能够丰富物品的表达, 在引入神经网络建模时, 将能够建立更多用户和物品特征的交互, 使推荐系统的性能大大提高[2].

当前国内外学者对于推荐算法的研究中, 根据辅助信息的种类, 其工作可以被分为3大类: 基于文本的推荐算法、基于视觉模态的推荐算法和基于多模态的推荐算法.

文献[3, 4]是基于文本信息的推荐算法, Wei等[3]提出基于紧耦合深度协同过滤的推荐模型, 使用改进的分解模型Time-SVD++, 并使用多个自编码器学习物品的文本特征, 能够有效解决冷启动的问题. Frolov等[4]提出一种集成的混合算法, 扩展传统的奇异值分解方法, 将交互数据和辅助的文本信息进行联合分解, 同样能够很好地解决冷启动的问题.

文献[5-7]是基于图像信息的多模态推荐算法, Lei等[5]提出双网深度网络用于图像的推荐, 将图片和用户偏好使用两个子网络映射到同一个潜在语义空间中, 形成了更有效的偏好表示和图像表示; Tang等[6]对视觉推荐模型的健壮性进行研究, 提出AMR模型, 通过对抗学习生成鲁棒性更强的推荐模型, 并验证了其对于图像推荐和视觉感知产品推荐的有效性; Qiu等[7]提出CausalRec模型, 通过因果推理框架仅保留有效的视觉特征, 解决了现有推荐系统存在的视觉偏差问题.

文献[8-10]是基于多模态融合的推荐算法, Oramas等[8]提出使用深度网络架构将文本和音频信息与用户反馈数据相结合, 使用简单的多层感知机对级联特征进行融合. Sun等[9]提出了一种用于融合文本与图像异构模态的紧耦合深度网络模型, 网络将原始图片与文本信息作为输入, 从特征提取级别开始训练, 在训练过程中同时对特征提取模块和协同过滤模型进行优化, 得到了较好的效果. 肖庆华等[10]则针对互补推荐的目标, 提出基于图片、文本以及评分的多模态互补物品特征提取算法: 结合卷积神经网络、文本向量化、贝叶斯推断3种方法, 提高了推荐系统的准确率, 同时使用Bandits算法提高了推荐系统的多样性.

与此同时, 文本、图像与音频3种模态特征生成融合表征已被国内外学者广泛关注: Huang等[11]提出视觉-语言的Transformer模型, 将上述3种模态特征应用于跨媒体检索; Wang等[12]受到人类记忆的再建构和联想性质整合启发, 将3种模态作为自编码器的输入来解决学习多模态单词表示的问题; 而Zadeh等[13]则从情感分析的角度比较了多模态协同学习和单峰学习的区别. 在实际的系统应用方面, 中科院自动化研究所发布了依托武汉人工智能计算中心算力研发的跨模态通用人工智能平台“紫东太初”, 在该平台上, Liu等[14]首次提出了视觉-文本-语音三模态预训练模型, 实现了三模态间的相互转换和生成.

目前, 将文本、图像与音频的融合与推荐系统结合应用目前尚未得到广泛应用. 而音频数据对于当今时代的推荐系统有着重要的作用, 声音中所包含的环境声、人物互动的情绪语气、甚至是其中包含的背景音乐等都是非常重要的物品风格, 而这些特征是文本和图像无法表征的[15]; 并且, 对于拥有多个模态的推荐系统来说, 线性模型不足以表示复杂的相互关系, 一次性融合所有特征将忽略复杂的局部相关性, 而只考虑双线性池化时, 需要先对两个模态融合, 再将融合结果与第3个模态进行融合, 其模型表达能力可能也会受到交互顺序的影响. 因此, 在基于多模态的方法中, 探索多模态数据的异质性, 提高模型的泛化能力, 仍然是一个重大的挑战.

本文基于上述问题, 提出基于张量网络的多模态推荐算法. 图像中的显著性区域和文本中的关键性单词具有较强的语义相关性[16], 另一方面, 张量融合方法通过张量外积将输入的多个模态转化为一个高维张量, 再将其映射回一个低维输出向量空间, 通过这种方式能够计算不同模态元素之间的相关性, 从而对跨模态之间的交互关系进行建模[17], 与早期融合在输入级别上简单地连接多模态特征相比, 能够更有效地建立模态内部之间的交互关系[18], 同时又比注意力机制等复杂的网络模型更为简单有效. 因此, 在高维张量上进行模态融合被认为是一种有效的模态交互方式. 本文提出的模型将首先在浅层的显著特征上通过3个分支对交互性进行两两融合建模, 对于该过程中维度过高的张量使用低秩矩阵因子对其进行降维; 之后将3个分支中的特征再次进行张量融合, 得到第2阶段的融合特征; 将二阶段张量融合后的特征输入深度协同过滤模型中, 通过联合损失函数对结果进行训练. 整个网络是一个端到端的训练过程, 能够大大提高的模型的表达能力. 近年来, 量子计算引起了研究者的广泛重视, 量子人工智能有望成为一种通向第3代人工智能的途径. 通过张量法可将参数矩阵整理为量子多体, 使用张量分解压缩模型参数, 可以大幅度提升计算资源的利用率, 降低计算的复杂度. 因此, 基于张量分解的推荐算法的量子计算模拟具有很好的发展前景[19].

为了最大化地利用融合特征, 本文使用融合特征在推荐结果的多样性上进行精化. 如今, 在越来越注重推荐准确率的同时, 推荐列表的多样性成为衡量推荐系统好坏的重要依据. 因此, 本文将模态融合特征用于多样性推荐中, 能够在不影响推荐准确率的前提下提高推荐系统的多样性, 使融合特征得到充分利用的同时, 能够完善整个推荐系统.

综上, 本文的贡献如下.

(1)提出一个基于全连接张量网络的端到端训练的多模态推荐模型, 通过张量积的方式将级联特征映射为高维张量, 对不同模态的相关性通过张量融合进行建模, 提取最有效的融合特征用于深度协同过滤模型.

(2)所建立的多模态融合的过程分成两个阶段, 第1阶段通过3个平行的分支对浅层多模态特征进行浅层特征融合, 第2阶段在深层特征上对3个分支进行融合. 充分考虑了不同模态的相关性, 以得到更好的融合特征表示.

(3)在模态融合之后加入多样性推荐模块, 能够最大化地利用融合特征并构建出更完整的推荐算法.

(4)在MovieLens数据集上构建文本、图像和音频的多模态数据集并进行实验, 取得了比基准实验更好的结果.

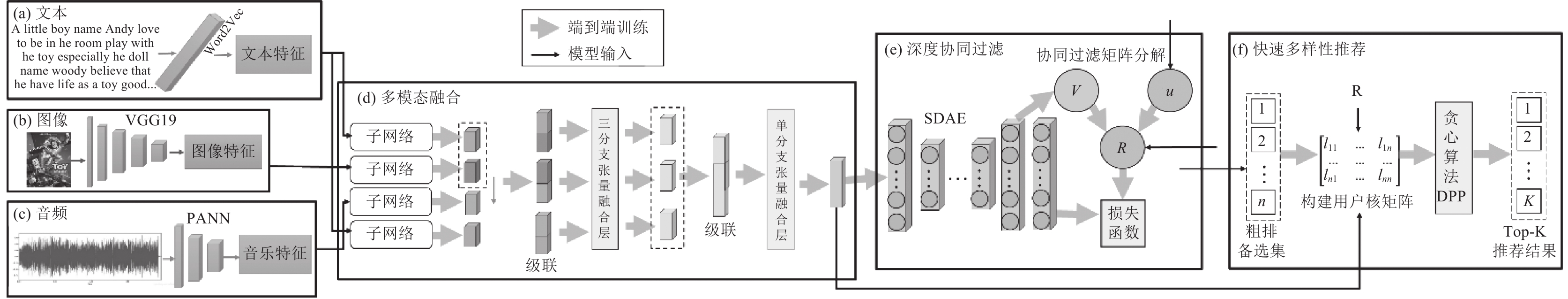

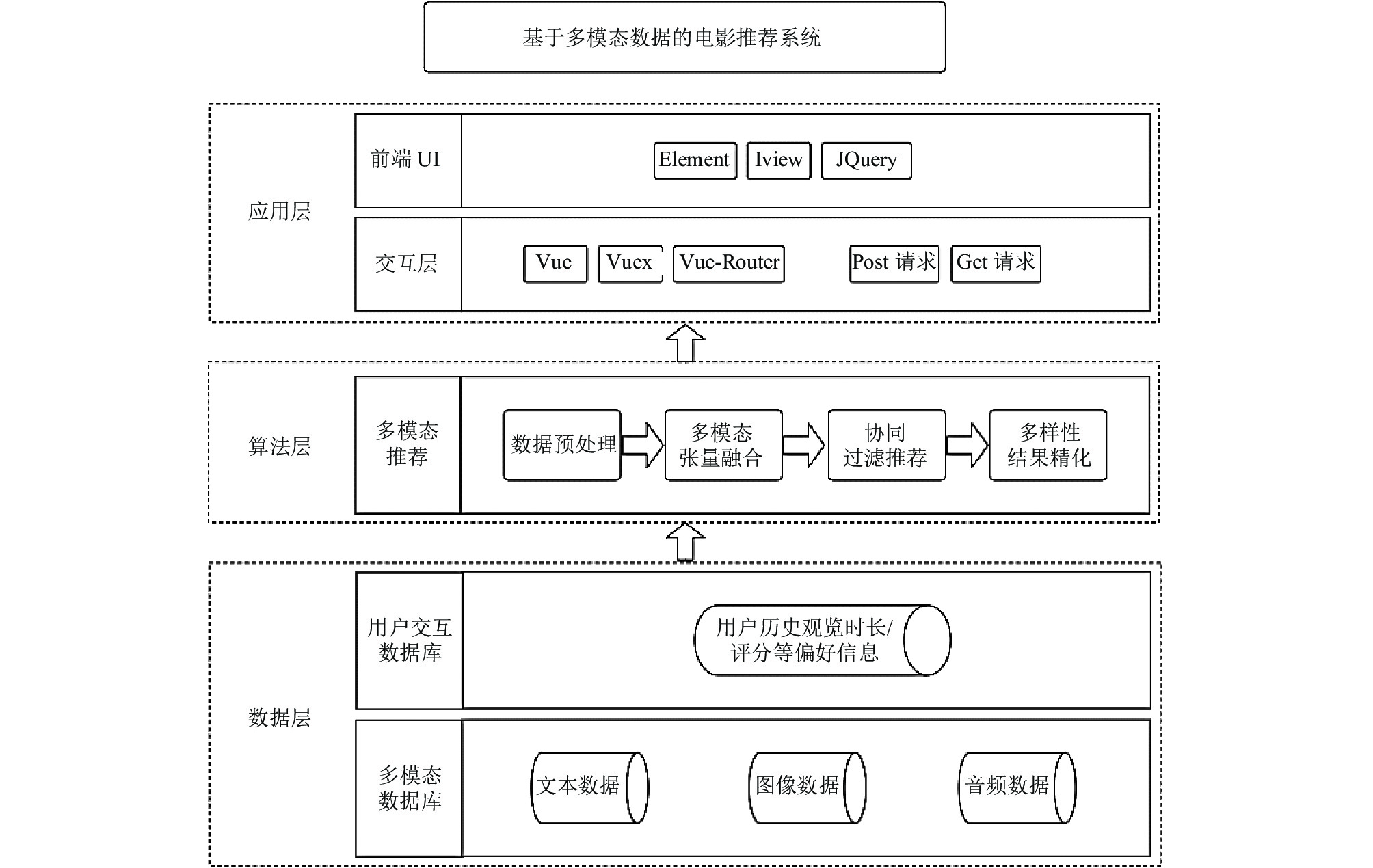

1 本文模型 1.1 模型框架本文使用二阶张量池化的方法学习文本、图像、音频3种模态的交互关系并对其进行特征融合, 同时结合用户偏好矩阵, 与深度协同过滤分解方法结合, 设计端到端的网络用于多模态推荐, 模型框架如图1所示. 本方法的创新性在于: (1)传统深度协同过滤模型仅考虑单一文本模态, 本文提出了针对图像、文本、音频3种模态的推荐算法; (2)在多模态融合中, 使用了二阶段张量融合方法, 不仅注重模态的两两交互, 并且能够使特征不受到融合顺序的影响; (3)模态融合之后使用联合优化方法, 构建端到端训练模型, 能够使得融合模态更加适用于推荐应用; (4)对前一阶段的推荐结果进行基于行列式点过程的精化, 生成多样化推荐.

|

图 1 本文模型框架图 |

预处理阶段首先需要对文本、图像、音频3种模态特征进行提取. 为了使后续阶段能够更好地探索模态之间的交互性, 这里需要提取到更原始的具有充分异质性的模态特征, 因此本文分别使用针对不同模态的特征提取方法进行特征提取: 文本模态参考文献[20]中的语义表示模型提取300维文本特征, 视觉模态使用大规模预训练模型VGG19[21]提取1 000维视觉特征, 音频模态使用音频模式识别领域的大规模预训练模型PANN[22]提取2 048维声音模态特征.

本文模型主要包括3个部分: 基于张量网络的特征融合(图1(d)), 深度协同过滤推荐(图1(e))基于融合特征的多样性推荐(图1(f)). 模态融合模块我们参考文献[15]中的多模态融合方法, 为确保融合模块的特征不会受到交互顺序的影响, 并充分探索模态特征两两之间的交互模式, 使用3个平行的分支和两个先后的阶段: 首先将3个模态特征进行两两组合形成3个平行分支, 然后通过多阶张量积的方式将模态相乘, 以求得到更好的交互效果, 之后通过张量网络降维方法, 与低秩矩阵因子相乘将参数维度变低, 最后通过一个神经网络层将该阶段的结果输出; 第2个阶段再对3个分支的交互性进行建模: 与第1阶段的流程大体相同, 首先将3个分支的输出结果进行级联, 再对特征进行多阶张量相乘, 然后通过低秩矩阵分解将维度变低, 最后通过一个全连接层将最终融合特征输出. 对于深度协同过滤推荐模块: 我们将融合特征作为协同过滤推荐的辅助特征输入堆叠自编码器中, 在自编码器的中间层输出隐语义特征, 辅助协同过滤分解, 并在损失函数上做调整, 使得堆叠自编码器模型能够与协同过滤矩阵分解两个模块互相适应, 以更好地提高模型的鲁棒性.

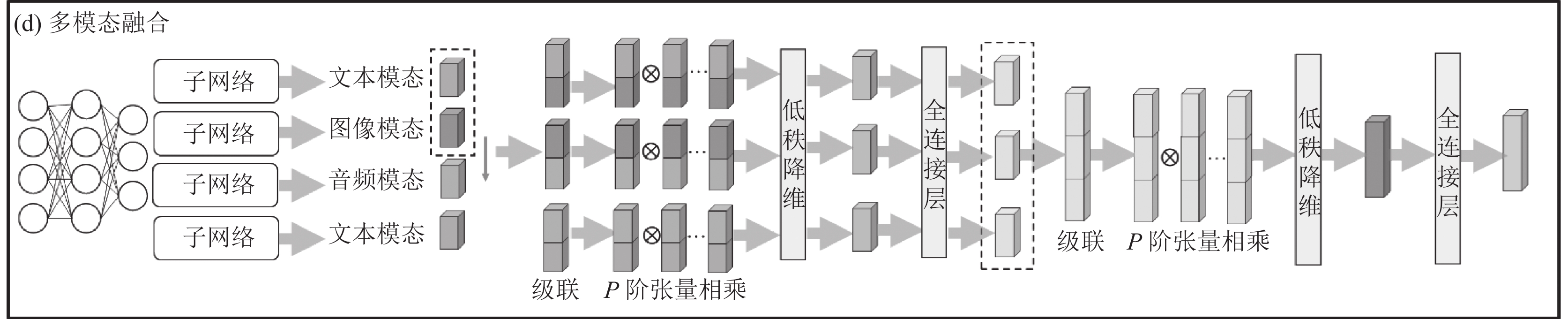

1.2 模态融合模块该模块的任务是通过建模模态之间的交互作用, 将单模态稀疏表示的高阶矩阵转变为紧凑表示的低阶矩阵[15]. 如图2所示: 分为3个阶段, 首先通过子网络自适应降维, 使用神经网络增强模型的非线性程度, 神经网络结构如表1所示, 将生成的高维特征维数降低; 再通过3个平行的分支对于3个模态两两之间的交互关系进行建模, 最后再对3个分支进行融合.

|

图 2 模态融合模块流程图 |

| 表 1 特征映射子网络结构表 |

对于第1个阶段: 首先将3个模态进行两两组合, 共有3种组合方式, 分别为音频和文本、音频和图像、文本和图像, 可以形成3个平行分支. 再对单个分支上的两个特征进行级联, 形成级联特征向量:

| $ \begin{array}{c}{f}_{i}=Concat\left({M}_{a}, {M}_{b}\right) \end{array} $ | (1) |

其中,

| $ \mathcal{F}_i=\underbrace{f_i \otimes f_i\otimes \cdots\otimes f_i}_{{P}{\textit{-}}{\rm{order}}} $ | (2) |

其中,

| $ \begin{array}{c}fusion\_{f}_{i}={W}^{H}\cdot {\mathcal{F}}_{i} \end{array} $ | (3) |

此时, 式(3)中的

| $ \begin{split} fusion\_{f}_{i}&=\sum _{r=1}^{R}{a}_{r}^{h}\prod _{p=1}^{P}{w}_{a}^{h\left(p\right)}\prod _{p=1}^{P}{f}_{i\left(p\right)}\\ &=\sum _{r=1}^{R}{a}_{r}^{h}\prod _{p=1}^{P}{w}_{a}^{h\left(p\right)}{f}_{i\left(p\right)} \end{split} $ | (4) |

其中,

对于第2个阶段: 基本步骤与第1个阶段相同, 仅在第1个级联步骤需要将在3个分支的操作结果上进行, 即:

| $ \begin{array}{c}{f}_{i}{'}=Concat\left({M}_{x}, {M}_{y}, {M}_{{\textit{z}}}\right) \end{array} $ | (5) |

其中,

深度协同过滤模块的目的是将融合模态输入堆叠降噪自编码器(SDAE)模型中, 输出协同过滤分解的辅助信息以进行最终的推荐. 该模块通过二阶段张量融合后的特征向量表征物品, 能够更好地提升推荐系统的性能.

基于SDAE的协同过滤推荐算法[23]与传统的基于矩阵分解的协同过滤推荐算法[24]类似, 都是将评分矩阵

| $ \begin{array}{c}{\hat{r}}_{mn}={u}_{m}^{{\rm{T}}}{v}_{n} \end{array} $ | (6) |

在SDAE模块, 本文所使用的SDAE模型由5层DAE组成, 前两层为编码器, 其映射函数如下:

| $ \begin{array}{c}{H}_{i}=dropout(ReLU\left({W}_{i}{H}_{i}+{b}_{i}\right)) \end{array} $ | (7) |

其中, i为SDAE的层编号, 第1层的

后两层为解码器, 其映射函数如下:

| $ \begin{array}{c}{Y}_{l}=ReLU\left({W}_{l}{H}_{l-1}+{b}_{i}\right) \end{array} $ | (8) |

同时, 需要从该模型中的第2层输出中获取物品融合特征的融合语义表达:

| $ \begin{array}{c}v{'}=dropout(ReLU\left({W}_{2}{H}_{1}+{b}_{2}\right)) \end{array} $ | (9) |

本文的目标函数使用联合损失函数, 联合损失的好处是可以通过多个目标对整个推荐系统的各个模块进行优化, 使其成为一个紧耦合的训练过程. 参考文献[23]中的联合损失函数, 为提高计算效率, 本文简化了其中SDAE每一层输出与原始输出的优化损失函数.

为防止模型过拟合, 需要在损失函数上增添规范化因子. 在SDAE模型中, 使用每一层权重和偏置的L2正则化表达; 在矩阵分解模型中, 使用分解后用户潜在向量的L2正则化表达:

| $ \begin{array}{c}{L}_{{\rm{SDAE}}}=\displaystyle\sum _{l}\left(\dfrac{1}{2}{‖{W}_{l}‖}^{2}+\dfrac{1}{2}{‖{b}_{l}‖}^{2}\right) \end{array} $ | (10) |

| $ \begin{array}{c}{L}_{{\rm{MF}}}=\displaystyle\sum _{m}{\left\| {u}_{m}{} \right\|}^{2} \end{array} $ | (11) |

| $ \begin{array}{c}{L}_{1}={\mathrm{\lambda }}_{u}{L}_{{\rm{MF}}}+{{\mathrm{\lambda }}_{w}L}_{w} \end{array} $ | (12) |

对于物品的潜在向量

| $ \begin{array}{c}{L}_{2}={\mathrm{\lambda }}_{v}\displaystyle\sum _{n}{\left\| {{v}_{n}-v{'}} \right\|}^{2} \end{array} $ | (13) |

对于SDAE编码器去噪效果的优化, 其目标为减少输入的融合特征与重构特征的误差:

| $ \begin{array}{c}{L}_{3}={\mathrm{\lambda }}_{n}\displaystyle\sum _{n}{\left\| {{Y}_{L}-fusion\_{f}_{i}{'}} \right\|}^{2} \end{array} $ | (14) |

对于评分矩阵

| $ \begin{array}{c}{L}_{4}={\mathrm{\lambda }}_{w}\displaystyle\sum _{m}\displaystyle\sum _{n}{\left({r}_{mn}-{\hat{r}}_{mn}\right)}^{2} \end{array} $ | (15) |

最终的损失为正则化因子与目标的损失函数之和:

| $ \begin{array}{c}L={L}_{1}+{L}_{2}+{L}_{3}+{L}_{4} \end{array} $ | (16) |

该模块利用模态融合模块中的特征向量构建电影之间的相似度矩阵, 再结合用户对电影的评分构建用户的核矩阵, 使用贪心算法完成对核矩阵子式的快速求解, 最终输出用户的推荐列表. 旨在兼顾推荐准确性的同时, 实现对用户的多样性推荐.

行列式点过程(determinantal point process)是一个概率模型[25], 是一种用于多样性推荐的抽样方法. 点过程

| $ \begin{array}{c}P\left(A\subseteq M\right)={det}\left({L}_{A}\right) \end{array} $ | (17) |

其中,

| $ \begin{split} {det}\left({L}_{A}\right)&=\left|\begin{array}{cc}{L}_{ii}& {L}_{ij}\\ {L}_{ji}& {L}_{jj}\end{array}\right| ={L}_{ii}{L}_{jj}-{L}_{ij}{L}_{ji}\\ &=P\left(i\in M\right)P\left(j\in M\right)-{L}_{ij}^{2} \end{split} $ | (18) |

由式(18)可知, 核矩阵

DPP从待选电影集合中选择能最大化后验概率(MAP)的电影子集. 但是, DPP的MAP直接求解比较复杂, 而贪心算法能大大加快求解速度[26]. 即每次选择一部电影j添加到结果集

| $ \begin{array}{c}j={{{\rm arg max}\;\log det}}\left({M}_{g}\cup \left\{i\right\}\right)-{{\log det}}\left({M}_{g}\right) \end{array} $ | (19) |

其中, 电影

| $ \begin{array}{c}{L}_{{M}_{g}\bigcup \left\{i\right\}}=\left[\begin{array}{cc}{L}_{{M}_{g}}& {L}_{{M}_{g}, i}\\ {L}_{{i, M}_{g}}& {L}_{ii}\end{array}\right]=\left[\begin{array}{cc}V& 0\\ {c}_{i}& {d}_{i}\end{array}\right]{\left[\begin{array}{cc}V& 0\\ {c}_{i}& {d}_{i}\end{array}\right]}^{{\rm{T}}} \end{array} $ | (20) |

由矩阵乘法, 行向量

| $ \begin{array}{c}V{c}_{i}^{{\rm{T}}}={L}_{{M}_{g}, i} \end{array} $ | (21) |

| $ \begin{array}{c}{d}_{i}^{2}={L}_{ii}-{‖{c}_{i}‖}_{2}^{2} \end{array} $ | (22) |

此时, 求解式(19)归结于求解式(23):

| $ \begin{array}{c}j={\rm{argmax\;log}}\left({d}_{i}^{2}\right) \end{array} $ | (23) |

式(23)求解后, 新的电影j被选择到

| $ \begin{array}{c}{c}_{i}{{'}}=\left[\begin{array}{cc}{c}_{i}& \dfrac{\left({L}_{ji}-\left\langle{{c}_{j}, {c}_{i}}\right\rangle\right)}{{d}_{j}}\end{array}\right]\triangleq \left[\begin{array}{cc}{c}_{i}& {e}_{i}\end{array}\right] \end{array} $ | (24) |

| $ \begin{array}{c}{d}_{i}{{'}^2}={L}_{ii}-{‖{c}_{i}{{'}}‖}_{2}^{2}={d}_{i}^{2}-{e}_{i}^{2} \end{array} $ | (25) |

使用贪心算法完成行列式点过程的MAP求解, 算法的每一次迭代都会推荐一部新的电影, 我们只需要根据模型需要设置终止条件, 即可快速实现电影的多样性推荐.

2 实验当前多模态推荐使用的公开数据集主要有Amazon商品数据集、Book-Crossing数据集、MovieLens数据集、KWAI短视频数据集等. 亚马逊和Book-Crossing数据集包含的物品模态均为图像和音频, KWAI中包含了快手平台提供的短视频以及相应的文字介绍, MovieLens平台提供了电影的简介数据以及相应电影的IMDB网页链接, 可以由此获取到相应的电影预告片视频. 本文的实验使用MovieLens进行实验.

为了使音频信息能够在计算效率较高的同时拥有更为丰富的多元信息, 考虑到电影的预告片中拥有具有代表性的人物对话、环境声音、有些预告片甚至有相应的主题曲配乐, 因此本文选用电影预告片的音频作为原始信息. 我们选取电影海报作为推荐系统的图像模态输入, 与视频中的画面帧相比, 电影海报图像与输入的声音具有更好的模态互补性. 通过爬虫爬取了IMDB网站[27]上相应电影的文字介绍、电影海报和预告片音频作为3个模态的信息, 构建起的最终数据集的统计数据如表2和表3所示.

| 表 2 MovieLens-100k数据统计表 |

| 表 3 MovieLens-100k物品多模态数据统计表 |

2.1 实验设计

本文的实验环境采用Windows 10操作系统, CPU配置为Core i7-5820K CPU@3.30 GHz, 内存为32 GB; GPU为GTX TITAN X, 显存为12 GB, 使用Python 3.9进行代码编写, 实验框架为基于TensorFlow 2.6.0的深度学习框架, 同时, 本文使用Cornac[28]作为多模态推荐系统的基准比较框架.

本文所使用的优化器为Adam优化器, 训练集、测试集与验证集的数据的比例为8:1:1, 关于实验中使用到的其他超参数, 我们经过调试后对其进行设置, 如表4所示.

| 表 4 实验过程参数设置表 |

2.2 评测指标

本文的实验使用推荐系统两个阶段指标: 召回阶段使用归一化折现累计增益(NDCG), 排序阶段使用AUC进行衡量, 能够相对全面真实地对模型进行评价. 对于这两个指标来说, 结果均是越大越好.

归一化折现累计增益(NDCG)用于衡量长度为k的推荐列表与理想排名的接近程度:

| $ \begin{array}{c}DCG@k=\displaystyle\sum _{i=1}^{k}\dfrac{rel\left(i\right)}{{\rm{log}}_{2}\left(i+1\right)} \end{array} $ | (26) |

| $ \begin{array}{c}NDCG@k=\dfrac{DCG}{IDCG} \end{array} $ | (27) |

其中,

AUC能够反映模型的排序能力, 它反映的是一个相对性:

| $ \begin{array}{c}AUC{(R)}_{n}=\dfrac{1}{\left|R\right|\left(n-\left|R\right|\right)}\displaystyle\sum _{r\in R}\displaystyle\sum _{{r}{{'}}\in 1, \cdots , n\backslash R}\delta \left(r < {r}{{'}}\right) \end{array} $ | (28) |

其中, R为推荐的item集合,

同时, 为了评测多样性推荐的效果, 本文使用ILAD和ILMD两个评测指标:

ILAD表示所有用户推荐列表中电影之间的平均距离(负相关性), 计算方法如式(29)所示:

| $ \begin{array}{c}ILAD=\underset{{u}\in {U}}{\mathrm{m}\mathrm{e}\mathrm{a}\mathrm{n}}\underset{{i}, {j}\in {R}_{u}, i\ne j}{\mathrm{m}\mathrm{e}\mathrm{a}\mathrm{n}}(1-{S}_{ij}) \end{array} $ | (29) |

其中,

ILMD表示所有用户推荐列表中电影之间的平均最小距离, 计算方法如式(30)所示:

| $ \begin{array}{c}ILMD=\underset{{u}\in {U}}{\mathrm{m}\mathrm{e}\mathrm{a}\mathrm{n}}\underset{{i}, {j}\in {R}_{u}, i\ne j}{\mathrm{m}\mathrm{i}\mathrm{n}}(1-{S}_{ij}) \end{array} $ | (30) |

1)

2)

3)

4)

5)

1)

2) MSD[33]: MSD是基于最大边缘算法(MMR)的改进, 同样使用物品对于用户的相关性及物品间的相似度, 构建新的目标函数以更加全面地衡量推荐列表的多样性.

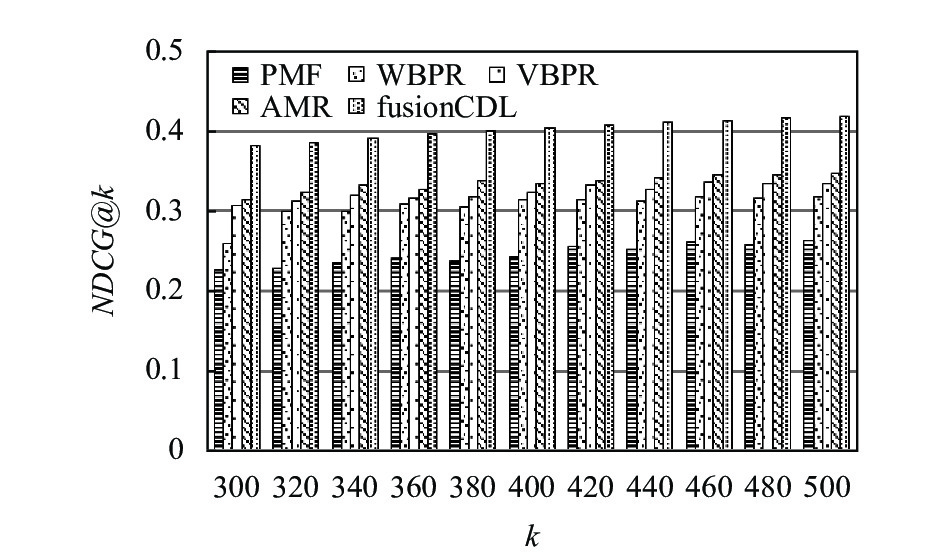

2.4 实验结果与讨论 2.4.1 与其他算法的比较表5展示了本文模型与其他基线模型在MovieLens-100k上NDCG指标的实验结果, 实验表明, 与基准实验相比, 本文的fusionCDL模型在推荐列表长度不同时, 均拥有最好的实验结果. 在多样性整合推荐之前先生成了较大的推荐列表用于多样性选择, 将推荐列表长度设置为300–500进行初步的融合与推荐准确性衡量. 实验结果中, 随着k值的增大, NDCG有缓慢上升, 这与现实情况相符. 同时, k的取值不同时, 推荐结果在NDCG这一指标上在均有最好的结果, 证明了本文算法的有效性.

| 表 5 本文模型与对比算法实验结果表(NDCG) |

对初步推荐结果NDCG指标进行可视化如图3所示. 从图中可以明显看出, 在NDCG这一指标上, 之前的模型结果提升并不明显, 但fusionCDL相比之前的结果提升了21.2%左右, 效果十分显著, 说明模态融合能够大幅提升推荐算法的性能.

|

图 3 推荐列表长度k对NDCG的影响 |

表6展示了本文模型与其他基线模型在MovieLens-100k上AUC指标的实验结果, 本文在AUC这一指标上相对于PMF等模型拥有了显著的提高. 作为查全率和查准率的综合指标, AUC结果超过0.92, 且与融合了较好鲁棒性的多模态模型AMR相比, 实验结果也有相应提高, 证明了本文多模态融合推荐模型较好的综合性能.

| 表 6 本文模型与对比算法实验结果表(AUC) |

在进行多样性的推荐时, 我们将最终推荐列表长度设置为10, 从初步推荐列表的500个结果中使用FGDPP进行迭代, 以生成最终的多样性推荐结果, 实验结果如表7所示. 对比算法MMR与MSD给出的推荐电影列表间的平均距离(ILAD)与平均最小距离(ILMD)分别超过了0.6与0.5, 这表明对比算法的实验结果已经具有较好的多样性. 在此基础上, 本文采用的FGDPP算法的实验结果在推荐多样性上有了进一步的提升, 在给用户推荐相关电影的基础上, 显著提高了电影之间的多样性.

| 表 7 多样性实验结果对比表 |

2.4.2 消融实验

本文使用了文本、图像、音频3种模态的融合信息作为辅助信息, 为了更好地验证这3种模态信息以及融合模块对模型的贡献, 设计了如下消融实验.

首先在单模态和级联模态上进行了对比实验, 实验结果如表8所示. 可以看到, 对于级联方法, 将3种模态同时进行级联时AUC结果最好, 由此可以看出多模态特征对于推荐精排具有重要意义. 同时, 在单模态特征上, 图像模态作为辅助特征时实验结果最好, 说明视觉观感对于电影推荐拥有比文本、音频更为重要的意义. 除此以外, 在NDCG这一指标上, 单模态的结果比多模态结果要好, 分析原因是简单级联使得特征向量拥有较多冗余特征且没有充分考虑模态之间的交互, 从而使得NDCG结果有明显下降.

我们对模态融合进行研究, 旨在探究哪种模态对于融合结果影响最大, 以及三分支两阶段的融合方式是否能够提高模型性能. 对于两种模态的融合我们使用单分支单阶段的张量融合方法. 从表8中可以看出, 一方面, 模态融合之后, NDCG结果有显著提升, 证明了融合模态对于推荐模型的有效性; 另一方面, 在几种融合方式中, 3种模态的三分支两阶段融合的NDCG与AUC均达到了最好的实验结果, 证明了本文特征融合算法的有效性. 同时, 在多种组合中, 融合了图像模态的推荐结果中, NDCG和AUC指标均较高, 这也说明了视觉图像对于电影推荐重要意义, 与单模态和级联模态上的结果相符.

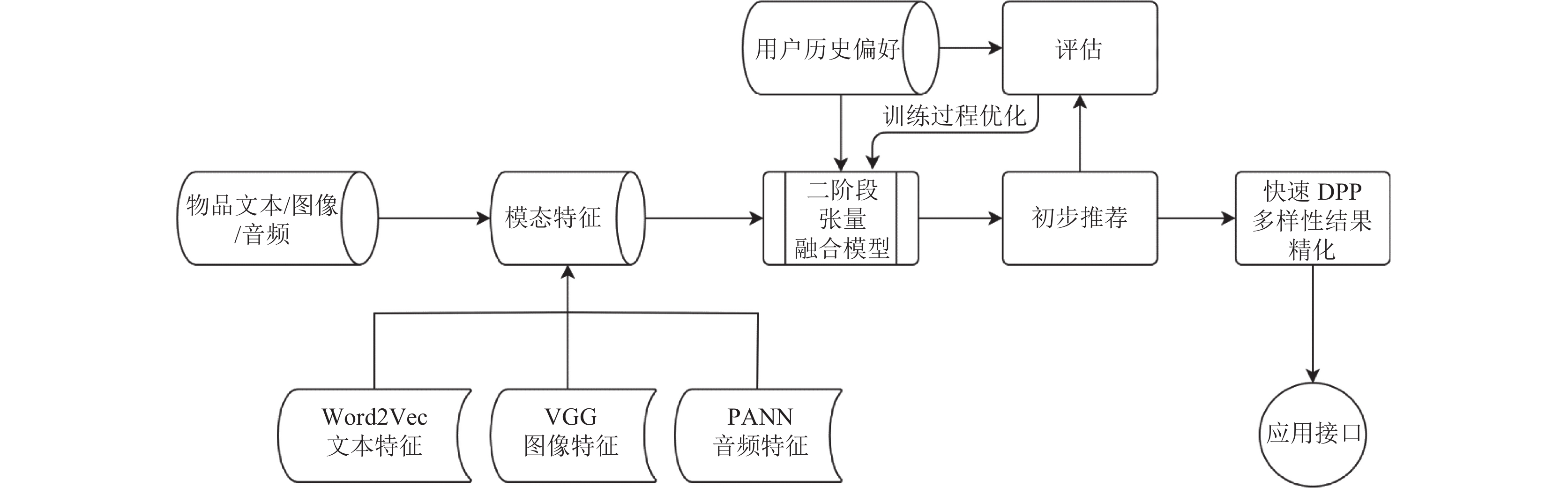

2.4.3 系统应用本文构建了基于文本、图像、音频3种模态融合和基于DPP多样化结果精化的多模态推荐系统, 其特点如下: ① 输入3种模态数据, 系统的适用场景较为广泛; ② 使用张量融合方法生成物品的多模态特征向量, 能够提高推荐系统的推荐性能; ③ 进行多样性的结果精化, 从而提高推荐结果的多样性.

本文构建出了软件系统的应用模式, 如图4和图5所示, 系统的输入为当前数据库中物品的文本、图像和音频, 提取模态特征并与用户历史偏好信息一起输入本文模型中, 得到初步推荐结果后再进行多样性结果精化, 最后使用接口形式方便用户调用.

| 表 8 融合模态与单模态和级联模态的比较 |

|

图 4 系统流程图 |

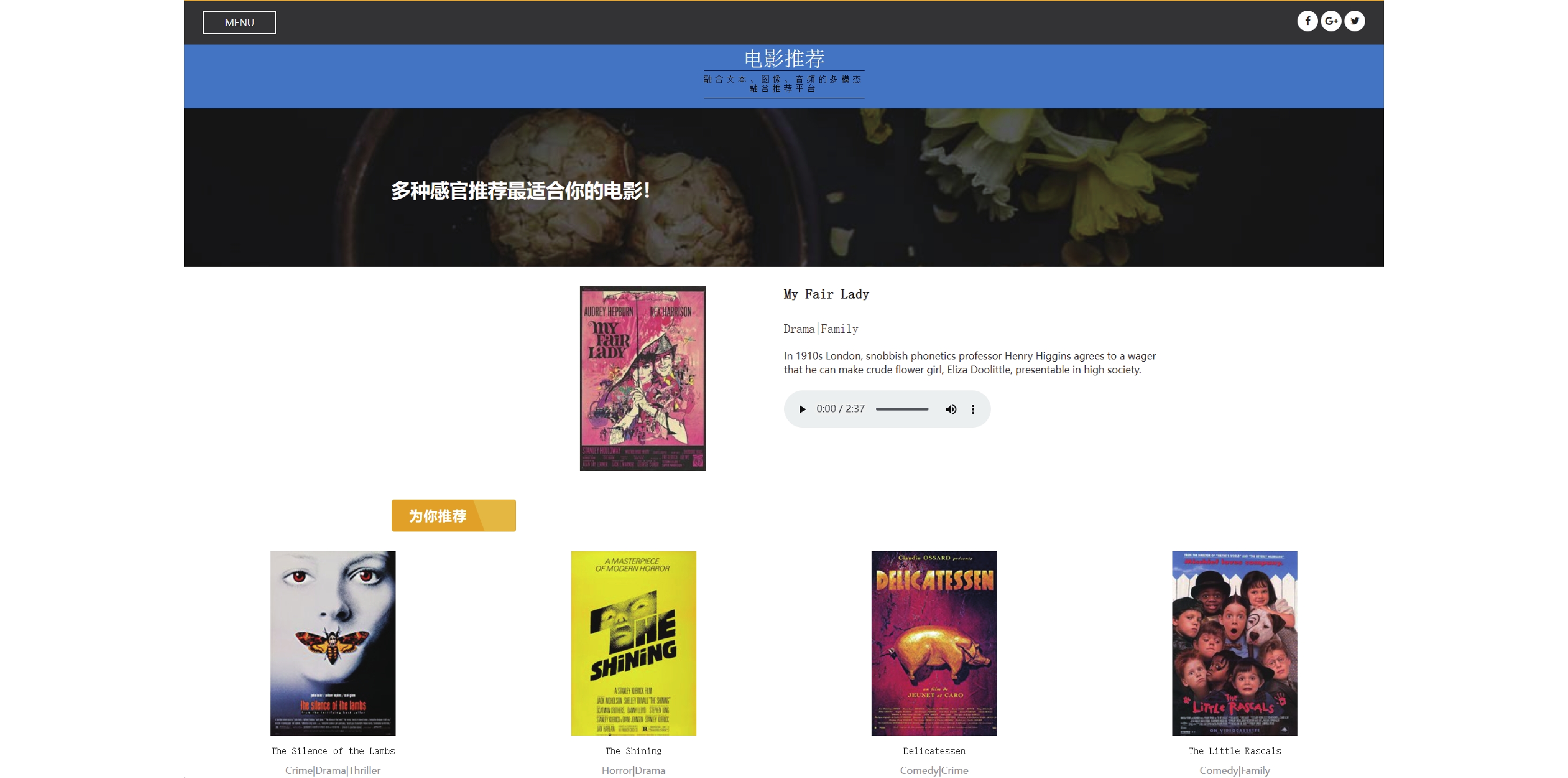

图6为本系统将MovieLens数据应用于电影平台的推荐样例, 本文为了使推荐结果更加清晰, 仅挑选一个用户推荐结果的图片以及电影标签进行展示, 可以看到, 上述电影虽然所属类别有共通之处, 但是各有不同, 能够充分满足用户在追求原有兴趣的同时探索多样结果的需求.

本文所提出的推荐系统, 不仅能够广泛应用于当前各类视频平台和音乐推荐中; 而且, 在各类线上展览、线上博物馆等平台更加注重沉浸式体验的当下, 使用展品图片、背景音频和文字介绍3种模态融合进行的推荐能够提升推荐系统的个性化程度, 从而带来更好的用户观览体验.

3 总结与讨论本文使用基于张量网络的多模态算法, 使用文本、图像、音频3种模态数据经过两个阶段的张量网络融合生成融合特征, 在此融合特征的基础上进行深度协同过滤推荐, 之后再将推荐结果通过快速多样性算法将推荐结果进行多样化精化. 通过对比实验, 本文模型在NDCG这一指标上拥有显著提升, 在AUC这一指标上也具有最先进的实验结果, 证明了本文推荐模型较好的性能. 同时, 在多样性推荐方面上也实现了较好的结果, 实现了一个较为完备的推荐系统, 基于多模态数据的推荐系统具有较高的精确性和推荐结果多样性, 具有很好的实用性.

在改进与提升方面, 加入多样性推荐之后NDCG指标有相应下降, 分析原因是多样性训练过程并没有加入到整个模型的训练过程中. 即, 初次生成推荐列表之后加入多样性模块会对推荐有一定影响, 未来可以在整个模型的训练过程中进行多样性与准确性的综合考量.

|

图 5 软件架构图 |

|

图 6 系统推荐样例 |

| [1] |

Dong X, Yu L, Wu ZH, et al. A hybrid collaborative filtering model with deep structure for recommender systems. Proceedings of the 31st AAAI Conference on Artificial Intelligence. San Francisco: AAAI Press, 2017. 1309–1315.

|

| [2] |

Truong QT, Salah A, Tran TB, et al. Exploring cross-modality utilization in recommender systems. IEEE Internet Computing, 2021, 25(4): 50-57. DOI:10.1109/MIC.2021.3059027 |

| [3] |

Wei J, He JH, Chen K, et al. Collaborative filtering and deep learning based recommendation system for cold start items. Expert Systems with Applications, 2017, 69: 29-39. DOI:10.1016/j.eswa.2016.09.040 |

| [4] |

Frolov E, Oseledets I. HybridSVD: When collaborative information is not enough. Proceedings of the 13th ACM Conference on Recommender Systems. Copenhagen: ACM, 2019. 331–339.

|

| [5] |

Lei CY, Li D, Li WP, et al. Comparative deep learning of hybrid representations for image recommendations. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Vegas: IEEE, 2016. 2545–2553.

|

| [6] |

Tang JH, Du XY, He XN, et al. Adversarial training towards robust multimedia recommender system. IEEE Transactions on Knowledge and Data Engineering, 2020, 32(5): 855-867. DOI:10.1109/TKDE.2019.2893638 |

| [7] |

Qiu RH, Wang S, Chen Z, et al. CausalRec: Causal inference for visual debiasing in visually-aware recommendation. Proceedings of the 29th ACM International Conference on Multimedia. New York: ACM, 2021. 3844–3852.

|

| [8] |

Oramas S, Nieto O, Sordo M, et al. A deep multimodal approach for cold-start music recommendation. Proceedings of the 2nd Workshop on Deep Learning for Recommender Systems. Como: ACM, 2017. 32–37.

|

| [9] |

Sun MX, Li F, Zhang J. A multi-modality deep network for cold-start recommendation. Big Data and Cognitive Computing, 2018, 2(1): 7. DOI:10.3390/bdcc2010007 |

| [10] |

肖庆华, 刘学军, 施浩杰. 多模态下的互补物品的多样性推荐. 小型微型计算机系统, 2021, 42(9): 1859-1864. DOI:10.3969/j.issn.1000-1220.2021.09.010 |

| [11] |

Huang PY, Patrick M, Hu JJ, et al. Multilingual multimodal pre-training for zero-shot cross-lingual transfer of vision-language models. Proceedings of the 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Online: Association for Computational Linguistics, 2021. 2443–2459.

|

| [12] |

Wang SN, Zhang JJ, Zong CQ. Associative multichannel autoencoder for multimodal word representation. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: Association for Computational Linguistics, 2018. 115–124.

|

| [13] |

Zadeh A, Liang PP, Morency LP. Foundations of multimodal Co-learning. Information Fusion, 2020, 64: 188-193. DOI:10.1016/j.inffus.2020.06.001 |

| [14] |

Liu J, Zhu XX, Liu F, et al. OPT: Omni-perception pre-trainer for cross-modal understanding and generation. arXiv: 2107.00249, 2021.

|

| [15] |

Hou M, Tang JJ, Zhang JH, et al. Deep multimodal multilinear fusion with high-order polynomial pooling. Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver: Curran Associates Inc., 2019. 12156–12166.

|

| [16] |

梁美玉, 王笑笑, 杜军平. 基于多模态图和对抗哈希注意力网络的跨媒体细粒度表示学习. 模式识别与人工智能, 2022, 35(3): 195-206. DOI:10.16451/j.cnki.issn1003-6059.202203001 |

| [17] |

Lin TY, RoyChowdhury A, Maji S. Bilinear CNN models for fine-grained visual recognition. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 1449–1457.

|

| [18] |

Zadeh A, Chen MH, Poria S, et al. Tensor fusion network for multimodal sentiment analysis. Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen: Association for Computational Linguistics, 2017. 1103–1114.

|

| [19] |

Al-Assam S, Clark SR, Jaksch D. The tensor network theory library. Journal of Statistical Mechanics: Theory and Experiment, 2017, 2017: 093102. DOI:10.1088/1742-5468/aa7df3 |

| [20] |

徐俊, 张政, 杜宣萱, 等. 基于项目语义的协同过滤冷启动推荐算法研究. 小型微型计算机系统, 2021, 42(11): 2246-2251. DOI:10.3969/j.issn.1000-1220.2021.11.002 |

| [21] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. Proceedings of the 3rd International Conference on Learning Representations. San Diego: ICLR, 2015.

|

| [22] |

Kong QQ, Cao Y, Iqbal T, et al. PANNs: Large-scale pretrained audio neural networks for audio pattern recognition. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2020, 28: 2880-2894. DOI:10.1109/TASLP.2020.3030497 |

| [23] |

Wang H, Wang NY, Yeung DY. Collaborative deep learning for recommender systems. Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. Sydney: ACM, 2015. 1235–1244.

|

| [24] |

Koren Y, Bell R, Volinsky C. Matrix factorization techniques for recommender systems. Computer, 2009, 42(8): 30-37. DOI:10.1109/MC.2009.263 |

| [25] |

Kulesza A, Taskar B. Determinantal point processes for machine learning. Foundations and Trends® in Machine Learning, 2012, 5(2–3): 123–286.

|

| [26] |

Chen LM, Zhang GX, Zhou HN. Fast Greedy MAP inference for determinantal point process to improve recommendation diversity. Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal: Curran Associates Inc., 2018. 5627–5638.

|

| [27] |

IMDb: Ratings, reviews, and where to watch the best movies & TV shows. https://mungfali.com/post/2B6635BC5C356BA561ED0C20A770FA2019262FA4. [2022-04-10].

|

| [28] |

Salah A, Truong QT, Lauw HW. Cornac: A comparative framework for multimodal recommender systems. Journal of Machine Learning Research, 2020, 21(95): 1-5. |

| [29] |

Salakhutdinov RR, Mnih A. Probabilistic matrix factorization. Proceedings of the 20th International Conference on Neural Information Processing Systems. Vancouver: Curran Associates Inc., 2007. 1257–1264.

|

| [30] |

Gantner Z, Drumond L, Freudenthaler C, et al. Personalized ranking for non-uniformly sampled items. Journal of Machine Learning Research, 2012, 18: 231-247. |

| [31] |

He RN, McAuley J. VBPR: Visual Bayesian personalized ranking from implicit feedback. Proceedings of the 30th AAAI Conference on Artificial Intelligence. Phoenix: AAAI Press, 2016. 144–150.

|

| [32] |

Carbonell J, Goldstein J. The use of MMR, diversity-based reranking for reordering documents and producing summaries. Proceedings of the 21st Annual International ACM SIGIR Conference on Research and Development in Information Retrieval. Melbourne: ACM, 1998. 335–336.

|

| [33] |

Borodin A, Lee HC, Ye YL. Max-sum diversification, monotone submodular functions and dynamic updates. Proceedings of the 31st ACM SIGMOD-SIGACT-SIGAI Symposium on Principles of Database Systems. Scottsdale: ACM, 2012. 155–166.

|

2023, Vol. 32

2023, Vol. 32