随着工业现代化的飞速发展, 国内的导光板厂商开始陆续尝试自动光学检测方法(AOI)进行导光板质检. AOI是以机器视觉技术为基础的缺陷检测技术, AOI是解决目前传统检测效率低、工人成本高问题的最有效方法. 广泛应用于PCB等相关行业的检测中. 稳定的AOI检测是目前导光板检测的发展方向.

2019年Ming等人提出了一种基于机器视觉的导光板(LPG)缺陷检测新方法. 在图像分割和增强之后, 对所提出的具有动态权重的组合分类器(CCDW)进行训练[1]. 导光板图像有背景复杂、对比度低、亮度不均、各种缺陷特征差异大等特点. 基于机器视觉和机器学习的传统检测方法需要提取手动特征, 鲁棒性差. 难以满足导光板在线缺陷检测的抗干扰性、检测精度、实时性等方面的需求.

近年来, 许多深度学习缺陷检测方法被广泛应用于LCD等工业领域. 并且在导光板缺陷检测领域也开始了一些初步的尝试. 2021年Li等人提出了一种用于手机导光板缺陷检测的端到端多任务学习网络架构. 同过U型编码结构获取多尺度特征, 并采用特征融合与多尺度特征交互[2]. Hong等人提出了一个密集双线性卷积神经网络(BCNN), 一个端到端缺陷检测网络[3]. 何炎森针对车载导航导光板缺陷, 结合轻量化与级联网络提出了一种缺陷快速检测方法[4].

导光板的缺陷检测要求相对高, 大部分缺陷, 如亮点、暗点、线划痕和压痕小于0.1 mm. 检测的精度需要大于99%, 每个导光板需要在12 s内检测到. 一般来说, 基于深度学习分类网络的缺陷检测只能获得粗略的位置. 相对而言, 目标检测网络可以获取目标的准确位置和类别信息. 目标检测模型可以分为两大类: 两阶段和一阶段网络. 两阶段网络需要在目标检测之前生成可能包含缺陷的候选区域, 主要是包括R-CNN[5]、Faster R-CNN[6]等网络. 一阶段网络通过从网络中提取的特征直接进行缺陷检测和识别, 主要包括YOLO[7, 8]系列和SSD[9]等网络. 检测速度更快, 目前在导光板缺陷检测问题上已经取得了很好的效果, 2022年Yao等人提出一种用于LGP缺陷检测的AYOLOv3-Tiny网络[10]. 对传统的 YOLOv3-Tiny主干部分的卷积操作进行改进, 满足了工业检测需求, 验证了YOLO模型在导光板缺陷检测任务上的优秀性能.

YOLOv5融合了YOLO系列版本的优点, 在检测速度和精度上都更优秀. 但是为了实现本文大尺寸导光板图像背景下对小目标缺陷的检测, 还需要对YOLOv5的网络结构进行相应的调整和改进. 因此本文结合导光板的缺陷特征和检测要求, 提出了一种基于改进YOLOv5s的大尺寸导光板缺陷检测算法.

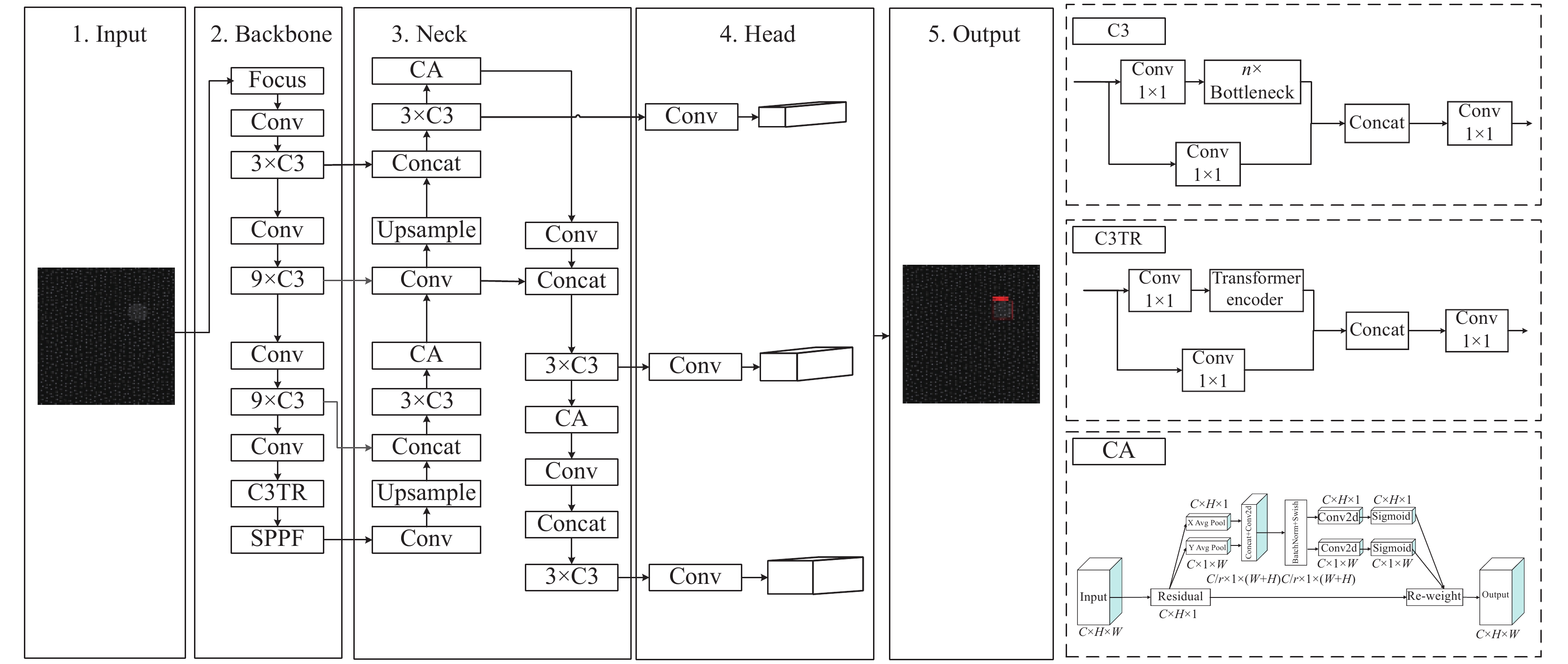

2 改进的YOLOv5s算法YOLOv5根据不同CSP结构的深度和宽度主要将模型分为4种: YOLOv5s、YOLOv5l、YOLOv5m、YOLOv5x. 模型依次增大, 推理时间依次延长, 考虑到算法的实时性, 本文选择YOLOv5s为基础架构进行改进. 图1为改进后的YOLOv5s网络结构图, 由Input、Backbone、Neck、Head组成, 本文将Backbone部分倒数第2层的C3模块替换为C3TR模块并将coordinate attention注意力机制[11]集成到Neck部分, 在激活函数方面选择了Meta-ACON[12], 在损失函数方面选择

|

图 1 AYOLOv5s网络结构 |

2.1 分图输入

本文待检导光板的尺寸为12–17英寸. 导光板的缺陷检测要求相对较高, 且导光板尺寸太大. 因此, 本文采用16k线阵相机获取高质量的图像. 图2为采集后的导光板图像, 为了适应不同尺寸导光板, 采集后的导光板图像分辨率统一为25000×16384≈4.1 亿个像素, 而小的缺陷仅为7个像素左右, 缺陷尺寸和图像背景差距悬殊, 无法直接进行检测, 因此考虑到算法的可实现性, 需要采用逐行扫描的方式进行检测. 本文首先将获得的完整导光板图像进行分图, 裁剪成数张640×640的小图后再通过算法进行滑窗检测. 从图2采集的导光板图像可以看出, 我们只需裁剪真正的导光板区域即可, 即18064×13548个像素的感兴趣区域. 值得注意的是由于导光板进料时非常稳定, 所以提取感兴趣区域时不需复杂操作, 只需根据相应尺寸提前设置好区域坐标即可. 为了消除边界缺陷的漏检, 设置的大小为10个像素的重叠区域overlap, 那么步长就为630个像素点. 从左上角开始切图, 切出来图像的左上角记为x, y, 那么可以容易想到y依次为: 0, 630, 1260, …, 17 010但接下来却并非是17 640, 因为17640+640>18064, 所以这里要对切图的overlap做一个调整, 最后一步的y=18064–640, 基于此就可完成将所有感兴趣区域切成小图, 将裁剪后的小图通过Mosaic数据增强后输入主干特征提取网络.

|

图 2 采集的导光板图像 |

2.2 基于Transformer的主干特征提取网络

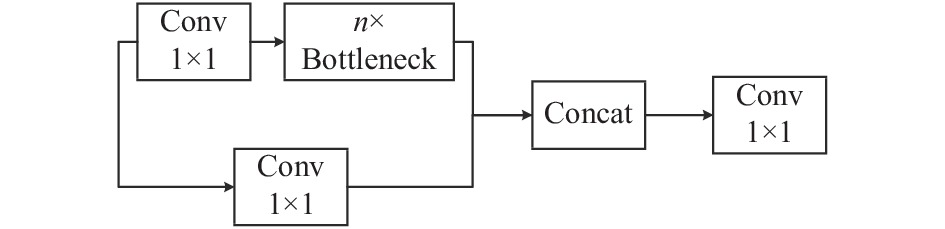

YOLOv5的主干部分采用了Focus下采样、改进CSP结构、SPPF池化金字塔结构提取图片的特征信息. YOLOv5所使用的主干特征提取网络为CSPDarknet, 都由残差卷积构成, 残差网络能够通过增加相当的深度来提高准确率. 其内部的残差块使用了跳跃连接, 缓解了在深度神经网络中增加深度带来的梯度消失问题. 图3为C3模块结构图, YOLOv5使用的C3模块结构是将原来的残差块的堆叠进行了一个拆分, 如图3所示由两个分支组成, 一个分支使用了多个Bottleneck堆叠和1个标准卷积层, 另一支仅经过一个基本卷积模块, 最后将两支进行Concat操作.

|

图 3 C3模块结构 |

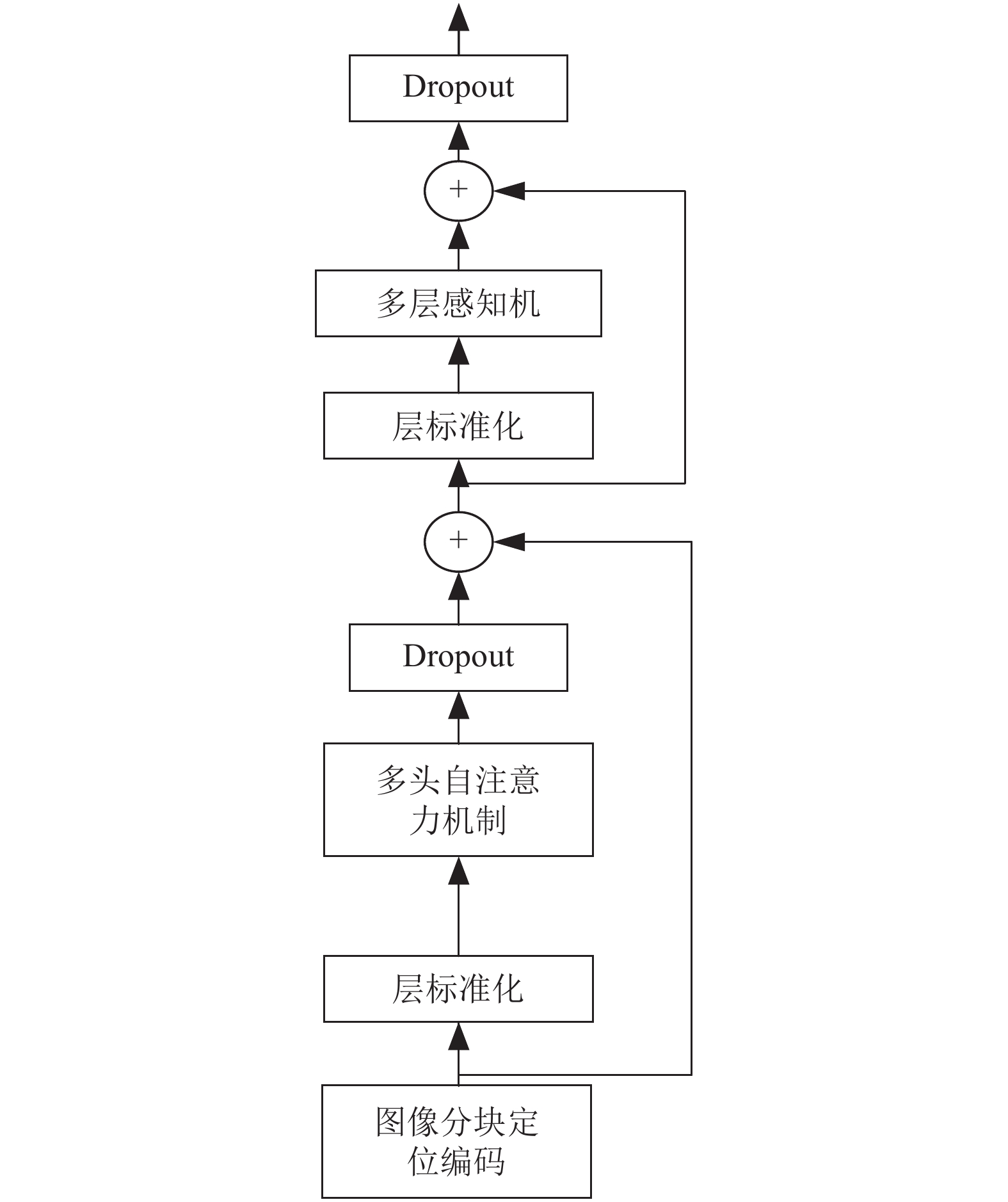

Zhu等人[13]在TPH-YOLOv5中用Transformer 编码块替代了YOLOv5中的一些卷积块和CSP bottlenck blocks, 其结构如下图4所示. Transformer中的基本成分, 包括多头自注意力机制 (multi-head self-attention, MSA)、多层感知机 (multi-layer perceptron, MLP)和层标准化 (layer normalization, LN)与CSPDarknet53中的bottleneck blocks相比, Transformer可以捕获全局信息和丰富的上下文信息. TPH-YOLOv5通过这种集成Transformer的结构使YOLOv5在小目标检测的任务上取得了更好的性能, 但是提升模型精度的同时也不可避免的增加了图像的推理时间.

|

图 4 Transformer 编码器结构 |

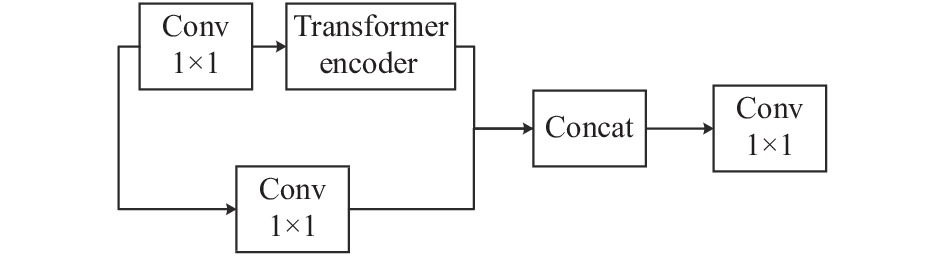

对于小目标来说, 一般在卷积的深层才能体现特征, 所以本文的思路是将Transformer加到YOLOv5s的主干网络的最后一个C3模块中, 这样就可以利用Transformer的特性及将注意力的方式更好捕获对小目标有利的信息上, 从而更好地方便后期特征提取和检测. 使用Transformer 编码器结构替换原YOLOv5中C3模块中的Bottleneck , 组成新的C3TR模块, C3TR的结构如图5所示.

|

图 5 C3TR模块结构 |

2.3 基于coordinate attention的特征融合网络

YOLOv5的特征融合主要采用FPN+PAN的特征金字塔结构, 实现了不同尺寸目标特征信息的传递, 解决了多尺度问题.

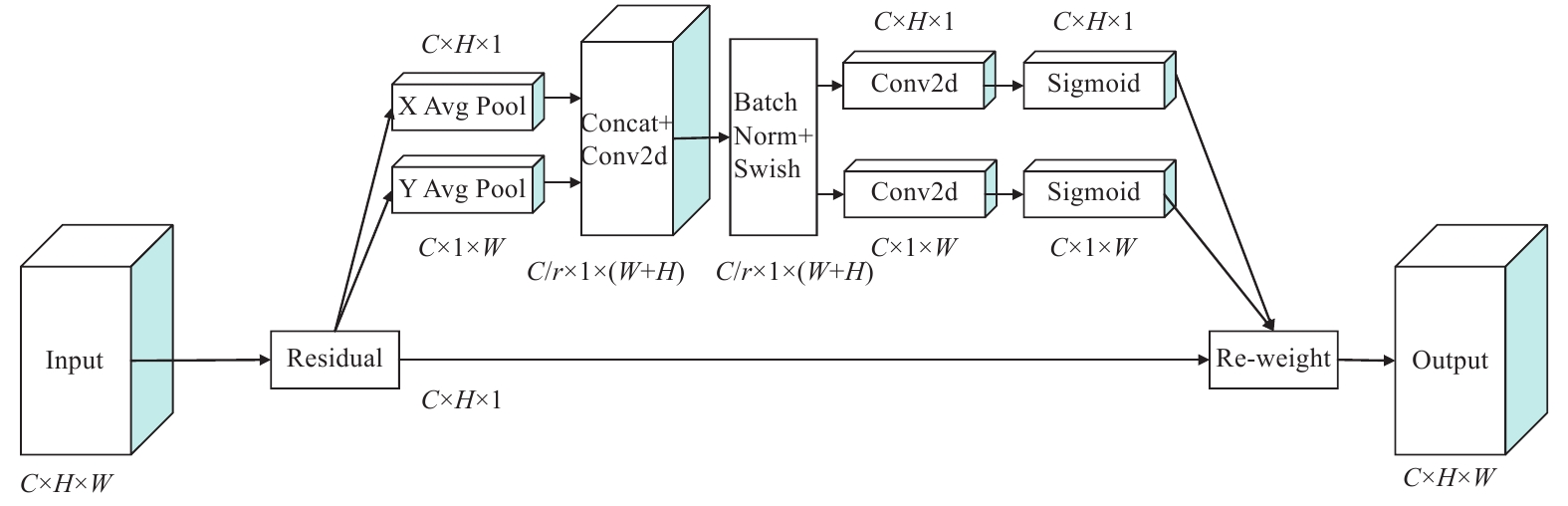

本文在使用卷积神经网络去处理导光板图像的时候, 更期望卷积神经网络去注意存在缺陷的地方, 而不是关注整个导光板图像背景, 这种期望无法通过手动调节来实现, 因此, 该思考的就是如何让卷积神经网络去自适应的注意导光板图像中的缺陷位置. 注意力机制就是实现思考的一种方式. Coordinate attention (CA)是Hou等人[11]提出的新的注意力机制. 图6为CA注意力模块结构图, 从图中可以看出CA分别在垂直和水平两个方向通过平均池化的方式得到两个一维向量, 在空间维度上Concat连接和1×1卷积来压缩通道, 然后通过BN和Non-linear来编码水平和垂直两个方向的空间信息, 接着进行分裂, 再各自通过1×1卷积得到和输入特征图一样的通道数, 最后归一化加权.

|

图 6 CA注意力模块结构 |

注意力机制是个即插即用的模块, 可以集成到任何CNN架构中, 并且不会对网络增加很大负担. 本文中在特征融合网络中插入CA注意力模块, 使用CA可以更加注意线缺陷的特征信息, 进而提高线缺陷的准确率.

2.4 激活函数选择Ma等人[12]提出了一个简单、有效、通用的激活函数, 称之为ACON, 它可以学习并决定是否要激活神经元, 然后又进一步提出了Meta-ACON, 它明确地学习优化非线性(激活)和线性(非激活)之间的参数切换. 作者提出一种新颖的Swish函数解释: Swish函数是ReLU函数的平滑近似(smooth maximum), 并基于这个发现, 进一步分析ReLU的一般形式Maxout系列激活函数, 利用smooth maximum将Maxout系列扩展得到简单且有效的ACON系列激活函数: ACON-A、ACON-B、ACON-C. 表1为Maxout和ACON系列激活函数的总结. 把

| 表 1 Maxout和ACON系列激活函数 |

ACON激活函数通过β来控制是否激活神经元(β为0则不激活). Meta-ACON设计了自适应函数来计算平滑因子. 提出一个G(x)模块由输入特征图x(C×H×W)来动态的学习β, 以达到自适应控制函数线性/非线性能力, 这种定制的激活行为有助于提高泛化和传递性能. 自适应函数包含了layer-wise, channel-wise, pixel-wise这3种空间, 分别对应的是层, 通道, 像素. Meta-ACON选择了通道空间, 首先分别对H, W维度求均值, 然后通过两个卷积层, 使得每一个通道所有像素共享一个权重, 公式如下:

| $ {\beta _c} = \sigma {W_1}{W_2}\sum\limits_{{{h}} = 1}^{{H}} {\sum\limits_{w = 1}^W {{x_{c, h, w}}} } $ | (1) |

其中, 每个通道共享参数β, 得到的β大小为C×1×1, 其中W是1×1卷积的参数, 有W1(C, C/r), W2(C, C/r), r为缩放参数, 设置为16. x首先在H和W维度上求均值, 然后经过两层1×1卷积, 最后由Sigmoid激活函数得到一个(0, 1)的值, 用于控制是否激活.

ACON可以很自然地应用于对象检测和语义分割, 这表明ACON在各种任务中是一种有效的替代方案. 因此本文将Meta-ACON激活函数应用到改进后的缺陷检测网络模型之中.

2.5 AYOLOv5s损失函数| $ Loss = {\lambda _{{\rm{box}}}}{L_{{\rm{box}}}} + {\lambda _{{\rm{conf}}}}{L_{{\rm{conf}}}} + {\lambda _{{\rm{cls}}}}{L_{{\rm{cls}}}} $ | (2) |

其中,

本文选择

| $ {L_{CIoU}} = 1 - IoU + \frac{{{\rho ^2}(b, {b^{gt}})}}{{{c^2}}} + \alpha \upsilon $ | (3) |

| $ \alpha = \frac{\upsilon }{{(1 - IoU) + \upsilon }} $ | (4) |

| $ \upsilon = \frac{4}{{{\pi ^2}}}{\left(\arctan \frac{{{\omega ^{gt}}}}{{{h^{gt}}}} - \arctan \frac{\omega }{h}\right)^2} $ | (5) |

其中,

| $ \begin{split} {L_{{\rm{conf}}}} = &{\lambda _{{\rm{obj}}}}\sum\limits_{i = 0}^{{s^2}} {\sum\limits_{j = 0}^B {I_{ij}^{{\rm{obj}}}{{({C_i} - {{\hat C}_i})}^2}} } \\ & + {\lambda _{{\rm{noobj}}}}\sum\limits_{i = 0}^{{s^2}} {\sum\limits_{j = 0}^B {I_{ij}^{{\rm{noobj}}}{{({C_i} - {{\hat C}_i})}^2}} } \end{split} $ | (6) |

| $ \begin{split} &{L_{{\rm{cls}}}} = \\ &\sum\limits_{i = 0}^{{s^2}} {\sum\limits_{j = 0}^B {I_{ij}^{{\rm{obj}}}} } \sum\limits_{c \in classes} {[{{\hat p}_i}(c)\log ({P_i}(c)) + (1 - {{\hat p}_i}(c))\log (1 - {p_i}(c))]} \end{split}$ | (7) |

其中,

本文主要针对导光板的亮点、压伤、划伤、脏污、异物、黑点、曲面斑纹等缺陷进行研究. 由于这些导光板的分类主观性较强, 实际成像上, 缺陷之间没有较明显的界限, 因此本文根据生产厂家的技术要求、一线工人的工作经验和导光板的成像特点, 将这些缺陷分为点缺陷和线缺陷两类, 图7为导光板缺陷分类情况.

|

图 7 导光板缺陷分类 |

导光板缺陷数据集(LGPDD)来自于真实的工业领域. 包含12–17英寸内的共500张导光板, 经过分图预处理后, 获得640×640的小图后制作数据集, 本文通过数据扩充来平衡两种缺陷的数量. 数据增强包括以50%的概率旋转, 120%–150%的亮度增强. 扩展后数据集具体参数如表2所示.

| 表 2 LGPDD数据集参数 |

3.2 实验环境与模型训练

本文实验的具体配置为: Windows 10操作系统、单RTX2060显卡、Python 3.7虚拟环境、PyTorch 1.7深度学习开源框架, CUDA11进行加速. 本文在自建数据集上将改进后的YOLOv5s模型与原始YOLOv5s进行对比实验, 代码参考YOLOv5官方代码6.1版本. 迭代次数为300 epoch, 优化器选择SGD, 初始学习率为0.01, 动量参数为0.937并采用epoch为3、动量参数为0.8的warmup方法预学习, 在warmup阶段, 采用一维线性插值更新学习率, 预学习结束后采用余弦退火对学习率进行更新. 训练过程中每完成一次迭代就会进入一次验证阶段. 每一次迭代后自动更新权重文件.

3.3 评价指标与实验结果分析本文评估指标采用平均精度均值(mAP)和每秒检测图片的帧数(FPS)这两种在目标检测算法中较为常见的评价指标来评估本文算法的性能. 平均精度与精确率(precision, P)和召回率(recall,R)有关, 精确率是指预测数据集中预测正确的正样本个数除以被模型预测为正样本的个数; 召回率是指预测数据集中预测正确的正样本个数除以实际为正样本的个数. mAP计算中的AP即P-R曲线下方面积, 具体计算基于式(8)–式(11):

| $ mAP = \frac{{\displaystyle\sum\limits_{i = 1}^N {A{P_i}} }}{N} $ | (8) |

| $ AP = \int_0^1 {P(R)dR} $ | (9) |

| $ P = \frac{{TP}}{{TP + FP}} $ | (10) |

| $ R = \frac{{TP}}{{TP + FN}} $ | (11) |

其中, AP值是指P-R曲线面积; mAP的值是通过所有类别的AP求均值得到; N表示检测的类别总数, 本实验中N=2, mAP的值越大, 表示算法检测效果越好, 识别精度越高; TP、FP和FN分别表示正确检测框、误检框和漏检框的数量.

为了评估AYOLOv5s网络的准确性和实时性本文在自建数据集LGPDD上进行了大量的实验, 图8为YOLOv5s和AYOLOv5s在训练过程中box_loss、cls_loss、mAP@0.5、mAP@0.5:0.95的曲线图. mAP@0.5代表在IoU阈值为0.5时的平均AP, mAP@0.5:0.95代表在IoU阈值为从0.5到0.95, 步长为0.05时各个mAP的平均值. mAP@0.5主要用于体现模型的识别能力, mAP@0.5:0.95 由于要求的IoU阈值更高, 主要用于体现定位效果以及边界回归能力, 通过观察训练过程中不同模型的曲线可以看出本文改进的YOLOv5s网络收敛效果优于原版本YOLOv5s模型, 说明AYOLOv5s面对导光板缺陷这种小目标的特征具有更好的学习能力.

|

图 8 训练过程中box_loss、cls_loss、mAP@0.5、mAP@0.5:0.95曲线 |

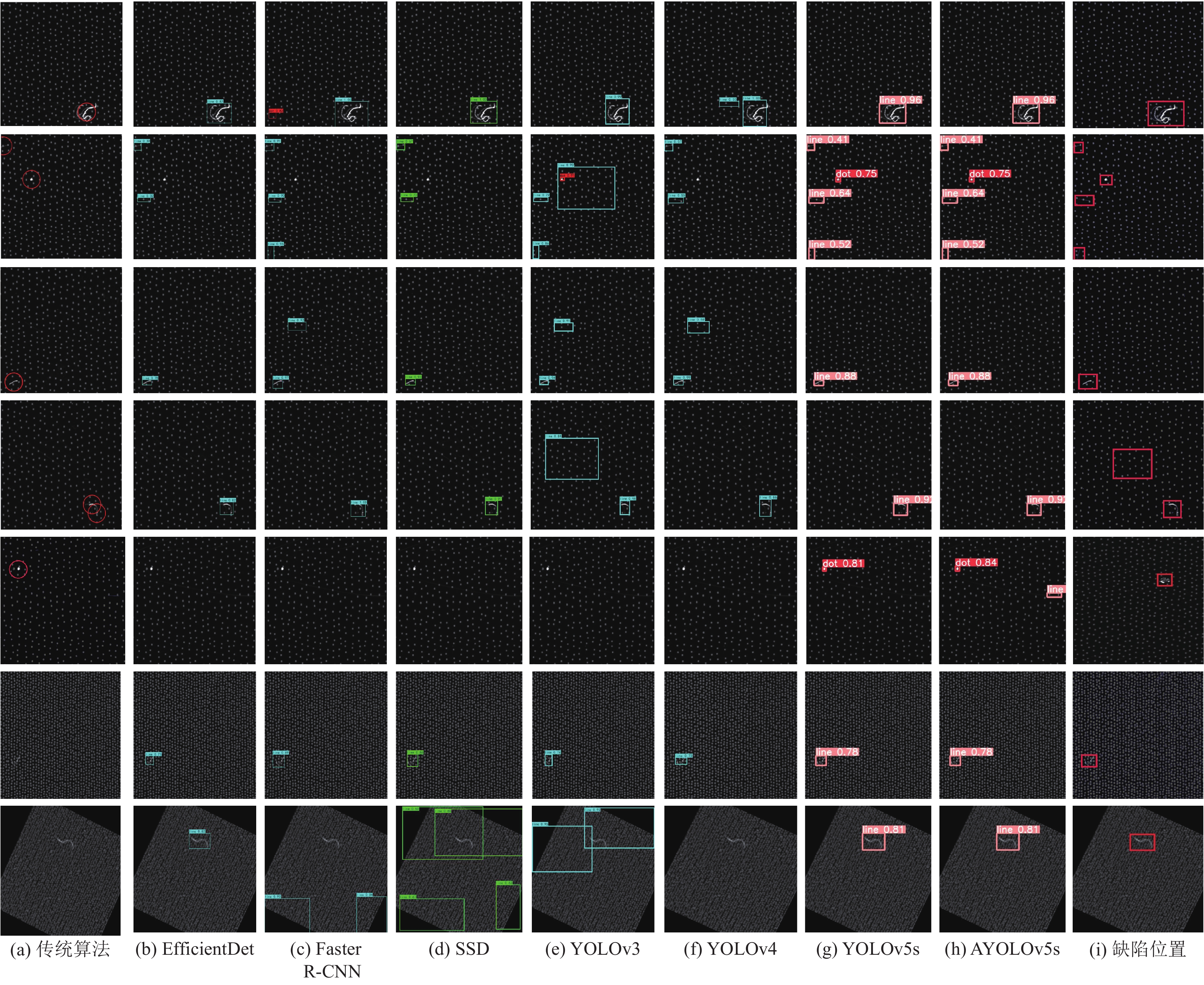

此外, 通过mAP和FPS, 将AYOLOv5s网络与SSD、YOLOv3、EfficientDet[15]、Faster R-CNN等目标检测网络进行了比较. 图9为各模型在LGPDD上部分测试结果, 表3为实验结果汇总.

|

图 9 各类算法结果对比 |

| 表 3 实验结果汇总 |

从表3可以看出, 随着YOLO系列网络的发展, YOLOv5s相较于其他经典缺陷检测算法有着更好的性能. 但是, YOLOv5s的检测精度并不满足导光板生产的要求, AYOLOv5s在点和线缺陷的准确性上有显著提高, 但FPS略有下降. 与YOLOv5s相比, AYOLOv5s对缺陷的平均检测精度提高了1.7%, 但FPS降低了24.5%. 由于网络的复杂性较高, 体积增加导致速度降低. 虽然AYOLOv5s的检测速度有损失, 但仍然可以满足基于导光板生产过程的实时检测要求, AYOLOv5s可以实现在12 s/pcs内对尺寸为17英寸的导光板中的亮点、划伤、异物、磕碰伤、脏污等缺陷具有较好的实际检测效果.

4 总结本文根据导光板的光学特性、缺陷形成原理和成像特性, 提出了一种用于大尺寸导光板缺陷检测的AYOLOv5s网络. 分别从输入端、主干特征提取网络、特征融合网络、激活函数、损失函数5个方面进行改进, 有效地提高了YOLOv5s网络模型对图像中细微缺陷的检测精度, 改进后的算法检测速率相较于原始YOLOv5s算法有所降低, 但仍能满足实时性要求, 可以满足导光板缺陷检测高速和高精度的实际生产需求.

| [1] |

Ming WY, Shen F, Zhang HM, et al. Defect detection of LGP based on combined classifier with dynamic weights. Measurement, 2019, 143: 211-225. DOI:10.1016/j.measurement.2019.04.087 |

| [2] |

Li Y, Li JF. An end-to-end defect detection method for mobile phone light guide plate via multitask learning. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 1-13. |

| [3] |

Hong LB, Wu XL, Zhou DB, et al. Effective defect detection method based on bilinear texture features for LGPs. IEEE Access, 2021, 9: 147958-147966. DOI:10.1109/ACCESS.2021.3111410 |

| [4] |

何炎森. 基于机器学习的车载导航导光板质量视觉检测系统研究[硕士学位论文]. 杭州: 浙江理工大学, 2021.

|

| [5] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [6] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2015. 91–99.

|

| [7] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [8] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934v1, 2020.

|

| [9] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Cham: Springer, 2016. 21–37.

|

| [10] |

Yao JH, Li JF. AYOLOv3-Tiny: An improved convolutional neural network architecture for real-time defect detection of PAD light guide plates. Computers in Industry, 2022, 136: 103588. DOI:10.1016/j.compind.2021.103588 |

| [11] |

Hou QB, Zhou DQ, Feng JS. Coordinate attention for efficient mobile network design. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13713–13722.

|

| [12] |

Ma NN, Zhang XY, Liu M, et al. Activate or not: Learning customized activation. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 8032–8042.

|

| [13] |

Zhu XK, Lyu SC, Wang X, et al. TPH-YOLOv5: Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 2778–2788.

|

| [14] |

Zheng ZH, Wang P, Ren DW, et al. Enhancing geometric factors in model learning and inference for object detection and instance segmentation. IEEE Transactions on Cybernetics, 2021, 52(8): 8574-8586. |

| [15] |

Tan MX, Pang RM, Le QV. EfficientDet: Scalable and efficient object detection. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 10778–10787.

|

2023, Vol. 32

2023, Vol. 32