2. 成都西图科技有限公司, 成都 610065

2. Chengdu Xitu Technology Co. Ltd., Chengdu 610065, China

由于地层中复杂的流体分布和地质结构, 油田在进入开发后期时难以进一步提升采收效率. 剩余油是油田经过水驱、聚驱以及复合驱等各种手段之后, 油藏储集层中的残油[1]. 为进一步提高油田的开发效果, 相关石油地质研究人员有必要对剩余油形态分布等特性展开研究[2]. 在实验室中, 主要通过微观驱替仿真模型完成对微观剩余油的分析. 实验人员仿照真实岩石薄片图像制作成玻璃刻蚀模型, 再将仿真模型注入石油至饱和状态, 最后依次注入水、化学剂等介质完成驱替[3]. 与此同时用显微镜连接高速工业相机对驱替过程进行采像, 形成一套完整的序列图像. 在驱替后期, 采收率几乎不再发生变化, 图像序列中的剩余油呈现不同的分布形态, 且随着驱替的进行, 其状态较为稳定[4].

由于实验方式、命名方式等的不同, 行业内对剩余油形态分类目前并没有形成统一的分类标准, 但有着相似的分类方法, 以至于同一类型的剩余油却存在多种名称的情况[5]. 根据分类依据的不同, 目前剩余油形态分类方法可大致分为两种方向. 第1种是基于剩余油形成原理的分类方法, 将形成原理划分为难以驱扫的孔隙死角、岩石壁面的亲油性、毛细管力的束缚性以及孔隙的非均质性等[6]. 由于该方法分类条件较为单一, 且不同的形成原理之间区分明显, 剩余油形态分类准确性相对较高[7]. 然而针对每一处的剩余油, 都需要结合孔隙特征分析其复杂的形成原理, 需要大量的计算量, 难以批量地应用到工程中大量的剩余油薄片的分析中.

第2种是目前主流的基于形态参数的剩余油分类方法. 根据剩余油本身的形态特征, 以及和岩石孔隙外在的接触条件[8], 主要将剩余油分为孤岛状、膜状、盲状(塞状、柱状)、簇状(条带状、网状)共6类[9]. 通过构建一系列参数, 如形状因子、凹度、最小外接矩形等来描述剩余油的形态特征. 剩余油形态各异, 其在形态参数数值上的表现也有着明显不同[10]. 因此程小龙等人[11]在上述形态参数的基础上, 结合机器学习中的K近邻(K-nearest neighbor, KNN)、支持向量机(support vector machine, SVM)等算法, 将人工标定好的数据集作为样本特征向量空间, 通过计算待分类样本与形态参数的欧氏距离来进行判定. 该分类方法的参数计算量较小, 在程序中可实现大规模的批量检测分类. 但由于判断分类条件易受人为主观因素的影响, 且人为所构建的形态参数并不能获取剩余油深层的形态特征, 使得识别模型通用性较差, 分类的准确率较低.

近年来, 随着计算机技术的不断更新, 基于深度学习的图像识别分类技术得到了快速的发展, 以卷积神经网络为代表的一系列分类网络模型应运而生, 如AlexNet[12]、GoogleNet[13]、VGGNet[14]等. 这些网络模型在大量的训练数据的基础上, 于前向传播的过程中根据任务需求自动提取图像的深层特征, 避免了人为因素对分类模型性能的影响, 分类准确性较高. 然而, 剩余油图像数据面临着类与类之间分布不均衡、小样本的问题, 难以将深度学习模型直接应用到剩余油形态分类中. 针对上述问题, 本文提出的分类算法主要分为数据集构建与增强、模型训练两个阶段. 在剩余油数据集构建与增强阶段, 针对有限的不均衡分布的剩余油数据, 采用辅助分类器生成对抗网络(auxiliary classifier GAN, ACGAN)[15]进行数据增强扩充, 增强后的图像数据集进行人为的预筛选, 使得最后用于训练的数据更加符合真实的剩余油分布. 在模型训练阶段, 本文基于VGG19模型, 通过引入SENet加强特征感知, 优化网络对剩余油目标特征提取能力. 用最终VGG19-SENet模型提取到的深层特征代替形状因子、矩形度、偏心率等形态参数所表示的表层特征, 使得模型分类的准确性得到大幅提升.

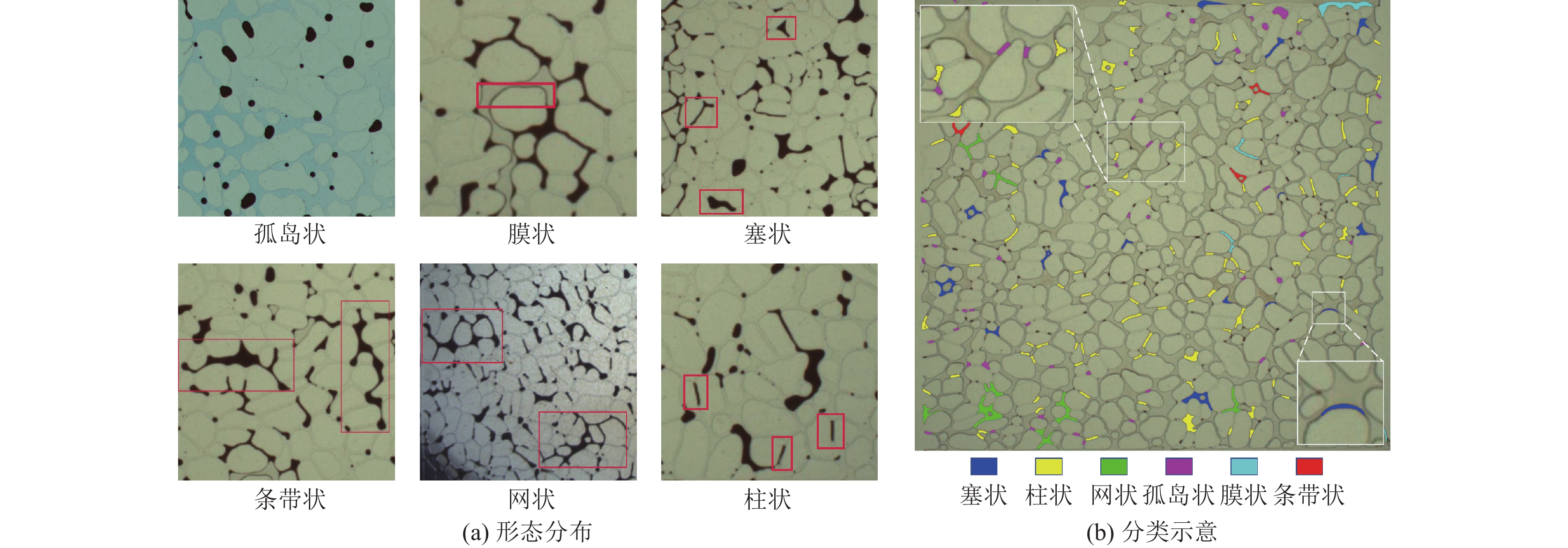

1 算法实现 1.1 剩余油形态参数及传统的分类标准剩余油的孤岛状、膜状、塞状、条带状、网状以及柱状的形态分布如图1(a)所示, 可以看出不同类别之间形态有着明显的差异. 其中, 孤岛状剩余油呈独立的滴状存在; 膜状剩余油由于岩石壁的亲油特性而呈薄膜状紧附在岩石表面; 柱状、塞状剩余油由于孔隙喉道太细、喉道处毛细管力和粘滞力太大等原因以孤立的盲状残留在连通孔隙的喉道处; 条带状和网状剩余油呈分布状充斥在大孔道包围的小喉道孔隙簇中, 其中条带状有明显的延伸趋势, 网状在孔隙喉道中呈网络分布, 并没有明显的纵长. 传统的分类方法是通过某些形态特征加以区分. 通过大量实验数据对比分析, 剩余油六种类别在形状因子、偏心率、凹度、最小外接矩形、矩形度等参数上有较好的鉴别力[16], 其计算公式以及所能反应的形状特征如表1所示.

通过上述对形态参数的分析, 并结合大量实验数据, 传统的剩余油形态分类方法可总结为以下步骤: 在数据预处理阶段, 需要对剩余油原始数据二值化, 再提取连通区域, 获得每个单一的剩余油目标; 针对单个目标计算其相应的形态参数, 通过设置特定的数值范围来完成对剩余油目标的形态判别. 但设定形态参数范围只能表征目标的表层形态特征, 针对一些特殊目标的鉴别能力不够. 如图1(b)所示, 其中的膜状、柱状并不能被有效地鉴别, 需要进一步获取每一类别剩余油的更深层特征, 以达到更高的分类准确度. 同时, 参数的范围设定受人为的影响较大.

|

图 1 剩余油分布及分类示意 |

| 表 1 形态参数描述 |

1.2 剩余油数据构建 1.2.1 整体框架

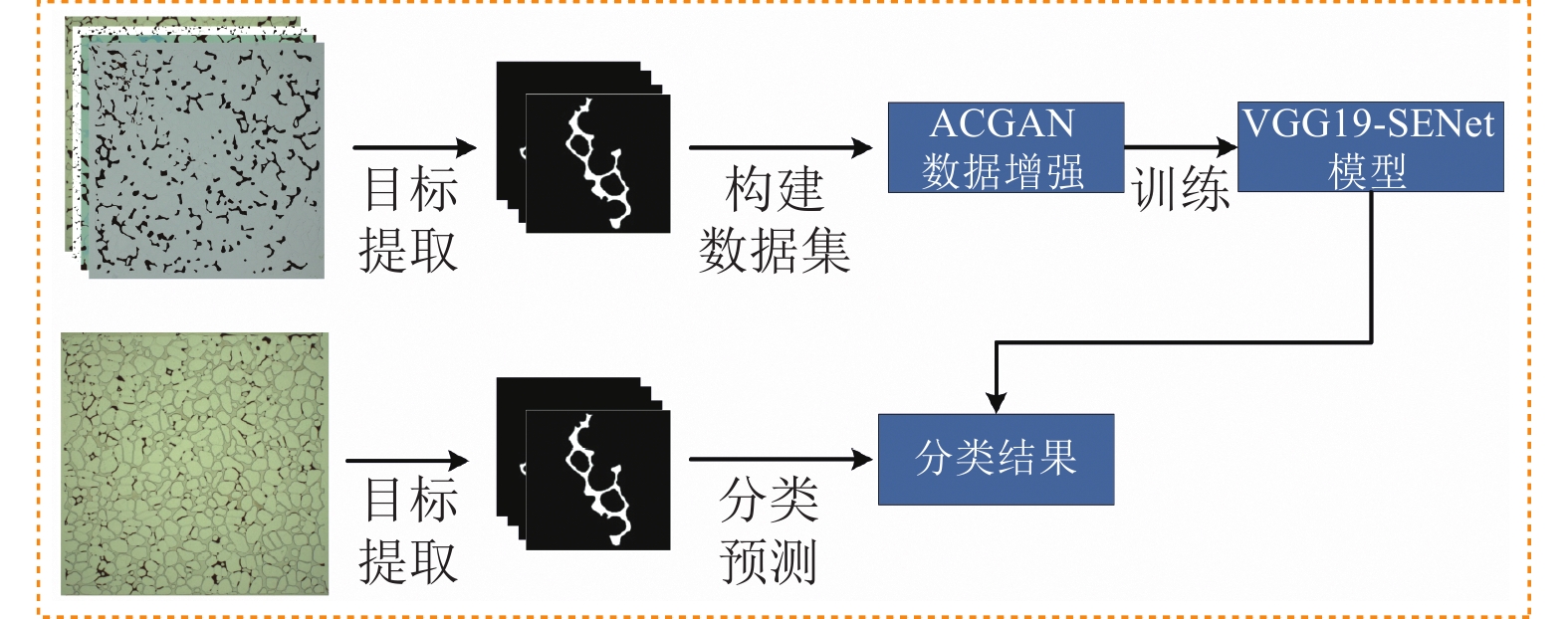

本文提出了一种基于深度学习剩余油形态分类方法, 算法的整体框架如图2所示, 主要分数据集构建以及预测分类两个部分. 原始的剩余油数据面临着总体数据量较大, 但针对具体某一类数据量较少的问题. 如图1(b)所示, 在驱替后期剩余油形态分布相对稳定时, 薄片中绝大多数分布的剩余油呈孤岛状, 而针对条带状、网状的剩余油目标极少, 造成了不同类别之间的数据量不平衡. 直接用传统的翻转、放大缩小等手段做数据增强往往会导致数据的多样性较差. 同时, 由于原始数据无明确标签, 人工标注的工作量很大. 针对上述样本量少, 缺乏多样性的问题, 在数据集构建阶段, 本文利用生成对抗网络ACGAN对原始数据进行数据增强, 极大地丰富了数据量以及数据之间的多样性. 为确保数据的真实性, 在数据增强网络前后用传统的形态参数以及人工标注完成预筛选. 在构建良好数据集的基础上, 采用VGG19作为基础网络, 通过引入SENet空间注意力机制增加相关特征通道的权重, 提升最终模型的分类性能. 在预测阶段, 将原始薄片中的剩余油目标单独提取出来后, 传入第1阶段训练完成的模型中, 得到最终的分类结果.

|

图 2 算法整体框架 |

1.2.2 ACGAN网络结构与生成原理

传统的生成对抗网络模型GAN的工作原理是输入一段噪声, 由生成器G生成目标图像, 连同真实图像输入到鉴别器D中, 由鉴别器鉴别该图像的真伪. 二者通过相互对抗博弈来达到生成器的生成结果足以以假乱真的程度. 但传统的GAN输入是一段随机噪声, 并不能指定生成图像的类别. 在本文项目中需要生成6种剩余油形态图像, 按原始GAN的思路需要针对每一类剩余油单独训练一种生成模型, 过程繁琐且工作量较大, 不适合应用到多类别生成任务当中.

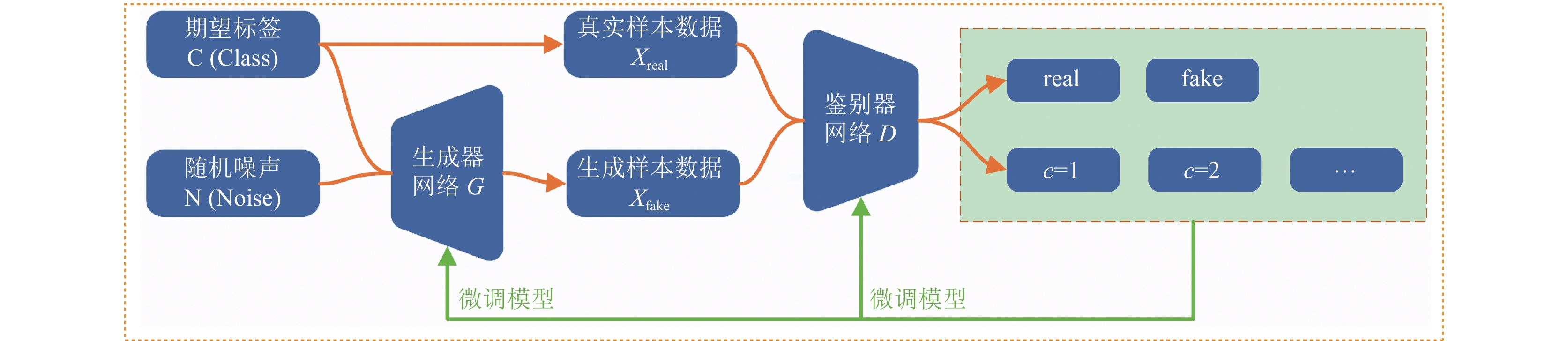

ACGAN是由Odena等人[15]于2017年提出的一种基于GAN的变种模型, 其结构如图3所示. 与传统GAN的网络结构不同的是, 生成器G的输入除了随机噪声z之外还有类别信息c, 鉴别器D的输出除了是否为真实图像的概率外还有其相应的类别概率. ACGAN的损失函数分为判别损失LS和分类损失LC, 如式(1)、式(2)所示, 其中LS表示鉴别器将正样本判定为正、负样本判定为负的能力, LC表示鉴别器将真假数据正确分类的能力. 生成器G的目标函数是最大化LC–LS, 鉴别器D的目标函数是最大化LC+LS. 通过带有辅助分类器的ACGAN可以适应多类别的图像生成任务.

| LS=E[logP(S=real|Xreal)]+E[logP(S=fake|Xfake)] | (1) |

| LC=E[logP(C=c|Xreal)]+E[logP(C=c|Xfake)] | (2) |

|

图 3 ACGAN框架结构图 |

1.3 分类网络模型设计 1.3.1 基础网络模型

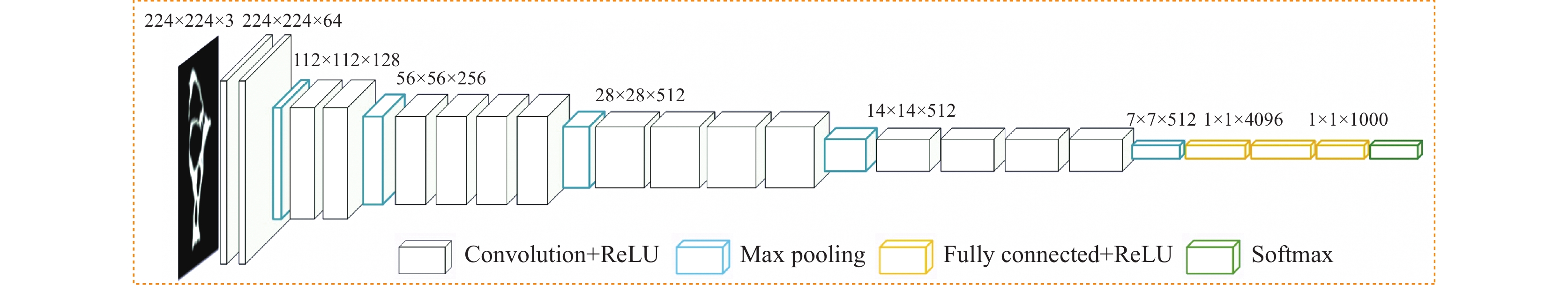

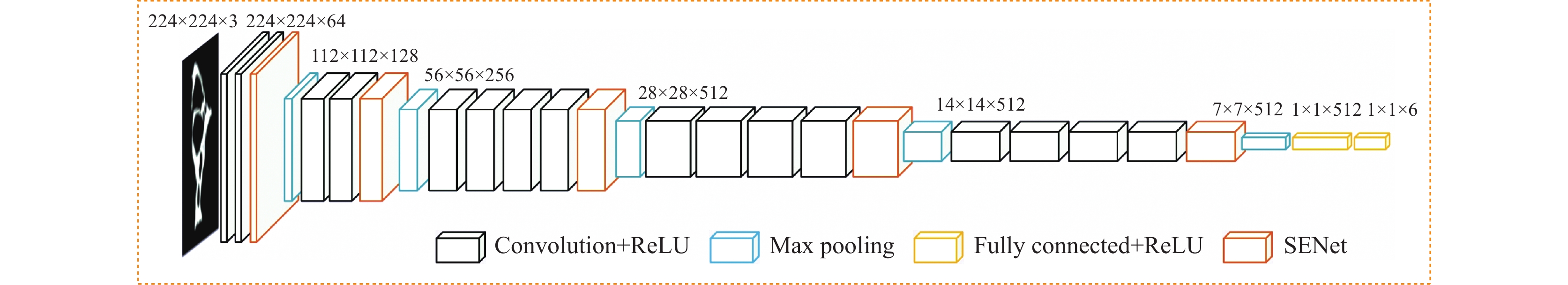

VGG模型是由牛津大学Simonyan等人[14]于2014年提出的一种通过增加卷积神经网络的深度来提高识别性能的网络. VGG模型有A–E共7种不同的层次结构, 基本上都是由3×3大小的卷积层和2×2大小的最大池化层有序组成. VGG网络在特征提取部分采用多个3×3的小卷积核叠加代替了以往的单个较大卷积核, 不仅确保了卷积层相同的感受野, 同时还减小了模型的参数量. 除此之外, 网络在每一层3×3卷积核之后加入了ReLU激活函数, 极大地提升了模型的非线性拟合能力. VGG模型由于其基于微小滤波器尺寸的设计, 被广泛用于图像分类和定位任务中. 本文采用的是VGG模型中的D结构, 即将VGG19作为剩余油图像的特征提取部分, 其网络结构如图4所示.

|

图 4 VGG19框架结构图 |

1.3.2 SENet注意力机制

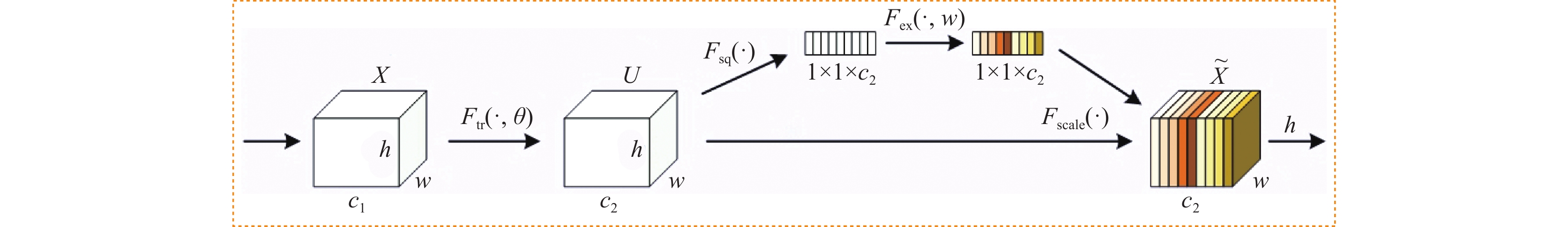

一般的CNN网络模型都是利用卷积操作来融合空间和通道的特征, 从而获取多维度多尺寸的空间特征信息. 但针对各种具体的图像分类任务, 各个通道所含的信息特征也就不同, 如果不加以区分各个通道, 在某种程度上于模型训练过程中会丢失图像的重要特征信息. 随着深度学习技术的发展, 为解决上述问题, 各种注意力机制在图像分类任务中得以广泛的应用, 其核心任务是让网络在提取特征时关注到模型更需要关注的特征信息. Hu等人于2017年提出了一种轻量级注意力机制模块(squeeze-and-excitation networks, SENet)[17], 可通过学习的方式来自动获取到每个特征通道的重要程度, 然后依照这个重要程度去提升有用的特征并抑制对当前任务用处不大的特征. 其结构如图5所示, 其中Fsq表示Sequence操作, Fex表示Excitation操作, Fscale表示Scale操作.

由于卷积只是在特征图的一个局部空间进行操作, 感受野较小, 难以获得足够的信息提取不同通道之间的关系. Squeeze操作公式如式(3)所示, 采用全局池化将一个通道上整个空间特征编码为一个全局特征, 将输入特征图的大小从(h, w)压缩至(1, 1).

| zc=Fsq(uc)=1h×wh∑i=1w∑j=1uc(i,j) | (3) |

在Squeeze的基础上, 对全局特征应用Excitation 方法, 强化学习各个通道之间的非线性联系, 获取不同通道的权重, 其公式如式(4)所示. 为了降低模型的复杂度以及泛化能力, 这里采用包含两个全连接层结构, 其中第一个全连接层起到降维的作用. Scale操作是将学习到的各个通道的激活值(Sigmoid激活, 值为0到1)乘以原始特征图, 生成全局最终目标特征. 通过上述的步骤, SENet注意力机制可以自适应的校正通道特征, 提取出待测图像中更加关键的信息, 引导网络对重点区域赋予更高的权值, 使得模型判断分类更加准确.

| s=Fex(z,W)=δ(g(z,W))=δ(W2ReLU(W1z)) | (4) |

|

图 5 SENet空间注意力机制结构图 |

1.3.3 完整模型设计

结合剩余油图像分类数据的实际情况, 基于VGG19基本网络模型和SENet空间注意力机制结构, 本文重新设计了新的特征提取主干网络. 如图6所示. 输入为224×224×3大小的剩余油图像, 在每一最大池化层之前插入SENet通道注意力机制. 最后一层最大池化层输出特征层为7×7×512大小, 通过展平处理变为1×1×4096的特征层, 通过两层全连接层变为剩余油图像分类任务所需要的1×1×6大小的张量. 由于模型训练过程中使用的损失函数是交叉熵函数, 该函数包含了Softmax函数, 可在模型输出时去掉Softmax层以减小空间. 同时, 本文模型使用了VGG19在ImageNet数据集上的预训练权重, 以达到损失函数快速收敛的目的.

|

图 6 VGG19-SENet框架结构图 |

2 实验结果与分析 2.1 数据集与数据预处理

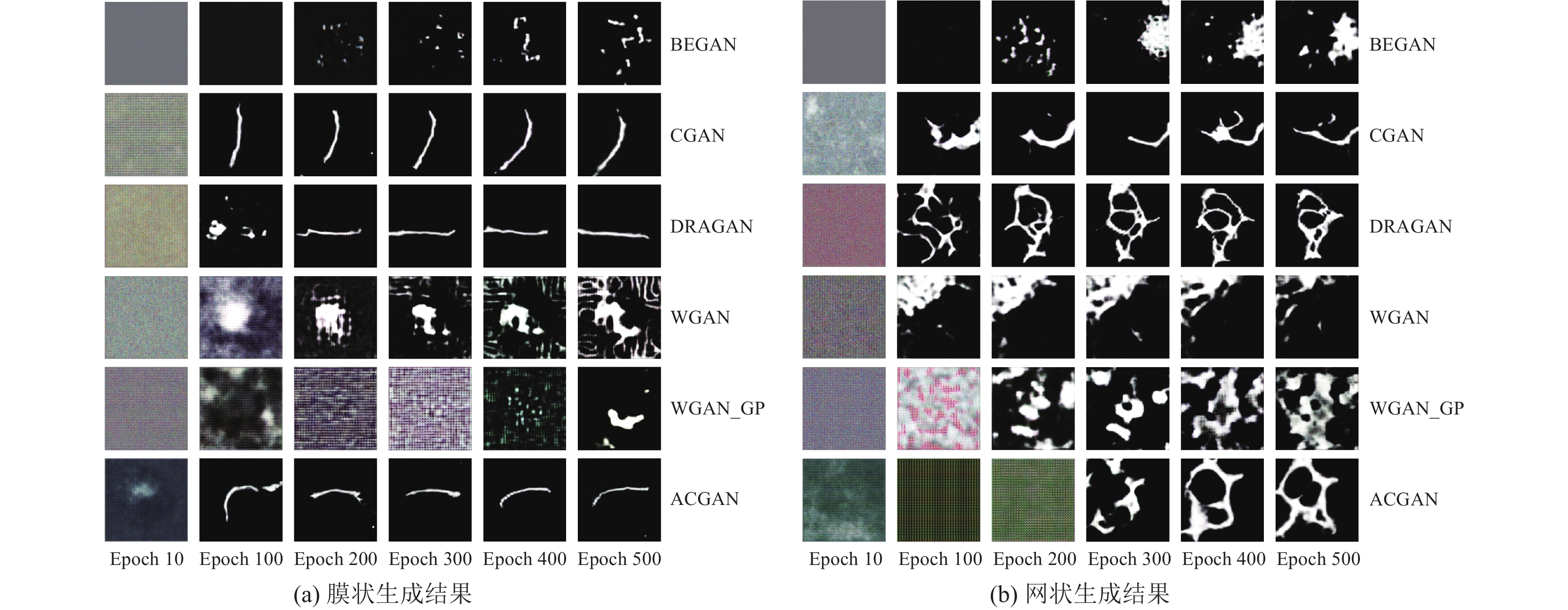

在数据集的构建阶段, 通过提取其连通区域获取每个单一的剩余油目标, 用传统的形态参数分类以及人工筛选的方式完成原始数据集的种类标定, 得到原始数据集. 将原始数据集二值化, 并统一缩放为224×224大小的图像. 通过实验了目前深度学习中常用的ACGAN、BEGAN、CGAN等多种生成对抗网络对原始数据集进行扩充增强测试, 选取其中的膜状、网状剩余油的生成结果为例, 如图7所示. 从直观层面来说, BEGAN模型生成效果较差, CGAN、DRGAN、WGAN、WGAN_GP对特定的形态效果较好, 但无法满足其他形态要求. 经过多轮迭代生成, 最终各类GAN模型的数据有效性如表2所示, 其中ACGAN生成数据的有效性较之其他的生成对抗模型最高. 实验最终采用ACGAN作为原始数据集的数据增强方式.

在分类模型的训练阶段, 构建完成数据集后, 为确保网络模型预测的真实有效性, 实验选取孤岛状、膜状、条带状等6类剩余油各3000张, 总计18000张剩余油形态图用于训练, 各类剩余油图像共1000张作为验证集, 各类剩余油图像共600张作为最终评价模型分类性能的测试集.

2.2 实验设置以及评价指标本文基于PyTorch 1.10.0、Cuda 10.2的开发环境完成实验网络的搭建以及模型的训练. 硬件环境以及训练的相关实验参数设置如表3所示.

|

图 7 各系列GAN生成结果 |

| 表 2 各类模型生成数据有效情况统计 |

| 表 3 实验参数设置 |

为评估剩余油形态分类系统的有效性, 本文采用图像分类任务中最常用的评价指标, 分别是准确率(Accuracy)、精确率(Precision)以及召回率(Recall). 其计算公式如式(5)–式(7)所示. 其中, 针对本文剩余油形态的多分类问题, 设当前考虑的类别为正样本, 则其他所有类别统一为负样本, 真实标签为正样本的剩余油目标被推断为正样本的数量用TP表示, 被推断为负样本的数量用FN表示; 真实标签为负样本的剩余油目标被推断为正样本的数量用FP表示, 被推断为负样本的数量用TN表示.

| Accuracy=TP+FPTP+FP+TN+FN | (5) |

| Precision=TPTP+FP | (6) |

| Recall=TPTP+FN | (7) |

由上述的定义, 准确率可表示所有样本中被正确识别的样本比例; 精确率可表示在全部预测为正的结果中, 被预测正确的正样本所占的比例; 召回率可表示所有为正的样本被预测正确的比例. 在图像分类任务中, 准确率、精确率以及召回率这3个指标可有效地评价模型的分类性能, 可为分类模型的对比、优化提供指导意见.

在训练各模型之前, 均加载了在ImageNet数据集上的预训练模型权重作迁移学习. 为验证本文方法的实际性能, 共设置了3组对比实验: 训练数据集数据增强前与增强后的分类性能对比、在引入SENet注意力机制的改进模型下、改进模型与原模型的分类性能对比以及改进模型与其他常见的分类模型的分类性能对比.

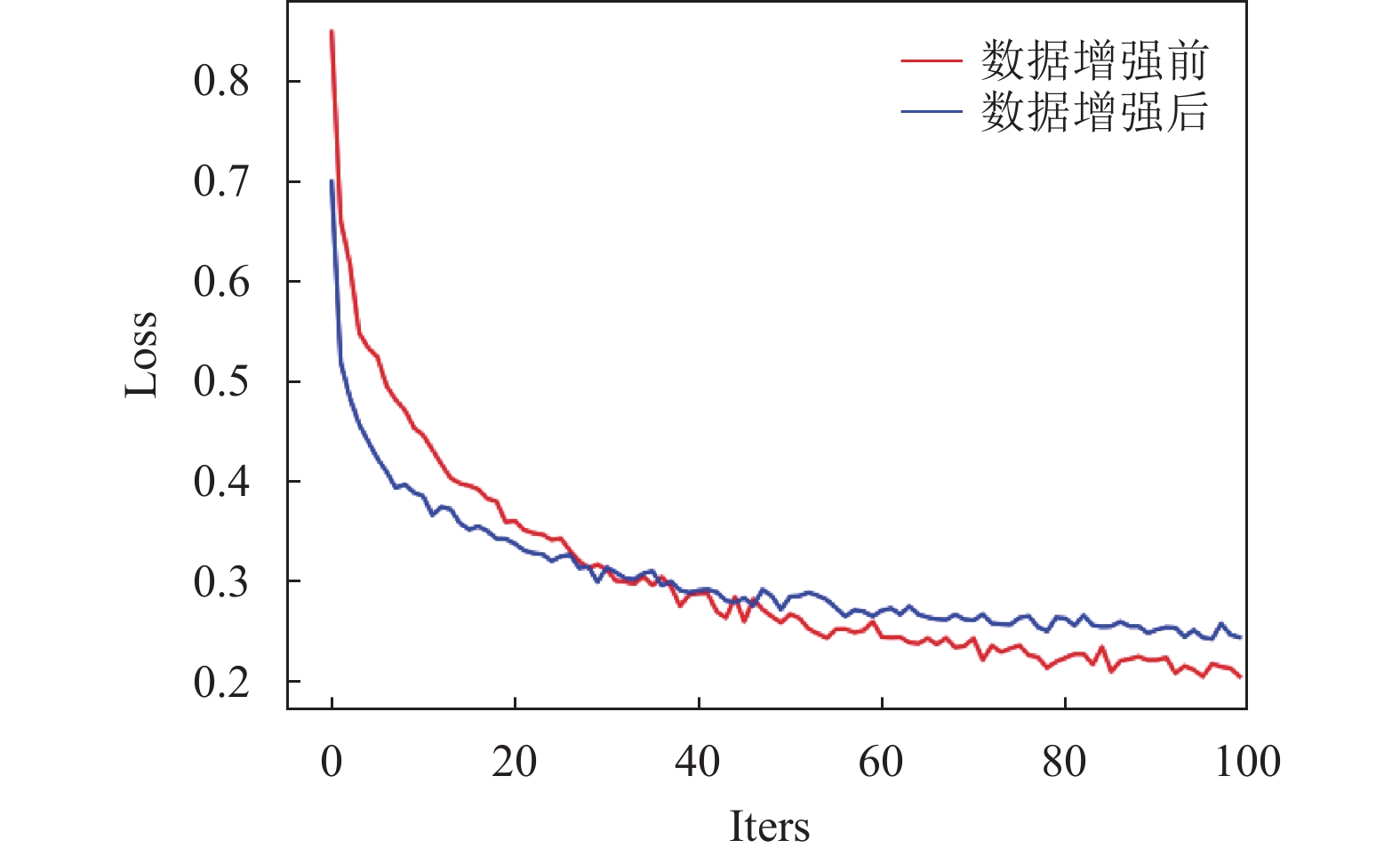

2.3 数据增强实验效果对比为验证数据增强手段对模型分类的实际提升能力, 在保证VGG19网络结构和SENet通道注意力优化机制相同的情况下, 分别将利用ACGAN数据增强前后的训练集输入模型中进行训练. 训练过程的损失曲线和最终的测试集分类情况如图8和表4所示. 由上述的实验结果可知, 在数据增强前的训练集上, 条带状、柱状剩余油在模型上的分类表现效果较差. 数据增强后的VGG19-SENet模型在条带状剩余油的精确率上较增强前提升了16个百分点, 在柱状剩余油上的精确率上提升了14个百分点; 整体上看, 模型在剩分类准确率上提升了7个百分点, 说明增强后的训练集对于模型的分类性能有着较大的提升. 同时, 结合增强前后模型的损失曲线分布情况和最终模型的分类效果可以看出, 数据增强操作可在一定程度上缓解了模型在数据集未增强时训练过程中出现的过拟合问题, 有效地强化了模型对各类剩余油的分类能力.

|

图 8 增强前后模型loss曲线 |

| 表 4 数据增强前后结果对比 |

2.4 组件消融实验

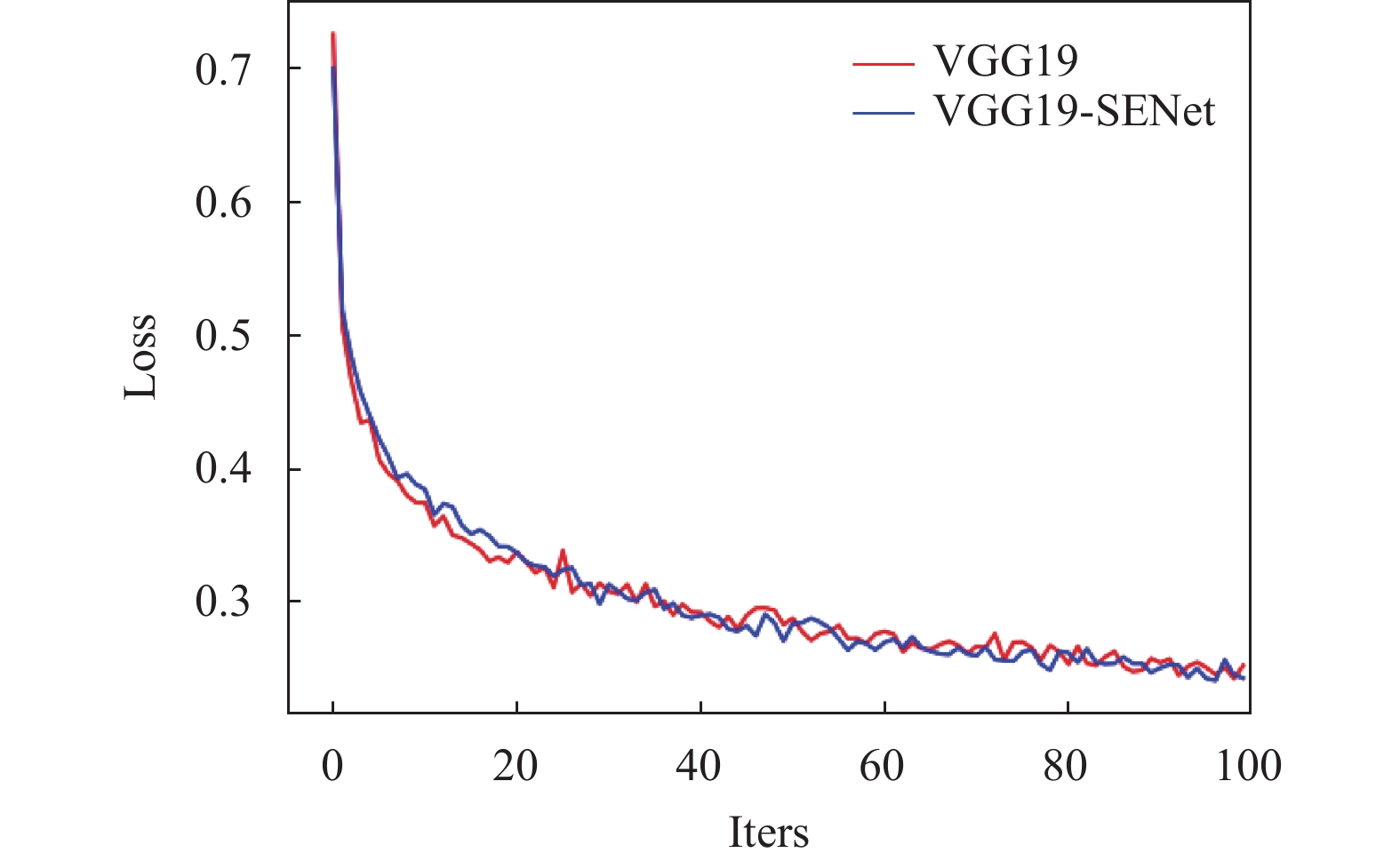

为验证本文添加的SENet注意力机制对网络模型分类性能的影响, 分别在迁移学习方法的基础上对原始VGG19模型、本文模型进行消融对比实验. 均采用数据增强后的数据集, 保持如表3所示的实验参数配置, 训练过程的损失曲线和最终的测试集分类情况如图9和表5所示. 在100轮迭代过程中, 加入SENet空间注意力机制的VGG19模型在损失函数曲线上和原始模型保持一致, 但原始模型较改进后模型而言, 在条带状、柱状剩余油的特征提取及识别上表现较差. 加入SENet空间注意力机制后, 在模型提取特征的前向传播过程中, SENet降低了无关特征的权重, 从而增强了对条带状、柱状剩余油的识别能力. 同时, 由表5数据也可以看出, 改进后的模型对其他类别的剩余油也保持着较高的分类精度.

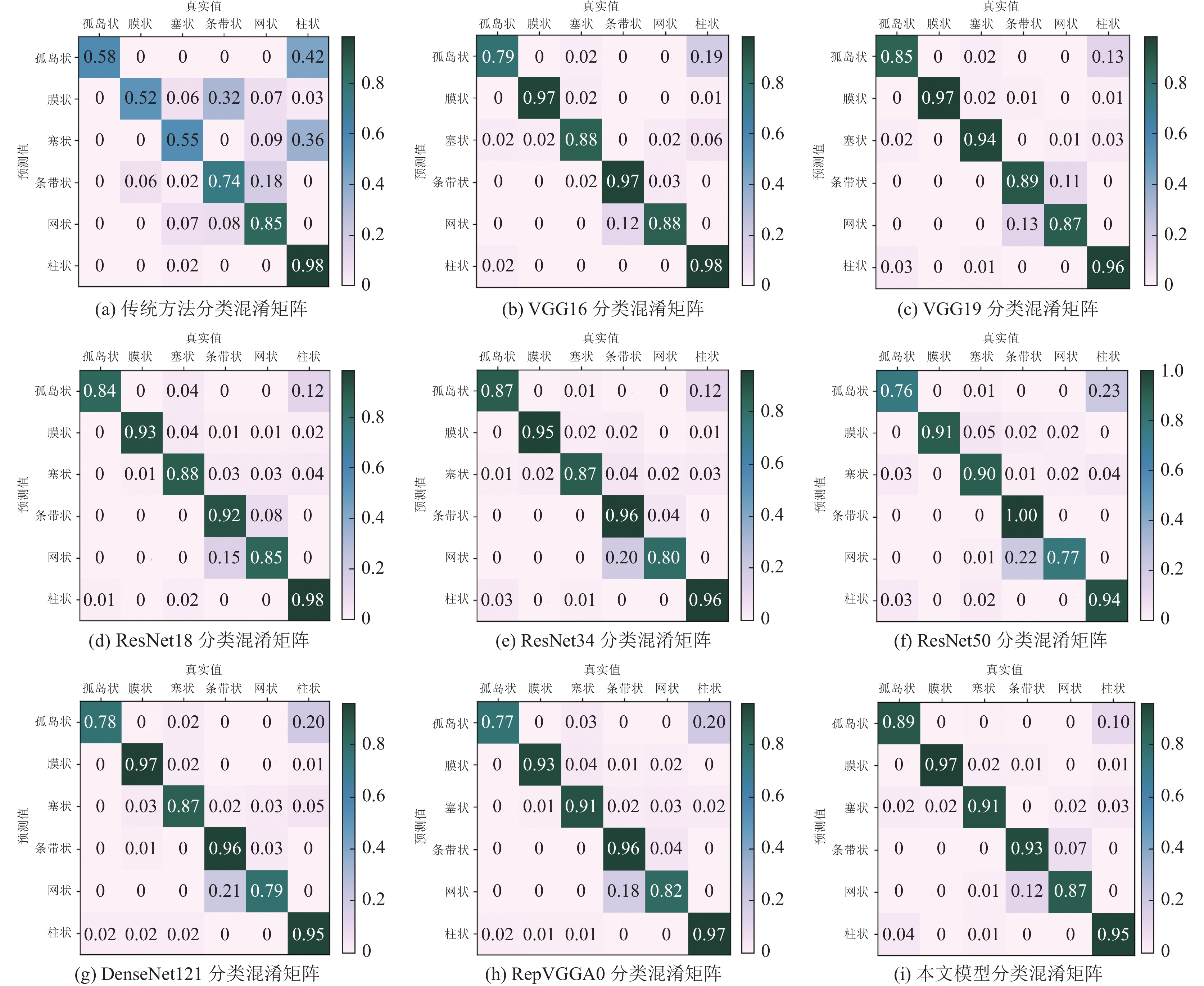

2.5 多种模型对比为客观验证本文模型的分类性能, 在相同数据集的基础上, 采用构建形态参数的传统方法以及ResNet系列[18]、DenseNet121、VGG16等目前在分类任务中主流的深度学习模型作为对照实验. 实验结果如表6所示, 混淆矩阵如图10所示.

由上述的实验结果可知, 传统方法通过构建形态因子等形态参数在孤岛状、膜状等剩余油上识别能力较强, 但无法识别复杂形态的网状条带状剩余油. 在深度学习方法中, 对比实验中的其他模型在条带状、柱状剩余油上性能较差, 本文模型保留了VGG性能的同时, 利用SENet加强了对条带状、柱状剩余油的特征提取, 使得其在6种剩余油分类精确率上分布均匀, 在各项评价指标中均具有一定优势.

|

图 9 增加SENet模块前后模型loss曲线 |

| 表 5 增加SENet模块前后结果对比 |

| 表 6 多种模型实验结果对比 |

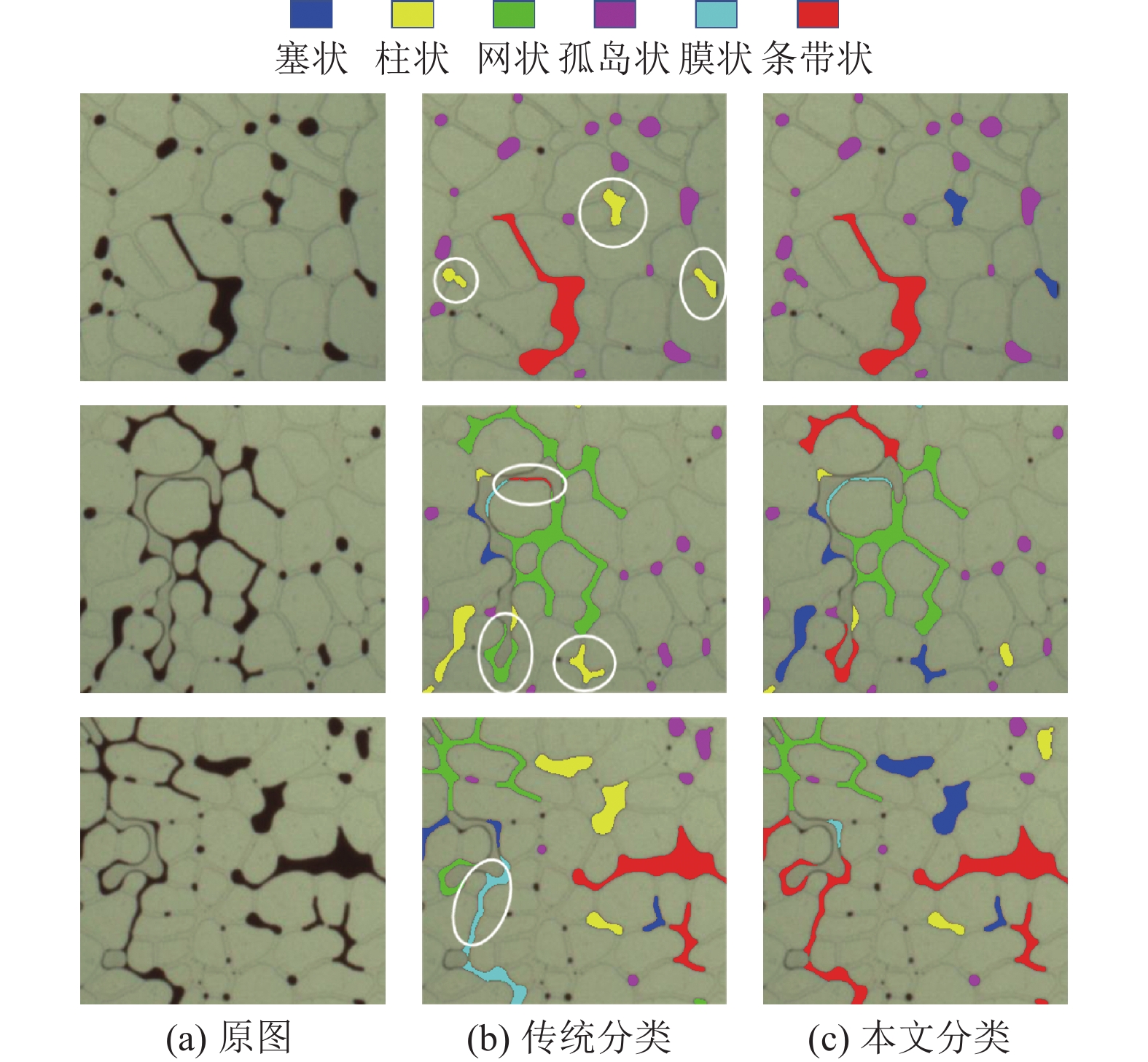

最后, 为直观地感受本文的分类效果, 图11给出了不同类别的剩余油形态分类结果. 图11(a)是原始剩余油图像, 图11(b)是用传统方法的分类结果, 图11(c)是本文的深度学习方法分类的结果图. 从结果可以看到, 针对容易混淆的膜状、柱状形态剩余油, 传统的分类方法通过构建形态参数难以适应特殊情况下的油滴分类, 其鉴别能力较差. 而无论针对较为复杂条带状、网状剩余油, 还是针对容易混淆的膜状、柱状剩余油, 本文方法皆有着良好的适应能力, 分类性能较好.

|

图 10 各模型测试分类混淆矩阵 |

|

图 11 不同分类方法下的分类结果对比 |

3 结束语

本文针对剩余油图像传统分类方法准确性不高, 且缺乏相应数据集的问题, 提出了一种基于深度学习的剩余油图像分类技术. 该方法首先利用ACGAN对不均衡分布的原始剩余油数据集进行数据增强, 在VGG19的网络技术基础上融入了SENet空间注意力机制, 完成了对不同形态剩余油的分类. 其中, VGG19采用较小的卷积核既有利于提高感受视野, 又有利于在减小卷积层参数的同时提高网络的表现力; 融入的SENet注意力机制模块增加特征信息内容的学习权重. 通过一系列实验数据比对分析, 分类结果不论是在主观效果上, 还是在客观指标上都有一定的优势. 本文模型在剩余油形态分类上具有良好的性能, 同时减少了传统分类算法后期的人工修复过程. 后期将考虑在保证有效性的前提下, 优化网络模型, 进一步减少参数量, 将算法应用于实际工程中.

| [1] |

王吉涛, 李俊键, 张博文, 等. 高含水老油田剩余油再富集质量评价及影响因素. 油气地质与采收率, 2023, 30(1): 153-160. |

| [2] |

张玉萍, 宫军, 高振杰, 等. 剩余油的形成基本方式及分布形态调研. 内蒙古石油化工, 2014, 40(12): 51-52. |

| [3] |

毛国庆, 滕奇志, 吴拥, 等. 基于BP神经网络的剩余油形态识别. 太赫兹科学与电子信息学报, 2014, 12(6): 858-864. |

| [4] |

汪洋, 黄延明, 同鑫, 等. 剩余油研究方法综述. 特种油气藏, 2023, 30(1): 14-21. |

| [5] |

高文彬, 李宜强, 何书梅, 等. 基于荧光薄片的剩余油赋存形态分类方法. 石油学报, 2020, 41(11): 1406-1415. |

| [6] |

朱光普, 姚军, 张磊, 等. 特高含水期剩余油分布及形成机理. 科学通报, 2017, 62(22): 2553-2563. |

| [7] |

李俊键, 刘洋, 高亚军, 等. 微观孔喉结构非均质性对剩余油分布形态的影响. 石油勘探与开发, 2018, 45(6): 1043-1052. |

| [8] |

张伟. 聚驱后剩余油分布及影响因素分析[硕士学位论文]. 大庆: 大庆石油学院, 2010.

|

| [9] |

李阳. 储层流动单元模式及剩余油分布规律. 石油学报, 2003, 24(3): 52-55. |

| [10] |

邱茂鑫. 基于CT的剩余油微观赋存状态描述方法研究[硕士学位论文]. 青岛: 中国石油大学(华东), 2013.

|

| [11] |

程小龙, 王正勇, 滕奇志. 基于KNN的剩余油形态识别. 信息技术与网络安全, 2020, 39(1): 104-107. DOI:10.19358/j.issn.2096-5133.2020.01.020 |

| [12] |

Krizhevsky A, Sutskever I, Hinton GE. Imagenet classification with deep convolutional neural networks. Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe: ACM, 2012. 1097–1105.

|

| [13] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 1–9.

|

| [14] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. Proceedings of the 3rd International Conference on Learning Representations. San Diego: ICLR, 2015.

|

| [15] |

Odena A, Olah C, Shlens J. Conditional image synthesis with auxiliary classifier GANs. Proceedings of the 34th International Conference on Machine Learning. Sydney: ACM, 2017. 2642–2651.

|

| [16] |

陈浩, 滕奇志, 何小海, 等. 基于几何形状特征的剩余油形态识别. 微型机与应用, 2017, 36(1): 18-21, 28. DOI:10.19358/j.issn.1674-7720.2017.01.006 |

| [17] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [18] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

2023, Vol. 32

2023, Vol. 32