2. 四川大学 电子信息学院, 成都 610065

2. College of Electronics and Information Engineering, Sichuan University, Chengdu 610065, China

随着生活水平的提升, 人们对能源的需求不断增长, 其中油气作为国家发展的重要能源, 在深井、高温高压气井以及含有腐蚀介质的气井等复杂工况下的开发日益增多. 油气能源开采时为了便于传输需要将数根螺纹油套管相互连通, 油套管上扣不到位或者油套管螺纹接口出现磕碰和破损, 都会影响油套管的密封性, 进而导致传输过程中油气泄露, 给油气开采带来一定安全隐患[1]. 在油套管上扣过程中, 扭矩仪实时检测油套管公、母螺纹接头的受力情况并生成上扣扭矩曲线图, 因此可以根据生成的扭矩曲线图像的形态特征来间接地分析和推断油套管的密封性. 当油套管上扣不到位, 螺纹上扣扭矩曲线表现为没有明显拐点; 当油套管口存在破损, 曲线表现为有强烈波动. 针对油套管密封性能的检测, 目前主要是采用人工监测油套管上扣扭矩曲线的方式. 然而, 多年的现场应用表明人工检测扭矩曲线的方式效率低下, 且容易受到人为主观因素的影响, 油气开发的安全性得不到保障.

为了解决人工检测扭矩曲线存在的问题, 根据油套管不同状态下的扭矩曲线的形态特征, 使用计算机识别曲线代替目前的人工检测方式, 提高油气开发过程的效率和可靠性. 李静等人[2]提出一种曲线特征提取方法, 李卫华等人[3]根据测井曲线特征识别砂砾岩沉积相, 张强等人[4]利用井径测井曲线作为样本数据分析岩性分层变化规律, 陶羽[5]对典型生产井曲线特征进行分析. 在传统的曲线分类方法中, 曲线特征提取完成后再通过SVM或随机森林等算法进行分类, 这些方法存在精度低、效果差等问题, 可靠性无法保障.

随着深度学习的不断发展, 神经网络模型由于其具有高精度和良好特征提取能力等特点得到广泛应用, 许多基于深度学习的曲线特征提取和分类方法被提出. 林顺富等人[6]提出了一种基于稀疏自动编码器神经网络的曲线分类方法, 董军等人[7]使用模糊C均值聚类的方法建立了曲线分类模型, 张慧波等人[8]提出一种改进K-means与长短期记忆神经网络-卷积神经网络分类模型结合的负荷曲线分类方法, Ma等人[9]设计了一种端对端的神经网络模型进行曲线分类识别. 深度神经网络也被广泛应用于图像分类领域, 并且许多图像分类算法已经被提出并取得了显著的成果, 在精度和模型量级方面表现出良好的性能[10–16]. 在将神经网络模型应用到工业生产时, 模型的精度和量级往往起到关键作用. 因此, 本文将基于深度学习的图像分类方法应用于气密封螺纹上扣扭矩曲线的检测工作, 通过扭矩曲线的分类识别, 判断油套管的密封性能.

基于上述情况, 本文对EfficientNet-B0网络模型进行了改进, 提出一种气密封螺纹上扣扭矩曲线分类网络模型: NAFENet, 用于对气密封螺纹油套管上扣扭矩曲线进行分类识别工作. 该模型的分类结果可以作为油套管气密封性能评价的一种指标, 进而有效提高油气开采现场的工作效率, 并为油套管的气密封性判断提供有效参考.

2 EfficientNet-B0网络模型从工业上的实际应用出发, 对于需要进行故障检测的网络模型, 精度和量级都是需要考虑的问题. 本文在自制UBT_Curve数据集上对多个图像分类网络进行了测试和验证, 从模型轻量化和高精度的方面考虑, EfficientNet-B0网络具有较大优势, 模型精度较高并且参数量较少. 因此, 本文基于图像分类算法EfficientNet-B0进行改进.

EfficientNet系列网络模型的基础架构是通过神经网络架构搜索(neural architecture search)进行设计的. 卷积神经网络的模型训练在已知硬件资源的条件下进行的, 因此, 当硬件资源充足时, 可以通过增加网络模型的深度和宽度来获得更好的训练结果. 在EfficientNet系列网络模型中, 研究人员提出了一种全新的模型缩放方法使系统模型更易于缩放, 该模型缩放方法通过合理地调整这些复合系数来平衡底调整网络的深度、宽度和输入图像的分辨率等参数.

EfficientNet-B0作为EfficientNet系列的基础网络模型, 在ImageNet数据集上进行训练[17], 总共包含5330564个参数. 该网络的核心结构是MBConv模块, 该模块还引入SENet注意力机制[18]. EfficientNet-B0模型结构, 是由16个MBConv模块, 2个卷积层, 1个全局平均池化层和1个分类层构成, 如表1所示.

| 表 1 EfficientNet-B0网络结构 |

3 改进的EfficientNet网络 3.1 EfficientNet-B0卷积结构优化

本文在EfficientNet-B0网络模型的基础上扩展卷积结构至11层得到EfficientNet-B11. 将训练网络原始第3层和第4层之间增加一层卷积, 该增加的卷积层与第3层的不同之处为卷积核大小变为5×5、步长变为1, 其他部分与第3层相同. 另外将训练网络原始第7层和第8层之间增加一层卷积, 该增加的卷积层与第7层的不同之处为卷积核大小变为3×3、步长变为1, 其他部分与第7层相同, 增加卷积层后的EfficientNet-B11共有11层卷积. 调整后的EfficientNet-B11模型框架如表2所示, 其中Operator表示在对应Stage的操作, Resolution对应每一个Stage的输出特征图的高和宽, Channels对应该Stage的输出特征通道数, Layers表示该Stage中的Operator重复了多少次.

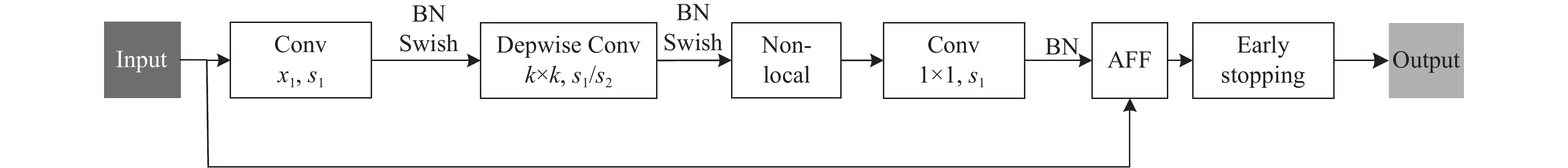

Stage1是一个常规卷积层, Stage2–Stage10是由16个如图1中的MBConv模块堆叠而成, 该模块是一个结合了深度可分离卷积和注意力机制的倒置残差结构, 可分为主干分支和残差分支两个部分. 在主干分支中, 首先对输入的特征矩阵进行1×1的逐点卷积并根据扩充倍数改变输出通道维度(扩充倍数为1时, 则没有这一层1×1的卷积), 接着使用k×k的逐通道卷积(depthwise convolution)进行特征提取, 再以1×1的逐点卷积结尾恢复原通道维度, 最后进行连接失活. Stage11由1×1的卷积层、平均池化层和全连接层组成, 在Stage1和Stage11中的卷积层都包含一个批归一化操作(batch normalization, BN), 并使用了Swish激活函数. 为了提高模型的泛化性能, 本文在卷积模块MBConv中采用了early stopping正则化技术[19], 该技术在每个迭代过程结束后, 评估模型在验证集上的性能, 进行判断是否停止训练. 通过这种策略, 有助于避免模型过度拟合训练数据, 提高其对新样本的适应能力.

| 表 2 优化后的EfficientNet-B11网络结构 |

|

图 1 MBConv模块 |

3.2 Non-local注意力机制

图像数据的卷积操作具有局部连接的特性, 意味着卷积的结果仅与周围的局部区域相关. 在曲线图像中, 曲线部分的像素区域只占整体图像的小部分, 而大部分图像像素则为空白或是图像边框. 传统的神经网络使用3×3或5×5的卷积核在整张图像上进行滤波操作, 这种方式处理了图像的局部信息, 但可能导致大部分区域的处理结果与问题无关, 因为这些区域不包含曲线信息. 此外, 曲线图像的识别任务不仅关注曲线各部分的细节信息, 更需要关注曲线的整体信息, 例如曲线的整体趋势和曲线部分在图像中的范围信息. 传统卷积操作可能无法充分捕捉到这些全局信息.

为了捕捉曲线图像中更广泛的依赖关系, 本文引入了non-local注意力机制[20]来提取曲线图像中的重要特征, 从而提高网络模型的分类精度. Non-local注意力模块如图2所示, 它通过计算任意两个位置之间的交互来捕捉远程依赖关系, 而不仅局限于相邻点, 这相当于在特征图上构建了一个与尺寸相同的大型卷积核, 从而保留更多的信息. 这种方法可以扩大卷积操作的感受野, 超出局部领域的范围. 最终, 通过相应的加权操作, 实现对更大范围内的特征进行有效处理, 而不仅仅局限于局部区域, 这样可以捕捉到更多的全局信息, 并提升对曲线图像的处理能力和分类准确性.

Non-local操作具体的计算过程如下:

| yi=1C(x)∑∀jf(xi,xj)g(xj) | (1) |

其中, x是输入特征图, i代表的是当前输出位置, 如空间、时间或者时空的索引, 其响应对j进行枚举然后计算得到, j代表全局响应, f函数计算i和j的相似度, g函数表示计算特征图在j中的位置, 最终的y是通过响应因子C(x)进行标准化处理以后得到的.

其中,f函数的计算公式如下:

| f(xi,xj)=exTixj | (2) |

| C(x)=∑∀jf(xi,xj) | (3) |

g函数的计算公式如下:

| g(xj)=Wgxj | (4) |

其中, Wg表示需要学习的权重矩阵.

|

图 2 Non-local注意力模块 |

如图1所示, 通过将EfficientNet-B11网络模型中MBConv模块中k×k的逐通道卷积之后引入non-local注意力操作来帮助模型获取曲线图像中较为全局的信息, 来为后续的分类提供更丰富的全局特征.

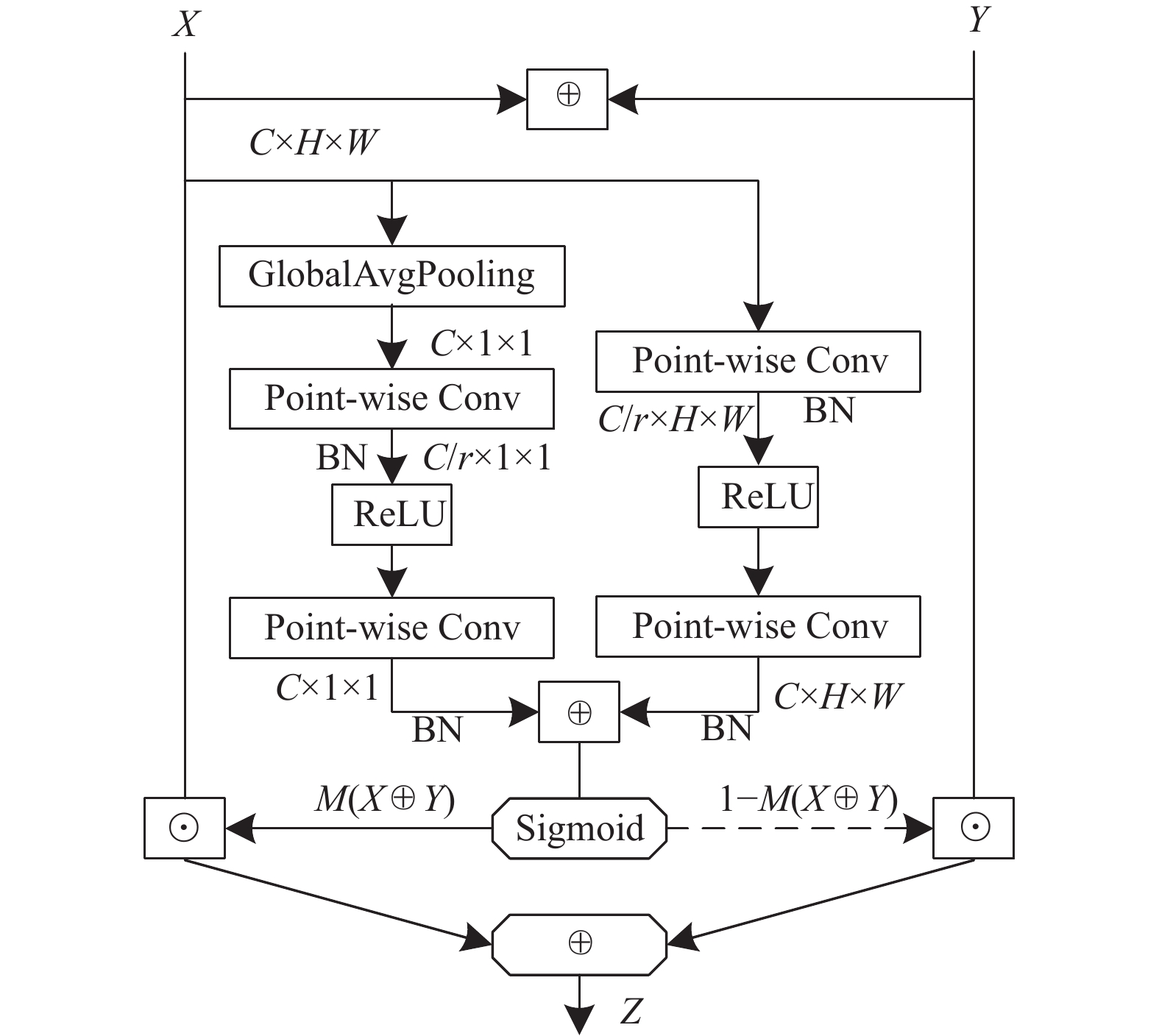

3.3 AFF特征融合模块特征融合的目的是把从图像中提取的特征合并成一个比输入特征更具有判别力的特征. 在大多数任务中, 通常使用简单线性的操作来实现不同特征的融合操作, 比较经典的图像融合方法有串联(concatenation)和逐个元素求和(summation), 串联融合方法的思想是直接将两个特征进行连接, 若两个输入特征F1和F2的维数分别为x和y, 输出特征的维数为x+y. 逐元素求和的方法则是对输入特征直接进行对应元素的相加, 这一操作的前提是这两个特征的维度相同, 假设两个输入特征为F1和F2, 则输出特征Z的表达式为Z = F1 + iF2, 其中i是虚数单位. 串联和求和的特征融合方式虽然简单有效, 但不一定是最佳选择, 为了提高网络对提取到的特征的利用能力, 在EfficientNet-B11网络中引入了注意力特征融合(attentional feature fusion, AFF)[21]来帮助模型更好地融合卷积注意力模块提取到的曲线图像特征.

如图3所示, 对于输入的特征X和特征Y, 首先使用逐元素求和的方式进行初始融合, 将得到的融合特征传入两个不同的分支来提取注意力权重, 一个分支使用全局平均池化加逐点卷积的方式来提取特征的全局注意力, 另一个分支直接使用逐点卷积提取特征的局部注意力. 然后将两个分支得到的注意力权重进行逐元素求和, 再进行Sigmoid运算, 得到融合权重, 最后在融合权重的基础上对输入特征进行加权平均, 得到最终的融合特征.

|

图 3 特征融合过程 |

对于给定的输入特征X和Y, AFF的计算方式如下:

| Z=M(X⊕Y)⊗X+(1−M(X⊕Y))⊗Y | (5) |

其中,

本文主要在EfficientNet-B0网络的基础上增加卷积层生成EfficientNet-B11, 并对其MBConv模块进行了改进, 最后得到NAFENet网络, 其整体结构如图4所示. NAFENet主要由11个Stage组成, 总体可分为3个部分, 第1部分包含了1个3×3的卷积, 1个BN层和1个Swish函数, 这一部分是为了对输入的730×530×3曲线特征图像进行初步的特征提取, 输出的维度为112×112×3的特征矩阵. 第2部分由一系列改进的MBConv模块组成, 通过引入non-local注意力机制, 来帮助模型能够获取曲线图像中较为全局的信息来为后续的分类提供更加丰富的全局特征, 并引入了AFF注意力融合模块帮助网络在执行曲线图像识别任务时, 拥有更强的特征表达能力. 第3部分为网络模型的输出部分, 由1个1×1的卷积、1个全局平均池化和1个全连接层组成, 以此来输出曲线图像的准确分类. NAFENet网络模型是一个轻量化模型, 模型表达能力更强, 实现了自动特征提取, 拥有较强的特征表达能力, 并且模型精度高.

|

图 4 NAFENet网络结构 |

4 实验结果与分析 4.1 实验配置

本文相关工作的实验硬件配置基于Linux操作系统, CPU型号是Intel(R) Core(TM) i7-9700 CPU, GPU型号是NVIDIA GeForce RTX 1080 Ti, 选择了PyTorch深度学习框架作为开发环境.

4.2 数据集制作本文数据集的初始样本来源于西南油气田工程技术研究院, 是由在输气管道上扣过程中使用气密封螺纹上扣扭矩仪对管道扣紧过程的压力值进行检测并生成相应的扭矩曲线所绘图像组成.

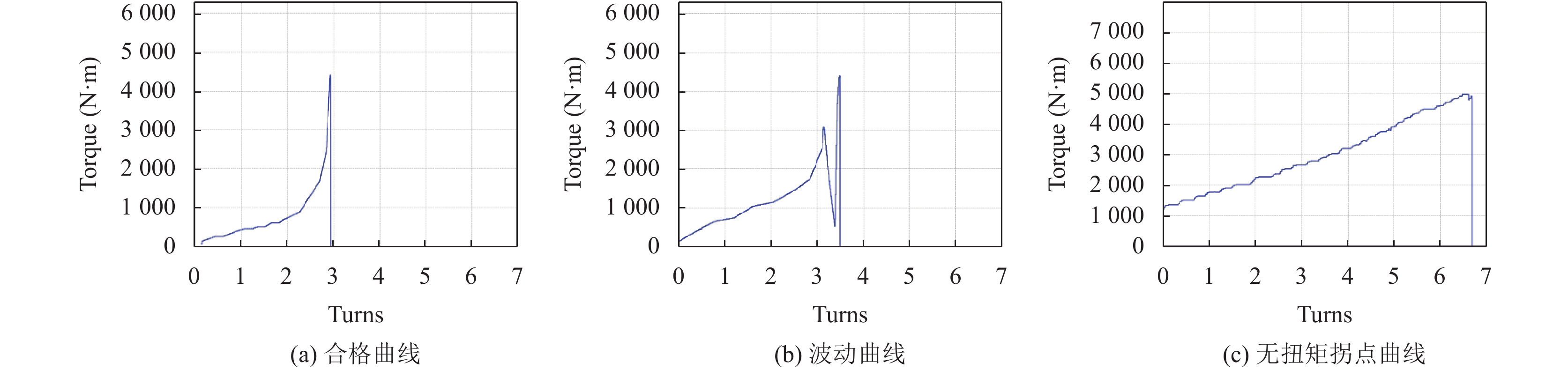

通过对气密封螺纹上扣扭矩曲线图像的特征进行深入研究, 分析了可接受曲线和不可接受曲线之间的特征差异. 关注了曲线的多个方面的特征, 包括拐点特征、上升趋势和波动情况. 为了进一步研究和应用这些曲线特征, 将现有的气密封螺纹上扣扭矩曲线历史数据制作成一套上扣扭矩曲线自动数据库, 并相应地构建了训练集和测试集. 通过前期对曲线数据的分析, 初步将曲线数据划分为3类: 合格曲线数据、波动曲线数据和无拐点曲线数据.

合格曲线是指具有明显拐点和合理上升趋势的曲线, 这些曲线在气密封螺纹上扣扭矩方面表现出良好的性能. 波动曲线是指在扭矩曲线上存在较大波动的情况, 特别是波动对曲线拐点特征产生影响的曲线. 而无扭矩拐点曲线则是指曲线拐点不明显, 或者曲线没有明显的上升趋势. 通过这样的分类, 可以更好地理解不同类型曲线的特征和性能, 并进一步进行分类识别工作, 提高曲线分类的准确性和效率, 图5展示了3种曲线样本的基本特征.

经过对历史数据进行人工类型标定, 制作了基于一个气密封螺纹上扣扭矩曲线图像的UBT_Curve数据集. 目前, 该数据集中可用的曲线数据数量已达到6450张, 原始图像分辨率为730×530. 为了进行后续的曲线分类、模型性能优化和实现自动化分类等工作, 将数据集划分为训练集和测试集. 训练集包含5170张图像, 用于训练和优化模型. 测试集包含1280张图像, 用于评估已训练模型的性能和泛化能力.

4.3 网络训练细节在网络训练过程中使用随机梯度下降算法(stochastic gradient descent, SGD)有效地优化损失函数, 动量为0.9, 权值衰减为 0.0005, 初始学习率为 0.001, 并且所有模型都训练200轮, batch size设置为32.

SGD优化算法的目标是改善NAFENet网络的训练方式, 以最小化损失函数. 优化算法基于损失函数的梯度信息, 通过调整网络的参数来更新模型. 损失函数用于度量网络输出结果

| l=−∑Ni=1yilog(pi) | (6) |

其中, y和p表示真实预测和期望, N表示类别数.

|

图 5 曲线样本 |

4.4 实验数据分析

为了测试本文改进算法的有效性, 在自制UBT_Curve数据集上进行了大量的对比试验. 表3实验对比了使用不同模块的模型性能比较, 主要改进策略为将原来的卷积结构扩展至11层得到EfficientNet-B11, 在每个卷积层中使用 non-local代替SE注意力模块, 特征融合使用AFF代替add方法. NAFENet网络模型首先通过一个3×3的卷积对扭矩图像进行初步的特征提取, 接着通过一系列的MBConv卷积模块帮助模型更好地分析特征间的权重关系, 最后使用一个1×1的卷积输出层输出曲线特征分类结果. 其中Params 表示模型训练的参数量, 准确率是衡量样本分类准确性的指标, 反映了预测正确样本数占总样本数的比例, 具体定义如下:

| Accuracy=TP+TNTP+TN+FP+FN | (7) |

其中, TP表示预测为正的正样本数量;TN表示被预测为负的负样本数量;FP表示被预测为正的负样本数量; FN表示被预测为负的正样本数量.

| 表 3 改进策略性能比较 |

本文对EfficientNet-B0网络模型进行细节优化, 通过表3发现, 在参数量小幅度增长的情况下, 模型的测试准确率由89.62%提升到了92.87%, 整体提升了3.25%, 模型性能得到较大的提升, 实验结果表明, 本文的模型优化方法具有较好的效果.

本文还对比了图像分类中比较经典的ResNet-50[12]、MobileNet-V2[22]、ShuffleNet-V1[23]、HRNet[24]、EfficientNet-B0[15]. 从表4可以看出, 针对曲线特征进行模型改进, 改进后的NAFENet模型性能优于其他的网络模型, 同时相较于EfficientNet-B0, NAFENet在数据集上的准确率目前可达到92.87%, 准确率有了3.25%的提升. 并且, 本文所提出的网络具有较小的参数数量和FLOPs (浮点运算数), 相较于其他高精度模型来说NAFENet模型是一个轻量级的网络, 适合在不同机器上的迁移和部署, 满足工业化应用需求. 与MobileNet-V2和ShuffleNet-V1等轻量级网络相比, 尽管增加了少量参数, 但模型的准确性更高, 满足了工业生产中对于安全性的需求. 因此, 从精度和轻量化的角度来说, 本文所提出的网络模型更加适用于实际工况下的图像分类任务, 表现出了优秀的性能.

| 表 4 不同模型的精度、参数量、浮点运算性能比较 |

5 总结

本文介绍了一种针对气密封螺纹上扣特征曲线进行自动识别分类的方法, 采用基于EfficientNet-B0神经网络进行改进的分类模型NAFENet, 适用于解决复杂背景干扰、多样变化的特征曲线图像的数据自动识别分类任务. 通过一系列实验数据对比分析, 结果表明本文提出的方法在特征曲线的识别分类上的准确率高于其他一些较为经典的分类模型, 且模型的泛化能力更强, 稳定性更好.

| [1] |

耿凌俊, 李淑平, 吴斌, 等. 盐穴储气库注水站整体造腔参数优化. 油气储运, 2016, 35(7): 779-783. |

| [2] |

李静, 张洪欣, 甘罕, 等. 基于回声状态网络的功耗曲线特征提取. 电波科学学报, 2014, 29(6): 1127-1132. |

| [3] |

李卫华, 谢俊阳, 余海涛. 基于测井曲线特征识别砂砾岩沉积相. 长江大学学报(自科版), 2018, 15(11): 33-37, 41. |

| [4] |

张强, 李家金, 王毛毛, 等. 基于改进主成分分析法的测井曲线岩性分层技术. 吉林大学学报(地球科学版), 2022, 52(4): 1369-1376. |

| [5] |

陶羽. 某区块典型生产井曲线特征分析. 石化技术, 2022, 29(10): 60-62. |

| [6] |

林顺富, 顾乡, 汤继开, 等. 基于稀疏自动编码器神经网络的负荷曲线分类方法. 电网技术, 2020, 44(9): 3508-3515. |

| [7] |

董军, 陈正鹏, 窦熙皓, 等. 基于EEMD-FCM的需求响应用户负荷曲线分类研究. 电力科学与工程, 2021, 37(10): 45-54. DOI:10.3969/j.ISSN.1672-0792.2021.10.006 |

| [8] |

张慧波, 王守相, 赵倩宇, 等. 考虑数据不均衡的居民用户负荷曲线分类方法. 电力工程技术, 2022, 41(3): 186-193. |

| [9] |

Ma ZH, Chen YX, Fan Y, et al. An improved AoT-DCGAN and T-CNN hybrid deep learning model for intelligent diagnosis of PTCs quality under small sample space. Applied Sciences, 2023, 13(15): 8699. DOI:10.3390/app13158699 |

| [10] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. Proceedings of the 3rd International Conference on Learning Representations. San Diego: ICLR, 2015. 1–14.

|

| [11] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 1–9.

|

| [12] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [13] |

Chollet F. Xception: Deep learning with depthwise separable convolutions. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1800–1807.

|

| [14] |

Huang G, Liu Z, Van Der Maaten L, et al. Densely connected convolutional networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2261–2269.

|

| [15] |

Tan MX, Le Q. EfficientNet: Rethinking model scaling for convolutional neural networks. Proceedings of the 36th International Conference on Machine Learning. Long Beach: PMLR, 2019. 6105–6114.

|

| [16] |

Han K, Wang YH, Tian Q, et al. GhostNet: More features from cheap operations. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 1577–1586.

|

| [17] |

Deng J, Dong W, Socher R, et al. ImageNet: A large-scale hierarchical image database. Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 248–255.

|

| [18] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [19] |

Prechelt L. Early stopping-but when? In: Orr GB, Müller KR, eds. Neural Networks: Tricks of the Trade. Berlin: Springer, 1998. 55–69.

|

| [20] |

Wang XL, Girshick R, Gupta A, et al. Non-local neural networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7794–7803.

|

| [21] |

Dai YM, Gieseke F, Oehmcke S, et al. Attentional feature fusion. Proceedings of the 2021 IEEE Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2021. 3559–3568.

|

| [22] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520.

|

| [23] |

Zhang XY, Zhou XY, Lin MX, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6848–6856.

|

| [24] |

Wang JD, Sun K, Cheng TH, et al. Deep high-resolution representation learning for visual recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3349-3364. DOI:10.1109/TPAMI.2020.2983686 |

2023, Vol. 32

2023, Vol. 32