随着电子商务的普及和成功, 在线评论已经成为消费者、企业和组织跨期决策过程的一个有价值的参考来源. 消费者喜欢在做购买决策之前先浏览评论以收集相关信息, 无需像在线下市场中接触到实物, 其就可以直接通过浏览大量评论以获得足够的产品质量信息, 这些都能够对消费者的行为产生直接的影响. 产品的销售会受到产品评论和特定产品类别的相关因素的影响[1], 而消费者对于产品的第一印象和他人的好评或者差评也都直接影响着消费者的购买行为, 因此在线评论已成为消费者在购物前识别商品质量的一个重要标志, 在很大程度上决定了消费者的意愿[2]. 但随着评论数量的不断增加, 定位有用的信息变得具有挑战性. 虽然电子商务平台收集用户对产品评论的有用性投票意见, 但实际上, 在不太受欢迎的产品中, 投票数据很少, 甚至缺失. 而提出的有用性预测旨在从投票数据中学习, 以识别高质量的评论并向客户推荐这些评论以帮助他们作出购买决策. 因此, 理解和预测在线评论的有用性行为将不仅可以大大节约消费者的决策时间, 提高购买决策正确性, 还对商家如何改进在线评论机制提供一定的辅助指导.

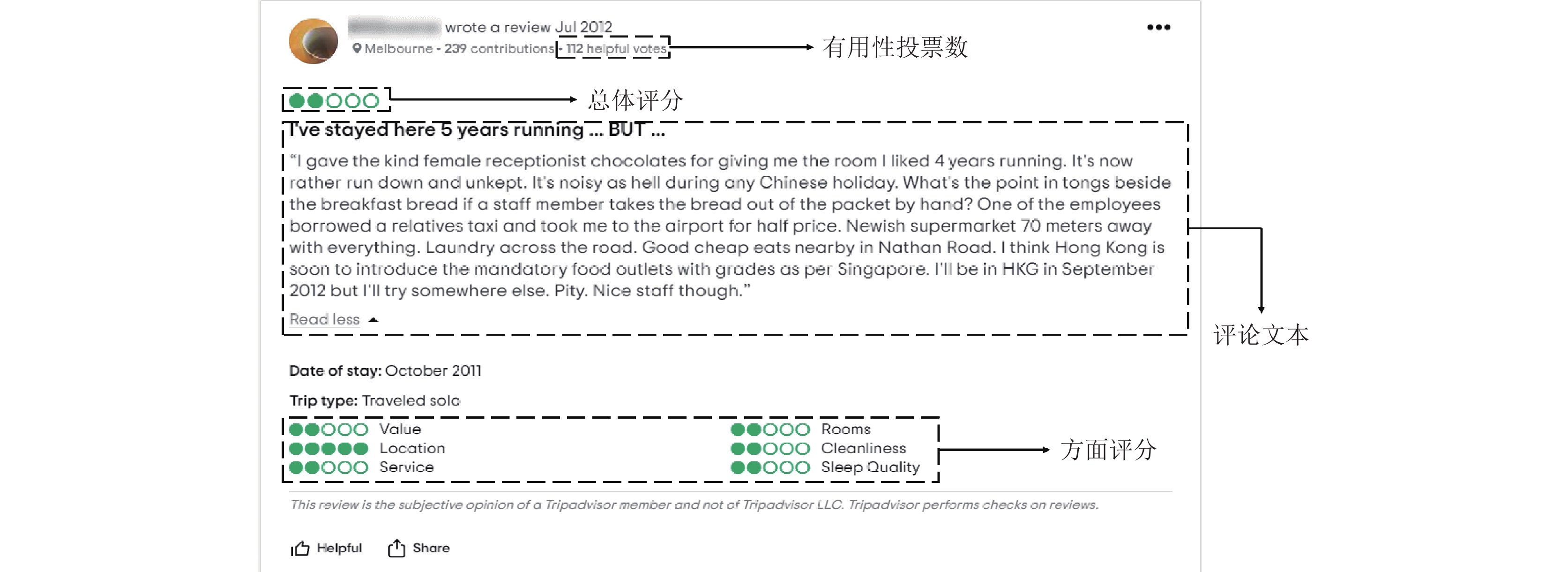

其实, 有用性预测在自然语言处理方面已得到了广泛的研究. 先前的研究表明, 有用性作为在线评论质量的内在度量, 受到内容和上下文特征[3,4]的影响. 内容特征包括直接来自评论文本(如评论内容、总体评分)[5]的信息, 而对上下文特征的研究主要关注评论文本以外的信息, 如用户信息和产品特征[6]. 本研究中我们关注前者, 因为相较用户个人数据而言, 用户提供的产品评论却是网站中更容易访问到的数据(图1). 在内容特征中, 有用性预测通常使用评论文本和总体评分. 此外, 研究表明, 这两个特征的交互作用可以进一步提高有用性预测任务的性能[7]. 尽管如此, 现有的研究主要集中在基于上下文信息生成内容表示, 并使用总体评分来优化内容的语义, 从而做出在线评论的有用性预测, 而这在很大程度上忽略了方面评分以及方面评分与句子之间的语义关联. 同时, 仅使用总体评分和文本内容进行建模容易出现情感不一致的问题, 而方面评分的出现可以对这种不一致性进行适当的修正, 如图2所示.

|

图 1 来自TripAdvisor的一个评论示例 |

|

图 2 方法对比 |

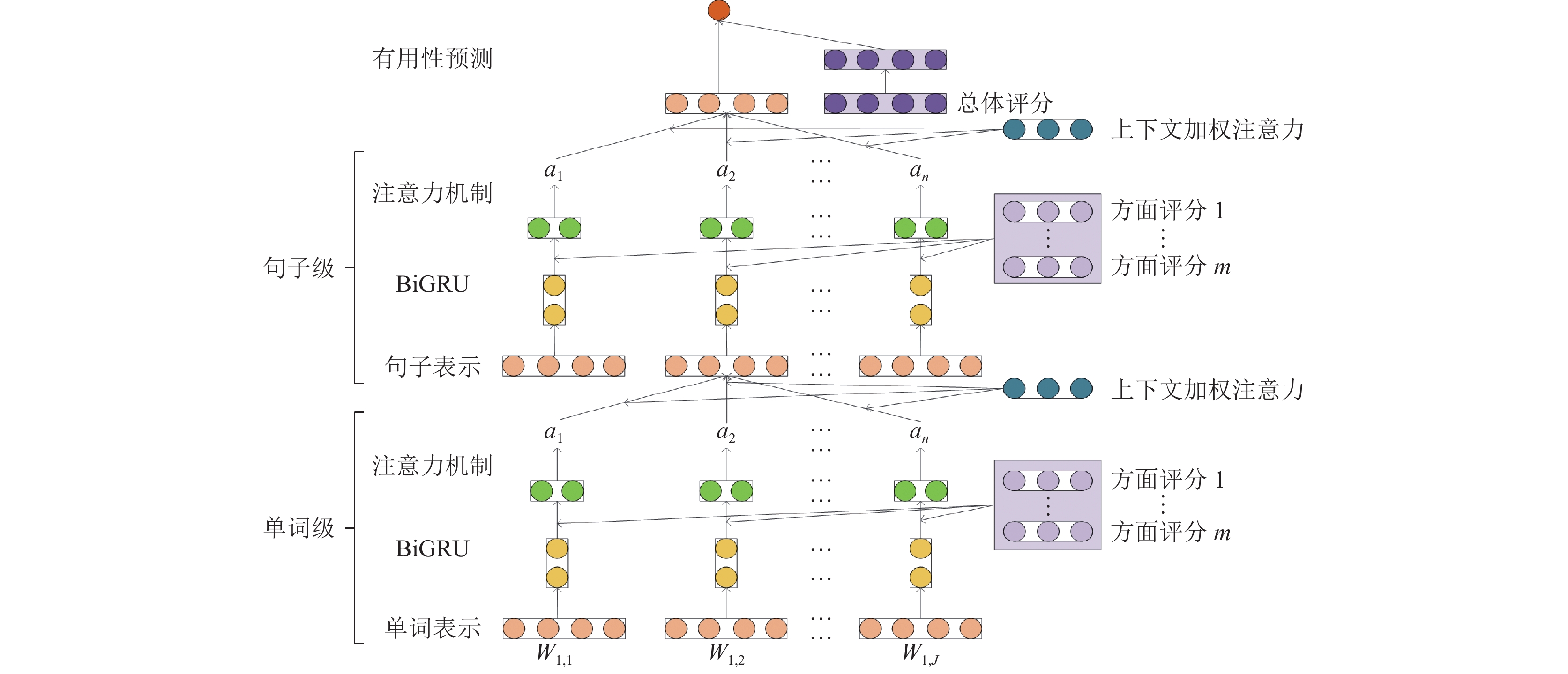

最近, 多维评分系统[8]已经应用于多个在线平台, 如TripAdvisor、Niche和WebMD, 它们要求用户除了给出评论文本和相应的总体评分外, 还对产品的具体方面进行评分(以下简称“方面评分”)(图1), 在用户决策的过程中, 方面评分、评论内容和总体评分在多个粒度层次上提供产品评估. 方面评分反映了用户对产品更具体的属性感受; 评论内容包括用户的意见和情绪; 总体评分则反映了用户对产品的整体满意程度. 理解有用性预测行为的挑战是如何联合执行各类评分和语义表示, 以学习一个更全面的预测行为模型. 由于评分过程反映了消费者自然地学习和概念化各个方面, 并在局部概念和整体评分之间建立关系, 因此有效的预测行为分析方法应该建立在人类认知的基础上. 而在这类系统中, 用户的评论行为就通常遵循一种从细到粗的模式. 例如, 总体评分可以看作是对多个方面的意见的粗粒度综合[9,10]. 在这项工作中, 我们假设建模这样的模式可以提高在线评论的感知有用性, 因为方面评分包含更详细的情绪, 并有能力缓解评论文本和总体评分[11]之间的不一致性问题. 具体来说, 我们提出了一个基于注意力机制的多层次网络, 利用总体评分、评论文本和方面评分来执行有用性预测任务(图2). 基于两个真实世界的数据集, 实验结果表明, HORA在预测在线评论的有用性方面表现良好, 同时也展示了方面评分对在线评论有用性的预测影响. 我们的主要贡献如下.

(1) 我们提出了HORA, 一个基于注意力机制的层次网络(hierarchical network), 利用总体评分(overall rating)、评论文本(review text)和方面评分(aspect ratings)来准确和稳健地执行在线评论的有用性预测任务.

(2) 据我们所知, HORA是第1个将来自多维评分系统的方面评分合并到有用性预测任务的模型.

(3) 我们在两个真实数据集上进行了实验, 以验证该方法的有效性. 结果表明, HORA的表现显著优于其他神经网络模型. 除此之外, 我们还证明了模型的稳健性.

2 相关工作在以往的文献工作中已提出有多种特征会影响在线评论的有用性, 而这些特征主要集中在两个方面: 基于内容的特征和基于上下文的特征.

2.1 内容特征内容特征包括评论文本, 总体评分和方面评分[4], 经典的在线评论有用性预测方法包括寻找新的手工特征, 以此来提高模型的表现. 例如基于情感[12], 方面[13], 论点[14]等特征都相继被研究学者发现其能够帮助预测在线评论的有用性. Ghose等人[15]和Korfiatis等人[16]探索了评论文本的多个方面, 如主观性水平、可读性的各种衡量标准和拼写错误的程度, 以确定基于文本的重要特征, 最后发现评论中的主观性、信息性、可读性和语言正确性会影响感知有用性. 与倾向于仅包含主观或仅包含客观信息的评论相比, 混合了客观和高度主观句子的评论对感知有用性的影响更大.

另外还有一些研究人员认为, 星级评分和有用性预测之间存在联系, 因此评论文本和总体评分在以往的研究中也被广泛应用. Otterbacher等人[17]认为评论中存在积极偏见, 即积极星级评分的评论被认为更有帮助; Martin等人 [12]在预测在线评论的有用性时, 将从评论文本中提取的情感词汇融入到他们的特征中. Chen等人[18]提出了一种利用字符级和字级信息的卷积网络, 取得了显著的效果. 通过测试总体评分的离散性是否对评论的有用性有影响, Lee等人[19]引入了一个新的变量来衡量在线评论的效用. Lee等人[20]发现, 随着时间的推移, 产品的平均评论评分是在线评论有用性预测的一个重要特征. Mukherjee等人[21]总结了来自总体评分和其他特征的一致性和语义特征, 提供了更多可解释的结果. Zhou等人[3]调查了总体评分和文本情绪的互动影响, 他们发现负面评价被认为比正面评价更有帮助. 除了从评论文本和总体评分中提取特征外, 一些研究还试图构建它们之间的交互作用. Qu等人[22]使用CNN将总体评分和评论文本结合起来, 提高了评论有用性预测任务的整体性能. Fan等人[23]提出了一种多任务神经网络学习架构, 认为它提高了基于满足总体评分作为辅助任务的有用性评论预测的准确性. 除此之外, Yang等人[13]提出, 在线评论的有用性预测受到评论中提到的一些细粒度方面的影响. 他们训练了一个基于方面的提取模型来衡量方面的覆盖率, 并将性能提高了7%. Sun等人[24]使用了方面的数量和方面的平均长度来帮助识别有用的评论.

2.2 上下文特征除了从评论文本和评分中获得特征之外, 诸如用户信息和产品信息等上下文特征也被用于研究其对用 户感知有用性的影响. Bilal等人[25]断言对于每个用户来说, 历史上有用的投票、过去评论的数量、评论的平均长度都是评论有用性预测的关键特征. 根据Qu等人[26]的说法, 评论的有用性会受到产品信息的影响, 而用户是否意识到相关的产品信息将会影响他们的购买选择. Fan等人[27]发现除了评论内容本身外, 评论的有用性预测还受目标产品的标题、品牌、类别和描述的影响. Li等人[28]通过4种度量找到了有用的评论, 包括可信度、可读性、保密性和LWC特性. Hong 等人[29–31]试图从产品特性中提取信息, 构建模型并最终获得了良好的性能.

3 本文方法 3.1 模型框架Yang等人[32]设计了一个层次注意网络, 利用语境注意机制来识别重要的词汇和句子. 此外, Wu等人[6]的研究表明, 对文档结构进行分层建模可以帮助生成更有效的内容表示. Du等人[7]将评分与评论内容分开编码, 自适应地调整内容表示的潜在方面的评分信息量. 然而, 这些方法忽略了明确的方面评分, 这为理解用户对产品的每个属性的情绪提供了重要的信息. 因此, 为了更好地探索评论内容中句子之间的深层关联, 并在学习评论内容表征时更多地关注与方面相关的词汇, 我们提出了一种新的多维度层次注意网络(简称HORA), 如图3所示.

该方法首先用BiGRU对单词的上下文信息进行编码, 并为每个单词生成一个上下文状态表示. 然后采用单词级注意力机制来计算每个单词的语义重要性, 并通过将单词的上下文状态聚合起来得到句子表示, 之后再利用BiGRU对句子之间的依赖关系进行建模, 为每个句子生成一个上下文状态表示. 基于此, 再通过一个句子级注意力机制来计算每个句子的权重, 并将句子状态的加权和作为评论内容表示. 最后, 将内容表示与总体评分连接起来, 得到最终的特征向量, 并根据所得到的特征向量预测评论的有用性.

|

图 3 模型架构 |

3.2 问题公式化

我们的目标是使用评论文本、总体评分和方面评分来执行在线评论的有用性预测任务. 我们的语料库是评论的集合, 假设一个评论内容由L个句子组成, 每个句子都是一个单词序列. 如果我们以第

1) 单词级BiGRU层: 类似于LSTM可以解决长期记忆和反向传播中的梯度问题, GRU也是一种递归神经网络. 然而, 对于非双向神经网络结构, 状态必须从前到后输出, 而在在线评论有用性预测研究任务中当前时刻的输出可以与前一时刻的状态和即将到来的时刻的状态相关联. 由于双向GRU网络更利于层次特征的提取, 因此我们选择了它. 首先, 我们使用GloVe预训练词向量

| xit=Wewit | (1) |

| ek=Ekaspectak | (2) |

因为一个单词的重要性高度依赖于上下文, 所以我们需要对每个单词的上下文信息进行编码. 根据 BiGRU神经网络模型图, 可以把 BiGRU 模型看做由前向 GRU 和反向 GRU 两部分组成, 第

| →hit=→GRU(xit) | (3) |

| ←hit=←GRU(xit) | (4) |

| hit=[→hit,←hit] | (5) |

2) 单词级注意力机制层: 以第

| uit=tanh(Wkwchit+Wkwaek+bkw) | (6) |

| αit=exp(uTitukw)∑Jt=1exp(uTitukw) | (7) |

| Ski=J∑t=1αithit | (8) |

现在, 我们已为每个方面生成一个句子表示, 为了得到集成所有方面信息的句子表示, 首先, 通过将

| tki=tanh(WwtSki+bwt) | (9) |

| βki=exp((tki)Txw)∑mk=1exp((tki)Txw) | (10) |

| Si=m∑k=1βkiSki | (11) |

3) 句子级BiGRU层: 与单词级BiGRU层一样, 句子级BiGRU层对句子之间的依赖关系进行编码, 旨在获得句子的上下文表示. 从第1个句子到最后一个句子, 在每个时间步长中, 前向GRU网络根据当前输入的句子序列和之前的句子序列计算句子的上下文状态, 从而记忆历史语义信息. 反向GRU网络计算从最后一句到第1个句子的状态, 以编码未来的上下文信息. 在每个时间步长中, 反向GRU网络产生的当前状态依赖于当前的目标句子和后面的句子序列. 最后, 将前向网络和后向网络在相应的时间步长上连接起来, 得到每个句子

| →hi=→GRU(Si),i∈[1,L] | (12) |

| ←hi=←GRU(Si),i∈[1,L] | (13) |

| hi=[→hi,←hi] | (14) |

4) 句子级注意力机制层: 句子级注意力机制层的目的是根据其上下文表征和方面评分来计算每个句子的语义权重, 计算过程类似于单词级注意力机制层. 首先, 将句子

| ui=tanh(Wkschi+Wksaek+bks) | (15) |

| αi=exp(uTiuks)∑Li=1exp(uTiuks) | (16) |

| Sk=L∑i=1αiui | (17) |

通过以上内容, 将基于每个方面生成一个评论内容表示, 为了获得最终的内容表示, 我们需计算每个评论表示的权重. 每个评论表示

| tk=tanh(WstSk+bst) | (18) |

| βk=exp((tk)Txs)∑mk=1exp((tk)Txs) | (19) |

| S=m∑k=1βktk | (20) |

5) 有用性预测层: 为了探讨方面评分与总体评分以及评论文本对于在线评论有用性预测的影响, 所提出的模型将综合了方面评分的内容表示和总体评分纳入了预测层. 具体地说, 首先通过全连接网络将总体评分r映射到与内容表示相同的潜在空间, 然后得到转换的总体评分表示

| er=Er⋅r | (21) |

| ˆy=W(S⊕er) + b | (22) |

最后通过减少黄金标签的分布和我们的模型在

| L=1NN∑j=1(yj−ˆyj)2 | (23) |

为了验证我们的预测模型HORA的性能, 我们从旅游网站TripAdvisor和健康IT平台WebMD构建了两个数据集. TripAdvisor网站提供与旅游相关的内容的评论, 如旅游景点、酒店和餐馆. 我们收集了239 876条酒店评论以及相应的总体评分和有用性投票数. 除了总体评分外, 每个评论包括以下6个方面的评分: {清洁度、地理位置、房间、服务、睡眠质量、价格}, 范围分为1−5. WebMD作为美国互联网医疗健康信息服务平台, 提供患者对各种药物的广泛评论. 我们收集了249 470篇药物评论, 每条评论都包括评论文本、有用性投票数、总体评分和3个方面评分: {易用性, 有效性, 满意度}, 取值区间仍为1−5. 在WebMD数据集中, 总体评分是方面评分的组合. 数据集的统计数据汇总见表1.

参照Mauro等人[33]的做法, 我们使用式(24)和式(25)来将有用性投票数规范化到区间(0−1):

| Helpfulness=f(|votes|) | (24) |

| f(x)=log(x+1)1+log(x+1) | (25) |

我们将数据集随机分成3个部分: 80%用于训练, 10%用于验证, 10%用于测试. 为了评价该模型的有效性, 我们采用了两个指标, 即平均绝对误差(MAE)[34]和均方根误差(RMSE)[35]来衡量预测的有用性标签和真实有用性标签之间的差异, 其定义如下:

| MAE=1NN∑k=1|yk−ˆyk| | (26) |

| RMSE=√1NN∑k=1(yk−ˆyk)2 | (27) |

其中,

我们在PyTorch框架中实现了模型, 并利用GloVe对单词嵌入进行了预训练. 为了加快训练速度, 我们限制一个评论文档最多有40个句子, 每一个句子不超过50个单词. 所有隐藏层的维度都设置为50; 批量大小设置为128. 辍学率为0.1. 当训练时, 我们使用优化器SGD来更新参数, 并根据经验设置初始学习率为0.01. 在优化过程中, 首先计算预测层的梯度, 并更新相应的参数. 基于预测层的梯度, 利用链式规则确定句子级注意力机制层的梯度, 并更新相应的参数. 然后依次对单词级注意力机制和BiGRU层执行类似的操作. 因此, 模型的所有参数都将被更新. 优化过程在目标函数收敛后完成. 最后, 我们根据验证集上的性能选择最佳参数, 并对测试集上的参数进行评估. 为了实验的严谨性, 我们将所有模型运行了5次, 最后结果见表2.

| 表 1 数据集统计汇总 |

| 表 2 各模型在两个数据集上的结果对比 |

4.3 基线模型

为了系统地评估我们提出的模型, 我们从之前的研究中选择了一系列具有代表性的基线方法, 以验证HORA模型的性能.

CNN[36]: 对一个句子进行卷积操作, 提取相邻特征, 然后通过池化层得到固定大小的表示.

Bi-LSTM: 对单词的上下文信息进行编码, 同时捕获过去和未来的信息, 得到单词序列的完整表示.

EG-CNN[37]: 普通CNN架构的一种变体, 在卷积操作之前执行字符编码和词编码.

CM1[22]: 普通CNN架构的一种变体, 其中将原始评分值和学习的内容表示连接在一起.

CM2[22]: 普通CNN架构的一种变体, 其中评分向量和单词嵌入被连接来学习内容表示.

ECRI[7]: 利用内容编码器和评分增强器将评分与评论内容分开编码, 自适应地调整内容表示的潜在方面的评分信息量.

MTNL[23]: 多任务学习的普通CNN架构的变体, 学习到的内容表示作为共享特征来预测评论的有用性和原始星级评分.

4.4 与基线模型对比结果实验结果如表2所示, 可将其分为两部分:使用了全部文本和评分信息的基线模型, 以及使用了部分文本和评分信息的基线模型.

从第1部分开始, 我们可以看到, CNN和Bi-LSTM的性能相对而言比较差, 即使它使用了评论文本, 总体评分和方面评分. 而与CNN和Bi-LSTM相比, 我们的模型HORA无论是在TripAdvisor数据集还是WebMD数据集上, 性能都有极大的提高, 均提高约9%−11%. 从第2部分开始, 首先, 我们观察到EG-CNN仅用到评论文本对问题进行建模, 而和同等条件下的HORA相比, HORA在TripAdvisor数据集上的MAE和WebMD数据集上的MAE, RMSE的效果明显优于EG-CNN, 虽然TripAdvisor数据集上的RMSE效果略差. 当应用更复杂的神经网络时, 比如MTNL, CM1, CM2, ECRI, 在同等条件下, 对于TripAdvisor数据集, 我们的模型在MAE和RMSE方面分别比之前的基线模型高出1%−5%和1%−4%. 对于WebMD数据集, 我们的模型在MAE和RMSE方面分别比之前的基线模型高出0.3%−4%和1%−4%. 对比表明, 我们的模型架构可以生成更有效的评论内容表示以提高在线评论有用性的预测性能.

4.5 多维评分的影响我们已经展示了HORA的结构对在线评论预测任务的有效性. 为了显示多维评分对于在线评论有用性的作用, 我们还比较了HORA在3种特征(即评论文本、总体评分和方面评分)的不同组合下的表现. 具体来说, 我们在保持其他参数设置不变的同时改变输入来执行不同维度的特征融合.

评论文本、总体评分和各个方面的评分是HORA中所用到的3种信息. 我们在表2下方展示了评论文本、总体评分和方面评分对在线评论有用性预测的影响. 从表中, 我们可以观察到: (1)与只使用评论的文本特征相比, 加入总体评分可以在两个数据集中分别实现1.6%、2.6%、1.4%和1.7%的改进, 这表明该模型对总体评分进行编码, 可以获得更丰富的文档表示, 对有用性预测帮助更大. (2)与仅用总体评分信息的模型相比, 考虑方面评分的模型在性能提升上更加明显, 可以在两个数据集中分别获得2.3%、4.1%和2.4%、3.1%的性能提升, 这表明方面评分有助于预测在线评论的有用性. (3)在综合考虑了评论文本、总体评分和方面评分以后, 与其他基线模型相比, HORA具有更小的平均绝对误差(MAE)和均方根误差(RMSE), 即我们的模型获得了最好的性能. 这说明充分利用用户留下来的信息数据, 进行多维度信息交互可以提高在线评论有用性的预测性能.

观察结果表明, 我们的模型以一种更有效的方式整合了评论文本, 总体评分, 方面评分三者的信息, 最终改进了评论有用性的预测性能.

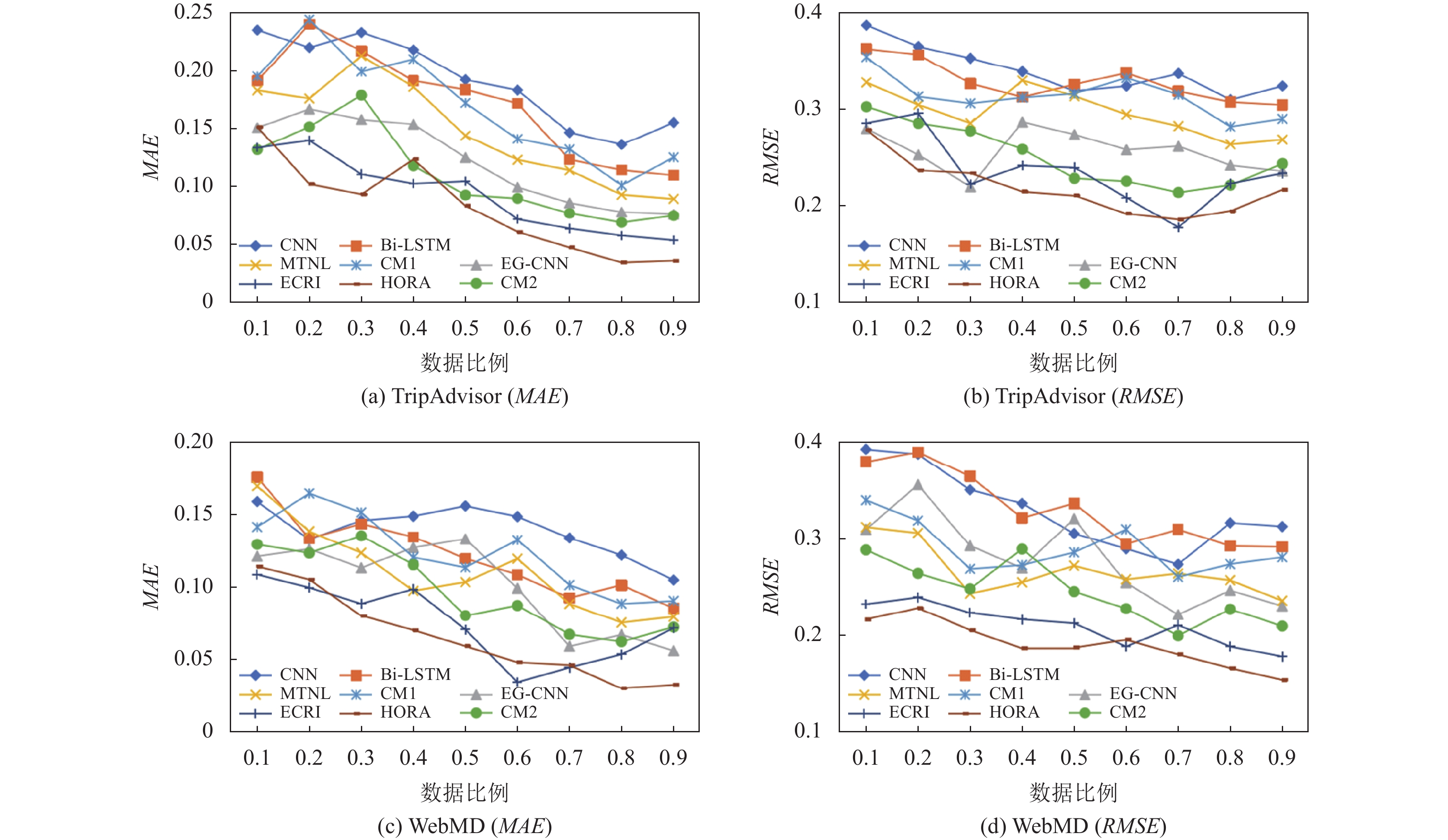

4.6 稳健性实验为了显示HORA的稳健性, 我们还进行了敏感性分析[38]. 具体来说, 我们将比率从0.1改变到0.9, 并检查当我们的方法与其他方法进行比较时, 性能是如何变化的. 如图4所示, 当训练数据的比例增加时, 两种评价指标的值都呈下降趋势, 即性能都有随着训练数据比例的增加而增加的总体趋势, 特别是当该比值等于和低于0.7时. 结果表明, 当比值大于0.7时, 大多数模型的性能都趋于稳定. 总的来说, 我们的模型比这些基线模型表现得更好. 对于一些特定的模型, 如ECRI, 与我们在TripAdvisor数据集上的模型性能相当, 但它们在WebMD数据集上实现的性能较低. 当训练数据的比例高于0.2时, HORA在MAE和RMSE两个评估指标上始终优于其他基线, 尽管大多数模型的性能曲线是混合的. 总的来说, 我们的方法比这些基线表现得更好, 而且也更稳健. 这说明在数据处理层面上, HORA模型在面临各类噪声情况下, 如虚假恶意评论, 数据缺失等问题时, 仍然能够较好地处理这些干扰, 提供合理的评论分析和情感判断以此来作出准确的有用性预测.

4.7 理论解释从众理论[19]认为消费者会根据大众的评价而做出购买决策. 一般消费者在确认自己的需求后, 便会自动地进入到信息搜索的过程, 而有经济头脑的消费者并不会因为最小努力原则而单纯从总体评分去做出购买决策, 因为评论星级的离散程度过大, 即评论者的总体星级水平远低于或高于平均星级水平时, 该条评论的可信度就会下降. 归因理论[39]认为评论者此时可能受到了除了产品因素以外的其他因素的刺激, 例如心情或者恶意发布虚假信息等, 因此大部分在线购买者都会充分查看已购买者留下来的信息数据, 比如除了总体评分以外, 还有产品的各个方面的评分, 以此来帮助自己作出正确的购买决策, 从而减少错误的购买成本.

|

图 4 所有模型在不同训练数据比例下的性能表现 |

5 总结与展望

预测在线评论的有用性和推荐有用的在线产品评论可以帮助用户做出明智的购买决策. 之前的方法主要集中于使用评论文本和总体评分等信息预测评论的有用性. 虽然考虑了评分, 但方面评分和其他潜在的可用性数据没有考虑. 本文提出了HORA, 一种用于评论有用性预测的深度神经网络模型, 它可以学习评分增强的内容表示. 与之前只使用文本内容和总体评分信息的工作相比, HORA采用多层次注意力机制, 利用多维度评分信息, 尤其是方面评分来统一文本效价和评分效价之间的一致性. 在两个真实数据集上进行的大量实验表明了HORA在学习文本特征和利用评分信息方面的前景.

虽然我们已经证明了HORA的有效性, 但本研究仍有其局限性, 有待于未来的进一步改进. 首先, 虚假评论检测是一个非常重要和具有挑战性的问题. 为了避免虚假评论的影响, 我们可以通过添加数据预处理层来扩展该框架, 该层可以自动识别基于内容的特征, 并从用户的行为中去判断. 其次, 我们的方法侧重于整合总体评分, 方面评分和评论内容来预测有用性, 在未来, 可以将用户, 产品等更多相关的信息集成到统一的框架中. 最后, 当前对于在线评论有用性预测这一研究领域, 研究人员并没有建立一个统一的数据集, 未来将需要一个共同的论坛来讨论这一领域的长期愿景.

| [1] |

冯进展, 蔡淑琴. 融合信息增益和梯度下降算法的在线评论有用程度预测模型. 计算机科学, 2020, 47(10): 69-74. DOI:10.11896/jsjkx.190700034 |

| [2] |

陈远高, 应梦茜, 毕然, 等. 管理者回复对在线评论与有用性关系的调节效应: 基于TripAdvisor的实证研究. 管理工程学报, 2021, 35(5): 110-116. |

| [3] |

Zhou SS, Guo B. The interactive effect of review rating and text sentiment on review helpfulness. Proceedings of the 16th International Conference on Electronic Commerce and Web Technologies. Valencia: Springer, 2015. 100–111.

|

| [4] |

Diaz GO, Ng V. Modeling and prediction of online product review helpfulness: A survey. Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics. Melbourne: ACL, 2018. 698–708.

|

| [5] |

Karimi S, Wang F. Online review helpfulness: Impact of reviewer profile image. Decision Support Systems, 2017, 96: 39-48. DOI:10.1016/j.dss.2017.02.001 |

| [6] |

Wu Z, Dai X Y, Yin C Y, et al. Improving review representations with user attention and product attention for sentiment classification. Proceedings of the 2018 AAAI Conference on Artificial Intelligence. New Orleans: AAAI, 2018.

|

| [7] |

Du JH, Rong J, Wang H, et al. Helpfulness prediction for online reviews with explicit content-rating interaction. Proceedings of the 20th International Conference on Web Information Systems Engineering. Hong Kong: Springer, 2019. 795–809.

|

| [8] |

Schneider C, Weinmann M, Mohr PNC, et al. When the stars shine too bright: The influence of multidimensional ratings on online consumer ratings. Management Science, 2021, 67(6): 3871-3898. DOI:10.1287/mnsc.2020.3654 |

| [9] |

Bu JH, Ren L, Zheng S, et al. ASAP: A Chinese review dataset towards aspect category sentiment analysis and rating prediction. Proceedings of the 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. ACL, 2021. 2069–2079.

|

| [10] |

Fei H, Li JY, Ren YF, et al. Making decision like human: Joint aspect category sentiment analysis and rating prediction with fine-to-coarse reasoning. Proceedings of the 2022 ACM Web Conference. Lyon: ACM, 2022. 3042–3051.

|

| [11] |

Hazarika B, Chen K, Razi M. Are numeric ratings true representations of reviews? A study of inconsistency between reviews and ratings. International Journal of Business Information Systems, 2021, 38(1): 85-106. DOI:10.1504/IJBIS.2021.118637 |

| [12] |

Martin L, Pu P. Prediction of helpful reviews using emotions extraction. Proceedings of the 2014 AAAI Conference on Artificial Intelligence. Québec City: AAAI, 2014.

|

| [13] |

Yang YF, Chen C, Bao FS. Aspect-based helpfulness prediction for online product reviews. Proceedings of the 28th IEEE International Conference on Tools with Artificial Intelligence (ICTAI). San Jose: IEEE, 2016. 836–843.

|

| [14] |

Liu HJ, Gao Y, Lv P, et al. Using argument-based features to predict and analyse review helpfulness. Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen: ACL, 2017. 1358–1363.

|

| [15] |

Ghose A, Ipeirotis P G. Estimating the helpfulness and economic impact of product reviews: Mining text and reviewer characteristics. IEEE Transactions on Knowledge and Data Engineering, 2011, 23(10): 1498-1512. DOI:10.1109/TKDE.2010.188 |

| [16] |

Korfiatis N, García-Bariocanal E, Sánchez-Alonso S. Evaluating content quality and helpfulness of online product reviews: The interplay of review helpfulness vs. review content. Electronic Commerce Research and Applications, 2012, 11(3): 205-217. DOI:10.1016/j.elerap.2011.10.003 |

| [17] |

Otterbacher J. ‘Helpfulness’ in online communities: A measure of message quality. Proceedings of the 2009 SIGCHI Conference on Human Factors in Computing Systems. Boston: ACM, 2009. 955–964.

|

| [18] |

Chen C, Yang YF, Zhou J, et al. Cross-domain review helpfulness prediction based on convolutional neural networks with auxiliary domain discriminators. Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Short Papers). New Orleans: ACL, 2018. 602–607.

|

| [19] |

Lee S, Lee S, Baek H. Does the dispersion of online review ratings affect review helpfulness? Computers in Human Behavior, 2021, 117: 106670.

|

| [20] |

Lee S, Choeh JY. Predicting the helpfulness of online reviews using multilayer perceptron neural networks. Expert Systems with Applications, 2014, 41(6): 3041-3046. DOI:10.1016/j.eswa.2013.10.034 |

| [21] |

Mukherjee S, Popat K, Weikum G. Exploring latent semantic factors to find useful product reviews. Proceedings of the 2017 SIAM International Conference on Data Mining. Houston: SDM, 2017. 480–488.

|

| [22] |

Qu XS, Li XP, Rose JR. Review helpfulness assessment based on convolutional neural network. arXiv:1808.09016, 2018.

|

| [23] |

Fan M, Feng Y, Sun MM, et al. Multi-task neural learning architecture for end-to-end identification of helpful reviews. Proceedings of the 2018 IEEE/ACM International Conference on Advances in Social Networks Analysis and Mining (ASONAM). Barcelona: IEEE, 2018. 343–350.

|

| [24] |

Sun XY, Han MX, Feng J. Helpfulness of online reviews: Examining review informativeness and classification thresholds by search products and experience products. Decision Support Systems, 2019, 124: 113099. DOI:10.1016/j.dss.2019.113099 |

| [25] |

Bilal M, Marjani M, Lali MI, et al. Profiling users’ behavior, and identifying important features of review “helpfulness”. IEEE Access, 2020, 8: 77227-77244. DOI:10.1109/ACCESS.2020.2989463 |

| [26] |

Qu XS, Li XP, Farkas C, et al. An attention model of customer expectation to improve review helpfulness prediction. Proceedings of the 42nd European Conference on Advances in Information Retrieval. Lisbon: Springer, 2020. 836–851.

|

| [27] |

Fan M, Feng C, Guo L, et al. Product-aware helpfulness prediction of online reviews. Proceedings of the 2019 World Wide Web Conference. San Francisco: ACM, 2019. 2715–2721.

|

| [28] |

Li ST, Pham TT, Chuang HC. Do reviewers’ words affect predicting their helpfulness ratings? Locating helpful reviewers by linguistics styles. Information & Management, 2019, 56(1): 28-38. DOI:10.1016/j.im.2018.06.002 |

| [29] |

Hong Y, Lu J, Yao JM, et al. What reviews are satisfactory: Novel features for automatic helpfulness voting. Proceedings of the 35th International ACM SIGIR Conference on Research and Development in Information Retrieval. Portland: ACM, 2012. 495–504.

|

| [30] |

Kim SM, Pantel P, Chklovski T, et al. Automatically assessing review helpfulness. Proceedings of the 2006 Conference on Empirical Methods in Natural Language Processing. Sydney: ACM, 2006. 423–430.

|

| [31] |

Liu JJ, Cao YB, Lin CY, et al. Low-quality product review detection in opinion summarization. Proceedings of the 2007 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning (EMNLP-CoNLL). Prague: ACL, 2007. 334–342.

|

| [32] |

Yang ZC, Yang DY, Dyer C, et al. Hierarchical attention networks for document classification. Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. San Diego: ACL, 2016. 1480–1489.

|

| [33] |

Mauro N, Ardissono L, Petrone G. User and item-aware estimation of review helpfulness. Information Processing & Management, 2021, 58(1): 102434. |

| [34] |

Jin ZP, Li QD, Zeng DD, et al. Jointly modeling review content and aspect ratings for review rating prediction. Proceedings of the 39th International ACM SIGIR Conference on Research and Development in Information Retrieval. Pisa: ACM, 2016. 893–896.

|

| [35] |

Chen HM, Sun MS, Tu CC, et al. Neural sentiment classification with user and product attention. Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Austin: ACL, 2016. 1650–1659.

|

| [36] |

Chen YH. Convolutional neural network for sentence classification [Master’s thesis]. Waterloo: University of Waterloo, 2015.

|

| [37] |

Chen C, Qiu MH, Yang YF, et al. Review helpfulness prediction with embedding-gated CNN. arXiv:1808.09896, 2018.

|

| [38] |

Zhang Z, Wei X, Zheng XL, et al. Predicting product adoption intentions: An integrated behavioral model-inspired multiview learning approach. Information & Management, 2021, 58(7): 103484. |

| [39] |

苗蕊, 徐健. 评分不一致性对在线评论有用性的影响——归因理论的视角. 中国管理科学, 2018, 26(5): 178-186. DOI:10.16381/j.cnki.issn1003-207x.2018.05.018 |

2023, Vol. 32

2023, Vol. 32