图像超分辨率(SR)是计算机视觉中的一个热点问题, 其目的是从相应的低分辨率(LR)图像中恢复具有丰富高频细节的高分辨率(HR)图像. 在遥感领域, 从卫星上观测到的图像可以在许多领域发挥重要作用并具有实用价值, 例如环境监测、资源勘探和监测. 然而, 由于硬件和低成本成像传感器的限制, 很难直接获得高分辨率(HR)图像. 因此, 低成本和高效的超分辨率重建技术(SR)应运而生, 充分利用低分辨率图像的信息, 重建出质量更好的高分辨率图像.

1 相关研究对于任何给定的低分辨率(LR)图像都存在多重解. 为了解决这一问题, 近年来提出了许多SR技术, 这些技术主要分为基于插值的方法[1]、基于重建的方法[2]以及基于学习的方法[3,4]. 基于学习的方法可进一步分为邻域嵌入方法[5]、稀疏编码方法[6]和基于卷积神经网络(CNN)的方法.

Dong等人[7]首先提出了一种三层卷积神经网络SRCNN, 其性能优于许多传统的SR方法. Liebel等人[8]首次提出将SRCNN用于遥感图像超分辨率重建. Lei等人[9]设计了一种“分支”结构的网络(local-global combined network, LGCnet), 来学习遥感图像的多尺度表示, 利用CNN随着网络深度加深感受野也随之扩大的特性, 将浅层和深层的特征映射进行级联从而实现局部与全局信息的结合. Haut等人[10]将视觉注意力机制融入到基于残差的网络设计中(remote sensing residual channel attention network, RSRCAN), 该机制能够引导网络训练过程朝向信息量最大的特征. Ahn等人[11]提出了级联残差网络(CARN), 该网络使用级联连接来融合局部和全局表示.

尽管这些基于CNN的方法在图像SR方面取得了重大进展, 但它们平等地对待不同的通道, 这在处理不同通道信息缺乏灵活性. 为了解决这个问题, Hu等人首先提出了SENet (squeeze-and-excitation network)[12], 该网络设计了一个通道注意模块来提高分类精度. 受SENet的启发, Zhang等人提出了一种用于自然图像SR的深度残差通道注意网络(RCAN)[13], 其中设计了一个通道注意(CA)模块, 自适应地学习不同通道的重要性. 目前基于注意力的方法通常仅从单个级别提取特征. 尽管一些文献也考虑了融合多级特征[9], 但它们忽略了不同通道和不同空间区域的不同重要性.

在本文中, 提出反投影注意力网络来克服这些问题. 每个初始残差注意块包含初始模块和注意模块. 初始模块用于通过使用3个卷积层提取局部多级特征, 随后通过使用另一个特征融合层融合提取的特征. 注意力模块结合通道注意力和空间注意力使网络更加关注高频信息的区域.

2 超分辨率重建方法考虑到遥感影像丰富的纹理信息和复杂的空间位置信息, 本文提出了一种基于反投影注意力网络的超分辨率模型, 其中使用了密集连接的上投影单元和下投影单元[14], 上投影单元的输出结果不仅作为下投影单元的输入还作为初始残差注意块(inception residual attention blocks, IRAB)[15]的输入, 通过IRAB使网络更加关注高频信息的区域.

2.1 网络结构考虑到遥感影像的特点, 本文提出了反投影注意力网络, 该网络采用迭代上采样策略, 其整体结构如图1所示, 该网络模型分为插值上采样分支和主网络分支. 主网络分支又分为4个部分: 特征提取部分、迭代投影部分、重构部分、IRAB.

2.1.1 插值上采样分支使用上采样分支使我们的网络学习全局残差. 该算法如图1所示, 可以用式(1)表示:

| Ibicubic=Hbicubic(ILR) | (1) |

其中,

(1)特征提取部分: 使用Conv(3, n0)从输入构建初始LR特征映射L0. 然后使用Conv(1, nR)将维数从n0降至nR, 然后进入投影步骤, 其中n0为初始LR特征提取中使用的卷积核个数, nR为每个投影单元中使用的卷积核个数.

(2)投影部分: 初始特征提取之后是一系列投影单元, 交替构建LR和HR特征映射, 通过密集连接使每个投影单元都可以访问所有先前投影单元的输出. 投影单元的结构如图2所示.

(3)重构部分: 使用3×3的卷积将拼接后的HR图像重构为SR图像, 其中fRec使用conv(3, 3)作为重构, [IRAB1, IRAB2, …, IRABt]是指在每个IRAB中产生的特征图的拼接, 称为深度拼接.

2.1.3 初始残差注意块(IRAB)IRAB共分为两个模块, 分别是Inception模块和Attention模块, 使得IRAB通过Inception模块捕获多层信息, 通过Attention模块是网络更加关注携带高频信息的区域, 其结构如图3所示.

|

图 1 网络结构 Fig. 1 Network structure |

|

图 2 投影单元 Fig. 2 Projection unit |

|

图 3 初始残差注意块 Fig. 3 Inception residual attention block |

(1) Inception模块

在Inception模块中, 首先使用了3个卷积层(即Conv(1, C), Conv(3, C), Conv(3, C))提取具有不同感知尺度的特征, 随后, 利用另一个卷积层对提取的特征进行融合. 假设第i个IRAB的输入是Fup, 4个卷积层可以表示为:

| {F1=f1,1(Fup)F2=f2,2(ReLU(F1))F3=f3,3(ReLU(F2))FInception=f4,1([F1,F2,F3]) | (2) |

其中, f(∙)表示卷积操作, k是卷积核的大小, [∙]表示拼接操作, F1、F2和F3表示不同感知尺度的特征图, FInception是Inception模块的最终输出, 它将被用作注意力模块的输入.

(2) Attention模块

LR遥感场景图像包含丰富的低频和有价值的高频特征. 低频特征似乎更平坦. 高频特征通常是区域、充满了边缘、纹理和其他细节. 在SR领域中, 高频通道特征对HR重构更为重要. 因此我们使用Attention模块, 该模块由通道注意模块和空间注意模块两个子模块组成.

通道注意模块用于提取不同通道的重要性, 整个通道注意模块的过程如下:

| Fc=Achannel⊗FInception | (3) |

| Fca=Fc+FInception | (4) |

其中, Fc表示中间特征图, Achannel表示通道注意向量, Fca表示输出的特征图,

考虑到不同的池化操作可能会收集到不同的重要特征, 本文使用两种池化操作来压缩输入特征图的信息, 之后得到两个通道向量, 其中每个通道向量的大小为R1×1×C, 随后将每个通道向量输入到具有一个隐藏层的共享全连接层(SFCL), 使用elementwise求和后使用激活函数, 可以得到通道注意向量Achannel. 因此, 计算通道细化特征图Fca过程如下:

| Fc=σ(SFCL(MaxPool(FInception))+SFCL(AvgPool(FInception)))⊗FInception | (5) |

| SFCL(MaxPool(FInception))=σ(Wuδ(WdMaxPool(FInception))) | (6) |

| SFCL(AvgPool(FInception))=σ(Wuδ(WdAvgPool(FInception))) | (7) |

其中, δ表示ReLU激活函数,

空间注意模块使网络更加关注携带高频信息的区域, 整个空间注意模块的过程如下:

| Fsa=Aspatial⊗Fca | (8) |

其中, Fsa表示输出的特征图, Aspatial表示空间注意向量,

沿着Fca的通道, 利用平均池化和最大池化操作, 对不同通道中每个位置的空间信息进行聚合, 分别生成两个特征图, 之后应用Conv(5, 2)得到融合后的特征图Ffused, 使用Conv(1, 1)将融合特征图压缩为一个通道, 最后使用Sigmoid函数得到空间特征权重Aspatial, 计算过程如下:

| Aspatial=σ(f(Ffused)) | (9) |

| Ffused=δ(f([MaxPool(Fca),AvgPool(Fca)])) | (10) |

其中, δ表示ReLU激活函数, σ表示Sigmoid函数, f(∙)表示卷积操作.

2.2 损失函数损失函数指导着网络优化的方向, 目前已经提出了许多损失函数, 例如L1损失和L2损失. 其中, L1损失函数已被证明在SR任务中更有用, 因此本文使用L1损失函数, 给定一个训练集

| L(θ)=1N∑Ni=1‖ˆIiHR−IiHR‖ | (11) |

本文选用AID[16]的遥感影像作为实验数据集, 该数据集来自Google Earth, 包含30个类别的场景图像, 其中每个类别有约220–420张, 整体共计10000张, 其中每张像素大小为600×600. 从每个类中随机抽取10张图像组成测试集, 从每个类中随机抽取5张图像组成验证集, 剩余的9550张图像组成训练集, 在实验过程中首先将RGB通道转为YCrCb模式, 将Y通道的数据提取出来作为主要处理对象, 通过对Y通道在特定的缩放因子上进行双三次插值下采样得到LR图像. 最后, 使用数据增强技术扩展训练集, 并随机旋转90°、180°、270°和翻转.

为了验证本文网络的性能, 本文的实验环境如表1所示.

在训练时, 针对不同的缩放因子, 投影单元中所使用的卷积核的大小是不同的. 对于×2的任务, 使用6×6, stride=2, padding=2的卷积核; 对于×3的任务, 使用7×7, stride=3, padding=2的卷积核; 对于×4的任务, 使用8×8, stride=4, padding=2的卷积核. 采用Adam优化器对网络进行优化, 其中Adam动量参数设置为β1=0.9, β2=0.999, ϵ=10−8, 初始学习率为1×10−4, 50个epoch后, 学习率降低到初始学习率的一半.

| 表 1 实验环境 Table 1 Experimental environment |

3.2 评价指标

本文选择峰值信噪比(peak signal-to-noise ratio, PSNR)[17]和结构相似度(structure similarity index, SSIM)[18]作为评价指标, 其公式如式(12)、式(14):

| PSNR(I,ˆI)=10log2552MSE(I,ˆI) | (12) |

其中,

| MSE(I,ˆI)=∑WW=1∑Hh=1(I(h,w)−ˆI(h,w))2H×W | (13) |

其中, W和H分别是图像的宽度和高度. PSNR值越大, 重构效果越好.

| SSIM(I,ˆI)=(2μIμˆI+C1)(σIˆI+C2)(μ2I+μ2ˆI+C1)(σ2I+σ2ˆI+C2) | (14) |

SSIM(∙)表示HR图像I与重建后的SR图像

为了验证本文方法的重建性能, 选择SRCNN、SAN、DSSR和DASR这4种方法进行2倍、3倍和4倍的重建实验对比, 实验结果见表2.

表2给出了本文方法及对比方法在不同数据集上的实验结果, 并以加粗字体表示最优结果, 从表格可以看出, 本文提出的方法在两个指标上基本优于比较方法, 只在个别类中略低于比较方法, 但差值并不显著. 通过观察所有测试图像的平均PSNR和平均SSIM, 证明了本文模型在超分辨率重建任务上的有效性.

| 表 2 不同方法在部分数据集上的PSNR(dB)和SSIM结果 Table 2 PSNR and SSIM results of partial methods on different data sets |

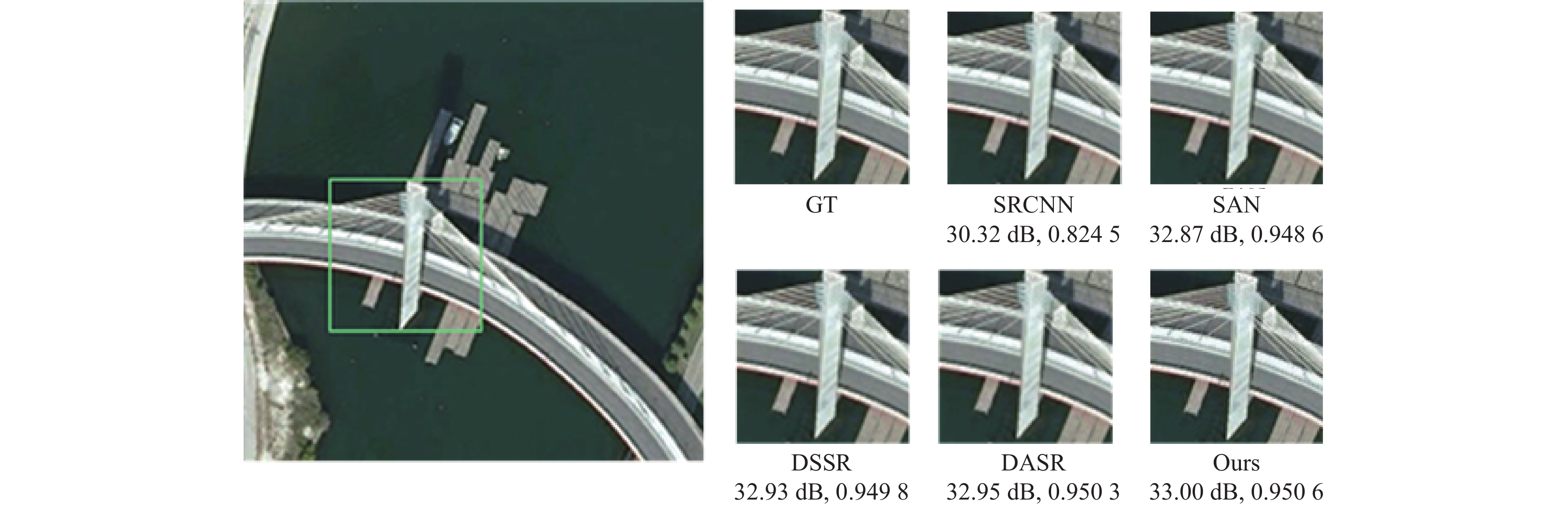

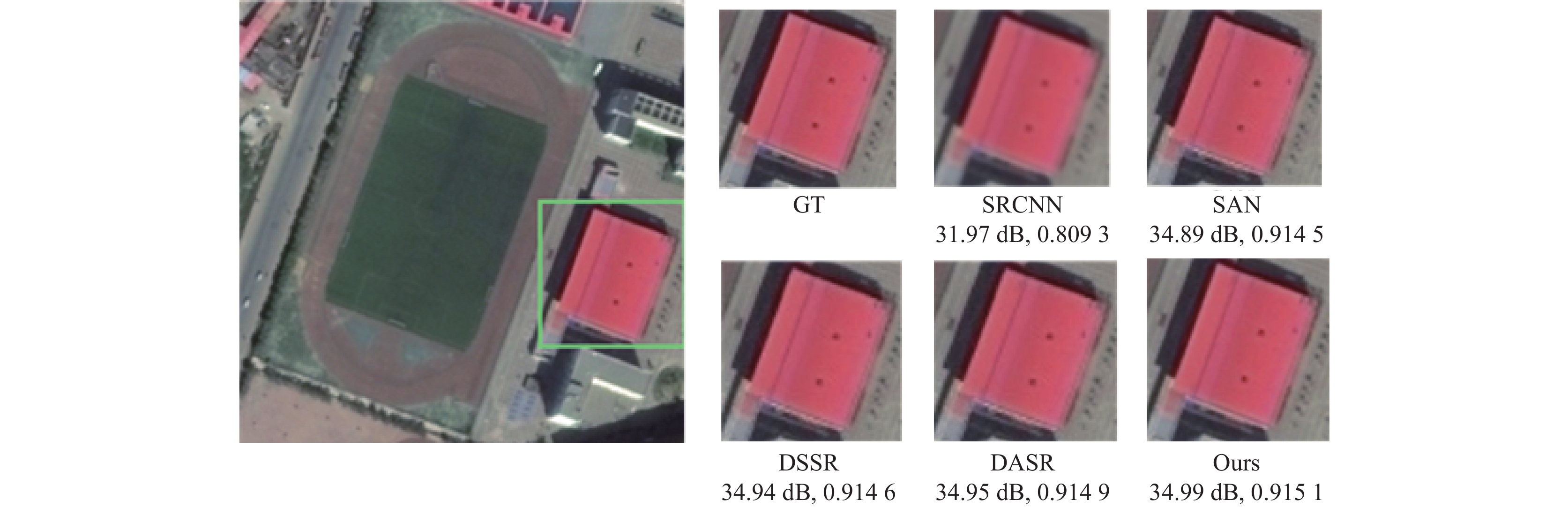

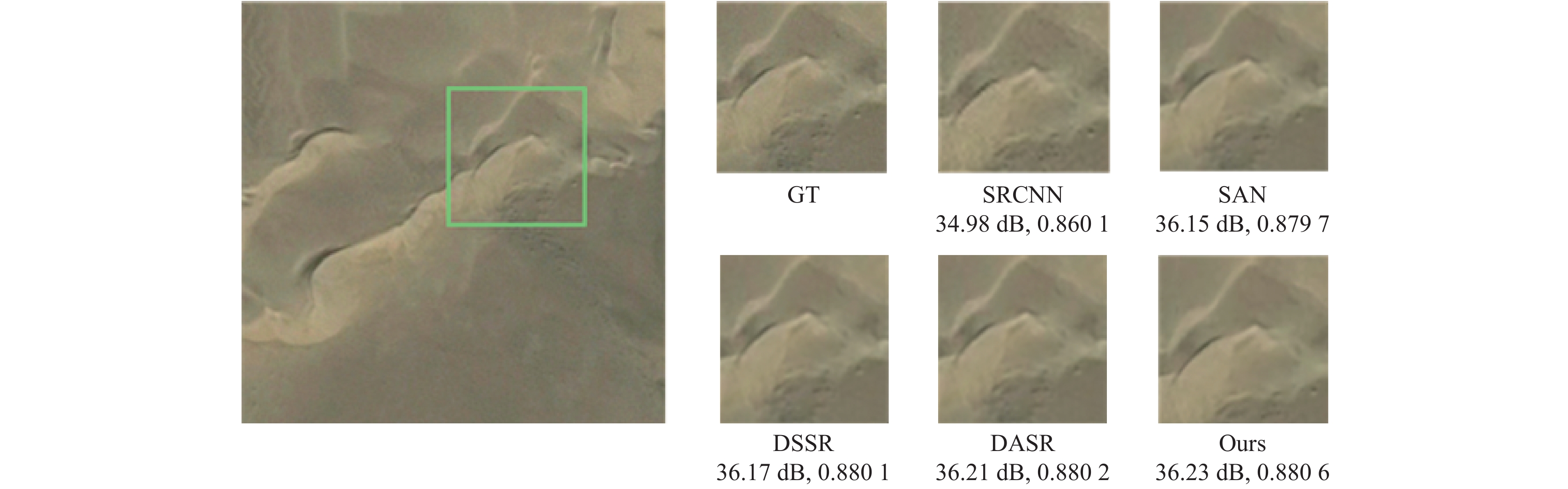

图4–图6给出了5种方法在×2、×3和×4不同放大倍数下对遥感影像测试集中部分影响的重建结果, 并与真实高分影像(GT)进行对比. 从图中可以看出本文所提方法重建得到的图像与原始图像更加接近, 影像细节更加丰富, 说明本文方法能够更好地重建出细节特征.

4 结论与展望本文提出了一种基于反投影注意力网络的超分辨率重建方法, 在该网络中, 联合了深度反投影网络和初始残差注意块. 利用上、下投影单元的误差反馈来引导网络达到更好的效果, 同时将上投影单元的输出结果作为初始残差注意块的输入, 通过初始模块融合不同网络深度的多层次特征, 为重构提供更详细的信息, 同时不引入过多的参数; 通过注意模块使网络更加关注高频信息的区域, 有助于网络恢复更完整的边缘和更详细的纹理. 在测试图像上的实验结果表明, 与其他方法相比, 该方法可以获得较好的效果.

|

图 4 bridge测试集2倍超分辨率重建结果对比 Fig. 4 Super-resolution results comparison of bridge test set for scale factor |

|

图 5 playground测试集3倍超分辨率重建结果对比 Fig. 5 Super-resolution results comparison of playground test set for scale factor |

|

图 6 desert测试集4倍超分辨率重建结果对比 Fig. 6 Super-resolution results comparison of desert test set for scale factor 3 |

| [1] |

Zhang L, Wu XL. An edge-guided image interpolation algorithm via directional filtering and data fusion. IEEE Transactions on Image Processing, 2006, 15(8): 2226-2238. DOI:10.1109/TIP.2006.877407 |

| [2] |

Kim KI, Kwon Y. Single-image super-resolution using sparse regression and natural image prior. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(6): 1127-1133. DOI:10.1109/TPAMI.2010.25 |

| [3] |

Huang JB, Singh A, Ahuja N. Single image super-resolution from transformed self-exemplars. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 5197–5206.

|

| [4] |

Schulter S, Leistner C, Bischof H. Fast and accurate image upscaling with super-resolution forests. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 3791–3799.

|

| [5] |

Chang H, Yeung DY, Xiong YM. Super-resolution through neighbor embedding. Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004. Washington: IEEE, 2004. 1.

|

| [6] |

Yang JC, Wright J, Huang TS, et al. Image super-resolution via sparse representation. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873. DOI:10.1109/TIP.2010.2050625 |

| [7] |

Dong C, Chen CL, He KM, et al. Learning a deep convolutional network for image super-resolution. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 184–199.

|

| [8] |

Liebel L, Körner M. Single-image super resolution for multispectral remote sensing data using convolutional neural networks. ISPRS-International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences. Copernicus Publications, 2016. 883–890.

|

| [9] |

Lei S, Shi ZW, Zou ZX. Super-resolution for remote sensing images via local-global combined network. IEEE Geoscience and Remote Sensing Letters, 2017, 14(8): 1243-1247. DOI:10.1109/LGRS.2017.2704122 |

| [10] |

Haut JM, Fernandez-Beltran R, Paoletti ME, et al. Remote sensing image superresolution using deep residual channel attention. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(11): 9277-9289. DOI:10.1109/TGRS.2019.2924818 |

| [11] |

Ahn N, Kang B, Sohn KA. Fast, accurate, and lightweight super-resolution with cascading residual network. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 256–272.

|

| [12] |

Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. DOI:10.1109/TPAMI.2019.2913372 |

| [13] |

Zhang YL, Li KP, Li K, et al. Image super-resolution using very deep residual channel attention networks. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 294–310.

|

| [14] |

Haris M, Shakhnarovich G, Ukita N. Deep back-projection networks for super-resolution. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 1664–1673.

|

| [15] |

Lei PC, Liu C. Inception residual attention network for remote sensing image super-resolution. International Journal of Remote Sensing, 2020, 41(24): 9565-9587. DOI:10.1080/01431161.2020.1800129 |

| [16] |

Xia GS, Hu JW, Hu F, et al. AID: A benchmark data set for performance evaluation of aerial scene classification. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(7): 3965-3981. DOI:10.1109/TGRS.2017.2685945 |

| [17] |

褚江, 陈强, 杨曦晨. 全参考图像质量评价综述. 计算机应用研究, 2014, 31(1): 13-22. |

| [18] |

Kim J, Lee JK, Lee KM. Accurate image super-resolution using very deep convolutional networks. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1646–1654.

|

2023, Vol. 32

2023, Vol. 32