近年来, 互联网尤其是在移动互联应用发展迅猛, 随之产生的信息数据也是呈爆炸性增长. 而推荐系统的出现提供了一种从庞杂的信中提取信息的手段, 在学术和工业界引起了极大的关注[1].

推荐系统用来帮助用户发现与其兴趣相关项目并提供不断提高用户体验. 在工业推荐系统中, 数据存储通常包含数十亿个项目, 这使得无法对每个项目与用户之间的相似度进行全面计算. 因此, 工业推荐系统的第1阶段是检索项目的候选生成. 在这个阶段, 系统会选择数百或数千个项目作为候选项, 然后将它们发送到后续的评分和排名阶段进行更精细的处理. 候选生成的目标是在不消耗过多计算资源的情况下, 为用户提供有吸引力的产品或服务. 为了实现这个目标, 候选生成器通常会采用一些技术, 例如倒排索引和图上的随机游走, 候选生成器的任务是在计算成本可控的前提下返回有限数量的候选项目.

顺序推荐系统捕获用户从过去到最近一段时间内的兴趣, 进而根据用户顺序参与项目的历史信息力求准确的推荐对用户最具吸引力的项目; 对于顺序推荐系统从不同角度利用用户的顺序参与记录, 可分为两种方式: 以用户为中心和以项目为中心的模型.

近来的研究中发现[2,3]对个人消费兴趣进行多重嵌入的重要性, 并希望以此来获取到用户的多重兴趣, 因为用户不会只对单一的主题感兴趣, 可能同时对多个主题感兴趣; 然而多个兴趣的折叠嵌入可能与其他的主题最为接近. 此外, 在分类和链接预测任务中显示了多重嵌入的优势[4]. 在多重嵌入中, 每个嵌入的权重也是十分重要的, 以往的多重嵌入方法, 例如PinnerSage[5], 假设嵌入的数量在所有用户中都是固定的, 这样会导致超参数的查找成本很高, 而且所有用户拥有相同数量兴趣的假设也是不可靠的. 一些休眠用户则可以使用一个或两个向量来很好地表示, 而其他用户则有更为多样化的兴趣集, 需要有几十个嵌入来表示他们. 在最近的一项研究[6]中提出了用户对每个项目的兴趣是否会持续到训练时间结束后, 这个概念被称为兴趣可持续; 其明确预测用户每个兴趣项目是否会在最近一段时间内被消费. 在顺序推荐模型研究中, Vaswani等[7]提出的Transformer网络为顺序建模带来了很大发展. 对于以用户为中心的模型没有很好的考虑到用户的兴趣持续性是否会超过训练的时间; 以项目为中心的模型虽然很好的考虑到了用户兴趣的持续性[8], 但是缺乏个性化的推荐.

对于上述问题, 需要有一种方法来改进. 本文提出的算法模型综合以商品和用户为中心的顺序推荐系统优势, 同时引用了个性化和上下文感知的兴趣权重, 在多个维度上学习用户兴趣. 主要贡献如下.

(1)利用用户其他的消费商品来补充每个项目用户的消费历史; 通过有着相同兴趣的群体用户的消费历史来填充目标用户的稀疏的消费历史.

(2)利用用户的连续购买(点击)历史为基点找到建立多种嵌入, 每个嵌入都代表用户对某个类别的兴趣, 为每个嵌入分配权重, 并通过从权重更高的嵌入中检索更多候选对象来改进候选生成的调用.

1 相关工作 1.1 顺序推荐模型推荐系统中的一个基本的认知是, 用户嵌入应该从用户的历史行为中推断出来[9], 因此顺序模型对于推荐模型是非常重要的. 之前使用的经典序列模型是马尔可夫链, 国内研究者He等[10]使用马尔可夫链很好地捕捉了一个序列的短期表现, 但是其对长序列的记忆表现一般. 后来出现的递归神经网络对长序列具有更强的表示能力, Xu等[11]将其用于从任意长序列中学习用户嵌入. 近几年, Li等[12]把Transformer网络用在顺序推荐模型上取得了比较好的推荐效果. 但是一般的模型并没有利用用户历史参与的项目来捕获他们的兴趣偏好.

以用户为中心的顺序模型主要利用点击或者购买商品信息来捕获用户的兴趣偏好. 国外研究者提出的SASRec模型[13]将自注意力机制应用于推荐系统, 以捕获与RNN和CNN相比消费项目之间的长期依赖性; 以及STAR-GCN模型[14]利用图卷积网络(GCN)对用户行为序列进行建模, 并通过多层堆叠和重构来提取更丰富的特征表示. 近来, 国内对于以用户为中心的顺序模型的研究有, LSAN模型[15]基于CNN和自注意力机制捕获了消费品之间的局部和全局的交互联系; 以及RippleNet模型[16]利用图神经网络和传播机制, 将用户的偏好信号在知识图谱上传播, 以进行个性化推荐. 虽然以上这些模型都达到了比较好的效果, 但并没有考虑到用户的兴趣是否会持续到训练时间结束之后. 以项目为中心的模型通过利用所有用户对每个项目的消费历史来捕获用户对每个产品的一般兴趣偏好. 根据国内以往的以项目为中心的研究来看, 如Wang等[17]考虑了每个项目最后一次消费之后的时间段, 以预测未来项目的重复消费; DIN模型[18]利用注意力机制建模用户对项目的兴趣, 同时考虑项目之间的关系, 提高点击率预测的精度和个性化能力. 同样, 国外对于此的研究也取得了一些进展, 如CRIS模型[7]通过预测每个项目是否在最近一段训练时间内消费, 以此来预测用户对项目的普遍兴趣是否会持续到未来; NISAML模型[19]用于下一个项目的推荐, 利用自注意力机制和度量学习方法, 捕捉用户行为序列中的关键信息, 并进行个性化推荐; 近来以项目为中心的模型[7]比以用户为中心的模型显示出更好的推荐准确性. 然而, 这些模型侧重于非个性化的兴趣偏移, 其倾向于推荐一般消费品, 而没有考虑到每个用户的个性化需求, 例如爱好素食或肉食. 本文通过预测每个用户的消费来获取个性化兴趣可持续性和预测用户在最近一段训练时间内的消费量, 来了解每个用户在训练时间之外可能消费哪些项目.

1.2 多兴趣用户表示使用多种嵌入的方式表示用户大大提高了推荐质量, 但并不是所有现有的推荐模型都能很容易地扩展到多兴趣框架. 经典的协同过滤和矩阵分解方法不会自然产生多个用户嵌入, 序列模型(如RNN和基于注意力的模型)也不会自然产生. 为了从用户参与项目历史中获取其多兴趣偏好, 国内外的研究方法大都是采用了启发式方法[20]和无监督学习方法, 国外的研究方法主要有, 如层次化聚类方法[5]和本体论社区挖掘方法[21]; 国内关于这方面采用的方法主要有, 混合推荐和基于图的推荐[22]. 此外, 科研人员还努力修改现有的神经网络以产生多种结果, 如文献[23]使用的动态路由胶囊网络和文献[24]使用的多头自注意力模型. 然而, 以上的模型是将用户兴趣的数量作为超参数进行估计, 并且不了解兴趣的权重. 因此, 它们为每个用户生成相同数量的聚类, 并以相同的权重对待用户的每个兴趣.

2 MIES算法本文提出的算法模型, 综合利用了顺序推荐系统的优势以及引用了个性化上下文感知兴趣权重, 从而捕捉用户的多维兴趣以及其兴趣的持续性; 该算法模型名为MIES (multi internal external sustainability). 该算法定义

因为事先设置了预测用户在训练时间内消费项目的目标, 因此该模型可以像以项目为中心的模型一样侧重于用户最近的偏好; 由于测试时间和捕获用户最新偏好的时间的间隔很短, 可以提供准确的推荐. 本文将最接近训练时间的一段时间认为是未来, 并根据时间

| hu=hpu∪hru | (1) |

| hpu=(i,t)|(i,t)∈hu,t<T | (2) |

| hru=(i,t)|(i,t)∈hu,t⩾T | (3) |

其中,

因为把用户的消费历史分为了两部分, 所以算法要根据用户过去的消费历史

| yu,i=1[i∈hru] | (4) |

其中,

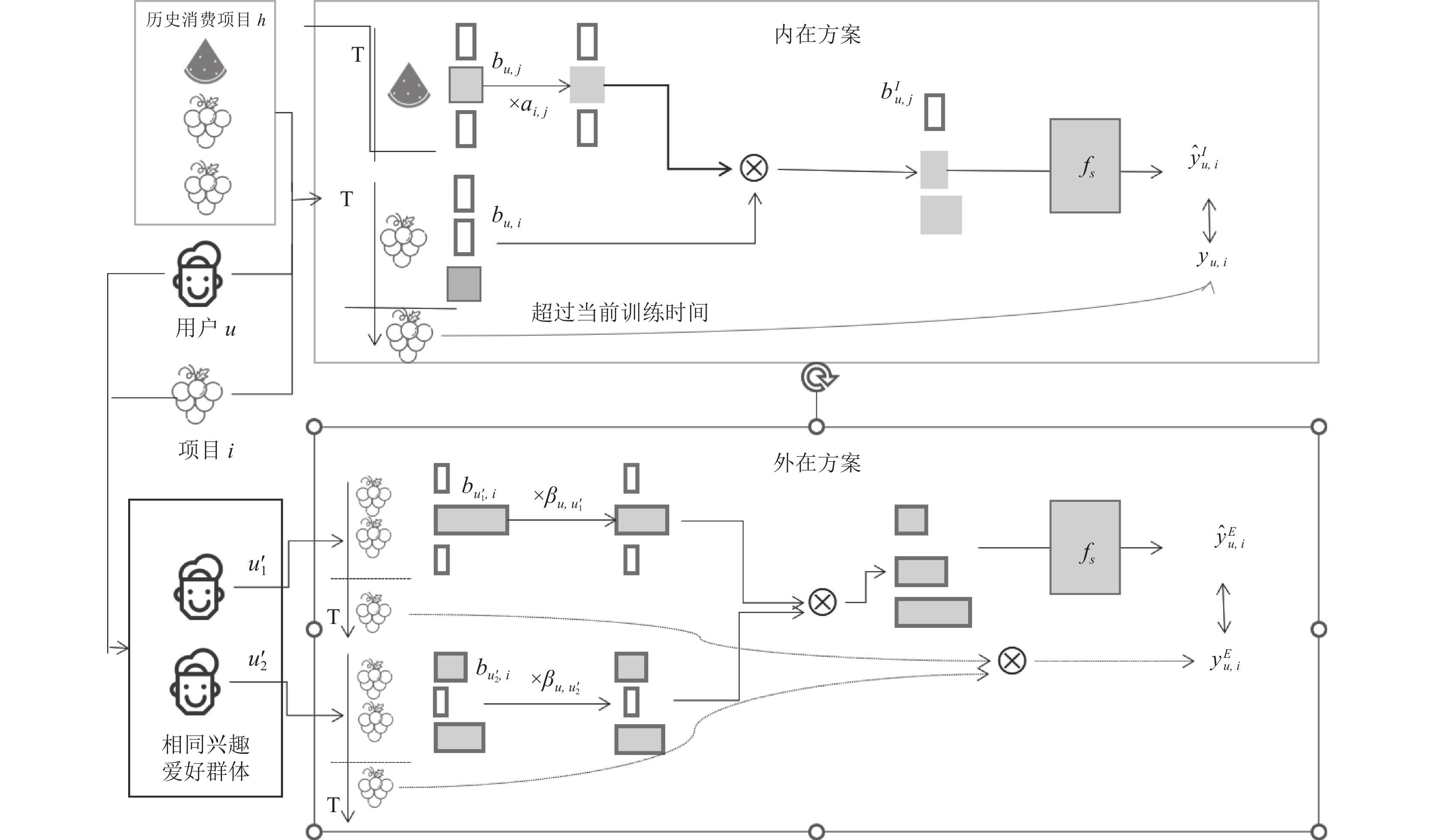

内在补充方案如图1所示, 在用户消费的其他项目情况下, 增加用户对一个项目的消费历史来缓解数据稀疏. 其基本思想是, 如果用户最近消费了类似的项目, 则用户对类似项目的兴趣被认为是持续的. 总体上来说, 内在方案的目标是利用用户消费其他商品的特征值, 基于一种项目相似度的计算来增强当前项目的特征值:

| bIu,i=b(u,i)+∑j∈hpu∖{i}ai,j⋅bu,j | (5) |

| ai,j=sim(vi,vj) | (6) |

其中,

| ˆyIu,i=fs(bIu,i+eu,i) | (7) |

其中,

外在补充方案同样在图1中给出了说明, 通过参考有着相同兴趣爱好的用户的消费历史, 来补充完善每个用户的消费历史. 换言之, 就是利用有着相同爱好人群对指定项目的兴趣来预测目标用户对该项目的兴趣. 首先, 为指定项目

| B(u,i)={bu′,i||u′∈U∖{u},i∈hpu′} | (8) |

| βu,u′=sim(uu,uu′) | (9) |

相似性函数

| yE(u,i)=ξ[∑u′βu,u′⋅yu′,i⩾1] | (10) |

其中, 聚合标签

|

图 1 用户消费历史的补充方案 |

2.3 算法模型

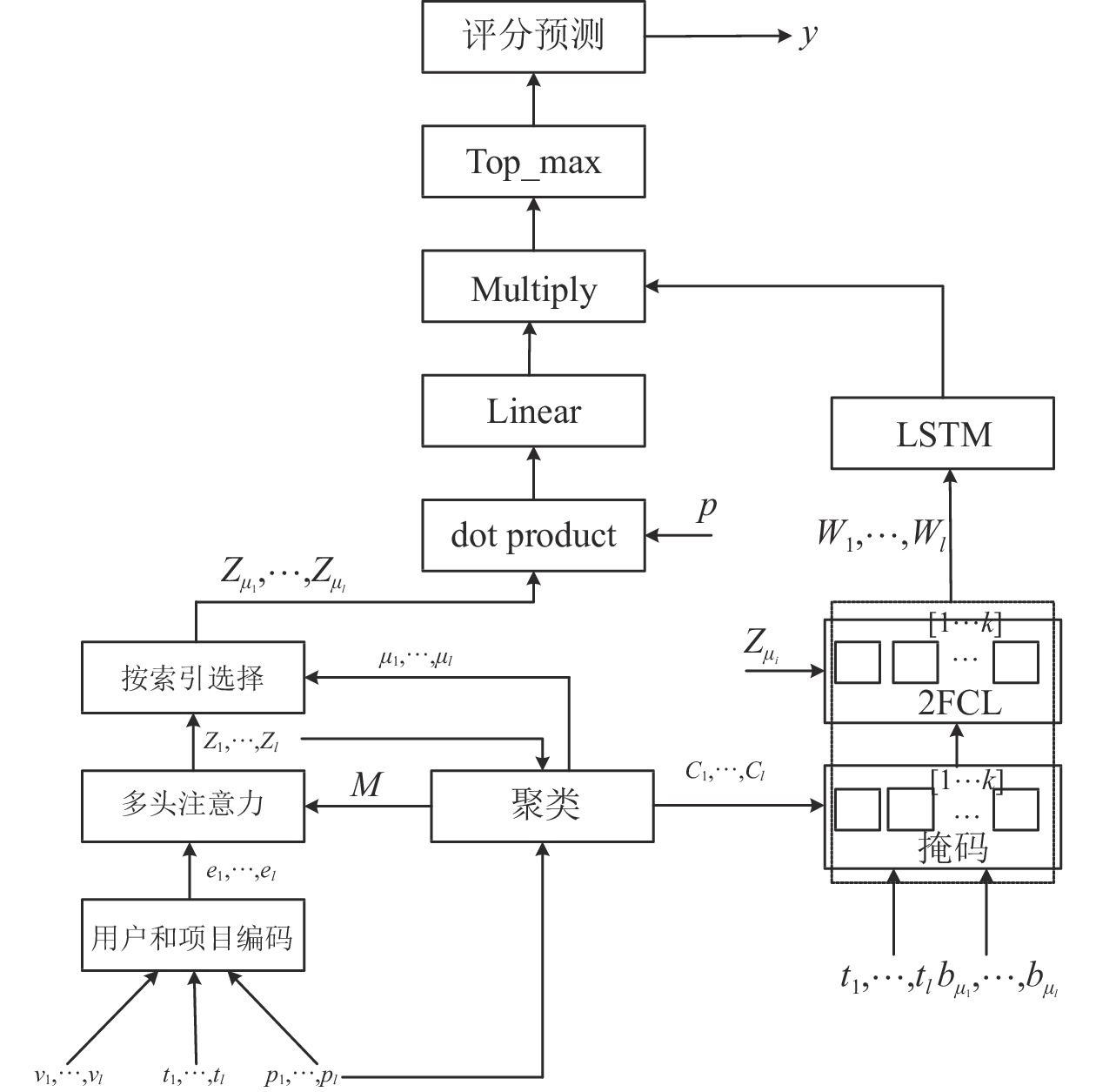

本文所提出的算法模型MIES, 图2给出了本文算法框架. 其由以下3部分构成, 分别为: 学习多兴趣项目的用户嵌入、兴趣聚类的选择以及兴趣聚类权重持续; 在第2.2.1–2.2.3节中分别介绍了构成算法框架的每个模块.

2.3.1 多兴趣用户嵌入用户的兴趣偏好可以通过其消费项目的顺序与时间来很好地表示出来, 因此, 可以将项目特征

| ej=[pj;τ(tj)] | (11) |

其中, [;]表示向量的串联, 时间戳的单位为天, 位置编码

| τ2j(ti)=sin(ti/(τmax)2j/mt) | (12) |

| τ2j+1(ti)=cos(ti/(τmax)2j/mt) | (13) |

| ρ2j(ti)=sin(ti/(ρmax)2j/mp) | (14) |

| ρ2j+1(ti)=cos(ti/(ρmax)2j/mp) | (15) |

为了使用向量来表示用户参与的整个项目, 算法模型必须要考虑到项目之间的相似性, 此过程是通过self-attention层实现的:

| eh(i,j)=((Whqej+bhq)T⋅(Whrei+bhr))√dmodel | (16) |

| ahi,j=Softmaxi(ehi,j) | (17) |

其中,

| zhj=∑iahi,jMi,jpi | (18) |

为了处理来所有注意力头的聚合向量, 在自注意力层之后应用了Dropout层、LayerNorm层和FCL层, 并将输出向量计算为:

| zj=FCL(LayerNorm(Dropout([z1j;⋯;zHj]))) | (19) |

其中,

|

图 2 MIES算法框架 |

由于多头注意力模块已经产生了

| Z=[zTμ1;⋯;zTμk] | (20) |

由于Ward聚类算法在PinnerSage[5]中的显示出了非常好的效果, 因此将其应用于MIES中, 有利于探索协同过滤数据集上聚类算法的选择和聚类数量. 为了证明Ward算法在MIES中的重要性, 将在实验部分比较各种聚类算法在模型上的表现.

2.3.3 兴趣聚类权重可持续模块在用户存在多种兴趣之外, 对每种兴趣的爱好是不均等的, 因而可以根据用户对不同兴趣爱好的侧重进行排序进而选出其中比较关键的候选项目, 即用户对某一兴趣相关的项目的参与度更高, 则对这一兴趣项目聚类分配更高的权重. 为更好利用该聚类种的上下文信息和用户参与序列, 在聚类表示zj和属于聚类

| wj=FCL([zj;ζ[c1∈c2]⋅τ1;⋯;ζ[c1∈c2]⋅τj]) | (21) |

具体而言, FCL由两个全连接层和一个LayerNorm层组成, Sigmoid在其中作为激活函数, 归一化层保证梯度不会消失, 使得模型收敛速度变快. 而多头注意力模块输出的是用户感兴趣的主题, 因此通过FCL输出的权重也应当是正的, 因此第2个全连接层的输出由log函数归一化到[0, +∞)上.

对于用户来说, 只要当前显示的项目在属于其兴趣的一种, 用户就在参与互动. 即项目嵌入只需要非常接近于用户嵌入的其中一种, 而不是接近所有的用户嵌入. 因此, 用户-项目的匹配度由每个兴趣维度上项目嵌入和用户嵌入的最大值决定; 此外, 用户对每个兴趣聚类的匹配度也应该表现在, 当用户更多地参与数据某一兴趣聚类的项目时, 应该为这个兴趣聚类分配更高的权重. 因而, 把用户与项目匹配度表示为:

| y=max{wjLinear(zj⋅bu,i}kj=1 | (22) |

其中,

为了捕获到

在训练MIES模型时, 本文将负似然对数(NLL)作为模型的损失函数:

| ξ=−∑u∈U(∑bu,i∈ξu+log(yui)+∑bu,i∈ξu−log(1−yui))∑u∈U(|ξu+|+|ξu−|) | (23) |

其中,

本次实验使用了3个具有代表性的数据集: Amazon-book, Advertisement和Miniprogram, 其中, Miniprogram是团队开发的小程序在使用过程中收集的用户点击商品的相关信息, 这3个数据集主要包括用户ID、项目ID和时间戳, 具体统计数据如表1所示.

| 表 1 实验数据集描述 |

3.2 评价标准

本文提出的算法是对用户潜在的兴趣偏好项目进行预测, 所以采用命中率(HR)、ROC曲线下面积(AUC)和归一化折损累计增益(NDCG)作为预测准确度指标. 计算公式如下:

| HR=1NN∑i=1hit(i) | (24) |

| AUC=∑i∈positiveClassrank−M(1+M)2M×N | (25) |

| NDCG=∑pi=12reli−1/log2(i+1)∑|REL|i=12reli−1/log2(i+1) | (26) |

为了验证Ward聚类算法在本文中的有效性, 选择了Spectral[25]、BIRCH、HOP-DBSCAN[26]、HDC[27]与其进行对比, 簇数根据需要设置为 4、9、12.

不同的聚类算法对性能有边际影响, PinnerSage提出了Ward算法优于Spectral, 根据下表可以看出并不矛盾. 聚类方法适用于外生的项目嵌入, 因此聚类方法会受到非平面几何和异常值的影响. 对于协作过滤数据集, 聚类方法适用于由多头自注意力层产生的编码, 该层对项目和所有其他项目的嵌入进行平均. 经过多头注意力处理之后的编码应该平滑分布, 因此任何聚类方法在这方面几乎同样有效. 再而, 选择聚类的数量是一个不简单的权衡. 减少聚类数量的动机是存储和计算成本, 这些成本随着聚类数量的增加而线性增长. 具体聚类算法的表现如表2所示.

| 表 2 聚类算法在AUC上的表现 |

3.4 参数设置

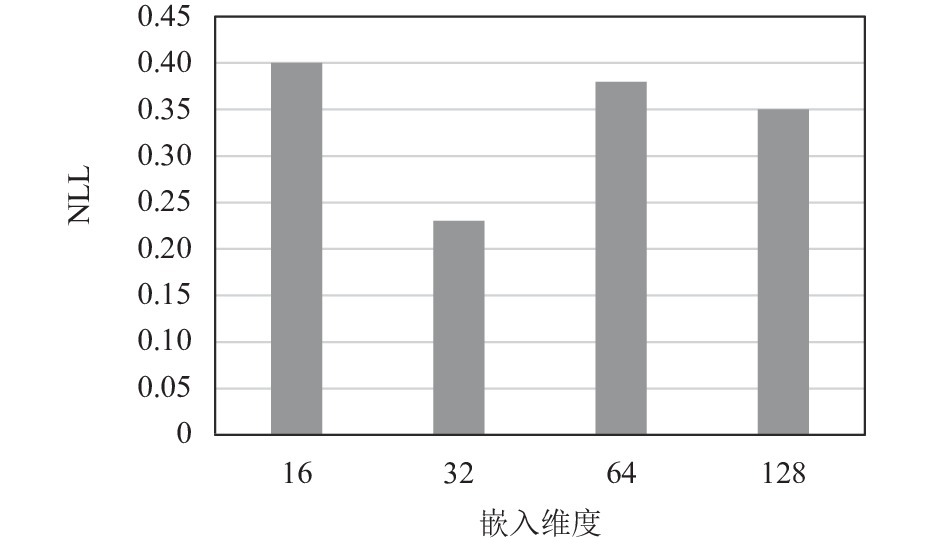

选取3个数据集中的60%的最后一个月, 即30天作为训练集, 20%的最后一个月作为验证集, 剩下的数据作为测试集. 本文将Adam 优化器的学习率调整为 {0.01, 0.005, 0.001}, 多头注意力设置为{8, 16, 32}, 批量大小调整为{64, 128, 256, 512, 1024, 2048}, 嵌入的维度k在 {16, 32, 64, 128}中, 使用 Xavier 初始化在模型中初始化用户和项目嵌入. 从图3可以看出当嵌入维度为32时NLL值最小, 效果最好.

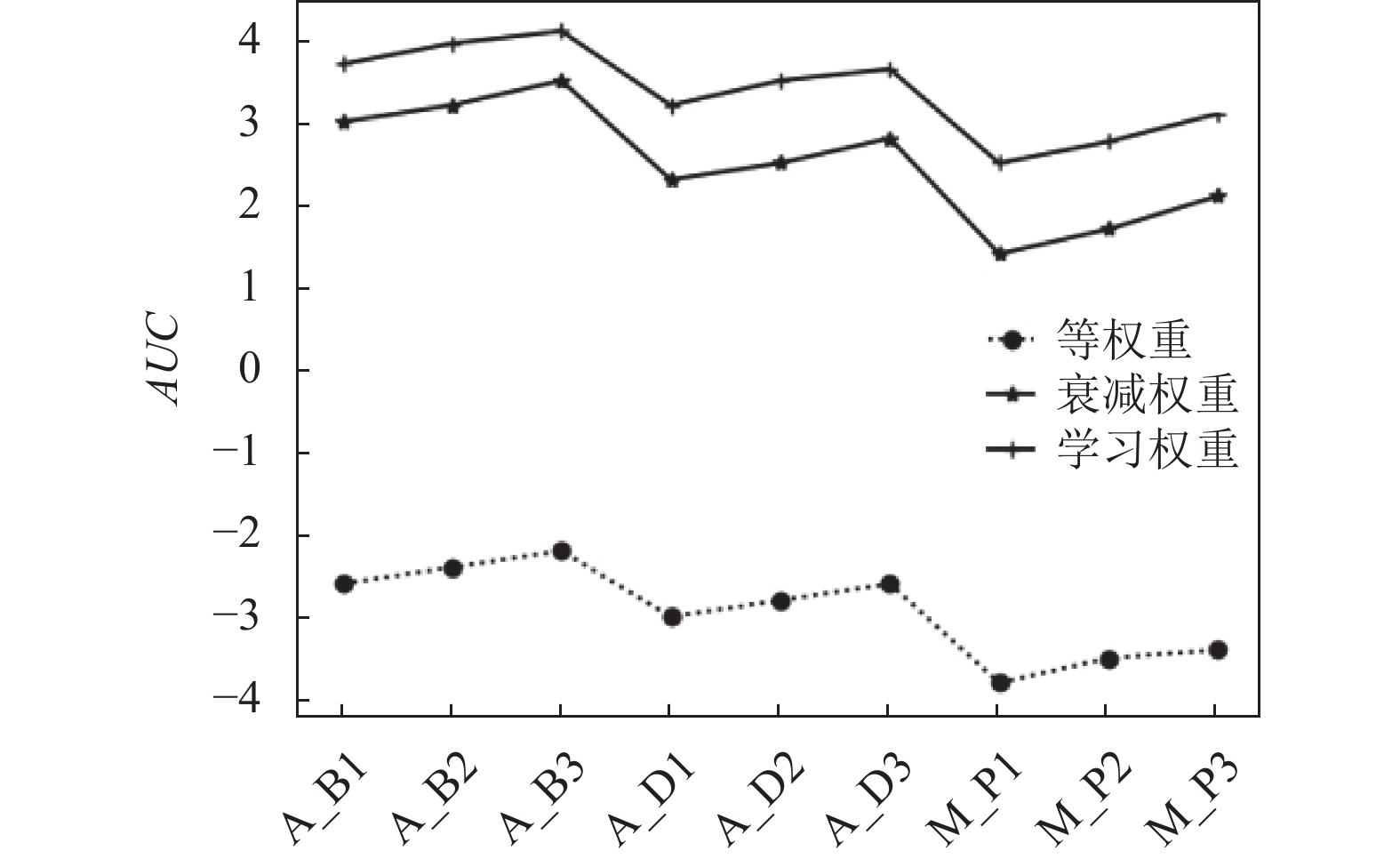

为验证多兴趣的权重是随用户参与项目而不断变化的, 将MIES与聚类权重模块的两个变体进行比较, 即等权重聚类模块和指数衰减权重聚类模块. 等权重是将1作为聚类权重, 进而产生加权相等的用户多兴趣表示; 指数衰减权重由

|

图 3 Amazon-book数据集下嵌入维度对NLL的影响 |

图4中分别展示了在3种不同权重的模型中, 3个数据集在更新过程中不同时间点的性能变化曲线; A_B表示Amazon-book数据集, A_D表示Advertisement数据集, M_P表示Miniprogram数据集; 而1, 2, 3分别为不同的时间段, 即每次以2×103叠加增长. 从图4可以看出等权重和指数衰减权重在AUC上表现较为平稳, 但是学习权重在总体上对模型的帮助是优于其他两个权重的, 因而, 基于个性化和上下文感知的聚类权重是用于推荐系统的更为合理的方案.

|

图 4 3类数据集下不同的聚类权重方式对模型的影响 |

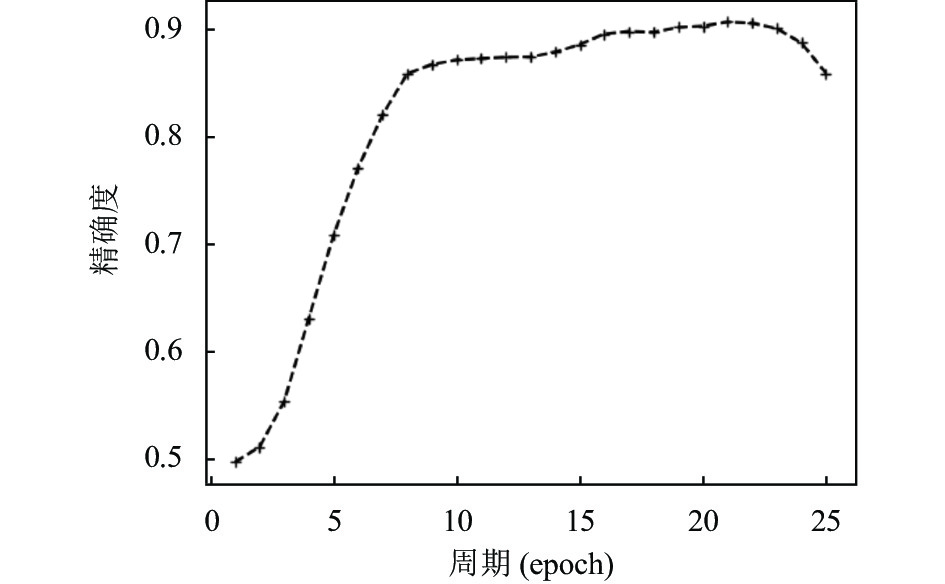

图5展示了推荐的前10个项目的精确度随着随迭代周期的变化, 每次迭代都会对当前推荐的项目进行一次评分. 其中, 迭代周期为21的时达到了最优值, 但是可以看出来当超过21时, 随着周期数的增加, 精确度的值在逐步下降, 即出现了过拟合的问题.

经过验证集的验证最终得到的参数是: 用户和项目嵌入维度为32, 批量大小为64, 多头注意力的注意力头的数量为8, 学习率为0.01, 迭代周期为21.

|

图 5 Amazon-book数据集下迭代周期数变化对NDCG的影响 |

3.5 算法性能对比

为验证本文算法的有效性选择了BPR、Caser、LSAN、NeuMF、SimpleX等经典推荐算法进行对比, 根据对比实验的结论进行了分析.

BPR[28]: 是基于贝叶斯后验优化的个性化排序算法, 本身不优化用户对物品的评分, 只是借由评分来优化用户对物品的排序.

Caser[29]: 采用卷积神经网络捕获用户最近活动的动态模式影响, 结合用户长期偏好以及短期兴趣, 更注重于短期信息的影响.

LSAN[15]: 利用组成嵌入的概念并同时注意到了项目的内在动态性, 提出一种时态上下文感知的嵌入合成方案, 通过双注意力网络有效的学习偏好.

NeuMF[30]: 是一个典型的基于深度学习的推荐算法, 结合了传统矩阵和多层感知机, 同抽取高纬度和低纬度的特征.

SimpleX[31]: 提出了两段式的搜索架构, 在针对用户历史行为序列的数据时有着更好的扩展性和准确性.

在Amazon-book和Advertisement数据集的60%的最后一个月, 即30天作为训练集, 20%的最后一个月作为验证集, 剩下的数据作为测试集. 并于上述模型进行了对比, 总体NDCG和Recall的比较结果如表3所示.

为了进一步验证MIES算法在一般数据集上的健壮性, 本文分别在Amazon-book和Advertisement数据集中训练出相关的推荐模型, 进而在Miniprogram数据集上测试算法的推荐性能, 总体NDCG的比较结果如表4所示.

| 表 3 MIES算法与其他模型对比结果 |

| 表 4 Miniprogram在其他数据集训练模型上的NDCG@10表现 |

4 结论与展望

在本文中提出了一个能获取到用户多个兴趣的偏好以及个性化兴趣的可持续性的推荐系统, 首先设计了简单有效的方式补充用户过往的消费历史, 使得用户的消费历史变得饱和而又不失合理, 然后基于不同用户有着不同数量类型兴趣的前提下, 用多个嵌入表示用户的兴趣, 并基于最接近用户嵌入的项目嵌入来定义它们的关联性, 进而更新相应聚类权重, 此外还模型种还设计了多头注意力机制来处理来自多用户多兴趣的嵌入, 更加深层次的凸显了用户对每个兴趣的不同偏好. 最后, 结合具有相应权重的多兴趣嵌入通过LSTM网络对用户最新的兴趣进行“记忆”, 进而对用户可能潜在的兴趣项目进行评分, 提高了推荐性能的准确度. 未来的工作中需要考虑到用户所处特殊时间节点, 如商家大促(双十一)等, 可能兴趣波动会给推荐效果较大带来的影响.

| [1] |

Kim D, Park C, Oh J, et al. Convolutional matrix factorization for document context-aware recommendation. Proceedings of the 10th ACM Conference on Recommender Systems. Boston: ACM, 2016. 233–240.

|

| [2] |

Epasto A, Perozzi B. Is a single embedding enough? Learning node representations that capture multiple social contexts. Proceedings of the 2019 World Wide Web Conference. San Francisco: ACM, 2019. 394–404.

|

| [3] |

Yu L, Liu L, Li XF. A hybrid collaborative filtering method for multiple-interests and multiple-content recommendation in e-commerce. Expert Systems With Applications, 2005, 28(1): 67-77. DOI:10.1016/j.eswa.2004.08.013 |

| [4] |

Liu NH, Tan QY, Li YN, et al. Is a single vector enough?: Exploring node polysemy for network embedding. Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. Anchorage: ACM, 2019. 932–940.

|

| [5] |

Pal A, Eksombatchai C, Zhou YT, et al. PinnerSage: Multi-modal user embedding framework for recommendations at pinterest. Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. ACM, 2020. 2311–2320.

|

| [6] |

Ma C, Kang P, Liu X. Hierarchical gating networks for sequential recommendation. Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. Anchorage: ACM, 2019. 825–833.

|

| [7] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [8] |

Hyun D, Cho J, Park C, et al. Interest sustainability-aware recommender system. Proceedings of the 2020 IEEE International Conference on Data Mining (ICDM). Sorrento: IEEE, 2020. 192–201.

|

| [9] |

Wang JL, Ding KZ, Hong LJ, et al. Next-item recommendation with sequential hypergraphs. Proceedings of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. Xi’an: ACM, 2020. 1101–1110.

|

| [10] |

He RN, McAuley J. Fusing similarity models with Markov chains for sparse sequential recommendation. Proceedings of the 16th IEEE International Conference on Data Mining (ICDM). Barcelona: IEEE, 2016. 191–200.

|

| [11] |

Xu CF, Zhao PP, Liu YC, et al. Recurrent convolutional neural network for sequential recommendation. Proceedings of the 2019 World Wide Web Conference. San Francisco: ACM, 2019. 3398–3404.

|

| [12] |

Li JC, Wang YJ, McAuley J. Time interval aware self-attention for sequential recommendation. Proceedings of the 13th International Conference on Web Search and Data Mining. Houston: ACM, 2020. 322–330.

|

| [13] |

Kang WC, McAuley J. Self-attentive sequential recommendation. Proceedings of the 2018 IEEE International Conference on Data Mining (ICDM). Singapore: IEEE, 2018. 197–206.

|

| [14] |

Zhang JN, Shi XJ, Zhao SL, et al. STAR-GCN: Stacked and reconstructed graph convolutional networks for recommender systems. Proceedings of the 28th International Joint Conference on Artificial Intelligence. Macao: AAAI Press, 2019. 4264–4270.

|

| [15] |

Li Y, Chen T, Zhang PF, et al. Lightweight self-attentive sequential recommendation. Proceedings of the 30th ACM International Conference on Information & Knowledge Management. Gold Coast: ACM, 2021. 967–977.

|

| [16] |

Wang HW, Zhang FZ, Wang JL, et al. RippleNet: Propagating user preferences on the knowledge graph for recommender systems. Proceedings of the 27th ACM International Conference on Information and Knowledge Management. Torino: ACM, 2018. 417–426.

|

| [17] |

Wang CY, Zhang M, Ma WZ, et al. Modeling item-specific temporal dynamics of repeat consumption for recommender systems. Proceedings of the 2019 World Wide Web Conference. San Francisco: ACM, 2019. 1977–1987.

|

| [18] |

Zhou GR, Mou N, Fan Y, et al. Deep interest evolution network for click-through rate prediction. Proceedings of the 33rd AAAI Conference on Artificial Intelligence. Honolulu: AAAI, 2019. 5941–5948.

|

| [19] |

Zhang S, Tay Y, Yao LN, et al. Next item recommendation with self-attentive metric learning. Proceedings of the 3rd AAAI Conference on Artificial Intelligence. Hawaii: AAAI, 2019.

|

| [20] |

Jiang H, Wang WJ, Wei YW, et al. What aspect do you like: Multi-scale time-aware user interest modeling for micro-video recommendation. Proceedings of the 28th ACM International Conference on Multimedia. Seattle: ACM, 2020. 3487–3495.

|

| [21] |

Arafeh M, Ceravolo P, Mourad A, et al. Ontology based recommender system using social network data. Future Generation Computer Systems, 2021, 115: 769-779. DOI:10.1016/j.future.2020.09.030 |

| [22] |

Darban ZZ, Valipour MH. GHRS: Graph-based hybrid recommendation system with application to movie recommendation. Expert Systems with Applications, 2022, 200: 116850. DOI:10.1016/j.eswa.2022.116850 |

| [23] |

Li C, Liu ZY, Wu MM, et al. Multi-interest network with dynamic routing for recommendation at Tmall. Proceedings of the 28th ACM International Conference on Information and Knowledge Management. Beijing: ACM, 2019. 2615–2623.

|

| [24] |

Liu J, Chen S, Wang B, et al. Attention as relation: Learning supervised multi-head self-attention for relation extraction. Proceedings of the 29th International Conference on International Joint Conferences on Artificial Intelligence. 2021. 3787–3793.

|

| [25] |

谢娟英, 丁丽娟, 王明钊. 基于谱聚类的无监督特征选择算法. 软件学报, 2020, 31(4): 1009-1024. Xie JY, Ding LJ, Wang MZ. Spectral clustering based unsupervised feature selection algorithms. Journal of Software, 2020, 31(4): 1009-1024. DOI:10.13328/j.cnki.jos.005927 |

| [26] |

Lai WH, Zhou MR, Hu F, et al. A new DBSCAN parameters determination method based on improved MVO. IEEE Access, 2019, 7: 104085-104095. DOI:10.1109/ACCESS.2019.2931334 |

| [27] |

McInnes L, Healy J, Astels S. HDBSCAN: Hierarchical density based clustering. The Journal of Open Source Software, 2017, 2(11): 205. DOI:10.21105/joss.00205 |

| [28] |

Rendle S, Freudenthaler C, Gantner Z, et al. BPR: Bayesian personalized ranking from implicit feedback. Proceedings of the 25th Conference on Uncertainty in Artificial Intelligence. Montreal: AUAI Press, 2012. 452–461.

|

| [29] |

Tang JX, Wang K. Personalized top-N sequential recommendation via convolutional sequence embedding. Proceedings of the 11th ACM International Conference on Web Search and Data Mining. Marina Del Rey: ACM, 2018. 565–573.

|

| [30] |

He XN, Liao LZ, Zhang HW, et al. Neural collaborative filtering. Proceedings of the 26th International Conference on World Wide Web. Perth: International World Wide Web Conferences Steering Committee, 2017. 173–182.

|

| [31] |

Mao KL, Zhu JM, Wang JP, et al. SimpleX: A simple and strong baseline for collaborative filtering. Proceedings of the 30th ACM International Conference on Information & Knowledge Management. Gold Coast: ACM, 2021. 1243–1252.

|

2023, Vol. 32

2023, Vol. 32