2. 河北工程大学附属医院 急诊科, 邯郸 056038;

3. 河北工程大学 河北省安防信息感知与处理重点实验室, 邯郸 056038

2. Department of Emergency, Affiliated Hospital of Hebei Engineering University, Handan 056038, China;

3. Hebei Key Laboratory of Security and Protection Information Sensing and Processing, Hebei University of Engineering, Handan 056038, China

随着医学水平的不断提高以及互联网科学技术的高速发展, 心理学不仅在医学领域成为重点研究学科, 在融合互联网、数据挖掘[1]、神经网络等新兴科技的心理与行为研究被更提升至前所未有的高度. 面对心理医学知识管理的复杂性以及领域信息收集与整理效率低下的现状, 心理科学研究和分析对心理医学数据提出更高的要求.

当前心理医学领域迫切需要一种高效便捷的信息管理体系. 拥有强大语义网络的知识图谱[2]能够为复杂的心理医学数据建立网络神经关系框架, 更好地为心理医学研究提供数据关系支撑. 徐春等人[3]通过融合BERT-WWM和指针网络的实体关系联合抽取模型构建了旅游知识图谱. Martnez-Rodrguez等人[4]使用开放信息提取(OpenIE)生成的二元关系方法构建了文本关系知识图谱. 黄梦醒等人[5]利用BiLSTM-CRF的实体识别与关系抽取方法构建电子病例知识图谱, 为个性化医疗推荐服务提供帮助. 廖开际等人[6]综合利用BiLSTM、BiGRU、CRF等深度学习模型对社区医疗文本进行实体识别与关系抽取, 通过图数据库构建成可视化知识图谱.

近年来, 由结构化数据组成的知识图谱逐渐被科研人员应用于生物医疗等垂直领域, 但是由于心理医学文本段落冗长、数据稀疏、知识散乱的特点, 常见深度学习模型难以学习到心理医学数据集全部特征, 无法支撑心理医学知识图谱构建工作, 因此目前心理医学领域方面的知识图谱研究少之又少, 无法满足当前社会对心理医学信息管理的需求.

为解决上述存在的问题, 本文将深度神经网络学习与心理医学实体识别、心理医学实体关系抽取相结合, 提出具有多层级特征抽取能力的MFE-BERT预训练模型和应用前向神经网络的注意力机制改进模型FNNAttention进行心理医学实体识别与心理医学实体关系抽取, 最终通过两模型中识别的实体及其关系形成的结构化数据搭建心理医学知识图谱. 相比于传统模型, 本文改进模型做出以下贡献.

(1) MFE-BERT模型将文本预处理生成动态词向量, 使心理医学实体识别和心理医学实体关系抽取的词向量融合上下文语义联系. 提出多层级特征抽取的改进预训练模型, 在全连接Transformer Encoder每层特征信息的基础上, 将每层的输出向量进行最终合并输出, 赋予词向量更为丰富的词级与语义信息.

(2)应用FNNAttention模型, 利用前向神经网络自适应学习函数分配特征权重, 可以有效解决长文本段落语义稀释问题, 避免相同心理医学实体在不同语句中标注不一致的问题. 本文对传统Attention机制进行改进, 采用前向神经网络注意力机制[7]捕获全局词级信息来强化长文本上下文的词级关系.

(3)基于自建的心理医学数据集以及公开的生物医学数据集, 将提出的模型与其他已有基准模型进行对比分析, 实验结果证明本文所提出模型的合理性及有效性.

1 相关工作 1.1 命名实体识别命名实体识别是将文本中的命名实体定位并分类为预定义实体类别的过程[8]. 近年来研究专家对深度学习不断探索且取得了良好进展, 部分学者尝试着将深度学习与命名实体识别相结合. Collobert等人[9]使用CNN对输入序列进行特征提取, 再通过CRF随机条件场合输出序列的标签. 这种模型对局部信息特征提取效果较好, 但是可能会忽略重要的上下文信息, 更适用于简单的表面特征抽取应用. Habibi等人[10]在生物医学领域中利用BiLSTM-CRF模型对医学实体进行识别, 相较于CNN模型, BiLSTM能够有效地捕捉句子和段落之间的关系, 更好地利用上下文语境进行实体识别, 但是BiLSTM模型容易出现过拟合问题, 因此不适合过小的数据集. 郭知鑫等人[11]通过BERT-BiLSTM-CRF模型有效对法律文本中的案件实体进行识别, 提高了案件处理的效率. 任媛等人[12]在BERT-BiLSTM-CRF模型的基础上引入了注意力机制, 在渔业标准定量指标的实体识别上做出了贡献. 心理医学领域, Lakel等人[13]在心理科学词典的基础上, 利用JAPE (Java注释模式引擎)规则来提取心理实体, 但是需要花费大量时间和精力来定义规则, 难以面对复杂的数据.

心理医学实体识别技术对于心理健康领域的临床和研究具有广泛的应用前景. 通过识别文本中的心理医学实体, 如疾病名称、治疗方法、药品等, 可以为医生提供辅助诊断的依据, 同时也可以从大量的文本数据中提取知识和信息, 帮助构建更全面和准确的心理健康知识库.

1.2 实体关系抽取关系抽取技术是搭建知识图谱过程中的重要一步, 也是自然语言处理任务的支撑基础. 关系抽取将文本中结构化、半结构化和非结构化的数据信息转化为具有结构化关系的数据信息存储在知识库中, 为之后的智能检索和语义分析提供一定的支持和帮助[14]. 关系抽取具体定义如下: 对于一个非结构化文本语句S, 句中包含给定的实体对(E1, E2), 提取两实体之间的关系r∈R (R为预定义的关系集合), 形成一个关系三元组<E1, r, E2>.

目前基于深度学习的关系抽取节省了大量的时间以及人力成本, 在提高准确率的同时其模型泛化性得到了很好的拓展[15]. 陆晓蕾等人[16]在多层级专利分类研究中将Word2Vec-CNN与BERT-CNN做对比实验, 后者表现更好, 准确率达到84.3%. Zhou等人[17]提出了融合注意力与BiLSTM模型来捕捉句子中最重要的语义信息, 在SemEval-2010分类任务中F1值达到82.5%. 刘峰等人[18]在已有研究的基础上通过引入Multi-head Attention和依存句法特征, 能够获取更多的文本句法信息. 姚宁等人[19]对CNN模型应用注意力机制, 在精神分裂症分类任务中拥有较高的分类精度, 为临床针对提供生物学依据.

心理医学领域实体关系抽取是一种基于自然语言处理技术的医学领域应用, 旨在对心理医学相关文本中的实体间的关系进行分类. 它可以帮助医生、研究人员和决策者更好地理解心理疾病的发生和发展机制, 提供更加准确、全面的支持.

2 心理医学知识图谱模型构建方法心理医学知识图谱构建的主要过程包括实体抽取和实体间关系的建立[20]. 首先通过MFE-BERT-BiLSTM-FNNAttention-CRF模型对心理医学文本进行实体识别, 其次将识别的实体与文本输入至MFE-BERT-CNN-FNNAttention模型进行实体之间的关系抽取, 最后进行知识融合, 利用Neo4j图数据库存储数据, 构成心理医学知识图谱.

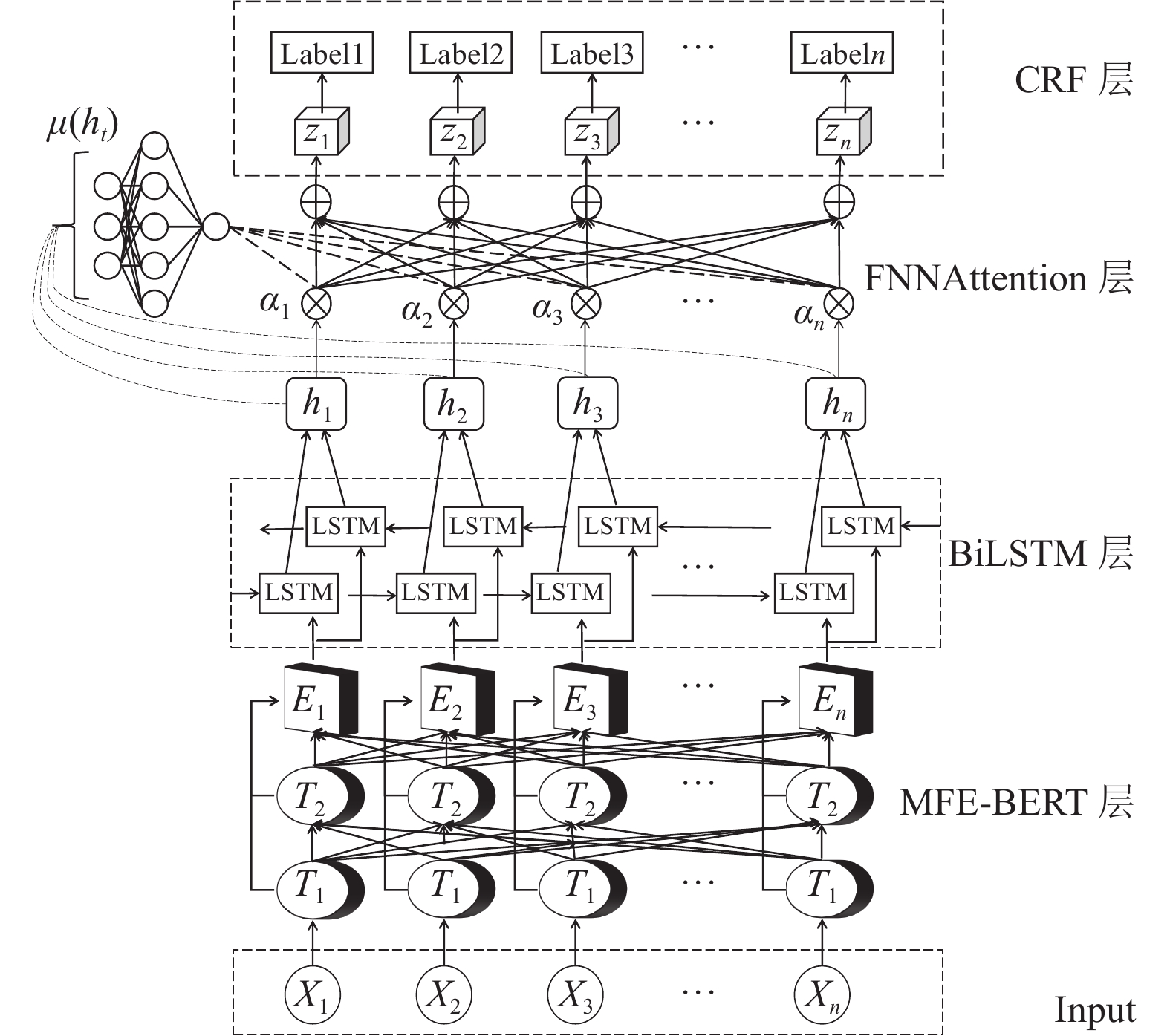

2.1 心理医学实体识别模型心理医学实体识别模型主要由4层组成, 分别是MFE-BERT预处理层, 双向长短记忆神经网络层, FNNAttention层和CRF条件随机场, 如图1所示.

|

图 1 MFE-BERT-BiLSTM-FNNAttention-CRF模型图 |

各层操作步骤如下.

(1)文本输入层: 将心理医学文本以句子为单位作为输入序列.

(2) MFE-BERT层: 接收文本输入层序列, 首先将序列向量化, 结合Token Embeddings、Segment Embeddings与Position Embeddings这3个向量作为输入, 经过对模型内部的改进, 每个向量经过12个Transformer Encoder层的输出被拼接成为一个具有当前序列深层特征语义的向量.

(3) BiLSTM层: 接收MFE-BERT模型输出的特征向量, 通过双向长短记忆网络捕获心理医学文本的上下文语义表征, 输出每个实体标签的分数(Emission_score).

(4) FNNAttention机制: 采用前向神经网络注意力机制对BiLSTM层运算向量进行加权平均处理, 对长文本语义信息进行强化, 同时避免相同心理医学实体在不同语句中标注不一致的问题.

(5) CRF层: 将经过权重分配处理的Emission_score作为输入, 通过对标签建模以及向最终的预测标签添加一些约束, 输出符合标注转移约束条件、最大可能的标注序列.

(6)输出层: 实体识别模型整体能够将复杂的心理医学文本处理为最优标注序列, 最终根据标心提取医学实体.

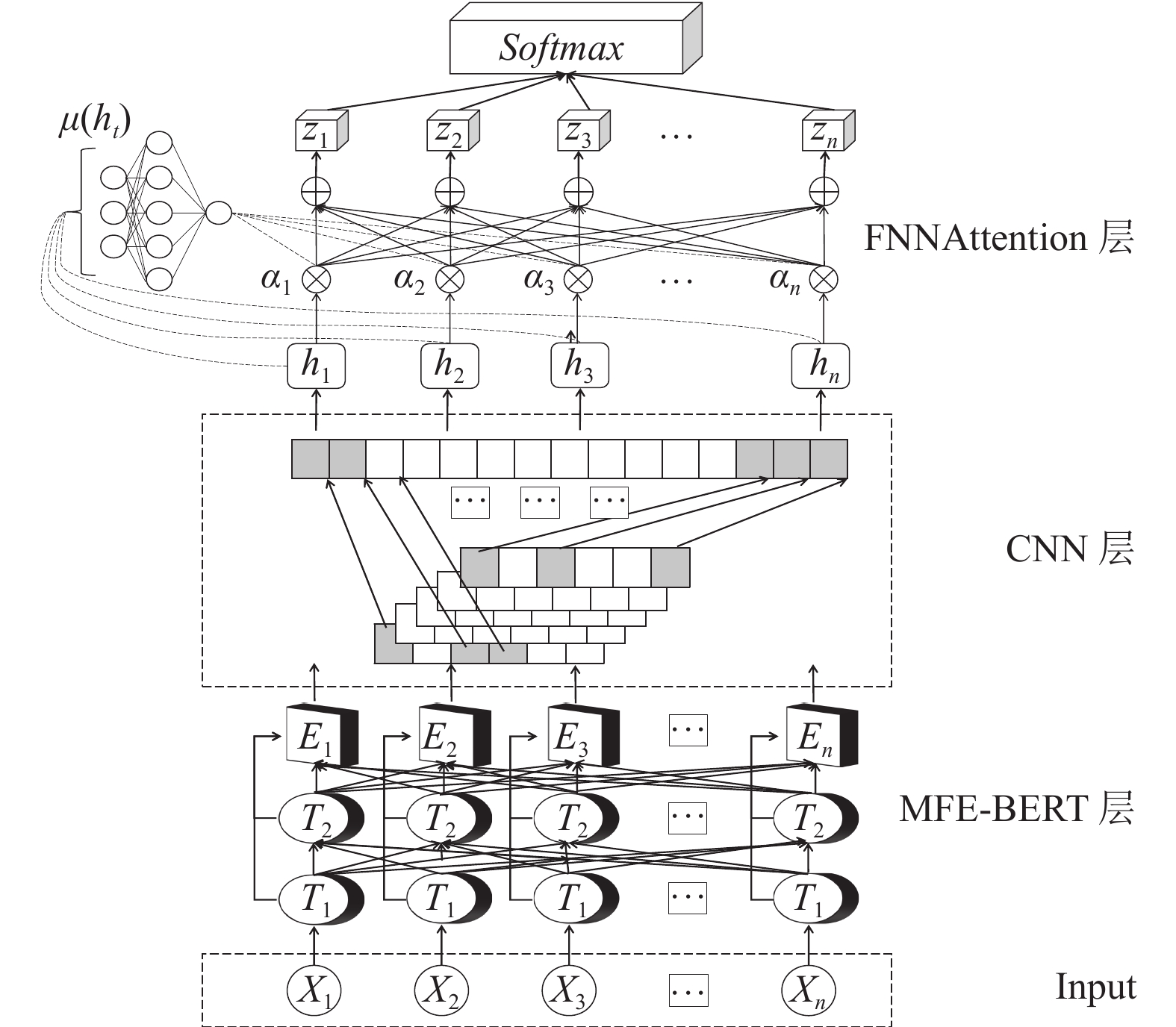

2.2 心理医学关系抽取模型心理医学关系模型由3部分组成, 分别是MFE-BERT预处理层, 卷积神经网络层(CNN)[21]和前向神经网络注意力机制. 关系抽取复合模型同样应用了上述改进的MFE-BERT预处理层和前向神经网络注意力机制来进行长文本语义信息的深度提取, 模型图如图2所示.

|

图 2 MFE-BERT-CNN-FNNAttention模型图 |

各层操作步骤如下.

(1)文本输入层: 利用心理医学实体识别模型处理以后的心理医学文本作为模型输入, 其结构为实体1, 实体2, 文本句子. 实体与实体, 实体与句子之间用“*”分隔, 句子中的心理医学实体用“#”表示, 如“忧郁症*中年人*###常见于###”这种方式使关系抽取模型在不进行额外距离标注的情形下也可以很好地学习到输入序列中两实体的关系.

(2) MFE-BERT层: 文本传输给MFE-BERT模型中, 文字此时会被模型处理为具有词向量、位置向量以及句子向量结合而成的特征向量, 通过12层Transformer Encoder对特征向量进行预训练.

(3) CNN层: 接收MFE-BERT模型输出的特征向量, 先利用卷积核对句子进行卷积操作以及池化层的降维和特征融合, 提取序列局部特征, 再通过多层卷积学习到文本的全局特征.

(4) FNNAttention层: 采用前向神经网络注意力机制加强对心理医学关系分类作用明显的字的权重, 同时强化长文本的语义信息.

(5)输出层: 采用Softmax函数作为分类器, 将FNNAttention层输出向量进行输入, 确定句中实体间特定的心理医学关系类型.

2.3 实体识别及关系抽取主要方法在心理医学实体识别与心理医学关系两部分自然语言处理任务中都应用了MFE-BERT模型及FNNAttention机制, 作为核心模型方法, 其对心理医学长文本数据的深度特征提取起着重要作用.

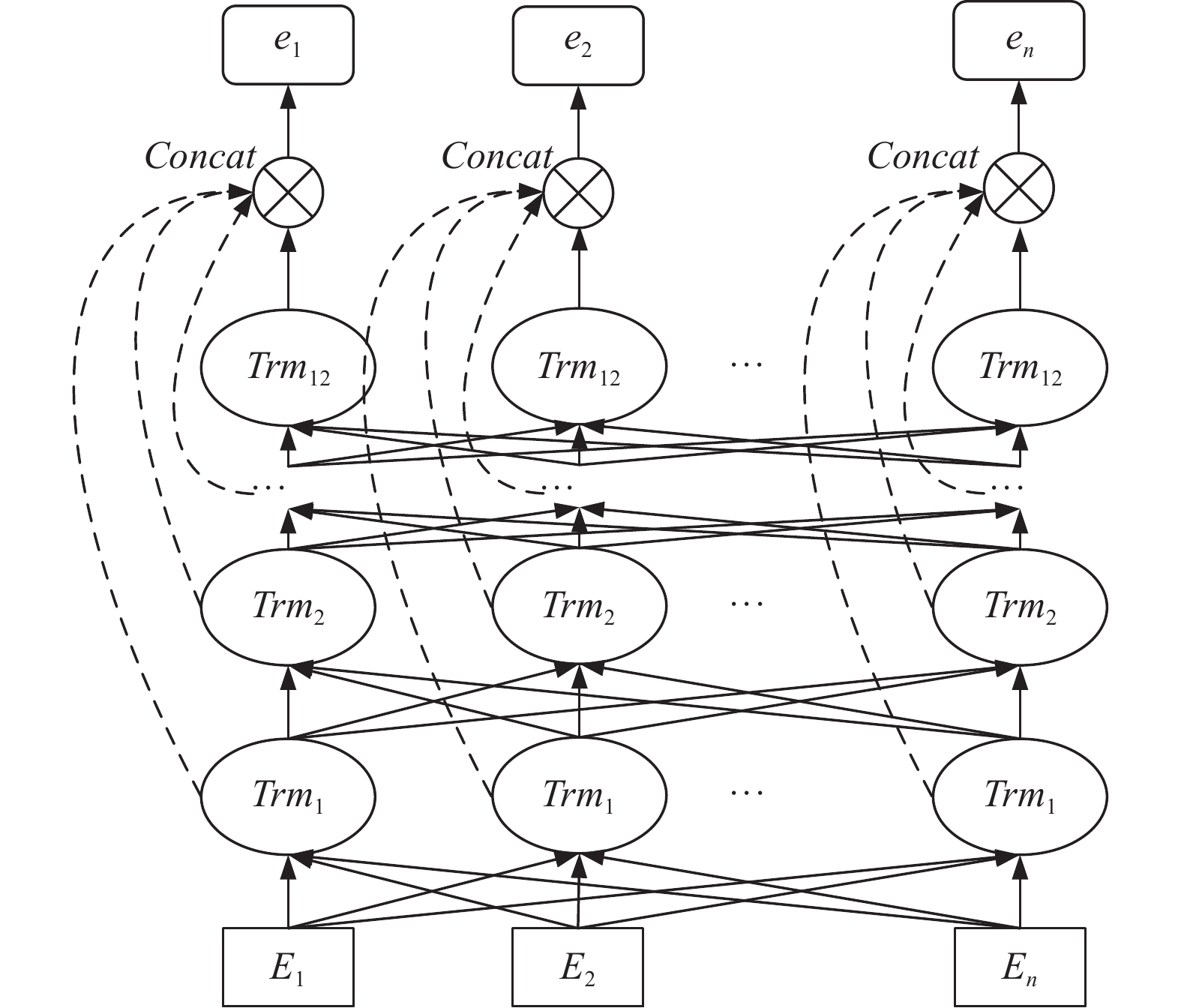

2.3.1 MFE-BERT模型对于心理医学文本, 其语句冗长且复杂, 实体关联性强, 在对序列的单个向量进行预处理时, 由于Transformer Encoder采用前馈传播特征向量的形式, 在单向传递的过程中所包含的语义信息逐层递减, 可能造成输出的特征向量语义不全的问题. MFE-BERT模型在原有全连接的基础上, 将其中11个Encoder层中处理以后的信息输出至最上层, 此时模型拥有了输入序列不同抽象力度的特征信息, 通过Concat函数将12层中具有上下文语义信息的特征向量进行拼接, 最后输出一个具有多层级语义信息的特征向量. 该模型除了可以获取序列的上下文语义信息, 还可以将当前特征向量的语义信息更深层次地提取出来. 改进BERT模型结构图如图3所示.

特征向量具体运算过程如下.

向量

| Attention(Q,K,V)=Softmax(QKT√dk)V | (1) |

MFE-BERT模型中Encoder层使用了注意力机制, 因此式(2)为通过不同的线性变化获取Q、K、V矩阵, 点积对应的权重矩阵

| headi=Attention(QWQi,KWKi,VWVi) | (2) |

| eij=Concat(head1,⋯,head12)Wo | (3) |

式(4)是对12层Encoder中输出的特征向量进行拼接工作.

| cei=Concat(ei1,ei2,⋯,ei12) | (4) |

式(5)是对向量进行了全链接映射降维处理, 使得MFE-BERT模型训练出的特征向量维度与下游任务维度对应, 最终输出一个具有深层语义信息的特征向量.

| xi=tanh(cei+bi) | (5) |

|

图 3 MFE-BERT结构图 |

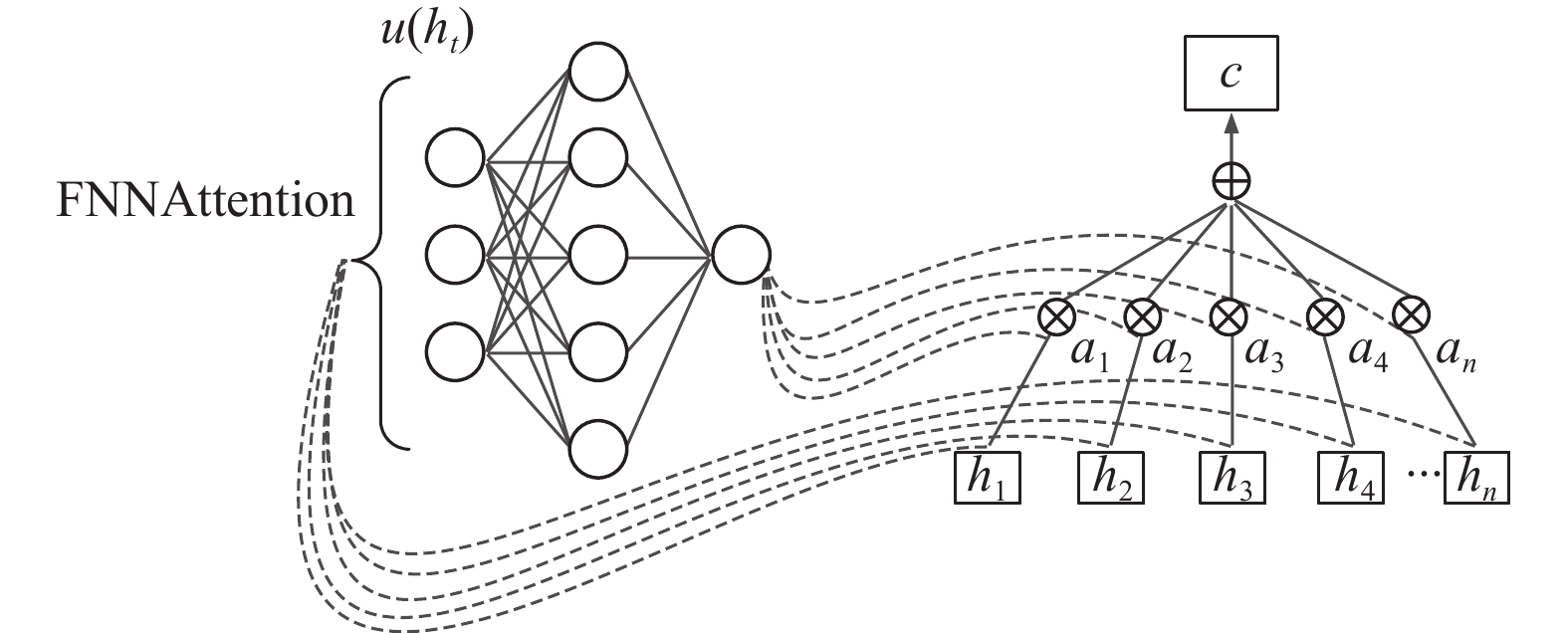

2.3.2 FNNAttention机制

到目前为止, 对于心理医学长文本的实体识别与关系抽取仍然存在字符标签在长文本中不同一的问题. 研究证明长短期记忆网络能够有效联系的上下文文字个数余额为200个, 而我们心理医学研究文本段落远多于这个数字. 在长段落文本中, 位置相距较远的相同的心理医学实体概率性被算法赋予不同的实体标签, 存在长序列语义稀释问题, 这就使得模型正确率难以提高.

FNNAttention的引进可以很好地解决这个问题, 其本质就是词向量的权重分配, 通过前向神经网络计算长距离词向量之间的语义关联程度, 自动学习调整语义权重, 强化词级关系. 我们通过FNNAttention可以有效利用长文本段落上下文之间的语义信息, 获取全局信息向量, 整合于当前特征向量进行计算, 把注意力主要分配给关键词, 在解决长文本中相同心理医学实体在不同语句中标注不一致问题的同时强化文本的词级关系. FNNAttention模型图如图4所示.

|

图 4 FNNAttention结构图 |

具体运算细则如下.

式(6)是通过计算状态序列

| c=T∑i=1exp(u(ht))T∑i=1exp(u(hk))ht | (6) |

其中,

式(7)是对向量

| pt=tanh[ht,c] | (7) |

式(8)和式(9)是对特征向量的降维处理,

| gt=tanh(Wppt+bp) | (8) |

| zt=tanh(Wzpt+bz) | (9) |

CRF模型能够在已给的输入序列基础上, 计算输出序列的条件分布概率分布, 为了能够避免实体识别模型最后结果出现过拟合现象, 对CRF损失函数融入惩罚机制进行优化, 如式(10):

| L=−(St−log(eS1+eS2+⋯+eSN))+α‖θ‖22 | (10) |

其中, St是序列中真实标签路径的得分,

心理医学文本经过实体识别以及关系抽取后, 所形成的知识存在大量错误与冗余数据, 因此需要对抽取的知识进行数据清洗整合, 其主要工作即为实体对齐, 具体操作如下.

首先基于规则的方法将心理医学文本中标注的实体与同义名称进行信息映射, 组成同义实体库. 然后通过计算心理医学实体之间近似程度进行实体对齐, 包括实体文本相似度与实体语义相似度两部分.

(1) 实体文本相似度计算

文本相似度通过计算文本中两个实体之间的相同字符占比来判断是否为同一表述, 主要采用Jaccard系数来计算其相似程度, 如式(11):

| simt(A,B)=|A∩B||A∪B|=|A∩B||A+B+(A∪B)| | (11) |

其中,

(2) 实体语义相似度计算

语义相似度利用实体在上下文语义中近似程度来计算两实体之间的相似度, 其方法是对实体间的词向量进行余弦计算. 余弦值越趋近于1, 则向量角距离越小, 两实体间的近似程度越大, 如式(12):

| sims(A,B)=cos(θ)=n∑iAi×Bi√n∑i(Ai)2×√n∑i(Bi)2 | (12) |

其中,

由于部分不同实体文本过于相似, 单纯使用文本相似度很容易造成错误实体对齐, 如“躁郁症”与“抑郁症”两种病症文本相似度很高, 但为两种不同的实体. 因此, 本文结合两种相似度计算方法, 对文本相似度与语义相似度分别分配0.4与0.6的权重进行实体相似度计算, 如式(13):

| sim(A,B)=simt(A,B)×0.4+sims(A,B)×0.6 | (13) |

(1)心理医学数据集

心理医学领域缺乏标准型标注的数据资源, 数据集从友心理、有来医生、医学百科等26个心理医学网站采用正则表达式与XPath批量爬取相关文本数据, 对心理医学文本进行预处理清洗, 通过手工标注方式最终得到含有3927个实体, 2662条关系的心理医学文本数据集. 其类别以及数量如下: 别称数量为77, 不适部位数量为166, 症状数量为924, 检查数量为313, 科室数量为385, 并发症数量是627, 易感人群数量为170.

(2) ChineseBLUE生物医学文本公开数据集

为了验证提出模型在公共数据集上对心理医学实体识别以及关系抽取的效果, 采用部分阿里公开的ChineseBLUE生物医学文本公开数据集进行测试. 其预定义类别同自建的心理医学数据集一致, 语料中训练集数据为2755条文本, 验证集数据为936条文本, 测试集数据为927条文本.

普遍采用精确率(precision)、召回率(recall)和F1值作为心理医学实体识别和关系抽取性能的评价指标, 本文主要以F1值作为性能指标判断, 指标计算公式如下所示:

| precision=TPTP+FP×100% | (14) |

| recall=TPTP+FN×100% | (15) |

| F1=2×precision×recallprecision+recall | (16) |

心理医学知识图谱构建研究所有实验的具体环境如表1所示.

| 表 1 实验环境 |

3.3 心理医学实体识别实验 3.3.1 实体标注

心理医学实体标注采用BIO的标志体系, 将搜集到的3927个实体逐一标注, 其中B (Begin)代表一个心理医学实体的开始, I (Intermediate)代表一个心理医学实体的中间部分, O (other)表示其他部分. 实验标注7种实体类型, 包括心理疾病(disease)、心理易患病人群(susceptible_crowd)、心理疾病症状(symptom)、心理疾病别名(alternate_name)、不适部位(pathogenic_site)、检查名称(check)、科室名称(department).

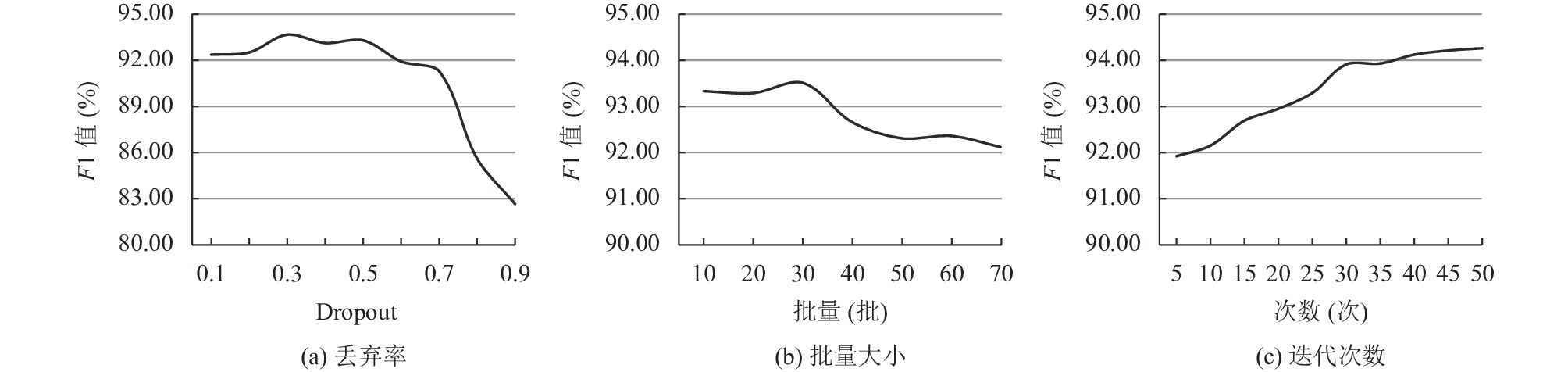

3.3.2 实体识别模型参数设置对于心理医学文本数据集中输入序列较长的特点, 设置句子的最大长度为300, 通过对模型在心理医学数据集进行丢弃率、批量大小、迭代次数等超参数的实验测试, 确定模型的参数. 实体识别的具体参数为: 选择Adam作为优化器, 学习率为1E–4, 为防止模型训练过程中出现的过拟合现象, 引入丢弃率(dropout)设置为0.3 (如图5(a)), 批量大小设置为32 (如图5(b)), 迭代次数设置为30 (如图5(c)).

|

图 5 不同超参数对模型性能的影响 |

在图5(a)中, 对dropout进行设置以防止模型出现过拟合现象, 在dropout=0.3时达到模型最优性能, 当dropout>0.6时, 模型性能过低, 这是由于丢弃率过高导致模型网络收敛速度减慢并且稳定性降低, 无法获取足量语义. 在图5(b)中, 批量大小在30附近模型性能达到最优, 降低模型批量大小之后难以达到收敛, 因此模型性能降低. 在图5(c)中, 模型F1值随着迭代次数的增多而增加, 当迭代次数大于30时, 模型F1值增加缓慢, 效率降低, 因此设置模型迭代次数为30.

3.3.3 对比实验为了验证模型在心理医学实体识别任务中的可行性, 将本模型在专业心理医学数据集和ChineseBLUE生物医学文本公开数据集上分别进行对比实验, 如表2所示.

对表2模型实验数据进行分析, 本文提出的MFE-BERT-BiLSTM-FNNAttention-CRF模型在自建的心理医学数据集测试中识别效果相比与其他方法更好, 精确率为96.69%, 召回率为92.85%, F1值为93.91%; 在ChineseBLUE生物医学公开数据集的实验中也取得了较好的成绩, 精确率为91.16%, 召回率为89.27%, F1值为89.52%, 说明其在心理医学实体识别任务中具有良好的适应性.

在对比实验中, 实验1–6在其他任务层相同的情况下, 分别对BiLSTM层与CNN层进行更换实验, 两数据集实验结果表明在实体识别任务中, BiLSTM层可以充分利用上下文信息, 因此特征向量所具有的语义更全面, 对特征向量的处理效果更好; 将实验7与实验8、实验9与实验11进行对比, 可以看出当选择BERT作为向量预训练模型使, 效果要优于GPT-2, 这是由于BERT使用的双向的语言模型; 而GPT-2用的是单向语言模型, 因此BERT还可以在一定程度上获取上下文语义, 对于序列特征提取更充足; 对比实验10与实验12, 将MFE-BERT作为预训练模型, 分别使用不同的注意力机制时, 在两数据集中取得了不同的效果, 在心理医学数据集中本文提出的改进模型达到最优, 其F1值为93.91%, 在公开数据集中F1值为89.52%, 仅次于使用传统注意力机制的模型, 其原因是心理医学数据集是长文本数据, FNNAttention在处理长文本任务中能够更好地强化语义信息, 而在公开数据集的短文本数据中, 传统Attention的权重分配计算更为合理, 对比两模型训练时间, 可以看出FNNAttention计算效率更优, 这是因为FNNAttention机制通过引入一个前馈神经网络来计算相似度, 减少了计算量. 从总体来看, 各模型在不同数据集之间的表现性能趋于一致, 且各模型在文本规范、格式固定, 经过数据清洗的心理医学数据集识别效果更好.

| 表 2 不同数据集实体识别对比结果 |

综上, 对比实验中应用MFE-BERT模型的实体识别模型在两数据集中均能达到最优表现, 应用FNNAttention模型的实体识别模型在心理医学长文本数据集中相对Attention模型表现更出色. MFE-BERT-BiLSTM-FNNAttention-CRF模型对心理医学实体识别任务中可以很好提取序列的隐含特征, 在两种数据集中均表现出不错的性能, 能够有效提取心理医学相应实体.

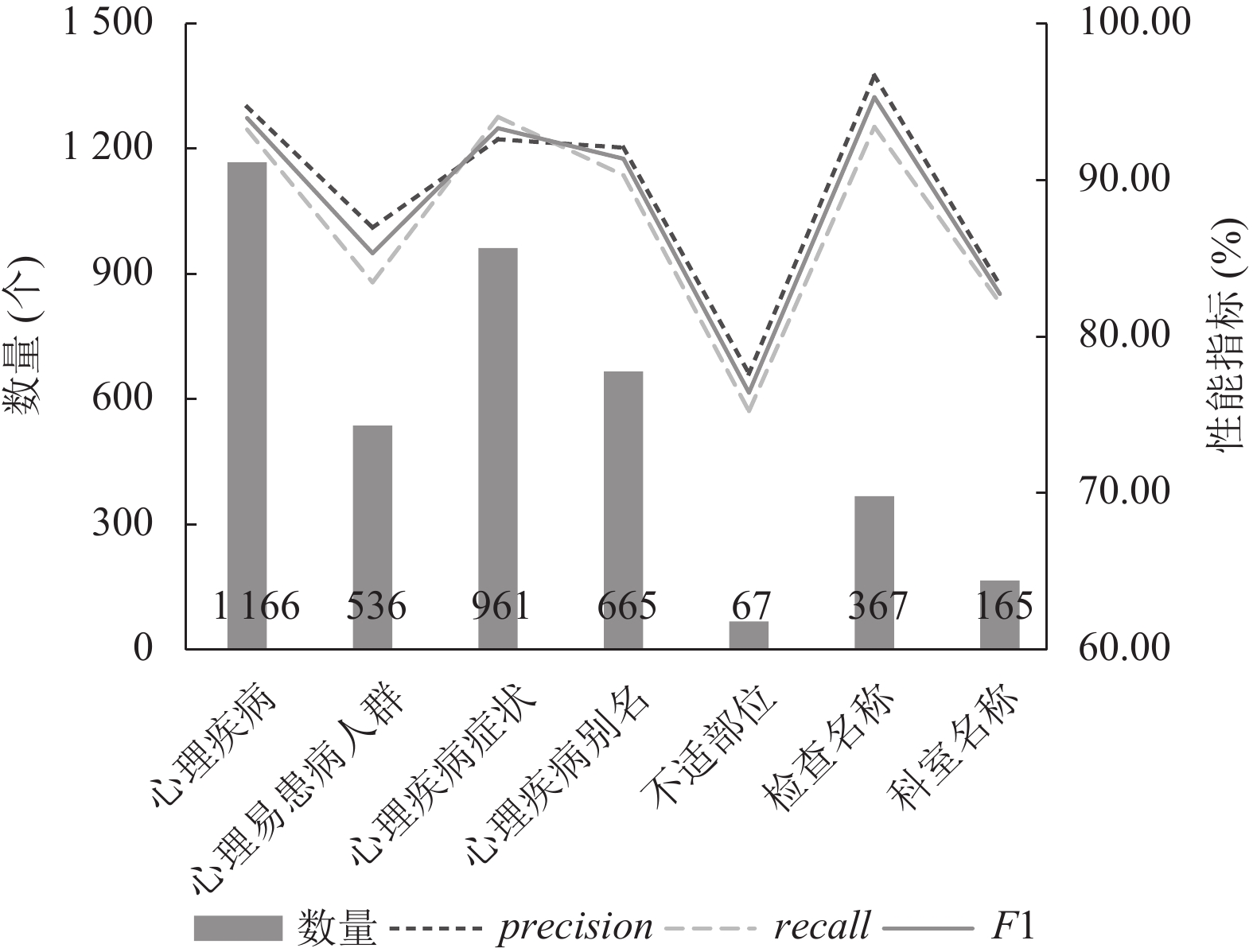

3.3.4 实体识别实验结果MFE-BERT-BiLSTM-FNNAttention-CRF模型对心理医学数据集种的7种共3927个标注实体进行性能测试实验, 实验结果如图6所示.

|

图 6 心理医学数据集实体识别数量及性能指标结果 |

从图6中可以看出, 心理疾病、心理疾病症状、心理疾病别名、检查名称这几种实体的F1值和精确率都在90%以上, 其中对检查名称实体识别的效果最好, 精确率为96.63%, 召回率为93.36%, F1值为95.25%, 这是因为在数据集中对其表述固定, 模型容易学习到其规则的描述方式; 心理易患病人群的实验F1值为85.29%, 性能相对较差, 这是由于部分患病人群实体的表述种含有心理疾病症状, 比如“常见于焦躁男性”的表述, 将“焦躁”识别为症状, 这也是心理疾病症状实体召回率较高的原因; 对不适部位与科室名称实体识别的效果较差, 主要原因是在心理医学数据集种关于这两种实体的样本数较少, 达不到训练效果.

3.3.5 MFE-BERT特征抽取层数量影响为了研究MFE-BERT预训练模型提取不同数量Encoder层特征对实体识别结果的影响, 设置6组不同的提取层L=[2, 4, 6, 8, 10, 12], 分别拼接第6层与第12层; 第1层、第5层、第9层、第12层, 以此类推, 每层间隔数量尽可能相近, 以保持特征分布的均匀性. 利用MFE-BERT-BiLSTM-FNNAttention-CRF模型在其他参数不变的基础上于自建的心理医学数据集进行实验, 实验结果如表3所示.

从表3中可以看出, 随着特征提取层数量的增加, 模型的性能逐步提升, 在提取12层全部特征时, 即本模型所采用方案, 模型性能达到最佳, F1值为93.82%; 模型性能提升速率随着层数增加而变缓慢, 其原因是在拼接Encoder输出层的过程中, 拼接层次越多, 学习到所包含的不同语义信息就越少, 因此模型的性能提升就越小. 综上, MFE-BERT模型所拼接的特征层越多, 就可以从心理医学文本数据集中获取越多的特征表示, 模型也将拥有更为丰富的表达能力, 从而提高模型的识别效果.

| 表 3 心理医学数据集不同数量特征抽取层实体识别结果 (%) |

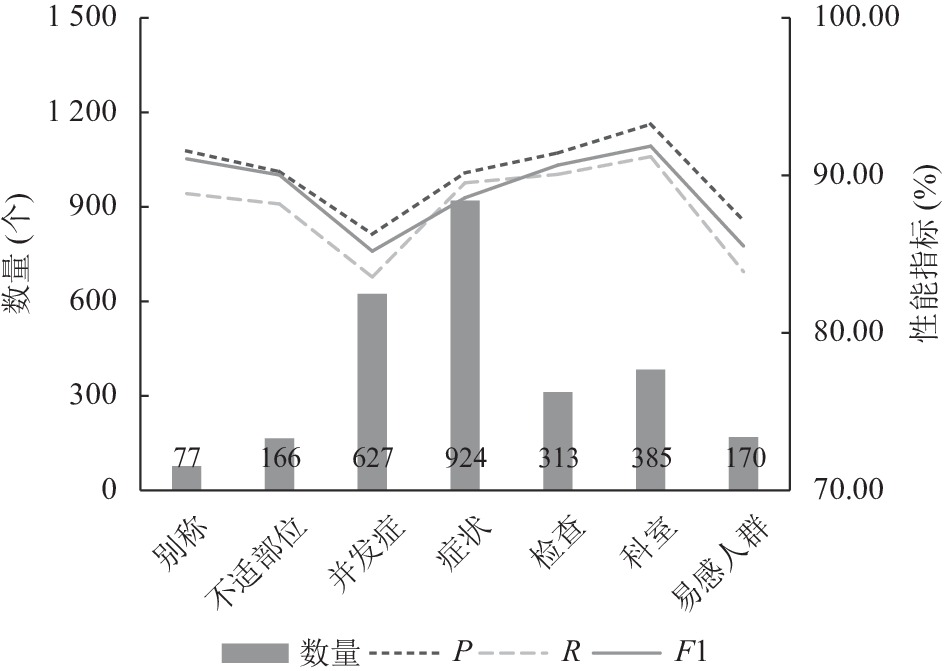

3.4 心理医学关系抽取实验 3.4.1 关系类别

将心理医学关系进行分类, 主要包括7大类, 在自建心理医学数据集中, 其类别以及数量如下: 别称(is_alternate_name)数量为77, 不适部位(is_pathogenic_site)数量为166, 症状(has_symptom)数量为924, 检查(is_check)数量为313, 科室(is_department)数量为385, 并发症(accompany_with)数量是627, 易感人群(is_susceptible_crowd)数量为170, 共2662条心理医学实体关系.

3.4.2 参数设置根据实验调试, 对MFE-BERT-CNN-FNNAttention关系抽取模型中所涉及的重要参数设置如表4所示.

| 表 4 关系抽取模型参数设计 |

3.4.3 对比实验

为了验证模型在心理医学关系抽取任务种的可行性, 将本模型在自建心理医学数据集和ChineseBLUE生物医学文本公开数据集上分别进行对比实验, 如表5所示.

| 表 5 不同数据集关系抽取对比结果 |

对关系抽取实验结果进行分析, 本文所提出的MFE-BERT-CNN-FNNAttention心理医学关系抽取模型在自建的心理医学数据集取得了最好的效果, 精确率达到89.39%, 召回率为88.52%, F1值为88.95%; 在生物医学公开数据集中效果显著, 精确率为87.49%, 召回率为86.67%, F1值为87.12%, 可以看出所改进的模型性能相对于基础模型都有了一定的提升, 能够有效对心理医学文本数据进行抽象建模.

在两个数据集的关系抽取实验中, 将实验1–4进行对比, BERT预训练模型的效果要优于Word2Vec预训练模型, 且CNN模型对关系特征的抽取能力更胜于BiLSTM模型; 将实验1与实验5, 实验2与实验6进行比较, 可以看出Attention机制对于关系抽取实验的精确度起着积极作用, 主要因为注意力机制进行了权重分配, 将更多注意力给心理医学关系; 对比实验8与实验9, 预训练模型从BERT更换为本文提出的改进的MFE-BERT, 在心理医学数据集中F1值分别为87.06%、88.19%, 说明改进的BERT利用层级拼接方式学习到了序列的深度词级关系信息; 再次将实验7与实验8, 实验9与实验10进行对比, 由于受文本长度的影响, FNNAttention机制仅在长文本数据集中能发挥其优势, 在心理医学数据集中FNNAttention表现比传统Attention更好, 在用时相对少的前提下F1值有了一定程度的提升, 在公开数据集中FNNAttention性能的提升仅次于Attention, 但是仍然比不加注意力机制的模型效果好.

综上, MFE-BERT-CNN-FNNAttention模型在心理医学关系抽取任务中表现良好, 所改进的MFE-BERT预处理模型能够很好地适应不同数据集的心理医学关系抽取任务.

3.4.4 关系抽取实验结果MFE-BERT-CNN-FNNAttention模型对心理医学数据集进行关系抽取, 对7种关系类别进行性能指标测试, 实验结果如图7所示. 通过实验可以看出, 心理疾病并发症和心理易患病人群两种关系的性能指标相对较低, F1值分别为83.61%和83.95%, 这是由于心理疾病并发症关系描述表达容易与疾病症状进行混淆, 且在数据集中对心理易患病人群关系的语料覆盖不足, 导致这两种关系抽取识别率不高. 疾病所属科室关系抽取效果最好, 其F1值达到了91.29%, 这是因为在实体识别任务中对应中文词组较少, 且标注正比例样本较多, 因此疾病所属科室关系可以被极大部分提取出来.

|

图 7 心理医学数据集关系抽取数量及性能指标结果 |

3.4.5 MFE-BERT特征抽取层数量影响

为了研究MFE-BERT预训练模型提取不同数量Encoder层特征对关系抽取结果的影响, 设置6组不同的提取层L=[2, 4, 6, 8, 10, 12], 其拼接方式同实体识别特征抽取实验一致. 利用MFE-BERT-CNN-FNNAttention模型在其他参数不变的基础上于自建的心理医学数据集进行实验, 实验结果如表6所示.

| 表 6 心理医学数据集不同数量特征抽取层关系抽取结果 (%) |

从表6中可以看出, 随着特征提取层数量的增加, 关系抽取模型的性能逐步提升, 同实体识别模型表现一致, 在提取所有层Encoder特征时, 模型性能达到最佳, F1值为88.32%. 实验说明MFE-BERT模型所拼接的特征层越多, 关系抽取模型对于整个文本的理解程度就越深入, 所学习到实体间的语义特征就越多, 从而提高模型的关系抽取效果.

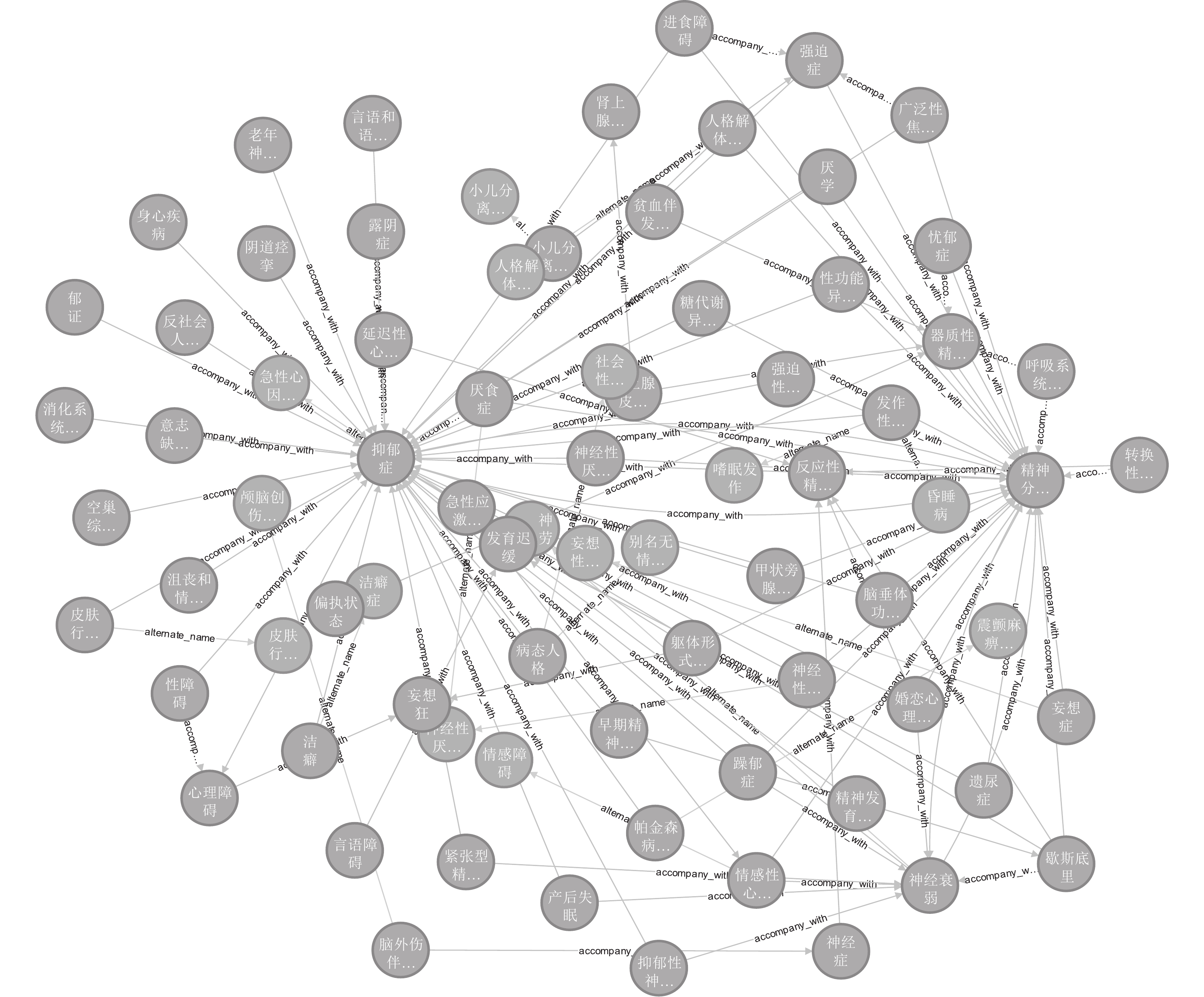

3.5 心理医学知识图谱可视化心理医学知识图谱可视化主要通过数据层提取信息以及前端视图层展示关系两部分组成. 数据层通过MFE-BERT-BiLSTM-FNNAttention-CRF模型进行实体识别, MFE-BERT-CNN-FNNAttention模型进行关系抽取, 两复合模型都是基于多层特征提取能力对BERT进行改进处理, 同时应用前向神经网络注意力机制. 知识图谱实体内容简洁但关系数据量巨大, 若使用关系型数据库如MySQL会产生大量的表结构, 造成数据冗余浪费大量存储空间, 因此对心理医学实体和关系存储时采用图数据库, 在提高查询效率的同时保证合理的存储空间, 前端视图层通过Neo4j图数据库浏览器可视化进行展示. 部分心理医学知识图谱可视化效果如图8所示.

4 结束语本文提出的心理医学实体识别模型以及心理医学实体关系抽取模型, 将心理医学数据集在两模型上进行训练提取心理医学实体及关系数据, 构建成一个领域内容全面且可视化的心理医学知识图谱. 通过应用FNNAttention机制以及对BERT基础预训练模型的改进, 以加强模型的语义特征提取能力, 同时改善在长段落文本中语义稀释的问题, 在心理医学数据集、ChineseBLUE公开数据集实验中均取得了较好的效果, 性能指标F1值均在85%以上.

|

图 8 心理医学知识图谱 |

后续研究还需从以下两个方面进一步优化.

①以满足心理医学特定应用背景的实际需求为前提, 考虑模型性能与训练效率的平衡问题, 设计高效的实体识别及关系抽取模型.

②尝试拓展实验样本的丰富性与多样性, 探索多任务学习方法, 针对不同领域进行相应知识图谱构建任务, 提高模型普适性.

| [1] |

Wang YZ, Jia YT, Liu DW, et al. Open Web knowledge aided information search and data mining. Journal of Computer Research and Development, 2015, 52(2): 456-474. |

| [2] |

Wang Q, Mao ZD, Wang B, et al. Knowledge graph embedding: A survey of approaches and applications. IEEE Transactions on Knowledge and Data Engineering, 2017, 29(12): 2724-2743. DOI:10.1109/TKDE.2017.2754499 |

| [3] |

徐春, 李胜楠. 融合BERT-WWM和指针网络的旅游知识图谱构建研究. 计算机工程与应用, 2022, 58(12): 280-288. |

| [4] |

Martinez-Rodriguez JL, Lopez-Arevalo I, Rios-Alvarado AB. OpenIE-based approach for knowledge graph construction from text. Expert Systems with Applications, 2018, 113: 339-355. DOI:10.1016/j.eswa.2018.07.017 |

| [5] |

黄梦醒, 李梦龙, 韩惠蕊. 基于电子病历的实体识别和知识图谱构建的研究. 计算机应用研究, 2019, 36(12): 3735-3739. DOI:10.19734/j.issn.1001-3695.2018.07.0414 |

| [6] |

廖开际, 黄琼影, 席运江. 在线医疗社区问答文本的知识图谱构建研究. 情报科学, 2021, 39(3): 51-59, 75. DOI:10.13833/j.issn.1007-7634.2021.03.008 |

| [7] |

Raffel C, Ellis DPW. Feed-forward networks with attention can solve some long-term memory problems. arXiv:1512.08756, 2015.

|

| [8] |

Li J, Sun AX, Han JL, et al. A survey on deep learning for named entity recognition. IEEE Transactions on Knowledge and Data Engineering, 2022, 34(1): 50-70. DOI:10.1109/TKDE.2020.2981314 |

| [9] |

Collobert R, Weston J, Bottou L, et al. Natural language processing (almost) from scratch. Journal of Machine Learning Research, 2011, 12: 2493-2537. |

| [10] |

Habibi M, Weber L, Neves M, et al. Deep learning with word embeddings improves biomedical named entity recognition. Bioinformatics, 2017, 33(14): i37-i48. DOI:10.1093/bioinformatics/btx228 |

| [11] |

郭知鑫, 邓小龙. 基于BERT-BiLSTM-CRF的法律案件实体智能识别方法. 北京邮电大学学报, 2021, 44(4): 129-134. DOI:10.13190/j.jbupt.2020-241 |

| [12] |

任媛, 于红, 杨鹤, 等. 融合注意力机制与BERT+BiLSTM+CRF模型的渔业标准定量指标识别. 农业工程学报, 2021, 37(10): 135-141. |

| [13] |

Lakel K, Bendella F, Benkhadda S. Named entity recognition for psychological domain: Challenges in document annotation for the Arabic language. Proceedings of the 1st International Conference on Embedded & Distributed Systems (EDiS). Oran: IEEE, 2017. 1–5.

|

| [14] |

李冬梅, 张扬, 李东远, 等. 实体关系抽取方法研究综述. 计算机研究与发展, 2020, 57(7): 1424-1448. |

| [15] |

Jain A, Pennacchiotti M. Open entity extraction from Web search query logs. Proceedings of the 23rd International Conference on Computational Linguistics. Beijing: ACM, 2010. 510–518.

|

| [16] |

陆晓蕾, 倪斌. 基于预训练语言模型的BERT-CNN多层级专利分类研究. 中文信息学报, 2021, 35(11): 70-79. |

| [17] |

Zhou P, Shi W, Tian J, et al. Attention-based bidirectional long short-term memory networks for relation classification. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers). Berlin: ACL, 2016. 207–212.

|

| [18] |

刘峰, 高赛, 于碧辉, 等. 基于Multi-head Attention和Bi-LSTM的实体关系分类. 计算机系统应用, 2019, 28(6): 118-124. DOI:10.15888/j.cnki.csa.006944 |

| [19] |

姚宁, 张淼, 陈宏涛. 基于CNN-Attention算法的精神分裂症分类. 电子设计工程, 2022, 30(10): 55-61. DOI:10.14022/j.issn1674-6236.2022.10.012 |

| [20] |

宋伟, 张游杰. 基于环境信息融合的知识图谱构建方法. 计算机系统应用, 2020, 29(6): 121-125. DOI:10.15888/j.cnki.csa.007424 |

| [21] |

周飞燕, 金林鹏, 董军. 卷积神经网络研究综述. 计算机学报, 2017, 40(6): 1229-1251. |

2023, Vol. 32

2023, Vol. 32