2. 山西省机电设计研究院有限公司, 太原 030009

2. Shanxi Electromechanical Design and Research Institute Co. Ltd., Taiyuan 030009, China

金属材料在工业制造中应用较为广泛, 但金属在加工过程中往往会因各种因素导致金属表面出现裂纹、斑块、麻点面、压痕、刮痕等不同程度和不同种类的缺陷, 这些表面缺陷不仅影响金属外观, 严重时还会导致金属材料断损, 从而发生一些事故, 因此金属表面缺陷需要在生产过程中准确地检测出来.

随着计算机视觉领域中基于深度学习的目标检测算法快速发展, 以其检测精度高、检测速度快等优势为金属表面缺陷的检测批量化、高效率检测提供了新思路新方法. 王道累等人[1]提出一种基于级联孪生密集网络的表面缺陷检测方法, 加入空洞空间金字塔池化结构获取不同采样率的特征图捕获多尺度信息, 融合浅层特征和高层复杂特征增强分类准确率, 解决金属表面缺陷实时检测中存在的缺陷检测精度不高以及难以定位等问题; 李维刚等人[2]对YOLOv3模型进行改进, 使用加权K-means聚类算法优化先验框参数, 融合浅层特征与深层特征, 提高模型对带钢表面缺陷检测精度; 王一等人[3]在YOLOv5原模型加入SE注意力模块, 减少无用特征干扰, 同时用Ghost卷积块替换主干网络中常规卷积, 提高了对金属工件表面缺陷检测的精度; Wang等人[4]在YOLOv4模型颈部加入SAF注意力模块增强路径间和跨层特征融合, 使用马赛克增强防止图像过度参与训练; Xie等人[5]提出一种基于特征增强YOLO的表面缺陷检测算法用于实际工业, 为了高效检测, 通过结合深度可分离卷积和密集连接降低模型的参数量, 为了提高检测精度, 提出了一种改进的特征金字塔网络, 以增强多尺度检测的空间位置相关性. 可以看出, 目前对于金属表面缺陷检测的研究取得了一定成就. 然而现有研究存在一些问题需要进一步完善: (1)工业生产中采集到的金属表面缺陷图像存在分辨率低的情况, 直接使用原始低分辨率缺陷图像进行检测会造成目标难检、误检及漏检问题. (2)现研究的主干网络提取特征尺度较单一, 不同尺度浅层特征和深层特征无法均衡, 小目标或密集目标的分类或定位能力较差. (3)现阶段的目标检测超参数优化多依靠研究人员的主观经验, 需要较强的专业经验, 通过大量耗时的“试错”实验进行优化以期达到较好的效果, 缺乏模型的自适应性和存在模型泛化性差的问题.

综合上述问题, 本文提出一种基于贝叶斯快速优化的金属表面缺陷超分辨率检测算法. 总结本文贡献有3点.

(1) 为有效降低低分辨率金属表面图像对缺陷检测效率的影响, 设计了一种多层融合超分辨率重建模型, 将ESRGAN和精细化分层结构有效融合, 丰富主干特征提取网络特征图的感受野, 在实现缺陷图像的超分辨率重建的同时提高重建图像边缘纹理清晰度.

(2) 为有效提高检测模型对小目标和密集目标的分类和定位能力, 设计了一种瓶颈残差密集结构, 丰富主干特征提取网络的位置信息和语义信息.

(3) 针对模型人工调参主观性强、自学习能力薄弱等问题, 论文以缺陷检测模型均值平均精度为优化目标, 采用贝叶斯优化算法对初始学习率、损失系数、IOU阈值等20个模型超参数进行自适应寻优, 提高检测模型自优化能力和模型泛化能力.

1 相关工作 1.1 超分辨率重建金属表面缺陷数据集分辨率较低, 直接使用原始图像进行目标检测会出现目标难检、误检和漏检的情况. 随着深度学习和卷积神经网络的快速发展, 基于深度学习的超分辨率也得到了积极的探索和研究. 相比传统基于插值和基于重构的超分辨率重建方法, 基于深度学习的超分辨率可以用深度模型自动提取更有表达能力的图像特征, 学习低分辨率图像ILR和高分辨率图像IHR之间的映射关系Fθ, 如式(1), 重建出更加逼真的图像纹理细节[6,7].

| θ=argmin1NN∑i=1L(Fθ(ILRi),IHRi) | (1) |

其中, θ = {w1, w2, …, wp, b1, b2, …, bp}表示p个卷积层的权重和偏置, N表示低分辨率图像ILR和高分辨率图像IHR训练样本对数, L表示最小化重建图像Fθ (ILR)和高分辨率图像IHR的损失函数.

一些研究者对表面缺陷图像的超分辨率重建方法进行了积极的研究. 刘孝保等人[8]构建一种基于超分辨率特征融合的数据扩增模型解决表面细微缺陷模型构建困难、图像特征不明显和工业应用困难的问题; Cheng等人[9]提出一种缺陷感知生成对抗网络框架, 通过分割缺陷图像的感知注意力图增强生成高分辨率图像缺陷区域的可见性; Akhyar等人[10]用生成对抗网络ESRGAN预处理原始钢铁表面缺陷图像, 生成具有更丰富的边缘轮廓缺陷图像, 提高了对缺陷检测的精度.

1.2 YOLOv5检测模型金属工件加工产线生产节奏快、检测精度要求高以及硬件资源有限等因素都对算法的实时性提出了挑战. YOLOv5自2020年6月发布v1.0以来, 到如今最新v6.2版本, 经过了9个版本的更新, 受到了较多研究者的关注. YOLOv5是当前目标检测模型中能够很好地平衡检测速度和准确率的模型之一, 其模型参数量只有7.04M, 这为嵌入移动设备实现轻量化提供了良好条件[11].

YOLOv5模型结构主要包括: 输入端、主干网络、颈部、预测端, 其中输入端应用了Mosaic数据增强技术、自适应锚框计算以及自适应图片缩放技术; 主干网络主要由CBS结构、C3模块提取特征和SPPF提升模型感受野; 颈部由FPN+PAN的结构设计进行特征融合; 预测端预设了由K-means聚类数据集得到9种不同尺寸的anchor, 3个为一组, 分别预测大、中、小3种尺度的目标.

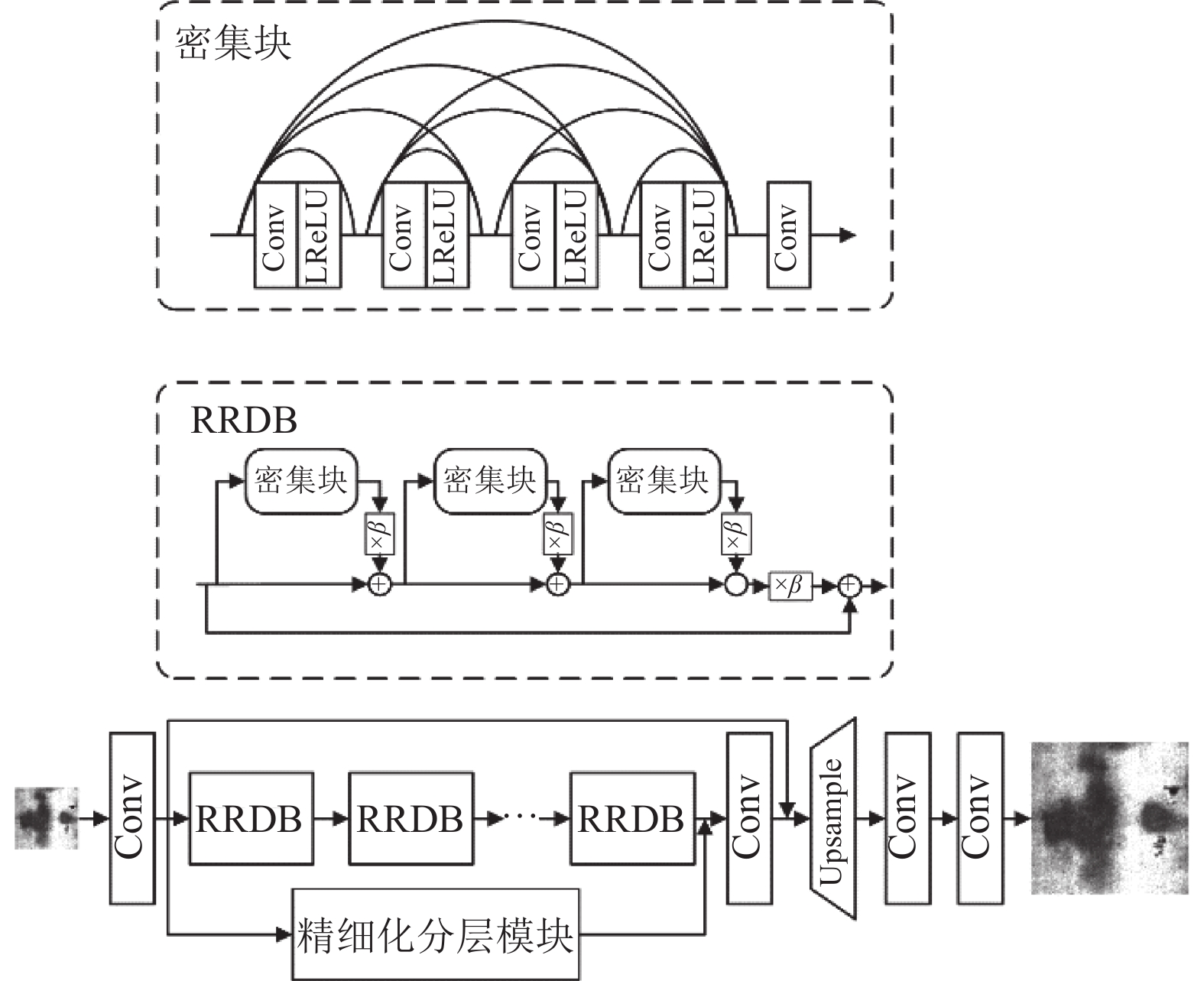

2 方法 2.1 多层融合超分辨率重建模型多层融合超分辨率重建模型主要由主干网络增强型超分辨率生成对抗网络(enhanced super-resolution generative adversarial network, ESRGAN)[12]、精细化分层结构两部分组成, 结构如图1所示. 残差密集块(residual-residual dense block, RRDB)移除了超分辨率网络经常使用的BN层, 防止重建图像产生伪影, 同时也能缩减网络的计算量. 图1中β为残差缩放系数, 即通过在0–1之间乘以一个常数来改变密集块支路的权重.

|

图 1 多层融合模型图 |

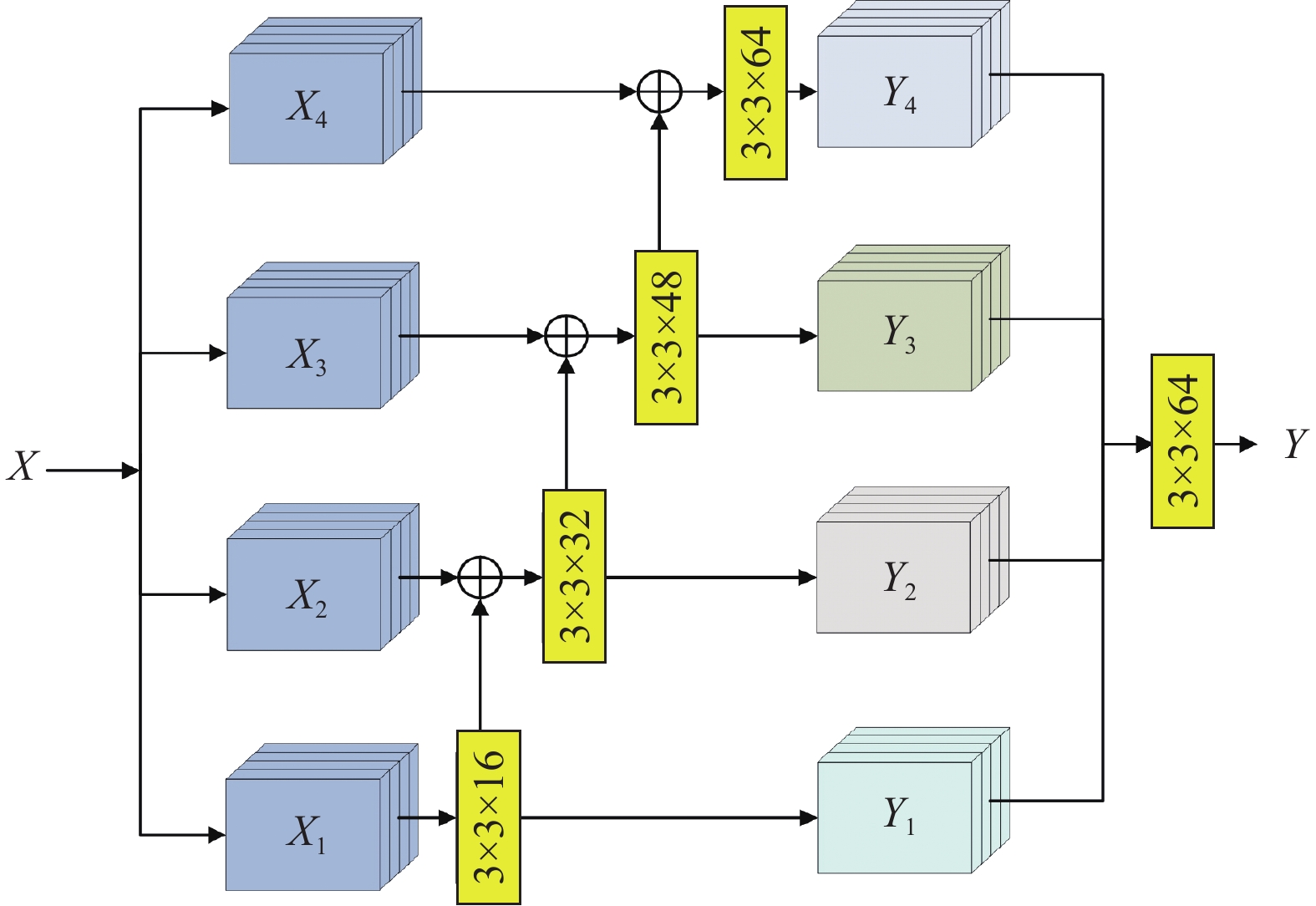

为了进一步提高主干特征提取网络不同尺度感受野的特征表示, 本文在主干网络设计了精细化分层支网络, 如图2所示, 精细化分层结构的输入特征图首先均分为4个通道的特征图Xi, 然后每个通道经过3×3卷积核分别提取来自本通道的特征图和上一层通道的特征图, 卷积之后每一层通道得到4个输出特征Yi, 每层的Xi和Yi存在如下关系:

| Yi={Xi,i=1Xi+Yi−1,1<i⩽4 | (2) |

|

图 2 精细化分层模块 |

最后, 在通道维度上拼接所有层的输出特征并得到重组特征Output, 重组特征使用1×1卷积核固定通道数, 使模块输入通道数与输出通道数保持一致. 精细化分层模块每一层特征子块Yi都能够学习来自Yi–1的特征, 可从输入特征中获取更多的通道信息, 有助于丰富特征图的感受野, 增强对特征图高低频信息的提取.

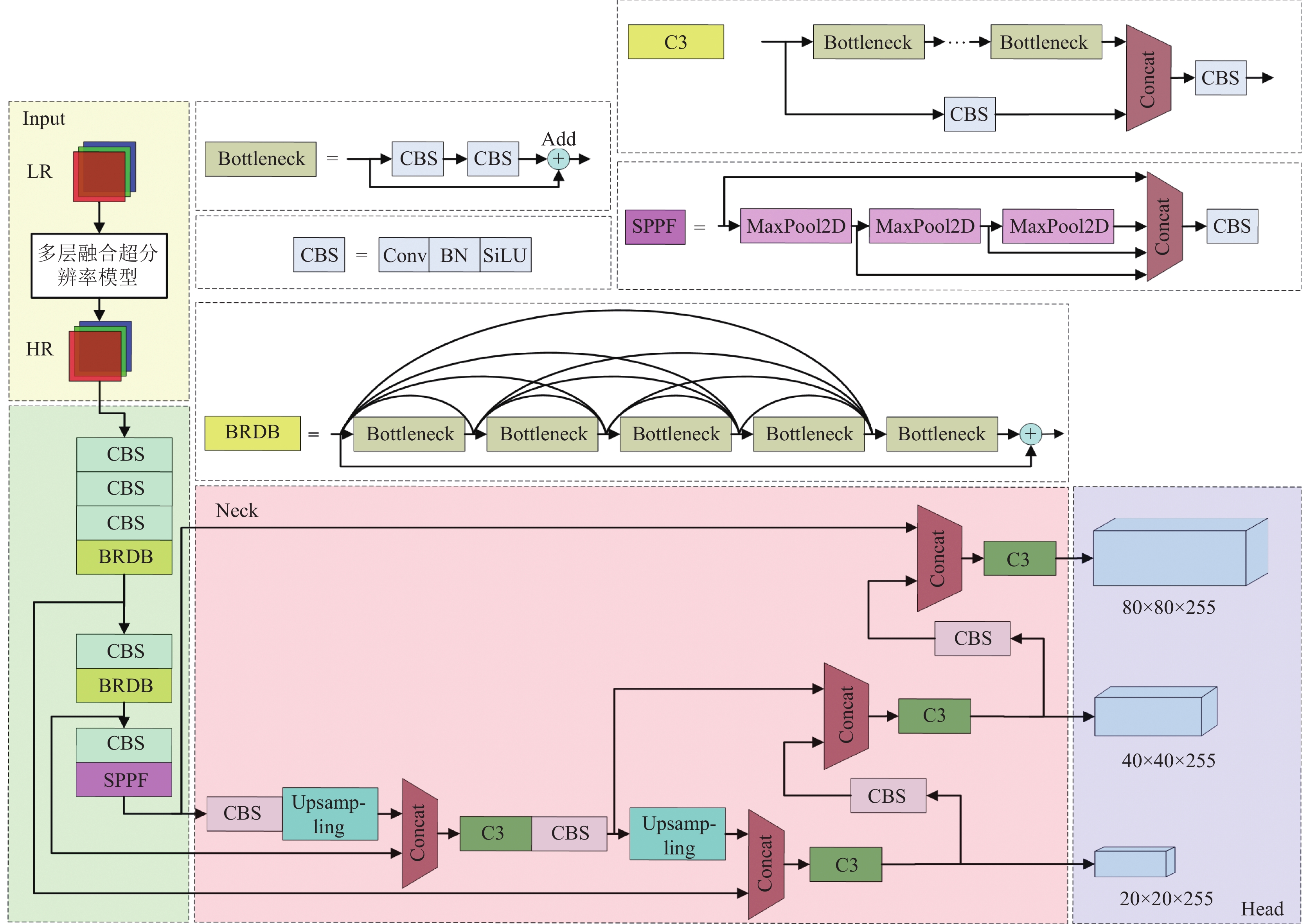

2.2 基于多层融合超分辨率重建的YOLOv5-BRDBYOLOv5在很多领域中取得了较好的检测结果, 但其检测背景复杂的多种尺度小目标和密集目标极易发生漏检或错检的情况. 主干特征提取网络Backbone浅层特征包含丰富的位置信息, 有利于目标的定位, 而深层特征包含较多的语义信息, 有利于目标的分类. 为进一步丰富主干特征提取网络的位置信息和语义信息, 本文构建了基于瓶颈残差密集块的YOLOv5 (YOLOv5 based on bottleneck residual dense block, YOLOv5-BRDB)检测模型, 其结构如图3所示, 首先原始的低分辨率缺陷图像LR经过多层融合超分辨率重建模型处理成高分辨率图像HR, 尺寸大小为800×800×3的HR作为YOLOv5-BRDB的输入图像. Backbone的BRDB模块通过瓶颈结构(Bottleneck)中的第1个1×1卷积核固定输入特征的维度, 避免使用普通卷积块使密集连接结构因后面卷积块特征输入增加引起BRDB模块计算量爆炸增长的缺点, 在BRDB模块中的每个Bottleneck结构的输出特征满足以下关系:

| Ti={Fi(A),i=1Fi(∑i−1t=1Ft(Tt−1)),1<i⩽5 | (3) |

其中, Ti表示第i个Bottleneck模块的输出特征, Fi(·)表示第i个Bottleneck卷积的卷积过程, A表示第1个Bottleneck的输入特征,

|

图 3 基于多层融合模超分辨率重建模型的YOLOv5-BRDB缺陷检测模型 |

从式(3)中可以发现BRDB结构可获得来自不同Bottleneck的不同尺度、不同深度特征, 增强主干网络Backbone对浅层位置特征和深层分类特征的提取能力, 提升模型对金属表面缺陷中的小目标和密集目标的检测准确率.

2.3 贝叶斯算法优化YOLOv5-BRDB超参数贝叶斯优化算法[13–15]是一种有效的全局优化算法, 广泛应用于机器学习、神经网络架构搜索、元学习等领域. 在深度学习领域中, 超参数的取值影响着模型的性能, 现有模型超参数的优化多依靠开发人员的主观经验, 需要专业的调参经验和耗时的“试错”使模型达到较好的效果. 一些研究者使用群智能优化算法优化深度模型的超参数, 但深度模型评估一次需要较高的时间和计算资源代价, 而贝叶斯优化算法能够根据未知目标函数学习先验知识更新评估位置, 相比群智能优化算法更高效找到深度模型的最优超参数组合.

贝叶斯优化算法利用代理模型拟合计算代价昂贵的真实的目标函数(即YOLOv5-BRDB), 并根据采集函数主动选择最具“潜力”的点作为下一个评估点(即YOLOv5-BRDB的超参数), 从而避免了不必要的采样, 其中贝叶斯优化算法的优化过程用到了贝叶斯定理:

| p(f|D1:t)=p(D1:t|f)p(f)p(D1:t) | (4) |

其中, f表示目标函数; D1:t={(x1, y1), (x2, y2), …, (x3, y3)}表示已观测集合; xt表示决策向量, yt = f (xt) + εt 表示观测值, εt表示观测误差; p(D1:t|f )表示y的似然分布; p(f)表示先验概率分布, 即对评估代价较大的目标函数状态的假设; p(D1:t)表示边缘似然分布; p(f|D1:t)表示f的后验概率分布, 描述已观测值对先验分布修正后目标函数的置信度.

代理模型和采集函数是贝叶斯优化算法的两个核心组成部分, 概率代理模型包含先验概率模型和观测模型, 两者分别可视为式(4)中的p(f)和p(D1:t|f). 更新概率代理模型表示后验分布p(f |D1:t)得到了更多的目标函数的分布信息. 采集函数用于选择下一个评估点.

本文构建的适应度函数即贝叶斯优化算法的目标函数, 为了有较高的均值平均精度, 本文以10%权值mAP0.5和90%权值mAP0.5:0.95之和作为适应度函数fitness, 在表1给定超参数的搜索范围内, 贝叶斯优化算法搜寻使fitness达到最大值的一组超参数解, fitness表达式如下:

| fitness=0.1×mAP0.5+0.9×mAP0.5:0.95 | (5) |

其中, mAP0.5、mAP0.5:0.95分别表示阈值IOU=0.5和IOU步长0.05从0.5到0.95的均值平均精度.

为了自适应寻优YOLOv5-BRDB超参数, 设计了算法1.

算法1. 贝叶斯算法优化YOLOv5-BRDB模型超参数

输入: 训练集记为Dt, 验证集记为Dv; YOLOv5-BRDB需要优化的超参数X; N为最大迭代次数.

输出: 适应度值fitness及超参数最优值vopt.

Initialization: 随机产生初始化点

1 while t<N:

2 最大化采集函数选择下一个评估点 xt=argmaxx∈Xα(x);

3 训练模型得到模型参数 mx←A(xt, Dt);

4 在验证集上计算式(5)适应度值 fitness=A(mx, Dv);

5 if fitness≥0.45:

6 结束算法;

7 end if

8 更新高斯代理模型及最优超参数值vopt;

9 t=t+1;

10 end while

11 return fitness和 vopt.

3 实验分析 3.1 实验环境及数据集金属表面缺陷超分辨率重建和检测的实验平台是64位的Windows 10, 学习框架PyTorch, CPU配置Intel(R) Core(TM) i5-9400F CPU @ 2.90 GHz, 内存配置16 GB, 显卡配置NVIDIA GeForce RTX 2060 SUPER.

本文对GC10-DET钢带缺陷数据集双三次插值退化为低分辨率数据, 将GC10-DET原始图像和退化图像分别作为高分辨率图像和低分辨率图像训练多层融合超分辨率模型, 其中GC10-DET划分为1836张训练集, 229张验证集及229张测试集. 然后用训练好的多层融合超分辨率模型对东北大学提供的NEU-DET钢带裂缝缺陷进行放大因子为4的超分辨率重建, 最后用YOLOv5-BRDB对重建好的NEU-DET数据集进行金属表面缺陷检测, 其中NEU-DET划分为1440张训练集、180张验证集和180张测试集.

3.2 评价指标金属表面缺陷超分辨率重建质量客观评估有峰值信噪比(peak signal-to-noise ratio, PSNR)和结构相似度(structural similarity, SSIM). PSNR单位是分贝(dB), 值越大表示重建质量越好[16].

| PSNR=20log10(Pmax√MSE) | (6) |

其中, Pmax表示图像中像素最大值, MSE为图像的均方差.

SSIM将图像的组成分为亮度、对比度和结构, 并用均值估计亮度, 标准差估计对比度、协方差估计结构, 是目前超分辨率领域最常用的评估图像失真的指标之一, 其值越大表示重建质量越好, 数学表达式如下:

| SSIM=(2μXμˆX+C1)(2σXˆX+C2)(μ2Xμ2ˆX+C1)(σ2Xσ2ˆX+C2) | (7) |

其中,

感知图像块相似度(perceptual image patch similarity, LPIPS)和感知度(perceptual index, PI)辅助评估图像质量. LPIPS是通过学习图像patch的相似度来评价图像质量, PI是通过非参考图像度量指标Ma和NIQE来评价图像质量, 而LPIPS和PI值越低, 表示图像边缘纹理细节越丰富, 图像质量越好[17]. PI计算公式如下:

| PI=12((10−Ma)+NIQE) | (8) |

金属表面缺陷检测性能可用精确率(precision, p)、召回率(recall, r)、平均精度(average precision, AP)和平均精度均值(mean average precision, mAP)这4个指标评估[18]. 模型预测框和人工标注的真实框无法完全一致, 根据匹配结果可分为: 真正例(true positive, TP)、真反例(true negative, TN)、假正例(false positive, FP)和假反例(false negative, FN).

精确率表示预测正确的正样本占所有预测为正样本的比例, 反映了模型的分类能力.

| p=TPTP+FP | (9) |

召回率表示预测正确的正样本占所有真实正样本的比例, 反映了模型的检测能力.

| r=TPTP+FN | (10) |

平均精度是以精确率为横坐标, 召回率为纵坐标围成P-R曲线的面积, 计算公式如下:

| AP=∫10p(r)dr | (11) |

均值平均精度是评估模型综合性能最重要的一个指标, 具体表示C个缺陷类别的平均精度, 计算公式如下:

| mAP=∑Ci=1APiC | (12) |

金属表面缺陷检测模型实时性评估可用FPS, FPS表示每秒传输的帧数, 计算公式如下:

| FPS=1latency | (13) |

其中, latency表示模型前向传播时间(预处理时间、推理时间和后处理时间之和), 单位是s.

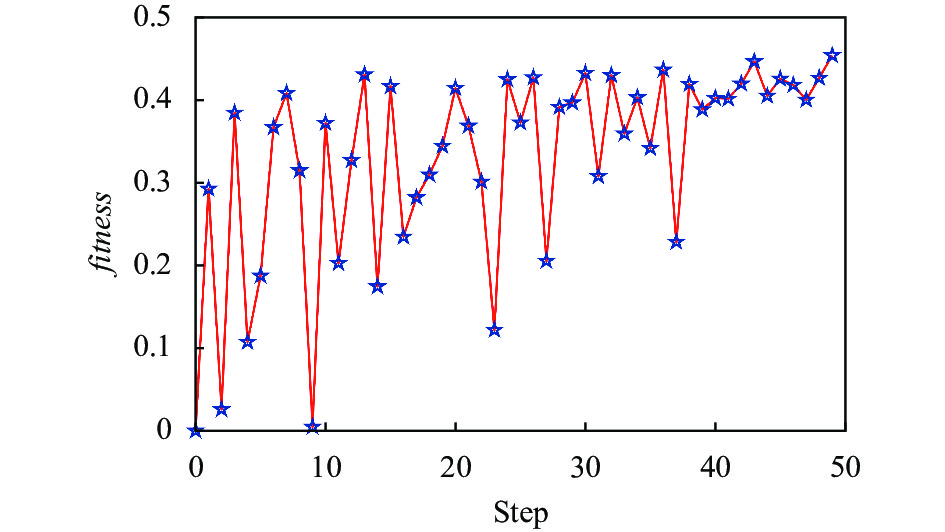

3.3 基于贝叶斯优化的超参数自适应寻优结果实验以式(5)适应度函数为优化目标, 寻找YOLOv5-BRDB 中20个关键超参数最优组合. 鉴于贝叶斯优化算法评估一次YOLOv5-BRDB需要数个小时, 评估代价较大, 本文设置YOLOv5-BRDB epochs为300, 贝叶斯优化算法迭代次数50, 同时设置早停机制当fitness≥0.45终止算法. 图4是适应度函数值随着迭代次数变化曲线, 在迭代次数内, 贝叶斯优化算法的探索和开发较为平衡, 逐步向最优适应度值靠近. 表1是超参数的寻优范围和最优值.

|

图 4 贝叶斯算法优化YOLOv5-BRDB模型迭代曲线 |

| 表 1 自适应寻优超参数范围及最优值 |

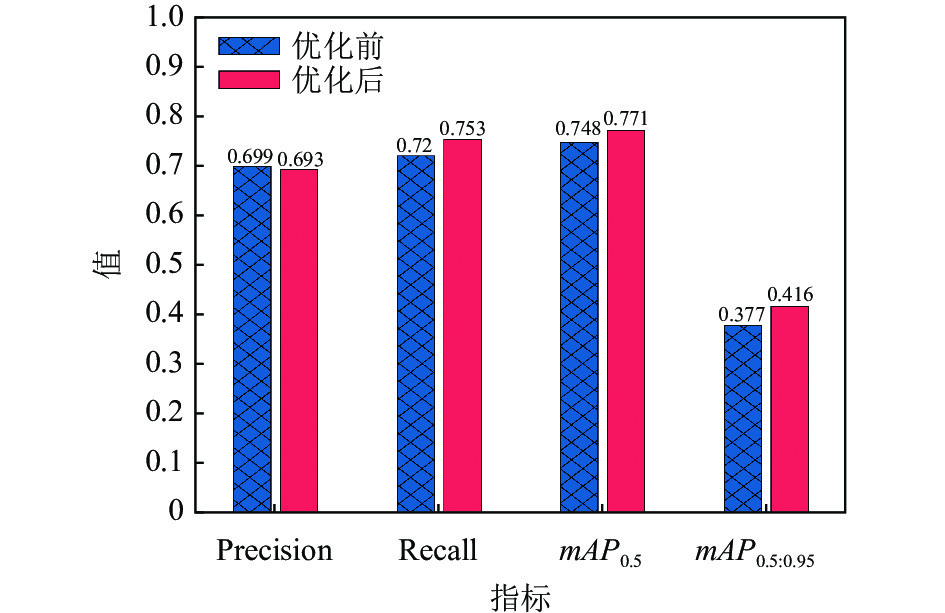

图5是YOLOv5-BRDB超参数优化前后分别设置epochs为500, 准确率、召回率、mAP0.5、mAP0.5:0.95对比的条形图. 由于精确率和召回率呈反相关, 故优化后比优化前的精确率低, 召回率优化前相比优化后提升4.58%, mAP0.5优化前相比优化后提升3.07%, mAP0.5:0.95优化前相比优化后提升10.34%, 验证了本文贝叶斯优化算法的有效性.

3.4 多层融合超分辨率重建模型实验本实验对NEU-DET数据集进行了放大因子为4的超分辨率处理. 表2对比了多层融合超分辨率重建模型与其他超分辨率模型的PSNR、SSIM、LPIPS、PI指标. PSNR、SSIM、LPIPS和PI均优于其他超分辨率重建算法, 表明本文多层融合超分辨率重建模型重建的图像质量更高.

|

图 5 寻优前后精确率, 召回率, mAP0.5, mAP0.5:0.95变化 |

| 表 2 在NEU-DET验证集上多层融合超分辨率模型与其他模型性能对比 |

3.5 贝叶斯优化的表面缺陷超分辨率检测实验

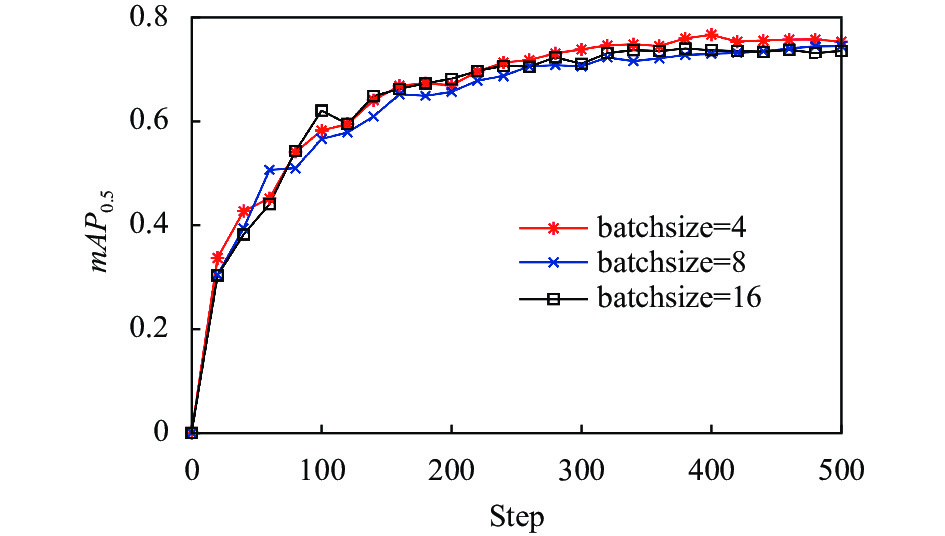

本实验在小样本数据集下进行金属表面缺陷模型的训练及检测, batchsize大小的设置影响模型的最终训练结果. 图6是batchsize分别设置4、8、16时, 模型训练500次的mAP0.5变化曲线. mAP0.5值随着batchsize变大而变小, 两者在小样本金属表面缺陷数据集下呈负相关, 故本文设置batchsize为4.

表3比较了原模型YOLOv5、改进模型YOLOv5-BRDB、YOLOv5-BRDB+多层融合超分辨率重建模型在6类金属表面缺陷下的精确率(precision)和mAP0.5. 在crazing缺陷检测中, YOLOv5-BRDB相比YOLOv5精确率提升30.74%, mAP0.5提升33.77%, YOLOv5-BRDB+多层融合超分辨率重建模型相比YOLOv5-BRDB精确率提升13.64%, mAP0.5提升19.92%; 在inclusion缺陷检测中, YOLOv5-BRDB相比YOLOv5精确率提升20.94%, mAP0.5提升2.59%, YOLOv5-BRDB+多层融合超分辨率重建模型相比YOLOv5-BRDB精确率提升1.46%, mAP0.5提升2.64%; 在patches缺陷检测中, YOLOv5-BRDB相比YOLOv5精确率提升7.5%, mAP0.5提升1.38%, YOLOv5-BRDB+多层融合超分辨率重建模型相比YOLOv5-BRDB精确率提升1.08%, mAP0.5提升2.05%; 在pitted_surface缺陷检测中, YOLOv5-BRDB相比YOLOv5精确率提升2.04%, mAP0.5下降0.11%, YOLOv5-BRDB+多层融合超分辨率重建模型相比YOLOv5-BRDB精确率提升1.41%, mAP0.5提升1.49%; 在rolled_in_scale缺陷检测中, YOLOv5-BRDB相比YOLOv5精确率提升12.19%, mAP0.5提升11.92%, YOLOv5-BRDB+多层融合超分辨率重建模型相比YOLOv5-BRDB精确率提升3.23%, mAP0.5提升3.11%; 在scratches缺陷检测中, YOLOv5-BRDB相比YOLOv5精确率提升0.87%, mAP0.5提升5.49%, YOLOv5-BRDB+多层融合超分辨率重建模型相比YOLOv5-BRDB精确率提升2.1%, mAP0.5提升1.17%. 综合以上分析, 验证了YOLOv5-BRDB和YOLOv5-BRDB+多层融合超分辨率重建模型的有效性.

|

图 6 不同batchsize大小下mAP0.5曲线 |

| 表 3 模型改进前后各类缺陷精度及均值平均精度变化 (%) |

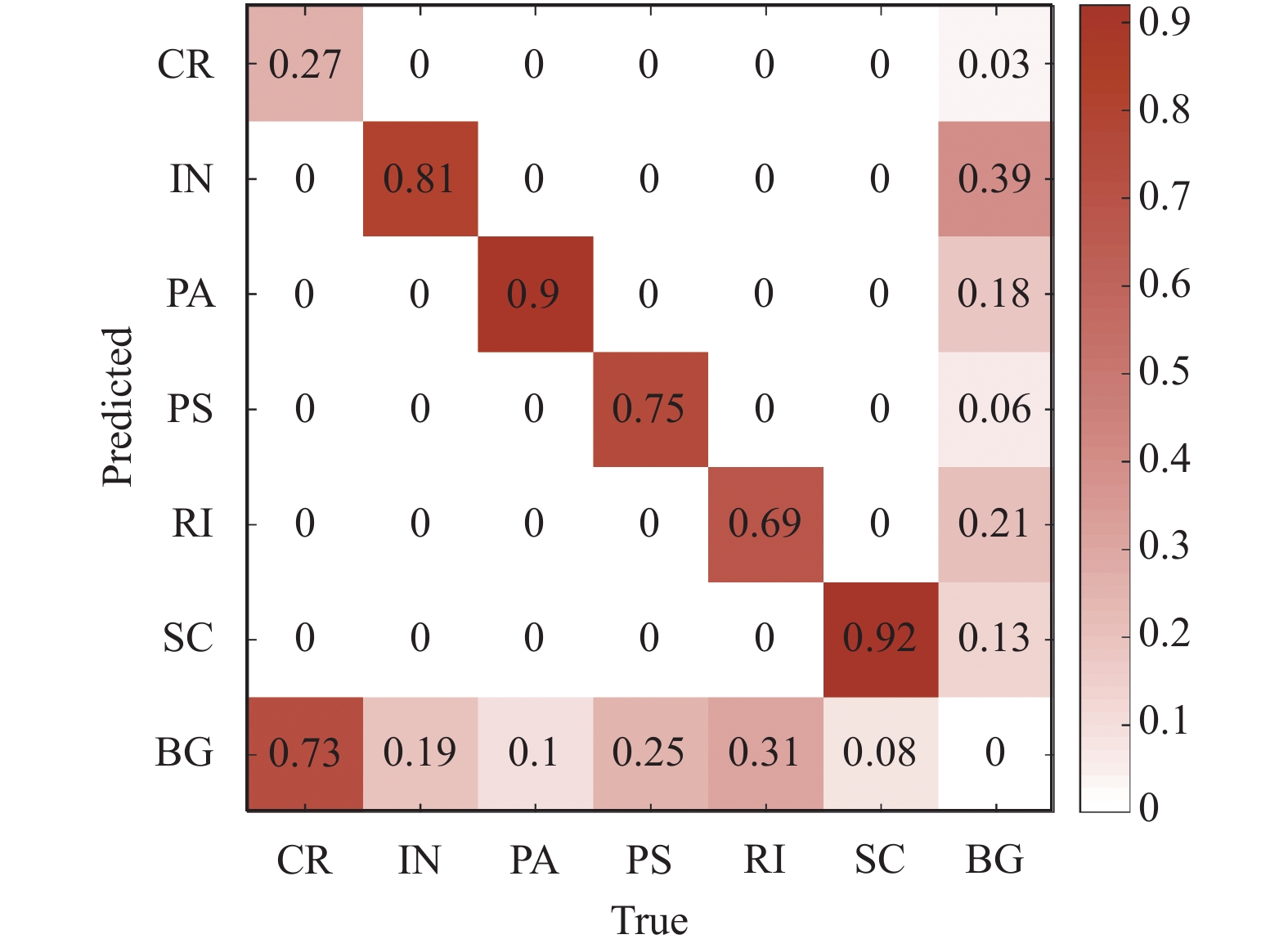

图7是YOLOv5-BRDB在验证集上训练500次预测框损失、分类损失、置信度损失曲线. 3类损失曲线中, YOLOv5-BRDB相比YOLOv5更平滑, 鲁棒性更好. 预测框损失和置信度损失曲线中, YOLOv5-BRDB相比YOLOv5损失值更低, 说明预测框和标注框更接近, 可信度更高. 其中分类损失曲线波动较大的原因可从图8 YOLOv5-BRDB+多层融合超分辨率重建模型的混淆矩阵分析, crazing、inclusion、pitted_surface、rolled_in_scale这4类缺陷与背景相近, 易被识别为背景, 故分类损失曲线波动较大.

|

图 7 预测框、分类、置信度损失函数 |

图8是YOLOv5-BRDB+多层融合超分辨率重建模型的混淆矩阵, 水平轴表示真实的缺陷类别, 垂直轴表示预测的缺陷类别, CR表示crazing, IN表示inclusion, PA表示patches, PS表示pitted_surface, RI表示rolled_in_scale, SC表示scratches, BG表示背景. 图中对角线表示正确分类的比例, 底部行表示错误将缺陷分类为背景的比例, 右侧列表示错误将背景分类为缺陷的比例. 图8中底部水平行CR、IN、PS、RI值较大, 表示这4种缺陷被分类为背景的比例较大; 右侧垂直列CR、IN、PA、PS、RI、SC值较大, 表示背景被分类这6类缺陷的比例较大; 分析是由于NEU-DET数据集类间差距小、类内差距大、缺陷与背景相近导致.

|

图 8 YOLOv5-BRDB+多层融合模型混淆矩阵 |

表4对比了YOLOv5-BRDB与Faster RCNN[19], YOLOv3[20], YOLOv5和2022年最新YOLOv7-tiny[21]在NEU-DET数据集上的综合检测性能. YOLOv5-BRDB相比YOLOv7-tiny参数量稍大, 但是mAP0.5较YOLOv5提升4.55%, mAP0.5:0.95较YOLOv5提升2.42%, FPS较YOLOv5提升22.51%; mAP0.5较YOLOv7-tiny提升2.62%, mAP0.5:0.95较YOLOv7-tiny提升2.42%, FPS较YOLOv7-tiny提升132.76%, 验证YOLOv5-BRDB有更高的检测精度和更快的检测速度.

| 表 4 本文检测算法与其他检测算法性能对比 |

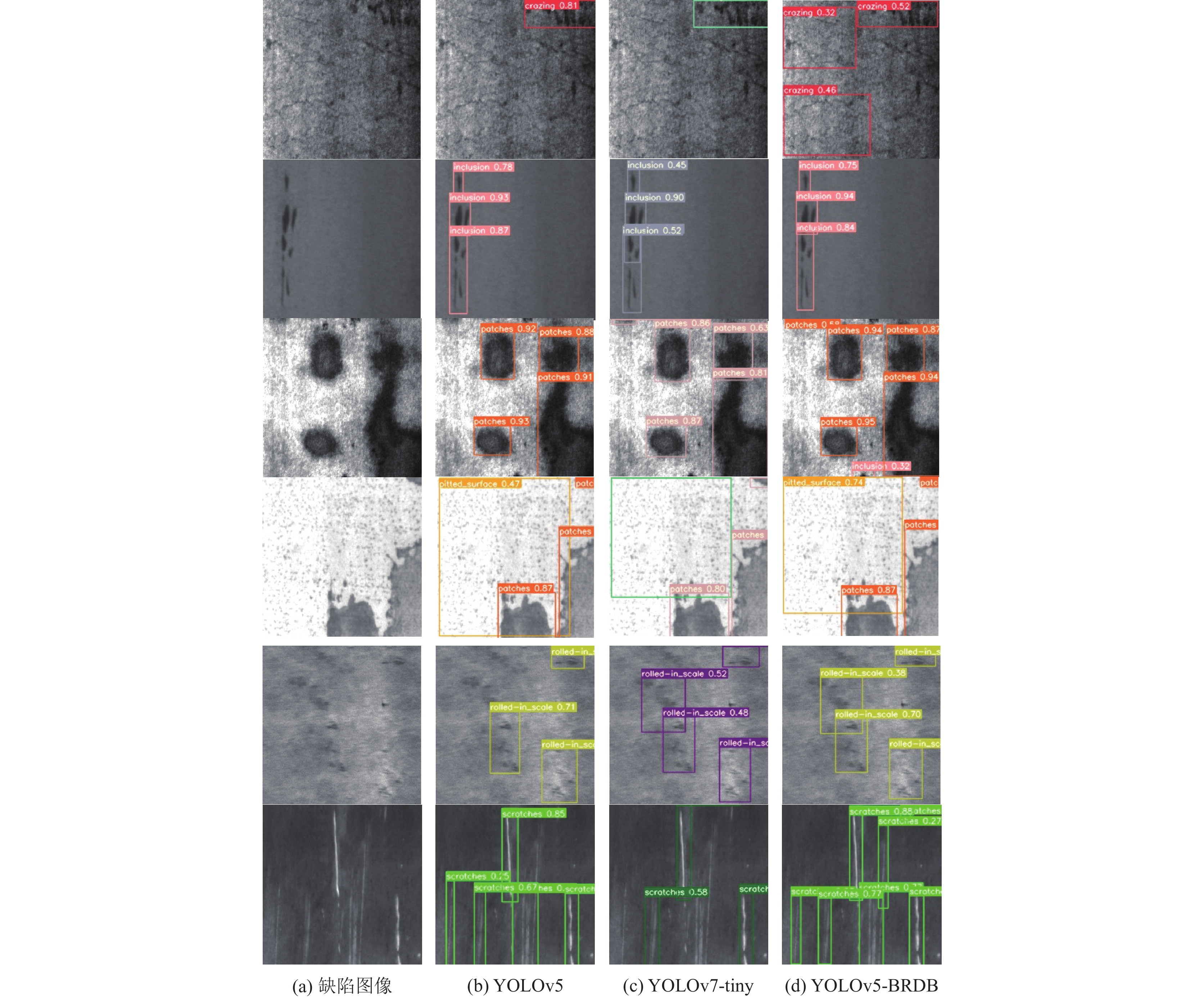

图9是YOLOv5、YOLOv7-tiny、YOLOv5-BRDB这3种模型对6种缺陷: crazing, inclusion, patches, pitted_surface, rolled_in_scale, scratches的检测结果对比, YOLOv5-BRDB相比YOLOv5和YOLOv7-tiny两种模型, 能够检测出复杂背景下的密集缺陷和小目标缺陷.

|

图 9 不同算法检测可视化比较 |

4 结论

本文提出一种基于贝叶斯优化的金属表面缺陷超分辨率检测算法. 通过构建多层融合超分辨率重建模型, 将ESRGAN和精细化分层结构有效融合, 丰富主干特征提取网络特征图的感受野, 增强对特征图高低频信息的提取, 重建出边缘纹理清晰的图像; 通过提出瓶颈残差密集结构, 丰富主干特征提取网络的浅层特征和深层特征, 增强模型对小目标和密集目标的分类和定位能力; 通过贝叶斯算法优化YOLOv5-BRDB模型中20个关键超参数, 提高模型超参数自适应能力. 实验表明, 多层融合超分辨率重建模型有较好的图像超分辨率重建效果, 同时改进模型YOLOv5-BRDB的mAP0.5可达0.782. 所提方法对crazing、inclusion、patches、pitted_surface、rolled_in_scale、scratches这6类缺陷的检测精度相比YOLOv5的检测精度分别提高48.6%、22.7%、8.7%、3.5%、15.8%、3.0%. 检测速度可达102 f/s, 对小目标和密集目标缺陷有较好的检测性能.

| [1] |

王道累, 刘易腾, 杜文斌, 等. 基于级联孪生密集网络的金属表面缺陷检测方法. 计算机辅助设计与图形学学报, 2022, 34(6): 946-952. DOI:10.3724/SP.J.1089.2022.19056 |

| [2] |

李维刚, 叶欣, 赵云涛, 等. 基于改进YOLOv3算法的带钢表面缺陷检测. 电子学报, 2020, 48(7): 1284-1292. DOI:10.3969/j.issn.0372-2112.2020.07.006 |

| [3] |

王一, 龚肖杰, 程佳, 等. 基于改进YOLOv5的金属工件表面缺陷检测. 包装工程, 2022, 43(15): 54-60. DOI:10.19554/j.cnki.1001-3563.2022.15.006 |

| [4] |

Wang CL, Zhou ZR, Chen ZM. An enhanced YOLOv4 model with self-dependent attentive fusion and component randomized mosaic augmentation for metal surface defect detection. IEEE Access, 2022, 10: 97758-97766. DOI:10.1109/ACCESS.2022.3203198 |

| [5] |

Xie YF, Hu WT, Xie SW, et al. Surface defect detection algorithm based on feature-enhanced YOLO. Cognitive Computation, 2023, 15(2): 565-579. DOI:10.1007/s12559-022-10061-z |

| [6] |

邢苏霄, 陈金玲, 李锡超, 等. 基于深度学习的单图像超分辨率重建综述. 计算机系统应用, 2022, 31(7): 23-34. DOI:10.15888/j.cnki.csa.008566 |

| [7] |

钟梦圆, 姜麟. 超分辨率图像重建算法综述. 计算机科学与探索, 2022, 16(5): 972-990. DOI:10.3778/j.issn.1673-9418.2111126 |

| [8] |

刘孝保, 刘佳, 阴艳超, 等. 基于超分辨率特征融合的工件表面细微缺陷数据扩增方法. 计算机集成制造系统, 2022, 28(6): 1844-1853. DOI:10.13196/j.cims.2022.06.022 |

| [9] |

Cheng LL, Kersemans M. Dual-IRT-GAN: A defect-aware deep adversarial network to perform super-resolution tasks in infrared thermographic inspection. Composites Part B: Engineering, 2022, 247: 110309. DOI:10.1016/j.compositesb.2022.110309 |

| [10] |

Akhyar F, Furqon EN, Lin CY. Enhancing precision with an ensemble generative adversarial network for steel surface defect detectors (EnsGAN-SDD). Sensors, 2022, 22(11): 4257. DOI:10.3390/s22114257 |

| [11] |

邵延华, 张铎, 楚红雨, 等. 基于深度学习的YOLO目标检测综述. 电子与信息学报, 2022, 44(10): 3697-3708. DOI:10.11999/JEIT210790 |

| [12] |

Wang XT, Yu K, Wu SX, et al. ESRGAN: Enhanced super-resolution generative adversarial networks. European Conference on Computer Vision. Munich: Springer, 2019. 63–79.

|

| [13] |

Young MT, Hinkle JD, Kannan R, et al. Distributed Bayesian optimization of deep reinforcement learning algorithms. Journal of Parallel and Distributed Computing, 2020, 139: 43-52. DOI:10.1016/j.jpdc.2019.07.008 |

| [14] |

邓帅. 基于改进贝叶斯优化算法的CNN超参数优化方法. 计算机应用研究, 2019, 36(7): 1984-1987. DOI:10.19734/j.issn.1001-3695.2018.01.0021 |

| [15] |

董丽娟, 方召, 陈会涛. 基于深度学习和贝叶斯优化的压缩机故障诊断. 机械设计与制造, 2023, 384(2): 45-52. DOI:10.19356/j.cnki.1001-3997.20221103.043 |

| [16] |

吴靖, 叶晓晶, 黄峰, 等. 基于深度学习的单帧图像超分辨率重建综述. 电子学报, 2022, 50(9): 2265-2294. DOI:10.12263/DZXB.20220091 |

| [17] |

Fu K, Peng JS, Zhang HX, et al. Image super-resolution based on generative adversarial networks: A brief review. Computers, Materials & Continua, 2020, 64(3): 1977-1997. DOI:10.32604/cmc.2020.09882 |

| [18] |

付苗苗, 邓淼磊, 张德贤. 深度神经网络图像目标检测算法综述. 计算机系统应用, 2022, 31(7): 35-45. DOI:10.15888/j.cnki.csa.008595 |

| [19] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 1440–1448.

|

| [20] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [21] |

Wang CY, Bochkovskiy A, Liao HYM. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. arXiv:2207.02696, 2022.

|

2023, Vol. 32

2023, Vol. 32