交通标志检测与识别作为辅助与自动驾驶的关键技术之一, 交通标志的准确、快速检测与识别对安全驾驶具有重要意义. 交通标志包含路段、车速限制以及险情警示等信息, 对智能驾驶的行车规划、车流限速和路面安全状况具有重要的指示作用. 车辆在行驶中, 因受光线、天气以及遮挡物等影响, 从而易使交通标志产生误检, 这给自动驾驶带来了巨大的安全隐患. 因此, 研究实时性强、精度高、误检率低的适合复杂场景的交通标志检测与识别方法成为该领域关注的热点.

传统的交通标志检测技术主要基于颜色、形状以及多层特征等方法. 最初, 研究者们以颜色信息作为交通标志识别的主要依据. Lin等人[1]提出一种基于颜色相似性的交通标志检测方法, 通过计算R、G、B分量的最大值与最小值, 去除与交通标志颜色相差较大的色素, 使用模板扫描方式检测出交通标志边缘信息. 朱双东等人[2]通过对颜色进行标准化, 降低交通标志颜色的复杂性, 使用两层智能分类器对交通标志进行识别. Lin等人[3]基于麦克斯韦颜色三角形的理论, 提出一种红、黄、蓝颜色切割公式, 经过多次实验后确定其阈值范围, 最终完成对交通标志的检测.

基于颜色的交通标志检测易受到光线的影响, 尤其是在强光、弱光等恶劣环境下, 为了消除光照的因素, 学者们开始对交通标志的形状进行研究. Andrey等人[4]使用背景直方图, 对从交通标志图像中提取到的候选符号进行分类, 将其分为圆形或三角形, 再使用模板匹配法对其进行细分. Wang等人[5]提出了一种基于颜色和形状的交通标志分割方法, 在二值图像中进行轮廓特征提取, 再根据颜色和形状进行切割. Yıldız等人[6]通过对图像进行降噪和形态学处理, 使交通标志图片变得易于处理, 并借助形状信息过滤非交通标志的部分.

传统的交通标志检测很容易受限于光照、遮挡物等因素, 导致检测速度慢, 预测精度低, 实用性不强. 近几年来, 由于计算机计算能力的不断提升, 深度学习网络逐渐应用于目标检测中. 深度学习不同于传统的检测方法, 它通过对交通标志大数据进行训练进而提取特征, 具有更强的特征提取和表达能力, 检测精度较高, 不易受到光照、天气等外界环境的影响. 因此, 深度学习目标检测技术成为当下主流的交通标志检测技术.

目前主流的目标检测算法可以分为以YOLO (you only look once)系列为主的单阶段法和以Faster RCNN (region-convolutional neural network)为主的双阶段法两大类. 熊昌镇等人[7]提出一种基于卷积神经网络(convolutional neural networks, CNN)的交通标志检测算法, 使用区域建议网络检测数据集, 最终取得了不错的效果. Zhang等人[8]提出了一种级联RCNN网络(region with CNN feature), 用于获得交通标志多尺度特征, 为了细化特征提取, 引入一种多尺度注意方法. Cao等人[9]提出了一种改进的稀疏RCNN算法, 该算法通过修改网络主干和引入跨渠道自我关注机制, 在不增加计算量的情况下获得了更好的效果. Sarumathi等人[10]将Faster RCNN 算法应用到交通标志检测中, 通过加入CNN数据流模型, 使模型的精度得到大幅度提高. 郭璠等人[11]为解决小目标识别不准确等问题, 将空间注意力和通道注意力机制引入到YOLOv3中, 提升了交通标志检测的精度和召回率. Wang等人[12]为了提高YOLOv4算法的精度, 采用K-means算法重新对交通标志进行聚类, 获得适用于交通标志的先验框尺寸, 并修改了模型输出的特征尺度, 该方法在速度和精度方面均得到提升. Aggar等人[13]将YOLOv5算法应用到交通标志检测中, 发现其各项评价指标都优于以往算法. 为了使YOLOv5s算法可以应用到实际交通场景中, Liu等人[14]将MobileNetV2作为主干网络载入YOLO网络中, 使整个模型的参数量降低60%, 同时保证mAP提升了0.129%. 张上等人[15]通过对YOLOv5网络进行模型裁剪, 压缩了网络的运算参数, 在模型中加入坐标注意力机制(coordinate attention, CA)和CBAM注意力机制(convolutional block attention module), 使网络的精度提升了2.8%.

现有的目标检测在交通标志检测领域取得了一定的成功, 但是, 由于行车环境复杂, 交通标志具有分辨率低、有效特征信息少等问题, 使得常规方法提取到的交通标志特征信息严重不足, 从而导致漏检现象的发生. 针对以上现象, 本文使用K-means++算法聚类交通标志数据集获得适合检测交通标志的锚框, 同时将坐标注意力和空洞空间金字塔池化(atrous spatial pyramid pooling, ASPP)引入到YOLOv7特征提取网络中, 使交通标志的坐标信息融入到深层次的特征信息中, 加强网络对有效信息的提取; 同时扩大卷积核的感受野, 避免交通标志特征信息在池化过程中丢失, 有助于后续在特征图上检测小目标, 从而提出了一种基于坐标注意力机制的YOLOv7算法——YOLOv7-PC(you only look once-pyramid coordinate)算法. CCTSDB测试结果表明, 本文提出的YOLOv7-PC模型相比于YOLOv7算法, mAP、召回率和精确率都得到了提高, 并且对不同环境下的标志标线具有良好的识别性能, 因此本文提出的YOLOv7-PC算法是一种有效的交通标志检测和识别算法.

2 YOLOv7算法YOLO是由Redmon等人[16]提出的一种单阶段的目标检测网络. 其核心思想就是把目标检测转变成一个回归问题, 将整张图作为网络的输入, 仅经过一个神经网络, 就能得到预测框的位置、目标所属类别和置信度. 相较于之前的算法, YOLO算法不仅检测速度更快, 精度也相对较高. 之后Redmon等人提出YOLOv2算法[17], 将Darknet-19作为主干特征提取网络, 并引入锚框机制, 旨在解决YOLO算法召回率和精确率较低等问题. 为了进一步提高目标检测的准确性, Redmon等人又提出YOLOv3算法[18], 这次改进将Darknet-53作为主干特征提取网络, 引入金字塔网络结构, 使网络在精度和速度两方面同时得到提升. YOLOv4在YOLOv3的基础上, 将原主干网络Darknet-53与CSPNet (cross stage partial network)进行结合, 生成CSPDarknet-53主干网络, 并引入SPP (spatial pyramid pooling)结构和PANet网络(path aggregation network), 进一步提高了检测效果. YOLOv5在YOLOv4的基础上引入Focus结构, 并将CSPNet应用到加强特征提取网络中, 使目标检测效果达到了一个新的高度.

YOLOv7是Wang等人[19]在2022年提出的目标检测算法, 在原有YOLOv5的基础上加以改进, 引入了扩展的高效层聚合网络和基于concatenate模型的模型缩放, 并在网络训练中加入辅助训练头、标签分配等技巧. 在一定范围内, YOLOv7的检测速度和精度超过了目前所有的检测网络.

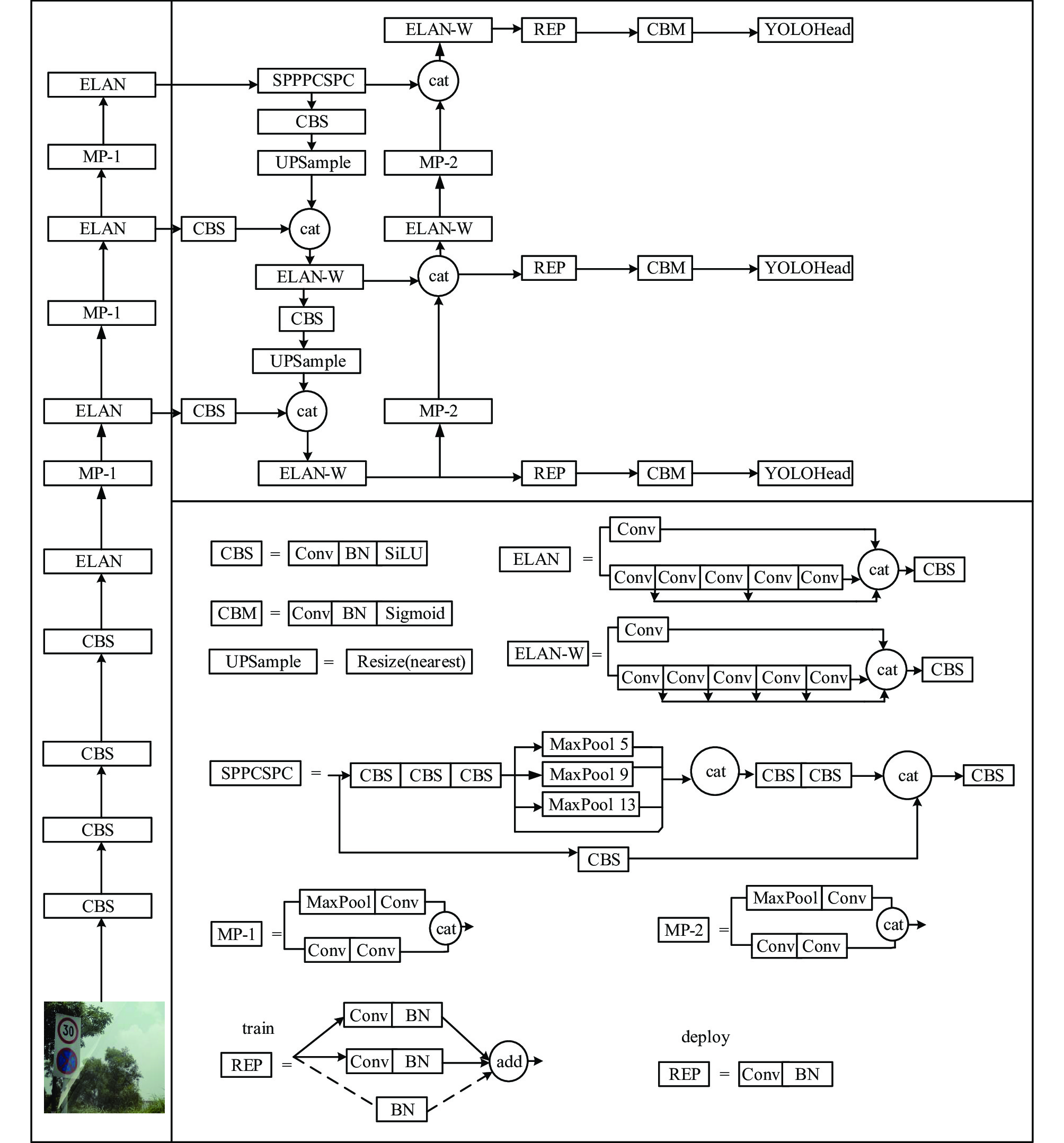

YOLOv7网络结构如图1所示, 其主要由主干特征提取网络、加强特征提取层、YOLOHead这3部分构成.

主干网络主要负责交通标志特征信息的初步提取, 其包括CBS结构、ELAN结构和MP-1结构. 在加强特征提取网络中, 通过连续的卷积和上采样操作, 将不同特征层次的特征信息进行特征融合, 加强提取有效特征. 最后将提取到的特征信息输入到YOLOHead中进行回归, 得到目标的置信度、类别和预测框等信息, 完成目标检测和识别.

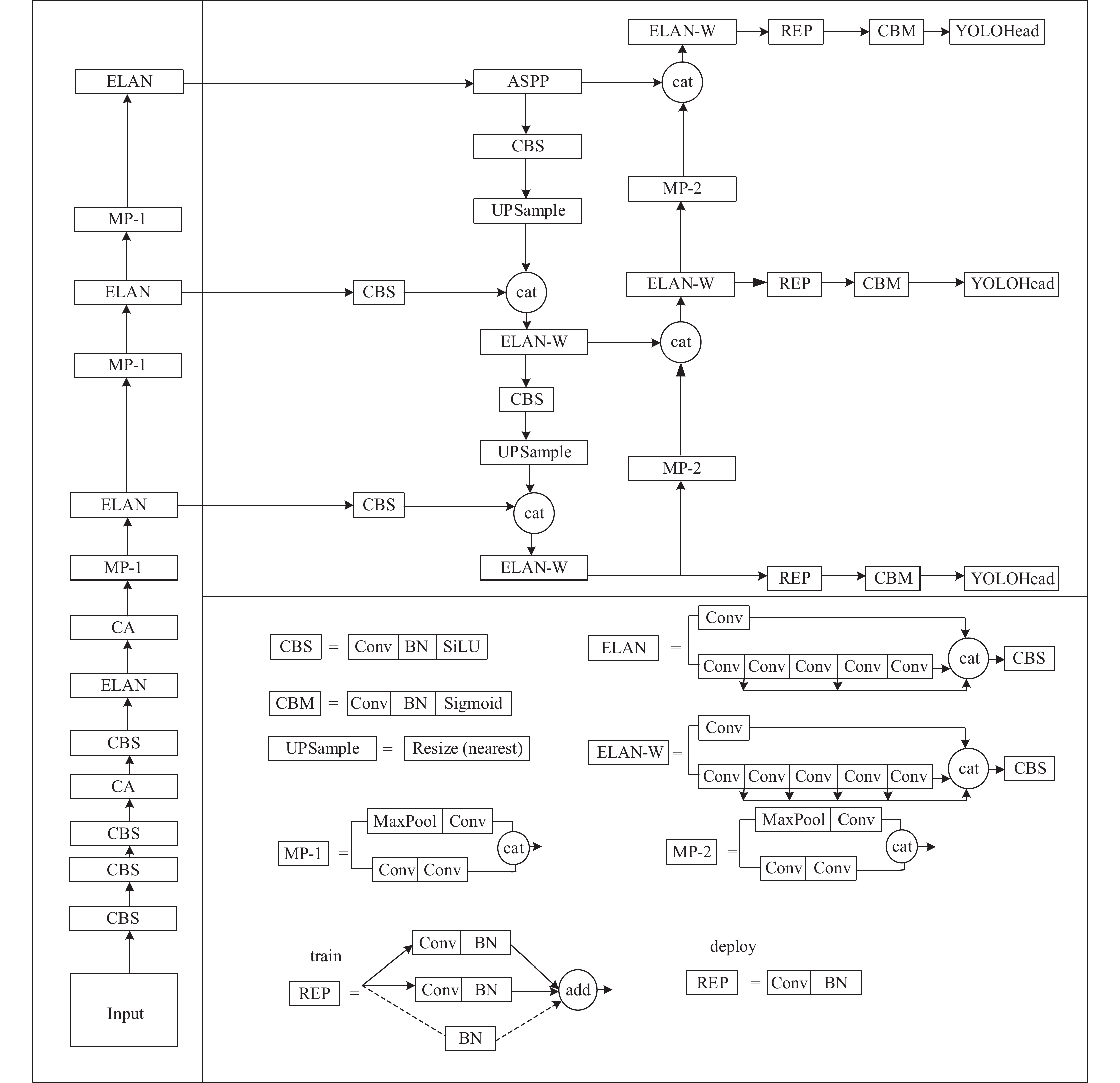

3 本文算法 3.1 YOLOv7-PC算法交通标志在目标检测中属于较小的目标, 由于交通标志检测环境较为复杂, 交通标志分辨率不足和特征信息过少, YOLOv7网络在检测交通标志时很容易发生漏检的现象. 针对此问题, 本文提出YOLOv7-PC算法, 从锚框优化、注意力机制、空洞空间卷积池化3个方面对YOLOv7网络进行改进. 本文提出的YOLOv7-PC算法结构如图2所示. 首先结合交通标志数据集特点, 使用K-means++算法来对交通标志数据集进行聚类, 获得适用于交通标志检测的锚框, 提高交通标志检测精度; 其次为了提高网络检测小目标的能力, 将CA注意力机制引入到YOLOv7主干特征提取网络中, 将交通标志的横向和纵向信息嵌入到通道中, 使生成的特征图具有交通标志对应的坐标信息, 进而避免发生漏检; 最后将空洞空间卷积池化金字塔引入到YOLOv7中, 捕获交通标志多尺度上下文信息, 在保证小目标分辨率的同时, 扩大卷积核感受野, 避免小目标在池化过程中丢失有效特征信息, 进一步避免发生漏检.

YOLOv7-PC网络首先将输入图片缩放到640×640×3大小, 之后通过主干网络进行初步的特征提取. 主干网络主要包括CBS结构、CA注意力结构、ELAN结构和MP-1结构. CBS结构包括卷积、批量标准化、SiLU激活函数3部分. ELAN结构主要包括CBS结构, 并对不同层次的特征进行融合, 该结构可有效提取特征并加速收敛. MP-1结构包括最大池化结构、步长为2的卷积, 其作用是进行下采样, 充分保留有用信息. 在主干提取网络中引入CA注意力结构, 使网络在特征提取过程中关注交通标志的坐标信息, 充分提取有效特征信息.

YOLOv7-PC算法特征加强提取网络主要包括CBS结构、ELAN-W结构、MP-2结构、上采样操作以及ASPP结构. ELAN-W结构相较于主干网络ELAN结构, 其在结构内部进行特征融合的特征数量要多于ELAN结构, 此操作是为了提取更有效的信息. 在加强特征提取网络中引入空洞空间金字塔池化结构, 使交通标志小目标的特征信息在池化过程中得到充分保留, 扩大了卷积核的视野, 减少有效特征信息的丢失.

在YOLOHead中可以得到目标的置信度、类别、中心点的偏移量以及宽高等信息. 根据置信度的大小可以判断网格内是否有物体; 根据中心点的偏移量和高宽信息绘制出所有预测框, 经过非极大抑制过滤重复的预测框, 并保留得分最高的预测框. 最终, 将目标的预测框、类别和置信度输出.

3.2 锚框优化在实时目标检测网络中, 如SSD (single shot multibox detector)和YOLO网络, 检测目标用到的锚框都是根据实验预先设计好的. 但是, 交通标志属于小目标, 常规数据集聚类得到的锚框根本不适用于交通标志数据集, 大多数锚框都远高于交通标志真实框尺寸, 因此常常导致漏检、误检等错误发生. 针对这一问题, 本文采用K-means++算法对交通标志数据集进行聚类, 获得适用于交通标志的锚框, 从而提高检测精度.

|

图 1 YOLOv7结构图 |

|

图 2 YOLOv7-PC结构图 |

YOLOv7网络默认使用K-means算法在COCO数据集中进行聚类获得锚框. K-means算法在聚类时一次性初始化K个聚类中心, 因此, 这K个聚类中心对聚类算法的收敛具有重要影响.

为缓解这一问题, 本文使用K-means++算法来对交通标志数据集进行聚类. K-means++算法一次只选择一个聚类中心, 当这个聚类中心达到最优解之后, 才会计算下一聚类中心, 因此, K-means++算法不仅可以获得局部最优解, 也有利于获得全局最优解[20]. 其过程与K-means类似, 如下.

(1)从输入的数据集中随机选取一个点作为第1个聚类中心点,

(2)对每一个点分别计算到已选取的中心点的距离.

(3)按照轮盘法选择一个新的点作为新的中心点, 选取的原则是: 距离较大的点, 有较大的概率被选取.

(4)重复步骤(2), (3)直到K个中心点被选出.

(5)利用这K个中心点作为初始点执行K-means算法.

通过K-means++算法对交通标志数据集进行聚类, 得到以下9个锚框尺寸, 以此作为YOLOv7-PC网络的锚框. 这9个锚框尺寸分别为(6, 12)、(9, 17)、(13, 24)、(12, 35)、(20, 39)、(17, 45)、(23, 58)、(35, 77)、(64, 108).

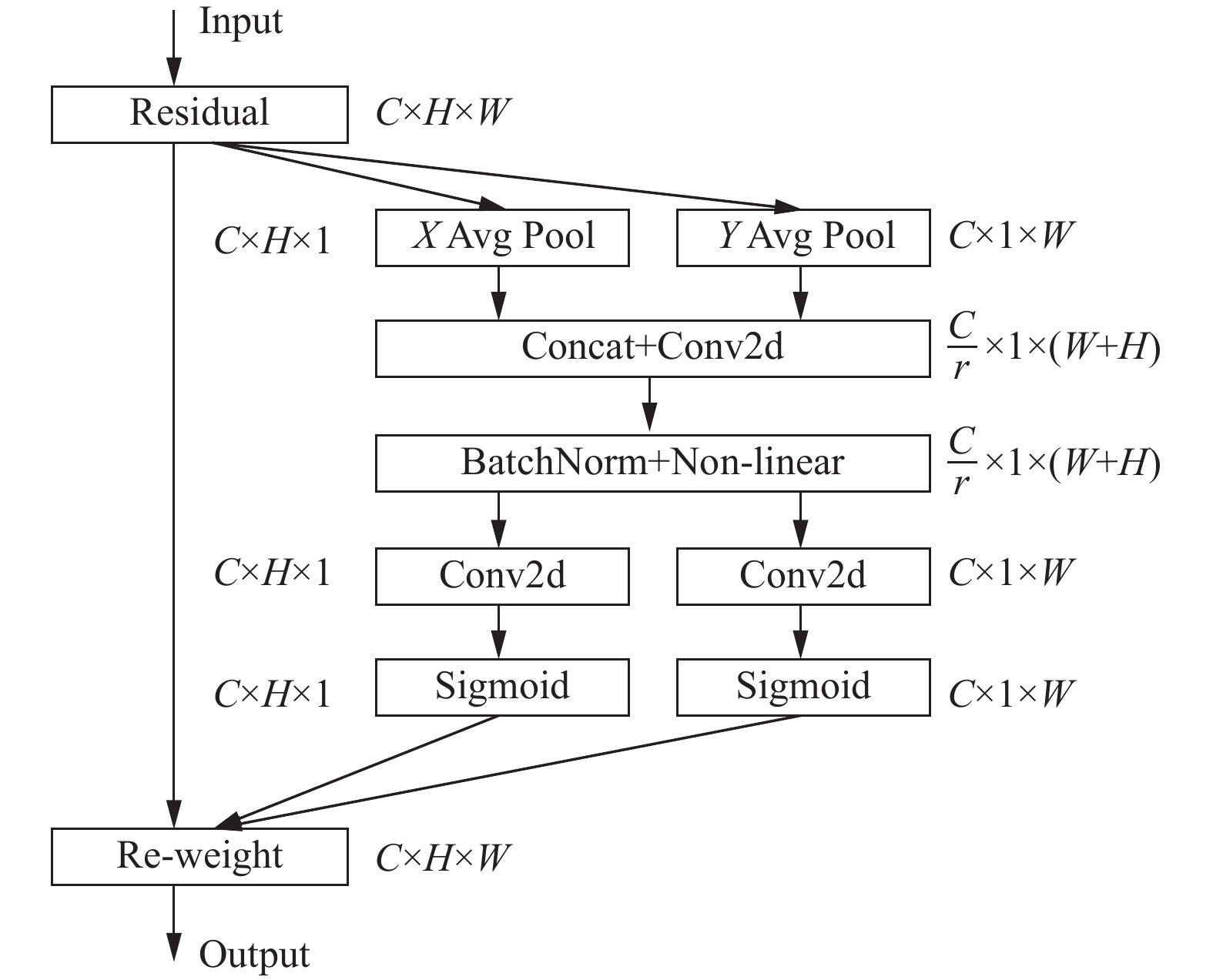

3.3 注意力机制交通标志数据集中交通标志大多偏小, 常处于边缘位置, 一张图中时常会出现多个紧密相排的交通标志, 因此在检测中常常发生漏检等现象. 针对这一问题, 本文在YOLOv7主干特征提取网络中引入CA注意力机制, 将交通标志的横向和纵向信息嵌入到特征通道中, 使生成的特征信息具有交通标志对应的坐标信息, 提高网络检测小目标能力, 进而避免发生漏检.

坐标注意力是将通道注意力分解为两个独立1D的特征编码过程, 分别沿水平、垂直两个方向进行特征聚合[21]. 通过这种方式, 使得其中一个方向具有位置信息, 另一方向具有长距离相关性, 然后将这两种特征信息融合成对位置信息敏感的注意力特征层, 加强对感兴趣区域的特征提取, 进而提高模型的检测效果.

CA注意力机制结构如图3所示, 对于任意一个输入特征X, 首先使用尺寸为(H, 1)或(1,W)的池化核分别沿水平方向和垂直方向对每个通道进行编码. 通过式(1)和式(2)变换使生成的特征层具有坐标信息, 同时又保持长距离相关性.

| $ Z_c^h(h) = \frac{1}{W}\displaystyle\sum\limits_{0 \leqslant i \leqslant W} {{x_c}} (h, i) $ | (1) |

| $ Z_c^w(w) = \frac{1}{H}\displaystyle\sum\limits_{0 \leqslant j \leqslant H} {{x_c}} (j, w) $ | (2) |

之后, 将两个聚合特征信息进行特征串联, 经过式(3) 1×1卷积变换函数

| $ f = \delta ({F_1}([{{\textit{z}}^h}, {{\textit{z}}^w}])) $ | (3) |

沿着空间维度将

| $ {g^h} = \sigma ({F_h}({f^h})) $ | (4) |

| $ {g^w} = \sigma ({F_w}({f^w})) $ | (5) |

| $ {y_c}(i, j) = {x_c}(i, j) \times g_c^h(i) \times g_c^w(j) $ | (6) |

|

图 3 CA注意力机制结构图 |

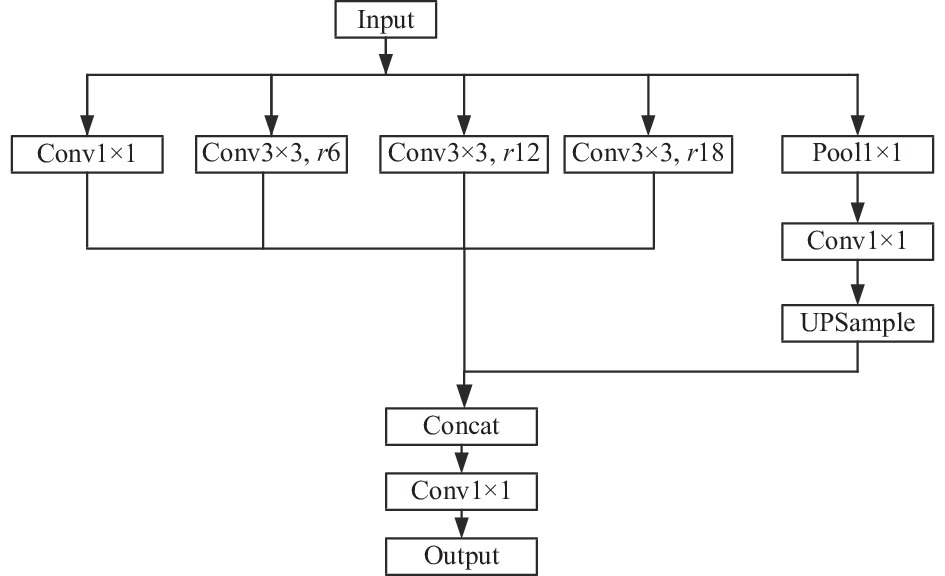

3.4 空洞空间金字塔池化

在交通标志数据集中, 交通标志存在特征信息不足, 分辨率较低等问题, 小目标在经过池化操作时, 容易降低空间分辨率. 对此, 本文将空洞空间金字塔池化引入到YOLOv7网络中, 使特征信息在进行池化操作时, 捕获交通标志多尺度上下文信息, 在保证交通标志小目标分辨率的同时, 扩大卷积核感受野, 避免小目标在池化过程中丢失有效特征信息, 进一步避免发生漏检.

传统的下采样虽可增加感受野, 但会降低空间分辨率. 使用空洞卷积能够在扩大感受野的同时, 保证分辨率[22]. 空洞空间金字塔池化使用具有不同采样率的多个并行空洞卷积层, 通过不同的空洞率构建不同感受野的卷积核, 用来获取多尺度物体信息, 每个采样率提取的特征在单独的分支中会进一步处理, 并融合以生成最终结果. 具体结构如图4所示.

|

图 4 空洞空间金字塔池化结构图 |

对输入特征以不同采样率的空洞卷积并行采样, 将得到的特征图融合到一起, 最后通过1×1卷积将通道数降低到预期的数值.

4 实验结果与分析 4.1 数据集为了检测本文算法的有效性, 本文以CCTSDB交通标志数据集作为测试数据集. CCTSDB数据集丰富, 拍摄角度专业, 更接近实际交通场景. 本文实验数据为20 491张图片, 按照比例8:1:1分为训练集、验证集和测试集, 其中包括L、M、S、XL、XS这5种不同尺寸的图片, 也包括雨、雾、多云、雪等4种不同天气下的交通标志图片. 数据类别分为3类: 指示、禁令及警告标志.

4.2 实验环境实验是在Linux操作系统下进行的, 所用到的硬件设备为Intel(R) Xeon(R) CPU E5-2620 v4 @ 2.10 GHz处理器、3块NVIDIA GeForce RTX 2080 Ti显卡和96 GB内存计算机. 实验所用到的编程环境为Python 3.7, 使用PyTorch 1.7框架, 设置训练参数Batch Size为16, Epoch为100.

4.3 评价指标本文的评价指标采用固定IoU阈值和置信度的方式, 来检测实验结果是否准确. 本文设定置信度为0.5, IoU为0.3, 通过实验结果获得精确率(Precision)和召回率(Recall), 以该结果来衡量算法的检测能力.

| $ {{Re}} call = \frac{{TP}}{{TP + FN}} $ | (7) |

| $ Pr ecision = \frac{{TP}}{{TP + FP}} $ | (8) |

其中, TP表示为: 本来是正样本, 检测后仍为正样本(真阳性); TN表示为: 本来是负样本, 检测后仍为负样本(真阴性); FP表示为: 本来是负样本, 检测为正样本(假阳性); FN表示为: 本来是正样本, 检测为负样本(假阴性).

| $ {{m}}AP = \frac{{\displaystyle\sum\limits_{i = 1}^k {A{P_i}} }}{k} $ | (9) |

为全面地评估算法的性能, 在这里引入mAP, 即对每个类别的AP求和取平均. 每个类别都能以Recall和Precision为坐标轴绘制PR曲线, 而每个类别的AP就是这条曲线与坐标轴围成的面积.

4.4 实验结果分析为验证本文提出的改进策略对网络的积极影响, 进行了消融实验, 实验结果如表1所示.

由表1可知, 相较于原始YOLOv7算法, YOLOv7-PC算法的mAP、召回率平均分别提高了5.22%、9.01%, 是一种有效的目标检测网络. 当YOLOv7算法使用K-means++聚类算法生成的锚框时, 召回率与mAP分别提高了7.57%和4%, 检测帧率并未发生改变. 当对YOLOv7算法使用空洞空间金字塔池化时, mAP与召回率分别提高了0.73%和1.53%. 实验表明, YOLOv7-PC算法不仅具有较好的检测精度, 同时具有良好的检测速度, 满足实时性要求.

| 表 1 消融实验结果 |

不同算法性能对比如表2所示. YOLOv7作为YOLO系列最新的目标检测算法, 其在mAP、召回率、精确率等指标上完全超过YOLOv5s、YOLOv3、Faster RCNN. YOLOv7-PC算法相较于YOLOv7, mAP、召回率、精确率分别提高了5.22%、9.01%、0.39%. 实验数据表明, 我们研究的算法YOLOv7-PC在检测精度方面完全优于原算法, 具有一定的价值.

| 表 2 各算法性能对比结果 (%) |

表3为YOLOv7-PC、YOLOv7、YOLOv3、YOLOv5s训练结果中每个类别的AP值. YOLOv7-PC算法每个类别的AP值均高于其他算法的AP值, 其中, mandatory、warming、prohibitory的AP值相比YOLOv7中同类别分别提高了5%、6.15%、4.51%; 相比YOLOv5s中同类别分别提高了7.67%、6.02%、9.73%. 这表明YOLOv7-PC算法在交通标志检测方面具有非常好的应用前景.

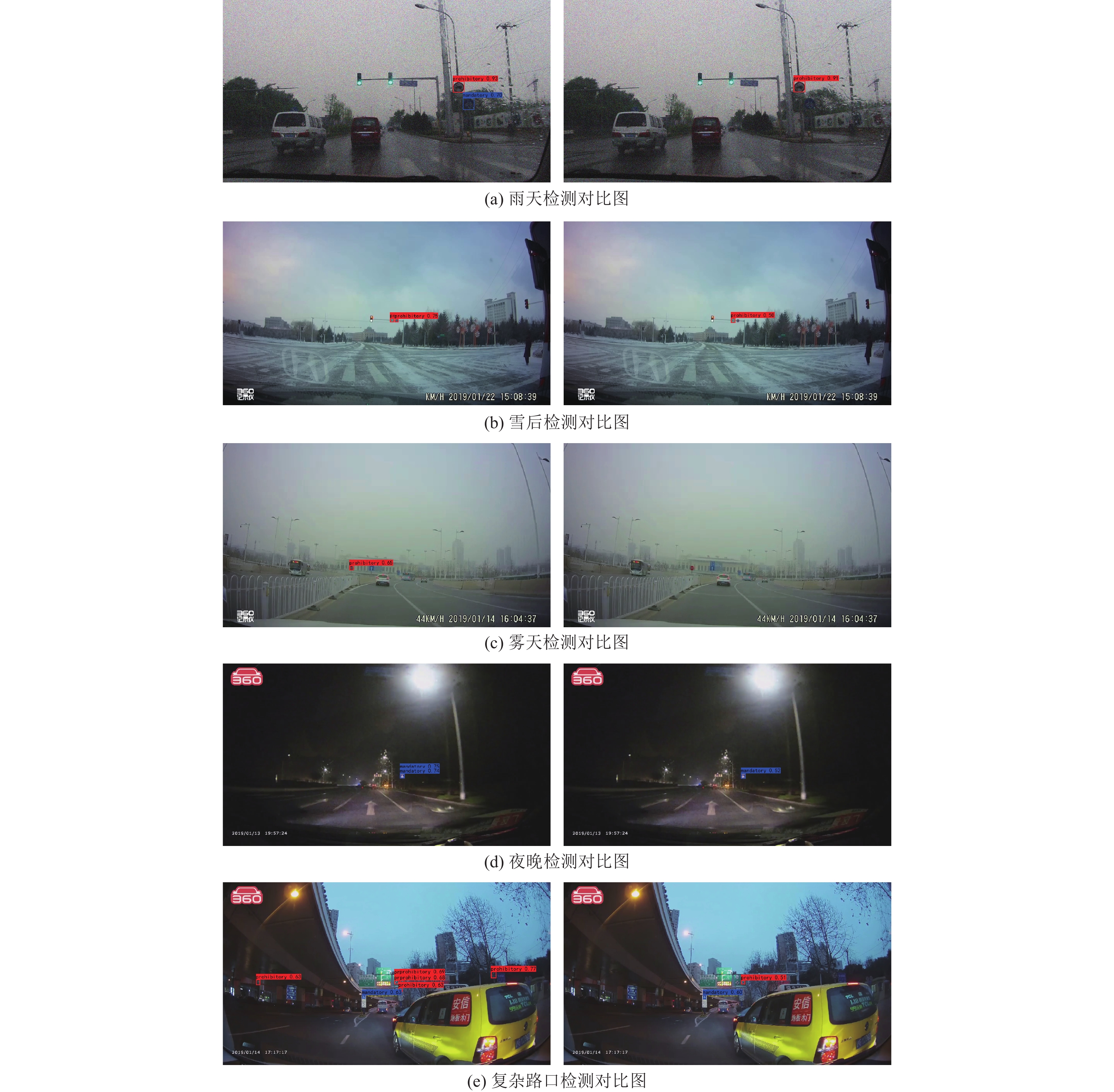

图5为YOLOv7-PC算法与YOLOv7算法在不同环境下的交通标志检测效果对比图, 左边一列是YOLOv7-PC算法的检测效果图, 右边则是YOLOv7算法的检测效果图. 从图5(a)–图5(c)这3幅图中可以看出, YOLOv7-PC算法可以在雾天、雨天、雪天等异常天气下检测出YOLOv7算法未能识别的交通标志, 并且YOLOv7-PC算法对交通标志的识别精度也优于YOLOv7算法. 图5(d)是昏暗环境下的交通标志检测,从中可以看出YOLOv7-PC算法可以对昏暗状况下的交通标志进行准确的检测, 其在昏暗环境下的交通标志检测性能要优于YOLOv7算法. 图5(e)是复杂路口环境下的交通标志检测, 在这种情况下, YOLOv7算法只检测出路口的两个目标, 而本文提出的YOLOv7-PC算法则把路口的交通标志全部精准的检测和识别出. 这表明, YOLOv7-PC算法检测效果优于YOLOv7算法, 其可以对交通标志在不同光照、天气下进行准确的检测和识别, 具有优良的性能. 经实验表明, YOLOv7-PC算法提升了对小目标的检测能力, 可以避免出现漏检现象.

| 表 3 不同算法下每个类别的AP值 (%) |

|

图 5 YOLOv7-PC算法与YOLOv7在不同环境下的检测效果对比图 |

5 总结

本文提出一种YOLOv7-PC算法, 对交通标志数据集进行聚类获得适合的锚框, 同时将CA注意力机制与空洞空间金字塔池化引入到YOLOv7算法中, 提升了网络检测小目标的能力. 相较于原算法, YOLOv7-PC算法的mAP、召回率、精确率分别得到提高. 为了更好地提高目标检测能力, 在未来的研究中, 准备将多个注意力机制进行结合, 加强主干网络特征提取能力, 进一步优化算法. 同时, 由于行车环境较为复杂, 容易受到光照、天气以及其他外界不利因素的影响, 接下来的研究将综合考虑以上因素, 提高算法在复杂环境下的检测能力.

| [1] |

Lin C, Pan SH, Zhang F, et al. A method of traffic sign detecting based on color similarity. Proceedings of the 3rd International Conference on Measuring Technology and Mechatronics Automation. Shanghai: IEEE, 2011. 123–126.

|

| [2] |

朱双东, 蒋甜甜, 刘兰兰. 基于颜色规格化的交通标志识别. 计算机应用与软件, 2008, 25(1): 220-222. DOI:10.3969/j.issn.1000-386X.2008.01.082 |

| [3] |

Lin C, Pan SH, Zhang F. Traffic sign segmentation based on Maxwell color triangle. Proceedings of the 2010 International Conference on Computer Application and System Modeling (ICCASM 2010). Taiyuan: IEEE, 2010. V9-116–V9-119.

|

| [4] |

Andrey V, Jo KH. Automatic detection and recognition of traffic signs using geometric structure analysis. Proceedings of the 2006 SICE-ICASE International Joint Conference. Busan: IEEE, 2006. 1451–1456.

|

| [5] |

Wang Q, Liu XX. Traffic sign segmentation in natural scenes based on color and shape features. Proceedings of the 2014 IEEE Workshop on Advanced Research and Technology in Industry Applications (WARTIA). Ottawa: IEEE, 2014. 374–377.

|

| [6] |

Yıldız G, Dizdaroğlu B. Traffic sign detection via color and shape-based approach. Proceedings of the 1st International Informatics and Software Engineering Conference (UBMYK). Ankara: IEEE, 2019. 1–5.

|

| [7] |

熊昌镇, 王聪. 图切技术和卷积网络的交通标志数据集构建方法. 计算机应用, 2017, 37(S1): 183-186. |

| [8] |

Zhang JM, Xie ZP, Sun J, et al. A cascaded R-CNN with multiscale attention and imbalanced samples for traffic sign detection. IEEE Access, 2020, 8: 29742-29754. DOI:10.1109/ACCESS.2020.2972338 |

| [9] |

Cao JH, Zhang JJ, Jin X. A traffic-sign detection algorithm based on improved sparse R-CNN. IEEE Access, 2021, 9: 122774-122788. DOI:10.1109/ACCESS.2021.3109606 |

| [10] |

Sarumathi KR, Dhivyashree M, Vishnu DRS. Traffic sign recognition with Faster RCNN and RPN for advanced driver assistance systems. Proceedings of the 5th International Conference on Electronics, Communication and Aerospace Technology (ICECA). Coimbatore: IEEE, 2021. 1–8.

|

| [11] |

郭璠, 张泳祥, 唐琎, 等. YOLOv3-A: 基于注意力机制的交通标志检测网络. 通信学报, 2021, 42(1): 87-99. |

| [12] |

Wang HB, Yu H. Traffic sign detection algorithm based on improved YOLOv4. Proceedings of the 9th IEEE Joint International Information Technology and Artificial Intelligence Conference (ITAIC). Chongqing: IEEE, 2020. 1946–1950.

|

| [13] |

Aggar A, Rahem AA, Zaiter M. Iraqi traffic signs detection based on YOLOv5. Proceedings of the 2021 International Conference on Advanced Computer Applications (ACA). Maysan: IEEE, 2021. 5–9.

|

| [14] |

Liu X, Jiang XK, Hu HC, et al. Traffic sign recognition algorithm based on improved YOLOv5s. Proceedings of the 2021 International Conference on Control, Automation and Information Sciences (ICCAIS). Xi’an: IEEE, 2021. 980–985.

|

| [15] |

张上, 王恒涛, 冉秀康. 基于YOLOv5的轻量化交通标志检测方法. 电子测量技术, 2022, 45(8): 129-135. |

| [16] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [17] |

Redmon J, Farhadi A. YOLO9000: Better, faster, stronger. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6517–6525.

|

| [18] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [19] |

Wang CY, Bochkovskiy A, Liao HYM. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. arXiv:2207.02696, 2022.

|

| [20] |

Ismkhan H. I-K-means+: An iterative clustering algorithm based on an enhanced version of the K-means. Pattern Recognition, 2018, 79: 402-413. DOI:10.1016/j.patcog.2018.02.015 |

| [21] |

Hou QB, Zhou DQ, Feng JS. Coordinate attention for efficient mobile network design. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13708–13717.

|

| [22] |

Chen LC, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation. arXiv:1706.05587, 2019.

|

2023, Vol. 32

2023, Vol. 32