2. 陆军工程大学 通信工程学院, 南京 210007

2. College of Communication Engineer, Army Engineering University of PLA, Nanjing 210007, China

函数回归是机器学习核心问题之一, 通常可以采用两种方法解决: 一方面可以将目标函数视为一个确定性函数, 借助深度神经网络训练, 高效地逼近单个目标函数, 但这一方法需要大量标记准确的数据; 另一方面可以对函数分布进行建模, 以高斯过程回归(Gaussian process regression, GPR)[1]为例, 通过对少量观测数据进行推理, 获得函数概率分布, 而后对该分布采样, 逼近真实的目标函数, 但目前该方法最优算法的计算复杂度仍高达

神经过程(neural process, NP)结合以上两种思路, 利用深度神经网络的计算优势, 模仿了高斯过程回归的功能[2], 且神经过程计算复杂度仅有

作为图像处理领域的研究热点, 图像补全问题获得了一系列解决方案. 一是基于卷积神经网络对图像进行补全系列方法, 包括: 上下文编码器[8]、部分卷积[9]和门控卷积[10]等经典法; 二是利用生成器和判别器博弈生成图像的生成式对抗网络(GAN)[11]系列模型, 包括: 深度卷积生成对抗网络(DCGAN)[12]、样本生成对抗网络(ExGAN)[13]及上下文感知语义修复方法[14]等. 三是基于深度自编码器[15]的自监督模型, 包括去噪自编码器[16]、变分自编码器 (variational auto-encoder, VAE)[17]系列模型, 该类模型相较于GAN系列具备更好的理论基础, 可解释性更强, 但视觉效果相对来说弱于GAN. 神经过程作为具有完备推导保证的回归模型, 其结构更接近于自编码器模型, 同样可以用于解决图像补全等二维数据回归问题, 但该模型提出时间较短, 且经典NP模型采用全连接神经网络(fully connected neural network, FCN)作为编码器、解码器, 相对于天然适于处理图像的卷积神经网络(convolutional neural network, CNN)[18], FCN结构并不具备优势. 因此, 神经过程家族模型在解决图像回归问题方面仍有缺憾.

实际上, 卷积神经网络已经具备丰富的基础操作和成熟的图像数据处理模型, 如: 空洞卷积[19]在扩大感受野的同时捕获多尺度上下文信息, 可变卷积[20]可以灵活应对物体复杂形变的场景; 残差网络[21]以跨层连接的方式解决退化问题, 增加了网络深度, 获得更具语义信息的特征; 非局部神经网络[22]通过直接计算嵌入空间中相似度矩阵, 获取全局信息. 为此, 本文尝试将CNN与NP相结合, 构建出面向图像的神经过程(image-faced neural process, IFNP), 以便于处理图像数据. IFNP在保留NP优势的同时, 也搭建起CNN和NP之间的桥梁, 使得丰富、成熟的图像处理技术得以应用到NP中.

本文的主要工作包括:

(1)通过结合CNN和NP, 构建了面向图像的神经过程(IFNP)基础模型; 并利用随机梯度变分推断方法[22]推导出IFNP的证据下界(ELBO)表达式及训练损失函数.

(2)设计局部池化聚合(local pooling adduction, LPA)模块和全局交叉注意力(global cross attention, GCA)模块改进本文提出的IFNP, 构建出一种面向图像的注意力神经过程(image-faced attention neural process, IFANP), 拓展了IFNP模型在图像处理中的应用前景.

(3)将IFANP模型应用于图像补全任务, 与变分自编码器(variational auto-encoder, VAE)[17]、NP等相关模型的补全结果进行比较, 显示IFANP模型更强的数据补全和细节拟合能力; 并对采用不同形式注意力的IFANP进行实验对比, 分析了更优的IFANP模型结构.

1 研究背景神经过程(NP)是一种能够将输入映射到输出的回归函数族模型, 于2018年由DeepMind公司首次提出[2], 这一模型利用神经网络的拟合能力和并行计算优势, 模仿了高斯过程回归(GPR)功能, 通过少量观测数据即可推断出目标函数的概率分布, 同时避免了高计算复杂度和固定核函数适用范围的问题.

NP解决回归问题时, 假设数据集由高斯过程

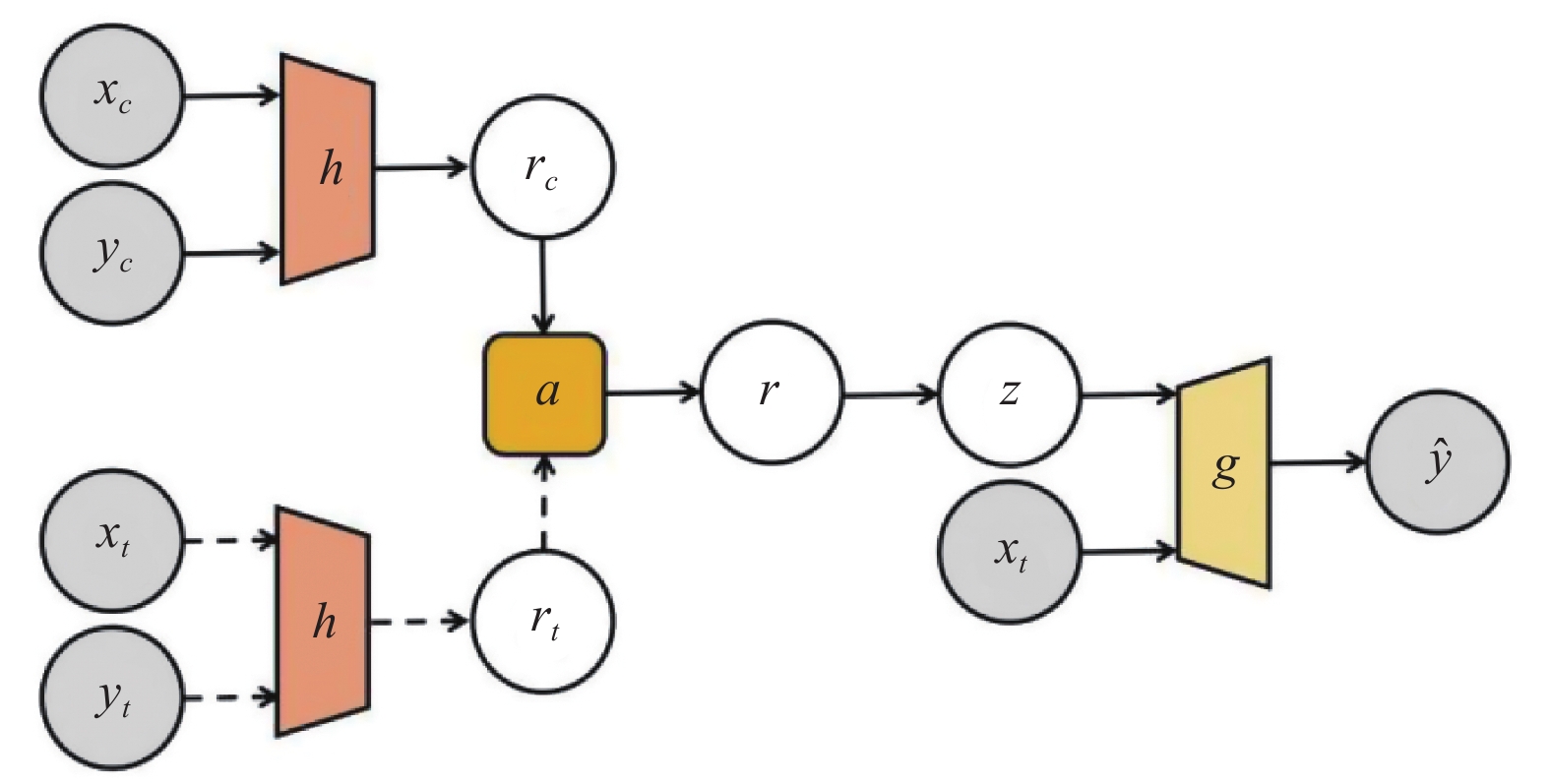

NP模型结构如图1所示, 结构图整体表示训练阶段, 实线部分表示生成阶段,

|

图 1 神经过程模型 |

训练阶段, 完整数据划分为上下文集

编码器

将神经过程应用于图像补全任务时, 一般以上下文坐标值为

与神经过程(NP)中对图像和坐标二元组处理形式不同, 本文提出的面向图像的神经过程(IFNP), 通过对完整数据集进行随机遮罩处理, 使用整张图像完成模型的训练与生成. 在第2.1节首先利用随机梯度变分推断(SGVI)方法[22,23]对IFNP的证据下界(ELBO)和损失函数进行推导, 并在随后的第2.2节对模型结构进行介绍.

2.1 证据下界和模型损失函数推导本文假设图像数据集

定义

若图像中像素值相互独立且引入随机噪声, 噪声值

| $ p({y_M}|M) = \begin{array}{*{20}{c}} {\int p (f){\mkern 1mu} \displaystyle \prod\limits_{i = 1}^h { \displaystyle \prod\limits_{j = 1}^w {\mathcal{N}({y_{i, j}}|f({m_{i, j}}), {\sigma ^2})} } df} \end{array} $ | (1) |

为了使用神经过程建模随机过程

| $ p({\textit{z}}, {y_M}|M) = p({\textit{z}}){\mkern 1mu} \begin{array}{*{20}{c}} {\displaystyle \prod\limits_{i = 1}^h {\displaystyle \prod\limits_{j = 1}^w {\mathcal{N}({y_{i, j}}|g({m_{i, j}}, {\textit{z}}), {\sigma ^2})} } } \end{array} $ | (2) |

受变分自编码器启发, 设式(2)中

根据

| $\begin{split}& \ln p({y_M}\left| M \right.) = \ln \left[ {\int {\frac{{p({\textit{z}}, {y_M}|M)}}{{q({\textit{z}}|{y_M}, M)}}} q({\textit{z}}|{y_M}, M){\mkern 1mu} d{\textit{z}}} \right] \\& \geqslant {E_{q({\textit{z}}|{y_M}, M)}}\left[ {\ln \frac{{p({\textit{z}})}}{{q({\textit{z}}|{y_M}, M)}}} \right.\left. {{\text{ + }}\ln \prod\limits_{i = 1}^h {\prod\limits_{j = 1}^w {p({y_{i, j}}|{\textit{z}}, {m_{i, j}})} } } \right] \end{split} $ | (3) |

式(3)中不等号右项即为边界下界ELBO.

为了便于训练和测试, 验证模型效果, 下面将数据集拆分为上下文集

| $\begin{split}& \ln p(\left. {{y_{M - }}} \right|{y_{M - }}, M + ) \geqslant {E_{q({\textit{z}}|{y_M}, M)}}[\ln \frac{{q({\textit{z}}|{y_{M + }}, M + )}}{{q({\textit{z}}|{y_M}, M)}} \\& +\sum\nolimits_{(i, j) \in \{ (i, j)|{m_{i, j}} \in M - \} } {\ln p({y_{i, j}}|{\textit{z}}, {m_{i, j}})} ] \\ \end{split} $ | (4) |

由式(3)可知, ELBO越大, 像素值

| $\begin{split}& \ln p(\left. {{y_{M - }}} \right|{y_{M + }}, M + ) \\& \geqslant - KL(q({\textit{z}}|{y_M}, M)||q({\textit{z}}|{y_{M + }}, M + )) \\& + \begin{array}{*{20}{c}} {\dfrac{1}{K} \displaystyle \sum\nolimits_{k = 1}^K { \displaystyle \sum\nolimits_{(i, j) \in \{ (i, j)|{m_{i, j}} \in M - \} } {\ln p({y_{i, j}}|{{\textit{z}}_k}, {m_{i, j}})} } } \end{array} \\ \end{split}$ | (5) |

其中,

因此, 式(5)中大于等于号右项即为模型损失函数负值, 即:

| $ \begin{split}& Loss = KL(q({\textit{z}}|{y_M}, M)||q({\textit{z}}|{y_{M + }}, M + )) \\& - \begin{array}{*{20}{c}} {\dfrac{1}{K} \displaystyle \sum\nolimits_{k = 1}^K { \displaystyle \sum\nolimits_{(i, j) \in \{ (i, j)|{m_{i, j}} \in M - \} } {\ln p({y_{i, j}}|{{\textit{z}}_k}, {m_{i, j}})} } } \end{array} \\ \end{split} $ | (6) |

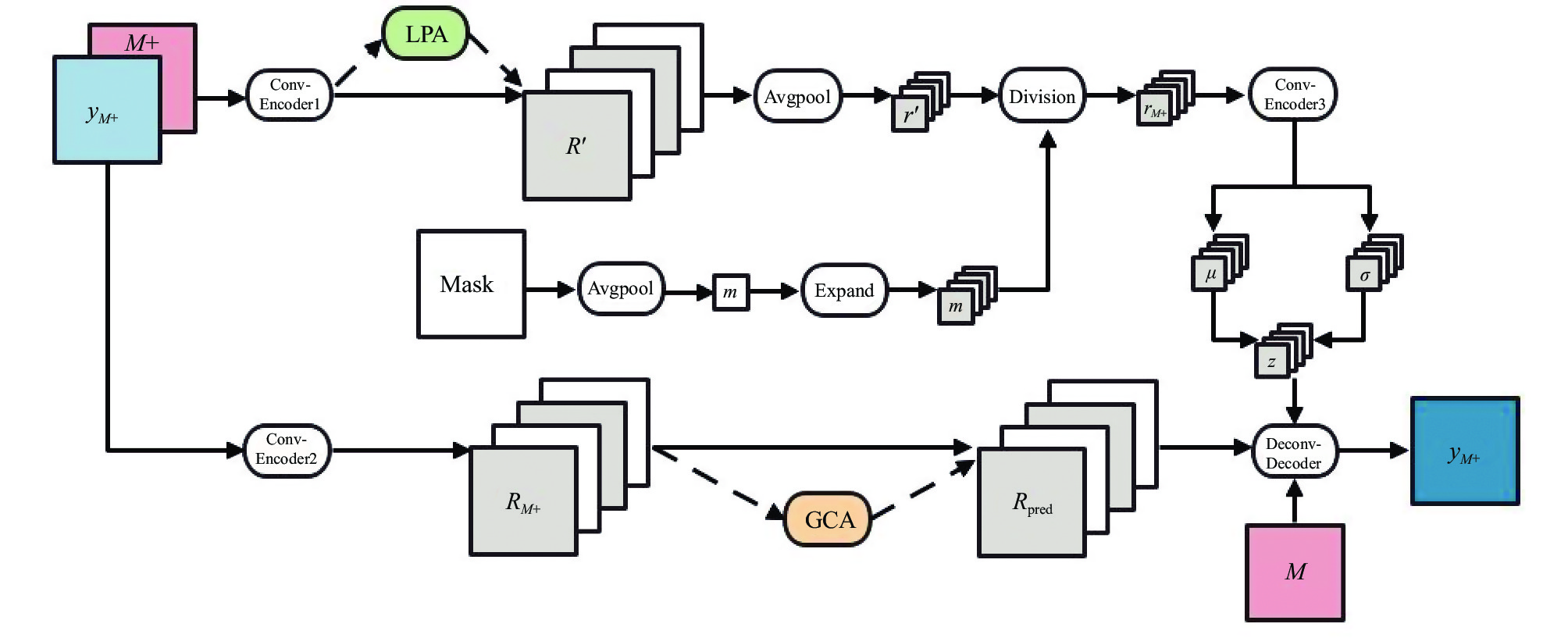

IFNP在保持图像结构及完整性的条件下, 以图像矩阵、坐标矩阵、未知点遮罩矩阵作为输入, 使用卷积神经网络及相关操作进行计算, IFNP结构见图2实线部分.

|

图 2 面向图像的神经过程及其改进模型 |

在训练阶段, 完整图像

训练过程中, 完整图像及坐标

在生成阶段,

以第2.1节ELBO和损失函数推导为基础, 利用卷积、池化、反卷积等操作, 本文设计出IFNP基础模型结构. 在保证输入图像完整性、捕捉像素点空间联系的同时, 为进一步改造基础模型、提升模型性能留下更多空间.

在使用IFNP进行图像补全实验过程中(第4.1节), 可以发现, 虽然IFNP能够实现对缺失信息的补全, 但对于已知上下文信息的拟合不尽人意, 且补全效果仅与NP持平. 其原因是, 在面向图像的神经过程(IFNP)中, 图像表征信息

当人类观察图片获取信息的过程中, 视觉系统并没有同时接收图片的全部内容, 而是将有限的注意力集中在少部分重点信息上[24]. 这一方式引导我们基于注意力对前文中设计的面向图像的神经过程(IFNP)改进. 受池化操作和非局部神经网络的启发, 本文利用局部池化聚合(LPA)和全局交叉注意力(GCA)模块构建了一种面向图像的注意力神经过程(IFANP). 在IFANP中, 局部池化自注意力在池化窗口范围内, 对像素间相似信息进行聚合, 实现对特征图的平滑操作, 便于抽取图像本质特征, 避免了背景信息的干扰; 全局交叉注意力则利用上下文数据对待补全数据的响应, 区分主次获取全局上下文数据, 预测未知数据表征, 便于补充图像细节特征. 通过局部特征聚合和全局信息响应相结合的方式, 模型数据补全及细节拟合能力得到增强, 图像重建损失进一步下降.

3.1 模型结构图2中原始IFNP模型结合虚线部分插入的两个模块描述的是一种基于注意力机制的面向图像的神经过程改(IFANP)进模型结构.

整体上看, 模型包括隐藏路径(上侧路径)和确定路径(下侧路径)两部分, 两条路径分别对应全局隐变量

具体来说, 隐藏路径中, 上下文数据经过卷积编码器(ConvEncoder1)编码后, 不直接采取全局平均池化操作, 而是通过LPA模块, 使高维表征矩阵

解码器部分除增加确定性目标表征

在卷积神经网络中, 由于图像中的相邻像素倾向于具有相似的值, 因此, 经过卷积后的输出中仍然包含了冗余信息. 而池化是一个特征选择和信息过滤的过程, 能够降低相邻像素的相似信息, 在二次提取特征的同时减少参数量和计算量[25]; 由于池化操作的下采样作用, 输出结果中的一个元素对应原输入数据的一个子区域, 该元素获得邻域信息, 使得模型可以抽取更大范围内的特征.

池化往往紧随卷积层后, 池化对输入数据的一个固定的窗口(又称池化窗口)中的元素按照一定规则直接计算输出, 包括平均池化、最大池化、随机池化等多种形式. 以3×3的平均池化窗口对像素为3×3的图像进行池化操作为例, 当池化窗口滑动到某一位置时, 将原输入数据的一个子区域的平均值汇合到输出中的某一个元素上, 窗口中输入子数组的平均值即为输出数组中相应位置的元素.

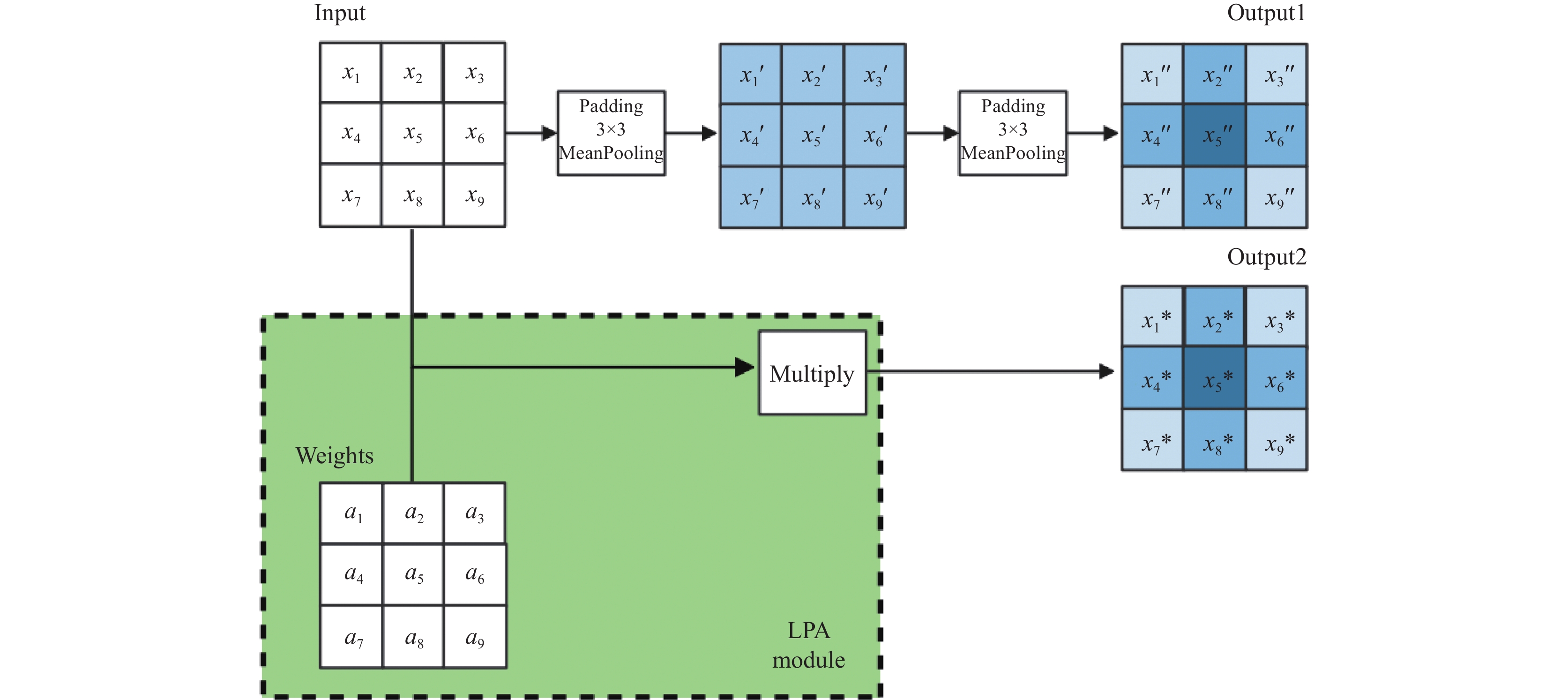

如图3中, 获得输出1 (Output1)路径所示, 以中心元素作为观察结点, 某一元素所在位置颜色越深, 代表初始值对观察结点的输出影响越大, 即所占权重越高. 对输入矩阵连续进行两次填充为1的池化, 观察结点对应输出为:

第1次池化后:

| $ {x'_5} = \dfrac{1}{9}\begin{array}{*{20}{c}} { \displaystyle \sum\nolimits_{i = 1}^9 {{x_i}} } \end{array} $ |

第2次池化后:

| $ {x''_5} = \frac{1}{{81}}(4{x_1} + 6{x_2} + 4{x_3} + 6{x_4} + 9{x_5} + 6{x_6} + 4{x_7} + 6{x_8} + 4{x_9}) $ |

|

图 3 局部池化聚合模块 |

随着池化层堆叠深度增加, 在像素更高的图像中, 邻域信息将按不同权重逐层汇合至观察结点, 且邻域范围不断增大, 权重不断减小. 同理, 当使用池化操作实现局部自注意力时, 池化窗口范围内的输入值对输出应当均有贡献, 但其贡献度会受与中心像素距离影响而有所区别. 对于图像而言, 从直观上来看, 距离中心像素越近的邻域像素, 其相似度越高, 使用池化注意力计算下一层输出时, 其贡献度或对应的权值也应当越大, 以更合理的方式筛选像素信息, 减少平均池化层的堆叠和计算开销, 更高效获得类似堆叠池化层的输出结果, 如图4获得输出2 (Output2)所示. 因此, 本文构建的局部池化聚合输出值遵循:

|

图 4 非局部运算示意图 |

| $ x_i^* = \begin{array}{*{20}{c}} { \displaystyle \sum\nolimits_j {{\alpha _j}{x_j}} } \end{array} $ | (7) |

| $ {\alpha _j} = \dfrac{{{{\rm{e}}^{ - d({x_i}, {x_j})}}}}{{\begin{array}{*{20}{c}} { \displaystyle \sum\nolimits_k {{{\rm{e}}^{ - d({x_i}, {x_k})}}} } \end{array}}} $ | (8) |

式(8)基于坐标之间的欧式距离

卷积神经网络中, 卷积运算仅能处理空间局部邻域, 需要不断堆叠卷积层才能获得全局信息. 而非局部神经网络提出通过非局部运算建立长距离像素之间的联系, 捕获两个像素之间的依赖.

非局部运算是计算机视觉中经典的非局部均值运算的一种泛化结果. 直观上看, 非局部运算将某一处位置的响应作为输入特征映射中所有位置的特征加权和来进行计算(如图4所示). 当计算

非局部神经网络模块可以通过关注图片或特征图中所有位置, 在嵌入空间中直接计算相似度矩阵, 可以考虑包括该位置自身在内的所有位置特征的加权, 不必局限于邻域空间, 避免堆叠运算, 因此能够高效汇聚信息. 同时, 该模块可以保证输入、输出尺度不变, 易于嵌入各种网络框架中, 在静态图像识别和视频分类任务中展现出其强大能力[22].

受非局部神经网络结构的启发, 本文定义了全局交叉注意力通式如下:

| $ {y_i} = \begin{array}{*{20}{c}} { \displaystyle \sum\nolimits_j {\frac{{{{\rm{e}}^{sim({x_i}, {x_j})}}}}{{ \displaystyle \sum\nolimits_j {{{\rm{e}}^{sim({x_i}, {x_j})}}} }}{r_j}} } \end{array} $ | (9) |

其中,

本文采用嵌入空间点积作为

| $ sim({x_i}, {x_j}) = \theta {({x_i})^{\rm{T}}}\theta ({x_j}) $ | (10) |

其中,

上下文坐标矩阵

上下文表征矩阵

|

图 5 全局交叉注意力模块 |

基于注意力的面向图像的神经过程模型形式多种多样, 本文设计的IFANP模型仅仅是利用局部池化聚合和全局交叉注意力对IFNP进行改进的一种方式. 由于在具体实验过程中, 该模型相较于IFNP和其他形式注意力面向图像的神经过程表现出更强的图像补全能力(详见实验分析第4.2节), 因此特地做以下介绍.

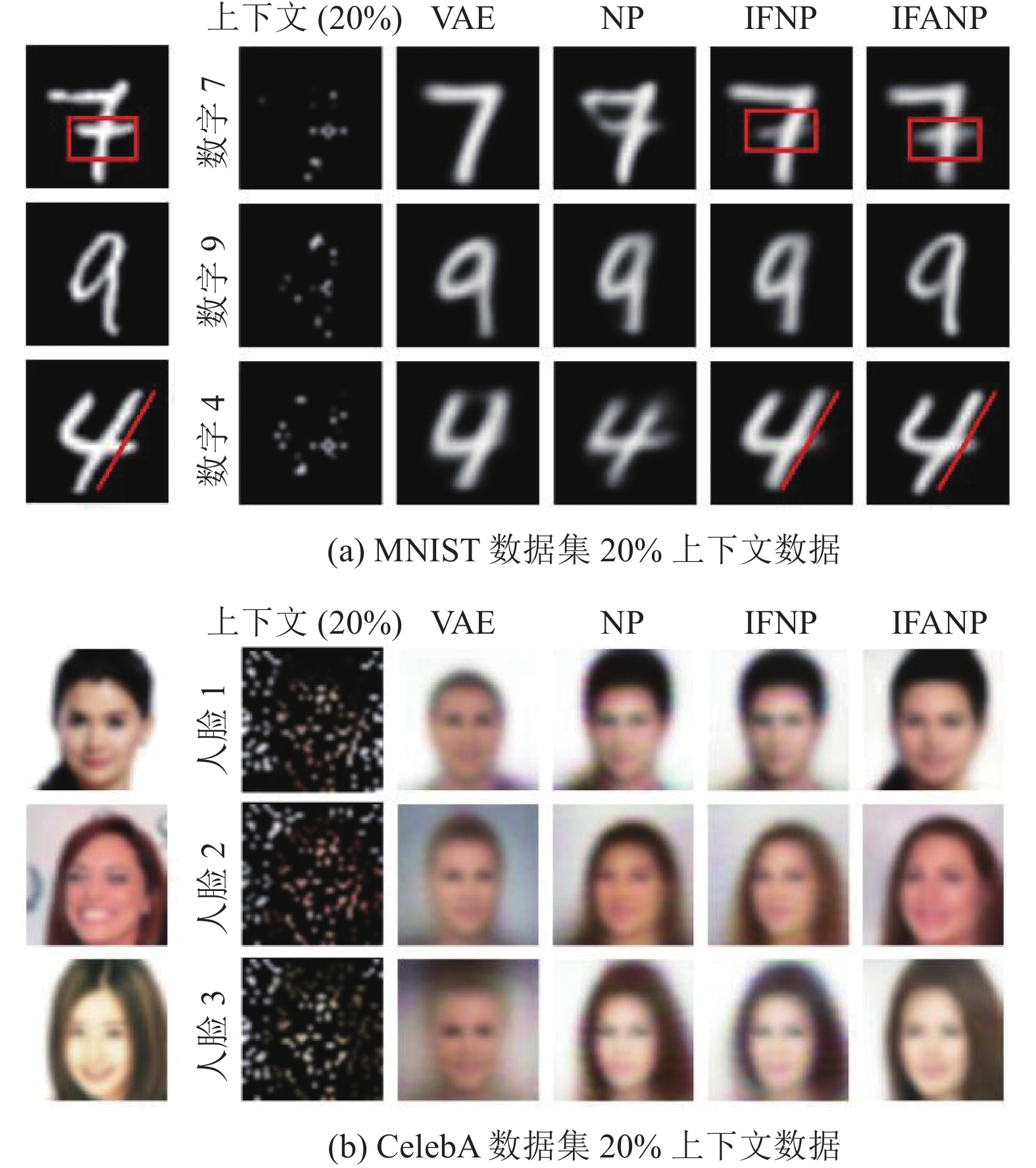

4 实验分析本节按照上文设计搭建了面向图像的神经过程(IFNP)模型和面向图像的注意力神经过程(IFANP)模型. 为了便于评估模型性能, 本文复现了神经过程(NP)作为基准进行对比, 同时复现了同样基于自编码器结构的自监督模型变分自编码器(VAE)进行比较分析, 且以上模型结构和参数量均相近, 具有较强的可比性.本节分为两个部分, 在第4.1节中以视觉感官为标准, 定性分析VAE、NP、IFNP和IFANP模型在图像补全任务中数据补全能力的差异, 展示IFANP模型在拟合上下文数据方面的明显优势; 在第4.2节中, 通过调整IFANP模型中注意力模块, 定量比较基于不同形式注意力机制的面向图像的神经过程图像性能差异.

实验使用手写数字图片MNIST和人脸数据CelebA[26]两种数据集, 其中MNIST为28×28大小的黑白灰度图像, CelebA为32×32大小的RGB彩图; 数据集均使用60000张图片作为训练集, 5000张图片作为测试集.

4.1 数据补全及上下文细节拟合能力比较在面对图像补全任务时, IFNP的优势之一是可以从上下文数据中灵活迅速地学习出函数近似分布, 特别是IFANP, 可以通过采样函数、输入目标像素坐标, 实现像素级预测, 因此在数据补全方面展现出更强的性能; 而变分自编码器以整张图片为预测目标, 在应对复杂纹理图片时, 预测结果的细节方面不佳.

为比较不同模型的图像补全能力, 本文先后使用MNIST数据集和CelebA数据集进行实验. 如图6(a)对手写数字图片补全, 在只给定少量上下文数据(20%)条件下, 使用4个模型对图像分别进行预测. 整体上看, 4个模型能够根据上下文点抽取先验信息, 基本实现了对手写数字的正确推断预测; 相对而言, 由VAE补全的图像细节信息表达不够完全, 数字7腰部手写斜杠未能在补全图像中得到还原, NP和IFNP补全的图像能体现出一定细节拟合能力, 在对手写数字补全时, 视觉效果差距不大, IFANP补全图像的特征则更为鲜明, 数字4、数字9的整体大小、长宽比例和倾斜角度与真实图像最为接近, 直观上看相似度最高.

在对人脸数据集补全实验中, 如图6(b)所示, 可以发现VAE补全效果差距更加明显, 仅可以生成人脸, 但却无法体现头部姿态甚至性别. 而NP和IFNP受限于上下文数据量, 模型会从大量的训练样本中寻找与上线文点可能相近的图像, 并最终收敛于较为相似的面孔, 如对人脸2的补全中, 两个模型不仅在肤色、脸型、五官等方面无法体现出个性化特征, 对上下文数据的拟合也表现出明显差距, 人脸的大小、位置与真实图像差异明显. 这一结果验证了在NP和IFNP模型中, 上下文表征经取平均值(或均值池化)操作, 限制了预测不同目标像素时上下文数据差异性表达, 面对更为复杂的人脸数据集时, 表现不佳. IFANP利用局部池化聚合(LPA)模块平滑图像表征获得更为普遍的人脸特征的同时, 通过全局交叉注意力(GCA)模块充分利用上下文数据, 对不同目标像素的预测给予差异化的上下文数据权重, 因此能够对人脸数据集表现出更好的补全效果.

|

图 6 图像补全效果图 |

为了进一步验证IFANP的数据补全和上下文点拟合能力, 本文使用人脸图像的上半部分作为上下文数据, 遮罩后未知像素更加集中, 补全任务难度更大. 如图7(a)所示, 通过多次采样补全结果, 以采样2为例, 可以发现IFANP补全结果与真实图像在发型、脸型等方面相似度更高, 拟合能力更强; 而IFNP的补全结果趋于“大众脸”, 整体上看, 3次采样均未体现出真实图像的面部特征. 在图7(b)中, 真实图像上半部分与采样图像下半部分拼接, 结果显示IFANP与真实图像衔接更加自然, 面部轮廓与真实图像更加接近, 表现出该模型在细节拟合方面的明显优势.

|

图 7 图像下半部分补全 |

4.2 基于不同形式注意力机制的面向图像的神经过程性能比较

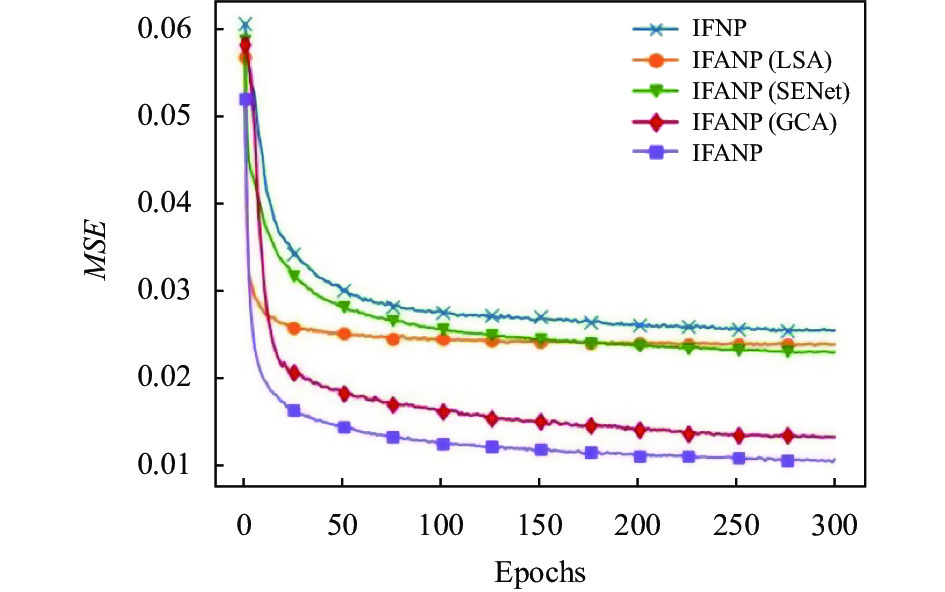

第4.1节实验说明, IFANP对图像补全时, 由于加入注意力机制, 在细节刻画方面显示出优于VAE、NP和IFNP的补全能力. 那么注意力机制是如何影响到模型效果的. 本文以各注意力模块组合为对比, 将面向图像的神经过程(IFNP)、基于压缩激活网络(squeeze-and-excitation networks, SENet)[27]的面向图像的神经过程(IFANP (SENet))、基于局部池化聚合模块的面向图像的神经过程(IFANP (LPA))、基于全局交叉注意力模块的面向图像的神经过程(IFANP (GCA))和本文提出的注意力面向图像的神经过程(IFANP)继续应用于人脸数据集补全任务, 结合KL散度、均方误差(mean squared error, MSE)、峰值信噪比(peak signal-to-noise ratio, PSNR)指标和视觉效果做以说明.

KL散度(见式(6))是衡量两个概率间差异的非对称性度量, 其数值越小, 代表补全图像和真实图像的隐变量

| $\begin{split} & {\textit{MSE}} = \frac{1}{{hw}}\sum\limits_{i = 1}^h {\sum\limits_{j = 1}^w {{{({y_{i, j}} - {{\widehat y}_{i, j}})}^2}} } \\ &{\textit{PSNR}} = 10 \cdot {\log_{10}}\left(\frac{{{{\textit{MAX}}^2}}}{{{\textit{MSE}}}}\right) \end{split} $ |

实验训练过程中, 每次迭代采用数量相同且随机采样30%至60%比例范围的图像像素作为上下文数据; 测试阶段, 不同模型采用完全相同的上下文数据, 数量分别占比真实图像20%、40%、60%. 训练和测试阶段以完整图像作为补全目标. 除注意力模块外, 均采用相同的表征变量维度和编码器、解码器结构. 实验结果如图8、图9及表1所示.

|

图 8 训练阶段MSE (平均值)曲线图 |

|

图 9 不同模型对上下文图像补全效果图 |

| 表 1 测试阶段不同比例上下文条件下的PSNR及KL值 |

图8中, 5种模型最终基本都达到收敛, 与面向图像的神经过程相比, 4种基于注意力机制的面向图像的神经过程均方误差下降速度更快. 基于不同形式注意力机制的面向图像的神经过程中, 本文提出的IFANP模型收敛速度更快, 收敛时PSNR值更高.

结合表1, 对收敛的模型进行测试, IFANP使用不同比例上下文数据条件下, 补全图像的MSE值更小、PSNR更大, 说明补全图像失真更小、质量更高, 进一步说明IFANP补全图像与真实图像更为接近.

另外, 由图9中可以看到, IFNP、IFANP (LPA)和IFANP (SE-Net)在少量上下文数据(20%)情况下, 能生成不同预测结果, 具有更强的生成能力, 这与表1中, 以上3个模型测试结果KL散度更大相吻合. 而IFANP (GCA)和IFANP与前三者的补全效果相比, 质量更高, 直观上看与原始图像更加接近.

分析以上实验结果, 不难看出, 以VAE为代表的生成模型与IFNP相比有较大差距, 在图像信息更为复杂的人脸数据集上, IFANP的细节信息更为丰富, 与上下文数据的拟合能力更强. 不同形式的注意力机制中, IFNP、IFANP (LPA)和IFANP (SE-Net)在生成能力更强; 而本文改进提出的IFANP在保持一定生成能力的情况下, 具备更强的预测精准度.

5 结束语本文将卷积神经网络(CNN)与神经过程(NP)相结合, 提出了一种用于图像补全的神经过程模型: 面向图像的神经过程(IFNP). 作为一种适用于图像处理的基础模型, IFNP继承了NP灵活抽取先验知识和线性复杂度的优势, 并展现出易于拓展的特点. 在IFNP基础上, 本文借鉴池化操作和非局部神经网络思想, 设计局部池化聚合和全局交叉注意力模块对其改进, 构建了面向图像的注意力神经过程(IFANP)模型. 与VAE、NP等其他生成模型相比, IFANP在以少量数据为上下文点条件下, 获得与真实图像相似度更高、图像轮廓衔接更加流畅的补全效果, 展现出了更强的数据补全和细节拟合能力. 通过基于不同注意力机制的IFANP模型比较, 本文提出的IFANP模型补全图像质量更高、损失更小.

本文提出的IFNP模型侧重于处理图像数据, 但直观上看, IFNP与IFANP都未能避免NP补全图像结果视觉效果不够清晰的问题. 下一步将会尝试实现对补全图像的超分重构和锐化, 以解决现有模型补全图像清晰度不高的问题. 另外, IFNP及IFANP均使用像素作为模型的输入, 而近期ViT (vision transformer)[29]及遮罩自编码器(masked auto-encoder, MAE)[30]等模型均尝试将图像切分为小块(patch), 以此作为模型输入, 克服了输入序列长度对注意力模块的影响. 因此, 在接下来的工作中, 拟采用类似手段改进模型.

| [1] |

Schulz E, Speekenbrink M, Krause A. A tutorial on Gaussian process regression: Modelling, exploring, and exploiting functions. Journal of Mathematical Psychology, 2018, 85: 1-16. DOI:10.1016/j.jmp.2018.03.001 |

| [2] |

Garnelo M, Schwarz J, Rosenbaum D, et al. Neural processes. arXiv:1807.01622, 2018.

|

| [3] |

Gordon J, Bruinsma WP, Foong AYK, et al. Convolutional conditional neural processes. arXiv:1910.13556, 2020.

|

| [4] |

Foong A, Bruinsma W, Gordon J, et al. Meta-learning stationary stochastic process prediction with convolutional neural processes. Proceedings of the 34th International Conference on Neural Information Processing Systems. , NIPS, 2020. 8284–8295.

|

| [5] |

Zhu JC, Qin SH, Wang WS, et al. Probabilistic trajectory prediction for autonomous vehicles with attentive recurrent neural process. arXiv:1910.08102v1, 2019.

|

| [6] |

Kumar A, Ali Eslami SM, Rezende DJ, et al. Consistent generative query networks. arXiv:1807.02033, 2018.

|

| [7] |

马烨, 王淑青, 毛月祥. 基于神经过程-粒子群算法的移动机器人路径规划. 湖北工业大学学报, 2020, 35(1): 17-20. DOI:10.3969/j.issn.1003-4684.2020.01.005 |

| [8] |

Pathak D, Krähenbuhl P, Donahue J, et al. Context encoders: Feature learning by inpainting. Proceedings of the 15th IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2536–2544.

|

| [9] |

Liu GL, Reda FA, Shih KJ, et al. Image inpainting for irregular holes using partial convolutions. Proceedings of the European Conference on Computer Vision (ECCV). Amsterdam: Springer, 2018. 89–105.

|

| [10] |

Yu JH, Lin Z, Yang JM, et al. Free-form image inpainting with gated convolution. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 4470–4479.

|

| [11] |

Wang KF, Gou C, Duan YJ, et al. Generative adversarial networks: Introduction and outlook. IEEE/CAA Journal of Automatica Sinica, 2017, 4(4): 588-598. DOI:10.1109/JAS.2017.7510583 |

| [12] |

Radford A, Metz L, Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networks. Proceedings of the 4th International Conference on Learning Representations. San Juan: ICLR, 2016. 1–16.

|

| [13] |

Iizuka S, Simo-Serra E, Ishikawa H. Globally and locally consistent image completion. ACM Transactions on Graphics, 2017, 36(4): 107. |

| [14] |

Li HF, Li GB, Lin L, et al. Context-aware semantic inpainting. IEEE Transactions on Cybernetics, 2018, 49(12): 4398-4411. |

| [15] |

Hinton GE, Salakhutdinov RR. Reducing the dimensionality of data with neural networks. Science, 2006, 313(5786): 504-507. DOI:10.1126/science.1127647 |

| [16] |

Vincent P, Larochelle H, Bengio Y, et al. Extracting and composing robust features with denoising autoencoders. Proceedings of the 25th International Conference on Machine Learning. Helsinki: ACM, 2008. 1096–1103.

|

| [17] |

Kingma DP, Welling M. Auto-encoding variational Bayes. arXiv:1312.6114, 2013.

|

| [18] |

周飞燕, 金林鹏, 董军. 卷积神经网络研究综述. 计算机学报, 2021, 40(6): 1229-1251. |

| [19] |

Yu F, Koltun V, Funkhouser T. Dilated residual networks. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 636–644.

|

| [20] |

Gao H, Zhu XZ, Lin S, et al. Deformable kernels: Adapting effective receptive fields for object deformation. Proceedings of the 8th International Conference on Learning Representations. Addis Ababa: ICLR, 2020.

|

| [21] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 770–778.

|

| [22] |

Wang XL, Girshick R, Gupta A, et al. Non-local neural networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7794–7803.

|

| [23] |

Odaibo S. Tutorial: Deriving the standard variational autoencoder (VAE) loss function. arXiv:1907.08956, 2019.

|

| [24] |

Kosiorek A. 神经网络中的注意力机制. 机器人产业, 2017(6): 12-17. DOI:10.3969/j.issn.2096-0182.2017.06.002 |

| [25] |

Hadji I, Wildes RP. What do we understand about convolutional networks? arXiv:1803.08834, 2018.

|

| [26] |

Liu ZW, Luo P, Wang XG, et al. Deep learning face attributes in the wild. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Accept: IEEE, 2015. 3730–3738.

|

| [27] |

Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [28] |

张雯柏, 赵华北, 胡爱云, 等. 峰值信噪比标准下轨道图像预处理方法研究. 湖南文理学院学报(自然科学版), 2019, 31(3): 7-12, 18. |

| [29] |

Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16×16 words: Transformers for image recognition at scale. arXiv:2010.11929, 2020.

|

| [30] |

He KM, Chen XL, Xie SN, et al. Masked autoencoders are scalable vision learners. arXiv:2111.06377, 2021.

|

2023, Vol. 32

2023, Vol. 32