图像超分辨率重建(super-resolution reconstruction, SR)是计算机视觉和图像处理领域中一个极具挑战性的热门研究课题. 大多数成像设备会受到硬件、环境等多种因素的干扰, 使得图像的分辨率并不能满足实际应用的需要. 为了提高图像空间分辨率, 研究学者们开始尝试在不改变成像设备的前提下, 利用图像处理、机器学习等算法将低分辨率(low resolution, LR)图像重建为高分辨率(high resolution, HR)图像[1]. 正是因为深度学习能自适应地学习LR图像与HR图像之间的非线性映射关系这种特性, 使得基于深度学习的图像SR算法明显优于传统方法, 因此也成为单图像超分辨率重建(single image super-resolution, SISR)的主流研究方法. 同时, SR技术在医学图像的分析与识别[2]、人脸超分辨率[3]、视频监控与安全[4]、遥感图像[5]等实际场景中有着广泛的应用.

近年来, 大量介绍SISR 方法的文献[6, 7]以及与超分辨率相关的综述类文章[8, 9]层出不穷, 这些文献中都对近年来SR领域提出的各种新型算法、设计的新型网络框架、新型的应用场景等进行了研究与总结. 与之不同的是, 本文按照学习方法的差异性将基于深度学习的SISR问题分为两大类: 有监督的SISR方法和无监督的SISR方法. 先全面介绍了与SISR问题相关的储备知识, 然后详细论述了以上两类方法的最新理论和研究进展, 同时比较了不同算法之间的异同点和优缺点, 最后对该领域存在的问题和未来的发展方向进行了总结和展望.

1 SISR方法的理论基础本节将从问题定义、基准数据集、评价指标和损失函数等方面对SISR方法的理论基础展开详细的调研, 并对其中涉及到的相关基础知识和理论实现进行论述.

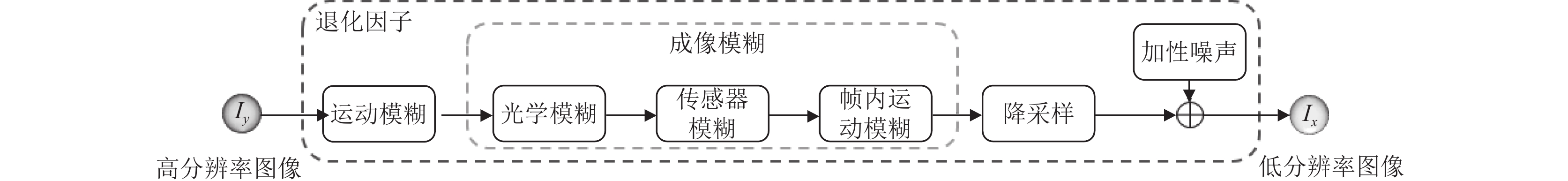

1.1 问题定义日常生活中, 由于成像设备、成像环境等多种退化因素的影响, 人们获取到的图像通常是LR图像, 其退化过程如图1所示. 设

|

图 1 图像退化过程 |

那么, LR与HR图像之间的关系则可以表示为:

| $ {I_x} = D\left( {{I_y}, \delta } \right) $ | (1) |

其中,

图像退化过程中的退化函数、模糊因子、噪声等因素通常都是未知的, 而能够被直接获取的只有LR图像

| $ {\hat I_y} = F\left( {{I_x}, \theta } \right) $ | (2) |

其中,

| $ {I_x} = D\left( {{I_y}, \delta } \right) = \left( {{I_y} \otimes k} \right) \downarrow s + {n_\sigma }, \left\{ {k, s, \sigma } \right\} \subseteq \delta $ | (3) |

其中,

| $ \hat \phi = {[\min L\left( {{{\hat I}_y}, {I_y}} \right)]_\phi } + \lambda \psi \left( \phi \right) $ | (4) |

其中,

数据作为深度学习算法的建模必不可少的基本要素之一, 其数据量的多少以及数据质量的好坏将直接影响着目标模型的效果. 现如今, SISR领域有着各式各样的数据集用于模型的训练与测试, 这些数据集在图像的数量、图像的质量、图像的分辨率、图像的多样性以及图像的成像环境等方面都有所不同. 其中, 大多数数据集仅包含HR图像, 不包含用于模型训练和测试所需的不同放大倍数下的LR-HR图像对, 需要通过双三次插值算法实现图像对的构造.

本节将对常用的SISR数据集进行调研, 汇总结果如表1所示. 本节列出了各类数据集在图像数量、图像格式、图像类型、图像平均分辨率以及图像中所包含的类别信息. 其中, Set5[11]、Set14[12]、Urban100[13]、BSDS100[14]、Manga109[15]常作为模型重建效果评估的基准数据集. 同时, 研究者们也常常倾向于多个数据集共同参与模型的训练与测试, 例如T91[16]与BSDS300[14]的结合, DIV2K[17]与Flickr2K[18]的结合. 其次, 一些其他视觉领域的数据集也参与到SR模型的训练过程中, 如ImageNet[19]、MS-COCO[20]、VOC2012[21]、CelebA-HQ[22]、L20[23]等.

| 表 1 SISR领域基准数据集 |

1.3 评价指标

根据测量方法的不同, 可以将图像质量评价(image quality assessment, IQA)方法[30]分为: 通过人类视觉对图像质量进行感知的主观评价方法和通过数值计算进行定量分析的客观评价方法. 其中, 主观评价方法相较于客观方法更加符合实际应用, 但其需要消耗更多的人力和时间资源, 所以基于客观评价方法进行定量评估是目前超分辨率重建领域的主流评价指标, 本节将对以上两类评价方法进行简要论述.

(1) 峰值信噪比(peak signal-to-noise ratio, PSNR)[31]是目前应用最为广泛的用于图像重建质量评价的指标之一. 在SR任务中,

| $ {\textit{PSNR}} = 10\log \left( {\frac{{MAX_I^2}}{{MSE}}} \right) $ | (5) |

单通道的

| $ {\textit{MSE}} = \frac{1}{{M \times N}}{\sum\nolimits_{i = 1}^M {\sum\nolimits_{j = 1}^N {\left( {{I_{ij}} - {{\hat I}_{ij}}} \right)} } ^2} $ | (6) |

多通道的

| $ {\textit{MSE}} = \frac{1}{{C \times M \times N}}\sum\nolimits_{k = 1}^C {{{\sum\nolimits_{i = 1}^M {\sum\nolimits_{j = 1}^N {\left( {{I_{ijk}} - {{\hat I}_{ijk}}} \right)} } }^2}} $ | (7) |

(2) 结构相似性评价(structural similarity index measure, SSIM)[32]是用于比较图像间亮度、对比度、结构细节的相似度指标. 与

| $ L\left( {X, Y} \right) = \frac{{2{\mu _X}{\mu _Y} + {C_1}}}{{{\mu _X}^2 + {\mu _Y}^2 + {C_1}}} $ | (8) |

| $ C\left( {X, Y} \right) = \frac{{2{\mu _X}{\mu _Y} + {C_2}}}{{{\mu _X}^2 + {\mu _Y}^2 + {C_2}}} $ | (9) |

| $ S\left( {X, Y} \right) = \frac{{{\sigma _{XY}} + {C_3}}}{{{\sigma _X}{\sigma _Y} + {C_3}}} $ | (10) |

| $ {\textit{SSIM}}\left( {X, Y} \right) = L{\left( {X, Y} \right)^\alpha }\times C{\left( {X, Y} \right)^\beta }\times S{\left( {X, Y} \right)^\gamma } $ | (11) |

其中,

(3) 平均意见得分(mean opinion score, MOS)[33]是属于IQA中一种常用的图像质量评价主观方法, 也是在图像感知质量评价方面最可靠的方法. 该方法要求参与评测的人员对被测图像从图像的清晰度、对比度、颜色、外观细节等方面进行视觉感知并打分, 最后的评估得分是每一个评级份数的算术平均分, 分数范围由坏至好分别为1到5分. 但是这种方法会因为评测标准的不同或人为偏见等不可控因素的影响而存在一些缺陷和局限性.

(4) 基于学习的IQA方法是为了减少人为因素的干扰, 更好地评估图像的视觉感知质量, 在大型理想参考图像数据集上通过学习的方式对图像进行质量评估的一种算法. 2017年, Kim等人[34]提出了基于CNN的全参考图像质量评估模型DeepQA, 该方法结合失真图像、主观评分和客观误差图进行模型的训练并对图像的视觉相似性进行预测. Ma等人[35]和Talebi等人[36]分别提出了MEON和NIMA的无参考IQA神经网络, 该方法不需要真实的参考图像, 直接从视觉感知分数中进行学习并预测图像的质量分数. 基于CNN的方法能够在视觉感知评估方面表现出更好的性能, 但需要更多的数据资源.

除了上述几种常见的方法外, 还有一些通过特定任务(图像分类、人脸识别、图像分割等)来间接衡量SISR性能的方法. 同时, 基于相位一致性和图像的梯度大小来计算图像的特征相似性[37]的方法也被用来评估图像的质量. Blau等人[38]在2018年的论文中提出, 图像的感知质量和图像的失真是相互矛盾的, 随着图像失真度的降低, 图像的视觉感知质量也会随之降低. 所以,

损失函数是深度学习模型迭代优化过程中必不可少的重要元素之一. 在SISR任务中, 损失函数的选择至关重要, 其通过计算误差来衡量HR图像的重建质量. 而长期的研究发现, 多种损失函数的共同指导更能在多方面指导HR图像的重建过程. SR领域中最为常见的损失是像素损失, 但由于像素并不能对图像的重建质量进行绝对评估, 所以内容损失、对抗损失、先验损失等各类损失函数应运而生, 以下将介绍几种常用的损失函数.

(1) 像素损失(pixel loss): 该损失是最为简单常用的一类损失函数, 其主要以像素为基础衡量两幅图像之间的差异, 包括L1、L2损失[39]以及L1损失的一种可区分的变体Charbonnier损失[40], 其具体表达式分别如式(12)、式(13)、式(14)所示. 这类损失能够提高模型的收敛速度, 但是缺乏对图像内容以及语义信息的考虑, 常会出现重建图像过度平滑的现象.

| $ {\mathcal{L}_{{L_1}}}\left( {{I_{SR}}, {I_y}} \right) = \frac{1}{{hwc}}\sum\nolimits_{i, j, k} {\left| {I_{SR}^{i, j, k} - I_y^{i, j, k}} \right|} $ | (12) |

| $ {\mathcal{L}_{{L_2}}}\left( {{I_{SR}}, {I_y}} \right) = \frac{1}{{hwc}}\sum\nolimits_{i, j, k} {{{\left( {I_{SR}^{i, j, k} - I_y^{i, j, k}} \right)}^2}} $ | (13) |

| $ {\mathcal{L}_{\rm Char}}\left( {{I_{SR}}, {I_y}} \right) = \frac{1}{{hwc}}\sum\nolimits_{i, j, k} {\sqrt {{{\left( {I_{SR}^{i, j, k} - I_y^{i, j, k}} \right)}^2} + {\varepsilon ^2}} } $ | (14) |

(2) 内容损失(content loss)[41]: 该损失也常被称为感知损失, 如式(15)所示. 其主要是从图像内容理解和感知层面对图像质量进行评价, 通常使用预先训练好的图像分类网络对两幅图像之间的语义差异进行评估, 从而提高重建图像的视觉相似性和真实度.

| $ {\mathcal{L}_{\rm Cont}}\left( {{I_{SR}}, {I_y}, \phi } \right) = \frac{1}{{hwc}}\sum\nolimits_{i, j, k} {\left( {\phi _{(l)}^{i, j, k}\left( {{I_{SR}}} \right) - \phi _{(l)}^{i, j, k}\left( {{I_y}} \right)} \right)} $ | (15) |

(3) 纹理损失(texture loss)[42]: 该损失主要源自于风格迁移领域, 其常被称为风格常见损失, 如式(17)所示. 通常使用重建图像与原始图像不同通道之间的相关性来度量两幅图像在颜色、纹理、对比度等方面的相似性.

| $ G_{i, j}^{(l)}(I) = vec(\phi _{(l)}^i(I)) \cdot vec(\phi _{(l)}^j(I)) $ | (16) |

| $ {\mathcal{L}_{\rm texture}}\left( {{I_{SR}}, {I_y}, \phi } \right) = \frac{1}{{{c_l}^2}}\sqrt {{{\sum\nolimits_{i, j, k} {\left( {G_{(l)}^{i, j, k}\left( {{I_{SR}}} \right) - G_{(l)}^{i, j, k}\left( {{I_y}} \right)} \right)} }^2}} $ | (17) |

(4) 对抗损失(adversarial loss)[43]: 该损失的提出主要是由于对抗生成网络(generative adversarial networks, GANs), GANs由生成器和判别器组成, 如式(18)所示. SISR任务中的生成器为超分模块, 而判别器主要用高层的语义信息来鉴别生成图像的真实性, 从而使得重建后的HR图像更加真实.

| $ {\mathcal{L}_{\rm Adversarial}}\left( {{I_x}, G, D} \right) = \sum\nolimits_{n = 1}^N { - \log } D(G({I_x})) $ | (18) |

(5) 先验损失(prior loss)[44]: 该损失主要是将稀疏先验、梯度先验和边缘先验等知识引入到SISR模型中, 如式(19)、式(20)所示. 该损失将已知的先验作为约束条件放入损失函数中, 从而能够优化图像的一些特定信息, 使得重建的效果能够朝着预期的方向发展, 重建后的HR图像也将包含更多的纹理细节.

| $ \begin{split} &{\mathcal{L}_{TV}}\left( {{I_{SR}}} \right) = \\ &\quad \frac{1}{{hwc}}\sum\nolimits_{i, j, k} {\sqrt {{{(I_{SR}^{i, j + 1, k} - I_y^{i, j, k})}^2} + {{(I_{SR}^{i + 1, j, k} - I_y^{i, j, k})}^2}} } \end{split}$ | (19) |

| $ {\mathcal{L}_{\rm Edge}}\left( {{I_{SR}}, {I_y}, E} \right) = \frac{1}{{hwc}}\sum\nolimits_{i, j, k} {\left| {E(I_{SR}^{i, j, k}) - E(I_y^{i, j, k})} \right|} $ | (20) |

目前, 大多数基于深度学习方法的SISR模型均侧重于使用LR图像和HR图像进行模型训练, 也即这类模型都属于有监督的深度学习模型. 虽然不同模型之间的差异性较大, 但是他们均是由模型框架、网络设计、学习策略等组件组合而成, 以适用于各种SR任务. 因此, 本节将从网络的类型和网络的框架两个层面对有监督的SISR方法进行分类, 并对其中的代表性算法进行介绍.

2.1 基于网络类型根据网络设计的差异性, 可以根据网络设计的不同将有监督的深度学习超分辨率重建网络分为以

随着卷积神经网络(convolutional neural network, CNN)在图像分类领域的成功应用, SISR方法也在CNN模型的启发下取得了显著的进步, 而前期基于深度学习的SISR模型大多数均是以获取较高的

SR问题也可以看作是一种图像转换的任务, 也即输入一张退化的LR图像, 经过模型处理后得到一张高质量的HR图像. 考虑到以PSNR为导向的重建方法常常会导致高频信息的缺失, 重建后的HR图像过度平滑, 与真实的HR图像在视觉感知上存在一定的差异. Johnson等人[41]在 2016年则提出利用感知损失来衡量重建后的图像质量, 以此来提升模型的重建性能. Ledig等人[30]在2016年提出了一个以视觉感知为驱动的SRGAN方法, 该方法首次将生成对抗网络(gene-rative adversarial network, GAN)[44]用于SISR领域, 并在MOS上表现出了卓越的性能. 随后, 大量以视觉感知为驱动的基于GAN的SR方法被提出, 例如Wang等人[56]通过在ESRGAN中引入密集残差块(residual-in-residual dense block, RRDB)来提高网络的性能; Soh等人[57]基于自然流形鉴别器设计了NatSR, 使得重建后的图像具有更加真实的纹理和更加自然的细节信息; Wang等人[29]则基于特征的空间信息感知提出了SFTGAN, 该方法让图像的纹理信息恢复更精细、更接近于真实的HR图像; Ma等人[58]发现基于上述方法重建后的HR图像常常存在明显的结构变形问题, 于是提出了结构保留的SPSR网络, 该方法能在缓解图像结构变形的同时还能够生成丰富的问题细节; 为了更好的构建LR图像和高频信息之间的关系, Lugmayr等人[59]基于归一化流设计了能够基于低分辨率输入学习输出的条件分布的SRFlow, 该方法能够探索超分辨率的解空间并生成多样性的图像, 且最终的生成图像在感知度量上均优于当前最优的GAN方法. 尽管现有的以感知为驱动的SISR方法的确能够有效提升图像的感知质量, 但是仍会出现伪影、几何变形等现象.

2.2 基于模型框架根据模型框架的差异性, 可以根据框架设计的不同将有监督的深度学习超分辨率重建网络分为预定义上采样网络、单次上采样网络、渐进上采样网络和迭代上下采样网络.

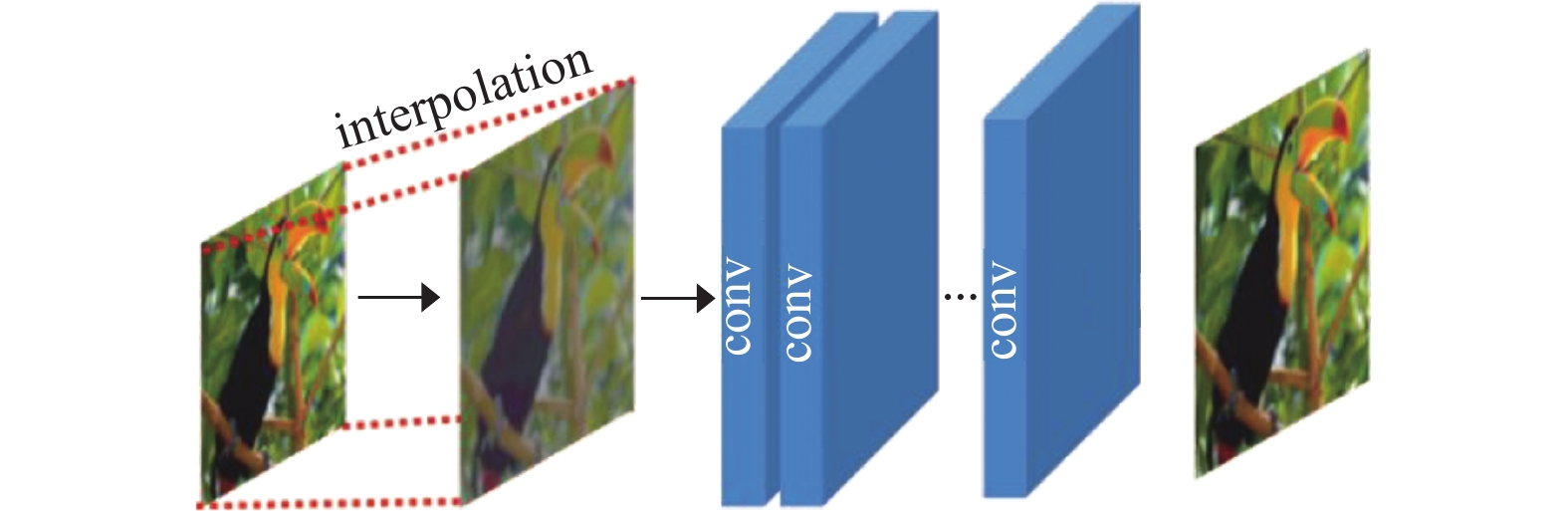

2.2.1 预定义上采样网络预定义上采样网络(predefined up-sampling network)的实现通常先利用传统的插值算法将输入的LR图像放大到具有目标尺寸的粗略HR图像, 然后使用深度卷积神经网络(deep convolutional neural network, DCNN)进行特征提取, 使得网络能自动学习LR图像到HR图像的端到端非线性映射关系, 从而实现SR图像的重建. Dong等人[26]率先使用预定义上采样的SR框架提出了SRCNN, 首次利用CNN实现了高质量的重建效果. 如图2所示, 该方法解决了LR图像直接映射到HR图像的困难, 降低了学习的难度, 同时也能实现任意缩放因子下的比传统单尺度SR模型更加精细的重建效果. 文献[53, 54]在这种主流框架的基础上对学习策略、模型设计等方面进行改进, 使得基于深度学习的SISR模型的性能逐步得到提升. 但是, 这种预先处理至目标尺寸的上采样操作会给输入图像带来额外的噪声和模糊, 并且使得大多数计算都是在高维空间实现的, 使得网络的时间复杂度和空间复杂度要明显高于其他框架.

|

图 2 预定义上采样网络 |

2.2.2 单次上采样网络

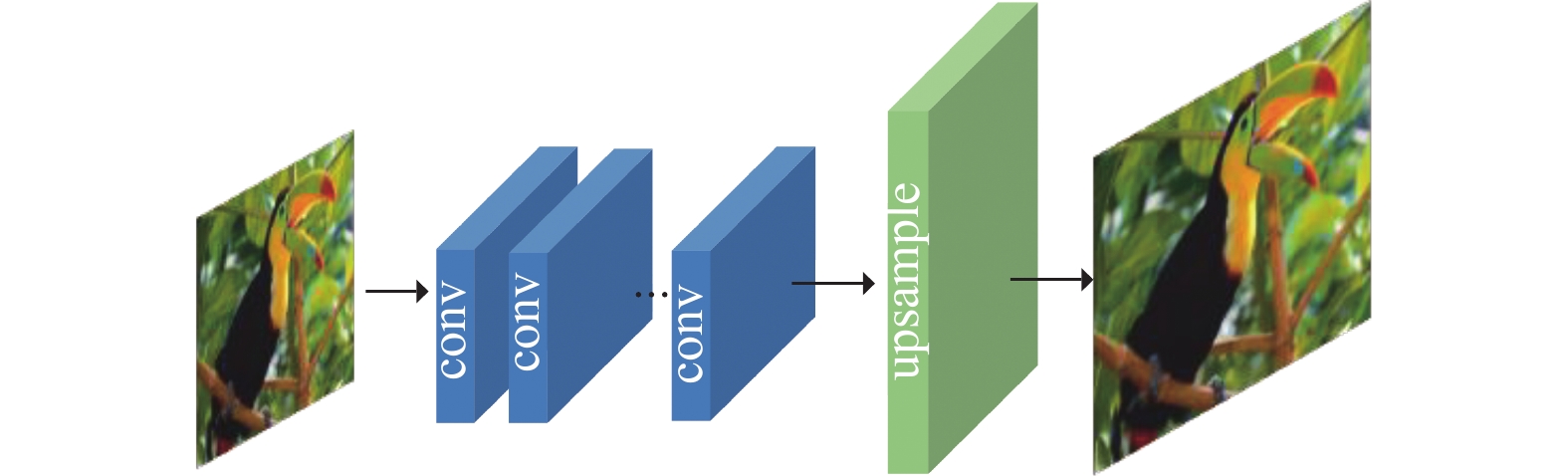

单次上采样网络(single up-sampling network)直接在低维空间实现大部分的计算过程, 也即在不对输入的LR图像进行目标尺寸缩放的前提下, 利用DCNN进行特征提取, 并在网络的后端采用可端到端学习的上采样层(亚像素卷积层或者反卷积)对非线性映射后的图像进行放大, 其网络设计如图3所示. 该方法能有效提高图像的空间分辨率, 且相较于预定义上采样网络能够大大降低网络的时间和空间成本, 因此, 基于这种网络的设计思想, 通过对特征提取层、上采样层、学习策略等模块的改进, 文献[56, 60,61]的方法也取得了更好的性能. 但是, 其无法学习到LR与HR图像之间复杂的非线性映射关系, 而且网络中只进行了一步上采样操作, 这样会增加网络的学习难度, 同时针对每一个缩放因子都需要训练一个独立的SR模型, 所以无法实现任意缩放尺寸的SR能力.

|

图 3 单次上采样网络 |

2.2.3 渐进上采样网络

渐进上采样网络(progressive up-sampling network)利用拉普拉斯金字塔网络在前向过程中重建出不同尺度的SR图像, 如图4所示. 该网络通过CNN的级联, 输入的LR图像在每一个上采样阶段都会被重建到一个更高分辨率的HR图像, 这种上采样叠加的操作使得网络能够更好地对浅层特征进行利用. LapSRN[40]、MS-LapSRN[62]和渐进式SR (ProSR)[63]也都采用了这种网络结构, 并取得了较单次上采样网络更优的性能, 并且ProSR在网络的学习过程中加强了上下文信息的流行性. 渐进式的上采样网络可以解决多种尺度的SR任务, 面对大尺度放大需求, 该框架可以有效降低时间复杂度, 但是将学习过程拆分为多个阶段会造成网络性能的不稳定.

|

图 4 渐进上采样网络 |

2.2.4 迭代上下采样网络

迭代上下采样网络(iterative up and down-sampling network)中加入了一种迭代式的误差修正反馈机制, 尝试利用反向传播的机制构建相互连接的上采样模块和下采样模块, 从而获取到不同层次的分辨率特征, 并利用误差对重建后的HR图像进行加强, 网络结构如图5所示. Haris等人[50]基于该网络提出了DBPN, 通过上采样层和下采样层交替连接的方式将中间所有的重建结果重建最终的HR图像. 随后, SRFBN[52]采用了迭代的上下采样反馈块, 跳过连接更密集, 学习到了更好的表示方法. 该框架下的模型可以更好地挖掘LR-HR图像对之间的深层关系, 产生更深层次的特征, 从而提供更高质量的重建结果, 但目前反向传播模块的设计并没有明确的标准.

|

图 5 迭代上下采样网络 |

3 无监督的SISR深度学习方法

目前, SISR网络的实现大多数都基于有监督的学习机制, 也即使用成对的LR-HR图像进行模型训练. 但想要收集到同一个场景并且具有不同分辨率的图像需要大量的人力和时间成本, 而且现有的大多数SR数据集都需要通过传统的插值算法生成与HR图像向配对的LR图像, 而这种已知的退化过程对真实场景下的SR需求并不适用. 因此, 基于无监督学习的SR方法受到研究学者的广泛关注, 该方法在训练过程中不需要成对的LR-HR图像, 模型也能学习到真实场景下的图像退化函数, 最终获取到的模型更容易适应真实自然场景下的SR问题. 本小节将对现有的几种无监督学习下的SISR深度学习方法进行介绍.

3.1 弱监督学习下的SISR方法基于弱监督学习的SISR方法在不利用插值算法构造成对的LR-HR数据的前提下, 使用非配对的LR-HR图像进行网络的训练, 在该学习方法下有两种网络训练方式:

一种是先学习HR图像退化为LR图像的退化核, 再用该函数生成HR图像对应的LR图像, 以构建成对的LR-HR数据集用于SR模型的训练. CVPR2021年接收的一篇最新的研究无监督学习下的退化感知SISR算法DASR[64], 该网络采用无监督学习的方式利用退化表达学习机制自适应地从LR图像中捕获到具有辨识性的特征, 从而获取到准确的退化信息, 最后结合对比学习的思想对低分辨率特征进行调制.

另一种是利用循环学习的思想让网络学习LR图像到HR图像的映射和HR图像到LR图像的退化函数, 从而实现相互验证和相互促进. 2018年, Yuan等人[65]受到CycleGAN[66]的启发, 于是设计了一个由4个生成器和2个判别器组合而成的无监督SISR模型CinCGAN. 该网络将HR图像和LR图像分别看作两个不同的作用域, 并利用CycleGAN的循环结构来解决真实场景下LR图像的重建问题.

3.2 零次学习下的SISR方法Shocher等人[67]最早将零次学习(zero-shot learning)应用到SR领域并提出完全无监督的SISR深度学习方法ZSSR. 其利用网络在对输入的单一特定图像进行测试时训练SR网络的思想, 学习图像内部的先验特征, 进而预测出图像的退化函数, 预估出LR图像与HR图像之间的退化关系并恢复出图像的高频细节. ZSSR的实现不需要大型的SR数据集, 只需要通过学习到的退化函数生成小型数据集, 并在该SR数据集上完成网络的训练. 所以, 该方法对真实场景下的图像进行重建时具有更大的优势, 但ZSSR需要对每张特定的图像进行上千次的迭代学习, 因此其推理时间要远大于其他基于深度学习的SISR方法. 2020年, Soh等人[68]为解决推理时间过长的问题, 将零次学习与元转换学习相结合应用到SR问题中, 从而提出了只需一次梯度更新便可使重建效果可观的MZSR方法. 虽然, 基于零次学习方法的SR网络在未知退化函数的条件下取得了出色的性能, 并且能够有效改善自然场景下LR图像的重建效果, 但仍然会存在噪声和伪影.

4 讨论与分析为了更加直观地比较SISR的性能, 本节将在4倍放大因子的条件下, 对目前一些典型的有监督和无监督的SISR算法在Set5、Set14、BSDS100三个基准数据集上分别计算PSNR和SSIM, 从定量分析的角度进行对比分析.

由表2可知, SRCNN作为第一个将CNN引入SISR领域的算法, 其得益于CNN强大的特征捕获和表达能力, 使得SRCNN对单张LR图像的重建能力远高于传统的双三次插值方法Bicubic; 其次, 密集连接、残差连接、特征金字塔等网络结构也在SISR领域取得了显著的进步, 如VDSR[53]、RRDB[56]、LapSRN[40]等算法; 随后, 为了解决SR的不适定性, 提高SISR网络对真实自然场景图像重建的自适应性和泛化能力, 研究人员逐渐将反馈回归机制、基于感知损失、先验损失、生成式建模思想、无监督学习等方法用于SISR领域. 其中, 基于归一化流的SRFlow重建方法取得了优异的重建性能, 无监督的重建算法ZSSR也能有效学习到LR图像的超分辨率信息, 其重建性能超越了经典的SRCNN, 也为基于无监督学习方法的SISR研究打下了坚实的基础.

| 表 2 ×4放大因子下不同算法在Set5、Set14、BSDS100数据集下的PSNR/SSIM指标 |

尽管各类SISR算法已经取得了显著的进步, 但是对结构复杂、纹理信息丰富的图像重建后还是会存在一定的重建伪影、信息丢失等问题, 所以SISR任务仍然面临着许多挑战.

5 总结与展望本文对深度学习方法在SISR领域的最新研究进展进行了详细调研与论述. SISR技术作为计算机视觉领域的重要研究任务之一, 其可以作为刑事侦查、医学诊断、遥感图像等领域的有效辅助工具. 基于深度学习的SISR算法层出不穷, 本文主要围绕基于有监督、无监督的SISR技术进行讨论, 也对其中涉及到的背景知识进行了具体的介绍. 虽然SISR的性能已经取得了显著的提升, 但是仍然还存在很多挑战, 以下将对SISR研究过程中存在的问题和未来发展趋势进行总结.

(1) 评价指标

SISR问题中常用IQA来衡量SR算法的性能, PSNR和SSIM作为两个最常用的评价指标. 前者容易导致过度平滑的问题, 使得差异较小的图片之间的定量分析误差较大, 而后者虽然从亮度、对比度和结构细节方面模拟人类的视觉感知, 但是不能完全准确表示图像的视觉感知效果, MOS虽然与视觉感知质量最为相近, 但是其评估过程需要消耗大量的时间和人工成本. 所以, 制定通用的、准确的SR质量评价指标是目前亟待解决的问题.

(2) 真实场景图片的SR

自然场景下的图片常常会受到加性噪声、运动模糊、压缩伪影等因素的影响, 使得模型面对未知的退化问题, 缺少成对的真实场景下的LR-HR图像. 因此, 在有人工设计的数据集上训练的SISR模型对自然场景图像的重建效果并不理想. 虽然, 已经有很多研究方法被提出, 但是仍然存在训练难度大、重建细节不够完善等缺点. 因此, 针对未知图像退化过程的建模依旧是SISR的重要发展方向.

(3) 网络框架的设计趋势

一个好的网络框架不仅能提升SISR的性能, 还能有效减少模型的时间复杂度和空间复杂度. 因此, 后续可以考虑在模型的学习过程中, 将全局信息和局部信息、底层特征与高层次特征相结合的思想, 利用不同尺度、不同层次的语义信息加强网络对图像特征的表征能力, 从而提升SISR算法的重建性能.

(4) 上采样方法的改进

目前使用的上采样方法会存在不能端到端学习、感受野分布不均匀、会产生棋盘效应等问题, 因此会导致SISR算法低效、重建效果不稳定等问题. 同时目前的上采样多为整数倍. 所以, 探索出一个高效地、适用于任意放大因子的上采样方法是未来值得进一步研究的方向.

| [1] |

唐艳秋, 潘泓, 朱亚平, 等. 图像超分辨率重建研究综述. 电子学报, 2020, 48(7): 1407-1420. DOI:10.3969/j.issn.0372-2112.2020.07.022 |

| [2] |

刘朋伟, 高媛, 秦品乐, 等. 基于多感受野的生成对抗网络医学MRI影像超分辨率重建. 计算机应用. http://kns.cnki.net/kcms/detail/51.1307.TP.20210708.1626.008.html. [2021-10-07].

|

| [3] |

蒋文杰, 罗晓曙, 戴沁璇. 基于对抗网络人脸超分辨率重建算法研究. 计算机工程与应用, 2021, 57(11): 219-223. DOI:10.3778/j.issn.1002-8331.2002-0370 |

| [4] |

Kappeler A, Yoo S, Dai QQ, et al. Video super-resolution with convolutional neural networks. IEEE Transactions on Computational Imaging, 2016, 2(2): 109-122. DOI:10.1109/TCI.2016.2532323 |

| [5] |

Yuan QQ, Li Y, Li JC, et al. Remote sensing image super-resolution via regional spatially adaptive total variation model. Proceedings of 2014 IEEE Geoscience and Remote Sensing Symposium. Quebec City: IEEE, 2014. 3073–3076.

|

| [6] |

Wang ZH, Chen J, Hoi SCH. Deep learning for image super-resolution: A survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3365-3387. DOI:10.1109/TPAMI.2020.2982166 |

| [7] |

Bashir SMA, Wang Y, Khan M, et al. A comprehensive review of deep learning-based single image super-resolution. PeerJ Computer Science, 2021, 7: e621. DOI:10.7717/peerj-cs.621 |

| [8] |

向海燕. 超分辨率图像恢复方法综述. 重庆理工大学学报(自然科学), 2014, 28(9): 72-76. |

| [9] |

陈文静, 唐轶. 基于深度学习的图像超分辨率重建方法综述. 云南民族大学学报(自然科学版), 2019, 28(6): 597-605. |

| [10] |

Zhang K, Zuo WM, Zhang L. Learning a single convolutional super-resolution network for multiple degradations. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 3262–3271.

|

| [11] |

Bevilacqua M, Roumy A, Guillemot C, et al. Low-complexity single-image super-resolution based on nonnegative neighbor embedding. Proceedings of British Machine Vision Conference. Surrey: BMVC, 2012. 1–10.

|

| [12] |

Zeyde R, Elad M, Protter M. On single image scale-up using sparse-representations. Proceedings of the 7th International Conference on Curves and Surfaces. Avignon: Springer, 2010. 711–730.

|

| [13] |

Huang JB, Singh A, Ahuja N. Single image super-resolution from transformed self-exemplars. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 5197–5206.

|

| [14] |

Martin D, Fowlkes C, Tal D, et al. A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics. Proceedings of the 8th IEEE International Conference on Computer Vision. Vancouver: IEEE, 2001. 416–423.

|

| [15] |

Ogawa T, Otsubo A, Narita R, et al. Object detection for comics using Manga109 annotations. arXiv: 1803.08670, 2018.

|

| [16] |

Yang JC, Wright J, Huang TS, et al. Image super-resolution via sparse representation. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873. DOI:10.1109/TIP.2010.2050625 |

| [17] |

Agustsson E, Timofte R. NTIRE 2017 challenge on single image super-resolution: Dataset and study. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu: IEEE, 2017. 1122–1131.

|

| [18] |

Lim B, Son S, Kim H, et al. Enhanced deep residual networks for single image super-resolution. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu: IEEE, 2017. 1132–1140.

|

| [19] |

Deng J, Dong W, Socher R, et al. ImageNet: A large-scale hierarchical image database. Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 248–255.

|

| [20] |

Lin TY, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 740–755.

|

| [21] |

Everingham M, Eslami SMA, van Gool L, et al. The PASCAL visual object classes challenge: A retrospective. International Journal of Computer Vision, 2015, 111(1): 98-136. DOI:10.1007/s11263-014-0733-5 |

| [22] |

Tolosana R, Vera-Rodriguez R, Fierrez J, et al. Deepfakes and beyond: A survey of face manipulation and fake detection. Information Fusion, 2020, 64: 131-148. DOI:10.1016/j.inffus.2020.06.014 |

| [23] |

Timofte R, Rothe R, van Gool L. Seven ways to improve example-based single image super resolution. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1865–1873.

|

| [24] |

Chao D, Loy CC, Tang XO. Accelerating the super-resolution convolutional neural network. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 391–407.

|

| [25] |

Arbeláez P, Maire M, Fowlkes C, et al. Contour detection and hierarchical image segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 898-916. DOI:10.1109/TPAMI.2010.161 |

| [26] |

Dong C, Loy CC, He KM, et al. Image super-resolution using deep convolutional networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307. DOI:10.1109/TPAMI.2015.2439281 |

| [27] |

Blau Y, Mechrez R, Timofte R, et al. The 2018 PIRM challenge on perceptual image super-resolution. Proceedings of European Conference on Computer Vision. Munich: Springer, 2018. 334–355.

|

| [28] |

Wang XT, Yu K, Dong C, et al. Recovering realistic texture in image super-resolution by deep spatial feature transform. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 606–615.

|

| [29] |

Sun LB, Hays J. Super-resolution from Internet-scale scene matching. Proceedings of 2012 IEEE International Conference on Computational Photography. Seattle: IEEE, 2012. 1–12.

|

| [30] |

Ledig C, Theis L, Huszár F, et al. Photo-realistic single image super-resolution using a generative adversarial network. IEEE Computer Society. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 105–114.

|

| [31] |

Almohammad A, Ghinea G. Stego image quality and the reliability of PSNR. Proceedings of the 2010 2nd International Conference on Image Processing Theory, Tools and Applications. Paris: IEEE, 2010. 215–220.

|

| [32] |

Marabini R, Sorzano COS, Matej S, et al. 3-D reconstruction of 2-D crystals in real space. IEEE Transactions on Image Processing, 2004, 13(4): 549-561. DOI:10.1109/TIP.2003.822620 |

| [33] |

Viswanathan M, Viswanathan M. Measuring speech quality for text-to-speech systems: Development and assessment of a modified mean opinion score (MOS) scale. Computer Speech & Language, 2005, 19(1): 55-83. |

| [34] |

Kim J, Lee S. Deep learning of human visual sensitivity in image quality assessment framework. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1969–1977.

|

| [35] |

Ma C, Yang CY, Yang XK, et al. Learning a no-reference quality metric for single-image super-resolution. Computer Vision and Image Understanding, 2017, 158: 1-16. DOI:10.1016/j.cviu.2016.12.009 |

| [36] |

Talebi H, Milanfar P. NIMA: Neural image assessment. IEEE Transactions on Image Processing, 2018, 27(8): 3998-4011. DOI:10.1109/TIP.2018.2831899 |

| [37] |

Zhang L, Zhang L, Mou XQ, et al. FSIM: A feature similarity index for image quality assessment. IEEE Transactions on Image Processing, 2011, 20(8): 2378-2386. DOI:10.1109/TIP.2011.2109730 |

| [38] |

Blau Y, Michaeli T. The perception-distortion tradeoff. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6228–6237.

|

| [39] |

Ahn N, Kang B, Sohn KA. Fast, accurate, and lightweight super-resolution with cascading residual network. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 256–272.

|

| [40] |

Lai WS, Huang JB, Ahuja N, et al. Deep Laplacian pyramid networks for fast and accurate super-resolution. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5835–5843.

|

| [41] |

Johnson J, Alahi A, Li FF. Perceptual losses for real-time style transfer and super-resolution. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 694−711.

|

| [42] |

Gatys LA, Ecker AS, Bethge M. Image style transfer using convolutional neural networks. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2414–2423.

|

| [43] |

Goodfellow IJ, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: NIPS, 2014. 2672–2680.

|

| [44] |

Bulat A, Tzimiropoulos G. Super-FAN: Integrated facial landmark localization and super-resolution of real-world low resolution faces in arbitrary poses with GANs. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 109–117.

|

| [45] |

Dong C, Loy CC, He KM, et al. Learning a deep convolutional network for image super-resolution. ECCV. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 184–199.

|

| [46] |

Kim J, Lee JK, Lee KM. Deeply-recursive convolutional network for image super-resolution. Proceedings of the IEEE conference on computer vision and pattern recognition. Las Vegas: IEEE, 2016. 1637–1645.

|

| [47] |

Zhang YL, Tian YP, Kong Y, et al. Residual dense network for image super-resolution. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 2472–2481.

|

| [48] |

Shi W, Caballero J, Huszár F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1874–1883.

|

| [49] |

Hu XC, Mu HY, Zhang XY, et al. Meta-SR: A magnification-arbitrary network for super-resolution. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 1575–1584.

|

| [50] |

Haris M, Shakhnarovich G, Ukita N. Deep back-projection networks for super-resolution. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 1664–1673.

|

| [51] |

Guo Y, Chen J, Wang JD, et al. Closed-loop matters: Dual regression networks for single image super-resolution. Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 5406–5415.

|

| [52] |

Li Z, Yang JL, Liu Z, et al. Feedback network for image super-resolution. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 3862–3871.

|

| [53] |

Zhang YL, Li KP, Li K, et al. Image super-resolution using very deep residual channel attention networks. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 294–310.

|

| [54] |

Dai T, Cai JR, Zhang YB, et al. Second-order attention network for single image super-resolution. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 11057–11066.

|

| [55] |

Niu B, Wen WL, Ren WQ, et al. Single image super-resolution via a holistic attention network. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 191–207.

|

| [56] |

Wang XT, Yu K, Wu SX, et al. ESRGAN: Enhanced super-resolution generative adversarial networks. Proceedings of European Conference on Computer Vision. Munich: Springer, 2019. 63–79.

|

| [57] |

Soh JW, Park GY, Jo J, et al. Natural and realistic single image super-resolution with explicit natural manifold discrimination. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 8114–8123.

|

| [58] |

Ma C, Rao YM, Cheng YA, et al. Structure-preserving super resolution with gradient guidance. Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 7766–7775.

|

| [59] |

Lugmayr A, Danelljan M, van Gool L, et al. SRFlow: Learning the super-resolution space with normalizing flow. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 715–732.

|

| [60] |

Tong T, Li G, Liu XJ, et al. Image super-resolution using dense skip connections. Proceedings of 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 4809–4817.

|

| [61] |

Han W, Chang SY, Liu D, et al. Image super-resolution via dual-state recurrent networks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 1654–1663.

|

| [62] |

Lai WS, Huang JB, Ahuja N, et al. Fast and accurate image super-resolution with deep Laplacian pyramid networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(11): 2599-2613. DOI:10.1109/TPAMI.2018.2865304 |

| [63] |

Wang YF, Perazzi F, McWilliams B, et al. A fully progressive approach to single-image super-resolution. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE, 2018. 977–986.

|

| [64] |

Wei YX, Gu SH, Li YW, et al. Unsupervised real-world image super resolution via domain-distance aware training. Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13380–13389.

|

| [65] |

Yuan Y, Liu SY, Zhang JW, et al. Unsupervised image super-resolution using cycle-in-cycle generative adversarial networks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE, 2018. 814–823.

|

| [66] |

Zhu JY, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks. Proceedings of 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2242–2251.

|

| [67] |

Shocher A, Cohen N, Irani M. Zero-shot super-resolution using deep internal learning. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 3118–3126.

|

| [68] |

Soh JW, Cho S, Cho NI. Meta-transfer learning for zero-shot super-resolution. Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 3513–3522.

|

| [69] |

Liang JY, Cao JZ, Sun GL, et al. SwinIR: Image restoration using swin transformer. Proceedings of 2021 IEEE/CVF International Conference on Computer Vision Workshops. Montreal: IEEE, 2021. 1833–1844.

|

| [70] |

Gu JJ, Lu HN, Zuo WM, et al. Blind super-resolution with iterative kernel correction. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 1604–1613.

|

| [71] |

Luo ZX, Huang Y, Li S, et al. Unfolding the alternating optimization for blind super resolution. Proceedings of the 34th Conference on Neural Information Processing Systems. Vancouver: NeurIPS, 2020. 1–12.

|

2022, Vol. 31

2022, Vol. 31