2. 广东工业大学 自动化学院, 广州 510006;

3. 广东工业大学 网络信息与现代教育技术中心, 广州 510006

2. School of Automation, Guangdong University of Technology, Guangzhou 510006, China;

3. Center of Campus Network & Modern Educational Technology, Guangdong University of Technology, Guangzhou 510006, China

目前随着互联网的发展, 网络视频和社交平台日渐火热, 诸如国内的哔哩哔哩、抖音、快手, 国外的YouTube、Twitter、TikTok等, 这些平台上的网络视频包含了大量用户对某个事物所发表的观点和评价, 这些点评数据蕴含着用户的情绪信息, 挖掘这些用户的情绪信息不仅有利于平台商家对用户进行有针对性的产品推送, 对一些需要获得用户情绪状态的互联网服务型行业有所帮助, 而且在面对某些社会突发事件时, 也能够协助相关部门掌握社会舆论的走向[1].

目前大多数的情感分析方法存在以下两个问题: (1)基于单模态数据的分析方法角度单一, 无法全面地反映人类复杂的情感表达. (2)目前大部分基于多模态数据的情绪分析方法没有充分考虑并融合时序数据的模态内和跨模态的话语间时序信息关联, 导致情绪分析的准确率较低. 为解决以上问题, 本文使用时序多模态数据, 在前人的研究基础上, 改进了多模态情绪分析模型, 提出一种基于话语间时序多模态数据的情绪分析方法.

1 相关研究情绪分析是一个涉及人工智能、计算机视觉、自然语言处理等多个多学科交叉的研究领域[2]. 早期的情绪分析大多是基于单一模态数据的, 目前主流方法是针对人脸表情和文本的情绪分析. Connie等人[3]使用由3个子网络构成的卷积神经网络在CK+和FER2013数据集上进行人脸表情情感识别, 在6类的情感分类中得到良好的识别效果. 李婷婷等人[4]针对微博短文本数据, 使用传统的SVM和CRF组合方法进行情感分析, 并选用不同的特征组合得到了最优的分析效果. 由于深度学习方法的兴起, 研究人员也开始在文本情感分析上使用深度学习模型. Chen等人[5]基于TF-IDF特征, 使用卷积神经网络进行文本情感分类, 相比传统的机器学习方法准确率得到了显著的提升. 曹宇等人[6]使用BGRU对文本的上下文信息进行提取分析, 实验表明加入上下文信息后能够有效提高情绪分析的准确性.

由于单模态数据分析方法存在一定的局限性, 无法应对某些真实的场景, 因此研究者们开始探索使用两种或以上模态数据的研究方法, 同时因为网络视频这种多模态数据载体的兴起, 近年来针对视频数据集的多模态情感分析成为了一个研究热点.

在多模态情绪分析研究领域, 目前大多数研究是基于文本、语音和视觉3种模态信息. Baltrušaitis等人[7]将多模态机器学习分为模态表示、模态传译、模态对齐、模态融合和合作学习5个方面[8], 其中模态融合的效果对分析结果的准确性有很大的影响[9]. 模态融合主要分为特征级融合(早期融合)和决策级融合(晚期融合), 二者的区别在于前者是将单模态特征直接进行融合后分析, 后者则是单独分析单模态特征后再对结果进行融合分析, 现在有研究者将这两种方式相结合并称之为混合融合. Pérez-Rosas等人[10]使用OpenEAR和CERT在MOUD多模态数据集中提取语音和面部的情感特征, 并且将单词与每个话语转录内的频率对应的值相关联, 得到加权特征图作为文本的情感特征, 最后将3种模态特征进行特征级融合后使用SVM分析, 在该数据集上得到良好的识别效果. Yu等人[11]针对中文微博数据, 使用CNN和DNN分别分析文本和视觉情感, 最后通过决策级融合的方法对分析结果进行融合, 在中文微博数据集上获得了最优的结果. Zadeh等人[12]提出一种张量融合方法(TFN), 使用张量乘法将3种单模态特征数据融合在一起, 最后使用MLP神经网络进行分析预测, 在MOSI数据集上获得较好的准确率, 但这种方法没有利用话语级别的上下文时序信息特征, 而且时间复杂度和空间复杂度极高. 后来他们又提出了一种分层的动态融合图方法[13], 将三种模态信息两两组合, 首次在MOSEI数据集上获得较高的识别准确率且具有一定的可解释性. Poria等人[14]提出一种非端到端的方法, 使用两层LSTM网络分别对单模态和组合模态进行训练, 这种方法虽然利用了模态内的话语上下文信息, 但非端到端的方法增加了分析的复杂性, 不利于应用到实际.

近年来, 研究者们希望模型能够像人类在观察事物的时候, 能够把注意力集中在特征明显的部分, 因此原本被用于机器翻译领域的注意力机制被情绪分析领域的研究者们广泛关注, 并尝试在自己的模型中加入注意力机制, 使得模型能够关注数据中对情绪影响较大的特征. 朱烨等人[15]融合了卷积神经网络和注意力机制对评论文本进行情绪分析, 实验表明使用注意力加权的方式识别准确率高于单一的CNN模型. Poria等人[16]对其原模型进行了改进, 先在单模态内部加入注意力机制, 随后在话语层面使用LSTM网络提取上下文信息, 然后再对拥有上下文信息的序列使用注意力模块, 相比他们原来的模型, 准确率有了较大的提升. Ghosal等人[17]提出了MMMU-BA模型, 对双模态使用注意力机制, 挖掘两个模态之间的上下文交互作用, 但该方法没有考虑增强单模态的上下文关联, 因此仍然存在改进的空间.

2 基于话语间时序多模态数据的情绪分析方法

|

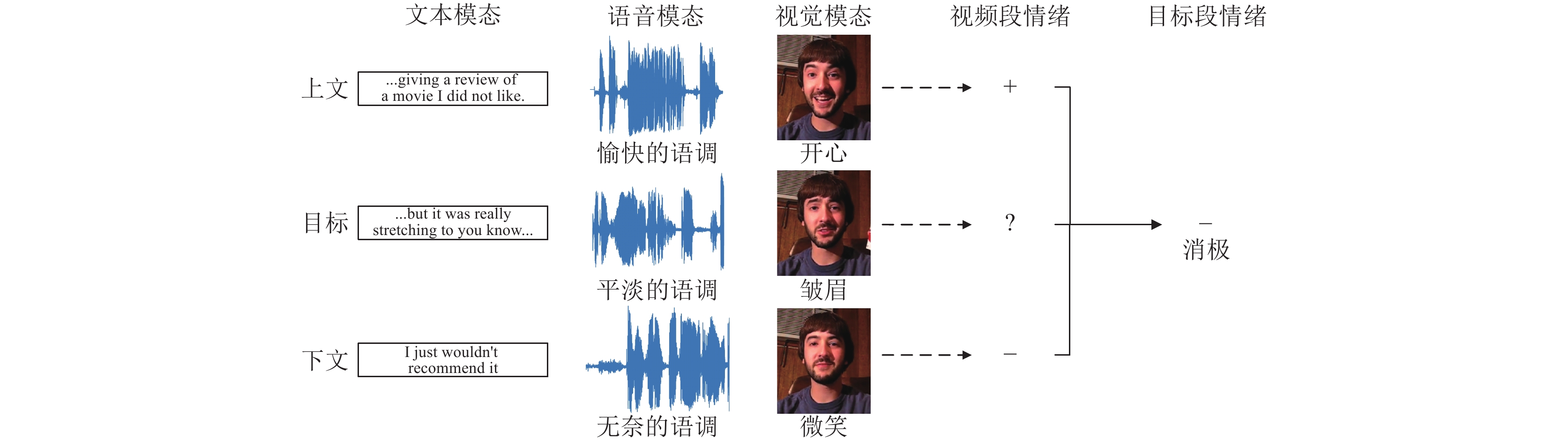

图 1 时序多模态数据上下文影响情感分析的例子 |

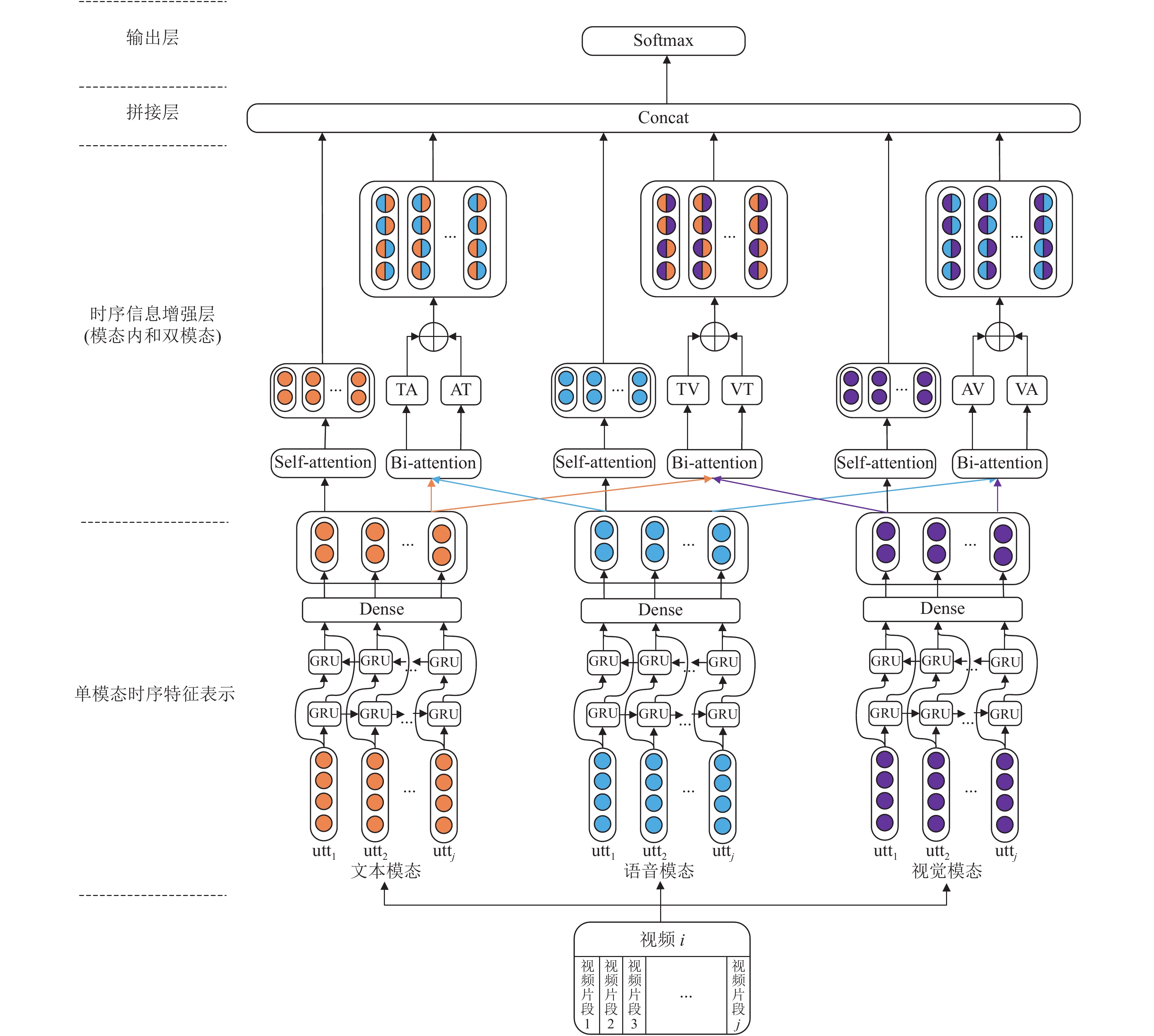

本文基于话语间时序多模态数据的情绪分析模型框架如图2所示, 模型主要由以下4个部分组成.

(1)单模态时序特征表示. 该部分主要是获取话语之间的上下文关联, 同时将各模态特征数统一到相同的维度.

(2)模态内时序信息增强. 这部分的任务是增强上一层所得到的各模态内部的上下文信息关联.

(3)双模态时序信息交互. 该层主要是对单模态时序信息特征进行跨模态融合, 不同模态两两组合, 并且挖掘跨模态的上下文关联.

(4)情绪分类. 将各层输出的特征矩阵进行拼接后获得多模态融合信息, 进行情绪分类.

2.1 单模态时序特征表示| $ \overrightarrow{{h}_{t}}=\overrightarrow{GRU}\left({h}_{t-1}, {x}_{t}\right) $ | (1) |

| $ \overleftarrow{{h}_{t}}=\overleftarrow{GRU}\left({h}_{t-1}, {x}_{t}\right) $ | (2) |

| $ {h}_{t}=\left[\overrightarrow{{h}_{t}}, \overleftarrow{{h}_{t}}\right] $ | (3) |

经过Bi-GRU层的处理后, 可以获得一个隐藏状态序列

这一部分主要是使用自注意力强化第2.1节中模态内部的上下文时序关联.

如图3所示, 首先将特征矩阵与其转置相乘, 获得上下文关联话语特征权重矩阵

| $ S=X \otimes {X}^{\rm T} $ | (4) |

| $ {S{'}}_{(i, j)}=\frac{{\rm{e}}^{{S}_{(i, j)}}}{\displaystyle\sum _{k=1}^{u}{\rm{e}}^{{S}_{(i, k)}}}, i, j=\mathrm{1, 2}, \cdots , u $ | (5) |

| $ A={S}{{'}} \otimes X $ | (6) |

| $ O=A \odot X $ | (7) |

|

图 2 基于时序多模态数据的情绪分析模型框架图 |

|

图 3 单模态内上下文交互增强方法 |

2.3 双模态时序信息交互

| $ {S}_{at}={X}_{t} \otimes {X}_{a}^{\rm T},\;{S}_{ta}={X}_{a} \otimes {X}_{t}^{\rm T} $ | (8) |

| $ {M}_{1(i, j)}=\frac{{\rm{e}}^{{S}_{at(i, j)}}}{\displaystyle\sum _{k=1}^{u}{\rm{e}}^{{S}_{at(i, k)}}},\;i, j=\mathrm{1, 2}, \cdots , u $ | (9) |

| $ {M}_{2(i, j)}=\frac{{\rm{e}}^{{S}_{ta(i, j)}}}{\displaystyle\sum _{k=1}^{u}{\rm{e}}^{{S}_{ta(i, k)}}},\;i, j=\mathrm{1, 2}, \cdots , u $ | (10) |

然后将相关性分数矩阵与关联模态特征矩阵相乘, 得到跨模态时序信息交互注意力表征矩阵

| $ {A}_{1}={M}_{1} \otimes {X}_{a},\;{A}_{2}={M}_{2} \otimes {X}_{t} $ | (11) |

最后将其与目标模态的特征矩阵逐元素相乘得到

| $ {B}_{1}={A}_{1} \odot {X}_{t},\;{B}_{2}={A}_{2} \odot {X}_{a} $ | (12) |

| $ {O}_{ta}=\left[{B}_{1}, {B}_{2}\right] $ | (13) |

同理, 文本-视觉和声音-视觉的双模态时序信息交互矩阵也用同样的计算方法获得, 分别记为

记

| $ P\left({\hat{y}}_{i}^{j}=c\right)=\frac{{\rm{e}}^{{x}_{i, c}^{j}}}{{\displaystyle\sum }_{k=0}^{c}{\rm{e}}^{{x}_{i, k}^{j}}},\;i=\mathrm{1, 2}, \cdots ,V,j=\mathrm{1, 2}, \cdots , u $ | (14) |

| $ loss=-\frac{1}{{\displaystyle\sum }_{i=1}^{V}{U}_{i}}\displaystyle\sum _{i=1}^{V}\displaystyle\sum _{j=1}^{{U}_{i}}\sum _{c=1}^{C}{y}_{i, c}^{j}{\log}_{2}\left({\hat{y}}_{i, c}^{j}\right) $ | (15) |

其中,

本文使用卡内基梅隆大学的研究者提供的MOSI数据集和MOSEI数据集对模型进行验证.

(1) MOSI数据集

该数据集包含了YouTube上的93个关于电影评论的视频, 每个视频都被切分为若干个视频片段并且打上情绪标签, 单个视频最多有63个话语片段, 总计2 199个片段. 本文使用Poria等人[14]提供的处理过的MOSI数据集, 文本模态、声音模态和视觉模态的话语特征维度分别为100、73和100, 由于只提供了训练集和测试集, 因此本文从训练集中抽取了一部分作为验证集, 得到训练集、验证集和测试集的视频数量为52、10、31, 由于每个视频的话语片段数量不一, 因此对不足63片段数的样本进行补0.

(2) MOSEI数据集

该数据集包含了3 228个视频, 单个视频的话语片段数最多为98, 总计22 677个视频片段. 本文使用卡内基梅隆大学提供的多模态数据SDK进行处理, 从原始数据集中提取包含话语间上下文时序信息的特征, 最终得到文本、声音和视觉3个模态的话语特征维度分别为300、74和35, 训练集、验证集和测试集的视频数量为2 250、300和678, 同样的, 对不足98个片段数的样本进行补0.

3.2 参数设置本实验在Ubuntu 16.04操作系统上完成, 内存大小为32 GB, GPU型号为GTX3070, CPU型号为3.7 GHz主频的i5-9600k, 深度学习框架使用TensorFlow 2.4的GPU加速版本. 模型中提到的Bi-GRU网络的隐藏层单元数为300, 后续全连接层神经元数量为100, 训练批次(batch_size)大小为64, 共迭代(epoch) 50次. 使用Adam优化器更新模型参数, 学习率为0.001. 同时在训练过程中, 使用dropout降低过拟合, 对于MOSI和MOSEI数据集, 模型设置dropout值分别为0.3和0.5. 最后使用准确率和F1值作为模型的评价指标.

3.3 基线模型选择(1) TFN[12]: 该模型由Zadeh等人在2017年提出, 直接将3种模态的特征数据统一到同一维度后, 进行张量乘法操作, 形成一个张量后输入到分析网络中, 没有考虑时序信息特征, 而且时间复杂度和空间复杂度都很高.

(2) MFN[18]: 该模型由Zadeh等人在2018年提出, 使用一种多视图顺序学习的神经网络结构, 使用LSTM网络挖掘一个话语中的前后文关联与跨模态交互.

(3) BC-LSTM[14]: 该方法是由Poria等人在2017年提出的一种非端到端学习方法, 使用双向LSTM网络先对单模态数据进行训练, 再将训练特征拼接起来作为多模态融合数据进行训练.

(4) GMFN[13]: 该模型由Zadeh等人在2018年提出, 它以分层的方式动态融合模态, 首次在MOSEI数据集上取得较好的结果.

(5) MMMU-BA[17]: 该模型由Ghosal等人在2018年提出, 它使用一种跨模态注意力机制充分融合了双模态的时序特征信息, 但并没有充分考虑到单模态内的时序信息的交互作用.

3.4 实验结果与分析| 表 1 模型中单一结构的效果对比(%) |

本文模型与其他模型的对比如表2所示. 从表中可以看到, 前3个模型都没有利用到多模态数据的时序特征, 仅仅是针对单个话语进行训练与识别, 而BC-LSTM和MMMU-BA模型利用到了数据的时序特征, 准确率与F1值都有明显的提高, 证明了话语级的时序信息特征确实能够提高情绪分析的识别. 本文的方法对前人的模型进行了改进, 同时融合模态内的时序信息特征和双模态的时序信息特征, 在MOSEI数据集上准确率比基准模型最高值提高了0.32%, 而F1值提高了1.96%, 在MOSI数据集上, 准确率提高了0.15%, 而F1值虽然比最高值低, 但仍然比非话语级时序的分析高. 由此可见, 本文提出的方法是能够提高情绪分析的识别准确率, 同时模型的稳健性更高.

| 表 2 不同模型的效果对比(%) |

4 结语

| [1] |

王雨竹, 谢珺, 陈波, 等. 基于跨模态上下文感知注意力的多模态情感分析. 数据分析与知识发现, 2021, 5(4): 49-59. |

| [2] |

刘继明, 张培翔, 刘颖, 等. 多模态的情感分析技术综述. 计算机科学与探索. 2021, 15(7): 1165–1182.

|

| [3] |

Connie T, Al-Shabi M, Cheah WP, et al. Facial expression recognition using a hybrid CNN-SIFT aggregator. Proceedings of the 11th International Workshop on Multi-disciplinary Trends in Artificial Intelligence. Gadong: Springer, 2017. 139–149.

|

| [4] |

李婷婷, 姬东鸿. 基于SVM和CRF多特征组合的微博情感分析. 计算机应用研究, 2015, 32(4): 978-981. DOI:10.3969/j.issn.1001-3695.2015.04.004 |

| [5] |

Chen JY, Yan SK, Wong KC. Verbal aggression detection on Twitter comments: Convolutional neural network for short-text sentiment analysis. Neural Computing and Applications, 2020, 32(15): 10809-10818. DOI:10.1007/s00521-018-3442-0 |

| [6] |

曹宇, 李天瑞, 贾真, 等. BGRU: 中文文本情感分析的新方法. 计算机科学与探索, 2019, 13(6): 973-981. DOI:10.3778/j.issn.1673-9418.1806018 |

| [7] |

Baltrušaitis T, Ahuja C, Morency LP. Multimodal machine learning: A survey and taxonomy. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(2): 423-443. DOI:10.1109/TPAMI.2018.2798607 |

| [8] |

林子杰, 龙云飞, 杜嘉晨, 等. 一种基于多任务学习的多模态情感识别方法. 北京大学学报(自然科学版), 2021, 57(1): 7-15. |

| [9] |

Wu LZ, Oviatt SL, Cohen PR. Multimodal integration—A statistical view. IEEE Transactions on Multimedia, 1999, 1(4): 334-341. DOI:10.1109/6046.807953 |

| [10] |

Pérez-Rosas V, Mihalcea R, Morency LP. Utterance-level multimodal sentiment analysis. Proceedings of the 51st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Sofia: Association for Computational Linguistics, 2013. 973–982.

|

| [11] |

Yu YH, Lin HF, Meng JN, et al. Visual and textual sentiment analysis of a microblog using deep convolutional neural networks. Algorithms, 2016, 9(2): 41. DOI:10.3390/a9020041 |

| [12] |

Zadeh A, Chen MH, Poria S, et al. Tensor fusion network for multimodal sentiment analysis. Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen: Association for Computational Linguistics, 2017. 1103–1114.

|

| [13] |

Zadeh AAB, Liang PP, Poria S, et al. Multimodal language analysis in the wild: CMU-MOSEI dataset and interpretable dynamic fusion graph. Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Melbourne: Association for Computational Linguistics, 2018. 2236–2246.

|

| [14] |

Poria S, Cambria E, Hazarika D, et al. Context-dependent sentiment analysis in user-generated videos. Proceedings of the 55th annual meeting of the association for computational linguistics (Volume 1: Long Papers). Vancouver: Association for Computational Linguistics, 2017. 873–883.

|

| [15] |

朱烨, 陈世平. 融合卷积神经网络和注意力的评论文本情感分析. 小型微型计算机系统, 2020, 41(3): 551-557. DOI:10.3969/j.issn.1000-1220.2020.03.018 |

| [16] |

Poria S, Cambria E, Hazarika D, et al. Multi-level multiple attentions for contextual multimodal sentiment analysis. Proceedings of 2017 IEEE International Conference on Data Mining. New Orleans: IEEE, 2017. 1033–1038.

|

| [17] |

Ghosal D, Akhtar S, Chauhan D, et al. Contextual inter-modal attention for multi-modal sentiment analysis. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: Association for Computational Linguistics, 2018. 3454–3466.

|

| [18] |

Zadeh A, Liang PP, Poria S, et al. Multi-attention recurrent network for human communication comprehension. Proceedings of the 32nd AAAI Conference on Artificial Intelligence. New Orleans: AAAI, 2018. 5642–5649.

|

2022, Vol. 31

2022, Vol. 31