在日常生活中, 图像随处可见. 但受成像设备分辨率、物体与成像设备距离等因素影响, 获得的图像分辨率较低, 无法满足实际应用的需求. 因此, 图像超分辨率重建技术应运而生. 该技术可以将模糊低分辨率图像重建为高分辨率图像[1], 目前已被广泛应用于人脸识别[2]、社会安全[3]、医学成像[4]、军事遥感[5]等领域.

早期的图像超分辨率重建算法以基于传统机器学习的方法为主[6], 常见的包括基于重建[7]和基于插值[8]等方法. 这些方法具有较大的局限性, 例如, 基于重建方法[7]只能处理结构比较简单的图像; 基于插值方法[8]得到的重建图像的边缘容易出现模糊现象. 近年来, 随着深度学习的蓬勃发展, 越来越多学者将深度学习的方法引入该领域[9]. Dong 等人[10]最早从事相关研究, 采用一个3层卷积神经网络实现单张图像的超分辨率重建, 该方法提高了重建图像的质量, 但无法满足实时性要求, 且网络训练难于收敛. 针对该问题, Dong 等人[11]在此基础上对网络进行改进, 缩小网络的输入特征维数, 采用更小的过滤器尺寸, 使网络结构更为紧凑, 从而有效地加快了网络的训练过程. 为了减少网络的参数量, Tai等人[12]引入了残差学习和递归学习, 有效防止梯度爆炸或消失问题. Lai 等人[13]提出基于拉普拉斯金字塔结构的 LapSRN 算法, 采用逐级放大来感知更多信息, 通过参数共享能够较高质量地实现实时超分辨率重建. Zhang等人[14]提出能够充分融合低分辨率图像中所有层次特征的残差密集网络(residual dense network, RDN), 该算法取得较好的重建效果, 但模型参数量过多, 存在特征冗余.

受生成对抗网络(generative adversarial networks, GAN)[15]启发, Ledig 等人[16]提出了超分辨率生成对抗网络(super-resolution generative adversarial networks, SRGAN), 通过生成网络和判别网络不断交替对抗训练, 并引入感知损失函数提高图像的视觉效果, 使得重建图像的纹理细节更为清晰. 但SRGAN 模型的参数量过多, 导致训练收敛速度较慢, 此外, 重建图像的高频纹理往往过于锐化, 导致部分细节出现扭曲现象, 而且在一些原本光滑的地方也产生尖锐的噪声. 针对 SRGAN 算法存在的问题, 本文提出了一种改进的 SRGAN 算法, 一方面, 优化了它的网络结构, 另一方面, 提出了联合感知损失, 从而获得更优的图像超分辨率重建性能. 本文主要工作如下:

(1) 针对模型参数量多而导致训练收敛速度慢的问题, 本文提出了稀疏残差密集网络(sparse residual dense network, SRDN), 并将其代替传统的 SRResNet 作为生成网络; 此外, 采用深度可分离卷积[17]思想改进生成网络, 进一步降低参数量; 移除生成网络的 BN (batch normalization)层, 提高模型的泛化能力.

(2) 针对重建图像的高频纹理过于锐化而导致部分细节扭曲、噪声过多的问题, 本文分析并改进了感知损失函数, 提出融合 VGG[18]的低频特征和高频特征的联合感知损失, 并结合均方误差损失来定义总损失.

(3) 分别在Set5[19]、Set14[20]、BSD100[21]数据集进行实验, 对本文算法的性能进行评价, 证明本文算法的优越性.

1 SRGAN网络模型SRGAN网络由一个生成网络和一个判别网络组成. 生成网络的主要作用是将低分辨率图像重建成高分辨率图像; 判别网络的主要作用则是判断给定图像是真实图像还是生成图像[16]. 两个网络通过相互对抗的训练过程, 使得生成网络最终可以将低分辨率图像重建为高分辨率图像. SRGAN 网络框架如图1所示.

|

图 1 SRGAN 网络框架 |

SRGAN 网络模型能够提高重建图像的感知质量, 但其参数量过多, 训练收敛速度较慢, 重建图像高频纹理过度锐化, 导致部分细节扭曲、产生噪声. 因此, 本文对 SRGAN 的网络结构进行改进, 采用 SRDN (移除了 BN 层)代替传统的 SRResNet 作为生成网络, 以实现对低分辨率图像特征的充分利用, 同时利用 SRDN 稀疏性的连接方式和深度可分离卷积[17]思想, 减少模型的参数量; 此外, 融合 VGG 中低频特征和高频特征的联合感知损失, 结合均方误差损失对网络的感知损失函数进行改进.

2 基于改进的SRGAN图像超分辨率重建算法 2.1 利用SRDN网络构建生成网络模型本文采用稀疏残差密集网络 SRDN 代替传统的 SRResNet 作为生成网络, 同时, 为了进一步减少计算量, 在稀疏残差密集块(sparse residual dense block, SRDB)中融入深度可分离卷积[17]的思想, 即将 SRDB 中3×3的卷积替换为1×3和3×1的卷积. SRDN以及SRDB的构成将在第3.1.1节详细阐述.

传统的 SRGAN 网络利用卷积层加 BN 层的方式, 让每一层的值在一个有效范围内进行传递, 加快网络收敛速度. 然而, 研究表明[22], 在 GAN 框架下进行训练或者在模型的网络层数较多时, BN 层很容易引入伪影问题, 并且会对模型的泛化能力产生一定的限制. 这些伪影一般情况下可能会出现在迭代时或者是不同设置之间, 不利于性能的稳定. 因此, 我们移除生成网络中的BN层, 从而保证网络训练的稳定性, 同时令模型的泛化能力得到提高. 此外, 移除BN层也有利于减少计算复杂度. 本文采用的SRDN网络结构如图2所示.

|

图 2 SRDN 网络结构 |

2.1.1 稀疏残差密集网络

稀疏残差密集网络 SRDN 是在残差密集网络 RDN[14]的基础上改进而来. RDN 结合残差网络和密集网络两者的特性, 其中, 残差网络[23]利用残差学习的思想, 对低频特征和通过卷积层提取的特征进行加权求和, 有效降低了训练误差; 密集网络[24]则引入了密集跳跃连接, 从而实现低频和高频特征的有效结合, 缓解了梯度消失的问题.

RDN 的网络主体架构是利用残差密集块 RDB, 通过特征相连的方式聚合输出, 其连接方式包含残差连接和密集连接. 残差连接和密集连接有一定的差异, 因而RDN 通过这两种连接进行聚合存在以下问题: (1) 密集连接的数量和参数量的增长速率为O(n2), n是网络深度, 这表明随着网络的加深, 网络的参数量将爆炸性增长. (2) 密集连接很大一部分都用于处理先前的特征表示, 这表明密集聚合将始终保持一些不相关的状态, 存在特征冗余.

针对 RDN 网络在聚合连接上的问题, 本文结合稀疏聚合网络的思想对 RDN 进行改进, 提出了稀疏残差密集网络 SRDN. 对于RDN中单个模块的聚合连接, 其公式如下:

| $ {y_0} = {F_0}(x) $ | (1) |

| $ \begin{split} \\ {y_k} = {F_k}\left( { \otimes \left( {{y_{k - 1}}, {y_{k - 2}}, {y_{k - 3}}, {y_{k - 4}}, \cdots, {y_0}} \right)} \right) \end{split} $ | (2) |

式中, x表示输入特征, F表示卷积操作, k表示网络层数, 满足

| $ {y_k} = {F_k}\left( { \otimes \left( {{y_{k - {c^0}}}, {y_{k - {c^1}}}, {y_{k - {c^2}}}, {y_{k - {c^3}, }}{y_{k - {c^4}, }}\cdots ,{y_{k - {c^k}}}} \right)} \right) $ | (3) |

式中, c表示正整数, k表示满足

SRDN 的网络结构和 RDN 类似, 但我们以式(3)聚合每一个输出块, 从而达到相同的计算资源可以构建更多网络层的目的.

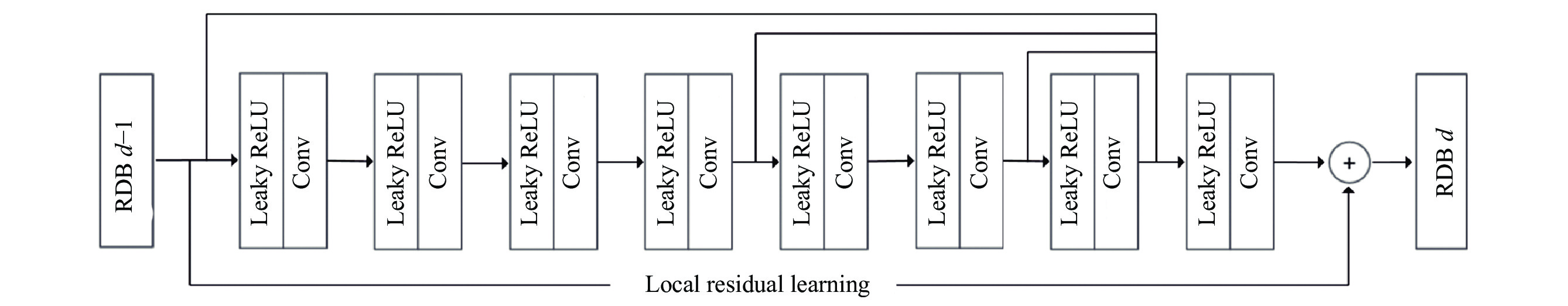

类似的, 我们采用基于稀疏聚合网络的思想对残差密集块 RDB 进行改进, 提出了稀疏残差密集块 SRDB. 与 RDB 类似, SRDB 允许将前一个 SRDB 的状态与接下来的其他层相连接, 从而形成连续内存机制, 不同之处在于采用式(3)进行不同层之间的特征传递, 这种连接方式有利于避免无关特征参与到网络的运算中造成特征冗余. SRDB 的连接方式如图3所示.

|

图 3 SRDB 的连接方式 |

2.1.2 深度可分离卷积

传统的 SRGAN 模型存在参数量过多而导致训练收敛速度较慢的问题, 为了减少计算量, 本文在稀疏性连接的基础上进一步采用深度可分离卷积(depthwise separable convolution, DSC)[17]的思想来改进生成网络, 将稀疏残差密集块 SRDB 中3×3的卷积替换为1×3和3×1的卷积.

深度可分离卷积包含深度卷积和逐点卷积[17]. 卷积过程通常是先进行深度卷积, 再进行逐点卷积. 图4分别展示了标准卷积和深度可分离卷积的卷积核结构.

|

图 4 标准卷积和深度可分离卷积的卷积核结构 |

为了比较两种卷积的参数计算量, 我们假设输入K通道大小为A×B的特征图, 采用大小为C×C的卷积核进行卷积后, 输出L通道大小为A×B的特征图. 那么, 标准卷积的参数计算量为:

| $ \begin{split} \\ {P_{\rm SC}} = K \times A \times B \times C \times C \times L \end{split} $ | (4) |

深度可分离卷积的参数计算量为:

| $ {P_{\rm DSC}} = K \times A \times B \times C \times C + A \times B \times K \times L $ | (5) |

因此, 两种结构参数计算量之比为:

| $ \alpha = \frac{{{P_{\rm DSC}}}}{{{P_{\rm SC}}}} = \frac{1}{L} + \frac{1}{{{C^2}}} $ | (6) |

由式(6)可以看出, 当输出通道和卷积核的大小远大于1的时候, 采用深度可分离卷积代替标准卷积, 可显著降低模型的参数量.

2.2 判别网络模型的构建本文的判别网络模型如图5所示, 参考了 Ledig等人[16]提出的 SRGAN 模型中的判别器网络结构. 判别器网络包含8次卷积过程, 所有的卷积层, 除用于接收图像的前端卷积层外, 其它均连接 BN 层, 同时选取 Leaky ReLU 作为激活函数. 随着卷积次数的增多, 提取的特征图数量不断增多, 而特征图的大小在持续变小, 最后的连接层则是对网络所有的特征作统一处理, 并通过最终的激活函数 Sigmoid 来对输出的图像进行概率的预测.

2.3 联合感知损失SRGAN 没有对传统的均方误差损失(MSE)作优化, 而是提出一种新的感知损失函数, 其中包括内容损失和对抗损失. 由于较深的网络层表示的特征更加抽象, 因此 SRGAN 将内容损失定义在 VGG-54 (VGG19 网络中第5次池化前的第4个卷积层之前的特征图)的高频特征的特征图上, 这些深层的特征图只关注内容, 而对抗损失则关注纹理细节. VGG-22 (VGG19 网络中第2次池化前的第2个卷积层之前的特征图)定义在较浅的网络层, 提取的特征大部分为轮廓、形状等低频特征[25], 这些特征无法体现出明显的细节差别. 文献[16]通过实验证明了使用高频特征作为内容损失的有效性.

|

图 5 判别网络模型 |

然而, 仅以 VGG-54 定义损失会使重建图像的纹理过于锐化, 从而导致细节部分扭曲, 容易产生尖锐的噪声, 伪影也较为严重; 而传统的MSE 虽然能使重建图像的细节较为平滑, 但不能有效重构图像的高频纹理细节信息. 为了有效地解决以上问题, 本文引入 VGG-22 和 MSE 两个部分, 与 VGG-54 一起定义为联合感知损失, 使得重建图像既能具备细节平滑的特性, 抵消一部分产生的噪声, 在主观上具有较好的视觉效果, 同时在客观评价中也能取得较好的指标结果.

研究表明[22], 激活函数激活后的特征非常稀疏, 而稀疏特征只能提供非常弱的监督效果, 会导致性能低下. 因此, 本文均采用激活函数前的特征来计算 VGG-22 和 VGG-54 两种特征图, 并对其赋予不同的权重值来对整体的对比损失进行调整, 使得重建图像的高频特征和低频特征更加均衡. 改进后的内容损失函数如式(7)所示.

| $ l_{\rm VGG}^{\rm SR} = \alpha \times {l_{\rm VGG {\text{-}} 22}} + \beta \times {l_{\rm VGG {\text{-}} 54}} $ | (7) |

式中,

本文改进后的损失函数如式(8)所示:

| $ {l^{\rm SR}} = l_{\rm VGG}^{\rm SR} + {10^{ - 2}}{l_{\rm MSE}} + {10^{ - 3}}l_{\rm Gen}^{\rm SR} $ | (8) |

式中,

本文模型采用 PyTorch 深度学习框架, 以 PyCharm 工具为平台, 通过 Python 3.6 编译实现, 并在 Google Colaboratory平台上进行训练; 在硬件层面, 本实验测试的电脑 CPU 为 i5-8250 U, 运行内存 8 GB, 显卡为 1050 Ti.

3.2 实验数据集对于训练数据, 本文采用DIV2K 数据集[26], 利用双三次插值对其中的800幅高分辨率RGB图像进行降采样, 得到低分辨率图像作为训练数据. 其中, 降采样因子r为 4, Batch_size 设置为16. 使用Adam优化器对每次的更新进行优化, 学习率初始值设为0.0001.

对于测试数据, 本文选用Set5[19]、Set14[20]和BSD100[21] 3个数据集, 对网络模型进行评价.

3.3 评价指标为了客观评价本文算法的性能, 我们使用了峰值信噪比(PSNR)和结构相似度(SSIM)[9]作为评价指标. 其中, PSNR 使用均方误差损失(MSE)来衡量两幅图像像素点之间的区别, PSNR 值愈高, 说明图像失真度愈小. SSIM 则结合了亮度、对比度、结构对图像相似性进行度量, SSIM值愈高, 说明两幅图像的相似度愈高.

此外, 本文引用文献[16]提出的平均选项得分(mean option score, MOS)作为主观评价指标, 量化不同算法的重建效果. 具体评价操作如下, 我们让20个评分员在未知图像版本的前提下使用1~5 五个分数对图像质量进行评分, 分数越高代表图像质量越好, 最后求分数平均值作为评价指标. 20个评分员分别对Set5、Set14和BSD100三个数据集的每张图片的6个版本, 即: 原始高分辨率图像(HR)、Bicubic[8]、SRCNN[10]、SRResNet[16]、SRGAN[16]和本文方法得到的超分辨率图像进行打分.

3.4 交叉验证实验为了确定式(7)中低频特征权重α和高频特征权重β的取值, 本文在Set5数据集上测试, 计算在不同的α和β取值下获得的 PSNR 值和 SSIM 值.

表1展示了不同特征权重下获得的结果. 由表1可知, 当α 和 β 都较小时, 导致所得的内容损失权重占比较小, 而均方误差损失的权重占比也很小, 因此计算损失时没有偏重的一面, 不仅导致计算得到的 PSNR 值和 SISM 值过小, 而且重建图像的视觉感知效果也并不理想. 当 α 较大而 β 较小时(如α =0.1, β =0.01), 虽然计算得到的 PSNR 值和 SSIM 值取得最好的结果, 但是高频特征损失的占比较小, 会导致重建图像在细节特征上的表现有所不足; 当 α 和 β 都较大时, 计算得到的 PSNR 值和 SSIM 值都有较好的结果, 且计算损失时偏重于感知损失上, 重建图像会有较好的视觉效果. 经过综合比较, 当α 和 β 的值分别为0.01和1时, 无论是在视角效果上还是高频细节上, 重建图像都表现较好. 因此, 本文最终确定α 和 β 值分别为0.01和1.

| 表 1 特征权重选取表 |

3.5 重建结果与评价 3.5.1 实验分析

本文采用客观评价和主观评价两种方式, 在3个公开数据集上测评Bicubic[8]、SRCNN[10]、SRResNet[16] 、SRGAN[16] 以及本文方法的重建效果. 表2展示了在不同数据集上采用不同算法获得的评价指标值. 表中的HR 表示原始高分辨率图像.

| 表 2 不同算法的评价指标对比(最优者以粗体表示) |

由表2可知, 深度残差网络 SRResNet 在 PSNR 和 SSIM 两个客观评价指标上取得了最好的结果, 但是在主观评价指标 MOS 上却表现不佳, 这是因为客观评价指标是基于对应像素点计算亮度颜色等差异, 并未考虑到人眼的视觉特性, 因而导致客观评价指标与人眼视觉感受不一致的情况. 而 SRResNet 以均方误差损失 MSE 作为损失函数, 能够取得较好的 PSNR 和 SSIM 值, 但是重建图像丢失了高频细节信息, 不能很好的符合人眼主观感受, 因而在主观评价指标 MOS 上表现不佳.

由于 MSE 损失函数会让模型过多关注图像像素之间的差异, 而忽略重建图像的固有特征. 因而, SRGAN较多关注图像感知质量上的提高, 利用感知损失和对抗损失来提升重建图像的真实感, 能够在主观评价指标MOS上表现较好. 本文提出的基于改进SRGAN的图像超分辨率重建算法, 相对于视觉感官效果较好的SRGAN而言, 其客观评价指标PSNR和SSIM值均有所提升, 且主观评价指标MOS也明显高于其他算法, 证明本文算法具有更优的综合性能.

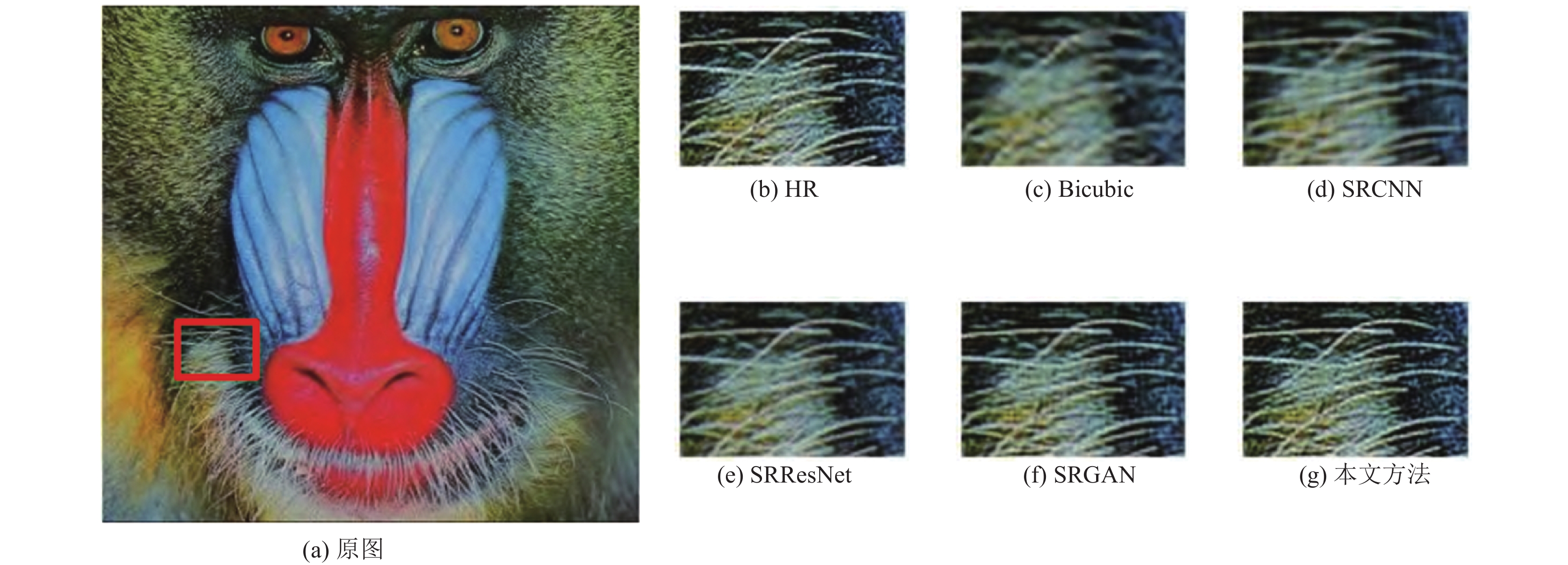

3.5.2 视觉效果对比为了更加有效地证明本文方法的重建效果, 本文选取了部分图像细节特征进行对比. 图6和图7中的原图分别是来自Set14数据集的图像baboon和comic. 在这两幅图中, 我们还展示了5种不同算法重建后的图像细节特征对比. 从图6、图7可以清晰地看出, 与其他算法相比, SRResNet虽然在客观评价指标上表现较好, 但视觉效果并不理想; SRGAN虽然能够提升重建图像的细节信息, 但与HR图像相比仍然存在部分纹理细节模糊、噪声过多、伪影也较为严重等问题. 而本文提出来的方法能够很好地弥补SRGAN的不足, 例如图6中baboon的胡须部分, 本文方法重建出来的图像, 胡须清晰可见, 根根分明; 图7中comic头上的锁饰纹理细节更加饱满, 充分证明本文方法能够更好地处理图像细节信息, 使重建图像更加清晰, 视觉效果更加优秀.

|

图 6 图像baboon的重建效果对比 |

|

图 7 图像comic的重建效果对比 |

4 总结

本文提出了一种基于改进的 SRGAN 图像超分辨率重建算法, 针对模型参数量多而导致训练收敛速度慢的问题, 采用稀疏残差密集网络 SRDN 来代替传统的 SRResNet 作为生成网络, 同时采用深度可分离卷积的思想来改进生成网络. 针对重建图像的高频纹理过于锐化而导致部分细节扭曲、噪声过多等问题, 本文分析并改进了感知损失函数, 提出融合 VGG 的低频特征和高频特征的联合感知损失, 并结合均方误差损失来定义总损失. 实验结果表明, 本文算法的PSNR、SSIM和MOS这3个评价指标结果均优于传统SRGAN算法, 重建图像的细节部分更加清晰, 整体表现出较好的鲁棒性和综合性能.

虽然本文提出的超分辨率重建算法取得了一定的效果, 但仍有待改进的地方: (1) 本文提出的 SRDN 网络主要调整了密集连接方式, 但对残差连接的研究较少, 并且本文的稀疏性网络架构未应用到其他算法上, 难以证明架构的可移植性; (2) 本文仅研究了基于 VGG 的感知损失, 但未深入探讨所有维度特征的有效性. 今后将会在此基础上研究如何进一步提升图像重建效果.

| [1] |

穆瑞娟. 基于低秩稀疏分解和字典学习的图像超分辨率重建研究[硕士学位论文]. 济南: 山东师范大学, 2017.

|

| [2] |

Nasrollahi K, Moeslund TB. Super-resolution: A comprehensive survey. Machine Vision and Applications, 2014, 25(6): 1423-1468. DOI:10.1007/s00138-014-0623-4 |

| [3] |

胡熹. 基于第二代小波的图像超分辨率重建研究[硕士学位论文]. 武汉: 华中科技大学, 2009.

|

| [4] |

Peled S, Yeshurun Y. Superresolution in MRI: Application to human white matter fiber tract visualization by diffusion tensor imaging. Magnetic Resonance in Medicine, 2001, 45(1): 29-35. DOI:10.1002/1522-2594(200101)45:1<29::AID-MRM1005>3.0.CO;2-Z |

| [5] |

Thornton MW, Atkinson PM, Holland DA. Sub-pixel mapping of rural land cover objects from fine spatial resolution satellite sensor imagery using super-resolution pixel-swapping. International Journal of Remote Sensing, 2006, 27(3): 473-491. DOI:10.1080/01431160500207088 |

| [6] |

唐艳秋, 潘泓, 朱亚平, 等. 图像超分辨率重建研究综述. 电子学报, 2020, 48(7): 1407-1420. DOI:10.3969/j.issn.0372-2112.2020.07.022 |

| [7] |

孙京, 袁强强, 李冀玮, 等. 亮度-梯度联合约束的车牌图像超分辨率重建. 中国图象图形学报, 2018, 23(6): 802-813. DOI:10.11834/jig.170489 |

| [8] |

Zhang L, Wu XL. An edge-guided image interpolation algorithm via directional filtering and data fusion. IEEE Transactions on Image Processing, 2006, 15(8): 2226-2238. DOI:10.1109/TIP.2006.877407 |

| [9] |

李泽鹏. 基于深度学习的超分辨率重建[硕士学位论文]. 南昌: 南昌大学, 2020.

|

| [10] |

Dong C, Loy CC, He KM, et al. Image super-resolution using deep convolutional networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307. DOI:10.1109/TPAMI.2015.2439281 |

| [11] |

Dong C, Loy CC, Tang XO. Accelerating the super-resolution convolutional neural network. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 391–407.

|

| [12] |

Tai Y, Yang J, Liu XM. Image super-resolution via deep recursive residual network. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2790–2798.

|

| [13] |

Lai WS, Huang JB, Ahuja N, et al. Deep Laplacian pyramid networks for fast and accurate super-resolution. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5835–5843.

|

| [14] |

Zhang YL, Tian YP, Kong Y, et al. Residual dense network for image super-resolution. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 2472–2481.

|

| [15] |

Goodfellow IJ, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets. Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014. 2672–2680.

|

| [16] |

Ledig C, Theis L, Huszár F, et al. Photo-realistic single image super-resolution using a generative adversarial network. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 105–114.

|

| [17] |

Ma SJ, Liu WK, Cai W, et al. Lightweight deep residual CNN for fault diagnosis of rotating machinery based on depthwise separable convolutions. IEEE Access, 2019, 7: 57023-57036. DOI:10.1109/ACCESS.2019.2912072 |

| [18] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. Proceedings of the 3rd International Conference on Learning Representations. San Diego, 2014.

|

| [19] |

Bevilacqua M, Roumy A, Guillemot C, et al. Low-complexity single-image super-resolution based on nonnegative neighbor embedding. Proceedings of 2012 British Machine Vision Conference. Durham: BMVA Press, 2012. 135.1–135.10.

|

| [20] |

Zeyde R, Elad M, Protter M. On single image scale-up using sparse-representations. Proceedings of the 7th International Conference on Curves and Surfaces. Avignon: Springer, 2010. 711–730.

|

| [21] |

李诚, 张羽, 黄初华. 改进的生成对抗网络图像超分辨率重建. 计算机工程与应用, 2020, 56(4): 191-196. DOI:10.3778/j.issn.1002-8331.1907-0055 |

| [22] |

Wang XT, Yu K, Wu SX, et al. ESRGAN: Enhanced super-resolution generative adversarial networks. Proceedings of European Conference on Computer Vision. Munich: Springer, 2018. 63–79.

|

| [23] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [24] |

Tong T, Li G, Liu XJ, et al. Image super-resolution using dense skip connections. Proceedings of 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 4809–4817.

|

| [25] |

Zeiler MD, Fergus R. Visualizing and understanding convolutional networks. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 818–833.

|

| [26] |

Timofte R, Gu SH, Wu JQ, et al. NTIRE 2018 challenge on single image super-resolution: Methods and results. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE, 2018. 965–96511.

|

2022, Vol. 31

2022, Vol. 31