遥感变化检测是近年来地表观测的热门课题之一. 其目的在于比较给定区域的多时相遥感影像以检测遥感信息的变化[1]. 根据场景的不同, 遥感变化检测又派生出了更多的子任务包括土地测量[2, 3]、城区扩建检测[4, 5]和自然灾害预警[6–8]等. 本文的第1节将回顾遥感变化检测的发展过程, 列举出存在的问题与解决方法.

1 遥感变化检测问题与方法 1.1 传统方法由于遥感变化检测的数据稀少, 早期的变化检测方法多以传统机器学习与图像处理为主, 包括K-means聚类[9]、主成分分析法[10]、支持向量机[11, 12]、决策树[13]和随机场[6, 14,15]. 这些方法主要的处理过程包含图像预处理、变化检测机制、图像后处理. 然而这些方法普遍存在的问题在于传统算法的变化检测机制无法提取鲁棒的特征.

1.2 基于卷积神经网络的方法随着遥感技术的不断发展, 越来越多的多时相遥感数据被采集获取. 此外, 卷积神经网络(CNN)也不断迭代更新, 在许多不同的领域里逐渐占领主导地位. 孪生网络[16]、伪孪生网络和双通道网络[17]分别给出了处理多图像输入的架构. 全卷积网络[18]使用彻底的卷积架构以实现图像像素级分割任务. U-Net[19]在此基础之上提出了带有跳跃连接的编解码结构以提升数据融合的效果. 遥感变化检测得益于这些工作, 衍生出了不同的网络框架与学习策略.

根据遥感变化检测融合数据方式的不同, 其网络框架可以被概括为编码前融合与解码前融合, 如图1所示. 解码前融合的方法[20–23]将两路图像输入分别进行编码. 其中, 编码器既可共享权重(即孪生网络)也可以独享权重(即伪孪生网络). 然后, 解码器融合编码器提取到的特征以生成遥感变化图. 此种结构的特点在于能够清晰地明确网络各个部分的处理任务, 将图像特征提取与特征融合分别安排给编码器与解码器.

编码前融合[3, 24–28]的方法在输入部分将不同时相的数据拼接起来再送入语义分割网络处理. 这种结构没有明确对编码器和解码器进行任务分工. 整个网络倾向于同时进行特征提取与特征比较. 这赋予了网络灵活性以及更鲁棒的训练条件[17].

|

图 1 变化检测网络框架示意图 |

为了对遥感变化特征进行学习, 不同的学习策略可主要归纳为逐像素与逐目标两种. 逐像素的方法通过解码器以逐个像素的方式对特征进行解码. 因此, 其后处理生成遥感变化图的方式多以阈值分割或聚类为主. 相关的数据集[20, 29–34]对图像组(多时相为一组)逐个像素进行二分类的标签制作. 其中, 正样本标签代表了遥感信息存在变化, 负样本标签表示没有变化. 然而, 不相关联地对逐个像素进行变化检测往往会导致输出的遥感变化图存在许多椒盐噪声.

逐目标的方法认为像素并不是完好地反映遥感变化对象结构与性质的最小单元[3]. 为了增强模型对遥感对象的理解, 逐目标的方法首先会对不同的输入图像进行语义分割的预测, 再通过逐目标比较的办法生成遥感变化图. 与逐像素的方法相比, 逐目标的方法对数据集标签制作要求更高且工作量更大, 需要对所有输入图像进行多分类的语义分割标签制作.

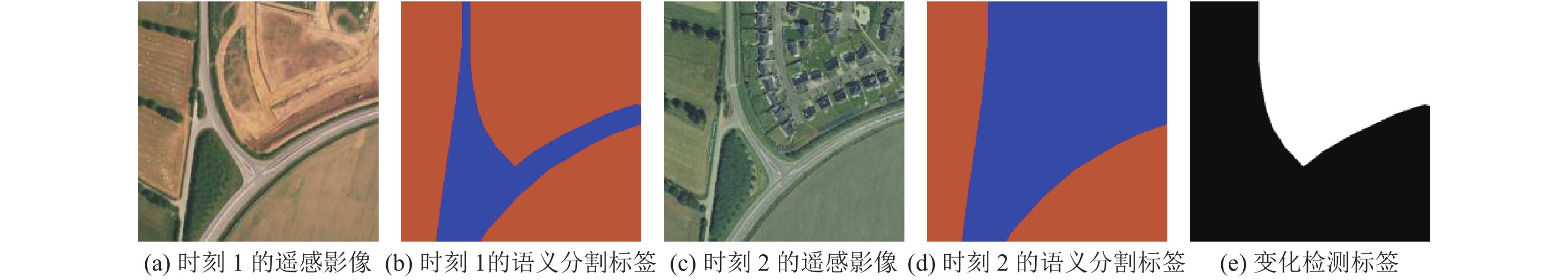

最近的研究[3, 21]表明, 逐像素和逐目标的方法也可以相互结合来实现遥感变化检测的多任务学习. 如图2所示, HRSCD数据集[3]即包含了多分类的语义分割标签又二分类的变化标签. HRSCD制作者在此基础上尝试了不同的学习策略, 证明了同时进行逐像素与逐目标学习的多任务策略是有效的.

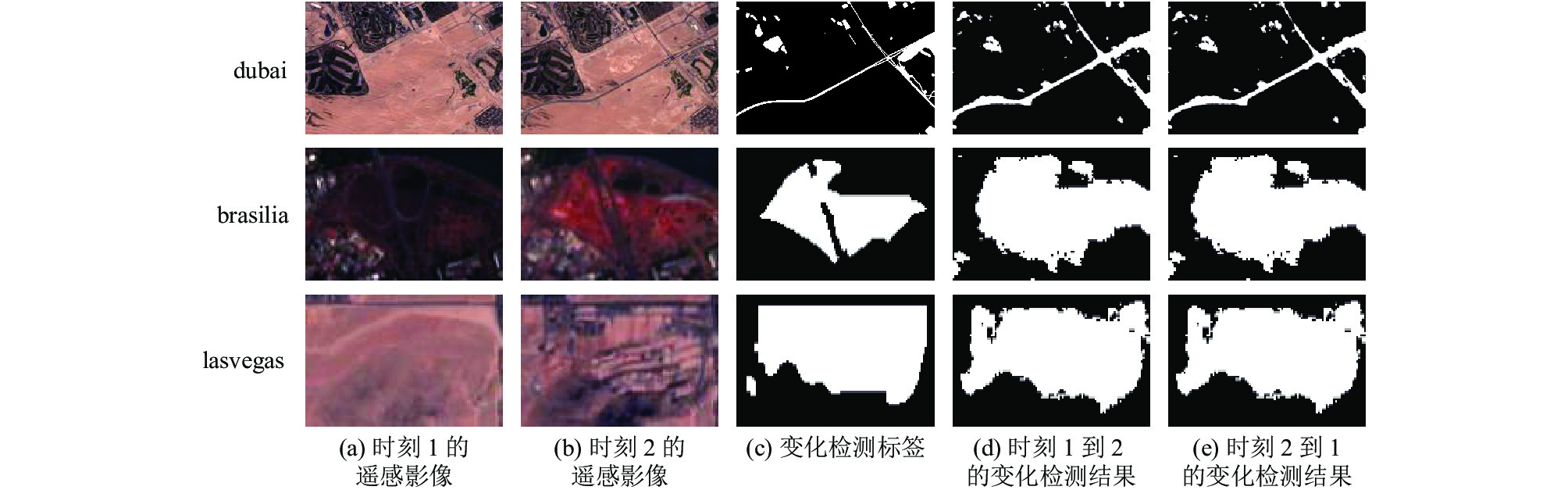

2 时序影响前述的研究中对时序的影响很少评估. 所训练的模型通常拟合从固定的一个时序点到另外一个时序点的变化. 因为时序的一致性, 所评估的模型往往能够生成效果较好的遥感变化图. 但是当图像输入的时序相反时, 这种模型的效果如何? 图3的结果表明, 所生成的遥感变化图效果不同程度上恶化了, 且所要检测的变化变化特征越细微, 模型呈现出的检测能力就越弱. 因此, 在实际应用中, 时序变化检测的模型无法进行反时序变化检测和双向时相检测的任务, 诸如季节变化, 天气变化和房屋建筑的修建拆迁等. 为了解决此问题, 最直观的方式是将数据集翻倍, 同时包含时序变化与反时序变化的数据. 然而, 此方式同时也会造成训练时间的延长. 本文希望提出一种模型调整的方法, 使模型能够在保持高精度检测的情况下获得有效的训练. 通过使模型对称化, 模型能够自适应不同的图像输入时序. 在此基础上, 本文添加了双通道孪生输入模块使模型编码器能够提取更鲁棒的特征. 为了进一步精炼编码器提取到的特征, 本文在模型跳跃连接处添加了注意力机制以实现不同感受野的特征聚合融合.

|

图 2 HRSCD数据集样本示例 |

|

图 3 FC-EF-Res[3]网络在OSCD测试集3个测试案例(dubai, brasilia, lasvegas)的遥感变化检测结果 |

本文之后部分论述安排如下: 第3节将细述所提出的模型与方法; 第4节将通过比较试验和消融实验从多个角度验证本文的模型与方法; 第5节总结全文.

3 双通道孪生网络 3.1 对称模型图3的结果表明遥感影像的时序变化和反时序变化存在着固有上的差异. 单用时序变化数据集或者反时序变化的数据集以训练模型, 模型参数都无法将两种不同的变化归纳泛化. 但是从另一个角度考虑, 模型参数本身就能归纳概括这两种不同的变化, 那么对于这种模型, 只需使用时序变化数据集或反时序变化数据集任意一个即可对其训练. 由此, 本文提出了符合这种条件的对称模型, 也即对于不同的图像输入时序, 输出结果恒等的一种模型. 同时, 本文给出了对称模型设计的3个准则: 1)对称函数: 模型中的每个多输入函数(如通道拼接、求和、求绝对值等)都应保证恒等输出; 2)对称模块: 一个对称模块应该包含多个对称函数输出或者是多个对称函数的堆叠; 3)对称模型: 对称模型由对称编码器模块、对称解码器模块和对称跳跃连接组成.

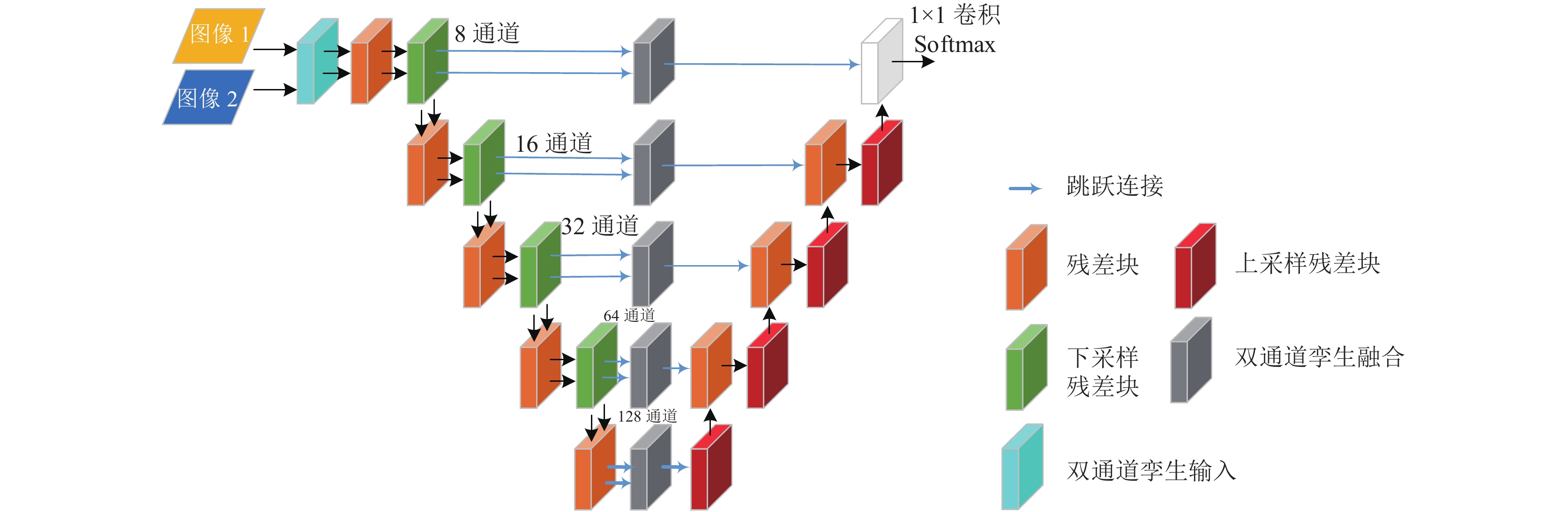

本文基于3个相关的网络FC-Siam-conc、FC-Siam-diff和FC-EF-Res进行本文的基准模型设计[3, 20]. FC-Siam-conc和FC-Siam-diff都采用了孪生U-Net结构并在解码器之前对特征进行融合, 如图1(a)所示. 两者的区别在于, FC-Siam-diff的跳跃连接输出计算的是绝对值差, 是一个对称函数. FC-EF-Res采用残差模块和瓶颈模块[35]以提升特征提取性能. 但是, 该网络采用的是编码前数据融合的结构, 如图1(b)所示, 使得整个网络失去了对称性. 本文将FC-EF-Res与FC-Siam-diff相结合构造本文的基准模型, 如图4所示. 值得注意的是FC-Siam-diff在第5个编码器模块上的跳跃连接放弃了计算绝对值, 这会导致模型的对称性被破坏. 本文在基准模型的设计中对此进行了修正, 具体情况如图中红色虚线框内所示. 本文仿照图3的实验初步训练并验证了基准模型的效果, 结果如图5所示. 结果表明, 该基准模型能够对于不同时序的图像输入保持输出恒等, 是对称模型.

|

图 4 基准模型模型结构示意图 |

|

图 5 基准模型在OSCD测试集3个测试案例(dubai, brasilia, lasvegas)的遥感变化检测结果 |

3.2 双通道孪生输入

如图6所示, 本文提出一种图像输入处理模块——双通道孪生输入. 该模块首先在图像通道维度上, 将图像分别以正时序和反时序拼接. 然后将包装完成的数据送入孪生网络进行后续的处理. 双通道孪生输入模块的设计思路主要源自图1的两种结构. 一方面, 双通道的拼接使得时序变化以及反时序变化的特征能同时且更有效地提取; 另一方面, 孪生结构符合对称模块设计原则保持了模型的对称性. 除此之外, 该模块的引入只会增加输入部分计算量, 不会对整体网络架构增加额外计算负担.

|

图 6 双通道孪生输入模块示意图 |

3.3 双通道孪生融合

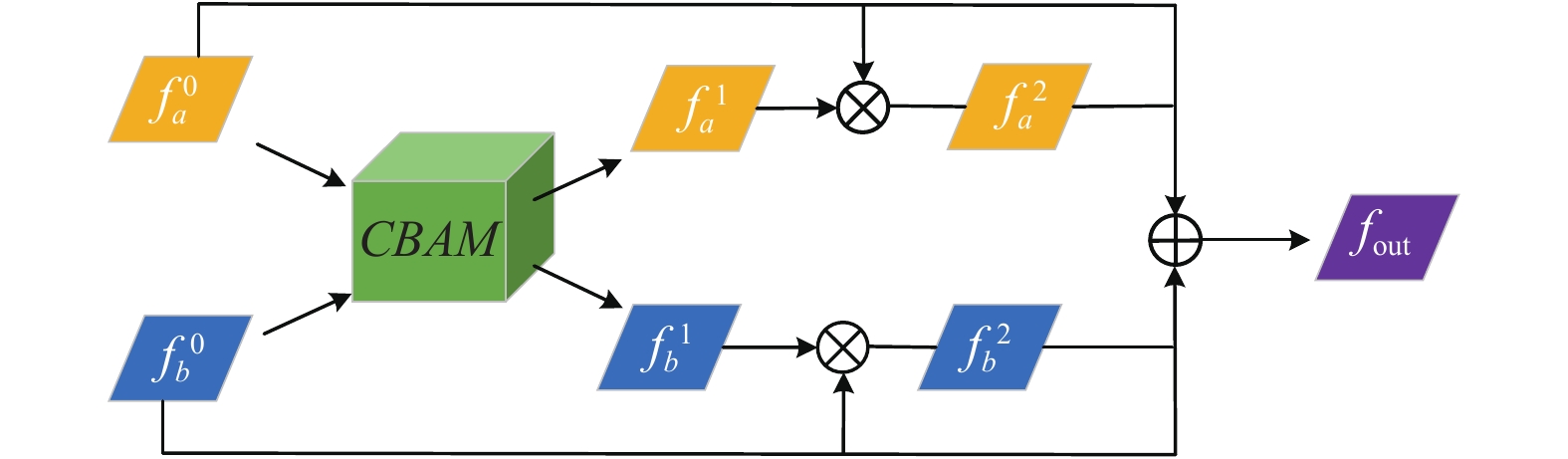

Attention U-Net[36]指出, 深层下采样后的CNN更专注于归纳概括全局图像信息而往往会忽视对细节物像信息的提取. 基于此, Attention U-Net采用了注意力门的机制以主动抑制全局图像中无关的背景信息. 遵循着这一思路, 本文在网络的跳跃连接处部署双通道孪生融合模块, 其作用机理如图7所示.

|

图 7 双通道孪生融合模块示意图. |

首先, 由编码器提取到的两组特征

| $ f_a^1 = CBAM(f_a^0) $ | (1) |

| $ f_b^1 = CBAM(f_b^0) $ | (2) |

然后, 相关性特征对原始特征

| $ f_a^2 = f_a^0 \otimes f_a^1 $ | (3) |

| $ f_b^2 = f_b^0 \otimes f_b^1 $ | (4) |

为了防止重新赋权的特征过拟合, 最后原始特征

| $ f_{\rm{out}}^{} = f_a^0 + f_b^0 + f_a^2 + f_b^2 $ | (5) |

不同于FC-Siam-diff在跳跃连接处直接计算特征的绝对值差以获得特征变化, 本文所提出的双通道孪生输入模块对输入图像包装后, 编码器本身就在提取时序变化特征和反时序变化特征, 故而, 在跳跃连接处部署双通道孪生融合模块可以进一步精炼图像前景信息并抑制图像背景信息. 与计算绝对值差相同的是, 该模块的设计同样是符合对称模块设计原则的.

最终, 在基准模型上添加了前述两个模块后, 本文所提出的双通道孪生网络结构如图8所示.

|

图 8 双通道孪生网络示意图 |

4 实验 4.1 数据集

为了评估本文第3节所介绍的模型与模块, 本文使用OSCD数据集[20]进行测评. OSCD数据集是一个遥感变化检测的经典数据集. 其多时相数据由Sentinel-2卫星获取. 数据集中共包含24组图像, 其中14组用于训练, 10组用于测试. 该数据集采集对象遍布全球24个城市, 主要着重于城区扩建、建筑变化和道路变化等数据标注. 值得注意的是, 除了传统RGB图像之外, OSCD数据集还提供了更利于特征提取的多分辨率多光谱图像. 本文之后的实验都是基于多光谱图像. 为了验证时序影响, 本文测试集将在原始数据集上翻倍, 同时囊括原始数据和反时序数据.

4.2 实验参数设置本文网络训练的批处理大小设置为32, 学习率初始化为10−4. 为了防止训练过拟合, 训练过程实施了指数学习率衰减. 优化器算法的选择为自适应动量估计法(Adam). 损失函数的选择为二分类交叉熵, 其计算公式如下:

| $ L = - {y_t}\lg {y_p} - (1 - {y_t})\lg (1 - {y_p}) $ | (6) |

其中, yt 表示数据集标签, yp表示模型预测结果. 实验整体框架使用PyTorch. 所有训练与预测过程皆在一台英伟达Tesla K80 GPU上完成.

遥感变化检测学习目标与二分类语义分割大体相似. 因此, 本文所采用的评价指标也源自语义分割任务, 即F1 指标 (F1)、精准率(P)、召回率 (R)和整体准确率(OA). 其定义如下:

| $ OA = \frac{{TP + TN}}{{TP + TN + FP + FN}} $ | (7) |

| $ P = \frac{{TP}}{{TP + FP}} $ | (8) |

| $ R = \frac{{TP}}{{TP + FN}} $ | (9) |

| $ {F1} = \frac{{2 \times TP}}{{2 \times TP + FP + FN}} $ | (10) |

其中, TP代表模型能正确识别遥感影像变化像素个数; TN代表模型能正确识别遥感影像未变化像素个数; FP代表模型错误地判定为遥感影像变化像素个数; FN代表模型错误地判定遥感影像未变化像素个数.

4.3 对比实验本文选取了最新的5个遥感变化检测网络与本文所提出的双通道孪生网络进行训练有效性与模型精度两方面的对比. 所选取的网络具体介绍如下:

1) CDNet[38]: CDNet是一个端到端像素级街景变化检测网络. 网络结构由收缩模块和扩张模块组成.

2) FCN-PP[39]: FCN-PP是一个用于山体滑坡变化测绘的网络. 其整体框架有编码器与解码器构建. 此外, 该网络还采用了特征金字塔的结构以获取更宽泛的视觉感受野.

3) FCN-Siam-conc[20]: FC-Siam-conc是为训练OSCD数据集而提出的网络. 其处理流程分3步. 首先, 不同时相的数据通过编码器分别进行编码. 然后, 编码后的特征通过通道拼接的方式送入解码器进行解码. 最后, 解码后的特征经过Softmax操作生成遥感变化图.

4) FC-Siam-diff[20]: FC-Siam-diff是FC-Siam-conc的改进. 其跳跃连接放弃了通道拼接方式的数据融合转而使用计算绝对值差的方式, 引导网络直接比较特征差异.

5) FC-EF-Res[3]: FC-EF-Res是为训练高分辨率遥感变化检测而提出的网络. 通过部署残差模块, 该网络精度相比FCN-Siam-conc和FCN-Siam-diff都大幅度提升.

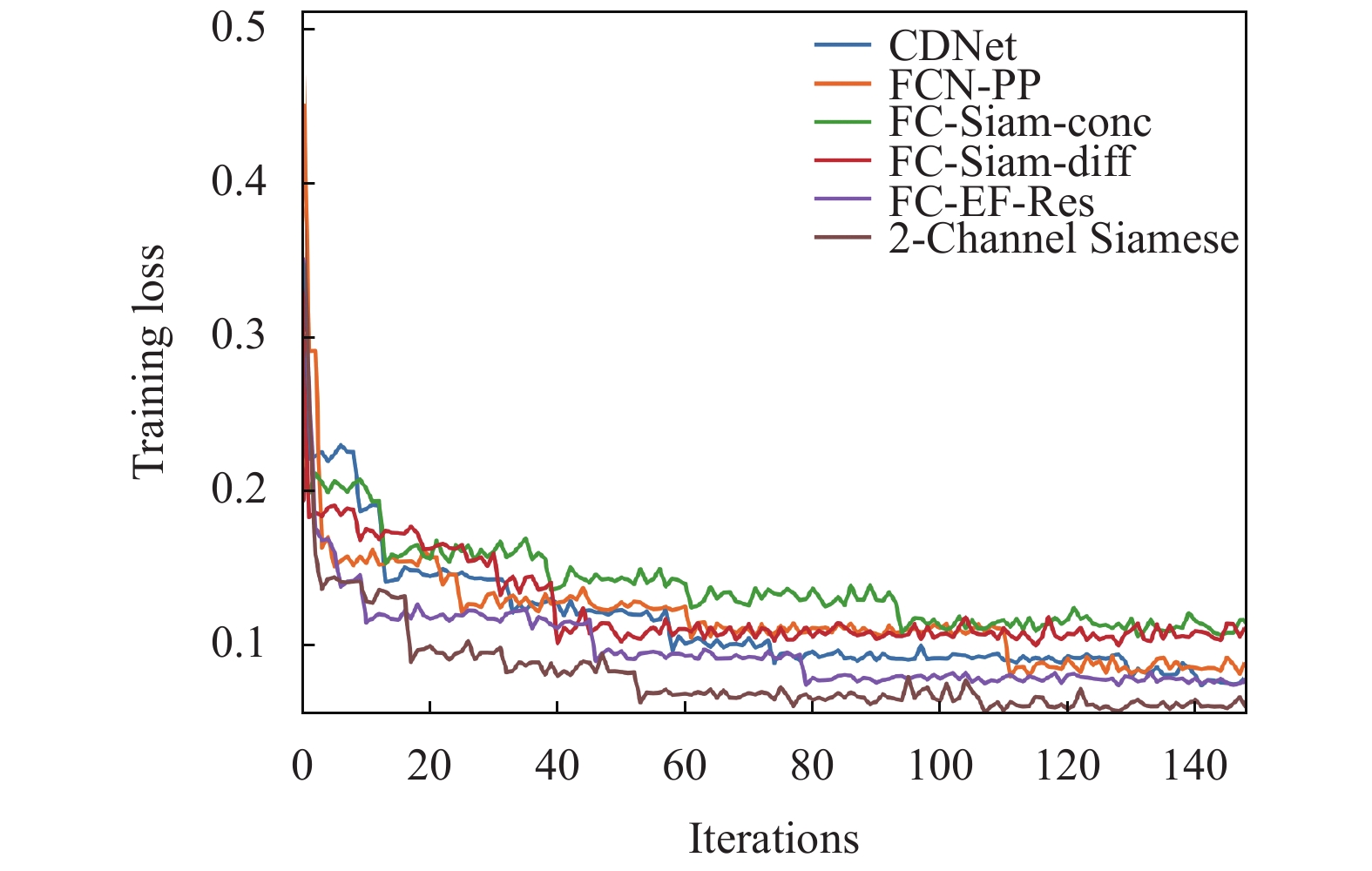

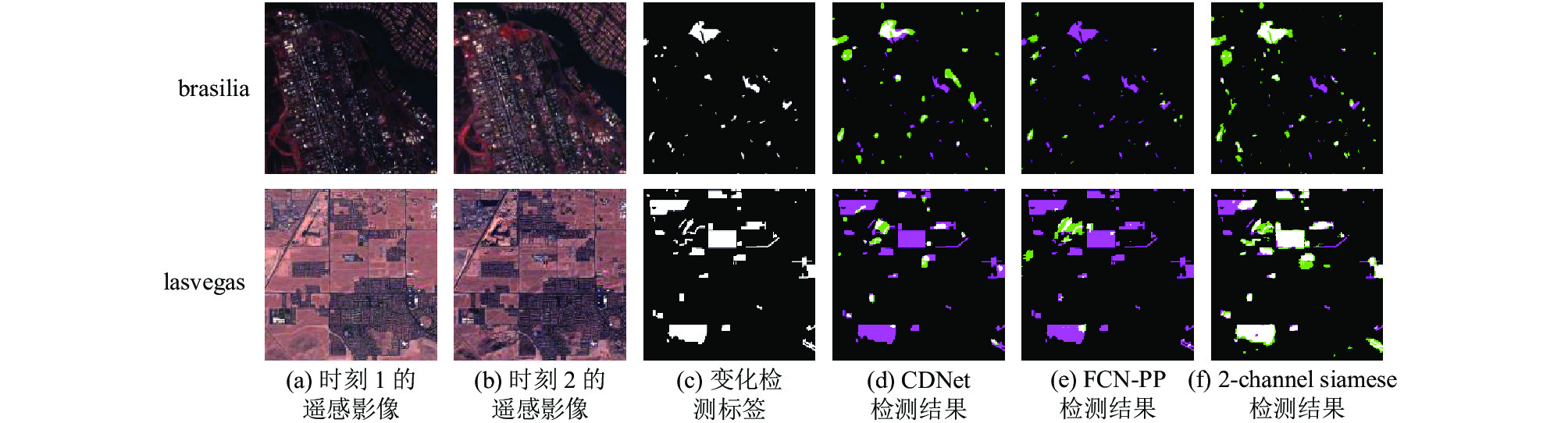

表1展示了各网络指标比较. 图9绘制了各网训练损失变化情况. 图10挑选了测试集中的两个测试案例进行遥感变化图的可视化.

| 表 1 双通道孪生网络与其他网络的指标对比(%) |

|

图 9 各网络的训练损失曲线. |

上述结果表明本文所提出的双通道孪生网络相比于其他网络有着更好的性能. 本文主要将其归因于两个方面. 一方面, 本文通过对模型调整使得模型对称. 模型能够对不同时序的图像输入保持输出恒等. 从图9可以看出, 这一点使得模型只需用原始的时序数据训练网络, 网络的训练损失可以更快地下降, 保证了训练的有效性. 另一方面, 本文所设计的双通道孪生输入以及双通道孪生融合是两个轻量级即插即用模块. 本文将其分别嵌入在网络输入和跳跃连接部分使得网络精度大幅提升.

|

图 10 不同模型在OSCD测试集2个测试案例的遥感变化检测结果,图中白、黑、绿、粉色部分分别代表TP、TN、FP、FN (定义见4.2节) |

4.4 消融实验

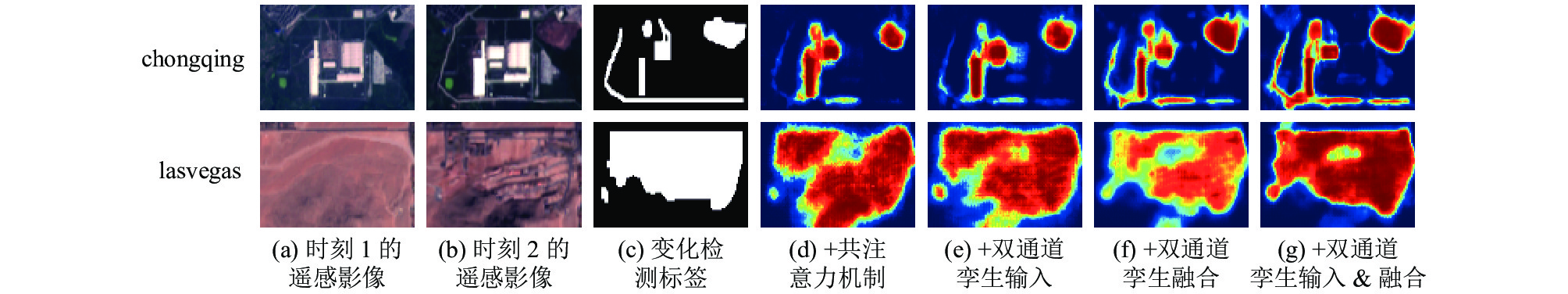

为了评估本文所提出的两个模块的性能. 在基准模型的基础上(图4), 本文设计消融实验逐步添加模块并验证效果. 为了比较注意力机制性能, 本文额外选取了PGA-SiamNet[40]的共注意力机制与本文的双通道孪生融合进行对比. 实验指标于表2给出. 图11选取了两个测试集样本并绘制了网络处理结果的热力图.

结果表明, 共注意力机制虽然提取不同时相特征相关性以提升变化检测性能(在lasvegas测试案例中), 但是对于小尺寸物像的差异变化信息捕捉较差(在chongqing的测试案例中). 原因之一便是共注意力机制计算开销较大, 往往被嵌入在网络的深层. 在网络的深层中, 视觉感受野较大往往会忽略图像细节信息. 而本文所提出的双通道孪生融合模块, 由于其计算轻量, 被嵌入在多处跳跃连接中, 以获得不同尺度感受野的信息融合, 以提升对小尺寸遥感物像变化检测的效果.

| 表 2 消融实验中各网络指标(%) |

|

图 11 表2模型在OSCD测试集2个测试案例的注意力热力图可视化 |

5 结论与展望

本文首先指出了时序影响对反时序变化检测效果的影响. 这种影响使得时序变化检测器无法处理反时序变化检测或者双向时序变化检测任务. 为了客观地验证这种影响, 本文在实验部分的测试集将原始数据集翻倍, 同时囊括原始数据和反时序数据. 在其他相关的数据集以及网络中, 类似的问题也可能存在. 因此, 本文强烈建议加上时序这一因素重新对其进行指标验证.

本文的另一个贡献在于提出了双通道孪生网络. 该网络的基准网络是由现有模型重构微调. 其整体呈现对称的特性, 对不同时序的图像输入, 都能保证输出恒等. 这一性质使得网络能够仅使用原始的时序数据对网络进行更快速更有效地训练. 此外, 双通道孪生网络嵌入了双通道孪生输入和双通道孪生融合两个模块进一步提升了网络的精度. 本文实验表明, 所提出的网络效果无论从训练有效性还是模型精度上都超过了现有的最新模型. 此外, 本文设计的消融实验验证了所提出的两个模块的性能. 这两个轻量性模块可供今后的相关研究采用.

| [1] |

Shi WZ, Zhang M, Zhang R, et al. Change detection based on artificial intelligence: State-of-the-art and challenges. Remote Sensing, 2020, 12(10): 1688. DOI:10.3390/rs12101688 |

| [2] |

Rokni K, Ahmad A, Selamat A, et al. Water feature extraction and change detection using multitemporal landsat imagery. Remote Sensing, 2014, 6(5): 4173-4189. DOI:10.3390/rs6054173 |

| [3] |

Daudt RC, Le Saux B, Boulch A, et al. Multitask learning for large-scale semantic change detection. Computer Vision and Image Understanding, 2019, 187: 102783. DOI:10.1016/j.cviu.2019.07.003 |

| [4] |

Marin C, Bovolo F, Bruzzone L. Building change detection in multitemporal very high resolution SAR images. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(5): 2664-2682. DOI:10.1109/TGRS.2014.2363548 |

| [5] |

Huang X, Zhang LP, Zhu TT. Building change detection from multitemporal high-resolution remotely sensed images based on a morphological building index. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2014, 7(1): 105-115. DOI:10.1109/JSTARS.2013.2252423 |

| [6] |

Chen CF, Son NT, Chang NB, et al. Multi-decadal mangrove forest change detection and prediction in Honduras, Central America, with Landsat imagery and a Markov chain model. Remote Sensing, 2013, 5(12): 6408-6426. DOI:10.3390/rs5126408 |

| [7] |

Gong MG, Zhao JJ, Liu J, et al. Change detection in synthetic aperture radar images based on deep neural networks. IEEE Transactions on Neural Networks and Learning Systems, 2016, 27(1): 125-138. DOI:10.1109/TNNLS.2015.2435783 |

| [8] |

Mahdavi S, Salehi B, Huang WM, et al. A PolSAR change detection index based on neighborhood information for flood mapping. Remote Sensing, 2019, 11(16): 1854. DOI:10.3390/rs11161854 |

| [9] |

Celik T. Unsupervised change detection in satellite images using principal component analysis and K-means clustering. IEEE Geoscience and Remote Sensing Letters, 2009, 6(4): 772-776. DOI:10.1109/LGRS.2009.2025059 |

| [10] |

Deng JS, Wang K, Deng YH, et al. PCA-based land-use change detection and analysis using multitemporal and multisensor satellite data. International Journal of Remote Sensing, 2008, 29(16): 4823-4838. DOI:10.1080/01431160801950162 |

| [11] |

Volpi M, Tuia D, Bovolo F, et al. Supervised change detection in VHR images using contextual information and support vector machines. International Journal of Applied Earth Observation and Geoinformation, 2013, 20: 77-85. DOI:10.1016/j.jag.2011.10.013 |

| [12] |

Huang CQ, Song KA, Kim S, et al. Use of a dark object concept and support vector machines to automate forest cover change analysis. Remote Sensing of Environment, 2008, 112(3): 970-985. DOI:10.1016/j.rse.2007.07.023 |

| [13] |

Im J, Jensen JR. A change detection model based on neighborhood correlation image analysis and decision tree classification. Remote Sensing of Environment, 2005, 99(3): 326-340. DOI:10.1016/j.rse.2005.09.008 |

| [14] |

Bruzzone L, Prieto DF. Automatic analysis of the difference image for unsupervised change detection. IEEE Transactions on Geoscience and Remote Sensing, 2000, 38(3): 1171-1182. DOI:10.1109/36.843009 |

| [15] |

Zhong P, Wang RS. A multiple conditional random fields ensemble model for urban area detection in remote sensing optical images. IEEE Transactions on Geoscience and Remote Sensing, 2007, 45(12): 3978-3988. DOI:10.1109/TGRS.2007.907109 |

| [16] |

Chopra S, Hadsell R, Lecun Y. Learning a similarity metric discriminatively, with application to face verification. Proceedings of 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego: IEEE, 2005. 539–546.

|

| [17] |

Zagoruyko S, Komodakis N. Learning to compare image patches via convolutional neural networks. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 4353–4361, doi: 10.1109/CVPR.2015.7299064.

|

| [18] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 3431–3440.

|

| [19] |

Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [20] |

Daudt RC, Le Saux B, Boulch A. Fully convolutional siamese networks for change detection. Proceedings of the 2018 25th IEEE International Conference on Image Processing. Athens: IEEE, 2018. 4063–4067.

|

| [21] |

Sakurada K, Shibuya M, Wang WM. Weakly supervised silhouette-based semantic scene change detection. Proceedings of 2020 IEEE International Conference on Robotics and Automation. Paris: IEEE, 2020. 6861–6867.

|

| [22] |

Varghese A, Gubbi J, Ramaswamy A, et al. ChangeNet: A deep learning architecture for visual change detection. Proceedings of European Conference on Computer Vision. Munich: Springer, 2019. 129–145.

|

| [23] |

Song A, Choi J, Han Y, et al. Change detection in hyperspectral images using recurrent 3D fully convolutional networks. Remote Sensing, 2018, 10(11): 1827. DOI:10.3390/rs10111827 |

| [24] |

Peng DF, Zhang YJ, Guan HY. End-to-end change detection for high resolution satellite images using improved UNet++. Remote Sensing, 2019, 11(11): 1382. DOI:10.3390/rs11111382 |

| [25] |

Zhang ZC, Vosselman G, Gerke M, et al. Detecting building changes between airborne laser scanning and photogrammetric data. Remote Sensing, 2019, 11(20): 2417. DOI:10.3390/rs11202417 |

| [26] |

El Amin AM, Liu QJ, Wang YH. Convolutional neural network features based change detection in satellite images. Proceedings of the SPIE 10011, First International Workshop on Pattern Recognition. Tokyo: SPIE, 2016. 100110W.

|

| [27] |

Gao F, Dong JY, Li B, et al. Automatic change detection in synthetic aperture radar images based on PCANet. IEEE Geoscience and Remote Sensing Letters, 2016, 13(12): 1792-1796. DOI:10.1109/LGRS.2016.2611001 |

| [28] |

Papadomanolaki M, Verma S, Vakalopoulou M, et al. Detecting urban changes with recurrent neural networks from multitemporal Sentinel-2 data. Proceedings of 2019 IEEE International Geoscience and Remote Sensing Symposium. Yokohama: IEEE, 2019. 214–217.

|

| [29] |

Lebedev MA, Vizilter YV, Vygolov OV, et al. Change detection in remote sensing images using conditional adversarial networks. International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, 2018, XLII-2: 565-571. DOI:10.5194/isprs-archives-XLII-2-565-2018 |

| [30] |

Chen H, Shi ZW. A spatial-temporal attention-based method and a new dataset for remote sensing image change detection. Remote Sensing, 2020, 12(10): 1662. DOI:10.3390/rs12101662 |

| [31] |

Connors C, Vatsavai RR. Semi-supervised deep generative models for change detection in very high resolution imagery. Proceedings of 2017 IEEE International Geoscience and Remote Sensing Symposium (IGARSS). Fort Worth: IEEE, 2017. 1063–1066.

|

| [32] |

Ji SP, Wei SQ, Lu M. Fully convolutional networks for multisource building extraction from an open aerial and satellite imagery data set. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(1): 574-586. DOI:10.1109/TGRS.2018.2858817 |

| [33] |

Bourdis N, Marraud D, Sahbi H. Constrained optical flow for aerial image change detection. Proceedings of 2011 IEEE International Geoscience and Remote Sensing Symposium. Vancouver: IEEE, 2011. 4176–4179.

|

| [34] |

Benedek C, Szirányi T. Change detection in optical aerial images by a multilayer conditional mixed Markov model. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(10): 3416-3430. DOI:10.1109/TGRS.2009.2022633 |

| [35] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [36] |

Oktay O, Schlemper J, Le Folgoc L, et al. Attention U-Net: Learning where to look for the pancreas. arXiv: 1804.03999, 2018.

|

| [37] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 3–19.

|

| [38] |

Alcantarilla PF, Stent S, Ros G, et al. Street-view change detection with deconvolutional networks. Autonomous Robots, 2018, 42(7): 1301-1322. DOI:10.1007/s10514-018-9734-5 |

| [39] |

Lei T, Zhang YX, Lv ZY, et al. Landslide inventory mapping from bitemporal images using deep convolutional neural networks. IEEE Geoscience and Remote Sensing Letters, 2019, 16(6): 982-986. DOI:10.1109/LGRS.2018.2889307 |

| [40] |

Jiang HW, Hu XY, Li K, et al. PGA-SiamNet: Pyramid feature-based attention-guided siamese network for remote sensing orthoimagery building change detection. Remote Sensing, 2020, 12(3): 484. DOI:10.3390/rs12030484 |

2022, Vol. 31

2022, Vol. 31