关系抽取[1, 2]任务是指对实体间的相互关系进行抽取, 其目标是在给定实体对的情况下识别并判断目标实体对之间的特定语义关联. 作为信息抽取[3]的核心技术之一, 关系抽取能够帮助计算机从自然文本中识别出实体之间蕴含的语义关系. 知识图谱[4]作为第三代人工智能的基石, 当下正处于高度发展的阶段, 其构建和应用的过程中都离不开关系抽取的帮助, 并且抽取任务完成的精确度会在一定程度上影响到知识图谱构建的质量及其上层应用的效果优劣. 随着自然语言处理技术的不断发展, 关系抽取的效果也获得了一定的提升, 但面对海量的网络文本, 尤其是丰富多变的语言环境时, 目前关系抽取的效果依旧不能满足当前发展的需求.

1 关系抽取目前, 可通过以下两类方法来实现关系抽取, 1)基于机器学习的方法[5-7]; 2) 基于深度学习的方法. 前者主要指通过由文本能够容易得到的浅层特征, 如词性、句法等特征信息, 从而完成关系抽取的工作; 后者则是利用深度神经网络将文本的浅层特征转换为更高级的语义特征. 相较于第1类方法, 第2类方法能有效地解决人工特征选择、特征提取误差传播两大主要问题.

第2类方法在早期由卷积神经网络(convolutional neural networks, CNN)和循环神经网络(recurrent neural networks, RNN)为代表. 其中Zeng等人[8]首次借助了CNN, 用于抽取文本中所包含的词或者句子级别的特征, 最终通过Softmax层进行关系分类, 从而得到了较好的层级. Xu等人[9]将句法特征融入到CNN中, 并在数据集SemEval-2010 Task8进行实验. 准确率相较于仅使用CNN进行抽取的模型提高了4.1%, 验证了该方法在关系抽取任务上的有效性. 除使用CNN作为特征提取网络外, Socher等人[10]采用RNN用于关系抽取, 实验结果表明RNN在该类任务中具有良好的表现. RNN虽然能很好地学习到文本序列的深层知识, 但相应地也会存在梯度爆炸等弊端.

针对上述弊端, 研究者们通过不断的改进和完善, 提出了RNN的变体: 长短期记忆网络(long short-term memory, LSTM). 其通过“门”机制控制信息的传递, 在RNN的基础上解决了长距离依赖以及梯度爆炸问题. Xu等人[11]将文本的浅层特征进行融合, 应用LSTM完成关系抽取, 实验证明该方法优于传统的CNN方法. Zhang等人[12]进一步使用LSTM的变体双向长短期记忆网络(Bi-LSTM)模型进行抽取, 其最佳的实验结果相较于传统方法准确率提高了14.6%, 可见Bi-LSTM模型在关系抽取中能获得更为优异的结果.

随着深度学习的发展, 研究者们试图寻找一种新的结构以帮助模型在学习的过程中对部分特征进行强化学习, 此时注意力机制(attention)[13]逐渐步入人们的视野. 它是由Treisman等人[14]提出的选择算法, 该算法通过注意力机制对特征的关键部分进行重点学习, 对于深度学习网络的学习过程有积极意义. 王红等人[15]将attention引入到Bi-LSTM中完成关系抽取, 在实验过程中取得了优秀的成绩. 但基于注意力机制的模型仅通过对输入特征的控制进行计算, 未考虑模型神经元之间特征的相关性. 并且在复杂的语意环境下, 这类模型也容易受到文本中非目标实体对关系语义的干扰, 从而影响方法的性能.

鉴于上述不足, 本文提出了控制输入长短期记忆网络CI-LSTM (control input long short-term memory), 该网络在传统LSTM的基础上增加了由注意力机制和控制门阀单元组成的输入控制单元, 控制门阀单元可依据控制向量进行关键位置上的重点学习, 注意力机制对单个LSTM的输入的不同特征与目标实体对信息进行计算, 从而对特征的关键部分进行可控制的选择学习, 有效提升了关系抽取的性能.

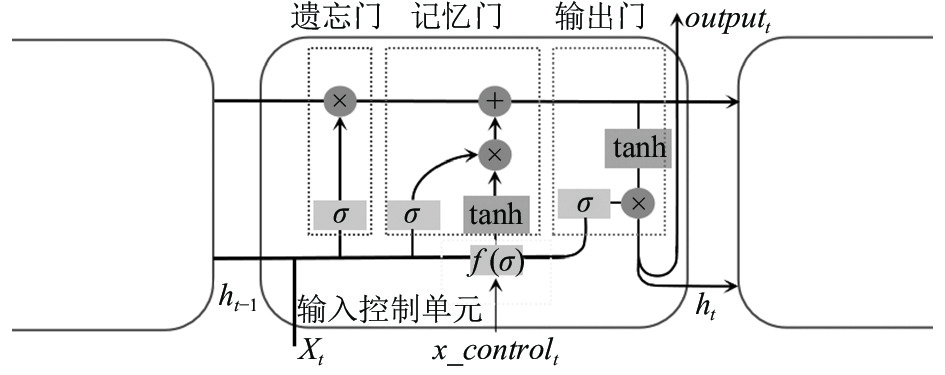

2 基于控制输入LSTM的关系抽取方法 2.1 输入控制单元为使网络能够有选择进行学习, 本文受门控机制的启发设计出输入控制单元, 输入控制单元结构如图1.

|

图 1 输入控制单元结构 |

由图1可以看出, 输入控制单元包含两部分.

第一部分为依靠控制向量和门控机制的门阀控制单元, 该单元能够根据控制向量对当前时刻的输入进行有选择地进行控制. 首先门阀控制单元依据当前时刻的输入和前一时刻的细胞状态计算控制门权重, 然后根据控制向量和控制门权重对输入进行计算.

| $ {c_t} = \sigma ({W_c} \cdot [{h_{t - 1}}, {x_t}] + {b_c}) $ | (1) |

| $ {x'_t} = {x_t} \cdot {c_t}^{x\_{c_t}} $ | (2) |

其中, ct为输入控制门的控制信息, x't为更新后的输入信息, x_ct为控制向量, Wc和bc为记忆门的权重及偏置值.

第二部分进行特征级别的注意力机制的计算, 本文选择聚焦式注意力机制将经过门阀控制单元计算出的输入与实体信息进行注意力机制的计算, 公式如下:

| $ {a_i} = {{Softmax}} (s({x_i}, q)) $ | (3) |

其中, ai为第i个特征的注意力权重, s为注意力打分函数, xi为t时刻第i个输入特征, q为作为key的实体特征.

在特征级别的注意力计算中, 输入为t时刻输入特征的值, q为实体信息的表示, 文本在选择注意力打分函数时使用双线性模型, 公式如下:

| $ s({x_i}, q) = {x_i}{W^{\text{T}}}{{q}} $ | (4) |

其中, W为可训练参数, 维度与q相同.

最终输入控制单元输出的结果

| $ {\tilde x_t} = {{a}} \cdot {x'_t} $ | (5) |

其中, x't为注意力模块的输入, a则代表注意力的权重矩阵.

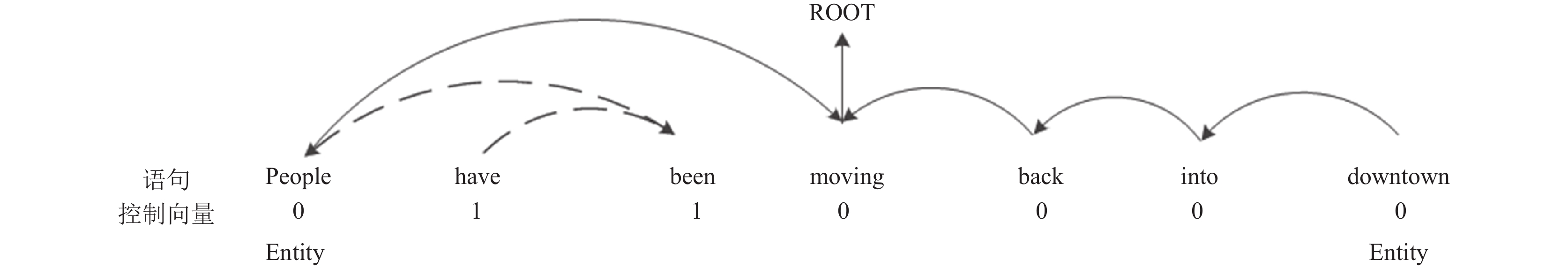

2.2 输入控制LSTM在LSTM中, 最为关键的部分是由细胞状态C以及3个门(即记忆门i、遗忘门f与输出门o)组成, 在时间t流入模型的信息由LSTM控制单元加以处理, 有选择地留下或舍弃C的部分信息, 并经由计算后传递给下一控制单元. 为使得网络能够在学习上下文特征时能够对输入进行有选择地学习, 本文在原有LSTM结构中引入输入控制单元. 输入控制LSTM控制单元结构如图2所示.

其中, 遗忘门将计算对前一时刻传入的细胞状态进行遗忘的数值, 这一部分的计算过程如式(6)所示:

| $ {f_t} = \sigma ({W_f} \cdot [{h_{t - 1}}, {x_t}] + {b_f}) $ | (6) |

其中, ft为遗忘门的控制信息, 用于减少t−1时C中的信息, Wf和bf则分别为遗忘门的权重及偏置值.

记忆门将决定输入的特征有多少能进入新的细胞状态, 记忆门的计算过程如式(7)所示:

| $ {i_t} = \sigma ({W_i} \cdot [{h_{t - 1}}, {x_t}] + {b_i}) $ | (7) |

其中, it为记忆门的控制信息, Wi和bi为记忆门的权重及偏置值.

|

图 2 CI-LSTM细胞结构 |

输入控制单元依据输入信息和控制向量来实现对输入信息的管理, 即对输入的信息有选择地遗忘. 输入控制门与记忆门的控制机制不同之处在于输入控制门的控制机制仅作用于输入信息, 这种控制方式能够更为直接的作用于输入信息本身, 从而在不影响记忆门对细胞状态控制的同时, 对输入特征进行有选择地学习.

进一步地, 根据遗忘门和记忆门的控制信息对细胞状态进行更新, 更新过程如下:

| $ {C_t} = {f_t} \times {C_{t - 1}} + {i_t} \times \tanh ({W_C} \cdot [{h_{t - 1}}, {\tilde x_t}] + {b_C}) $ | (8) |

其中, Ct为新的细胞状态, Ct−1为前一时刻的细胞状态, Wc、bc分别反映计算临时细胞状态的权重及偏置值.

输出门将计算哪些信息将被输出, 这一过程如下所示:

| $ {o_t} = \sigma ({W_o} \cdot [{h_{t - 1}}, {\tilde x_t}] + {b_o}) $ | (9) |

| $ {h_t} = {o_t} \times \tanh {C_t} $ | (10) |

其中, ot为该门的控制信息, Wo、bo则分别反映该门的权重及偏置值.

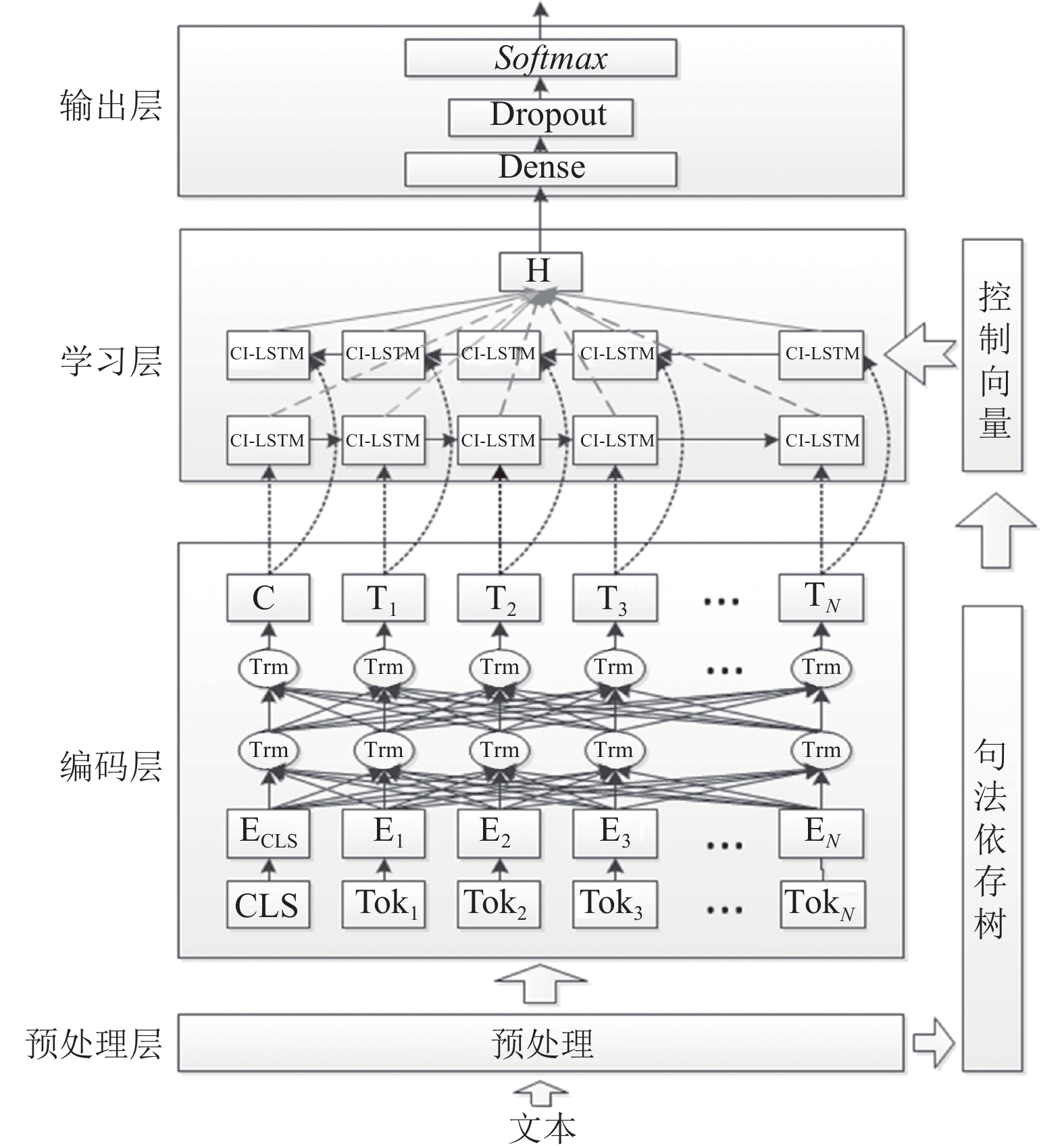

2.3 基于控制输入LSTM的关系抽取模型本文将关系抽取分为4层, 分别为预处理层、编码层、学习层以及输出层.

预处理层主要作用在于生成控制向量, 并依据BERT的需要进行预编码. 其中控制向量的生成本文选择依靠句法依存树辅助完成, 句法依存树[16]是文本中句法关系和语法关系的一种表现形式, 通过句法依存树能够很清晰地将词与词之间的依存关系表现出来.并且通过句法依存树能够将句子中主干部分进行提炼, 从而弥补语句中表达不清楚的问题.

本文选择以句法依存树所生成的最短依存路径作为控制向量生成的方式. 首先本文借助工具生成句子的句法依存树, 并以两实体为两端来寻找最短依存路径, 最后基于该路径按原本句子中词的位置生成控制向量. 如图3所示.

|

图 3 句法依存树的关系表示 |

控制向量的生成计算如式(11)所示:

| $ x\_{c_i} = \left\{ {\begin{array}{*{20}{l}} {1, \; wor{d_i} \notin D} \\ {0, \; wor{d_i} \in D} \end{array}} \right. $ | (11) |

其中, x_ci为文本中i位置的控制向量, wordi为文本中i位置的单词, D为最短依存路径.

由于自然语言处理中神经网络不能直接输入文本, 需要将文本转化为向量的数据. 因此编码层使用BERT[17]作为模型的编码层, BERT模型自推出以来就备受自然语言处理界的青睐, 该模型以其优秀的性能已经逐步取代Word2Vec、ELmo成为语言模型中不可或缺的一部分.

学习层以双向的控制输入LSTM结构进行学习. 其中实体信息表示本文通过记录实体开始位置, 并从编码层截取实体出现位置的编码向量作为实体信息的表示. 同时将首实体与尾实体的拼接作为实体信息的表示输入到控制输入LSTM中帮助输入控制单元的注意力计算.

输出层以一个全连接层和Dropout层作为中间层, Dropout层可以在一定程度上减少过拟合的现象, 最后通过Softmax函数进行判断关系类别的判断. CI-LSTM模型结构如图4所示.

3 实验分析 3.1 实验数据为验证所提模型的效果, 本文采用SemEval2010- task8数据集作为实验语料进行测试. 该数据集包含10类关系, 共10717条数据. 其中包括8 000条训练数据和2 717条测试样本. 样本关系分布如表1所示.

除SemEval2010-task8数据集外, 本文同时选取150条SemEval2010-task8数据集测试数据中存在多种语义关系的样本作为复杂语境下的实验样本.

本文评价指标采用准确率P、召回率R以及F值, 各指标的具体定义为:

| $ P = \frac{{{T_P}}}{{{T_P} + {F_P}}} $ | (12) |

| $ R = \frac{{{T_P}}}{{{T_P} + {F_N}}} $ | (13) |

| $ F = \frac{{2 \times P \times R}}{{P + R}} $ | (14) |

其中, TP表示模型对输出类型判断正确的数据条目; FP表示模型对输出关系判断错误的数据条目; FN表示模型对输出关系判断错误但实际正确的条目.

|

图 4 基于CI-LSTM的关系抽取模型结构图 |

| 表 1 SemEval2010-task8数据集样本关系分布 |

3.2 参数设置

本文实验基于Keras深度学习框架, 采用Adam优化算法训练模型, 并使用最小化交叉熵的方法进行最优参数的选取. 为方便模型的对比, 在后续试验中, 模型的公共参数均按照最优参数进行实验, 并同样使用BERT_BASE作为编码层, 模型的最优参数设置如表2.

| 表 2 模型最优参数设置 |

3.3 控制向量生成方式实验

为验证以句法依存树作为控制向量的生成标准的可靠性, 本文以单词相对于实体的位置作为控制向量的生成依据进行了实验. 依据位置的控制向量生成即将文本以实体为界限分为三段式, 在实体之间的信息视作关键信息, 处于两实体两侧的信息视作非关键信息. 以实体位置进行控制向量的生成如图5所示.

|

图 5 基于实体位置生成控制向量 |

实验结果如表3所示.

| 表 3 实验结果对比 (%) |

实验结果表明依据句法依存树的控制向量生成方式在关系抽取中与本文提出的基于输入控制LSTM结构结合能够更好地对关系特征进行学习.

3.4 实验结果为验证本文模型在关系抽取的效果, 本文分别对本文模型和RNN、CNN、LSTM、Bi-LSTM、Attention-LSTM模型进行实验对比, 实验结果如表4.

| 表 4 SemEval2010-task8数据集实验结果 (%) |

从表4中可以看出, 相较于RNN、CNN, CI-LSTM的在F上分别提升了20.03%、12.32%, 这是因为CI-LSTM内部采用以LSTM的结构来学习语句的特征, 而LSTM相对于CNN和RNN具有更为优秀的结构. 相比于LSTM模型和Bi-LSTM, CI-LSTM的F值分别提升了3.7%和3.13%, 这是因为CI-LSTM在传统LSTM的基础上增加了控制输入单元, 输入控制单元的引入能够使模型能够对关键部分的特征进行重点学习, 并且针对实体信息的特征级注意力的计算能够帮助模型学习到专注于当前实体对的语义关系信息. CI-LSTM相较于Attention-LSTM效果提升了1.26%. 这是因为相对于Attention机制自动的计算句子各个部分的权重, 在训练过程中容易受到其他关系的干扰, 而CI-LSTM可以根据控制向量的值进行选择性的学习, 从而增加了复杂语境下的关系判断精度.

为验证本文模型在复杂语境下的性能, 本文使用SemEval2010-task8中选取出的语句中包含多种关系的样本进行单独的测试. 复杂语境实验结果如表5所示.

| 表 5 复杂语境模型实验结果 (%) |

这一结果表明本文提出的CI-LSTM相较于传统的方法能够在复杂语境下进行更好的关系抽取任务.

4 结论与展望本文针对当前传统深度学习关系抽取方法在复杂语境下所存在的文本中其他关系对目标关系抽取产生干扰的问题提出了CI-LSTM网络. 该网络在传统LSTM的基础上增加了由注意力机制和控制门阀单元组成的输入控制单元, 其中控制门阀单元可依据控制向量进行关键位置上的重点学习, 而注意力机制则对单个LSTM的输入的不同特征与实体对信息进行计算. 本文通过句法依存关系进行控制向量的生成, 并以控制输入LSTM作为学习层, Softmax函数作为判断关系的方式进行关系抽取模型的构建. 在SemEval2010-task8任务数据集上进行实验, 由实验结果可以看出CI-LSTM优于其他方法, 能得到更好的关系抽取效果. 另外, 本文通过对SemEval2010-task8中具有复杂语境的数据进行了再次的验证, 实验结果表明, 相对于传统深度学习方法, 本文所提方法对复杂语境下的关系抽取更具有效性. 在后续的研究中, 可以考虑如何在减少参数量的同时根据控制向量进行更好的选择学习, 以及在控制向量生成的方法上进行改进.

| [1] |

刘辉, 江千军, 桂前进, 等. 实体关系抽取技术研究进展综述. 计算机应用研究, 2020, 37(S2): 1-5. |

| [2] |

鄂海红, 张文静, 肖思琪, 等. 深度学习实体关系抽取研究综述. 软件学报, 2019, 30(6): 1793-1818. DOI:10.13328/j.cnki.jos.005817 |

| [3] |

郭喜跃, 何婷婷. 信息抽取研究综述. 计算机科学, 2015, 42(2): 14-17, 38. DOI:10.11896/j.issn.1002-137X.2015.02.003 |

| [4] |

刘峤, 李杨, 段宏, 等. 知识图谱构建技术综述. 计算机研究与发展, 2016, 53(3): 582-600. DOI:10.7544/issn1000-1239.2016.20148228 |

| [5] |

Kambhatla N. Combining lexical, syntactic, and semantic features with maximum entropy models for extracting relations. Proceedings of the ACL 2004 on Interactive Poster and Demonstration Sessions. San Diego: Association for Computational Linguistics, 2004. 22–26.

|

| [6] |

Sun X, Dong LH. Feature-based approach to Chinese term relation extraction. 2009 International Conference on Signal Processing Systems. Singapore: IEEE, 2009. 410–414.

|

| [7] |

甘丽新, 万常选, 刘德喜, 等. 基于句法语义特征的中文实体关系抽取. 计算机研究与发展, 2016, 53(2): 284-302. DOI:10.7544/issn1000-1239.2016.20150842 |

| [8] |

Zeng DJ, Liu K, Lai SW, et al. Relation classification via convolutional deep neural network. Proceedings of 25th International Conference on Computational Linguistics. Dublin: ACL, 2014. 2335–2344.

|

| [9] |

Xu K, Feng Y, Huang S, et al. Semantic relation classification via convolutional neural networks with simple negative sampling. Computer Science, 2015, 71(7): 941-949. |

| [10] |

Socher R, Huval B, Manning CD, et al. Semantic compositionality through recursive matrix-vector spaces. Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. Stroudsburg: ACL, 2012. 1201–1211.

|

| [11] |

Xu Y, Mou LL, Li G, et al. Classifying relations via long short term memory networks along shortest dependency paths. Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Lisbon: ACL, 2015. 1785–1794.

|

| [12] |

Zhang S, Zheng DQ, Hu XC, et al. Bidirectional long short-term memory networks for relation classification. 29th Pacific Asia Conference on Language, Information and Computation. Shanghai: ACL, 2015. 73–78.

|

| [13] |

邹晓春, 赵歆波, 杨勇佳, 等. 一种基于有监督学习的视觉注意力模型. 中国体视学与图像分析, 2015, 20(3): 201-207. |

| [14] |

Treisman AM, Gelade G. A feature-integration theory of attention. Cognitive Psychology, 1980, 12(1): 97-136. DOI:10.1016/0010-0285(80)90005-5 |

| [15] |

王红, 史金钏, 张志伟. 基于注意力机制的LSTM的语义关系抽取. 计算机应用研究, 2018, 35(5): 1417-1420, 1440. DOI:10.3969/j.issn.1001-3695.2018.05.029 |

| [16] |

Nivre J. Dependency parsing. Language and Linguistics Compass, 2010, 4(3): 138-152. DOI:10.1111/j.1749-818X.2010.00187.x |

| [17] |

Devlin J, Chang MW, Lee K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Minneapolis: ACL, 2019. 4171–4186.

|

2022, Vol. 31

2022, Vol. 31