神经网络是机器学习中的重要技术手段, 在图像处理、语音识别、时间序列预测等领域有着广泛的应用[1]. 在过去20年中, 随着计算机技术的发展, 神经网络的结构、规模以及训练方法都得到了飞速的发展. 诸如卷积神经网络、循环神经网络等一系列技术的引入使得神经网络的准确率取得了快速的提升. 但是由于引入了大量非线性的结构, 神经网络的训练过程存在非常强的非凸性, 这使得对神经网络准确性的评估也变得更加复杂, 尤其是当神经网络的准确率越来越高时, 其评分也都越来越接近极限[2].

对神经网络的评估主要是通过对比神经网络在训练集以外的测试集上的表现. 通常会用损失(loss)、准确率(accuracy)等函数作为神经网络的表现分数. 为此在很多问题上, 大量学者和机构提供了很多公开的训练集、验证集以及测试集(如对于手写字体分类的mnist[3], 对于自然分割问题的Oxford-IIIT[4]). 由于神经网络的训练是一个非凸问题, 不同的神经网络初始参数可能最终得到的网络模型并不相同, 因此在评估神经网络时, 通常会选择不同次训练中表现最好的模型的表现分数来与其他网络对比. 但这个过程通常具有较大的偶然性和不可复制性, Reimers等[5, 6]指出通过分析同一网络不同随机种子训练得到模型的表现分数的分布能更稳定地比较分数接近的不同网络之间的优劣. 在此基础之上, Dror等[7]引入了随机占优(stochastic dominance)和几乎随机占优(almost stochastic dominance)来分析两个分数相近的网络分数分布的优劣. 随机占优是一种基于不同随机变量的分布函数间关系得到排序的检验. 最早明确地提出随机占优概念的是Quirk等[8], 直到上世纪60年代末70年代初, Hadar等[9]、Hanoch等[10]一系列随机占优的经典论文发表后, 这一理论的相关发展和应用逐步推广到金融、医学、工程等不同领域中[11]. 随机占优理论弥补了均值-方差模型判断随机变量分布的局限性. 通常评价两个神经网络时, 我们希望其中一个神经网络分数的期望优于另一网络, 同时其标准差也比另一网络小. 但实际上可能存在期望较优, 但是标准差更大的情况, 随机占优可以很好地应对这种情况.

除了不同初始模型训练得到不同模型的分布值得关注, 我们认为不同模型对于测试集中不同样本的表现的分布也值得关注. 尤其是在对于神经网络预测精度的稳定性有要求的领域(如图像分割、股票预测)[12, 13], 我们要求训练出的模型在对测试集进行预测时具有较高的准确率且较小的标准差. 因此本文中进一步将随机占优引入到图像分割问题中不同网络模型在测试集中不同样本表现分布的比较中. 以图像分割中常用的卷积编码器-解码器网络(convolutional encoder decoder, 以下简称CED)[14]和U-Net网络[15]为例, 本文先对比了两个网络在500个不同初始模型训练之后表现的分布, 再进一步地对比了这些训练出的模型在测试集中不同样本表现的分布. 结果显示尽管不同初始模型训练得到的结果U-Net占优于CED网络, 但是CED网络在测试集不同样本中表现的标准差要小于U-Net网络, 这使得在本文的抽样测试对比中, 半数以上的CED网络模型在不同样本表现中的分布占优于U-Net网络模型. 因此本文认为, 不同模型在测试集中表现的标准差应该引起网络对比中的重视, 通过随机占优方法可以更合理地对比不同的模型, 并给出合适的选择.

2 随机占优和几乎随机占优理论 2.1 随机占优的定义令随机变量X、Y, 累积分布函数分别为F、G, 且F、G都是定义在

Leshno等[17]提出了几乎随机占优的概念, 允许G在一些a处位于F的下方, 见图1(b). del Barrio等[18]则采用L2-Wasserstein距离来定义和检验几乎随机占优. 接下来从分位数的概念开始介绍.

令

| $\left\{ { \begin{split} &{A_X} = \{ t \in (0, 1):{F^{ - 1}}(t) < {G^{ - 1}}(t)\}\\ &{A_Y} = \{ t \in (0, 1):{F^{ - 1}}(t) > {G^{ - 1}}(t)\} \end{split}} \right.$ |

del Barrio等[18]基于这些概念提出占优指数

| $ {\varepsilon _{{w_2}}}\left( {F, G} \right): = \dfrac{{\int_{{A_X}} {{{({F^{ - 1}}(t) - {G^{ - 1}}(t))}^2}dt} }}{{{{({w_2}(F, G))}^2}}} $ |

其中,

|

图 1 随机占优和几乎随机占优的示意图 |

同时, 随机占优具有传递性, 这意味着若分布F占优于G, G占优于H, 那么F占优于H. 这样在比较多个分布时, 可以大大减少比较次数[19].

2.2 几乎随机占优的统计检验使用占优指数

| $\left\{ { \begin{split} &{H}_{0}:{\varepsilon }_{w}{}_{{}_{2}}(F, G)\geqslant \epsilon\\ & H_{1}: \varepsilon_{w_{2}}(F, G)> \epsilon \end{split}} \right.$ |

对于提前给定的

累积分布函数F、G可由经验分布函数估计得到:

del Barrio等[18]证明了占优指数

| $ \sqrt{\dfrac{nm}{n+m}}({\varepsilon }_{{w}_{2}}({F}_{n}, {G}_{m})-{\epsilon}) < {\hat{\sigma }}_{n, m}{\Phi }^{-1}(\alpha ) $ |

则在显著性水平

此外, 在置信水平为

| $ {{\epsilon}}^{{\rm{min}}}({F}_{n}, {G}_{m}, \alpha )={\varepsilon }_{{w}_{2}}({F}_{n}, {G}_{m})-{\hat{\sigma }}_{n, m}{\Phi }^{-1}(\alpha ) $ |

若

在

现有来自两个神经网络模型A、B的评分集合:

(1) 将两个集合中分值从小到大排列得到:

(2) 计算评分的经验分布函数

(3) 用式

(4) 计算随机占优指数

(5) 估计

(6) 在置信水平

| $ {{\epsilon}}^{{\rm{min}}}({F}_{n}, {G}_{m}, \alpha )={\varepsilon }_{{w}_{2}}({F}_{n}, {G}_{m})-{\hat{\sigma }}_{n, m}{\Phi }^{-1}(\alpha ) $ |

当

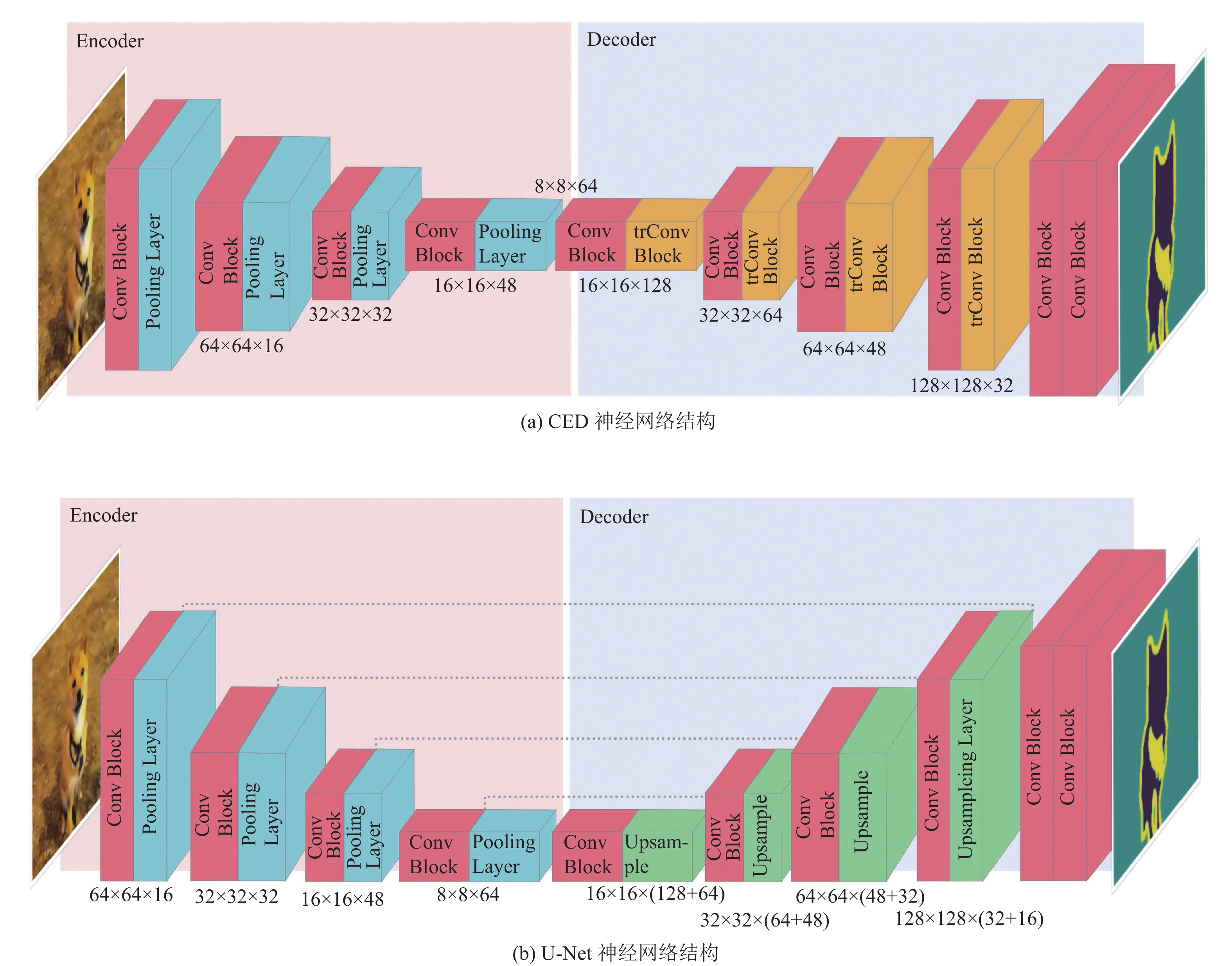

图像分割是神经网络的重要应用, 其主要任务是把图片分割为若干个具有独特特征的区域, 是图像分析以及计算机视觉等领域中的关键步骤[20]. 高精度的图像分割在工业生产、医学图像处理以及科学研究等诸多领域都具有重要的应用空间. 卷积神经网络(CNN)是图像分割任务中的重要实现手段. 本文以卷积神经网络发展而来的CED和U-Net网络在Oxford-IIIT 3.0.0数据集[4]中的表现为例, 展示随机占优在神经网络比较中的应用. 两者的网络结构如图2所示, 其中Conv Block表示由两个包含3×3卷积核的卷积层组成卷积块; Pooling Layer为池化层; trConv Block表示由两组转制卷积(transposed convolution)组成的转制卷积块; Upsampling Layer表示上采样层. 需要注意的是, 为通过随机占优直观地对比两组结果相近的神经网络模型, 我们这里仅选用这两种在图像分类任务中经典的神经网络结构, 且无需关注在网络参数和结果精度上的优化.

|

图 2 本文使用的CED 神经网络结构和U-Net神经网络结构 |

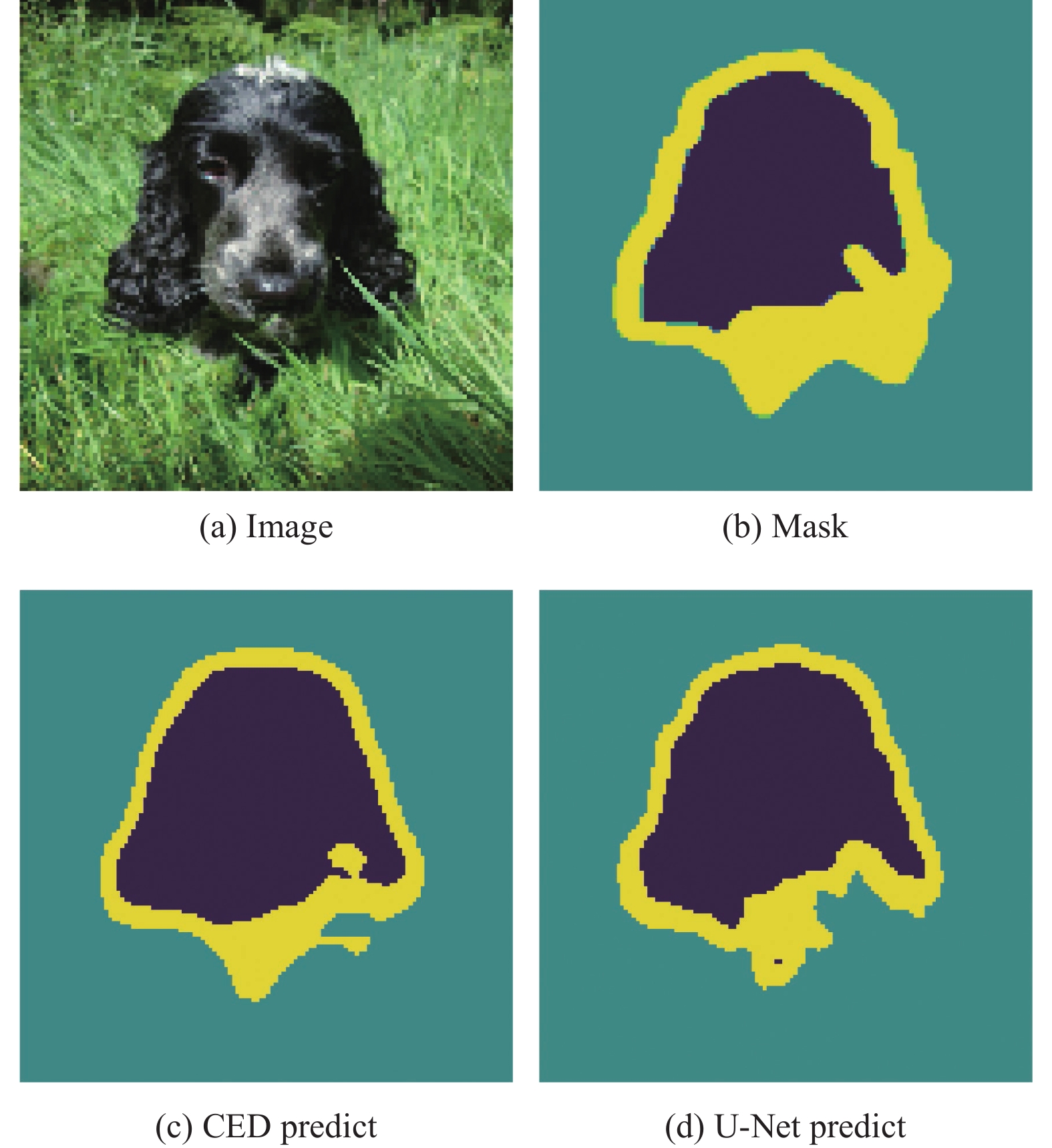

Oxford-IIIT数据集是一个宠物图像数据集, 包含了37种宠物的图片, 每种宠物约200张图片, 并包含了每张图片的宠物轮廓的标注信息. 我们分别以0, 1, 2标注没有宠物的区域, 宠物的轮廓以及宠物所在的区域. 在训练时, 我们把每一张图片转化为128×128像素的三通道图片, 并定义每一张图片的准确率(accuracy)为和标注完全一致的像素点占总的像素点的比例作为本文对网络评分的主要参数. 如图3所示, 图3(a)为需要进行图像分割的宠物图片, 图3(b)为标注后的轮廓图片, 图3(c)、图3(d)则分别是两个模型预测的结果.

|

图 3 宠物图片实例及其轮廓标注 |

3.2 应用随机占优对比网络模型预测结果的流程

传统的网络对比方法通常只关注网络预测结果与正确标签的误差. Dror等[7]将随机占优引入到网络对比中, 其主要流程为: 对于两个不同的网络结构A和B, 分别由n个和m个随机初始模型训练得到n个和m个模型

在实际应用中, 比较训练好的每个模型的表现同样值得关注, 因此本文提出随机占优应用于比较两个训练好的图像分割网络模型A和B, 流程如下: 分别计算A和B在测试集中每张图片中的准确率

我们首先重复Reimers等[5,6]以及Dror等[7]的方法对这两个网络进行评估. 我们分别使用500组不同的随机种子生成500组不同的初始模型对U-Net和CED网络各进行了500次训练. 每次训练使用的优化器均为Adam优化器[21], 且参数完全相同, 每次训练最大训练次数为50次, 并设置了accuracy稳定之后停止训练, 每次训练最终保留验证集表现最好模型.

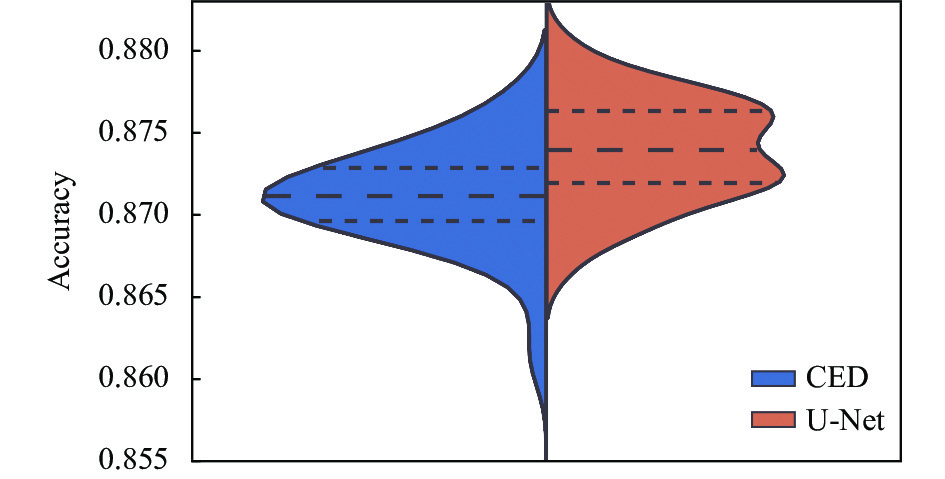

图4展示了通过训练得到的500个U-Net和CED模型在测试集中准确率的分布对比, 表1展示了两个网络得到500个模型准确率的均值、标准差、最大值、最小值. 可以看出U-Net网络表现的均值优于CED网络, 同时其标准差较小. 通过随机占优比较我们计算出U-Net相对于CED的占优指数为0, 这表明U-Net网络得到的模型的表现完全占优于CED网络.

|

图 4 在Oxford-IIIT数据集中500次初始模型训练对比 |

| 表 1 U-Net和CED在测试集500次得分的统计特征 |

4.2 U-Net和CED不同模型在测试集不同样本表现分布的对比

从不同随机种子的训练结果来看U-Net网络的表现明显是优于CED网络的表现的. 但是我们发现, U-Net网络训练出的模型对于训练集中不同样本的准确率的标准差(0.8附近)要比CED网络训练出的模型对于训练集中不同样本的准确率的标准差(0.7附近)更大. 这意味着U-Net网络训练出的模型尽管表现分数更好, 但是也更加离散. 这里我们从U-Net网络和CED网络中分别选出一个模型进行对比. 表2展示了这两个模型在测试集不同样本中准确率的均值、标准差、最大值和最小值. 从均值上看, U-Net模型的表现仍然优于CED模型的表现, 但是在标准差上U-Net模型的表现的离散程度要比CED模型的离散程度更大. 通过几乎随机占优, 我们可以得到CED相对于U-Net网络的占优指数为0.081928, 此时CED模型占优于U-Net模型.

| 表 2 U-Net和CED同一测试集得分的统计特征 |

为了排除这种占优是一种偶然现象, 我们从训练出的模型中有放回地随机选取了500对模型进行对比. 图5展示了这500对模型中CED网络模型相对于U-Net网络模型的占优指数的分布. 根据几乎随机占优理论占优指数小于0.5时CED网络模型占优于U-Net网络模型, 而当占优指数小于0.1时这种占优关系尤为明显, 相反则U-Net占优于CED网络. 从抽样结果中, 共有267对CED网络占优于U-Net网络, 163对占优指数小于0.1, 而占优指数大于0.9的仅有137对. 这显然与网络之间的对比的结论相反. 因此我们认为不同模型对于测试集中不同样本的表现的离散程度值得在神经网络评估时的重视.

|

图 5 500组抽样的CED和U-Net模型对的占优指数分布 |

在对神经网络结构和训练的研究中, 网络的占优关系可以有效地减少随机因素对研究的影响. 但在实际解决问题中, 模型的占优与否往往要比网络的占优与否更重要. 尤其是随着神经网络的发展准确率越来越接近100%的今天, 不同模型之间的差距越来越小, 模型在测试集中表现的离散度应引起足够的重视. 但仍然需要值得注意的是, 通常在表现相近的网络或模型(如准确率差距小于3%)中, 占优关系才可能和均值的表现相反, 而在表现差距较大时, 占优关系大概率和均值的表现是一致的.

4.3 通过几乎随机占优筛选出更合适的模型在上文中我们已经验证了随机占优可以有效地对不同模型进行比较. 更进一步我们可以利用随机占优的传递性筛选出更合适的模型, 对于n个训练好的模型其具体流程如下:

(1) 挑选模型集合中排序前两个模型分别命名为A和B;

(2) 通过随机占优对比A和B模型在测试集中评分的表现, 保留其中占优的模型并命名为A;

(3) 将集合序列中下一个模型命名为B;

(4) 重复步骤(2)和步骤(3)直至所有模型都被比较, 最后保留下的A模型即为n个模型中最优模型.

通过上述流程, 可以得到本文训练得到的500个U-Net模型中最优模型的评分均值为0.880197, 标准差为0.071627; 本文训练得到的500个CED模型中最优模型的评分均值为0.877677, 标准差为0.062972; 这两者中CED模型占优于U-Net模型, 计算得到的占优指数为0.187514.

5 结论与展望如何精确地评估神经网络的表现是当下神经网络的重要问题. 本文在Reimers等[5,6]以及Dror等[7]的工作基础之上进一步将几乎随机占优引入到神经网络模型在测试集中不同样本表现分布的对比中. 随机占优可以有效地解决在评估不同分布的对比时均值和方差结论不统一的问题. 通过图像分割的实验对比, 本文关注到不同神经网络模型在测试集中不同样本表现的离散性对于评估不同神经网络的重要性. 对于一些网络, 尽管不同次训练出来的模型总体的表现可能更好, 但是其每个模型对于测试集不同样本表现的方差仍然可能较大. 本文希望通过对随机占优方法的研究进一步提高神经网络对比的有效性.

| [1] |

周志华. 机器学习. 北京: 清华大学出版社, 2016.

|

| [2] |

Dauphin YN, Pascanu R, Gulcehre C, et al. Identifying and attacking the saddle point problem in high-dimensional non-convex optimization. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2014. 2933–2941.

|

| [3] |

Deng L. The MNIST database of handwritten digit images for machine learning research [best of the Web]. IEEE Signal Processing Magazine, 2012, 29(6): 141-142. DOI:10.1109/MSP.2012.2211477 |

| [4] |

Parkhi OM, Vedaldi A, Zisserman A, et al. Cats and dogs. 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012. 3498–3505.

|

| [5] |

Reimers N, Gurevych I. Optimal hyperparameters for deep LSTM-networks for sequence labeling tasks. arXiv:1707.06799, 2017.

|

| [6] |

Reimers N, Gurevych I. Reporting score distributions makes a difference: Performance study of LSTM-networks for sequence tagging. arXiv:1707.09861, 2017.

|

| [7] |

Dror R, Shlomov S, Reichart R. Deep dominance—How to properly compare deep neural models. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: ACL, 2019. 2773–2785.

|

| [8] |

Quirk JP, Saposnik R. Admissibility and measurable utility functions. The Review of Economic Studies, 1962, 29(2): 140-146. DOI:10.2307/2295819 |

| [9] |

Hadar J, Russell WR. Rules for ordering uncertain prospects. The American Economic Review, 1969, 59(1): 25-34. |

| [10] |

Hanoch G, Levy H. The efficiency analysis of choices involving risk. Stochastic Optimization Models in Finance. New York: Academic Press, 1975. 89–100.

|

| [11] |

唐爱国. 广义随机占优理论: 群体决策、收入分配与风险管理. 北京: 北京大学出版社, 2005.

|

| [12] |

Minaee S, Boykov Y, Porikli F, et al. Image segmentation using deep learning: A survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(7): 3523-3542. |

| [13] |

Chong E, Han C, Park FC. Deep learning networks for stock market analysis and prediction: Methodology, data representations, and case studies. Expert Systems with Applications, 2017, 83: 187-205. DOI:10.1016/j.eswa.2017.04.030 |

| [14] |

Yang JM, Price B, Cohen S, et al. Object contour detection with a fully convolutional encoder-decoder network. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 193–202.

|

| [15] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [16] |

Zhuang WW, Hu BY, Chen J. Semiparametric inference for the dominance index under the density ratio model. Biometrika, 2019, 106(1): 229-241. DOI:10.1093/biomet/asy068 |

| [17] |

Leshno M, Levy H. Preferred by “all” and preferred by “most” decision makers: Almost stochastic dominance. Management Science, 2002, 48(8): 1074-1085. DOI:10.1287/mnsc.48.8.1074.169 |

| [18] |

del Barrio E, Cuesta-Albertos JA, Matrán C. An optimal transportation approach for assessing almost stochastic order. The Mathematics of the Uncertain. Cham: Springer, 2018. 33–44.

|

| [19] |

Levy H, Robinson M. Stochastic Dominance: Investment Decision Making Under Uncertainty. New York: Springer, 2006.

|

| [20] |

Shapiro LG, Stockman GC. Computer Vision. New Jersey: Prentice Hall, 2001.

|

| [21] |

Kingma DP, Ba J. Adam: A method for stochastic optimization. arXiv:1412.6980, 2014.

|

2022, Vol. 31

2022, Vol. 31