在人机交互的场景中手势识别是一个基础研究, 因而在计算机视觉领域被广泛研究. 近年来, 随着廉价的动作传感器[1, 2]的普及和高效的手势估计算法[3–5]的发展, 基于骨架的手势识别吸引了越来越多研究人员的关注. 骨架数据相比于其他视频数据能够提供更为紧凑和对环境条件稳健的信息, 因此使用骨架实现更为准确的手势识别在人机交互[6]、人体行为理解[7]和监护系统[8]等方面具有非常有潜力的应用价值.

在实际应用中, 我们希望手势识别方法尽可能的快速轻量, 方便在低功耗的计算设备上部署应用. 因此, 如何使手势识别的方法更加轻量高效是在实际应用中最关键的一个问题.

我们将基于骨架的手势识别研究在特征设计方面大体分为两种: 一种是手工设计的描述符, 一种是基于深度学习自动学习的特征.

基于手工设计的描述符的方法除了直接使用骨架关节点的坐标[9–12]外, 还会利用关节点之间的联系设计一些几何特征和运动特征. 文献[13]使用关节点间距离、关节点间向量夹角、关节点间向量的模比这3种骨架的几何特征来描述手势动作, 然后利用长短期记忆网络(long short-term memory, LSTM)模型建立出多层级的手势识别模型. 文献[14]提出手在空间中运动的全局特征和局部特征, 然后将这两种特征融合后进行线性判别分析特征降维, 最后利用高斯核的支持向量机(support vector machine, SVM)进行动态的手势识别分类. 这里, 手部运动的全局特征为整个手部的平移和旋转运动, 局部特征为手指的平移和旋转运动. 文献[11, 12]提出使用腕关节和手心关节来描述手部的方向, 使用分组的关节坐标描述手部的形状, 运动信息使用关节点的速度作为特征, 最后使用线性核的SVM作为分类器实现手势识别. 文献[15, 16]提出计算每个关节点对的欧式距离和偏移, 以及关节点运动轨迹的双速度作为输入特征, 使用卷积网络提取特征完成手势分类. 虽然相比自动学习的特征, 手工设计的特征更为紧凑高效, 但是因为这些特征都是基于经验设计的特征, 对于难以充分描述的时域特征还有待充分挖掘.

随着机器学习的发展, 基于深度学习的手势识别方法成为研究人员的主要方向. 此类方法往往使用端对端的方式实现手势识别. 由于图卷积在节点分类、图分类上取得了不错的进展, 有很多文献使用图卷积提取骨架特征实现手势识别. 由于图卷积只能提取空域的特征, 但是对于动态手势识别来说, 时域信息也非常重要. 为了解决这个问题, 文献[17]使用了一种称为时空图卷积的模型, 可以同时提取骨架的空间特征和时间特征. 文献[18]提出使用图卷积和自注意力机制提取关节点和骨骼在空间和时间的特征. 然而除了图卷积比普通的卷积需要更多的计算量外, 有些关节点在骨架图上距离很远, 但在实际运动时却有很强的相关性, 这往往会限制图卷积学习到的骨架特征.

针对以上存在的问题, 我们提出一种轻量快速的手势识别模型. 它使用从骨架的关节点坐标序列经过简单的计算得到的几何特征, 以及自动学习的关节点运动轨迹特征. 然后只使用卷积网络作为骨干网络提取高层次的特征实现手势识别.

1 动态骨架序列的特征为了简化手势识别模型的复杂度, 我们提出了3种从骨架序列中提取的特征来作为模型的输入. 其中前两种特征是每一帧的空间特征, 可以通过简单的几何计算快速获得; 后一种是帧与帧之间的运动特征, 通过浅层的神经网络自动学习而来.

1.1 关节点集距离特征受到文献[15]的启发, 我们采用关节点集距离(joint collection distance, JCD)作为一个空间信息特征. 关节点距离特征的主要优点具有位置-视角不变性, 并且相比同类的特征[19]包含更少的元素.

关节点集距离的计算方式是计算骨架的每对关节点的欧式距离, 这样可以得到一个包含所有关节点对距离的对称矩阵. 然后为了压缩重复的信息, 我们只使用矩阵的下三角元素来构成一个特征向量. 具体来说, 我们假设一个骨架序列有T帧, 每帧的骨架有N个关节点, 那么在第k帧的关节点n的坐标可以表示为

| $ JC{D^k} = \left[ {\begin{array}{*{20}{c}} {\left\| {J_2^kJ_1^k} \right\|}&{}&{} \\ \vdots & \ddots &{} \\ {\left\| {J_N^kJ_1^k} \right\|}& \cdots &{\left\| {J_N^kJ_{N - 1}^k} \right\|} \end{array}} \right] $ |

其中,

关节点集距离只描述了每对关节点的距离, 而这些距离可以唯一的确定出一个没有方向(或者旋转)信息的形状. 但是我们认为骨架的方向信息对手势识别来说也很重要. 比如在前面拍篮球的手势, 和在侧边拍篮球的手势, 这两个动作的唯一的区别就是手部的朝向. 基于以上的观察, 我们又补充了关节点集方向特征作为手势识别模型的输入.

为了描述关节点集的方向, 我们考虑了两种方式来表示这一信息: 关节点方向锥和关节点方向树.

(1) 关节点方向锥(joint direction cone, JDC)

关节点方向锥是通过从关节点集中选择一个点作为起始点, 然后计算其他点与该点的偏移. 具体来说, 假如我们选择的起始点是手腕节点, 它的编号为1, 那么第k帧的骨架的关节点方向锥特征的计算公式如下:

| $ JD{C^k} = \left( {\overrightarrow {J_1^kJ_2^k} , \overrightarrow {J_1^kJ_3^k} , \cdots , \overrightarrow {J_1^kJ_N^k} } \right) $ |

其中,

(2) 关节点方向树(joint direction tree, JDT)

关节点方向树是在骨架的生理结构上定义的. 如图1所示, 我们在手部骨架上选择一个关节点作为树的根节点, 然后沿着手部骨架的骨骼逐步计算相邻关节点的偏移.

|

图 1 关节点方向树 |

一般来说, 假如骨架是一个无向图, 那么我们可以用类似于拓扑排序的方式得到这个图的关节点方向树特征. 具体算法如算法1.

算法1. 关节点方向树特征的算法

输入: 骨架

输出: JDT列表即为关节点方向树特征

1. JDT = []

2. S = [

3. Visited = [

4. while S is not empty do

5. i = Pop(S)

6. for all

7. Append(JDT,

8. Append(S, j)

9. Append(Visited, j)

10. end for

11. end while

这样, 可以通过以上算法获得一个唯一的描述关节点方向树的关节点偏移顺序, 进而就可以得到每一帧的JDT特征.

1.3 运动轨迹特征虽然关节点集距离特征和方向特征描述了骨架的空间特征, 但是它不包含全局的运动信息. 当一个手势运动涉及到运动轨迹时, 比如画V字型或者X字型的手势, 这时只使用空间信息是不够的.

在描述骨架运动时, 许多文献[9,12,15,16,20]使用速度或者加速度来描述, 并且文献[15]提出使用双速度来弥补运动速率不确定的问题. 而速度、加速度以及双速度的计算都是从同一关节点的连续3帧上计算得到的. 基于以上的观察, 我们提出一种简单的策略来自动学习运动轨迹特征, 就是使用核大小为1×3的2维卷积对骨架序列进行特征提取. 其中, 卷积核的1×3分别对应这骨架关节点数维度和骨架序列的时间长度. 我们叠加了多个2维卷积来更好地学习运动轨迹的语义特征.

2 基于骨架的手势识别在这一节, 我们介绍一下手势识别的数据预处理流程和手势识别模型的架构.

2.1 骨架序列预处理给定一段骨架序列, 我们首先使用中值滤波器(核大小为3)来对数据的每一维度降噪, 然后对每个维度使用三次样条插值算法将骨架序列采样为固定长度的序列(本文使用32帧), 并且再次使用中值滤波器降噪.

在送入模型提取特征之前, 我们对骨架序列做了归一化处理. 我们对每一维度减去该维度的均值, 这样既不影响关节点特征的计算, 又可以将骨架序列移动到中点位置起到归一化的效果.

2.2 手势识别模型的架构我们的手势识别模型的架构如图2所示. 相仿文献[15], 我们使用超参数filters来改变模型的参数量, 进而控制模型的计算复杂度. 在实验时我们使用16、32、64这3个级别展开对比.

对于预处理后的骨架序列, 假设其大小为T×N×D, 其中T代表序列长度(时间维度), N代表骨架关节点数(点数维度), D代表关节点信息(信息维度, 对于3维骨架来说

图2中, 标记“CNN (1, 2×filters), /2”表示使用的卷积为1维卷积(2维卷积使用“CNN2”表示), 卷积核大小为1, 输出通道的数量为2×filters, 并且使用BatchNorm和LeakyReLU激活函数. “/2”表示会对卷积的输出使用核大小为2的最大池化层以及在点数维度上的概率为0.1的Dropout. 标记“

|

图 2 模型结构 |

由于我们设计的3个特征能够较好地代表骨架运动, 所以不需要使用复杂的循环神经网络、图卷积或者自注意力机制等网络端对端地从关节点坐标上学习抽象特征, 而是只使用普通的卷积网络来做网络骨干即可取得较好的手势分类结果. 在设计卷积时, 我们使用的卷积都只在时间维度上提取特征, 而不在点数维度上提取特征. 这是因为不同的数据集在设计骨架关节点的顺序时, 序号连续的关节点不一定在空间和运动上有很强的相关关系.

最终我们的设计的手势识别模型非常轻量化. 和其他轻量化模型相比, 比如MobileNetV2[21], 其参数量为2.1 M到6.9 M, 而我们的模型的参数量在最小情况下仅为0.16 M, 而最大情况下也只有2.0 M. 虽然我们的模型的参数量非常少, 但是与其他手势识别方法相比性能也毫不逊色, 具体的比较见第3节的实验分析部分.

3 实验分析这一节, 我们分别在公开的数据集SHREC’17[12]和JHMDB[22]做实验. 我们首先在模型复杂度和两种关节点集方向特征上做实验对比, 最后与其他文献的结果做比较.

3.1 数据集(1) SHREC’17

SHREC 2017 Track数据集[12]是一个公开的动态手势数据集. 该数据集中的手势是从手部运动或者手部形状中定义出来的, 分为粗略的手势和精细的手势. 该数据集一共包含2 800个视频段, 分为14类手势. 然后每类手势又以两种方式表演: 使用一根手指或者整只手. 该数据集包含深度图像和骨架两种模态的数据, 其中骨架数据的关节点坐标又分为深度图像空间的和三维世界空间. 我们只使用三维世界空间的骨架数据做实验. 该数据集提供了官方的划分, 其中1 960段数据用作训练集(70%), 840段数据用作测试集(30%). 在测试时, 为了减少随机效果, 我们随机地选择3个不同的随机种子, 最后记录这些结果的平均值和标准差.

(2) JHMDB

关节点标注的人体动作数据集(joint-annotated human motion data base, JHMDB)[22]是一个人体动作和姿态的数据集. 该数据集的视频段采自互联网或者电影, 一共包含21种动作. 每个视频段为15到40帧, 并且人工地用人体姿态标注软件为每帧标注了2D关节点、缩放、视角等信息. 该数据集提供了官方的3种划分, 在测试时我们统计在这3个划分上取得结果的平均值和标准差.

3.2 实现细节因为我们的模型非常轻量, 在训练时我们将整个训练集整合为一个批次送给模型训练, 使用一个GTX 2080Ti显卡. 我们选择Adam (

(1) 比较两种关节点集方向特征和模型复杂度

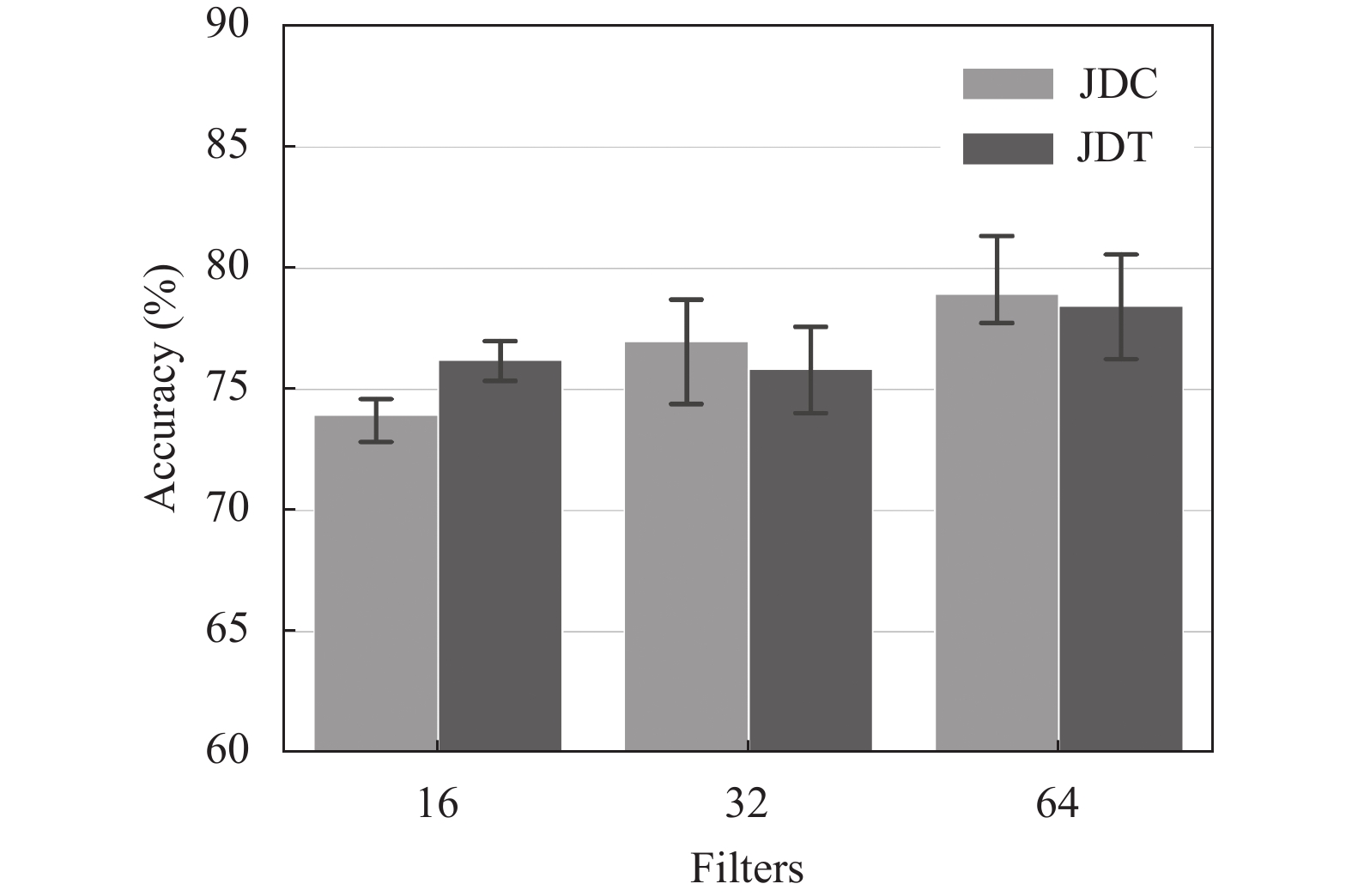

如第2.2节所述, 我们使用filters的大小来控制模型的复杂度(我们使用16、32和64来做对比), 然后在数据集SHREC’17和JHMDB对比了两种关节点集方向特征的差别, 它们的结果如图3和图4所示.

|

图 3 本文方法在数据集SHREC’17的结果 |

|

图 4 本文方法在数据集JHMDB的结果 |

在数据集SHREC’17上, 对于14种手势的分类, 使用JDC定义的模型在不同的复杂度下取得结果分别为94.57% (±0.3%), 95.33% (±0.3%), 95.90% (±0.2%); 使用JDT在不同的模型复杂度下取得结果分别为94.40% (±0.2%), 94.07% (±0.2%), 95.59% (±0.4%). 而在要求更为精细的28种手势分类下, JDC取得的结果为91.91% (±0.5%), 93.25% (±0.2%), 93.48% (±0.1%); JDT取得的结果为91.54% (±0.5%), 92.57% (±0.2%), 93.52% (±0.3%).

在数据集JHMDB上, 使用JDC取得的结果分别为73.96% (±0.8%), 76.98% (±1.9%), 78.94% (±1.7%); 使用JDT取得的结果分别为76.21% (±0.7%), 75.84% (±1.5%), 78.45% (±1.8%).

从结果我们可以看得出来, 这两种表示关节点集方向特征的方式具有相似的成效, 特别是对数据集JHMDB而言. 我们分析, 数据集JHMDB的关节点为2维坐标, 其运动轨迹没有像3维坐标那么有相似性, 所以该数据集的分类性能主要依赖空间特征而非运动特征. 但是总体来说, JDC略好于JDT.

(2) 和其他文献的结果对比

我们将这两个数据集的实验结果和其他文献对比, 结果展示在表1和表2中. 在数据集SHREC’17上, 和使用骨架的方法相比, 我们的方法在参数量仅为0.16 M时已与之前的最佳结果相近, 我们的方法最佳结果在14种手势上提高了1.3%的准确率, 在28种手势上提高了1.6%的准确率. 和使用其他模态的方法相比, 我们的方法在14种手势上与最佳方法接近, 而在28种手势上略低于最佳的方法. 但是由于我们的模型在提取特征的方式上非常简单直接, 相比于使用点云的最佳方法, 我们的模型的计算速度会快很多. 事实上, 使用点云的方法的计算量为16.1 GFLOPs, 而我们最佳结果的方法计算量仅为 0.03 GFLOPs. 在数据集JHMDB上, 我们的方法在参数量为0.53 M时与当前最佳方法的结果接近, 而我们最佳结果提高了1.7%的准确率.

| 表 1 数据集SHREC’17上的结果 |

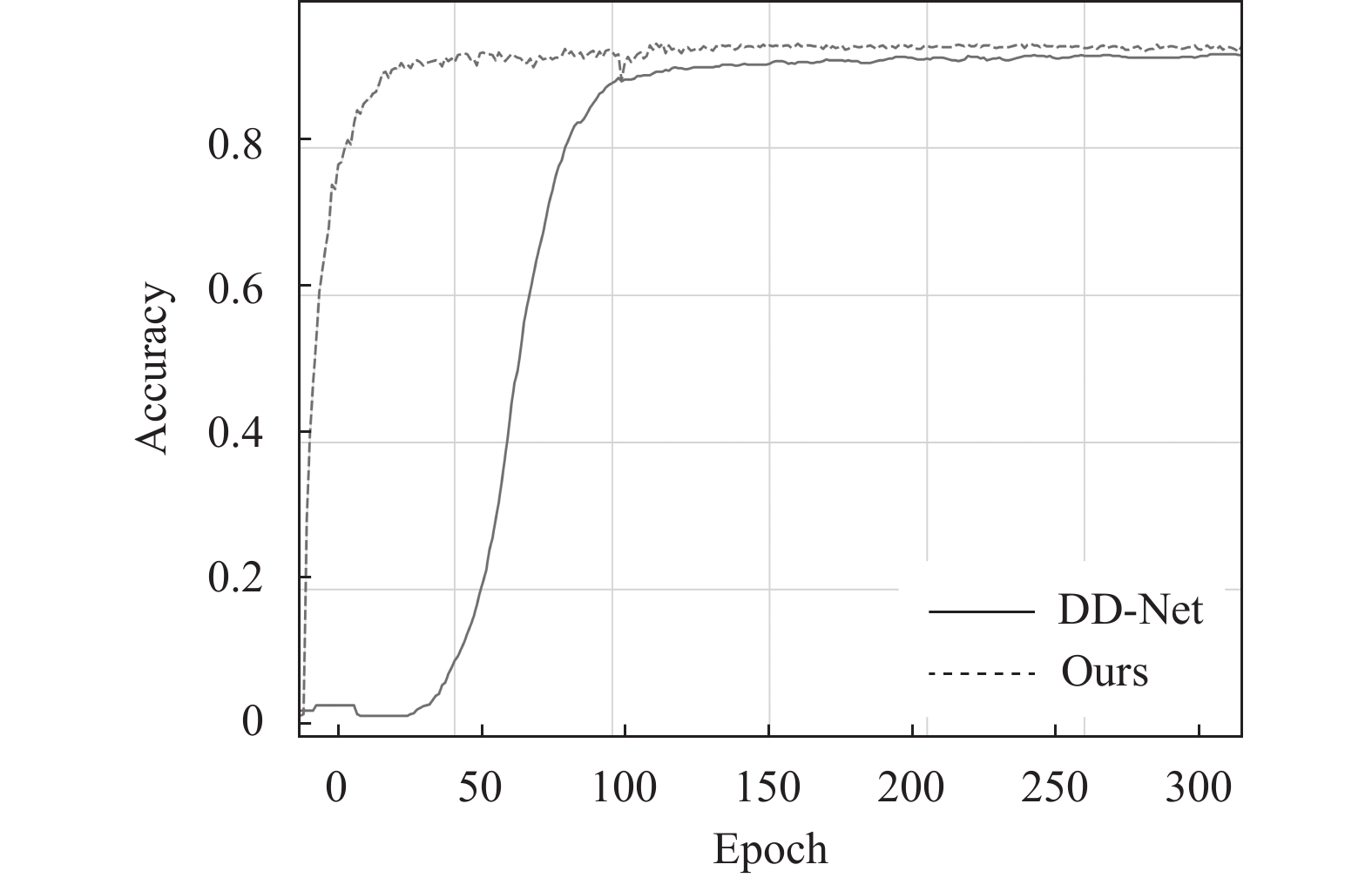

最后, 我们将我们的方法与其他方法进行收敛速度的对比. 我们对比的方法为同样轻量化的手势识别模型DD-Net[15], 该模型为数据集SHREC’17和JHMDB的当前最佳方法. 我们对比的代码为该模型公开的PyTorch实现版本. 我们在数据集SHREC’17的28种手势上使用相同的训练方式进行的对比, 图5为每个训练轮次模型在测试集上的准确率变化图, 可以观察到我们的方法具有更快的收敛速度.

| 表 2 数据集JHMDB上的结果 |

|

图 5 本文方法在收敛速度上的对比 |

4 结论与展望

本文提出了一种轻量的基于骨架的手势识别模型. 我们为这个模型提供了3种输入特征, 它们分别为关节点集距离特征、关节点集方向特征和运动轨迹特征. 本文为关节点集方向特征提出两种基本等效的描述方式, 它们分别为关节点方向锥(JDC)和关节点方向树(JDT). 我们将本文提出的方法在公开数据集SHREC’17和数据集JHMDB上进行了评估, 与输入为骨架模态的方法相比, 我们的方法上都取得了最好的识别结果. 在未来, 我们计划扩展我们模型的输入模态支持RGB和深度图像数据, 进一步提高模型的准确率.

| [1] |

Cao Z, Hidalgo G, Simon T, et al. OpenPose: Realtime multi-person 2D pose estimation using part affinity fields. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(1): 172-186. DOI:10.1109/TPAMI.2019.2929257 |

| [2] |

Shahroudy A, Liu J, Ng TT, et al. NTU RGB+ D: A large scale dataset for 3d human activity analysis. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1010–1019.

|

| [3] |

Zhang F, Bazarevsky V, Vakunov A, et al. MediaPipe hands: On-device real-time hand tracking. arXiv: 2006.10214, 2020.

|

| [4] |

Panteleris P, Oikonomidis I, Argyros A. Using a single RGB frame for real time 3D hand pose estimation in the wild. Proceedings of 2018 IEEE Winter Conference on Applications of Computer Vision. Lake Tahoe: IEEE, 2018. 436–445.

|

| [5] |

Ge LH, Liang H, Yuan JS, et al. Real-time 3D hand pose estimation with 3D convolutional neural networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(4): 956-970. DOI:10.1109/TPAMI.2018.2827052 |

| [6] |

Ren Z, Meng JJ, Yuan JS, et al. Robust hand gesture recognition with Kinect sensor. Proceedings of the 19th ACM International Conference on Multimedia. Scottsdale: ACM, 2011. 759–760.

|

| [7] |

Wei SE, Tang NC, Lin YY, et al. Skeleton-augmented human action understanding by learning with progressively refined data. Proceedings of the 1st ACM International Workshop on Human Centered Event Understanding from Multimedia. Orlando: ACM, 2014. 7–10.

|

| [8] |

Vijayakumari SG, Nandhinee G, Sneha KR. Hand gesture controlled aerial surveillance drone. International Journal of Pure and Applied Mathematics, 2018, 119(15): 897-901. |

| [9] |

Ghorbel E, Boutteau R, Boonaert J, et al. Kinematic spline curves: A temporal invariant descriptor for fast action recognition. Image and Vision Computing, 2018, 77: 60-71. DOI:10.1016/j.imavis.2018.06.004 |

| [10] |

Wang HS, Wang L. Beyond joints: Learning representations from primitive geometries for skeleton-based action recognition and detection. IEEE Transactions on Image Processing, 2018, 27(9): 4382-4394. DOI:10.1109/TIP.2018.2837386 |

| [11] |

de Smedt Q, Wannous H, Vandeborre JP. Skeleton-based dynamic hand gesture recognition. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Las Vegas: IEEE, 2016. 1206–1214.

|

| [12] |

de Smedt Q, Wannous H, Vandeborre JP, et al. SHREC’17 track: 3D hand gesture recognition using a depth and skeletal dataset. Proceedings of the 10th Eurographics Workshop on 3D Object Retrieval. Lyon: HAL, 2017. 1–6.

|

| [13] |

郭贺圆. 基于Kinect的手势动作识别技术研究[硕士学位论文]. 长春: 长春理工大学, 2020.

|

| [14] |

缪永伟, 李佳颖, 孙树森. 融合手势全局运动和手指局部运动的动态手势识别. 计算机辅助设计与图形学学报, 2020, 32(9): 1492-1501. |

| [15] |

Yang F, Sakti S, Wu Y, et al. Make skeleton-based action recognition model smaller, faster and better. arXiv: 1907.09658, 2020.

|

| [16] |

Emporio M, Caputo A, Giachetti A. STRONGER: Simple trajectory-based online gesture recognizer. In: Frosini P, Giorgi D, Melzi S, et al., eds. Proceedings of Eurographics Italian Chapter Conference—Smart Tools and Apps for Gra-phics. The Euro-graphics Association, 2021.

|

| [17] |

王焱章. 基于时空图卷积网络的手语翻译[硕士学位论文]. 南京: 南京邮电大学, 2020.

|

| [18] |

Chen YX, Zhao L, Peng X, et al. Construct dynamic graphs for hand gesture recognition via spatial-temporal attention. Proceedings of the 30th British Machine Vision Conference. Cardiff: BMVA Press, 2019. 103.

|

| [19] |

Li CK, Wang PC, Wang S, et al. Skeleton-based action recognition using LSTM and CNN. Proceedings of 2017 IEEE International Conference on Multimedia & Expo Workshops. Hong Kong: IEEE, 2017. 585–590.

|

| [20] |

Wang YX, Shi YB, Wei GL. A novel local feature descriptor based on energy information for human activity recognition. Neurocomputing, 2017, 228: 19-28. DOI:10.1016/j.neucom.2016.07.058 |

| [21] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520.

|

| [22] |

Jhuang H, Gall J, Zuffi S, et al. Towards understanding action recognition. Proceedings of 2013 IEEE International Conference on Computer Vision. Sydney: IEEE, 2013. 3192–3199.

|

| [23] |

Kingma DP, Ba J. Adam: A method for stochastic optimization. arXiv: 1412.6980, 2014.

|

| [24] |

Min YC, Zhang YX, Chai XJ, et al. An efficient PointLSTM for point clouds based gesture recognition. Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 5760–5769.

|

| [25] |

Hou JX, Wang GJ, Chen XH, et al. Spatial-temporal attention Res-TCN for skeleton-based dynamic hand gesture recognition. Proceedings of ECCV 2018 Workshops on Computer Vision. Munich: Springer, 2018. 273–286.

|

| [26] |

Yan SJ, Xiong YJ, Lin DH. Spatial temporal graph convolutional networks for skeleton-based action recognition. Proceedings of the 32nd AAAI Conference on Artificial Intelligence and 30th Innovative Applications of Artificial Intelligence Conference and 8th AAAI Symposium on Educational Advances in Artificial Intelligence. New Orleans: AAAI, 2018. 912.

|

| [27] |

Zolfaghari M, Oliveira GL, Sedaghat N, et al. Chained multi-stream networks exploiting pose, motion, and appearance for action classification and detection. Proceedings of 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2904–2913.

|

| [28] |

Ludl D, Gulde T, Curio C. Simple yet efficient real-time pose-based action recognition. Proceedings of 2019 IEEE Intelligent Transportation Systems Conference. Auckland: IEE, 2019. 581–588.

|

| [29] |

Choutas V, Weinzaepfel P, Revaud J, et al. PoTion: Pose motion representation for action recognition. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7024–7033.

|

2022, Vol. 31

2022, Vol. 31