2. 西南交通大学 计算机与人工智能学院, 成都 610031

2. School of Computing and Artificial Intelligence, Southwest Jiaotong University, Chengdu 610031, China

随着移动应用和物联网的快速发展, 功率和计算资源有限的移动设备(MDs)不再满足资源密集型应用的严格要求, 如低延迟、高可靠性、用户体验连续性的要求[1]. 在移动边缘计算(MEC)中, 网络运营商和服务提供商进行合作, 在网络边缘提供优秀的通信和计算资源, 以增强MD能力[2].

在MEC中, 计算资源的管理在提高资源利用率和优化系统资源效益方面起着至关重要的作用[3]. 由MEC服务器处理外部任务会消耗本地计算资源. 因此, 每个MD根据某种资源定价机制支付一定的服务费, 以激励边缘云提供足够的计算资源.

现有的定价机制, 如基于拍卖的, 依赖于中间机构的静态定价[4–6]. 拍卖双方都需要向中介提供的服务支付费用. 总成本的增加使得双方都无法从资源交易中获得最佳的利益. 同时, 静态定价也不能适应MD不断变化的资源需求. 在这种情况下, MEC服务器很难有效地利用其本地资源. 因此, 一个关键的问题是如何有效地将有限的MEC资源分配给具有不同需求和偏好的相互竞争的MD. 为此, 我们将MEC环境中的多资源分配和定价问题表述为一个包含一个领导者和多个跟随者的多阶段Stackelberg博弈, 其中所有MEC服务器同时将它们的实时价格发送到一个聚合平台(AP). 在第1阶段, 通过MEC服务器公布的价格, AP通过解决一个效用最大化问题来找到最优的资源分配解决方案. 在第2阶段, 基于环境的反馈(即资源如何分配给MDs), 我们利用多代理近端策略优化(MAPPO)算法[7]学习每个MEC服务器的最优定价策略, 这种策略不需要MEC服务器获取其他MEC服务器实现的定价策略就可以做出最优的决策.

我们的主要贡献如下: (1)我们通过构建一个Stackelberg的领导者-跟随者博弈, 充分考虑了AP和MEC服务器之间的互动以及服务器之间的竞争. 纳什均衡给出了完全竞争的合理结果. (2)该算法基于MAPPO, 这是一种具有集中式训练和分布式执行的深度强化学习算法, 能够适应环境动力学和参数的不确定性. 每个MEC服务器作为一个智能体, 不断地与环境交互, 以生成一系列的培训经验. 智能体既不需要事先了解MEC资源的折扣成本, 也不需要知道其他智能体所采取的行动. 因此, 信号传递的开销就大大减少了. (3)仿真结果表明, 该算法可以为每个MEC服务器学习一个优秀的策略, 以确定其资源的单价.

2 相关工作边缘系统的最优资源分配和定价已经引起了越来越多的研究关注. 主要有两个研究方向: 定价导向因素和最优定价策略.

定价导向因素. Dong等人[8]提出了一种云计算资源定价算法, 分析历史资源使用情况并不断调整资源价格. 但该算法只考虑了资源利用率, 没有分析其他重要因素. Liu等人[9]提出了一种基于价格的分布式算法, 只强调了任务调度. Li等人[10]提出了云计算的静态资源定价方案. 定价操作简单, 但难以满足终端设备的动态需求. 他们没有考虑用户需求与资源价格之间的实时关系, 因此不能根据用户需求动态调整资源价格.

最优定价策略. 现有的最优定价策略大多是基于拍卖和博弈论的. Zhang等人[11]研究了通过基于拍卖的算法对系统效益和多维资源的联合优化. 解决方案是系统性能改进和单位效益的产物. 然而, 该算法以每一轮拍卖为优化目标, 难以接近全局最优. 因此, 执行成本非常高. Dong等人[12]采用了一种基于价格的双层Stackelberg博弈来模拟一个由单个MEC服务器和多个用户组成的MEC系统.

3 系统模型 3.1 网络模型MEC系统模型由多个利益相关者组成: (1)希望出售免费资源的MEC服务器; (2)希望购买资源以执行计算任务的MD; (3)AP作为第三方代理, 代表MD从MEC服务器购买资源. 不失一般性, 我们考虑一个通用的“多对多”场景, 即每个MEC都可以将资源出售给多个MD. 同时, 每个MD可以购买多个MEC服务器出售的资源.

我们考虑一个具有多个MD和具有多种类型资源的多个MEC服务器的MEC系统. 我们用

(1) MEC服务器

(2) 给定价格

(3) MD

Stackelberg领导者-跟随者博弈是一个策略游戏, 其中领导者承诺一个策略, 然后跟随者跟随[13]. 一般来说, 游戏中的所有玩家都是自私的, 因为他们每个人都考虑了他人的策略来最大化自己的利益. 具体来说, 考虑到跟随者可能采取的策略, 领导者选择了一种最大化其利益的策略. 基于观察领导者的策略, 每个跟随者都采用了使其利益最大化的策略. 然后, 我们解释了跟随者之间的竞争. 通过MAPPO算法, 得到了每个跟随者的最佳响应. 在这个算法中, 每个跟随者都与环境交互, 并学习一种策略来优化其长期奖励, 而不需要考虑他人采取的行动. Stackelberg领导者-跟随者博弈的定义如下:

玩家: AP和MEC服务器都是游戏玩家. AP是领导者, 而所有的MEC服务器都是跟随者.

策略: 对于MEC服务器

收益: MEC服务器、MD 和AP的收益函数分别由式(1)–式(3)给出.

令

| ψi(xi,pi)=∑r∈Rpi,r∑j∈Uxi,j,r,∀i∈M | (1) |

其中,

MD

| ϕj(xi,p)=∑r∈Rlog(∑i∈Mωi,j,rxi,j,r)−∑i∈Mpi,j,rxi,j,r,∀j∈U | (2) |

其中,

AP的收益是所有MEC服务器和MD收益的总和(即社会福利), 定义如下:

| ϕ(x,p)=∑i∈Mψi(xi,pi)+∑j∈Uϕj(xi,p)=∑j∈U∑r∈Rlog(∑i∈Mωi,j,rxi,j,r) | (3) |

其中,

由于所有资源都有独立的预算, 且彼此不受影响, 因此我们可以将多资源分配和定价问题分解为多个单资源分配和定价子问题. 因此, 我们将优化问题分解为R个独立的子问题, 每个子问题都与特定的资源类型相关联. 与整体处理原始优化问题相比, 该分解的主要优点是处理多个子问题显著降低了计算复杂度. 与

| ψi,r(xi,r,pi,r)=pi,r∑j∈Uxi,j,r,∀i∈M | (4) |

| ϕr(xr,pr)=∑j∈Ulog(∑i∈Mωi,j,rxi,j,r) | (5) |

其中,

定义1. 令

| ψi,r(x∗i,r,p∗i,r)⩾ψi,r(x∗i,r,pi,r), ∀pi,r≠p∗i,r | (6) |

| φr(x∗r,p∗r)⩾φr(xr,p∗r), ∀xr≠x∗r | (7) |

针对与资源

问题1:

| {maxxr={xi,j,r}i∈M,j∈Uϕr(xr,pr)s.t.∑j∈Uxi,j,r⩽Qi,r,∀i∈M∑i∈Mpi,rxi,j,r⩽Bj,r,∀j∈U | (8) |

其中,

定理1. 问题1的最优解如下:

| x∗i,j,r={Bj,rωi,j,rpi,r∑i∈Mωi,j,r,ifI⩾0Qi,rωi,j,r∑j∈Uωi,j,r,otherwise | (9) |

其中,

| I=∑j∈Ulog(∑i∈MBj,rω2i,j,rpi,r∑i∈Mωi,j,r)−∑j∈UQi,rω2i,j,r∑j∈Uωi,j,r | (10) |

证明见附录A.

4 基于MAPPO的AP收益优化本节将介绍每个MEC服务器如何选择其对AP所采用的策略的最佳响应.

4.1 基于深度强化学习的方法我们使用多智能体强化学习(multi-agent reinfo-rcement learning, MARL)来解决多重单一资源分配和定价子问题. 我们将每个子问题描述为一个马尔可夫决策过程(Markov decision process, MDP), 以准确地反映资源分配和定价的决策过程. 然后, 我们将 MAPPO应用于这些子问题. 由于其在全局优化方面的出色性能, MAPPO可以在需要时快速为每个MEC服务器获得接近最优的单一资源分配和定价策略.

对于资源

| maxpi,rψi,r(xi,r,pi,r)s.t.pi,r⩾0 | (11) |

MDP的元素如下所示, 包括状态空间、动作空间和奖励函数.

状态空间: MEC服务器

| oti=[pt−1i,r,xt−1i,r,⋯,pt−Li,r,xt−Li,r],∀i∈M | (12) |

全局状态: MAPPO基于全局状态

| st=(ot1,⋯,otM) | (13) |

动作空间: 在时隙

| ati=ui(oti|θui) | (14) |

奖励函数: 奖励函数定义如下:

| rt=M∑i=1log(1+pti,r∑j∈Uxti,j,r−cti∑j∈Uxti,j,r) | (15) |

其中,

MARL 算法可以分为两种框架: 集中式学习和分散式学习. 集中式方法假设合作博弈, 并通过学习单一策略直接扩展单智能体强化学习算法, 以同时产生所有智能体的联合动作. 在分散学习中, 每个智能体都优化自己的独立奖励; 这些方法可以解决非零和博弈, 但可能会受到非平稳转换的影响. 最近的工作已经开发出两条研究路线来弥合这两个框架之间的差距: 集中培训和分散执行(centralized training and decentralized execution, CTDE)和值分解(value decomposition, VD). CTDE通过采用actor-critic结构并学习集中的critic来减少方差, 从而改进了分散的强化学习. 代表性的CTDE方法是多智能体深度确定性策略梯度(multi-agent deep deterministic policy gradient, MADDPG)[14]. VD通常与集中式Q学习相结合, 将联合Q函数表示为每个代理的局部Q函数的函数[15], 这已被视为许多MARL基准测试的黄金标准. MAPPO通过将单个近端策略优化算法(proximal policy optimization algorithms, PPO)[16]训练与全局值函数相结合, 属于CTDE类别. 不同的是PPO是一个on-policy算法, MADDPG是基于off-policy的算法, 但是MAPPO经过简单的超参数调整就能获得比较好的成绩.

在RAP-MAPPO中, 每个MEC服务器都被视为一个智能体. 每个智能体都有一个参数为

Actor网络被训练用来最大化:

| L(θ)=[1BnB∑i=1n∑k=1min(rkθ,iAki,clip(rkθ,i,1−ε,1+ε)Aki)]+σ1BnB∑i=1n∑k=1S[πθ(oki)] | (16) |

其中,

Critic网络被训练用来最大化.

| L(ς)=1BnB∑i=1n∑k=1max[(Vς(ski) - ˆRi)2, (clip(Vς(ski),Vςold(ski)−ε,Vςold(ski)+ε)−ˆRi)2] | (17) |

其中,

算法1. RAP-MAPPO的训练过程

初始化: 初始化actor网络和critic网络的参数

1: 设置学习率

2: while

3: 令 data buffer

4: for

5:

6: fort=1 to T do

7:

8: 计算动作

9:

10: 计算

11: for 1=1, 2, …, T //L do

12:

13: 从D中随机抽取K个样本

14: 通过

我们考虑一个由多个MEC服务器和多个MD组成的MEC系统. 收益最大化问题取决于可用的资源和预算. 为简单起见, 我们设置

质量比例最优定价(quality proportional optimalpricing, QPOP): 我们假设AP对每个MEC服务器提供的资源质量有一个先验的知识. 单价设置与服务器的资源质量成正比, 同时消耗确定的资源和货币预算(即

随机: 单价在(0, 5)区间内随机产生.

| 表 1 仿真参数 |

MADDPG: 每个MEC服务器都被视为一个智能体, 状态空间由前L个时隙的价格和资源分配组成, 动作是资源的单价, 奖励函数基于MEC服务器的资源收入和成本设计.

5.2 收敛性图1为所提出的RAP-MAPPO和MADDPG在不同MEC服务器数量下的收敛曲线. 随着训练次数的增加, MEC服务器的平均奖励逐渐上升, 最终变为积极和稳定. 我们首先研究了MEC服务器的数量对收敛性的影响. 随着MEC服务器的增加, 这两种算法都需要更多的时间来收敛. 这是因为更多的服务器会导致更大的状态空间. 这两种算法需要对状态空间进行更多的探索, 才能获得可观的奖励. 此外, MEC服务器的平均奖励随着MEC服务器的增加而降低. 这是因为更多的服务器会在竞争期间降低价格, 也就是说, 每个服务器都希望出售其资源. 然后, 我们比较了两种算法在收敛性方面的性能. 我们很容易观察到, 与MADDPG相比, RAP-MAPPO具有收敛速度更快、平均奖励速度更高的特点.

|

图 1 不同算法的收敛性曲线 |

5.3 MEC服务器和MDs在Stackelberg均衡下的收益

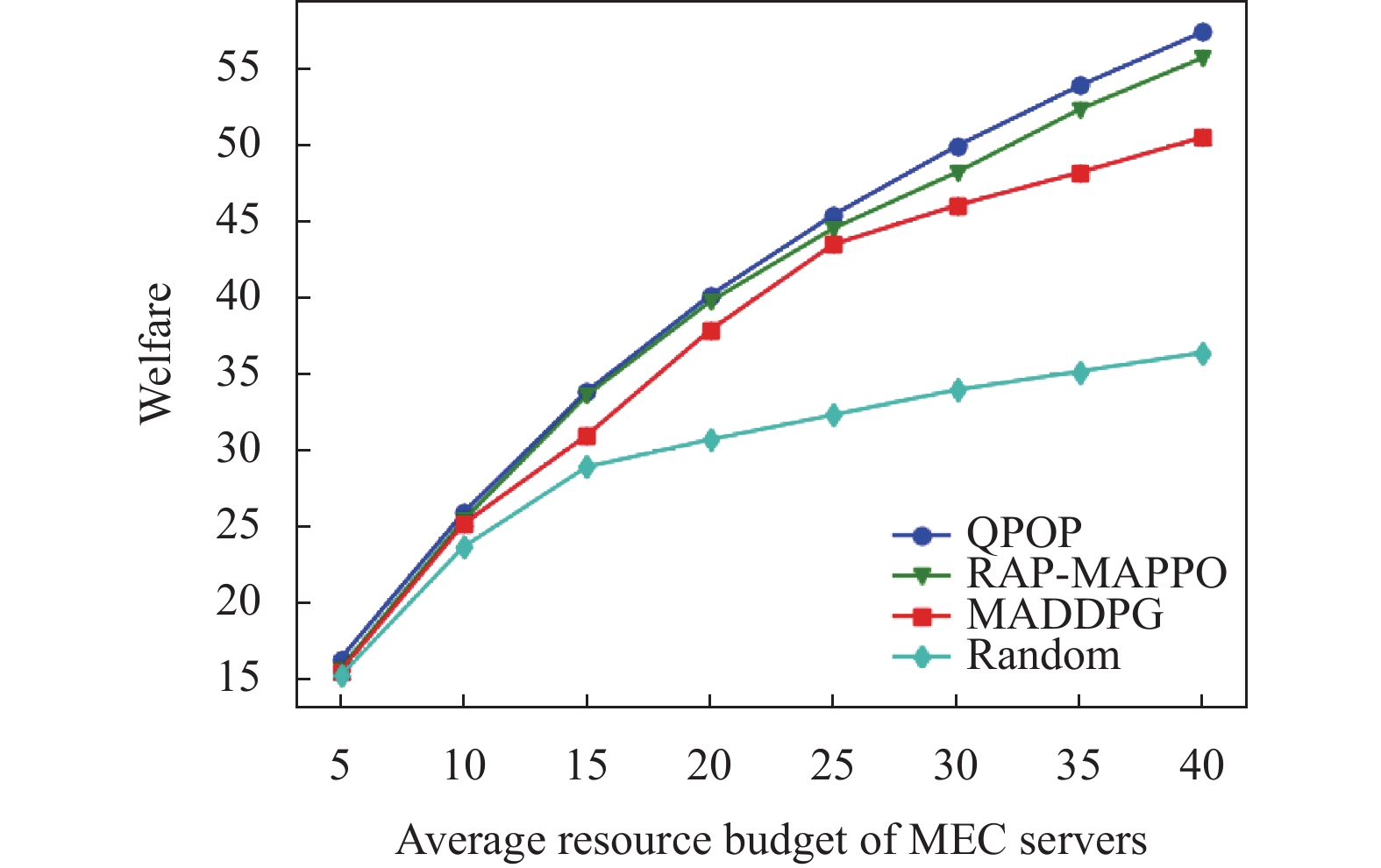

我们在两种场景下比较了这4种算法. 在第1种场景下,

在第1种场景下, RAP-MAPPO在没有对MEC服务器提供的资源质量的先验知识的情况下, 获得了接近最优的性能, 如图2所示. 当MEC服务器的资源不足时, MD之间的激烈竞争导致了卖方市场. 同时, RAP-MAPPO在社会福利方面优于MADDPG和随机算法(见图3). 这是因为随机定价不能充分利用MEC服务器的资源, 而RAP-MAPPO则鼓励MEC服务器动态调整其单价, 以达到提高资源效率的目的.

|

图 2 不同MEC资源数量下MEC服务器收益 |

|

图 3 不同MEC资源数量下社会福利 |

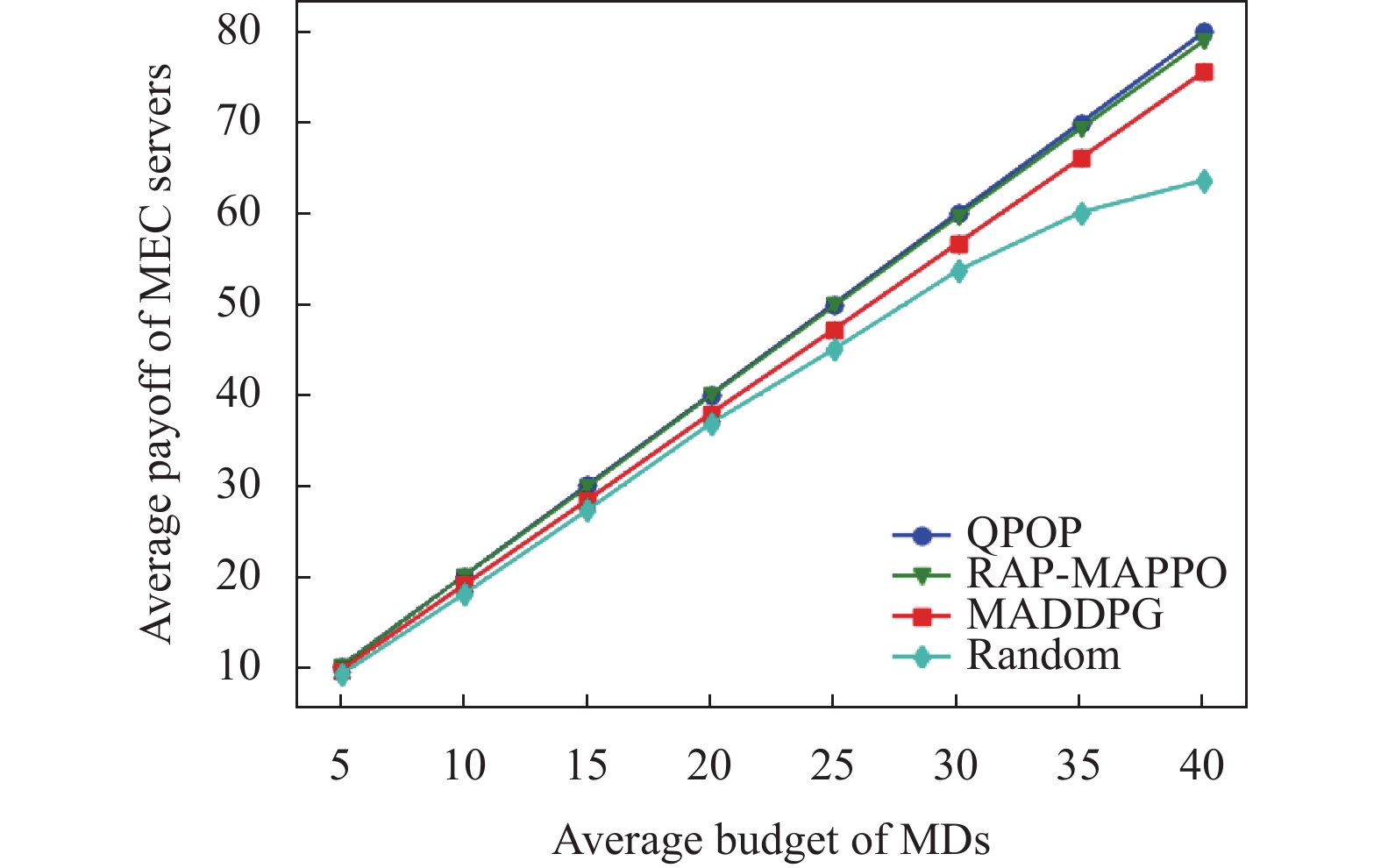

在第2种场景下, 从图4和图5可以看出, 在大多数情况下, RAP-MAPPO在MD收益和社会福利方面比MADDPG和随机算法获得了更好的性能. 随着MD的平均货币预算的增长, MEC服务器更有可能提高价格, 以响应AP的资源购买策略. 因此, MD需要降低他们的资源需求或支付更多的费用来鼓励MEC服务器销售更多的资源, 从而减少MD的回报, 即卖方市场.

|

图 4 不同MD预算下MEC服务器收益 |

|

图 5 不同MD预算下社会福利 |

综上所述, RAP-MAPPO在MEC服务器的收益和社会福利方面的表现优于MADDPG和随机算法. 它的性能与QPOP类似. QPOP需要知道MEC服务器的质量权重信息和MEC服务器之间的无条件合作, 而我们的方法只是基于与环境相互作用的局部观察.

6 结论本文研究了基于Stackelberg博弈的资源分配和定价问题, 其中AP和MEC服务器是领导者和追随者. 这个问题被分解为多个可以单独解决的单一资源类型的子问题. 我们采用MAPPO来解决这个问题. 对于任意的MEC服务器, RAP-MAPPO不需要知道其他MEC服务器所采取的操作, 这有助于减少信令开销. 此外, RAP-MAPPO可以通过一系列的状态-行动-奖励观察来指导竞争智能体实现收益最大化. 仿真结果表明, 在RAP-MAPPO中, MD和MEC服务器在满足前者严格的货币预算约束的同时, 学习了接近最优的回报. 此外, RAP-MAPPO在收益和社会福利方面都优于QPOP、随机和MADDPG.

| [1] |

Ding HC, Zhang C, Cai Y, et al. Smart cities on wheels: A newly emerging vehicular cognitive capability harvesting network for data transportation. IEEE Wireless Communications, 2018, 25(2): 160-169. DOI:10.1109/MWC.2017.1700151 |

| [2] |

Asir TRG, Manohar HL. Key challenges and success factors in IoT—A study on impact of data. Proceedings of 2018 International Conference on Computer, Communication, and Signal Processing. Chennai: IEEE, 2018. 1–5.

|

| [3] |

Shi WS, Cao J, Zhang Q, et al. Edge computing: Vision and challenges. IEEE Internet of Things Journal, 2016, 3(5): 637-646. DOI:10.1109/JIOT.2016.2579198 |

| [4] |

Yang B, Li ZY, Jiang SL, et al. Envy-free auction mechanism for VM pricing and allocation in clouds. Future Generation Computer Systems, 2018, 86: 680-693. DOI:10.1016/j.future.2018.04.055 |

| [5] |

Bonacquisto P, di Modica G, Petralia G, et al. A procurement auction market to trade residual cloud computing capacity. IEEE Transactions on Cloud Computing, 2015, 3(3): 345-357. DOI:10.1109/TCC.2014.2369435 |

| [6] |

Tanaka M, Murakami Y. Strategy-proof pricing for cloud service composition. IEEE Transactions on Cloud Computing, 2016, 4(3): 363-375. DOI:10.1109/TCC.2014.2338310 |

| [7] |

Yu C, Velu A, Vinitsky E, et al. The surprising effectiveness of PPO in cooperative, multi-agent games. arXiv: 2103.01955, 2021.

|

| [8] |

Dong SQ, Li HL, Qu YB, et al. Survey of research on computation unloading strategy in mobile edge computing. Computer Science, 2019, 46(11): 32-40. |

| [9] |

Liu MY, Liu Y. Price-based distributed offloading for mobile-edge computing with computation capacity constraints. IEEE Wireless Communications Letters, 2018, 7(3): 420-423. DOI:10.1109/LWC.2017.2780128 |

| [10] |

Li ZT, Kang JW, Yu R, et al. Consortium Blockchain for secure energy trading in industrial Internet of Things. IEEE Transactions on Industrial Informatics, 2018, 14(8): 3690-3700. |

| [11] |

Zhang HL, Guo FX, Ji H, et al. Combinational auction-based service provider selection in mobile edge computing networks. IEEE Access, 2017, 5: 13455-13464. DOI:10.1109/ACCESS.2017.2721957 |

| [12] |

Dong LQ, Han SY, Gao Y, et al. A game-theoretical approach for resource allocation in mobile edge computing. Proceedings of the 2020 IEEE 20th International Conference on Communication Technology. Nanning: IEEE, 2020. 436–440.

|

| [13] |

Varian HR. Intermediate Microeconomics: A Modern Approach. 9th ed, New York: William Warder Norton & Company, 2014.

|

| [14] |

Lowe R, Wu Y, Tamar A, et al. Multi-agent actor-critic for mixed cooperative-competitive environments. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6382–6393.

|

| [15] |

Sunehag P, Lever G, Gruslys A, et al. Value-decomposition networks for cooperative multi-agent learning based on team reward. Proceedings of the 17th International Conference on Autonomous Agents and MultiAgent Systems. Stockholm: ACM, 2018. 2085–2087.

|

| [16] |

Schulman J, Wolski F, Dhariwal P, et al. Proximal policy optimization algorithms. arXiv: 1707.06347, 2018.

|

2022, Vol. 31

2022, Vol. 31