2. 中国科学院大学, 北京 100049;

3. 中国医科大学附属第四医院, 沈阳 110032;

4. 东软集团股份有限公司 医疗解决方案事业本部, 沈阳 110003

2. University of Chinese Academy of Sciences, Beijing 100049, China;

3. The Fourth Affiliated Hospital of China Medical University, Shenyang 110032, China;

4. Medical Solutions Business Division, Neusoft Group Co. Ltd., Shenyang 110003, China

医疗电子病历[1]现今在临床诊断中被广泛应用, 近几年伴随着机器学习、深度学习的快速发展, 结构化电子病历得到了大众的关注. 由于难以将医生对病症的描述进行统一, 使得结构化医疗术语无法建立. 具体来说, 对于同一种疾病, 不同的医生在表达方式、中文的繁简体, 英文字母的大小写上的区别, 导致在医疗领域难以形成规范化的标准.

命名实体识别(NER)是自然语言处理(NLP)中信息抽取任务的一种, 在NLP的基础建设中有着较为广泛的应用. 结构化的电子病历需要实体的准确描述, 不能存在歧义或表述不明. 中文由于没有明确的分隔符, 使得实体识别的难度大大增加. 就模型训练而言, 使用词作为最小粒度还是字作为最小粒度会随着不同的应用场景有不同的效果, 难以确定使用哪种方式最好.

就提高命名实体识别的准确率方面, 孟捷[2]使用条件随机场CRF先对文本进行分词, 之后对分词结果进行属性标注, 并在词典中引入ICD-10标准, 使得实体识别取得了较好的效果. 江涛[3]提出了一种兼顾字词并通过自注意力机制延长实体联系距离的WC-LSTM模型, 使用Word2Vec训练的100维词向量嵌入模型, 并与Bi-LSTM和Lattice-LSTM模型进行对比. 沈宙锋等人[4]基于XLNet-BiLSTM模型, 通过对电子病历的序列化表示, 使得一词多义的问题得到了更好的解决. 王若佳等人[5]在使用无监督学习的AC自动机上对中文电子病历进行分词, 结合条件随机场和不同的实体类别, 得到了较好的识别模板. Zhang等人[6]为解决中文实体的边界问题, 提出了一种基于单词方法和基于字符方法进行识别的方式, 在研究中, 为解决字符缺乏词级别信息和词边界信息, 使用了一种融合自匹配词特征的神经实体识别模型, 并在训练集上取得了不错的效果. Ji等人[7]提出一种句子级的基于多神经网络模型的协同协作方法来进行实体识别, 通过Word2Vec、GloVe、ELMo对特定汉字嵌入预训练, 在BiLSTM-CRF和CNN模型上进行了模型测试. 李丹等人[8]提出了一种部首感知的识别方法, 该方法将部首信息编码到字向量中, 利用BiLSTM-CRF结合Bert模型, 使实体识别有一定的提高.

在过去的研究中, 大部分研究人员着重在于对文字进行处理, 而对标签在文本的上下文中的作用以及文本的预处理结果是否符合规范缺少关注. 查阅资料中考虑到, 如果可以在研究文字的同时挖掘电子病历标签中的隐含信息, 对于命名实体识别工作会有帮助. 例如, 病历中常用“宫颈癌”作为疾病术语, 那么在宫颈一词中被预测为疾病的实体, 应该以3个字的可能性较大, 不会出现诸如“宫颈的癌”或“宫颈的癌变”这样的实体, 从而提高实体识别的准确性, 且多头注意力机制使得模型在训练过程中关注模型感兴趣的部分, 对于模型的训练有益. 基于以上描述, 本文以建立结构化电子病历为目的, 从电子病历的实体识别开始研究, 提出WT-MHA-BiLSTM-CRF模型, 该模型同时考虑文字和标签中的信息. 为保证模型的可信性, 将实验结果与BiLSTM-CRF[9], BiGRU-CRF, MHA-BiLSTM-CRF模型进行了对比.

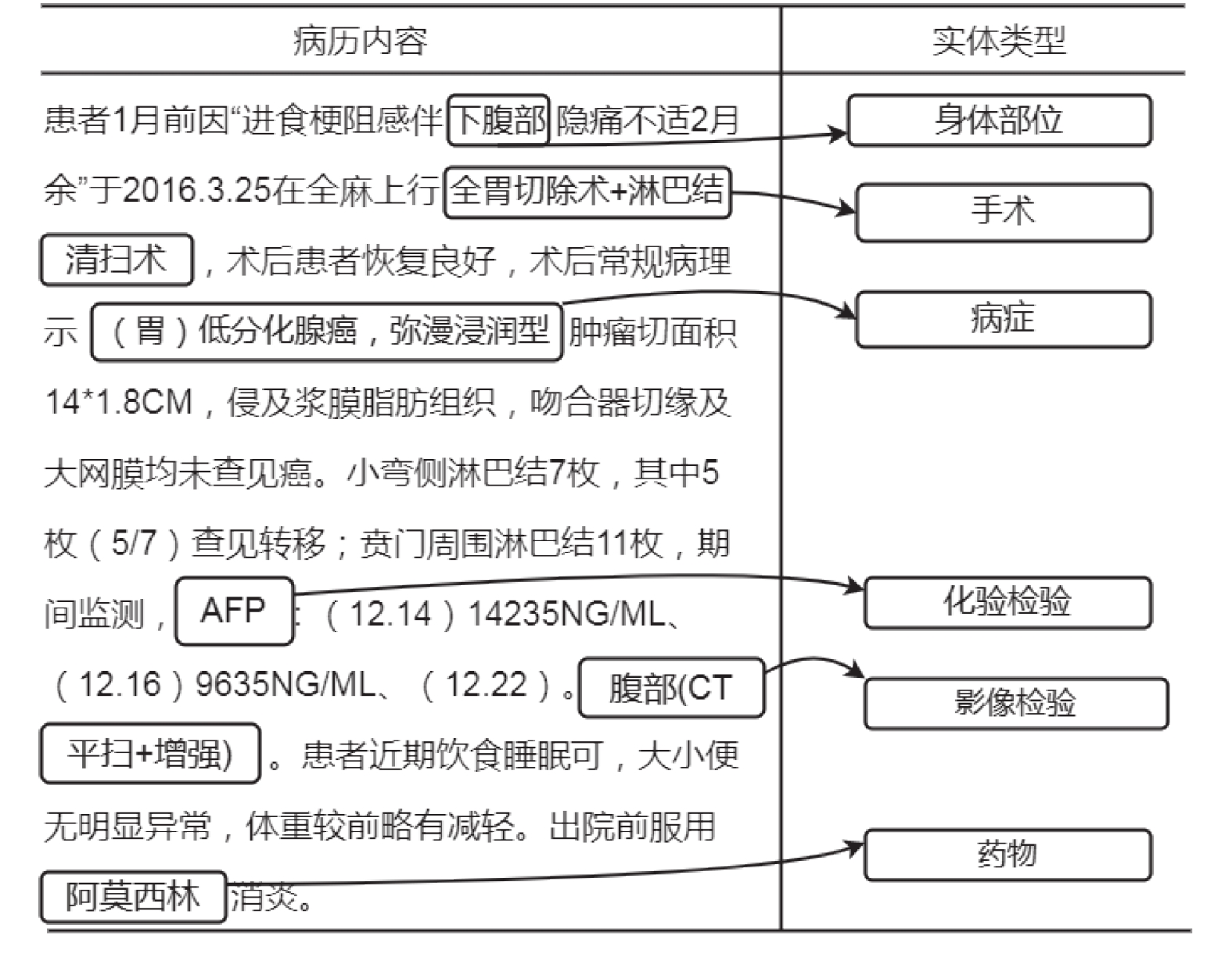

2 电子病历数据预处理 2.1 类别定义人工将实体分类分为以下6个方面: 病症, 身体部位, 手术, 药物, 化验检验, 影像检验. 在测试中发现, 如果直接以中文作为类别标签, 会导致训练结果较差, 因此本文将上述6个类别使用英文简写代替, 病症的标签为DISEASE, 身体部位的标签为BODY, 手术的标签为OPERATION, 药物的标签为MEDICINE, 化验检验的标签为LAB-CHECK, 影像检验的标签为IMG-CHECK. 实验期望得到的实体识别效果如图1所示.

|

图 1 电子病历实体对应关系图 |

2.2 原始数据清洗

数据清洗的过程主要利用Python程序将原始文本中的空格, 首尾标点符号以及一些错误符号进行删除, 并检查人工标记的起始位置和终点位置的实体是否标记有误, 例如起始位置开始过早或者终点位置结束过晚等情况. 为了防止标点符号的使用不一致情况, 本文将原始文本中的标点全部使用英文标点表示. 实验发现, 没有进行过数据清洗的数据会比进行过数据清洗的数据在训练结果上产生的误差在10%左右, 说明对于原始数据进行清洗在模型训练中存在一定的作用.

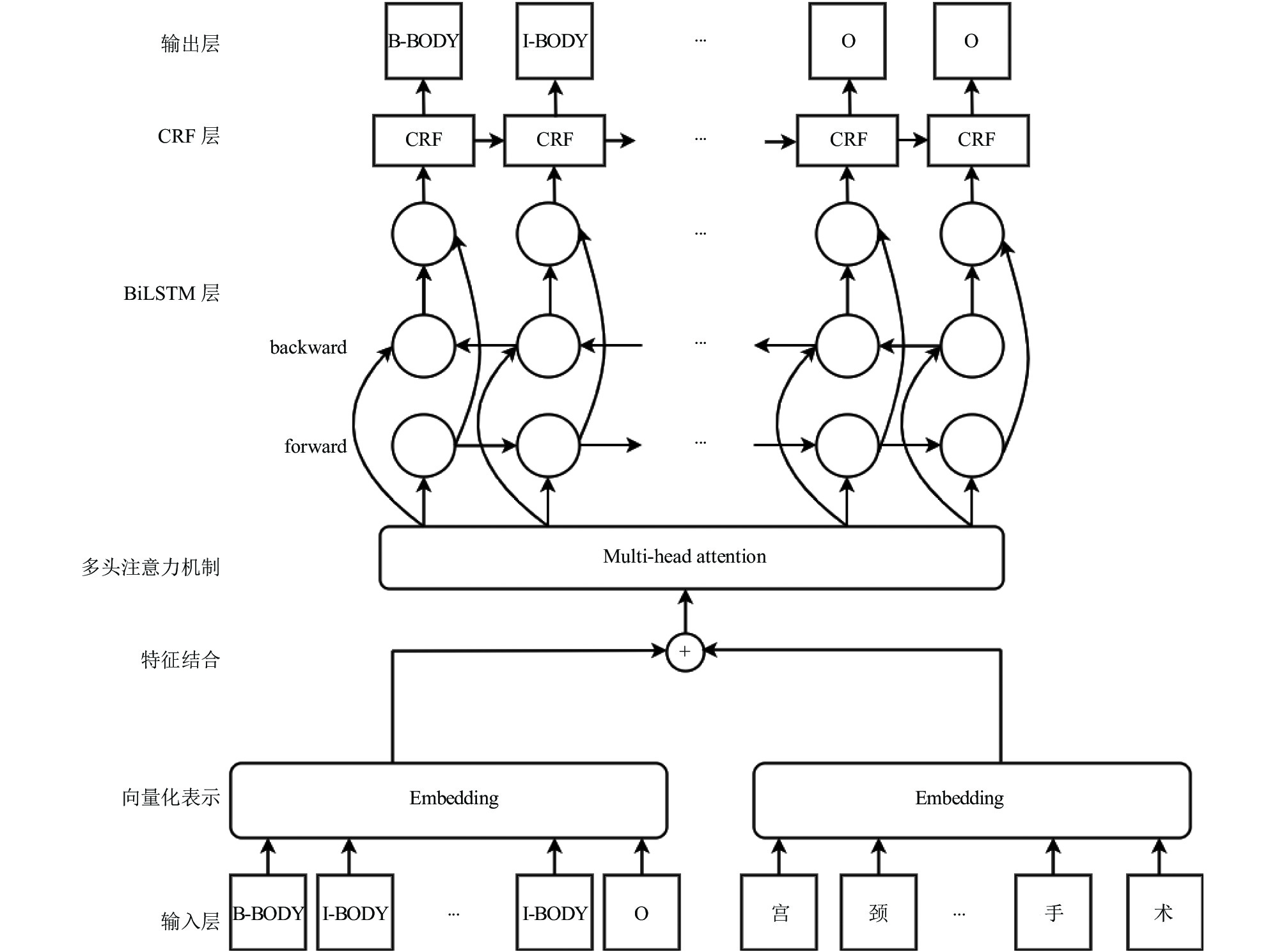

3 模型结构本文提出的一种融合文字与标签的WT-MHA-BiLSTM-CRF模型结构如图2所示. 在模型中, 输入层获取电子病历的每个文字及文字对应的标签, 将文字和标签分别建立字典, 得到每个字和标签对应在字典中的序号, 即向量化表示后的结果, 将两者进行结合, 输入到multi-head attention[10]中, attention机制会使得模型在句子中捕捉到更多的上下文信息, 其输出结果是在3个维度上的加权整合, 并映射到模型设定的矩阵维度上. 该输出的结果作为BiLSTM模型的输入, BiLSTM模型根据上下文信息, 计算每个字符在每一个类别中的概率值大小. 基于BiLSTM-CRF模型抛弃了Softmax层并使用CRF进行代替, CRF层在训练过程中可以自主学习到一些约束规则, 这些约束可以保证预测标签的合理性, CRF层将BiLSTM层的输出结果作为输入, 进一步约束, 得到更加准确的输出结果, 整体模型将CRF的输出作为最后的预测结果, 并与标准结果进行比对, 计算预测的误差.

|

图 2 WT-MHA-BiLSTM-CRF模型结构图 |

本文提出的模型相对于传统的命名实体识别模型来说, 同时关注文字和标签中的信息, 使得输入信息更加充分, 发现标签中的隐含信息对模型结果带来的价值.

3.1 BiLSTM模型双向长短期神经网络(BiLSTM)[11]是一种为解决循环神经网络(RNN)中梯度消失或者梯度爆炸问题而提出的模型, 它较好地解决了RNN在长依赖训练过程中的缺陷. 长短期神经网络(LSTM)是一种单向网络, 主要使用门机制[12]来解决RNN中的长期依赖问题, 其模型结构如图3 (图中sig代表Sigmoid函数)所示.

|

图 3 LSTM模型结构图 |

LSTM[13]在隐藏单元中提出了3种门的概念: 输入门, 输出门, 遗忘门. 式(1)和式(2)体现了输入门与单元状态更新的计算公式:

| it=σ(Wi⋅[ht−1,x]+bi) | (1) |

| ~Ct=tanh(WC⋅[ht−1,x]+bC) | (2) |

输入门用来确定当前输入中被保存状态的个数, 其中,

| σ(x)=11+e−x | (3) |

| tanh(x)=sinh(x)cosh(x)=ex−e−xex+e−x | (4) |

输入门通过控制

| Ct=ft∗Ct−1+it∗ ˜Ct | (5) |

输出门将会决定传输多少个单元状态作为 LSTM 的当前输出值, 通过计算隐藏节点

| ot=σ(Wo[ht−1,x]+bo) | (6) |

| ht=ot∗tanh(Ct) | (7) |

遗忘门负责上一个时刻的单元状态保存多少到当前时刻, 表现为

| ft=σ(Wf⋅[ht−1,x]+bf) | (8) |

单元状态作为LSTM中的核心部分, 始终贯穿整个计算, 其计算表达式为:

| Ct=ft×Ct−1+it×~Ct | (9) |

本文使用的BiLSTM模型相对于LSTM模型来说, 能够在未来上下文的预测中有较好的表现, 使得训练不仅能够接受前文的序列也可以得到后续序列, 在进行命名实体识别的过程中会有更好的效果.

3.2 GRU模型门控循环单元(GRU)也是为了解决循环神经网络存在的长期依赖问题而提出的, 模型中使用了更新门和重置门两种门机制, 使得模型在训练效果不变的同时, 计算更加简单, 其计算过程如式(10)–式(13)所示.

| zt=σ(Wzxt+Uzht−1+bz) | (10) |

| rt=σ(Wrxt+Urht−1+br) | (11) |

| ~ht=tanh(Whxt+Uh(rt⊙ht−1)+bh) | (12) |

| ht=zt⊙ht−1+(1−zt)⊙~ht | (13) |

其中,

由于单层的attention所包含的信息可能不够支持众多的下游任务, 因此2017年谷歌推出的Transformer将其堆叠成multi-head attention (MHA), 其本质是多次的self-attention[14]计算. Attention机制[15]会使网络在训练过程中更多的注意到输入包含的相关信息, 而对无关信息进行简略, 从而提高训练的准确性.

Self-attention对输入的每个词向量创建3个新向量: Query、Key、Value, 这3个向量分别是词向量和Q,K,V三个矩阵乘积得到的, Q,K,V三个矩阵是一个需要学习的参数, 其定义如下所示:

| Attention(Q,K,V)=Softmax(QKT√dk) | (14) |

其中,

MHA定义如式(15)所示:

| headi=Attention(QWQi,KWKi,VWVi) |

| MultiHead(Q,K,V)=Concat(head1,⋯,headh)Wo | (15) |

其中,

条件随机场(CRF)[16]是一种较为经典的条件概率分布模型, 通过观测序列

| Pw(y|x)=exp(w⋅F(y,x))Zw(x) |

| Zw(x)=∑yexp(w⋅F(y,x)) | (16) |

其中,

CRF模型通过式(17)得到评估分数, 式中Emit代表BiLSTM输出的概率, Trans代表对应的转移概率.

| score(x,y)=∑iEmit(xi,yi)+∑iTrans(yi−1,yi) | (17) |

最后模型使用最大似然法来进行训练, 相应的损失函数为:

| −logp(y|x)=−score(x,y)+logZ(x) | (18) |

由于

|

图 4 Multi-head attention计算过程图 |

4 实验及结果分析 4.1 实验数据集

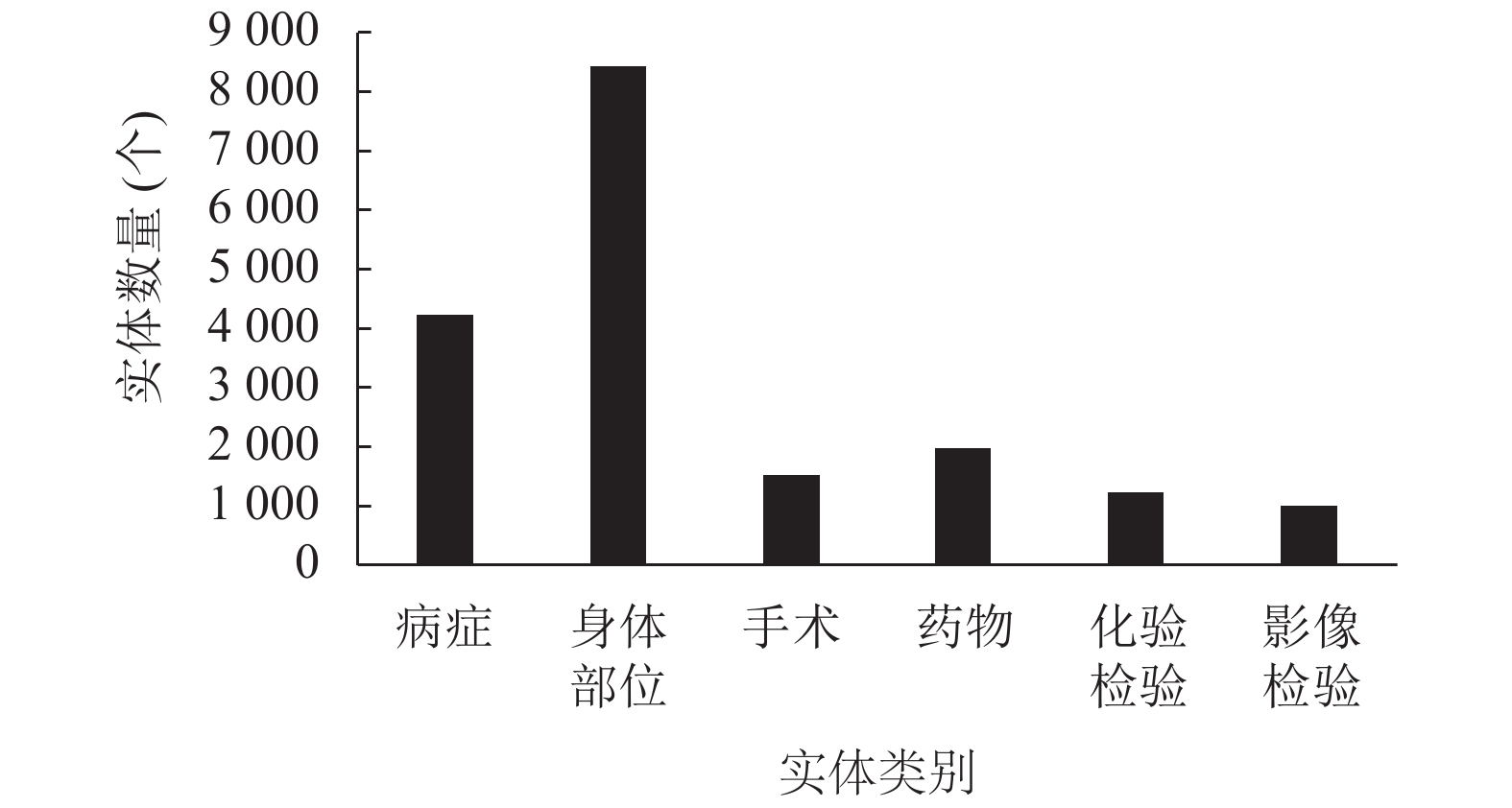

实验过程中比较了4种模型的训练情况, 使用人工标注过的1 000份数据集, 按照6:2:2的比例将数据划分为训练集、验证集、测试集. 在实体识别中常用的实体标注方式[18]包括BIO、BIOE、BIOES等, 本实验使用BIO标注方式, 具体的标注情况与实体数量见表1和图5所示. 根据第2.2节中所述, 数据集的准确性对模型最终结果存在影响, 因此实验对原始数据进行预处理, 主要包括中英文统一, 利用程序检查原始数据集中是否有启始位置错误信息, 并针对错误信息进行修改.

4.2 数据集评价指标实验使用精确率(结果中的P值)、召回率(结果中的R值)和F1值作为模型评价指标, 其中精确率代表在所有预测结果中为正确的个数在实际正确分类所占的比例; 召回率代表所有预测正确的结果在实际正确中的占比; F1值使用加权和平均来保证两者在结果中的作用, 由于综合考虑了精确率和召回率的结果, 因此F1的值往往作为实验结果的最有力的证明, 其值越高说明实验的效果越好, 三者的计算过程见式(19)–式(21).

| P=TpTp+Fp×100% | (19) |

| R=TpTp+FN×100% | (20) |

| F1=2×P×RP+R×100% | (21) |

其中,

| 表 1 数据标注表 |

|

图 5 实体数量图 |

4.3 实验环境与结果

本文中命名实体识别模型基于PyTorch框架, 详细实验环境设置见表2所示.

| 表 2 训练环境表 |

训练中模型的详细参数为: 每次训练选取的样本数batch_size值为64, 学习率lr设定为1E–4, 训练轮数epoch设置为30, 时序模型的网络层数设置为1, 词向量维数为128, 使用Adam优化器, 丢失率dropout值为0.5.

本文对4种模型进行了测试来增强模型结果的说服力, 4种模型定义如下.

(1) BiLSTM-CRF: 使用单层的BiLSTM网络, 并将模型的输出结果直接作为条件随机场的输入计算最终结果.

(2) BiGRU-CRF: 使用单层的BiGRU模型, 将输出结果投入CRF计算.

(3) MHA-BiLSTM-CRF: 对字向量做Embedding后先进入mutli-head attention模型中, 模型输出的结果作为BiLSTM模型的输入, 其结果作为CRF层输入.

(4) WT-MHA-BiLSTM-CRF: 同时对字、标签做Embedding, 将两者结合, 作为mutli-head attention的输入, 之后进入BiLSTM模型训练, 最终进入CRF层进行训练.

表3展示了4种模型在各个实体上的精确率、召回率和F1值, 从结果来看, WT-MHA-BiLSTM-CRF在大多数的实体分类结果上均有一定的提高, 与BiLSTM-CRF模型的比较中, 在病症方面F1值提高了3%, 身体部位提高了6%, 手术提高了4%, 化验检验提高了7%, 影像检验提高了11%. 但是在药物的类别方面, WT-MHA-BiLSTM-CRF的结果与其他模型相比有些下降, 初步分析原因是, 由于本文提出的模型是针对字和标签同时作为模型的输入来进行训练, 并且经过attention机制的处理, 在实验过程中, 可能过度的对某些字、标签产生了过度的关注, 而使得分类结果产生了误差, 因而导致分类效果的下降, 在以后的研究中会针对这一方面进行深入研究. 最后, 图6展示了WT-MHA-BiLSTM-CRF模型在各个实体中的预测结果.

| 表 3 实验结果表(%) |

5 结论与展望

本文提出了一种结合字与标签同时训练的WT-MHA-BiLSTM-CRF模型, 用于解决结构化电子病历中命名实体识别的问题. 传统的BiLSTM-CRF模型更多的注重字在模型中训练产生的结果, 忽略了标签中可能隐含的信息, 因此在训练输入之前, 将字和标签同时做Embedding处理. 并使用mutli-head attention使模型更多的注意力放在关键的字和标签上, BiLSTM结合上下文得到每个字的类别概率, 模型的最后使用CRF对分类结果进行处理, 使得模型的预测输出更有说服力. 从实验结果中可以看出, 该模型在大部分的类别识别中均有提升. 对于个别类别来说, 考虑到模型的结果中可能有部分信息被过度关注, 导致训练结果上有些许问题, 在以后的研究中也会针对这个问题着重来处理.

|

图 6 WT-MHA-BiLSTM-CRF模型各类别结果图 |

| [1] |

杨锦锋, 关毅, 何彬, 等. 中文电子病历命名实体和实体关系语料库构建. 软件学报, 2016, 27(11): 2725-2746. DOI:10.13328/j.cnki.jos.004880 |

| [2] |

孟捷. 基于中文电子病历文本的医学语义网络构建方法研究[硕士学位论文]. 北京: 北京交通大学, 2019.

|

| [3] |

江涛. 基于深度神经网络的电子病历命名实体识别关键技术研究与应用[硕士学位论文]. 成都: 电子科技大学, 2020.

|

| [4] |

沈宙锋, 苏前敏, 郭晶磊. 基于XLNet-BiLSTM的中文电子病历命名实体识别方法. 智能计算机与应用, 2021, 11(8): 97-102. DOI:10.3969/j.issn.2095-2163.2021.08.021 |

| [5] |

王若佳, 赵常煜, 王继民. 中文电子病历的分词及实体识别研究. 图书情报工作, 2019, 63(2): 34-42. |

| [6] |

Zhang D, Chi CY, Zhan XG. Leveraging lexical features for Chinese named entity recognition via static and dynamic weighting. IAENG International Journal of Computer Science, 2021, 48(1): IJCS_48_1_13. |

| [7] |

Ji B, Li SS, Yu J, et al. Research on Chinese medical named entity recognition based on collaborative cooperation of multiple neural network models. Journal of Biomedical Informatics, 2020, 104: 103395. DOI:10.1016/j.jbi.2020.103395 |

| [8] |

李丹, 徐童, 郑毅, 等. 部首感知的中文医疗命名实体识别. 中文信息学报, 2020, 34(12): 54-64. DOI:10.3969/j.issn.1003-0077.2020.12.009 |

| [9] |

张旭, 朱艳辉, 梁文桐, 等. 基于SoftLexicon的医疗实体识别模型. 湖南工业大学学报, 2021, 35(5): 77-84. DOI:10.3969/j.issn.1673-9833.2021.05.010 |

| [10] |

吕晴, 赵奎, 曹吉龙, 等. 基于文本与图像的肺疾病研究与预测. 自动化学报, 2022, 48(2): 531-538. |

| [11] |

屈倩倩, 阚红星. 基于Bert-BiLSTM-CRF的中医文本命名实体识别. 电子设计工程, 2021, 29(19): 40-43, 48. |

| [12] |

Ma RT, Peng ML, Zhang Q, et al. Simplify the usage of lexicon in Chinese NER. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Online: ACL, 2020. 5951–5960.

|

| [13] |

Gong C, Li ZH, Xia QR, et al. Hierarchical LSTM with char-subword-word tree-structure representation for Chinese named entity recognition. Science China Information Sciences, 2020, 63(10): 202102. DOI:10.1007/s11432-020-2982-y |

| [14] |

Yin JZ, Luo SL, Wu ZT, et al. Chinese named entity recognition with character-level BLSTM and soft attention model. Journal of Beijing Institute of Technology, 2020, 29(1): 60-71. |

| [15] |

曾青霞, 熊旺平, 杜建强, 等. 结合自注意力的BiLSTM-CRF的电子病历命名实体识别. 计算机应用与软件, 2021, 38(3): 159-162, 242. DOI:10.3969/j.issn.1000-386x.2021.03.024 |

| [16] |

丁锋, 孙晓. 基于注意力机制和BiLSTM-CRF的消极情绪意见目标抽取. 计算机科学, 2022, 49(2): 223–230.

|

| [17] |

肖丹. 基于半监督学习的中文电子病历实体关系抽取研究[硕士学位论文]. 绵阳: 西南科技大学, 2021.

|

| [18] |

袁贞明, 沈辉, 俞凯, 等. 基于电子病历文本的诊疗事件实体抽取研究. 中国数字医学, 2021, 16(7): 33-38. DOI:10.3969/j.issn.1673-7571.2021.07.007 |

2022, Vol. 31

2022, Vol. 31