云存储服务在个人和组织环境中, 随着云用户数的增加, 冗余数据量也随之增加. 众所周知, 云服务提供商通常利用跨用户数据去重复来尽量减少存储开销, 允许云服务器检测两个或多个用户上传同一文件的副本, 并且只存储该文件的一个副本.

云服务提供商自由访问用户数据, 这就要求云用户充分信任云服务提供商做正确的事情. 传统的加密算法将文件的相同副本加密成完全独立的密文, 这使得重复删除的工作复杂化. Douceur等人[1]提出的收敛加密(CE)的技术, CE是一种确定性加密方案, 使得文件的相同副本被加密成相同的密文.

虽然CE提供了一种简单而有效的方法来在数据隐私和加密重复数据消除的功能要求之间取得平衡, 但它有安全性和性能限制. 利用CE的概念, Bellare等人[2-4]构建了一个名为消息锁定加密(MLE)的新加密原语, 以方便在加密数据上的重复数据消除, 他们还为MLE定义了两个安全要求: 隐私性和标签一致性.

在本文中, 我们提出了一种随机、安全、跨用户重复数据消除方案, 请求上传文件的用户需要与云服务器进行交互, 以确保同一文件的副本被加密到同一密文中, 同时实现抵抗暴力攻击. 具体地说, 拥有相同文件副本的不同用户通过共享相同的随机值生成文件加密密钥, 因此只有具有该文件相同副本的用户才能获得随机值并计算正确的加密密钥.

1 背景知识 1.1 椭圆曲线Millier[5]基于椭圆曲线提出了椭圆曲线密码体制,

Fan等人在2014年提出布谷过滤器(Cuckoo filter), 这是一种用于近似集合查询的新型数据结构[6].

本文提出了动态布谷鸟滤波器(DCF), 以支持可靠的删除操作和弹性容量的动态集. 影响DCF设计的效率有两个因素, 首先, DCF数据结构是可扩展的, 使动态集空间的表示更有效. 其次, DCF使用垄断指纹来表示一个项, 并保证可靠的删除操作. 实验结果表明, 与现有的先进设计相比, DCF的内存成本降低了75%, 构建速度提高了50%, 会员查询速度提高了80%.

布谷鸟滤波器一般是成对的哈希函数, 一个是记录的位置, 另一个是备用位置, 这个备用位置是处理碰撞时用的.

使用

此外, 在迁移过程中, 存储的是原始数据的哈希值

| $\left\{ { \begin{array}{l} loc1 = Hash(x) \\ loc2 = loc1 \oplus Hash({\xi _x}) \end{array} } \right.$ |

如果在添加新元素时, 两个哈希列表均被偶然的占据, 则会导致假阳性的结果. 可计算假阳性概率的上限为:

| $ \rho = 1 - {\left(1 - \frac{1}{{{2^f}}}\right)^\lambda } \approx \frac{{{2^\lambda }}}{{{2^f}}} $ |

椭圆曲线离散对数问题(ECDLP): 给定

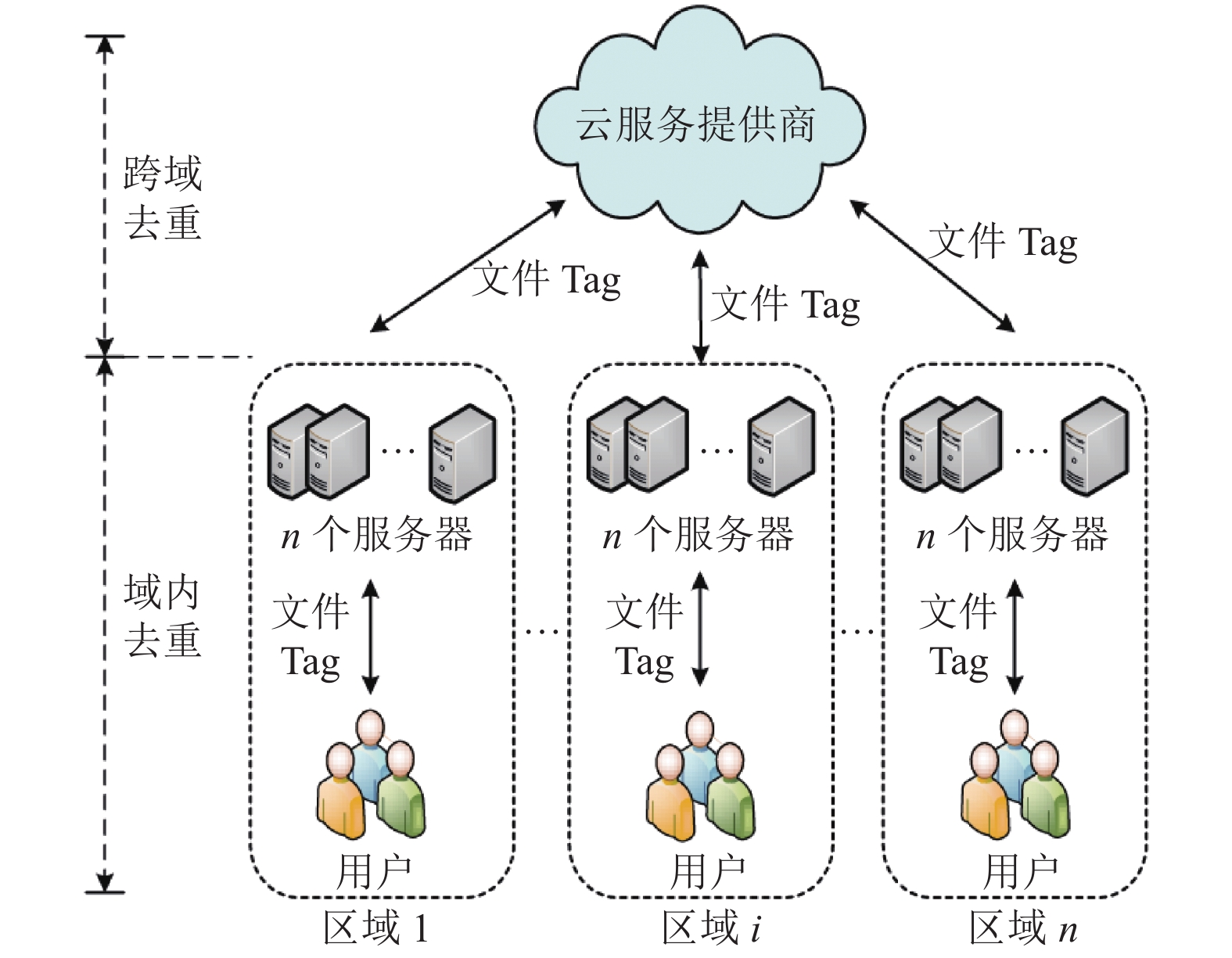

该系统模型图如图1所示, 参与者包括3个实体: 云服务器(CSP), 域服务器(KS), 用户(U).

|

图 1 网络模型 |

云服务提供商

区域服务器

用户

我们的目标是在所提方案中实现以下安全目标.

(1)数据机密性: 任何对手, 包括未经授权的用户

(2)数据完整性[8]: 所提方案应保护数据完整性免受对手的影响. 也就是说, 它应该允许

(3)可扩展性: 所有的密钥服务器都不应参与收敛的密钥生成过程, 这会导致系统的性能下降.

2 本文方案 2.1 系统建立所提方案包含6个阶段: 系统初始化阶段、用户注册阶段、用户文件标签产生阶段、去重阶段、数据完整性校验、用户动态更新.

系统初始化: 该算法由

(1)给定一个安全参数

(2)

区域服务器参数生成: 区域服务器

用户注册: 用户选择

给定系统参数

(1)用户

(2)区域服务器

(3)生成标签: 区域服务器

去重工作包含两个阶段, 区域内部去重、跨区域去重. 区域内部去重由区域服务器执行, 跨区域去重由

(1)区域内去重阶段区域服务器

第1类: 本区域内存在重复, 即本区域内存在

区域服务器

第2类: 如果本区域内文件不存在重复, 意味着在同一个区域的用户没有上传过与用户

(2)区域间去重阶段,

第1类: 跨区域不存在重复文件, 则表示用户

第2类: 跨区域存在重复文件, 意味着在之前已经有处在不同区域的用户上传了与用户

用户

用户

| $ c{k_i} = {H_3}({a_i}),{C_{i1}} = En{c_{c{k_i}}}({m_i}), {C_{i2}} = En{c_{{H_1}{\text{(}}{{{m}}_i}{\text{)}}}}({a_i}) $ |

其中,

用户

用户在下载请求后将收到密文

当有用户想要删除文件时, 需要进行密钥的更新,

数据的保密性和完整性是对加密数据的重复数据消除研究中重要的安全问题. 因此, 在这部分, 我们讨论如何实现更高层次的安全性, 且比其他方案的设置更简单.

内部攻击通常被定义为服务器试图获得明文[9-11], 在我们的方案中, 由于服务器和云是半信任的, 它们将按指定的方式执行数据的去重复, 但出于好奇, 他们试图获得明文. 具体地, 区域服务器为每个数据存储哈希值

本节与以前的去重方案的安全属性和计算成本方面的比较.

(1) 安全属性比较

方案的安全属性比较如表1.

| 表 1 安全属性比较 |

(2) 计算代价比较

本节将比较所提方案与现有去重方案的计算代价和通信代价.

基于MIRACL Crypto SDK, 仿真实验在CPU为英特尔i7 (2.53 GHz), 内存为8 GB的64位Window 7操作系统下进行. 平均运行时间如表2所示. 表3和表4给出了文献[12–16]和本文提出的方案计算代价比较.

| 表 2 基本操作的执行时间 |

由表3可知, 在文件标签上传阶段, 所提方案计算代价为1.16 ms, 与已有的数据去重方案[12-16]相比, 计算代价最小, 分别降低了59.15%, 95.70%, 95.70%, 95.97%和72.76%.

在文件加密阶段中, 所提方案加密文件计算代价为0.0048 ms, 与已有的数据去重方案[12-14, 16]相比, 分别降低了99.91%, 99.96%, 99.96%和99.96%, 与方案[15]相比, 计算代价近乎相同, 但方案[15]不能满足访问控制和用户的动态更新.

密文解密阶段, 在非上传者解密2 KB文件过程中, 所提方案解密文件计算代价为0.39 ms, 与已有的数据去重方案[12-14,16]相比, 分别降低了86.26%, 96.31%, 98.33%和99.96%, 尽管方案[15]的非上传者在文件解密阶段具有更低的计算代价, 但所提方案在功能方面优于方案[15].

由图2可知, 在文件标签上传阶段, 所提方案通信代价为320 bits, 与已有的数据去重方案[12-16]相比, 通信代价最小, 分别降低了68.75%, 79.17%, 79.17%, 68.75%和68.75%.

| 表 3 该方案与其他方案用户计算代价比较 |

| 表 4 通信代价比较 (bits) |

|

图 2 通代价比较 |

文件密文上传阶段, 在密文大小相同的情况下, 对辅助参数的通信代价进行比较. 由图2所知, 与已有的数据去重方案[12-16]相比, 所提方案在密文上传阶段的通信代价最小, 所提方案分别降低了89.58%, 84.38%, 87.50%, 68.75%和72.97%.

文件密文下载阶段, 与已有的数据去重方案[12-16]相比, 所提方案的通信代价最小, 所提方案分别降低了84.38%, 84.38%, 87.50%, 68.75%和72.97%.

由以上分析表明, 所提方案在实际应用中具有更好的适用性.

4 总结本文提出了一种随机、安全、服务器端去重方案. 通过共享用于为持有相同文件副本的用户生成加密密钥的随机值, 可以抵抗来自恶意云服务器和用户的暴力攻击. 在所提方案中, 昂贵和复杂的计算由云服务器处理, 因此在客户端发生的计算开销较少. 安全性分析表明, 该方案提供了一个更简单的去重复框架, 具有更高的安全性. 性能评估的结果表明, 本文方案在客户端产生最小的计算开销, 这是足够轻量级的.

| [1] |

Douceur JR, Adya A, Bolosky WJ, et al. Reclaiming space from duplicate files in a serverless distributed file system. Proceedings of the 22nd International Conference on Distributed Computing Systems. Vienna: IEEE, 2002. 617–624.

|

| [2] |

Bellare M, Keelveedhi S. Interactive message-locked encryption and secure deduplication. Proceedings of the 18th IACR International Workshop on Public Key Cryptography. Gaithersburg: Springer, 2015. 516–538.

|

| [3] |

Bellare M, Boldyreva A, O’Neill A. Deterministic and efficiently searchable encryption. Proceedings of the 27th Annual International Cryptology Conference. Santa Barbara: Springer, 2007. 535–552.

|

| [4] |

Bellare M, Keelveedhi S, Ristenpart T. Message-locked encryption and secure deduplication. Proceedings of the 32nd Annual International Conference on the Theory and Applications of Cryptographic Techniques. Athens: Springer, 2013. 296–312.

|

| [5] |

Miller VS. Use of elliptic curves in cryptography. Williams HC. Advances in Cryptology (CRYPTO ’85). Berlin, Heidelberg: Springer, 1986. 417–426.

|

| [6] |

赵晓永, 陈晨. 面向云平台的二代测序数据近似去重方法研究. 计算机工程与应用, 2017, 53(23): 1-5. DOI:10.3778/j.issn.1002-8331.1706-0449 |

| [7] |

Yuan HR, Chen XF, Jiang T, et al. DedupDUM: Secure and scalable data deduplication with dynamic user management. Information Sciences, 2018, 456: 159-173. DOI:10.1016/j.ins.2018.05.024 |

| [8] |

Duan Y. Distributed key generation for encrypted deduplication: Achieving the strongest privacy. Proceedings of the 6th Edition of the ACM Workshop on Cloud Computing Security. Scottsdale: ACM, 2014. 57–68.

|

| [9] |

Miao YB, Ma JF, Liu XM, et al. Lightweight fine-grained search over encrypted data in fog computing. IEEE Transactions on Services Computing, 2019, 12(5): 772-785. DOI:10.1109/TSC.2018.2823309 |

| [10] |

Koo D, Hur J. Privacy-preserving deduplication of encrypted data with dynamic ownership management in fog computing. Future Generation Computer Systems, 2018, 78: 739-752. DOI:10.1016/j.future.2017.01.024 |

| [11] |

Katz J, Lindell Y. Introduction to Modern Cryptography. Boca Raton: Chapman and Hall/CRC, 2007.

|

| [12] |

Guo C, Jiang XR, Choo KKR, et al. R-Dedup: Secure client-side deduplication for encrypted data without involving a third-party entity. Journal of Network and Computer Applications, 2020, 162: 102664. DOI:10.1016/j.jnca.2020.102664 |

| [13] |

Shin Y, Koo D, Yun J, et al. Decentralized server-aided encryption for secure deduplication in cloud storage. IEEE Transactions on Services Computing, 2020, 13(6): 1021-1033. |

| [14] |

Nayak SK, Tripathy S. SEDS: Secure and efficient server-aided data deduplication scheme for cloud storage. International Journal of Information Security, 2020, 19(2): 229-240. DOI:10.1007/s10207-019-00455-w |

| [15] |

Yan JJ, Wang XX, Gan QQ, et al. Secure and efficient big data deduplication in fog computing. Soft Computing, 2020, 24(8): 5671-5682. DOI:10.1007/s00500-019-04215-9 |

| [16] |

Yang X, Lu RX, Choo KKR, et al. Achieving efficient and privacy-preserving cross-domain big data deduplication in cloud. IEEE Transactions on Big Data, 2017, 32(2): 1344-1354. |

2022, Vol. 31

2022, Vol. 31