红外与可见光图像融合技术在军事和民用领域中占有重要地位, 如目标检测、监控和情报收集等. 其中, 可见光图像含有丰富的细节和纹理信息, 但易受光线和天气等因素的影响, 难以捕捉到场景内的所有信息; 红外图像是经红外成像传感器获得的图像, 易丢失许多空间细节信息, 视觉感受不自然. 红外与可见光图像融合的目的是充分利用红外图像和可见光图像的优势, 生成一幅含有丰富细节背景和热目标的高质量图像, 便于计算机视觉任务[1].

由于成像机理的不同, 同一空间位置的红外和可见光图像的像素强度往往差异很大, 为了得到具有良好视觉感知的融合结果, 引入多尺度变换(Multi-Scale Transformation, MST). 常用的MST方法包括: Curvelet[2]、Contourlet[3]、DTCWT[4]等, 这些方法能将图像分解为低频子带和高频子带, 但它们不具有平移不变性, 容易造成伪Gibbs现象. 虽然NSCT变换[5]、NSST变换[6]等增强了图像的平移不变性, 但在融合过程中未考虑空间一致性, 也容易引起亮度失真. 随着机器学习的发展, 稀疏表示具有良好的去噪能力和空间一致性等特征, 但仍存在捕获全局结构的能力有限以及细节信息不足的缺点. 为了解决稀疏表示的问题, Liu等[7, 8]提出的潜在低秩表示法(Latent Low-Rank Representation, LatLRR), 该方法能够提取源图像的全局结构信息和局部结构信息. 已有学者[9-11]将其应用到红外与可见光图像融合中, 并取得较好的融合结果. 但仅使用潜在低秩方法分解源图像, 存在高频信息提取不完全的问题, 导致融合效果不佳.

本文针对红外与可见光图像融合过程中出现的细节损失严重等问题, 提出了潜在低秩表示和导向滤波的红外与可见光图像融合方法. 该方法将潜在低秩表示方法和导向滤波相结合, 较充分地挖掘源图像的基础信息、细节信息和显著信息, 并应用各信息的特征进行融合. 实验结果表明本文方法能保留较多的源图像的细节信息.

1 相关理论 1.1 潜在低秩表示方法LatLRR方法具有较好的空间一致性, 能有效提取原始数据中的全局结构和局部结构. 它将图像分解为基础子带与显著子带, 其表达式为:

| $X = BX + DX + N$ | (1) |

式中,

将LatLRR问题进行最优化求解, 其表达式为:

| $\begin{split} & \min {\left\| B \right\|_*} + {\left\| D \right\|_*} + \alpha {\left\| N \right\|_1} \\ & {\rm{s.t.}} \;\;X = BX + DX + N \\ \end{split} $ | (2) |

式中,

He等[12]提出了导向滤波(Guided Filtering, GF)的概念, 通过引导图像完成滤波过程, 不仅能够滤除图像噪声, 而且能够平滑边缘、保持其梯度特性.

设输入图像I, 导向图J, 导向滤波过程表示为:

| $GF\left( {I,J,r,\varepsilon } \right) = \mathop \cup \limits_{i \in I} \left\{ {{a_k}{J_i} + {b_k}{\rm{|}}i \in {w_k}} \right\}$ | (3) |

其中,

| ${a_k} = \frac{{\dfrac{1}{{\left| w \right|}}\displaystyle\sum\nolimits_{i \in {w_k}} {{J_i}{I_i}} - \overline {{J_k}} \overline {{I_k}} }}{{\sigma _k^2 + \varepsilon }}, {b_k} = \overline {{I_k}} - {a_k}\overline {{J_k}} $ | (4) |

式中,

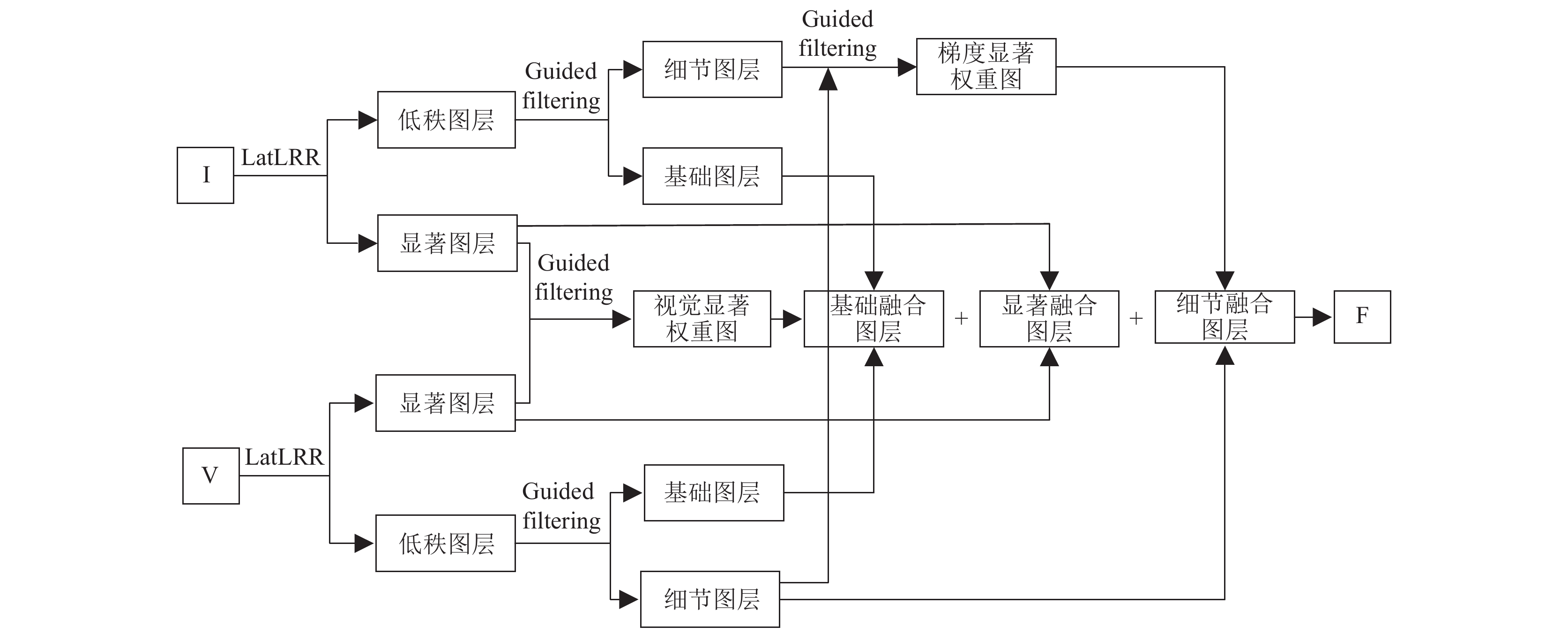

已知红外图像I, 可见光图像V, 设融合结果为F, 图1给出了本文融合方法的流程图, 具体融合步骤为:

Step 1. 应用LatLRR和导向滤波将源图像分解为基础图层、细节图层和显著图层.

Step 2. 各图层融合规则: 基础图层、细节图层、显著图层分别以视觉显著度加权法、梯度显著度加权法、绝对值最大选择法为融合规则, 考虑到初始权重具有噪声且不与物体边界对齐, 应用导向滤波优化初始权重.

Step 3. 将基础融合图层、细节融合图层和显著融合图层叠加, 得到融合图像.

2.1 图层分解首先, 采用LatLRR方法分解红外图像I和可见光图像V, 分别得到红外低秩图层

| $\left\{ \begin{gathered} {I_{\rm Based}} = GF\left( {\overline {{B_I}} ,I,r,\varepsilon } \right) \\ {I_{\rm Detail}} = {\overline B _I} - {I_{\rm Based}} \\ \end{gathered} \right.;\;\left\{ \begin{gathered} {V_{\rm Based}} = GF\left( {\overline {{B_V}} ,V,r,\varepsilon } \right) \\ {V_{\rm Detail}} = {\overline B _V} - {V_{\rm Based}} \\ \end{gathered} \right.$ | (5) |

其中,

|

图 1 本文融合方法流程图 |

|

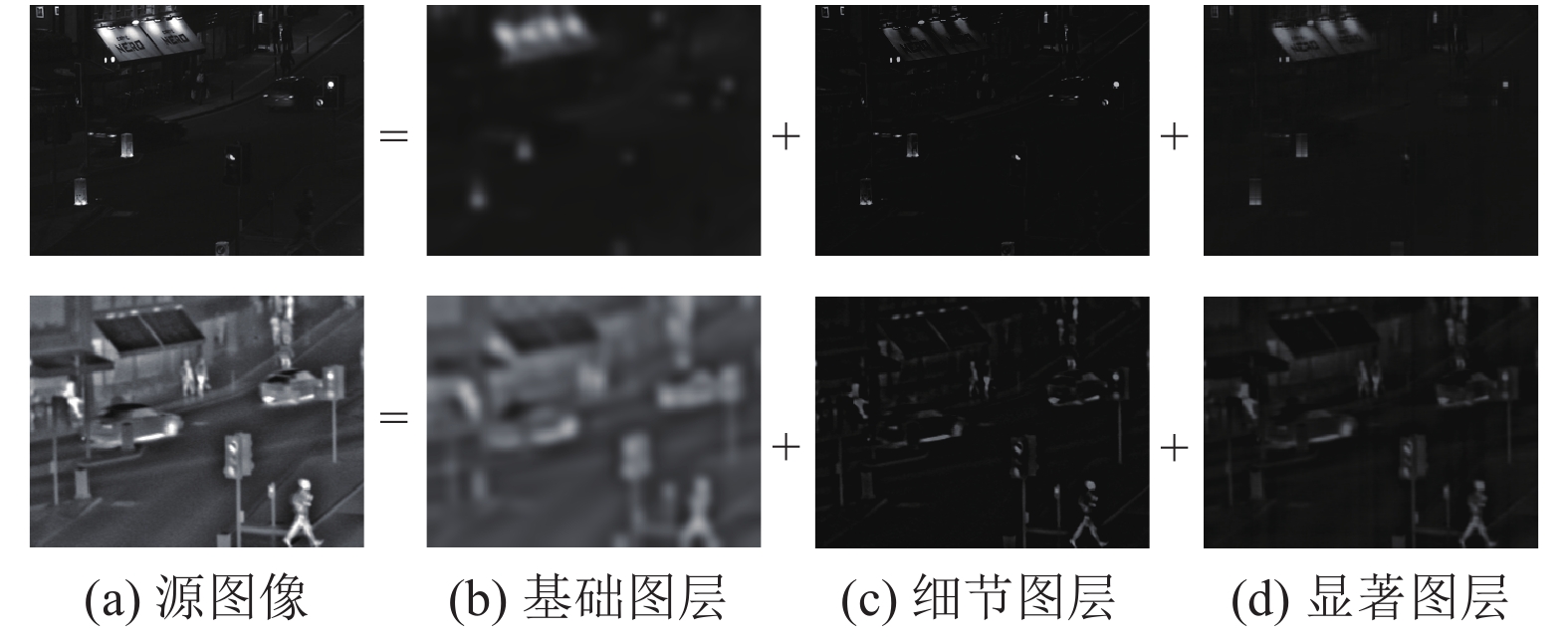

图 2 源图像分解 |

由图2可以看出, 基础图层包含着基本信息, 结构信息较少, 例如可见光图像中的文字基本已经模糊不清; 细节图层包含着图像结构信息, 例如红外图像中行人的轮廓、汽车等轮廓信息; 显著图层包含着源图像的显著信息, 例如行人、车辆、红绿灯、招牌等信息. 因此, 将LatLRR和导向滤波相结合, 可充分地分解源图像信息.

2.2 融合规则及融合图像重建可见光图像和红外图像均被分解为基础图层、细节图层和显著图层, 该节分别针对每层的特征, 采用视觉显著度加权法、梯度显著度加权法、绝对值最大选择法作为每层的融合规则. 具体介绍如下:

(1) 基础图层融合规则

基础图层包含着图像大部分信息, 尤其以显著性目标为主. 因此, 该层以视觉显著度加权法作为融合规则, 其融合公式为:

| ${F_{\rm Based}} = {w_{\rm Based}}{I_{\rm Based}} + \left( {1 - {w_{\rm Based}}} \right){V_{\rm Based}}$ | (6) |

其中,

(2) 细节图层融合规则

细节图层包含着源图像大量的边缘信息和结构信息, 采用Scharr算子[13]

| ${E^I} = E_m^I \times E_n^I, {E^V} = E_m^V \times E_n^V$ | (7) |

其中,

| $\left\{ \begin{split} &E_m^I\left( {i,j} \right) = \frac{1}{{mn}}\sum\limits_{p = - m}^m {\sum\limits_{q = - n}^n {\left[ {IM{L_I}\left( {i + p,j + q} \right)} \right]} }\\ &\begin{split} IM{L_I}\left( {i,j} \right) =& \left| {2{I_{\rm Detail}}\left( {i,j} \right) - {I_{\rm Detail}}\left( {i - 1,j} \right) - {I_{\rm Detail}}\left( {i + 1,j} \right)} \right| + \left| {2{I_{\rm Detail}}\left( {i,j} \right) - {I_{\rm Detail}}\left( {i,j - 1} \right) - {I_{\rm Detail}}\left( {i,j + 1} \right)} \right| \\ & \!\! +\!\!\frac{1}{{\sqrt 2 }}\left| {2{I_{\rm Detail}}\left( {i,j} \right)\!\! -\!\! {I_{\rm Detail}}\left( {i \!\!-\!\! 1,j \!\!-\!\! 1} \right)\!\! - \!\!{I_{\rm Detail}}\left( {i\!\! + \!\!1,j \!\!+\!\! 1} \right)} \right|\!\!+\!\!\frac{1}{{\sqrt 2 }}\left| {2{I_{\rm Detail}}\left( {i,j} \right)\!\! -\!\! {I_{\rm Detail}}\left( {i\!\! + \!\!1,j\!\! -\!\! 1} \right) \!\!- \!\!{I_{\rm Detail}}\left( {i \!\!-\!\! 1,j\!\! + \!\!1} \right)} \right| \\ \end{split} \end{split}\right. $ | (8) |

| $E_n^I = \sqrt {{{\left( {{L_1} \cdot {I_{{\rm{Detail}}}}} \right)}^2} + {{\left( {{L_2} \cdot {I_{{\rm{Detail}}}}} \right)}^2}} $ | (9) |

其中,

融合图像的细节层融合公式为:

| ${F_{{\rm{Detail}}}} = {w_{{\rm{Detail}}}}{I_{{\rm{Detail}}}} + \left( {1 - {w_{{\rm{Detail}}}}} \right){V_{{\rm{Detail}}}}$ | (10) |

其中,

(3) 显著图层融合规则

由图2可以看出, 红外与可见光显著图信息相辅相成, 故采用绝对值最大为权重图. 即:

| ${\overline D _F} = w{\overline D _I} + \left( {1 - w} \right){\overline D _V}$ | (11) |

其中, 权重

(4) 融合图像重建

将基础融合层

| $F = {F_{\rm Based}} + {F_{\rm Detail}} + {\overline D _F}$ | (12) |

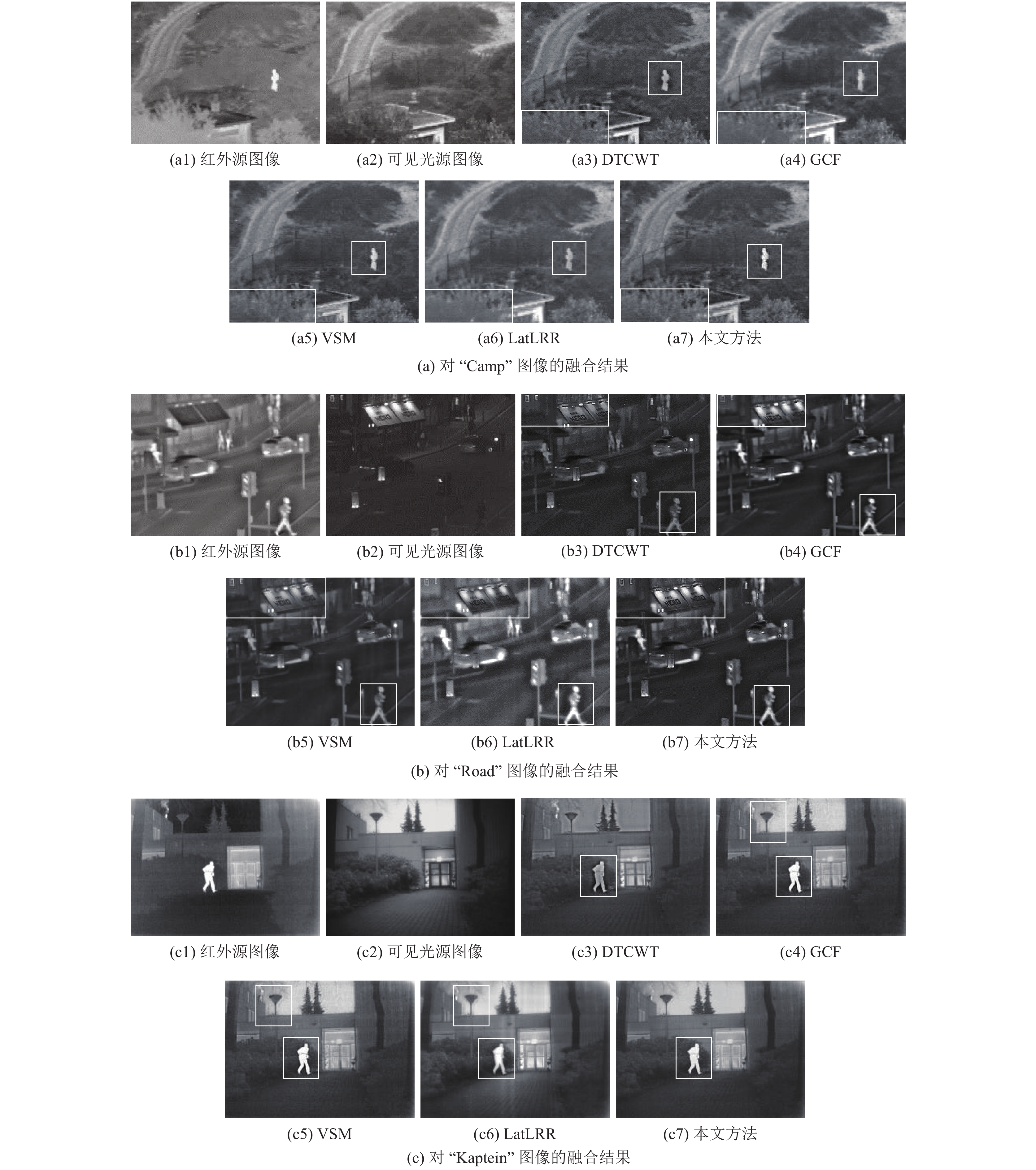

在本节中, 通过主、客观评价多组融合图像的效果, 分析本文融合方法的有效性. 其中, 3组红外与可见光源图像对分别是“Camp”、“Road”和 “Kaptein”, 它们均来自于TNO Image Fusion Dataset; 采用的融合方法包括: DTCWT[4]、GCF [15]、VSM[16]、LatLRR[9]和本文方法. 其中, DTCWT和GCF属于多尺度分解, DTCWT滤波器参数为“legall”、“qshift_06”, 分解级数为2级; GCF采用高斯曲率滤波迭代分解源图像, 其迭代次数为20次; VSM融合方法通过滚动引导滤波器分解源图像, 其中

对比第1组的融合结果可以看出, 在基于DTCWT融合结果中, 虽然左侧树杈的纹理较为清晰, 但行人周边存在明显的光晕. 这是因为基于DTCWT不具有平移不变性; 在基于GCF和VSM融合结果中, 无论左侧树杈的纹理还是行人的边缘都存在模糊性, 说明它们未能充分提取源图像的细节信息; 在基于LatLRR融合结果中, 左侧树杈纹理明显模糊不清, 房顶细节不清晰. 基于本文融合方法的融合结果较好地保留了左侧树杈纹理信息, 且行人边缘较为清楚, 热目标亮度适中, 符合人眼视觉效果.

对比第2组融合结果可以看出, 在基于DTCWT融合结果中, 整幅图像较为模糊、偏暗, 行人周边存在明显光晕, 红绿灯亮度不明显; 在基于GCF融合结果中, 行人边缘存在锯齿状; 在基于VSM融合结果中, 整幅图像较为模糊, 例如招牌上的文字、行人边缘等; 虽然基于LatLRR融合方法提高了图像亮度, 但也存在细节信息挖掘不充分的问题, 例如, 招牌上的文字、窗户的边缘、车身的边缘等; 基于本文方法的融合结果不仅保留了可见光场景的细节信息, 且行人、车辆、红绿灯等红外热目标边缘清晰, 接近自然场景.

对比第3组融合结果可以看出, 在基于DTCWT融合结果中, 整幅图像亮度偏暗, 热目标边缘存在光晕; 在基于GCF和VSM融合结果中, 地面纹理不清晰, 左侧草丛纹理不清晰, 且路灯周边存在明显的伪边缘; 基于LatLRR融合方法导致整幅图像较为模糊, 且热目标亮度不均匀; 基于本文方法的融合结果保留了可见光场景的细节信息, 如地面纹理信息、草丛纹理信息, 且行人和窗户等边缘清晰.

3.2 融合图像的客观评价为了更加客观地评价本文融合方法的有效性, 应用互信息MI[17]、边缘信息传递量QAB|F[18]、结构相似度SSIM[19]和特征相似度FSIM[20]分别从互信息、边缘信息保留程度、结构相似度和特征相似度评价融合图像质量. 这4个指标数值越大, 则融合效果越好. 表1给出了3组融合图像的客观评价值.

|

图 3 多组红外与可见光融合结果 |

由表1可以看出: 1)对比“Camp”, 本文方法的融合结果具有较高的MI值、QAB|F值、SSIM值和FSIM值, 表明本文融合方法在互信息、边缘保留度、结构相似度和特征相似度上均优于其他融合方法; 2)对比“Road”, 本文方法的融合结果具有较高的MI值、QAB|F值、SSIM值, 表明本文融合方法较好地保留了源图像的边缘信息、结构信息等; 在FSIM指标上, 5种融合方法的FSIM值基本接近, 表明这5种融合方法都较好地保留了源图像的特征信息; 3)对比“Kaptein”, 本文方法的融合结果具有较高的MI值、QAB|F值、SSIM值和FSIM值, 也表明本文融合方法较好地保留了源图像的灰度信息、边缘信息、结构信息和特征信息.

表2给出了3组融合图像的客观评价均值.

| 表 1 多组融合结果评价指标值 |

| 表 2 融合方法客观评价均值 |

由表2可以看出, 本文融合方法在互信息、边缘保持度、结构相似度和特征相似度均优于其他融合方法, 尤其是MI指标和QAB|F指标. 这4个评价指标均反映了融合图像与源图像间的细节保留程度, 因此, 本文融合方法能有效保留源图像的细节信息.

4 结论与展望针对红外与可见光图像融合过程中出现的细节损失严重等问题, 提出一种基于潜在低秩表示与导向滤波的红外与可见光图像融合方法. 该方法结合潜在低秩表示方法和导向滤波的优势, 将源图像分解为基础图层、细节图层和显著图层, 并分别以视觉显著度加权法、梯度显著度加权法、绝对值最大选择法作为融合规则. 最后通过叠加3个图层获得最终融合结果. 通过对多组融合结果的主、客观评价, 分析了本文方法是切实可行的, 能够得到具有丰富信息且较为清晰的融合图像, 在视觉质量和客观评价方法较优于其他方法. 但本文方法的融合结果的FSIM评价值较其他融合方法略高, 优势不是很明显, 其主要原因可能在于导向滤波的参数设置. 因此, 后续将对本文方法的灵敏度进行分析, 优化参数设置.

| [1] |

Zhu ZQ, Chai Y, Yin HP, et al. A novel dictionary learning approach for multi-modality medical image fusion. Neurocomputing, 2016, 214: 471-482. DOI:10.1016/j.neucom.2016.06.036 |

| [2] |

郭全民, 王言, 李翰山. 改进IHS-Curvelet变换融合可见光与红外图像抗晕光方法. 红外与激光工程, 2018, 47(11): 440-448. |

| [3] |

Yang SY, Wang M, Jiao LC, et al. Image fusion based on a new contourlet packet. Information Fusion, 2010, 11(2): 78-84. DOI:10.1016/j.inffus.2009.05.001 |

| [4] |

Jin X, Jiang Q, Yao SW, et al. Infrared and visual image fusion method based on discrete cosine transform and local spatial frequency in discrete stationary wavelet transform domain. Infrared Physics & Technology, 2018, 88: 1-12. |

| [5] |

Wu CM, Chen L. Infrared and visible image fusion method of dual NSCT and PCNN. PLoS One, 2020, 15(9): e0239535. DOI:10.1371/journal.pone.0239535 |

| [6] |

沈瑜, 陈小朋, 苑玉彬, 等. 基于显著矩阵与神经网络的红外与可见光图像融合. 激光与光电子学进展, 2020, 57(20): 76-86. |

| [7] |

Liu GC, Lin ZC, Yu Y. Robust subspace segmentation by low-rank representation. Proceedings of the 27th International Conference on Machine Learning. Haifa, Israel. 2010. 663–670.

|

| [8] |

Liu GC, Yan SC. Latent low-rank representation for subspace segmentation and feature extraction. Proceedings of 2011 International Conference on Computer Vision. Barcelona, Spain. 2011. 1615–1622.

|

| [9] |

Yu S, Chen XP. Infrared and visible image fusion based on a latent low-rank representation nested with multiscale geometric transform. IEEE Access, 2020, 8: 110214-110226. DOI:10.1109/ACCESS.2020.3001974 |

| [10] |

江泽涛, 蒋琦, 黄永松, 等. 基于潜在低秩表示与复合滤波的红外与弱可见光增强图像融合方法. 光子学报, 2020, 49(4): 0410001. |

| [11] |

Wang XZ, Yin JF, Zhang K, et al. Infrared weak-small targets fusion based on latent low-rank representation and DWT. IEEE Access, 2019, 7: 112681-112692. DOI:10.1109/ACCESS.2019.2934523 |

| [12] |

He KM, Sun J, Tang XO. Guided image filtering. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(6): 1397-1409. DOI:10.1109/TPAMI.2012.213 |

| [13] |

李浩谊, 马春庭. 基于改进的Scharr算法的海上舰船图像边缘检测. 舰船电子工程, 2019, 39(3): 103-106. |

| [14] |

Ma JY, Zhou Y. Infrared and visible image fusion via gradientlet filter. Computer Vision and Image Understanding, 2020, 197−198: 103016. DOI:10.1016/j.cviu.2020.103016 |

| [15] |

Tan W, Zhou HX, Song JLQ, et al. Infrared and visible image perceptive fusion through multi-level Gaussian curvature filtering image decomposition. Applied Optics, 2019, 58(12): 3064-3073. DOI:10.1364/AO.58.003064 |

| [16] |

Ma JL, Zhou ZQ, Wang B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization. Infrared Physics & Technology, 2017, 82: 8-17. |

| [17] |

Aktar M, Mamun MA, Hossain MA, et al. Weighted normalized mutual information based change detection in remote sensing images. Proceedings of the 19th International Conference on Computer and Information Technology. Dhaka, Bangladesh. 2016. 257–260.

|

| [18] |

Xydeas CS, Petrović V. Objective image fusion performance measure. Electronics Letters, 2000, 36(4): 308-309. DOI:10.1049/el:20000267 |

| [19] |

Ma KD, Zeng K, Wang Z. Perceptual quality assessment for multi-exposure image fusion. IEEE Transactions on Image Processing, 2015, 24(11): 3345-3356. DOI:10.1109/TIP.2015.2442920 |

| [20] |

Zhang L, Zhang L, Mou XQ, et al. FSIM: A feature similarity index for image quality assessment. IEEE Transactions on Image Processing, 2011, 20(8): 2378-2386. DOI:10.1109/TIP.2011.2109730 |

2021, Vol. 30

2021, Vol. 30