风能是清洁能源, 受到各国的广泛关注. 我国风能资源丰富, 修建了大量的风场及风机, 但风机所处的环境通常比较恶劣, 受到雨雪、雷电等自然因素的影响, 风机叶片容易出现腐蚀、裂纹、磨损和断裂等缺陷, 日常的巡检维护是必不可少的. 传统的人工巡检采用吊篮、回形平台等方式进行, 工作量较大且巡检效率低. 随着无人机在各行各业的广泛应用, 基于无人机的风机巡检[1-3]已成为主流趋势. 而基于无人机的风机自主巡检以其无人工干预、高效化地巡检模式受到了极大的关注, 风机自主巡检是预先根据风机的形态进行无人机航迹[4,5]和载荷姿态[6]的规划, 在作业中, 无人机自主飞行, 载荷自主动作, 对各叶片部位进行高质量成像, 以便后续分析叶片是否存在缺陷.

在巡检时, 风机可能朝向任何方向, 而各叶片相对塔筒的相位也是不同的, 若光照条件不合适, 如产生逆光拍摄, 则叶片整体过暗, 无法清晰分辨叶片出现的裂纹等缺陷, 因此风机巡检过程中的光照分析是必不可少的. 光照分析在图像层面可以理解为曝光度分析, 目前的曝光度分析大多基于灰度直方图. 赵芳等[7]以图像的灰度直方图为基础, 计算平均灰度, 依据峰值灰度和灰度图像两侧是否存在零像素区域, 估计图像曝光量效果是否恰当. 尹传海[8]采用0和255区域分析, 像素加权和、两端溢出等特性对曝光程度进行分析. 由于风机一般呈白色, 叶片等部位的像素值在正常光照下基本处于255一侧, 通常的灰度直方图分析算法[9-11]难以适用. 且基于图像的光照分析算法只能在无人机起飞到达每个叶片部位拍摄后进行判定, 并在完成巡检流程后进行整体评估, 此时若多个拍摄点出现光照异常情况, 只能重新飞行, 极大的影响作业的效率. 本文提出一套从起飞前到作业中的光照分析算法, 全面保证叶片巡检中拍摄图像的质量. 在巡检前, 基于规划的航迹和载荷姿态及太阳方位[12,13]进行光照条件预判, 以便对各拍照点的光照情况进行综合分析, 对是否开展飞行作业进行指导; 在巡检中, 对风机叶片、塔筒进行分割得到关键部位区域, 对关键区域的图像进行灰度分析, 从而判定光照是否合适, 同时, 本文引入基于加权均值的整幅图像光照分析算法, 以便全面覆盖巡检的各个时刻.

1 基于航迹规划点的光照分析基于航迹规划点的光照分析是在起飞前, 根据预先规划的航点及载荷的姿态, 对载荷是否存在正对阳光拍摄的情况进行分析. 在该情况下, 拍摄出现逆光, 风机叶片在图像中过暗, 极大的影响后续的缺陷分析.

本文首先根据巡检时间、当地纬度、无人机姿态及载荷姿态, 对相机朝向和太阳的方位进行分析, 判断每个拍照点是否发生逆光, 然后, 对航迹中所有可能的逆光点进行统计, 计算其在整个航迹中所占的比重, 进而完成当前巡检光照是否合适的预判.

1.1 太阳方位计算太阳的方位包括高度角和方位角. 本文的太阳方位计算, 参考李志明等在文献[12]提出的方法.

太阳高度角指太阳光的入射方向和地平面之间的夹角. 当日出或日落时, 太阳高度角为 0度(0 rad), 当正午时刻时, 太阳高度角最大, 计算公式如下:

| ${{h}} = \arcsin (\sin \phi \sin \delta + \cos \phi \cos \delta \cos t)$ | (1) |

其中, h是高度角,

太阳赤纬角

| $\delta = 0.409\sin \left( {\frac{{2\pi }}{{365}}(N + 284)} \right)$ | (2) |

太阳时角指地球自转的角度. 当中午12点时, 太阳时角为0; 上午时, 太阳时角为负值; 下午时, 太阳时角为正值. 计算公式如下, 其中T表示24小时制的时间.

| $t = \frac{{150\pi }}{{180}}\left( {T - 12} \right)$ | (3) |

太阳方位角指太阳光线在地平面的投影与当地子午线的夹角. 当太阳在正南方时, 太阳方位角为0; 当太阳向西运动时, 太阳方位角增大; 当太阳向东运动时, 太阳方位角减小. 计算公式如式(4), 其中A表示方位角.

| $A = \arcsin \left( {\frac{{\cos \delta \sin t}}{{\cos h }}} \right)$ | (4) |

相机的拍摄朝向与飞机和载荷的姿态角相关, 分为俯仰角与方位角. 一般, 飞机和载荷的俯仰角PitchLoad0、PitchPlane均上正下负, 飞机方位角HeadingPlane真北为0, 顺时针为正. 载荷方位角HeadingLoad0是相对值, 与机头指向一致为0, 逆时针为正. 因此, 相机朝向的绝对方位角HeadingLoad和绝对俯仰角为PitchLoad的计算公式如下:

| $ HeadingLoad = HeadingPlane - HeadingLoad0 $ | (5) |

| $ PitchLoad = PitchPlane + PitchLoad0 $ | (6) |

太阳的方位角以正南方为0, 相机朝向以真北为0, 顺时针为正. 将太阳方位角转换为与相机朝向同样的坐标系, 转换后的方位角A_h=A+180. 单个航迹点, 若太阳方位角A_h与相机朝向绝对方位角HeadingLoad相差小于阈值Thheading, 且太阳高度角与相机朝向俯仰角差值小于阈值Thpitch, 则认为相机可能指向太阳, 即产生逆光, 当前航迹点的光照不合适. 对当前规划的所有叶片拍摄航迹点的光照进行分析, 统计出现光照不合适的航迹点的数量, 若大于所有航迹点的50%, 则判定此次规划的航迹在作业中光照可能不合适, 建议暂时不进行巡检.

基于航迹规划点的光照分析方法适用于晴天或者薄云场景, 在云层非常厚的严重阴天情况下, 由于阳光较弱, 逆光拍摄状况减轻, 会对本文的预判准确性产生一定影响. 但对于无人机的风机巡检任务来说, 其作业通常会选择天气状况较好的条件进行, 尽可能避免对巡检图像产生较大范围的影响, 出现叶片裂纹[14-16]无法分辨的情况, 因此, 本文方法适用于通常条件的无人机风机巡检.

2 基于图像的光照分析基于图像的光照分析是在巡检过程中, 基于视频图像对当前风机影像的光照情况进行分析, 以便在出现光照过暗或者过亮时给出提示, 及时调整曝光量, 保证叶片拍摄的质量. 在风机巡检全流程中, 基于图像的光照分析主要分为两种情况, 一是图像中无风机关键部位或占比较小, 与自然图像类似, 在光照正常时, 灰度直方图的0及255端无显著溢出. 二是图像中风机关键部位占比较大, 在光照正常时, 灰度直方图在255端呈溢出状态.

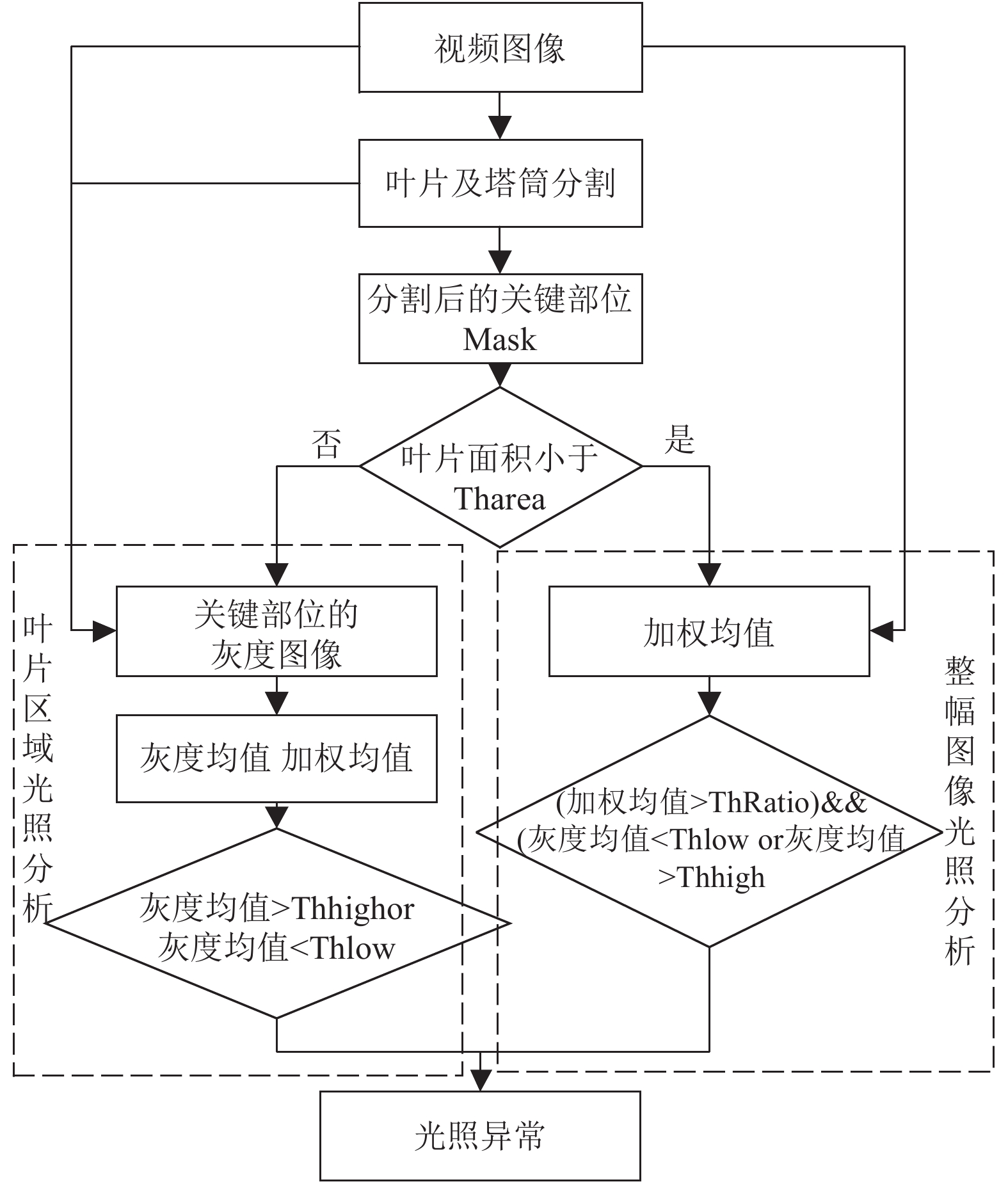

本文基于图像的光照分析方法的流程图如图1.

首先基于无人机巡检视频对风机的叶片和塔筒关键部位进行分割, 若关键部位在视频图像中占比较小, 则采用加权均值方法对当前整幅图像的光照情况进行判别, 若关键部位的占比较大, 则对关键部位的灰度均值进行分析得到光照判别的结果.

2.1 叶片及塔筒分割本文采用Mobilnetv2作为基础网络进行叶片和塔筒的分割. MobilNet[17]是Google针对手机等嵌入式设备提出的一种轻量级的深层卷积神经网络, 利用通道可分离的卷积有效减少网络参数, 提高运算速度. MobileNet v2[18]则引入Linear Bottleneck 和 Inverted Residuals增强网络的表达能力. 具体地, 本文的网络结构如表1所示, 其中, n表示模块的重复数量, c表示通道数, s表示stride, t表示中间卷积层通道的扩增倍数. bottleneck的连接方式如图2所示, 在stride为1时, 采用残差连接方式, 即将bottleneck的输入连接到输出, 在s为2时, 采用普通的顺序连接. 同时, 本文在原始MobileNet v2网络的基础上进一步减少了通道数, 提高了叶片和塔筒的分割效率.

|

图 1 基于图像的光照分析流程图 |

| 表 1 分割的基础网络结构 |

参考DeepLab[19-21]语义分割算法, 在网络输出部分, 本文将第1个和第13个bottleneck的特征作为低维度特征, 最后一个bottleneck的输出作为高维度特征. 对高维度特征分别进行Ratio为8, 16, 24的空洞卷积得到多感受野组合特征. 将多感受野组合特征与两个低纬度特征进行采样及联合后经卷积解码得到分割结果, 即mask图像, 叶片和塔筒关键部位目标点为1, 非目标点为0.

|

图 2 bottleneck 结构 |

2.2 关键部位光照分析

若mask图像中关键部位像素点与整幅图像像素点的比例大于Tharea, 则进行关键部位的光照分析, 即计算关键部位区域图像的灰度均值, 若均值小于Thlow或者大于Thhigh, 则认为存在光照过度或者光照不足的异常情况.

2.3 整幅图像光照分析若mask图像中关键部位不存在或者关键部位像素点极少, 则上述关键部位光照分析方法无法适用. 本文采用加权均值的方法对整幅图像进行光照分析. 一般, 自然图像的灰度直方图, 在光照异常的情况下, 0或者255端可能存在溢出, 那么灰度直方图中间区域对光照评判结果影响较小, 两侧对评判结果影响较大. 本文分别给像素值0–128赋予递减的权重值, 给129–255赋予递增的权重值, 采用下式方法求加权均值Sum, 加权均值越大则光照异常的可能性越高. 其中, weight(i)表示像素值i的权重, p(i)表示像素i在灰度直方图中的归一化值.

| $Sum = \sum\limits_{i = 0}^{255} {weights(i)\times p(i)} $ | (7) |

各像素值的权重采用高斯分布进行赋值. 其中

| $weights(i) = \frac{1}{{\sqrt {2\pi } \sigma }}{{\rm{e}}^{ - \textstyle\frac{{{{({{i}} - \mu )}^2}}}{{2{\sigma ^2}}}}}$ | (8) |

本文对一段包含277个点的航迹在不同日期不同时刻进行光照预判断, 并对各航迹规划点的光照分析结果进行统计. 图3展示了部分航迹规划点, 其中loadHeadingPitchRoll表示载荷的方位角、俯仰角和横滚角; planeHeadingPitchRoll表示无人机的方位角、俯仰角和横滚角. pos表示经纬高信息. 在巡检过程中, 无人机的方位角进行变化, 以便辅助调整载荷指向, 俯仰角和横滚角保持为0; 载荷的方位角和俯仰角进行变化, 以便调整相机的方位拍摄指向和俯仰拍摄指向, 来覆盖叶片的各个部位.

|

图 3 部分航迹规划点 |

表2展示了其中第1、147、264个点在2020年1月1日8:00、14:00、17:00的检核结果, 1表示出现光照异常, 0表示光照正常.

| 表 2 基于航迹规划的光照分析结果 |

不同日期不同时刻航迹规划点的光照异常统计结果如表3所示. 20200101, 8:00, 出现光照不合格的航迹点的比例为42.6%, 14:00的比例为26.7%, 18:00的比例为52.7%. 20200623, 8:00出现光照不合格的航迹点的比例为3.6%, 14:00为0, 18:00为6.4%, 可以看出, 本文算法符合北半球光照可能异常的规律, 具有较好的光照异常推断效果.

| 表 3 航迹规划点光照异常统计结果 |

为了进一步评价光照条件分析的准确性, 本文分别对3个不同时刻的风机巡检情况进行分析, 在巡检中, 相机采用固定参数拍摄模式. 将巡检航迹点与拍摄图像进行一一对应, 共形成669条数据, 对图像采用目视判断, 得到光照正常图像653幅, 光照异常图像16幅. 基于航迹规划点采用本文方法进行光照分析, 结果统计如表4所示, 正确判别光照正常点514个, 正确判别光照异常点14个.

| 表 4 基于航迹规划点的光照分析准确率统计 |

由于本文算法旨在对光照异常情况进行分析, 在此, 以光照异常作为正样本, 光照正常为负样本, 召回率为87.5%, F1值为0.1657, 准确率为78.92%.

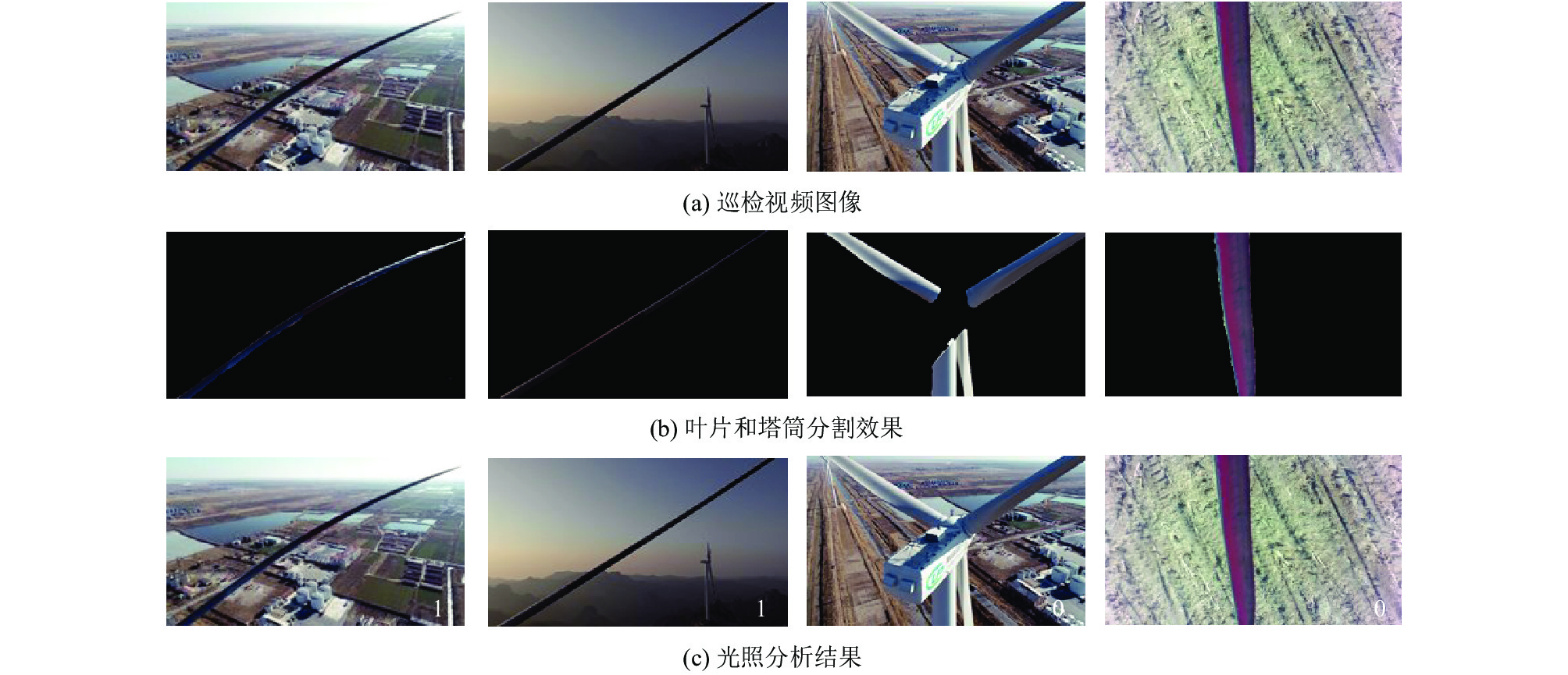

3.2 基于图像的光照分析对于叶片和塔筒分割网络的训练, 输入数据共包含6种风机类型, 多种场景、多种拍摄距离、不同焦距的图像1287幅, 并采用镜像、光照变换、多尺度等数据增强策略. 初始learning rate为0.007, 采用多项式梯度下降法, 迭代200 epoches, 测试准确率为0.976, 处理效率为28 fps. 光照异常判断阈值Thlow和Thhigh分别为90和130. 图4展示了巡检视频图像的叶片和塔筒分割效果及光照分析结果, 其中图4(a)为巡检视频图像、图4(b)为叶片和塔筒分割效果, 图4(c)为光照分析结果, 其中右下角数字0表示光照正常, 1表示光照异常.

本文对312幅图像进行光照分析算法的测试, 经过人眼目视判别光照正常的图像为283幅, 光照异常的图像为29幅, 如表5所示, 算法正确判别光照正常图像269幅, 正确判别光照异常图像26幅.

|

图 4 基于图像的光照分析结果 |

| 表 5 基于图像的光照分析结果统计 |

以光照异常作为正样本, 光照正常为负样本, 召回率为89.66%, F1值为0.7536, 准确率为94.55%.

4 结论本文面向无人机风机自主巡检, 在巡检前, 基于规划的航迹和载荷姿态及太阳方位进行光照条件预判, 以便对各拍照点的光照情况进行综合分析, 对是否开展飞行作业进行指导; 在巡检中, 基于视频图像对风机叶片、塔筒进行分割得到关键部位区域, 对关键区域的图像进行灰度分析, 从而判定光照是否合适. 同时, 本文引入基于加权均值的整幅图像光照分析算法, 以便全面覆盖巡检的各个时刻.

试验表明, 本文基于规划航迹点的光照分析符合自然规律, 预判分析准确率为78.92%, 基于图像的光照分析准确率达到了94.55%. 实现了从巡检前到巡检中全方位高准确性的光照检核, 可以有效地指导风机巡检作业, 保证拍摄图像的质量.

| [1] |

潘佳捷. 风机叶片的无人机自主巡检系统[硕士学位论文]. 成都: 电子科技大学, 2020.

|

| [2] |

勾月凯, 代海涛, 董健, 等. 风力发电机组叶片智能巡检系统研究. 第五届中国风电后市场专题研讨会论文集. 上海, 中国. 2018. 6.

|

| [3] |

贺斌, 贾建华, 赵峰, 等. 无人机在风机叶片检测中的应用. 电工技术, 2019(13): 64-65. DOI:10.3969/j.issn.1002-1388.2019.13.023 |

| [4] |

简康. 无人机航迹规划算法研究[硕士学位论文]. 西安: 西安电子科技大学, 2014.

|

| [5] |

王涵. 无人机航迹规划及导航定位系统研究[硕士学位论文]. 杭州: 浙江大学, 2017.

|

| [6] |

郭小军. 多旋翼无人机变载荷姿态稳定控制[硕士学位论文]. 长春: 吉林大学, 2018.

|

| [7] |

赵芳, 栾晓明, 孙越. 基于灰度图像的曝光量估计方法. 应用科技, 2009, 36(8): 32-34. |

| [8] |

尹传海. 基于图像处理的自动曝光和自动对焦算法研究[硕士学位论文]. 苏州: 苏州大学, 2017.

|

| [9] |

周杰. 基于多区域分割及模糊逻辑的自动曝光方法[硕士学位论文]. 上海: 上海交通大学, 2007.

|

| [10] |

闵武国. CCD成像电子学系统自动曝光和自动增益研究[硕士学位论文]. 大连: 大连海事大学, 2010.

|

| [11] |

倪国瑜, 黄昶. 基于亮度直方图宽度的自动曝光方法研究. 光学仪器, 2009, 31(6): 21-24. DOI:10.3969/j.issn.1005-5630.2009.06.005 |

| [12] |

李志明, 王文兰, 齐咏生. 太阳方位自动跟踪系统研究. 华北电力技术, 2016(2): 39-46. |

| [13] |

王斌, 张珣. 太阳方位的自动获取及实时跟踪系统的设计. 天文研究与技术, 2011, 8(1): 52-57. |

| [14] |

仇梓峰. 基于计算机视觉的风机叶片表面损伤检测研究[硕士学位论文]. 北京: 北京交通大学, 2019.

|

| [15] |

张越, 张印辉, 何自芬. 海上风力发电机叶片裂纹图像分割方法研究. 中国水运, 2019(3): 74-78. |

| [16] |

徐灵鑫. 风力发电机叶片表面缺陷检测的研究[硕士学位论文]. 杭州: 中国计量学院, 2015.

|

| [17] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. https://arxiv.org/abs/1704.04861.pdf. (2017-04-17).

|

| [18] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. 2018. 4510–4520.

|

| [19] |

Chen LC, Papandreou G, Kokkinos I, et al. DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs. The IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 |

| [20] |

Chen LC, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation. https://arxiv.org/pdf/1706.05587.pdf. (2017-12-05).

|

| [21] |

Chen LC, Zhu YK, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation. Proceedings of the 15th European Conference on Computer Vision. Munich, Germany. 2018. 833–851.

|

2021, Vol. 30

2021, Vol. 30