随着信息处理技术、网络通信技术、大数据、人工智能等科技的迅猛发展, 计算机正逐渐地融入到人类的生活中, 并与人类协同工作. 在某些领域, 计算机甚至已经取代人类去完成各种高挑战性的工作. 为了让人与计算机能够更加高效地协同工作, 更加智能、自然地交互, 新型的人机交互(Human Machine Interaction, HMI)技术已经成为社会各行各业关注和研究的热点. 拟人化必然是新型人机交互技术发展的重点, 不仅要使计算机能够通过类似于人的感官系统感知周围环境、气氛, 以及使用者的意图、情感等, 还要使其能够通过学习和模仿人类的认知习惯与人类进行交流、工作等. 研究表明, 在人机交互中需要解决的相互理解的问题, 与人和人交流中相互影响的重要因素是一致的, 最关键的因素都是“情感智能”的能力[1-3]. 具有“情感智能”能力的计算机能够高效地识别使用者的情感, 从而调整与使用者的交流方式与环境, 实现更加智能、自然的交互.

近年来, 情感识别技术逐渐被应用在医学、教育、安全驾驶、电子商务等领域. 例如, 在教育领域, 智能教育系统通过分析学生们的学习情绪, 反馈学习数据, 老师可以根据相关数据调整教学模式, 以满足学生个性化学习的需求, 提高学习效率与效果; 在安全驾驶领域, 计算机使用情感识别技术分析驾驶者的情绪, 可以根据驾驶者的情绪变化调整车速上限、规划路线等, 从而避免危险的发生, 保证驾驶者的安全. 随着人机交互领域的不断扩张和情感识别领域的不断发展, 情感识别技术的应用也越来越广.

2 情感识别研究现状美国心理学家梅拉比安认为, 情感表达=55%面部表情+38%声音+7%其它[4,5]. 人的情感主要通过面部状态、声音以及文字等方式进行表达. 从生物角度来看, 人类主要通过视听觉感知系统来进行情感识别, 即是主要在语音和图像两种模态上进行情感识别. 在语音和图像多模态情感识别的研究中, 许多学者已经取得了一定的研究成果.

在语音模态上, 曹鹏等使用Mallat塔式算法与小波变换奇异点检测算法相结合进行基音频率参数提取, 并通过实验证实了该算法的有效性[3]. 屠彬彬等提出了一种基于样本熵与Mel频率倒谱系数融合的语音情感识别方法, 得到了较高的识别率[6]. 姚增伟等通过提取Mel频率倒谱系数作为输入, 分别使用卷积神经网络和长短时记忆网络进行特征提取, 并且在IEMOCAP语音情感语料库中获得51.7%的准确率[7].

在面部图像模态上, 邹元彬等在JAFFE数据集上分别提取面部图像的局部二值模式LBP和局部相位量LPQ特征, 并使用支持向量机SVM作为分类器进行实验, 得到了90.57%的识别率[8]. 陈津徽等提出了一种基于改进VGG19网络的人脸表情识别算法, 并在FER2013数据集上得到了72.69%的准确率[9].

在语音和面部图像的多模态研究中, 朱晨岗基于视听觉感知系统, 分别使用基于Mel尺度小波包分解的子带能量特征基于光流法提取的运动特征等, 并用循环神经网络作为分类器进行多模态情感分类实验[10]. 贺奇基于语音和图像进行多模态情感识别研究, 分别使用92维语音情感特征和基于序列图像脸部特征点提取方法提取的表情图像特征进行实验, 并验证了基于语音和图像的多模态情感识别比单一模态的识别效果更好[11]. 袁亮通过深度学习技术进行情感识别研究, 分别提出了一种基于卷积神经网络和循环神经网络的面部表情识别方法和一种基于长短时间记忆网络和卷积神经网络的语音情感识别方法, 并通过决策融合算法融合面部表情和语音模态的特征进行实验, 同样验证了多模态的情感识别效果要优于单模态的情感识别效果[12]. 因此, 多模态情感识别研究具有可行性, 同时从以上文献成果可以发现, 多模态融合实现的方法和实验选择是比较灵活的. 融合的目的就是将各单模态下能反应情感的特征数据合并成一个性能更优的数据结果. 所以, 可以基于相同实验数据, 尝试对两种模态进行早期融合或晚期融合, 还可以通过调整其融合权重, 灵活选择实验测试方法, 以达到更加精确的识别率.

3 研究原理和实现方法本文对于情感识别的研究主要也是在语音和图像两种主流模态上进行, 首先将视频样本切分为语音和图像数据, 然后分别提取两种模态的情感特征, 并使用多个分类器进行实验, 得到多个基于单特征的表情识别模型, 最后采用晚期融策略进行模型融合, 得到最优的集成表情识别模型, 实验的主要流程如图1所示.

|

图 1 实验流程图 |

3.1 语音特征提取

语音模态的特征主要包括Mel频率倒谱系数MFCC、SoundNet卷积神经网络提取的特征以及IS09、IS11、IS13等帧级特征, 其中IS09、IS11、IS13等帧级特征使用openSMILE工具提取.

(1) Mel倒谱系数MFCC

首先, 对采样得到的一帧离散语音序列x(n)作快速傅里叶变换FFT, 快速傅里叶变换的公式如下:

| $X(k) = \sum\limits_{n = 0}^{N - 1} {x(n){{\rm{e}}^{ - j\tfrac{{2\pi }}{N}nk}}} ,{\rm{ }}k = 0,1,2, \cdots ,N - 1$ | (1) |

其中, N为帧长.

其次, 配置Mel滤波器组并计算滤波输出, Mel滤波器的频率响应Hm(k)为:

| $\begin{split} {H_m}(k) = \left\{ \begin{array}{l} 0,\quad k < f(m - 1)\\ \dfrac{{2(k - f(m - 1))}}{{(f(m + 1) - f(m - 1))(f(m) - f(m - 1))}},\\ \qquad\qquad\qquad\qquad\qquad f(m - 1) \le k \le f(m)\\ \dfrac{{2(f(m + 1) - k)}}{{(f(m + 1) - f(m - 1))(f(m) - f(m - 1))}},\\ \qquad\qquad\qquad\qquad\qquad f(m) \le k \le f(m + 1)\\ 0,\quad k \ge f(m + 1) \end{array} \right. \end{split}$ | (2) |

其中, f(m)为滤波器的中心频率.

然后, 计算每个滤波器组输出的对数能量S(m).

| $S(m) = \ln \left( {\sum\limits_{k = 0}^{N - 1} {{{\left| {{X_a}(k)} \right|}^2}{H_m}(k)} } \right),\;0 \le m \le M $ | (3) |

其中, M为滤波器的个数.

最后, 经离散余弦变换DCT可得到MFCC系数C(n), 公式描述如下:

| $\begin{split} \\ C(n) = \sum\limits_{m = 0}^{N - 1} {S(m)\cos \left( {\frac{{\pi n(m - 0.5)}}{M}} \right)},\;n = 1,2, \cdots ,L \end{split}$ | (4) |

其中, L为MFCC系数的阶数.

(2) SoundNet卷积神经网络

SoundNet网络是一种具有较高语音信息学习能力的深度卷积神经网络[16], 其实现的基本原理如下:

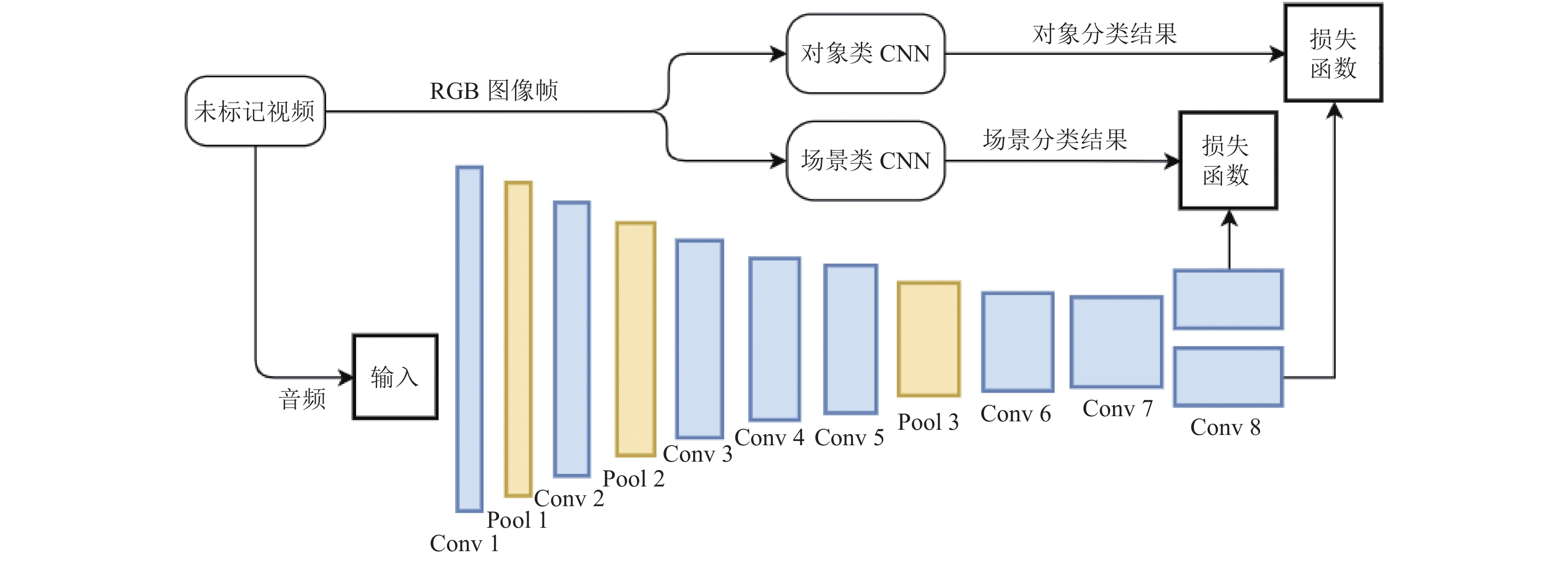

首先将视频切割音频和RGB图像帧两部分, RGB图像帧部分分别使用了图像类卷积神经网络ImageNet CNN和场景类神经网络Places CNN进行识别分类, 并将RGB图像帧分类的结果作为SoundNet网络的监督信息, 从而可以学习得到语音的相关信息. SoundNet网络由8层卷积层和3层池化层组成, 损失函数为KL散度. 图2为SounNet网络结构图, 其中conv n代表第n层卷积层, pool n代表第n层池化层, 下同.

3.2 图像特征提取图像模态的特征主要包括使用DenseNet、VGG等卷积神经网络提取的特征, 以及LBP-TOP特征描述子.

(1) DenseNet网络

DenseNet网络采用了一种密集连接的模式, 不需要重新学习冗余的特征映射, 具有减轻梯度消失、加强特征的传递以及高效利用特征等优点. 本文实验中使用的是DenseNet网络中的一个特殊网络DenseNet-BC网络.

DenseNet-BC网络是包含了Bottleneck layer瓶颈层和Transition layer过渡层的特殊DenseNet网络结构, 其中, 过渡层即由一层卷积层和一层池化层组成的网络层. DenseNet-BC网络包含了3个Dense Block和2层过渡层. 图3为DenseNet-BC网络结构图, 其中Dense block n代表第n个密集块.

|

图 2 SoundNet网络结构及实现原理图 |

|

图 3 DenseNet-BC网络结构图 |

(2) VGG网络

VGG网络是使用3×3小卷积核和2×2最大池化层的深度卷积神经网络, 并且极大地提升了网络的深度, 其独特的结构特点在很大程度上提高了神经网络的学习能力. 本文实验中使用的是VGG系列网络中的VGG-16网络. VGG-16网络具有13个卷积层、5个池化层和3个全连接层. 图4为VGG-16网络结构图, 其中Fc n代表第n层全连接层.

|

图 4 VGG-16网络结构图 |

3.3 分类器的选择与设计

在分类器方面, 本文选择了多种分类器进行实验, 包括支持向量机SVM和随机森林RF等经典分类器, 同时, 考虑到在将视频样本切分为图像样本时, 得到的是长序列的图像帧, 而长短期记忆网络LSTM在处理长序列数据具有较显著的优势, 所以设计了一个基于LSTM的分类器用以实验.

(1)基于LSTM的分类器设计

基于LSTM设计的分类器的结构如图5所示, 输入序列X为不同时间的特征, 在输入层后添加一层批标准化层, 多个LSTM结点组成的LSTM阵列进行特征信息的捕获, 通过平均池化层对不同时间的特征信息平均并输出到Softmax层进行分类.

3.4 决策层融合在多模态情绪识别领域, 加权投票法、加权平均法是较为常见的决策融合方法, 其中, 投票法更适用于决策融合中的各模型相互独立的情况. 考虑到本文中各个模型的训练都相互独立, 并不存在强依赖关系, 采用加权投票法进行决策融合可能会带来一定的提升. 加权投票法具体实现如下:

|

图 5 基于LSTM的分类器结构图 |

设表情类别数目为M, 模型的数量为L, hi为第i个情感识别模型, wi第i个模型对融合模型决策结果的贡献权重, 其中, wi的约束为:

| $\left\{ {\begin{array}{*{20}{l}} {\displaystyle\sum\limits_{i = 1}^L {{w_i}} = 1}\\ {{w_i} \in \left[ {0,1} \right],\;i = 1,2, \cdots ,L} \end{array}} \right.$ | (5) |

对于样本x, 设f(x)是基于加权投票法得到的各种表情类别的加权投票值的集合, y(x)是表情类别的决策结果, 则有:

| ${f_j}(x) = \sum\limits_{i = 1}^L {{w_i}I({h_i}(x),j)} $ | (6) |

| $y(x) = \arg \max {f_j}(x)$ | (7) |

其中, j=1, 2, …, M, 指示函数I的定义为:

| $I(a,b) = \left\{ {\begin{array}{*{20}{c}} {1,}&{a = b} \\ {0,}&{a \ne b} \end{array}} \right.$ | (8) |

权重的学习使用基于个体分类模型相对优势的投票权重学习方法[17].

4 实验过程及结果本文主要基于AFEW数据集[18]来进行多模态情感识别研究. 实验首先将AFEW数据集的视频数据切分为音频数据和图片数据, 分别进行语音、图像模态的情感特征提取.

4.1 音频数据处理和特征提取在提取语音特征前, 需要对音频文件进行重采样、分帧和加窗3个预处理操作, 其中帧长为25 ms, 帧移为10 ms, 窗函数为汉明窗, 然后提取MFCC、IS09、IS11、IS13等段级特征, 其中段长度为整个话语段的长度, IS09、IS11、IS13是基于openSMILE工具包提取的. 在使用SoundNet卷积神经网络提取特征时, 把音频文件的原始数据作为输入, 提取后的特征标记为SoundNet.

4.2 图像数据处理和特征提取在提取图像特征时, 首先要对图像进行人脸检测和人脸的校正裁剪两个预处理操作. 由于AFEW数据集的作者已经提供了大部分已经裁剪好的人脸灰度图像, 未提供的图片数据仅为Train训练集下的17个视频和Val验证集下的12个视频. 因此, 我们仅对未提供的图片数据进行预处理操作, 在成功提取人脸灰度图像后仍需进行直方图均衡化处理, 以减轻灯光对图像的影响.

完成预处理操作后, 我们将预训练后的DenseNet-BC和VGG16卷积神经网络模型在FRE2013数据集上微调, 然后将预处理后的图像作为微调后的模型的输入来提取图像特征. 使用DenseNet-BC卷积神经网络提取特征时, 将DenseNet-BC网络的最后一个平均池化层的输出作为特征, 该特征被标记为DenseNet-pooling3. 使用VGG卷积神经网络提取特征时, 将VGG-16网络的第13层卷积层和第1层全连接层的输出作为特征, 分别被标记为VGG-conv13、VGG-fc1.

基于LBP-TOP特征描述子提取的特征已经被AFEW数据集的作者提供, 将该特征标记为LBP-TOP.

4.3 实验结果与分析在完成语音和图像模态的特征提取后, 使用支持向量机SVM、随机森林RF以及基于LSTM的分类器进行表情分类, 得到多个基于音频、图像单特征表情识别模型.

(1)基于语音单特征模型的分类结果, 如表1所示.

| 表 1 基于音频单特征表情识别模型及其准确率 |

通过分析实验结果数据, 可以得出以下几点结论:

① LSTM分类器在语音特征MFCC、SoundNet上相较于支持向量机SVM、随机森林RF等分类器有着3.4%~6.26%准确率提升;

② 在语音单特征模型中, 基于IS09特征的模型取得最高准确率为32.11%.

(2)基于图像单特征模型的分类结果, 如表2所示.

| 表 2 基于图像单特征表情识别模型及其准确率 |

通过分析实验结果, 可以发现以下几点:

① 基于LSTM的分类器在图像特征VGG-conv13、VGG-fc1、DenseNet-pooling3上相较于分类器支持向量机SVM有着3.92%~6.27%准确率提升;

② 在图像单特征模型中, 基于VGG-conv13特征的模型取得最高准确率为42.56%;

③ 基于图像单特征的最优模型比基于语音单特征的最优模型的准确率高11.23%.

(3)基于融合模型的分类结果, 如表3所示.

在进一步实验中, 使用加权投票法对多个单特征模型进行决策融合, 分别得到基于语音模态、图像模态以及语音和图像双模态的3种融合模型.

通过对比3种融合模型的分类结果, 可以发现基于音频和图像双模态融合模型的准确率达到50.13%, 此准确率高于单模态融合模型的准确率. 该双模态融合模型在愤怒Angry、害怕Fear、高兴Happy、中性Neutral等几种情绪上的分类准确率均达到60%以上, 而在厌恶Disgust和惊讶Surprise两种情绪上的识别效果较差, 其混淆矩阵数据如图6所示.

| 表 3 3种融合模型及其准确率 |

|

图 6 融合模型的混淆结果矩阵 |

4.4 双模态融合模型的实验结果对比与分析

情绪识别的相关研究有很多. 本文提出的一种基于视听觉感知系统的多模态表情识别算法, 在AFEW数据集进行实验得到了50.13%的准确率.

如表4所示, AFEW数据集是EmotiW比赛的官方数据集, 该数据集的准确率基线Baseline为41.07%, 在该比赛中, 参赛者的平均准确率50%左右, 最高准确率为61.87%. 虽然本文的方案在准确率上低于最高的准确率, 但也保持在平均水平之上, 仍然具有一定的竞争力.

5 结语本文提出了一种基于视听觉感知系统的多模态表情识别算法, 分别提取语音和图像两种模态的情感特征, 并设计多个分类器为单个情感特征进行情绪分类实验, 得到多个基于单特征的表情识别模型. 最后使用晚期融合策略进行特征融合, 得到基于多个单特征模型的融合表情识别模型, 并通过对比实验证明语音和图像双模态融合表情识别模型的有效性.

本文使用AFEW数据集进行表情识别实验, 首先将AFEW数据集的视频数据切分为音频数据和图片数据, 分别进行语音、图像模态的情感特征提取. 在语音数据上, 提取的情感特征包括MFCC、IS09、IS11、IS13等段级特征, 以及使用卷积神经网络SounNet提取的特征. 在图片数据上, 提取的情感特征包括使用深度卷积神经网络VGG-16和DenseNet提取的特征, 以及基于LBP-TOP特征描述子提取的特征. 然后, 使用了多个分类器对单个特征进行了情绪分类实验, 并证明了使用基于LSTM分类器相较于支持向量机SVM、随机森林RF等分类器对实验效果有着小幅度的提高. 最后使用加权投票法进行模态融合实验, 通过对比基于语音模态、图像模态以及语音和图像双模态的3种融合模型的分类结果, 证明了基于语音和图像双模态融合模型的效果要优于基于单模态融合模型的识别效果.

| 表 4 EmotiW比赛: 音视频情绪分类的部分数据[19] |

但本文仍然存在许多不足之处: 情感的体现过程一般为: 开始——高潮——结束, 情感主要体现在高潮部分, 而在音频模态实验中, 提取的特征是基于整段语音样本的, 其中包含过多冗余数据, 影响了识别的准确性, 考虑将语音样本分段或许可以有效地降低数据的冗余; 在特征融合阶段可以尝试采用特征层融合策略进行实验对比, 甚至根据应用场景或应用群体的需求, 可以考虑基于文本、声音、图像、视频等多种模态融合的情感识别实践研究.

| [1] |

张会云. 语音情感识别研究综述. 信息通信, 2019(11): 58-60. DOI:10.3969/j.issn.1673-1131.2019.11.027 |

| [2] |

潘家辉, 何志鹏, 李自娜, 等. 多模态情绪识别研究综述. 智能系统学报, 2020, 15(4): 633-645. DOI:10.11992/tis.202001032 |

| [3] |

曹鹏. 语音情感识别技术的研究与实现[硕士学位论文]. 镇江: 江苏大学, 2005.

|

| [4] |

林记明. 体态语言的功能及其应用. 西安外国语学院学报, 2001, 9(4): 47-51. DOI:10.3969/j.issn.1673-9876.2001.04.013 |

| [5] |

Soleymani M, Pantic M, Pun T. Multimodal emotion recognition in response to videos. IEEE Transactions on Affective Computing, 2012, 3(2): 211-223. DOI:10.1109/T-AFFC.2011.37 |

| [6] |

屠彬彬, 于凤芹. 基于样本熵与MFCC融合的语音情感识别. 计算机工程, 2012, 38(7): 142-144. DOI:10.3969/j.issn.1000-3428.2012.07.047 |

| [7] |

姚增伟, 刘炜煌, 王梓豪, 等. 基于卷积神经网络和长短时记忆神经网络的非特定人语音情感识别算法. 新型工业化, 2018, 8(2): 68-74. DOI:10.19335/j.cnki.2095-6649.2018.2.009 |

| [8] |

邹元彬, 乐思琦, 廖清霖, 等. 基于LBP和LPQ的面部表情识别. 信息技术与信息化, 2020(9): 199-205. DOI:10.3969/j.issn.1672-9528.2020.09.064 |

| [9] |

陈津徽, 张元良, 尹泽睿. 基于改进的VGG19网络的面部表情识别. 电脑知识与技术, 2020, 16(29): 187-188. DOI:10.14004/j.cnki.ckt.2020.3328 |

| [10] |

朱晨岗. 基于视听觉感知系统的情感识别技术研究[硕士学位论文]. 天津: 天津理工大学, 2018.

|

| [11] |

贺奇. 基于语音和图像的多模态情感识别研究[硕士学位论文]. 哈尔滨: 哈尔滨工业大学, 2017.

|

| [12] |

袁亮. 基于深度学习的双模态情感识别[硕士学位论文]. 南京: 南京邮电大学, 2018.

|

| [13] |

张钰莎, 蒋盛益. 基于MFCC特征提取和改进SVM的语音情感数据挖掘分类识别方法研究. 计算机应用与软件, 2020, 37(8): 160-165, 212. DOI:10.3969/j.issn.1000-386x.2020.08.028 |

| [14] |

郭卉, 姜囡, 任杰. 基于MFCC和GFCC混合特征的语音情感识别研究. 光电技术应用, 2019, 34(6): 34-39. DOI:10.3969/j.issn.1673-1255.2019.06.008 |

| [15] |

罗相林, 秦雪佩, 贾年. 基于MFCC及其一阶差分特征的语音情感识别研究. 现代计算机, 2019(11): 20-24. DOI:10.3969/j.issn.1007-1423.2019.11.004 |

| [16] |

Aytar Y, Vondrick C, Torralba A. Soundnet: Learning sound representations from unlabeled video. arXiv: 1610.09001, 2016.

|

| [17] |

李宏菲, 李庆, 周莉. 基于多视觉描述子及音频特征的动态序列人脸表情识别. 电子学报, 2019, 47(8): 1643-1653. DOI:10.3969/j.issn.0372-2112.2019.08.006 |

| [18] |

Dhall A, Goecke R, Lucey S, et al. Collecting large, richly annotated facial-expression databases from movies. IEEE MultiMedia, 2012, 19(3): 34-41. DOI:10.1109/MMUL.2012.26 |

| [19] |

Dhall A, Kaur A, Goecke R, et al. EmotiW 2018: Audio-video, student engagement and group-level affect prediction. Proceedings of the 20th ACM International Conference on Multimodal Interaction. Boulder: ACM, 2018. 653–656.

|

| [20] |

Liu CH, Tang TH, Lv K, et al. Multi-feature based emotion recognition for video clips. Proceedings of the 20th ACM International Conference on Multimodal Interaction. Boulder: ACM, 2018. 630–634.

|

| [21] |

Fan YR, Lam JCK, Li VOK. Video-based emotion recognition using deeply-supervised neural networks. Proceedings of the 20th ACM International Conference on Multimodal Interaction. Boulder: ACM, 2018. 584–588.

|

| [22] |

Lu C, Zheng WM, Li CL, et al. Multiple spatio-temporal feature learning for video-based emotion recognition in the wild. Proceedings of the 20th ACM International Conference on Multimodal Interaction. Boulder: ACM, 2018. 646–652.

|

2021, Vol. 30

2021, Vol. 30