2. 海丰通航科技有限公司, 北京 100070;

3. 中国科学院 软件研究所, 北京 100190

2. Haifeng General Aviation Technology Co. Ltd., Beijing 100070, China;

3. Institute of Software, Chinese Academy of Sciences, Beijing 100190, China

大型舰船舰面保障作业指大型舰船携带的飞机从降落至舰面到起飞离舰的整个过程涉及的所有作业, 包括飞机降落、卸载物资、检查、维修、充电、补充燃料与滑油、加注特种气体、换胎、加载物资、调运、起飞等数十个保障作业[1]. 基于舰面监控视频检测舰面保障作业利于分析并提高保障作业效率, 对大型舰船作战效能的发挥至关重要. 然而, 一架飞机的保障作业具有复杂的串并行关系, 不同类型飞机的保障作业串并行关系不同. 单个保障作业由数位操作员使用多种器械协作完成. 大型舰船携带的机群的一次出动, 往往需要数十架不同类型的飞机并行地进行舰面保障作业, 涉及数以百计的操作员、器械与设施设备统筹协作. 这导致同一舰面监控视频场景内同时发生多个保障作业, 不同保障作业的参与者(操作员、器械或设施设备等)位置交叉; 如图1所示, 同一视频场景内同时发生调运车调运(图1(a)左下角3个参与者)与调运员调运飞机(图1(a)右上角3个参与者)两个保障作业, 在视频的中间时刻两组保障作业参与者相遇(图1(b)), 从整个保障作业过程来看, 两组保障作业参与者位置交叉(图1(c)).

|

图 1 同一视频场景内同时发生的参与者位置交叉的保障作业示意图 |

随着监控设备的普及与发展, 监控视频中事件检测受到越来越多的关注. 现有的监控视频事件检测技术主要针对3类问题: 第1类是个体姿态事件的检测问题[2, 3], 例如, 走路、跑步、指人、打电话、放东西等. 这类事件有区别于其他事件的标志性姿态, 通过检测视频内标志性姿态实现事件检测; 第2类是个体运动事件的检测问题[4], 例如, 徘徊、逆行等, 通过检测目标个体的运动轨迹实现事件检测; 第3类是群体运动事件的检测问题[5], 比如, 人群聚集、人群分离等, 通过分析群体运动轨迹实现事件检测. 而舰面保障作业持续时间长(数分钟至十几分钟不等)、参与者多(单个保障作业由数个操作员使用多种器械协作完成)、参与者动作多样(操作员需做多个动作完成一个保障作业)、不同保障作业参与者的位置交叉重叠; 单个关键帧、单个特征或个体的单个动作、轨迹无法刻画整个保障作业. 现有的监控视频事件检测技术不太适合大型舰船舰面保障作业检测.

相对传统的监控视频中事件检测技术, 近年兴起的复杂事件检测技术关注持续时间较长(从数分钟至数小时不等)、类内变化较大(涉及多个参与者的多个动作)、包含信息丰富复杂的事件[6]. 然而, 现有的复杂事件检测技术[7-9]从样本视频的关键帧内提取特征训练模型, 更适合场景内只发生一个复杂事件的情况. 但在大型舰船舰面上, 同一视频场景中同时发生多个保障作业, 而且各保障作业的参与者位置交叉. 现有的复杂事件技术难以满足大型舰船舰面保障作业检测的需求.

本文提出了一种基于视频事件的大型舰船舰面保障作业检测技术, 可检测同一视频场景中并发的参与者位置交叉的舰面保障作业. 我们将舰面保障作业视为一系列小粒度事件按一定约束组合成的复杂事件; 先采用基于轨迹层次聚类的保障作业结构提取算法, 确定场景内保障作业的组合层次结构; 再采用基于作业模型的保障作业识别算法, 逐层识别保障作业类型, 实现并发的参与者位置交叉的保障作业的检测.

本文方法有两个创新点: 1)基于轨迹层次聚类的保障作业结构提取算法. 该算法对场景内目标物轨迹自顶向下层次聚类, 使参与同一保障作业的目标物轨迹于同一聚类内, 从而获得场景内保障作业的组合层次关系与各保障作业的参与者; 2)基于作业模型的保障作业识别算法. 我们将保障作业视为一系列小粒度事件按一定约束构成的复杂事件; 先采用视频事件描述语言(video event description language)定义保障作业模型, 再依据保障作业模型, 针对保障作业的组合层次结构, 自底向上逐层识别保障作业.

1 本文方法概述本文方法共分为两个阶段, 视频数据预处理与保障作业检测(如图2). 本文的重点是保障作业检测. 在视频数据预处理阶段, 跟踪获得场景内目标物(操作员、器械、设施设备)运动轨迹并对轨迹进行修剪, 得到清晰、连贯的轨迹. 在保障作业检测阶段, 假设已获取场景内目标物的运动轨迹. 先采用基于轨迹层次聚类的保障作业结构提取算法, 对场景内目标物轨迹自顶向下层次聚类, 使参与同一保障作业的目标物轨迹于同一聚类内, 从而得到场景内保障作业的层次组合关系及各保障作业的参与者(第2.1节); 再采用基于作业模型的保障作业识别算法, 针对保障作业的层次组合结构, 依据保障作业模型, 自底向上识别各保障作业(第2.2节).

|

图 2 本文方法流程图 |

视频数据预处理. 在预处理阶段, 首先采用现有方法[10]跟踪舰面监控视频, 再对跟踪得到的轨迹做修剪, 包括连接间断轨迹、除掉过短轨迹及修剪噪声轨迹, 最终得到清晰、连贯的目标物运动轨迹. 轨迹修剪方法如下:

第1步. 长度过短轨迹视为噪音, 过滤掉. 令轨迹长度

第2步. 角度突变的轨迹顶点视为噪音, 进行平滑操作. 令轨迹顶点

第3步. 连接间断轨迹. 若两轨迹目标物类型相同、距离相近且于彼此延长线上, 视为间断轨迹, 联接成一条轨迹. 令轨迹T的正向延长线

我们将保障作业视为由一系列小粒度事件按一定约束组合成的复杂事件. 提取保障作业结构就是提取场景内保障作业的层次组合关系, 并确定各保障作业的参与者. 目标物运动轨迹反映出保障作业参与者位置的变化, 是判断其参与的保障作业的重要线索. 基于此, 我们将保障作业层次组合结构提取形式化成目标物轨迹层次聚类问题. 为了解决该问题, 我们先将场景中目标物轨迹组织到轨迹图中, 再通过轨迹图的层次分割得到轨迹层次聚类(如图3). 一个轨迹聚类表示一个保障作业. 聚类包含的轨迹为该保障作业的参与者. 轨迹聚类的层次结构为保障作业的层次组合结构.

|

图 3 轨迹层次聚类示意图 |

目标物轨迹图. 目标物轨迹图的一个顶点表示一条轨迹, 边表示轨迹间相邻关系, 边权重表示目标物轨迹参与同一保障作业的概率. 我们依据3个原则计算边权重: 1)轨迹夹角. 若两目标物在整个作业过程中保持运动方向基本一致, 它们极可能参与同一保障作业; 2)轨迹间距. 若两目标物作业过程中始终保持在很小距离内, 它们极可能参与同一保障作业; 3)轨迹共现. 参与同一保障作业的目标物必然同时出现于同一场景. 轨迹图边权重

轨迹图层次分割. 给定轨迹图, 我们迭代地对其进行二分割, 直至各子图只包含一个顶点. 如此, 得到轨迹的层次聚类结构(如图3). 对轨迹图的每一次二分割, 都通过求解如下目标函数[11]实现:

| ${\rm {arg\;min}}(\dfrac{{cut\left( {A,B} \right)}}{{tcon\left( {A,V} \right)}} + \dfrac{{cut\left( {A,B} \right)}}{{tcon\left( {B,V} \right)}})$ |

其中,

给定场景内保障作业的层次组合结构, 需要识别各保障作业的类型. 为此, 定义保障作业模型(第2.2.1节); 再依据作业模型, 针对保障作业层次组合结构, 自底向上逐层识别各保障作业(第2.2.2节).

2.2.1 保障作业模型采用视频事件描述语言定义保障作业模型, 将其描述成由一系列小粒度事件按一定约束组合成的复杂事件. 保障作业模型

事件按复杂度分为状态与事件两类[12]. 状态指在某一时刻或某一段时间内保持稳定不变的情况. 最小粒度的状态称为基本状态. 基本状态不可再分. 图4(a)为基本状态的一个例子. 该基本状态的参与者只有飞机一个实体. 飞机的移动速度有两条约束: 大于0, 小于阈值

|

图 4 状态的例子 |

事件指实体在两个连续时刻的状态发生了改变. 事件按复杂度分为基本事件与组合事件. 基本事件是只涉及基本状态改变的事件; 基本事件的一个例子见图5(a). 该基本事件的参与者只有飞机一个实体, 由飞机的两个基本状态, 飞机移动与飞机滑动组合而成. 该基本事件的约束是飞机由移动状态转变为滑动状态. 复杂事件是由一系列状态与事件组合成的事件; 复杂事件的一个例子见图5(b). 该复杂事件有两位操作员和一架飞机3个参与者. 构成它的子事件包括:

|

图 5 事件的例子 |

本文共定义了13个基本状态(飞机滑动、飞机移动、调运车移动、操作员移动、物资转运车移动、物资挂载车移动、物资于物资转运车上、物资不在物资转运车上、物资于物资挂载车上、物资不在物资挂载车上、叉车移动、飞机静止、操作员静止)、4个组合状态(调运车调运飞机、操作员调运飞机、操作员指挥调运车调运飞机、物资转运)、3个基本事件(飞机加速、物资转运车卸载、物资挂载)和1个组合事件(飞机起飞). 保障作业模型就是某个状态或某个事件. 本文总共定义了13个保障作业模型, 包括: 飞机移动、调运车转运、调运员移动、物资转运车调运、物资挂载车调运、叉车调运、调运车调运飞机、调运员调运飞机、调运员指挥调运车调运飞机、物资转运、物资转运车卸载、物资挂载和飞机起飞.

2.2.2 保障作业识别我们依据保障作业模型, 沿着场景内保障作业层次组合结构, 自底向上识别保障作业. 对只包含一个轨迹的聚类, 我们检测其符合的基本状态, 再依次检查组合状态、基本事件与组合事件[14]. 为了检查基本状态, 我们查询聚类内各目标物是否符合基本状态的约束; 若符合约束, 则判断发生了对应的基本状态. 在检测组合状态时, 首先, 找到包含发生的基本状态的组合状态; 然后, 检查这些组合状态的其他参与者是否被发现. 若已被发现, 则检查其约束是否得到满足. 一旦约束得到满足, 则判断发生了对应的组合状态. 基本事件与组合事件采用类似方法检查. 若轨迹聚类不满足任何一个状态或事件的约束, 则视它的两个子事件为并发事件. 如此, 沿着保障作业层次组合结构逐层向上检测, 直至顶层. 整个过程中, 检测到哪些保障作业模型就表示场景内发生了哪些保障作业.

3 实验验证与分析采用HP Z840图形工作站(Intel Xeon 6136 3.0 GHZ, NVIDIA TITAN XP GPU)实现本文方法. 为了验证并分析本文方法, 制作了大型舰船舰面保障作业视频数据集, 包括28个视频, 视频帧速率25帧/s, 分辨率

保障作业识别算法机制分析. 保障作业识别算法可视为保障作业模型定义的逆过程. 作业模型对保障作业自顶向下地形式化定义. 而保障作业识别算法从保障作业模型树形结构的叶子结点开始, 先识别最基本、最简单的保障作业(基本状态或基本事件), 再向上逐层识别涉及更多目标物、更加复杂的保障作业(组合状态或组合事件), 直至达到保障作业模型的根结点, 即识别整个场景内所有保障作业. 保障作业识别算法的优势有两点: 1)沿着轨迹层次结构, 依据保障作业模型, 自底向上, 从最简单、最基本的状态或事件开始, 逐步检测到更加复杂的作业, 避免组合爆炸, 计算量更小; 2)各聚类内保障作业独立对待, 实现同一场景并发保障作业的检测. 为了评估本文保障作业识别算法的性能, 对比了如下3种作业识别算法:

1) Ours: 本文提出的保障作业识别算法.

2) TopDown: 沿着场景内轨迹层次聚类结构, 自顶向下识别保障作业, 即从轨迹层次结构的根结点开始, 先得到包含根结点内目标物的所有保障作业模型, 再依次对这些作业模型及其组合逐层向下检测, 得到场景内保障作业.

3) Bruteforce: 针对场景内所有轨迹, 遍历所有保障作业模型及其组合, 检测场景内保障作业.

|

图 6 保障作业视频数据集数量统计 |

3种作业识别算法的mAP见图7. 观察可知, 3种算法的mAP基本相同. 3种作业识别算法的运行时间见图8. 观察图8, TopDown与Bruteforce所用时间远超本文算法. 因为TopDown与Bruteforce需遍历所有相关保障作业模型及其组合, 面临组合爆炸问题. 而本文算法, 因采取自底向上的策略, 避免了组合爆炸, 所用时间极大缩短.

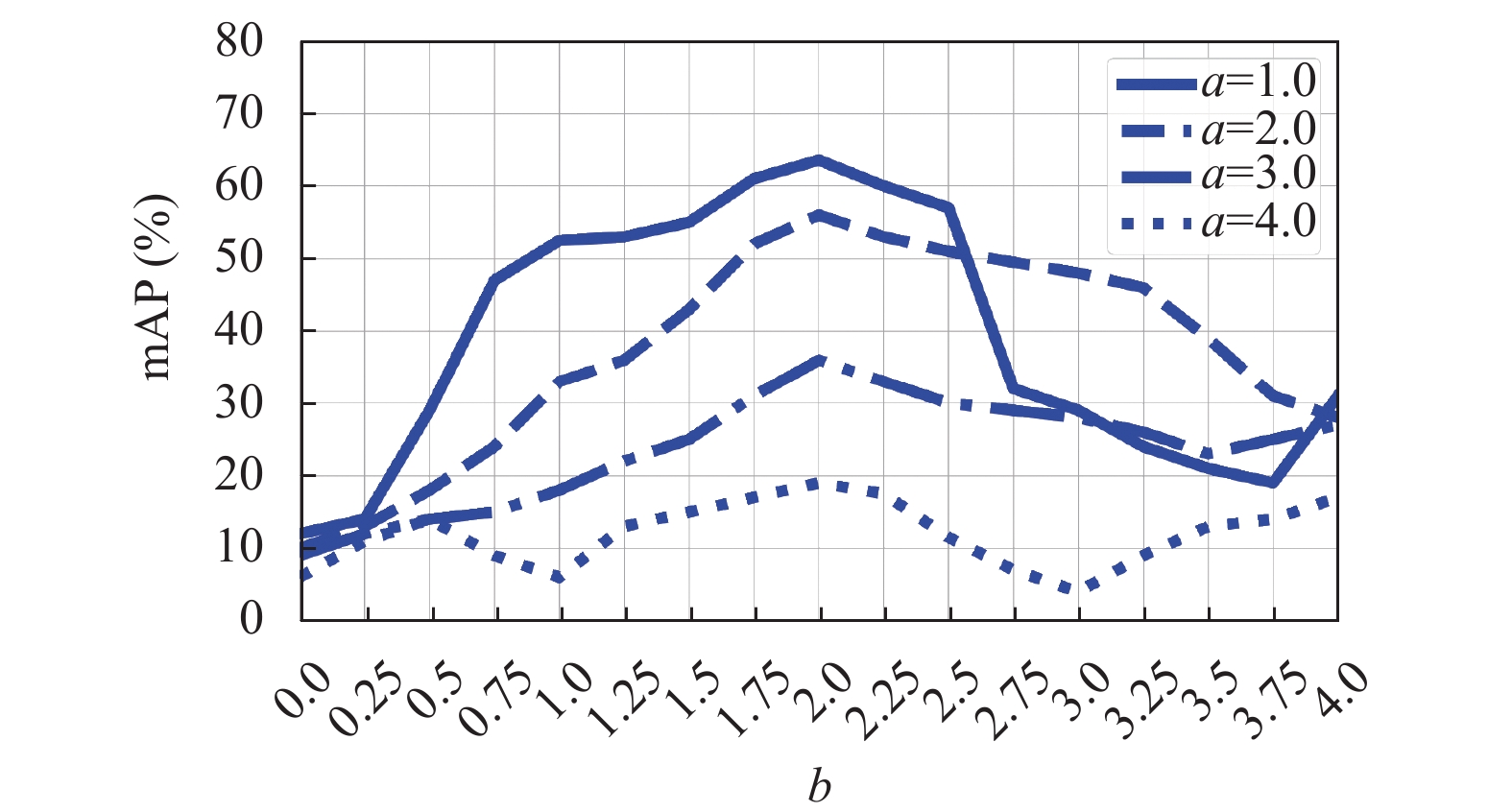

轨迹图边权重对保障作业检测效果影响分析. 图9展示了轨迹图边权重计算式内轨迹夹角权重

|

图 7 保障作业识别算法mAP对比 |

|

图 8 保障作业识别算法运行时间对比 |

|

图 9 不同

|

|

图 10 不同

|

保障作业结构提取算法对保障作业检测效果影响分析. 为了评估本文提出的基于轨迹层次聚类的保障作业结构提取算法对保障作业检测效果的影响, 对比了3种聚类方法及无聚类方法的保障作业检测结果: 1)本文方法(Ours); 2)非层次聚类的方法: 采用k-means算法[15]对场景内轨迹进行聚类, 然后采用本文提出的保障作业识别算法检测保障作业(NoHieCluster); 3)无聚类过程的方法: 直接用本文保障作业识别算法检测保障作业(NoCluster); 4)凝聚层次聚类的方法: 采用凝聚层次聚类算法[16], 然后采用本文提出的保障作业识别算法检测保障作业(AggCluster). 4种方法的保障作业检测结果mAP如图11所示, accuracy如图12所示.

|

图 11 使用不同聚类算法的事件检测的mAP对比结果 |

|

图 12 使用不同聚类算法的事件检测的accuracy对比结果 |

舰面保障作业检测效果分析. 为了评估本文技术对舰面保障作业检测的效果, 计算了各舰面保障作业的Average Precision (AP)如图13所示. AP反映了检测器对事件的检测能力. AP值越大, 检测器对该事件的检测能力越强. 观察图13可知, 调运车转运(TM)事件的检测效果最好, 而调运员指挥调运车调运飞机(WTMP)的检测效果最差. 因为调运车转运属于基本状态, 仅有调运车一个参与者, 相对容易检测. 而调运员指挥调运车调运飞机为组合状态, 涉及调运员、调运车与飞机3个参与者, 且参与者间必须满足一定约束, 是相对复杂的事件, 所以检测效果较差. 本文技术针对各舰面保障作业的accuracy如图14所示.

|

图 13 舰面保障作业检测的AP |

|

图 14 舰面保障作业检测的accuracy |

|

图 15 保障作业检测技术的averaged precsion-recall曲线 |

轨迹层次聚类精确性及保障作业结构提取算法性能分析. 为了分析轨迹层次的聚类精确性, 计算了聚类算法对各保障作业的聚类精确率. 保障作业的聚类精确率

|

图 16 轨迹层次聚类算法针对各保障作业的聚类精确率 |

保障作业检测技术对比. 为了评估本文方法(Ours)检测保障作业的效果, 与其他3种复杂事件检测技术做了对比: 1) Timeception, 利用基于多尺度时间卷积核检测复杂事件[17]; 2) EODL (Event Oriented Dictionary Learning)[8], 首先从图像数据库内学习语义概念, 然后与多任务字典学习框架结合, 得到各事件的字典表示形式; 3) Unsupervised, 在子事件的视频特征描述与子事件的时间结构间迭代, 检测由若干子事件构成的复杂事件[18]. 4种方法的mAP对比结果如图18所示, accuracy对比结果如图19所示.

|

图 17 保障作业结构提取算法针对各保障作业的正确率 |

|

图 18 mAP对比结果 |

|

图 19 Accuracy对比结果 |

4 结论与展望

为了解决大型舰船舰面保障作业检测问题, 本文提出基于视频事件的保障作业检测技术, 实现了同一视频场景内并发的参与者位置交叉的舰面保障作业的检测. 在预处理阶段, 获取舰面监控视频内目标物运动轨迹. 在保障作业检测阶段, 将舰面保障作业视为更小粒度保障作业按一定约束组合成的复杂事件, 先采用基于轨迹层次聚类的保障作业结构提取算法, 确定场景内保障作业的组合层次结构; 再采用基于作业模型的保障作业识别算法, 逐层识别保障作业类型. 实验结果表明, 本文方法具有良好的舰面保障作业检测效果, 并可检测同一视频场景内同时发生的且参与者位置交叉的舰面保障作业.

局限与未来的工作. 当前轨迹修剪方法不够鲁棒, 轨迹多且高度重叠的情况下无法得到清晰连贯的轨迹, 未来打算开发更加高效的轨迹跟踪算法与轨迹修剪方法. 本文方法基于轨迹推断保障作业, 所以无法检测参与者无明显移动的保障作业(比如, 飞机检查、机械师站在飞机尾部区域检测飞机). 为此, 打算进一步完善保障作业检测技术, 增加动作检测或姿态检测, 使可检测参与者无明显移动的保障作业. 目前定义的保障作业模型种类有限, 而保障作业种类繁多, 无法检测未定义作业模型的保障作业, 将来进一步完善、扩充保障作业模型, 使其涵盖更多的保障作业类.

| [1] |

赵远征. 航母关键系统对架次率的影响研究. 舰船科学技术, 2016, 38(9): 145-149. |

| [2] |

Wang ML, Li X, Chen Q, et al. Surveillance event detection based on CNN. Acta Automatica Sinica, 2016, 42(6): 892-903. |

| [3] |

Aggarwal JK, Ryoo MS. Human activity analysis: A review. ACM Computing Surveys, 2011, 43(3): 16. |

| [4] |

Wang XG, Tieu K, Grimson E. Learning semantic scene models by trajectory analysis. Proceedings of 9th European Conference on Computer Vision-ECCV 2006. Graz, Austria. 2006. 110–123.

|

| [5] |

Mehran R, Oyama A, Shah M. Abnormal crowd behavior detection using social force model. Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL, USA. 2009. 935–942.

|

| [6] |

Wu JF, Guo Y. A complex event detection algorithm based on cross-feature learning. Research and Exploration in Laboratory, 2016, 35(5): 141-145, 244. |

| [7] |

Liu H, Zheng QH, Luo MN, et al. How unlabeled web videos help complex event detection? Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence. Australia. 2017. 4040–4046.

|

| [8] |

Yan Y, Yang Y, Meng DY, et al. Event oriented dictionary learning for complex event detection. IEEE Transactions on Image Processing, 2015, 24(6): 1867-1878. DOI:10.1109/TIP.2015.2413294 |

| [9] |

Xu ZW, Yang Y, Hauptmann AG. A discriminative CNN video representation for event detection. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA. 2015. 1798–1807.

|

| [10] |

Chen K, Song X, Liu J. Pedestrian tracking framework based on deep convolution network and SIFT. Scientia Sinica Informationis, 2018, 48(7): 841-855. DOI:10.1360/N112017-00286 |

| [11] |

Shi JB, Malik J. Normalized cuts and image segmentation. Proceedings of 1997 Conference on Computer Vision and Pattern Recognition. San Juan, Puerto Rico. 1997. 731–737.

|

| [12] |

Ferryman J, Borg M, Thirde D, et al. Automated scene understanding for airport aprons. Proceedings of the 18th Australian Joint Conference on Artificial Intelligence. Sydney, Australia. 2005. 593–603.

|

| [13] |

Allen JF. Maintaining knowledge about temporal intervals. Communications of the ACM, 1983, 26(11): 832-843. DOI:10.1145/182.358434 |

| [14] |

Vu VT, Bremond F, Thonnat M. Automatic video interpretation: A novel algorithm for temporal scenario recognition. Proceedings of the 18th international joint conference on Artificial intelligence. Mexico City, Mexico. 2003. 9–15.

|

| [15] |

Lloyd S. Least squares quantization in PCM. IEEE Transactions on Information Theory, 1982, 28(2): 129-137. DOI:10.1109/TIT.1982.1056489 |

| [16] |

Christopher D. Manning, Raghavan P, et al. Introduction to information retrieval. Cambridge: Cambridge University Press. 2008.

|

| [17] |

Hussein N, Gavves E, Smeulders AWM. Timeception for complex action recognition. arXiv: 1812.01289v2, 2019.

|

| [18] |

Fadime S, Angela Y. Unsupervised learning and segmentation of complex activities from video. arXiv: 1803.09490, 2018.

|

2020, Vol. 29

2020, Vol. 29