2. 福建师范大学 医学光电科学与技术教育部重点实验室, 福州 350007;

3. 福建师范大学 福建省光子技术重点实验室, 福州 350007;

4. 福建师范大学 福建省光电传感应用工程技术研究中心, 福州 350007

2. Key Laboratory of Optoelectronic Science and Technology for Medicine (Ministry of Education), Fujian Normal University, Fuzhou 350007, China;

3. Fujian Provincial Key Laboratory of Photonics Technology, Fujian Normal University, Fuzhou 350007, China;

4. Fujian Provincial Engineering Technology Research Center of Photoelectric Sensing Application, Fujian Normal University, Fuzhou 350007, China

近些年, 由于深度学习的火热, 在视频中的运动目标追踪中出现了很多新方法. 就追踪任务而言, 可分为MOT (Multiple Object Tracking)和VOT (Visual Object Tracking) [1–3]. MOT主要是同时追踪多个目标, 对抗干扰能力要求不高, VOT则是在干扰条件下持续追踪单个目标. 基于监督学习算法的主流目标追踪方法的可分为, 生成法和判别法两种. 两种方法都是通过数据集训练模型, 达到预测结果的目的. 不同的是生成法先求出联合概率

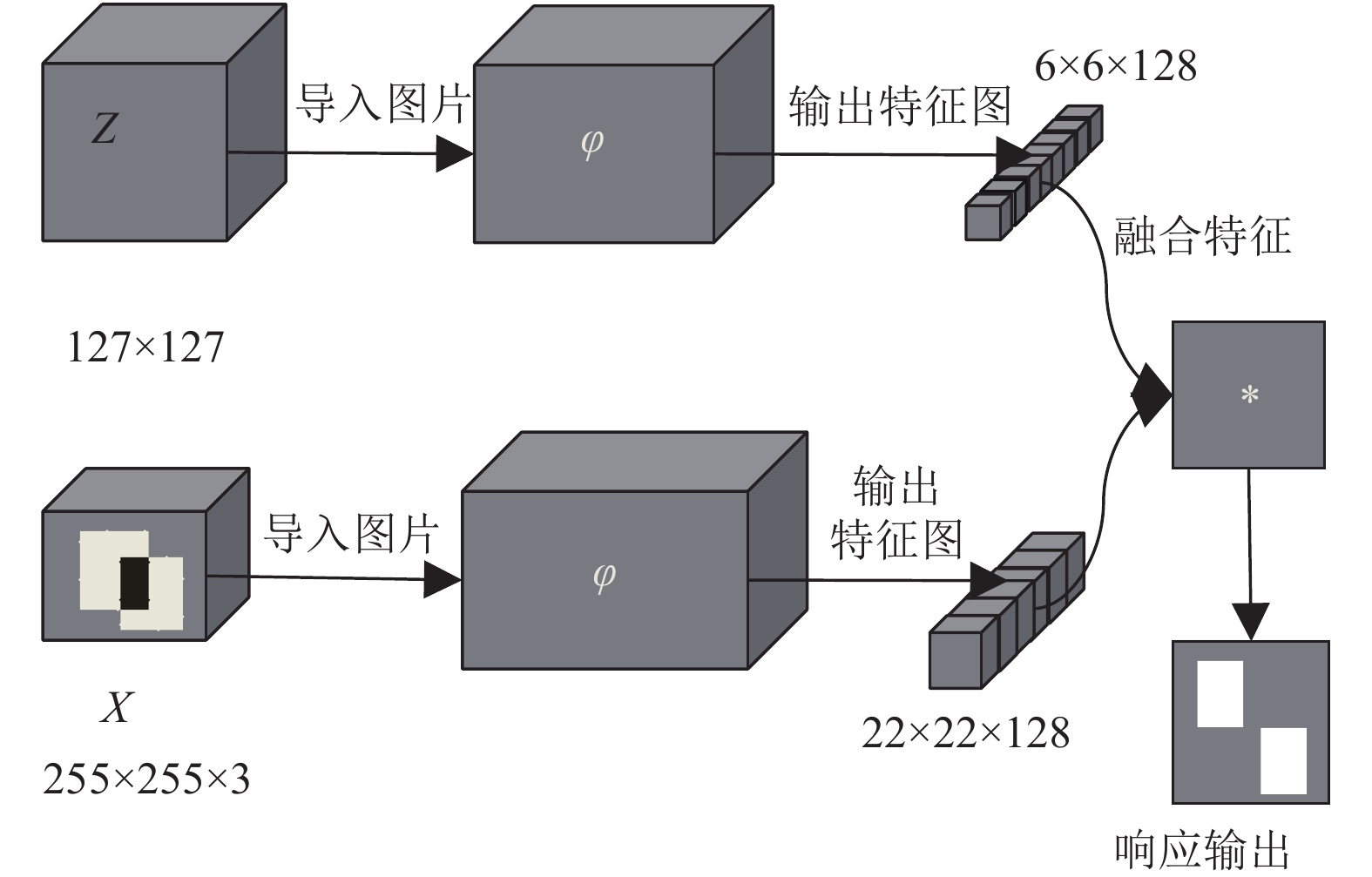

图1中SiamFC由对称的两个神经网络架构组成, Z代表标注的图片, X为候选图片. 在X上计算候选区域和预测区域重叠面积的得分, 从而计算出预测精确度, φ通常是若干卷积层和池化层(经典Alexnet采用5层卷积层), 网络通过φ函数得到128个通道的特征图, 并将两个特征图通过深度卷积进行融合定位视频中目标位置.

|

图 1 SiamFC网络基础架构 |

1 视频中运动目标追踪

由于CNN网络在目标检测领域取得良好的效果, 能有效记忆目标的特征, 所以CNN网络也被引入追踪网络算法中[9]. SiamFC网络在VOT2016 (Visual Object Tracking)竞赛中获得良好的比赛成绩, 相较KCF (Kernelized correlation filter)有较大的提升, SiamFC在ILSVRC2015数据集上进行训练, 训练两条分支的网络参数权重ω和偏置b[5,7,8,10–16]. 在得到稳定的网络模型后, 可进行在线追踪的任务. 进行追踪任务时, SiamFC只需要读入初始标定的目标, 即可持续在未标定视频中连续追踪特定目标, 给出预测的目标位置框, 并计算与GroundTruth集合的重叠面积, 从而得到预测精确度.

图1中两个孪生的φ在实际网络中可用5层卷积神经网络代替, 其中Conv1和Conv2卷积层之后有Pool1和Pool2池化层. 两个池化层目的是减少网络参数的个数, 但同时也会失去目标的一些细节特征. 上述情况在VOT2017数据集上表现尤为明显[17,18]. 因而对于追踪方法来说, 一定的细节保留是必要的. DPP池化层能保留目标物的一些细节特征, 对于追踪方法中的一些细节判别和寻找提供一定的帮助. 因而我们在每层网络都引入DPP池化层同时又在Conv1和Conv3层之后添加到融合层的残差网络. 本文的残差网络解决网络深度增加引起的梯度消失问题, DPP池化层主要解决特征提取时的细节丢失问题[9].

1.1 残差网络DPP-SiamFC网络不仅在SiamFC网络上每层引入DPP池化层, 还引入Conv1和Conv3的池化层之后到融合层的残差网络. 残差网络能很大程度将输入的特征引入输出, 而并不带来很多网络开销. 在网络达到一定深度以后能很好帮助前馈网络, 同时降低错误率. SiamFC的Conv1–Conv5层是类似于AlexNet的神经网络. 定义

| $h(x) = \alpha f(x) + \beta g(f(x))$ | (1) |

式(1)所示的残差网络将一部分输入特征直接引入网络输出, 使得网络的梯度下降的更快,

DPP细节保留池化是应用于目标检测的CNN网络Conv卷积层之后的池化层, 目的是改善原来CNN检测网络的池化层对目标细节特征的丢失. 目标检测比较常用的Avg-Pooling和Max-Pooling分别利用池化区域的平均值和最大值来代替原来的像素点, 而在目标追踪领域常用的是Max-Pooling. 随着网络层数以及数据集难度的增加, Max-Pooling和Avg-Pooling丢失目标特征的弊端将逐渐展现出来. DPP池化的结构如图2, 主要完成线性减少特征图I的数据量. 处理流程是将原始特征图I进行线性缩减尺度, 将得到的结果与原始特征进行比较(方法是引入逆双边权重), 判断出特征丢失程度. 输入特征图I经过激励函数得到的输出O特征公式(2):

| ${D_{\alpha ,\lambda }}(O)[p] = \frac{1}{{\displaystyle\sum\limits_{{q'} \in {\Omega _p}} {{\omega _{\alpha ,\lambda }}[p,{q'}]} }}\sum\limits_{q \in {\Omega _p}} {{\omega _{\alpha ,\lambda }}[p,q]I[q]} $ | (2) |

|

图 2 DPP池化层逻辑结构示意图 |

式(2)计算的是输入相邻点

| ${\omega _{\alpha ,\lambda }}[p,q] = \alpha + {\rho _\lambda }(I[q] - \tilde I[p])$ | (3) |

在网络反馈学习中, 通过优化

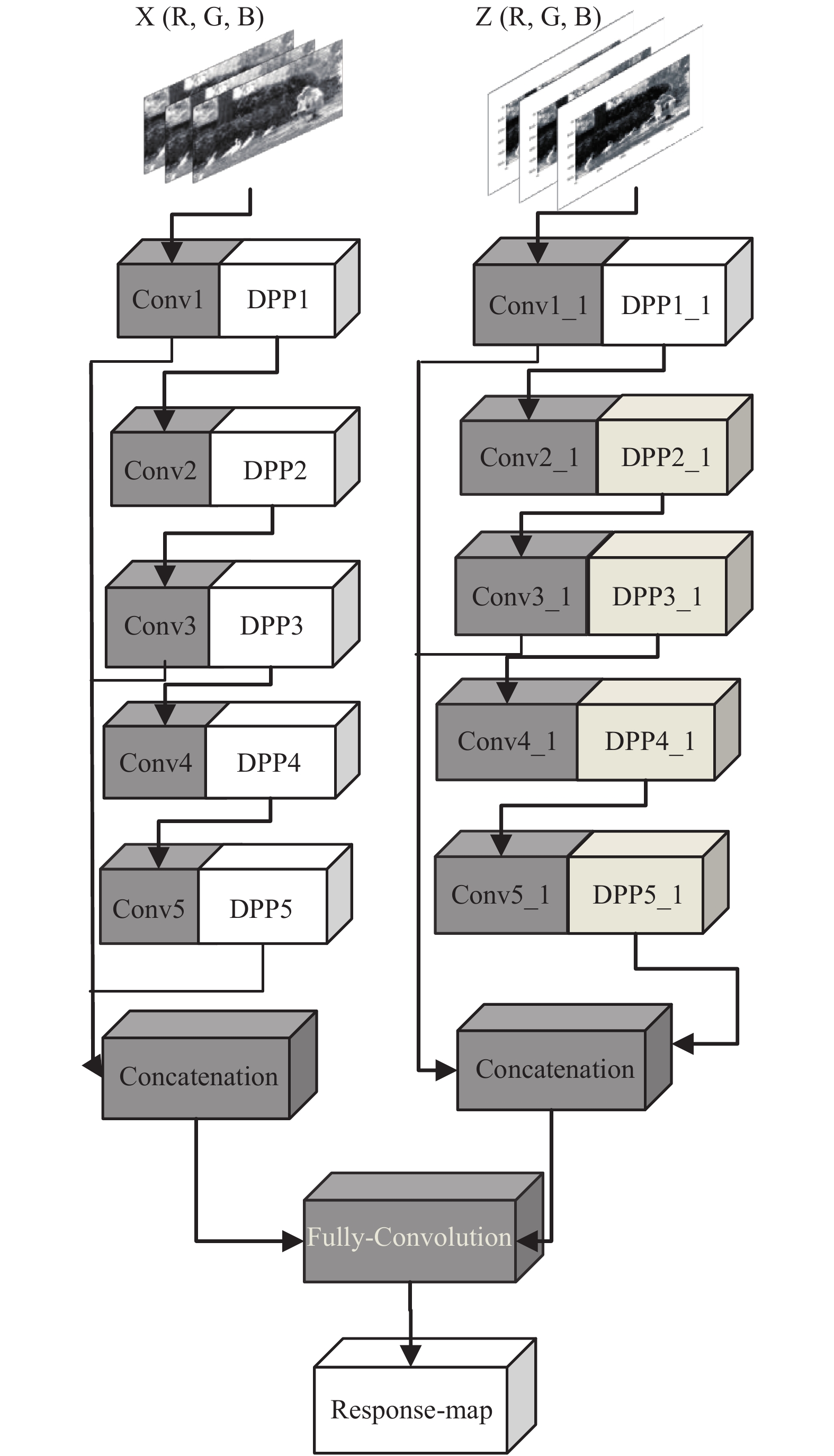

本文为了实现视频中目标相似性干扰、旋转、快速移动、遮挡和变形等问题处理能力. 对SiamFC网络进行改进, 改进之后的网络结构如图3, 融合网络(Concatenation)是3条分支的加权平均值, 再通过深度卷积层对特征进行融合.

|

图 3 DPP-SiamFC网络架构 |

Conv和Conv_1是对称的卷积层, 它们卷积核大小, 通道数和步长并不相同, 相同的是两个卷积层使用的卷积核的个数. 这使得输出特征图的个数一致. DPP池化层的结构如图2所示, 目的是更好的保留目标细节特征.

Fully-Convolution是将两个分支的结果进行卷积处理, 生产下一帧的目标位置, 从而得到最终的特征输出.

2.2 DPP-SiamFC网络各层参数DPP-SiamFC网络各层参数并不相同, 其中DPP 层提供

| 表 1 DPP-SiamFC网络各层参数 |

3 实验分析

我们将DPP-SiamFC网络于ILSVRC2015数据集上进行训练, 实现对每个分类特征的离线训练. 在线追踪于VOT2017追踪数据集, 观察在各个分类追踪的效果[19–21].

3.1 运动目标追踪实验展示DPP-SiamFC在VOT2017各个分类效果, 尤其在含有复杂背景, 有众多干扰物、遮挡、快速移动、和目标变形的数据集.

3.2 DPP-SiamFC与经典网络实验效果对比图4展示了DPP-SiamFC在有很多干扰物且存在部分遮挡条件下追踪单个目标物的效果, 整个视频的标定区域和预测区域重叠面积比平均约为79.1%, 高于80%预测精度的视频帧约占总数的83%.

图5是DPP-SiamFC在目标快速移动任务中效果. 该数据集是摩托车比赛, 途中有树木的遮挡.

|

图 4 groundtruth(蓝色)、DPP-SiamFC(红色)、KCF(相关滤波算法黄色)和SiamFC(绿色)在相似物干扰数据集的效果 |

|

图 5 groundtruth(蓝色)、DPP-SiamFC(红色)、KCF(相关滤波算法黄色)和SiamFC(绿色)在快速移动(包含部分遮挡数据集)的效果 |

图6是目标形变, 和背景复杂的夜间街道数据集中DPP-SiamFC追踪效果. 追踪效果较为良好, 能实现对目标持续追踪的目的.

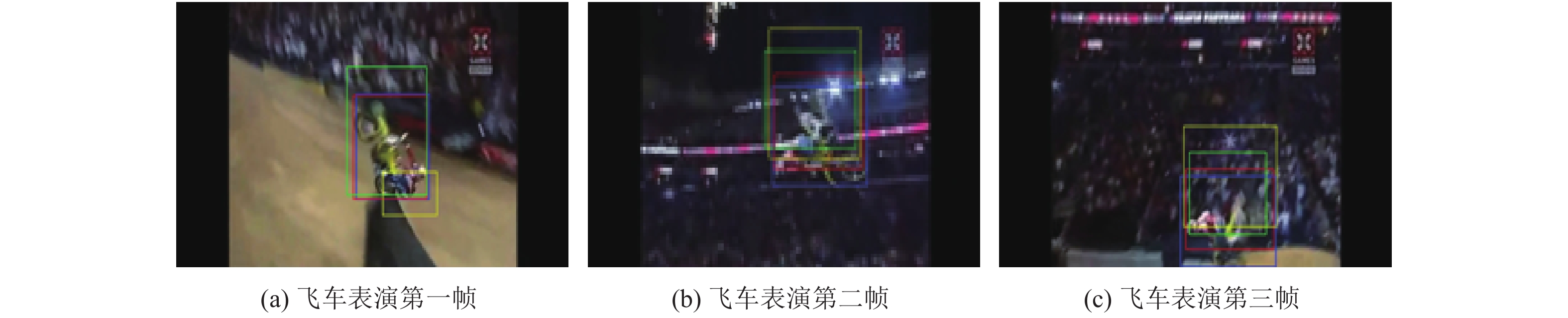

如图7所示SiamFC很难追踪快速上升并旋转的特技摩托. 而DPP-SiamFC能很好的将目标捕捉, 达到旋转物体追踪的效果.

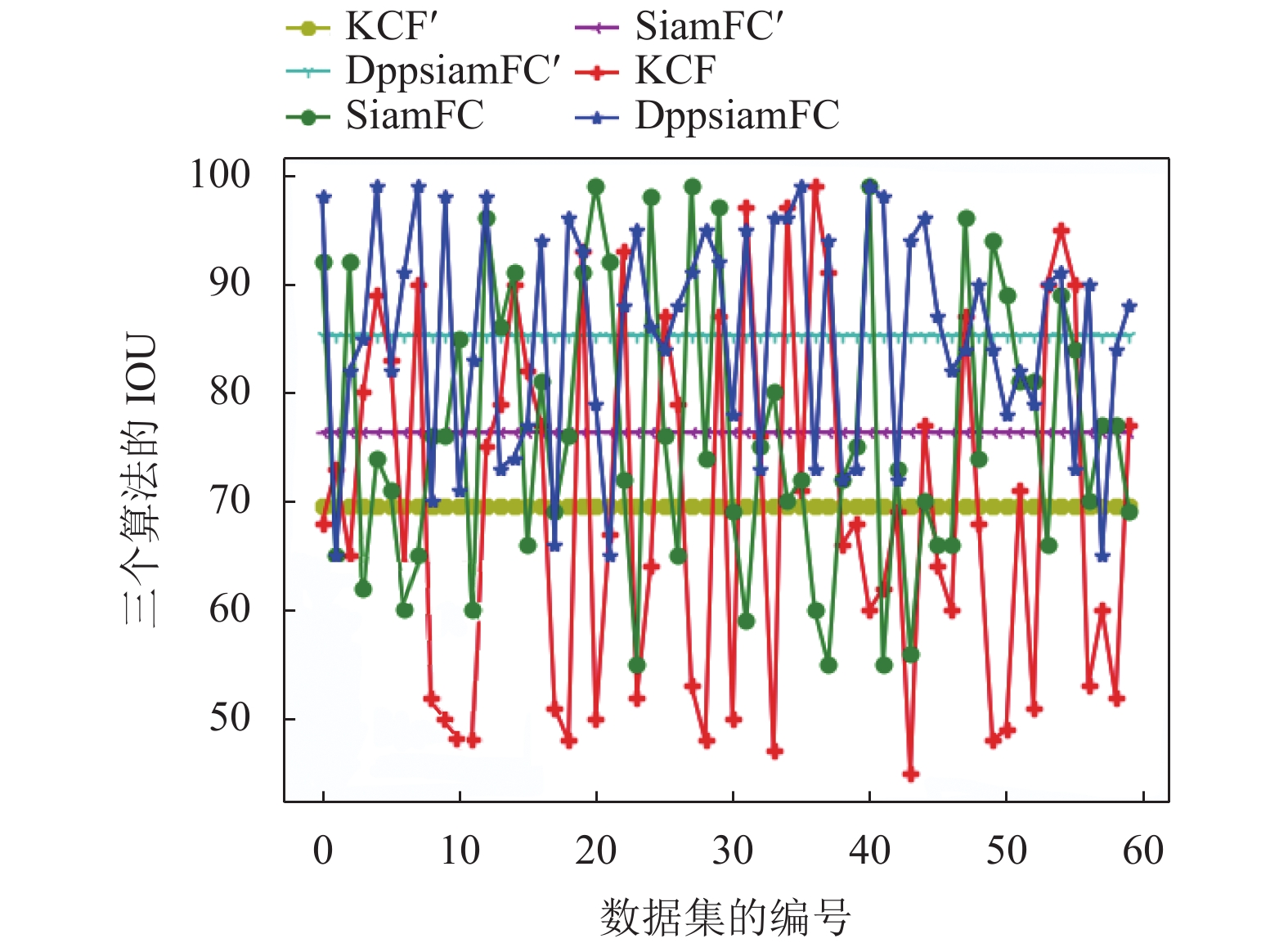

通过图8中SiamFC、DPP-SiamFC和KCF算法预测区域和groundtruth标定的重叠面积比(IOU) 在60个追踪数据集上的平均精确度(例如: 图8中 KCF'表示KCF算法在60个数据集上的精度平均值)78%, 87%, 70%(如表2)可以看出, 改进之后的DPP-SiamFC神经网络在大多数数据集上效果优于SiamFC和KCF网络, 本文在SiamFC网络中引入DPP池化层和残差网络能很好保留数据集上的细节特征, 提升在追踪任务中的准确度, 但在综合的任务数据集中稳定性还需提高.

|

图 6 groundtruth(蓝色)、DPP-SiamFC(红色)、KCF(相关滤波算法黄色)和SiamFC(绿色)在目标变形和背景复杂条件下的追踪图像 |

|

图 7 groundtruth(蓝色)、DPP-SiamFC(红色)、KCF(相关滤波算法黄色)和SiamFC(绿色)在摩托车特技比赛中的对比 |

|

图 8 SiamFC、DPP-SiamFC和KCF的IOU比较 |

4 结论与展望

实验结果证明, 通过在SiamFC孪生网络上引入DPP池化层和残差网络, 有利于网络细节特征的保留, 在VOT2017追踪数据集中DPP-SiamFC有更高精确度, 同时在背景复杂、物体变形、快速移动、遮挡等数据集中目标追踪有一定改善. 但是在多重任务追踪集的效果还有待提高. 今后我们的工作将致力于网络与数据集之间的对抗性研究.

| 表 2 SiamFC、DPP-SiamFC和KCF精度比较 (单位: %) |

| [1] |

Hua Y, Alahari K, Schmid C. Online object tracking with proposal selection. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile. 2015. 3092–3100.

|

| [2] |

Zhu G, Porikli F, Li HD. Beyond local search: Tracking objects everywhere with instance-specific proposals. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 943–951.

|

| [3] |

Yang TY, Chan AB. Recurrent filter learning for visual tracking. Proceedings of 2017 IEEE International Conference on Computer Vision Workshops. Venice, Italy. 2017. 2010–2019.

|

| [4] |

Kosiorek AR, Bewley A, Posner I. Hierarchical attentive recurrent tracking. arXiv preprint arXiv: 1706.09262, 2017.

|

| [5] |

He AF, Luo C, Tian XM, et al. A twofold Siamese network for real-time object tracking. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. 2018. 4834–4843.

|

| [6] |

Hao ZX, Li Y, You SD, et al. Detail preserving depth estimation from a single image using attention guided networks. Proceedings of 2018 International Conference on 3D Vision. Verona, Italy. 2018. 304–313.

|

| [7] |

Zhu G, Porikli F, Li HD. Tracking randomly moving objects on edge box proposals. arXiv: 1507.08085, 2015.

|

| [8] |

Kristan M, Matas J, Leonardis A, et al. The visual object tracking vot2015 challenge results. Proceedings of the IEEE International Conference on Computer Vision Workshops. Santiago, Chile. 2015. 564–586.

|

| [9] |

Weber N, Waechter M, Amend SC, et al. Rapid, detail-preserving image downscaling. ACM Transactions on Graphics, 2016, 35(6): 205. |

| [10] |

Choi J, Chang HJ, Jeong J, et al. Visual tracking using attention-modulated disintegration and integration. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 4321–4330.

|

| [11] |

Bertinetto L, Valmadre J, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking. Proceedings of European Conference on Computer Vision. Amsterdam, The Netherlands. 2016. 850–865.

|

| [12] |

Wang MM, Liu Y, Huang ZY. Large margin object tracking with circulant feature maps. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. 2017. 4800–4808.

|

| [13] |

Huang C, Lucey S, Ramanan D. Learning policies for adaptive tracking with deep feature cascades. Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy. 2017. 105–114.

|

| [14] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. 2018. 7132–7141.

|

| [15] |

Wang LJ, Ouyang WL, Wang XG, et al. Visual tracking with fully convolutional networks. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile. 2015. 3119–3127.

|

| [16] |

Wu Y, Lim J, Yang MH. Object tracking benchmark. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848. DOI:10.1109/TPAMI.2014.2388226 |

| [17] |

Tao R, Gavves E, Smeulders AWM. Siamese instance search for tracking. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 1420–1429.

|

| [18] |

Cen MB, Jung C. Fully convolutional Siamese fusion networks for object tracking. Proceedings of 2018 25th IEEE International Conference on Image Processing. Athens, Greece. 2018. 3718–3722.

|

| [19] |

Liang PP, Blasch E, Ling HB. Encoding color information for visual tracking: Algorithms and benchmark. IEEE Transactions on Image Processing, 2015, 24(12): 5630-5644. DOI:10.1109/TIP.2015.2482905 |

| [20] |

Danelljan M, Häger G, Khan FS, et al. Convolutional features for correlation filter based visual tracking. Proceedings of the IEEE International Conference on Computer Vision Workshops. Santiago, Chile. 2015. 621–629.

|

| [21] |

Abadi M, Agarwal A, Barham P, et al. Tensorflow: Large-scale machine learning on heterogeneous distributed systems. arXiv preprint arXiv: 1603.04467, 2016.

|

2020, Vol. 29

2020, Vol. 29