红外与可见光图像融合在公共安全方面均有广泛的应用, 特别是在国家和社会安全监控等民用领域[1]. 图像融合评估有助于研究人员设计出更为科学、精度更高的图像融合方法. 图像融合质量评价分为主观评价和客观评价[2]. 主观评价是由观察者的主观感觉和统计结果对融合图像的优劣做出主观定性评价. 例如, Petrovixc[3]建立一个包含120组图像的数据集, 其中110组为遥感图像融合, 6组为红外与可见光融合, 4组为可见光与可见光图像融合, 每组图像包含2幅源图像和2幅融合图像, 并提供组内两幅融合图像获得的投票数, 客观评价采用数学公式定量评价图像融合质量. 常用的客观评价指标有很多种, 大致分为四类: 1)基于统计特性的评价指标; 2)基于信息论的评价指标; 3)基于结构相似度的评价指标; 4)基于人眼视觉系统的评价指标.

张小利等人[4]在Petrovixc图像融合数据库的基础上, 研究了评价指标的正确率排名, 结果表明: 大部分评价指标的正确率排名均小于0.8, 故单个评价指标很难完成准确评估融合质量的任务, 需要进行综合评价. 因此面临的主要问题在于: 所选的评价指标必须满足非冗余性原则. 虽然文献[4]研究了融合图像质量评价指标的相关性, 但结合红外与可见光图像融合质量评价, 该研究存在以下不足: 1) Petrovixc图像融合主观数据库中遥感图像的个数占91.7%, 文献[4]侧重分析遥感图像图像融合质量评价指标的相关性; 2) 文献[4]采用的融合方法比较陈旧, 已经无法满足现阶段融合方法质量评价的需求; 3) 文献[4]采用阈值分类对评价指标进行聚类分析, 所选阈值具有随机性, 无法保证分类的有效性.

借鉴文献[4]总结的融合图像质量评价指标, 本文从斯皮尔曼等级相关系数和灰色关联分析理论研究评价指标在红外与可见光图像融合质量评价的相关性.

1 客观评价指标根据图像融合质量评价原理, 将图像融合质量评价方法分为4类: 基于统计特性的评价指标、基于信息论的评价指标、基于结构相似度的评价指标、基于人眼视觉系统的评价指标.

设A, B分别表示两源图像, 采用融合算法将两源图像进行融合, 得到融合图像F, 图像的大小均为M×N, 图像中的灰度级数为L.

1.1 基于统计特性评价指标本文主要介绍常用的统计特性评价指标, 包括: 平均梯度(Average Gradient, AG)、空间频率(Spatial Frequency, SF)、均方误差(Mean Square Error, MSE)、峰值信噪比(peak signal to noise ratio, PSNR)、相关系数(Correlation Coefficient, CC). 其中, AG反映图像微小细节变化与纹理变化的反差特征, SF反映图像灰度的变化率, MSE反映变量之间的差异, PSNR衡量有效信息与噪声之间的比率, CC衡量变量间相关关系密切的程度. 上述评价指标的计算公式详见文献[4].

1.2 基于信息论的评价指标信息熵作为图像融合质量评价指标, 用于衡量融合图像信息丰富程度. 但该指标只是衡量了融合图像自身的信息量, 无法衡量源图像传递给融合图像的信息量, 评价结果具有片面性. 互信息用于衡量融合图像保留源图像信息量的多少, 较为准确地反映图像融合质量. 故本文介绍源图像与融合图像间的互信息及其改进算法.

(1) 互信息

对于图像X, Y, 它们间的互信息计算公式如下:

| ${I_{X,Y}} = \sum\limits_{x,y} {{p_{XY}}\left( {x,y} \right){{\log }_2}\frac{{{p_{XY}}\left( {x,y} \right)}}{{{p_X}\left( x \right){p_Y}\left( y \right)}}} $ |

式中,

在已知源图像A, B和融合图像F的基础上, 基于互信息的融合质量评价指标计算公式如下:

| $M_{A,B}^F = {I_{F,A}} + {I_{F,B}}$ |

融合图像的互信息越大, 融合图像质量越优, 反之, 则融合图像质量越差.

(2) Taillis熵

Cvejic[5]利用Taillis熵改进了互信息, 其计算公式如下所示:

| $M_{F,A,B}^\alpha = I_{F,A}^\alpha + I_{_{F,B}}^\alpha $ |

这里,

| $I_{F,A}^\alpha \left( {f,a} \right) = \frac{1}{{1 - \alpha }}\left( {1 - \sum\limits_{f,a} {\frac{{{{\left( {{p_{F,A}}\left( {f,a} \right)} \right)}^\alpha }}}{{{{\left( {{p_F}\left( {f,a} \right){p_A}\left( a \right)} \right)}^{\alpha - 1}}}}} } \right)$ |

| $I_{F,B}^\alpha \left( {f,b} \right) = \frac{1}{{1 - \alpha }}\left( {1 - \sum\limits_{f,b} {\frac{{{{\left( {{p_{F,B}}\left( {f,b} \right)} \right)}^\alpha }}}{{{{\left( {{p_F}\left( {f,a} \right){p_B}\left( b \right)} \right)}^{\alpha - 1}}}}} } \right)$ |

融合图像的Taillis熵越大, 则融合图像质量越优, 反之, 则融合图像质量越差.

1.3 基于结构相似度的图像融合评估指标结构相似度理论是一种关于图像质量评价的新思想. 它自顶向下地模拟HVS整体功能, 使得测量结构信息的改变与感知图像质量的变化非常接近. 图像X, Y间的结构相似度表达式如下:

| $SSIM\left( {X,Y} \right) \! = \! \frac{{2{\mu _X}{\mu _Y} \! + \! {C_1}}}{{\mu _X^2 + \mu _Y^2 \! + \! {C_1}}}\frac{{2{\sigma _X}{\sigma _Y} \! + \! {C_2}}}{{\sigma _X^2 \! + \! \sigma _Y^2 \! + \! {C_2}}}\frac{{2{\sigma _{XY}} \! + \! {C_3}}}{{{\sigma _X}{\sigma _Y} \! + \! {C_3}}}$ |

这里,

在此基础上, Piealla[6]提出了三个融合图像质量评价指标:

下面对三个指标进行描述:

(1) 评价指标Q

评价指标Q的计算思想: 首先分别计算融合图像F和源图像A, B在局部窗口w内的结构相似度SSIM

| $\begin{split}Q\left( {A,B,F} \right) & = \; \frac{1}{{\left| W \right|}}\sum\limits_{w \in W} {\lambda \left( w \right)SSIM\left( {A,F|w} \right) } \\&+ \left( {1 - \lambda \left( w \right)} \right)SSIM\left( {B,F|w} \right)\end{split}$ | (1) |

其中,

| $\lambda \left( w \right) = \frac{{s\left( {A|w} \right)}}{{s\left( {A|w} \right) + s\left( {B|w} \right)}}$ |

这里,

(2) 评价指标Qw

Piella考虑到窗口重要性不同, 对式(1)进行改进, 得到加权结构相似度

| $\begin{split}{Q_w}\left( {A,B,F} \right)& = \; \sum\limits_{w \in W} {c\left( w \right)} \left[ {\lambda \left( w \right)SSIM\left( {A,F|w} \right) } \right.\\& + \left. {\left( {1 - \lambda \left( w \right)} \right)SSIM\left( {B,F|w} \right)} \right]\end{split}$ |

其中,

| $c\left( w \right) = \frac{{C\left( w \right)}}{{\sum\limits_{w’ \in W} {C\left( {w’} \right)} }},C\left( w \right) = \max \left\{ {s\left( {A|w} \right),s\left( {B|w} \right)} \right\}。$ |

(3) 评价指标QE

考虑到图像质量优劣与边缘的完整度、清晰度有关, Piella在获得评价指标

| ${Q_E} = {Q_w}{\left( {A,B,F} \right)^{1 - \alpha }} + {Q_w}{\left( {A’,B’,F’} \right)^\alpha }$ |

基于人眼视觉系统的评价指标是模仿人眼对像素层绝对差值的认知机制, 通过掩盖低于人眼感知能力的差异修正评测结果. 该类指标主要被划分为2部分: 1)基于显著性几何评价指标; 2)基于边缘保持度的评价指标.

1.4.1 基于显著性几何评价指标Luo等人[7]利用图像区域显著性对结构相似度进行改进, 提出了基于显著性几何评价指标. 该指标的计算过程如下:

首先, 分别计算源图像A, B的显著性, 将所得结果存入到

然后, 分别统计源图像A, B与融合图像F在显著性区域、非显著性区域的相似度. 以源图像A和融合图像F为例, 计算方法如下所示:

| $\begin{array}{l}{S_{SSIM}}\left( {F,A} \right) = \frac{1}{{{m_1}}}\sum\limits_{{S_{A\left( {x,y} \right) \ge t}}} {\left| {SSI{M_{FA}}\left( {x,y} \right)} \right|} \\{L_{SSIM}}\left( {F,A} \right) = \frac{1}{{{m_2}}}\sum\limits_{{S_{A\left( {x,y} \right) < t}}} {\left| {SSI{M_{FA}}\left( {x,y} \right)} \right|} \end{array}$ |

式中,

其次, 将它们进行整合, 得到源图像A和融合图像F的整体相似度为:

| $FIQRO\left( {F,A} \right) = {\left[ {{S_{SSIM}}\left( {F,A} \right)} \right]^\alpha }{\left[ {{L_{SSIM}}\left( {F,A} \right)} \right]^{1 - \alpha }}$ |

同样, 获得源图像B和融合图像F的整体相似度

结合

| $FIFQ = 1 - \sqrt {\frac{{{{\left( {{a_1} - FIQRO\left( {F,A} \right)} \right)}^2} + {{\left( {{a_2} - FIQRO\left( {F,B} \right)} \right)}^2}}}{2}} $ |

其中,

根据视觉系统特性, Xydeas等人[8]提出了一种衡量边缘信息量从源图像到融合图像多少的客观评价指标. 其实质是通过Sobel算子分别计算输入、输出图像的边缘信息, 得到边缘信息传递的量化值, 然后对源图像的边缘保持度加权求和得到最终值. 其计算步骤如下:

Step 1. 计算源图像A, B到融合图像F的边缘信息保留值

以

首先, 应用式(2)计算源图像A和融合图像F在点

| $\left\{ {\begin{array}{l}{g_A}\left( {x,y} \right) = \sqrt {S_x^A{{\left( {x,y} \right)}^2} + S_x^A{{\left( {x,y} \right)}^2}} \\{g_F}\left( {x,y} \right) = \sqrt {S_x^F{{\left( {x,y} \right)}^2} + S_x^F{{\left( {x,y} \right)}^2}} \end{array}}\right.$ | (2) |

其中,

再应用式(3)计算源图像A和图像F在点

| $\left\{ {\begin{aligned}{\alpha _A}\left( {x,y} \right) = \arctan \frac{{S_y^A\left( {x,y} \right)}}{{S_x^A\left( {x,y} \right)}}\\{\alpha _F}\left( {x,y} \right) = \arctan \frac{{S_y^F\left( {x,y} \right)}}{{S_x^F\left( {x,y} \right)}}\end{aligned}}\right.$ | (3) |

然后, 应用式(4)计算源图像A相对于融合图像F的相对边缘强度

| $\left\{ {\begin{aligned} {G_{AF}}\left( {x,y} \right) & = \left\{ \begin{aligned} & \frac{{{g_F}\left( {x,y} \right)}}{{{g_A}\left( {x,y} \right)}}, \;\;\;\;if \;\;{g_A}\left( {x,y} \right) > {g_F}\left( {x,y} \right) \\ & \frac{{{g_A}\left( {x,y} \right)}}{{{g_F}\left( {x,y} \right)}}, \;\;\;\;otherwise \end{aligned} \right.\\ {A_{AF}}\left( {x,y} \right) & = \frac{{\left| {\left| {{\alpha _A}\left( {x,y} \right) - {\alpha _F}\left( {x,y} \right)} \right| - \pi /2} \right|}}{{\pi /2}} \end{aligned}}\right.$ | (4) |

应用式(5)得到源图像A到融合图像F的边缘信息保留值

| $\begin{aligned}{Q_{AF}}\left( {x,y} \right) & = Q_g^{AF}\left( {x,y} \right)Q_\alpha ^{AF}\left( {x,y} \right)\\& = \frac{{{\Gamma _g}}}{{1 + {e^{{k_g}\left( {{G_{AF}}\left( {x,y} \right) - {\sigma _g}} \right)}}}}\frac{{{\Gamma _\alpha }}}{{1 + {e^{{k_\alpha }\left( {{A_{AF}}\left( {x,y} \right) - {\sigma _\alpha }} \right)}}}}\end{aligned}$ | (5) |

其中,

同样, 应用式(2)至式(5)得到源图像B到融合图像F的边缘信息保留值

Step 2. 计算基于边缘保持度的质量评价指标

| ${Q_{AB/F}} = \frac{{\sum\limits_{x = 1}^M {\sum\limits_{y = 1}^N {\left( {{Q_{AF}}\left( {x,y} \right){\omega _A}\left( {x,y} \right) + {Q_{BF}}\left( {x,y} \right){\omega _B}\left( {x,y} \right)} \right)} } }}{{\sum\limits_{x = 1}^M {\sum\limits_{y = 1}^N {\left( {{\omega _A}\left( {x,y} \right) + {\omega _B}\left( {x,y} \right)} \right)} } }}$ | (6) |

这里,

| ${\omega _A}\left( {x,y} \right){\rm{ = }}{\left( {{g_A}\left( {x,y} \right)} \right)^L},\;\;{\omega _B}\left( {x,y} \right){\rm{ = }}{\left( {{g_B}\left( {x,y} \right)} \right)^L}$ |

式中, L是常数.

Xydeas等人[9]在进一步考虑人眼视觉感知性能后, 通过对融合图像与源图像之间各像素点上的边缘强度添加阈值Tg和计算各邻域内像素方向的一致性程度来分辨融合图像中出现的噪声和边缘情况, 在此基础上, 改进了加权系数

| $\left\{ {\begin{aligned}{\omega _A}\left( {x,y} \right) = \left\{ \begin{array}{l}\omega _{\min }^A,\begin{array}{*{20}{c}}{}&{}&{}&{}&{}\end{array}{g_A}\left( {x,y} \right) \le {T_g}\\{g_A}\left( {x,y} \right) \times {c_A}\left( {x,y} \right),{g_A}\left( {x,y} \right) > {T_g}\end{array} \right.\\{\omega _B}\left( {x,y} \right) = \left\{ \begin{array}{l}\omega _{\min }^B,\begin{array}{*{20}{c}}{}&{}&{}&{}&{}\end{array}{g_B}\left( {x,y} \right) \le {T_g}\\{g_B}\left( {x,y} \right) \times {c_B}\left( {x,y} \right),{g_B}\left( {x,y} \right) > {T_g}\end{array} \right.\end{aligned}}\right.$ | (7) |

式中,

| $c\left( {x,y} \right) = \frac{{\sum\limits_{\left( {x{\rm{*}},y{\rm{*}}} \right) \in W{\rm{*}}} {g\left( {x{\rm{*}},y{\rm{*}}} \right)} }}{{\sum\limits_{\left( {x{\rm{*}},y{\rm{*}}} \right) \in W} {g\left( {x{\rm{*}},y{\rm{*}}} \right)} }}$ | (8) |

这里, W是中心处在

将新的权重系数

本文采用斯皮尔曼等级相关系数和灰色关联理论分析图像融合质量评价指标在红外与可见光图像融合中的相关性.

2.1 基于灰色关联度的相关性分析灰色系统理论对样本数据量的要求不高、设计思路相对简单, 能够解决因统计资料不足而造成的信息不完善的问题. 灰色关联分析理论是灰色系统理论的重要组成部分, 它通过各个样本序列的曲线几何形状的相似度来判断序列之间的关系.

向量

| ${r_{xy}} = \frac{1}{{N{\rm{ - }}1}}\sum\limits_{i = 1}^{N{\rm{ - }}1} {\frac{1}{{1{\rm{ + }}\left| {\left( {{x_{i + 1}} - {x_i}} \right) - \left( {{y_{i + 1}} - {y_i}} \right)} \right|}}} $ | (9) |

设两变量X和Y, 它们的长度均为N. X和Y均按降序排列后分别记为Xsort和Ysort. X’和Y’分别记录X和Y中元素在Xsort和Ysort中的位置, 并称其为秩次. 记

| ${\rho_s} = 1 - \frac{{6\sum\limits_{i = 1}^N {d_i^2} }}{{N\left( {{N^2} - 1} \right)}}$ | (10) |

通过计算两两评价指标间的相关度得到对角线为1的相关矩阵

| $1 = {\theta _1} > {\theta _2} > {\theta _3} > \cdots $ | (11) |

取阈值

设

Zhang[10]采用

| ${C_i} = \frac{{{\theta _{i - 1}} - {\theta _i}}}{{{n_i} - {n_{i - 1}}}}$ | (12) |

其中, i为

| ${C_i} = \mathop {\max }\limits_j \left( {{C_j}} \right)$ | (13) |

则认为第i次聚类对应阈值为最优聚类阈值.

从公式(12)可以看出: 阈值θ的变化率Ci越大, 表明类别之间的差异越大, 类与类之间的边界就越明显. 因此, 取最大Ci对应的θi为最优聚类阈值.

3 融合图像质量评价指标相关性分析实验图像来源于美国麻省理工学院林肯实验室、荷兰人力资源研究所、美国海军研究生院在网络上提供的红外与可见光源图像, 共计10组图像, 见图1.

|

图 1 10组红外与可见光源图像 |

本文采用融合方法包括: 基于奇异值分解的PCNN融合方法[11]、基于Tetrolet变换的融合方法[12]、基于非下采样Contourlet变换和稀疏表示的融合方法[13]、基于对比度增强的融合方法[14]、基于多特征的融合方法[15]和基于剪切波变换的图像融合方法[16]. 上述融合方法既具有代表性, 且融合效果比较好. 由于篇幅限制, 图2给出了第七组源图像及其融合图像.

采用的评价指标有: 峰值信噪比

|

图 2 源图像与融合图像 |

3.1 评价指标规范化处理

图像融合质量评价指标的物理意义和计量单位不相同, 在对融合图像质量评价指标进行相关性分析时, 需要对评价指标进行规范化处理. 根据评价指标与融合图像质量的关系, 除了均方误差属于“越小越优型”外, 其它评价指标均属于“越大越优型”. 本文采用公式(14)对评价指标值进行规范化处理.

| ${x_{ij}} = \left\{ \begin{array}{l}\frac{{{x_{ij}} - \mathop {\min }\limits_i \left\{ {{x_{ij}}} \right\}}}{{\mathop {\max }\limits_i \left\{ {{x_{ij}}} \right\} - \mathop {\min }\limits_i \left\{ {{x_{ij}}} \right\}}},{u_j} \in {T_1}\\\frac{{\mathop {\max }\limits_i \left\{ {{x_{ij}}} \right\} - {x_{ij}}}}{{\mathop {\max }\limits_i \left\{ {{x_{ij}}} \right\} - \mathop {\min }\limits_i \left\{ {{x_{ij}}} \right\}}},{u_j} \in {T_2}\end{array} \right.$ | (14) |

这里,

| 表 1 客观评价指标的相关系数 |

3.2 基于灰色关联度的相关性分析

本文利用数据集内10组融合图像, 分别计算两两客观评价指标间的灰色关联度, 并求其均值. 计算结果见表1所示.

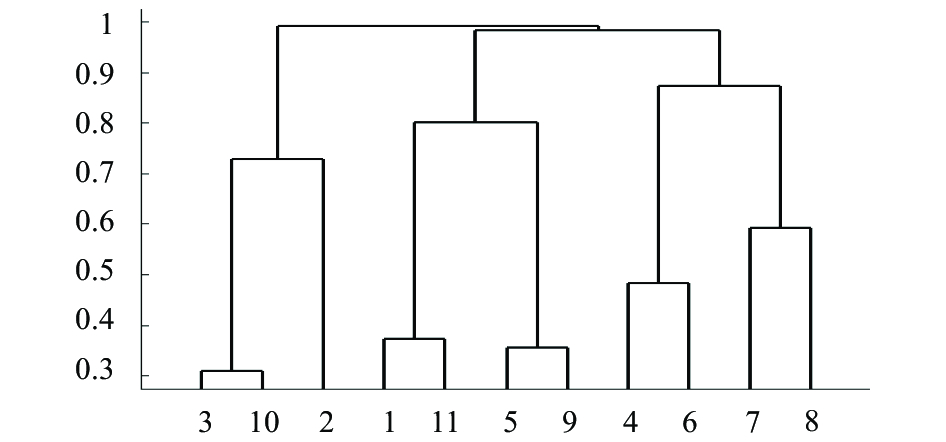

图3给出了基于灰色关联度的动态聚类图. 由公式(12)和公式(13)确定聚类阈值

| $\left\{ {\left( {3,10} \right), \left( {1,11} \right), \left( {2,8,4,6} \right), \left( {5,9,7} \right)} \right\}$ |

图4给出了基于斯皮尔曼相关系统的动态聚类图.

|

图 3 动态聚类图 |

|

图 4 动态聚类图 |

确定聚类阈值

| $\left\{ {\left( {3,10,2} \right),\left( {1,11,5,9} \right),\left( {4,6,7,8} \right)} \right\}$ |

显然, 上述两种聚类结果不一致, 这是因为基于灰色关联度的聚类方法反映两变量间的相关系数; 基于斯皮尔曼等级相关系数的聚类分析法反映两变量之间联系的强弱程度. 结合上述两种分类结果, 将上述11个评价指标分为6类, 即:

| $\left\{ {\left( {3,10} \right),\left( {1,11} \right),\left( {5,9} \right),\left( {4,6,8} \right){\rm{,2,7}}} \right\}$ |

因此, 在建立红外与可见光图像融合质量评价指标体系时, 可以选择相关性较低的评价指标, 保证了评价指标的合理性和非冗余性, 既提高了综合评价的速度, 同时也保证了综合评价的合理性.

4 结论与展望红外与可见光图像融合质量评价能够进一步丰富和完善图像融合理论框架. 单个评价指标往往不能准确地评价图像融合质量, 需要进行综合评价. 评价指标体系是进行综合评价的关键, 它的建立应该满足非冗余性原则. 本文选取有代表性的评价指标共计11个, 采用斯皮尔曼相关等级系数和灰色关联度研究评价指标的相关程度, 在此基础上分析阈值变化率选取最优聚类阈值, 将评价指标进行分类. 为后续研究红外与可见光图像融合质量综合评价提供理论支持.

| [1] |

张宝辉. 红外与可见光的图像融合系统及应用研究[博士学位论文]. 南京: 南京理工大学, 2013.

|

| [2] |

夏明革, 何友, 黄晓东. 多传感器图像融合效果评价方法研究. 电光与控制, 2003, 10(2): 31-35. |

| [3] |

Petrović V. Subjective tests for image fusion evaluation and objective metric validation. Information Fusion, 2007, 8(2): 208-216. DOI:10.1016/j.inffus.2005.05.001 |

| [4] |

张小利, 李雄飞, 李军. 融合图像质量评价指标的相关性分析及性能评估. 自动化学报, 2014, 40(2): 306-315. |

| [5] |

Cvejic N, Canagarajah CN, Bull DR. Image fusion metric based on mutual information and Tsallis entropy. Electronics Letters, 2006, 42(11): 626-627. DOI:10.1049/el:20060693 |

| [6] |

Piella G, Heijmans H. A new quality metric for image fusion. Proceedings of the 2003 IEEE International Conference on Image Processing. Barcelona, Spain. 2003. 173–176.

|

| [7] |

Luo XY, Zhang J, Dai QH. Saliency-based geometry measurement for image fusion performance. IEEE Transactions on Instrumentation and Measurement, 2012, 61(4): 1130-1132. DOI:10.1109/TIM.2011.2174898 |

| [8] |

Xydeas CS, Petrovic V. Objective image fusion perfor-mance measure. Electronics Letters, 2000, 36(4): 308-309. DOI:10.1049/el:20000267 |

| [9] |

Xydeas CS, Petrovic VS. Objective pixel-level image fusion performance measure. Proceedings of SPIE 4051, Sensor Fusion: Architectures, Algorithms, and Applications IV. Orlando, FL, USA. 2000. 89–98.

|

| [10] |

Zhang ZG. An approach to multiple attribute group decision making for supplier selection. Proceedings of 2011 IEEE International Conferenc on Advanced Management Science. Chengdu, China. 2010. 536–539.

|

| [11] |

陈广秋, 高印寒, 段锦, 等. 基于奇异值分解的PCNN红外与可见光图像融合. 液晶与显示, 2015, 30(1): 126-136. |

| [12] |

沈瑜, 党建武, 冯鑫, 等. 基于Tetrolet变换的红外与可见光融合. 光谱学与光谱分析, 2013, 33(6): 1506-1511. |

| [13] |

王珺, 彭进业, 何贵青, 等. 基于非下采样Contourlet变换和稀疏表示的红外与可见光图像融合方法. 兵工学报, 2013, 34(7): 815-820. |

| [14] |

周渝人, 耿爱辉, 王莹, 等. 基于对比度增强的红外与可见光图像融合. 中国激光, 2014, 41(9): 0909001. |

| [15] |

杨桄, 童涛, 陆松岩, 等. 基于多特征的红外与可见光图像融合. 光学精密工程, 2014, 22(2): 489-496. |

| [16] |

郑红, 郑晨, 闫秀生, 等. 基于剪切波变换的可见光与红外图像融合算法. 仪器仪表学报, 2012, 33(7): 1613-1619. |

2018, Vol. 27

2018, Vol. 27