2. 福建师范大学 医学光电科学与技术教育部重点实验室, 福州 350007;

3. 福建师范大学 福建省光子技术重点实验室, 福州 350007;

4. 福建师范大学 福建省光电传感应用工程技术研究中心, 福州 350007;

5. 福建师范大学 智能光电系统工程研究中心, 福州 350007

2. Key Laboratory of Optoelectronic Science and Technology for Medicine of Ministry of Education, Fujian Normal University, Fuzhou 350007, China;

3. Fujian Provincial Key Laboratory of Photonics Technology, Fujian Normal University, Fuzhou 350007, China;

4. Fujian Provincial Engineering Technology Research Center of Photoelectric Sensing Application, Fujian Normal University, Fuzhou 350007, China;

5. Intelligent Optoelectronic Systems Engineering Research Center, Fujian Normal University, Fuzhou 350007, China

在计算机视觉领域, 目标跟踪是一个有趣且有意义的课题. 其在社会中广泛应用于金融, 交通, 人机交互等领域. 从目标跟踪问题提出到现在已经有一段时间了, 大量科研工作者对这一方向进行了不懈的努力研究, 提出了许多优秀的算法. 视频目标跟踪面临的挑战主要有光照变化、尺度变化、目标遮挡等.

近年来, 相关滤波运用到目标跟踪领域取得了相当不错的效果. 2010年Bolme等人在文献[1]中首次将相关滤波方法引入到目标跟踪领域, 提出了最小误差输出平方和(Minimum Output Summer of Squared Error, MOSSE). 作者借助于快速离散傅里叶变换, 运用相关滤波将时域上的卷积转换为频域上的点积, 大大的减少了运算量. 同时论文所提方法跟踪效果也有669帧每秒的出色表现. 由于其在跟踪上面展现出的优秀结果, 此后基于此算法改进算法相继提出, 最具有代表性的是循环结构跟踪(Circulant Structure Kernel, CSK)[2]方法. 该方法首次在跟踪中提出了密集抽样, 使得训练出来的滤波器更加的鲁棒和精确. 2014年Henriques等人在文献[3]提出核相关滤波跟踪算法(Kernelized Correlation Filter, KCF), 该方法在CSK的基础上用方向梯度直方图(Histogram of Oriented Gradient, HOG)特征代替了原算法中仅仅使用的像素灰度值特征, 从而提高了跟踪的准确性. Danelljan在论文[4]中在CSK的基础上引入了颜色特征(CN), 增强了视频跟踪的鲁棒性, 在速度方面也取得了不错的效果. 对于相关滤波在目标尺度变化不敏感的问题上, Danelljan在DSST[5]中增加了一个专门用于尺度评估的相关滤波器, 该方法对目标跟踪中尺度变化有较好的处理效果.

本文在核相关滤波(KCF)的基础上提出一种基于遮挡检测的自适应尺度变换相关滤波(OSCF)算法. 本算法在特征提取算法上使用方向梯度直方图(HOG)和原有图像的灰度信息. 针对遮挡问题提出一种基于相关滤波的检测机制. 首先我们将当前帧的目标分为四个小块, 并由此对每一块训练新的分类器. 然后分别计算每一块响应图的PSR值. 然后根据PSR值判断目标的遮挡情况并取得PSR值最大值那一块的峰值响应位置. 最后根据所处中心位置, 提出一种尺度计算策略, 实现尺度自适应更新.

1 核相关滤波(KCF)本文是以核相关滤波(KCF)为基础架构的. KCF跟踪器以目标为中心, 选取目标及其周围一定范围内矩形图像块x来训练线性分类器, 假设选取补丁图像的尺度大小为M×N. 令M×N等价于

训练分类器的目标是寻找一个函数

| $w = \arg \mathop {\min }\limits_w \sum\limits_{m,n} {{{\left| {\langle w,\varphi (x) - y(m,n)} \right|}^2}} + \lambda {\left\| w \right\|^2}$ | (1) |

式中,

采用核函数将线性输入问题映射到非线性特征空间

| $w = \sum\nolimits_{m,n} {\alpha (m,n)\varphi ({x_{m,n}})}, $ | (2) |

其中, 系数

| $F(\alpha ) = \frac{Y}{{{K_x} + \lambda }},$ | (3) |

在式(3)中F表示傅里叶变换(Discrete Fourier Transform, DFT); Y=F(y);

KCF跟踪采用的核函数是高斯核函数, 即

跟踪过程就是在下一帧中用

| $\hat y = {F^{ - 1}}(\hat A \odot {K_{z\hat x}})$ | (4) |

其中,

在找到当前帧t的位置后, 整个模型可以一帧一帧的进行更新:

| $\left\{ \begin{array}{l}{{\hat x}_t} = (1 - \eta ){{\hat x}_{t - 1}} + \eta {z_t}\\{{\hat A}_t} = (1 - \eta ){{\hat A}_{t - 1}} + \eta {A_t}\end{array} \right.$ | (5) |

KCF跟踪目标的原理是把当前帧与滤波模板相互作用后得到的响应最大的地方作为目标位置. 其在响应图的响应峰值强度一般使(Peak-to-Sidelobe Ratio, PSR)[6] 来衡量. PSR的定义为式(6)

| $PSR = \frac{{{g_{\max }} - \mu }}{\sigma }$ | (6) |

式中,

在跟踪中, 我们令第t–1帧的目标中心位置为

在第t帧中, 我们在

本文使用PSR的值作为衡量跟踪目标块和候选图像块的相似程度的一个标准, 同时定义了一个更新权重

| ${\delta _i} = \left\{ \begin{array}{l}1,PSR \ge \tau \\0,{\text{其他}}\end{array} \right.$ | (7) |

|

图 1 遮挡检测与尺度变换流程图 |

3 尺度计算

在得到4个分块响应图的最大响应位置后, 计算每个分块的PSR值. 尺度变化率

| ${\gamma _t} = \sqrt {\frac{{\left| {{w_i}(t)} \right|}}{{\left| {{w_j}(t - 1)} \right|}}\frac{{\left| {{h_i}(t)} \right|}}{{\left| {{h_j}(t - 1)} \right|}}}, \; \; i,j \in [1,4]$ | (8) |

其中,

第t帧的目标

| $\left\{ \begin{array}{l}{w_t} = {\gamma _t}{w_{t - 1}}\\{h_t} = {\gamma _t}{h_{t - 1}}\end{array} \right.$ | (9) |

最终, 在第t帧在以

| $\left\{ \begin{array}{l} {\hat x _t} = (1 - {\delta _i}\eta ){\hat x _{t - 1}} + {\delta _i}\eta {z_t} \\ {\hat A _t} = (1 - {\delta _i}\eta ){\hat A _{t - 1}} + {\delta _i}\eta {A_t} \\ \end{array} \right.$ | (10) |

本节对算法实现步骤进行展示, 主要分为参数初始化、目标定位、遮挡检测、尺度计算、模板更新五部分. 算法流程如图2所示.

|

图 2 OSCF算法流程 |

5 实验结果分析 5.1 评判标准

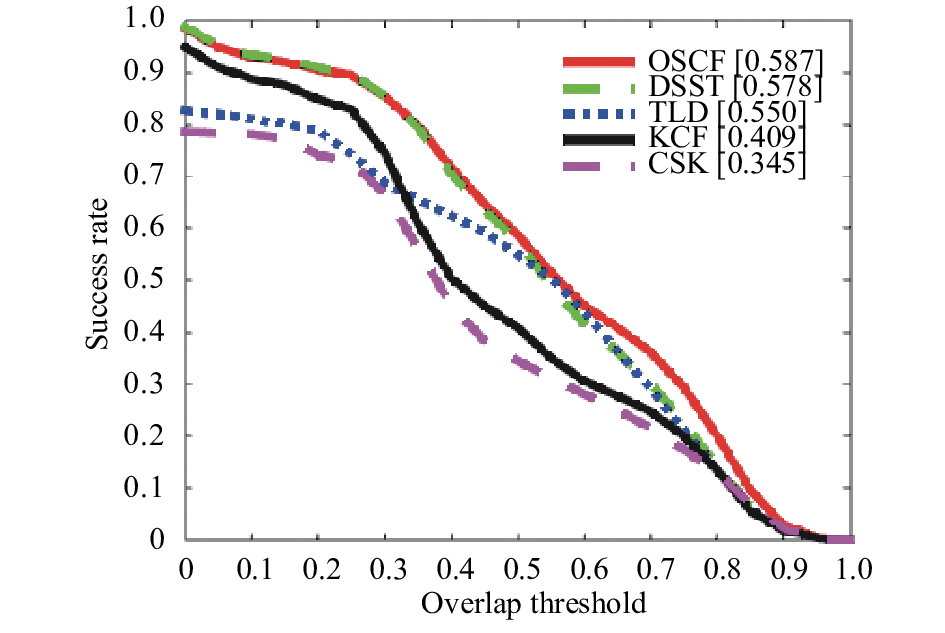

为了评估本文算法在跟踪目标方面的性能, 本文选取了8段公开的视频, 视频包含了光照变化, 目标遮挡, 尺度变化, 目标旋转等问题. 使用文献[7]中评估标准, 即距离精度(Distance Precision, DP)、成功率(Success Rate, SR)和中心位置误差(Centre Location Error, CLE). 精确度是指跟踪目标的中心坐标与人工标定的准确值间的欧式距离小于某个阈值的帧数占全部视频帧数的百分比, 阈值越低时精确度越高, 则跟踪效果就越好. 成功率是指包围跟踪目标的边框区域与人工标定的准确值间的重叠率大于某个阈值的帧数占全部视频帧数的百分比. 当阈值越高时成功率越高, 则跟踪效果越好.

5.2 参数设定在PC机上(Windows 10系统, Inter Core i7-6700, 3.40 GHz, 4 G内存)上基于Matlab 2013b完成实验. 对于每一帧图像, 在选取图像块z时扩展系数

为了评估算法的有效性以及对比算法性能, 本文选取了近年来出现的几种高效的跟踪方法DSST, KCF, TLD, CSK. 表1列出了本文所提算法OSCF与其他几种算法的性能对比, 性能指标为中心位置误差, 距离精度, 成功率精度和跟踪的平均速度四个方面. 由表1可以看出, OSCF算法的成功率和距离精度相比其它四中算法都有所提高. 在成功率方面OSCF算法分别提升了1.9%, 30%, 6.7%, 70.1%; 在距离精度方面分别提升了0.4%, 10.8%, 21.5%,71.1%. 所达到的跟踪平均速度为76.8帧/每秒,可以达到实时性的要求.

| 表 1 OSCF算法和其他算法性能对比 |

图3和图4分别表示本文算法的距离精度曲线和成功率精度曲线, 图中红色实线表示本文所提算法, 从两图中可以看出本文算法OSCF在目标跟踪方面相较其他算法都要优秀.

|

图 3 距离精度曲线 |

|

图 4 成功率曲线 |

图5列举了OSCF, DSST和KCF三种算法在其中八段视频中目标跟踪效果图, 每段视频抽取具有代表性的两帧. 其中视频的共性在于他们都具有尺度变化问题, 另外在视频2和视频8中还含有目标遮挡问题, 视频4中视频还有光照变化问题, 视频5中含有目标旋转问题, 视频6中含有目标快速移动等问题. 图中红色实线表示的是本文所提算法OSCF, 蓝色虚线和绿色虚线分别表示的是DSST算法和KCF算法. 从视频图片帧可以看出, 本文算法OSCF在处理光照变化, 目标旋转, 目标快速运动等问题有效处理的同时, 对目标遮挡和目标尺度变化等问题也达到了较好的跟踪效果, 特别是尺度变换方面算法做到了较好的处理.

|

图 5 不同方法跟踪效果图 |

6 结语

本文在KCF的基础上引入分块的思想, 提出一种遮挡检测机制, 对分块PSR值的研究分析, 得出目标的遮挡程度, 在此基础上提出一种自适应的尺度处理方法, 在一定程度上解决了相关滤波对于尺度不敏感的问题. 实验仿真结果表明OSCF算法跟踪性能要优于其他算法, 能够实现实时跟踪, 在处理尺度变换的同时, 对于日常跟踪中遇到的遮挡、光照、形变等问题也具有一定的鲁棒性. 同时发现本算法存在的一定的缺陷: (1)当遇到目标快速运动, 大幅度的形变时会出现漂移甚至丢失的问题; (2)当目标漂移或丢失时跟踪无法重新侦测直至视频结束. 下一步研究的方向是, 在研究处理目标尺度的同时也要考虑跟踪的鲁棒性, 做到长时跟踪.

| [1] |

Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters. The Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA. 2010. 2544–2550

|

| [2] |

Henriques JF, Caseiro R, Martins P, et al. Exploiting the circulant structure of tracking-by-detection with kernels. In: Fitzgibbon A, Lazebnik S, Perona P, et al, eds. Computer Vision–ECCV 2012. Berlin, Heidelberg: Springer, 2012.

|

| [3] |

Henriques JF, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(3): 583-596. |

| [4] |

Danelljan M, Khan FS, Felsberg M, et al. Adaptive color attributes for real-time visual tracking. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA. 2014. 1090–1097.

|

| [5] |

Danelljan M, Häger G, Khan F, et al. Accurate scale estimation for robust visual tracking. Proceedings of British Machine Vision Conference. Nottingham, UK. 2014. 1–11.

|

| [6] |

Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7): 1409-1422. |

| [7] |

Wu Y, Lim J, Yang MH. Object tracking benchmark. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848. DOI:10.1109/TPAMI.2014.2388226 |

| [8] |

朱明敏, 胡茂海. 基于相关滤波器的长时视觉目标跟踪方法. 计算机应用, 2017, 37(5): 1466-1470. |

| [9] |

沈秋, 严小乐, 刘霖枫, 等. 基于自适应特征选择的多尺度相关滤波跟踪. 光学学报, 2017, 37(5): 174-183. |

| [10] |

Bolme DS, Lui YM, Draper BA, et al. Simple real-time human detection using a single correlation filter. 2009 Twelfth IEEE International Workshop on Performance Evaluation of Tracking and Surveillance. Snowbird, UT, USA. 2009. 1–8.

|

| [11] |

徐玉龙, 王家宝, 李阳, 等. 基于相关滤波的尺度自适应目标跟踪. 计算机应用研究, 2016, 33(11): 3513-3516, 3520. |

| [12] |

Van De Weijer J, Schmid C, Verbeek J, et al. Learning color names for real-world applications. IEEE Transactions on Image Processing, 2009, 18(7): 1512-1523. DOI:10.1109/TIP.2009.2019809 |

2018, Vol. 27

2018, Vol. 27