世界卫生组织调查显示, 全球约2.85亿人有视力障碍, 其中3900万人失明[1]. 中国盲人协会2019年公布的数据显示, 中国有1700多万[2]视障人士, 是世界上盲人数量最多的国家. 尽管视障人群数量庞大, 但在日常生活中却很少见到他们独立出行, 这主要是因为视障独立出行主要面临两大障碍[3]: 行走定向障碍和动作定向障碍. 行走定向障碍指视障在陌生环境中行走能力受到限制, 需要借助听觉、触觉、嗅觉等其他感官构建自己的空间感知, 例如通过盲杖的触觉反馈感知路面障碍, 或在路口通过车辆和人声等语音反馈了解交通路况. 而动作定向障碍则是指视障在完成特定目标动作后面临的其他困难, 如抵达公交站后不知如何选择乘坐车次, 或在过马路时难以准确把握交通信号状态等. 这些问题都严重影响了视障的独立出行能力, 需要得到更多的关注和研究.

针对视障出行难题, 我国已相继制定了一系列政策法规和发展规划以保障视障出行安全. 早在1990年, 我国就提出了《中华人民共和国残疾人保障法》, 明确要求保障残疾人享有平等的出行权利. 随后, 在2001年通过的《城市道路无障碍物设计规范》中, 详细规定了城市道路、交通工具等设施的无障碍物设计要求. 目前视障独立出行主要依靠导盲杖和导盲犬两种辅助方式. 导盲杖成本低、适用范围广, 但探测范围有限且功能单一, 无法提供丰富的语义信息. 相比之下, 导盲犬更能有效处理地面障碍物还能对潜在的危险提前预警, 但由于训练周期长、成本高等因素, 在我国普及率相对较低.

辅助视障独立出行主要体现在障碍物检测和路径规划两方面. 随着嵌入式设备和人工智能等技术的不断进步, 电子出行辅助工具(electronic travel aids, ETAS)[4]已经成为一种有效的解决方案. 目前, 一些功能比较完善的典型例子包括: 智能导盲杖[5]、可穿戴辅助导盲设备[6]、基于终端的导盲系统[7]及导盲机器人[8]等. 这些设备通过利用内置的传感器、计算机视觉技术、路径规划算法等能够精确地检测障碍物并规划安全路径, 通过震动或语音向用户传递相关引导信息, 进而提高视障独立出行能力.

本文对辅助视障独立出行的智能导盲设备中障碍物检测识别关键技术和路径规划相关算法进行总结, 结合人工智能、嵌入式等技术的进步对未来视障辅助出行工具提出展望, 以期对未来辅助导盲研究提供一定的思路.

1 障碍物检测技术视觉是人类获取周围未知环境的重要感官之一, 视障人士由于视力受损无法全面获取周围环境信息, 因此对他们的生活造成各种不便. ETA设备的障碍物检测系统可以辅助视障人士检测并识别障碍物, 其检测方法主要分为主动探测和被动探测两种.

1.1 基于主动探测的障碍物检测方法主动的障碍物探测方法指传感器主动发送能量或信号, 根据其与障碍物的反射、散射或回波来检测是否存在障碍物. 超声波传感器和红外传感器是典型的障碍物主动探测方式, 利用两者进行障碍物探测时, 传感器会主动发送超声波信号[9]或红外信号[10]并通过接收信号的回波或强度来检测障碍物的位置.

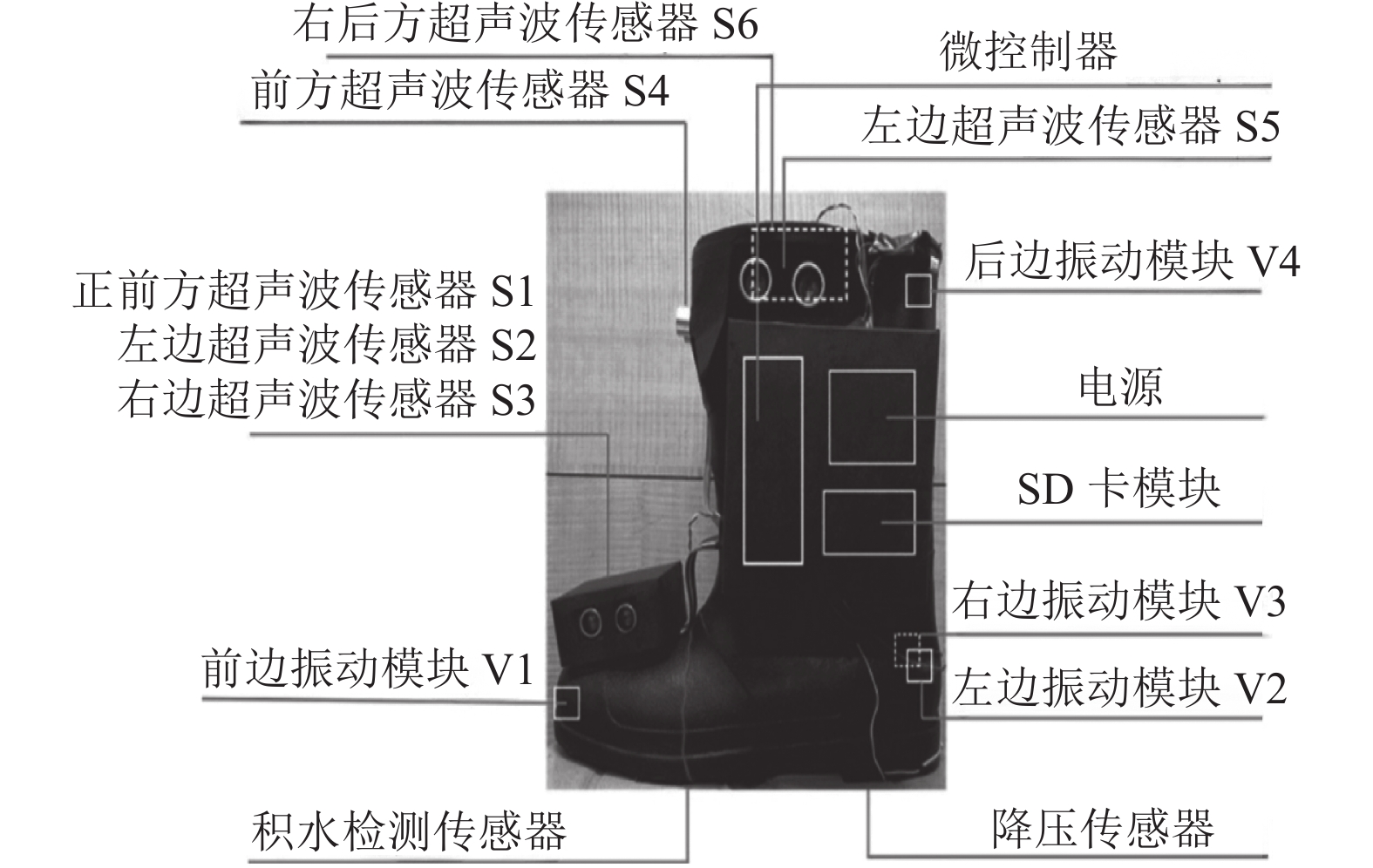

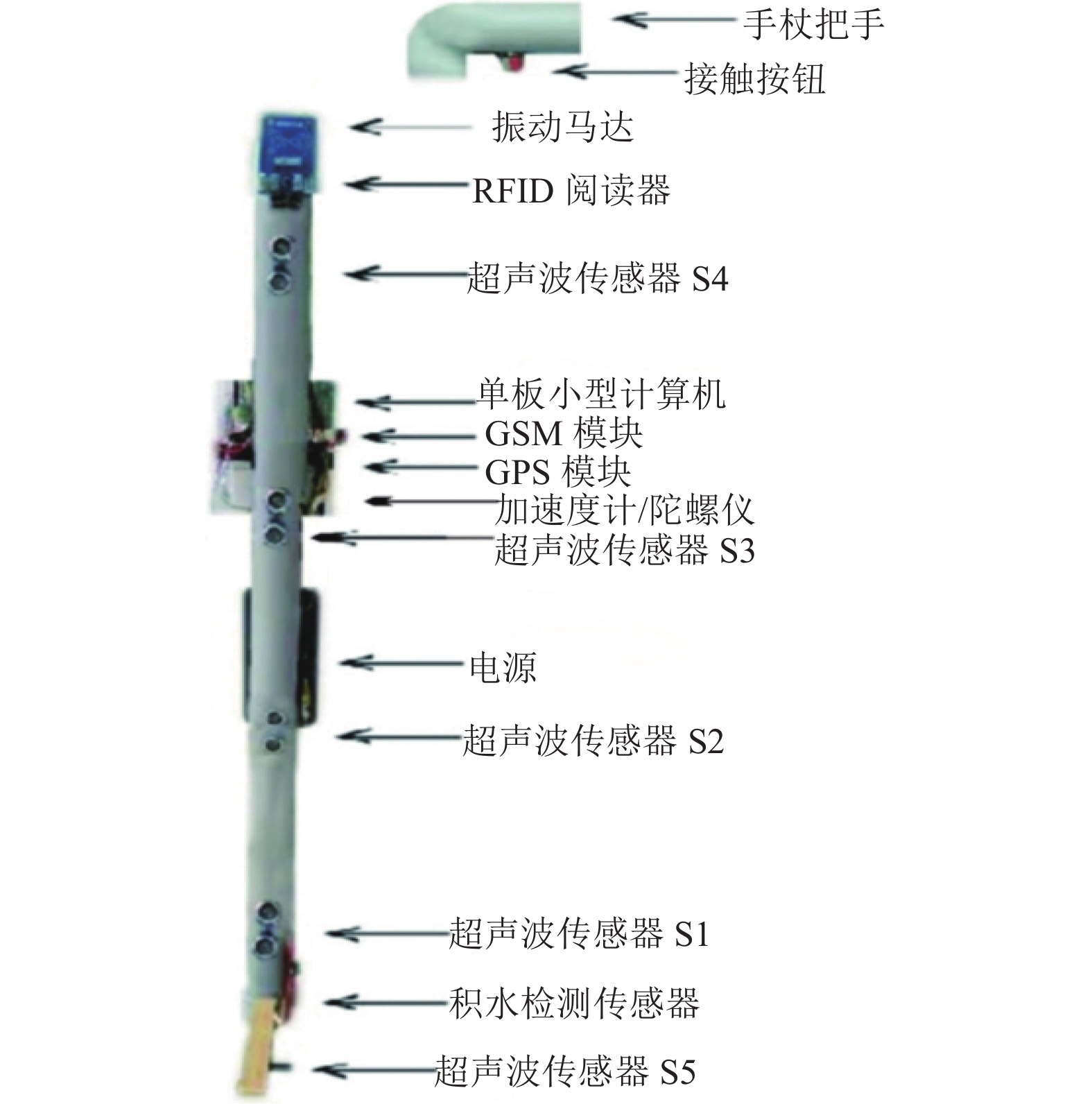

行进方向障碍物检测是最常见的应用场景, Patil等人[11]设计了Navguide的鞋子(如图1所示), 通过在鞋子前方及左右两侧安装多个传感器从各个方向检测障碍物信息并利用触觉向用户传递引导信息, 该设备可以检测动态和静态物体但无法探测深坑、楼梯等低处障碍物. 为处理低矮障碍物, Meshram等人[12]研发了电子辅助设备NavCane (如图2所示), 利用超声波传感器可在室外环境下实现地面水平障碍物的更优检测, 通过触觉和听觉将障碍物信息传达给用户, 相比于其他导盲设备, 其可以提供关于路径中障碍物的优先级信息而不会导致信息过载.

|

图 1 Navguide组成图[11] |

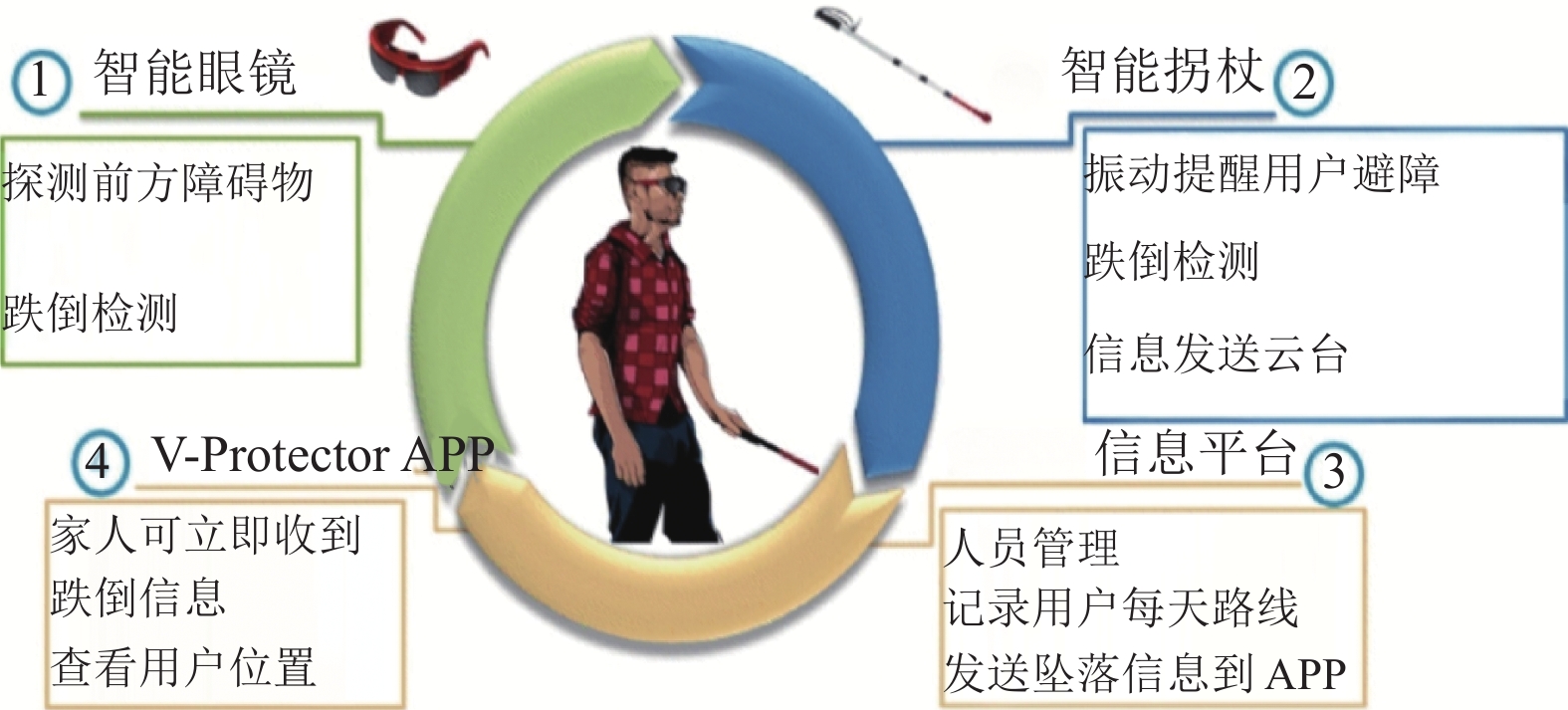

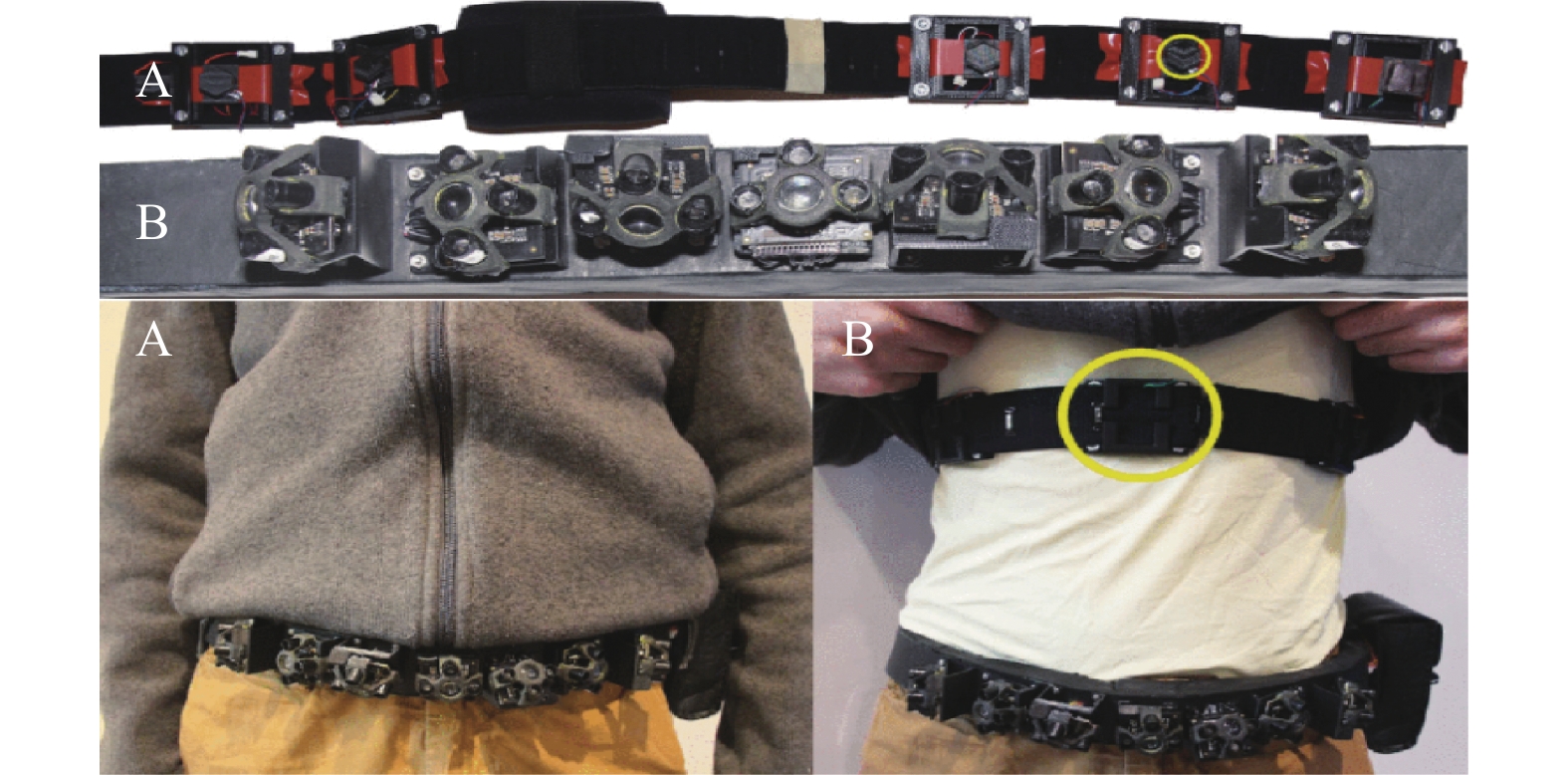

头部高度障碍物对视障出行造成严重威胁, 对此Chang等人[13]提出基于智能眼镜和智能手杖的辅助系统(如图3所示), 利用智能眼镜中的红外传感器对空中障碍物进行探测, 但其检测方向过于单一. 为全面检测身前障碍物, Katzschman等人[14]利用红外传感器研发了可穿戴辅助设备ALVU (如图4所示). 围绕在用户腰前的红外传感器提供用户与障碍物之间的距离, 通过触觉振动强度传送距离信息, 但其穿戴舒适性因人而异.

|

图 2 NavCane组成图[12] |

|

图 3 智能辅助系统组成[13] |

|

图 4 可穿戴辅助设备ALVU组成和穿戴位置[14] |

为弥补单一传感器带来的缺陷, 韦中超等人[15]设计了一个融合超声波和红外传感器的智能语音导盲器, 整个装置放于使用者头部, 超声波传感器置于用户前方, 红外传感器置于两侧, 其探测角度随头部变化而变化, 通过语音向用户报数实现了方向与距离的精确指示. 为减少传感器受外界干扰向用户传递误导信息, Ahmad等人[16]提出一种基于智能手杖的多传感器障碍物检测系统, 利用基于模型的状态反馈控制策略动态调节超声波和红外传感器的探测角度, 从而最大限度减少对用户的误报同时集成了动态反馈补偿器以提高报警准确度.

超声波和红外传感器是障碍物主动探测常用的硬件装置, 红外传感器适用于近距离障碍物检测但在户外和强光环境下表现不稳定而在室内环境中表现出色. 相比之下, 超声波传感器更具通用性, 是多数辅助导盲设备的首选, 常用于检测行走路径上的障碍物. 在实际应用中可将二者结合以提高障碍物检测的灵敏度和准确性.

1.2 基于被动探测的障碍物检测方法被动的障碍物检测方法主要依赖环境中已存在的自然能量或信号来探测障碍物信息, 其中最典型的例子就是基于视觉的方法. 相较于测距传感器只能检测障碍物的存在, 该方法通过摄像机采集图像或视频流作为主要的信息来源, 还能进一步结合深度学习技术对障碍物进行识别分类. 常用的采集方法主要有单目摄像机、双目摄像机和彩色-深度(RGB-depth, RGB-D)摄像机3种方式.

1.2.1 基于单目视觉的障碍物检测方法单目视觉使用单个摄像机采集环境信息, 其结构简单但缺少环境空间立体信息[17]. Ou等人[18]利用单目摄像机提出一个目标识别系统, 利用摄像机进行环境采集同时目标识别模块以每秒的速度判断行人信息, 通过语音引导用户, 但其局限于只能识别一类物体. 为实现多障碍物识别, 任慧娟等人[19]利用视障头部的单目视觉系统获取外界信息, 在三帧差法的基础上对相邻帧差图像进行加法运算, 实现了对正前方和两测横穿障碍物的检测和定位, 并结合单目视觉标定测距模型测量用户与障碍物之间的距离, 实验证明对8 m内障碍物的测量误差在5%以下.

1.2.2 基于双目视觉的障碍物检测方法双目视觉采用两个相同规格的摄像机对同一个物体拍摄, 利用信息差计算障碍物距离[20]. 王涛等人[21]提出基于双目立体视觉的视障辅助系统, 采用张正友标定法进行校正, 经双目图像立体匹配后获得亚像素级视差图像, 通过处理调节为适宜皮肤刺激的电信号, 但其只验证了系统的可行性, 并未考虑实际应用场景. 对此Jiang等人[22]提出基于大数据和双目视觉的视障可穿戴辅助系统, 利用视差原理按照固定频率实时采集图像形成立体视觉图像源, 通过引入的图像质量评价方法对捕获的图像按需选择, 上传至云计算平台后利用卷积神经网络进行图像处理, 最终帮助视障做出合理决策.

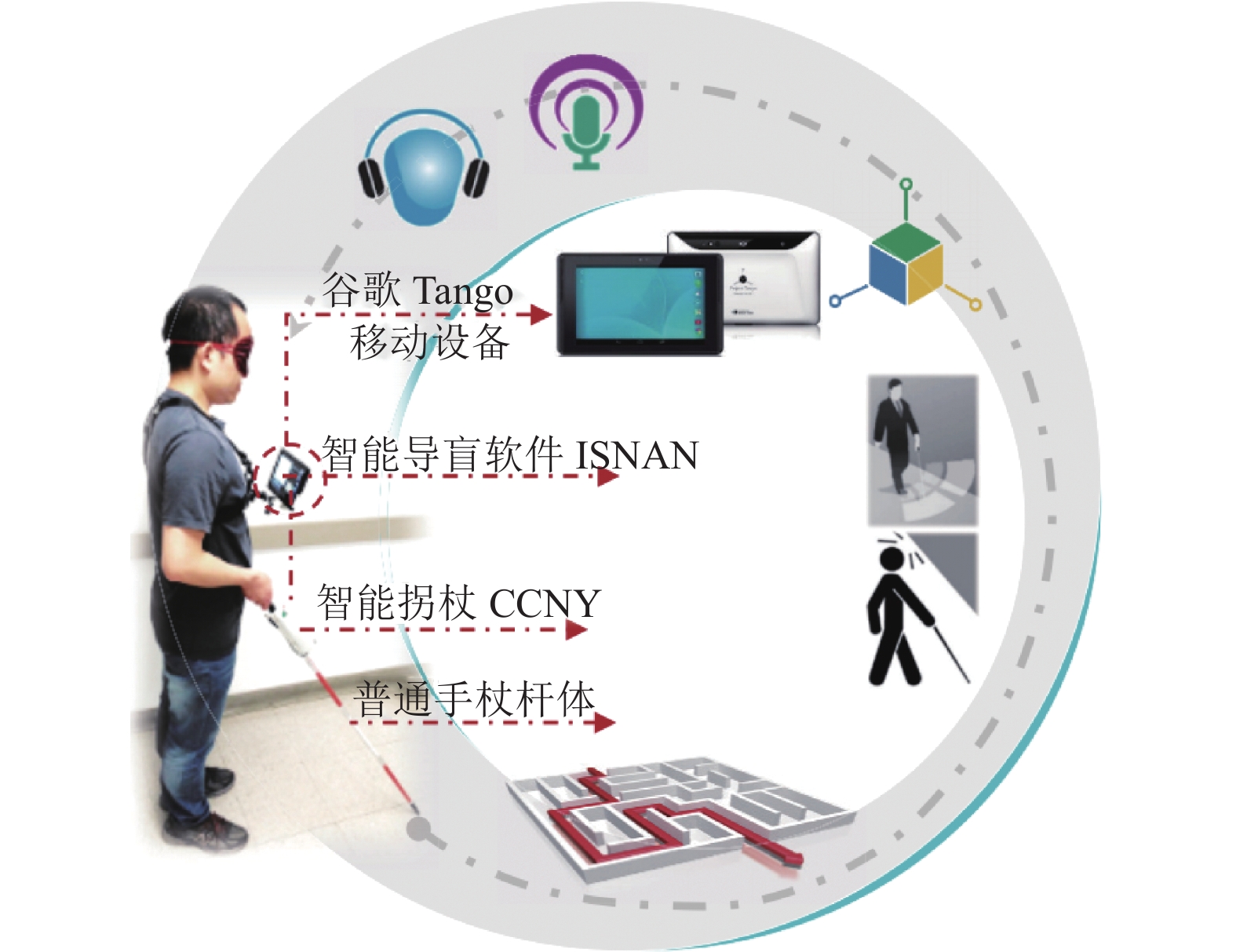

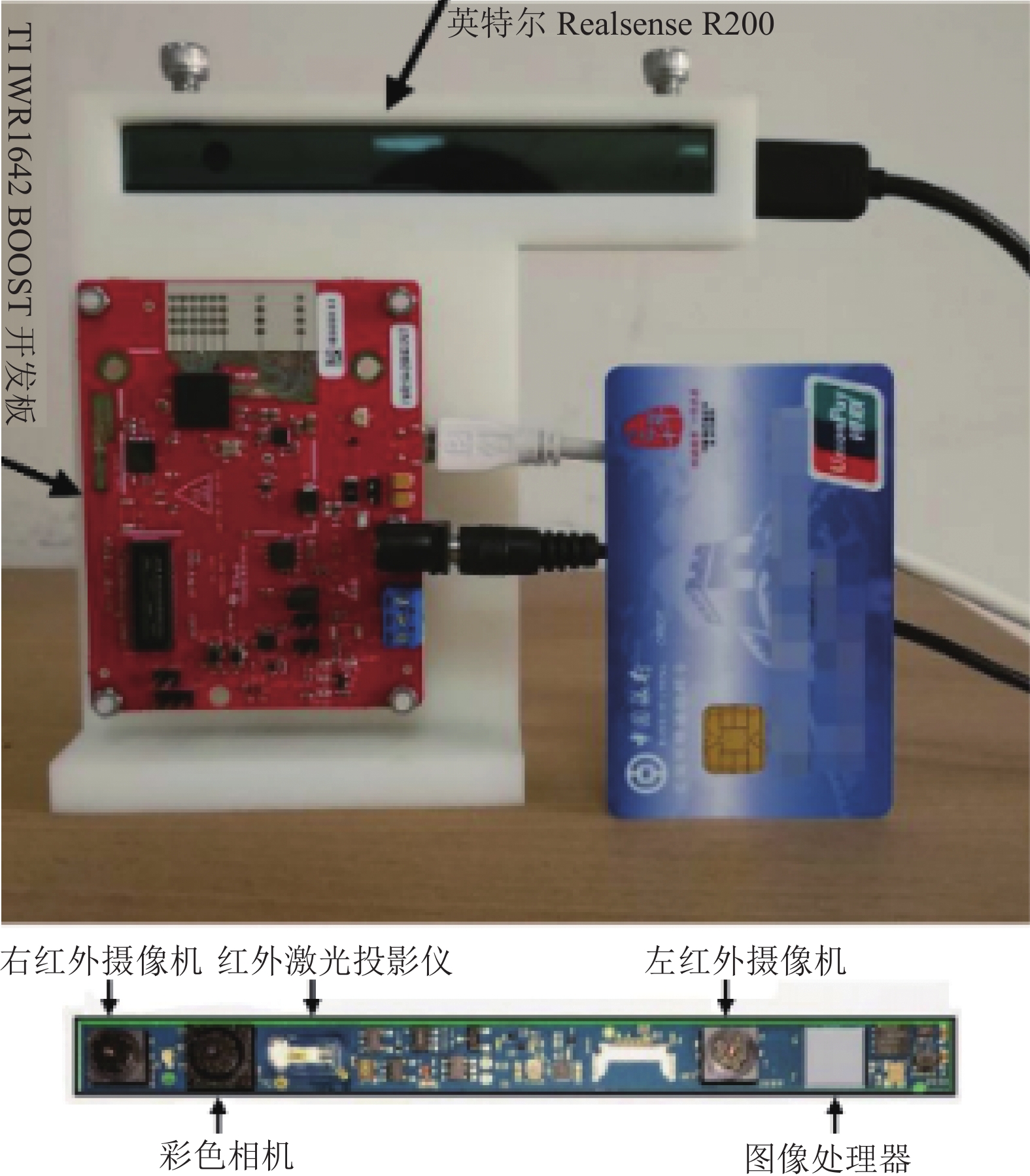

1.2.3 基于RGB-D的障碍物检测方法RGB-D摄像机不仅能捕获彩色数据流还能获取反映对象距离的深度数据流[23], 具有环境适应性强、同步好及结构简单等优点[24], 成为障碍物检测领域的研究热点. Li等人[25]提出一种新型整体视觉移动辅助系统基本组成如图5所示, 其创新点在于利用RGB-D摄像机采集的图像提出了基于时间戳滤波算法的障碍物检测方法和基于二维投影的避障方法, 利用智能手杖实现了语音触觉融合的多模态人机交互. 为提高视障辅助设备检测准确性, Long等人[26]提出融合RGB-D摄像机和毫米波雷达的障碍物检测系统相关硬件(如图6所示), 采用RGB-D摄像机进行环境采集, 毫米波雷达利用调频连续波获取多个目标数据, 通过对RGB-D摄像机的输出进行轮廓特征提取, 运用MeanShift算法验证障碍物的位置, 最后借助粒子滤波技术对毫米波雷达和RGB-D摄像机数据融合得到精确的状态估计.

基于视觉的障碍物检测方法中, 单目摄像机成本低、应用场景广泛但其深度感知能力有限. 相比之下, 双目摄像机能够获得一定的深度信息, 但设备复杂度高检测速度相对较慢. 而RGB-D摄像机融合了颜色和深度信息提供了更精确的检测, 可与深度学习结合进行物体识别及分类. 三者相比, RGB-D相机具有更高的准确度和鲁棒性, 但对硬件和软件要求也更复杂. 表1对比了相关文献中采取不同检测方法的优缺点及人机交互方式.

|

图 5 辅助导航设备系统组成[25] |

|

图 6 实验平台与Realsense R200模块组成图[26] |

| 表 1 不同文献采取的障碍物检测方法及人机交互方式 |

1.3 深度学习在障碍物检测识别中的应用

人工智能正引领视障实现更为独立和安全的出行, 其中深度学习技术在图像处理方面表现出色, 成为辅助视障独立出行的重要方法. 为给视障提供一个安全的生活环境, Wong等人[27]研究了基于卷积神经网络的目标检测导盲系统, 利用单目摄像机采集环境, 采用SSD目标检测算法实现了障碍物的定位和识别. Yu等人[28]也提出一种障碍物定位识别方法, 首先利用增强现实技术标记信息以识别特定的无障碍设施, 其次利用RGB-D摄像机捕获场景并生成彩色深度图像, 再经神经网络处理进而识别和定位障碍物. 相比Wong等人[27]提出的方法, 该方法的创新之处在于利用深度图像进行分割可精准从背景中分离特定对象, 使用叠加RGB图像进行区域提取可获取物体表面细节, 同时利用缩放的深度图像进行障碍物定位避免了传统定位方法的复杂过程.

视障用户在室外出行时面临的环境更加复杂, 为帮助用户更好区分盲道和人行道, 陈朝阳等人[29]直接利用YOLOv3目标检测算法对盲道进行检测识别, 通过针对性调优最终识别准确率达87.46%. 因人为、环境等因素致使盲道存在不同障碍物对视障出行安全构成威胁, 对此孙嘉鑫等人[30]利用计算机视觉技术结合单目摄像机, 联合采用Canny边缘检测算法和Hough变换提取盲道轮廓, 引用YOLOv3模型进行物体检测识别, 实验表明对盲道障碍物检测的平均准确率为96%, 检测速度达15 f/s. 牛恒等人[31]也提出一种结合图像处理和YOLO算法的障碍物检测系统, 首先通过摄像机获取场景信息利用图像处理技术实现了盲道、红绿灯、斑马线等重要交通标识物的识别, 其次采用YOLOv3算法对障碍物相关信息进行检测并结合单目测距原理实现了障碍物的距离探测.

基于视觉的障碍物检测方法结合人工智能图像处理和深度学习技术可实现对环镜的智能感知. 相比于超声波和红外传感器融合使用, 该方法能够获取更丰富的语义信息, 对特定障碍物如交通标志物、行人车辆等有较高的识别精度和准确率, 但其对光照和天气影响较大且对一些透明或反光物体难以检测, 另外也需要较高的硬件平台和软件算法.

2 融合障碍物检测的路径规划算法障碍物检测系统提供了良好的场景感知能力, 路径规划通过利用有效的算法帮助用户规划从起始位置到目标位置的最优路径并在规划过程中躲避障碍物[32], 最终使用户在较短时间内安全到达终点. 路径规划算法主要可分为传统算法和智能算法.

2.1 传统算法在路径规划中的应用传统算法作为路径规划算法中的重要组成部分, 在辅助视障出行中发挥重要作用. 根据对先验环境信息的掌握程度, 可将其分为基于先验完全信息的全局路径规划和基于传感器信息的局部路径规划两类[33].

2.1.1 全局路径规划算法全局路径规划指在已知环境地图情况下, 为视障用户规划从起始点到终点的最优路径. 视障辅助设备中常用的全局路径规划算法主要是Dijkstra算法[34]和A*算法[35]. 基于贪婪策略的Dijkstra算法[36]以源节点为中心向外, 通过迭代选择下一个节点进行层层扩展直至终点为止. 相比于Dijkstra算法, A*算法[37]使用启发函数估计从当前节点到目标节点的代价, 其核心公式是每一步的代价G加估算代价H从而得到总代价F, 其中G是确定的, H主要取决于启发函数, 常用的启发函数主要包括曼哈顿距离和欧几里得距离.

Dijkstra算法以广度优先, 在搜索时不考虑方向. 为提升视障自主移动能力, Kammoun等人[38]在视障可穿戴辅助设备NAVIG中通过立体相机捕获环境, 结合带注释的地理信息系统数据库, 以步行区原点、目标点和交点构建图示, 采用Dijkstra算法进行最优路径选择, 但该方法数据处理十分繁杂. 对此, 曹梦凡等人[39]在经典Dijkstra算法基础上将线要素抽象成点要素, 并利用安卓导航地图SDK开发了盲道导航应用程序. 相比之下, 该方法既提高了算法的运算效率也降低了搜索的时间复杂度.

虽然A*算法在启发函数的帮助下在搜索效率方面具有优势, 但其计算复杂度仍然较高. 对此Chen等人[40]在智能盲杖中利用Google Tango采集周围环境, 使用曼哈顿距离作为启发函数, 通过引入迭代终点拟合算法可减少路径规划的复杂性. 对视障人士进行路径规划时要充分考虑其出行的特定需求, 例如在室外行走时, 他们更倾向于靠近墙壁和感兴趣的点, 同时避开障碍物并保持一定距离, 对此Hosny等人[41]提出一种视障轮椅导航系统, 利用定位器收集用户位置及环境信息, 在目标函数曼哈顿距离中充分考虑了上述需求, 结果表明该方法规划的路径具有无障碍、转弯少、靠近墙等特点方便视障出行.

Dijkstra算法和A*算法是全局路径规划中常用的搜索算法. Dijkstra算法通过图搜索找到最短路径, 适合求解单源最短路径问题, 能够保证是最短路径但效率较低, 适用于需要精确路径长度的场景. 而A*算法通过启发函数高效搜索从起点到目标点的最短路径, 适用于有启发函数的加权图, 具有较高的搜索效率, 适合大规模图和复杂环境但性能依赖于合适的启发函数.

2.1.2 局部路径规划算法当环境信息未知或者部分未知时, 导盲系统根据传感器实时感知障碍物分布情况并进行局部路径规划. 目前辅助导盲系统中常用的局部路径规划算法主要有动态窗口法(dynamic window approaches, DWA)和人工势场法. DWA算法的核心思想[42]是在速度空间对线速度和角速度进行多组采样, 结合导盲机器人当前状态对未来可能的运动轨迹进行预测并通过评价函数对预测轨迹进行评价, 选取最优路径. 而人工势场法[43]将目标和障碍物分别看作是对导盲机器人有引力和斥力的物体, 机器人沿着两者的合力进行运动, 该算法只需要所处环境信息和目前状态便可确定下一步的移动方向.

导盲机器人采用DWA算法进行局部路径规划时, 由于没有考虑方向和速度之间的矛盾, 容易出现避障不及时、方向变换频繁和规划耗时等问题, 对此Liu等人[44]利用雷达和单目摄像机融合的方法对环境实时检测, 通过在DWA轨迹评价函数中引入方位变化因子以此抑制某一特定因素在特定情况下对评价函数的过度影响, 降低了环境对DWA参数的干扰, 提升了盲人路径规划的友好性同时改进后的轨迹更加平滑避障更加及时.

针对人工势场法极易陷入局部极小点困境且当目标点附近有障碍物时, 导盲机器人无法到达终点等问题[45], Guo等人[46]利用双目视觉和超声波传感器融合的障碍物检测方法, 通过计算目标点和障碍物的引力及斥力以此调整导盲机器人的速度和转向角度, 同时利用多传感器数据对合力进行修正, 改进的方法可引导机器人跳出局部极小值并实现了局部避障后安全到达目的地. 此外Yuan等人[47]利用超声波传感器对周围障碍物进行全方位检测, 在路径规划算法中提出将人工势场法和Bug算法相结合的思想, 利用人工势场法使机器人接近目标点, 采用Bug算法避开路径上的障碍物实现了导盲机器人的无目标避障.

单一全局规划的不安全性和单一局部规划的盲目性给导盲系统带来更多的不确定性. 为使导盲系统更稳定安全, 路径规划算法应根据传感器采集的视障位置、方向和周围障碍物信息为其提供实时精准导航. Zhang等人[48]提出结合静态全局与动态局部的路径规划方法, 利用导航模块和双目摄像机检测当前环境, 根据GIS获取全局路径, 通过对摄像机实时采集的信息采取瞄准-跟踪机制确定局部目标, 将人工势场法计算的势场函数作为A*算法的启发函数权系数, 以此产生新的代价函数用于路径规划, 结果表明其不仅可以提高路径搜索效率而且实现了盲人实时避障引导. 针对传统A*算法在全局路径规划中避障效果不佳的问题, Xu等人[49]通过在A*算法中加入安全距离判断实现了障碍物的探测避让, 采取动态切线法对A*算法规划的路径进行平滑, 将改进的A*算法搜索的路径关键点提取为速度自适应的DWA算法的中间目标点, 实验表明改进的方法更符合移动导盲机器人的运动特点.

人工势场法在局部路径规划中适用于实时避障问题, 但需要一些策略解决局部极小值困扰. 而DWA算法更适用于考虑导盲机器人运动受限情况, 可以产生平滑路径但是计算复杂度较高, 在实际应用中要根据问题需求和导盲机器人的功能特点选择更合适的方法.

2.2 智能算法在动态路径规划中的应用以强化学习[50]为代表的智能算法通过与环境交互获取信息后, 路径规划算法根据获取的信息进行训练最终得到较优的路线, 其具备较强的学习能力和环境适应性. 近年来, 强化学习算法被广泛应用于机器人在内的各个领域以增强它们学习适应新空间和新任务的能力, 其中代表性的Q-learning算法[51]指导导盲机器人发现执行各种任务的最佳策略, 包括路径规划和避障. 在路径规划[52]任务中, 机器人可通过评估每个可能动作的预期奖励来学习选择到达目标位置的最佳路径; 在避障任务[53]中, 机器人可通过评估每个状态下每个可能动作的预期来学习避开障碍物. 为解决动态路径规划问题, Chewu等人[54]提出一种基于SLAM与强化学习结合的方法, 该研究认为使用强化学习技术可使移动机器人轻松穿越动态障碍环境. 为改善Q学习性能, Wang等人[55]在Q学习算法中引入了优先级权重应用于动态路径规划中, 实验表明改进后的方法显著提升了算法的精度和收敛速度.

基于强化学习的路径规划算法容易出现维数灾难、收敛速度慢和可移植性差[56]等问题. Minh等人[57]于2013年首次提出深度强化学习的概念, 其融合了深度学习的感知能力和强化学习的决策能力[58], 此后研究人员提出将深度强化学习用于动态路径规划研究中. Xiang等人[59]提到仅用深度强化学习的连续空间路径规划足以帮助移动机器人在动态环境中规划路径并避开障碍物, 与传统算法相比该方法表现出较高的成功率. 相比于经典的地图定位导航, 导盲机器人使用深度强化学习算法无需构建地图即可学习, 通过反复实验可实现动态路径规划和防撞功能, Lu等人[60]提出利用深度强化学习和超宽带定位融合的路径规划方法, 使用深度强化学习算法训练导盲机器人实现了固定航点之间的动态路径规划.

作为深度强化学习的代表算法之一, Deep Q-Network算法将深度学习的神经网络和强化学习的Q-learning算法结合, 使该算法具有较好的通用性. Feng等人[61]介绍了使用几种深度强化学习算法例如 Deep Q-Network、Double Deep Q-Network 及 Prioritized Experience Replay相结合如何实现无碰撞策略, 该类框架从环境中感知信息以自主帮助移动机器人进行动态规划路径.

为实现未知动态环境下导盲机器人自动探索问题, Li等人[62]将探测过程分为决策、规划和映射模块并提出一个通用探测框架, 在此基础上, 利用深度学习的深度神经网络从局部地图中学习探索策略, 提出一种基于深度强化学习的决策算法, 实验发现该算法具有较好的环境适应性和学习能力. 针对未知环境下导盲机器人路径规划中环境状态空间探索能力差、奖励稀疏等问题, Wang等人[63]通过传感器感知环境, 结合位置和目标点形成状态空间作为输入, 利用当前位置的Q值作为输出, 采用贪婪策略进行动态路径选择, 同时将人工势场与奖励函数结合对状态动作空间进行优化, 结果表明该方法提高了运行效率和环境对空间奖励的稀疏性. 为实现动态路径规划并解决特定情况下无法寻路问题, Choi等人[64]提出一种动态路径规划模型MCAL, 选用基于值函数逼近的深度强化学习算法训练机器人, 使其能够独立做出决策避免与障碍物发生碰撞, 同时将A*算法与MCAL模型集成提高了寻路效率.

在路径规划算法选择方面, 传统方法如Dijkstra和A*适用于简单环境, 人工势场和动态窗口法适用于实时避障. 人工智能算法中强化学习和深度强化学习则适用于自主学习和长期决策, 但需要权衡其计算复杂度和训练成本. 选择合适的路径规划算法取决于环境地图的特性、路径复杂度、计算资源以及实时性需求.

3 总结障碍物检测为路径规划提供了关键的环境感知. 传统的障碍物检测方法在特定的环境下能够取得一定的效果, 但也存在一些限制, 比如可能对透明物体和光照变化较为敏感, 且对于复杂场景和小目标的处理能力有限. 以深度学习为代表的人工智能方法已取得显著进步, 能够为视障出行提供实时障碍物和交通标识物识别等功能, 然而在实际应用中仍存在如场景识别准确率较低和实时性较差等问题. 兼顾全局最优与局部随机避障是路径规划的研究热点. 全局路径规划需要理解和构建全局地图模型进行离线计算, 侧重于环境建模和路径评估. 而局部路径规划则注重在线计算实时采集的环境信息, 具有高度灵活性但其可能只获得局部最优路径. 实际应用中通常将二者结合: 全局规划提供整体路径, 局部规划进行实时避障. 此外, 以强化学习和深度强化学习为代表的智能算法在路径规划方面展现出较高的自适应性和鲁棒性, 但也仍面临训练时间长、大规模数据标注的需求等挑战.

尽管目前辅助视障出行领域已经取得较大进步, 但仍有一些问题值得探索: 首先是如何在复杂环境中提升远距离小目标的识别精度; 其次是如何对路口交通信号和行人进行识别优化, 为视障提供更加实时的路口引导; 最后要综合考虑如何设计更易操作和理解的交互界面以及如何将多模态交互方式进行整合以提高用户出行体验. 对这些问题的深入研究将进一步提升辅助视障出行的技术和服务水平, 为视障出行提供更为独立、安全和便捷的出行方式. 未来, 随着技术的进步, 辅助导盲设备可将北斗、5G与AI等技术进行融合, 为视障提供更精确的定位、障碍物检测和路径规划服务, 帮助他们更好认知环境和规划行程. 随着自动驾驶技术的不断发展, 智能交通系统的整合将成为可能, 这将会为视障出行带来更安全高效的出行体验. 此外辅助导盲设备也可与虚拟现实技术相结合, 为用户呈现更加丰富的语义信息, 进而增强他们对环境的感知与理解能力.

综上所述, 尽管当前的辅助视障出行技术已取得了显著的进展和突破, 但仍存在诸多值得探索和优化的问题. 通过深入研究和不断创新, 辅助导盲设备有望为视障者提供更为完善、高效的出行解决方案.

| [1] |

Jivrajani K, Patel SK, Parmar C, et al. AIoT-based smart stick for visually impaired person. IEEE Transactions on Instrumentation and Measurement, 2023, 72: 2501311. DOI:10.1109/TIM.2022.3227988 |

| [2] |

毛志伟, 傅悦, 崔瑶. 视障群体的信息无障碍应用现状分析. 信息记录材料, 2019, 20(7): 51-53. DOI:10.16009/j.cnki.cn13-1295/tq.2019.07.032 |

| [3] |

丁虹月, 杨婧. 基于视障人群特征的出行穿戴设备通感设计研究. 山东工艺美术学院学报, 2018(1): 64-68. DOI:10.3969/j.issn.1671-606X.2018.01.008 |

| [4] |

Akram S, Mahmood A, Ullah I, et al. Construction and analysis of a novel wearable assistive device for a visually impaired person. Applied Bionics and Biomechanics, 2020, 2020: 6153128. DOI:10.1155/2020/6153128 |

| [5] |

宋玉娥, 刘业辉, 张小燕, 等. 基于STM32的智能导盲杖的设计. 电子器件, 2020, 43(5): 1180-1184. DOI:10.3969/j.issn.1005-9490.2020.05.042 |

| [6] |

杨礼, 崔永利, 霍毅, 等. 基于人工智能技术的多信息融合可穿戴式导盲系统设计. 科技创新与应用, 2023, 13(18): 19-22. |

| [7] |

彭琳钰, 刘宇红, 马治楠, 等. 基于深层卷积神经网络的智能导盲终端设计与应用. 贵州大学学报(自然科学版), 2019, 36(3): 86-90, 95. |

| [8] |

李子康, 徐桂芝, 郭苗苗. 视听融合导盲机器人的设计与研究. 激光与光电子学进展, 2017, 54(12): 346-356. |

| [9] |

黄涛. 超声波测距传感器在高速公路自动发卡机中的应用. 电子产品世界, 2021, 28(7): 39-41. |

| [10] |

张亦勋. 基于红外技术测距仪的设计与实现. 电子制作, 2021, 29(24): 12-14. DOI:10.3969/j.issn.1006-5059.2021.24.004 |

| [11] |

Patil K, Jawadwala Q, Shu FC. Design and construction of electronic aid for visually impaired people. IEEE Transactions on Human-machine Systems, 2018, 48(2): 172-182. DOI:10.1109/THMS.2018.2799588 |

| [12] |

Meshram VV, Patil K, Meshram VA, et al. An astute assistive device for mobility and object recognition for visually impaired people. IEEE Transactions on Human-machine Systems, 2019, 49(5): 449-460. DOI:10.1109/THMS.2019.2931745 |

| [13] |

Chang WJ, Chen LB, Chen MC, et al. Design and implementation of an intelligent assistive system for visually impaired people for aerial obstacle avoidance and fall detection. IEEE Sensors Journal, 2020, 20(17): 10199-10210. DOI:10.1109/JSEN.2020.2990609 |

| [14] |

Katzschmann RK, Araki B, Rus D. Safe local navigation for visually impaired users with a time-of-flight and haptic feedback device. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2018, 26(3): 583-593. DOI:10.1109/TNSRE.2018.2800665 |

| [15] |

韦中超, 廖浚宏, 张准, 等. 基于超声波测距和PSD红外测距的智能语音导盲器. 现代电子技术, 2013, 36(10): 115-118. DOI:10.3969/j.issn.1004-373X.2013.10.035 |

| [16] |

Ahmad NS, Boon NL, Goh P. Multi-sensor obstacle detection system via model-based state-feedback control in smart cane design for the visually challenged. IEEE Access, 2018, 6: 64182-64192. DOI:10.1109/ACCESS.2018.2878423 |

| [17] |

Lee TJ, Yi DH, Cho DID. A monocular vision sensor-based obstacle detection algorithm for autonomous robots. Sensors, 2016, 16(3): 311. DOI:10.3390/s16030311 |

| [18] |

Ou S, Park H, Lee J. Implementation of an obstacle recognition system for the blind. Applied Sciences, 2019, 10(1): 282. DOI:10.3390/app10010282 |

| [19] |

任慧娟, 金守峰, 林强强, 等. 面向视障人群的障碍物位置与距离的视觉测量方法. 轻工机械, 2020, 38(3): 65-68, 73. DOI:10.3969/j.issn.1005-2895.2020.03.013 |

| [20] |

朱爱斌, 何大勇, 罗文成, 等. 基于双目视觉方法的可穿戴式导盲机器人研究. 机械设计与研究, 2016, 32(5): 31-34. |

| [21] |

王涛, 王学. 基于双目立体视觉的视障辅助系统设计. 电子制作, 2023, 31(5): 21-25, 47. DOI:10.3969/j.issn.1006-5059.2023.05.004 |

| [22] |

Jiang B, Yang JC, Lv ZH, et al. Wearable vision assistance system based on binocular sensors for visually impaired users. IEEE Internet of Things Journal, 2019, 6(2): 1375-1383. DOI:10.1109/JIOT.2018.2842229 |

| [23] |

Yang KL, Wang KW, Lin SF, et al. Long-range traversability awareness and low-lying obstacle negotiation with realsense for the visually impaired. Proceedings of the 1st International Conference on Information Science and Systems. Jeju: ACM, 2018. 137–141. [doi: 10.1145/3209914.3209943]

|

| [24] |

Hua MJ, Nan YB, Lian SG. Small obstacle avoidance based on RGB-D semantic segmentation. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW). Seoul: IEEE, 2019. 886–894.

|

| [25] |

Li B, Muñoz JP, Rong XJ, et al. Vision-based mobile indoor assistive navigation aid for blind people. IEEE Transactions on Mobile Computing, 2019, 18(3): 702-714. DOI:10.1109/TMC.2018.2842751 |

| [26] |

Long NB, Wang KW, Cheng RQ, et al. Assisting the visually impaired: Multitarget warning through millimeter wave radar and RGB-depth sensors. Journal of Electronic Imaging, 2019, 28(1): 013028. DOI:10.1117/1.JEI.28.1.013028 |

| [27] |

Wong YC, Lai JA, Ranjit SSS, et al. Convolutional neural network for object detection system for blind people. Journal of Telecommunication, Electronic and Computer Engineering (JTEC), 2019, 11(2): 1-6. |

| [28] |

Yu XR, Yang GJ, Jones S, et al. AR marker aided obstacle localization system for assisting visually impaired. Proceedings of the 2018 IEEE International Conference on Electro/Information Technology (EIT). Rochester: IEEE, 2018. 271–276. [doi: 10.1109/EIT.2018.8500166]

|

| [29] |

陈朝阳, 高翔森, 孙铭悦, 等. 基于YOLOv3算法的盲道识别. 科学技术创新, 2021(7): 148-149. DOI:10.3969/j.issn.1673-1328.2021.07.067 |

| [30] |

孙嘉鑫, 吴琳. 基于YOLOv3算法的盲道障碍物识别技术应用研究. 现代计算机, 2021, 27(5): 71-74. DOI:10.3969/j.issn.1007-1423.2021.05.015 |

| [31] |

牛恒, 陈智利, 周泉, 等. 基于图像处理技术的盲人避障系统研究与实现. 自动化技术与应用, 2023, 42(1): 1-4, 9. |

| [32] |

Karur K, Sharma N, Dharmatti C, et al. A survey of path planning algorithms for mobile robots. Vehicles, 2021, 3(3): 448-468. DOI:10.3390/vehicles3030027 |

| [33] |

Liu LX, Wang X, Yang X, et al. Path planning techniques for mobile robots: Review and prospect. Expert Systems with Applications, 2023, 227: 120254. DOI:10.1016/j.eswa.2023.120254 |

| [34] |

Fallah N, Apostolopoulos I, Bekris K, et al. Indoor human navigation systems: A survey. Interacting with Computers, 2013, 25(1): 21-33. DOI:10.1093/iwc/iws010 |

| [35] |

鲁毅, 高永平, 龙江腾. A*算法在移动机器人路径规划中的研究. 湖北师范大学学报(自然科学版), 2022, 42(2): 59-65. |

| [36] |

林梓健, 刘凯, 林群煦. 路径规划算法的研究综述. 现代信息科技, 2023, 7(4): 75-80. |

| [37] |

刘志飞, 曹雷, 赖俊, 等. 多智能体路径规划综述. 计算机工程与应用, 2022, 58(20): 43-62. DOI:10.3778/j.issn.1002-8331.2203-0467 |

| [38] |

Kammoun S, Dramas F, Oriolaand B, et al. Route selection algorithm for blind pedestrian. Proceedings of the 2010 International Conference on Control, Automation and Systems. Gyeonggi-do: IEEE, 2010. 2223–2228. [doi: 10.1109/ICCAS.2010.5669846]

|

| [39] |

曹梦凡, 李佩玲, 唐轲. 基于Dijkstra算法的盲道导航软件的设计与开发. 电脑知识与技术, 2021, 17(30): 82-85, 100. |

| [40] |

Chen QT, Khan M, Tsangouri C, et al. CCNY smart cane. Proceedings of the 7th IEEE Annual International Conference on CYBER Technology in Automation, Control, and Intelligent Systems (CYBER). Honolulu: IEEE, 2017. 1246–1251. [doi: 10.1109/CYBER.2017.8446303]

|

| [41] |

Hosny M, Alsarrani R, Najjar A. Indoor wheelchair navigation for the visually impaired. Proceedings of the 2015 International Conference on HCI International Posters’ Extended Abstracts. Los Angeles: Springer, 2015. 411–417.

|

| [42] |

林韩熙, 向丹, 欧阳剑, 等. 移动机器人路径规划算法的研究综述. 计算机工程与应用, 2021, 57(18): 38-48. DOI:10.3778/j.issn.1002-8331.2103-0519 |

| [43] |

Moorthy AK, Bovik AC. Blind image quality assessment: From natural scene statistics to perceptual quality. IEEE Transactions on Image Processing, 2011, 20(12): 3350-3364. DOI:10.1109/TIP.2011.2147325 |

| [44] |

Liu TY, Yan RX, Wei GR, et al. Local path planning algorithm for blind-guiding robot based on improved DWA algorithm. Proceedings of the 2019 Chinese Control and Decision Conference (CCDC). Nanchang: IEEE, 2019. 6169–6173. [doi: 10.1109/CCDC.2019.8833259]

|

| [45] |

Gu SY, Bao JM, Chen D, et al. GIQA: Generated image quality assessment. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 369–385.

|

| [46] |

Guo YC, Hao LN, Wu YL. Research on vision based outdoor blind guiding robot. Proceedings of the 12th International Conference on CYBER Technology in Automation, Control, and Intelligent Systems (CYBER). Baishan: IEEE, 2022. 283–288. [doi: 10.1109/CYBER55403.2022.9907114]

|

| [47] |

Yuan WB, Guo YC, Hao LN, et al. Local path planning of the outdoor blind guiding robot. Proceedings of the 11th IEEE Annual International Conference on CYBER Technology in Automation, Control, and Intelligent Systems (CYBER). Jiaxing: IEEE, 2021. 209–213. [doi: 10.1109/CYBER53097.2021.9588256]

|

| [48] |

Zhang YD, Zhao Y, Wei T, et al. Dynamic path planning algorithm for wearable visual navigation system based on the improved A*. Proceedings of the 2017 IEEE International Conference on Imaging Systems and Techniques (IST). Beijing: IEEE, 2017. 1–6. [doi: 10.1109/IST.2017.8261468]

|

| [49] |

Xu ZY, Yuan W. Mobile robot path planning based on fusion of improved A* algorithm and adaptive DWA algorithm. Journal of Physics: Conference Series, 2022, 2330: 012003. DOI:10.1088/1742-6596/2330/1/012003 |

| [50] |

宋丽君, 周紫瑜, 李云龙, 等. 改进Q-learning的路径规划算法研究. 小型微型计算机系统. http://kns.cnki.net/kcms/detail/21.1106.tp.20230218.2208.008.html. (在线出版)(2023-08-25).

|

| [51] |

刘晓晨, 郑孝遥, 沈晨. 结合人工势场的Q-learning无人驾驶汽车路径规划算法. 电子质量, 2022(12): 1-5. DOI:10.3969/j.issn.1003-0107.2022.12.001 |

| [52] |

López-Lozada E, Rubio-Espino E, Sossa-Azuela JH, et al. Reactive navigation under a fuzzy rules-based scheme and reinforcement learning for mobile robots. PeerJ Computer Science, 2021, 7: e556. DOI:10.7717/peerj-cs.556 |

| [53] |

Xie LH, Wang S, Markham A, et al. Towards monocular vision based obstacle avoidance through deep reinforcement learning. arXiv:1706.09829, 2017.

|

| [54] |

Chewu CCE, Kumar VM. Autonomous navigation of a mobile robot in dynamic indoor environments using SLAM and reinforcement learning. IOP Conference Series: Materials Science and Engineering, 2018, 402: 012022. DOI:10.1088/1757-899X/402/1/012022 |

| [55] |

Wang CL, Yang X, Li H. Improved Q-Learning applied to dynamic obstacle avoidance and path planning. IEEE Access, 2022, 10: 92879-92888. DOI:10.1109/ACCESS.2022.3203072 |

| [56] |

许宏鑫, 吴志周, 梁韵逸. 基于强化学习的自动驾驶汽车路径规划方法研究综述. 计算机应用研究, 2023, 40(11): 3211-3217. |

| [57] |

Mnih V, Kavukcuoglu K, Silver D, et al. Playing Atari with deep reinforcement learning. arXiv:1312.5602, 2013.

|

| [58] |

封硕, 舒红, 谢步庆. 基于改进深度强化学习的三维环境路径规划. 计算机应用与软件, 2021, 38(1): 250-255. DOI:10.3969/j.issn.1000-386x.2021.01.042 |

| [59] |

Xiang JQ, Li QD, Dong XW, et al. Continuous control with deep reinforcement learning for mobile robot navigation. Proceedings of the 2019 Chinese Automation Congress (CAC). Hangzhou: IEEE, 2019. 1501–1506. [doi: 10.1109/CAC48633.2019.8996652]

|

| [60] |

Lu CL, Liu ZY, Huang JT, et al. Assistive navigation using deep reinforcement learning guiding robot with UWB/voice beacons and semantic feedbacks for blind and visually impaired people. Frontiers in Robotics and AI, 2021, 8: 654132. DOI:10.3389/frobt.2021.654132 |

| [61] |

Feng SM, Ren HL, Wang XR, et al. Mobile robot obstacle avoidance based on deep reinforcement learning. Proceedings of the 2019 International Design Engineering Technical Conferences and Computers and Information in Engineering Conference. Anaheim: American Society of Mechanical Engineers, 2019. V05AT07A048. [doi: 10.1115/DETC2019-97536]

|

| [62] |

Li HR, Zhang QC, Zhao DB. Deep reinforcement learning-based automatic exploration for navigation in unknown environment. IEEE Transactions on Neural Networks and Learning Systems, 2020, 31(6): 2064-2076. DOI:10.1109/TNNLS.2019.2927869 |

| [63] |

Wang W, Wu ZK, Luo HF, et al. Path planning method of mobile robot using improved deep reinforcement learning. Journal of Electrical and Computer Engineering, 2022, 2022: 5433988. DOI:10.1155/2022/5433988 |

| [64] |

Choi J, Lee G, Lee C. Reinforcement learning-based dynamic obstacle avoidance and integration of path planning. Intelligent Service Robotics, 2021, 14(5): 663-677. DOI:10.1007/s11370-021-00387-2 |

2024, Vol. 33

2024, Vol. 33