2. 机器视觉与虚拟现实山西省重点实验室, 太原 030051;

3. 山西省视觉信息处理及智能机器人工程研究中心, 太原 030051

2. Shanxi Key Laboratory of Machine Vision and Virtual Reality, Taiyuan 030051, China;

3. Shanxi Province’s Vision Information Processing and Intelligent Robot Engineering Research Center, Taiyuan 030051, China

人类视觉系统在光线不足时通常难以有效地识别周围环境, 这对夜间行动、安全监控以及军事作战等多个领域都带来了重大挑战. 微光增强技术能够有效克服该问题, 它通过捕获微弱的光信号, 经过一系列数字图像处理步骤, 包括信号增强等, 将原本几乎不可见的场景变得清晰可辨, 为各行业提供了高效的视觉支持. 图像增强算法主要分为传统图像处理方法和基于深度学习的方法.

传统方法可以细分为基于直方图均衡化的方法、基于伽马校正的方法和基于Retinex[1]的方法. 基于直方图均衡化的方法对图像的对比度提升效果较好, 但容易降低图像的灰度级, 导致图像过度增强; 伽马矫正的方法可以有效增强图像较暗的部分, 但会导致较亮区域的细节丢失; 而基于Retinex的方法增强虽然可以有效增强微光图像, 但是生成后的图像色彩失真且伴随较大的图像噪声.

随着深度学习方法在图像领域的发展, 研究人员尝试将深度学习技术应用到图像增强上, 一定程度上解决了计算复杂度高以及泛化性能不佳等问题. 基于Retinex思想的RetinexNet[2]、KIND[3] 和 KIND++[4]等方法通过对图像的反射分量和光照分量改善图像效果, 其中RetinexNet仅将图像分解为光照分量与反射分量, 由此得到的图像缺少图像图层之间的联系, 恢复效果不够理想, 所以在KIND中增加了图层分解的相关信息, KIND++在此基础上进一步增加了多尺度注意力模块, 有效解决了一些视觉缺陷的问题. 运用参数估计的ZERO-DCE[5]、ZERO-DCE++[6]等方法通过学习图像亮度的变化曲线来完成图像增强任务, 然而图片中较亮的地方容易形成亮斑. 结合LUT的3D-LUT[7]等方法通过学习查找表中的LUT映射关系来进行图像增强, 虽然提升了图像中的亮度但同时也放大了图像中的噪声. 使用GAN网络的EnglishGAN[8]、DBEN[9] 等方法通过不断学习微光与正常光之间的映射关系来提高图像清晰度, 但是可能产生不合理的图像光照强度. 融合Transformer的Uformer[10]、IPT[11]、RCT[12]、MAXIM[13]及UHDFour[14]等方法通过加深图像中色素之间空间关系保留图像的结构特征. 然而, 深度学习方法中的单一的图像增强结构都有各自侧重的图像恢复能力, 无法兼顾生成图像的细节与结构信息, 生成的图像往往伴随大量的噪声并且生成的图像色彩偏暗. 为了解决该问题, 本文提出一种复合主干融合的图像增强方法, 通过逐层融合不同主干网络模块, 并以并行结构的方式共同作用. 相较于简单的网络深化和拓宽策略, 通过设计的复合主干网络融合结构, 将不同网络骨干交叉融合, 充分发挥各自网络结构的优势, 从而获得更强大的特征提取能力. 该网络结构可以有效改善图像中的噪音和细节丢失问题, 进一步提高了微光图像生成的质量. 本文主要贡献是提出了IEM (inception enhancement module)模块并使用IEM模块与简单CNN构建新的主干网络并验证了其有效性.

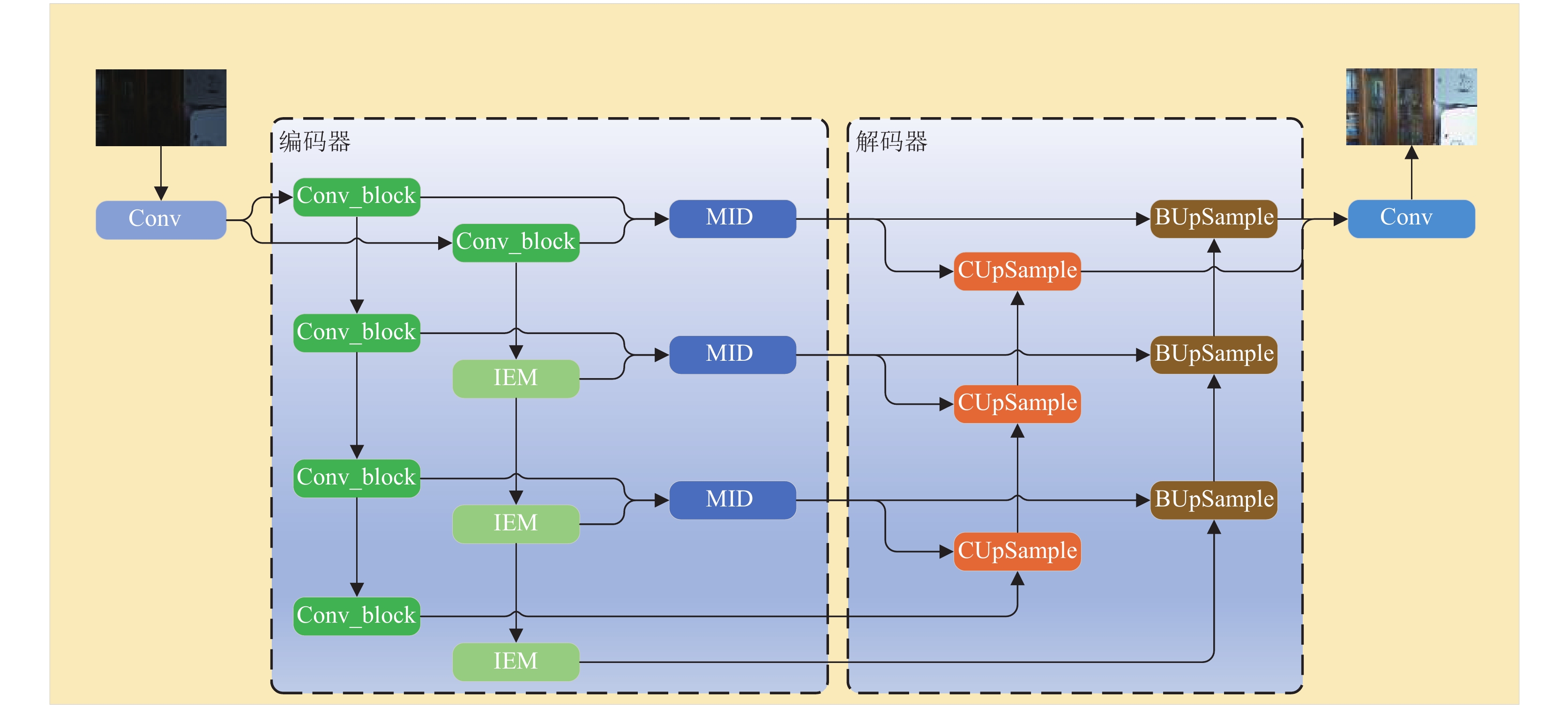

1 网络整体结构本文网络整体结构主要由编码器和解码器两个关键部分组成, 如图1所示. 微光图像在进入编码器之前, 为增加特征的丰富性, 采用卷积神经网络(CNN)对输入特征进行维度增加. 然后, 将特征送入编码器中提取融合特征. 编码器由3层双分支结构组成, 初始层采用双CNN网络, 其余两层采用CNN结构与IEM模块共同作用. 为了保持融合特征的原始特性, 通过Concat操作将输出特征堆叠在一起, 并输入到解码器中. 解码器利用不同的解码结构对不同融合层的特征进行解码, 然后通过Concat操作堆叠在一起, 最后使用卷积操作将特征转换为增强后的图像. 本文网络结构的创新体现在以下两个方面.

(1)提出了一种复合主干网络融合的方法, 将CNN网络与本文引入的IEM模块相结合, 并汲取了其他分支融合策略的经验, 更有效地实现了对目标图像的增强.

(2)在分支网络结构中, 构建了一种IEM的新模块, 对IAT (illumination adaptive Transformer)的串行结构进行了改进, 提出了更加有效的基于并行结构的特征提取策略, 对多个尺度卷积形成的图像进行融合.

|

图 1 复合主干融合网络的图像增强网络结构图 |

1.1 编码器结构

图像增强的目标是将在不良光照下获得的图像L映射到正常光照下的图像Ni. 本文通过逆映射函数F, 将RGB图像L映射到相应的Raw-RGB空间F(L)上. 然后, 通过学习图像像素的映射关系S, 来动态调整图像的亮度, 生成最终的预测图像S(F(L)), 使其尽量逼近正常的光照图像Ni. 具体公式如下:

| $ {N_i} = S \left({F \left(L\right)} \right) $ | (1) |

为了提高网络特征的提取效率, 本文采用了复合主干融合网络来学习图像像素映射关系S. 在网络的每一层中, 提取图像特征的独立表达公式如下:

| $ MI{D_n} = C_1^n{X_1} + {C_1}C_2^{n - 1}{X_2} $ | (2) |

其中, C1为CNN操作, C2为IEM操作, n为特征提取的层数,

复合主干融合网络通过在编码器的不同层次和顶层之间采用不同的特征提取方式, 增加层次之间的特征多样性. 同时, 为了最大程度地减少网络模型的参数量, 使用了大量简单的CNN结构作为基本特征提取单元. 复合主干融合的网络模型分为3层特征提取, 第1层特征提取由两个CNN结构分支组成, 初步学习输入和输出之间的映射关系. 为了防止信息损失, 在CNN中采用LeakyReLU函数提取早期特征; 第2层和第3层特征提取采用CNN与信息融合模块(IEM)结合的方式, 增强解码器在特征提取方面的表现能力. 复合主干融合的分层提取方式能更好地帮助网络捕获和表达特征, 提高其在图像处理任务中的性能.

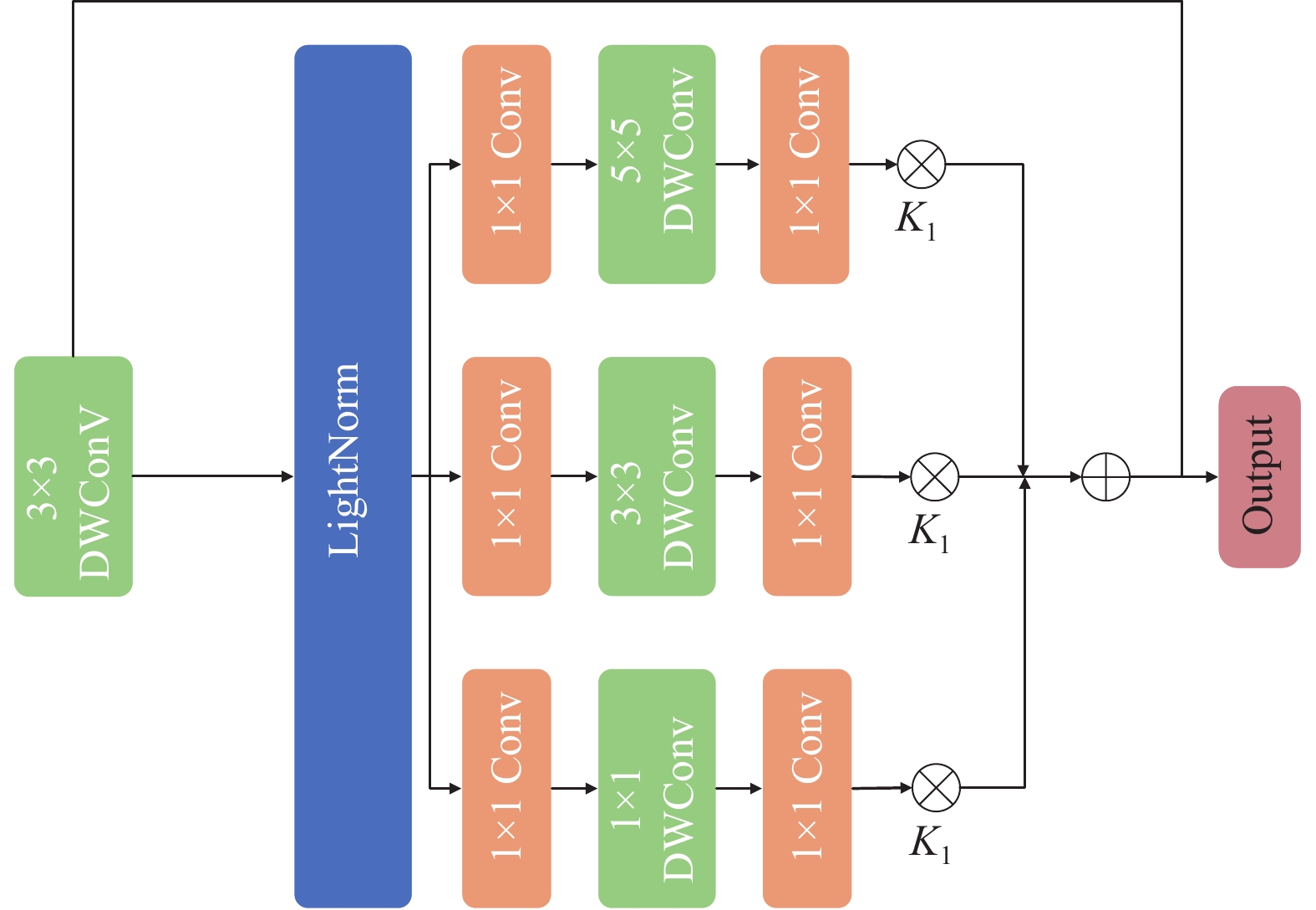

在分支网络的设计方面, 为了更全面地满足色彩处理的需求, 秉承了IAT [15]中PEM (pixel-wise enhancement module)模块设计的灵感. 但PEM中的串行结构不能很好地表达图像映射的线性关系, 因此改为并行结构的特征提取方式IEM, 以更好提取图像的结构信息. IEM网络结构如图2, 首先采用深度可分离卷积DWConv编码位置信息得到特征, 然后运用LightNorm模块对特征进行提取, 再并行使用不同大小的卷积核处理特征, 最后将特征进行融合. IEM网络流程公式如下:

| $ N = X + \left( {{K_{1\times 1}} + {K_{3\times3}} + {K_{5\times5}}} \right){\left( {AX + B} \right)^r} $ | (3) |

其中, A为可学习的缩放因子, B为偏置项, r为调整参数,

在整个过程中, 由于受到并行的LightNorm的约束, 参数学习过程能够很好地保留图像的结构信息, 从而更充分地满足色彩处理的需求. IEM的设计方法有助于提高图像处理的效率和性能, 并使网络在色彩校正任务中表现更出色.

1.2 解码器结构解码器的目的是生成多个层次的特征, 使其与真实数据的特征更接近, 为后续的损失函数提供更好的约束关系. 在复合主干网络中, 为了丰富解码器之间的特征关联, 将解码器分为CUpSample和BUpSample两种结构, 为不同的主干应用不同结构的解码器.

|

图 2 IEM网络示意图 |

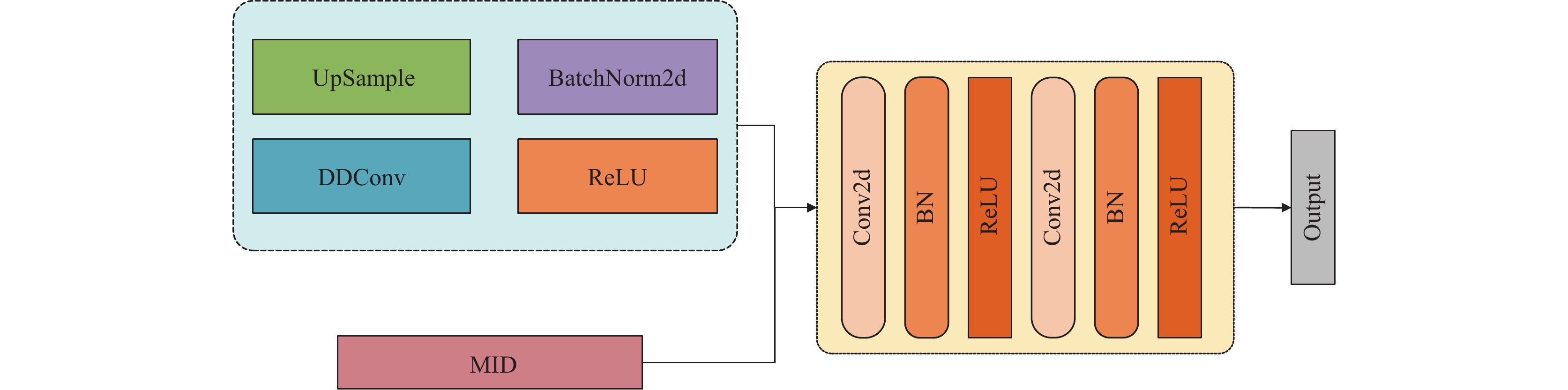

1.2.1 CUpSample

CUpSample网络结构如图3所示, 浅层特征图分辨率相对较高, 可以保留诸如边缘、纹理和形状等低级别的视觉特征, 能够更好地捕捉图像中的结构信息. 与此相反, 深层特征图在卷积神经网络中的深层层级中生成, 可以捕捉更高级别的抽象特征, 如对象的类别、形状等更多地语义信息. 深层特征与来自于同层级的浅层特征MID相结合, 可以充分利用浅层特征与深层特征的优势. CUpSample网络在对深层特征进行提取的时候, 经过UpSample输入到DDConv模块[16], 用以提高特征的感知域, 增强特征的表达能力, 使CNN能够更好地捕捉到特征图中的空间信息, 提高特征的质量和多样性. 为了确保通道数的值与下一层的通道数相匹配以及避免在特征融合过程中产生较大的偏差, 最后通过连续的卷积操作来减少特征图的通道数, 保持特征的相对均衡. 通道数的均衡有助于确保深层特征和浅层特征之间的融合不会引入过多的噪音或偏置, 更有效地结合不同层级的信息, 提高模型的性能.

|

图 3 CUpSample网络结构图 |

1.2.2 DDConv

由于感受野的局限性, 普通卷积Conv很难提取边缘模糊小目标或目标的特征. 因此, 卷积不可避免地对图像生成的适应性较差, 泛化能力较弱. 尽管可变形卷积和动态卷积在一定程度上优于普通卷积, 在处理图像生成的时候, 它们仍然不具备平衡网络性能和大小的能力. 为了解决当前卷积操作的缺点, 本文采用了CIT[16]中的DDConv的卷积策略, 其能够根据具体的任务和数据分布自适应地学习核变形偏移和权重系数, 从而实现卷积核的形状和值的变化. 其特征图的输出是:

| $ y = \sigma \left(\left({a}1\cdot {W}1+\cdots +an\cdot Wn\right)\cdot x\right) $ | (4) |

其中, n 是权重系数的数量, an 是可学习参数的权重系数, y 是 DDConv 生成的输出特征图.

DDConv在执行卷积操作之前, 根据相应的权重系数线性组合不同的权重矩阵, 实现了卷积核权重的动态调整.

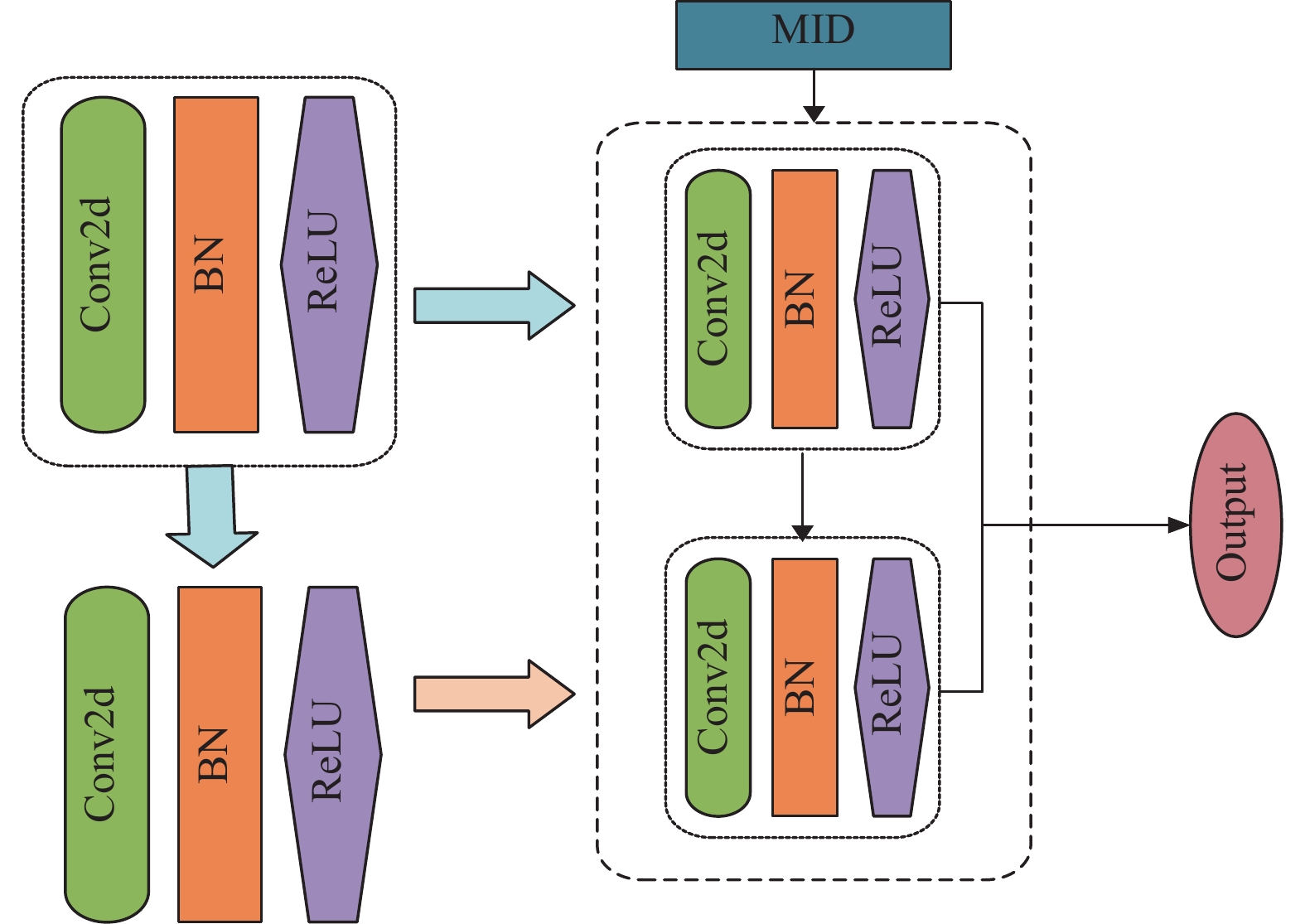

1.2.3 BUpSampleBUpSample网络结构如图4所示, 旨在将浅层和深层的特征信息有机地结合在一起, 以提高神经网络的性能. 与CUpSample不同的是, 在进入到BUpSample之前, 网络中已经引入相应的全局的信息, 为了避免DDConv结构对全局特征产生影响, 在设计中取消了对应的DDConv的结构. 在深度卷积神经网络中, 特征图中通常会出现一些相似性很高的特征图, 它们之间的差异较小. BUpSample中的Ghost module模块是处理具有高度相似性的特征图的模块, 通过简单的线性运算, 能够生成更多像素的特征图, 而无需引入大量的额外参数, 这意味着网络可以用更少的参数表示更多的特征信息, 从而降低计算和存储成本, 提高计算效率. 与CUpSample一致的是, 深层特征需要与浅层特征图的MID模块进行连接, 完成深浅层的融合, 将来自深层结构的高级语义特征与来自浅层结构的纹理特征巧妙地结合在一起, 提高网络的表现力. 值得注意的是, 在融合特征之后, 为了充分地提取特征, 还需要进一步地进行特征提取. 为了实现这一目标, 网络两次使用Ghost Module模块将融合后的特征进一步提取, 有效增强了网络的表现能力.

|

图 4 BUpSample网络结构图 |

2 损失函数

本文构建了SmoothL1与感知损失相结合的损失函数, 既缓解了梯度不平滑与爆炸的问题, 同时保证了图像质量.

在图像生成学习过程中, 使用L1损失有助于模型学习生成图像的每一个细节与目标之间的对应关系. 然而, L1损失可能会引起一些梯度不平滑的问题, 而L2损失则会导致梯度爆炸. 为了解决梯度问题, 使用L1和L2结合的SmoothL1损失, 其公式如下:

| $ loss_{x, y}=\left\{\begin{array}{l} 0.5{\left(x-y\right)}^{2}\text{, }\;{\mathrm{if}}\left|x-y\right| < 1\\ \left|x-y\right|-0.5\text{, }{\mathrm{otherwise}}\end{array} \right.$ | (5) |

其中, x和y分别表示模型的输出和标签, |x–y|表示它们之间的差异. 当|x–y|小于1时, 即差异较小时, 采用平方误差, 差异较大时, 采用线性误差.

当x较小时, 式(5)等效于L2损失, 有助于在学习中保持平滑; 而当x较大时, 式(5)等效于L1损失, 在一定程度上解决了梯度爆炸的问题.

为了使生成的图像更符合人眼对图像质量的感知, 在SmoothL1基础上增加感知损失. 与传统的损失函数不同, 感知损失源自图像风格迁移, 它通过比较不同层的特征表示来衡量图像之间的感知差异, 使生成的图像更符合人眼对图像质量的感知. 其公式如下:

| $ PerceptualLoss = \frac{1}{N}\mathop \sum \limits_{i = 1} N{\left( {{F_i}\left( x \right) - {F_i}\left( y \right)} \right)^2} $ | (6) |

其中, x表示输入图像, y表示目标图像,

本文采用公开数据集 low-light dataset[2], 它是在真实场景中拍摄的低光与正常光照下的配对数据集, 被广泛地应用于基于深度学习的低照度图像增强领域. 该数据集包括弱光和正常光, 通过改变曝光时间与ISO来收集, 包括LOL-V1和LOL-V2两个版本. LOL-V1数据集包括500个图像对, 分辨率为400×600, 其中485对作为训练集, 15对作为测试训练集. LOL-V2数据集包括789对图像, 分辨率为400×600, 其中689对作为训练集, 100对作为测试集.

3.2 实验与参数设置本文实验的硬件环境为GPU GeForce RTX 3090, CUDA版本11.3, 所使用的深度学习框架为PyTorch, Python版本为3.8. 实验参数batch_size为3, 迭代次数为600, 学习率初始值为0.001, 在300轮之后数值基本稳定. 损失函数采用SmoothL1与感知损失联合计算, 其中感知损失的参数为0.4. 学习率的调整使用余弦退火算法, 参数设置为300.

实验选取PSNR指标和SSIM指标作为图像质量的衡量指标, 作为在不同的应用场景下的判断标准. PSNR使用峰值信噪比评价图像质量, 它可以评价两幅图像之间的相似程度. 由于PSNR不能很好地按照人眼的感受来衡量两张图像的相似度, 因此增加SSIM指标, 它不仅考虑了图像的亮度信息, 而且还考虑了图像的结构和纹理的相似性, 能更接近人眼的感受. 两个指标可以对图像增强效果进行良好的综合评价.

3.3 实验结果对比及分析本实验中使用的数据集为LOL-V1和LOL-V2. 为了验证本文所提模型的有效性, 在LOL-V1数据集上将本文的算法模型与ZERO-DCE、RetinexNet、DRBN、3D-LUT、KIND、Uformer、IPT、RCT、UHDFour、MAXIM及IAT等主流方法进行性能对比, 实验结果见表1. 如表1所示, 本文方法在PSNR和SSIM上都取得了更好的结果, 比之前产生较好结果的IAT与UHD-Four在PSNR指标上分别提升了0.44 dB和0.16 dB, 在SSIM指标上分别提升了0.016与0.027.

| 表 1 主干融合网络在LOL-V1数据集下的效果 |

在LOL-V2数据集上, 将本文的算法模型与ZERO-DCE、RetinexNet、DRBN、3D-LUT、KIND、Uformer、IPT、RCT、MAXIM及IAT方法进行对比, 实验结果见表2. 如表2所示, 本文方法在PSNR和SSIM上都取得了更好的结果, 比之前产生较好结果的IAT与MAXIM在PSNR指标上分别提升了0.85 dB和1.49 dB, 在SSIM指标上分别提升了0.053与0.046.

| 表 2 主干融合网络在LOL-V2数据集下的效果 |

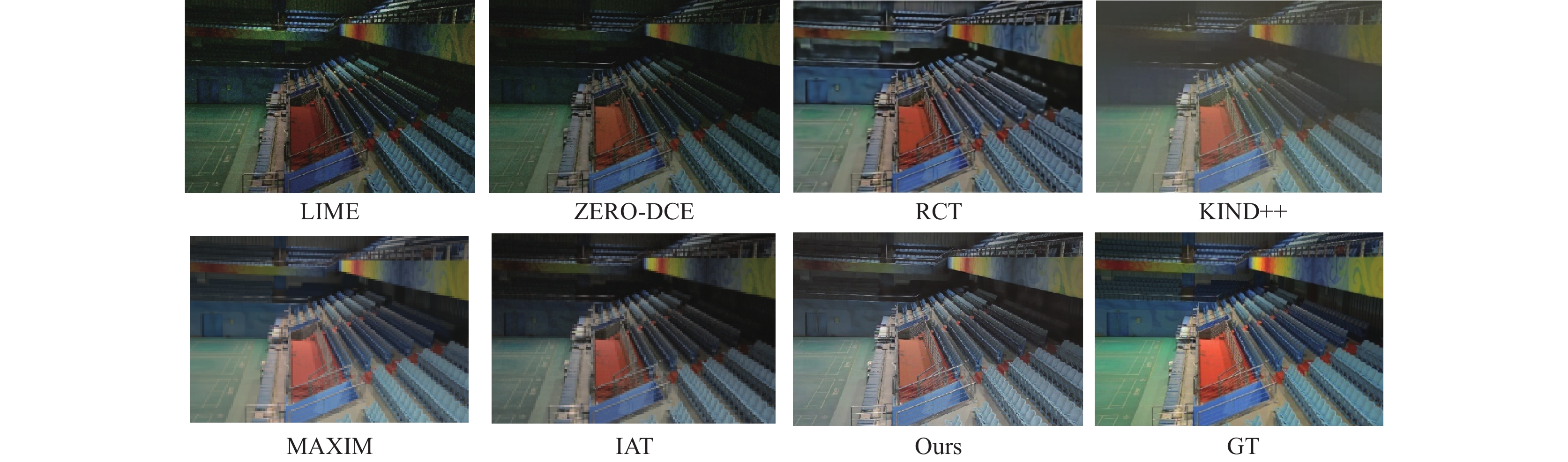

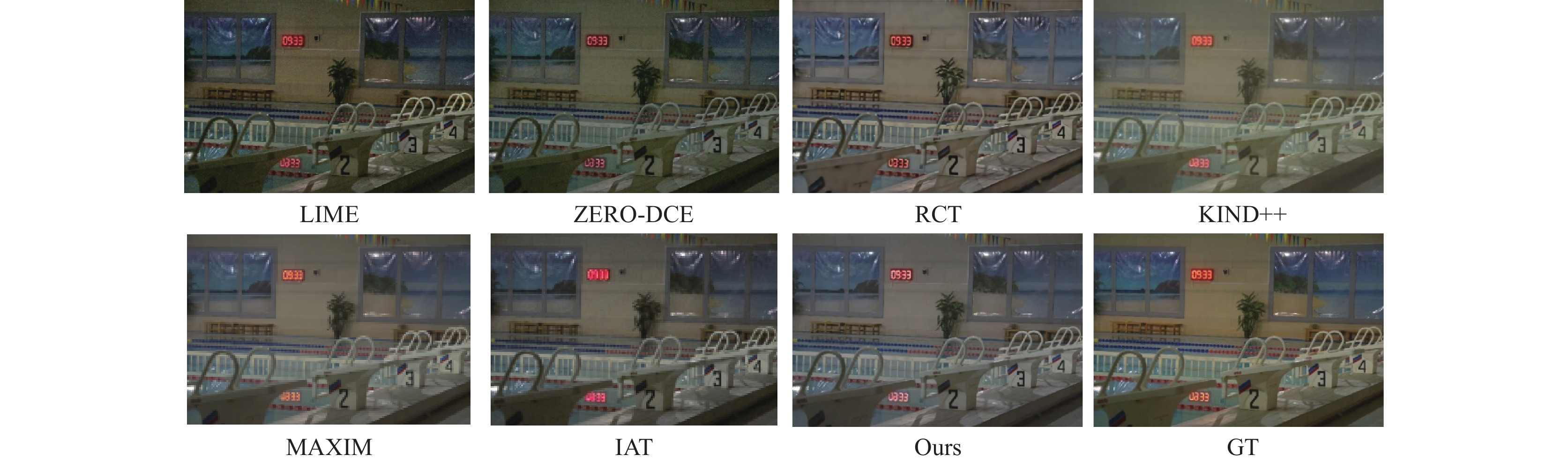

为了直观地验证本文模型的有效性, 将本文增强后的微光图像视觉效果与LIME、ZERO-DCE、RCT、KIND++、MAXIM和IAT算法的可视化效果进行比较, 如图5和图6所示, LIME和ZERO-DCE方法的可视化效果最差, 图像亮度提升效果不佳, 大部分区域呈现亮度不足的情况. RCT、KIND++、MAXIM和IAT方法都可以提高图像的亮度, 但是细节上均存在缺失, 无法产生令人满意的效果. 本文模型增强的微光图像, 虽然整体亮度略高于真实图像, 但在图像细节和噪声去除方面都优于对比的全部方法.

|

图 5 非均匀光照的视觉效果对比图 |

3.4 消融实验

为了验证双分支上采样结构的有效性, 在LOL-V1数据集上, 使用4种不同的双分支构成方式进行消融实验对比. 如表3所示, Exp1中两个分支均是BUpSample的双分支结构; Exp2中两个分支均是CUpSample的双分支结构; Exp3中分支1是CUpSample, 分支2是BUpSample的双分支结构; Exp4分支1是BUpSample, 分支2是CUpSample的双分支结构. 实验结果见表3, 结果显示, Exp3中分支1为CUpSample且分支2为BUpSample的双分支结构更能提高图像增强效果, 其在PSNR和SSIM评价指标上结果都更优, 分别为23.54 dB和0.836.

为了验证损失函数对网络结构的影响, 本实验在LOL-V1数据集进行损失函数的消融实验, 使用6组常用的损失函数组合进对比, 实验结果见表4. Exp1、Exp2和Exp3分别使用L1损失函数、SmoothL1损失函数以及感知损失函数. 由表4可见, 感知损失表现比其他的损失函数表现得更好. 为了探索模型更好的拟合程度, Exp4、Exp5和Exp6分别将L1和SmoothL1损失与感知损失结合在一起, 由表4中可以观测出, SmoothL1与感知损失函数相结合是实验中效果最好的一种组合, PSNR和SSIM评价指标分别为23.54 dB和0.836.

最后为了验证复合主干融合的网络优于单分支的网络结构. 本实验在LOL-V1数据集, 以3种结构进行消融实验对比, 分别为仅使用CNN结构(Exp1)仅使用IEM结构(Exp2)以及CNN与IEM结合的结构(Exp3). 实验结果见表5, 由表中的数据可以观察到, Exp3的PSNR和SSIM评价指标比Exp2分别提升了1.03 dB和0.145, 表明了复合主干融合网络的有效性.

|

图 6 均匀光照下的视觉效果对比图 |

| 表 3 采样结构对网络效果的影响 |

| 表 4 损失函数对网络模型的影响 |

| 表 5 各分支对网络模型的影响 |

4 结束语

本文提出了一种复合主干融合的网络结构, 从特征提取的方向提升了图像亮度增强的效果, 为图像保留了更多的细节特征使暗光图像能够更加清晰. 在损失函数中使用SmoothL1损失和感知损失相结合, 使图像更加平滑, 增强图像的视觉效果. 在LOL-V1和LOL-V2两个数据集上的实验结果表明, 复合主干融合的网络结构可以有效地增强暗光图像质量, 优于全部对比的算法. 由于复合主干融合网络的模型复杂程度高, 参数量大, 训练时间长, 在未来的工作中, 将继续寻找新的轻型网络结构的组合模式, 降低模型复杂度, 提升网络性能.

| [1] |

王利娟, 常霞, 张君. 基于Retinex的彩色图像增强方法综述. 计算机系统应用, 2020, 29(6): 13-21. DOI:10.15888/j.cnki.csa.007430 |

| [2] |

Wei C, Wang WJ, Yang WH, et al. Deep retinex decomposition for low-light enhancement. Proceedings of the 2018 British Machine Vision Conference. Newcastle: BMVC, 2018.

|

| [3] |

Zhang YH, Zhang JW, Guo XJ. Kindling the darkness: A practical low-light image enhancer. Proceedings of the 27th ACM International Conference on Multimedia. Nice: ACM, 2019. 1632–1640.

|

| [4] |

Zhang YH, Guo XJ, Ma JY, et al. Beyond brightening low-light images. International Journal of Computer Vision, 2021, 129(4): 1013-1037. DOI:10.1007/s11263-020-01407-x |

| [5] |

Guo CL, Li CY, Guo JC, et al. Zero-reference deep curve estimation for low-light image enhancement. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 1777–1786.

|

| [6] |

Li CY, Guo CL, Loy CC. Learning to enhance low-light image via zero-reference deep curve estimation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(8): 4225-4238. |

| [7] |

Zeng H, Cai JR, Li LD, et al. Learning image-adaptive 3D lookup tables for high performance photo enhancement in real-time. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(4): 2058-2073. DOI:10.1109/TPAMI.2020.3026740 |

| [8] |

Jiang YF, Gong XY, Liu D, et al. EnlightenGAN: Deep light enhancement without paired supervision. IEEE Transactions on Image Processing, 2021, 30: 2340-2349. DOI:10.1109/tip.2021.3051462 |

| [9] |

Wang ZD, Cun XD, Bao JM, et al. Uformer: A general U-shaped Transformer for image restoration. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). New Orleans: IEEE, 2022. 17662–17672.

|

| [10] |

Lim S, Kim W. DSLR: Deep stacked Laplacian restorer for low-light image enhancement. IEEE Transactions on Multimedia, 2021, 23: 4272-4284. DOI:10.1109/TMM.2020.3039361 |

| [11] |

Chen HT, Wang YH, Guo TY, et al. Pre-trained image processing Transformer. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 12294–12305.

|

| [12] |

Kim H, Choi SM, Kim CS, et al. Representative color transform for image enhancement. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 4439–4448.

|

| [13] |

Tu ZZ, Talebi, Zhang H, et al. MAXIM: Multi-axis MLP for image processing. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 5759–5770.

|

| [14] |

Li CY, Guo CL, Zhou M, et al. Embedding Fourier for ultra-high-definition low-light image enhancement. Proceedings of the 11th International Conference on Learning Representations. Kigali: ICLR, 2023.

|

| [15] |

Cui ZT, Li KC, Gu L, et al. You only need 90k parameters to adapt light: A light weight Transformer for image enhancement and exposure correction. Proceedings of the 33rd British Machine Vision Conference. London: BMVC, 2022. 238.

|

| [16] |

Lei T, Sun R, Wang X, et al. CiT-Net: Convolutional neural networks hand in hand with vision Transformers for medical image segmentation. Proceedings of the 32nd International Joint Conference on Artificial Intelligence. Macao: IJCAI, 2023. 1017–1025.

|

2024, Vol. 33

2024, Vol. 33