近年来, 场景文本识别在自动驾驶、车票识别和身份证识别等行业中得到了广泛应用. 然而, 在这些行业中捕获的文本图像往往容易受到成像过程中出现的低分辨率以及画面模糊等问题的影响, 这严重限制了场景文本识别器的性能. 因此, 场景文本超分辨率算法[1–6]可以用作场景文本识别器之前的预处理器, 获取模糊文本图像中的文本信息, 以提升低分辨率场景下文本图像的质量.

早期的方法[7,8]将场景文本图像超分辨率(scene text image super-resolution, STISR)视为一般的超分辨率任务, 忽略了场景文本图像中蕴含的文本特有属性. 最近, 一些方法试图引入与文本相关的先验知识, 以帮助模型更好地重建文本区域的细节, 从而获得更具视觉效果的超分辨率(super-resolution, SR)图像. PlugNet[9]基于多任务学习策略, 提出了一种可插拔的超分辨率分支, 该分支与识别分支联合训练, 提取具有文本语义的特征, 进一步提高了识别性能. TSRN[1]在特征提取模块中使用循环神经网络(RNN)来捕获文本序列相关性信息. TG[2]通过预训练一个基于Transformer的文本识别器, 使用其注意力图获取笔画级别的监督来恢复图像中文本区域的笔画细节. C3-STISR[3]在TG的基础上, 还引入了文本视觉和文本语义信息作为超分辨率过程的指导. TPGSR[4]以迭代的方式将字符概率序列作为文本先验添加到超分辨率模型中. 尽管这些方法可以在一定程度上提升低分辨率的模糊图像的质量, 但它们受到真实场景中训练数据集不足的限制. 例如, 目前场景文本图像超分辨率任务使用的数据集TextZoom[1]仅包含17367个用于训练的样本, 这对于当前基于深度学习的STISR模型来说仍然是远远不够的.

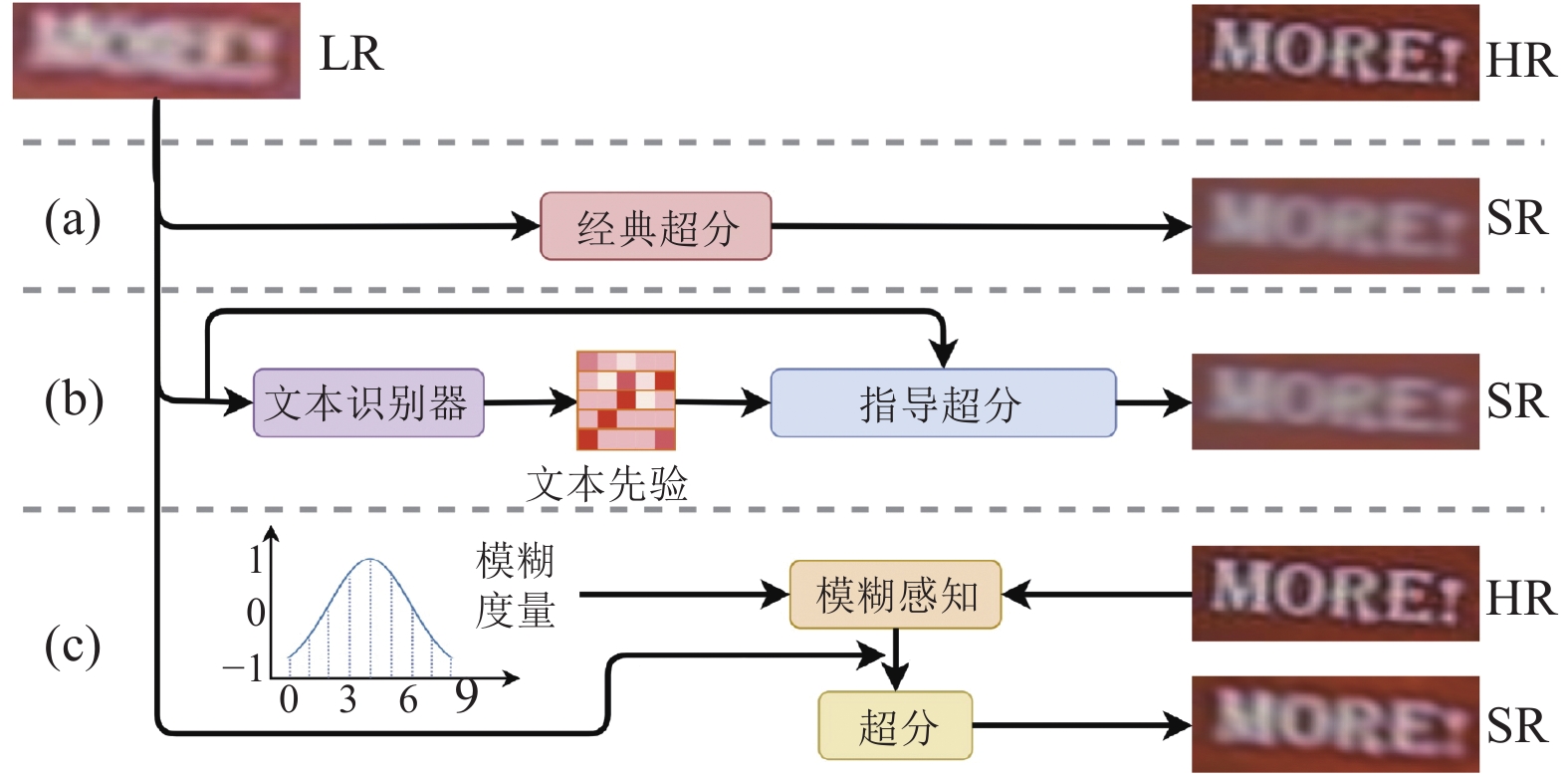

大多场景文本图像超分辨率方法将场景文本图像视为一般图像, 忽略了场景文本图像的文本先验信息. 如图1(b)所示, 尽管一些方法[5,6]提出引入额外的文本相关监督, 使得这些模型专注于图像中的文本区域, 但这些方法只试图学习从低分辨率(LR)图像到高分辨率(HR)图像的映射, 完全忽略了从HR到LR图像的模糊模式.

为此, 本文提出了模糊模式感知模块(blurring pattern aware module, BPAM), 从现有训练数据中的HR-LR文本图像对中学习真实世界的模糊模式. 采用本文提出的模糊模式感知模块将学习到的模糊模式转移到其他高分辨率图像中, 以生成更多符合真实场景下低分辨率模糊图像分布范式的HR-LR文本图像对供场景文本图像超分辨率模型进行训练, 这将极大地缓解训练数据短缺的问题, 并使场景文本图像超分辨率模型对真实世界的低分辨率文本图像更具鲁棒性与泛化性. 具体而言, 本文使用条件生成对抗性网络(conditional generative adversarial network, CGAN)[10]来构建模糊模式感知模块, 其中输入条件表示即将生成的低分辨率模糊图像的不同退化程度. 为了在训练阶段提供退化程度, 在TextZoom数据集中手动注释了低分辨率图像的退化程度. 本文提出的模糊模式感知模块仅在训练阶段与场景文本超分模型联合训练使用, 而不参与推理阶段. 因此在训练完成后, 可以在不增加文本超分模型推理开销的条件下, 显著地提升其性能. 本文使用两种图像质量指标(即SSIM和PSNR)和识别准确度来验证模糊模式感知模块的有效性. 实验结果表明, 当配备本文所提出的模块时, 现有场景文本图像超分辨率方法的性能可以获得明显提高. 具体地, 当配备所提出的BPAM模块时, TG[2]在CRNN文本识别器上的识别精度提高了5.8%.

|

图 1 与先前方法的对比 |

本文的主要贡献可以总结为如下3点.

(1)本文首次尝试从真实世界的高分辨率-低分辨率(HR-LR)场景文本图像对中学习模糊模式, 以便为场景文本图像超分辨率模型生成更多的训练样本, 进一步释放其生成能力.

(2)本文提出了模糊模式感知模块(BPAM)来学习真实世界场景文本图像中所蕴含的模糊模式, 并生成符合真实场景中低分辨率图像分布范式的模糊文本图像.

(3)本文在公开数据集TextZoom上验证了所提出的方法的有效性. 实验结果表明, 现有场景文本图像超分辨率模型配备本文提出的模糊模式感知模块时, 其性能可以进一步提高.

1 相关工作 1.1 场景文本图像超分辨率单图像超分辨率(single image super-resolution, SISR)的目的是从低分辨率图像重建高分辨率图像, 并保持高分辨率图像具有丰富的细节信息. 在早期的工作中, 研究人员结合了人工特征来提高重建图像的质量. 近年来, 基于深度学习的模型在SISR中发挥着重要作用. SRCNN模型[11]是深度学习在超分辨率重建领域的开山之作. EDSR[12]受到ResNet的启发, 采用了残差结构, 并且在标准的残差结构中去除了批量归一化层, 节省了内存空间的同时, 也避免了批量归一化所导致的对比度、色彩拉伸的问题. RDN[13]则是在EDSR的基础上, 进一步地扩大了网络的规模, 引入了密集残差块 (residual dense block, RDB)使得模型更加充分地获取局部特征信息和全局特征信息. 经典的RCAN[14]模型则是引入了通道注意力机制, 促进了特征在通道维度进行进一步融合, 提高重要的通道的权重, 舍弃不重要的通道的特征.

与SISR相比, 场景文本图像超分辨率更加侧重于利用图像中蕴含的文本语义信息. 因此, 基于场景文本识别器的识别准确度(recognition accuracy)是被用来评估场景文本图像超分辨率模型性能优劣的最重要指标. TPGSR[4]利用预先训练的场景文本识别算法获得字符概率序列作为文本先验, 并提出了一个文本先验引导的超分辨率框架来引导模型基于文本先验重构文本区域的细节. STT[5]引入了位置感知模块和内容感知模块, 使得场景文本图像超分辨率模型专注于图像的文本区域. PCAN[15]设计了一个并行的上下文注意力块, 以自适应地选择文本序列中的关键信息来指导模型生成文本图像. TG[2]通过预训练一个基于Transformer的文本识别器, 使用其注意力图获取笔画级别的监督来恢复图像中文本区域的笔画细节. TATT[6]通过基于Transformer的文本注意力网络提取文本语义, 以应对空间变形的文本图像. 此外, TATT提出了文本结构一致性损失, 通过在规则文本和变形文本的重建上施加结构一致性来细化视觉外观. C3-STISR[3]使用场景文本识别器的反馈、视觉和语言信息作为线索来引导模型生成更易识别的超分辨率文本图像, 其中语言信息由预先训练好的字符级语言模型进行直接生成.

1.2 场景文本识别场景文本识别(scene text recognition, STR)的目标是将场景文本图像转换为文本序列. 在过去的数年里, 涌现了许多基于深度学习的方法来解决场景文本识别问题. CRNN[16]结合卷积神经网络和循环神经网络作为编码器来提取文本序列特征. 在特征提取之后, 使用CTC损失函数(connectionist temporal classification loss)用于对齐预测文本序列和目标文本序列. 近年来, 基于注意力的文本识别方法取得了巨大的成功. MORAN[17]和ASTER[18]使用空间变换网络(spatial Transformer network, STN)来校正输入图像, 对于倾斜、弯曲的图像表现良好, 然后使用注意力机制来提高对空间变形文本的鲁棒性. 此外, 在SEED[19]中使用预先训练的FastText来学习文本语义信息. 尽管现有的场景文本识别算法已经取得了不错的性能, 但低分辨率的模糊文本图像仍然对场景文本识别提出了巨大的挑战, 直接将模糊图像输入场景文本识别模型, 往往难以获得令人满意的结果. 因此, 有必要设计一种超分辨率预处理器来提高文本图像的质量.

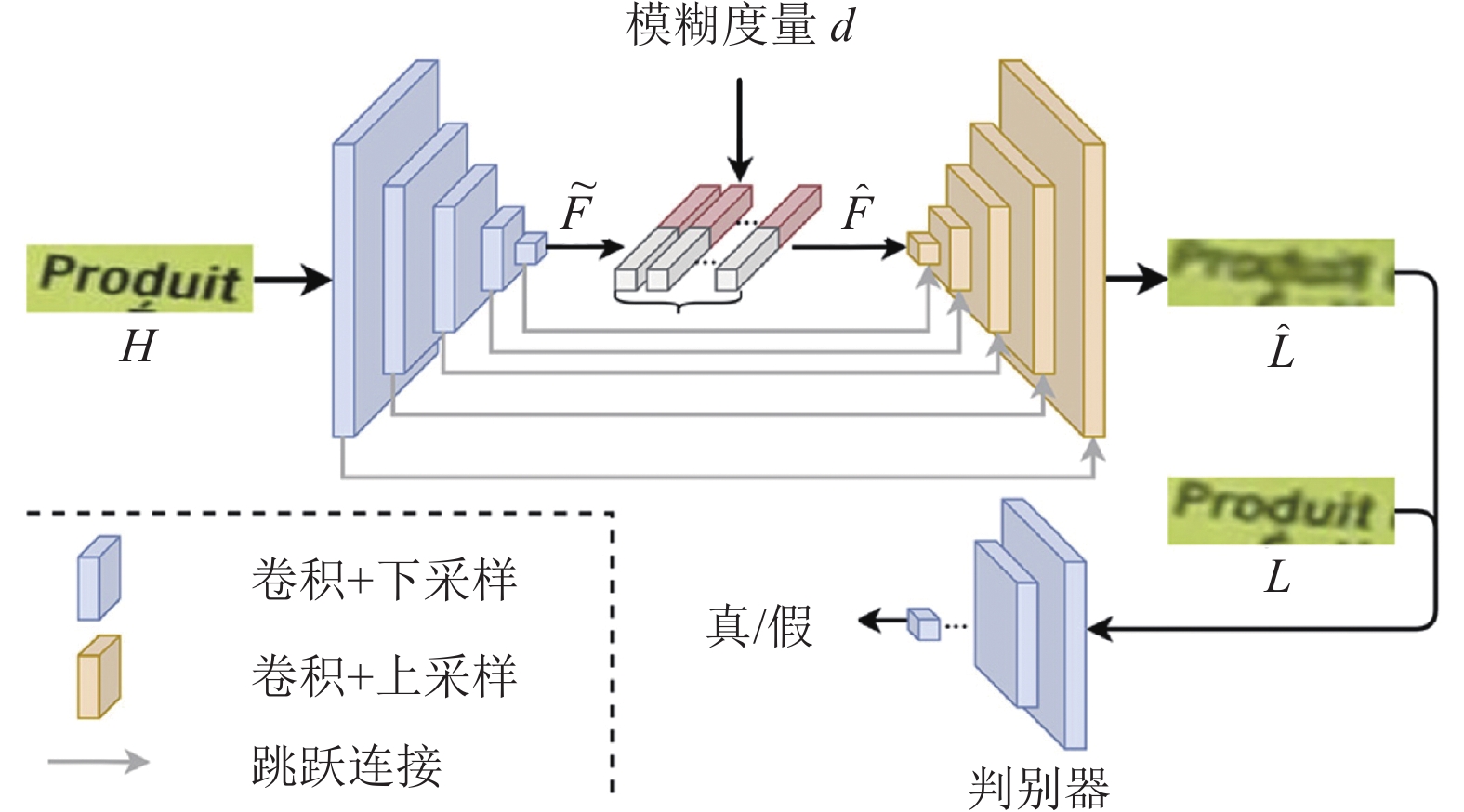

2 模型方法设计本文提出了基于模糊模式感知的场景文本图像超分辨率算法, 该方法的框架如图2所示. 模型主要由两个模块组成, 模糊模式感知模块(BPAM)和场景文本图像超分辨率模块. 基于条件生成对抗网络(CGAN)[10]的模糊模式感知模块包含生成器

在现实生活中, 可以发现相同分辨率的图像通常拥有着不同的模糊程度. 正如第3.1节中提到的TextZoom[1]数据集中测试集分为Easy、Medium、Hard这3个子集. 明显地, Hard子集中的数据样本的模糊程度远超Easy子集. 在一定程度上, 模糊程度决定了该低分辨率场景文本图像能否被识别. 此时, 能否正确地表示图像的模糊程度成为研究的重点.

|

图 2 模型整体网络图 |

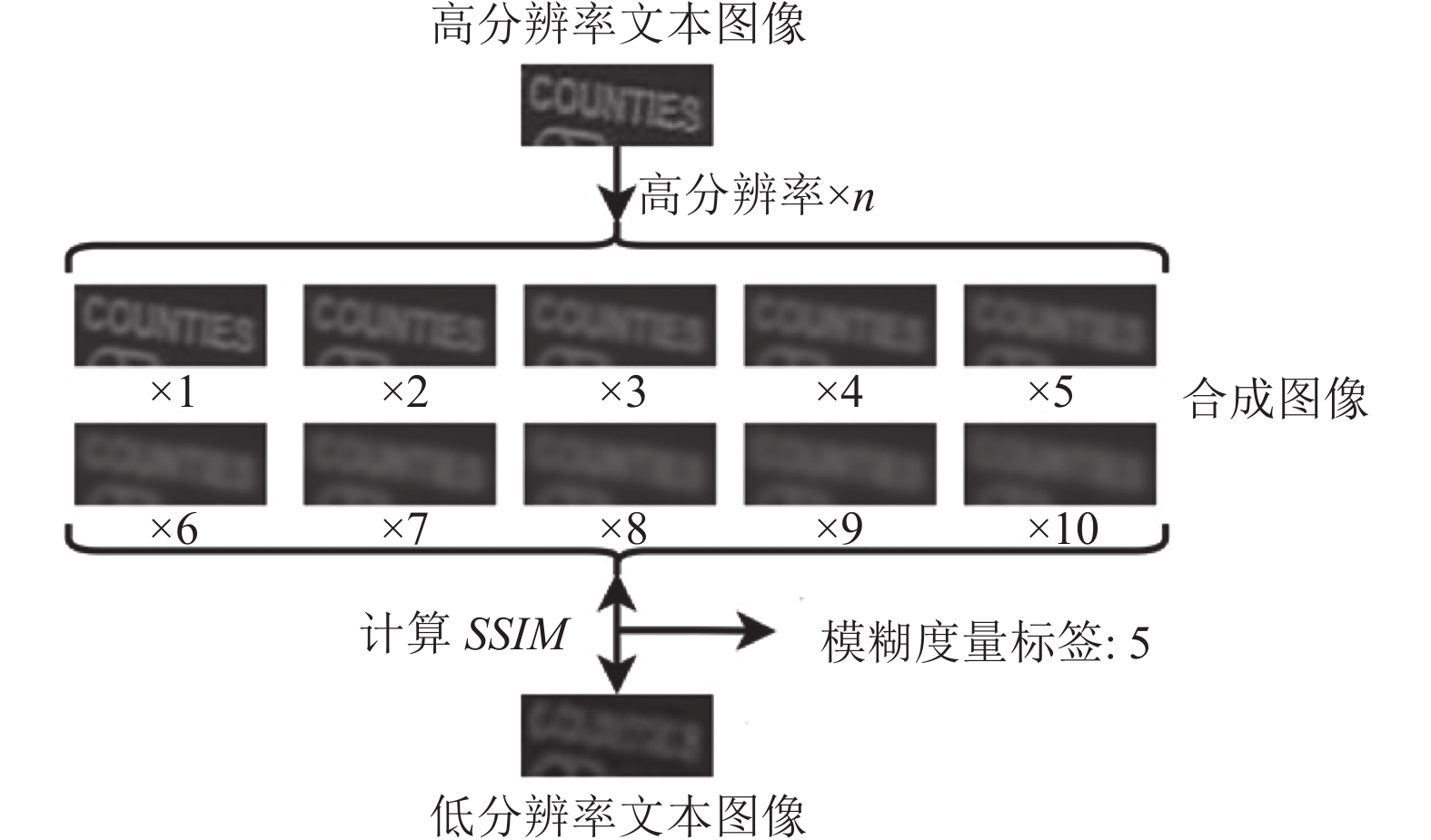

为了衡量图像的模糊程度, 本方法针对TextZoom数据集[1]进行重新设计. 将衡量图像的模糊程度的变量称为模糊度量(degradation degree), 同时, 模糊度量也是设计模糊模式感知模块所必不可少的一部分. 手动注释TextZoom训练集中具有相应退化程度的低分辨率文本图像, 退化程度共有10个级别, 范围为{0, 1, …, 9}.

具体地, 如图3所示, 对于TextZoom数据集中的高分辨率文本图像, 使用高斯模糊(模糊核大小设置为3)对其进行模糊处理, 共计10次. 模糊1次的图像标记为1, 模糊2次的图像标记为2, …, 模糊10次的图像标记为10. 然后通过计算真实低分辨率文本图像(TextZoom训练集中的低分辨率文本图像)与合成低分辨率图像之间的结构相似性(SSIM)度量:

| $ i = \arg \mathop {\max }\limits_j ({\textit{SSIM}}(L, L_j^\prime )),\;\;\;j = 0, 1, \cdots, 9 $ | (1) |

|

图 3 计算模糊度量的策略 |

选定与真实低分辨率文本图像具有最高SSIM的合成低分辨率图像的标记, 减1后, 作为真实低分辨率文本图像的模糊度量. 此外, 由于TextZoom数据集中的图像对存在像素点错位的问题, 需先挑选出SSIM计算值异常的图像对, 并一一对其进行人工位置矫正对齐, 以便获得正确的模糊度量值.

2.2 模糊模式感知模块模糊模式感知模块(BPAM)基于条件生成对抗网(conditional generative adversarial network, CGAN)[10]设计而成, 包含一个生成器(generator)和一个判别器(discriminator).

在CGAN中的生成器, 给定一个输入噪声

| $ \begin{split} {{\mathrm{min}} _G}{{\mathrm{max}} _D}V(D, G) = & {\mathbb{E}_{x\sim {p_{{\text{data }}}}(x)}}[\log D(x\mid y)] \\ & + {\mathbb{E}_{{\textit{z}}\sim {p_{\textit{z}}}({\textit{z}})}}[\log (1 - D(G({\textit{z}}\mid y)))] \end{split} $ | (2) |

模糊模式感知模块网络架构如图4所示. 将高分辨率场景文本图像

| $ \tilde F = {\text{tanh}}(F{W_d}) $ | (3) |

其中,

| $ F = \left[ {\begin{array}{*{20}{c}} {{\text{Concat}}({{\tilde F}_1}, d)} \\ {{\text{Concat}}({{\tilde F}_2}, d)} \\ {{\text{Concat}}({{\tilde F}_i}, d)} \\ {\vdots} \\ {{\text{Concat}}({{\tilde F}_K}, d)} \end{array}} \right] $ | (4) |

其中,

| $ \widehat F = {\text{ReLU}}({F^\prime }{W_u}) $ | (5) |

其中,

|

图 4 模糊模式感知模块详细网络图 |

基于条件对抗生成网络的模糊模式感知模块还需要判别器对生成图像与真实世界低分辨率图像进行识别, 其结构较为简单, 如表1所示, 经过3次卷积操作降低维度后使用全局平均池化进而将维度变为1, 判断输入图像的真伪, 1表示判别为真, 0则表示判别器判别为假. 最终希望生成器能够生成让判别器难辨真假的低分辨率场景文本图像.

2.3 训练策略本方法采用两阶段训练策略, 包括热身阶段(warm-up stage)与联合训练阶段(joint-training stage). 具体而言, 首先对模糊模式感知模块进行初步训练, 使其感知到不同的模糊模式, 并将one-hot模糊度量作为提示条件输入模糊模式感知模块. 然后, 通过协同训练模糊模式感知模块和场景文本图像超分辨率模块. 在此阶段, 使用平滑加权采样(smooth weighted sampling)采样模糊度量向量作为模糊模式感知模块的条件输入, 为场景文本图像超分辨率模块提供具有不同模糊模式的低分辨率文本图像.

| 表 1 判别器D的参数设置 |

2.4 损失函数

整体的损失函数设计包含3个部分: 像素均方误差损失、对抗损失、超分辨率模块损失.

(1) 像素均方误差损失

| $ {\mathcal{L}_{{\rm{lr}}}} = \left\| {L - \widehat L} \right\|_2^2 $ | (6) |

其中,

(2) 对抗损失

| $ {\mathcal{L}_{{\rm{GAN}}}} = \frac{1}{N}\sum\limits_{n = 1}^N {\log } D({L_n}) + \frac{1}{N}\sum\limits_{n = 1}^N {\log } (1 - D(G({H_n}))) $ | (7) |

其中,

(3) 超分辨率模块损失

于是, 完整的损失函数

| $ \mathcal{L}=\left\{\begin{array}{ll}{\mathcal{L}}_{{\rm{lr}}}+\lambda \underset{G}{\mathrm{min}}\underset{D}{\mathrm{max}}{\mathcal{L}}_{{\rm{GAN}}}, & 启动阶段 \\ {\mathcal{L}}_{{\rm{sr}}}+\lambda \underset{G}{\mathrm{min}}\underset{D}{\mathrm{max}}{\mathcal{L}}_{{\rm{GAN}}}, & 联合训练阶段 \end{array} \right.$ | (8) |

其中,

本节中, 首先介绍本文训练以及测试使用的数据集, 随后介绍评价指标以及具体的实验设置细节, 最后再详细分析实验结果.

3.1 数据集本文主要对广泛使用的场景文本图像超分辨率数据集TextZoom[1]进行训练和评估. TextZoom中的部分示例如图5所示. 此外, 使用合成场景文本识别数据集SynthText进行预训练, 并使用3个场景文本识别基准数据集(IC15、IC13和CUTE80)来评估所提出方法的有效性. 在下文中, 较详细地介绍上述5个数据集.

|

图 5 TextZoom测试子集样例 |

(1) TextZoom. TextZoom数据集[1]是从RealSR和SR-RAW两个数据集中收集而来. TextZoom数据集包含训练集与测试集两部分, 其中训练集17367对图像及文本标签, 测试集拥有4373对图像及文本标签. 相机拍摄时的焦距一般决定了拍摄图像的清晰度. 如图所示, Wang等人[1]基于焦距的长短将测试集划分成3个不同难度的测试子集, 其中Easy测试子集包含1619对数据, Medium测试子集包含1411对数据, Hard测试子集包含1343对数据. 可以看到相比Easy测试子集. HR图像的大小调整为

(2) SynthText. 在场景文本识别领域, SynthText数据集是最常用的合成文本图像数据集之一, 该数据集包含大约7200000张利用自然场景图像与标准字体合成的文本图像. 通常SynthText数据集用于文本识别模型的预训练过程中.

(3) IC13. IC13数据集(全称ICDAR13)是由ICDAR在2013年比赛中公开的数据集, 其中训练集包括848张图像, 而测试集包括1095张图像. 部分图像中拥有特殊字符, 因本文中方法不涉及特殊字符, 故将其删除, 最终测试集包括1015张图像.

(4) IC15. IC15数据集(全称ICDAR15)是由ICDAR在2015年比赛中公开的数据集, 其中训练集包括4468张图像, 而测试集包括2077张图像. 该数据集较难, 包含大量不规则文本图像, 如斜向文本、弯曲文本以及带有仿射变换的文本图像等.

(5) CT80. CT80数据集(全称CUTE80)包含288张测试使用的文本图像, 文本图像大多为包含不规则文本的高分辨率图像, 难度较高.

3.2 评价指标在超分辨率图像的质量方面, 本文使用峰值信噪比(PSNR)和结构相似性指标(SSIM)来评估. 与单图像超分辨率任务不同, 场景文本图像超分辨率更关注文本区域是否变得更清晰、更容易识别. 因此, 识别准确率被用作衡量模型性能的最重要指标. 本文遵循以前的方法[1–6]进行公平比较.

3.3 训练设置本文方法使用PyTorch实现. 本文中的所有实验都是在12 GB内存的NVIDIA 2080Ti GPU上进行的. Batch大小设置为16. 联合训练之前, 在TextZoom[1]中训练50个epoch, 为模糊模式感知模块预热. 在联合训练阶段中, 将学习率设置为场景文本图像超分辨率模型原始学习率的1/10. 本文使用4种SOTA方法(TATT[6]、TPGSR[4]、C3-STISR[3]和TG[2])作为基线模型. 我们使用了6种场景文本识别方法, 包括CRNN[16]、MORAN[17]、ASTER[18]、AutoSTR[20]、SEED[19]和ABINet[21], 来评估识别的准确性, 并使用他们的官方PyTorch代码和发布的预训练模型.

3.4 超参数选择实验本节讨论关于超参数选择的实验, 方便选取能够发挥模型最佳性能的参数.

首先是关于损失函数的超参数

|

表 2 关于超参数 |

在第2.2节中, 高分辨率文本图像输入模糊模式感知模块, 经过5次的降维处理后, 在进行模糊度量的特征融合之前进行了特征的压缩操作, 而其压缩后的特征维度是可选的. 过低的维度容易导致特征包含的内容丢失; 而过大的维度则增加了模型的参数, 同时使得模糊度量特征所占的比重过低, 影响其发挥该有的能力, 难以获得更优的效果. 如表3所示, 实验选择

|

表 3 关于超参数 |

3.5 文本识别数据集实验

本文还在3个文本识别基准数据集上进行了实验(即IC13、IC15和CT80), 以验证本文提出的模糊模式感知模块的有效性. 按照前面的方法[5], 我们通过从3个基准数据集中选择低分辨率图像重新构建测试数据集.

本文从3个基准数据集中挑选361张低分辨率图像, 其中79张来自IC13, 216张来自IC15, 66张来自CT80, 并将所选图像的尺寸调整为

在本节中, 使用目前的4个SOTA方法(TATT[6]、TPGSR[4] 、C3-STISR[3]以及TG[2])作为基准模型. 使用3个场景文本识别模型(CRNN[16]、MORAN[17] 、ASTER[18])从识别率衡量场景文本超分辨率模型的重建质量. 此外, AutoSTR[20]、SEED[19]以及ABINet[21]作为补充, 进一步比较模型的性能.

| 表 4 在场景文本识别基准数据集上的比较实验 (%) |

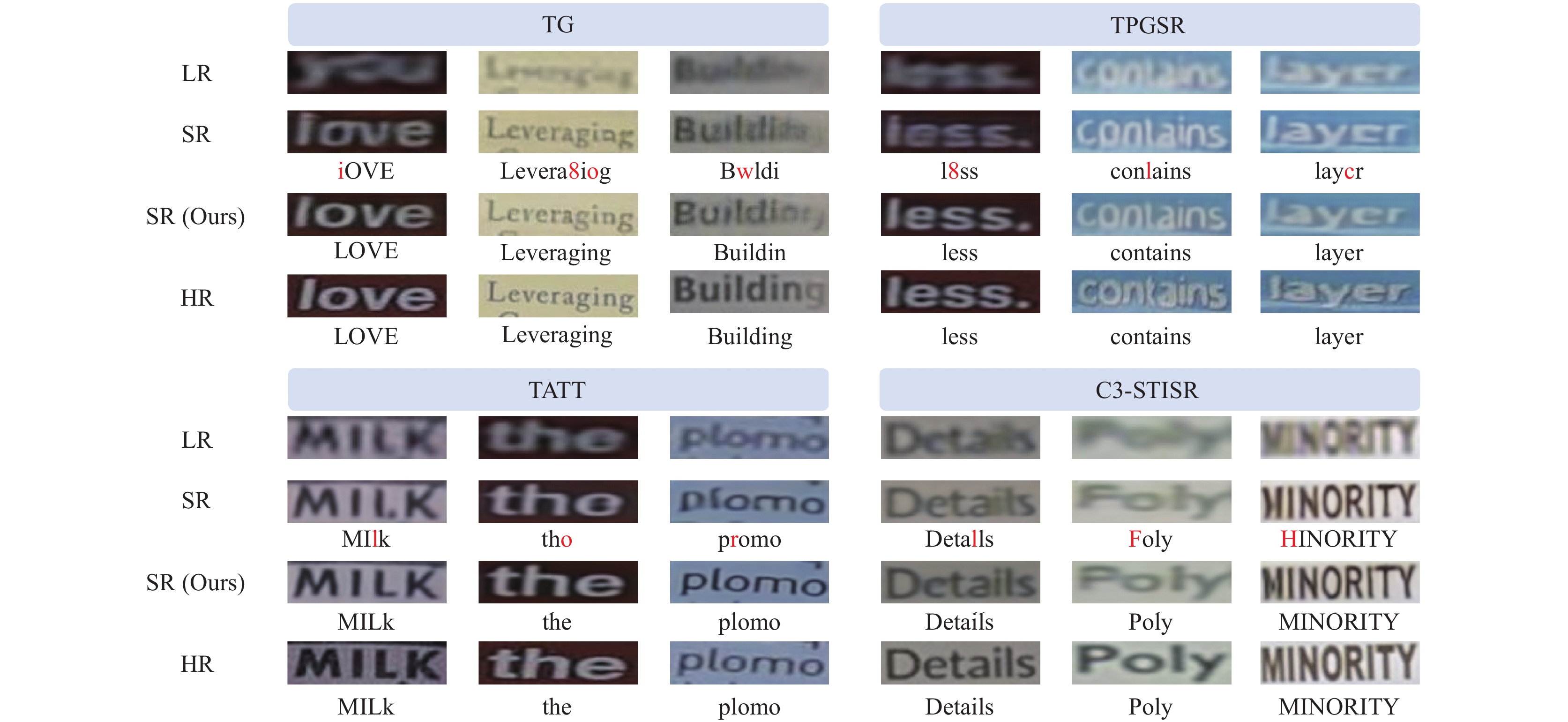

现有的场景文本超分辨率任务以TextZoom数据集为最重要的测试数据集, 因此本节的对比实验也聚焦于该数据集. 如表5所示, 详细对比了低分辨率文本图像(LR)、高分辨率文本图像(HR)以及场景文本图像超分辨率模型(TATT、TPGSR、C3-STISR和TG)在6个场景文本识别模型(CRNN 、MORAN 、ASTER、AutoSTR、SEED以及ABINet)的表现, 并且对于是否使用模糊模式感知模块(BPAM)进行了两遍实验, 共计72个实验, 使用相关论文GitHub库的官方代码, 重新实现并训练. 综合Easy、Medium、Hard这3个子数据集以及总体平均识别准确率(average recognition accuracy)上的表现, 在使用BPAM模块后, 模型的性能普遍获得了明显提升. 例如, 相比基线(baseline)模型, 使用CRNN、MORAN和ASTER识别模型进行评估, 在配备本文所提出的模糊模式感知模块后, SOTA方法TG实现了5.8%、4.3%和3.6%的提升, 远比SOTA模型(TATT、TG等)之间的差距来得巨大. 另外, 在更多的模型(如AutoSTR、SEED、ABINet)上, BPAM模块表现依然突出.

可视化结果如图6所示. 与基线模型相比, 它们可以在BPAM的帮助下恢复更多文本区域的细节. 由于BPAM可以为STISR模型生成具有真实世界模糊的LR图像, 因此可以显著提高它们的鲁棒性.

3.7 关于数据增强的比较实验超分辨率任务的现有增强策略依赖于人工模糊核, 导致生成的图像和真实世界的图像之间存在明显的数据域差异. 与现有的数据增强不同, 本文提出的BPAM使用现有的HR-LR文本图像对来学习真实场景中的模糊模式, 并将学习到的模糊模式转移到其他HR图像上, 以生成与真实场景相似的LR图像. 为了验证所提出的BPAM相对于以前的数据增强方法的优越性, 本文进行了相应的实验. 具体地, 利用中值模糊、高斯模糊、归一化模糊和运动模糊来增强TextZoom的训练数据集. 如表6所示, 当使用数据增强策略时, 基线模型的性能略有提高, 这是由于人工模糊图像和真实世界的LR图像之间存在明显的域差异. 相反, 本文提出的BPAM模块可以显著提高现有方法的性能.

| 表 5 在TextZoom数据集上的对比实验 (%) |

|

图 6 可视化结果展示 |

| 表 6 使用CRNN[16]评估数据增强的比较实验 (%) |

本文继续探究在更多训练数据上模型的表现. TextZoom只有17367个训练样本, 这对于现有的基于深度学习的场景文本图像超分辨率模型来说是不够的. 我们试图通过引入SynthText来扩大训练数据的规模, 进一步提高场景文本超分辨率模型的性能. 如表6最后一行(TG+BPAM+Syn)结果所示, 在联合训练阶段使用更多的数据可以进一步提高我们方法的性能.

4 讨论 4.1 模糊度量采样策略在联合训练阶段, 需要对随机退化程度进行采样, 以提示模糊模式感知模块生成相应的LR图像. 为此进行了实验, 以选择合适的采样方法. 具体来说, 我们探索了3种采样方法: 1)一次热采样, 2)平滑加权采样, 3)随机高斯采样. 此外, 我们尝试对每个退化程度进行随机高斯采样, 作为BPAM的条件. 表7中的实验结果表明, 平滑加权采样实现了最佳性能. 一个可能的原因是, 通过平滑加权采样方法采样的退化程度矢量与预热阶段的退化程度向量相似, 同时保持采样的多样性.

| 表 7 使用CRNN[16]评估采样方法的比较实验 (%) |

4.2 时间效率

以场景文本超分模型TG[2]为例, 结果如表8所示, 在训练阶段, 相比原TG模型, 装备BPAM模块的TG模型训练一个epoch所花费的时间增加了10%左右; 推理阶段, 则取得相近的速度. 增加的少许训练开销对于明显的模型性能提升而言是值得的.

| 表 8 关于训练和推理的时间效率实验 |

4.3 失败样例

TextZoom[1]中的一些失败样例如图7所示. 根据可视化结果, 我们观察到所提出的方法在处理长文本的低分辨率图像时仍然存在困难. 此外, 低分辨率模糊图像中的艺术字体也是一个巨大的挑战, 因为在TextZoom的训练集中艺术字体的样本很少.

|

图 7 TextZoom数据集中的一些失败样例 |

5 总结

本文提出了基于条件生成对抗网络的模糊模式感知模块(BPAM). 为了训练基于CGAN[10]的模型, 我们在TextZoom[1]的训练数据集中手动注释每个低分辨率图像的退化程度. 在联合训练阶段, 对不同退化程度进行采样, 为场景文本超分辨率模型生成相应的低分辨率图像, 增强了其对真实世界低分辨率图像的鲁棒性. 实验表明, 本文提出的模糊模式感知模块可以显著提高现有SOTA场景文本图像超分辨率模型的性能, 同时在推理中不引入额外的时间成本.

| [1] |

Wang WJ, Xie EZ, Liu XB, et al. Scene text image super-resolution in the wild. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 650–666.

|

| [2] |

Chen JY, Yu HY, Ma JQ, et al. Text gestalt: Stroke-aware scene text image super-resolution. Proceedings of the 36th AAAI Conference on Artificial Intelligence. AAAI, 2022. 285–293.

|

| [3] |

Zhao MY, Wang M, Bai F, et al. C3-STISR: Scene text image super-resolution with triple clues. Proceedings of the 31st International Joint Conference on Artificial Intelligence. Vienna: IJCAI, 2022. 1707–1713.

|

| [4] |

Ma JQ, Guo S, Zhang L. Text prior guided scene text image super-resolution. IEEE Transactions on Image Processing, 2023, 32: 1341-1353. DOI:10.1109/TIP.2023.3237002 |

| [5] |

Chen JY, Li B, Xue XY. Scene text telescope: Text-focused scene image super-resolution. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 12021–12030.

|

| [6] |

Ma JQ, Liang ZT, Zhang L. A text attention network for spatial deformation robust scene text image super-resolution. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 5901–5910.

|

| [7] |

Pandey RK, Vignesh K, Ramakrishnan AG, et al. Binary document image super resolution for improved readability and OCR performance. arXiv:1812.02475, 2018.

|

| [8] |

Xu XY, Sun DQ, Pan JS, et al. Learning to super-resolve blurry face and text images. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 251–260.

|

| [9] |

Mou YQ, Tan L, Yang H, et al. PlugNet: Degradation aware scene text recognition supervised by a pluggable super-resolution unit. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 158–174.

|

| [10] |

Mirza M, Osindero S. Conditional generative adversarial nets. arXiv:1411.1784, 2014.

|

| [11] |

Dong C, Loy CC, He KM, et al. Learning a deep convolutional network for image super-resolution. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 184–199.

|

| [12] |

Lim B, Son S, Kim H, et al. Enhanced deep residual networks for single image super-resolution. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu: IEEE, 2017. 1132–1140.

|

| [13] |

Zhang YL, Tian YP, Kong Y, et al. Residual dense network for image super-resolution. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 2472–2481.

|

| [14] |

Zhang YL, Li KP, Li K, et al. Image super-resolution using very deep residual channel attention networks. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 294–310.

|

| [15] |

Zhao CR, Feng SY, Zhao BN, et al. Scene text image super-resolution via parallelly contextual attention network. Proceedings of the 29th ACM International Conference on Multimedia. ACM, 2021. 2908–2917.

|

| [16] |

Shi BG, Bai X, Yao C. An end-to-end trainable neural network for image-based sequence recognition and its application to scene text recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(11): 2298-2304. DOI:10.1109/TPAMI.2016.2646371 |

| [17] |

Luo CJ, Jin LW, Sun ZH. MORAN: A multi-object rectified attention network for scene text recognition. Pattern Recognition, 2019, 90: 109-118. DOI:10.1016/j.patcog.2019.01.020 |

| [18] |

Shi BG, Yang MK, Wang XG, et al. ASTER: An attentional scene text recognizer with flexible rectification. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(9): 2035-2048. DOI:10.1109/TPAMI.2018.2848939 |

| [19] |

Qiao Z, Zhou Y, Yang DB, et al. SEED: Semantics enhanced encoder-decoder framework for scene text recognition. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 13525–13534s.

|

| [20] |

Zhang H, Yao QM, Yang MK, et al. AutoSTR: Efficient backbone search for scene text recognition. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 751–767.

|

| [21] |

Fang SC, Xie HT, Wang YX, et al. Read like humans: Autonomous, bidirectional and iterative language modeling for scene text recognition. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 7094–7103.

|

2024, Vol. 33

2024, Vol. 33