随着5G网络技术的蓬勃发展以及智能移动设备的迅速普及, 各类计算密集型和延迟敏感型任务大量涌现, 如高清视频传输、增强现实(AR)/虚拟现实(VR)应用, 实时在线游戏等[1]. 用户对高速的移动通信和计算服务的需求不断增加, 他们期望能够在移动环境下获得与传统有线网络不相上下的数据传输速度和低延迟的计算体验. 但是, 传统的蜂窝网络和中心化的云计算模式已经难以满足这些需求[2]. 蜂窝网络在高密度区域和热点区域往往面临频谱资源紧张、干扰加剧等问题, 难以实现高速率和低延迟的要求; 中心化的云计算模式由于数据传输和处理需要通过远程的数据中心, 可能导致较长的数据传输延迟和网络拥塞现象.

5G通信技术的逐步商用推广将为我们带来前所未有的高速数据传输. 超密集网络作为5G网络的重要组成部分, 可以缓解频谱资源有限性的问题, 有效地提高网络容量和覆盖范围. 通过大规模部署小基站、提高网络密度和减小用户设备与接入点之间的距离, 提供更加稳定和高速的通信服务, 进一步满足海量移动设备的接入以及高效通信的需求[3]. 边缘计算中的任务卸载技术则是5G时代的一项重要技术. 通过将计算任务卸载到放置在网络边缘的服务器上, 可以实现更低的时延和更好的用户体验. 此外, 边缘计算还可以减轻核心网络的负担, 降低数据传输时延, 提高网络整体性能[4]. 然而, 在学校、商场等任务密集区域, 超密集网络中的同信道干扰也会随之增加, 如何合理地分配频谱资源, 优化移动设备的发射功率, 有效降低系统的信道干扰, 进而降低任务卸载过程中的时延和能耗是近年来研究的热点. 一些研究者将自适应遗传算法与粒子群算法相结合, 设计了一种频谱资源管理的节能机制[5]. 还有一些研究者提出迭代搜索的任务卸载方案, 联合优化计算资源的分配和发射功率调控过程, 以最小化任务处理的时延和能耗[6]. 在边缘服务器和基站同时密集部署的情况下, 引入牛顿内点法和遗传算法来优化资源调度问题, 达到最小化任务处理的时延和能耗的目的[7].

现有的方案大多基于全局信息集中进行频谱资源的分配以及发射功率的调控, 全局信息的获取以及全局决策的制定困难, 会浪费大量的时间[8–10]. 其次, 当任务有时延约束时, 要保证任务的传输时间小于任务的截止时间.

针对以上问题, 本文设计了超密集网络融合边缘计算的场景, 其中多个小基站密集部署在宏基站的覆盖范围内, 移动设备随机部署在基站覆盖范围内. 移动设备随机请求任务, 通过超密集网络结构将任务卸载到基站进行处理. 本文引入博弈论模型, 将频谱资源分配和发射功率调控问题转化为小基站间的博弈过程, 通过不断迭代优化, 提高最优策略的选择概率, 最终使得结果收敛至纳什均衡. 通过仿真实验, 证明了该策略在降低任务传输过程中的时延和能耗, 提高任务传输成功率方面的有效性.

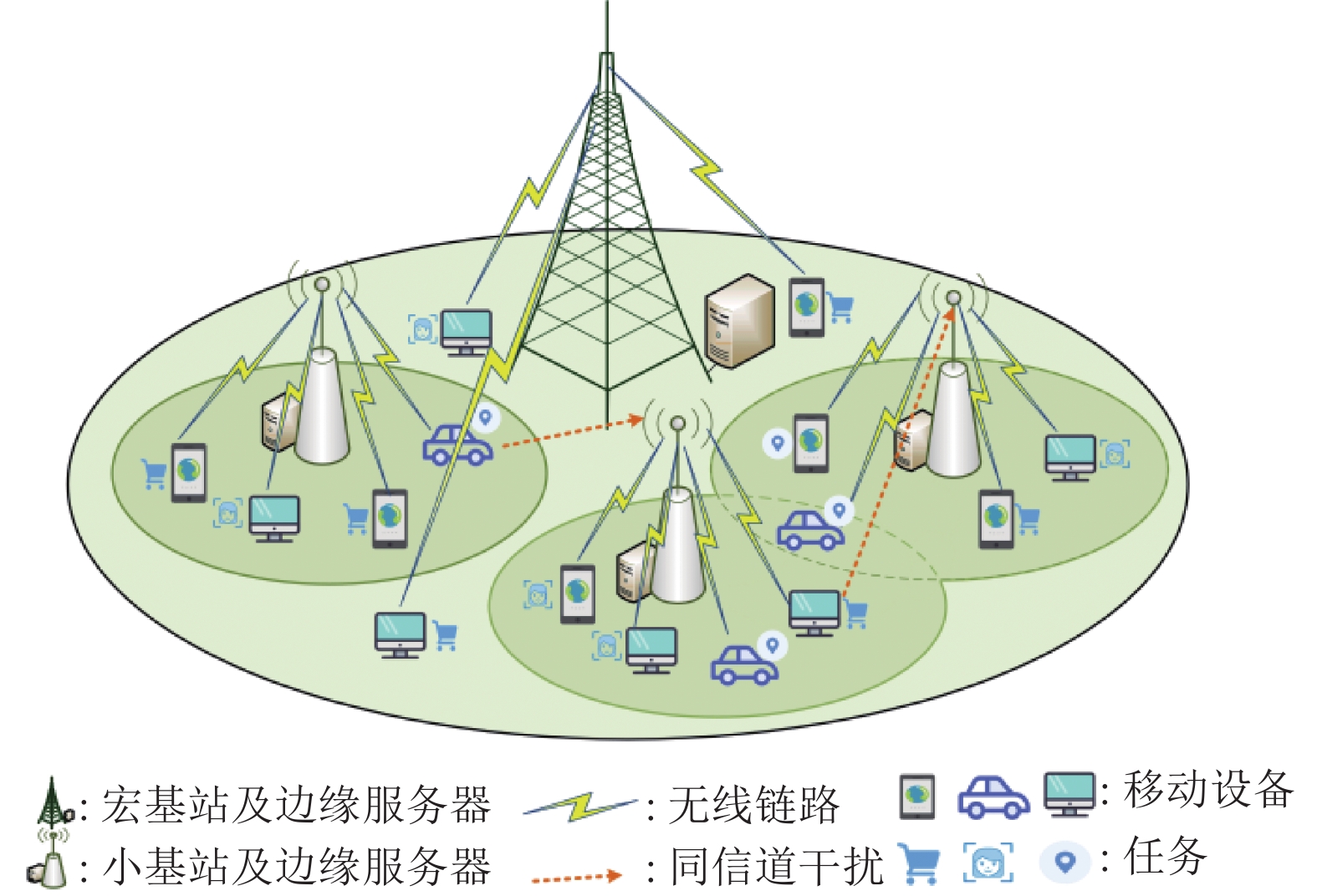

1 系统模型本节我们考虑了一个超密集网络融合边缘计算的场景, 如图1所示, 其由一个宏基站和S个小基站构成. 在宏基站的覆盖范围内, 随机部署U个移动设备. 移动设备将自己产生的任务通过超密集网络中的无线链路上传到基站进行处理. 下面对任务的传输过程进行系统建模, 并提出本文的优化目标.

|

图 1 超密集网络场景图 |

1.1 通信模型

在本文中, 采用了正交频分多址技术[11]将可用的基站频谱资源F划分为多个互相正交的子信道, 以供不同的用户进行数据传输, 有效提高了频谱利用率. 为了减少信道之间的干扰, 首先将整个频谱资源F划分为两部分, 分别为

移动设备产生任务时将任务卸载到边缘服务器时, 其通信过程如下: 基站会在其频谱资源中获取空闲信道信息, 将空闲的子信道资源分配给该移动设备, 移动设备获取到信道资源时, 调节自己的发射功率, 将任务通过无线信道发送给边缘服务器进行处理, 边缘服务器处理完成后, 将处理的结果发送给移动设备, 由于结果的数据量很小, 我们在设计通信模型时, 忽略了结果发送的时间. 在本文中, 我们优化的就是基站的子信道资源分配和移动设备上传任务时的发射功率.

用集合

| $ {r_{u, 0}} = \frac{{\displaystyle\sum\limits_{k \in {{\boldsymbol{K}}_{{0}}}} {x_{u, 0}^k{p_{u, 0}}{{({g_{u, 0}})}^2}d_{u, 0}^{ - \alpha }} }}{{{\sigma ^2}}}\;\; $ | (1) |

其中,

根据香农公式, 移动设备u与宏基站之间的数据上传速率可以写为[14]:

| $ {R_{u, 0}} = B\log (1 + {r_{u, 0}}) $ | (2) |

其中,

当移动设备与小基站进行数据传输时, 由于小基站之间共用频谱资源, 所以当多个用户同时使用相同信道进行数据传输时, 可能会产生同信道干扰. 所以移动设备u与小基站s进行通信时, 信噪比可以表示为:

| $ {r_{u, s}} = \frac{{\displaystyle\sum\limits_{k \in {{\boldsymbol{K}}_{{s}}}} {x_{u, s}^k{p_{u, s}}{{({g_{u, s}})}^2}d_{u, s}^{ - \alpha }} }}{{{\sigma ^2} + \displaystyle\sum\limits_{k \in {{\boldsymbol{K}}_{{s}}}} {x_{u, s}^k} \displaystyle\sum\limits_{\{ i \in {\boldsymbol{U}}, j \in {\boldsymbol{S}}\} \backslash \{ i = u, j = s\} } {x_{{\text{i}}, j}^k{p_{i, j}}{{({g_{i, j}})}^2}d_{i, s}^{ - \alpha }} }} $ | (3) |

其中,

| $ {R_{u, s}} = B\log (1 + {r_{u, s}}) $ | (4) |

因此, 当移动设备u将任务数据传输到基站s时, 时延和能耗可以表示为:

| $ {T_{u, s}} = \frac{{{L_u}}}{{\displaystyle\sum\limits_{s \in {\boldsymbol{S}}} {{b_{u, s}}{R_{u, s}}} }} $ | (5) |

| $ {E_{u, s}} = {p_u}{T_{u, s}} $ | (6) |

当

经过上述分析, 我们知道, 在实际的超密集网络和边缘计算融合场景中, 频谱资源和移动设备的能源是宝贵且有限的资源. 随着移动通信用户数量的不断增加以及对高速数据传输的需求不断上升, 如何有效地利用有限的频谱资源和减少移动设备的能量消耗, 成为了至关重要的问题. 另外, 由于超密集网络中存在信道干扰的问题, 有效降低任务传输过程中的同信道干扰, 保证数据传输的成功率, 也直接关系到任务传输过程的性能. 基于上述模型, 本文将任务数据传输过程中时延和能耗最小化问题建模为混合整数非线性规划问题, 意在优化无线传输过程中子信道分配和发射功率调控问题, 最终达到降低任务数据传输时延和能耗加权和, 并且提高任务传输成功率的目的. 优化问题可以表述为:

| $ \left\{\begin{split} & {\text{P1}}:\mathop {\min }\limits_{{\boldsymbol{X, P}}} \sum\limits_{s \in {\boldsymbol{S}}} {\sum\limits_{u \in {\boldsymbol{U}}} {{\omega _u}\frac{{{E_{u, s}}}}{{\overline E }}} } + (1 - {\omega _u})\frac{{{T_{u, s}}}}{{\overline T }} \\ & {\text{s}}{\text{.t. }} \left\{\begin{split} &{\text{C1: }}{T_{u, s}} \leqslant D_u^{\max }, \forall u \in {\boldsymbol{U}}\\ & {\text{C2: 0}} \leqslant {p_{u, s}} \leqslant {P_{\max }}, \forall u \in {\boldsymbol{U}}, s \in {\boldsymbol{S}} \\ & {\text{C3: }}x_{u, s}^k \in \{ 0, 1\} , \forall k \in {\boldsymbol{K}}, u \in {\boldsymbol{U}}, s \in {\boldsymbol{S}}\\ & {\text{C4: }}\sum\limits_{{{u}} \in {\boldsymbol{U}}} {x_{u, s}^k} \leqslant 1, \forall k \in {\boldsymbol{K}}, s \in {\boldsymbol{S}} \\ & {\text{C5: }}{r_{u, s}} \geqslant {{\textit{SINR}}_{\min }}, \forall u \in {\boldsymbol{U}}, s \in {\boldsymbol{S}} \end{split}\right. \end{split} \right.$ | (7) |

其中,

基于以上提出的问题, 我们首先确定每个移动设备的卸载基站, 每个基站针对卸载到其的移动设备分布式优化其无线资源管理策略. 针对要卸载到宏基站的移动设备, 我们提出基于迭代的方法优化其无线资源管理策略; 针对卸载到小基站的移动设备, 由于存在多个移动设备需要共享有限的频谱资源的情况, 这涉及到多方之间的竞争和协作. 博弈论能够帮助建模和分析不同用户之间的竞争行为, 以及他们可能采取的策略, 从而更好地理解多方之间的相互影响和冲突. 此外, 博弈论能够帮忙应对无线通信系统动态变化的环境, 使系统能够更加灵活地适应系统中用户数量、数据需求、信道质量等因素的变化. 因此, 本文引入博弈论[15]的算法, 提出一种基于奖励驱动的策略选择算法(reward-based driven strategy selection algorithm, RDSS)优化多个小基站博弈下的子信道分配和发射功率调控策略.

2.1 移动设备卸载基站的确定在本文中, 我们以每个基站作为一个控制中心, 控制卸载到其的移动设备进行子信道分配以及发射功率的调控. 我们规定移动设备的划分依据为当一个移动设备未处在小基站覆盖范围内, 我们规定它将任务卸载到宏基站; 当一个移动设备处于一个小基站的覆盖范围内时, 我们规定它将任务卸载到该小基站; 当一个移动设备处在2个及以上小基站的覆盖范围内时, 默认它将任务卸载其距离最近的小基站. 我们可以将所有的移动设备表示为

针对宏基站, 由于宏基站独立使用一部分频谱资源, 其不存在信道干扰. 所以宏基站下每个移动设备的无线资源管理策略是相对独立的. 在本文中, 对于宏基站下的用户我们随机分配信道资源, 在信道资源确定的情况下, 优化发射功率的调控, 基于问题P1, 宏基站的发射功率优化模型可以进一步写成:

| $ \left\{\begin{split} & {\text{P2}}:\mathop {\min }\limits_{\boldsymbol{P}} \sum\limits_{u \in {{\boldsymbol{U}}_{{0}}}} {{\omega _u}\frac{{{E_{u, 0}}}}{{\overline E }} + (1 - {\omega _u})} \frac{{{T_{u, 0}}}}{{\overline T }}\\ & {\text{s}}{\text{.t. }}\left\{\begin{split} &{\text{C1: }}{T_{u, 0}} \leqslant D_u^{\max }, \forall u \in {{\boldsymbol{U}}_0}\\ &{\text{C2: 0}} \leqslant {p_{u, 0}} \leqslant {P_{\max }}, \forall u \in {{\boldsymbol{U}}_0} \\ &{\text{C5: }}{r_{u, 0}} \geqslant {{\textit{SINR}}_{\min }}, \forall u \in {{\boldsymbol{U}}_0} \end{split}\right. \end{split} \right.$ | (8) |

结合约束C1、C2、C5, 针对每一个移动设备u,

| $ \max \left(\frac{{{{\textit{SINR}}_{\min }} \cdot {\sigma ^2}}}{{{{({g_{u, 0}})}^2}d_{u, 0}^{ - \alpha }}}, \dfrac{{{2^{\frac{{{L_u}}}{{D_u^{\max } \cdot B}}}} \cdot {\sigma ^2} - {\sigma ^2}}}{{{{({g_{u, 0}})}^2}d_{u, 0}^{ - \alpha }}}\right) \leqslant {p_{u, 0}} \leqslant {P_{\max }} $ |

我们进一步将发射功率离散化为

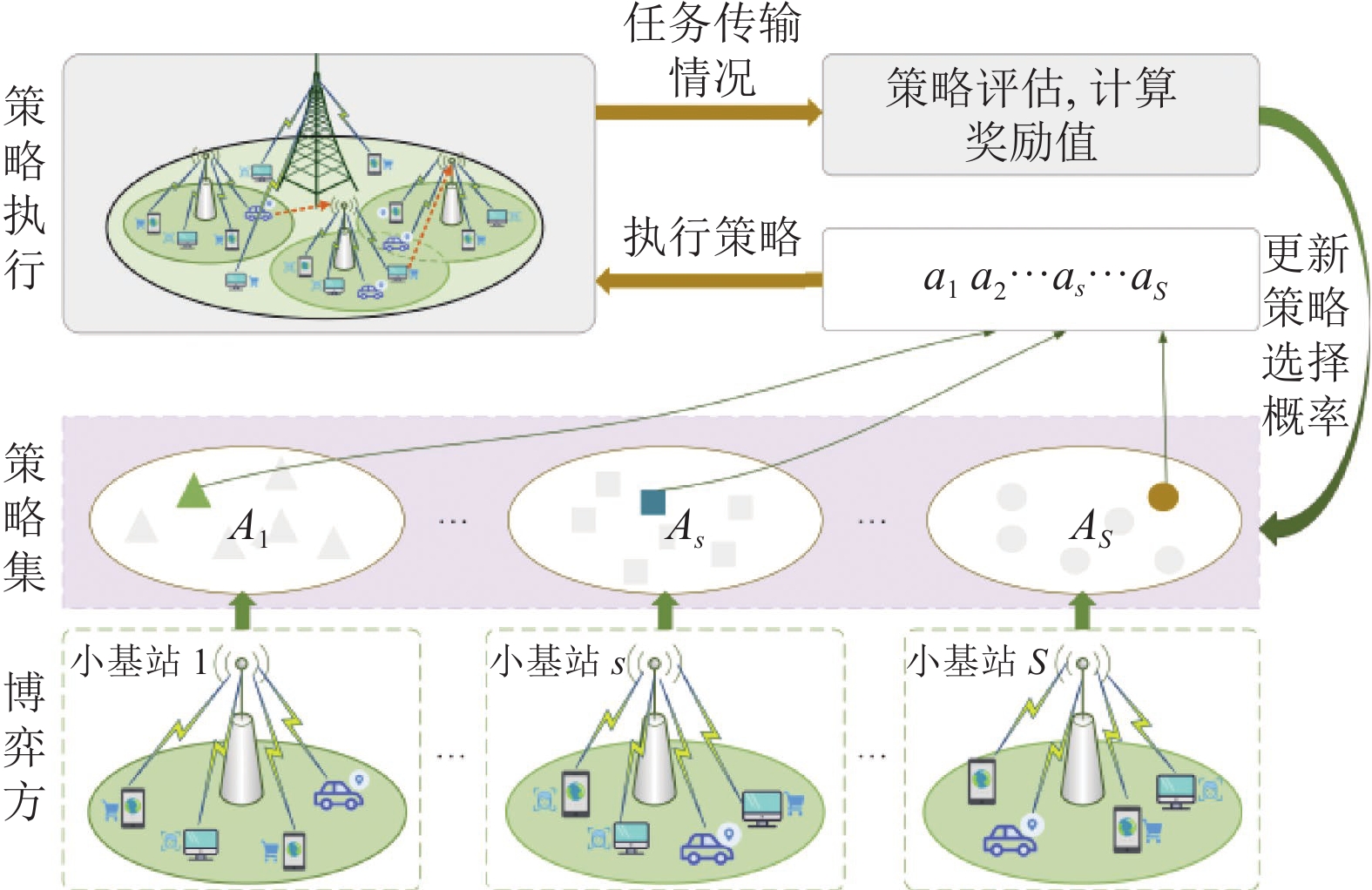

针对小基站, 由于频谱资源的复用, 多个小基站的无线资源管理策略存在紧耦合的关系, 无法直接求解, 我们引入博弈论的思想来进行策略的优化提出RDSS算法来优化多个小基站博弈下的无线资源管理策略. 算法的主要思想如图2所示, 以小基站作为博弈对象, 每个基站针对卸载到其的移动设备分布式的优化子信道分配策略和发射功率调控策略, 在策略实施后, 根据任务的时延、能耗以及任务的完成率, 获取该策略的奖励值, 以此来更新该策略的选择概率. 当策略选择概率趋于稳定时, 该算法收敛. 当算法收敛后, 每个基站选择概率最大的策略作为最优的子信道分配和发射功率调控策略.

(1) 博弈模型

将小基站以及卸载到该小基站的移动设备作为一个博弈对象, 小基站作为控制中心, 分布式制定无线资源管理策略分布式控制移动设备的卸载过程. 小基站s的无线资源管理策略可以写成

|

图 2 基于奖励驱动的策略选择算法模型 |

(2) 策略选择的更新机制

RDSS算法的本质是通过迭代不断提高最优策略的选择概率, 直到算法达到纳什均衡. 更新过程为每个小基站作为一个博弈参与者, 从其策略空间中基于概率选择无线资源管理策略, 控制其移动设备进行任务卸载. 每个小基站监测其移动设备任务数据的传输过程, 获取数据传输的时延能耗以及完成情况, 确定该策略的奖励值, 基于奖励值更新该策略的选择概率.

将第t次迭代时, 策略

| $ \begin{split} {{{R}}^{{t}}}{{(}}{{{a}}_{{s}}}{{, }}{{{a}}_{{{ - s}}}}{{)}} =& - \sum\limits_{{{u}} \in {{\boldsymbol{U}}_{{s}}}} {{{{\omega}}_{{u}}}\frac{{{{{E}}_{{{u, s}}}}}}{{\overline {{E}} }}} {{ + (1 - }}{{{\omega}}_{{u}}}{{)}}\frac{{{{{T}}_{{{u, s}}}}}}{{\overline {{T}} }} \\ & {{ - \alpha (}}{{{I}}_{{{\{ D}}_{{u}}^{{{{\rm{max}}}}} \geqslant {{{T}}_{{{u, s}}}}{{\} }}}}{{ - }}{{{I}}_{{{\{ D}}_{{u}}^{{{{\rm{max}}}}}{{ < }}{{{T}}_{{{u, s}}}}{{\} }}}}{{)}} \end{split} $ | (9) |

其中,

| $ {q^{t + 1}}({a_s}) = {q^t}({a_s}) + \lambda \frac{{{R^t}({a_s}, {a_{ - s}}) - R_s^{\max }}}{{R_s^{\max }}}{q^t}({a_s}) $ | (10) |

其中,

(3) 算法的步骤

RDSS算法的伪代码如算法1所示, 其主要包括策略初始化、策略选择、环境交互、策略选择概率更新这4个过程.

算法1. 基于奖励驱动的策略选择算法(RDSS)

输入: 每个任务的最大时延约束

输出: 每个小基站的子信道分配和发射功率调控策略

1) 将每个小基站下策略的选择概率均设为

2) 每个小基站随机选择一个策略, 计算执行该策略的奖励值, 将历史最大奖励值初始化为该值;

3) for

4) for

5) 小基站s基于概率分布随机选择策略

6) 将选择策略

7) 每个小基站执行策略;

8) for

9) 小基站s基于式(9)计算奖励值

10) 基于式(10)更新策略

11) if

12) 设置小基站s的历史最大奖励值为

13) 输出概率最大的子信道分配和发射功率调控策略.

策略初始化: 每个小基站将自己所有策略的选择概率设为一致, 从策略空间中随机选择一个策略. 与环境交互, 获取奖励值, 历史最大奖励值设为该值.

策略选择: 每个小基站根据策略选择的概率随机从策略选择空间中选择一个策略. 将其分解为移动设备的子信道分配和发射功率调控策略, 移动设备进行任务卸载.

环境交互: 执行每个小基站选择的策略, 获取每个小基站下的移动设备的任务卸载情况, 根据任务卸载情况基于式(9)计算每个策略的奖励值.

策略选择概率更新: 根据奖励值基于式(10)更新下一次迭代时, 该策略的选择概率.

(4) 算法分析

算法的具体过程为: 初始阶段, 每个小基站的策略选择权重都设为

小基站根据式(10)更新下一轮迭代的策略选择概率, 当该策略的奖励值优于历史奖励值时, 在其原来的基础上增加其下一轮迭代的选择概率, 反之降低其选择概率. 显然, 经过多次迭代后, 奖励值越高的策略其选择概率会越来越高, 奖励值越低的策略其选择概率会越来越低. 而当该策略是历史最优策略时, 其选择概率不变. 当策略

在本节中, 我们通过仿真实验来评估所提算法的性能. 我们从2014年8月20日成都市出租车的轨迹信息中提取部分数据作为用户设备的位置进行输入. 该数据集中包含了车辆ID、纬度、经度、日期、时间, 我们将车辆的纬度、经度转化为移动设备的位置, 每个车辆在随机时间产生任务, 任务大小和所需的计算量随机获取. 实验场景中的宏基站和小基站随机分布. 宏基站和小基站的覆盖半径分别为1000 m和200 m. 算法性能由任务完成率、信道利用率以及任务传输的时延和能耗来评估.

3.2 仿真环境的搭建仿真实验所涉及的参数是根据实际情况确定的. 此外, 使用了Python 3.9.12和PyTorch 1.8.1来构建仿真环境和实现算法. 仿真参数如表1所示[16].

| 表 1 仿真参数 |

为了评估所提算法的性能, 我们引入2个基准算法分别与本文提出的任务卸载算法和无线资源管理算法进行比较.

(1) 随机无线资源管理(RA)算法: 每个UE随机选择子信道和发射功率进行任务数据传输.

(2) 基于注水(WFA)算法的无线资源管理: 注水算法是一种存在时间相对较长且成熟的无线资源管理算法. 它通过数学优化的方法使移动设备能够根据信道状态动态地调节发射功率, 以最大限度地提高传输速率[17].

3.3 实验结果分析使用式(9)来评估算法的收敛程度, 如图3所示, 在不同的移动设备数量的情况下, 系统传输数据获得的总奖励值, 随着迭代次数的增加, 不断增加, 并最终实现收敛. 此外, 还可以看出随着移动设备数量的减小, 达到收敛所需要的迭代次数不断减少, 这是因为随着移动设备数量的减少, 基站的策略空间减小, 算法达到收敛所需要的迭代次数减少.

|

图 3 不同设备数量下RDSS的收敛性 |

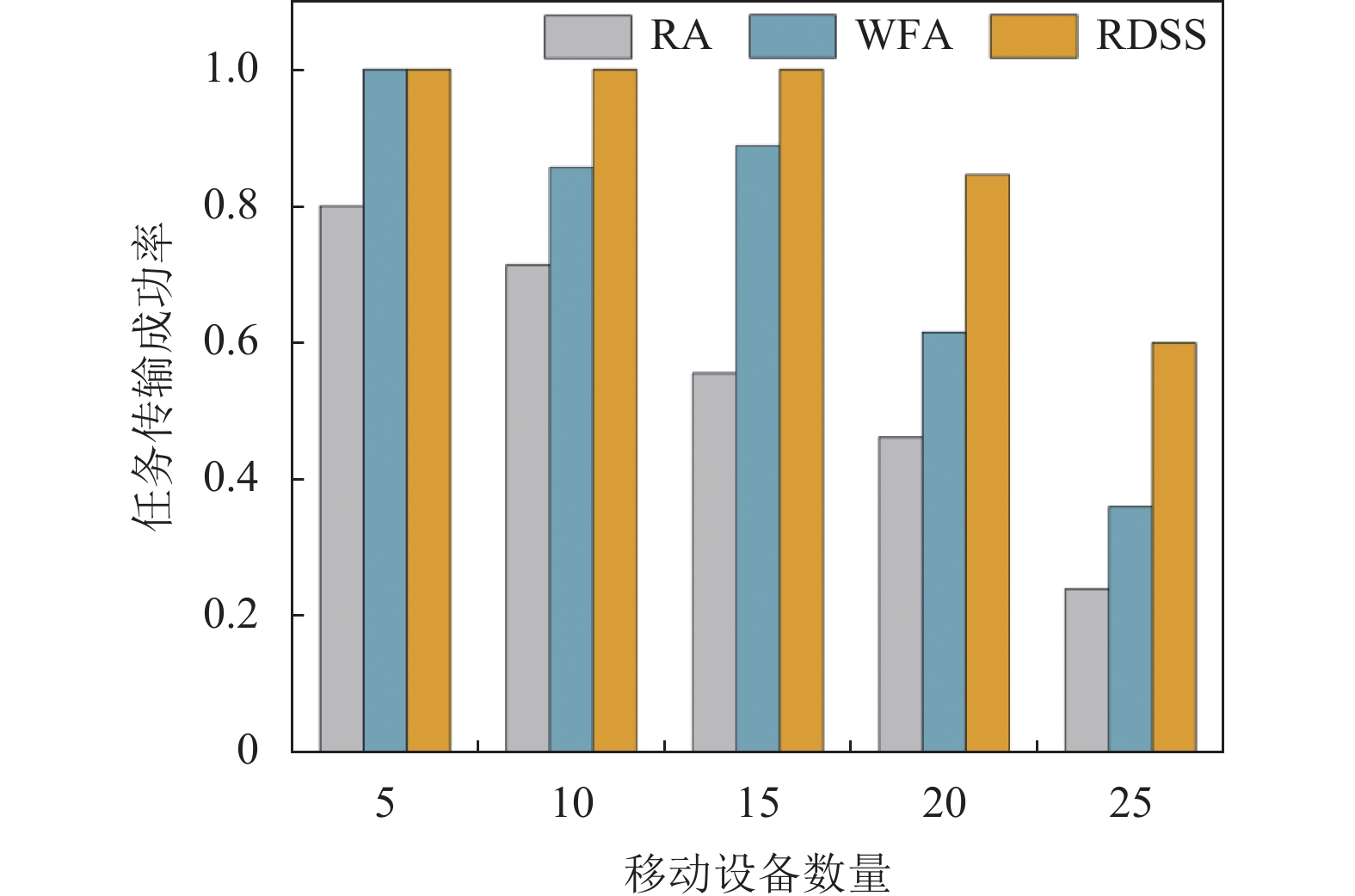

图4表示不同算法在不同数量移动设备下的任务传输成功率. 可以看出, 本文提出的算法优于其他两种算法. 同时, 任务传输的成功率随着移动设备数量的增加而逐渐降低. 这是因为移动设备的数量越多, 小基站之间的频谱复用的概率就越高. 频谱的复用会造成同信道干扰, 导致任务传输时间增加, 成功率下降.

|

图 4 任务传输成功率比较 |

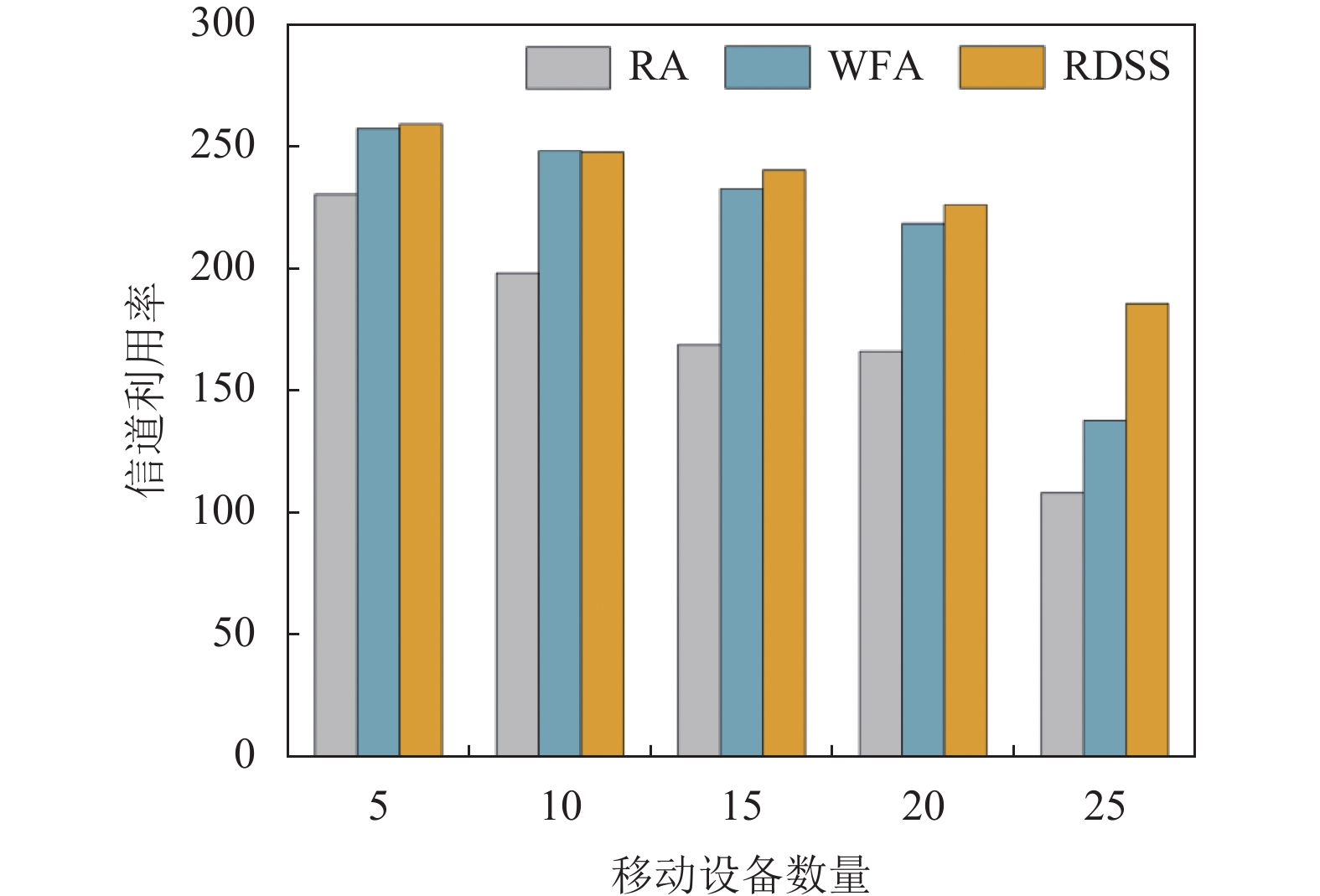

从图5中可以看出, 我们提出算法具有最高的信道利用率, 而且随着UE数量的增加, 其优势也越来越明显. 此外, 信道利用率随着用户设备数量的增加而趋于下降. 这是因为用户设备数量的增加使得小基站之间的同信道干扰增加.

|

图 5 信道利用率比较 |

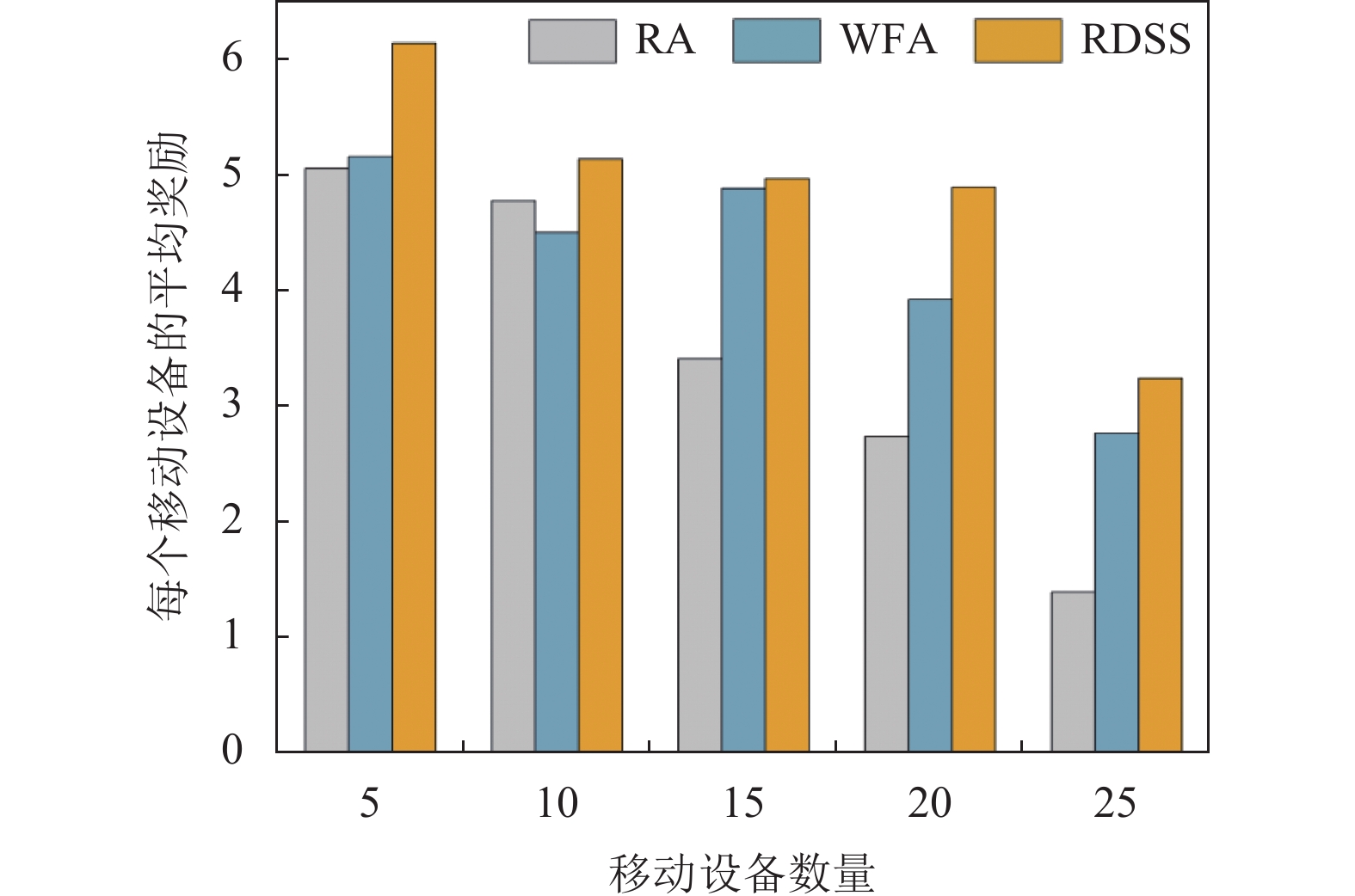

为了便于比较, 我们引入移动设备的平均奖励来观察不同算法在不同移动设备数量下的性能. 平均奖励被定义为总奖励与移动设备数量的比率. 不同算法对不同数量的移动设备获得的平均奖励如图6所示, 从图6可以看出, 我们提出的算法获得了最高的平均奖励. 此外, 可以看出, 随着移动设备数量的增加, 平均奖励不断减少, 这是因为随着移动设备数量的增加, 同信道干扰增加, 任务传输所需要的时延和能耗增加, 并且任务传输失败的概率也会增加, 进而减少了系统的平均奖励.

|

图 6 移动设备平均奖励比较 |

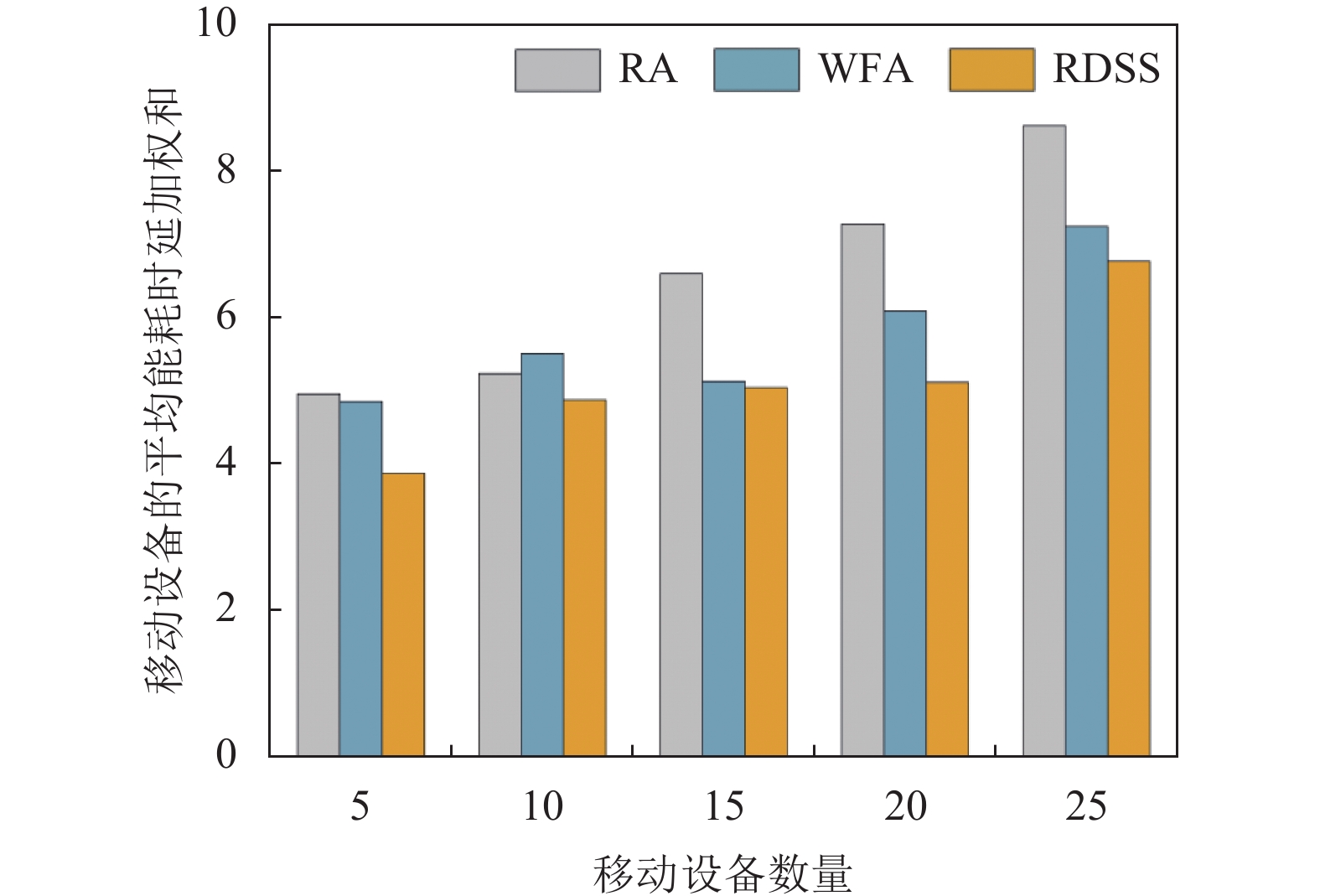

基于本文的目标, 我们来比较本文提出的算法在任务处理时延和能耗上的优势, 图7显示了任务处理的平均时延和能耗的加权和的比较, 可以看出与其他算法相比, 本文提出的RDSS算法表现较好. 此外, 可以看出随着移动设备数量的增加, 任务处理所花费的时延和能耗也随之增加. 这是因为, 当移动设备数量增加时, 信道的利用率提高, 相同信道被同时使用的概率会增加, 同信道干扰增加, 所以移动设备在传输任务时, 所花费的时延和能耗会增加.

|

图 7 移动设备平均能耗时延加权和比较 |

4 结论与展望

在本文中, 我们研究了超密集网络中的无线资源管理问题. 我们提出了一种基于奖励驱动的策略选择算法, 该算法优化了移动设备传输任务时的子信道分配和发射功率调节策略, 降低了任务处理的时延和能耗. 我们将小基站之间的无线资源管理问题建模参与者之间的博弈问题, 通过不断的迭代优化, 来寻找最优策略. 通过仿真实验证明我们提出的算法在提高任务完成率, 信道利用率和提高系统奖励方面优于其他算法. 在未来的工作中, 我们将考虑边缘计算任务卸载策略与无线资源管理策略综合优化, 有效降低任务处理全流程的时延和能耗.

| [1] |

Mishra K, Rajareddy GNV, Ghugar U, et al. A collaborative computation and offloading for compute-intensive and latency-sensitive dependency-aware tasks in dew-enabled vehicular fog computing: A federated deep Q-learning approach. IEEE Transactions on Network and Service Management, 2023, 20(4): 4600-4614. DOI:10.1109/TNSM.2023.3282795 |

| [2] |

Sadeeq MM, Abdulkareem NM, Zeebaree SRM, et al. IoT and cloud computing issues, challenges and opportunities: A review. Qubahan Academic Journal, 2021, 1(2): 1-7. DOI:10.48161/qaj.v1n2a36 |

| [3] |

Siriwardhana Y, Porambage P, Liyanage M, et al. A survey on mobile augmented reality with 5G mobile edge computing: Architectures, applications, and technical aspects. IEEE Communications Surveys & Tutorials, 2021, 23(2): 1160-1192. |

| [4] |

Sun W, Wang L, Liu JJ, et al. Movement aware CoMP handover in heterogeneous ultra-dense networks. IEEE Transactions on Communications, 2021, 69(1): 340-352. DOI:10.1109/TCOMM.2020.3019388 |

| [5] |

Zhou TQ, Qin D, Nie XF, et al. Energy-efficient computation offloading and resource management in ultradense heterogeneous networks. IEEE Transactions on Vehicular Technology, 2021, 70(12): 13101-13114. DOI:10.1109/TVT.2021.3116955 |

| [6] |

Li SL, Tao YZ, Qin XQ, et al. Energy-aware mobile edge computation offloading for IoT over heterogenous networks. IEEE Access, 2019, 7: 13092-13105. DOI:10.1109/ACCESS.2019.2893118 |

| [7] |

Lu YG, Chen X, Zhang YC, et al. Cost-efficient resources scheduling for mobile edge computing in ultra-dense networks. IEEE Transactions on Network and Service Management, 2022, 19(3): 3163-3173. DOI:10.1109/TNSM.2022.3163297 |

| [8] |

Hong SG, Park J, Bahk S. Subchannel and power allocation for D2D communication in mmWave cellular networks. Journal of Communications and Networks, 2020, 22(2): 118-129. DOI:10.1109/JCN.2020.000007 |

| [9] |

Zhang GB, Zhang HJ, Han Z, et al. Spectrum allocation and power control in full-duplex ultra-dense heterogeneous networks. IEEE Transactions on Communications, 2019, 67(6): 4365-4380. DOI:10.1109/TCOMM.2019.2897765 |

| [10] |

Tian XJ, Jia WJ. Improved clustering and resource allocation for ultra-dense networks. China Communications, 2020, 17(2): 220-231. DOI:10.23919/JCC.2020.02.017 |

| [11] |

Shi LQ, Chu XL, Sun HJ, et al. Wireless-powered OFDMA-MEC networks with hybrid active-passive communications. IEEE Internet of Things Journal, 2023, 10(12): 10484-10496. DOI:10.1109/JIOT.2023.3241088 |

| [12] |

Ye YH, Hu RQ, Lu GY, et al. Enhance latency-constrained computation in MEC networks using uplink NOMA. IEEE Transactions on Communications, 2020, 68(4): 2409-2425. DOI:10.1109/TCOMM.2020.2969666 |

| [13] |

Cao B, Zhang L, Li Y, et al. Intelligent offloading in multi-access edge computing: A state-of-the-art review and framework. IEEE Communications Magazine, 2019, 57(3): 56-62. DOI:10.1109/MCOM.2019.1800608 |

| [14] |

Alatoun K, Matrouk K, Mohammed MA, et al. A novel low-latency and energy-efficient task scheduling framework for internet of medical things in an edge fog cloud system. Sensors, 2022, 22(14): 5327. DOI:10.3390/s22145327 |

| [15] |

Wu W, Song HF, Wang HW, et al. Potential game based task offloading in the high-speed railway with reinforcement learning. IEEE Transactions on Intelligent Transportation Systems, 2023, 24(11): 12671-12685. DOI:10.1109/TITS.2023.3290619 |

| [16] |

Zhang HX, Yang YJ, Shang BD, et al. Joint resource allocation and multi-part collaborative task offloading in MEC systems. IEEE Transactions on Vehicular Technology, 2022, 71(8): 8877-8890. DOI:10.1109/TVT.2022.3174530 |

| [17] |

Qiu CR, Hu Y, Chen Y, et al. Deep deterministic policy gradient (DDPG)-based energy harvesting wireless communications. IEEE Internet of Things Journal, 2019, 6(5): 8577-8588. DOI:10.1109/JIOT.2019.2921159 |

2024, Vol. 33

2024, Vol. 33