2. 华南理工大学 计算机科学与工程学院, 广州 510006

2. School of Computer Science and Engineering, South China University of Technology, Guangzhou 510006, China

视网膜血管是全身微循环系统的重要组成部分, 其形态变化与糖尿病、高血压等心血管疾病的严重程度密切相关. 糖尿病患者体内长期高血糖代谢紊乱可引起全身微循环紊乱, 越来越多的人被诊断为糖尿病视网膜病变(DR), 这是世界各地失明的主要原因[1]. 视网膜血管分割在糖尿病视网膜病变预防和分析中起着重要的作用, 但是人工视网膜血管分割方法耗时且代价昂贵, 不适用于大规模筛查或诊断工作. 因此, 自动分割方法就显得特别有意义.

现阶段视网膜血管分割算法按照是否需要专家手工标注的金标准, 通常可以分为有监督方法和无监督方法. 无监督方法通常利用血管的天然形态或固有规律来判断像素是否为血管, 常用的方法基于匹配滤波、形态学处理、多尺度分析和血管跟踪等. Li等[2]利用匹配滤波器的多尺度响应对血管像素提取, 该方法在3个尺度乘上滤波器响应增强血管对滤波器响应, 弱化背景影响, 然而该方法分割病变视网膜时, 匹配滤波很容易将病变区域误判为血管. Fraz等[3]提出一种结合形态学位平面和中心线检测的血管分割方法, 先利用高斯滤波器在4个方向提取中心线, 然后再对具有线性结构的灰度图进行多方向顶帽运算, 最后对图像进行形态学位平面切片, 但这种方法不适用于处理不同宽度的血管, 可能会丢失微小的结构信息. Orlando等[4]采用结构化支持向量机学习参数, 并提出一个全连接条件随机场模型对血管像素分类. 虽然上述方法取得了一定效果, 但有金标准的情况下, 大多数实验表明无监督方法的分割效果与有监督方法有较明显差异.

有监督方法中, 血管分割的先验知识是从眼科专家手工分割的图像中直接获取的, 采用提取的特征向量训练一个分类器对血管和非血管像素自动分类, 通过神经网络可以获得更抽象、更有效的表征能力. Liskowski等[5]通过实验证明深度卷积神经网络引入视网膜血管分割领域, 能有效缓解传统机器学习毛细血管难以分割的问题. Wang等[6]提出一种结合卷积神经网络(CNN)和随机森林(RF)的算法完成了对视网膜血管的分割任务. Shelhamer等[7]提出全卷积神经网络(FCN), 将全连接层替换为卷积层大大减少了计算量, 更为重要是实现了图像的端到端分割. 随后, Ronneberger等[8]构建了基于FCN的U型全卷积网络(U-Net), 该网络被广泛应用于医学图像分割, 在小样本数据集上取得了优异的成果. 尽管现有算法逐步提高了分割的精度, 但是仍然存在血管断裂、末端血管漏分、空间信息关注度不足的问题.

视网膜血管的分割方法虽然很多, 但制作更精准更高效的网络仍然是一个挑战. 为提取更丰富的眼底视网膜血管细节信息, 提高分类灵敏度, 本文采用HRNet框架[9], 该框架以其优异的特征信息交换能力和高分辨率保持能力在关键点检测和人体姿态估计上取得了卓越的效果. 由于视网膜血管形态结构复杂、边界信息丰富, 本文在HRNet框架的基础上提出一种融合可变形卷积和空间金字塔池化卷积的视网膜血管分割算法. 首先, 对提取的绿色通道采用限制对比度自适应直方图均衡化(CLAHE)提高目标与背景的对比度, 并利用自适应的Gamma矫正进一步突出微血管信息; 然后, 将预处理灰度图像输出HRNet网络中, 由于整个结构中连续保持高分辨率的灰度图, 并行连接的方式很大程度保存了每层的图像信息, 其包含多个U型子网提高了对特征信息的捕获能力; 其次, 针对视网膜血管多变的形态结构, 采用可变形卷积在编码阶段使网络学习更具信息量的形态学特征; 最后, 在多尺度信息融合阶段, 通过空间金字塔池化和金字塔型多尺度卷积提取更丰富的局部信息, 降低特征融合阶段特征冗余造成的伪影问题, 加强微血管的提取能力.

1 算法原理 1.1 可变形卷积眼底视网膜血管图像几何形状复杂, 其表征图像有丰富的高频信号. 传统的卷积核几何结构固定, 不能有效地处理复杂几何图形; 可变形卷积[10]通过对传统方块形卷积核的改进, 提升了卷积的几何变换能力, 能够更好拟合视网膜血管的形状和尺度特征. 可变形卷积通过加入普通卷积层, 学习特征图每个位置偏移量, 带偏移量的卷积能抓取更多视网膜血管的复杂特征信息. 图1更为直观表现了可变型卷积对目标区域抓取能力.

|

图 1 3×3传统卷积和可变形卷积对比图 |

为了更好说明可变形卷积以一个的3×3卷积K(i, j)为例, 取特征图像局部位置

| $y({p_0}) = \sum\limits_{{p_l} \in k} {\omega ({p_l})F({p_0} + {p_l})} $ | (1) |

其中,

| $y({p_0}) = \sum\limits_{{p_l} \in K} {\omega ({p_l})} F({p_0} + {p_l} + \Delta {p_{ab}})$ | (2) |

可变形卷积利用学习到的偏移量, 使聚合的卷积扩散并聚焦于目标区域, 其针对性更强.

1.2 空间金字塔池化卷积模块为了解决目标检测中目标物大小与网络输入图像尺寸不匹配的问题, He等[11]提出空间金字塔池化(SPP)模块. 在解决这一问题的同时发现, 该模型对特征图进行不同尺寸的池化操作时可以进一步提高网络的准确度和稳健性. 受此启发, 本文提出空间金字塔池化卷积 (SPPC)模块, 结构如图2所示.

在金字塔池化的基础上加入一个金字塔卷积层, 分别采用1×1、3×3、5×5的卷积对输入特征图提取语义信息, 针对本文特征图的大小, 金字塔池化层分别采用2×2、3×3、4×4、5×5的池化窗口, 并通过1×1卷积调整其权重, 然后将卷积层和池化层特征Concatenate连接, 生成的特征输出通道数为特征输入的2倍. 该模块通过多个池化和反池化层使数据稀疏化, 减弱病变和伪影对血管图像造成的干扰, 加强网络对全局信息的提取和细小血管的重构能力; 多尺度卷积层采用不同大小的卷积核作用于同一区域提取不同感受野的多尺度特征信息, 减弱池化层造成的信息丢失.

|

图 2 空间金字塔池化卷积模块 |

2 网络结构

针对视网膜血管细微且形态结构复杂, 样本数量偏少的特点, 采用HRNet框架对眼底图像进行分割. 该框架在保证目标图像一直保持高分辨率的基础上, 通过各个并行子网络实现多信息交换, 使高低分辨率特征相互增强, 充分利用上下文信息多尺度融合, 改善采样过程中的信息丢失, 有效还原血管形态抑制噪音. 本文算法为增强模型对眼底血管图像复杂结构适应性, 在编码部分采用可变形卷积替换普通卷积, 利用可变形卷积具有自适应血管形态的能力使网络学习更具信息量的血管特征; 在解码特征多尺度融合部分, 通过SPPC模块对多尺度的融合特征图进行特征提取, 利用金字塔池化层和金字塔卷积层对融合多层特征信息的卷积块特征提取, 强化捕捉目标全局和局部特征能力, 优化分割结果. 本文提出的改进HRNet模型DSP-HRNet, 如图3所示.

|

图 3 DSP-HRNet网络框架图 |

图3中的网络结构的主体框架是由3个不同分辨率网络并行连接的方式组成, 输入图片大小为64×64, 上层可变形卷积的通道数为64, 中层和下层通道数分别为128和256, 卷积核大小均为3×3, 并在每个SPPC模块后加一个1×1的卷积, 确保输出该模块的特征图通道数保持不变. Maxpooling和Unpooling均设置为步长为2, 采样核大小为2×2, 相邻层之间单次池化或反池化, 相隔层采用2次池化或反池化的方式保持分辨率一致. 本文采用Concatenate方式对上下层特征融合, 并在其后接一个的1×1的卷积, 使同一层输入SPPC模块的特征图通道数与输入可变形卷积的特征图通道数保持一致. 为防止梯度爆炸, 卷积采用LeakyReLU作为激活函数, 通过Dropout减缓模型过拟合问题. 最后采用Softmax函数对图像和背景进行二分类.

3 实验过程 3.1 数据集本文用于视网膜血管分割的数据集为2004年的开源数据集DRIVE (Digital Retinal Image for Vessel Extraction)[12]. 该数据集由荷兰的图像科学研究所发布, DRIVE数据集包含训练集RGB图片和测试集RGB图片各20张, 图像像素尺寸均为565×584. 其中33幅图片来源为健康人体眼球, 7幅图片存在早期糖尿病引起的病灶. 每幅彩色图像都有一张对应的掩膜和两幅专家手工分割的血管灰度标准图片, 其中第一分割标准的微血管信息更为丰富. 本文均采用第一专家分割金标准眼底图片进行训练和对分割结果进行评测.

3.2 预处理DRIVE数据集40张彩色图像都为RGB模式图像, 将每幅图像红色、绿色和蓝色三通道像素分别取出, 得到的灰度图像中绿色通道血管与背景对比度最高, 利于图片进一步处理. 通过限制对比度自适应直方图均衡化[13]对绿色通道图像灰度级分布调整, 抑制噪声凸显血管; 再利用自适应Gamma矫正[14]调节图像的曝光度, 进一步提高对比度, 抑制光照不均等问题. 预处理各阶段效果如图4所示.

|

图 4 预处理各阶段效果图 |

考虑到样本数量太小训练容易过拟合的问题, 本文通过对图像旋转的方式, 以30度的旋转角对训练集图像进行数据扩充, 将DRIVE数据集扩充为220张图片. 为了进一步降低网络模型存在的过拟合问题, 加强算法的泛化性能, 本文采用64×64的滑动窗口对训练集和金标准图片随机裁剪, 并随机选取100000张局部样本图片用于训练网络.

3.3 评价指标为了对本文算法性能进行定量分析, 以判断算法的各项性能, 定义视网膜血管分割结果与专家手工分割金标准相同像素点的数目为真阳性 (

| $SE = \frac{{{T_P}}}{{{T_P} + F_N}}$ | (3) |

| $SP = \frac{{{T_N}}}{{{T_N} + {F_P}}}$ | (4) |

| $ACC = \frac{{{T_P} + {T_N}}}{{{T_P} + {F_P} + {T_N} + {F_N}}}$ | (5) |

| $F1 - score = \frac{{2{T_P}}}{{2{T_P} + {F_P} + {F_N}}}$ | (6) |

本文实验在Ubuntu操作系统上使用Keras和TensorFlow进行训练, 批量设置为16, 采用Adam算法[15]优化模型, 学习率设置为0.001, 迭代次数为60, 当6次迭代后损失率不变, 则将学习率乘以系数0.1. 实验环境配置为InterCorei7-6700H CPU和Nvidia GeForce GTX2070 GPU.

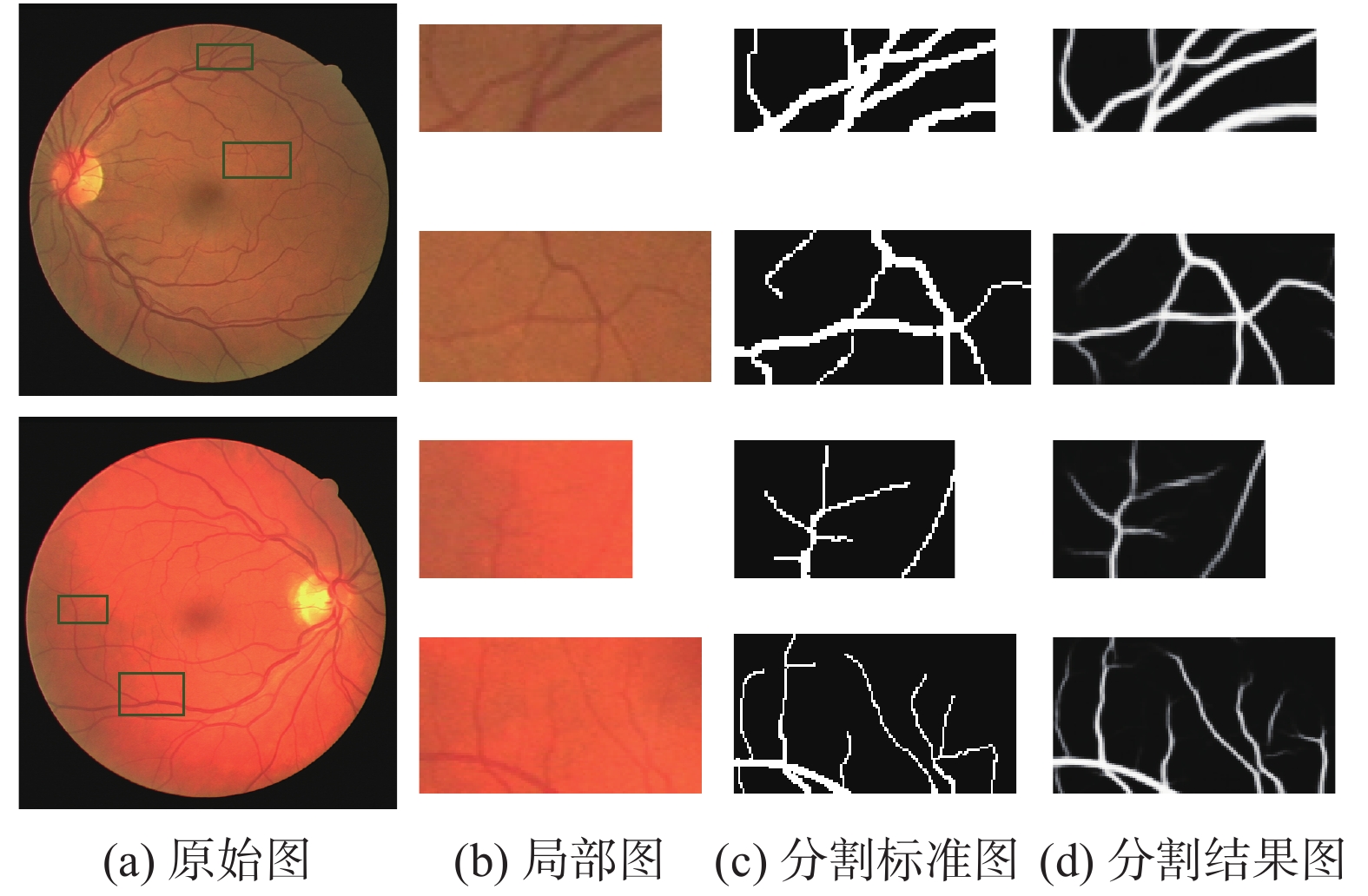

4 实验结果与分析 4.1 实验结果本文算法性能在DRIVE数据集上评估, 部分分割结果如图5所示. 其中, 图5(a)为原始图像, 图5(b)为第一专家金标准图像, 图5(c)为本文算法分割图像. 图5中第1行、第2行和第4行为健康的视网膜图像, 第3行为存在病变区域的视网膜图像. 由图可知, 本文算法在视网膜血管分割时受黄斑中心凹和视盘[16]的影响较少, 位于此处血管未出现粘连或者断裂现象; 对于存在病变的图像分割时, 本文算法表现出较好的抗干扰性, 基本未出现误分区域; 从整体图像分析, 本文算法分割效果十分接近专家手工分割标准.

|

图 5 DRIVE数据库分割结果 |

图6展示了图5中第1行和第2行分割结果细小血管的局部放大图. 由图可知, 本文算法对血管交叉处和低对比度的微血管区域有很强的稳健性, 保持了粗细血管的对比度和连通性, 解决了血管交叉处出现断裂或者粘连的问题, 血管平滑度更是优于金标准, 验证了本算法的对眼底视网膜血管分割的优越性和稳定性.

4.2 算法改进前后对比为了进一步说明HRNet对比传统U-Net网络结构的优越性, 以及可变形卷积和空间金字塔池化卷积模型融入HRNet网络的合理性, 并在DRIVE数据集上进行对比实验. 具体调整如下: H0表示原始U-Net算法的分割结果, H1表示原始HRNet算法的分割结果, H2表示仅融合可变形卷积和HRNet算法的分割结果, H3表示仅融合SPPC模块和HRNet算法的分割结果, H4为本文算法分割结果.

|

图 6 局部区域分割结果 |

由表1可知, HRNet在视网膜血管分割领域全面优于U-Net, 说明该网络模型的合理性和优越性. H2相较于H1在灵敏度方面有大幅提升, 说明可变形卷积对复杂结构的血管图像有更强的特征提取能力, 但精确度提升不大, 说明采样过程中存在严重信息丢失问题. H3相较于H2灵敏度下降了0.79%, 精确度却提升了0.06%, 可见空间金字塔池化卷积模块对多尺度上下文特征信息捕捉能力更强, 能有效恢复图像细节信息, 特异性的提升说明对背景信息的误判有所减少. 本文算法H4在各个方面都优于算法H3, 表明该方法在对提取完整血管信息和对信息还原方面有很大优势, 在保持血管信息的同时还能有效提取高层特征信息来对背景和目标进行分辨.

| 表 1 基于HRNet网络不同算法性能比较 |

综上所述, 改进后的HRNet网络对视网膜血管拥有更高的灵敏度和特异性, 增强了血管特征信息的提取能力, 有效解决了血管断裂和微小血管难以分割的问题.

4.3 不同分割算法比较分析为了进一步体现本文算法性能, 表2将本文算法与不同文献中血管分割算法的准确率、灵敏度、特异性和AUC值进行对比, 其中加粗字体部分为每项最优指标. 其中文献[3, 17-20]为无监督方法, 文献[21-25]为有监督方法.

| 表 2 DRIVE数据库不同算法分割结果 |

由表2可以看出, 本文算法在DRIVE数据集中有优异表现, 其准确率和灵敏度分别达到了95.79%和80.33%, 特异性和AUC的值为98.12%和98.10%, 明显优于非监督学习算法. 文献[22]中特异性比本文方法高0.06%, 但是灵敏度与本文方法相差较大, 可见本文提取血管信息能力更强; 文献[25]的灵敏度比本文算法高了0.29%, 但其余指标均低于本文算法. 综上所述, 本文通过保持目标图像在高分辨下, 结合可变形卷积和多尺度的空间特征信息对目标图像进行语义信息的提取和融合, 能有效地对视网膜眼底图像进行分割, 在保证高准确率的同时也有较高的抗干扰能力和泛化能力.

5 结论针对现有视网膜图像分割算法存在血管断裂、病理信息误判和低对比度区域微小血管难以识别的问题, 本文提出了一种改进的HRNet分割视网膜血管的方法. 首先将预处理后的视网膜图片输出HRNet网络, 通过其丰富的子网结构提高特征信息交换能力和重复利用率, 减少编码-解码过程中的信息丢失; 其次在编码阶段利用可变形卷积较好地捕捉了不同大小和形状血管; 最后在多尺度特征融合阶段利用空间金字塔池化卷积模块提取多尺度局部特征信息, 降低了噪声的影响. 实验结果表明, 本文算法在DRIVE数据库中能有效分割出细微血管, 且过度分割区域较少, 但是该算法对存在病灶的复杂眼底图像仍然会出现少数错分和细微血管分割不全问题. 因此, 在后续的工作需要对预处理过程进一步优化, 并对网络结构优化, 提高本文算法对带有病灶的眼底图像的稳健性和泛化能力.

| [1] |

Mookiah MRK, Acharya UR, Martis RJ, et al. Evolutionary algorithm based classifier parameter tuning for automatic diabetic retinopathy grading: A hybrid feature extraction approach. Knowledge-Based Systems, 2013, 39: 9-22. DOI:10.1016/j.knosys.2012.09.008 |

| [2] |

Li Q, You J, Zhang D. Vessel segmentation and width estimation in retinal images using multiscale production of matched filter responses. Expert Systems with Applications, 2012, 39(9): 7600-7610. DOI:10.1016/j.eswa.2011.12.046 |

| [3] |

Fraz MM, Barman SA, Remagnino P, et al. An approach to localize the retinal blood vessels using bit planes and centerline detection. Computer Methods and Programs in Biomedicine, 2012, 108(2): 600-616. DOI:10.1016/j.cmpb.2011.08.009 |

| [4] |

Orlando JI, Prokofyeva E, Blaschko MB. A discriminatively trained fully connected conditional random field model for blood vessel segmentation in fundus images. IEEE Transactions on Biomedical Engineering, 2017, 64(1): 16-27. DOI:10.1109/TBME.2016.2535311 |

| [5] |

Liskowski P, Krawiec K. Segmenting retinal blood vessels with deep neural networks. IEEE Transactions on Medical Imaging, 2016, 35(11): 2369-2380. DOI:10.1109/TMI.2016.2546227 |

| [6] |

Wang SL, Yin YL, Cao GB, et al. Hierarchical retinal blood vessel segmentation based on feature and ensemble learning. Neurocomputing, 2015, 149: 708-717. DOI:10.1016/j.neucom.2014.07.059 |

| [7] |

Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651. DOI:10.1109/TPAMI.2016.2572683 |

| [8] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich, Germany. 2015. 234–241.

|

| [9] |

Sun K, Xiao B, Liu D, et al. Deep high-resolution representation learning for human pose estimation. 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA. 2019. 5586–5696.

|

| [10] |

Dai JF, Qi HZ, Xiong YW, et al. Deformable convolutional networks. 2017 IEEE International Conference on Computer Vision (ICCV). Venice, Italy. 2017. 764–773.

|

| [11] |

He KM, Zhang XY, Ren SQ, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(9): 1904-1916. |

| [12] |

Staal J, Abramoff MD, Niemeijer M, et al. Ridge-based vessel segmentation in color images of the retina. IEEE Transactions on Medical Imaging, 2004, 23(4): 501-509. DOI:10.1109/TMI.2004.825627 |

| [13] |

Reza AM. Realization of the Contrast Limited Adaptive Histogram Equalization (CLAHE) for real-time image enhancement. Journal of VLSI Signal Processing Systems for Signal, Image and Video Technology, 2004, 38(1): 35-44. DOI:10.1023/B:VLSI.0000028532.53893.82 |

| [14] |

储清翠, 王华彬, 陶亮. 图像的局部自适应Gamma校正. 计算机工程与应用, 2015, 51(7): 189-193, 208. DOI:10.3778/j.issn.1002-8331.1305-0193 |

| [15] |

Kingma DP, Ba J. Adam: A method for stochastic optimization. Computer Science, 2014. arXiv:1412.6980v9.

|

| [16] |

梁礼明, 盛校棋, 熊文, 等. 融合空洞卷积与注意模型的U型视盘分割. 计算机工程与设计, 2020, 41(3): 808-814. |

| [17] |

Azzopardi G, Strisciuglio N, Vento M, et al. Trainable COSFIRE filters for vessel delineation with application to retinal images. Medical Image Analysis, 2015, 19(1): 46-57. DOI:10.1016/j.media.2014.08.002 |

| [18] |

Roychowdhury S, Koozekanani DD, Parhi KK. Iterative vessel segmentation of fundus images. IEEE Transactions on Biomedical Engineering, 2015, 62(7): 1738-1749. DOI:10.1109/TBME.2015.2403295 |

| [19] |

Zhang J, Chen Y, Bekkers E, et al. Retinal vessel delineation using a brain-inspired wavelet transform and random forest. Pattern Recognition, 2017, 69: 107-123. DOI:10.1016/j.patcog.2017.04.008 |

| [20] |

徐光柱, 张柳, 邹耀斌, 等. 自适应脉冲耦合神经网络与匹配滤波器相结合的视网膜血管分割. 光学精密工程, 2017, 25(3): 756-764. |

| [21] |

Li QL, Feng BW, Xie LP, et al. A cross-modality learning approach for vessel segmentation in retinal images. IEEE Transactions on Medical Imaging, 2016, 35(1): 109-118. DOI:10.1109/TMI.2015.2457891 |

| [22] |

Yan ZQ, Yang X, Cheng KT. Joint segment-level and pixel-wise losses for deep learning based retinal vessel segmentation. IEEE Transactions on Biomedical Engineering, 2018, 65(9): 1912-1923. DOI:10.1109/TBME.2018.2828137 |

| [23] |

Alom Z, Hasan M, Yakopcic C, et al. Recurrent residual convolutional neural network based on U-Net (R2U-Net) for medical image segmentation. arXiv: 1802.06955, 2018.

|

| [24] |

Ni JJ, Wu JH, Tong J, et al. GC-net: Global context network for medical image segmentation. Computer Methods and Programs in Biomedicine, 2020, 190: 105121. DOI:10.1016/j.cmpb.2019.105121 |

| [25] |

吕晓文, 邵枫, 熊义明, 等. 基于双流网络的视网膜血管分割方法. 光学学报, 2020, 40(4): 0410002. |

2021, Vol. 30

2021, Vol. 30