2. 复旦大学 上海市数据科学重点实验室, 上海 201203

2. Shanghai Key Laboratory of Data Science, Fudan University, Shanghai 201203, China

21世纪以来, 手机用户不断增加, 特别是智能手机的使用越来越多, 人们可以通过短信快速高效的获取信息, 但随之而来的是垃圾短信的泛滥, 垃圾短信不仅仅影响到人们正常的手机使用和体验, 更主要的是垃圾短信会带来严重的安全隐患, 很多不法分子通过垃圾短信获取用户的私人信息, 危害到用户隐私安全. 因此, 垃圾短信的识别具有重要的现实意义. 治理垃圾短信不仅需要有关部门的持法监督和相应手机安全厂商的屏蔽, 同时应该利用先进的技术, 直接在源头上消灭垃圾短信.

目前常用的垃圾短信识别的方法主要包括基于黑白名单的方法, 基于规则的方法和基于短信内容的方法这样3种[1], 前两种方法要人工手动添加发送垃圾短信号码的名单或者手动添加与垃圾短信对应关键词, 由于手动添加的数据量有限且效率低, 因此目前主要是使用基于短信内容的方法来进行短信识别, 即将文本分类技术用于识别垃圾短信.

文本分类是计算机应用于根据特定的分类系统或者标准自动分类文本[2,3]. 随着深度学习在自然语言预处理领域的应用, 相对于传统的文本分类算法如朴素贝叶斯, 支持向量机等[4-6], 深度学习在文本分类上获得了令人满意的结果. 目前长短时记忆网络(Long Short-Term Memory, LSTM)已经广泛应用在文本分类里面, 与循环神经网络(Recurrent Neural Network, RNN)相比, LSTM网络采用了特殊隐式单元, 因此更适合于处理长期依赖关系, 很好的解决了RNN的梯度消失或者梯度爆炸的问题, 可以更好的获取文本的全局特征信息. 以LSTM网络为基础的双向循环神经网络(Bidirectional LSTM, Bi-LSTM)网络是由向前的LSTM和向后的LSTM组成[7-13], 在处理文本分类上面可以更好的捕捉双向的语义依赖, 对于词向量[14]的依赖更少, 从而提高文本的分类效率.

专家学者根据基于对人类视觉的研究, 提出注意力(attention)机制[15], 目前Attention机制已经引入到自然语言预处理领域[16,17], 学习并重点关注目标区域, 使得模型在有效资源的情况下关注重点消息. Attention机制通常结合编码解码(encoder-decoder)模型使用, 应用场景十分广泛, 因此随后出现多种注意力机制的变形, 如自注意力(self-attention)机制.

根据以上背景本文提出一种结合TFIDF的self-attention-based Bi-LSTM神经网络模型. 首先, 使用Word2Vec[18-20]将短信文本处理成词向量形式, 随后使用Bi-LSTM模型对词向量形式的短信文本的特征信息进行提取, 接着引入自注意机制, 并结合TFIDF模型, 对重点词汇进行加权, 最后将输出的特征向量输入Softmax分类器得到分类结果. 该模型不仅能够充分利用上下文本信息来进行短信文本特征提取, 还能在对短信文本进行分类时分辨中不同词语的重要程度从而实现对重点词语的提取, 与未使用自注意机制和TFIDF模型的Bi-LSTM模型相比, 在对垃圾短信和正常短信分类时的分类准确率, 召回率, F1值, 运行时间等值上有较大的提升, 其中分类准确率达到了90.1%, 召回率达到了90.5%, F1值达到了90.2%, 说明该模型在对短信文本处理时具有更好的分类能力[21], 同时从实验结果的准确率与训练集大小的性能趋势曲线上来看, 该模型始终优于其他模型, 该模型相较于其他模型需要更少的训练数据就可以到达较高的准确率. 实验结果验证了结合TFIDF的self-attention-based Bi-LSTM神经网络模型的可行性和有效性.

本文的主要贡献如下:

(1)将Bi-LSTM模型运用到垃圾短信识别中, 既可以利用过去的信息也可以利用将来的信息.

(2)将自注意机制和TFIDF模型相结合, 进一步加强重点词汇的权重, 增强分类效果.

(3)在BI-LSTM模型中引用自注意机制和TFIDF模型, 进一步获取对短信文本分类结果产生影响的重点词语的特征.

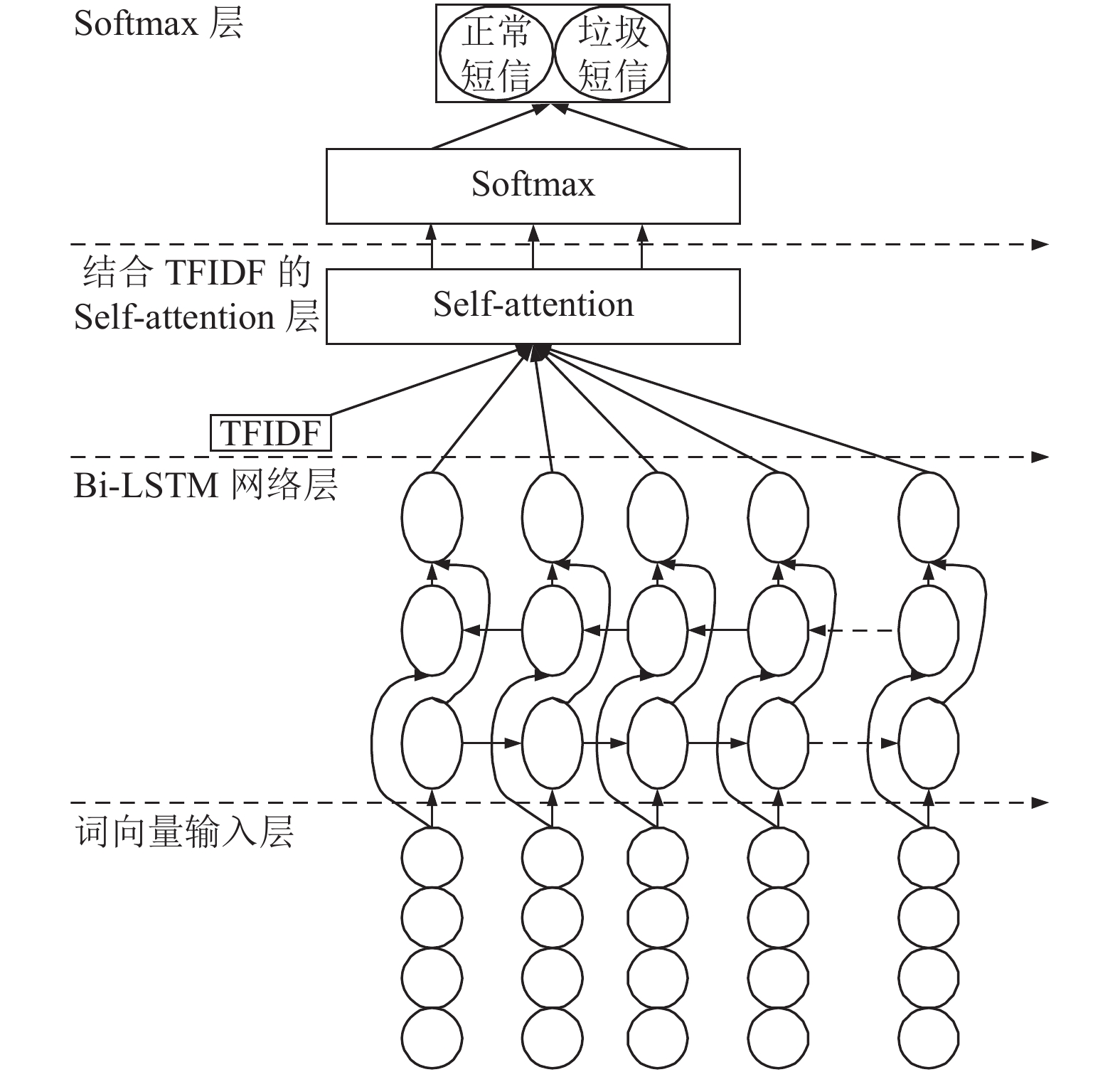

1 模型构建本文结合TFIDF的self-attention-based Bi-LSTM神经网络总体模型如图1所示, 模型包含词向量输入层, Bi-LSTM网络层, 结合TFIDF的自注意层, Softmax层. 模型流程主要是短信文本以词向量的方式输入到Bi-LSTM层, 经过特征提取并结合TFIDF和自注意层的重点词汇加权从而获得最后的特征向量, 最后通过Softmax分类器对最终的特征向量进行分类从而得到短信文本分类结果.

1.1 RNN模型RNN能处理序列问题, 允许信息持久化, 即将上一刻运算结果添加到当前计算的输入中去, 从而实现了“考虑上下文信息”的功能, 可用于一段段连续的语义, 一段段连续的段落等, RNN包含循环结构, 例如一个tanh层. 具体运行过程是t时刻输入当前信息

|

图 1 结合TFIDF的self-attention-based Bi-LSTM模型 |

|

图 2 RNN结构 |

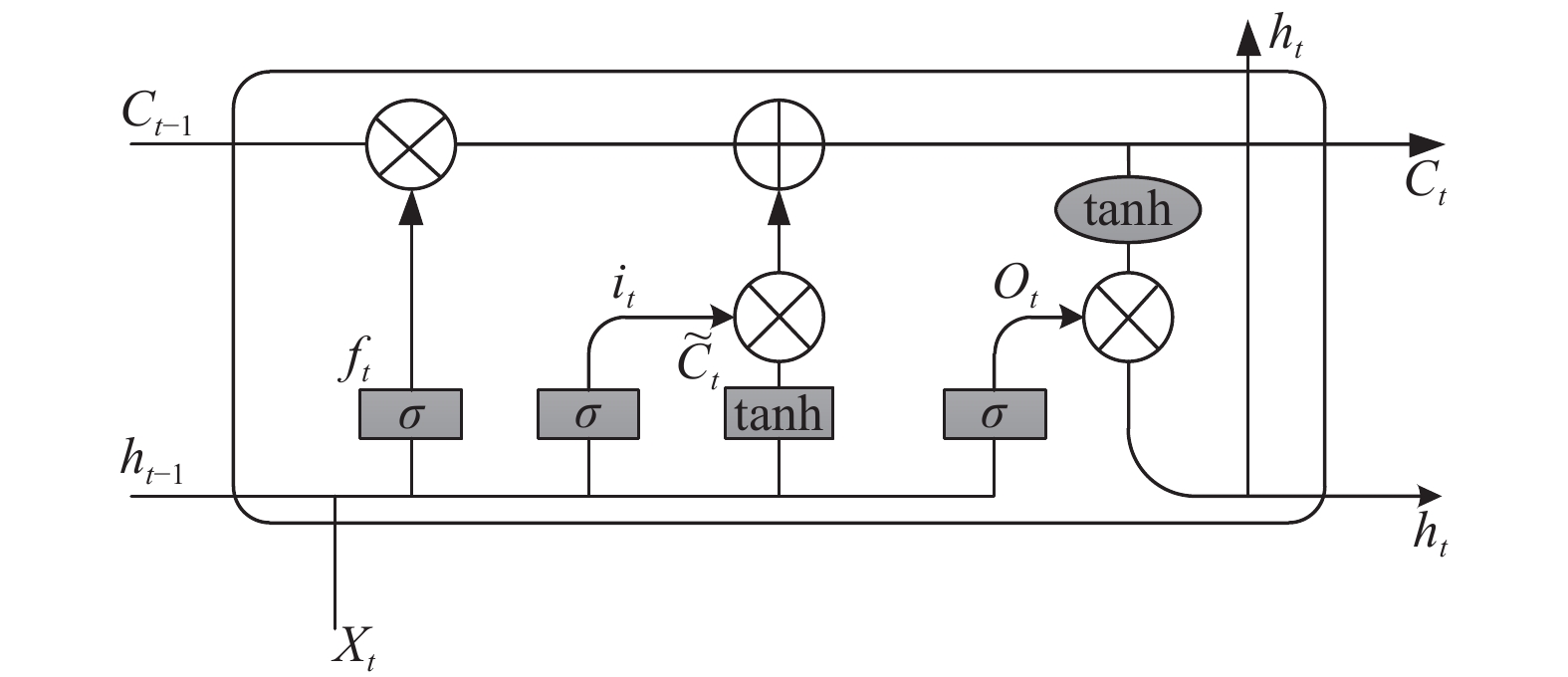

1.2 LSTM模型

在RNN模型中仅靠一条线来记录所有的输入信息其工作效果并不是很理想, 很难完美的处理具有长期依赖的信息, 如一段很长的英语句子, RNN很难记住前面主语的时态形式从而在句子后面选择相应的合适的时态. 因此在RNN模型的基础上, 出现了LSTM. LSTM是一种特殊的循环神经网络, 可以学习长期依赖信息, 其结构和传统的RNN结构相同, 只是重复模块A结构更加复杂些, 多了一个单元控制器Cell, 其能够判断信息是否有用, 从而解决了RNN常有的梯度消失或者梯度爆炸的问题. LSTM结构内部主要包括输入门

|

图 3 LSTM结构 |

(1)遗忘门

| ${{{f}}}_{{{t}}}={{\sigma }}\left({{{W}}}_{{{f}}} \cdot \left[{{{h}}}_{{{t}}-1},{{{x}}}_{{{t}}}\right]+{{{b}}}_{{{f}}}\right)$ | (1) |

其中,

(2)输入门

| ${i}_{t}=\sigma ({W}_{i} \cdot [{h}_{t-1},{x}_{t}]+{b}_{i})$ | (2) |

| ${\tilde C}_{t}={\rm tanh}({W}_{C} \cdot [{h}_{t-1},{x}_{t}]+{b}_{C})$ | (3) |

| ${C}_{t}={f}_{t}*{C}_{t-1}+{i}_{t}*{\tilde C}_{t}$ | (4) |

其中,

(3)输出门控制哪些信息用于此刻的输出, 输出门是由历史信息

| ${{{o}}}_{{{t}}}={{\sigma }}({{{W}}}_{{{o}}} \cdot [{{{h}}}_{{{t}}-1},{{{x}}}_{{{t}}}]+{{{b}}}_{{{o}}})$ | (5) |

| ${{{h}}}_{{{t}}}={{{o}}}_{{{t}}}*{{\rm tanh}}\left({{{C}}}_{{{t}}}\right)$ | (6) |

其中,

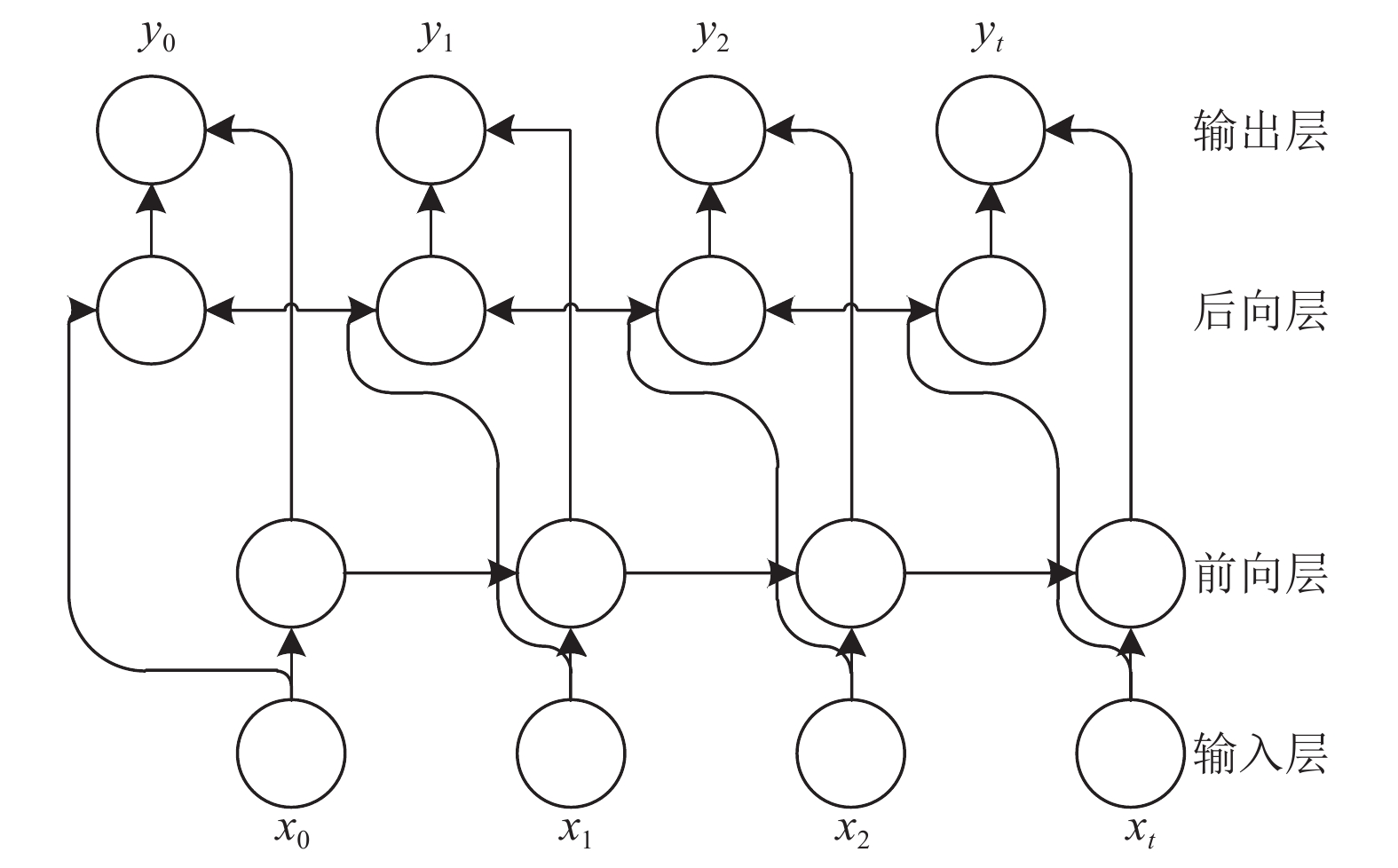

Bi-LSTM是对LSTM的改进, 因为LSTM是序列化处理信息, 所以在信息处理上有先后的顺序, 也就是常常忽略下文信息, 不能综合上下文的信息, 例如: “作业写完了, 我想_手机”, 要在横线中填词, 如果只考虑前面的信息, 那么横线可以填“睡觉”, “玩”, “看电视”等, 但是如果同时结合后面的信息“手机”一词, 那么横线处填“玩”的概率最大, 而Bi-LSTM模型包含一个前向的LSTM模型和一个后向的LSTM模型, 可以获取足够的上下文信息, 并且两个模型都被连接到相同的输出层, Bi-LSTM结构如图4所示.

|

图 4 Bi-LSTM结构 |

图4中前向的LSTM模型捕捉当前时刻的前文特征信息, 后向的LSTM模型捕捉当前时刻的后文特征信息, Bi-LSTM模型t时刻的输入的计算公式如下:

| ${{{H}}}_{{{t}}}=\left[\overleftarrow{{{{h}}}_{{{t}}}}, \overrightarrow{{{{h}}}_{{{t}}}}\right]$ | (7) |

其中,

TFIDF是一种于咨询检索与咨询勘探的常用加权技术, 主要用以评估一字词对于一个文集的重要程度或者对于一个语料库中的其中一份文件的重要程度, 字词的重要程度与它在文档中出现的次数成正比, 与它在整个语料库出现次数成反比. 该模型主要包括: 词频(TF)和逆文档频率(IDF)两个部分, TF表示某个词

| $TF\left({w}_{n},{d}_{m}\right)=\frac{{f}_{n,m}}{\sum _{i=1}^{N}{f}_{i,m}}$ | (8) |

| $IDF\left({w}_{n},{d}_{m}\right)=\log\left(\frac{D}{{D}_{{w}_{n}}+1}\right)$ | (9) |

其中,

TFIDF权重即为TF和IDF的乘积, 计算公式如下:

| $TFID{F_{MN}} = \left[ {\begin{array}{*{20}{c}} {t{f_{11}},}&t{f_{12}},& \cdots&{t{f_{1N}}}\\ {t{f_{21}},}&{t{f_{22}}},&\cdots &{t{f_{2N}}}\\ \vdots & \vdots & \ddots & \vdots \\ {t{f_{M1}},}&{t{f_{M2}},}& \cdots &{t{f_{MN}}} \end{array}} \right]$ | (10) |

短信文本的识别过程中, 文本所包含的词数比较少, 很难获取更多的句子语义信息, 但通过对比语料库可以发现, 在句子中的某些重点词汇可以更快的帮助识别短信类别, 如在“元旦特惠, 原价xxx的三星手机现在特惠, 全部八折, 最高直降xxx”这样的一条垃圾短信中, 就包含了一些重点词汇: “三星”(品牌名称), “特惠”, “八折”, “直降”等. 对于不同的词汇, 其对文本分类起到的作用也不一样, 因此为突出关键词并优化特征词提取过程, 引入Attention机制, 结构如图5所示.

|

图 5 Attention机制结构 |

Attention机制通过对不同的词汇分配不同的权重从而强化关键信息的比重. 传统的attention机制模型需要依赖部分外部信息, 而self-attention机制不需要使用其他外部的信息, 它会自动从自身所给的信息训练来更新参数从而给不同信息分配不同的权重, 因此本文采用self-attention机制.

根据Bi-LSTM所有的输出向量组成的矩阵H=

计算公式如下:

| $Y = \left[ {\begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {}&H&{} \end{array}}\\ {\begin{array}{*{20}{c}} {TFID{F_N}}& \otimes &{{e_N}} \end{array}} \end{array}} \right]$ | (11) |

| $M={\rm{tanh}}\left(Y\right)$ | (12) |

| $\alpha ={Softmax}\left({W}^{\rm T}M\right)$ | (13) |

| $\gamma = H{\alpha }^{T}$ | (14) |

H包含Bi-LSTM所输出向量

本文参与实验的短信数据共有20万条, 分为垃圾短信(negative)和正常短信(positive)两种, 其中正常短信数量为10万条, 垃圾短信数量为10万条, 这些数据在初始化时已经被分为了垃圾短信或者正常短信.

2.2 实验数据预处理和参数设置原始短信数据包含了很多非法符号, 例如表情符号这些对于短信分类并没有用, 所以数据不直接使用, 先进行数据的清洗. 经过清洗过的短信数据要进行中文分词处理, 将短信的句子拆成单个中文单词, 本文中使用结巴分词工具对短信进行分词, 分词结束之后去除短信文本中的停用词, 常见的停用词有“的”“得”“在”等, 提高关键词密度, 增强搜索效率.

分词处理之后, 本文使用Word2Vec工具初始化词向量, 同时使用Skip-gram[22, 23]模型训练数据集, 并结合维基中文语料库训练词向量维度, 词向量维度越高可以越好的表达中文单词的语义, 但是随着维度的升高也会增加模型参数的数量, 因此经过实验对比, 将词向量维度设置为100, 隐藏层设置为128, 窗口大小设置为5, 经过预处理之后的短信数据最长的一条为100个中文词汇, 因此每条短信的特征矩阵大小均为, 将特征矩阵作为TFIDF-self-attention-based Bi-LSTM模型的输入参与到模型的训练中去.

2.3 评价指标本文以准确率Precision, 召回率Recall和F1作为指标来评估模型在垃圾短信识别任务中的有效性, 计算公式如下:

| $ Precision = \frac{{{{{N}}_{{\rm{right}}}}}}{{{{{N}}_{{\rm{right}}}} + {N_{\rm wrong}}}} $ | (15) |

| $ Recall = \frac{{TP}}{{TP + FN}} $ | (16) |

| $ F1 = \frac{{2 \times Precision \times Recall}}{{Precision + Recall}} $ | (17) |

其中,

本文采用十折交叉验证法来评估模型在短信测试集上的准确率.

3 结语 3.1 实验结果在本文中, 设计了4组对比实验, 分别使用了LSTM, Bi-LSTM, self-attention-based Bi-LSTM (SA Bi-LSTM), 结合TFIDF的self-attention-based Bi-LSTM (TSA Bi-LSTM) 4组不同的模型, 准确率实验结果和运行时间对比实验结果分别如表1和表2所示, 对4种模型根据不同训练集的大小进行实验结果如图6所示.

| 表 1 准确率对比实验结果 |

| 表 2 运行时间对比实验结果 |

|

图 6 训练集大小与准确率比较 |

3.2 模型对比分析

4种不同模型的准确率可以看出, LSTM模型的准确率低于Bi-LSTM模型的准确率, 在Bi-LSTM模型中引入attention机制准确率得到了提高, 而self-attention-based BI-LSTM模型结合TFIDF则又进一步提高了模型准确率.

因此, 通过以上实验结果可得出结论:

(1)对比LSTM模型和Bi-LSTM模型, 发现Bi-LSTM1模型准确率高于LSTM模型, 同时模型用时更短, 所以Bi-LSTM模型对文本特征信息提取具有更精确的效果.

(2)对比Bi-LSTM模型和self-attention-based Bi-LSTM模型, 可以得出在Bi-LSTM模型引入self-attention机制之后可以提高模型的准确率并且一定程度上缩短了模型运行时间, 证明了self-attention机制的有效性.

(3)对比self-attention-based Bi-LSTM模型和结合TFIDF的self-attention-based Bi-LSTM模型, 可以得出将注意力机制和TFIDF模型相结合, 更能有效提高重点词汇的权重达到更好的分类效果.

4 结语本文将self-attention机制和TFIDF模型相结合加入到Bi-LSTM模型, 设计出结合TFIDF的self-attention-based Bi-LSTM模型, 并应用到垃圾短信识别中, 通过4组对比实验, 验证了该模型具有良好的使用效果.

由于self-attention机制的引用需要消耗一定的计算成本, 因此在未来的工作中, 将考虑如何在减少self-attention机制对计算成本消耗的基础上继续优化结合TFIDF的self-attention-based Bi-LSTM模型, 使得该模型能在未来的应用中达到更好的使用表现.

| [1] |

Shahi TB, Yadav A. Mobile SMS spam filtering for Nepali text using Naïve Bayesian and support vector machine. International Journal of Intelligence Science, 2014, 4(1): 24-28. DOI:10.4236/ijis.2014.41004 |

| [2] |

Kim Y. Convolutional neural networks for sentence classification. arXiv: 1408.5882, 2014.

|

| [3] |

Jiang MY, Liang YC, Feng XY, et al. Text classification based on deep belief network and softmax regression. Neural Computing and Applications, 2018, 29(1): 61-70. DOI:10.1007/s00521-016-2401-x |

| [4] |

Talman A, Yli-Jyrä A, Tiedemann J. Natural language inference with hierarchical BiLSTM max pooling architecture. arXiv: 1808.08762, 2018.

|

| [5] |

雷朔, 刘旭敏, 徐维祥. 基于词向量特征扩展的中文短文本分类研究. 计算机应用与软件, 2018, 35(8): 269-274. DOI:10.3969/j.issn.1000-386x.2018.08.049 |

| [6] |

Zhang R, Lee H, Radev D. Dependency sensitive convolutional neural networks for modeling sentences and documents. arXiv: 1611.02361, 2016.

|

| [7] |

Anoop VS, Prem SC, Asharaf S, et al. Generating and visualizing topic hierarchies from microblogs: An iterative latent dirichlet allocation approach. Proceedings of 2015 International Conference on Advances in Computing, Communications and Informatics (ICACCI). Kochi, India. 2015. 824–828.

|

| [8] |

Wigington C, Stewart S, Davis B, et al. Data augmentation for recognition of handwritten words and lines using a CNN-LSTM network. Proceedings of the 14th IAPR International Conference on Document Analysis and Recognition (ICDAR). Kyoto, Japan. 2017. 639–645.

|

| [9] |

Kim Y, Jernite Y, Sontag D, et al. Character-aware neural language models. arXiv: 1508.06615, 2015.

|

| [10] |

Gers FA, Schmidhuber E. LSTM recurrent networks learn simple context-free and context-sensitive languages. IEEE Transactions on Neural Networks, 2001, 12(6): 1333-1340. DOI:10.1109/72.963769 |

| [11] |

Graves A. Supervised sequence labelling with recurrent neural networks. Berlin, Heidelberg: Springer, 2012.

|

| [12] |

Hochreiter S, Schmidhuber J. Long short-term memory. Neural Computation, 1997, 9(8): 1735-1780. DOI:10.1162/neco.1997.9.8.1735 |

| [13] |

Kiperwasser E, Goldberg Y. Simple and accurate dependency parsing using bidirectional LSTM feature representations. Transactions of the Association for Computational Linguistics, 2016, 4: 313-327. DOI:10.1162/tacl_a_00101 |

| [14] |

唐明, 朱磊, 邹显春. 基于Word2Vec的一种文档向量表示. 计算机科学, 2016, 43(6): 214-217, 269. DOI:10.11896/j.issn.1002-137X.2016.06.043 |

| [15] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, CA, USA. 2017. 5998–6008.

|

| [16] |

Carrasco M, Barbot A. Spatial attention alters visual appearance. Current Opinion in Psychology, 2019, 29: 56-64. DOI:10.1016/j.copsyc.2018.10.010 |

| [17] |

郑雄风, 丁立新, 万润泽. 基于用户和产品Attention机制的层次BGRU模型. 计算机工程与应用, 2018, 54(11): 145-152. DOI:10.3778/j.issn.1002-8331.1701-0337 |

| [18] |

Cho K, Van Merrienboer B, Gulcehre C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation. arXiv: 1406.1078, 2014.

|

| [19] |

Mikolov T, Yih WT, Zweig G. Linguistic regularities in continuous space word representations. Proceedings of the 2013 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Atlanta, GA, USA. 2013. 746–751.

|

| [20] |

Mikolov T, Sutskever I, Chen K, et al. Distributed representations of words and phrases and their compositionality. Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, NV, USA. 2013. 3111–3119.

|

| [21] |

Mikolov T, Chen K, Corrado G, et al. Efficient estimation of word representations in vector space. Proceedings of the 1st International Conference on Learning Representations. Scottsdale, AZ, USA. 2013. 1–12.

|

| [22] |

Zhao MZ, Xu B, Lin HF, et al. Discover potential adverse drug reactions using the skip-gram model. Proceedings of 2015 IEEE International Conference on Bioinformatics and Biomedicine. Washington, WA, USA. 2015. 599–698.

|

| [23] |

来斯惟, 徐立恒, 陈玉博, 等. 基于表示学习的中文分词算法探索. 中文信息学报, 2013, 27(5): 8-14. DOI:10.3969/j.issn.1003-0077.2013.05.002 |

2001, Vol. 29

2001, Vol. 29